Ramai penyelidik dari akademia dan industri menjalankan perbincangan mendalam mengenai "teknologi pemprosesan imej dan teks pintar serta teknologi aplikasi berbilang senario". Selepas pengeboman berterusan GPT-4 dan Microsoft 365 Copilot, saya percaya ramai orang mempunyai perasaan ini.

Berbanding dengan GPT-3.5, GPT-4 telah mencapai peningkatan yang ketara dalam banyak aspek Contohnya, dalam peperiksaan mock bar, ia telah berkembang daripada 10% terbawah asal kepada 10%. Sudah tentu, orang biasa mungkin tidak mempunyai sebarang idea tentang peperiksaan profesional ini. Tetapi jika saya tunjukkan gambar kepada anda, anda akan faham betapa menakutkannya peningkatan itu:

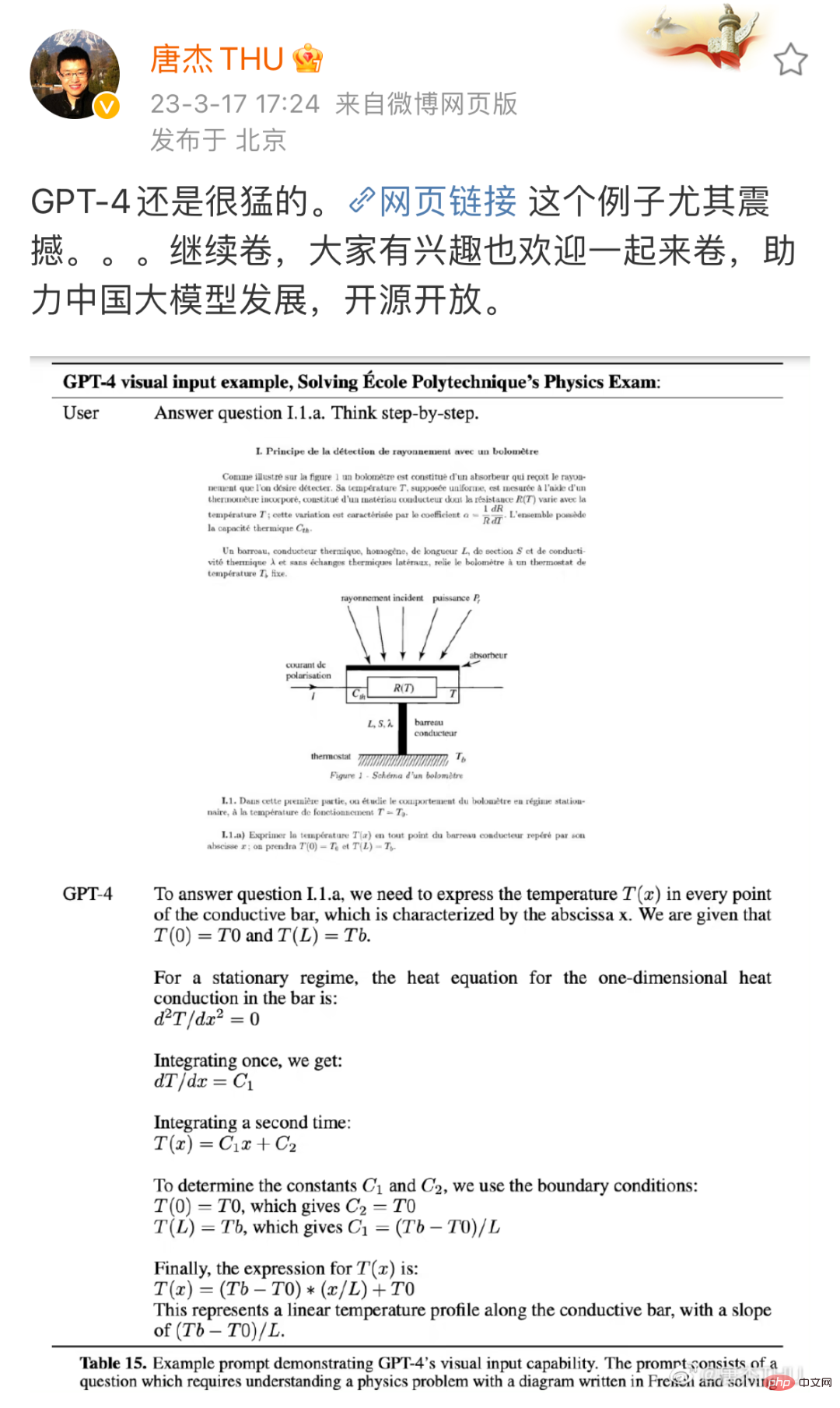

Sumber: Weibo of Tang Jie, profesor Jabatan Sains Komputer di Universiti Tsinghua. Pautan: https://m.weibo.cn/detail/4880331053992765

Ini adalah soalan fizik GPT-4 diperlukan untuk menyelesaikan masalah langkah demi langkah berdasarkan gambar dan teks Ini ialah GPT-3.5 (di sini Merujuk kepada keupayaan yang tidak dimiliki oleh model yang ChatGPT bergantung sebelum naik taraf. Di satu pihak, GPT-3.5 hanya dilatih untuk memahami teks, dan ia tidak dapat memahami gambar dalam soalan. Sebaliknya, keupayaan menyelesaikan masalah GPT-3.5 juga sangat lemah, dan ia boleh dihalang oleh ayam dan arnab dalam sangkar yang sama. Tetapi kali ini, kedua-dua masalah nampaknya telah diselesaikan dengan indah. Apabila semua orang menganggap ini adalah masalah besar, Microsoft mengeluarkan satu lagi blokbuster: GPT-4 Keupayaan ini telah disepadukan ke dalam aplikasi baharu yang dipanggil Microsoft 365 Copilot. Dengan keupayaan pemprosesan imej dan teks yang berkuasa, Microsoft 365 Copilot bukan sahaja boleh membantu anda menulis pelbagai dokumen, tetapi juga dengan mudah menukar dokumen kepada PPT dan secara automatik meringkaskan data Excel ke dalam carta...

Dari debut teknologi hingga pelancaran produk, OpenAI dan Microsoft hanya memberi masa dua hari kepada orang ramai untuk bertindak balas. Nampaknya dalam sekelip mata, revolusi produktiviti baharu telah tiba.

Oleh kerana perubahan berlaku begitu pantas, kedua-dua akademia dan industri lebih kurang berada dalam keadaan keliru dan "FOMO (takut terlepas, takut terlepas)". Pada masa ini, semua orang ingin mengetahui jawapan: Apa yang boleh kita lakukan dalam gelombang ini? Apakah peluang yang ada? Daripada tunjuk cara yang dikeluarkan oleh Microsoft, kami boleh menemui kejayaan yang jelas:

Oleh kerana perubahan berlaku begitu pantas, kedua-dua akademia dan industri lebih kurang berada dalam keadaan keliru dan "FOMO (takut terlepas, takut terlepas)". Pada masa ini, semua orang ingin mengetahui jawapan: Apa yang boleh kita lakukan dalam gelombang ini? Apakah peluang yang ada? Daripada tunjuk cara yang dikeluarkan oleh Microsoft, kami boleh menemui kejayaan yang jelas:

.

Dalam senario kehidupan sebenar, banyak pekerjaan dalam pelbagai industri berkaitan dengan pemprosesan grafik dan teks, seperti menyusun data tidak berstruktur ke dalam carta, menulis laporan berdasarkan carta dan mengekstrak maklumat berguna daripada maklumat grafik dan teks yang besar. Maklumat dan sebagainya. Oleh kerana itu, kesan revolusi ini mungkin jauh lebih mendalam daripada yang dibayangkan oleh ramai orang. Kertas kerja blokbuster baru-baru ini dikeluarkan oleh OpenAI dan Sekolah Wharton meramalkan kesan ini: kira-kira 80% daripada tenaga kerja A.S. mungkin mempunyai sekurang-kurangnya 10% daripada tugas kerja mereka terjejas oleh pengenalan GPT, dan kira-kira 19% pekerja mungkin melihat di sekurang-kurangnya 50% daripada tugas terjejas. Adalah dijangkakan bahawa sebahagian besar kerja melibatkan kecerdasan grafik dan teks. Pada titik permulaan sedemikian, apakah usaha penyelidikan atau usaha kejuruteraan yang patut diterokai? Dalam acara Jelajah Perusahaan CSIG baru-baru ini yang dihoskan oleh Persatuan Imej dan Grafik Cina (CSIG) dan anjuran bersama oleh Hehe Information dan Jawatankuasa Profesional Analisis dan Pengiktirafan Imej Dokumen CSIG, ramai penyelidik dari akademia dan industri menumpukan pada "

Grafik dan Teks "Teknologi pemprosesan pintar dan teknologi aplikasi berbilang senario" telah dibincangkan secara mendalam, yang mungkin memberikan sedikit inspirasi kepada penyelidik dan pengamal yang mengambil berat tentang bidang pemprosesan imej dan teks pintar.

Memproses grafik dan teks bermula dengan penglihatan asasSeperti yang dinyatakan sebelum ini, grafik dan keupayaan pemprosesan teks GPT-4 sangat mengejutkan. Sebagai tambahan kepada soalan fizik di atas, laporan teknikal OpenAI juga memetik contoh lain, seperti membenarkan GPT-4 membaca imej kertas:

Namun, jika kita ingin membuat teknologi ini meluas Mungkin masih banyak kerja asas yang perlu dilakukan sebelum ia dilaksanakan, dan visi asas adalah salah satunya. Ciri-ciri penglihatan asas sangat jelas: input ialah imej, dan output juga imej. Prapemprosesan imej, penapisan, pemulihan dan peningkatan semuanya termasuk dalam kategori ini.

Ciri-ciri penglihatan asas sangat jelas: input ialah imej, dan output juga imej. Prapemprosesan imej, penapisan, pemulihan dan peningkatan semuanya termasuk dalam kategori ini.

"Teori dan kaedah penglihatan asas digunakan secara meluas dalam banyak bidang, seperti telefon bimbit, analisis imej perubatan, pemantauan keselamatan, dll. Perusahaan dan institusi yang menghargai kualiti imej dan kandungan video mesti memberi perhatian ke arah visi asas Penyelidikan Jika visi asas tidak dilakukan dengan baik, banyak sistem penglihatan peringkat tinggi (seperti pengesanan, pengecaman dan pemahaman) tidak dapat dilaksanakan dengan benar."

Guo Fengjun, pengarah algoritma imej. penyelidikan dan pembangunan di Hehe Information, kata semasa acara Jelajah Perusahaan CSIG. Bagaimana untuk memahami ayat ini? Kita boleh melihat beberapa contoh:

Berbeza daripada situasi ideal yang ditunjukkan dalam demo OpenAI dan Microsoft, grafik dan teks dalam dunia nyata sentiasa wujud dalam bentuk yang mencabar, seperti ubah bentuk, bayang-bayang dan corak moiré, yang akan meningkatkan kesukaran pengecaman dan pemahaman seterusnya . Matlamat pasukan Guo Fengjun adalah untuk menyelesaikan masalah ini pada peringkat awal.

Untuk tujuan ini, mereka membahagikan tugas ini kepada beberapa modul, termasuk pengekstrakan kawasan minat (RoI), pembetulan ubah bentuk, pemulihan imej (seperti penyingkiran bayang-bayang, corak moiré), peningkatan kualiti (seperti penajaman) , kejelasan), dsb.

Gabungan teknologi ini boleh mencipta beberapa aplikasi yang sangat menarik. Selepas bertahun-tahun penerokaan, modul ini telah mencapai keputusan yang agak baik, dan teknologi yang berkaitan telah digunakan pada produk pengecaman teks pintar syarikat "Pengimbas".

Selepas imej diproses, tugas seterusnya ialah mengenal pasti kandungan gambar dan teks di atas. Ini juga merupakan kerja yang sangat terperinci, malah mungkin dilakukan dalam unit "perkataan".

Dalam banyak senario dunia sebenar, aksara mungkin tidak semestinya muncul dalam bentuk cetakan standard, yang membawa cabaran kepada pengecaman aksara.

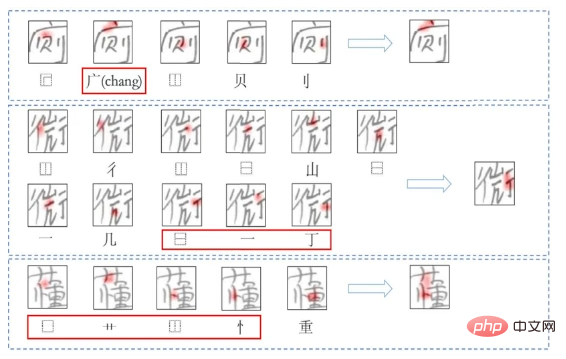

Ambil adegan pendidikan sebagai contoh. Katakan anda seorang guru, dan anda pasti mahu AI secara langsung membantu anda membetulkan semua kerja rumah pelajar, dan pada masa yang sama merumuskan penguasaan pelajar dalam setiap bahagian pengetahuan Adalah lebih baik untuk memberikan soalan, kesilapan dan pembetulan yang salah cadangan. Du Jun, profesor madya di Makmal Kejuruteraan Kebangsaan untuk Pemprosesan Maklumat Pertuturan dan Bahasa di Universiti Sains dan Teknologi China sedang melakukan kerja di kawasan ini.

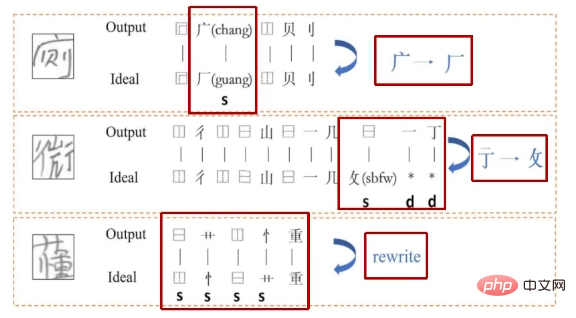

Secara khusus, mereka mencipta sistem pengecaman, penjanaan dan penilaian aksara Cina berdasarkan radikal, kerana terdapat lebih sedikit kombinasi radikal daripada pemodelan watak keseluruhan. Antaranya, pengiktirafan dan penjanaan dioptimumkan secara bersama, iaitu sedikit sebanyak proses pengukuhan bersama literasi dan penulisan apabila pelajar belajar. Pada masa lalu, kebanyakan kerja penilaian tertumpu pada tahap tatabahasa, tetapi pasukan Du Jun mereka kaedah yang boleh mencari kesilapan menaip terus daripada imej dan menerangkan ralat secara terperinci. Kaedah ini akan sangat berguna dalam senario seperti penandaan pintar.

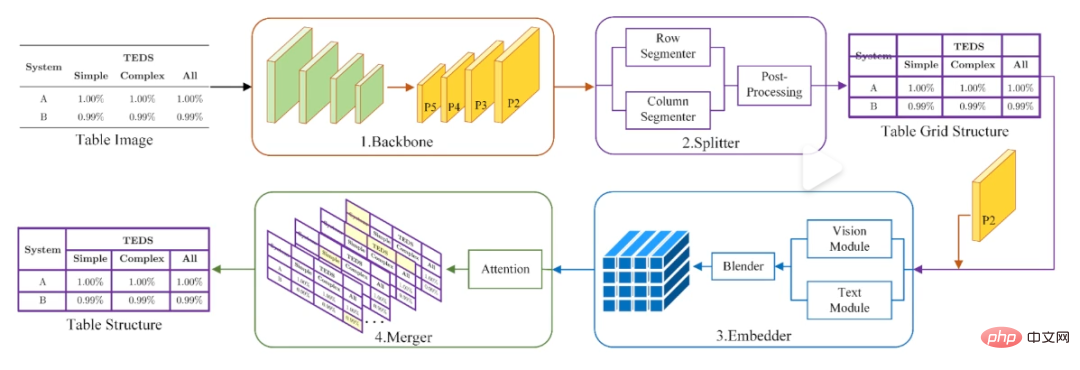

Selain teks, pengenalan dan pemprosesan jadual sebenarnya merupakan satu kesukaran besar, kerana anda bukan sahaja perlu mengenal pasti kandungan di dalam, tetapi juga menjelaskan hubungan struktur antara kandungan ini, dan sesetengah jadual mungkin tidak mempunyai bingkai wayar. Untuk tujuan ini, pasukan Du Jun mereka bentuk kaedah "pecah dahulu, kemudian cantumkan", iaitu, mula-mula bahagikan imej jadual kepada satu siri grid asas, dan kemudian buat pembetulan selanjutnya melalui penggabungan.

Kaedah pengecaman borang "perpecahan pertama, kemudian gabung" pasukan Du Jun.

Sudah tentu, semua kerja ini akhirnya akan memainkan peranan dalam penstrukturan dan pemahaman dokumen di peringkat bab. Dalam persekitaran kehidupan sebenar, kebanyakan dokumen yang dihadapi oleh model adalah lebih daripada satu halaman (seperti kertas). Ke arah ini, kerja pasukan Du Jun memfokuskan pada klasifikasi elemen dokumen merentas halaman dan pemulihan struktur dokumen merentas halaman. Walau bagaimanapun, kaedah ini masih mempunyai had dalam senario berbilang susun atur.

Mengenai pemprosesan dan pemahaman imej dan teks peringkat bab, kita sebenarnya tidak jauh dari GPT-4. "Selepas GPT-4 pelbagai mod keluar, kami juga memikirkan sama ada kami boleh melakukan sesuatu dalam aspek ini," kata Du Jun pada majlis itu. Saya percaya bahawa ramai penyelidik atau pengamal dalam bidang pemprosesan imej dan teks mempunyai idea ini.

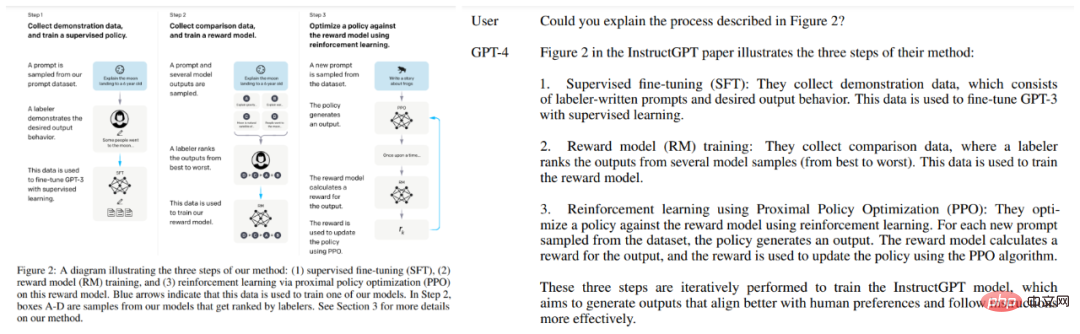

Matlamat siri model GPT sentiasa berusaha untuk meningkatkan fleksibiliti dan akhirnya mencapai kecerdasan am buatan (AGI). Keupayaan pemahaman imej dan teks yang berkuasa yang ditunjukkan oleh GPT-4 kali ini merupakan bahagian penting dalam keupayaan umum ini. Untuk membuat model dengan keupayaan yang sama, OpenAI telah memberikan beberapa rujukan, tetapi juga meninggalkan banyak misteri dan masalah yang tidak dapat diselesaikan.

Pertama sekali, kejayaan GPT-4 menunjukkan bahawa pendekatan model besar + pelbagai mod boleh dilaksanakan. Walau bagaimanapun, apakah isu yang perlu dikaji dalam model besar dan cara menyelesaikan keperluan kuasa pengkomputeran yang berlebihan bagi model berbilang modal adalah semua cabaran yang dihadapi oleh penyelidik.

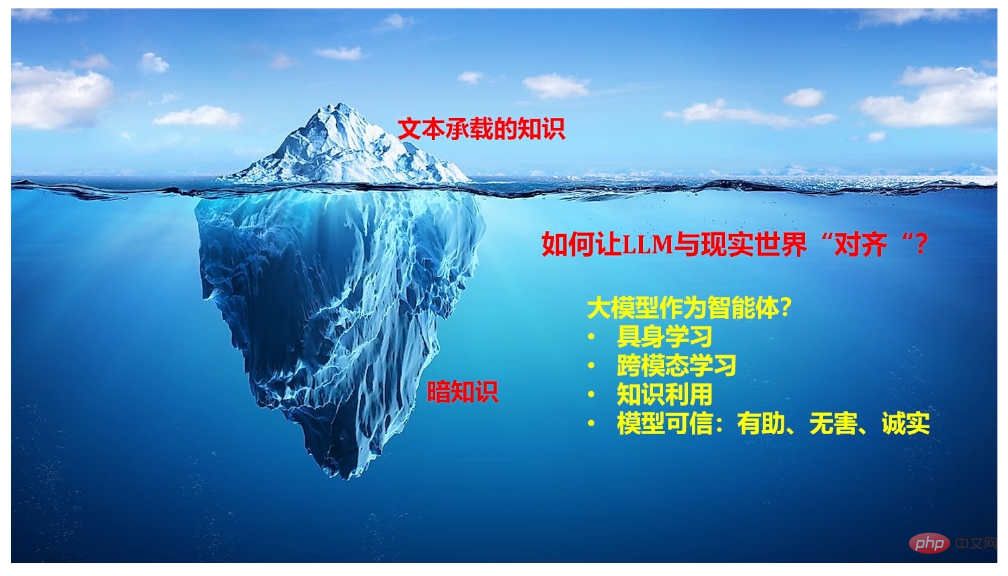

Untuk soalan pertama, Qiu Xipeng, seorang profesor di Pusat Pengajian Sains Komputer di Universiti Fudan memberikan beberapa arahan yang patut dirujuk. Menurut beberapa maklumat yang sebelum ini didedahkan oleh OpenAI, kami tahu bahawa ChatGPT tidak dapat dipisahkan daripada beberapa teknologi utama, termasuk pembelajaran dalam konteks, rantaian pemikiran dan belajar daripada arahan. Qiu Xipeng menegaskan dalam perkongsiannya bahawa masih banyak isu yang perlu dibincangkan ke arah ini, seperti dari mana kebolehan ini datang, bagaimana untuk terus menambah baik, dan cara menggunakannya untuk mengubah paradigma pembelajaran sedia ada. Di samping itu, beliau juga berkongsi keupayaan yang harus dipertimbangkan semasa membina model bahasa berskala besar perbualan dan hala tuju penyelidikan yang boleh dipertimbangkan untuk menyelaraskan model ini dengan dunia sebenar.

Untuk soalan kedua, Profesor Terhormat Nanqiang Universiti Xiamen Ji Rongrong menyumbangkan idea penting. Dia percaya bahawa terdapat hubungan semula jadi antara bahasa dan penglihatan, dan pembelajaran bersama antara keduanya adalah trend umum. Tetapi dalam menghadapi gelombang ini, kuasa mana-mana universiti atau makmal adalah tidak penting. Jadi sekarang, bermula dari Universiti Xiamen tempat dia bekerja, dia cuba memujuk penyelidik untuk mengintegrasikan kuasa pengkomputeran dan membentuk rangkaian untuk membina model berbilang modal yang besar. Malah, pada satu acara suatu ketika dahulu, Ahli Akademik E Weinan, yang memberi tumpuan kepada AI untuk Sains, menyatakan pandangan yang sama, berharap semua lapisan masyarakat akan "berani mengumpulkan sumber dalam arah inovasi asal."

Namun, adakah laluan yang diambil oleh GPT-4 pasti membawa kepada kecerdasan buatan am? Sesetengah penyelidik ragu-ragu tentang perkara ini, dan pemenang Anugerah Turing Yann LeCun adalah salah seorang daripada mereka. Beliau percaya bahawa model besar semasa ini mempunyai permintaan yang mengejutkan untuk data dan kuasa pengkomputeran, tetapi kecekapan pembelajarannya sangat rendah (seperti kereta pandu sendiri). Oleh itu, beliau mencipta teori yang dipanggil "model dunia" (model dalaman bagaimana dunia berfungsi), mempercayai bahawa mempelajari model dunia (yang boleh difahami sebagai menjalankan simulasi untuk dunia sebenar) mungkin menjadi kunci untuk mencapai AGI. Pada majlis itu, Profesor Yang Xiakang dari Shanghai Jiao Tong University berkongsi kerja mereka ke arah ini. Khususnya, pasukannya menumpukan pada model dunia intuisi visual (kerana gerak hati visual mempunyai sejumlah besar maklumat), cuba memodelkan penglihatan, gerak hati, dan persepsi masa dan ruang. Akhir sekali, beliau juga menekankan kepentingan persilangan matematik, fizik, kognisi maklumat dan disiplin komputer untuk jenis penyelidikan ini.

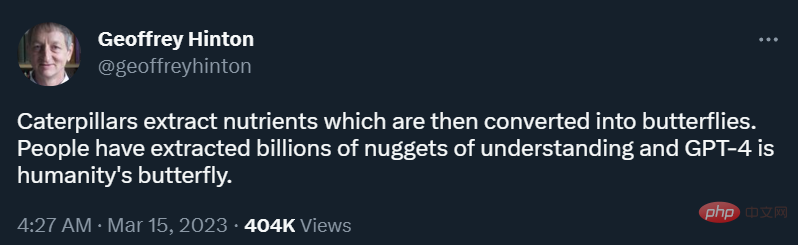

"Ulat mengekstrak nutrien daripada makanan mereka dan bertukar menjadi rama-rama. Orang ramai telah mengekstrak berbilion-bilion petunjuk untuk memahami bahawa GPT-4 adalah rama-rama untuk manusia sehari selepas GPT-4 dikeluarkan , Geoffrey Hinton, the bapa pembelajaran mendalam, tweeted.

Pada masa ini, tiada siapa yang dapat mengetahui betapa besar taufan rama-rama ini akan bergerak. Tetapi yang pasti, ini bukan rama-rama yang sempurna lagi, dan keseluruhan teka-teki dunia AGI masih belum lengkap. Setiap penyelidik dan pengamal masih mempunyai peluang.

Atas ialah kandungan terperinci Apabila GPT-4 belajar membaca gambar dan teks, revolusi produktiviti tidak dapat dihalang. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Apakah kemahiran yang diperlukan untuk bekerja dalam industri PHP?

Apakah kemahiran yang diperlukan untuk bekerja dalam industri PHP?

Penggunaan rangka kerja DWZ

Penggunaan rangka kerja DWZ

SVN mengabaikan tetapan fail

SVN mengabaikan tetapan fail

Apakah maksud pembubaran?

Apakah maksud pembubaran?

Perkara yang perlu dilakukan mengenai ralat sambungan

Perkara yang perlu dilakukan mengenai ralat sambungan

Cara menggunakan setrequestproperty

Cara menggunakan setrequestproperty

apa itu html

apa itu html

Pengenalan kepada parameter indeks prestasi CPU

Pengenalan kepada parameter indeks prestasi CPU

Perisian penilaian pelayan

Perisian penilaian pelayan