ChatGPT dan Google Bard: Mana satu lebih baik dan mana satu lebih teruk?

Dua pesaing terbesar dalam industri AIGC: ChatGPT lwn Google Bard Artikel ini memperkenalkan perbezaan teknikal antara dua enjin kecerdasan buatan ini.

Penterjemah | Huraikan perbezaan teknikal antara kedua-dua enjin kecerdasan buatan ini.

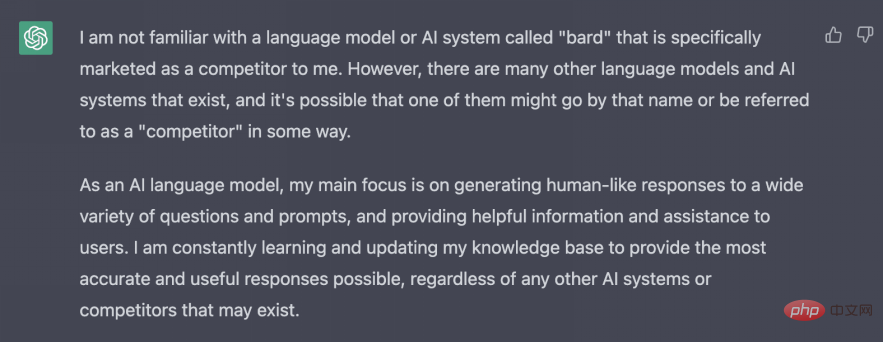

Perbezaan terbesar setakat ini antara Google Bard dan ChatGPT ialah: Bard tahu tentang ChatGPT, tetapi ChatGPT tidak tahu tentang Bard. Walaupun kita boleh bermain-main dengan ChatGPT, Bard masih tidak dapat dicapai oleh kebanyakan kita.

ChatGPT pada asalnya dibangunkan oleh OpenAI dan kemudian dibiayai oleh Microsoft untuk $10 bilion yang menarik perhatian (sebagai tambahan kepada pelaburan awal $1 bilion). Google, bagi pihaknya, agak panik bahawa monopoli carian mereka mungkin akan berakhir, jadi ia melancarkan Bard, tetapi versi ini masih mempunyai beberapa kelemahan. Semasa demonstrasi langsung pertamanya, Bard membuat beberapa kesilapan fakta yang memalukan Google.

ChatGPT pada asalnya dibangunkan oleh OpenAI dan kemudian dibiayai oleh Microsoft untuk $10 bilion yang menarik perhatian (sebagai tambahan kepada pelaburan awal $1 bilion). Google, bagi pihaknya, agak panik bahawa monopoli carian mereka mungkin akan berakhir, jadi ia melancarkan Bard, tetapi versi ini masih mempunyai beberapa kelemahan. Semasa demonstrasi langsung pertamanya, Bard membuat beberapa kesilapan fakta yang memalukan Google.

ChatGPT dan Google Bard adalah lebih kompleks daripada fungsi teks ramalan telefon pintar Jika anda ingin memahami perbezaan antara dua robot pintar ini, anda tidak boleh terlepas kandungan berikut.

Di sini kami akan menerangkan secara mendalam perbezaan teknikal antara dua enjin kecerdasan buatan.

ChatGPT dan Bard: Rahsia tersembunyi?

Kami boleh memahami dengan cepat perbezaan teknikal antara mereka melalui jadual berikut, yang melaluinya anda boleh melihat banyak butiran.

|

C |

B ard |

Model |

| LaMDA, model bahasa untuk aplikasi perbualan | Struktur rangkaian saraf |

|

Transformer |

||

Data latihan |

Teks rangkaian, terutamanya dataset , yang dipanggil "commoncrawl", akan tiba pada pertengahan 2021. |

1.56 juta perkataan data perbualan awam dan teks rangkaian |

Tujuan | Menjadi chatbot penjana teks pelbagai guna |

Khusus dalam membantu carian |

Parameter |

175 bilion parameter |

137 bilion parameter |

Pencipta |

OpenAI |

Google |

Kelebihan |

- Terbuka kepada semua orang - Lebih fleksibel dan mampu mengendalikan teks terbuka - Data latihan setakat 2021 |

- Data latihan setakat ini - Dilatih khusus untuk perbualan, jadi apabila anda bercakap dengannya, bunyinya lebih seperti manusia. |

Kelemahan |

- Dialognya tidak begitu meyakinkan. - Bukan itu Penalaan halus |

- Belum lagi - Mungkin tidak begitu sesuai untuk penciptaan teks umum |

Sekarang kita memahami perbezaan antara kedua-duanya melalui jadual di atas, mari kita lihat dengan lebih mendalam pada penunjuk lain.

Apakah itu ChatGPT?

ChatGPT tiba-tiba muncul di atas pentas pada 30 November 2022. Mulai 4 Disember 2022, perkhidmatan itu mempunyai lebih satu juta pengguna harian. Pada Januari 2023, jumlah ini meningkat kepada lebih 100 juta pengguna.

Sebab asas popularitinya secara tiba-tiba ialah ia memberikan anda jawapan yang boleh dipercayai kepada banyak topik dengan cara yang hampir seperti manusia, dan sesiapa sahaja yang mempunyai sambungan Internet boleh menggunakannya .

ChatGPT telah dicipta oleh OpenAI, sebuah makmal kecerdasan buatan yang terletak di San Francisco yang memfokuskan pada mencipta penyelesaian kecerdasan buatan yang mesra. Chatbot dibangunkan berdasarkan GPT-3.5, model bahasa besar yang boleh terus memberikan respons kepada peminta apabila diberikan teks.

ChatGPT menambah beberapa latihan tambahan atas dasar ini - jurulatih manusia menambah baik model melalui interaksi dengan model dan memberi model keupayaan untuk memberikan jawapan berkualiti tinggi melalui "ganjaran".

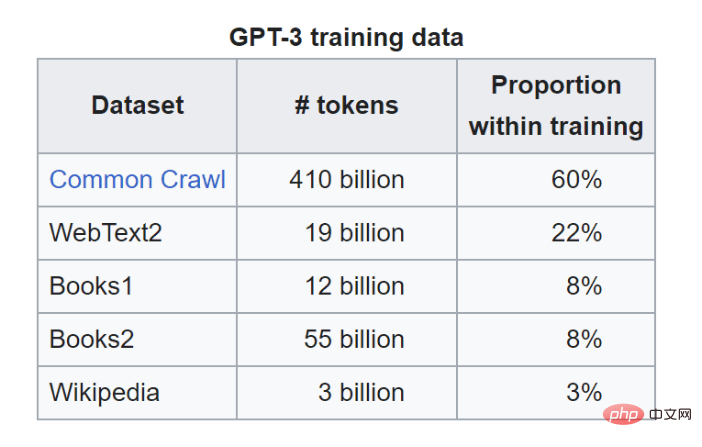

Data Latihan

GPT-3.5 dilatih pada set data teks web yang besar, termasuk set data popular yang dipanggil Common Crawl. Common Crawl mengandungi petabait data web, termasuk data halaman web mentah, pengekstrakan metadata dan pengekstrakan teks. Contohnya, ia termasuk koleksi URL daripada StrataScratch. Tidak gila untuk berfikir bahawa data latihan yang digunakan oleh ChatGPT datang daripada input netizen di ChatGPT?

Common Crawl bertanggungjawab untuk 60% daripada data latihan, tetapi GPT-3.5 juga mempunyai sumber data lain.

Apakah itu Google Bard?

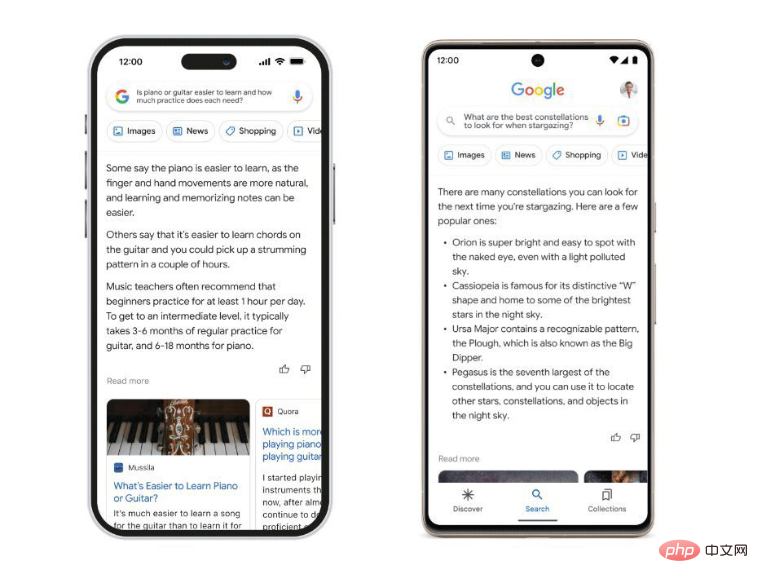

Google Bard ialah robot sembang pintar yang dilancarkan oleh Google apabila ChatGPT menjadi sangat popular. Tidak seperti ChatGPT, Bard dikuasakan oleh model Google sendiri, LaMDA. LaMDA ialah singkatan daripada Model Bahasa untuk Aplikasi Perbualan Tidak seperti ChatGPT, ia tidak begitu mengagumkan kerana kebanyakan orang belum mempunyai akses kepadanya. Walaupun Google mempunyai demo Bard yang janggal pada awal Februari, Bard pada masa ini hanya tersedia untuk beberapa orang terpilih.

Kelebihan utama Google Bard ialah ia terbuka kepada Internet. Tanya ChatGPT "Siapa presiden sekarang dan ia tidak tahu. Ini kerana data latihan telah dipotong sekitar pertengahan 2021. Bard, sebaliknya, menggunakan maklumat yang terdapat di Internet hari ini. Secara teorinya, Bard sepatutnya dapat menarik daripada data di Internet hari ini dan memberitahu anda siapa presiden sekarang.

Mudah untuk melihat cara Bard menonjol daripada ChatGPT dalam beberapa aspek utama.

Data latihan

Pertama sekali, LaMDA dilatih tentang perbualan, khusus untuk perbualan, dan bukannya hanya menghasilkan teks seperti model GPT-n . Walaupun ChatGPT tidak segan silu tentang data latihannya, kami tidak tahu banyak tentang data yang dilatih oleh Bard dan boleh membuat kesimpulan dengan melihat kertas penyelidikan LaMDA. Penyelidik Google mengatakan bahawa 12.5% daripada data latihan berasal daripada Common Crawl, seperti model GPT-n. 12.5% lagi datang dari Wikipedia. Menurut kertas penyelidikan itu, mereka menggunakan 1.56 trilion perkataan "data perbualan awam dan teks dalam talian."

Berikut ialah pecahan lengkap:

- 12.5% berdasarkan data C4 (turunan daripada data Common Crawl).

- 12.5% dari Wikipedia Bahasa Inggeris

- 12.5% daripada pengaturcaraan tapak web Soal Jawab, tutorial dan dokumen kod lain

- 6.25% daripada dokumen dalam talian Bahasa Inggeris

- 6.25% daripada dokumen dalam talian bukan bahasa Inggeris

- 50% data perbualan daripada forum awam

Daripada maklumat di atas, kita boleh mengetahui data yang digunakan oleh kedua-duanya, jelas ada Wikipedia. Selebihnya data telah disembunyikan dengan jelas dengan sengaja oleh Google, mungkin untuk melindungi Bard (dan LaMDA) daripada ditiru.

LaMDA telah dibentuk dengan memperhalusi model bahasa saraf Transformer, seni bina rangkaian saraf sumber terbuka yang asalnya dibangunkan oleh Google. (GPT juga berdasarkan Transformer).

ChatGPT mempunyai beberapa halangan untuk menghalangnya daripada menjengkelkan atau bercakap kosong, tetapi Google menekankan cara memastikan kualiti untuk menjadikan Bard robot sembang yang lebih baik dan selamat. Bard telah diperhalusi untuk menjadi "berkualiti tinggi, berasas dan selamat".

Google mempunyai banyak perkara untuk diperkatakan tentang perkara ini, saya syorkan membaca catatan blog mereka yang berkaitan, tetapi jika anda kekurangan masa, ia boleh dibahagikan kepada aspek berikut:

- Bard harus membalas dengan cara yang bermakna - tiada yang tidak masuk akal, tiada yang bercanggah

- Bard harus membalas dengan cara yang bernas, cerdik atau tidak dijangka.

- Bard harus mengelakkan apa-apa yang boleh menyebabkan kemudaratan kepada pengguna - darah, prejudis, stereotaip kebencian, dll.

- Bard tidak mengada-adakan

Ia tiada rahsia lagi bahawa Google masih belum memahami keperluan asas kerana pelancaran yang buruk. Tetapi perlu diperhatikan bahawa Google sangat jelas tentang keperluan reka bentuknya, manakala ChatGPT tidak begitu jelas - sekurang-kurangnya buat masa ini.

Perbandingan antara ChatGPT dan Google Bard: Mengapa parameter model penting?

ChatGPT mempunyai lebih banyak parameter model daripada Bard - 175 bilion berbanding 137 bilion. Anda boleh menganggap parameter sebagai tombol atau tuas yang model laraskan agar sesuai dengan data yang dilatihnya. Lebih banyak parameter biasanya bermakna model mempunyai lebih banyak keupayaan untuk menangkap perhubungan yang kompleks dalam bahasa, tetapi terdapat juga risiko pemasangan berlebihan. Google Bard mungkin kurang fleksibel daripada ChatGPT, tetapi ia juga mungkin lebih berkuasa kerana kes penggunaan bahasa baharu.

ChatGPT dan Google Bard: Apakah persamaan mereka?

Perlu ditekankan bahawa model Bard dan ChatGPT (LaMDA dan GPT-3.5 masing-masing) adalah berdasarkan rangkaian neural pembelajaran mendalam berasaskan Transformer.

Contohnya, Transformer boleh membolehkan model terlatih membaca ayat atau perenggan, perhatikan hubungan antara perkataan tersebut, dan kemudian meramalkan perkataan yang difikirkannya akan datang seterusnya - serupa dengan kecerdasan yang dinyatakan sebelum ini. teks ramalan pada telefon mudah alih.

Saya tidak akan pergi ke perbincangan itu di sini, tetapi apa yang anda perlu tahu ialah ini bermakna bahawa pada asasnya, Bard dan ChatGPT tidak begitu berbeza antara satu sama lain.

ChatGPT lwn. Google Bard: Pemilikan

Walaupun pemilikan bukanlah perbezaan teknikal, ia perlu diingati.

Google Bard dibuat dan dimiliki sepenuhnya oleh Google, selain daripada LaMDA, yang turut dicipta oleh Google.

ChatGPT dibangunkan oleh OpenAI, sebuah makmal penyelidikan kecerdasan buatan yang berpusat di San Francisco. OpenAI pada asalnya bukan untung, tetapi ia mencipta anak syarikat untung pada 2019. OpenAI juga berada di belakang Dall-E, generasi teks-ke-imej kecerdasan buatan yang mungkin anda pernah mainkan.

Walaupun Microsoft telah melabur banyak dalam OpenAI, buat masa ini, ia adalah organisasi penyelidikan bebas.

Mana satu lebih baik, ChatGPT atau Google Bard?

Sukar untuk memberikan jawapan yang adil kepada soalan ini kerana terdapat banyak persamaan antara kedua-duanya, tetapi terdapat juga perbezaan. Pertama, hampir tiada sesiapa yang mempunyai akses kepada Google Bard sekarang. Di samping itu, data latihan ChatGPT telah dipotong hampir dua tahun lalu.

Kedua-duanya ialah penjana teks - anda memberikan gesaan dan kedua-dua Google Bard dan ChatGPT boleh menjawabnya. Kedua-duanya mempunyai berbilion parameter untuk memperhalusi model. Kedua-duanya mempunyai sumber data latihan yang bertindih dan dibina pada Transformer, model rangkaian saraf yang sama.

Ia juga direka untuk tujuan yang berbeza, Bard akan membantu anda menyemak imbas carian Google dan ia direka untuk menjadi perbualan. ChatGPT boleh menjana keseluruhan catatan blog. Ia direka untuk mengeluarkan teks yang bermakna.

Walaupun kita bercakap tentang perbezaan antara ChatGPT dan Google Bard, ia hanya membuktikan sejauh mana teknologi penjanaan teks dipacu kecerdasan buatan telah datang. Walaupun kedua-duanya mempunyai cara untuk pergi, dan kedua-duanya menghadapi kontroversi hak cipta dan etika, kedua-dua penjana adalah bukti kukuh kepada pembangunan model AI moden.

Pengenalan Penterjemah

Cui Hao, editor komuniti 51CTO dan arkitek kanan, mempunyai 18 tahun pengalaman pembangunan perisian dan seni bina serta 10 tahun pengalaman seni bina yang diedarkan.

Tajuk asal: ChatGPT vs Google Bard: Perbandingan Perbezaan Teknikal, pengarang: Nate Rosidi

Atas ialah kandungan terperinci ChatGPT dan Google Bard: Mana satu lebih baik dan mana satu lebih teruk?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1379

1379

52

52

ChatGPT kini membenarkan pengguna percuma menjana imej dengan menggunakan DALL-E 3 dengan had harian

Aug 09, 2024 pm 09:37 PM

ChatGPT kini membenarkan pengguna percuma menjana imej dengan menggunakan DALL-E 3 dengan had harian

Aug 09, 2024 pm 09:37 PM

DALL-E 3 telah diperkenalkan secara rasmi pada September 2023 sebagai model yang jauh lebih baik daripada pendahulunya. Ia dianggap sebagai salah satu penjana imej AI terbaik setakat ini, mampu mencipta imej dengan perincian yang rumit. Walau bagaimanapun, semasa pelancaran, ia adalah tidak termasuk

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Laman web ini melaporkan pada 27 Jun bahawa Jianying ialah perisian penyuntingan video yang dibangunkan oleh FaceMeng Technology, anak syarikat ByteDance Ia bergantung pada platform Douyin dan pada asasnya menghasilkan kandungan video pendek untuk pengguna platform tersebut Windows , MacOS dan sistem pengendalian lain. Jianying secara rasmi mengumumkan peningkatan sistem keahliannya dan melancarkan SVIP baharu, yang merangkumi pelbagai teknologi hitam AI, seperti terjemahan pintar, penonjolan pintar, pembungkusan pintar, sintesis manusia digital, dsb. Dari segi harga, yuran bulanan untuk keratan SVIP ialah 79 yuan, yuran tahunan ialah 599 yuan (nota di laman web ini: bersamaan dengan 49.9 yuan sebulan), langganan bulanan berterusan ialah 59 yuan sebulan, dan langganan tahunan berterusan ialah 499 yuan setahun (bersamaan dengan 41.6 yuan sebulan) . Di samping itu, pegawai yang dipotong juga menyatakan bahawa untuk meningkatkan pengalaman pengguna, mereka yang telah melanggan VIP asal

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Tingkatkan produktiviti, kecekapan dan ketepatan pembangun dengan menggabungkan penjanaan dipertingkatkan semula dan memori semantik ke dalam pembantu pengekodan AI. Diterjemah daripada EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, pengarang JanakiramMSV. Walaupun pembantu pengaturcaraan AI asas secara semulajadi membantu, mereka sering gagal memberikan cadangan kod yang paling relevan dan betul kerana mereka bergantung pada pemahaman umum bahasa perisian dan corak penulisan perisian yang paling biasa. Kod yang dijana oleh pembantu pengekodan ini sesuai untuk menyelesaikan masalah yang mereka bertanggungjawab untuk menyelesaikannya, tetapi selalunya tidak mematuhi piawaian pengekodan, konvensyen dan gaya pasukan individu. Ini selalunya menghasilkan cadangan yang perlu diubah suai atau diperhalusi agar kod itu diterima ke dalam aplikasi

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Model Bahasa Besar (LLM) dilatih pada pangkalan data teks yang besar, di mana mereka memperoleh sejumlah besar pengetahuan dunia sebenar. Pengetahuan ini dibenamkan ke dalam parameter mereka dan kemudiannya boleh digunakan apabila diperlukan. Pengetahuan tentang model ini "diperbaharui" pada akhir latihan. Pada akhir pra-latihan, model sebenarnya berhenti belajar. Selaraskan atau perhalusi model untuk mempelajari cara memanfaatkan pengetahuan ini dan bertindak balas dengan lebih semula jadi kepada soalan pengguna. Tetapi kadangkala pengetahuan model tidak mencukupi, dan walaupun model boleh mengakses kandungan luaran melalui RAG, ia dianggap berfaedah untuk menyesuaikan model kepada domain baharu melalui penalaan halus. Penalaan halus ini dilakukan menggunakan input daripada anotasi manusia atau ciptaan LLM lain, di mana model menemui pengetahuan dunia sebenar tambahan dan menyepadukannya

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Editor |ScienceAI Question Answering (QA) set data memainkan peranan penting dalam mempromosikan penyelidikan pemprosesan bahasa semula jadi (NLP). Set data QA berkualiti tinggi bukan sahaja boleh digunakan untuk memperhalusi model, tetapi juga menilai dengan berkesan keupayaan model bahasa besar (LLM), terutamanya keupayaan untuk memahami dan menaakul tentang pengetahuan saintifik. Walaupun pada masa ini terdapat banyak set data QA saintifik yang meliputi bidang perubatan, kimia, biologi dan bidang lain, set data ini masih mempunyai beberapa kekurangan. Pertama, borang data adalah agak mudah, kebanyakannya adalah soalan aneka pilihan. Ia mudah dinilai, tetapi mengehadkan julat pemilihan jawapan model dan tidak dapat menguji sepenuhnya keupayaan model untuk menjawab soalan saintifik. Sebaliknya, Soal Jawab terbuka

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Editor |. KX Dalam bidang penyelidikan dan pembangunan ubat, meramalkan pertalian pengikatan protein dan ligan dengan tepat dan berkesan adalah penting untuk pemeriksaan dan pengoptimuman ubat. Walau bagaimanapun, kajian semasa tidak mengambil kira peranan penting maklumat permukaan molekul dalam interaksi protein-ligan. Berdasarkan ini, penyelidik dari Universiti Xiamen mencadangkan rangka kerja pengekstrakan ciri berbilang mod (MFE) novel, yang buat pertama kalinya menggabungkan maklumat mengenai permukaan protein, struktur dan jujukan 3D, dan menggunakan mekanisme perhatian silang untuk membandingkan ciri modaliti yang berbeza penjajaran. Keputusan eksperimen menunjukkan bahawa kaedah ini mencapai prestasi terkini dalam meramalkan pertalian mengikat protein-ligan. Tambahan pula, kajian ablasi menunjukkan keberkesanan dan keperluan maklumat permukaan protein dan penjajaran ciri multimodal dalam rangka kerja ini. Penyelidikan berkaitan bermula dengan "S

SK Hynix akan memaparkan produk berkaitan AI baharu pada 6 Ogos: HBM3E 12 lapisan, NAND 321 tinggi, dsb.

Aug 01, 2024 pm 09:40 PM

SK Hynix akan memaparkan produk berkaitan AI baharu pada 6 Ogos: HBM3E 12 lapisan, NAND 321 tinggi, dsb.

Aug 01, 2024 pm 09:40 PM

Menurut berita dari laman web ini pada 1 Ogos, SK Hynix mengeluarkan catatan blog hari ini (1 Ogos), mengumumkan bahawa ia akan menghadiri Global Semiconductor Memory Summit FMS2024 yang akan diadakan di Santa Clara, California, Amerika Syarikat dari 6 hingga 8 Ogos, mempamerkan banyak produk penjanaan teknologi baru. Pengenalan kepada Sidang Kemuncak Memori dan Penyimpanan Masa Depan (FutureMemoryandStorage), dahulunya Sidang Kemuncak Memori Flash (FlashMemorySummit) terutamanya untuk pembekal NAND, dalam konteks peningkatan perhatian kepada teknologi kecerdasan buatan, tahun ini dinamakan semula sebagai Sidang Kemuncak Memori dan Penyimpanan Masa Depan (FutureMemoryandStorage) kepada jemput vendor DRAM dan storan serta ramai lagi pemain. Produk baharu SK hynix dilancarkan tahun lepas

Meletakkan pasaran seperti AI, GlobalFoundries memperoleh teknologi gallium nitrida Tagore Technology dan pasukan berkaitan

Jul 15, 2024 pm 12:21 PM

Meletakkan pasaran seperti AI, GlobalFoundries memperoleh teknologi gallium nitrida Tagore Technology dan pasukan berkaitan

Jul 15, 2024 pm 12:21 PM

Menurut berita dari laman web ini pada 5 Julai, GlobalFoundries mengeluarkan kenyataan akhbar pada 1 Julai tahun ini, mengumumkan pemerolehan teknologi power gallium nitride (GaN) Tagore Technology dan portfolio harta intelek, dengan harapan dapat mengembangkan bahagian pasarannya dalam kereta dan Internet of Things dan kawasan aplikasi pusat data kecerdasan buatan untuk meneroka kecekapan yang lebih tinggi dan prestasi yang lebih baik. Memandangkan teknologi seperti AI generatif terus berkembang dalam dunia digital, galium nitrida (GaN) telah menjadi penyelesaian utama untuk pengurusan kuasa yang mampan dan cekap, terutamanya dalam pusat data. Laman web ini memetik pengumuman rasmi bahawa semasa pengambilalihan ini, pasukan kejuruteraan Tagore Technology akan menyertai GLOBALFOUNDRIES untuk membangunkan lagi teknologi gallium nitride. G