Bagaimanakah kecerdasan yang tidak dapat dijelaskan berkembang pada masa hadapan?

Sejak 2023, ChatGPT dan GPT-4 sentiasa berada dalam senarai carian hangat Di satu pihak, orang awam terpegun melihat bagaimana AI tiba-tiba begitu berkuasa dan sama ada ia akan merevolusikan kehidupan "pekerja"; Di satu pihak, orang dalam pun tidak faham mengapa kecerdasan menakjubkan tiba-tiba "muncul" selepas skala model menembusi had tertentu.

Kemunculan kecerdasan adalah perkara yang baik, tetapi tingkah laku model yang tidak terkawal, tidak dapat diramalkan dan tidak dapat dijelaskan telah menjerumuskan seluruh komuniti akademik ke dalam kekeliruan dan pemikiran yang mendalam.

Soalan mudah dahulu, apakah filem yang diwakili oleh emoj berikut?

Model bahasa yang paling mudah selalunya boleh terus menulis "Filem adalah filem tentang seorang lelaki yang lelaki yang lelaki"; jawapan model kerumitan sederhana adalah lebih dekat, dan jawapan yang diberikan Ia "The Emoji Movie"; tetapi model bahasa yang paling kompleks hanya akan memberikan satu jawapan: Finding Nemo "Finding Nemo"

Malah, gesaan ini juga 204 item yang direka untuk menguji keupayaan pelbagai bahasa berskala besar model Salah satu tugas.

Ethan Dyer, seorang saintis komputer di Google Research, mengambil bahagian dalam menganjurkan ujian ini. Dia berkata walaupun saya bersedia untuk kejutan apabila membina set data BIG-Bench, apabila saya benar-benar menyaksikan apa yang boleh dilakukan oleh model ini. masih sangat terkejut.

Perkara yang mengejutkan ialah model ini hanya memerlukan gesaan: iaitu, mereka menerima rentetan teks sebagai input dan meramalkan berulang kali perkara yang akan datang semata-mata berdasarkan kandungan statistik.

Saintis komputer telah menjangkakan bahawa penskalaan akan meningkatkan prestasi pada tugas yang diketahui, tetapi mereka tidak menjangka bahawa model tiba-tiba akan dapat mengendalikan begitu banyak tugas baharu yang tidak dapat diramalkan.

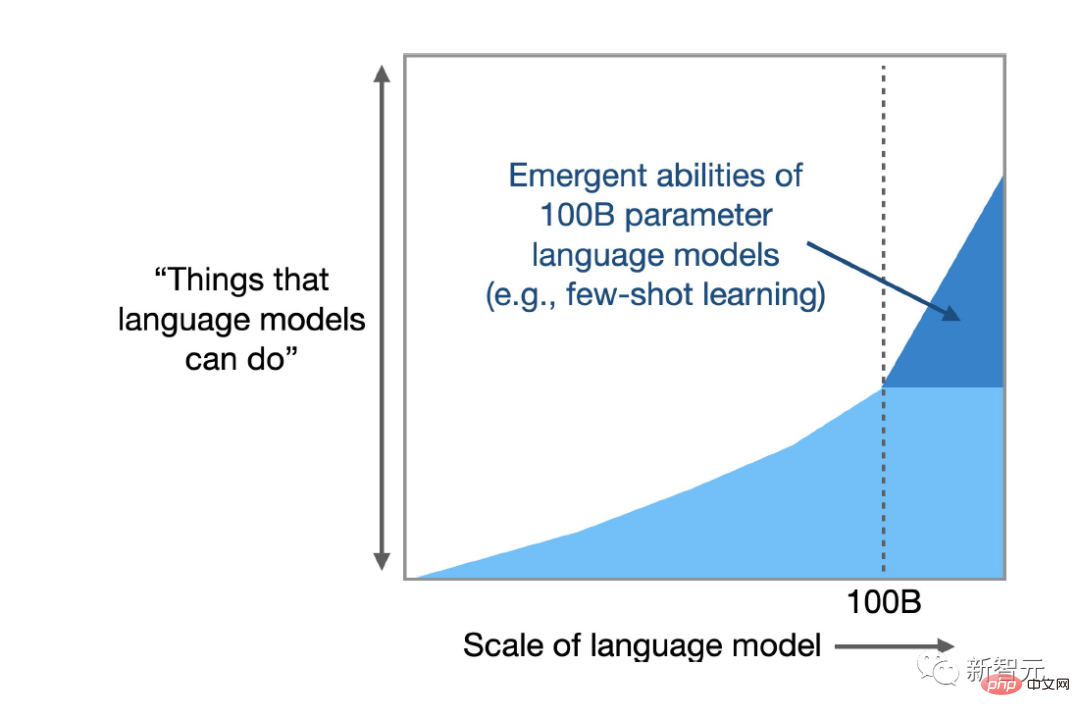

Hasil tinjauan baru-baru ini yang Dyer sertai menunjukkan bahawa LLM boleh menghasilkan beratus-ratus keupayaan "muncul", iaitu tugasan yang boleh disiapkan oleh model besar tetapi tidak dapat diselesaikan oleh model kecil berkaitan dengan menganalisis teks. Tidak berkaitan, seperti daripada pengiraan pendaraban hingga menjana kod komputer boleh laku, termasuk penyahkodan filem berdasarkan simbol Emoji, dsb.

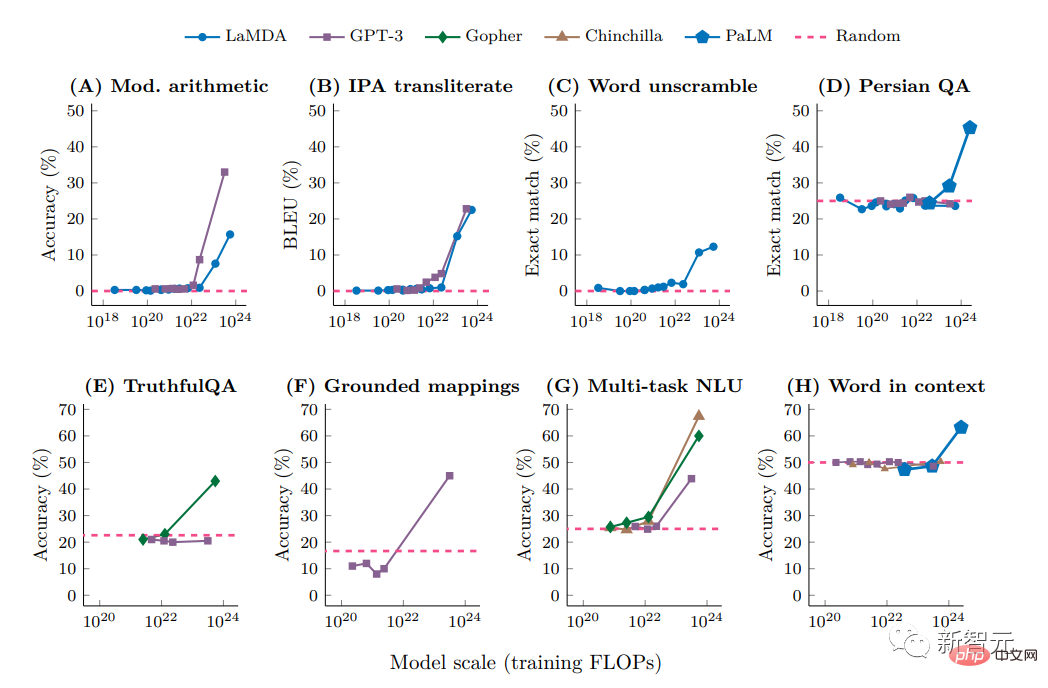

Analisis baharu menunjukkan bahawa untuk tugasan tertentu dan model tertentu, terdapat ambang kerumitan yang melepasi fungsi model bertambah baik dengan pesat.

Para penyelidik juga mencadangkan satu lagi kesan sampingan negatif daripada keupayaan yang muncul: Apabila kerumitan meningkat, sesetengah model memaparkan berat sebelah dan ketidaktepatan baharu dalam respons mereka.

Rishi Bommasani, seorang saintis komputer di Universiti Stanford, berkata bahawa tiada perbincangan dalam mana-mana literatur yang saya sedar bahawa model bahasa boleh melakukan perkara ini.

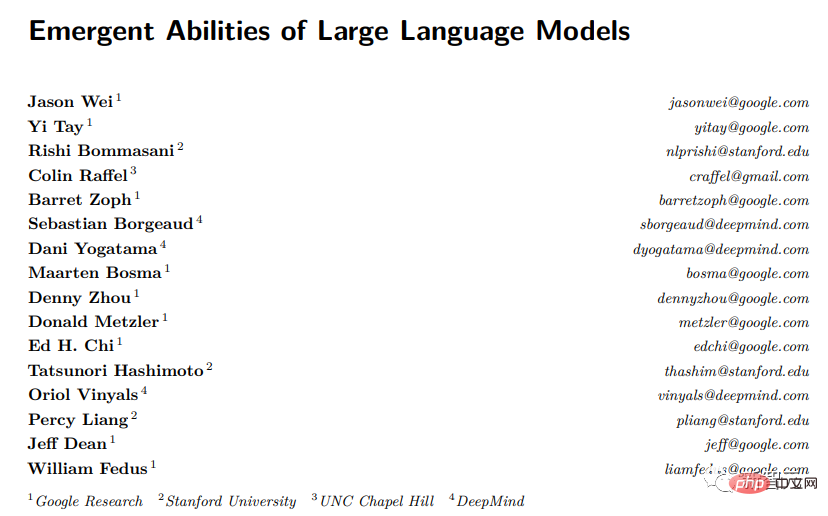

Tahun lepas, Bommasani membantu menyusun senarai berdozen gelagat yang muncul, termasuk beberapa yang ditemui dalam projek Dyer, dan senarai itu terus berkembang.

Pautan kertas: https://openreview.net/pdf?id=yzkSU5zdwD

Pada masa ini penyelidik bukan sahaja berlumba-lumba untuk menemui lebih banyak keupayaan yang muncul, Dan juga cuba memikirkan mengapa dan bagaimana ia berlaku, pada asasnya cuba meramalkan ketidakpastian.

Memahami kemunculan boleh mendedahkan jawapan kepada soalan mendalam mengenai kecerdasan buatan dan pembelajaran mesin secara umum, seperti sama ada model yang kompleks sebenarnya melakukan sesuatu yang baharu, atau semakin mahir dalam statistik, serta Bantu penyelidik mengeksploitasi potensi kelebihan dan mengurangkan risiko yang muncul.

Deep Ganguli, seorang saintis komputer di syarikat permulaan kecerdasan buatan Anthroic, berkata bahawa kami tidak tahu cara menilai keupayaan berbahaya aplikasi yang akan muncul, sama ada ia normal atau tidak dapat diramalkan.

Ahli biologi, ahli fizik, ahli ekologi, dan saintis lain menggunakan perkataan "kemunculan" untuk menggambarkan apabila sekumpulan besar benda bertindak sebagai satu keseluruhan kelakuan kolektif yang mengatur diri sendiri yang muncul dari semasa ke semasa.

Contohnya, atom-atom tidak bernyawa bergabung untuk mencipta sel-sel hidup; menghasilkan gelombang;

Yang penting, keupayaan yang muncul terdapat dalam sistem yang melibatkan sejumlah besar bahagian bebas, tetapi penyelidik baru-baru ini dapat menemui keupayaan ini dalam LLM, mungkin kerana model telah berkembang ke skala yang cukup besar.

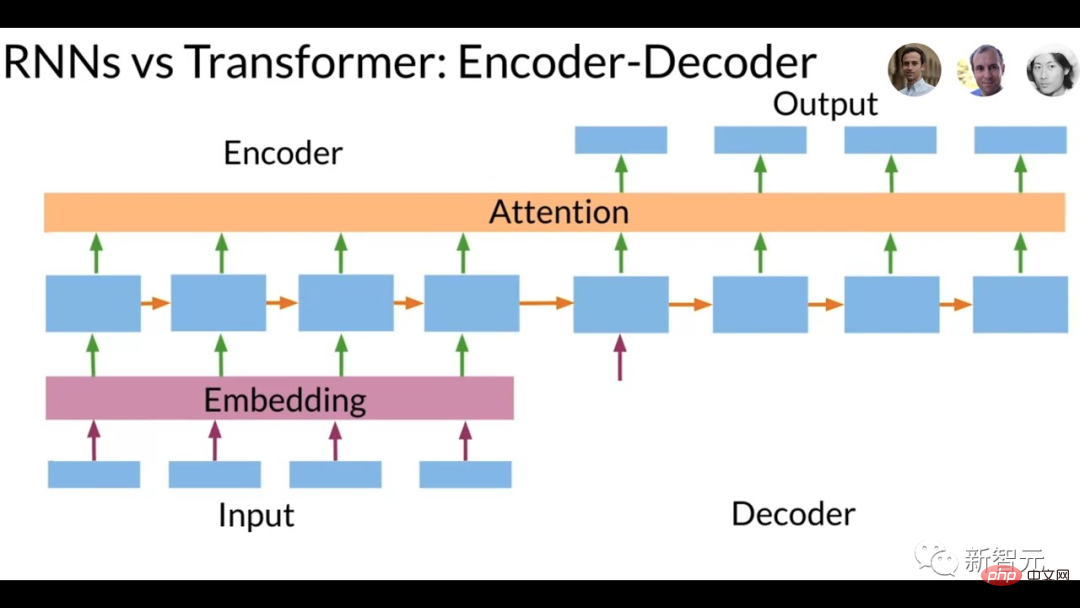

Model bahasa telah wujud selama beberapa dekad, tetapi sehingga lima tahun yang lalu, senjata paling berkuasa adalah berdasarkan rangkaian saraf berulang (RNN) Kaedah latihan adalah untuk memasukkan rentetan teks dan meramalkan perkataan seterusnya; sebab mengapa ia dipanggil berulang (recurrent), kerana model belajar daripada outputnya sendiri, iaitu, ramalan model disalurkan semula kepada rangkaian untuk meningkatkan prestasi.

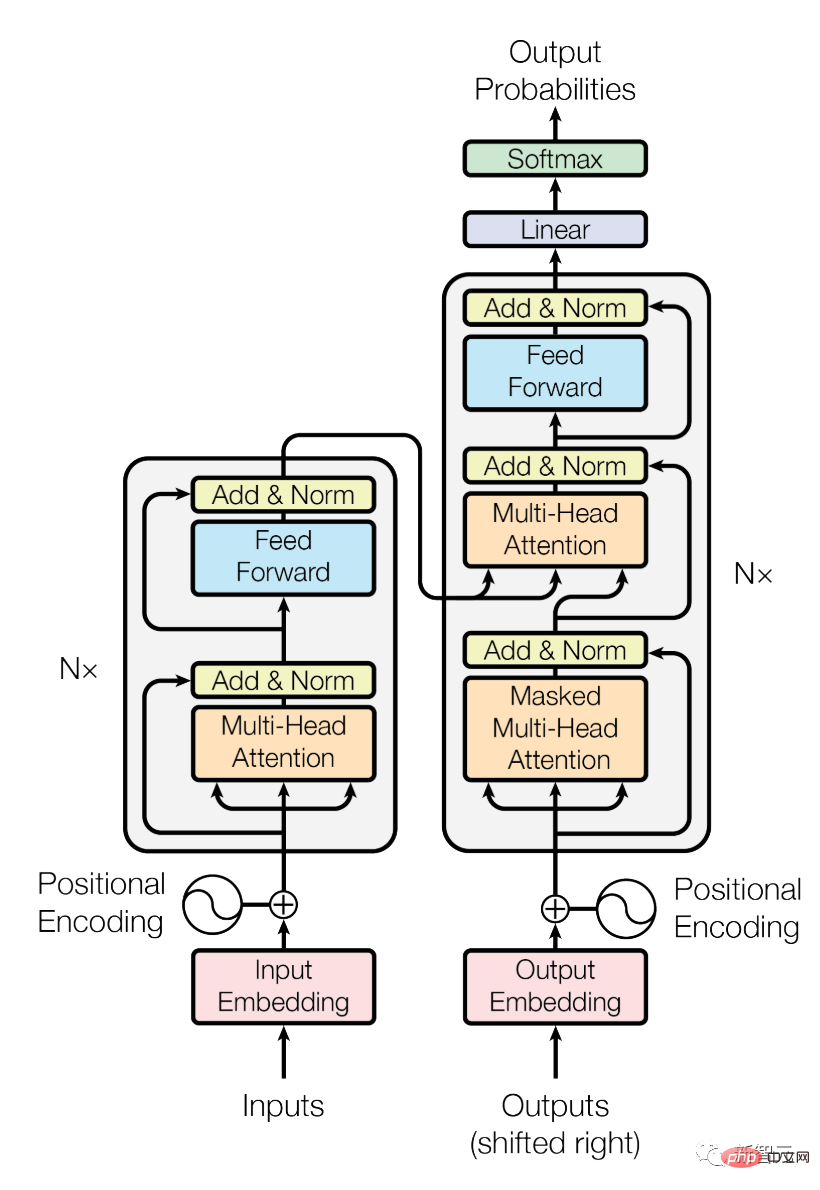

Pada tahun 2017, penyelidik di Google Brain memperkenalkan seni bina baharu yang dipanggil Transformer Berbanding dengan rangkaian berulang yang menganalisis perkataan ayat demi perkataan, Transformer boleh memproses semua perkataan pada masa yang sama, yang bermaksud Transformer boleh disejajarkan. Memproses sejumlah besar teks.

Transformer membolehkan kerumitan model bahasa dipertingkatkan dengan cepat dengan meningkatkan bilangan parameter dalam model, di mana parameter boleh dianggap sebagai sambungan antara perkataan dan faktor lain . Perbaik ramalan dengan melaraskan berat sambungan ini semasa latihan.

Lebih banyak parameter dalam model, lebih kuat keupayaan untuk mewujudkan sambungan dan lebih kuat keupayaan untuk mensimulasikan bahasa manusia.

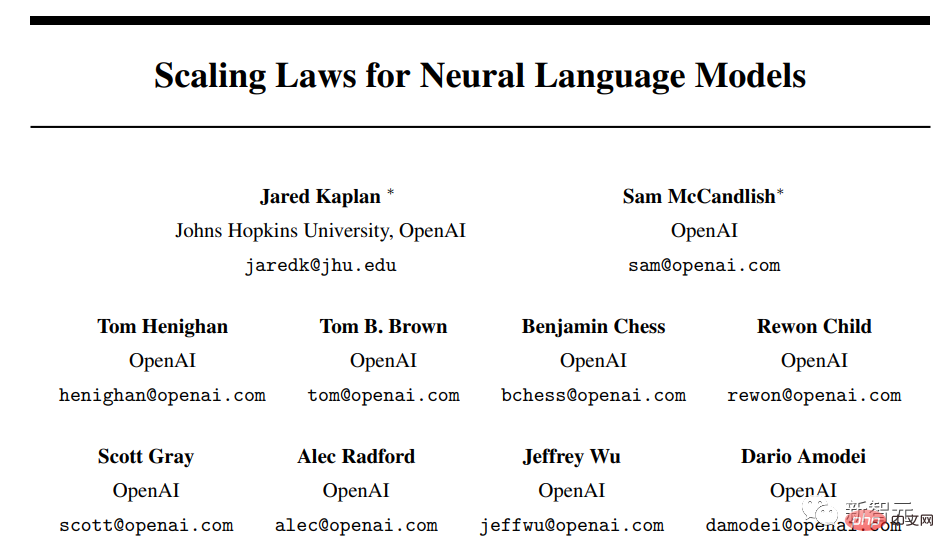

Seperti yang dijangkakan, analisis 2020 oleh penyelidik OpenAI mendapati bahawa apabila model bertambah dalam saiz, ketepatan dan keupayaannya bertambah baik.

Pautan kertas: https://arxiv.org/pdf/2001.08361.pdf

Dengan GPT-3 (dengan 175 bilion parameter) dan Google With keluaran model seperti PaLM (boleh berskala kepada 540 bilion parameter), pengguna sedang menemui lebih banyak keupayaan yang muncul.

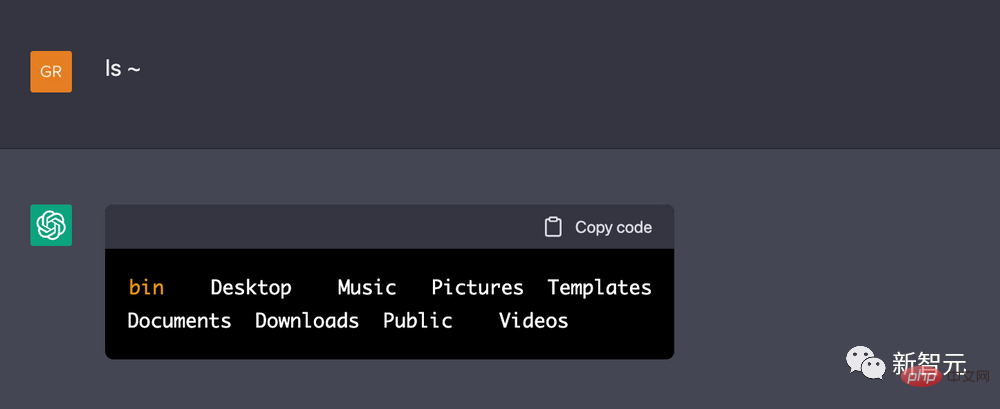

Seorang jurutera DeepMind malah melaporkan bahawa dia boleh membuat ChatGPT menganggap ia adalah terminal Linux dan menjalankan beberapa kod matematik mudah untuk mengira 10 nombor perdana pertama. Perlu diingat bahawa ChatGPT boleh menyelesaikan tugas dengan lebih cepat daripada menjalankan kod yang sama pada kotak Linux sebenar.

Seperti tugasan simbol Emoji filem, penyelidik tidak mempunyai sebab untuk berfikir bahawa model bahasa untuk meramalkan teks boleh meniru terminal komputer, dan banyak tingkah laku yang muncul mempamerkan Sifar model bahasa. -shot atau few-shot learning ability iaitu keupayaan LLM menyelesaikan masalah yang belum pernah dilihat atau jarang dilihat sebelum ini.

Setelah menemui tanda bahawa LLM boleh mengatasi kekangan data latihan, sekumpulan penyelidik berusaha untuk memahami dengan lebih baik rupa kemunculan dan cara ia berlaku, dan langkah pertama ialah mendokumentasikannya sepenuhnya.

Pada tahun 2020, Dyer dan yang lain di Google Research meramalkan bahawa LLM akan mempunyai kesan transformatif, tetapi sebenarnya apakah kesan tersebut masih menjadi persoalan terbuka.

Oleh itu, mereka meminta pelbagai pasukan penyelidik untuk memberikan contoh tugas yang sukar dan pelbagai untuk mencari sempadan keupayaan model bahasa Kerja ini juga dipanggil "BIG-bench, Beyond the Imitation Game" (BIG-bench,. Di sebalik projek Penanda Aras Permainan Tiruan, dinamakan sempena "permainan tiruan" yang dicadangkan oleh Alan Turing, menguji sama ada komputer boleh menjawab soalan dengan cara yang meyakinkan dan berperikemanusiaan, juga dikenali sebagai ujian Turing.

Seperti yang dijangkakan, pada beberapa tugasan, prestasi model bertambah baik dengan lancar dan boleh diramalkan apabila kerumitan meningkat , pengembangan bilangan parameter tidak menghasilkan sebarang peningkatan.

Walau bagaimanapun, dalam kira-kira 5% daripada tugasan, penyelidik menemui apa yang dipanggil "kejayaan", iaitu, lompatan pantas dan dramatik dalam prestasi dalam julat ambang tertentu, yang berbeza-beza mengikut tugasan dan Berbeza daripada model untuk membuat model.

Sebagai contoh, model dengan parameter yang agak sedikit (hanya beberapa juta) tidak dapat menyelesaikan masalah penambahan tiga digit atau dua digit dengan jayanya, tetapi untuk berpuluh bilion parameter, ketepatan sesetengah model akan Diperbaiki dengan ketara.

Tugas lain menyaksikan lompatan yang serupa, termasuk menyahkod Abjad Fonetik Antarabangsa, mentafsir huruf sesuatu perkataan, mengenal pasti kandungan yang menyinggung perasaan dalam petikan Hinglish (gabungan bahasa Hindi dan Inggeris), dan menjana perkataan yang serupa dengan bahasa Inggeris Swahili yang setara dengan pepatah Heli.

Tetapi penyelidik segera menyedari bahawa kerumitan model bukan satu-satunya pemacu Jika kualiti data cukup tinggi, beberapa keupayaan yang tidak dijangka boleh diperoleh daripada model yang lebih kecil dengan parameter yang lebih sedikit, atau dalam model yang lebih besar set, selain itu, kata-kata pertanyaan juga akan mempengaruhi ketepatan respons model.

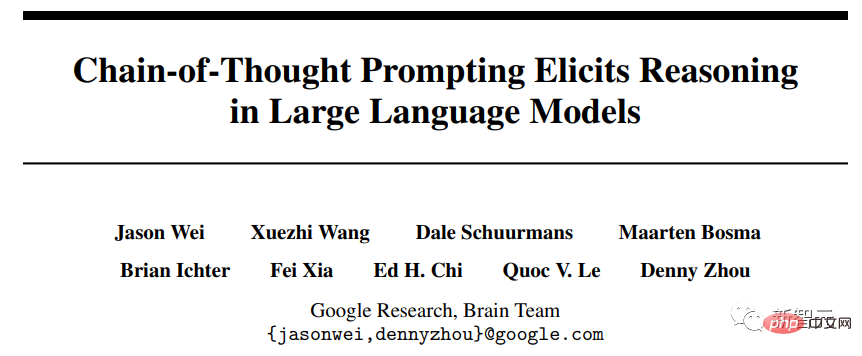

Tahun lepas, dalam kertas kerja yang dibentangkan di NeurIPS, persidangan utama bidang itu, penyelidik di Google Brain menunjukkan cara membenarkan model menerangkan diri mereka menggunakan pembayang (penaakulan rantai pemikiran), seperti cara menyelesaikan masalah perkataan matematik dengan betul, yang model yang sama tidak dapat menyelesaikan dengan betul tanpa petunjuk.

Pautan kertas: https://neurips.cc/Conferences/2022/ScheduleMultitrack?event=54087

Yi Tay, seorang saintis di Google Brain, komited untuk penyelidikan sistematik tentang penemuan, Beliau menegaskan bahawa penyelidikan baru-baru ini menunjukkan bahawa gesaan rantaian pemikiran mengubah lengkung skala model dan juga mengubah titik kemunculan Penggunaan gesaan rantaian pemikiran boleh mendorong tingkah laku yang tidak ditemui dalam eksperimen BIG .

Ellie Pavlick, seorang saintis komputer di Universiti Brown yang mengkaji model pengiraan bahasa, percaya bahawa penemuan terbaru ini menimbulkan sekurang-kurangnya dua kemungkinan:

Yang pertama adalah, seperti yang ditunjukkan oleh perbandingan dengan sistem biologi, model yang lebih besar secara spontan memperoleh kebolehan baharu, kemungkinan besar kerana model itu pada asasnya mempelajari sesuatu yang baru dan berbeza yang tidak mungkin pada saiz kecil Apa yang tiada dalam model, dan inilah yang kita mahu menjadi kes, ialah terdapat beberapa anjakan asas yang berlaku apabila model meningkat.

Kemungkinan lain yang kurang sensasi ialah apa yang kelihatan sebagai peristiwa terobosan mungkin merupakan proses dalaman yang didorong oleh statistik yang beroperasi melalui penaakulan rantaian pemikiran dan LLM yang besar mungkin hanya mempelajari heuristik Bagi parameter dengan parameter yang lebih sedikit atau kualiti data yang lebih rendah, algoritma heuristik tidak dapat dilaksanakan.

Tetapi dia percaya bahawa mencari tahu yang mana antara penjelasan ini lebih berkemungkinan bergantung pada kebolehan memahami cara LLM beroperasi, dan kerana kami tidak tahu cara ia berfungsi di bawah hud, kami tidak boleh bercakap banyak tentang tekaan ini Manakah antara mereka yang lebih munasabah.

Google mengeluarkan produk seperti ChatGPT Bard pada bulan Februari, tetapi ralat fakta telah didedahkan dalam demonstrasi, yang turut membawa pendedahan Walaupun semakin ramai penyelidik mula untuk bergantung pada model bahasa ini untuk melakukan kerja asas, mereka tidak boleh mempercayai hasil keluaran model ini dan memerlukan orang ramai menyemak kerja mereka dengan lebih lanjut.

Kecemasan membawa kepada ketidakpastian, dan ketidakpastian meningkat mengikut skala, menyukarkan penyelidik untuk meramalkan akibat penggunaan yang meluas.

Jika anda ingin mengkaji fenomena kemunculan, anda mesti terlebih dahulu mempunyai kes dalam fikiran anda Sebelum mengkaji kesan skala, anda tidak boleh mengetahui keupayaan atau batasan yang mungkin timbul.

Sesetengah tingkah laku berbahaya juga akan muncul dalam beberapa model Analisis terbaru LLM menunjukkan bahawa kemunculan berat sebelah sosial selalunya disertai dengan sejumlah besar parameter, yang bermaksud model besar akan menjadi lebih berat sebelah , kegagalan untuk menangani risiko ini boleh menjejaskan subjek penyelidikan model ini.

Atas ialah kandungan terperinci GPT-4 terlalu kuat, malah OpenAI tidak memahaminya! Bagaimanakah kecerdasan tiba-tiba 'muncul'?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!