Untuk mengetahui tentang reka bentuk, kekangan dan evolusi di sebalik model bahasa berskala besar kontemporari, anda boleh mengikuti senarai bacaan artikel ini.

Model bahasa berskala besar telah menarik perhatian orang ramai, dan dalam tempoh lima tahun sahaja, model seperti Transforme telah hampir mengubah sepenuhnya bidang pemprosesan bahasa semula jadi. Selain itu, mereka mula merevolusikan bidang seperti penglihatan komputer dan biologi pengiraan.

Memandangkan Transformers mempunyai kesan yang begitu besar pada proses penyelidikan semua orang, artikel ini akan memperkenalkan senarai bacaan ringkas untuk penyelidik dan pengamal pembelajaran mesin untuk bermula.

Senarai berikut dikembangkan terutamanya dalam susunan kronologi, terutamanya beberapa kertas penyelidikan akademik. Sudah tentu, terdapat banyak sumber lain yang berguna. Contohnya:

Jika anda baru menggunakan Transformers dan model bahasa besar , maka artikel ini adalah yang terbaik untuk anda.

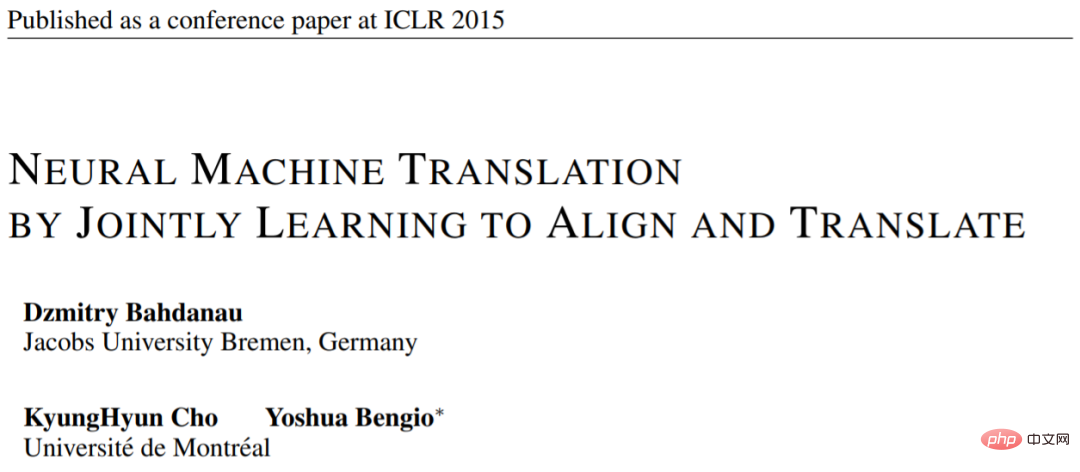

Kertas 1: "Terjemahan Mesin Neural dengan Belajar Bersama Menjajarkan dan Terjemah"

Alamat kertas: https:// arxiv.org/pdf/1409.0473.pdf

Artikel ini memperkenalkan mekanisme perhatian rangkaian saraf berulang (RNN) untuk meningkatkan keupayaan pemodelan jujukan jarak jauh model. Ini membolehkan RNN menterjemah ayat yang lebih panjang dengan lebih tepat - motivasi di sebalik pembangunan seni bina Transformer yang asal.

Sumber imej: https://arxiv.org/abs/1409.0473

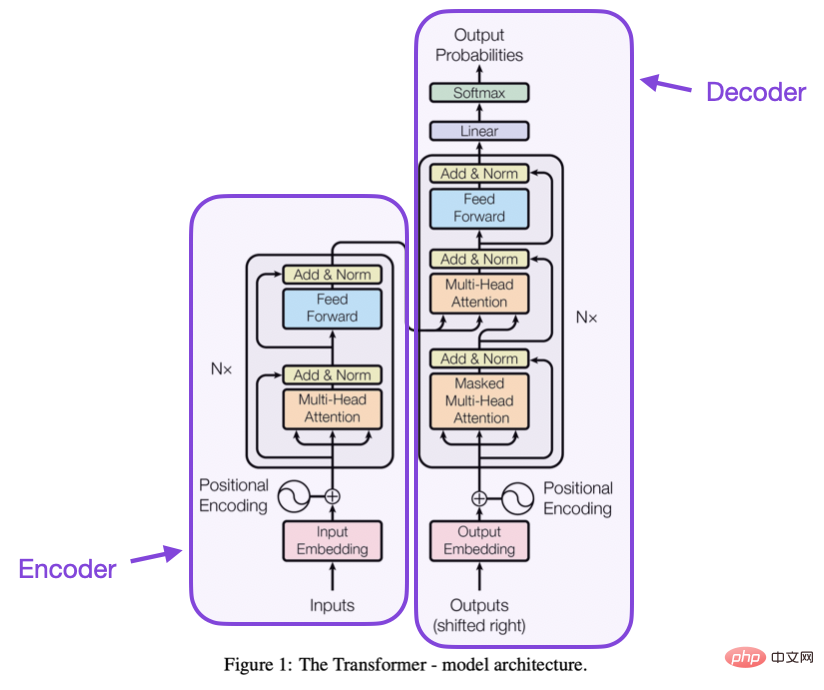

Kertas 2: "Perhatian Adalah Semua yang Anda Perlukan " 》

Alamat kertas: https://arxiv.org/abs/1706.03762

Artikel ini memperkenalkan komposisi pengekod dan penyahkod Seni bina Transformer asal, bahagian ini akan diperkenalkan sebagai modul berasingan kemudian. Selain itu, artikel ini memperkenalkan konsep seperti mekanisme perhatian produk titik skala, blok perhatian berbilang kepala dan pengekodan input kedudukan, yang kekal sebagai asas Transformers moden.

Sumber imej: https://arxiv.org/abs/1706.03762

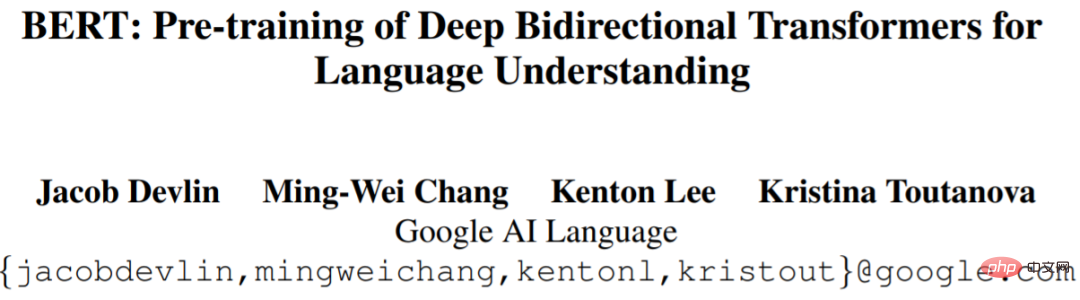

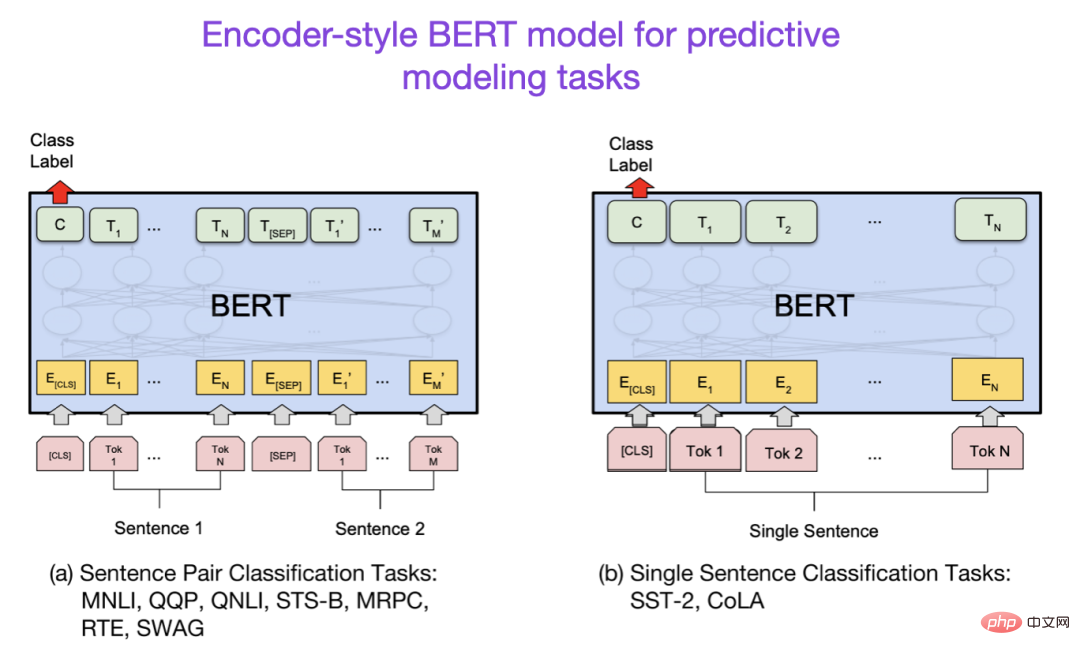

Kertas 3: "BERT: Pra-latihan Transformer Dwi Arah Dalam untuk Pemahaman Bahasa》

Alamat kertas: https://arxiv.org/abs/1810.04805

Penyelidikan model bahasa berskala besar mengikuti seni bina Transformer awal dan kemudian mula meluas dalam dua arah: Transformer untuk tugas pemodelan ramalan (seperti klasifikasi teks) dan Transformer untuk tugas pemodelan generatif (seperti terjemahan, ringkasan dan bentuk penciptaan teks yang lain. ) Transformer.

Kertas BERT memperkenalkan konsep asal pemodelan bahasa bertopeng Jika anda berminat dengan cabang penyelidikan ini, anda boleh membuat susulan dengan RoBERTa, yang memudahkan matlamat pra-latihan.

Sumber imej: https://arxiv.org/abs/1810.04805

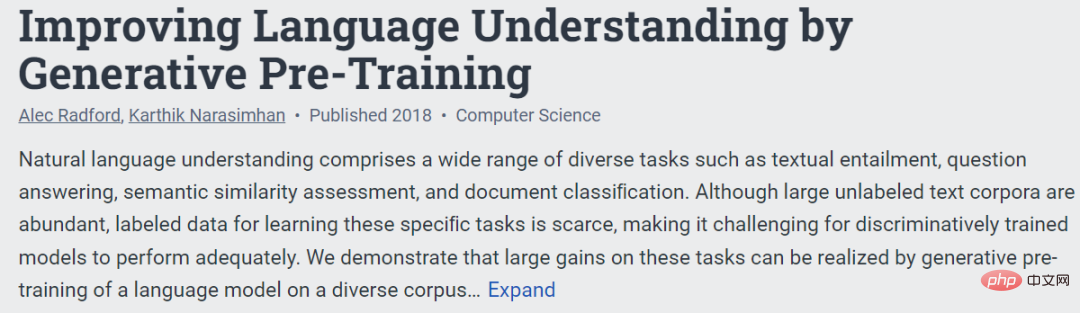

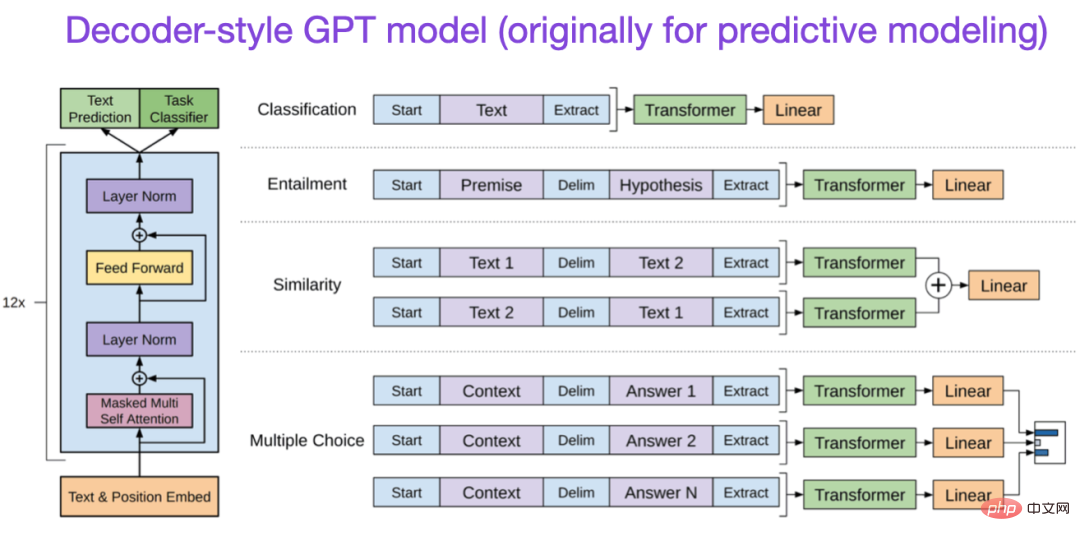

Kertas 4: "Memperbaiki Bahasa Pemahaman oleh Pra-Latihan Generatif》

Alamat kertas: https://www.semanticscholar.org/paper/Improving-Language-Understanding-by-Generative- Radford-Narasimhan/cd18800a0fe0b668a1cc19f2ec95b5003d0a5035

Kertas GPT asal memperkenalkan seni bina gaya penyahkod popular dan pra-latihan dengan ramalan perkataan seterusnya. BERT boleh dianggap sebagai Transformer dua hala kerana matlamat pra-latihan model bahasa bertopengnya, manakala GPT ialah model autoregresif sehala. Walaupun pembenaman GPT juga boleh digunakan untuk pengelasan, kaedah GPT adalah teras kepada LLM yang paling berpengaruh hari ini seperti ChatGPT.

Jika anda berminat dengan cawangan penyelidikan ini, anda boleh membuat susulan pada kertas GPT-2 dan GPT-3. Di samping itu, artikel ini akan memperkenalkan kaedah InstructGPT secara berasingan kemudian.

Kertas 5: "BART: Latihan Pra-Latihan Urutan-ke-Urutan Denoising untuk Penjanaan, Terjemahan dan Pemahaman Bahasa Semulajadi"

Alamat kertas https://arxiv.org/abs/1910.13461.

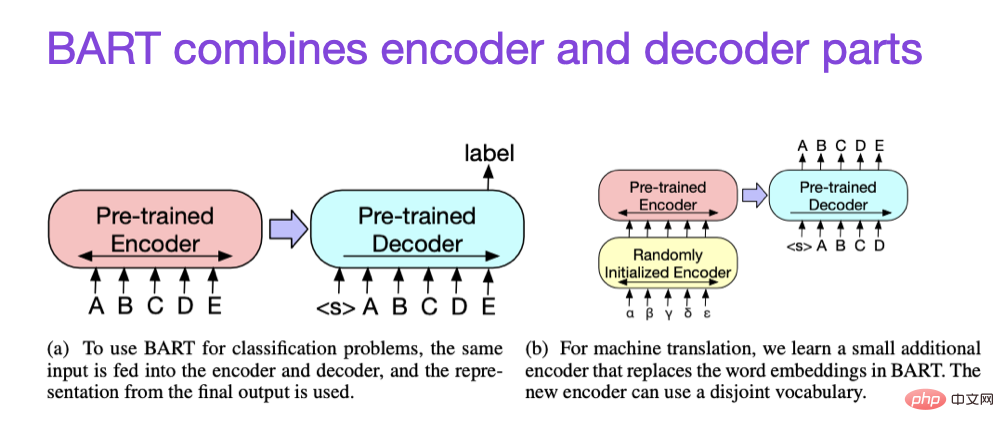

Seperti yang dinyatakan di atas, LLM gaya pengekod jenis BERT biasanya merupakan pilihan pertama untuk tugas pemodelan ramalan, manakala GPT LLM gaya penyahkod lebih baik dalam menjana teks. Untuk mendapatkan yang terbaik dari kedua-dua dunia, kertas BART di atas menggabungkan bahagian pengekod dan penyahkod.

Jika anda ingin mengetahui lebih lanjut tentang teknik untuk meningkatkan kecekapan Transformer, anda boleh merujuk kertas berikut

Selain itu, terdapat kertas kerja "Training Compute-Optimal Large Language Models"

Alamat kertas: https:// arxiv.org/abs /2203.15556

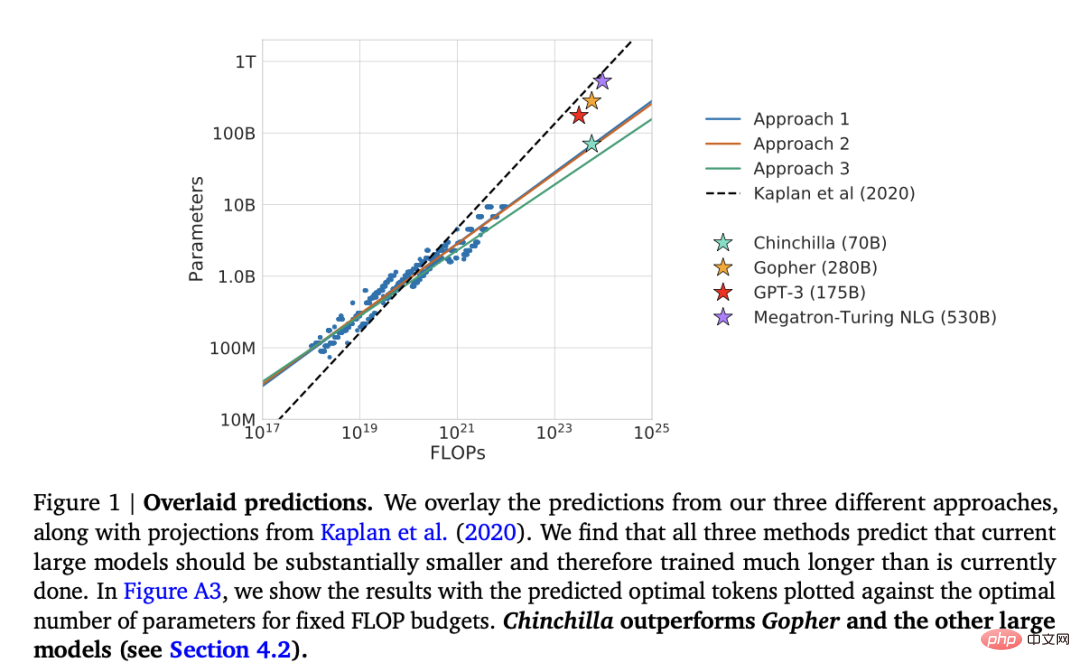

Kertas kerja ini memperkenalkan 70 bilion parameter model Chinchilla, yang mengatasi model 175 bilion parameter GPT-3 yang popular pada tugas pemodelan generatif. Walau bagaimanapun, sorotan utamanya ialah model bahasa berskala besar kontemporari sangat kurang terlatih.

Artikel ini mentakrifkan undang-undang penskalaan linear untuk latihan model bahasa besar. Sebagai contoh, walaupun Chinchilla adalah separuh saiz GPT-3, ia mengatasi GPT-3 kerana ia dilatih pada 1.4 trilion (bukan 300 bilion) token. Dalam erti kata lain, bilangan token latihan adalah sama pentingnya dengan saiz model.

Penjajaran - membimbing model bahasa besar ke arah matlamat dan minat yang diingini

Banyak model yang agak berkuasa telah muncul dalam beberapa tahun kebelakangan ini Model bahasa besar yang boleh menjana teks sebenar (cth. GPT-3 dan Chinchilla). Dari segi paradigma pra-latihan yang biasa digunakan, nampaknya had atas telah dicapai.

Untuk menjadikan model bahasa lebih berguna kepada manusia dan mengurangkan maklumat salah dan bahasa yang tidak baik, penyelidik telah mereka bentuk paradigma latihan tambahan untuk memperhalusi model asas pra-latihan, termasuk kertas kerja berikut.

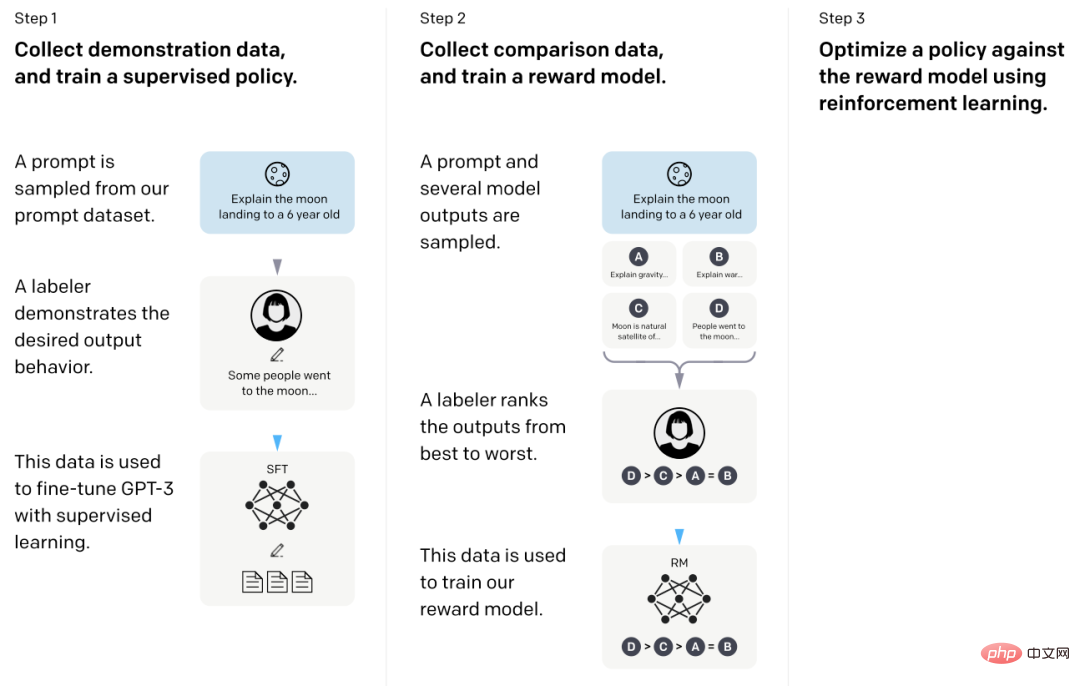

Dalam kertas yang dipanggil InstructGPT ini, penyelidik menggunakan RLHF (Pembelajaran Pengukuhan daripada Maklum Balas Manusia). Mereka bermula dengan model asas GPT-3 yang telah dilatih dan memperhalusinya lagi pada pasangan isyarat-gerak balas yang dijana manusia menggunakan pembelajaran diselia (langkah 1). Seterusnya, mereka meminta manusia untuk menilai output model untuk melatih model ganjaran (langkah 2). Akhir sekali, mereka menggunakan model ganjaran untuk mengemas kini model GPT-3 yang telah dilatih dan diperhalusi menggunakan pembelajaran pengukuhan melalui pengoptimuman dasar proksimal (langkah 3).

Dengan cara ini, makalah ini juga dikenali sebagai kertas yang menerangkan idea di sebalik ChatGPT - menurut khabar angin baru-baru ini, ChatGPT ialah versi lanjutan InstructGPT yang diperhalusi pada set data yang lebih besar.

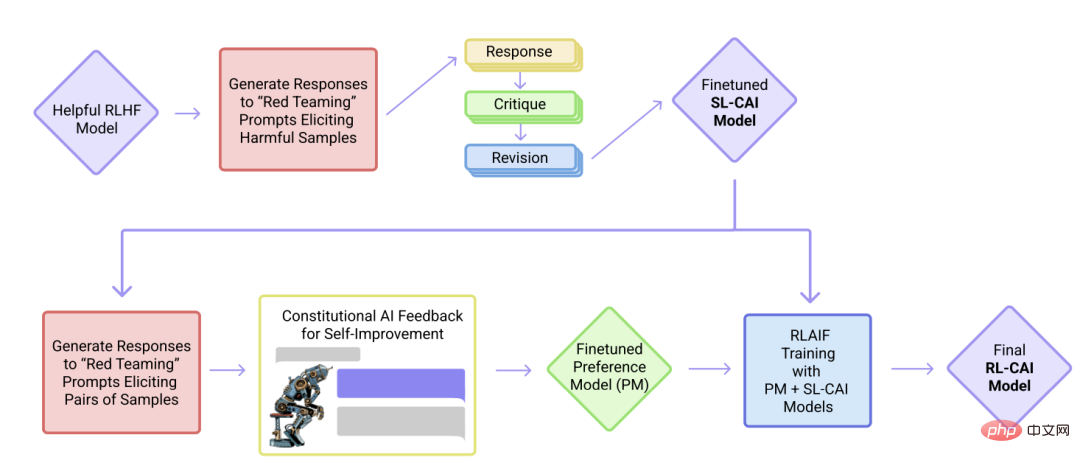

Dalam artikel ini Dalam kertas itu, para penyelidik memajukan lagi idea penjajaran dan mencadangkan mekanisme latihan untuk mencipta sistem AI "tidak berbahaya". Para penyelidik mencadangkan mekanisme latihan diri berdasarkan senarai peraturan (disediakan oleh manusia), dan bukannya pengawasan manusia secara langsung. Sama seperti kertas InstructGPT yang dinyatakan di atas, kaedah yang dicadangkan menggunakan kaedah pembelajaran pengukuhan.

Artikel ini cuba memastikan susunan borang di atas semudah dan secantik mungkin untuk memahami idea di sebalik model bahasa berskala besar kontemporari, batasan dan evolusi.

Sekiranya anda ingin membaca secara mendalam, disarankan untuk merujuk rujukan dalam kertas kerja di atas. Sebagai alternatif, berikut ialah beberapa sumber tambahan untuk pembaca meneroka lebih lanjut:

Alternatif Sumber Terbuka kepada GPT

Alternatif kepada ChatGPT

Model bahasa berskala besar dalam biologi pengiraan

Atas ialah kandungan terperinci Untuk pemahaman yang menyeluruh tentang model bahasa besar, berikut ialah senarai bacaan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Apakah motor servo

Apakah motor servo

Pengenalan kepada kaedah diagnostik SEO

Pengenalan kepada kaedah diagnostik SEO

Apakah yang termasuk storan penyulitan data?

Apakah yang termasuk storan penyulitan data?

Apakah perbezaan utama antara linux dan windows

Apakah perbezaan utama antara linux dan windows

Memori yang boleh bertukar maklumat secara terus dengan CPU ialah a

Memori yang boleh bertukar maklumat secara terus dengan CPU ialah a

Bagaimana untuk membuka fail mds

Bagaimana untuk membuka fail mds

Tukar warna latar belakang perkataan kepada putih

Tukar warna latar belakang perkataan kepada putih

Apakah alat pembangunan?

Apakah alat pembangunan?