Peranti teknologi

Peranti teknologi

AI

AI

Memeriksa semula masalah pengoptimuman Segera, bias ramalan menjadikan pembelajaran konteks model bahasa lebih kukuh

Memeriksa semula masalah pengoptimuman Segera, bias ramalan menjadikan pembelajaran konteks model bahasa lebih kukuh

Memeriksa semula masalah pengoptimuman Segera, bias ramalan menjadikan pembelajaran konteks model bahasa lebih kukuh

LLM telah mencapai prestasi yang baik di bawah pembelajaran dalam konteks, tetapi memilih contoh yang berbeza akan membawa kepada persembahan yang berbeza sama sekali. Kerja penyelidikan baru-baru ini mencadangkan strategi carian segera dari perspektif bias ramalan, dan kira-kira mencari gabungan contoh yang optimum.

- Pautan kertas: https://arxiv.org/abs/2303.13217

- Pautan kod: https://github.com/MaHuanAAA /g_fair_searching

Pengenalan Penyelidikan

Model bahasa berskala besar telah menunjukkan keupayaan yang menakjubkan dalam pembelajaran kontekstual Model ini boleh belajar daripada konteks yang dibina daripada beberapa contoh input dan output tanpa memerlukan denda -penalaan. Pengoptimuman digunakan secara langsung pada banyak tugas hiliran. Walau bagaimanapun, kajian terdahulu telah menunjukkan bahawa pembelajaran kontekstual boleh mempamerkan tahap ketidakstabilan yang tinggi disebabkan oleh perubahan dalam contoh latihan, susunan contoh dan format segera. Oleh itu, membina gesaan yang sesuai adalah penting untuk meningkatkan prestasi pembelajaran kontekstual.

Penyelidikan sebelum ini biasanya mengkaji isu ini dari dua arah: (1) penalaan segera dalam ruang pengekodan (penalaan segera), (2) mencari dalam ruang asal (pencarian segera).

Idea utama Penalaan Segera adalah untuk menyuntik benam khusus tugasan ke dalam lapisan tersembunyi dan kemudian menggunakan pengoptimuman berasaskan kecerunan untuk melaraskan benam ini. Walau bagaimanapun, kaedah ini memerlukan pengubahsuaian proses inferens asal model dan mendapatkan kecerunan model, yang tidak praktikal dalam perkhidmatan LLM kotak hitam seperti GPT-3 dan ChatGPT. Tambahan pula, penalaan pembayang memperkenalkan kos pengiraan dan penyimpanan tambahan, yang selalunya mahal untuk LLM.

Pendekatan yang lebih sesuai dan cekap ialah mengoptimumkan gesaan dengan mencari ruang teks asal untuk sampel dan jujukan demonstrasi anggaran. Sesetengah kerja membina gesaan daripada "Paparan global" atau "Paparan setempat". Kaedah berasaskan paparan global biasanya mengoptimumkan elemen gesaan yang berbeza secara keseluruhan untuk mencapai prestasi yang lebih baik. Sebagai contoh, pendekatan [1] berpandukan Kepelbagaian mengeksploitasi kepelbagaian keseluruhan demonstrasi untuk carian, atau cuba mengoptimumkan keseluruhan susunan gabungan sampel [2] untuk mencapai prestasi yang lebih baik. Berbeza dengan pandangan Global, kaedah berasaskan paparan Tempatan berfungsi dengan mereka bentuk kriteria pemilihan heuristik yang berbeza, seperti KATE [3].

Tetapi kaedah ini mempunyai hadnya sendiri: (1) Kebanyakan penyelidikan semasa tertumpu terutamanya pada mencari petunjuk sepanjang satu faktor, seperti pemilihan contoh atau susunan. Walau bagaimanapun, kesan keseluruhan setiap faktor terhadap prestasi adalah tidak jelas. (2) Kaedah ini biasanya berdasarkan kriteria heuristik dan memerlukan perspektif yang bersatu untuk menerangkan cara kaedah ini berfungsi. (3) Lebih penting lagi, kaedah sedia ada mengoptimumkan petunjuk secara global atau tempatan, yang mungkin membawa kepada prestasi yang tidak memuaskan.

Artikel ini mengkaji semula masalah pengoptimuman segera dalam bidang NLP dari perspektif "kecondongan ramalan" dan menemui fenomena utama: kualiti gesaan yang diberikan bergantung pada kecenderungan yang wujud. Berdasarkan fenomena ini, artikel tersebut mencadangkan kriteria alternatif untuk menilai kualiti gesaan berdasarkan bias ramalan Metrik ini boleh menilai gesaan melalui satu proses ke hadapan tanpa memerlukan set pembangunan tambahan.

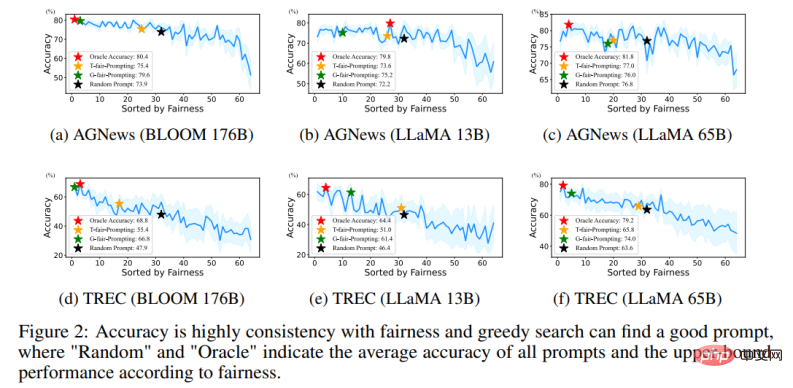

Secara khusus, dengan memasukkan ujian "tiada kandungan" di bawah gesaan yang diberikan, model dijangka akan mengeluarkan taburan ramalan yang seragam (input "tiada kandungan" tidak mengandungi sebarang maklumat berguna) . Oleh itu, keseragaman taburan ramalan digunakan dalam kertas ini untuk mewakili sisihan ramalan bagi gesaan yang diberikan. Ini adalah serupa dengan metrik yang digunakan oleh kaedah pasca penentukuran sebelumnya [4], tetapi tidak seperti pasca penentukuran yang menggunakan metrik ini untuk penentukuran pasca kebarangkalian di bawah gesaan tetap, makalah ini meneroka lebih lanjut aplikasinya dalam mencari gesaan anggaran secara automatik. Dan melalui eksperimen yang meluas, kami mengesahkan korelasi antara bias yang wujud bagi gesaan yang diberikan dan prestasi tugas puratanya pada set ujian tertentu.

Tambahan pula, metrik berasaskan berat sebelah ini membolehkan kaedah mencari gesaan yang sesuai dalam cara "tempatan ke global". Walau bagaimanapun, masalah yang realistik ialah tidak mungkin untuk mencari penyelesaian optimum dengan merentasi semua kombinasi kerana kerumitannya akan melebihi O (N!).

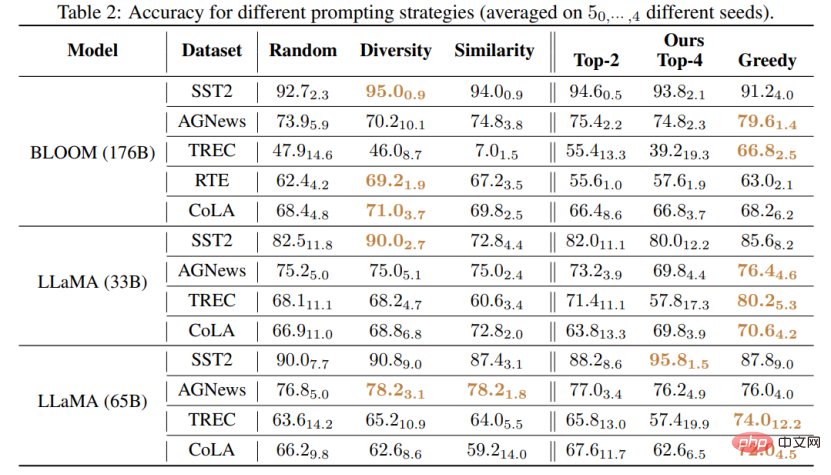

Kerja ini mencadangkan dua strategi baru untuk mencari gesaan berkualiti tinggi dengan cara yang cekap: (1) T-fair-Prompting (2) G-fair-Prompting. T-fair-Prompting menggunakan pendekatan intuitif, mula-mula mengira sisihan setiap contoh secara individu membentuk gesaan, dan kemudian memilih contoh paling adil Top-k untuk digabungkan menjadi gesaan akhir. Strategi ini agak cekap, dengan kerumitan O (N). Tetapi perlu diperhatikan bahawa T-fair-Prompting adalah berdasarkan andaian bahawa gesaan optimum biasanya dibina daripada contoh yang paling berat sebelah. Walau bagaimanapun, ini mungkin tidak berlaku dalam situasi praktikal dan selalunya membawa kepada penyelesaian optimum tempatan. Oleh itu, G-fair-Prompting diperkenalkan lagi dalam artikel untuk meningkatkan kualiti carian. G-fair-Prompting mengikuti proses biasa pencarian rakus untuk mencari penyelesaian optimum dengan membuat pilihan optimum setempat pada setiap langkah. Pada setiap langkah algoritma, contoh dipilih supaya gesaan yang dikemas kini mencapai keadilan optimum dengan kerumitan masa terburuk O (N^2), meningkatkan kualiti carian dengan ketara. G-fair-Prompting berfungsi dari perspektif tempatan-ke-global, di mana berat sebelah sampel individu dipertimbangkan pada peringkat awal, manakala peringkat kemudian menumpukan pada mengurangkan bias ramalan global.

Hasil eksperimen

Kajian ini mencadangkan kaedah yang berkesan dan boleh ditafsir untuk meningkatkan prestasi pembelajaran konteks model bahasa, yang boleh digunakan untuk pelbagai tugas hiliran. Artikel itu mengesahkan keberkesanan kedua-dua strategi ini pada pelbagai LLM (termasuk siri model GPT dan siri LMaMA yang dikeluarkan baru-baru ini Berbanding dengan kaedah SOTA, G-fair-Prompting mencapai lebih daripada 10% pada tugasan hiliran yang berbeza). .

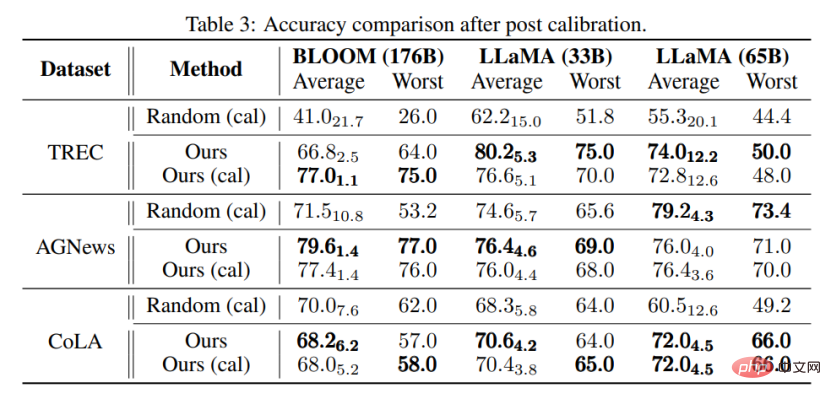

Perkara yang paling hampir dengan penyelidikan ini ialah kaedah Penentukuran-sebelum digunakan [4], yang kedua-duanya menggunakan input "bebas kandungan" untuk meningkatkan prestasi model. Walau bagaimanapun, kaedah Kalibrasi-sebelum-penggunaan direka bentuk untuk menggunakan piawaian ini untuk menentukur keluaran, yang masih terdedah kepada kualiti contoh yang digunakan. Sebaliknya, kertas kerja ini bertujuan untuk mencari ruang asal untuk mencari gesaan yang hampir optimum untuk meningkatkan prestasi model tanpa sebarang pasca pemprosesan output model. Tambahan pula, kertas ini adalah yang pertama menunjukkan melalui eksperimen yang meluas hubungan antara bias ramalan dan prestasi tugas akhir, yang belum lagi dikaji dalam kaedah penentukuran sebelum digunakan.

Ia juga boleh didapati melalui eksperimen bahawa walaupun tanpa penentukuran, gesaan yang dipilih mengikut kaedah yang dicadangkan dalam artikel ini boleh lebih baik daripada gesaan yang dipilih secara rawak yang ditentukur. Ini menunjukkan bahawa kaedah itu boleh menjadi praktikal dan berkesan dalam aplikasi praktikal dan boleh memberi inspirasi untuk penyelidikan pemprosesan bahasa semula jadi pada masa hadapan.

Atas ialah kandungan terperinci Memeriksa semula masalah pengoptimuman Segera, bias ramalan menjadikan pembelajaran konteks model bahasa lebih kukuh. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1376

1376

52

52

Menyelam mendalam ke dalam model, data dan rangka kerja: tinjauan menyeluruh 54 halaman model bahasa besar yang cekap

Jan 14, 2024 pm 07:48 PM

Menyelam mendalam ke dalam model, data dan rangka kerja: tinjauan menyeluruh 54 halaman model bahasa besar yang cekap

Jan 14, 2024 pm 07:48 PM

Model bahasa berskala besar (LLM) telah menunjukkan keupayaan yang menarik dalam banyak tugas penting, termasuk pemahaman bahasa semula jadi, penjanaan bahasa dan penaakulan yang kompleks, dan telah memberi kesan yang mendalam kepada masyarakat. Walau bagaimanapun, keupayaan cemerlang ini memerlukan sumber latihan yang ketara (ditunjukkan di sebelah kiri) dan masa inferens yang panjang (ditunjukkan di sebelah kanan). Oleh itu, penyelidik perlu membangunkan cara teknikal yang berkesan untuk menyelesaikan masalah kecekapan mereka. Di samping itu, seperti yang dapat dilihat dari sebelah kanan rajah, beberapa LLM (Model Bahasa) yang cekap seperti Mistral-7B telah berjaya digunakan dalam reka bentuk dan penggunaan LLM. LLM yang cekap ini boleh mengurangkan memori inferens dengan ketara sambil mengekalkan ketepatan yang serupa dengan LLaMA1-33B

Menghancurkan H100, GPU generasi seterusnya Nvidia didedahkan! Reka bentuk modul berbilang cip 3nm pertama, diperkenalkan pada 2024

Sep 30, 2023 pm 12:49 PM

Menghancurkan H100, GPU generasi seterusnya Nvidia didedahkan! Reka bentuk modul berbilang cip 3nm pertama, diperkenalkan pada 2024

Sep 30, 2023 pm 12:49 PM

Proses 3nm, prestasi melepasi H100! Baru-baru ini, media asing DigiTimes mengumumkan bahawa Nvidia sedang membangunkan GPU generasi akan datang, B100, dengan nama kod "Blackwell" Dikatakan bahawa sebagai produk untuk aplikasi kecerdasan buatan (AI) dan pengkomputeran berprestasi tinggi (HPC). , B100 akan menggunakan proses proses 3nm TSMC, serta reka bentuk modul berbilang cip (MCM) yang lebih kompleks, dan akan muncul pada suku keempat 2024. Bagi Nvidia, yang memonopoli lebih daripada 80% pasaran GPU kecerdasan buatan, ia boleh menggunakan B100 untuk menyerang semasa seterika panas dan seterusnya menyerang pencabar seperti AMD dan Intel dalam gelombang penggunaan AI ini. Menurut anggaran NVIDIA, menjelang 2027, nilai output medan ini dijangka mencapai lebih kurang

Gabungan hebat model penyebaran + resolusi super, teknologi di sebalik penjana imej Google Imagen

Apr 10, 2023 am 10:21 AM

Gabungan hebat model penyebaran + resolusi super, teknologi di sebalik penjana imej Google Imagen

Apr 10, 2023 am 10:21 AM

Dalam beberapa tahun kebelakangan ini, pembelajaran multimodal telah mendapat banyak perhatian, terutamanya dalam dua arah sintesis teks-imej dan pembelajaran kontrastif imej-teks. Sesetengah model AI telah menarik perhatian umum kerana aplikasinya dalam penjanaan dan penyuntingan imej kreatif, seperti model imej teks DALL・E dan DALL-E 2 yang dilancarkan oleh OpenAI, dan GauGAN dan GauGAN2 NVIDIA. Tidak ketinggalan, Google mengeluarkan model teks-ke-imej sendiri Imagen pada penghujung Mei, yang nampaknya memperluaskan lagi sempadan penjanaan imej bersyarat kapsyen. Memandangkan hanya perihalan adegan, Imagen boleh menghasilkan kualiti tinggi, resolusi tinggi

Semakan paling komprehensif tentang model besar multimodal ada di sini! 7 penyelidik Microsoft bekerjasama bersungguh-sungguh, 5 tema utama, 119 halaman dokumen

Sep 25, 2023 pm 04:49 PM

Semakan paling komprehensif tentang model besar multimodal ada di sini! 7 penyelidik Microsoft bekerjasama bersungguh-sungguh, 5 tema utama, 119 halaman dokumen

Sep 25, 2023 pm 04:49 PM

Kajian yang paling komprehensif tentang model besar berbilang mod ada di sini! Ditulis oleh 7 penyelidik Cina di Microsoft, ia mempunyai 119 halaman - ia bermula daripada dua jenis arahan penyelidikan model besar berbilang modal yang telah selesai dan masih berada di barisan hadapan, dan meringkaskan secara komprehensif lima topik penyelidikan khusus: pemahaman visual dan penjanaan visual Ejen berbilang modal model besar berbilang modal yang disokong oleh model visual bersatu LLM memfokuskan pada fenomena: model asas berbilang modal telah beralih daripada khusus kepada universal. Ps. Inilah sebabnya penulis melukis secara langsung imej Doraemon pada permulaan kertas. Siapa yang patut membaca ulasan (laporan) ini? Dalam kata-kata asal Microsoft: Selagi anda berminat untuk mempelajari pengetahuan asas dan kemajuan terkini model asas pelbagai mod, sama ada anda seorang penyelidik profesional atau pelajar, kandungan ini sangat sesuai untuk anda berkumpul.

Penyesuai I2V daripada komuniti SD: tiada konfigurasi diperlukan, pasang dan main, serasi sempurna dengan pemalam video Tusheng

Jan 15, 2024 pm 07:48 PM

Penyesuai I2V daripada komuniti SD: tiada konfigurasi diperlukan, pasang dan main, serasi sempurna dengan pemalam video Tusheng

Jan 15, 2024 pm 07:48 PM

Tugas penjanaan imej-ke-video (I2V) merupakan satu cabaran dalam bidang penglihatan komputer yang bertujuan untuk menukar imej statik kepada video dinamik. Kesukaran tugas ini adalah untuk mengekstrak dan menjana maklumat dinamik dalam dimensi temporal daripada imej tunggal sambil mengekalkan keaslian dan keselarasan visual kandungan imej. Kaedah I2V sedia ada selalunya memerlukan seni bina model yang kompleks dan sejumlah besar data latihan untuk mencapai matlamat ini. Baru-baru ini, hasil penyelidikan baharu "I2V-Adapter: AGeneralImage-to-VideoAdapter for VideoDiffusionModels" yang diketuai oleh Kuaishou telah dikeluarkan. Kajian ini memperkenalkan kaedah penukaran imej-ke-video yang inovatif dan mencadangkan modul penyesuai ringan, i.e.

Hadiah Boltzmann 2022 diumumkan: Pengasas Hopfield Network memenangi anugerah

Aug 13, 2023 pm 08:49 PM

Hadiah Boltzmann 2022 diumumkan: Pengasas Hopfield Network memenangi anugerah

Aug 13, 2023 pm 08:49 PM

Dua saintis yang telah memenangi Hadiah Boltzmann 2022 telah diumumkan Anugerah ini ditubuhkan oleh Jawatankuasa IUPAP mengenai Fizik Statistik (C3) untuk mengiktiraf para penyelidik yang telah mencapai pencapaian cemerlang dalam bidang fizik statistik. Pemenang mestilah seorang saintis yang belum pernah memenangi Hadiah Boltzmann atau Hadiah Nobel. Anugerah ini bermula pada tahun 1975 dan dianugerahkan setiap tiga tahun untuk memperingati Ludwig Boltzmann, pengasas fizik statistik Deepak Dharistheoriginalstatement. model kritikal, pertumbuhan antara muka, gangguan

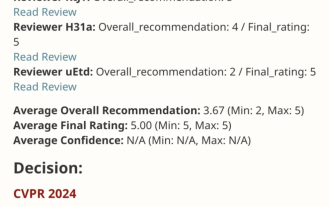

Kertas skor sempurna VPR 2024! Meta mencadangkan EfficientSAM: cepat belah semuanya!

Mar 02, 2024 am 10:10 AM

Kertas skor sempurna VPR 2024! Meta mencadangkan EfficientSAM: cepat belah semuanya!

Mar 02, 2024 am 10:10 AM

Kerja EfficientSAM ini telah dimasukkan ke dalam CVPR2024 dengan skor sempurna 5/5/5! Penulis berkongsi hasilnya di media sosial, seperti yang ditunjukkan dalam gambar di bawah: Pemenang Anugerah LeCun Turing juga sangat mengesyorkan karya ini! Dalam penyelidikan baru-baru ini, penyelidik Meta telah mencadangkan kaedah baharu yang dipertingkatkan, iaitu pra-latihan imej topeng (SAMI) menggunakan SAM. Kaedah ini menggabungkan teknologi pra-latihan MAE dan model SAM untuk mencapai pengekod ViT pra-latihan berkualiti tinggi. Melalui SAMI, penyelidik cuba meningkatkan prestasi dan kecekapan model dan menyediakan penyelesaian yang lebih baik untuk tugas penglihatan. Cadangan kaedah ini membawa idea dan peluang baharu untuk meneroka dan mengembangkan lagi bidang visi komputer dan pembelajaran mendalam. dengan menggabungkan berbeza

MiniGPT-5, yang menyatukan penjanaan imej dan teks, ada di sini: Token menjadi Voken, dan model itu bukan sahaja boleh meneruskan penulisan, tetapi juga menambah gambar secara automatik.

Oct 11, 2023 pm 12:45 PM

MiniGPT-5, yang menyatukan penjanaan imej dan teks, ada di sini: Token menjadi Voken, dan model itu bukan sahaja boleh meneruskan penulisan, tetapi juga menambah gambar secara automatik.

Oct 11, 2023 pm 12:45 PM

Model berskala besar membuat lompatan antara bahasa dan penglihatan, menjanjikan untuk memahami dan menjana kandungan teks dan imej dengan lancar. Dalam satu siri kajian baru-baru ini, penyepaduan ciri berbilang mod bukan sahaja menjadi trend yang semakin berkembang tetapi telah membawa kepada kemajuan utama yang terdiri daripada perbualan pelbagai mod kepada alatan penciptaan kandungan. Model bahasa yang besar telah menunjukkan keupayaan yang tiada tandingan dalam pemahaman dan penjanaan teks. Walau bagaimanapun, secara serentak menjana imej dengan naratif teks yang koheren masih merupakan bidang yang perlu dibangunkan Baru-baru ini, pasukan penyelidik di University of California, Santa Cruz mencadangkan MiniGPT-5, algoritma interleaving yang inovatif berdasarkan konsep "baucar generatif". teknologi penjanaan bahasa. Alamat kertas: https://browse.arxiv.org/p