Cara pemikiran GPT-4 semakin seperti manusia.

Apabila manusia melakukan kesilapan, mereka akan merenung tindakan mereka untuk mengelak daripada melakukan kesilapan lagi Jika model bahasa yang besar seperti GPT-4 juga mempunyai keupayaan untuk mencerminkan, prestasi akan dipertingkatkan.

Adalah diketahui umum bahawa model bahasa besar (LLM) telah menunjukkan prestasi yang tidak pernah berlaku sebelum ini dalam pelbagai tugas. Walau bagaimanapun, kaedah SOTA ini biasanya memerlukan penalaan halus model, pengoptimuman dasar dan operasi lain pada ruang keadaan yang ditentukan. Oleh kerana kekurangan data latihan berkualiti tinggi dan ruang keadaan yang jelas, masih sukar untuk melaksanakan model pengoptimuman. Tambahan pula, model belum lagi mempunyai kualiti tertentu yang wujud dalam proses membuat keputusan manusia, terutamanya keupayaan untuk belajar daripada kesilapan.

Tetapi kini, dalam kertas kerja baru-baru ini, penyelidik dari Universiti Timur Laut, MIT dan institusi lain mencadangkan Refleksi, yang memberikan ejen keupayaan untuk mengingati dan mencerminkan diri secara dinamik.

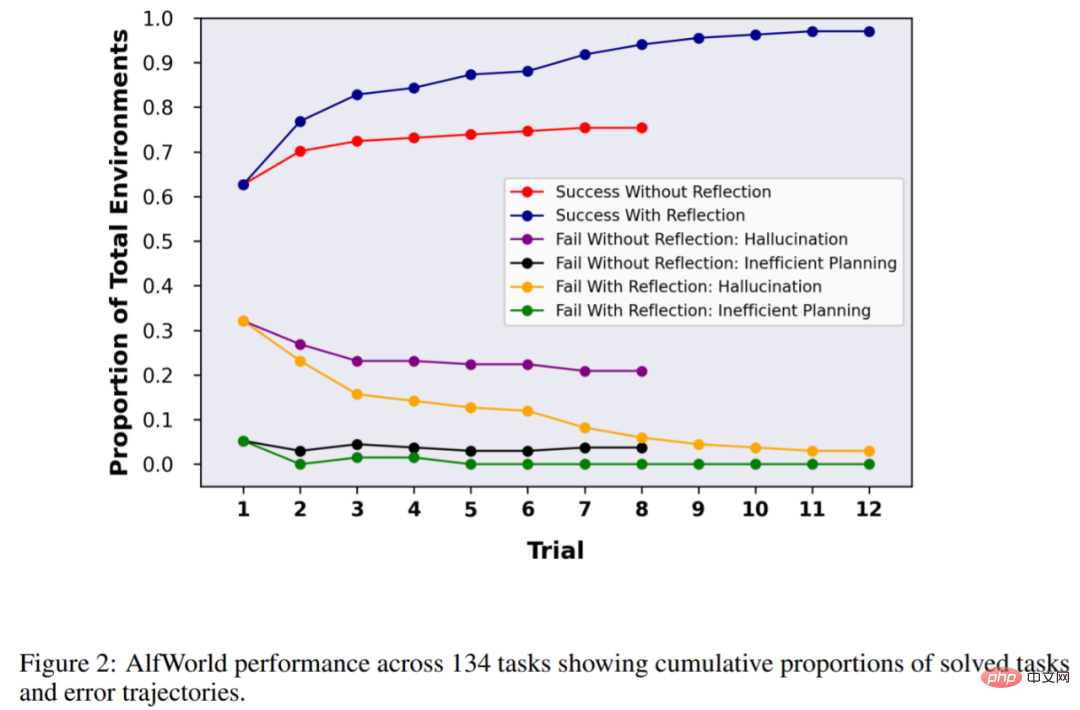

Untuk mengesahkan keberkesanan kaedah, kajian menilai keupayaan ejen untuk menyelesaikan tugas membuat keputusan dalam persekitaran AlfWorld, dan untuk menyelesaikan tugasan soal jawab berasaskan carian yang intensif pengetahuan dalam HotPotQA. persekitaran. Kadar kejayaan misi masing-masing adalah 97% dan 51%.

Alamat kertas: https://arxiv.org/pdf/2303.11366.pdf

Alamat projek: https://github.com/GammaTauAI/ reflexion-human-eval

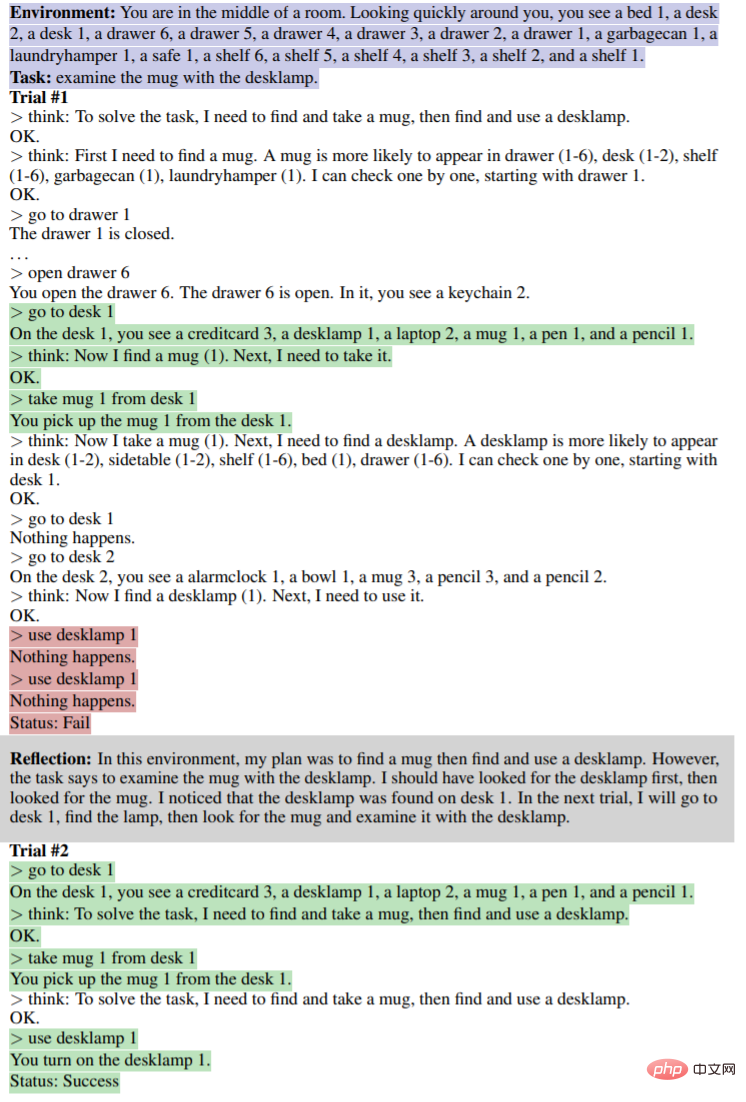

Seperti yang ditunjukkan dalam rajah di bawah, dalam persekitaran AlfWorld, pelbagai item diletakkan di dalam bilik, dan ejen dikehendaki memberikan pelan penaakulan untuk mendapatkan objek tertentu daripada rajah di bawah adalah disebabkan oleh Ejen gagal kerana perancangan yang tidak cekap. Selepas refleksi, ejen menyedari kesilapan, membetulkan trajektori penaakulan, dan memberikan kaedah trajektori ringkas (bahagian bawah angka).

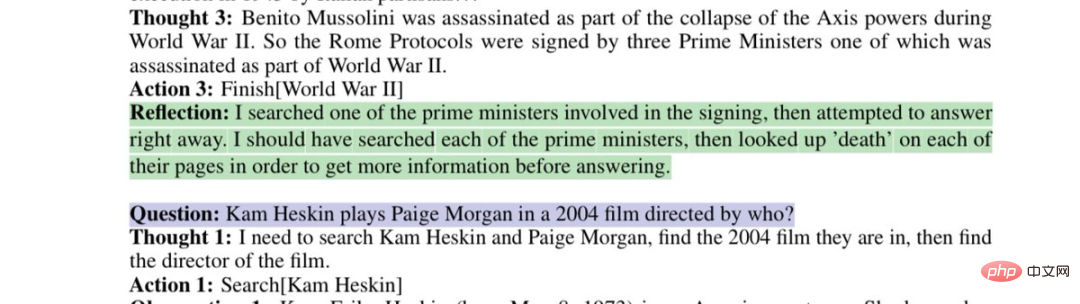

Refleksi model tentang strategi carian yang cacat:

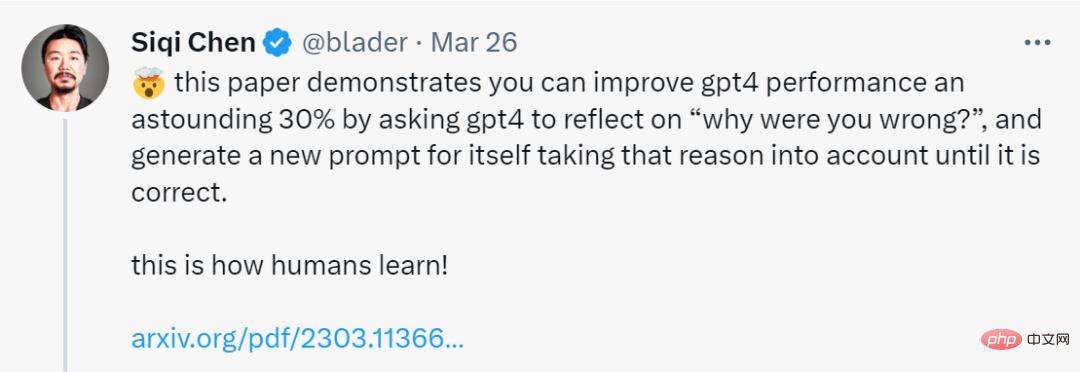

Kertas ini menunjukkan bahawa anda boleh melakukan ini dengan memerlukan GPT-4 Renungkan "Mengapa anda salah?" dan jana gesaan baharu untuk diri sendiri, mengambil kira ralat itu sehingga keputusannya betul, dengan itu meningkatkan prestasi GPT-4 sebanyak 30%.

Netizen tidak dapat mengeluh: Kepantasan pembangunan kecerdasan buatan telah melebihi keupayaan kami untuk menyesuaikan diri.

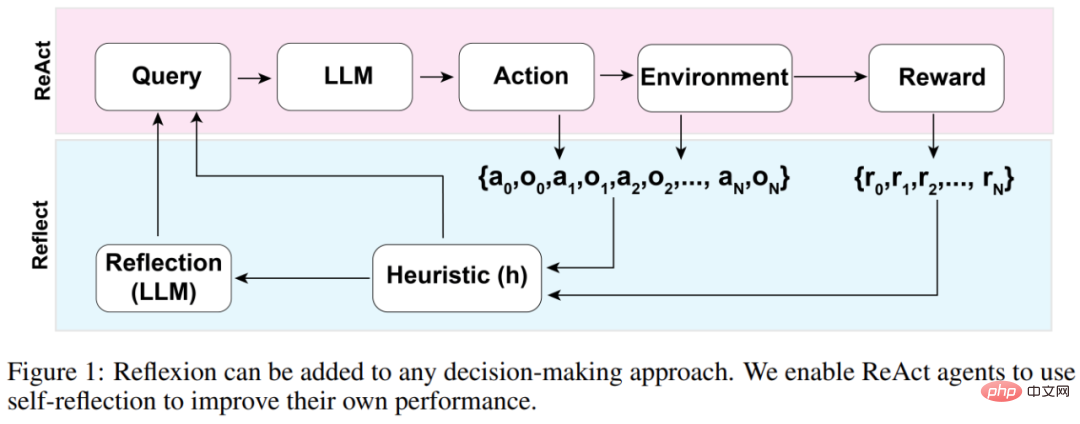

Seni bina keseluruhan ejen Refleks ditunjukkan dalam Rajah 1 di bawah, di mana Reflexion menggunakan ReAct (Yao et al., 2023). Dalam percubaan pertama, ejen diberi tugas daripada persekitaran yang membentuk pertanyaan awal, dan kemudian ejen melakukan urutan tindakan yang dijana oleh LLM dan menerima pemerhatian dan ganjaran daripada persekitaran. Untuk persekitaran yang menawarkan ganjaran deskriptif atau berterusan, kajian mengehadkan output kepada keadaan kejayaan binari mudah untuk memastikan kebolehgunaan.

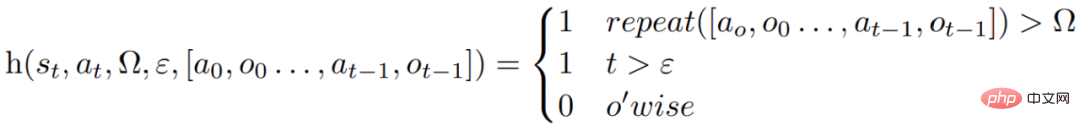

Selepas setiap tindakan a_t, ejen akan mengira fungsi heuristik h, seperti yang ditunjukkan dalam rajah di bawah

Fungsi heuristik ini direka bentuk untuk mengesan ilusi maklumat (iaitu maklumat palsu atau salah) atau ketidakcekapan ejen, dan "memberitahu" ejen apabila ia perlu mencerminkan (refleksi), di mana t ialah langkah masa, s_t ialah keadaan semasa, Ω mewakili bilangan kitaran tindakan berulang, ε mewakili jumlah maksimum tindakan yang dilaksanakan, [a_o, o_0 , a_(t−1), o_(t−1)] mewakili sejarah trajektori. ulang ialah fungsi mudah yang menentukan bilangan kali gelung tindakan berulang menghasilkan hasil yang sama.

Jika fungsi h memberitahu ejen bahawa refleksi diperlukan, maka ejen akan bertanya kepada LLM untuk menggambarkan tugas semasa, sejarah trajektori dan ganjaran terakhirnya, dan kemudian ejen menetapkan semula persekitaran dan mencuba lagi pada percubaan berikutnya. Jika fungsi h tidak memberitahu ejen bahawa refleksi diperlukan, maka ejen menambah a_t dan o_t pada sejarah trajektorinya dan menanyakan LLM untuk tindakan seterusnya.

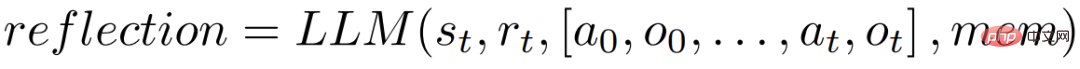

Jika heuristik h mengesyorkan refleksi pada langkah masa t, ejen akan mencerminkan berdasarkan keadaan semasa s_t, ganjaran terakhir r_t, tindakan dan pemerhatian sebelumnya [a_0, o_0, mem stor kerja ejen sedia ada, mulakan proses refleksi.

Tujuan refleksi adalah untuk membantu ejen membetulkan "ilusi" dan ketidakcekapan melalui percubaan berulang. Model yang digunakan untuk refleksi ialah LLM yang menggunakan trajektori kegagalan tertentu dan contoh pantulan yang ideal untuk digesa.

Ejen akan melakukan proses refleksi di atas secara berulang. Dalam eksperimen, kajian menetapkan bilangan pantulan yang disimpan dalam ingatan ejen kepada maksimum 3 kali untuk mengelakkan pertanyaan melebihi had LLM. Larian akan ditamatkan dalam situasi berikut:

Kajian itu menguji ejen dalam 134 persekitaran AlfWorld, dengan tugas termasuk mencari objek tersembunyi (contohnya, mencari pisau buah dalam laci), memindahkan objek (contohnya, mengalihkan pisau ke papan pemotong), dan menggunakan objek lain untuk memanipulasi objek lain (contohnya, menyejukkan tomato dalam peti sejuk).

Tanpa refleksi, ketepatan ejen adalah 63%, dan Refleksi telah ditambah untuk perbandingan. Keputusan menunjukkan bahawa ejen itu mampu mengendalikan 97% persekitaran dalam 12 ujian dan gagal menyelesaikan hanya 4 daripada 134 tugasan.

Percubaan seterusnya telah dijalankan dalam HotPotQA, iaitu set data berdasarkan Wikipedia dan mengandungi 113k pasangan soalan dan jawapan, terutamanya digunakan untuk mencabar ejen untuk menghuraikan kandungan dan kebolehan menaakul.

Percubaan seterusnya telah dijalankan dalam HotPotQA, iaitu set data berdasarkan Wikipedia dan mengandungi 113k pasangan soalan dan jawapan, terutamanya digunakan untuk mencabar ejen untuk menghuraikan kandungan dan kebolehan menaakul.

Mengenai 100 ujian pasangan soalan jawapan HotpotQA, kajian itu membandingkan ejen asas dan ejen berasaskan Refleksi sehingga mereka gagal meningkatkan ketepatan berbanding percubaan berturut-turut. Keputusan menunjukkan bahawa prestasi agen asas tidak bertambah baik Dalam percubaan pertama, ketepatan agen asas adalah 34% dan ketepatan agen Refleks adalah 32%. ejen bertambah baik dengan ketara. Peningkatan hampir 30%, yang jauh lebih baik daripada ejen asas.

Begitu juga, apabila menguji keupayaan model untuk menulis kod, GPT-4 dengan Refleksi juga jauh lebih baik daripada GPT-4 biasa:

Begitu juga, apabila menguji keupayaan model untuk menulis kod, GPT-4 dengan Refleksi juga jauh lebih baik daripada GPT-4 biasa:

Atas ialah kandungan terperinci Apabila GPT-4 mencerminkan kesilapannya: prestasi meningkat hampir 30%, dan keupayaan pengaturcaraan meningkat sebanyak 21%. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Bagaimana untuk menukar jenis fail dalam win7

Bagaimana untuk menukar jenis fail dalam win7

Pengenalan kepada maksud kata laluan tidak sah

Pengenalan kepada maksud kata laluan tidak sah

Bagaimana untuk memuat naik html

Bagaimana untuk memuat naik html

Bagaimana untuk membuka akaun dengan mata wang u

Bagaimana untuk membuka akaun dengan mata wang u

Bagaimana untuk membuka fail ofd

Bagaimana untuk membuka fail ofd

Bagaimana untuk mengekstrak audio daripada video dalam java

Bagaimana untuk mengekstrak audio daripada video dalam java

jsonp menyelesaikan masalah merentas domain

jsonp menyelesaikan masalah merentas domain

Apakah maksud c#?

Apakah maksud c#?

Analisis keberkesanan kos pembelajaran python, java dan c++

Analisis keberkesanan kos pembelajaran python, java dan c++