Peranti teknologi

Peranti teknologi

AI

AI

Adakah laluan penyelidikan GPT-4 tiada harapan? Yann LeCun menjatuhkan hukuman mati kepada Zi Hui

Adakah laluan penyelidikan GPT-4 tiada harapan? Yann LeCun menjatuhkan hukuman mati kepada Zi Hui

Adakah laluan penyelidikan GPT-4 tiada harapan? Yann LeCun menjatuhkan hukuman mati kepada Zi Hui

Pandangan Yann LeCun memang agak berani.

"Tiada sesiapa yang waras akan menggunakan model autoregresif 5 tahun dari sekarang, Pemenang Anugerah Turing Yann LeCun memberikan pembukaan khas untuk perdebatan. Autoregresi yang diperkatakannya adalah betul-betul paradigma pembelajaran yang bergantung pada model keluarga GPT yang popular pada masa ini.

Sudah tentu, bukan hanya model autoregresif yang ditunjukkan oleh Yann LeCun. Pada pandangan beliau, keseluruhan bidang pembelajaran mesin kini menghadapi cabaran besar.

Tema perbahasan ini ialah "Adakah model bahasa yang besar memerlukan asas deria untuk makna dan pemahaman dan merupakan sebahagian daripada persidangan "The Philosophy of Deep Learning" yang diadakan baru-baru ini. Persidangan itu meneroka isu-isu semasa dalam penyelidikan kecerdasan buatan dari perspektif falsafah, terutamanya kerja baru-baru ini dalam bidang rangkaian saraf tiruan dalam. Tujuannya adalah untuk mengumpulkan ahli falsafah dan saintis yang memikirkan tentang sistem ini untuk lebih memahami keupayaan, batasan, dan hubungan model ini dengan kognisi manusia.

Menurut PPT perbahasan, Yann LeCun meneruskan gaya tajamnya yang biasa dan terus terang menunjukkan bahawa "Pembelajaran Mesin menyebalkan!" . Dalam artikel ini, kami menyusun idea teras Yann LeCun berdasarkan PPT.

Untuk maklumat video susulan, sila beri perhatian kepada laman web rasmi persidangan: https://phildeeplearning.github.io/

Pandangan teras Yann LeCun

Apakah yang salah dengan pembelajaran mesin? LeCun menyenaraikan beberapa item mengikut situasi:Pembelajaran diselia (SL) memerlukan sejumlah besar sampel berlabel; 🎜>

Pembelajaran penyeliaan kendiri (SSL) memerlukan sejumlah besar sampel tidak berlabel.- Selain itu, kebanyakan sistem AI semasa berdasarkan pembelajaran mesin membuat kesilapan yang sangat bodoh dan tidak boleh membuat alasan atau merancang.

- Sebagai perbandingan, manusia dan haiwan boleh melakukan lebih banyak lagi, termasuk:

- memahami cara dunia berfungsi

- adalah lebih penting Masalahnya ialah manusia dan haiwan mempunyai akal, manakala akal yang dimiliki oleh mesin semasa adalah agak dangkal.

- Model bahasa besar autoregresif tidak mempunyai masa depan

Perkara pertama yang anda boleh lihat ialah pembelajaran penyeliaan kendiri telah menjadi paradigma pembelajaran arus perdana semasa LeCun, "Pembelajaran Penyeliaan Kendiri telah mengambil alih dunia." Dalam beberapa tahun kebelakangan ini, kebanyakan model besar untuk pemahaman dan penjanaan teks dan imej telah menerima pakai paradigma pembelajaran ini.

Perkara pertama yang anda boleh lihat ialah pembelajaran penyeliaan kendiri telah menjadi paradigma pembelajaran arus perdana semasa LeCun, "Pembelajaran Penyeliaan Kendiri telah mengambil alih dunia." Dalam beberapa tahun kebelakangan ini, kebanyakan model besar untuk pemahaman dan penjanaan teks dan imej telah menerima pakai paradigma pembelajaran ini.

Dalam pembelajaran penyeliaan kendiri, model bahasa besar autoregresif (AR-LLM) yang diwakili oleh keluarga GPT semakin popular. Prinsip model ini adalah untuk meramalkan token seterusnya berdasarkan di atas atau di bawah (token di sini boleh menjadi perkataan, blok imej atau klip ucapan). Model seperti LLaMA (FAIR) dan ChatGPT (OpenAI) yang kami kenali adalah semua model autoregresif. Tetapi pada pandangan LeCun, model jenis ini tidak mempunyai masa depan (LLM Auto-Regresif akan ditakdirkan). Kerana walaupun prestasi mereka mengagumkan, banyak masalah sukar diselesaikan, termasuk kesilapan fakta, kesilapan logik, ketidakkonsistenan, penaakulan terhad dan penjanaan kandungan berbahaya yang mudah. Yang penting, model sedemikian tidak memahami realiti asas dunia.

Dari perspektif teknikal, andaikan e ialah kebarangkalian bahawa token yang dijana secara sewenang-wenangnya boleh membawa kita menjauhi set jawapan yang betul, maka kebarangkalian bahawa jawapan yang panjang n akan akhirnya menjadi jawapan yang betul Iaitu P (betul) = (1-e)^n. Menurut algoritma ini, ralat terkumpul dan ketepatan berkurangan secara eksponen. Sudah tentu, kita boleh mengurangkan masalah ini (melalui latihan) dengan menjadikan ia lebih kecil, tetapi ia tidak boleh dihapuskan sepenuhnya, jelas Yann LeCun. Beliau percaya bahawa untuk menyelesaikan masalah ini, kita perlu menjadikan LLM tidak lagi autoregresif sambil mengekalkan kelancaran model.

LeCun percaya bahawa terdapat hala tuju yang menjanjikan: model dunia

Model GPT yang popular pada masa ini, If tidak ada masa depan, lalu apa yang mempunyai masa depan? Menurut LeCun, jawapannya ialah: model dunia.

Sejak beberapa tahun, LeCun telah menekankan bahawa model bahasa berskala besar semasa ini sangat tidak cekap dalam pembelajaran berbanding manusia dan haiwan: seorang remaja yang tidak pernah memandu kereta boleh belajar dalam masa 20 jam Belajar memandu, tetapi sistem pemanduan sendiri yang terbaik memerlukan berjuta-juta atau berbilion-bilion data berlabel, atau berjuta-juta ujian pembelajaran pengukuhan dalam persekitaran maya. Walaupun dengan semua usaha ini, mereka tidak akan dapat mencapai keupayaan pemanduan yang boleh dipercayai seperti manusia.

Jadi, terdapat tiga cabaran utama yang dihadapi oleh penyelidik pembelajaran mesin semasa: satu ialah mempelajari model perwakilan dan ramalan dunia; yang satu lagi ialah mempelajari inferens (Sistem disebutkan oleh LeCun 2 Untuk perbincangan berkaitan, sila rujuk kepada laporan Profesor Wang Jun dari UCL); yang ketiga ialah belajar merancang urutan tindakan yang kompleks.

Berdasarkan masalah ini, LeCun mencadangkan idea membina model "dunia", dan menerbitkan kertas kerja bertajuk "Laluan ke arah kecerdasan mesin autonomi" adalah dijelaskan secara terperinci.

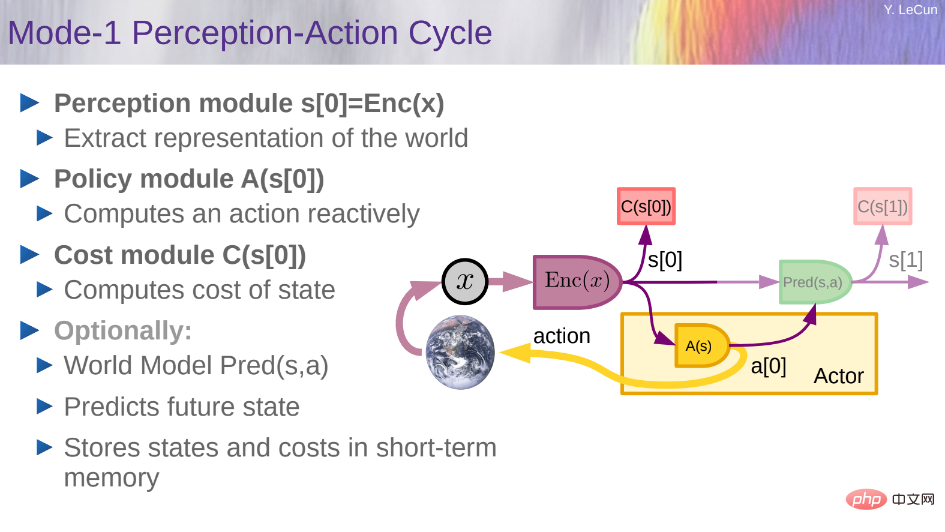

Secara khusus, dia mahu membina seni bina kognitif yang mampu membuat penaakulan dan perancangan. Seni bina ini terdiri daripada 6 modul bebas:

- Modul konfigurator;

- Modul persepsi; > modul pelakon;

- Modul ingatan jangka pendek.

- Maklumat terperinci tentang modul ini boleh didapati dalam artikel Heart of the Machine sebelum ini "Pemenang Anugerah Turing Yann LeCun: Cabaran terbesar untuk penyelidikan AI dalam beberapa masa akan datang dekad ialah "Model Dunia Ramalan".

Yann LeCun juga menjelaskan beberapa butiran yang disebut dalam kertas sebelum ini dalam PPT.

Melatih model dunia ialah contoh tipikal pembelajaran penyeliaan kendiri (SSL), idea asasnya ialah pelengkapan corak. Ramalan input masa hadapan (atau input tidak diperhatikan buat sementara waktu) ialah kes khas penyiapan corak.

Bagaimana untuk membina dan melatih model dunia? Apa yang perlu dilihat ialah dunia hanya boleh diramalkan sebahagian sahaja. Pertama, persoalannya ialah bagaimana mencirikan ketidakpastian dalam ramalan.

Jadi, bagaimanakah satu model ramalan boleh mewakili berbilang ramalan?

Seperti yang ditunjukkan dalam rajah di atas, dalam seni bina ini, x mewakili pemerhatian masa lalu dan semasa, y mewakili masa depan, a mewakili tindakan, z mewakili pembolehubah pendam yang tidak diketahui, D() mewakili kos ramalan, C() mewakili kos penggantian. JEPA meramalkan perwakilan S_y untuk masa hadapan daripada perwakilan S_x untuk masa lalu dan sekarang.

Seni bina generatif meramalkan semua butiran y, termasuk yang tidak berkaitan manakala JEPA meramalkan perwakilan abstrak y.

Dalam kes ini, LeCun percaya terdapat lima idea yang perlu "sepenuhnya terbengkalai ":

- Tinggalkan model generatif dan sokong seni bina benam bersama;

- Tinggalkan penjanaan autoregresif;

- Tinggalkan model probabilistik dan model tenaga sokongan;

- Meninggalkan kaedah kontrastif memihak kepada kaedah regularisasi;

- Cadangannya adalah untuk menggunakan RL hanya apabila rancangan itu tidak menghasilkan keputusan yang diramalkan, untuk melaraskan model dunia atau pengkritik.

Seperti model tenaga, JEPA boleh dilatih menggunakan kaedah kontrastif. Walau bagaimanapun, kaedah kontrastif tidak cekap dalam ruang dimensi tinggi, jadi lebih sesuai untuk melatih mereka dengan kaedah bukan kontrastif. Dalam kes JEPA, ini boleh dicapai melalui empat kriteria, seperti yang ditunjukkan dalam rajah di bawah: 1. Maksimumkan jumlah maklumat s_x mempunyai tentang x 2. Maksimumkan jumlah maklumat s_y mempunyai tentang y 3. Jadikan s_y mudah untuk meramal daripada s_x ;4 Minimumkan kandungan maklumat yang digunakan untuk meramalkan pembolehubah terpendam z.

Rajah di bawah ialah seni bina yang mungkin untuk ramalan keadaan dunia pada berbilang peringkat dan berskala. Pembolehubah x_0, x_1, x_2 mewakili urutan pemerhatian. Rangkaian peringkat pertama, yang dilambangkan JEPA-1, menggunakan perwakilan peringkat rendah untuk melaksanakan ramalan jangka pendek. Rangkaian tahap kedua JEPA-2 menggunakan perwakilan peringkat tinggi untuk ramalan jangka panjang. Orang boleh membayangkan jenis seni bina ini mempunyai banyak lapisan, mungkin menggunakan konvolusi dan modul lain, dan menggunakan pengumpulan temporal antara peringkat untuk memberikan perwakilan berbutir kasar dan melaksanakan ramalan jangka panjang. Latihan boleh dilakukan secara peringkat atau secara global menggunakan mana-mana kaedah bukan kontras JEPA.

Rajah di bawah ialah seni bina yang mungkin untuk ramalan keadaan dunia pada berbilang peringkat dan berskala. Pembolehubah x_0, x_1, x_2 mewakili urutan pemerhatian. Rangkaian peringkat pertama, yang dilambangkan JEPA-1, menggunakan perwakilan peringkat rendah untuk melaksanakan ramalan jangka pendek. Rangkaian tahap kedua JEPA-2 menggunakan perwakilan peringkat tinggi untuk ramalan jangka panjang. Orang boleh membayangkan jenis seni bina ini mempunyai banyak lapisan, mungkin menggunakan konvolusi dan modul lain, dan menggunakan pengumpulan temporal antara peringkat untuk memberikan perwakilan berbutir kasar dan melaksanakan ramalan jangka panjang. Latihan boleh dilakukan secara peringkat atau secara global menggunakan mana-mana kaedah bukan kontras JEPA.

Perancangan hierarki adalah sukar, terdapat sedikit penyelesaian, dan kebanyakannya memerlukan kata-kata pengantara bagi tindakan yang telah ditetapkan. Rajah berikut menunjukkan peringkat perancangan hierarki di bawah ketidakpastian:

Perancangan hierarki adalah sukar, terdapat sedikit penyelesaian, dan kebanyakannya memerlukan kata-kata pengantara bagi tindakan yang telah ditetapkan. Rajah berikut menunjukkan peringkat perancangan hierarki di bawah ketidakpastian:

Apakah langkah ke arah sistem AI autonomi? LeCun juga memberikan ideanya sendiri:

Apakah langkah ke arah sistem AI autonomi? LeCun juga memberikan ideanya sendiri:

Mempelajari perwakilan dunia

- Mempelajari model ramalan. dunia

Seni bina ramalan tertanam bersama

- Rangka kerja model tenaga

Seperti haiwan dan bayi manusia?

Serasi dengan pembelajaran berasaskan kecerunan

- Tiada simbol, tiada logik → vektor dan berterusan Fungsi

- Beberapa sangkaan lain termasuk:

- Ramalan adalah intipati kecerdasan: pembelajaran model ramalan dunia adalah asas akal sehat

- Hampir semua dipelajari melalui pembelajaran penyeliaan kendiri: ciri peringkat rendah, ruang, objek, Fizik, perwakilan abstrak...; hampir tiada apa yang dipelajari melalui peneguhan, penyeliaan atau peniruan

- Inferens = simulasi/ramalan + pengoptimuman matlamat: secara pengiraan lebih berkuasa daripada penjanaan autoregresif.

- H-JEPA dan latihan bukan kontrastif adalah seperti ini: model generatif probabilistik dan kaedah kontrastif ditakdirkan untuk gagal.

- Kos intrinsik dan seni bina memacu gelagat dan tentukan perkara yang dipelajari

- Emosi ialah satu sine qua non untuk kecerdasan autonomi: jangkaan hasil daripada pengkritik atau model dunia + kos intrinsik.

Akhirnya, LeCun merumuskan cabaran semasa penyelidikan AI: (Bacaan yang disyorkan: Ringkasan pemikiran 10 tahun, pemenang Anugerah Turing Yann LeCun menunjukkan hala tuju generasi AI: Autonomous Machine Intelligence)

- Cari kaedah umum untuk melatih model dunia berasaskan H-JEPA daripada video, imej, audio, teks

- Kos alternatif reka bentuk untuk memacu pembelajaran H-JEPA Perwakilan yang relevan (ramalan hanyalah salah satu daripadanya); kaedah berasaskan, carian rasuk, MCTS....) Prosedur inferens reka bentuk perancangan hierarki;

- Adakah GPT-4 boleh dilaksanakan?

- Sudah tentu, idea LeCun mungkin tidak memenangi sokongan semua orang. Sekurang-kurangnya, kami pernah mendengar bunyi bising.

- Selepas ucapan itu, seseorang berkata bahawa GPT-4 telah mencapai kemajuan besar dalam "masalah gear" yang dicadangkan oleh LeCun dan memberikan prestasi generalisasinya. Tanda-tanda awal kelihatan kebanyakannya baik:

Apakah maksudnya? "Keupayaan potensi LLM, dan terutamanya GPT-4, mungkin jauh lebih besar daripada yang kita sedar, dan selalunya adalah satu kesilapan untuk bertaruh bahawa mereka tidak akan dapat melakukan sesuatu pada masa hadapan. Jika anda menggunakan gesaan yang betul, mereka sebenarnya boleh melakukannya berikan hasil yang betul. Jawapannya...

Dalam percubaan yang diumumkan oleh netizen, kebanyakan orang yang mendapat jawapan yang betul memberikan gesaan yang sangat kaya, manakala yang lain lambat. untuk bertindak balas. Bolehkah "kejayaan" seperti ini diulangi. Ia boleh dilihat bahawa keupayaan GPT-4 juga "berkedip", dan penerokaan had atas tahap kecerdasannya akan berterusan untuk beberapa waktu.

Atas ialah kandungan terperinci Adakah laluan penyelidikan GPT-4 tiada harapan? Yann LeCun menjatuhkan hukuman mati kepada Zi Hui. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1385

1385

52

52

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Perintah shutdown CentOS adalah penutupan, dan sintaks adalah tutup [pilihan] [maklumat]. Pilihan termasuk: -h menghentikan sistem dengan segera; -P mematikan kuasa selepas penutupan; -r mulakan semula; -T Waktu Menunggu. Masa boleh ditentukan sebagai segera (sekarang), minit (minit), atau masa tertentu (HH: mm). Maklumat tambahan boleh dipaparkan dalam mesej sistem.

Apakah kaedah sandaran untuk gitlab di centos

Apr 14, 2025 pm 05:33 PM

Apakah kaedah sandaran untuk gitlab di centos

Apr 14, 2025 pm 05:33 PM

Dasar sandaran dan pemulihan Gitlab di bawah sistem CentOS untuk memastikan keselamatan data dan pemulihan, Gitlab pada CentOS menyediakan pelbagai kaedah sandaran. Artikel ini akan memperkenalkan beberapa kaedah sandaran biasa, parameter konfigurasi dan proses pemulihan secara terperinci untuk membantu anda menubuhkan strategi sandaran dan pemulihan GitLab lengkap. 1. Backup Manual Gunakan Gitlab-Rakegitlab: Backup: Buat Perintah untuk Melaksanakan Backup Manual. Perintah ini menyokong maklumat utama seperti repositori Gitlab, pangkalan data, pengguna, kumpulan pengguna, kunci, dan kebenaran. Fail sandaran lalai disimpan dalam direktori/var/opt/gitlab/sandaran. Anda boleh mengubah suai /etc /gitlab

Cara Memeriksa Konfigurasi HDFS CentOS

Apr 14, 2025 pm 07:21 PM

Cara Memeriksa Konfigurasi HDFS CentOS

Apr 14, 2025 pm 07:21 PM

Panduan Lengkap untuk Memeriksa Konfigurasi HDFS Dalam Sistem CentOS Artikel ini akan membimbing anda bagaimana untuk memeriksa konfigurasi dan menjalankan status HDFS secara berkesan pada sistem CentOS. Langkah -langkah berikut akan membantu anda memahami sepenuhnya persediaan dan operasi HDFS. Sahkan Pembolehubah Alam Sekitar Hadoop: Pertama, pastikan pembolehubah persekitaran Hadoop ditetapkan dengan betul. Di terminal, laksanakan arahan berikut untuk mengesahkan bahawa Hadoop dipasang dan dikonfigurasi dengan betul: Hadoopversion Semak fail konfigurasi HDFS: Fail konfigurasi teras HDFS terletak di/etc/hadoop/conf/direktori, di mana core-site.xml dan hdfs-site.xml adalah kritikal. gunakan

Bagaimana sokongan GPU untuk Pytorch di CentOS

Apr 14, 2025 pm 06:48 PM

Bagaimana sokongan GPU untuk Pytorch di CentOS

Apr 14, 2025 pm 06:48 PM

Membolehkan pecutan GPU pytorch pada sistem CentOS memerlukan pemasangan cuda, cudnn dan GPU versi pytorch. Langkah-langkah berikut akan membimbing anda melalui proses: Pemasangan CUDA dan CUDNN Tentukan keserasian versi CUDA: Gunakan perintah NVIDIA-SMI untuk melihat versi CUDA yang disokong oleh kad grafik NVIDIA anda. Sebagai contoh, kad grafik MX450 anda boleh menyokong CUDA11.1 atau lebih tinggi. Muat turun dan pasang Cudatoolkit: Lawati laman web rasmi Nvidiacudatoolkit dan muat turun dan pasang versi yang sepadan mengikut versi CUDA tertinggi yang disokong oleh kad grafik anda. Pasang Perpustakaan Cudnn:

Penjelasan terperinci mengenai Prinsip Docker

Apr 14, 2025 pm 11:57 PM

Penjelasan terperinci mengenai Prinsip Docker

Apr 14, 2025 pm 11:57 PM

Docker menggunakan ciri -ciri kernel Linux untuk menyediakan persekitaran berjalan yang cekap dan terpencil. Prinsip kerjanya adalah seperti berikut: 1. Cermin digunakan sebagai templat baca sahaja, yang mengandungi semua yang anda perlukan untuk menjalankan aplikasi; 2. Sistem Fail Kesatuan (Unionfs) menyusun pelbagai sistem fail, hanya menyimpan perbezaan, menjimatkan ruang dan mempercepatkan; 3. Daemon menguruskan cermin dan bekas, dan pelanggan menggunakannya untuk interaksi; 4. Ruang nama dan cgroups melaksanakan pengasingan kontena dan batasan sumber; 5. Pelbagai mod rangkaian menyokong interkoneksi kontena. Hanya dengan memahami konsep -konsep teras ini, anda boleh menggunakan Docker dengan lebih baik.

CentOS memasang MySQL

Apr 14, 2025 pm 08:09 PM

CentOS memasang MySQL

Apr 14, 2025 pm 08:09 PM

Memasang MySQL pada CentOS melibatkan langkah -langkah berikut: Menambah sumber MySQL YUM yang sesuai. Jalankan YUM Pasang Perintah MySQL-Server untuk memasang pelayan MySQL. Gunakan perintah mysql_secure_installation untuk membuat tetapan keselamatan, seperti menetapkan kata laluan pengguna root. Sesuaikan fail konfigurasi MySQL seperti yang diperlukan. Tune parameter MySQL dan mengoptimumkan pangkalan data untuk prestasi.

Cara Melihat Log Gitlab Di Bawah Centos

Apr 14, 2025 pm 06:18 PM

Cara Melihat Log Gitlab Di Bawah Centos

Apr 14, 2025 pm 06:18 PM

Panduan Lengkap untuk Melihat Log Gitlab Di bawah Sistem CentOS Artikel ini akan membimbing anda bagaimana untuk melihat pelbagai log Gitlab dalam sistem CentOS, termasuk log utama, log pengecualian, dan log lain yang berkaitan. Sila ambil perhatian bahawa laluan fail log mungkin berbeza -beza bergantung pada versi GitLab dan kaedah pemasangan. Jika laluan berikut tidak wujud, sila semak fail Direktori Pemasangan dan Konfigurasi GitLab. 1. Lihat log Gitlab utama Gunakan arahan berikut untuk melihat fail log utama aplikasi GitLabRails: Perintah: Sudocat/var/Log/Gitlab/Gitlab-Rails/Production.log Perintah ini akan memaparkan produk

Cara Mengendalikan Latihan Pittorch Diagihkan di Centos

Apr 14, 2025 pm 06:36 PM

Cara Mengendalikan Latihan Pittorch Diagihkan di Centos

Apr 14, 2025 pm 06:36 PM

Latihan yang diedarkan Pytorch pada sistem CentOS memerlukan langkah -langkah berikut: Pemasangan Pytorch: Premisnya ialah Python dan PIP dipasang dalam sistem CentOS. Bergantung pada versi CUDA anda, dapatkan arahan pemasangan yang sesuai dari laman web rasmi Pytorch. Untuk latihan CPU sahaja, anda boleh menggunakan arahan berikut: PipinstallToRchTorchVisionTorchaudio Jika anda memerlukan sokongan GPU, pastikan versi CUDA dan CUDNN yang sama dipasang dan gunakan versi pytorch yang sepadan untuk pemasangan. Konfigurasi Alam Sekitar Teragih: Latihan yang diedarkan biasanya memerlukan pelbagai mesin atau mesin berbilang mesin tunggal. Tempat