Peranti teknologi

Peranti teknologi

AI

AI

Anda boleh meneka filem berdasarkan emotikon Dari manakah datangnya keupayaan 'kemunculan' ChatGPT?

Anda boleh meneka filem berdasarkan emotikon Dari manakah datangnya keupayaan 'kemunculan' ChatGPT?

Anda boleh meneka filem berdasarkan emotikon Dari manakah datangnya keupayaan 'kemunculan' ChatGPT?

Sekarang model bahasa besar seperti ChatGPT cukup berkuasa, model tersebut telah mula menunjukkan tingkah laku yang mengejutkan dan tidak dapat diramalkan.

Sebelum kami memperkenalkan artikel ini secara rasmi, mari kita ajukan soalan: Apakah filem yang digambarkan oleh emotikon dalam gambar di bawah?

Anda mungkin tidak dapat menekanya. Filem yang diwakili oleh empat simbol ini ialah "Finding Nemo". ) 204 tahun lepas. Untuk model LLM yang paling mudah, jawapan yang diberikan adalah agak rawak, dan ia berpendapat bahawa filem ini mengisahkan seorang lelaki untuk model bersaiz sederhana yang agak kompleks, jawapan yang diberikan adalah "The Emoji Movie". . Tetapi model yang paling kompleks meneka dengan betul, memberikan jawapan "Mencari Nemo."

Saintis komputer Google Ethan Dyer berkata: "Tingkah laku model ini mengejutkan. Apa yang lebih mengejutkan ialah model ini hanya menggunakan arahan: iaitu, mereka menerima rentetan teks sebagai input dan kemudian meramalkan apa akan berlaku seterusnya, dan terus mengulangi proses ini berdasarkan statistik sepenuhnya." banyak tugas baru dan tidak dapat diramalkan.

Tinjauan terbaru yang dijalankan oleh Ethan Dyer menunjukkan bahawa LLM boleh mencipta beratus-ratus keupayaan "muncul", iaitu keupayaan model besar untuk menyelesaikan tugas tertentu yang model kecil tidak dapat diselesaikan. Jelas sekali, keupayaan untuk menskalakan model meningkat, daripada pendaraban mudah kepada penjanaan kod komputer boleh laku kepada penyahkodan filem berdasarkan emoji. Analisis baharu menunjukkan bahawa untuk tugasan tertentu dan model tertentu, terdapat ambang kerumitan di atasnya yang mana keupayaan model meroket. Walau bagaimanapun, penyelidik juga menunjukkan kesan negatif penskalaan model, iaitu, apabila kerumitan meningkat, sesetengah model mempamerkan berat sebelah dan ketidaktepatan baharu dalam respons mereka.

"Dalam semua kesusasteraan yang saya ketahui, tidak pernah ada sebarang perbincangan tentang model bahasa yang melakukan perkara ini," kata Rishi Bommasani, seorang saintis komputer di Universiti Stanford yang membantu menyusun dokumen tahun lepas yang merangkumi berpuluh-puluh model. Senarai tingkah laku yang muncul, termasuk beberapa yang dikenal pasti dalam projek Ethan Dyer. Hari ini, senarai itu terus berkembang.

Hari ini, penyelidik berlumba bukan sahaja untuk menentukan keupayaan kemunculan model besar, tetapi juga untuk memahami sebab dan cara ia berlaku—pada asasnya cuba meramalkan ketidakpastian. Memahami sifat kemunculannya boleh mendedahkan jawapan kepada soalan mendalam yang berkaitan dengan kecerdasan buatan dan pembelajaran mesin, seperti sama ada model yang kompleks sebenarnya melakukan sesuatu yang baharu atau hanya menjadi sangat mahir dalam statistik. Selain itu, ia boleh membantu penyelidik mengeksploitasi potensi manfaat dan mengurangkan risiko yang muncul.

Kemunculan secara tiba-tiba

Ahli biologi, ahli fizik, ahli ekologi dan saintis lain menggunakan istilah kemunculan untuk menggambarkan kolektif penyusunan diri yang berlaku apabila sekumpulan besar perkara bertindak sebagai satu unit tingkah laku seksual. Gabungan atom-atom tidak bernyawa menghasilkan sel-sel yang hidup; molekul air mencipta gelombang; Yang penting, keupayaan yang timbul berlaku dalam sistem yang melibatkan banyak bahagian bebas. Tetapi penyelidik baru-baru ini dapat mendokumentasikan kuasa yang muncul ini dalam LLM kerana model baru sahaja berkembang kepada skala yang cukup besar.

Model bahasa telah wujud selama beberapa dekad. Sehingga kira-kira lima tahun yang lalu, model yang paling berkuasa adalah berdasarkan rangkaian saraf berulang. Model ini pada asasnya mengambil rentetan teks dan meramalkan perkataan seterusnya. Apa yang menjadikan gelung model ialah ia belajar daripada outputnya sendiri: ramalannya disalurkan semula ke dalam rangkaian untuk meningkatkan prestasi masa hadapan.

Pada 2017, penyelidik di Google Brain memperkenalkan seni bina baharu yang dipanggil Transformer. Walaupun rangkaian berulang menganalisis perkataan ayat demi perkataan, Transformer memproses semua perkataan secara serentak. Ini bermakna Transformer boleh memproses sejumlah besar teks secara selari.

"Kemungkinan model itu mempelajari sesuatu yang pada asasnya baharu dan berbeza yang tidak dipelajari pada model yang lebih kecil," kata Ellie Pavlick dari Universiti Brown.

Transformer boleh meningkatkan kerumitan model bahasa dengan cepat dengan meningkatkan bilangan parameter dalam model, antara faktor lain. Parameter ini boleh dianggap sebagai sambungan antara perkataan, dan dengan merombak teks semasa latihan, transformer boleh melaraskan sambungan ini untuk menambah baik model. Lebih banyak parameter yang terdapat dalam model, lebih tepat ia boleh membuat sambungan dan lebih dekat untuk meniru pertuturan manusia. Seperti yang dijangkakan, analisis 2020 oleh penyelidik OpenAI mendapati bahawa model meningkatkan ketepatan dan kuasa semasa skala.

Tetapi kemunculan model bahasa berskala besar juga membawa banyak perkara yang benar-benar tidak dijangka. Dengan kemunculan model seperti GPT-3, yang mempunyai 175 bilion parameter, atau Google PaLM, yang berskala kepada 540 bilion parameter, pengguna mula menerangkan semakin banyak gelagat yang muncul. Seorang jurutera DeepMind malah melaporkan dapat meyakinkan ChatGPT untuk mengakui ia adalah terminal Linux dan menjalankan beberapa kod matematik mudah untuk mengira 10 nombor perdana pertama. Terutama, ia menyelesaikan tugas dengan lebih cepat daripada menjalankan kod yang sama pada peranti Linux sebenar.

Seperti tugas menggambarkan filem melalui emoji, para penyelidik tidak mempunyai sebab untuk berfikir bahawa model bahasa yang dibina untuk meramalkan teks akan dipujuk untuk digunakan untuk meniru terminal komputer. Kebanyakan tingkah laku yang timbul ini menunjukkan pembelajaran sifar atau beberapa pukulan, dan ia menggambarkan keupayaan LLM untuk menyelesaikan masalah yang tidak pernah (atau jarang) dihadapi sebelum ini. Ini telah menjadi matlamat jangka panjang penyelidikan kecerdasan buatan, kata Ganguli. Ia juga menunjukkan bahawa GPT-3 boleh menyelesaikan masalah dalam tetapan sifar tanpa sebarang data latihan yang jelas, kata Ganguli "Ia membuatkan saya berhenti daripada apa yang saya lakukan dan lebih terlibat dalam penyelidikan ini." bukan sahaja dalam bidang penyelidikan ini. Petunjuk pertama bahawa LLM boleh mengatasi batasan data latihan mereka telah ditemui oleh sebilangan besar penyelidik, yang berusaha untuk memahami dengan lebih baik rupa kemunculan dan cara ia berlaku. Dan langkah pertama ialah mendokumentasikannya secara menyeluruh dan menyeluruh.

Ethan Dyer membantu meneroka keupayaan yang tidak dijangka yang dimiliki oleh model bahasa besar dan perkara yang dibawa ke meja. -Gabrielle Lurie

Melangkaui Peniruan

Pada tahun 2020, Dyer dan penyelidik lain di Google Research meramalkan bahawa model bahasa yang besar akan mempunyai kesan transformatif—tetapi kesan tersebut adalah Apa yang kekal soalan terbuka. Oleh itu, mereka meminta komuniti penyelidik untuk memberikan contoh tugas yang sukar dan pelbagai untuk mendokumentasikan had luar perkara yang boleh dilakukan oleh LLM penjejakan. Usaha itu, yang dikenali sebagai projek BIG-bench (Beyond the Imitation Game Benchmark), meminjam namanya daripada permainan tiruan Alan Turing, direka untuk menguji sama ada komputer boleh menjawab soalan dengan cara yang meyakinkan manusia. (Ini kemudiannya dikenali sebagai ujian Turing.) Kumpulan penyelidik amat berminat dengan contoh LLM yang tiba-tiba memperoleh keupayaan baharu dan belum pernah berlaku sebelum ini.

Seperti yang dijangkakan, dalam sesetengah tugas, prestasi model bertambah baik dengan lebih konsisten dan boleh diramalkan apabila kerumitan meningkat. Pada tugas lain, mengembangkan bilangan parameter tidak menghasilkan sebarang peningkatan dalam prestasi model. Dan untuk kira-kira 5 peratus daripada tugasan, para penyelidik menemui apa yang mereka panggil sebagai satu kejayaan—lompatan pantas dan dramatik dalam prestasi melebihi ambang tertentu. Walau bagaimanapun, ambang ini berbeza-beza bergantung pada tugas dan model.

Sebagai contoh, model dengan parameter yang agak sedikit (hanya beberapa juta) mungkin tidak berjaya menyelesaikan penambahan tiga digit atau masalah pendaraban dua digit, tetapi dengan berpuluh bilion parameter, beberapa model Ketepatan pengiraan akan meningkat. Lompatan prestasi yang serupa dilihat pada beberapa tugas lain, termasuk menyahkod Abjad Fonetik Antarabangsa, mentafsir huruf perkataan, mengenal pasti kandungan yang menyinggung dalam petikan dalam Hinglish (gabungan bahasa Hindi dan Inggeris), dan menjana teks yang berkaitan dengan Swahili Peribahasa Inggeris setara.

Walau bagaimanapun, penyelidik segera menyedari bahawa kerumitan model itu bukan satu-satunya pemacu prestasinya. Jika kualiti data cukup tinggi, beberapa keupayaan yang tidak dijangka boleh didorong daripada model yang lebih kecil dengan parameter yang lebih sedikit atau dilatih pada set data yang lebih kecil. Selain itu, cara pertanyaan diperkatakan boleh menjejaskan ketepatan respons model. Contohnya, apabila Dyer dan rakan sekerja menggunakan format aneka pilihan untuk tugasan emoji filem, ketepatan tidak bertambah baik dalam lompatan mendadak tetapi bertambah baik secara beransur-ansur apabila kerumitan model meningkat. Tahun lepas, dalam kertas kerja yang dibentangkan di NeurIPS, persidangan akademik teratas dalam bidang itu, penyelidik di Google Brain menunjukkan cara model dengan gesaan boleh menerangkan dirinya sendiri (keupayaan yang dikenali sebagai penaakulan rantaian-pemikiran dengan betul menyelesaikan masalah perkataan matematik). bahawa model yang sama tanpa gesaan tidak akan dapat diselesaikan.

Sehingga anda mengkaji kesan saiz model, anda tidak akan tahu apakah keupayaan yang mungkin ada dan apakah kelemahannya.

Yi Tay, seorang saintis penyelidikan sistematik di Google Brain, menegaskan bahawa penyelidikan baru-baru ini menunjukkan bahawa gesaan rantaian pemikiran mengubah keluk pengembangan, dengan itu mengubah nod tempat model itu muncul. Dalam kertas NeurIPS mereka, penyelidik Google menunjukkan bahawa menggunakan gesaan rantaian pemikiran boleh menimbulkan tingkah laku yang tidak dikenal pasti dalam kajian BIG-bench. Gesaan sedemikian, yang memerlukan model untuk menerangkan alasan mereka, boleh membantu penyelidik mula menyiasat mengapa kemunculan berlaku.

Penemuan terbaru ini mencadangkan sekurang-kurangnya dua kemungkinan mengapa kemunculan berlaku, kata Ellie Pavlick, seorang saintis komputer di Universiti Brown yang mengkaji model pengiraan bahasa. Kemungkinan pertama ialah model yang lebih besar memperoleh keupayaan baru secara spontan, seperti yang dicadangkan perbandingan dengan sistem biologi. Mungkin model itu mempelajari sesuatu yang benar-benar baharu dan berbeza yang tidak ada pada model berskala lebih kecil, itulah yang kita semua harapkan, bahawa sesuatu yang asas berlaku apabila model diperbesarkan perubahan.

Ellie Pavlick juga menyatakan bahawa satu lagi kemungkinan yang agak normal dan objektif ialah apa yang kelihatan muncul sebaliknya mungkin merupakan kemuncak proses didorong statistik dalaman yang beroperasi melalui penaakulan rantaian pemikiran. LLM yang besar mungkin hanya mempelajari heuristik yang tidak dapat difahami oleh model yang lebih kecil dengan parameter yang lebih sedikit atau data kualiti yang lebih rendah.

Walau bagaimanapun, Pavlick percaya bahawa kerana kami tidak tahu cara model asas berfungsi, kami tidak dapat memberitahu apa yang berlaku.

Keupayaan dan kelemahan yang tidak dapat diramalkan

Tetapi model besar juga mempunyai kelemahan, seperti Bard, robot sembang kecerdasan buatan yang dilancarkan oleh Google suatu ketika dahulu, semasa menjawab soalan berkaitan James Webb Space Telescope Make kesilapan fakta.

Kemunculan membawa kepada ketidakpastian, dan ketidakpastian — yang nampaknya meningkat apabila saiz model meningkat — sukar untuk dikawal oleh penyelidik.

"Sukar untuk mengetahui lebih awal cara model ini akan digunakan atau digunakan," kata Ganguli. "Untuk mengkaji fenomena kemunculan, anda perlu mempertimbangkan situasi di mana anda tidak akan mengetahui keupayaan yang mungkin ada dan kelemahannya sehingga anda mengkaji kesan saiz model." Dalam analisis LLM, penyelidik Anthropic meneliti sama ada model ini mempamerkan jenis berat sebelah kaum atau sosial tertentu, tidak seperti algoritma sebelumnya yang tidak berdasarkan LLM dan digunakan untuk meramalkan bekas pesalah yang mungkin akan melakukan kesalahan semula. Penyelidikan ini diilhamkan oleh paradoks yang jelas berkaitan secara langsung dengan kemunculan: Apabila model meningkatkan prestasi apabila ia meningkat, mereka juga boleh meningkatkan kemungkinan fenomena yang tidak dapat diramalkan, termasuk yang mungkin membawa kepada berat sebelah atau menyebabkan bahaya.

"Gelagat berbahaya tertentu akan muncul dalam model tertentu," kata Ganguli. Dia menunjuk kepada analisis terbaru LLM - juga dikenali sebagai penanda aras BBQ - yang menunjukkan bahawa berat sebelah sosial muncul merentasi pelbagai parameter. "Model yang lebih besar tiba-tiba menjadi lebih berat sebelah," katanya, satu risiko yang boleh menjejaskan penggunaan model ini jika tidak ditangani.

Tetapi dia juga membuat jawapan balas: Apabila penyelidik hanya memberitahu model supaya tidak bergantung pada stereotaip atau berat sebelah sosial — secara literal, dengan memberi mereka arahan ini, model meningkatkan ramalan dan respons mereka. Biasnya lebih kecil. Ini menunjukkan bahawa beberapa sifat yang timbul juga boleh digunakan untuk mengurangkan berat sebelah. Dalam kertas kerja yang diterbitkan pada bulan Februari, pasukan Anthropic melaporkan mod pembetulan kendiri moral baharu di mana pengguna menggesa program untuk membantu, jujur dan tidak berbahaya.

Ganguli berkata kemunculan mendedahkan kedua-dua potensi menakjubkan model bahasa besar dan risikonya yang tidak dapat diramalkan. Aplikasi LLM ini telah berkembang pesat, jadi pemahaman yang lebih baik tentang dualiti ini akan membantu mengeksploitasi kepelbagaian keupayaan model bahasa.

Ganguli berkata: "Kami sedang mengkaji cara pengguna sebenarnya menggunakan sistem ini, tetapi mereka juga sentiasa memikirkan dan menambah baik sistem ini. Kami menghabiskan banyak masa hanya berbual dengan model kami dan menggunakannya. Ia berfungsi dengan lebih baik dan ketika itulah kami mula mempercayai model ini."

Atas ialah kandungan terperinci Anda boleh meneka filem berdasarkan emotikon Dari manakah datangnya keupayaan 'kemunculan' ChatGPT?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1382

1382

52

52

ChatGPT kini membenarkan pengguna percuma menjana imej dengan menggunakan DALL-E 3 dengan had harian

Aug 09, 2024 pm 09:37 PM

ChatGPT kini membenarkan pengguna percuma menjana imej dengan menggunakan DALL-E 3 dengan had harian

Aug 09, 2024 pm 09:37 PM

DALL-E 3 telah diperkenalkan secara rasmi pada September 2023 sebagai model yang jauh lebih baik daripada pendahulunya. Ia dianggap sebagai salah satu penjana imej AI terbaik setakat ini, mampu mencipta imej dengan perincian yang rumit. Walau bagaimanapun, semasa pelancaran, ia adalah tidak termasuk

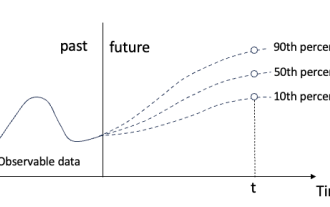

Regresi kuantil untuk ramalan kebarangkalian siri masa

May 07, 2024 pm 05:04 PM

Regresi kuantil untuk ramalan kebarangkalian siri masa

May 07, 2024 pm 05:04 PM

Jangan ubah maksud kandungan asal, perhalusi kandungan, tulis semula kandungan dan jangan teruskan. "Regression kuantil memenuhi keperluan ini, menyediakan selang ramalan dengan peluang yang dikira. Ia adalah teknik statistik yang digunakan untuk memodelkan hubungan antara pembolehubah peramal dan pembolehubah tindak balas, terutamanya apabila taburan bersyarat pembolehubah tindak balas adalah menarik Apabila. Tidak seperti regresi tradisional kaedah, regresi kuantil memfokuskan pada menganggar magnitud bersyarat pembolehubah bergerak balas dan bukannya min bersyarat "Rajah (A): Regresi kuantil Regresi kuantil ialah anggaran. Kaedah pemodelan untuk hubungan linear antara set regresi X dan kuantil. daripada pembolehubah yang dijelaskan Y. Model regresi yang sedia ada sebenarnya adalah kaedah untuk mengkaji hubungan antara pembolehubah yang dijelaskan dan pembolehubah penjelasan. Mereka memberi tumpuan kepada hubungan antara pembolehubah penjelasan dan pembolehubah yang dijelaskan

SIMPL: Penanda aras ramalan gerakan berbilang ejen yang mudah dan cekap untuk pemanduan autonomi

Feb 20, 2024 am 11:48 AM

SIMPL: Penanda aras ramalan gerakan berbilang ejen yang mudah dan cekap untuk pemanduan autonomi

Feb 20, 2024 am 11:48 AM

Tajuk asal: SIMPL: ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving Paper pautan: https://arxiv.org/pdf/2402.02519.pdf Pautan kod: https://github.com/HKUST-Aerial-Robotics/SIMPL Unit pengarang: Universiti Sains Hong Kong dan Teknologi Idea Kertas DJI: Kertas kerja ini mencadangkan garis dasar ramalan pergerakan (SIMPL) yang mudah dan cekap untuk kenderaan autonomi. Berbanding dengan agen-sen tradisional

Gabungan sempurna ChatGPT dan Python: mencipta chatbot perkhidmatan pelanggan yang pintar

Oct 27, 2023 pm 06:00 PM

Gabungan sempurna ChatGPT dan Python: mencipta chatbot perkhidmatan pelanggan yang pintar

Oct 27, 2023 pm 06:00 PM

Gabungan sempurna ChatGPT dan Python: Mencipta Perkhidmatan Pelanggan Pintar Chatbot Pengenalan: Dalam era maklumat hari ini, sistem perkhidmatan pelanggan pintar telah menjadi alat komunikasi yang penting antara perusahaan dan pelanggan. Untuk memberikan pengalaman perkhidmatan pelanggan yang lebih baik, banyak syarikat telah mula beralih kepada chatbots untuk menyelesaikan tugas seperti perundingan pelanggan dan menjawab soalan. Dalam artikel ini, kami akan memperkenalkan cara menggunakan bahasa ChatGPT dan Python model OpenAI yang berkuasa untuk mencipta bot sembang perkhidmatan pelanggan yang pintar untuk meningkatkan

Bagaimana untuk memasang chatgpt pada telefon bimbit

Mar 05, 2024 pm 02:31 PM

Bagaimana untuk memasang chatgpt pada telefon bimbit

Mar 05, 2024 pm 02:31 PM

Langkah pemasangan: 1. Muat turun perisian ChatGTP dari laman web rasmi ChatGTP atau kedai mudah alih 2. Selepas membukanya, dalam antara muka tetapan, pilih bahasa sebagai bahasa Cina 3. Dalam antara muka permainan, pilih permainan mesin manusia dan tetapkan Spektrum bahasa Cina; 4 Selepas memulakan, masukkan arahan dalam tetingkap sembang untuk berinteraksi dengan perisian.

Apakah perbezaan antara inferens AI dan latihan? Adakah awak tahu?

Mar 26, 2024 pm 02:40 PM

Apakah perbezaan antara inferens AI dan latihan? Adakah awak tahu?

Mar 26, 2024 pm 02:40 PM

Jika saya ingin merumuskan perbezaan antara latihan AI dan penaakulan dalam satu ayat, saya fikir "satu minit di atas pentas, sepuluh tahun kerja keras di luar pentas" adalah yang paling sesuai. Xiao Ming telah berkencan dengan dewi yang telah lama dia kagumi selama bertahun-tahun, dan dia mempunyai banyak pengalaman dalam teknik dan petua untuk mengajaknya keluar, tetapi dia masih keliru tentang misteri itu. Dengan bantuan teknologi AI, bolehkah ramalan yang tepat dicapai? Xiao Ming berfikir berulang kali dan merumuskan pembolehubah yang mungkin mempengaruhi sama ada dewi menerima jemputan: sama ada hari cuti, cuaca buruk, terlalu panas/sejuk, dalam mood yang tidak baik, sakit, dia ada temu janji lain, saudara mara sedang datang ke rumah... ..dll. Gambar menimbang dan menjumlahkan pembolehubah ini Jika ia lebih besar daripada ambang tertentu, dewi mesti menerima jemputan. Jadi, berapa banyak berat pembolehubah ini, dan apakah ambangnya? Ini adalah soalan yang sangat kompleks dan sukar untuk dijawab

Bagaimana untuk membangunkan chatbot pintar menggunakan ChatGPT dan Java

Oct 28, 2023 am 08:54 AM

Bagaimana untuk membangunkan chatbot pintar menggunakan ChatGPT dan Java

Oct 28, 2023 am 08:54 AM

Dalam artikel ini, kami akan memperkenalkan cara membangunkan chatbot pintar menggunakan ChatGPT dan Java, dan menyediakan beberapa contoh kod khusus. ChatGPT ialah versi terkini Generative Pre-training Transformer yang dibangunkan oleh OpenAI, teknologi kecerdasan buatan berasaskan rangkaian saraf yang boleh memahami bahasa semula jadi dan menjana teks seperti manusia. Menggunakan ChatGPT kami boleh membuat sembang adaptif dengan mudah

Mempelajari pengetahuan penghunian rentas mod: RadOcc menggunakan teknologi penyulingan berbantukan pemaparan

Jan 25, 2024 am 11:36 AM

Mempelajari pengetahuan penghunian rentas mod: RadOcc menggunakan teknologi penyulingan berbantukan pemaparan

Jan 25, 2024 am 11:36 AM

Tajuk asal: Radocc: LearningCross-ModalityOccupancyKnowledge throughRenderingAssistedDistillation Paper pautan: https://arxiv.org/pdf/2312.11829.pdf Unit pengarang: FNii, CUHK-ShenzhenSSE, CUHK-Shenzhen Huawei Noah's Arkiv Paper 20 ialah Persidangan Precision AAAI2cy Paper 302:D tugas baru muncul yang bertujuan untuk menganggarkan keadaan penghunian dan semantik adegan 3D menggunakan imej berbilang paparan. Walau bagaimanapun, disebabkan kekurangan prior geometri, senario berasaskan imej