GPT4All ialah bot sembang yang dilatih berdasarkan sejumlah besar data pembantu bersih (termasuk kod, cerita dan perbualan Data termasuk ~800k keping data yang dijana GPT-3.5-Turbo Ia dilengkapkan berdasarkan LLaMa dan boleh digunakan dalam M1 Mac, Windows dan persekitaran lain Boleh dijalankan. Mungkin seperti namanya, masanya telah tiba apabila semua orang boleh menggunakan GPT peribadi.

Sejak OpenAI mengeluarkan ChatGPT, chatbots telah menjadi semakin popular sejak beberapa bulan kebelakangan ini.

Walaupun ChatGPT berkuasa, hampir mustahil untuk OpenAI membuka sumbernya. Ramai orang mengusahakan sumber terbuka, seperti LLaMA, yang bersumberkan terbuka oleh Meta suatu ketika dahulu. Ia adalah istilah umum untuk siri model dengan kuantiti parameter antara 7 bilion hingga 65 bilion Antaranya, model LLaMA 13 bilion parameter boleh mengatasi 175 bilion parameter GPT-3 "pada kebanyakan penanda aras".

Sumber terbuka LLaMA telah memberi manfaat kepada ramai penyelidik Sebagai contoh, Stanford menambah arahan penalaan kepada LLaMA dan melatih model 7 bilion parameter baharu yang dipanggil Alpaca (berdasarkan LLaMA 7B ). Keputusan menunjukkan bahawa prestasi Alpaca, model ringan dengan hanya parameter 7B, adalah setanding dengan model bahasa berskala sangat besar seperti GPT-3.5.

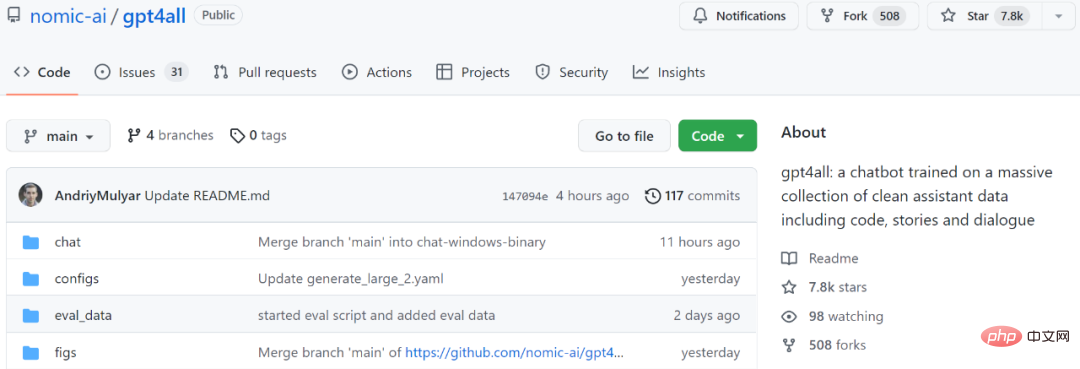

Untuk contoh lain, model yang akan kami perkenalkan seterusnya, GPT4All, juga merupakan model bahasa 7B baharu berdasarkan LLaMA. Dua hari selepas projek itu dilancarkan, bilangan Bintang telah melebihi 7.8k.

Alamat projek: https://github.com/nomic-ai/gpt4all

Ringkasnya, GPT4All mempunyai 800k dalam GPT-3.5- Latihan Turbo dilakukan pada kepingan data, termasuk soalan teks, penerangan cerita, berbilang pusingan dialog dan kod.

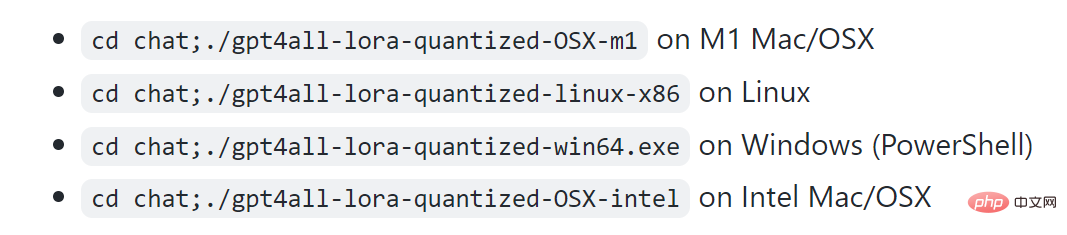

Menurut paparan projek, M1 boleh dijalankan dalam Mac, Windows dan persekitaran lain.

Mari kita lihat kesannya dahulu. Seperti yang ditunjukkan dalam rajah di bawah, pengguna boleh berkomunikasi dengan GPT4All tanpa sebarang halangan, seperti bertanya kepada model: "Bolehkah saya menjalankan model bahasa besar pada komputer riba jawapan GPT4All ialah: "Ya, anda boleh menggunakan komputer riba untuk melatih dan menguji rangkaian saraf Atau model pembelajaran mesin untuk bahasa semula jadi lain (seperti bahasa Inggeris atau Cina Yang penting, anda memerlukan memori tersedia (RAM) yang mencukupi untuk menampung saiz model ini..."

Seterusnya, jika anda tidak jelas Anda boleh terus bertanya kepada GPT4All berapa banyak memori yang diperlukan, dan ia akan memberikan jawapan. Berdasarkan keputusannya, keupayaan GPT4All untuk menjalankan beberapa pusingan dialog masih sangat kukuh.

Persampelan masa nyata pada M1 Mac

Sesetengah orang memanggil kajian ini "permainan-mengubah" Peraturan, dengan sokongan GPT4All, anda kini boleh menjalankan GPT secara setempat pada MacBook "

Serupa dengan GPT-4, GPT4All juga menyediakan "teknologi".

Alamat laporan teknikal: https://s3.amazonaws.com/static.nomic.ai/gpt4all/2023_GPT4All_Technical_Report.pdf

Permulaan teknikal ini laporan menerangkan secara ringkas butiran pembinaan GPT4All. Para penyelidik mendedahkan data yang dikumpul, prosedur perbalahan data, kod latihan dan pemberat model akhir untuk mempromosikan penyelidikan terbuka dan kebolehulangan Mereka juga mengeluarkan versi model 4-bit terkuantisasi, yang bermaksud hampir Sesiapa sahaja boleh menjalankan model pada CPU.

Seterusnya, mari lihat apa yang ditulis dalam laporan ini.

1 Pengumpulan dan organisasi data

Dalam tempoh dari 20 Mac 2023 hingga 26 Mac 2023, Penyelidik menggunakan. API OpenAI GPT-3.5-Turbo untuk mengumpulkan kira-kira 1 juta pasang respons segera.

Pertama, penyelidik mengumpul sampel soalan/gesaan yang berbeza dengan memanfaatkan tiga set data yang tersedia secara terbuka:

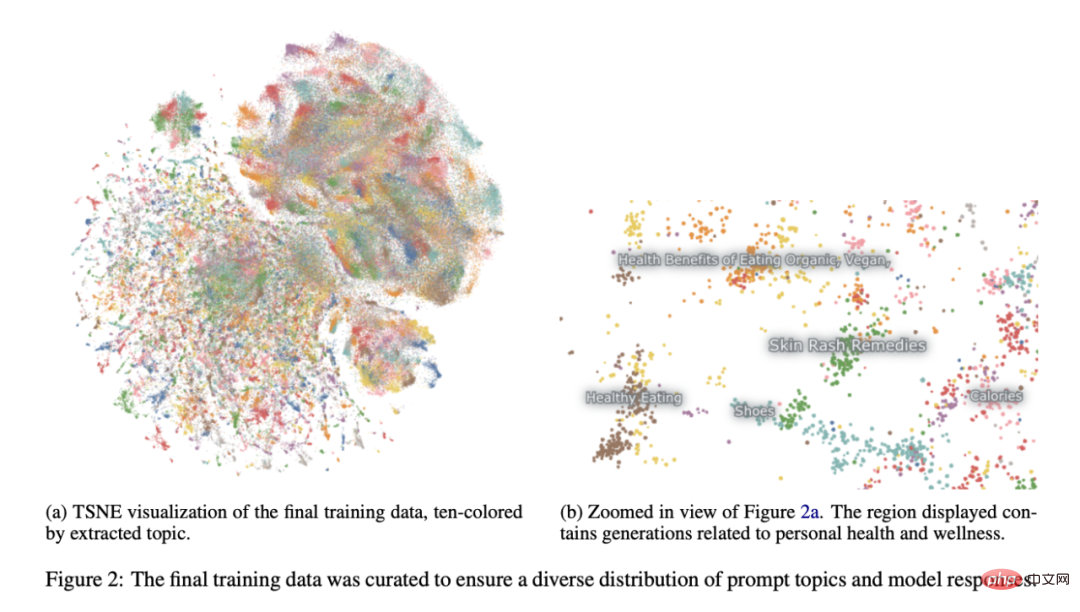

Merujuk kepada projek Alpaca Universiti Stanford (Taori et al., 2023), penyelidik telah memberi banyak perhatian kepada penyediaan dan organisasi data. Selepas mengumpul set data awal pasangan yang dijana dengan segera, mereka memuatkan data ke dalam Atlas untuk mengatur dan membersihkannya, mengalih keluar sebarang sampel yang GPT-3.5-Turbo gagal membalas gesaan dan menghasilkan output yang tidak betul. Ini mengurangkan jumlah sampel kepada 806199 pasangan yang dijana segera berkualiti tinggi. Seterusnya, kami mengalih keluar keseluruhan subset Bigscience/P3 daripada set data latihan akhir kerana kepelbagaian outputnya sangat rendah. P3 mengandungi banyak gesaan homogen yang menjana respons pendek dan homogen daripada GPT-3.5-Turbo.

Kaedah penyingkiran ini menghasilkan subset akhir sebanyak 437,605 pasangan yang dijana segera, seperti ditunjukkan dalam Rajah 2.

Latihan model

Para penyelidik menggabungkan beberapa model dalam contoh LLaMA 7B (Touvron et al., 2023) pelarasan. Model yang dikaitkan dengan keluaran awam awal mereka dilatih dengan LoRA (Hu et al., 2021) dalam 4 zaman pada 437,605 contoh pasca diproses. Hiperparameter model terperinci dan kod latihan boleh didapati dalam perpustakaan sumber yang berkaitan dan log latihan model.

Kebolehhasilan semula

Para penyelidik mengeluarkan semua data (termasuk generasi P3 yang tidak digunakan), kod latihan dan pemberat model untuk komuniti untuk menghasilkan semula. Penyelidik yang berminat boleh mencari data terkini, butiran latihan dan pusat pemeriksaan dalam repositori Git.

Kos

Penyelidik mengambil masa kira-kira empat hari untuk membuat model ini, dan kos GPU ialah $800 (disewa daripada Lambda Labs and Paperspace, termasuk beberapa latihan yang gagal) , sebagai tambahan kepada yuran API OpenAI $500.

Model keluaran terakhir, gpt4all-lora, boleh dilatih dalam kira-kira 8 jam pada DGX A100 8x 80GB Lambda Labs, dengan jumlah kos $100.

Model ini boleh dijalankan pada komputer riba biasa Bak kata seorang netizen, "Tiada kos kecuali bil elektrik." >

Para penyelidik menjalankan penilaian awal model menggunakan data penilaian manusia dalam kertas SelfInstruct (Wang et al., 2022). Laporan itu juga membandingkan kebingungan kebenaran asas model ini dengan model alpaca-lora awam yang paling terkenal (disumbangkan oleh chainyo pengguna huggingface). Mereka mendapati bahawa semua model mempunyai kebingungan yang sangat besar pada sebilangan kecil tugasan dan melaporkan kebingungan sehingga 100. Model yang diperhalusi pada set data yang dikumpul ini menunjukkan kebingungan yang lebih rendah dalam penilaian Arahan Kendiri berbanding dengan Alpaca. Para penyelidik mengatakan bahawa penilaian ini tidak menyeluruh, dan masih ada ruang untuk penilaian lanjut - mereka mengalu-alukan pembaca untuk menjalankan model pada CPU tempatan (dokumentasi tersedia di Github) dan mendapatkan pemahaman kualitatif tentang keupayaannya. Akhir sekali, adalah penting untuk ambil perhatian bahawa penulis menerbitkan data dan butiran latihan dengan harapan ia akan mempercepatkan penyelidikan LLM terbuka, terutamanya dalam bidang penjajaran dan kebolehtafsiran. GPT4Semua berat dan data model adalah untuk tujuan penyelidikan sahaja dan dilesenkan terhadap sebarang penggunaan komersial. GPT4All adalah berdasarkan LLaMA, yang mempunyai lesen bukan komersial. Data penolong dikumpul daripada GPT-3.5-Turbo OpenAI, yang syarat penggunaannya melarang pembangunan model yang bersaing secara komersial dengan OpenAI.

Akhir sekali, adalah penting untuk ambil perhatian bahawa penulis menerbitkan data dan butiran latihan dengan harapan ia akan mempercepatkan penyelidikan LLM terbuka, terutamanya dalam bidang penjajaran dan kebolehtafsiran. GPT4Semua berat dan data model adalah untuk tujuan penyelidikan sahaja dan dilesenkan terhadap sebarang penggunaan komersial. GPT4All adalah berdasarkan LLaMA, yang mempunyai lesen bukan komersial. Data penolong dikumpul daripada GPT-3.5-Turbo OpenAI, yang syarat penggunaannya melarang pembangunan model yang bersaing secara komersial dengan OpenAI.

Atas ialah kandungan terperinci Gantian untuk ChatGPT yang boleh dijalankan pada komputer riba ada di sini, dengan laporan teknikal penuh dilampirkan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Bahasa Komputer

Bahasa Komputer

Medan aplikasi komputer

Medan aplikasi komputer

Apakah pengekodan yang digunakan di dalam komputer untuk memproses data dan arahan?

Apakah pengekodan yang digunakan di dalam komputer untuk memproses data dan arahan?

Sebab utama mengapa komputer menggunakan binari

Sebab utama mengapa komputer menggunakan binari

Apakah ciri-ciri utama komputer?

Apakah ciri-ciri utama komputer?

Apakah komponen asas komputer?

Apakah komponen asas komputer?

Apakah kekunci yang dirujuk oleh anak panah dalam komputer?

Apakah kekunci yang dirujuk oleh anak panah dalam komputer?

Bagaimana untuk memulihkan sejarah penyemak imbas pada komputer

Bagaimana untuk memulihkan sejarah penyemak imbas pada komputer