Peranti teknologi

Peranti teknologi

AI

AI

PromptPG: Apabila pembelajaran peneguhan memenuhi model bahasa berskala besar

PromptPG: Apabila pembelajaran peneguhan memenuhi model bahasa berskala besar

PromptPG: Apabila pembelajaran peneguhan memenuhi model bahasa berskala besar

Penaakulan matematik ialah keupayaan teras kecerdasan manusia, tetapi pemikiran abstrak dan penaakulan logik masih menjadi cabaran besar bagi mesin. Model bahasa pra-latihan berskala besar, seperti GPT-3 dan GPT-4, telah mencapai kemajuan yang ketara dalam penaakulan matematik berasaskan teks (seperti masalah perkataan matematik). Walau bagaimanapun, pada masa ini tidak jelas sama ada model ini boleh mengendalikan masalah yang lebih kompleks yang melibatkan maklumat heterogen seperti data jadual. Untuk mengisi jurang ini, penyelidik dari UCLA dan Allen Institute for Artificial Intelligence (AI2) melancarkan Tabular Math Word Problems (TabMWP), set data 38,431 masalah domain terbuka yang memerlukan kedua-dua teks dan Lakukan penaakulan matematik pada data jadual untuk mendapatkan yang betul. jawab. Setiap soalan dalam TabMWP dikaitkan dengan konteks yang mengandungi imej, teks atau jadual dalam format berstruktur.

Para penyelidik menilai model pra-latihan yang berbeza pada TabMWP termasuk GPT-3 Few-shot. Seperti yang ditemui oleh penyelidikan sedia ada, Few-shot GPT-3 sangat bergantung pada pemilihan contoh dalam konteks, yang mengakibatkan prestasinya agak tidak stabil apabila contoh dipilih secara rawak. Ketidakstabilan ini lebih teruk apabila berhadapan dengan masalah inferens yang kompleks seperti TabMWP. Bagi menyelesaikan masalah ini, penulis mencadangkan kaedah PromptPG, yang menukar pemilihan contoh kepada masalah bandit kontekstual dalam pembelajaran pengukuhan, dan menggunakan Kecerunan Dasar untuk melatih rangkaian dasar untuk belajar memilih dalam optimum daripada jumlah yang kecil. data latihan. -contoh konteks. Keputusan eksperimen menunjukkan bahawa kaedah PromptPG yang dicadangkan mereka melebihi garis dasar optimum (Few-shot CoT GPT-3) sebanyak 5.31% dalam menjawab soalan, dan kaedah mereka mengurangkan masalah dengan ketara berbanding contoh dalam konteks yang dipilih secara rawak Varians ramalan meningkatkan kestabilan kaedah jenis ini.

- Pautan kertas: https://arxiv.org/abs/2209.14610

- Pautan kod: https://github.com/lupantech/PromptPG

- Laman utama projek: https://promptpg.github.io

- Penggambaran data: https://promptpg.github.io/explore

1. Set data TabMWP

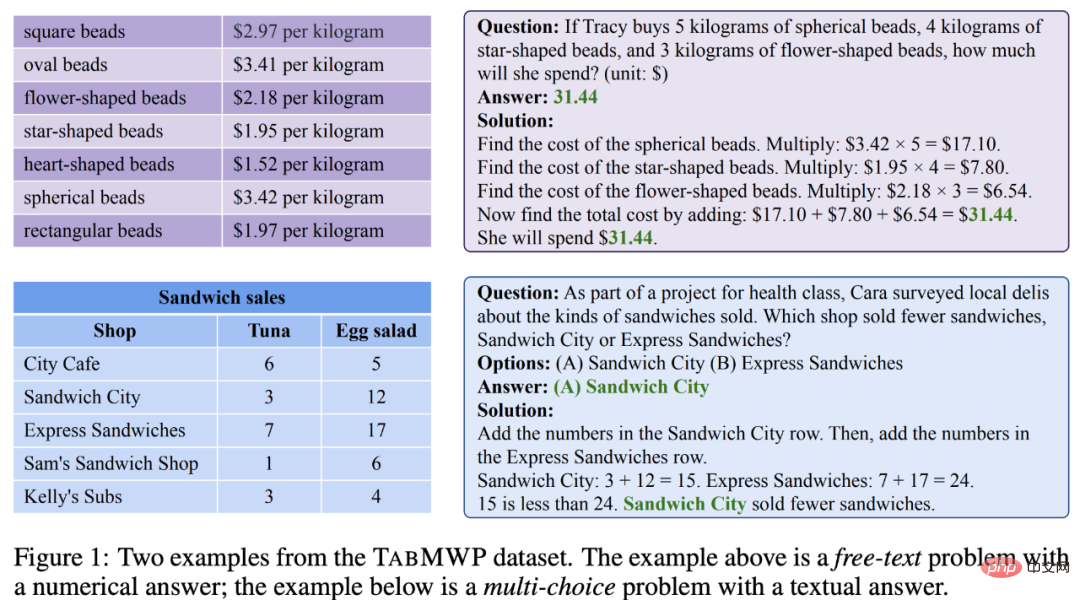

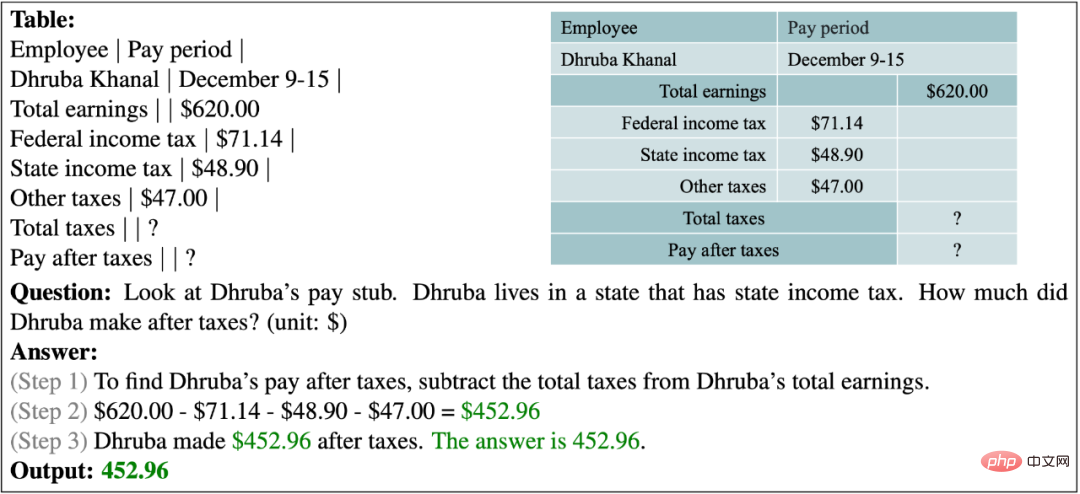

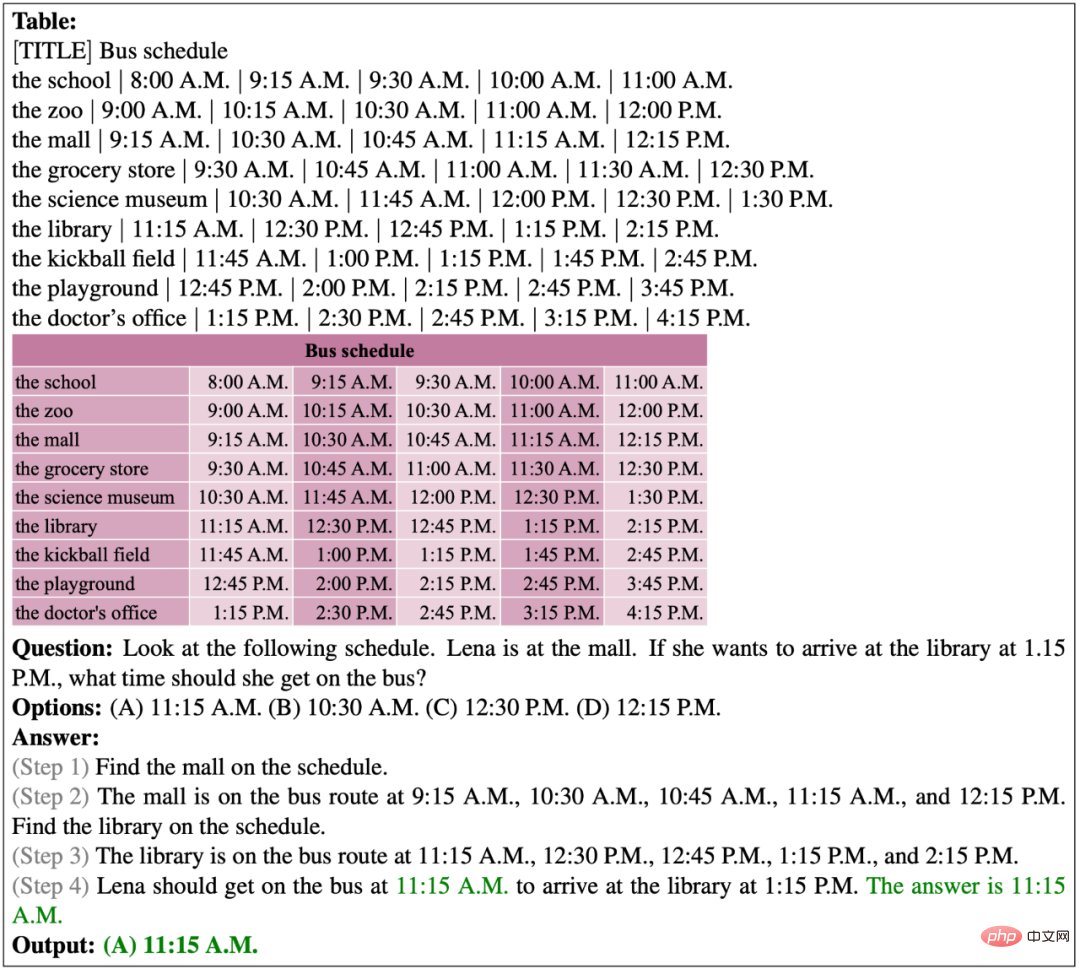

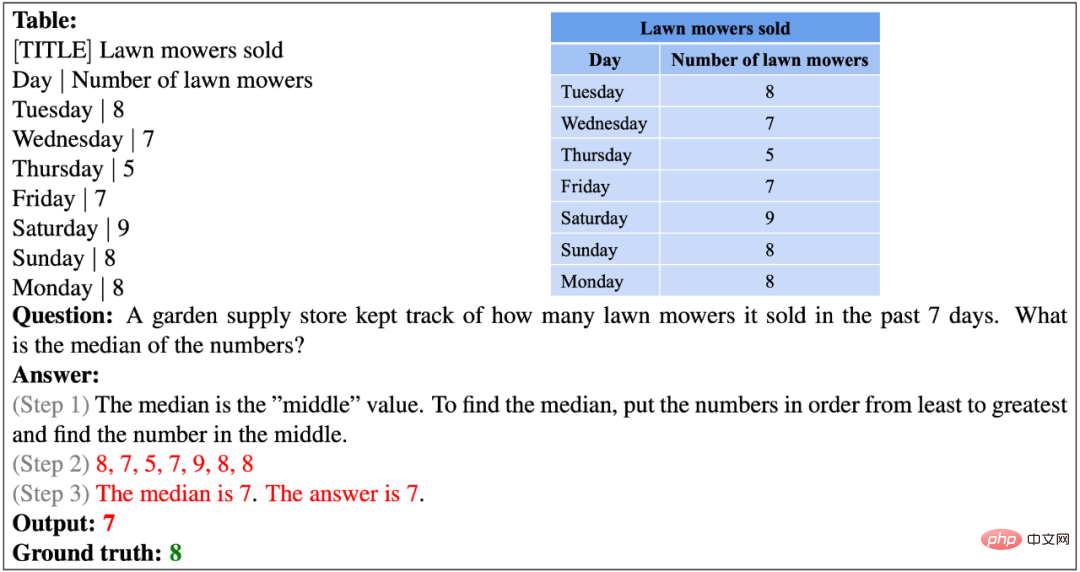

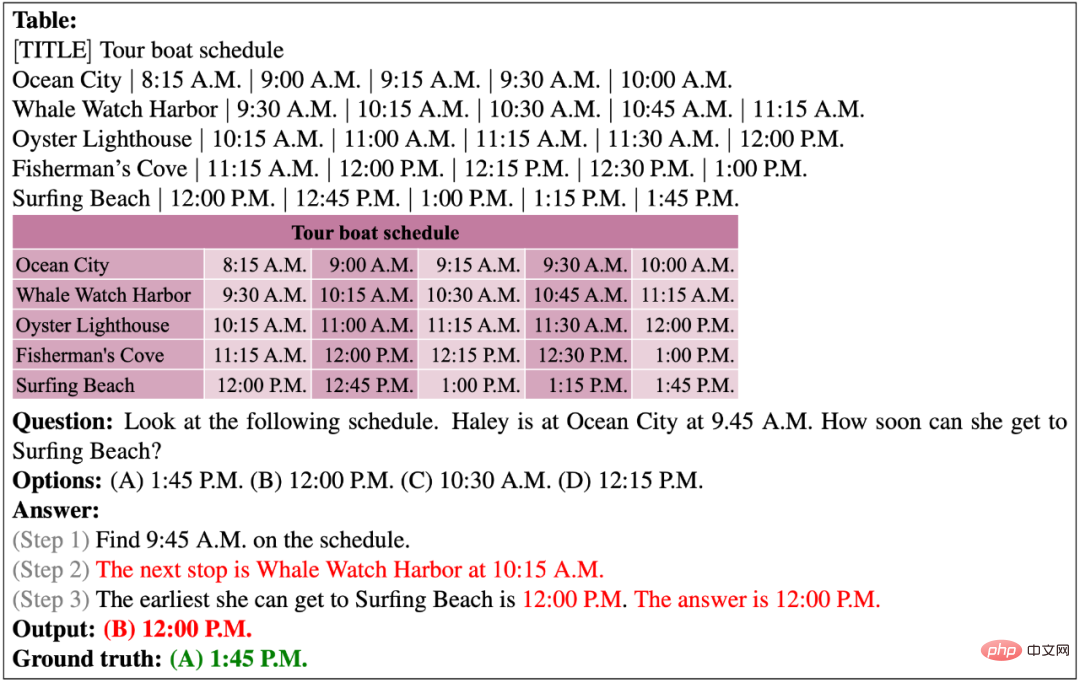

Berikut ialah dua contoh daripada set data TabMWP. Satu ialah soalan teks percuma dengan jawapan berangka, dan satu lagi soalan berbilang pilihan dengan jawapan teks. Seperti yang anda lihat, setiap soalan menyediakan penyelesaian yang merangkumi penaakulan langkah demi langkah. Untuk menyelesaikan masalah dalam TabMWP, sistem mesti mampu mencari jadual dan penaakulan matematik berbilang langkah. Ambil contoh dalam gambar di bawah, untuk menjawab "berapa banyak yang dia akan belanjakan (jika Tracy membeli tiga jenis roti)", kita perlu terlebih dahulu mencari harga yang sepadan bagi tiga jenis roti dalam jadual, dan kemudian mengira kos membeli setiap jenis roti dan menjumlahkannya untuk mendapatkan kos akhir.

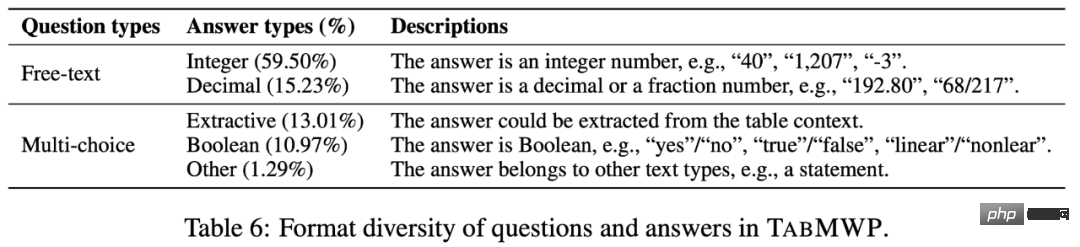

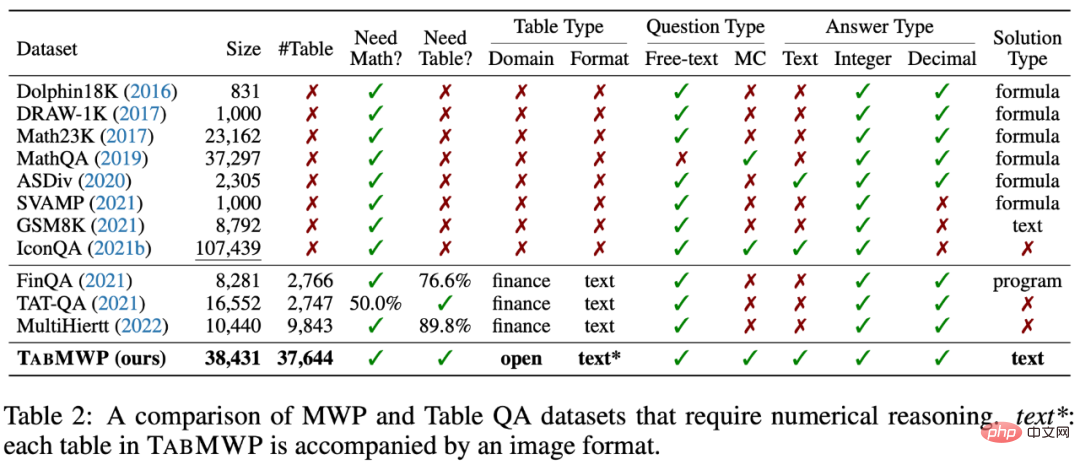

Seperti yang ditunjukkan dalam statistik dalam jadual di bawah, set data TabMWP mengandungi 38,431 masalah matematik jadual. 74.7% daripada soalan adalah soalan teks bebas dan 25.3% adalah soalan aneka pilihan. TabMWP mempunyai sejumlah 28,876 soalan unik, 6,153 jawapan unik dan 35,442 penyelesaian unik, yang menunjukkan kepelbagaian yang kaya dalam pengedaran soalan. Purata panjang soalan ialah 22.1 patah perkataan dan purata panjang jawapan ialah 49.5 patah perkataan, menunjukkan kekayaan leksikal TabMWP. Ciri tersendiri TabMWP ialah setiap masalah disertakan dengan konteks jadual, tanpanya masalah tidak dapat diselesaikan. TabMWP mempunyai sejumlah 37,644 jadual berbeza, dengan saiz jadual purata 5.9 baris dan 2.2 lajur, 12.9 sel dan maksimum 54 sel. Statistik ini menunjukkan bahawa jadual dalam TabMWP juga kaya dengan kepelbagaian.

Dataset TabMWP mempunyai dua jenis soalan yang berbeza dan lima jenis jawapan yang berbeza:

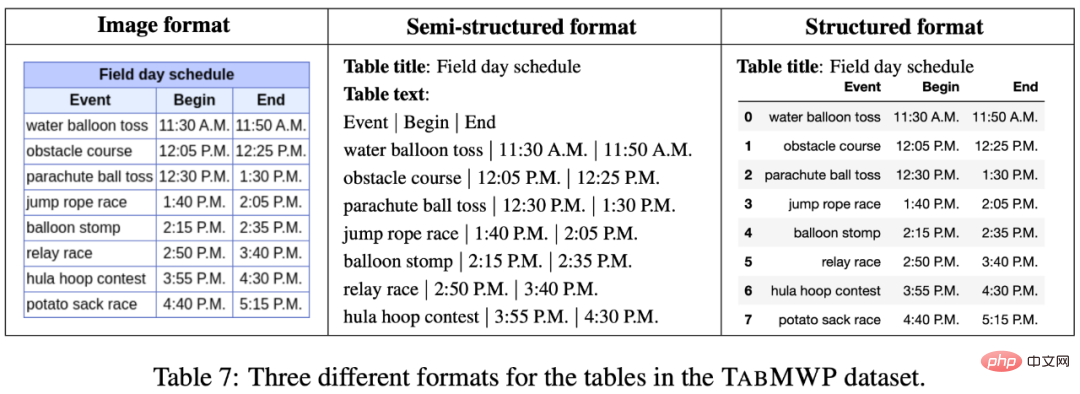

Setiap soalan dalam TabMWP mempunyai konteks jadual, yang diwakili dalam tiga format: imej, teks separa berstruktur dan berstruktur. Ini membuka kemungkinan untuk membangunkan pelbagai jenis model inferens.

Berbanding dengan set data sedia ada, TabMWP memerlukan pemahaman jadual dan keupayaan penaakulan matematik untuk menjawab soalan. Di samping itu, TabMWP mempunyai proses penaakulan pelbagai langkah yang terperinci untuk setiap soalan, yang mempunyai kelebihan yang jelas dalam saiz set data, jenis jadual, jenis soalan dan jenis jawapan. Untuk pengetahuan terbaik kertas ini, TabMWP ialah set data penaakulan matematik pertama dalam senario jadual domain terbuka.

2. Kaedah PromptPG

Memandangkan pencapaian model pra-latihan berskala besar seperti GPT-3 dalam menyelesaikan matematik masalah aplikasi Berjaya, pengarang mula-mula menetapkan penanda aras pada TabMWP menggunakan GPT-3 beberapa tangkapan. Mereka secara rawak memilih beberapa contoh kontekstual daripada set latihan serta contoh ujian untuk membentuk gesaan yang menggesa GPT-3 untuk meramalkan jawapan. Walau bagaimanapun, penyelidikan terkini menunjukkan bahawa jenis pembelajaran beberapa pukulan berdasarkan pemilihan rawak ini mungkin menunjukkan prestasi yang sangat tidak stabil pada pilihan contoh kontekstual yang berbeza. Pemilihan rawak mungkin kurang berkesan apabila menangani masalah inferens yang kompleks seperti TabMWP, yang melibatkan jadual jenis dan format yang berbeza.

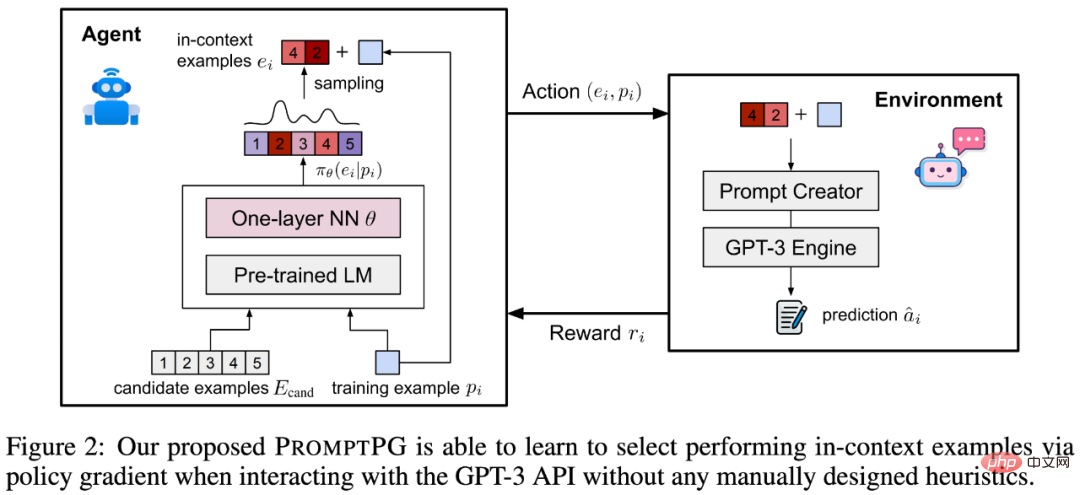

Untuk menyelesaikan masalah ini, penulis mencadangkan kaedah yang lebih baik: Pembelajaran segera melalui Kecerunan Dasar, belajar memilih contoh kontekstual daripada sejumlah kecil data latihan , dipanggil untuk PromptPG. Seperti yang ditunjukkan dalam Rajah 2, rangkaian dasar belajar untuk mencari contoh dalam konteks terbaik daripada kumpulan calon (contoh calon), dan matlamat pengoptimumannya adalah untuk memaksimumkan ramalan contoh latihan yang diberikan (contoh latihan) apabila berinteraksi dengan GPT -3 anugerah alam sekitar. Rangkaian dasar untuk memilih contoh ialah model bahasa BERT berdasarkan parameter tetap dan rangkaian neural satu lapisan dengan parameter yang boleh dipelajari. Selepas melengkapkan pembelajaran pengoptimuman, PromptPG boleh memilih secara dinamik contoh optimum berbeza daripada contoh calon untuk soalan ujian yang berbeza, dengan itu memaksimumkan prestasi inferens GPT-3.

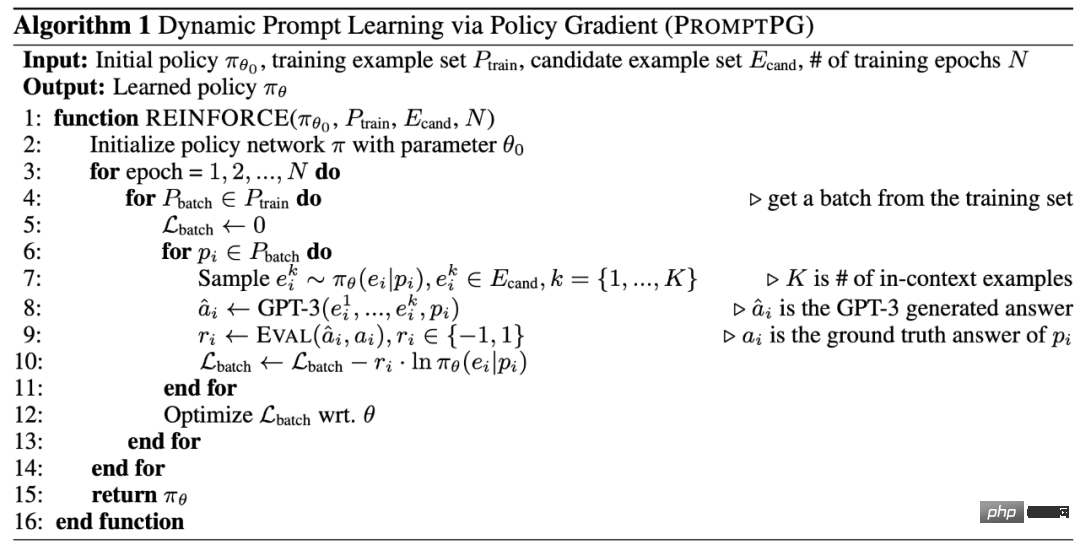

Berikut ialah algoritma pembelajaran PromptPG.

3 Eksperimen dan analisis

Pra-latihan dan denda- penalaan

Jadual 3 membandingkan keputusan PromptPG dan penanda aras yang berbeza pada set data TabMWP. Dapat dilihat bahawa TAPEX berprestasi lebih baik daripada UnifiedQA disebabkan oleh pra-latihan pada data jadual dengan jumlah parameter yang serupa. Untuk kedua-dua TAPEX dan UnifiedQA, meningkatkan bilangan parameter dalam model boleh meningkatkan ketepatan ramalan. Di samping itu, penalaan halus model pada TabMWP juga boleh meningkatkan ketepatan ramalan dengan banyak.

Model bahasa berskala besar

GPT-3 tanpa sebarang penalaan halus (Zero-shot GPT- 3 ), ia boleh mencapai ketepatan yang serupa dengan model UnifiedQA dan TAPEX yang diperhalusi. Jika model GPT-3 Few-shot secara rawak memilih dua contoh dalam konteks sebagai pembayang GPT-3, model ini boleh bertambah baik sebanyak 0.17% berbanding Zero-shot GPT-3. Dengan mempunyai GPT-3 Few-shot menjana beberapa langkah perantaraan sebelum menjana jawapan akhir (Few-shot-CoT GPT-3), penyelidik dapat memperoleh model garis dasar yang optimum dengan ketepatan 62.92%.

PromptPG

Berbeza daripada memilih contoh dalam konteks secara rawak, PromptPG yang dicadangkan dalam artikel ini melatih rangkaian dasar melalui Kecerunan Dasar untuk memilih contoh dalam konteks yang lebih sesuai dan mencapai hasil ramalan tertinggi (68.23%) pada TabMWP. Purata ketepatan ramalannya melebihi model garis dasar terbaik (Few-shot-CoT GPT-3) sebanyak 5.31%. Terutama, PromptPG menunjukkan keunggulannya dalam ketepatan ramalan untuk hampir semua jenis soalan, jenis jawapan dan kesukaran soalan. Walaupun begitu, PromptPG masih mempunyai banyak ruang untuk penambahbaikan daripada prestasi manusia sebanyak 90.22%.

Eksperimen Ablasi

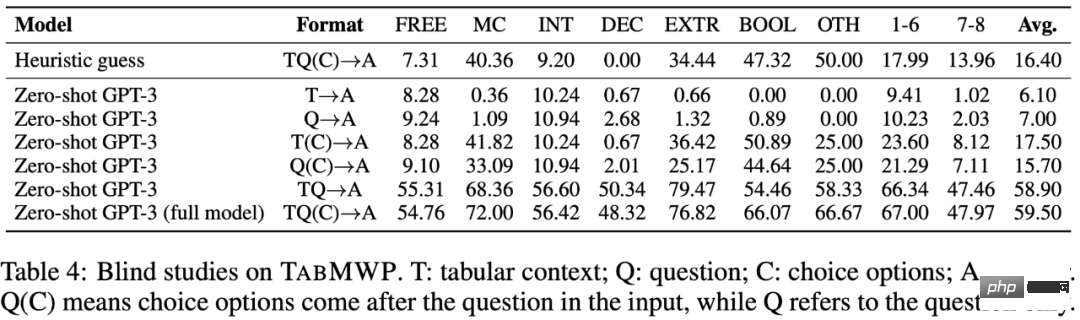

Jadual 4 menunjukkan bahawa semua elemen input TabMWP (teks soalan, maklumat borang, maklumat pilihan) semuanya penting untuk menjawab soalan dengan betul. Hanya dengan semua elemen masalah sebagai maklumat input, Zero-shot GPT-3 mencapai ketepatan ramalan purata tertingginya (59.50%).

Pilihan sampel yang berbeza

Sebagai eksperimen perbandingan, penyelidik juga Kaedah lain dengan pemilihan sampel yang berbeza telah dibandingkan. Seperti yang ditunjukkan dalam Jadual 5, memilih jenis soalan atau jenis jawapan yang sama seperti soalan ujian boleh membantu model mencari contoh yang lebih relevan dan meningkatkan ketepatan jawapan. Memilih contoh yang paling kompleks tidak secara konsisten meningkatkan ketepatan jawapan. Pemilihan tetap dua contoh terbaik antara contoh calon boleh meningkatkan sedikit ketepatan dan mengurangkan varians. Memilih contoh yang secara semantik paling hampir dengan masalah ujian mencapai ketepatan yang paling hampir dengan kaedah PromptPG. Secara keseluruhannya, PromptPG menunjukkan sepenuhnya kelebihannya dalam meningkatkan ketepatan ramalan dan mengurangkan varians ramalan.

Rajah di bawah menunjukkan contoh pemilihan PromptPG dan keputusan ramalan akhir. Ia boleh dilihat bahawa kaedah PromptPG boleh memilih contoh dengan kebolehan matematik yang serupa dengan soalan ujian, dengan itu meningkatkan prestasi inferens GPT-3 Sedikit pukulan.

Contoh ramalan yang berjaya

Berikut menunjukkan PromptPG untuk percuma Jawapan yang betul kepada soalan teks. Soalan ini memerlukan menambah dan membahagi lapan nombor dalam jadual untuk mencari purata.

Dalam contoh berikut, model diminta memahami laporan cukai dan mengira gaji selepas potongan cukai.

Berikut menunjukkan ramalan betul PromptPG untuk soalan aneka pilihan. Jadual yang diberikan mempunyai sejumlah 9 baris dan 6 lajur. Model berjaya mengesan sel sasaran dalam jadual dan melakukan inferens berbilang langkah untuk meramalkan jawapan yang betul.

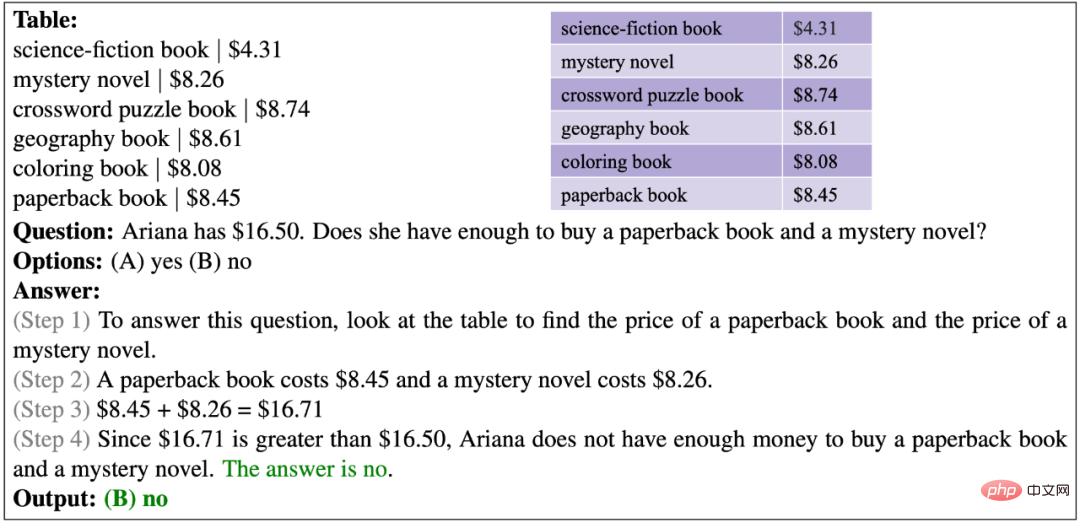

Dalam contoh berikut, model perlu membandingkan belanjawan dan jumlah kos untuk mengesahkan sama ada Ariana mempunyai wang yang mencukupi.

Contoh kegagalan ramalan

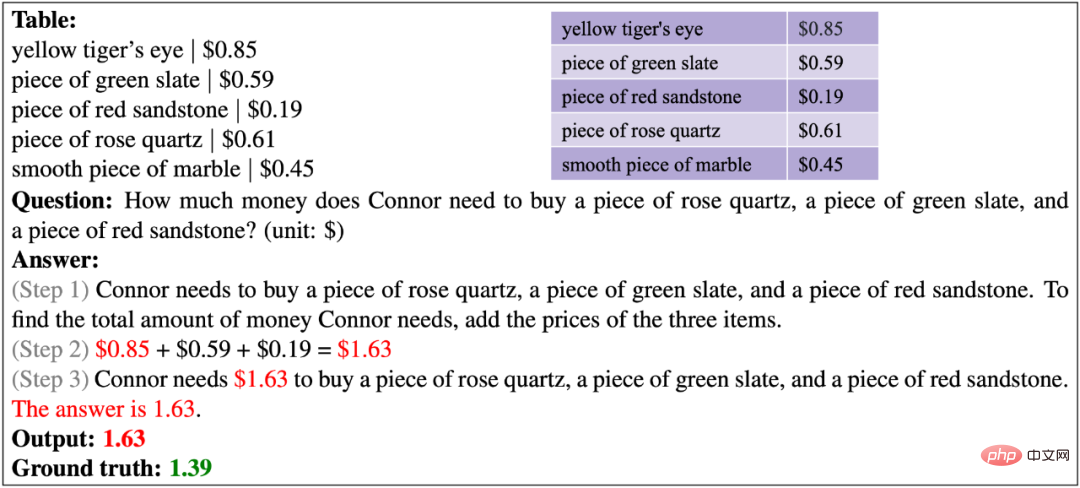

Berikut menunjukkan PromptPG untuk teks percuma Salah ramalan masalah. Model itu mendapatkan semula harga yang salah untuk kuarza mawar, dengan itu salah mengira jumlah kos bagi tiga item.

Dalam contoh berikut, soalan menyediakan jadual abstrak daun batang. Model tidak dapat memahami jadual khusus domain ini dan tidak mempunyai keupayaan penaakulan logik lanjutan untuk mendapatkan jawapan yang salah.

Contoh berikut menunjukkan bahawa model sedia ada nampaknya tidak mempunyai keupayaan untuk mengisih nombor.

Dalam contoh berikut, masa yang betul-betul konsisten dengan masa semasa yang disebut dalam soalan tidak muncul dalam jadual, jadi model tidak boleh dengan tepat cari masa seterusnya Masa berlepas untuk satu perhentian.

Dalam contoh berikut, adalah sukar untuk model melengkapkan operasi aritmetik dengan tepat pada siri nombor yang panjang.

4. Kesimpulan dan pandangan

Pengarang mencadangkan TabMWP, iaitu penyelesaian masalah matematik pertama dalam konteks jadual berskala besar set data. TabMWP mengandungi 38,431 soalan domain terbuka, termasuk dua jenis soalan dan lima jenis jawapan, dengan setiap soalan ditandakan dengan proses penyelesaian berbilang langkah. Penulis menggunakan kaedah QA dan TableQA yang terkini, menjalankan eksperimen komprehensif pada TabMWP dalam tetapan pra-terlatih dan diperhalusi, dan dinilai menggunakan model bahasa pra-terlatih yang besar GPT-3. Penulis selanjutnya mencadangkan kaedah pembelajaran tetulang baharu, PromptPG, yang menggunakan pembelajaran Kecerunan Dasar untuk memilih kejadian optimum daripada data latihan untuk menggesa model GPT-3. Keputusan eksperimen menunjukkan bahawa PromptPG dengan ketara mengatasi garis dasar sedia ada dan mengurangkan ketidakstabilan prestasi dalam ramalan berbanding pemilihan rawak.

Atas ialah kandungan terperinci PromptPG: Apabila pembelajaran peneguhan memenuhi model bahasa berskala besar. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1379

1379

52

52

Petua Konfigurasi Firewall Pelayan Mel Debian

Apr 13, 2025 am 11:42 AM

Petua Konfigurasi Firewall Pelayan Mel Debian

Apr 13, 2025 am 11:42 AM

Mengkonfigurasi firewall pelayan Mail Debian adalah langkah penting dalam memastikan keselamatan pelayan. Berikut adalah beberapa kaedah konfigurasi firewall yang biasa digunakan, termasuk penggunaan iptables dan firewalld. Gunakan iptables untuk mengkonfigurasi firewall untuk memasang iptables (jika belum dipasang): sudoapt-getupdateudoapt-getinstalliplesview peraturan iptables semasa: konfigurasi sudoiptable-l

Cara Menetapkan Tahap Log Debian Apache

Apr 13, 2025 am 08:33 AM

Cara Menetapkan Tahap Log Debian Apache

Apr 13, 2025 am 08:33 AM

Artikel ini menerangkan cara menyesuaikan tahap pembalakan pelayan Apacheweb dalam sistem Debian. Dengan mengubah suai fail konfigurasi, anda boleh mengawal tahap maklumat log yang direkodkan oleh Apache. Kaedah 1: Ubah suai fail konfigurasi utama untuk mencari fail konfigurasi: Fail konfigurasi apache2.x biasanya terletak di direktori/etc/apache2/direktori. Nama fail mungkin apache2.conf atau httpd.conf, bergantung pada kaedah pemasangan anda. Edit Fail Konfigurasi: Buka Fail Konfigurasi dengan Kebenaran Root Menggunakan Editor Teks (seperti Nano): Sudonano/ETC/APACHE2/APACHE2.CONF

Bagaimana Debian Readdir Bersepadu Dengan Alat Lain

Apr 13, 2025 am 09:42 AM

Bagaimana Debian Readdir Bersepadu Dengan Alat Lain

Apr 13, 2025 am 09:42 AM

Fungsi Readdir dalam sistem Debian adalah panggilan sistem yang digunakan untuk membaca kandungan direktori dan sering digunakan dalam pengaturcaraan C. Artikel ini akan menerangkan cara mengintegrasikan Readdir dengan alat lain untuk meningkatkan fungsinya. Kaedah 1: Menggabungkan Program Bahasa C dan Pipeline Pertama, tulis program C untuk memanggil fungsi Readdir dan output hasilnya:#termasuk#termasuk#includeintMain (intargc, char*argv []) {dir*dir; structdirent*entry; if (argc! = 2) {

Cara Mengoptimumkan Prestasi Debian Readdir

Apr 13, 2025 am 08:48 AM

Cara Mengoptimumkan Prestasi Debian Readdir

Apr 13, 2025 am 08:48 AM

Dalam sistem Debian, panggilan sistem Readdir digunakan untuk membaca kandungan direktori. Jika prestasinya tidak baik, cuba strategi pengoptimuman berikut: Memudahkan bilangan fail direktori: Split direktori besar ke dalam pelbagai direktori kecil sebanyak mungkin, mengurangkan bilangan item yang diproses setiap panggilan readdir. Dayakan Caching Kandungan Direktori: Bina mekanisme cache, kemas kini cache secara teratur atau apabila kandungan direktori berubah, dan mengurangkan panggilan kerap ke Readdir. Cafh memori (seperti memcached atau redis) atau cache tempatan (seperti fail atau pangkalan data) boleh dipertimbangkan. Mengamalkan struktur data yang cekap: Sekiranya anda melaksanakan traversal direktori sendiri, pilih struktur data yang lebih cekap (seperti jadual hash dan bukannya carian linear) untuk menyimpan dan mengakses maklumat direktori

Cara Melaksanakan Penyortiran Fail oleh Debian Readdir

Apr 13, 2025 am 09:06 AM

Cara Melaksanakan Penyortiran Fail oleh Debian Readdir

Apr 13, 2025 am 09:06 AM

Dalam sistem Debian, fungsi Readdir digunakan untuk membaca kandungan direktori, tetapi urutan yang dikembalikannya tidak ditentukan sebelumnya. Untuk menyusun fail dalam direktori, anda perlu membaca semua fail terlebih dahulu, dan kemudian menyusunnya menggunakan fungsi QSORT. Kod berikut menunjukkan cara menyusun fail direktori menggunakan ReadDir dan QSORT dalam sistem Debian:#termasuk#termasuk#termasuk#termasuk // fungsi perbandingan adat, yang digunakan untuk qSortintCompare (Constvoid*A, Constvoid*b) {Returnstrcmp (*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(

Kaedah pemasangan sijil SSL Server Server Debian

Apr 13, 2025 am 11:39 AM

Kaedah pemasangan sijil SSL Server Server Debian

Apr 13, 2025 am 11:39 AM

Langkah -langkah untuk memasang sijil SSL pada pelayan mel Debian adalah seperti berikut: 1. Pasang OpenSSL Toolkit terlebih dahulu, pastikan bahawa OpenSSL Toolkit telah dipasang pada sistem anda. Jika tidak dipasang, anda boleh menggunakan arahan berikut untuk memasang: sudoapt-getupdateudoapt-getinstallopenssl2. Menjana permintaan kunci dan sijil peribadi seterusnya, gunakan OpenSSL untuk menjana kunci peribadi RSA 2048-bit dan permintaan sijil (CSR): Membuka

Cara Melakukan Pengesahan Tandatangan Digital dengan Debian Openssl

Apr 13, 2025 am 11:09 AM

Cara Melakukan Pengesahan Tandatangan Digital dengan Debian Openssl

Apr 13, 2025 am 11:09 AM

Menggunakan OpenSSL untuk Pengesahan Tandatangan Digital pada Sistem Debian, anda boleh mengikuti langkah -langkah berikut: Penyediaan untuk memasang OpenSSL: Pastikan sistem Debian anda telah dipasang. Jika tidak dipasang, anda boleh menggunakan arahan berikut untuk memasangnya: sudoaptdateudoaptininstallopenssl untuk mendapatkan kunci awam: Pengesahan tandatangan digital memerlukan kunci awam penandatangan. Biasanya, kunci awam akan disediakan dalam bentuk fail, seperti public_key.pe

Bagaimana Debian OpenSSL Menghalang Serangan Man-dalam-Middle

Apr 13, 2025 am 10:30 AM

Bagaimana Debian OpenSSL Menghalang Serangan Man-dalam-Middle

Apr 13, 2025 am 10:30 AM

Dalam sistem Debian, OpenSSL adalah perpustakaan penting untuk pengurusan penyulitan, penyahsulitan dan sijil. Untuk mengelakkan serangan lelaki-dalam-pertengahan (MITM), langkah-langkah berikut boleh diambil: Gunakan HTTPS: Pastikan semua permintaan rangkaian menggunakan protokol HTTPS dan bukannya HTTP. HTTPS menggunakan TLS (Protokol Keselamatan Lapisan Pengangkutan) untuk menyulitkan data komunikasi untuk memastikan data tidak dicuri atau diganggu semasa penghantaran. Sahkan Sijil Pelayan: Sahkan secara manual Sijil Pelayan pada klien untuk memastikan ia boleh dipercayai. Pelayan boleh disahkan secara manual melalui kaedah perwakilan urlSession