Peranti teknologi

Peranti teknologi

AI

AI

Superkomputer AI super Google menghancurkan NVIDIA A100! Prestasi TPU v4 meningkat sebanyak 10 kali ganda, butiran didedahkan buat kali pertama

Superkomputer AI super Google menghancurkan NVIDIA A100! Prestasi TPU v4 meningkat sebanyak 10 kali ganda, butiran didedahkan buat kali pertama

Superkomputer AI super Google menghancurkan NVIDIA A100! Prestasi TPU v4 meningkat sebanyak 10 kali ganda, butiran didedahkan buat kali pertama

Walaupun Google menggunakan cip AI yang paling berkuasa pada masa itu, TPU v4, di pusat datanya sendiri seawal 2020.

Tetapi baru 4 April tahun ini Google mengumumkan butiran teknikal superkomputer AI ini buat kali pertama.

Alamat kertas: https://arxiv.org/abs/2304.01433

Berbanding dengan TPU v3, prestasi TPU v4 adalah 2.1 kali lebih tinggi, dan selepas menyepadukan 4096 cip, prestasi superkomputer dipertingkatkan sebanyak 10 kali ganda.

Selain itu, Google juga mendakwa cipnya sendiri lebih pantas dan lebih cekap tenaga berbanding Nvidia A100.

Bersaing dengan A100, 1.7 kali lebih pantas

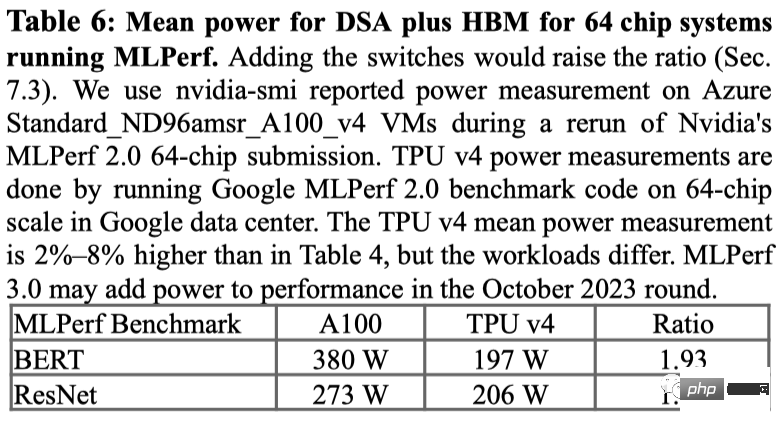

Dalam kertas itu, Google menyatakan bahawa untuk sistem saiz yang setanding, TPU v4 It boleh memberikan prestasi 1.7 kali lebih baik daripada NVIDIA A100, di samping meningkatkan kecekapan tenaga sebanyak 1.9 kali.

Selain itu, kelajuan pengkomputeran besar Google adalah kira-kira 4.3 hingga 4.5 kali lebih pantas daripada Graphcore IPU Bow.

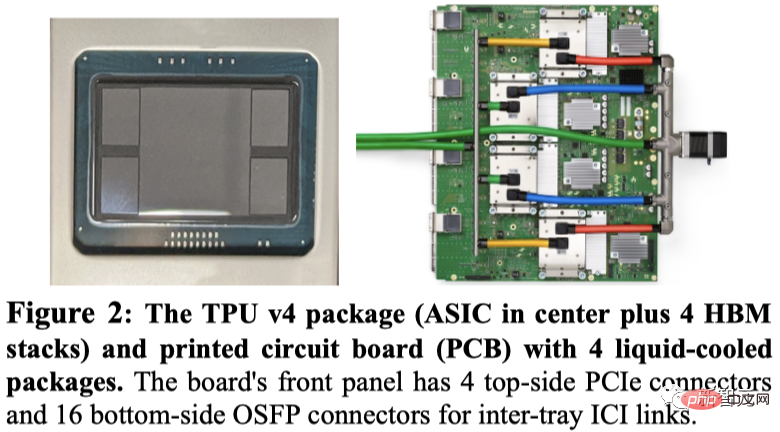

Google mempamerkan pakej TPU v4, serta 4 pakej yang dipasang pada papan litar.

Seperti TPU v3, setiap TPU v4 mengandungi dua TensorCore (TC). Setiap TC mengandungi empat unit pendaraban matriks (MXU) 128x128, unit pemprosesan vektor (VPU) dengan 128 saluran (16 ALU setiap saluran) dan 16 memori vektor MiB (VMEM).

Dua TC berkongsi memori biasa (CMEM) 128 MiB.

Perlu diambil perhatian bahawa cip A100 telah dilancarkan pada masa yang sama dengan TPU generasi keempat Google, jadi bagaimanakah prestasi khusus mereka dibandingkan?

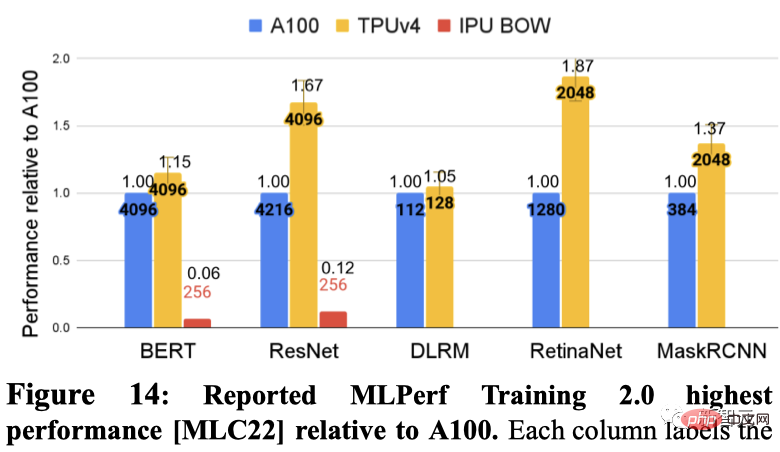

Google menunjukkan prestasi terpantas setiap DSA dalam 5 penanda aras MLPerf secara berasingan. Ini termasuk BERT, ResNET, DLRM, RetinaNet dan MaskRCNN.

Antaranya, Graphcore IPU menyerahkan keputusan dalam BERT dan ResNET.

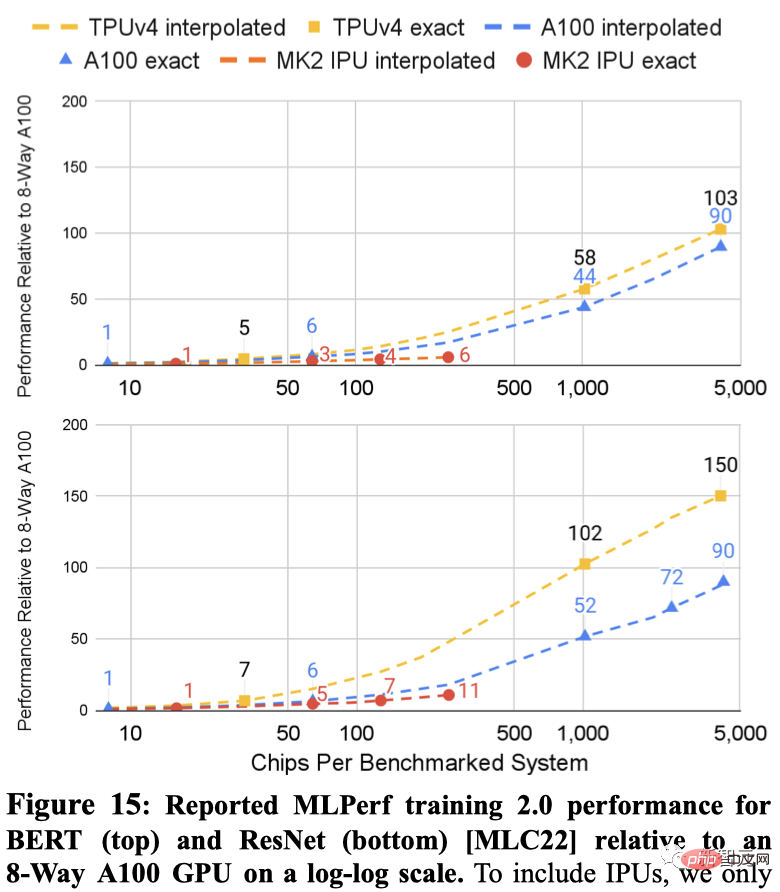

Berikut menunjukkan keputusan kedua-dua sistem pada ResNet dan BERT Garis putus-putus antara titik adalah interpolasi berdasarkan bilangan cip.

Hasil MLPerf untuk kedua-dua skala TPU v4 dan A100 kepada sistem yang lebih besar daripada IPU (4096 cip lwn. 256 cip).

Untuk sistem bersaiz serupa, TPU v4 adalah 1.15x lebih pantas daripada A100 pada BERT dan kira-kira 4.3x lebih pantas daripada IPU. Untuk ResNet, TPU v4 masing-masing adalah 1.67x dan kira-kira 4.5x lebih pantas.

Mengenai penggunaan kuasa pada penanda aras MLPerf, A100 menggunakan secara purata 1.3x hingga 1.9x lebih kuasa.

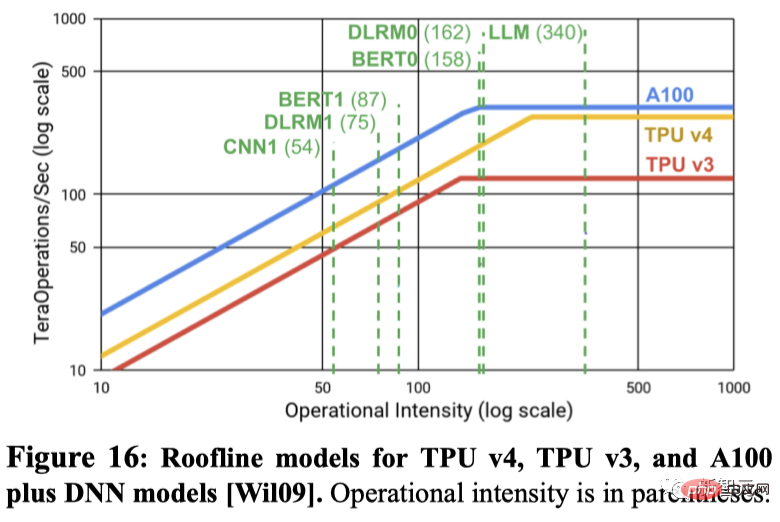

Adakah FLOPS puncak meramalkan prestasi sebenar? Ramai orang dalam bidang pembelajaran mesin percaya bahawa operasi titik terapung puncak sesaat adalah proksi yang baik untuk prestasi, tetapi sebenarnya tidak.

Sebagai contoh, TPU v4 adalah 4.3x hingga 4.5x lebih pantas pada dua penanda aras MLPerf daripada IPU Bow pada sistem saiz yang sama, walaupun hanya mempunyai kelebihan 1.10x dalam operasi titik terapung puncak sesaat.

Contoh lain ialah operasi titik terapung puncak A100 sesaat ialah 1.13 kali ganda berbanding TPU v4, tetapi untuk bilangan cip yang sama, TPU v4 adalah 1.15 hingga 1.67 kali lebih pantas.

Rajah berikut menggunakan model Roofline untuk menunjukkan hubungan antara FLOPS puncak/saat dan lebar jalur memori.

Jadi, persoalannya, kenapa Google tidak membandingkan dengan H100 terbaru Nvidia?

Google berkata kerana H100 dibina menggunakan teknologi yang lebih baharu selepas pelancaran cip Google, ia tidak membandingkan produk generasi keempatnya dengan cip H100 perdana Nvidia semasa.

Walau bagaimanapun, Google membayangkan bahawa ia sedang membangunkan TPU baharu untuk bersaing dengan Nvidia H100, tetapi tidak memberikan butiran. Penyelidik Google Jouppi berkata dalam temu bual dengan Reuters bahawa Google mempunyai "barisan pengeluaran untuk cip masa depan."

TPU vs GPU

Semasa ChatGPT dan Bard "bertempur", kedua-dua raksasa itu juga bekerja keras di belakang tabir untuk memastikan mereka berjalan - Sokongan NVIDIA CUDA GPU (Unit Pemprosesan Grafik) dan TPU tersuai Google (Unit Pemprosesan Tensor).

Dalam erti kata lain, ini bukan lagi mengenai ChatGPT lwn. Bard, tetapi TPU lwn. GPU dan betapa cekapnya mereka boleh melakukan pendaraban matriks.

Disebabkan reka bentuk yang sangat baik dalam seni bina perkakasan, GPU NVIDIA sangat sesuai untuk tugas pendaraban matriks - bertukar secara berkesan antara berbilang teras CUDA Laksanakan pemprosesan selari .

Oleh itu, model latihan mengenai GPU telah menjadi konsensus dalam bidang pembelajaran mendalam sejak 2012, dan ia tidak berubah sehingga hari ini.

Dengan pelancaran NVIDIA DGX, NVIDIA mampu menyediakan penyelesaian perkakasan dan perisian sehenti untuk hampir semua tugasan AI, yang tidak dapat disediakan oleh pesaing kerana kekurangan hak harta intelek .

Sebaliknya, Google melancarkan unit pemprosesan tensor (TPU) generasi pertama pada 2016, yang bukan sahaja menyertakan ASIC tersuai (litar bersepadu khusus), dan juga dioptimumkan untuk unitnya sendiri. Rangka kerja TensorFlow. Ini juga memberi kelebihan kepada TPU dalam tugas pengkomputeran AI lain selain pendaraban matriks, malah boleh mempercepatkan tugasan penalaan halus dan inferens.

Selain itu, penyelidik di Google DeepMind juga telah menemui cara untuk mencipta algoritma pendaraban matriks yang lebih baik - AlphaTensor.

Walau bagaimanapun, walaupun Google telah mencapai keputusan yang baik melalui teknologi yang dibangunkan sendiri dan kaedah pengoptimuman pengkomputeran AI yang baru muncul, kerjasama Microsoft dan Nvidia yang telah lama terjalin dan mendalam telah bergantung pada masing-masing. kepakaran dalam industri Pengumpulan produk secara serentak telah memperluaskan kelebihan daya saing kedua-dua pihak.

TPU generasi keempat

Kembali pada tahun 2021 di persidangan Google I/O, Pichai mengumumkannya untuk yang pertama masa TPU cip AI generasi terbaharu Google v4.

"Ini ialah sistem terpantas yang pernah kami gunakan di Google dan satu kejayaan bersejarah bagi kami." Peningkatan ini telah menjadi titik penting dalam persaingan antara syarikat yang membina superkomputer AI, kerana model bahasa besar seperti Google's Bard atau OpenAI's ChatGPT telah dilaksanakan pada skala parameter Explosive growth.

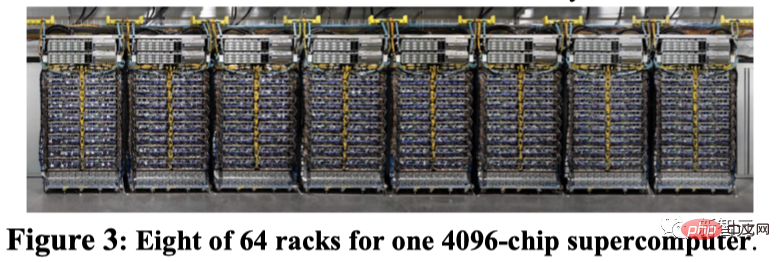

Jadi model besar ini perlu diedarkan merentasi ribuan cip, dan kemudian cip tersebut perlu bekerja bersama selama berminggu-minggu, atau lebih lama lagi, untuk melatih model itu. Pada masa ini, PaLM, model bahasa terbesar yang didedahkan secara terbuka oleh Google setakat ini, mempunyai 540 bilion parameter, yang dibahagikan kepada dua superkomputer 4000 cip untuk latihan dalam masa 50 hari. Google berkata superkomputernya boleh mengkonfigurasi semula sambungan antara cip dengan mudah untuk mengelakkan masalah dan melakukan penalaan prestasi. Penyelidik Google Norm Jouppi dan Jurutera Terbilang Google David Patterson menulis dalam catatan blog tentang sistem, “Pensuisan litar membolehkan pintasan Mengatasi gagal Komponen menjadi mudah. Fleksibiliti ini malah membolehkan kami menukar topologi interkoneksi superkomputer untuk mempercepatkan prestasi model pembelajaran mesin, yang telah berada dalam talian sejak 2020 di pusat data yang terletak di Mayes County, Oklahoma. Google mengatakan bahawa Midjourney menggunakan sistem ini untuk melatih modelnya dan versi terkini V5 membolehkan semua orang melihat penjanaan imej yang menakjubkan.

Baru-baru ini, Pichai berkata dalam temu bual dengan New York Times bahawa Bard akan dipindahkan dari LaMDA ke PaLM. Kini dengan berkat superkomputer TPU v4, Bard hanya akan menjadi lebih kuat.

Atas ialah kandungan terperinci Superkomputer AI super Google menghancurkan NVIDIA A100! Prestasi TPU v4 meningkat sebanyak 10 kali ganda, butiran didedahkan buat kali pertama. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1378

1378

52

52

Cara Melaksanakan Penyortiran Fail oleh Debian Readdir

Apr 13, 2025 am 09:06 AM

Cara Melaksanakan Penyortiran Fail oleh Debian Readdir

Apr 13, 2025 am 09:06 AM

Dalam sistem Debian, fungsi Readdir digunakan untuk membaca kandungan direktori, tetapi urutan yang dikembalikannya tidak ditentukan sebelumnya. Untuk menyusun fail dalam direktori, anda perlu membaca semua fail terlebih dahulu, dan kemudian menyusunnya menggunakan fungsi QSORT. Kod berikut menunjukkan cara menyusun fail direktori menggunakan ReadDir dan QSORT dalam sistem Debian:#termasuk#termasuk#termasuk#termasuk // fungsi perbandingan adat, yang digunakan untuk qSortintCompare (Constvoid*A, Constvoid*b) {Returnstrcmp (*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(

Cara Mengoptimumkan Prestasi Debian Readdir

Apr 13, 2025 am 08:48 AM

Cara Mengoptimumkan Prestasi Debian Readdir

Apr 13, 2025 am 08:48 AM

Dalam sistem Debian, panggilan sistem Readdir digunakan untuk membaca kandungan direktori. Jika prestasinya tidak baik, cuba strategi pengoptimuman berikut: Memudahkan bilangan fail direktori: Split direktori besar ke dalam pelbagai direktori kecil sebanyak mungkin, mengurangkan bilangan item yang diproses setiap panggilan readdir. Dayakan Caching Kandungan Direktori: Bina mekanisme cache, kemas kini cache secara teratur atau apabila kandungan direktori berubah, dan mengurangkan panggilan kerap ke Readdir. Cafh memori (seperti memcached atau redis) atau cache tempatan (seperti fail atau pangkalan data) boleh dipertimbangkan. Mengamalkan struktur data yang cekap: Sekiranya anda melaksanakan traversal direktori sendiri, pilih struktur data yang lebih cekap (seperti jadual hash dan bukannya carian linear) untuk menyimpan dan mengakses maklumat direktori

Cara Menetapkan Tahap Log Debian Apache

Apr 13, 2025 am 08:33 AM

Cara Menetapkan Tahap Log Debian Apache

Apr 13, 2025 am 08:33 AM

Artikel ini menerangkan cara menyesuaikan tahap pembalakan pelayan Apacheweb dalam sistem Debian. Dengan mengubah suai fail konfigurasi, anda boleh mengawal tahap maklumat log yang direkodkan oleh Apache. Kaedah 1: Ubah suai fail konfigurasi utama untuk mencari fail konfigurasi: Fail konfigurasi apache2.x biasanya terletak di direktori/etc/apache2/direktori. Nama fail mungkin apache2.conf atau httpd.conf, bergantung pada kaedah pemasangan anda. Edit Fail Konfigurasi: Buka Fail Konfigurasi dengan Kebenaran Root Menggunakan Editor Teks (seperti Nano): Sudonano/ETC/APACHE2/APACHE2.CONF

Bagaimana Debian OpenSSL Menghalang Serangan Man-dalam-Middle

Apr 13, 2025 am 10:30 AM

Bagaimana Debian OpenSSL Menghalang Serangan Man-dalam-Middle

Apr 13, 2025 am 10:30 AM

Dalam sistem Debian, OpenSSL adalah perpustakaan penting untuk pengurusan penyulitan, penyahsulitan dan sijil. Untuk mengelakkan serangan lelaki-dalam-pertengahan (MITM), langkah-langkah berikut boleh diambil: Gunakan HTTPS: Pastikan semua permintaan rangkaian menggunakan protokol HTTPS dan bukannya HTTP. HTTPS menggunakan TLS (Protokol Keselamatan Lapisan Pengangkutan) untuk menyulitkan data komunikasi untuk memastikan data tidak dicuri atau diganggu semasa penghantaran. Sahkan Sijil Pelayan: Sahkan secara manual Sijil Pelayan pada klien untuk memastikan ia boleh dipercayai. Pelayan boleh disahkan secara manual melalui kaedah perwakilan urlSession

Kaedah pemasangan sijil SSL Server Server Debian

Apr 13, 2025 am 11:39 AM

Kaedah pemasangan sijil SSL Server Server Debian

Apr 13, 2025 am 11:39 AM

Langkah -langkah untuk memasang sijil SSL pada pelayan mel Debian adalah seperti berikut: 1. Pasang OpenSSL Toolkit terlebih dahulu, pastikan bahawa OpenSSL Toolkit telah dipasang pada sistem anda. Jika tidak dipasang, anda boleh menggunakan arahan berikut untuk memasang: sudoapt-getupdateudoapt-getinstallopenssl2. Menjana permintaan kunci dan sijil peribadi seterusnya, gunakan OpenSSL untuk menjana kunci peribadi RSA 2048-bit dan permintaan sijil (CSR): Membuka

Bagaimana Debian Readdir Bersepadu Dengan Alat Lain

Apr 13, 2025 am 09:42 AM

Bagaimana Debian Readdir Bersepadu Dengan Alat Lain

Apr 13, 2025 am 09:42 AM

Fungsi Readdir dalam sistem Debian adalah panggilan sistem yang digunakan untuk membaca kandungan direktori dan sering digunakan dalam pengaturcaraan C. Artikel ini akan menerangkan cara mengintegrasikan Readdir dengan alat lain untuk meningkatkan fungsinya. Kaedah 1: Menggabungkan Program Bahasa C dan Pipeline Pertama, tulis program C untuk memanggil fungsi Readdir dan output hasilnya:#termasuk#termasuk#includeintMain (intargc, char*argv []) {dir*dir; structdirent*entry; if (argc! = 2) {

Petua Konfigurasi Firewall Pelayan Mel Debian

Apr 13, 2025 am 11:42 AM

Petua Konfigurasi Firewall Pelayan Mel Debian

Apr 13, 2025 am 11:42 AM

Mengkonfigurasi firewall pelayan Mail Debian adalah langkah penting dalam memastikan keselamatan pelayan. Berikut adalah beberapa kaedah konfigurasi firewall yang biasa digunakan, termasuk penggunaan iptables dan firewalld. Gunakan iptables untuk mengkonfigurasi firewall untuk memasang iptables (jika belum dipasang): sudoapt-getupdateudoapt-getinstalliplesview peraturan iptables semasa: konfigurasi sudoiptable-l

Cara Belajar Debian Syslog

Apr 13, 2025 am 11:51 AM

Cara Belajar Debian Syslog

Apr 13, 2025 am 11:51 AM

Panduan ini akan membimbing anda untuk belajar cara menggunakan syslog dalam sistem Debian. SYSLOG adalah perkhidmatan utama dalam sistem Linux untuk sistem pembalakan dan mesej log aplikasi. Ia membantu pentadbir memantau dan menganalisis aktiviti sistem untuk mengenal pasti dan menyelesaikan masalah dengan cepat. 1. Pengetahuan asas syslog Fungsi teras syslog termasuk: mengumpul dan menguruskan mesej log secara terpusat; menyokong pelbagai format output log dan lokasi sasaran (seperti fail atau rangkaian); Menyediakan fungsi tontonan log dan penapisan masa nyata. 2. Pasang dan konfigurasikan syslog (menggunakan rsyslog) Sistem Debian menggunakan rsyslog secara lalai. Anda boleh memasangnya dengan arahan berikut: sudoaptupdatesud