Peranti teknologi

Peranti teknologi

AI

AI

Gesa untuk memotong gambar dengan satu klik! Meta mengeluarkan model pembahagian imej asas pertama dalam sejarah, mencipta paradigma baharu untuk CV

Gesa untuk memotong gambar dengan satu klik! Meta mengeluarkan model pembahagian imej asas pertama dalam sejarah, mencipta paradigma baharu untuk CV

Gesa untuk memotong gambar dengan satu klik! Meta mengeluarkan model pembahagian imej asas pertama dalam sejarah, mencipta paradigma baharu untuk CV

Sebentar tadi, Meta AI mengeluarkan Model Segmen Anything (SAM) - model asas pertama untuk pembahagian imej.

SAM boleh mencapai pembahagian satu klik bagi mana-mana objek daripada foto atau video, dan boleh dipindahkan ke tugas lain dengan sifar sampel.

Secara keseluruhannya, SAM mengikut idea model asas:

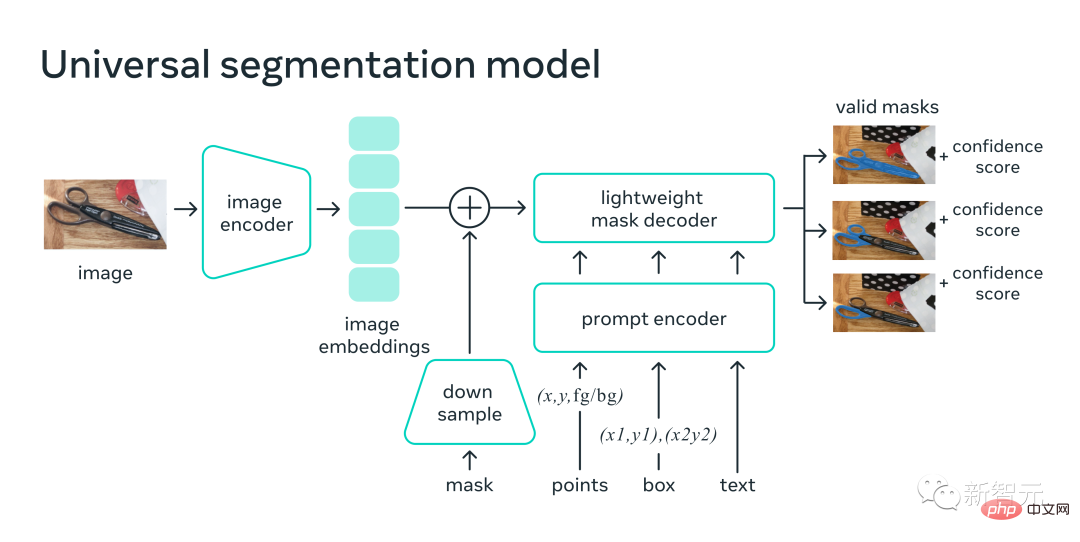

1. Seni bina yang sangat Mudah namun berskala yang boleh mengendalikan isyarat berbilang modal: teks, titik kunci, kotak sempadan.

2. Proses anotasi intuitif, berkait rapat dengan reka bentuk model.

3. Roda tenaga data yang membolehkan model diikat pada sejumlah besar imej tidak berlabel.

Selain itu, tidak keterlaluan untuk mengatakan bahawa SAM telah mempelajari konsep umum "objek", walaupun untuk objek yang tidak diketahui, pemandangan yang tidak dikenali (seperti di bawah air dan di bawah mikroskop) dan kabur. begitu juga untuk kes tersebut.

Selain itu, SAM juga boleh digeneralisasikan kepada tugasan baharu dan bidang baharu, dan pengamal tidak perlu lagi memperhalusi model itu sendiri.

Alamat kertas: https://ai.facebook.com/research/publications/segment-anything/

Perkara yang paling berkuasa ialah Meta melaksanakan paradigma CV yang sama sekali berbeza Anda boleh menentukan titik, kotak sempadan dan ayat dalam pengekod gesaan rangka kerja bersatu untuk membahagikan objek secara langsung dengan satu klik.

Dalam hal ini, pakar algoritma Tencent AI Jin Tian berkata, "Paradigma segera dalam bidang NLP telah mula meluas ke bidang CV. Kali ini, ia mungkin mengubah sepenuhnya cara tradisional pemikiran ramalan tentang CV . Kini anda benar-benar boleh menggunakan model untuk membahagikan mana-mana objek, dan ia adalah dinamik! penglihatan!

Jadi, CV benar-benar tidak wujud lagi?

SAM: "Potong" semua objek dalam mana-mana imej dengan satu klik

Segmen Anything ialah model asas pertama yang dikhususkan untuk pembahagian imej.Segmentasi merujuk kepada mengenal pasti piksel imej yang dimiliki oleh objek dan sentiasa menjadi tugas teras penglihatan komputer.

Walau bagaimanapun, jika anda ingin mencipta model segmentasi yang tepat untuk tugasan tertentu, ia biasanya memerlukan kerja yang sangat khusus oleh pakar Proses ini memerlukan infrastruktur untuk melatih AI dan sejumlah besar data domain beranotasi dengan teliti, jadi ambang adalah sangat tinggi.

Untuk menyelesaikan masalah ini, Meta mencadangkan model asas untuk segmentasi imej-SAM. Model boleh dibayangkan ini, dilatih pada data yang pelbagai, bukan sahaja boleh disesuaikan dengan pelbagai tugas, tetapi juga beroperasi sama seperti cara pembayang digunakan dalam model NLP.

Model SAM memahami konsep "apa itu objek" dan boleh menjana topeng untuk sebarang objek dalam mana-mana imej atau video, malah objek yang tidak pernah dilihat semasa latihan.

SAM sangat serba boleh sehingga meliputi pelbagai kes penggunaan dan boleh digunakan di luar kotak dalam domain pengimejan baharu tanpa latihan tambahan, sama ada foto dalam air, Atau mikroskop sel. Dalam erti kata lain, SAM sudah mempunyai keupayaan migrasi sifar sampel.

Meta berkata dengan teruja dalam blog: Boleh dijangka pada masa hadapan, SAM akan digunakan dalam mana-mana aplikasi yang perlu mencari dan membahagikan objek dalam imej.

SAM boleh menjadi sebahagian daripada sistem AI yang lebih besar untuk memberikan pemahaman pelbagai mod yang lebih umum tentang dunia, contohnya, memahami kandungan visual dan tekstual halaman web.

Dalam bidang AR/VR, SAM boleh memilih objek berdasarkan garis penglihatan pengguna dan kemudian "menaik taraf" objek kepada 3D.

Untuk pencipta kandungan, SAM boleh mengekstrak kawasan imej untuk kolaj atau penyuntingan video.

SAM juga boleh mencari dan menjejak haiwan atau objek dalam video, membantu penyelidikan sains semula jadi dan astronomi.

Kaedah segmentasi universal

Pada masa lalu, terdapat dua cara untuk menyelesaikan masalah segmentasi.

Salah satunya ialah pembahagian interaktif, yang boleh membahagikan objek dalam mana-mana kategori, tetapi memerlukan seseorang untuk memperhalusi topeng melalui lelaran.

Yang kedua ialah pembahagian automatik, yang boleh membahagikan objek tertentu yang ditakrifkan terlebih dahulu, tetapi proses latihan memerlukan sejumlah besar objek yang dilabel secara manual (contohnya, untuk membahagikan kucing, beribu-ribu contoh).

Ringkasnya, kedua-dua kaedah ini tidak boleh menyediakan kaedah segmentasi automatik sepenuhnya yang universal.

Walaupun SAM boleh dilihat sebagai generalisasi kedua-dua kaedah ini, ia boleh dengan mudah melakukan segmentasi interaktif dan segmentasi automatik.

Pada antara muka pantas model, pelbagai tugas pembahagian boleh diselesaikan dengan hanya mereka bentuk gesaan yang betul (klik, kotak, teks, dll.) untuk model.

Selain itu, SAM dilatih mengenai set data yang pelbagai dan berkualiti tinggi yang mengandungi lebih 1 bilion topeng, membolehkan model membuat generalisasi kepada objek dan imej baharu di luar Apa yang diperhatikan semasa latihan. Akibatnya, pengamal tidak perlu lagi mengumpul data pembahagian mereka sendiri untuk memperhalusi model bagi kes penggunaan.

Fleksibiliti jenis ini yang boleh digeneralisasikan kepada tugasan baharu dan medan baharu adalah kali pertama dalam bidang pembahagian imej.

(1) SAM membenarkan pengguna membahagikan objek dengan satu klik, atau mengklik secara interaktif pada banyak mata, dan juga boleh menggunakan pembayang kotak sempadan untuk model.

(2) Apabila berhadapan dengan kekaburan objek bersegmen, SAM boleh mengeluarkan berbilang topeng sah, yang merupakan keupayaan penting untuk menyelesaikan masalah pembahagian dalam dunia nyata.

(3) SAM boleh menemui dan menyekat semua objek dalam imej secara automatik. (4) Selepas prapengiraan pembenaman imej, SAM boleh menjana topeng segmentasi untuk sebarang gesaan dalam masa nyata, membolehkan pengguna berinteraksi dengan model dalam masa nyata.

Cara ia berfungsi

SAM yang dilatih oleh penyelidik boleh mengembalikan topeng segmentasi yang sah untuk sebarang gesaan. Isyarat boleh menjadi titik latar depan/latar belakang, kotak atau topeng kasar, teks bentuk bebas atau secara amnya sebarang maklumat yang menunjukkan bahawa pembahagian diperlukan dalam imej.

Keperluan untuk topeng yang berkesan bermakna walaupun dalam kes di mana gesaan itu samar-samar dan mungkin merujuk kepada berbilang objek (cth. titik pada baju mungkin mewakili sama ada baju atau orang yang memakai baju itu), keluarannya mestilah topeng munasabah bagi salah satu objek.

Para penyelidik mendapati bahawa tugasan pra-latihan dan pengumpulan data interaktif mengenakan kekangan khusus pada reka bentuk model .

Khususnya, model perlu dijalankan dalam masa nyata pada CPU dalam penyemak imbas web supaya kakitangan standard boleh berinteraksi dengan SAM secara cekap dalam masa nyata untuk anotasi.

Walaupun kekangan masa jalan bermakna terdapat pertukaran antara kualiti dan masa jalan, para penyelidik mendapati bahawa dalam amalan, reka bentuk mudah boleh mencapai hasil yang baik.

Pengekod imej SAM menghasilkan pembenaman sekali sahaja untuk imej, manakala penyahkod ringan menukar sebarang pembayang kepada pembenaman vektor dengan cepat. Kedua-dua sumber maklumat ini kemudiannya digabungkan dalam penyahkod ringan yang meramalkan topeng segmentasi.

Selepas mengira pembenaman imej, SAM boleh menjana segmen imej dalam masa 50 milisaat sahaja dan memberikan sebarang gesaan dalam penyemak imbas web.

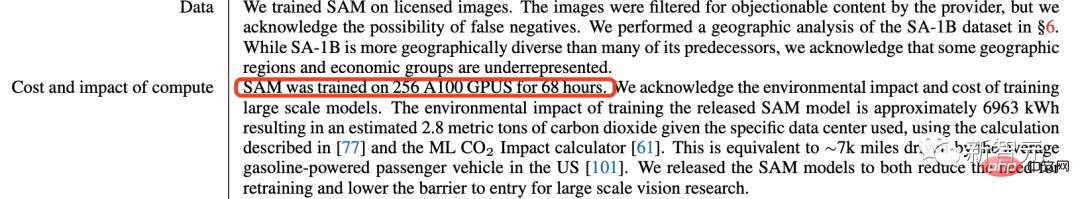

Model SAM terbaharu dilatih pada 256 imej A100 selama 68 jam (hampir 5 hari).

Demonstrasi Projek

Gesaan input berbilang

Gesaan untuk menentukan kandungan yang akan dibahagikan dalam imej, Pelbagai tugasan segmentasi boleh dicapai tanpa latihan tambahan.

Gunakan titik interaksi dan kotak sebagai gesaan

Secara automatik bahagikan semua elemen dalam imej

Janakan berbilang topeng yang sah untuk gesaan yang tidak jelas

Reka bentuk pantas

SAM boleh menerima input gesaan daripada sistem lain.

Sebagai contoh, pilih objek yang sepadan berdasarkan maklumat fokus visual pengguna daripada set kepala AR/VR. Pembangunan AI Meta yang boleh memahami dunia sebenar akan membuka jalan untuk perjalanan metaverse masa depannya.

Sebagai alternatif, laksanakan pembahagian teks ke objek menggunakan pembayang kotak terikat daripada pengesan objek.

Output boleh skala

Topeng output boleh digunakan sebagai input kepada sistem AI lain.

Sebagai contoh, topeng objek boleh dijejaki dalam video, bertukar menjadi 3D melalui aplikasi pengeditan pengimejan atau digunakan untuk tugas kreatif seperti kolaj.

Generalisasi tembakan sifar

SAM belajar seorang jeneral idea tentang apa itu objek - pemahaman ini membolehkan generalisasi sifar pukulan kepada objek dan imej yang tidak dikenali tanpa memerlukan latihan tambahan.

Pelbagai ulasan

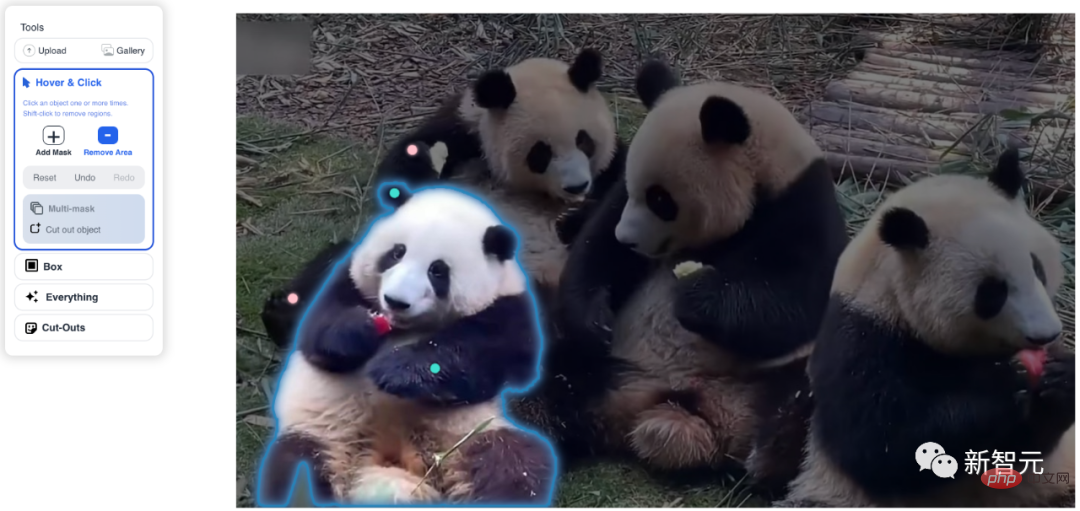

Pilih Tuding&Klik, klik Tambah Topeng dan titik hijau akan muncul, klik Alih Keluar Kawasan dan titik merah akan muncul, Huahua pemakan epal segera dibulatkan.

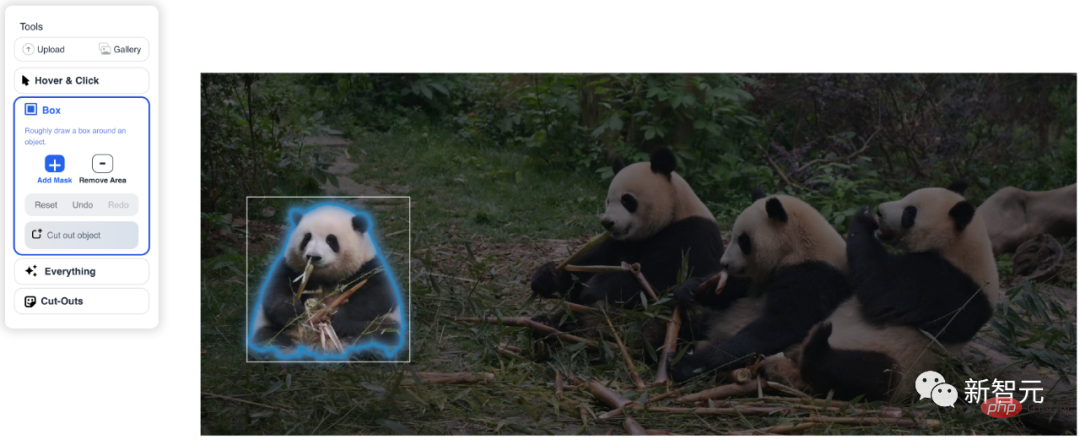

Dalam fungsi Box, hanya pilih kotak dan pengecaman akan selesai serta-merta.

Selepas mengklik Semuanya, semua objek yang dikenali oleh sistem diekstrak serta-merta.

Selepas memilih Potongan, anda akan mendapat ladu segi tiga dalam beberapa saat.

Dataset SA-1B: 11 juta imej, 1.1 bilion topeng

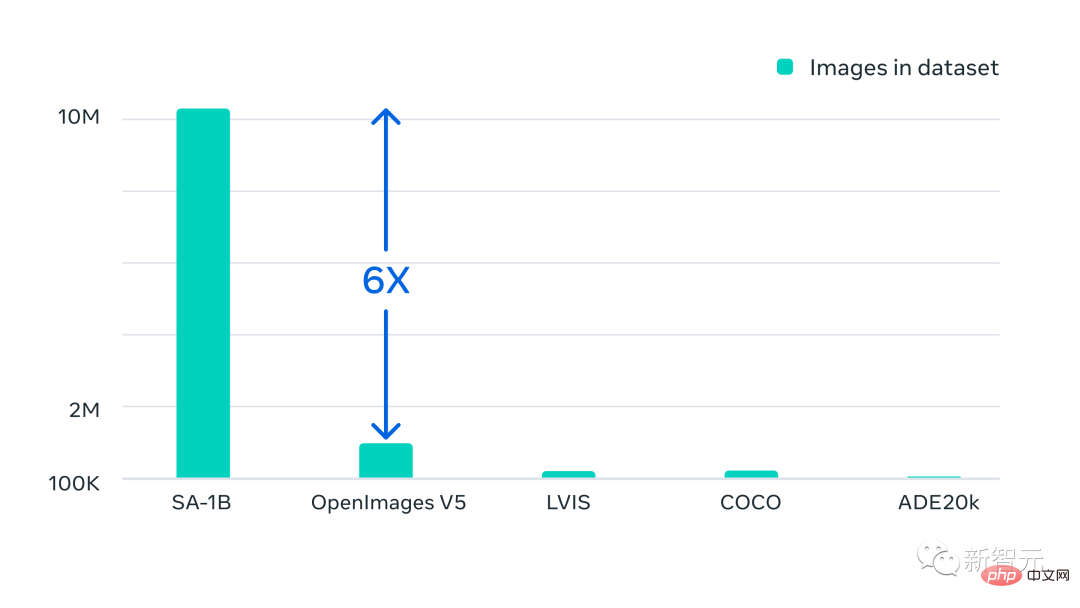

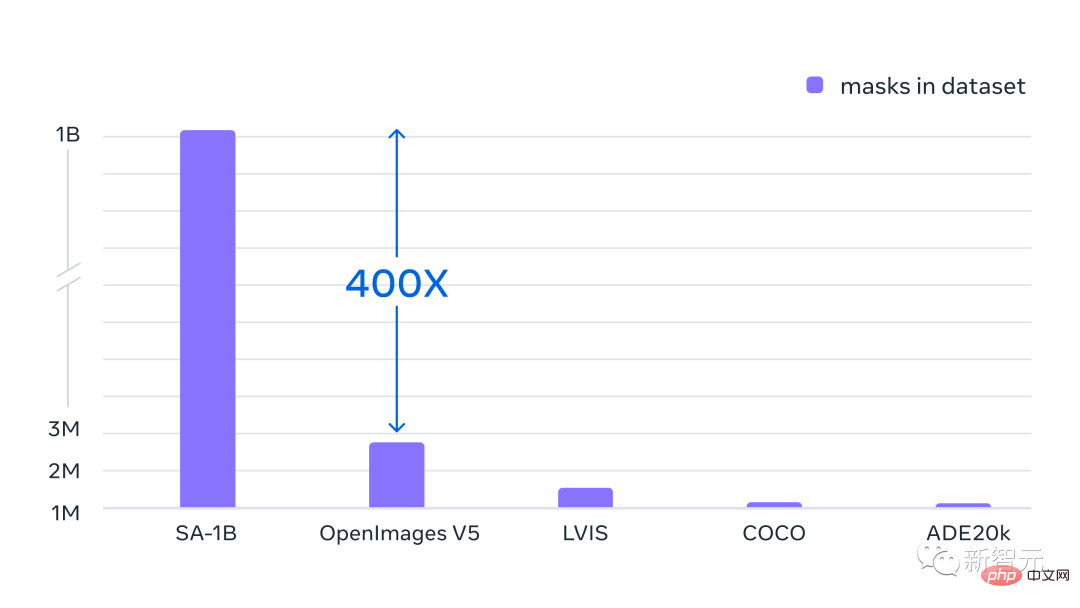

Selain model baharu yang dikeluarkan, Meta Juga dikeluarkan ialah SA-1B, set data segmentasi terbesar setakat ini.

Data data ini terdiri daripada 11 juta imej yang pelbagai, beresolusi tinggi, memelihara privasi dan 1.1 bilion topeng segmentasi berkualiti tinggi.

Ciri-ciri keseluruhan set data adalah seperti berikut:

· Jumlah bilangan imej: 11 juta

· Jumlah bilangan topeng: 1.1 bilion

· Purata topeng bagi setiap imej: 100

· Purata peleraian imej: 1500 × 2250 piksel

Nota: Anotasi imej atau topeng tidak mempunyai label kelas

Meta secara khusus menekankan bahawa data ini dikumpulkan melalui enjin data kami , semua Topeng semuanya dijana secara automatik sepenuhnya oleh SAM.

Dengan model SAM, pengumpulan topeng segmentasi baharu adalah lebih pantas berbanding sebelum ini, dan menganotasi topeng secara interaktif hanya mengambil masa kira-kira 14 saat.

Proses pelabelan untuk setiap topeng hanya 2 kali lebih perlahan daripada melabel kotak sempadan Menggunakan antara muka pelabelan terpantas, pelabelan kotak sempadan mengambil masa kira-kira 7 saat.

Berbanding dengan usaha pengumpulan data segmentasi berskala besar sebelum ini, anotasi topeng berasaskan poligon manual penuh model SAM COCO adalah 6.5 kali lebih pantas daripada usaha anotasi data terbesar sebelumnya (juga model Auxiliary) 2 kali lebih cepat.

Walau bagaimanapun, bergantung pada topeng anotasi interaktif tidak mencukupi untuk mencipta lebih daripada 1 bilion set data bertopeng. Oleh itu, Meta membina enjin data untuk mencipta set data SA-1B.

Enjin data ini mempunyai tiga "gear":

1 anotasi tambahan model

2. Campuran anotasi automatik sepenuhnya dan anotasi tambahan membantu meningkatkan kepelbagaian topeng yang dikumpul

3. Penciptaan topeng automatik sepenuhnya membolehkan set data dikembangkan

Set data terakhir kami termasuk lebih 1.1 bilion topeng segmentasi yang dikumpulkan pada kira-kira 11 juta imej yang dibenarkan dan memelihara privasi.

SA-1B mempunyai 400x lebih topeng daripada mana-mana set data segmentasi sedia ada. Dan kajian penilaian manusia mengesahkan bahawa topeng adalah berkualiti tinggi dan kepelbagaian, dan dalam beberapa kes malah secara kualitatif setanding dengan topeng sebelumnya daripada set data beranotasi manual sepenuhnya yang lebih kecil.

Gambar SA-1B diperolehi melalui pembekal foto dari pelbagai negara, Negara-negara ini merangkumi wilayah geografi yang berbeza dan tingkat pendapatan.

Walaupun sesetengah wilayah geografi masih kurang diwakili, SA-1B mempunyai lebih banyak imej dan perwakilan keseluruhan yang lebih baik di semua wilayah berbanding set data segmentasi sebelumnya.

Akhirnya, Meta berkata ia berharap data ini boleh membentuk asas set data baharu yang mengandungi anotasi tambahan, seperti penerangan teks yang dikaitkan dengan setiap topeng.

Tuan RBG mengetuai pasukan

Ross Girshick

Ross Girshick (sering dipanggil guru RBG) ialah seorang saintis penyelidikan di Institut Penyelidikan Kecerdasan Buatan Facebook (FAIR), di mana beliau komited terhadap penglihatan komputer dan penyelidikan pembelajaran mesin.

Pada tahun 2012, Ross Girshick menerima PhD dalam Sains Komputer dari Universiti Chicago di bawah penyeliaan Pedro Felzenszwalb.

Sebelum menyertai FAIR, Ross ialah seorang penyelidik di Microsoft Research dan postdoc di University of California, Berkeley, di mana mentornya ialah Jitendra Malik dan Trevor Darrell.

Beliau menerima Anugerah Penyelidik Muda PAMI pada 2017 dan Anugerah PAMI Mark Everingham pada 2017 dan 2021 sebagai mengiktiraf sumbangannya kepada perisian sumber terbuka.

Seperti yang kita sedia maklum, Ross dan He Kaiming bersama-sama membangunkan algoritma pengesanan sasaran kaedah R-CNN. Pada 2017, kertas Mask R-CNN oleh Ross dan He Kaiming memenangi kertas terbaik dalam ICCV 2017.

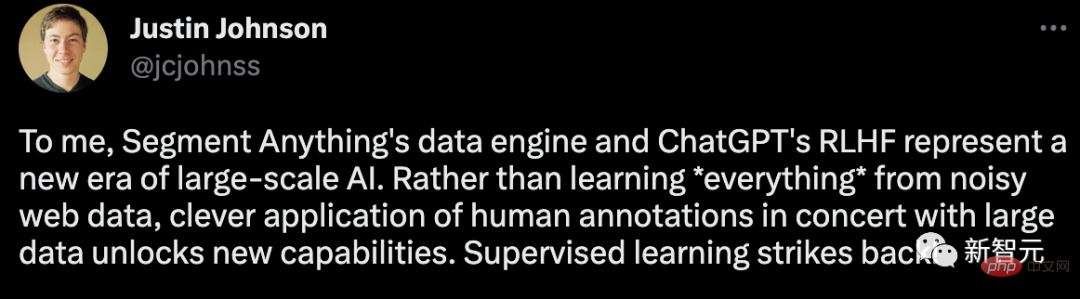

Netizen: CV benar-benar tidak wujud lagi

Model asas segmentasi dalam medan CV ciptaan Meta ini telah membuatkan ramai netizen menjerit, “Sekarang, CV betul-betul tidak 'Tidak wujud lagi. "Bagi saya, enjin data Segment Anything dan RLHF ChatGPT mewakili gambaran besar," kata saintis Meta, Justin Johnson, era baharu kecerdasan buatan daripada mempelajari segala-galanya daripada data rangkaian yang bising pelabelan manusia dengan data besar untuk mengeluarkan keupayaan baharu 》

Satu-satunya penyesalan ialah keluaran model SAM. diketuai terutamanya oleh Ross Girshick, tetapi He Yuming tidak hadir.

Rakan "matriks Mingzi" berkata bahawa artikel ini membuktikan lagi bahawa multimodaliti adalah CV Tiada hari esok untuk CV tulen.

Atas ialah kandungan terperinci Gesa untuk memotong gambar dengan satu klik! Meta mengeluarkan model pembahagian imej asas pertama dalam sejarah, mencipta paradigma baharu untuk CV. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1378

1378

52

52

Cara Melaksanakan Penyortiran Fail oleh Debian Readdir

Apr 13, 2025 am 09:06 AM

Cara Melaksanakan Penyortiran Fail oleh Debian Readdir

Apr 13, 2025 am 09:06 AM

Dalam sistem Debian, fungsi Readdir digunakan untuk membaca kandungan direktori, tetapi urutan yang dikembalikannya tidak ditentukan sebelumnya. Untuk menyusun fail dalam direktori, anda perlu membaca semua fail terlebih dahulu, dan kemudian menyusunnya menggunakan fungsi QSORT. Kod berikut menunjukkan cara menyusun fail direktori menggunakan ReadDir dan QSORT dalam sistem Debian:#termasuk#termasuk#termasuk#termasuk // fungsi perbandingan adat, yang digunakan untuk qSortintCompare (Constvoid*A, Constvoid*b) {Returnstrcmp (*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(

Cara Mengoptimumkan Prestasi Debian Readdir

Apr 13, 2025 am 08:48 AM

Cara Mengoptimumkan Prestasi Debian Readdir

Apr 13, 2025 am 08:48 AM

Dalam sistem Debian, panggilan sistem Readdir digunakan untuk membaca kandungan direktori. Jika prestasinya tidak baik, cuba strategi pengoptimuman berikut: Memudahkan bilangan fail direktori: Split direktori besar ke dalam pelbagai direktori kecil sebanyak mungkin, mengurangkan bilangan item yang diproses setiap panggilan readdir. Dayakan Caching Kandungan Direktori: Bina mekanisme cache, kemas kini cache secara teratur atau apabila kandungan direktori berubah, dan mengurangkan panggilan kerap ke Readdir. Cafh memori (seperti memcached atau redis) atau cache tempatan (seperti fail atau pangkalan data) boleh dipertimbangkan. Mengamalkan struktur data yang cekap: Sekiranya anda melaksanakan traversal direktori sendiri, pilih struktur data yang lebih cekap (seperti jadual hash dan bukannya carian linear) untuk menyimpan dan mengakses maklumat direktori

Bagaimana Debian OpenSSL Menghalang Serangan Man-dalam-Middle

Apr 13, 2025 am 10:30 AM

Bagaimana Debian OpenSSL Menghalang Serangan Man-dalam-Middle

Apr 13, 2025 am 10:30 AM

Dalam sistem Debian, OpenSSL adalah perpustakaan penting untuk pengurusan penyulitan, penyahsulitan dan sijil. Untuk mengelakkan serangan lelaki-dalam-pertengahan (MITM), langkah-langkah berikut boleh diambil: Gunakan HTTPS: Pastikan semua permintaan rangkaian menggunakan protokol HTTPS dan bukannya HTTP. HTTPS menggunakan TLS (Protokol Keselamatan Lapisan Pengangkutan) untuk menyulitkan data komunikasi untuk memastikan data tidak dicuri atau diganggu semasa penghantaran. Sahkan Sijil Pelayan: Sahkan secara manual Sijil Pelayan pada klien untuk memastikan ia boleh dipercayai. Pelayan boleh disahkan secara manual melalui kaedah perwakilan urlSession

Cara Menetapkan Tahap Log Debian Apache

Apr 13, 2025 am 08:33 AM

Cara Menetapkan Tahap Log Debian Apache

Apr 13, 2025 am 08:33 AM

Artikel ini menerangkan cara menyesuaikan tahap pembalakan pelayan Apacheweb dalam sistem Debian. Dengan mengubah suai fail konfigurasi, anda boleh mengawal tahap maklumat log yang direkodkan oleh Apache. Kaedah 1: Ubah suai fail konfigurasi utama untuk mencari fail konfigurasi: Fail konfigurasi apache2.x biasanya terletak di direktori/etc/apache2/direktori. Nama fail mungkin apache2.conf atau httpd.conf, bergantung pada kaedah pemasangan anda. Edit Fail Konfigurasi: Buka Fail Konfigurasi dengan Kebenaran Root Menggunakan Editor Teks (seperti Nano): Sudonano/ETC/APACHE2/APACHE2.CONF

Bagaimana Debian Readdir Bersepadu Dengan Alat Lain

Apr 13, 2025 am 09:42 AM

Bagaimana Debian Readdir Bersepadu Dengan Alat Lain

Apr 13, 2025 am 09:42 AM

Fungsi Readdir dalam sistem Debian adalah panggilan sistem yang digunakan untuk membaca kandungan direktori dan sering digunakan dalam pengaturcaraan C. Artikel ini akan menerangkan cara mengintegrasikan Readdir dengan alat lain untuk meningkatkan fungsinya. Kaedah 1: Menggabungkan Program Bahasa C dan Pipeline Pertama, tulis program C untuk memanggil fungsi Readdir dan output hasilnya:#termasuk#termasuk#includeintMain (intargc, char*argv []) {dir*dir; structdirent*entry; if (argc! = 2) {

Kaedah pemasangan sijil SSL Server Server Debian

Apr 13, 2025 am 11:39 AM

Kaedah pemasangan sijil SSL Server Server Debian

Apr 13, 2025 am 11:39 AM

Langkah -langkah untuk memasang sijil SSL pada pelayan mel Debian adalah seperti berikut: 1. Pasang OpenSSL Toolkit terlebih dahulu, pastikan bahawa OpenSSL Toolkit telah dipasang pada sistem anda. Jika tidak dipasang, anda boleh menggunakan arahan berikut untuk memasang: sudoapt-getupdateudoapt-getinstallopenssl2. Menjana permintaan kunci dan sijil peribadi seterusnya, gunakan OpenSSL untuk menjana kunci peribadi RSA 2048-bit dan permintaan sijil (CSR): Membuka

Petua Konfigurasi Firewall Pelayan Mel Debian

Apr 13, 2025 am 11:42 AM

Petua Konfigurasi Firewall Pelayan Mel Debian

Apr 13, 2025 am 11:42 AM

Mengkonfigurasi firewall pelayan Mail Debian adalah langkah penting dalam memastikan keselamatan pelayan. Berikut adalah beberapa kaedah konfigurasi firewall yang biasa digunakan, termasuk penggunaan iptables dan firewalld. Gunakan iptables untuk mengkonfigurasi firewall untuk memasang iptables (jika belum dipasang): sudoapt-getupdateudoapt-getinstalliplesview peraturan iptables semasa: konfigurasi sudoiptable-l

Cara Belajar Debian Syslog

Apr 13, 2025 am 11:51 AM

Cara Belajar Debian Syslog

Apr 13, 2025 am 11:51 AM

Panduan ini akan membimbing anda untuk belajar cara menggunakan syslog dalam sistem Debian. SYSLOG adalah perkhidmatan utama dalam sistem Linux untuk sistem pembalakan dan mesej log aplikasi. Ia membantu pentadbir memantau dan menganalisis aktiviti sistem untuk mengenal pasti dan menyelesaikan masalah dengan cepat. 1. Pengetahuan asas syslog Fungsi teras syslog termasuk: mengumpul dan menguruskan mesej log secara terpusat; menyokong pelbagai format output log dan lokasi sasaran (seperti fail atau rangkaian); Menyediakan fungsi tontonan log dan penapisan masa nyata. 2. Pasang dan konfigurasikan syslog (menggunakan rsyslog) Sistem Debian menggunakan rsyslog secara lalai. Anda boleh memasangnya dengan arahan berikut: sudoaptupdatesud