Peranti teknologi

Peranti teknologi

AI

AI

Untuk menyelesaikan masalah pembelajaran perwakilan VAE, Universiti Hokkaido mencadangkan model generatif baharu GWAE

Untuk menyelesaikan masalah pembelajaran perwakilan VAE, Universiti Hokkaido mencadangkan model generatif baharu GWAE

Untuk menyelesaikan masalah pembelajaran perwakilan VAE, Universiti Hokkaido mencadangkan model generatif baharu GWAE

Mempelajari perwakilan berdimensi rendah bagi data berdimensi tinggi adalah tugas asas dalam pembelajaran tanpa penyeliaan kerana perwakilan tersebut secara ringkas menangkap intipati data dan membolehkan pelaksanaan berdasarkan input berdimensi rendah tugas hiliran adalah mungkin. Pengekod auto variasi (VAE) ialah kaedah pembelajaran perwakilan yang penting, namun disebabkan pembelajaran perwakilan kawalan objektifnya masih merupakan tugas yang mencabar. Walaupun matlamat evidens lower bound (ELBO) VAE dimodelkan secara generatif, perwakilan pembelajaran tidak disasarkan secara langsung pada matlamat ini, yang memerlukan pengubahsuaian khusus kepada tugas pembelajaran perwakilan, seperti pengasingan. Pengubahsuaian ini kadangkala membawa kepada perubahan tersirat dan tidak diingini dalam model, menjadikan pembelajaran perwakilan terkawal sebagai tugas yang mencabar.

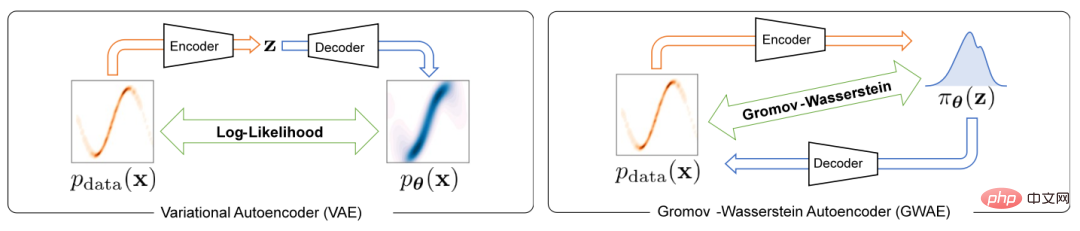

Untuk menyelesaikan masalah pembelajaran perwakilan dalam autoenkoder variasi, kertas kerja ini mencadangkan model generatif baharu yang dipanggil Gromov-Wasserstein Autoencoders (GWAE). GWAE menyediakan rangka kerja baharu untuk pembelajaran perwakilan berdasarkan seni bina model pengekod auto variasi (VAE). Tidak seperti kaedah pembelajaran perwakilan berasaskan VAE tradisional untuk pemodelan generatif pembolehubah data, GWAE memperoleh perwakilan yang bermanfaat melalui pemindahan optimum antara data dan pembolehubah terpendam. Metrik Gromov-Wasserstein (GW) membolehkan pemindahan optimum sedemikian antara pembolehubah yang tidak dapat dibandingkan (cth. pembolehubah dengan dimensi berbeza), yang memfokuskan pada struktur jarak pembolehubah yang sedang dipertimbangkan. Dengan menggantikan objektif ELBO dengan metrik GW, GWAE melakukan perbandingan antara data dan ruang terpendam, secara langsung menyasarkan pembelajaran perwakilan dalam pengekod auto variasi (Rajah 1). Rumusan pembelajaran perwakilan ini membolehkan perwakilan yang dipelajari mempunyai sifat khusus yang dianggap bermanfaat (cth., kebolehuraian), yang dipanggil meta-prior.

Rajah 1 Perbezaan antara VAE dan GWAE

Kajian ini telah setakat ini Diterima oleh ICLR 2023.

- Pautan kertas: https://arxiv.org/abs/2209.07007

- Pautan kod: https://github.com/ganmodokix/gwae

Pengenalan kaedah

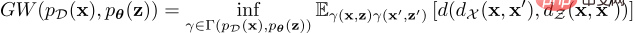

Antara pengedaran data dan potensi pengedaran terdahulu The GW sasaran ditakrifkan seperti berikut:

Formula kos penghantaran optimum ini boleh mengukur ketidakkonsistenan pengagihan dalam ruang yang tiada tandingannya, bagaimanapun, untuk pengagihan berterusan; adalah tidak praktikal untuk mengira nilai GW yang tepat kerana keperluan untuk mengikat bawah semua gandingan. Untuk menyelesaikan masalah ini, GWAE menyelesaikan masalah pengoptimuman yang santai untuk menganggar dan meminimumkan penganggar GW, yang kecerunannya boleh dikira dengan pembezaan automatik. Sasaran kelonggaran ialah jumlah anggaran metrik GW dan tiga kerugian regularisasi, yang semuanya boleh dilaksanakan dalam rangka kerja pengaturcaraan yang boleh dibezakan seperti PyTorch. Objektif kelonggaran ini terdiri daripada kerugian utama dan tiga kerugian regularisasi, iaitu anggaran kehilangan GW utama, kerugian pembinaan semula berasaskan WAE, kerugian keadaan mencukupi yang digabungkan, dan kerugian regularisasi entropi.

Skim ini juga boleh menyesuaikan pengedaran terdahulu secara fleksibel untuk memperkenalkan ciri berfaedah ke dalam perwakilan dimensi rendah. Secara khusus, makalah itu memperkenalkan tiga populasi terdahulu, iaitu:

Neural Priori (NP) Dalam GWAE dengan NP , rangkaian neural yang bersambung sepenuhnya digunakan untuk membina pensampel priori. Keluarga taburan terdahulu ini membuat lebih sedikit andaian tentang pembolehubah asas dan sesuai untuk situasi umum.

Factorized Neural Prior (FNP)Dalam GWAE dengan FNP, gunakan prior neural yang disambungkan secara setempat Rangkaian membina pensampel di mana entri untuk setiap pembolehubah terpendam dijana secara bebas. Pensampel ini menghasilkan perwakilan bebas sebelum berfaktor dan perwakilan bebas mengikut istilah, yang merupakan kaedah yang menonjol untuk pembongkaran meta-dahulu perwakilan.

Gaussian Mixture Prior (GMP) Dalam GMP, ia ditakrifkan sebagai campuran beberapa taburan Gaussian, dan pensampelnya boleh menggunakan berat Teknik parameterisasi dan teknik Gumbel-Max dilaksanakan. GMP membenarkan kluster dihipotesiskan dalam perwakilan, di mana setiap komponen Gaussian sebelumnya dijangka menangkap kluster.

Eksperimen dan keputusan

Kajian ini menjalankan penilaian empirikal GWAE dengan dua meta-prior utama : Keterjeratan Penyelesaian dan pengelompokan .

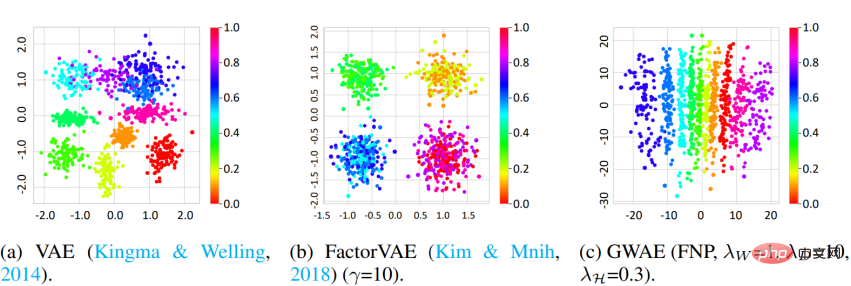

Penyelesaian Kajian menggunakan set data Bentuk 3D dan metrik DCI untuk mengukur keupayaan penguraian GWAE. Keputusan menunjukkan bahawa GWAE menggunakan FNP dapat mempelajari faktor rona objek pada paksi tunggal, yang menunjukkan keupayaan penguraian GWAE. Penilaian kuantitatif juga menunjukkan prestasi penguraian GWAE.

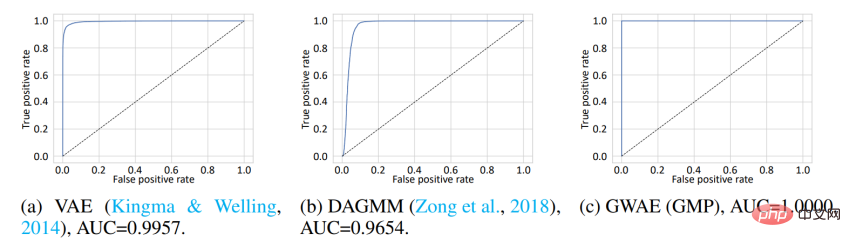

Pengelompokkan Untuk menilai perwakilan yang diperolehi berdasarkan pengelompokan meta-prioris, kajian ini menjalankan Out-of -Pengesanan pengedaran (OoD). Dataset MNIST digunakan sebagai data In-Distribution (ID) dan dataset Omniglot digunakan sebagai data OoD. Walaupun MNIST mengandungi nombor tulisan tangan, Omniglot mengandungi huruf tulisan tangan dengan huruf yang berbeza. Dalam percubaan ini, set data ID dan OoD berkongsi domain imej tulisan tangan, tetapi ia mengandungi aksara yang berbeza. Model dilatih tentang data ID dan kemudian menggunakan perwakilan yang dipelajari untuk mengesan data ID atau OoD. Dalam VAE dan DAGMM, pembolehubah yang digunakan untuk pengesanan OoD ialah kemungkinan log terdahulu, manakala dalam GWAE ia adalah potensi Kantorovich. Sebelum untuk GWAE telah dibina menggunakan GMP untuk menangkap kelompok MNIST. Lengkung ROC menunjukkan prestasi pengesanan OoD model, dengan ketiga-tiga model mencapai prestasi hampir sempurna walau bagaimanapun, GWAE yang dibina menggunakan GMP menunjukkan prestasi terbaik dari segi kawasan di bawah lengkung (AUC).

Selain itu, kajian ini menilai keupayaan generatif GWAE.

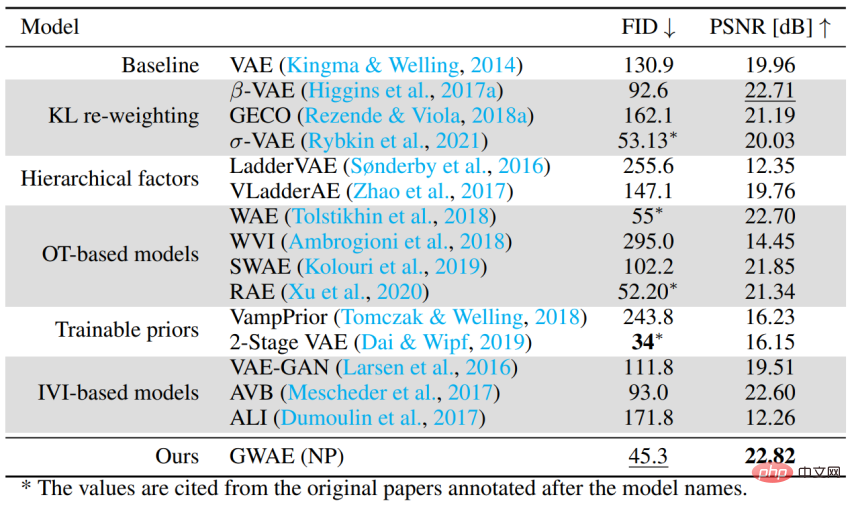

Prestasi sebagai model generatif berasaskan pengekod auto Untuk menilai keupayaan GWAE mengendalikan kes umum tanpa meta-prior tertentu, data CelebA telah digunakan Set prestasi penjanaan dinilai. Percubaan menggunakan FID untuk menilai prestasi generatif model dan PSNR untuk menilai prestasi pengekodan auto. GWAE mencapai prestasi generatif kedua terbaik dan prestasi autopengekodan terbaik menggunakan NP, menunjukkan keupayaannya untuk menangkap pengedaran data dalam modelnya dan menangkap maklumat data dalam perwakilannya.

Ringkasan

- GWAE ialah model generatif autoenkoder variasi yang dibina berdasarkan metrik Gromov-Wasserstein, bertujuan untuk Mengarahkan pembelajaran perwakilan.

- Memandangkan prior hanya memerlukan sampel yang boleh dibezakan, pelbagai tetapan pengedaran terdahulu boleh dibina untuk menganggap meta-prior (sifat ideal bagi perwakilan).

- Eksperimen pada meta-prior utama dan penilaian prestasi sebagai pengekod auto variasi menunjukkan fleksibiliti perumusan GWAE dan keupayaan pembelajaran perwakilan GWAE.

- Laman utama peribadi pengarang pertama Nao Nakagawa: https://ganmodokix.com/note/cv

- Laman utama Makmal Multimedia Universiti Hokkaido: https://www-lmd.ist.hokudai.ac.jp/

Atas ialah kandungan terperinci Untuk menyelesaikan masalah pembelajaran perwakilan VAE, Universiti Hokkaido mencadangkan model generatif baharu GWAE. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1376

1376

52

52

Pemula AI secara kolektif menukar pekerjaan kepada OpenAI, dan pasukan keselamatan berkumpul semula selepas Ilya pergi!

Jun 08, 2024 pm 01:00 PM

Pemula AI secara kolektif menukar pekerjaan kepada OpenAI, dan pasukan keselamatan berkumpul semula selepas Ilya pergi!

Jun 08, 2024 pm 01:00 PM

Minggu lalu, di tengah gelombang peletakan jawatan dalaman dan kritikan luar, OpenAI dibelenggu oleh masalah dalaman dan luaran: - Pelanggaran kakak balu itu mencetuskan perbincangan hangat global - Pekerja menandatangani "fasal tuan" didedahkan satu demi satu - Netizen menyenaraikan " Ultraman " tujuh dosa maut" ” Pembasmi khabar angin: Menurut maklumat dan dokumen bocor yang diperolehi oleh Vox, kepimpinan kanan OpenAI, termasuk Altman, sangat mengetahui peruntukan pemulihan ekuiti ini dan menandatanganinya. Di samping itu, terdapat isu serius dan mendesak yang dihadapi oleh OpenAI - keselamatan AI. Pemergian lima pekerja berkaitan keselamatan baru-baru ini, termasuk dua pekerjanya yang paling terkemuka, dan pembubaran pasukan "Penjajaran Super" sekali lagi meletakkan isu keselamatan OpenAI dalam perhatian. Majalah Fortune melaporkan bahawa OpenA

Bagaimana untuk menilai keberkesanan kos sokongan komersial untuk rangka kerja Java

Jun 05, 2024 pm 05:25 PM

Bagaimana untuk menilai keberkesanan kos sokongan komersial untuk rangka kerja Java

Jun 05, 2024 pm 05:25 PM

Menilai kos/prestasi sokongan komersial untuk rangka kerja Java melibatkan langkah-langkah berikut: Tentukan tahap jaminan yang diperlukan dan jaminan perjanjian tahap perkhidmatan (SLA). Pengalaman dan kepakaran pasukan sokongan penyelidikan. Pertimbangkan perkhidmatan tambahan seperti peningkatan, penyelesaian masalah dan pengoptimuman prestasi. Timbang kos sokongan perniagaan terhadap pengurangan risiko dan peningkatan kecekapan.

Model 70B menjana 1,000 token dalam beberapa saat, penulisan semula kod mengatasi GPT-4o, daripada pasukan Kursor, artifak kod yang dilaburkan oleh OpenAI

Jun 13, 2024 pm 03:47 PM

Model 70B menjana 1,000 token dalam beberapa saat, penulisan semula kod mengatasi GPT-4o, daripada pasukan Kursor, artifak kod yang dilaburkan oleh OpenAI

Jun 13, 2024 pm 03:47 PM

Model 70B, 1000 token boleh dijana dalam beberapa saat, yang diterjemahkan kepada hampir 4000 aksara! Para penyelidik memperhalusi Llama3 dan memperkenalkan algoritma pecutan Berbanding dengan versi asli, kelajuannya adalah 13 kali lebih pantas! Bukan sahaja ia pantas, prestasinya pada tugas menulis semula kod malah mengatasi GPT-4o. Pencapaian ini datang dari mana-mana, pasukan di belakang Kursor artifak pengaturcaraan AI yang popular, dan OpenAI turut mengambil bahagian dalam pelaburan. Anda mesti tahu bahawa pada Groq, rangka kerja pecutan inferens pantas yang terkenal, kelajuan inferens 70BLlama3 hanyalah lebih daripada 300 token sesaat. Dengan kelajuan Kursor, boleh dikatakan bahawa ia mencapai penyuntingan fail kod lengkap hampir serta-merta. Sesetengah orang memanggilnya lelaki yang baik, jika anda meletakkan Curs

Bagaimanakah keluk pembelajaran rangka kerja PHP berbanding rangka kerja bahasa lain?

Jun 06, 2024 pm 12:41 PM

Bagaimanakah keluk pembelajaran rangka kerja PHP berbanding rangka kerja bahasa lain?

Jun 06, 2024 pm 12:41 PM

Keluk pembelajaran rangka kerja PHP bergantung pada kecekapan bahasa, kerumitan rangka kerja, kualiti dokumentasi dan sokongan komuniti. Keluk pembelajaran rangka kerja PHP adalah lebih tinggi jika dibandingkan dengan rangka kerja Python dan lebih rendah jika dibandingkan dengan rangka kerja Ruby. Berbanding dengan rangka kerja Java, rangka kerja PHP mempunyai keluk pembelajaran yang sederhana tetapi masa yang lebih singkat untuk bermula.

Bagaimanakah pilihan rangka kerja PHP yang ringan mempengaruhi prestasi aplikasi?

Jun 06, 2024 am 10:53 AM

Bagaimanakah pilihan rangka kerja PHP yang ringan mempengaruhi prestasi aplikasi?

Jun 06, 2024 am 10:53 AM

Rangka kerja PHP yang ringan meningkatkan prestasi aplikasi melalui saiz kecil dan penggunaan sumber yang rendah. Ciri-cirinya termasuk: saiz kecil, permulaan pantas, penggunaan memori yang rendah, kelajuan dan daya tindak balas yang dipertingkatkan, dan penggunaan sumber yang dikurangkan: SlimFramework mencipta API REST, hanya 500KB, responsif yang tinggi dan daya pemprosesan yang tinggi.

China Mobile: Kemanusiaan memasuki revolusi perindustrian keempat dan secara rasmi mengumumkan 'tiga rancangan'

Jun 27, 2024 am 10:29 AM

China Mobile: Kemanusiaan memasuki revolusi perindustrian keempat dan secara rasmi mengumumkan 'tiga rancangan'

Jun 27, 2024 am 10:29 AM

Menurut berita pada 26 Jun, pada majlis perasmian Persidangan Komunikasi Mudah Alih Dunia 2024 Shanghai (MWC Shanghai), Pengerusi Mudah Alih China Yang Jie menyampaikan ucapan. Beliau berkata, pada masa ini, masyarakat manusia memasuki revolusi industri keempat, yang dikuasai oleh maklumat dan sangat bersepadu dengan maklumat dan tenaga, iaitu "revolusi kecerdasan digital", dan pembentukan kuasa produktif baru semakin pesat. Yang Jie percaya bahawa daripada "revolusi mekanisasi" yang digerakkan oleh enjin wap, kepada "revolusi elektrifikasi" yang didorong oleh elektrik dan enjin pembakaran dalaman, kepada "revolusi maklumat" yang didorong oleh komputer dan Internet, setiap pusingan revolusi perindustrian adalah berdasarkan "maklumat dan "Tenaga" adalah barisan utama, membawa pembangunan produktiviti

Bagaimana untuk memilih rangka kerja golang terbaik untuk senario aplikasi yang berbeza

Jun 05, 2024 pm 04:05 PM

Bagaimana untuk memilih rangka kerja golang terbaik untuk senario aplikasi yang berbeza

Jun 05, 2024 pm 04:05 PM

Pilih rangka kerja Go terbaik berdasarkan senario aplikasi: pertimbangkan jenis aplikasi, ciri bahasa, keperluan prestasi dan ekosistem. Rangka kerja Common Go: Gin (aplikasi Web), Echo (Perkhidmatan Web), Fiber (daya pemprosesan tinggi), gorm (ORM), fasthttp (kelajuan). Kes praktikal: membina REST API (Fiber) dan berinteraksi dengan pangkalan data (gorm). Pilih rangka kerja: pilih fasthttp untuk prestasi utama, Gin/Echo untuk aplikasi web yang fleksibel, dan gorm untuk interaksi pangkalan data.

Kisah dalaman algoritma carian Google telah didedahkan, dan 2,500 halaman dokumen telah dibocorkan dengan nama sebenar! Pembohongan Kedudukan Carian Terbongkar

Jun 11, 2024 am 09:14 AM

Kisah dalaman algoritma carian Google telah didedahkan, dan 2,500 halaman dokumen telah dibocorkan dengan nama sebenar! Pembohongan Kedudukan Carian Terbongkar

Jun 11, 2024 am 09:14 AM

Baru-baru ini, 2,500 halaman dokumen dalaman Google telah dibocorkan, mendedahkan cara carian, "penimbang tara Internet yang paling berkuasa," beroperasi. Pengasas bersama dan Ketua Pegawai Eksekutif SparkToro ialah orang tanpa nama Dia menerbitkan catatan blog di tapak web peribadinya, dengan mendakwa bahawa "orang tanpa nama berkongsi dengan saya beribu-ribu halaman dokumentasi API Carian Google yang perlu dibaca oleh semua orang dalam SEO." ! "Selama bertahun-tahun, RandFishkin telah menjadi jurucakap teratas dalam bidang SEO (Pengoptimuman Enjin Carian, pengoptimuman enjin carian), dan beliau mencadangkan konsep "pihak berkuasa laman web" (DomainRating). Oleh kerana dia sangat dihormati dalam bidang ini, RandFishkin