Peranti teknologi

Peranti teknologi

AI

AI

Semakan model bahasa berskala besar yang baru dikeluarkan: ulasan paling komprehensif dari T5 hingga GPT-4, dikarang bersama oleh lebih daripada 20 penyelidik domestik

Semakan model bahasa berskala besar yang baru dikeluarkan: ulasan paling komprehensif dari T5 hingga GPT-4, dikarang bersama oleh lebih daripada 20 penyelidik domestik

Semakan model bahasa berskala besar yang baru dikeluarkan: ulasan paling komprehensif dari T5 hingga GPT-4, dikarang bersama oleh lebih daripada 20 penyelidik domestik

Sejak Ujian Turing dicadangkan pada tahun 1950-an, orang ramai telah meneroka keupayaan mesin untuk memproses kecerdasan linguistik. Bahasa pada asasnya adalah sistem ekspresi manusia yang rumit, dikawal oleh peraturan tatabahasa. Oleh itu, terdapat cabaran besar dalam membangunkan algoritma AI yang berkuasa yang boleh memahami dan menguasai bahasa. Dalam dua dekad yang lalu, kaedah pemodelan bahasa telah digunakan secara meluas untuk pemahaman dan penjanaan bahasa, termasuk model bahasa statistik dan model bahasa saraf.

Dalam beberapa tahun kebelakangan ini, penyelidik telah menghasilkan model bahasa pra-latihan (PLM) dengan melatih pra-latihan model Transformer pada korpora berskala besar, dan telah menunjukkan kuasa besar dalam menyelesaikan pelbagai tugas NLP kebolehan. Dan penyelidik mendapati bahawa penskalaan model boleh membawa peningkatan prestasi, jadi mereka terus mengkaji kesan penskalaan dengan meningkatkan saiz model. Menariknya, apabila saiz parameter melebihi tahap tertentu, model bahasa yang lebih besar ini mencapai peningkatan prestasi yang ketara dan muncul keupayaan yang tidak terdapat dalam model kecil, seperti pembelajaran konteks. Untuk membezakannya daripada PLM, model sedemikian dipanggil model bahasa besar (LLM).

Dari Google T5 pada 2019 kepada siri OpenAI GPT, model besar dengan saiz parameter yang meletup terus muncul. Boleh dikatakan bahawa penyelidikan mengenai LLM telah banyak dipromosikan dalam kedua-dua akademik dan industri Khususnya, kemunculan model perbualan besar ChatGPT pada akhir November tahun lalu telah menarik perhatian meluas dari semua lapisan masyarakat. Kemajuan teknikal dalam LLM telah memberi kesan penting kepada seluruh komuniti AI dan akan merevolusikan cara orang ramai membangun dan menggunakan algoritma AI.

Memandangkan kemajuan teknologi pesat LLM, lebih daripada dua dozen penyelidik dari Universiti Renmin China menyemak kemajuan terkini LLM daripada tiga aspek: pengetahuan latar belakang, penemuan utama dan teknologi arus perdana, terutamanya Fokus pada pra-latihan, penalaan adaptif, penggunaan dan penilaian keupayaan LLM. Di samping itu, mereka merumuskan dan membangunkan sumber yang tersedia untuk LLM dan membincangkan hala tuju pembangunan masa depan dan isu-isu lain. Kajian ini merupakan sumber pembelajaran yang amat berguna untuk penyelidik dan jurutera dalam bidang tersebut.

Pautan kertas: https://arxiv.org/abs/2303.18223

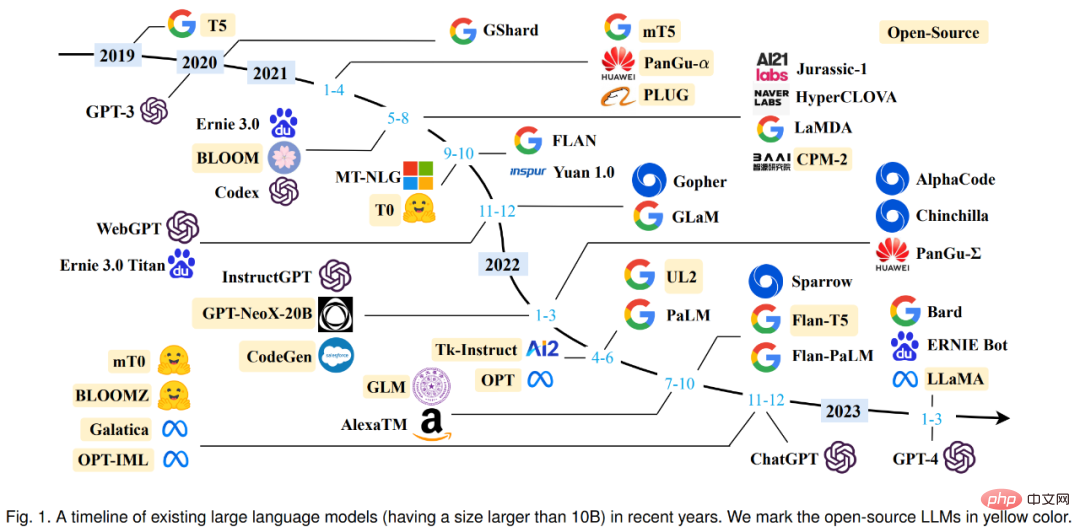

Sebelum memasukkan teks, mari kita lihat dahulu garis masa pelbagai model bahasa besar (lebih daripada 10 bilion parameter) yang telah muncul sejak 2019. Antaranya, model besar yang ditandakan dengan warna kuning adalah sumber terbuka.

Ikhtisar LLM

Dalam bahagian pertama, penyelidik memperkenalkan latar belakang, keupayaan dan teknologi utama LLM secara terperinci.

Latar belakang pada LLM

Secara amnya, model bahasa besar (LLM) ialah model yang mengandungi ratusan bilion (atau lebih ) Model bahasa berbilang parameter yang dilatih mengenai sejumlah besar data teks, seperti model GPT-3, PaLM, Galactica dan LLaMA. Khususnya, LLM dibina pada seni bina Transformer, di mana lapisan perhatian berbilang kepala disusun dalam rangkaian saraf yang sangat dalam. LLM sedia ada terutamanya menggunakan seni bina model (iaitu Transformer) dan objektif pra-latihan (iaitu pemodelan bahasa) yang serupa dengan model bahasa kecil. Sebagai perbezaan utama, LLM menskalakan saiz model, data pra-latihan dan jumlah pengiraan (faktor peningkatan skala) pada tahap yang besar. Mereka boleh lebih memahami bahasa semula jadi dan menjana teks berkualiti tinggi berdasarkan konteks tertentu (seperti gesaan). Peningkatan kapasiti ini boleh diterangkan sebahagiannya oleh undang-undang penskalaan, di mana prestasi meningkat secara kasar berikutan peningkatan besar dalam saiz model. Walau bagaimanapun, menurut undang-undang penskalaan, beberapa keupayaan (cth., pembelajaran kontekstual) tidak dapat diramalkan dan hanya boleh diperhatikan apabila saiz model melebihi tahap tertentu.

Keupayaan Kemunculan LLM

Keupayaan kemunculan LLM secara rasmi ditakrifkan sebagai "keupayaan kemunculan yang tidak wujud dalam model kecil tetapi Keupayaan untuk muncul dalam model besar" adalah salah satu ciri paling ketara yang membezakan LLM daripada PLM sebelumnya. Apabila keupayaan baharu ini muncul, ia turut memperkenalkan ciri ketara: apabila skala mencapai tahap tertentu, prestasi jauh lebih tinggi daripada rawak. Secara analogi, model baharu ini berkait rapat dengan fenomena peralihan fasa dalam fizik. Pada dasarnya, keupayaan ini juga boleh dikaitkan dengan beberapa tugas yang kompleks, manakala orang lebih mementingkan kebolehan umum yang boleh digunakan untuk menyelesaikan pelbagai tugas. Berikut ialah pengenalan ringkas kepada tiga keupayaan kemunculan wakil LLM:

Pembelajaran kontekstual. GPT-3 secara rasmi memperkenalkan keupayaan pembelajaran kontekstual: dengan mengandaikan bahawa model bahasa telah disediakan dengan arahan bahasa semula jadi dan pelbagai huraian tugas, ia boleh menjana output yang dijangkakan bagi contoh ujian dengan melengkapkan urutan perkataan teks input tanpa latihan tambahan atau kecerunan. kemas kini.

Arahan untuk diikuti. LLM berfungsi dengan baik pada tugasan kecil dengan memperhalusi campuran set data berbilang tugas yang diformatkan dengan penerangan bahasa semula jadi (iaitu arahan), yang juga diterangkan dalam bentuk arahan. Dalam kapasiti ini, penalaan arahan membolehkan LLM melaksanakan tugas baharu dengan memahami arahan tugasan tanpa menggunakan sampel eksplisit, yang boleh meningkatkan keupayaan generalisasi dengan banyak.

Penaakulan langkah demi langkah. Untuk model bahasa kecil, selalunya sukar untuk menyelesaikan tugasan kompleks yang melibatkan pelbagai langkah penaakulan, seperti masalah perkataan dalam mata pelajaran matematik. Pada masa yang sama, melalui strategi penaakulan rantaian pemikiran, LLM boleh menyelesaikan tugasan sedemikian untuk mencapai jawapan akhir dengan menggunakan mekanisme segera yang melibatkan langkah penaakulan pertengahan. Mungkin, kebolehan ini boleh diperolehi melalui latihan pengekodan.

Teknologi Utama

Seterusnya, mari kita lihat teknologi utama LLM, termasuk penskalaan, latihan, rangsangan keupayaan , Penalaan penjajaran, penggunaan alat, dsb.

Zum. Penskalaan ialah faktor utama dalam meningkatkan kapasiti model LLM Pada mulanya, GPT-3 meningkatkan parameter model kepada 175 bilion, dan kemudian PaLM meningkatkan lagi parameter model kepada 540 bilion. Parameter berskala besar adalah penting untuk keupayaan yang muncul. Penskalaan bukan sahaja mengenai saiz model, tetapi juga mengenai saiz data dan jumlah usaha pengiraan.

Latihan. Oleh kerana skala besar, berjaya melatih LLM dengan keupayaan yang kuat adalah sangat mencabar. Oleh itu, algoritma latihan teragih diperlukan untuk mempelajari parameter rangkaian LLM, selalunya menggunakan gabungan pelbagai strategi selari. Untuk menyokong latihan teragih, rangka kerja pengoptimuman seperti DeepSpeed dan Megatron-LM digunakan untuk memudahkan pelaksanaan dan penggunaan algoritma selari. Selain itu, teknik pengoptimuman adalah penting untuk kestabilan latihan dan prestasi model, seperti memulakan semula pancang kehilangan latihan dan latihan ketepatan campuran. GPT-4 baru-baru ini membangunkan infrastruktur khas dan kaedah pengoptimuman untuk memanfaatkan model yang lebih kecil untuk meramalkan prestasi model besar.

Rangsangan keupayaan. Selepas pra-latihan dalam korpus berskala besar, LLM dikurniakan dengan potensi keupayaan untuk menyelesaikan tugas umum. Walau bagaimanapun, keupayaan ini mungkin tidak ditunjukkan secara eksplisit apabila LLM melaksanakan tugas tertentu. Oleh itu, adalah amat berguna untuk mereka bentuk arahan tugas yang sesuai atau strategi kontekstual khusus untuk merangsang kebolehan ini Contohnya, gesaan rantaian pemikiran boleh membantu menyelesaikan tugasan penaakulan yang kompleks melalui langkah penaakulan pertengahan. Di samping itu, arahan boleh ditala lebih lanjut untuk LLM dengan perihalan tugas bahasa semula jadi untuk meningkatkan generalisasi kepada tugas yang tidak kelihatan.

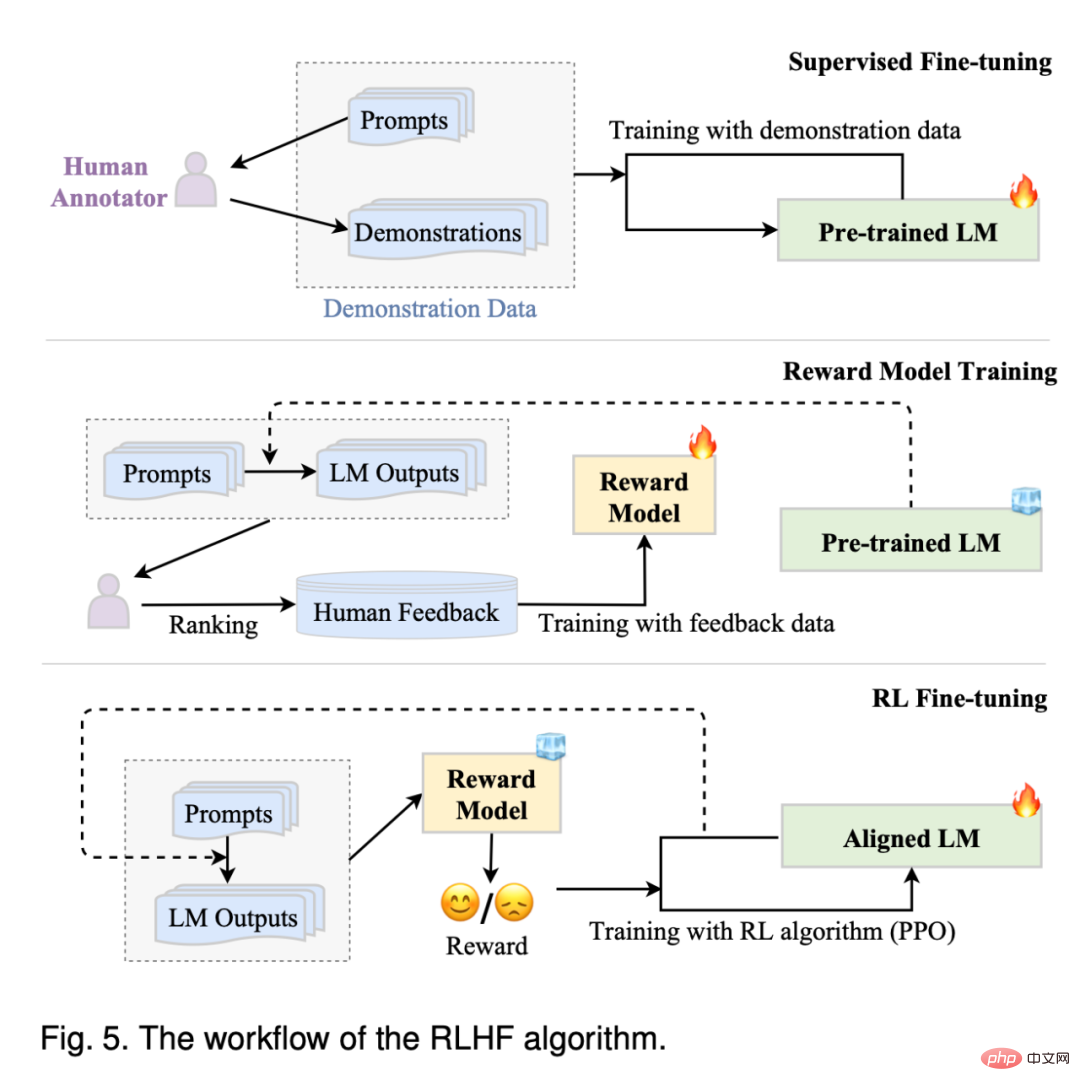

Pelajaran penjajaran. Memandangkan LLM dilatih untuk menangkap ciri data korpora pra-latihan (termasuk data berkualiti tinggi dan rendah), mereka berkemungkinan menghasilkan kandungan teks yang toksik, berat sebelah dan berbahaya. Untuk menyelaraskan LLM dengan nilai kemanusiaan, InstructGPT mereka kaedah penalaan yang cekap yang memanfaatkan pembelajaran pengukuhan dan maklum balas manusia supaya LLM boleh mengikut arahan yang dijangkakan. ChatGPT dibangunkan pada teknologi yang serupa dengan InstructGPT dan telah menunjukkan keupayaan penjajaran yang kukuh dalam menghasilkan respons yang berkualiti tinggi dan tidak berbahaya.

Penggunaan alatan. LLM pada asasnya ialah penjana teks yang dilatih pada korpora teks biasa berskala besar, dan oleh itu tidak berfungsi dengan baik pada tugas seperti pengiraan berangka yang teks tidak dinyatakan dengan baik. Selain itu, keupayaan LLM dihadkan oleh data pra-latihan dan tidak dapat menangkap maklumat terkini. Sebagai tindak balas kepada masalah ini, orang ramai telah mencadangkan menggunakan alat luaran untuk mengimbangi kelemahan LLM, seperti menggunakan kalkulator untuk melakukan pengiraan yang tepat dan menggunakan enjin carian untuk mendapatkan maklumat yang tidak diketahui. ChatGPT juga menggunakan pemalam luaran untuk mempelajari pengetahuan baharu dalam talian Mekanisme ini boleh meluaskan keupayaan LLM secara meluas.

Sumber LLM

Memandangkan masalah teknikal yang mencabar dan keperluan sumber pengiraan yang besar, membangunkan atau mereplikasi LLM bukanlah satu tugas yang mudah. Satu pendekatan yang mungkin adalah untuk belajar daripada LLM sedia ada dan menggunakan semula sumber yang tersedia secara umum untuk pembangunan tambahan atau penyelidikan eksperimen.

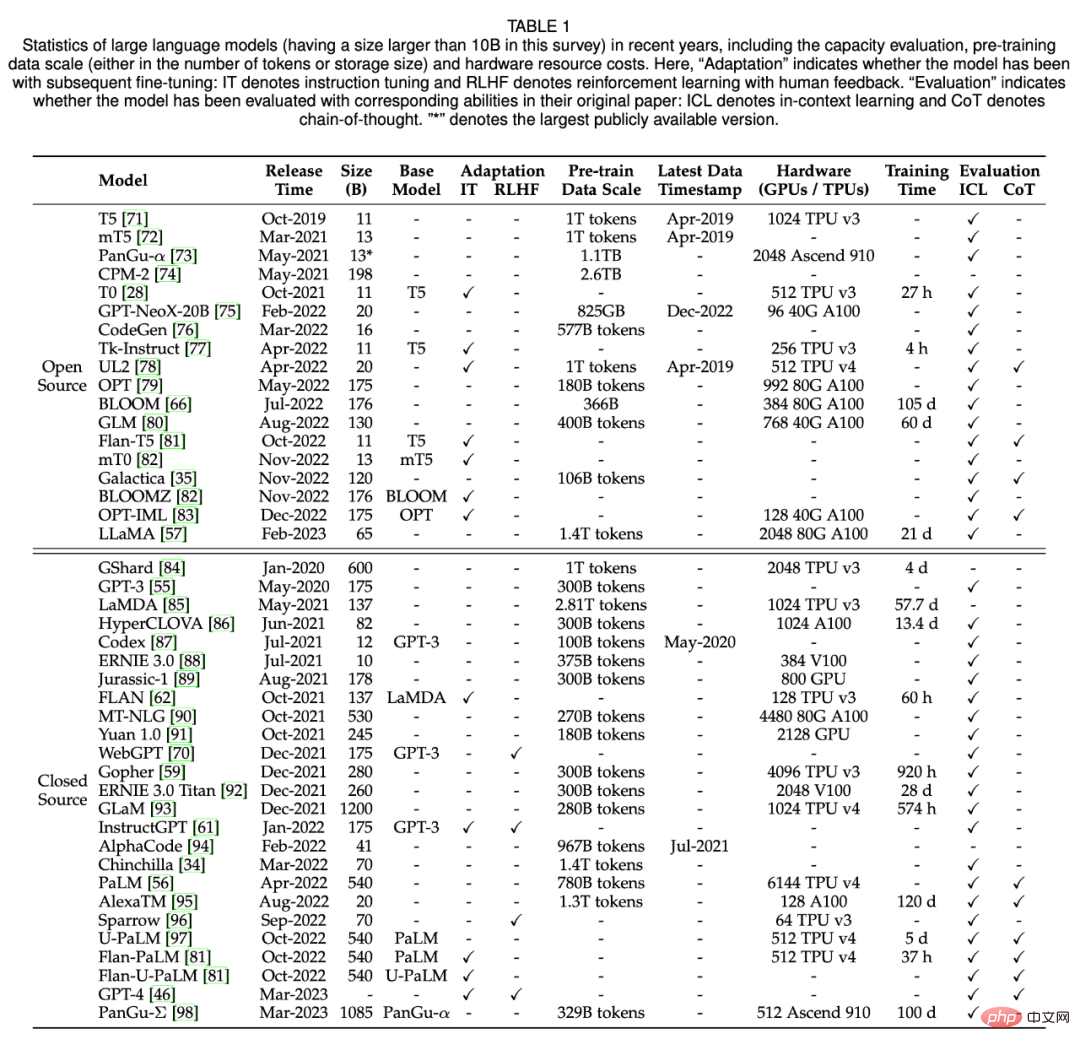

Dalam Bahagian 3, penyelidik meringkaskan terutamanya pusat pemeriksaan model sumber terbuka atau API, korpora tersedia dan perpustakaan yang berguna untuk LLM. Jadual 1 di bawah menunjukkan data statistik model besar dengan lebih daripada 10 bilion parameter dalam beberapa tahun kebelakangan ini.

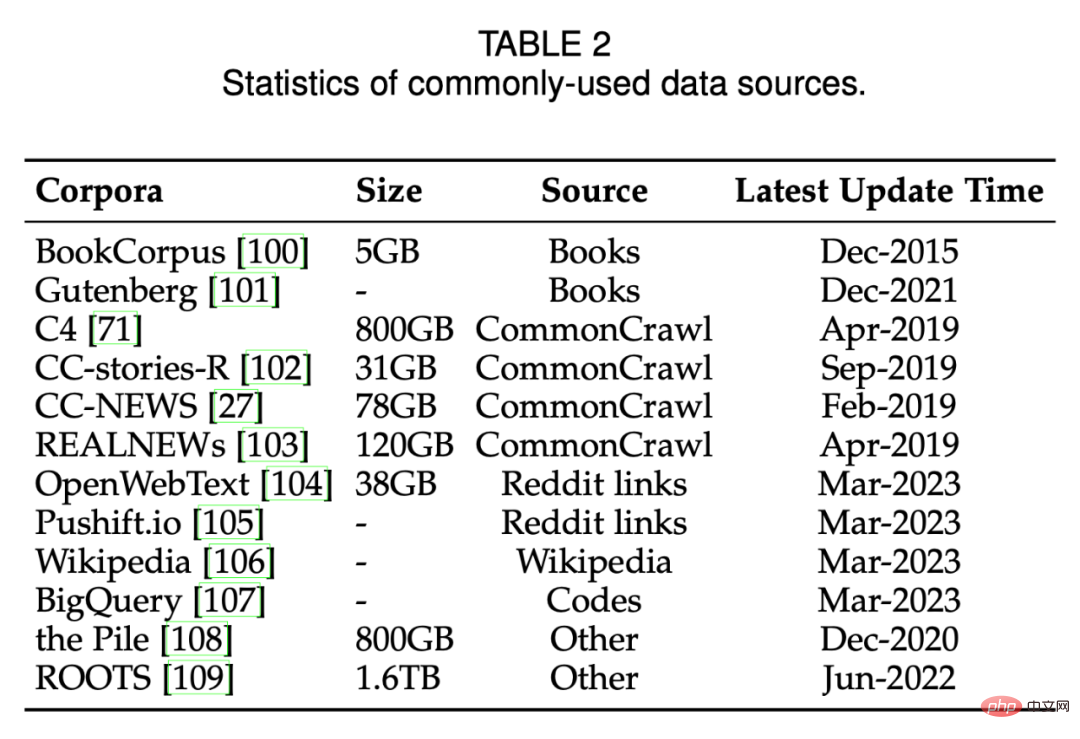

Jadual 2 di bawah menyenaraikan sumber data yang biasa digunakan.

Pra-latihan

Pra-latihan membina asas keupayaan LLM. Melalui pra-latihan mengenai korpora berskala besar, LLM boleh memperoleh pemahaman bahasa asas dan kemahiran pengeluaran. Dalam proses ini, saiz dan kualiti korpus pra-latihan adalah kunci untuk LLM mencapai keupayaan yang kukuh. Tambahan pula, untuk pralatih LLM dengan berkesan, seni bina model, kaedah pecutan dan teknik pengoptimuman semuanya perlu direka bentuk dengan teliti. Dalam Bahagian 4, penyelidik mula-mula membincangkan pengumpulan dan pemprosesan data dalam Bahagian 4.1, kemudian memperkenalkan seni bina model yang biasa digunakan dalam Bahagian 4.2, dan akhirnya memperkenalkan teknik latihan untuk pengoptimuman LLM yang stabil dan berkesan dalam Bahagian 4.3.

Pengumpulan Data

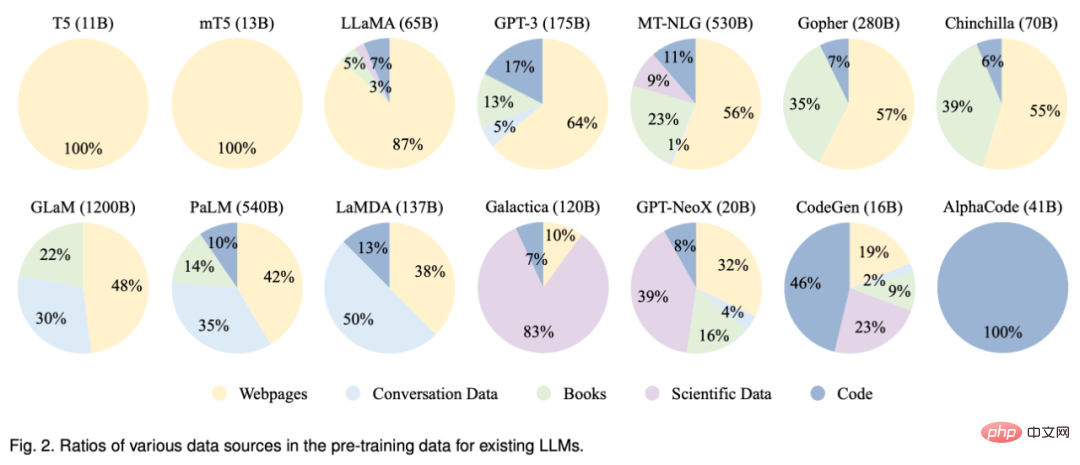

Untuk membangunkan LLM yang berkuasa, kumpulkan sejumlah besar bahasa semula jadi daripada pelbagai sumber data Corpus ialah penting. LLM sedia ada terutamanya menggunakan pelbagai set data teks awam sebagai korpora pra-latihan. Rajah 2 di bawah menyenaraikan taburan sumber data pra-latihan untuk LLM sedia ada.

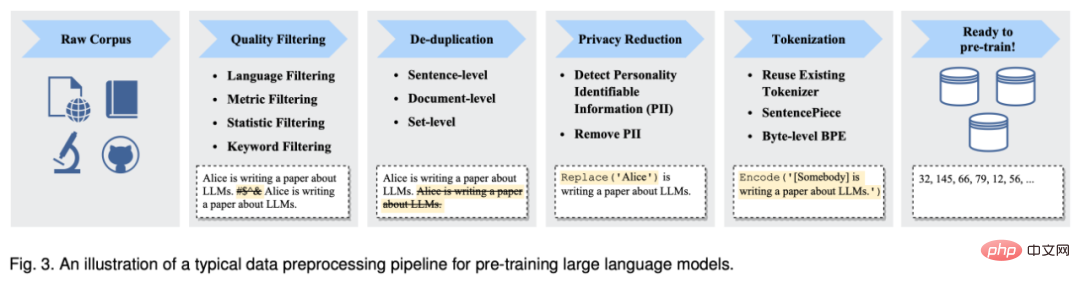

Selepas mengumpul sejumlah besar data teks, mereka mesti dilatih terlebih dahulu untuk membina korpus pra-latihan, termasuk menafikan, menghapuskan lebihan, dan mengalih keluar data yang tidak berkaitan dan berpotensi toksik. Rajah 3 di bawah menunjukkan saluran paip pra-pemprosesan untuk data pra-latihan untuk LLM.

Seni Bina

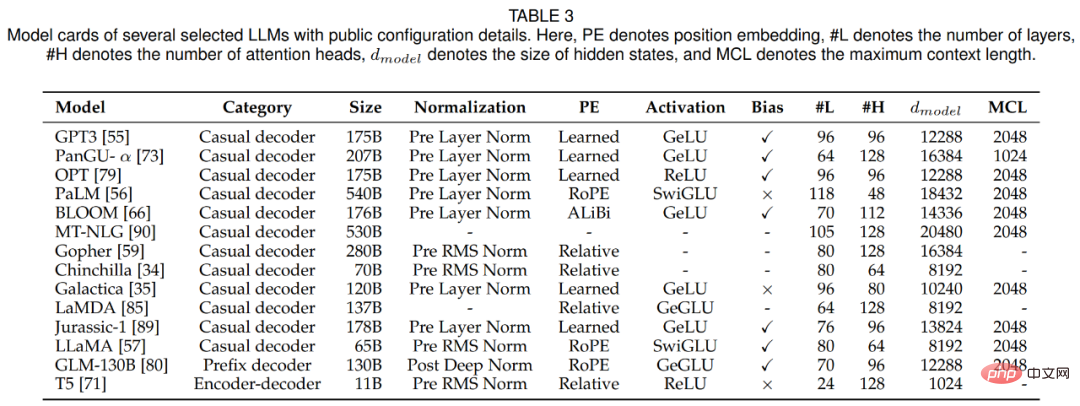

Dalam bahagian ini, penyelidik menyemak LLMs The architecture reka bentuk, iaitu seni bina arus perdana, matlamat pra-latihan dan konfigurasi terperinci. Jadual 3 di bawah menyenaraikan kad model untuk beberapa LLM wakil dengan butiran tersedia secara umum.

Disebabkan keselarian dan kapasitinya yang sangat baik, seni bina Transformer telah menjadi tulang belakang untuk membangunkan pelbagai LLM, membolehkan penskalaan model bahasa kepada ratusan berbilion parameter adalah mungkin. Secara umumnya, seni bina arus perdana LLM sedia ada boleh dibahagikan secara kasar kepada tiga kategori utama, iaitu penyahkod pengekod, penyahkod ad hoc dan penyahkod awalan.

Sejak kemunculan Transformer, pelbagai penambahbaikan telah dicadangkan untuk meningkatkan kestabilan latihan, prestasi dan kecekapan pengiraannya. Dalam bahagian ini, penyelidik membincangkan konfigurasi sepadan empat bahagian utama Transformer, termasuk normalisasi, pengekodan kedudukan, fungsi pengaktifan, mekanisme perhatian dan berat sebelah.

Pra-latihan memainkan peranan yang sangat kritikal, mengekodkan pengetahuan am daripada korpus berskala besar kepada parameter model berskala besar. Untuk latihan LLM, terdapat dua tugas pra-latihan yang biasa digunakan: pemodelan bahasa dan penyahkodan auto.

Latihan Model

Dalam bahagian ini, penyelidik menyemak tetapan, teknik dan latihan penting untuk latihan LLM LLM Petua.

Untuk pengoptimuman parameter LLM, penyelidik telah mencadangkan tetapan latihan kelompok, kadar pembelajaran, pengoptimuman dan kestabilan latihan yang biasa digunakan.

Apabila model dan saiz data meningkat, menjadi sukar untuk melatih model LLM dengan sumber pengkomputeran yang terhad dengan berkesan. Khususnya, dua isu teknikal utama perlu ditangani, seperti meningkatkan latihan dengan input dan memuatkan model yang lebih besar ke dalam memori GPU. Bahagian ini mengkaji beberapa kaedah yang digunakan secara meluas dalam kerja sedia ada untuk menangani dua cabaran di atas, iaitu keselarian 3D, ZeRO, dan latihan ketepatan campuran, dan memberi cadangan tentang cara memanfaatkannya untuk latihan.

Penalaan Adaptif LLM

Selepas pra-latihan, LLM boleh memperoleh keupayaan umum untuk menyelesaikan pelbagai tugas. Namun, badan penyelidikan yang semakin meningkat menunjukkan bahawa keupayaan LLM boleh disesuaikan dengan matlamat tertentu. Dalam Bahagian 5, penyelidik memperkenalkan secara terperinci dua kaedah utama untuk menala LLM pra-latihan, iaitu penalaan arahan dan penalaan penjajaran. Pendekatan terdahulu adalah terutamanya untuk menambah baik atau membuka kunci keupayaan LLM, manakala pendekatan yang terakhir adalah untuk menjadikan tingkah laku LLM konsisten dengan nilai atau keutamaan manusia.

Penalaan Arahan

Pada asasnya, penalaan arahan adalah pada set contoh berformat dalam bentuk bahasa semula jadi Kaedah untuk denda -menala LLM pra-latihan, yang sangat relevan dengan latihan penalaan halus dan pelbagai tugasan yang diselia. Untuk melakukan penalaan arahan, kita perlu terlebih dahulu mengumpul atau membina contoh format arahan. Kami kemudiannya biasanya menggunakan tika berformat ini untuk memperhalusi LLM dalam cara pembelajaran yang diselia (mis., dilatih menggunakan kehilangan urutan ke turutan). Apabila arahan mereka ditala, LLM boleh menunjukkan kebolehan unggul untuk membuat generalisasi kepada tugas yang tidak kelihatan, walaupun dalam persekitaran berbilang bahasa.

Tinjauan baru-baru ini memberikan gambaran keseluruhan sistematik tentang penyelidikan penalaan arahan. Sebaliknya, kertas kerja ini memfokuskan pada kesan penalaan arahan pada LLM dan menyediakan garis panduan atau strategi terperinci contohnya pengumpulan dan penalaan. Selain itu, kertas kerja ini membincangkan penggunaan penalaan arahan untuk memenuhi keperluan sebenar pengguna, yang telah digunakan secara meluas dalam LLM sedia ada seperti InstructGPT dan GPT-4.

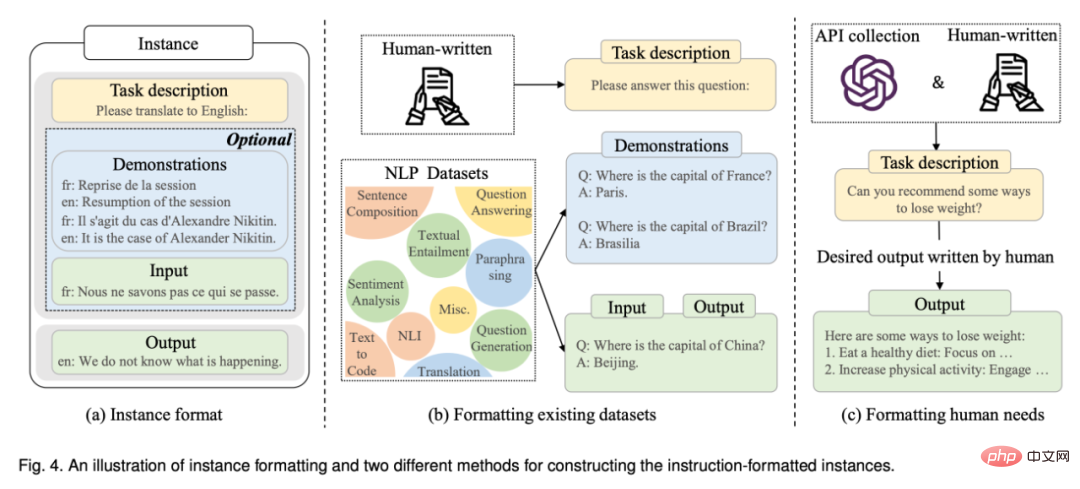

Pembinaan contoh berformat: Biasanya, contoh dalam format arahan terdiri daripada penerangan tugasan (dipanggil arahan), pasangan input-output dan sebilangan kecil demonstrasi (pilihan) . Penyelidikan sedia ada telah menerbitkan sejumlah besar data berlabel yang diformatkan dalam bahasa semula jadi sebagai sumber awam yang penting (lihat Jadual 5 untuk senarai sumber yang tersedia). Seterusnya, artikel ini memperkenalkan dua kaedah utama untuk membina contoh berformat (lihat ilustrasi dalam Rajah 4), dan kemudian membincangkan beberapa faktor utama dalam pembinaan contoh.

Strategi penalaan arahan: Tidak seperti pra-latihan, penalaan arahan secara amnya lebih cekap kerana hanya bilangan kejadian yang sederhana digunakan untuk latihan. Walaupun penalaan arahan boleh dianggap sebagai proses latihan yang diselia, pengoptimumannya berbeza daripada pra-latihan dalam beberapa aspek, seperti objektif latihan (iaitu, kehilangan urutan-ke-jujukan) dan konfigurasi pengoptimuman (mis., saiz kelompok yang lebih kecil) dan kadar pembelajaran ), yang memerlukan perhatian khusus dalam amalan. Selain konfigurasi pengoptimuman ini, penalaan arahan juga perlu mempertimbangkan dua aspek penting:

- Pengagihan data seimbang.

- Gabungan penalaan arahan dan pra-latihan.

Penjajaran Penjajaran

Bahagian ini diperkenalkan dahulu. latar belakang penjajaran dan definisi serta piawaiannya kemudian diserlahkan, dan kemudian pengumpulan data maklum balas manusia untuk menjajarkan LLM diserlahkan, dan akhirnya teknik utama pembelajaran pengukuhan maklum balas manusia untuk pelarasan penjajaran dibincangkan.

Menggunakan

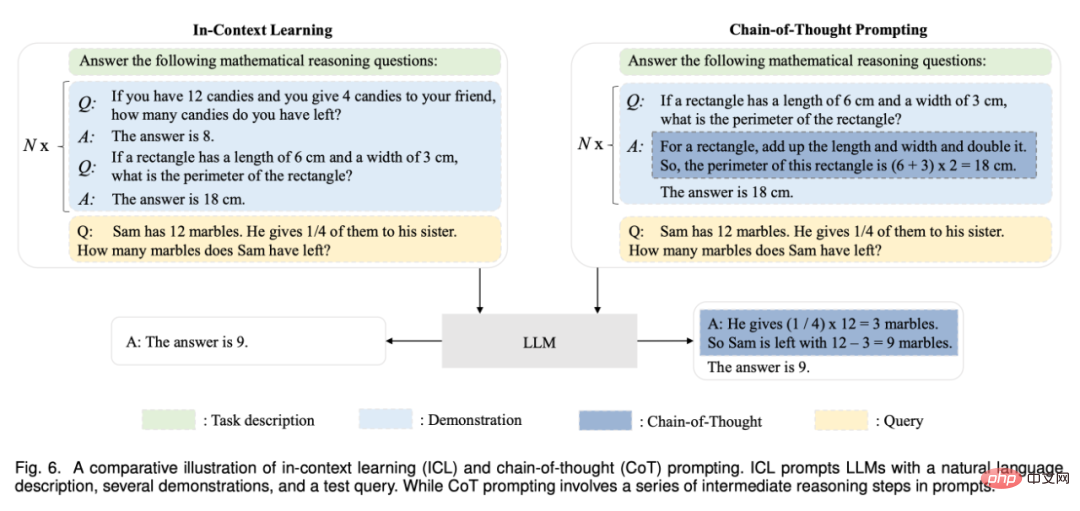

Cara utama untuk menggunakan LLM selepas pra-latihan atau penyesuaian adalah untuk mereka bentuknya untuk menyelesaikan pelbagai tugas Gesaan yang sesuai strategi. Pendekatan dorongan biasa ialah pembelajaran dalam konteks, yang merumuskan huraian tugas atau demonstrasi dalam bentuk teks bahasa semula jadi. Di samping itu, kaedah penggerak rantai pemikiran boleh meningkatkan pembelajaran kontekstual dengan memasukkan satu siri langkah penaakulan pertengahan ke dalam gesaan. Dalam Bahagian 6, penyelidik memperkenalkan butiran kedua-dua teknik ini secara terperinci.

Pembelajaran kontekstual

Sebagai bentuk segera khas, pembelajaran kontekstual (ICL) pertama kali dicadangkan dalam GPT-3, dan ia telah menjadi kaedah biasa untuk menggunakan LLM.

Gesaan rantaian berfikir

Chain of Thoughts (CoT) ialah strategi segera yang dipertingkatkan yang boleh meningkatkan prestasi LLM dalam tugasan penaakulan yang kompleks, seperti penaakulan aritmetik, penaakulan akal dan penaakulan simbolik. Daripada hanya membina gesaan daripada pasangan input-output seperti ICL, CoT menggabungkan ke dalam langkah penaakulan perantaraan segera yang membawa kepada output akhir. Dalam Bahagian 6.2, kami memperincikan penggunaan CoT berbanding ICL dan membincangkan bila dan mengapa CoT berkesan.

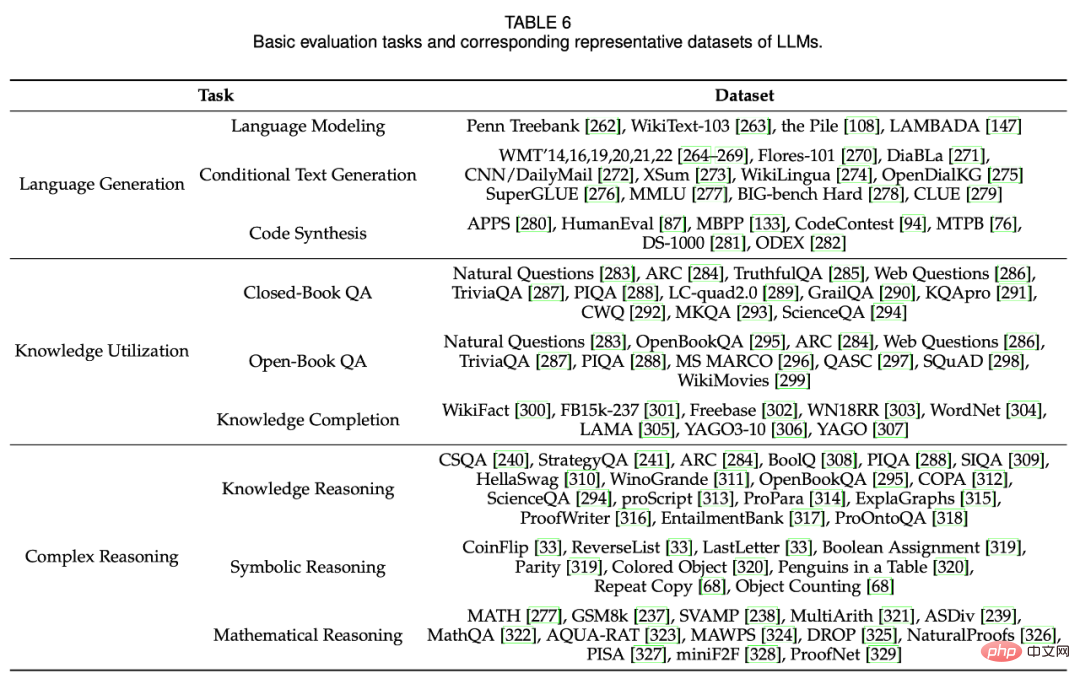

Penilaian Keupayaan

Untuk mengkaji keberkesanan dan keunggulan LLM, penyelidik telah menggunakan sejumlah besar tugas dan penanda aras untuk penilaian dan analisis empirikal. Bahagian 7 mula-mula memperkenalkan tugas penilaian asas untuk tiga LLM untuk penghasilan dan pemahaman bahasa, kemudian memperkenalkan beberapa tugas lanjutan untuk LLM dengan tetapan atau matlamat yang lebih kompleks, dan akhirnya membincangkan penanda aras sedia ada dan analisis empirikal.

Tugas Penilaian Asas

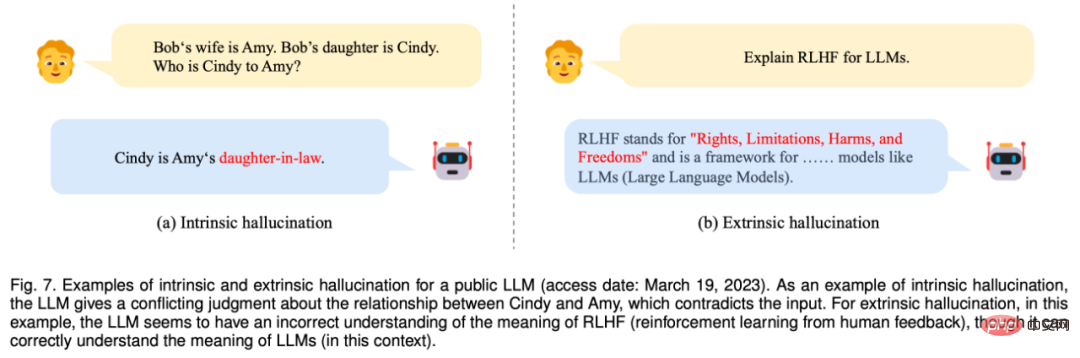

Rajah 7: Contoh ilusi dalaman dan luaran yang mendedahkan LLM (Diakses pada 19 Mac 2023). Sebagai contoh halusinasi dalaman, LLM memberikan pertimbangan tentang hubungan antara Cindy dan Amy yang bercanggah dengan input. Untuk halusinasi ekstrinsik, dalam kes ini LLM nampaknya mempunyai pemahaman yang salah tentang maksud RLHF (pembelajaran pengukuhan daripada maklum balas manusia), walaupun ia memahami maksud LLM dengan betul.

Penilaian Tugas Lanjutan

Selain tugas penilaian asas di atas, LLM juga menunjukkan beberapa tugasan lanjutan kebolehan, Penilaian khas diperlukan. Dalam Bahagian 7.2, penyelidik membincangkan beberapa keupayaan peringkat tinggi yang mewakili dan kaedah penilaian yang sepadan, termasuk penjajaran manual, interaksi dengan persekitaran luaran, dan operasi alat.

Ringkasan dan hala tuju masa hadapan

Dalam bahagian terakhir, penyelidik merumuskan perbincangan tinjauan ini dan memperkenalkan cabaran dan hala tuju masa hadapan LLM daripada aspek berikut pembangunan masa hadapan arah.

Teori dan Prinsip: Untuk memahami mekanisme kerja asas LLM, salah satu misteri terbesar ialah bagaimana maklumat diedarkan, disusun dan digunakan melalui rangkaian saraf dalam yang sangat besar. Adalah penting untuk mendedahkan prinsip atau elemen asas yang membina asas keupayaan LLM. Khususnya, penskalaan nampaknya memainkan peranan penting dalam meningkatkan keupayaan LLM. Penyelidikan sedia ada telah menunjukkan bahawa apabila saiz parameter model bahasa meningkat kepada titik kritikal (seperti 10B), beberapa keupayaan yang muncul akan muncul dalam cara yang tidak dijangka (lonjakan mendadak dalam prestasi), biasanya termasuk pembelajaran kontekstual, mengikut arahan dan Langkah- penaakulan mengikut langkah. Kebolehan "muncul" ini menarik tetapi juga membingungkan: bila dan bagaimana LLM memperolehnya? Beberapa penyelidikan baru-baru ini sama ada telah menjalankan eksperimen berskala luas yang menyiasat kesan kebolehan yang muncul dan faktor yang membolehkannya, atau menggunakan rangka kerja teori sedia ada untuk menerangkan kebolehan tertentu. Catatan teknikal bernas yang menyasarkan keluarga model GPT juga membincangkan topik ini secara khusus, namun teori dan prinsip yang lebih formal untuk memahami, menerangkan dan menerangkan keupayaan atau tingkah laku LLM masih kurang. Memandangkan keupayaan yang muncul mempunyai persamaan yang hampir dengan peralihan fasa dalam alam semula jadi, teori atau prinsip antara disiplin (seperti sama ada LLM boleh dianggap sebagai sejenis sistem yang kompleks) mungkin membantu dalam menerangkan dan memahami tingkah laku LLM. Soalan asas ini patut diterokai oleh komuniti penyelidikan dan penting untuk membangunkan LLM generasi akan datang.

Seni bina model: Transformer, yang terdiri daripada lapisan perhatian diri berbilang kepala bertindan, telah menjadi seni bina biasa untuk membina LLM kerana kebolehskalaan dan keberkesanannya. Pelbagai strategi telah dicadangkan untuk meningkatkan prestasi seni bina ini, seperti konfigurasi rangkaian saraf dan latihan selari berskala (lihat perbincangan dalam Bahagian 4.2.2). Untuk meningkatkan lagi kapasiti model (seperti keupayaan dialog berbilang pusingan), LLM sedia ada biasanya mengekalkan panjang konteks yang panjang Contohnya, GPT-4-32k mempunyai panjang konteks yang sangat besar iaitu 32768 token. Oleh itu, pertimbangan praktikal adalah untuk mengurangkan kerumitan masa (kos kuadratik primitif) yang ditanggung oleh mekanisme perhatian kendiri standard.

Selain itu, adalah penting untuk mengkaji kesan varian Transformer yang lebih cekap ke atas membina LLM, seperti perhatian yang jarang digunakan untuk GPT-3. Pelupaan bencana juga telah menjadi cabaran untuk rangkaian saraf, yang juga telah memberi kesan negatif kepada LLM. Apabila LLM ditala dengan data baharu, pengetahuan yang dipelajari sebelum ini mungkin akan musnah Sebagai contoh, penalaan halus untuk beberapa tugasan tertentu akan menjejaskan keupayaan amnya. Situasi yang sama berlaku apabila LLM diselaraskan dengan nilai kemanusiaan, yang dipanggil cukai penjajaran. Oleh itu, adalah perlu untuk mempertimbangkan untuk melanjutkan seni bina sedia ada dengan mekanisme atau modul yang lebih fleksibel untuk menyokong kemas kini data dan pengkhususan tugas dengan berkesan.

Latihan model: Secara praktiknya, pra-latihan LLM yang boleh digunakan adalah sangat sukar disebabkan oleh usaha pengiraan yang besar dan kepekaan terhadap kualiti data dan teknik latihan. Oleh itu, dengan mengambil kira faktor-faktor seperti keberkesanan model, pengoptimuman kecekapan dan kestabilan latihan, adalah menjadi sangat penting untuk membangunkan kaedah pra-latihan yang lebih sistematik dan menjimatkan untuk mengoptimumkan LLM. Bangunkan lebih banyak pemeriksaan model atau diagnostik prestasi (seperti penskalaan boleh diramal dalam GPT-4) untuk menangkap anomali pada awal latihan. Selain itu, ia juga memerlukan sokongan perkakasan yang lebih fleksibel atau mekanisme penjadualan sumber untuk mengatur dan menggunakan sumber dengan lebih baik dalam kelompok pengkomputeran. Memandangkan pralatihan LLM dari awal adalah mahal, mekanisme yang sesuai mesti direka bentuk untuk pralatihan atau memperhalusi LLM secara berterusan berdasarkan pusat pemeriksaan model yang tersedia secara umum (cth., LLaMA dan Flan-T5). Untuk melakukan ini, beberapa isu teknikal mesti ditangani, termasuk ketidakkonsistenan data, pelupaan bencana dan pengkhususan tugas. Sehingga kini, masih terdapat kekurangan pusat pemeriksaan model sumber terbuka untuk LLM yang boleh dihasilkan semula dengan log prapemprosesan dan latihan yang lengkap (cth. skrip untuk menyediakan data pralatihan). Menyediakan lebih banyak model sumber terbuka untuk penyelidikan tentang LLM akan menjadi sangat berharga. Di samping itu, ia juga penting untuk membangunkan lebih banyak strategi pelarasan yang lebih baik dan mekanisme kajian untuk merangsang keupayaan model dengan berkesan.

Penggunaan model: Memandangkan penalaan halus adalah mahal dalam aplikasi dunia sebenar, gesaan telah menjadi kaedah yang menonjol untuk menggunakan LLM. Dengan menggabungkan huraian tugas dan contoh tunjuk cara ke dalam gesaan, pembelajaran kontekstual (sebuah bentuk gesaan khas) memberikan LLM prestasi yang baik pada tugasan baharu, malah mengatasi prestasi model lengkap yang diperhalusi dalam beberapa kes. Di samping itu, untuk meningkatkan keupayaan penaakulan yang kompleks, teknik segera lanjutan telah dicadangkan, seperti strategi rantaian pemikiran (CoT), yang menggabungkan langkah-langkah penaakulan pertengahan ke dalam gesaan. Walau bagaimanapun, kaedah segera sedia ada masih mempunyai kelemahan berikut. Pertama, ia memerlukan banyak tenaga kerja apabila mereka bentuk gesaan, jadi secara automatik menghasilkan gesaan yang berkesan untuk menyelesaikan pelbagai tugas akan menjadi sangat berguna kedua, beberapa tugas yang kompleks (seperti pembuktian formal dan pengiraan berangka) memerlukan pengetahuan atau peraturan logik tertentu, Pengetahuan atau ini; peraturan mungkin tidak diterangkan dalam bahasa semula jadi atau dibuktikan dengan contoh, jadi adalah penting untuk membangunkan kaedah segera dengan lebih banyak maklumat dan pemformatan tugas yang lebih fleksibel ketiga, strategi segera sedia ada tertumpu terutamanya pada satu pusingan dari segi Prestasi, oleh itu sangat berguna; untuk membangunkan mekanisme segera interaktif untuk menyelesaikan tugas yang kompleks (seperti melalui perbualan bahasa semula jadi), seperti yang ditunjukkan oleh ChatGPT.

Keselamatan dan Penjajaran: Walaupun mempunyai keupayaan yang besar, LLM mengalami masalah keselamatan yang serupa seperti model bahasa kecil. Sebagai contoh, LLM menunjukkan kecenderungan untuk menjana teks halusinasi, seperti teks yang kelihatan munasabah tetapi mungkin tidak sepadan dengan fakta. Lebih teruk lagi, LLM boleh didorong oleh arahan yang disengajakan untuk menghasilkan teks berbahaya, berat sebelah atau toksik untuk sistem berniat jahat, yang membawa kepada potensi risiko penyalahgunaan. Untuk perbincangan terperinci tentang isu keselamatan lain dengan LLM (seperti privasi, terlalu bergantung, disinformasi dan operasi impak), pembaca dirujuk kepada laporan teknikal GPT-3/4. Sebagai kaedah utama untuk mengelakkan masalah ini, pembelajaran pengukuhan daripada maklum balas manusia (RLHF) telah digunakan secara meluas, yang menggabungkan manusia ke dalam gelung latihan untuk membangunkan LLM yang baik. Untuk meningkatkan keselamatan model, adalah penting untuk menambah gesaan berkaitan keselamatan semasa proses RLHF, seperti yang ditunjukkan dalam GPT-4. Walau bagaimanapun, RLHF sangat bergantung pada data maklum balas manusia berkualiti tinggi daripada pelabel profesional, menjadikannya sukar untuk dilaksanakan dengan betul dalam amalan. Oleh itu, adalah perlu untuk menambah baik rangka kerja RLHF untuk mengurangkan kerja pelabel manusia dan mencari kaedah anotasi yang lebih berkesan untuk memastikan kualiti data Sebagai contoh, LLM boleh diguna pakai untuk membantu kerja anotasi. Baru-baru ini, pasukan merah telah diterima pakai untuk meningkatkan keselamatan model LLM, yang menggunakan gesaan musuh yang dikumpul untuk memperhalusi LLM (iaitu, mengelakkan serangan pasukan merah). Di samping itu, ia juga bermakna untuk mewujudkan mekanisme pembelajaran untuk LLM melalui komunikasi dengan manusia Maklum balas yang diberikan oleh manusia melalui sembang boleh digunakan secara langsung oleh LLM untuk peningkatan diri.

Aplikasi dan Ekosistem: Memandangkan LLM mempamerkan keupayaan yang kukuh dalam menyelesaikan pelbagai tugas, ia boleh digunakan dalam pelbagai aplikasi dunia sebenar (cth., mengikut arahan bahasa semula jadi yang khusus). Sebagai kemajuan yang ketara, ChatGPT mempunyai potensi untuk mengubah cara manusia mengakses maklumat, yang membawa kepada keluaran Bing baharu. Dalam masa terdekat, adalah dijangkakan bahawa LLM akan memberi impak yang besar terhadap teknologi carian maklumat, termasuk enjin carian dan sistem pengecaman.

Selain itu, dengan peningkatan teknologi LLM, pembangunan dan penggunaan pembantu maklumat pintar akan sangat digalakkan. Pada skala yang lebih luas, gelombang inovasi teknologi ini cenderung untuk mewujudkan ekosistem aplikasi yang dilesenkan oleh LLM (cth., sokongan ChatGPT untuk pemalam) yang akan berkait rapat dengan kehidupan manusia. Akhirnya, kebangkitan LLM memberikan inspirasi untuk penerokaan kecerdasan am buatan (AGI). Ia memegang janji untuk membangunkan lebih banyak sistem pintar (berpotensi dengan isyarat multimodal) berbanding sebelum ini. Pada masa yang sama, dalam proses pembangunan ini, keselamatan kecerdasan buatan harus menjadi salah satu kebimbangan utama, iaitu, biarkan kecerdasan buatan membawa manfaat dan bukannya membahayakan manusia.

Atas ialah kandungan terperinci Semakan model bahasa berskala besar yang baru dikeluarkan: ulasan paling komprehensif dari T5 hingga GPT-4, dikarang bersama oleh lebih daripada 20 penyelidik domestik. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1375

1375

52

52

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Laman web ini melaporkan pada 27 Jun bahawa Jianying ialah perisian penyuntingan video yang dibangunkan oleh FaceMeng Technology, anak syarikat ByteDance Ia bergantung pada platform Douyin dan pada asasnya menghasilkan kandungan video pendek untuk pengguna platform tersebut Windows , MacOS dan sistem pengendalian lain. Jianying secara rasmi mengumumkan peningkatan sistem keahliannya dan melancarkan SVIP baharu, yang merangkumi pelbagai teknologi hitam AI, seperti terjemahan pintar, penonjolan pintar, pembungkusan pintar, sintesis manusia digital, dsb. Dari segi harga, yuran bulanan untuk keratan SVIP ialah 79 yuan, yuran tahunan ialah 599 yuan (nota di laman web ini: bersamaan dengan 49.9 yuan sebulan), langganan bulanan berterusan ialah 59 yuan sebulan, dan langganan tahunan berterusan ialah 499 yuan setahun (bersamaan dengan 41.6 yuan sebulan) . Di samping itu, pegawai yang dipotong juga menyatakan bahawa untuk meningkatkan pengalaman pengguna, mereka yang telah melanggan VIP asal

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Tingkatkan produktiviti, kecekapan dan ketepatan pembangun dengan menggabungkan penjanaan dipertingkatkan semula dan memori semantik ke dalam pembantu pengekodan AI. Diterjemah daripada EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, pengarang JanakiramMSV. Walaupun pembantu pengaturcaraan AI asas secara semulajadi membantu, mereka sering gagal memberikan cadangan kod yang paling relevan dan betul kerana mereka bergantung pada pemahaman umum bahasa perisian dan corak penulisan perisian yang paling biasa. Kod yang dijana oleh pembantu pengekodan ini sesuai untuk menyelesaikan masalah yang mereka bertanggungjawab untuk menyelesaikannya, tetapi selalunya tidak mematuhi piawaian pengekodan, konvensyen dan gaya pasukan individu. Ini selalunya menghasilkan cadangan yang perlu diubah suai atau diperhalusi agar kod itu diterima ke dalam aplikasi

Tujuh Soalan Temuduga Teknikal GenAI & LLM yang Cool

Jun 07, 2024 am 10:06 AM

Tujuh Soalan Temuduga Teknikal GenAI & LLM yang Cool

Jun 07, 2024 am 10:06 AM

Untuk mengetahui lebih lanjut tentang AIGC, sila layari: 51CTOAI.x Komuniti https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou berbeza daripada bank soalan tradisional yang boleh dilihat di mana-mana sahaja di Internet memerlukan pemikiran di luar kotak. Model Bahasa Besar (LLM) semakin penting dalam bidang sains data, kecerdasan buatan generatif (GenAI) dan kecerdasan buatan. Algoritma kompleks ini meningkatkan kemahiran manusia dan memacu kecekapan dan inovasi dalam banyak industri, menjadi kunci kepada syarikat untuk kekal berdaya saing. LLM mempunyai pelbagai aplikasi Ia boleh digunakan dalam bidang seperti pemprosesan bahasa semula jadi, penjanaan teks, pengecaman pertuturan dan sistem pengesyoran. Dengan belajar daripada sejumlah besar data, LLM dapat menjana teks

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Model Bahasa Besar (LLM) dilatih pada pangkalan data teks yang besar, di mana mereka memperoleh sejumlah besar pengetahuan dunia sebenar. Pengetahuan ini dibenamkan ke dalam parameter mereka dan kemudiannya boleh digunakan apabila diperlukan. Pengetahuan tentang model ini "diperbaharui" pada akhir latihan. Pada akhir pra-latihan, model sebenarnya berhenti belajar. Selaraskan atau perhalusi model untuk mempelajari cara memanfaatkan pengetahuan ini dan bertindak balas dengan lebih semula jadi kepada soalan pengguna. Tetapi kadangkala pengetahuan model tidak mencukupi, dan walaupun model boleh mengakses kandungan luaran melalui RAG, ia dianggap berfaedah untuk menyesuaikan model kepada domain baharu melalui penalaan halus. Penalaan halus ini dilakukan menggunakan input daripada anotasi manusia atau ciptaan LLM lain, di mana model menemui pengetahuan dunia sebenar tambahan dan menyepadukannya

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Editor |ScienceAI Question Answering (QA) set data memainkan peranan penting dalam mempromosikan penyelidikan pemprosesan bahasa semula jadi (NLP). Set data QA berkualiti tinggi bukan sahaja boleh digunakan untuk memperhalusi model, tetapi juga menilai dengan berkesan keupayaan model bahasa besar (LLM), terutamanya keupayaan untuk memahami dan menaakul tentang pengetahuan saintifik. Walaupun pada masa ini terdapat banyak set data QA saintifik yang meliputi bidang perubatan, kimia, biologi dan bidang lain, set data ini masih mempunyai beberapa kekurangan. Pertama, borang data adalah agak mudah, kebanyakannya adalah soalan aneka pilihan. Ia mudah dinilai, tetapi mengehadkan julat pemilihan jawapan model dan tidak dapat menguji sepenuhnya keupayaan model untuk menjawab soalan saintifik. Sebaliknya, Soal Jawab terbuka

Lima sekolah pembelajaran mesin yang anda tidak tahu

Jun 05, 2024 pm 08:51 PM

Lima sekolah pembelajaran mesin yang anda tidak tahu

Jun 05, 2024 pm 08:51 PM

Pembelajaran mesin ialah cabang penting kecerdasan buatan yang memberikan komputer keupayaan untuk belajar daripada data dan meningkatkan keupayaan mereka tanpa diprogramkan secara eksplisit. Pembelajaran mesin mempunyai pelbagai aplikasi dalam pelbagai bidang, daripada pengecaman imej dan pemprosesan bahasa semula jadi kepada sistem pengesyoran dan pengesanan penipuan, dan ia mengubah cara hidup kita. Terdapat banyak kaedah dan teori yang berbeza dalam bidang pembelajaran mesin, antaranya lima kaedah yang paling berpengaruh dipanggil "Lima Sekolah Pembelajaran Mesin". Lima sekolah utama ialah sekolah simbolik, sekolah sambungan, sekolah evolusi, sekolah Bayesian dan sekolah analogi. 1. Simbolisme, juga dikenali sebagai simbolisme, menekankan penggunaan simbol untuk penaakulan logik dan ekspresi pengetahuan. Aliran pemikiran ini percaya bahawa pembelajaran adalah proses penolakan terbalik, melalui sedia ada

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Editor |. KX Dalam bidang penyelidikan dan pembangunan ubat, meramalkan pertalian pengikatan protein dan ligan dengan tepat dan berkesan adalah penting untuk pemeriksaan dan pengoptimuman ubat. Walau bagaimanapun, kajian semasa tidak mengambil kira peranan penting maklumat permukaan molekul dalam interaksi protein-ligan. Berdasarkan ini, penyelidik dari Universiti Xiamen mencadangkan rangka kerja pengekstrakan ciri berbilang mod (MFE) novel, yang buat pertama kalinya menggabungkan maklumat mengenai permukaan protein, struktur dan jujukan 3D, dan menggunakan mekanisme perhatian silang untuk membandingkan ciri modaliti yang berbeza penjajaran. Keputusan eksperimen menunjukkan bahawa kaedah ini mencapai prestasi terkini dalam meramalkan pertalian mengikat protein-ligan. Tambahan pula, kajian ablasi menunjukkan keberkesanan dan keperluan maklumat permukaan protein dan penjajaran ciri multimodal dalam rangka kerja ini. Penyelidikan berkaitan bermula dengan "S

Meletakkan pasaran seperti AI, GlobalFoundries memperoleh teknologi gallium nitrida Tagore Technology dan pasukan berkaitan

Jul 15, 2024 pm 12:21 PM

Meletakkan pasaran seperti AI, GlobalFoundries memperoleh teknologi gallium nitrida Tagore Technology dan pasukan berkaitan

Jul 15, 2024 pm 12:21 PM

Menurut berita dari laman web ini pada 5 Julai, GlobalFoundries mengeluarkan kenyataan akhbar pada 1 Julai tahun ini, mengumumkan pemerolehan teknologi power gallium nitride (GaN) Tagore Technology dan portfolio harta intelek, dengan harapan dapat mengembangkan bahagian pasarannya dalam kereta dan Internet of Things dan kawasan aplikasi pusat data kecerdasan buatan untuk meneroka kecekapan yang lebih tinggi dan prestasi yang lebih baik. Memandangkan teknologi seperti AI generatif terus berkembang dalam dunia digital, galium nitrida (GaN) telah menjadi penyelesaian utama untuk pengurusan kuasa yang mampan dan cekap, terutamanya dalam pusat data. Laman web ini memetik pengumuman rasmi bahawa semasa pengambilalihan ini, pasukan kejuruteraan Tagore Technology akan menyertai GLOBALFOUNDRIES untuk membangunkan lagi teknologi gallium nitride. G