Topik perkongsian ini ialah teknologi ChatGPT, percubaan penyetempatan dan model sumber terbuka. Perkongsian ini terdiri daripada tiga bahagian Bahagian pertama memberikan pengenalan keseluruhan kepada teknologi berkaitan ChatGPT: evolusi teknologi ChatGPT, masalah semasa, tiga peringkat pembelajaran teknologi ChatGPT, organisasi data dan penilaian kesan; Percubaan kami pada penyetempatan teknologi termasuk masalah yang kami hadapi semasa percubaan, pemikiran kami, dan kesan serta aplikasi model bahagian ketiga memperkenalkan model besar sumber terbuka China yang telah kami keluarkan, dan cara menggunakan data kami sendiri untuk melatih a model tempatan Semasa operasi, masalah yang mungkin anda hadapi semasa percubaan, jurang antara model itu dan model sumber terbuka lanjutan, dan cara menambah baik lagi kesan model tersebut.

ChatGPT ialah pembantu berfungsi am. Pada 5 Disember 2022, Ketua Pegawai Eksekutif OpenAI Sam Altman menyiarkan di media sosial bahawa ChatGPT telah melebihi 1 juta pengguna lima hari selepas pelancarannya. Chatbot AI ChatGPT meledak menjadi popular dan telah menjadi acara penting. Microsoft sedang berbincang untuk meningkatkan pegangannya sebanyak $10 bilion dan tidak lama lagi mengintegrasikannya ke dalam Microsoft Cloud.

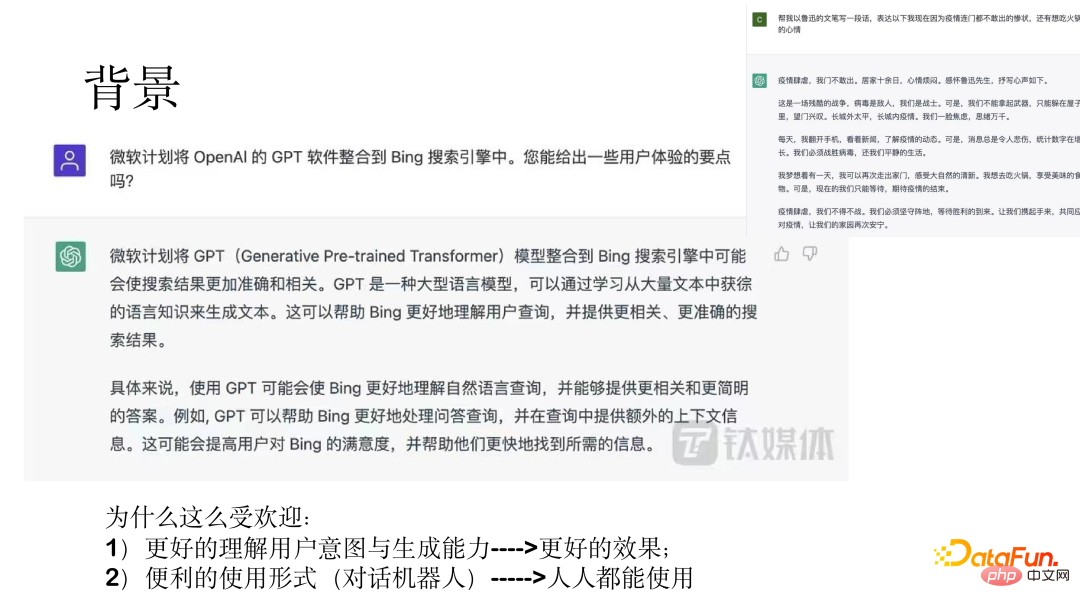

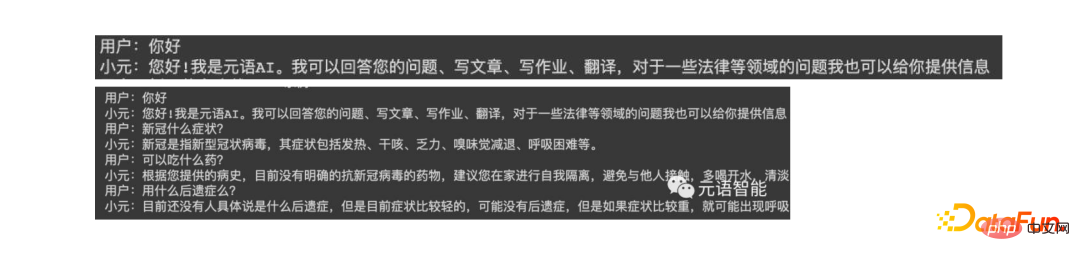

Dua contoh ditunjukkan dalam gambar di atas, menunjukkan hasil yang menakjubkan. | penggunaan robot perbualan membentuk supaya semua orang boleh menggunakannya.

Berikut akan merangkumi evolusi model, masalah dengan model awal, tiga peringkat pembelajaran model ChatGPT dan organisasi data serta kesan latihan model ChatGPT memperkenalkan.

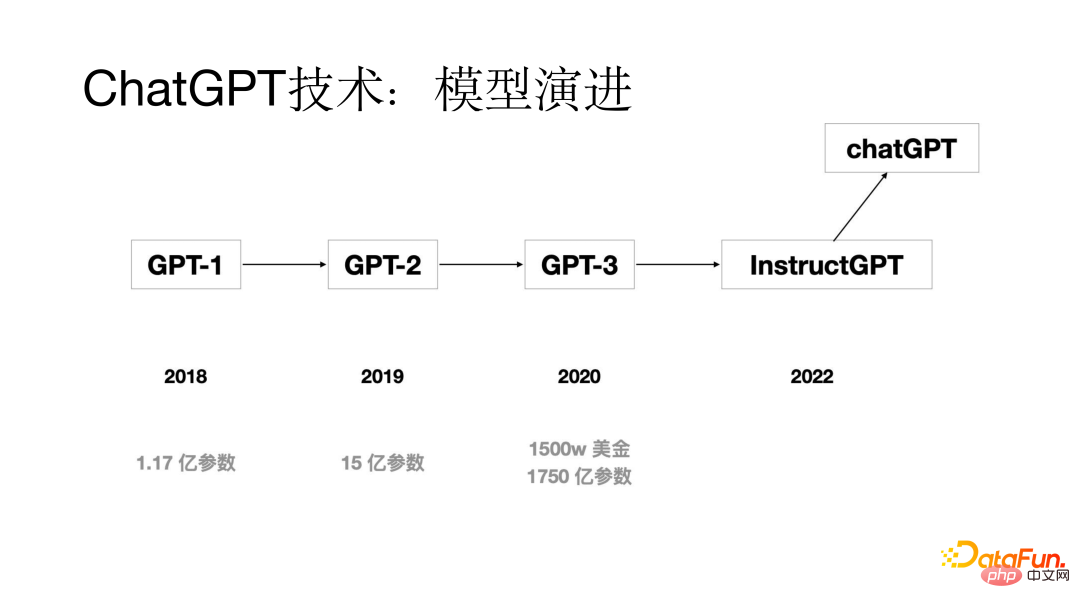

1. Evolusi model

2. Apakah masalah yang dihadapi oleh model sebelumnya? adakah masalah dengan model sebelum model ChatGPT keluar? Melalui analisis, didapati bahawa salah satu masalah yang lebih jelas ialah masalah penjajaran Walaupun keupayaan penjanaan model besar agak kuat, jawapan yang dihasilkan kadangkala tidak memenuhi kehendak pengguna. Melalui kajian, didapati punca utama masalah penjajaran ialah matlamat latihan latihan model bahasa adalah untuk meramal perkataan seterusnya, bukannya menjananya mengikut niat pengguna. Untuk menyelesaikan masalah penjajaran, proses Pembelajaran Pengukuhan daripada Maklum Balas Manusia (RLHF) ditambah pada proses latihan model ChatGPT.

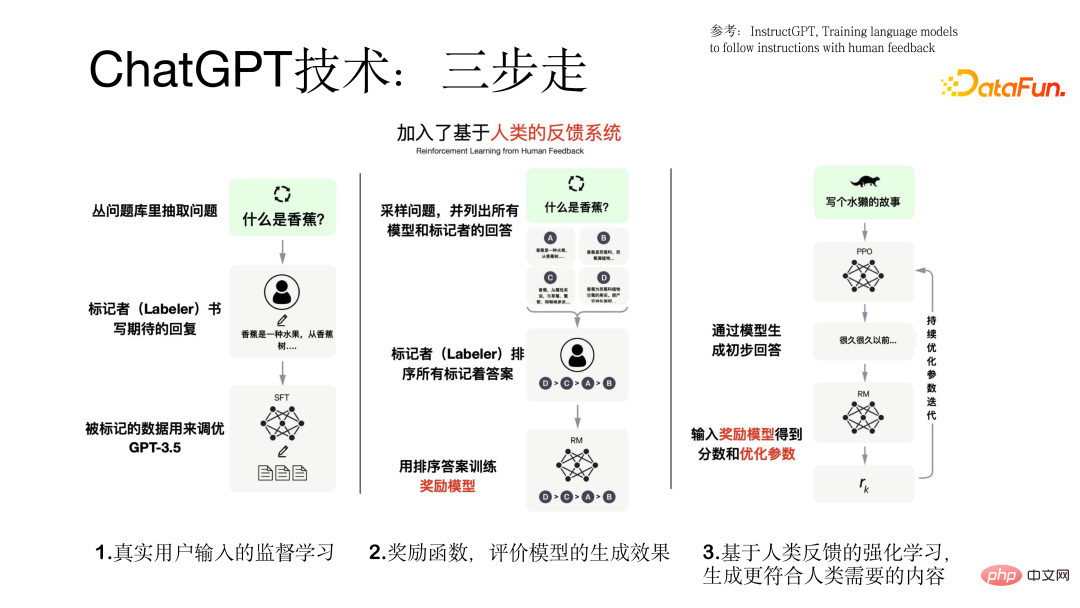

Proses latihan model ChatGPT dijalankan dalam tiga langkah.

menggunakan input pengguna sebenar untuk pembelajaran terselia berdasarkan model GPT Data dalam proses itu datang daripada pengguna sebenar, dan kualiti data agak tinggi dan bernilai.

Langkah kedua ialah melatih model ganjaran Model yang berbeza akan menghasilkan output yang berbeza untuk pertanyaan. Akibatnya, penanda mengisih hasil keluaran semua model dan menggunakan data yang diisih ini untuk melatih model ganjaran.

Langkah ketiga ialah memasukkan jawapan awal yang dijana oleh model ke dalam model ganjaran Model ganjaran akan menilai jawapan Sekiranya jawapan memenuhi hasrat pengguna, maklum balas positif akan diberikan, sebaliknya maklum balas negatif akan diberikan, seterusnya menjadikan model lebih baik dan lebih baik Ini adalah tujuan memperkenalkan pembelajaran pengukuhan untuk menjadikan hasil yang dihasilkan lebih sesuai dengan keperluan manusia . Proses tiga langkah melatih model ChatGPT ditunjukkan dalam rajah di bawah.

Kita perlu menyediakan set data sebelum melatih model Dalam proses ini, kita akan menghadapi masalah permulaan sejuk data, yang boleh diselesaikan melalui tiga aspek berikut:

(1) Kumpul set data yang digunakan oleh pengguna sistem lama

( 2) Biarkan penganotasi menganotasi beberapa gesaan dan output yang serupa berdasarkan input soalan oleh pengguna sebenar sebelum ini.

Data untuk melatih model ChatGPT mengandungi tiga bahagian set data (77k data sebenar): (1) Berasaskan pembelajaran diselia pada gesaan pengguna sebenar Data, gesaan pengguna, respons model, jumlah data ialah 13k.

(2) Set data yang digunakan untuk melatih model ganjaran ini adalah untuk pengisihan berbilang respons yang sepadan dengan satu gesaan, dan volum data ialah 33k.

(3) Set data berdasarkan model ganjaran menggunakan teknologi pembelajaran tetulang untuk latihan model Ia hanya memerlukan gesaan pengguna keperluan kualiti yang tinggi.

Selepas melengkapkan latihan model ChatGPT, penilaian model adalah agak mencukupi, terutamanya dari aspek berikut: (1 ) Sama ada hasil yang dijana oleh model memenuhi hasrat pengguna

(2) Sama ada hasil yang dihasilkan dapat memenuhi kekangan yang disebutkan oleh pengguna

(3) Sama ada model itu boleh memberikan hasil yang baik dalam bidang perkhidmatan pelanggan

Butiran perbandingan dengan Model asas GPT Keputusan eksperimen ditunjukkan dalam rajah di bawah.

2 Penyetempatan teknologi ChatGPT

1 Latar belakang dan isu

(1) Teknologi ChatGPT sendiri agak maju dan berfungsi lebih baik pada banyak tugas, tetapi ia tidak menyediakan perkhidmatan ke tanah besar China.

(2) Ia mungkin tidak dapat memenuhi keperluan pelanggan peringkat perusahaan domestik dan tidak dapat menyediakan sokongan dan perkhidmatan teknikal setempat.

(3) Harganya adalah dalam dolar AS, yang merupakan pasaran utama di Eropah dan Amerika Syarikat Harganya agak mahal dan kebanyakan pengguna domestik mungkin tidak mampu. Melalui ujian, didapati bahawa setiap keping data berharga kira-kira 0.5 yuan, dan pengkomersilan adalah mustahil untuk pelanggan yang mempunyai jumlah data yang besar.

Disebabkan oleh tiga masalah di atas, kami cuba menyetempatkan teknologi ChatGPT.

Kami sedang dalam proses penyetempatan teknologi ChatGPT , mengamalkan strategi berjalan secara teragih.

Pertama, model pra-latihan Cina dengan berpuluh bilion parameter telah dilatih; kedua, pembelajaran diselia tugasan dilakukan menggunakan Prompt pada data tugas peringkat bilion; berbual, iaitu, dalam Berinteraksi dengan orang dalam bentuk dialog atau interaksi manusia-komputer akhirnya, kami memperkenalkan teknologi RLHF pembelajaran pengukuhan model ganjaran dan maklum balas pengguna.

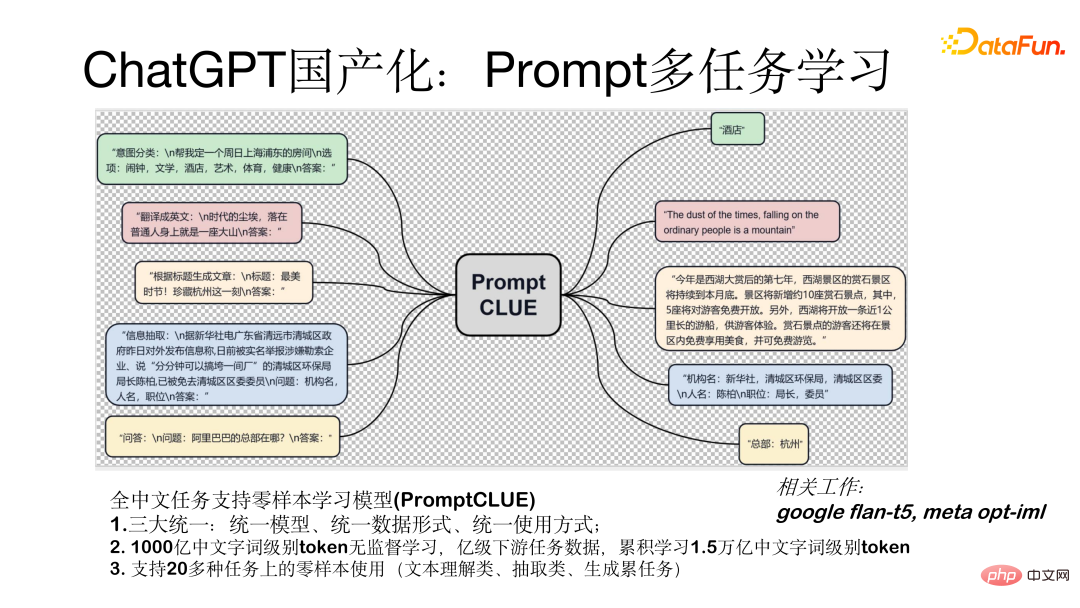

Model pembelajaran pelbagai tugas segera (PromptCLUE) ialah model yang menyokong pembelajaran sifar pukulan untuk semua tugasan bahasa Cina. Model ini mencapai tiga penyatuan utama: model bersatu, borang data bersatu (semua tugas ditukar kepada bentuk segera) dan kaedah penggunaan bersatu (digunakan dalam bentuk sampel sifar). Model ini berdasarkan pembelajaran tanpa pengawasan 100 bilion token peringkat perkataan Cina Ia dilatih pada data tugas hiliran peringkat bilion dan telah mengumpul 1.5 trilion token peringkat perkataan Cina. Menyokong penggunaan sampel sifar pada lebih daripada 20 tugasan (tugas pemahaman teks, pengekstrakan dan penjanaan).

Cara menukar model kepada model perbualan, iaitu menukarkannya kepada model dalam bentuk manusia -interaksi komputer. Kami terutamanya melakukan aspek berikut Bekerja:

Pertama sekali, untuk menjadikan model mempunyai kesan penjanaan yang lebih baik, kami mengalih keluar tugas pemahaman dan pengekstrakan teks, dengan itu mengukuhkan pembelajaran soal jawab, dialog dan penjanaan tugasan, kedua, selepas berubah menjadi model dialog, hasil yang dihasilkan akan diganggu oleh konteks Untuk menangani masalah ini, kami menambah data anti-gangguan supaya model boleh mengabaikan konteks yang tidak relevan apabila perlu; akhirnya, kami berdasarkan data maklum balas pengguna sebenar Proses pembelajaran ditambah untuk membolehkan model memahami dengan lebih baik niat pengguna. Rajah di bawah menunjukkan bentuk ujian pusingan tunggal dan berbilang pusingan dengan model.

Berikut adalah ujian untuk. model Dengan membandingkan kesan semasa dengan model ChatGPT, masih terdapat jurang 1 hingga 2 tahun Walau bagaimanapun, jurang ini boleh dibuat secara beransur-ansur Pada masa ini, kami telah membuat beberapa percubaan yang berguna dan telah mencapai keputusan tertentu kini mempunyai beberapa dialog, Soal Jawab, penulisan dan interaksi lain. Imej di bawah menunjukkan keputusan ujian.

Di atas bermula dengan Platform Huggingface diambil sebagai contoh untuk menunjukkan cara menggunakan model secara tempatan. Cari ChatYuan pada platform, muatkan model dan lakukan pembungkusan mudah. Terdapat beberapa parameter penting yang digunakan, seperti sama ada untuk sampel sampel Jika anda perlu menjana pelbagai sampel, anda perlu membuat sampel.

Di atas bermula dengan Platform Huggingface diambil sebagai contoh untuk menunjukkan cara menggunakan model secara tempatan. Cari ChatYuan pada platform, muatkan model dan lakukan pembungkusan mudah. Terdapat beberapa parameter penting yang digunakan, seperti sama ada untuk sampel sampel Jika anda perlu menjana pelbagai sampel, anda perlu membuat sampel.

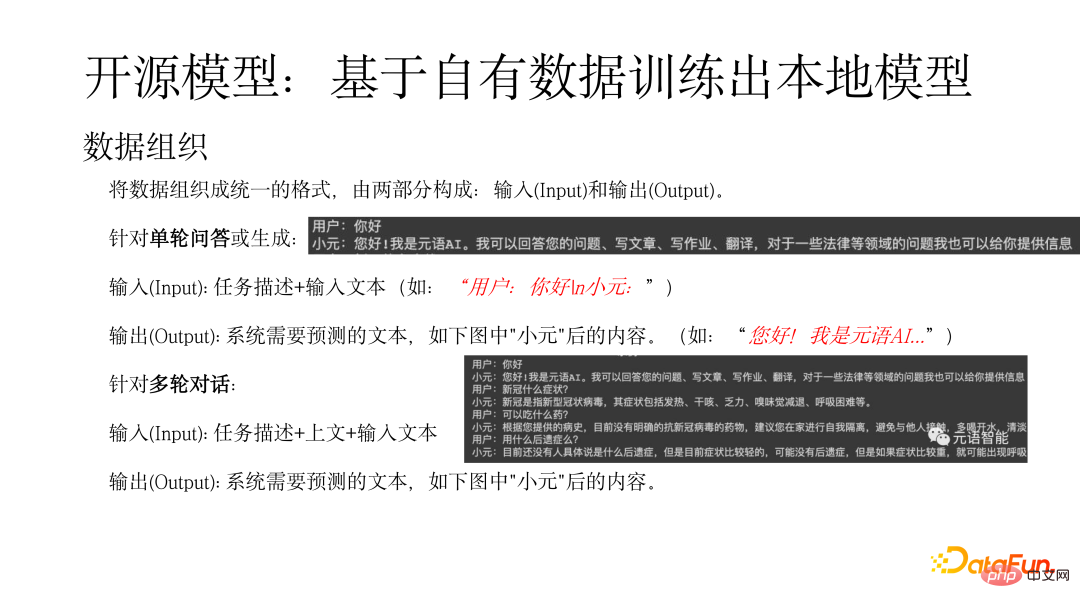

Pertama, data perlu disusun dalam bentuk bersatu, yang terdiri daripada dua bahagian : input dan Output. Untuk satu pusingan soalan dan jawapan atau input yang dijana (Input): penerangan tugas + teks input (seperti: "Pengguna: Hello n Xiaoyuan:"), output (Output) merujuk kepada teks yang perlu diramalkan oleh sistem (seperti sebagai: "Hello! I Ia adalah metalanguage AI..."). Untuk input dialog berbilang pusingan (Input): perihalan tugas + di atas + teks input, output merujuk kepada teks yang perlu diramalkan oleh sistem, seperti kandungan selepas "Xiaoyuan" dalam rajah di bawah.

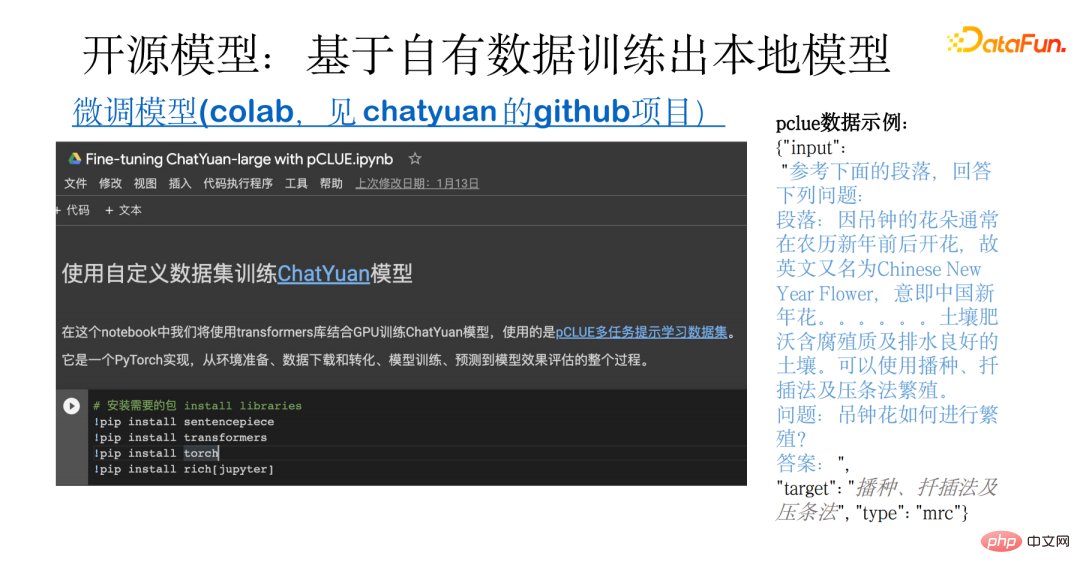

Rajah berikut menunjukkan contoh melatih model tempatan berdasarkan datanya sendiri. Contoh ini merangkumi keseluruhan proses, daripada penyediaan data kepada memuat turun dan menukar data sumber terbuka, serta latihan model, ramalan dan penilaian. Asasnya ialah set data berbilang tugas pCLUE. Pengguna boleh menggunakan data mereka sendiri untuk latihan, atau menggunakan pCLUE untuk latihan awal untuk menguji kesannya.

<.>ChatYuan dan ChatGPT kedua-duanya adalah model dialog berfungsi untuk tujuan umum, mampu bersoal jawab, interaksi dan penjanaan dalam sembang atau bidang profesional seperti undang-undang dan perubatan. Berbanding dengan model ChatGPT, masih terdapat jurang tertentu, terutamanya dicerminkan dalam aspek berikut:

Anda mungkin menghadapi masalah dengan kesan penjanaan dan panjang teks semasa penggunaan model, bergantung pada sama ada format data adalah betul dan sama ada Sampel pensampelan, panjang hasil keluaran mengawal max_length, dsb.

Untuk menambah baik lagi kesan model, anda boleh bermula dari aspek berikut:

(1) Gabungkan data industri untuk latihan lanjut, termasuk pra-latihan tanpa pengawasan, dan gunakan sejumlah besar data berkualiti tinggi untuk pembelajaran terselia.

(2) Pembelajaran menggunakan data maklum balas pengguna sebenar boleh mengimbangi perbezaan pengedaran.

(3) Memperkenalkan pembelajaran pengukuhan untuk menyelaraskan niat pengguna.

(4) Pilih model yang lebih besar Secara umumnya, lebih besar model, lebih kuat keupayaan model.

Teknologi baharu dan senario penggunaan yang dibawa oleh ChatGPT membolehkan orang ramai melihat potensi besar AI. Lebih banyak aplikasi akan dinaik taraf, mewujudkan kemungkinan untuk beberapa aplikasi baharu.

Yuanyu Intelligence, sebagai penyedia perkhidmatan Model-as-a-Service model besar, juga sentiasa meneroka dalam bidang ini. Rakan kongsi yang berminat dialu-alukan untuk memberi perhatian kepada laman web dan akaun rasmi kami.

Itu sahaja perkongsian hari ini, terima kasih semua.Atas ialah kandungan terperinci Percubaan untuk menyetempatkan teknologi ChatGPT. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Pendaftaran ChatGPT

Pendaftaran ChatGPT

Ensiklopedia ChatGPT percuma domestik

Ensiklopedia ChatGPT percuma domestik

Bagaimana untuk memasang chatgpt pada telefon bimbit

Bagaimana untuk memasang chatgpt pada telefon bimbit

Bolehkah chatgpt digunakan di China?

Bolehkah chatgpt digunakan di China?

Apa yang perlu dilakukan jika kod skrin biru 0x0000007e berlaku

Apa yang perlu dilakukan jika kod skrin biru 0x0000007e berlaku

Pengenalan kepada arahan pendaftaran Windows yang biasa digunakan

Pengenalan kepada arahan pendaftaran Windows yang biasa digunakan

Perisian sistem pengurusan harta

Perisian sistem pengurusan harta

Semak status port yang diduduki dalam tingkap

Semak status port yang diduduki dalam tingkap