Peranti teknologi

Peranti teknologi

AI

AI

Tafsiran topik hangat: Keupayaan muncul model besar dan anjakan paradigma yang dicetuskan oleh ChatGPT

Tafsiran topik hangat: Keupayaan muncul model besar dan anjakan paradigma yang dicetuskan oleh ChatGPT

Tafsiran topik hangat: Keupayaan muncul model besar dan anjakan paradigma yang dicetuskan oleh ChatGPT

Baru-baru ini, terdapat minat yang besar terhadap keupayaan berkuasa yang ditunjukkan oleh model bahasa berskala besar (seperti rantai pemikiran[2], pad gores[3]), dan banyak kerja telah dijalankan. Kami secara kolektif merujuk kepada ini sebagai keupayaan muncul model besar [4]. Keupayaan ini mungkin [5] hanya wujud dalam model besar tetapi tidak dalam model yang lebih kecil, jadi ia dipanggil "emergent". Banyak daripada keupayaan ini sangat mengagumkan, seperti penaakulan yang kompleks, penaakulan pengetahuan, dan keteguhan di luar pengedaran, yang akan kita bincangkan secara terperinci kemudian.

Terutamanya, keupayaan ini hampir dengan apa yang dicari oleh komuniti NLP selama beberapa dekad, dan dengan itu mewakili anjakan paradigma penyelidikan yang berpotensi daripada memperhalusi model kecil kepada menggunakan model besar untuk pembelajaran kontekstual. Bagi penggerak pertama, anjakan paradigma mungkin jelas. Walau bagaimanapun, demi ketegasan saintifik, kita memerlukan sebab yang sangat jelas mengapa seseorang itu perlu beralih kepada model bahasa yang besar, walaupun model ini mahal [6] dan sukar untuk digunakan [ 7 ], dan kesannya mungkin sederhana[8]. Dalam artikel ini, kami akan melihat dengan lebih dekat apakah keupayaan ini, model bahasa besar yang boleh ditawarkan dan potensi kelebihannya dalam julat tugas NLP/ML yang lebih luas.

Pautan asal: yaofu.notion.site/A-Closer-Look-at-Large-Language-Models-Emergent-Abilities-493876b55df5479d80686d7>Jadual Kandungan

: Kami menganggap pembaca mempunyai pengetahuan berikut:

- 1 Keupayaan muncul yang wujud dalam model besar dan bukannya model kecil

- <.>

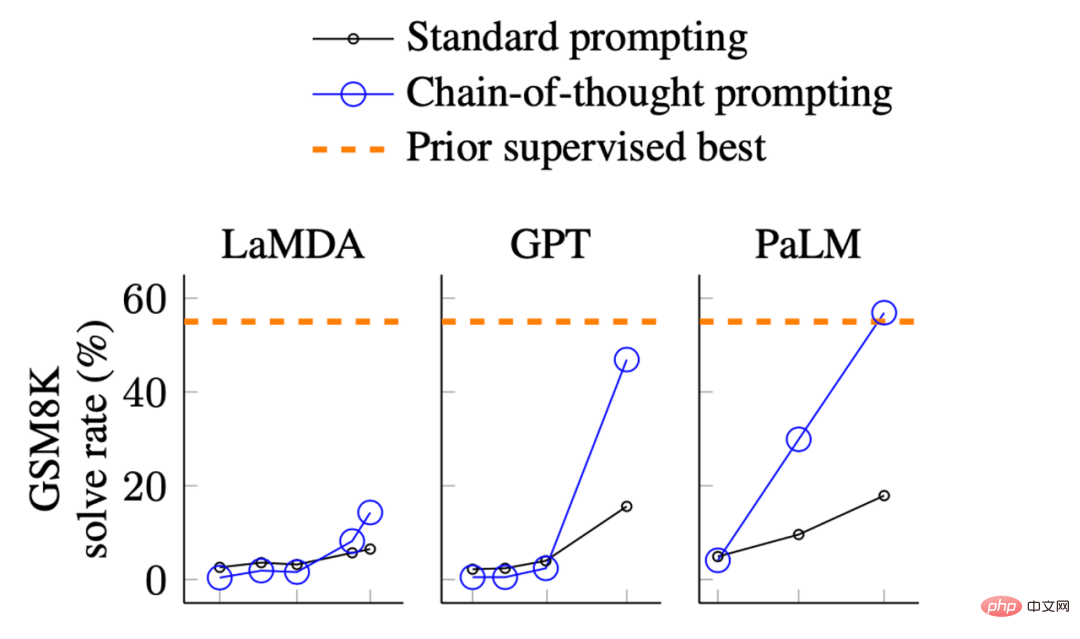

- Imej daripada Wei et al. Paksi X ialah saiz model. GSM8K ialah koleksi masalah matematik peringkat sekolah rendah.

Dalam pemaparan di atas, kita boleh melihat prestasi model:

Dalam pemaparan di atas, kita boleh melihat prestasi model:

Apabila saiz Apabila model agak kecil, tidak banyak peningkatan

Apabila model menjadi lebih besar, terdapat peningkatan yang ketara

- Ini secara asasnya menunjukkan bahawa, beberapa keupayaan mungkin tidak wujud dalam model kecil tetapi diperoleh dalam model besar.

- Terdapat banyak jenis keupayaan yang muncul, seperti yang diselesaikan oleh Wei et al pada tahun 2022

- [9]. Sesetengah kebolehan adalah menarik, tetapi kami tidak akan membincangkannya dalam artikel ini, seperti mengeja huruf terakhir rentetan perkataan Kami fikir ini adalah tugas untuk Python dan bukannya model bahasa atau penambahan 3 digit adalah pengiraan ini yang dilakukan oleh pemproses dan bukannya model bahasa.

Dalam artikel ini, kami amat berminat dengan keupayaan berikut:

1 Komuniti NLP telah memberi perhatian kepadanya sejak beberapa tahun kebelakangan ini , tetapi Keupayaan NLP sebelumnya yang sukar dicapai oleh model 2 Keupayaan yang diperolehi daripada intipati terdalam bahasa manusia (depth of capabilities)

. 3. Keupayaan yang mungkin mencapai tahap kecerdasan manusia yang tertinggi (had atas keupayaan)

2. Tiga contoh tipikal kebolehan yang muncul

Banyak yang menarik kebolehan boleh dikelaskan seperti di atas Antara kategori yang disebutkan dalam artikel, antaranya, kami membincangkan tiga kebolehan tipikal berikut:

Penaakulan yang kompleks

Penaakulan yang rumit

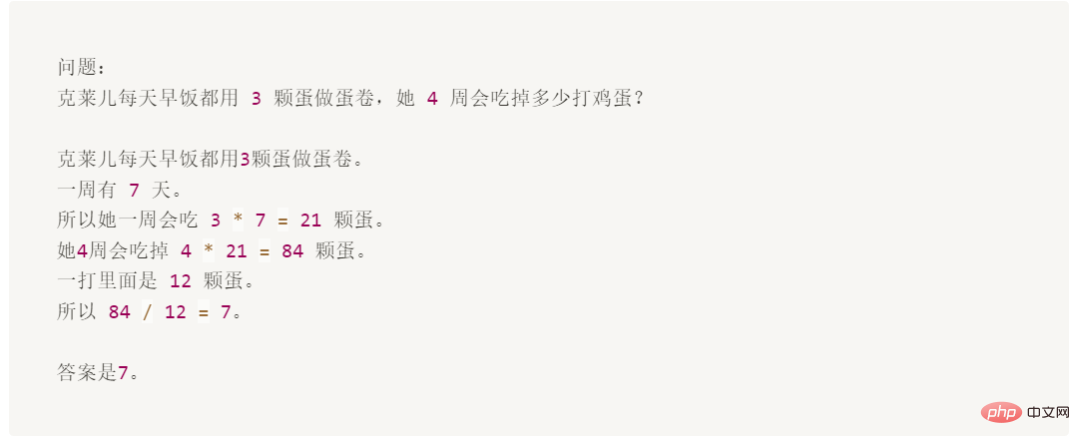

Berikut ialah contoh dalam set data GSM8K yang menggunakan perkataan gesaan dengan ketara melebihi penalaan halus:

Walaupun soalan ini mudah untuk kanak-kanak berumur 10 tahun, ia adalah sukar untuk model bahasa, terutamanya disebabkan oleh gabungan matematik dan bahasa.

GSM8K pada asalnya dicadangkan oleh OpenAI pada Oktober 2021 [10]. Pada masa itu, mereka menggunakan versi pertama [11]GPT3 untuk memperhalusi keseluruhan set latihan, dengan ketepatan kira-kira 35%. Keputusan ini menjadikan pengarang agak pesimis, kerana keputusan mereka menunjukkan undang-undang penskalaan model bahasa: apabila saiz model meningkat secara eksponen, prestasi meningkat secara linear (saya akan membincangkannya kemudian). Oleh itu, mereka merenung dalam Bahagian 4.1:

“Model 175B nampaknya memerlukan sekurang-kurangnya dua urutan magnitud lebih banyak data latihan untuk mencapai kadar penyelesaian 80%. ”

Tiga bulan kemudian, pada Januari 2022, Wei et al. Contoh meningkatkan ketepatan kepada 56.6% (tanpa meningkatkan set latihan sebanyak dua urutan magnitud). Kemudian pada Mac 2022, Wang et al. [13] berdasarkan model PaLM 540B yang sama dan meningkatkan ketepatan kepada 74.4% melalui kaedah undian majoriti. SOTA semasa datang daripada kerja saya sendiri pada AI2 (Fu et. al. Nov 2022[14]), di mana kami mencapai ketepatan 82.9% pada Codex 175B dengan menggunakan rantai pemikiran yang kompleks. Seperti yang dapat dilihat daripada kemajuan di atas, kemajuan teknologi sememangnya berkembang dengan pesat. Gesaan rantai pemikiran ialah contoh tipikal untuk menunjukkan keupayaan muncul model apabila ia berskala:

Daripada keupayaan yang timbul Mari kita lihat

- : Hanya apabila model lebih besar daripada 100B boleh kesan rantaian pemikiran lebih besar daripada satu-satunya gesaan jawapan. Jadi keupayaan ini hanya wujud dalam model besar.

- Dari sudut kesan : Prestasi gesaan rantaian pemikiran jauh lebih baik daripada penalaan halus sebelumnya

- [15] kaedah. Dari perspektif kecekapan anotasi : Gesaan rantai pemikiran hanya memerlukan anotasi sebanyak 8 contoh, manakala penalaan halus memerlukan set latihan yang lengkap.

- Sesetengah pelajar mungkin berfikir bahawa ini tidak bermakna model itu boleh melakukan matematik sekolah rendah (dalam erti kata lain, mereka sebenarnya tidak begitu hebat). Tetapi GSM8K hanyalah permulaan, dan kerja baru-baru ini telah mendorong masalah canggih kepada sekolah menengah [16]

[17] dan juga masalah Olimpik Matematik Antarabangsa[ 18] . Adakah ia lebih sejuk sekarang? Pengetahuan Penaakulan

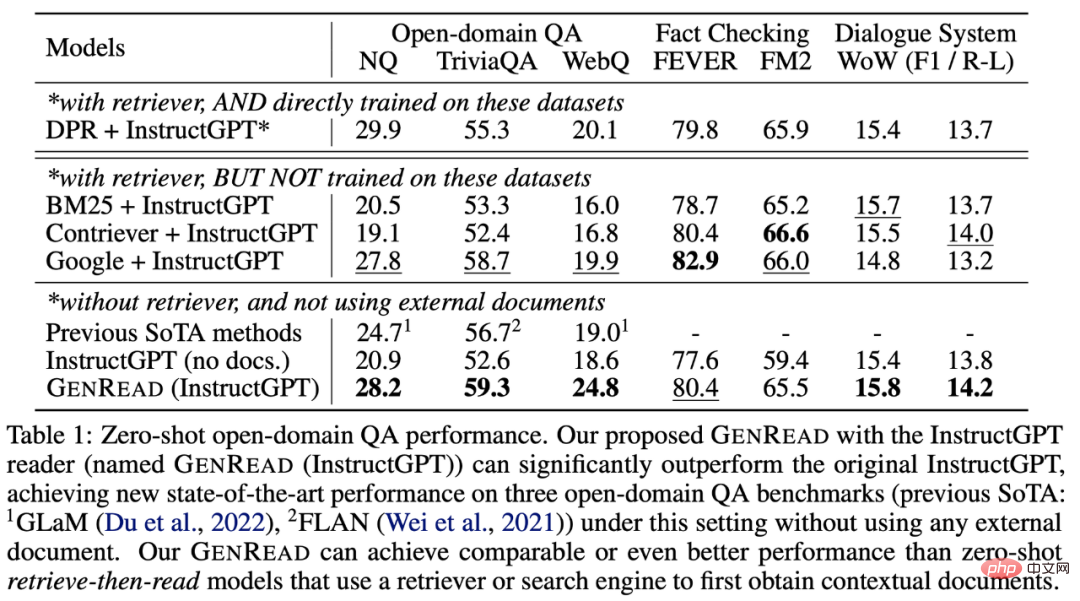

Contoh seterusnya ialah kebolehan penaakulan yang memerlukan pengetahuan (seperti soal jawab dan akal penaakulan). Dalam kes ini, menggesa model besar tidak semestinya lebih baik daripada memperhalusi model kecil (model mana yang lebih baik masih perlu dilihat). Tetapi kecekapan anotasi dalam kes ini diperkuatkan kerana:

Dalam banyak set data, untuk mendapatkan latar belakang/pengetahuan akal sehat yang diperlukan, model (sebelum ini kecil) An external graf korpus/pengetahuan diperlukan untuk mendapatkan

[19]- , atau latihan tentang tambahan

- [20] data diperlukan melalui pembelajaran berbilang tugas Untuk model bahasa yang besar, anda boleh mengalih keluar retriever terus [21] dan hanya bergantung pada pengetahuan dalaman model

- [22] tanpa memerlukan penalaan halus

Seperti yang ditunjukkan dalam jadual, tidak seperti contoh masalah matematik, GPT-3 tidak begitu ketara mengatasi model diperhalusi sebelumnya. Tetapi ia tidak perlu diambil dari dokumen luar, ia sendiri mengandungi pengetahuan [23]

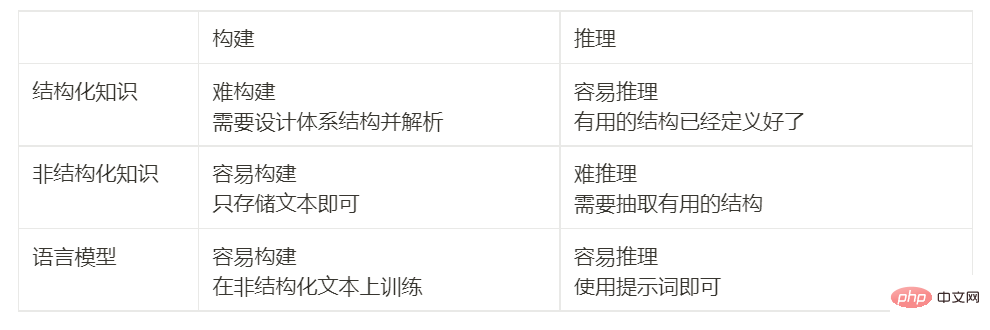

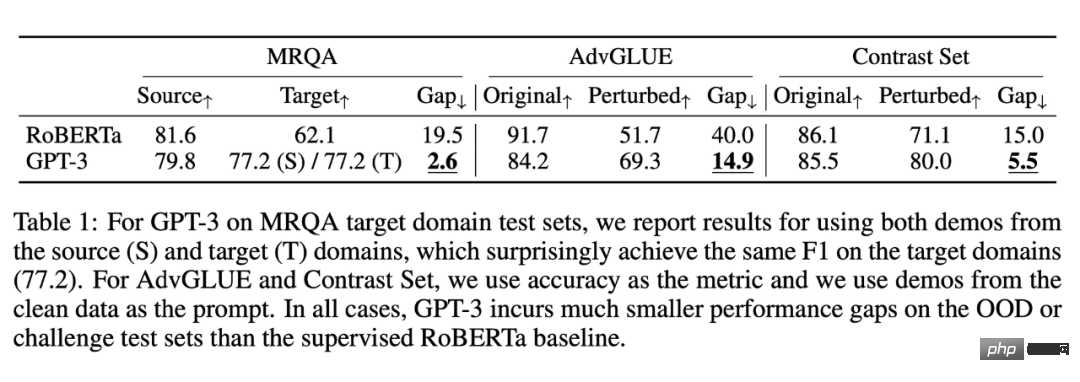

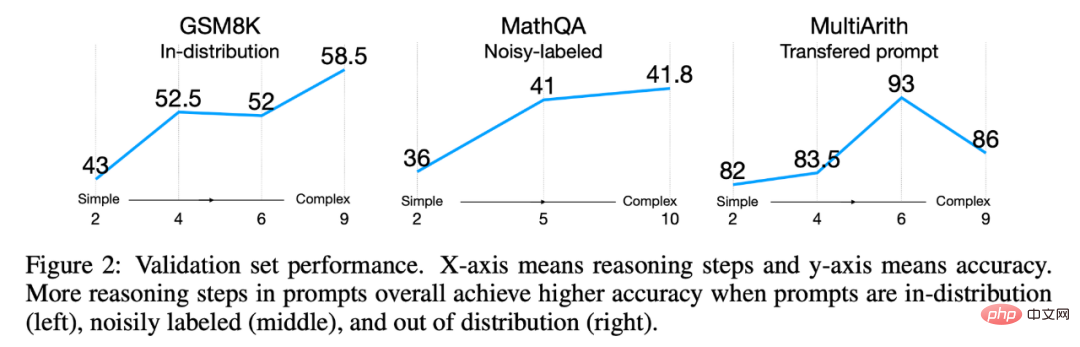

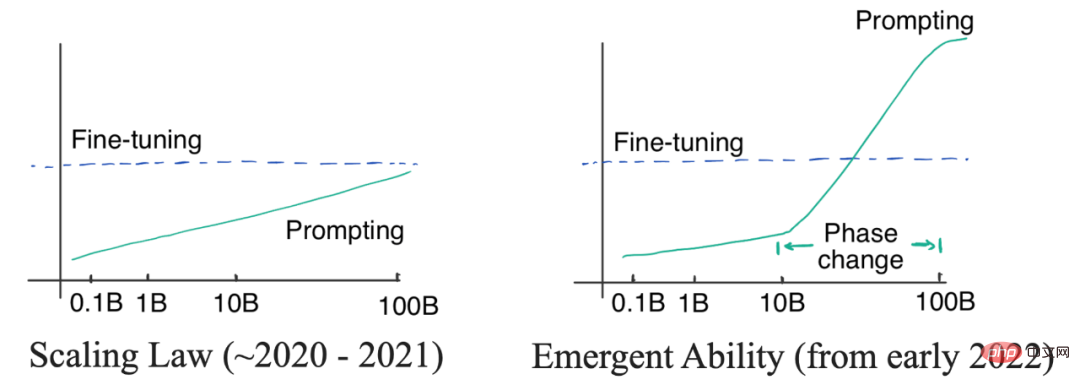

.Untuk memahami kepentingan keputusan ini, kita boleh melihat kembali sejarah: komuniti NLP telah menghadapi cabaran cara mengekod pengetahuan dengan cekap dari awal. Orang ramai sentiasa meneroka cara untuk menyimpan pengetahuan di luar atau di dalam model. Sejak 1990-an, orang ramai telah cuba merekodkan peraturan bahasa dan dunia di perpustakaan gergasi, menyimpan pengetahuan di luar model. Tetapi ini sangat sukar, lagipun, kita tidak boleh menghabiskan semua peraturan. Oleh itu, penyelidik mula membina pangkalan pengetahuan khusus domain untuk menyimpan pengetahuan dalam bentuk teks tidak berstruktur, separa berstruktur (seperti Wikipedia) atau berstruktur sepenuhnya (seperti graf pengetahuan). Secara amnya, pengetahuan berstruktur sukar untuk dibina (kerana sistem struktur pengetahuan perlu direka bentuk), tetapi mudah untuk menaakul (kerana seni bina), pengetahuan tidak berstruktur adalah mudah untuk dibina (hanya simpan terus), tetapi sukar untuk digunakan untuk alasan (tiada seni bina). Walau bagaimanapun, model bahasa menyediakan cara baharu untuk mengekstrak pengetahuan dengan mudah daripada teks dan alasan yang tidak berstruktur berdasarkan pengetahuan dengan cekap tanpa memerlukan corak yang telah ditetapkan. Jadual berikut membandingkan kebaikan dan keburukan: Keteguhan luar pengedaran Keupayaan ketiga yang kita bincangkan ialah keteguhan luar pengedaran. Antara tahun 2018 dan 2022, terdapat banyak penyelidikan mengenai anjakan pengedaran/kekukuhan musuh/penjanaan gabungan dalam bidang NLP, CV dan pembelajaran mesin am Didapati bahawa apabila pengedaran set ujian berbeza daripada pengedaran latihan, tingkah laku prestasi model mungkin akan menurun dengan ketara. Walau bagaimanapun, ini nampaknya tidak berlaku dalam pembelajaran konteks model bahasa besar. Penyelidikan oleh Si et al.[24] pada 2022 menunjukkan: Data datang daripada Si al. Begitu juga, dalam eksperimen ini, kesan GPT-3 berdasarkan kata gesaan di bawah pengedaran yang sama tidak sebaik RoBERTa yang ditala halus. Tetapi ia mengatasi RoBERTa dalam tiga pengedaran lain (penukaran domain, bunyi bising dan gangguan musuh), yang bermaksud GPT3 lebih mantap. Selain itu, walaupun terdapat anjakan pengedaran, prestasi generalisasi yang dibawa oleh kata-kata gesaan yang baik akan tetap dikekalkan. Contohnya: Imej daripada Fu et al. Walaupun pengedaran ujian berbeza daripada pengedaran latihan, isyarat yang kompleks sentiasa lebih baik daripada isyarat mudah Petunjuk berprestasi lebih baik. Kajian 2022 Fu et al. [25] menunjukkan bahawa lebih kompleks gesaan input, lebih baik prestasi model. Aliran ini berterusan di bawah anjakan pengedaran: isyarat kompleks secara konsisten mengatasi isyarat mudah, sama ada pengedaran ujian berbeza daripada pengedaran asal, datang daripada pengedaran hingar atau dipindahkan daripada pengedaran lain. Ringkasan setakat ini Di atas, saya membincangkan tiga jenis yang hanya terdapat pada model besar Emergent ability. Mereka ialah: Memandangkan kelebihan yang disenaraikan di atas, anda mungkin mula berfikir bahawa model bahasa yang besar sememangnya sangat baik. Sebelum membincangkan lebih lanjut, mari kita semak kerja sebelumnya dan kita akan mendapati soalan yang sangat pelik: GPT-3 dikeluarkan pada 2020, tetapi mengapa kita tidak menemui dan mula memikirkan anjakan paradigma sehingga sekarang? Jawapan kepada soalan ini terletak pada dua jenis lengkung: lengkung linear logaritma dan lengkung perubahan fasa. Seperti yang ditunjukkan di bawah: Gambar kiri: Hukum kadaran. Apabila saiz model berkembang secara eksponen, prestasi model yang sepadan berkembang secara linear. Kanan: Apabila saiz model mencapai skala tertentu, keupayaan yang muncul akan muncul, membolehkan prestasi meningkat secara mendadak. Pada mulanya, penyelidik (OpenAI) percaya bahawa hubungan antara prestasi model bahasa dan saiz model boleh diramalkan oleh lengkung log-linear, iaitu model saiz meningkat secara eksponen, prestasi akan meningkat secara linear. Fenomena ini dikenali sebagai undang-undang penskalaan model bahasa, seperti yang dibincangkan oleh Kaplan et al dalam artikel asal 2020 GPT3. Yang penting, pada peringkat itu, walaupun GPT-3 terbesar tidak dapat mengatasi penalaan halus model kecil dengan petunjuk. Oleh itu, tidak perlu menggunakan model besar yang mahal pada masa itu (walaupun pelabelan perkataan cepat sangat cekap). Sehingga 2021, Cobbe et al. [28] mendapati bahawa undang-undang penskalaan juga terpakai untuk penalaan halus. Ini adalah penemuan yang agak pesimis, kerana ini bermakna bahawa kita mungkin dikunci dalam saiz model - manakala pengoptimuman seni bina model mungkin meningkatkan prestasi model sedikit sebanyak, kesannya masih akan Dikunci dalam julat ( sepadan dengan saiz model), sukar untuk mendapatkan kejayaan yang lebih ketara . Di bawah kawalan undang-undang penskalaan (2020 hingga 2021), memandangkan GPT-3 tidak dapat mengatasi prestasi penalaan halus T5-11B, dan penalaan halus T5-11B sudah sangat menyusahkan, jadi NLP Tumpuan komuniti lebih kepada mengkaji model yang lebih kecil atau penyesuaian parameter yang cekap. Penalaan awalan[29] [30] pada 2021. Logik pada masa itu adalah mudah: Jika kesan penalaan halus adalah lebih baik, kita harus berusaha lebih pada penyesuaian parameter yang cekap; jika kaedah perkataan segera adalah lebih baik, kita harus melabur lebih banyak tenaga dalam melatih model bahasa besar. Lewat Januari 2022, karya Rantaian Pemikiran telah dikeluarkan. Seperti yang ditunjukkan oleh pengarang, isyarat rantai pemikiran mempamerkan peralihan fasa Apabila menggunakan rantaian pemikiran untuk gesaan, model besar menunjukkan prestasi yang lebih baik daripada penalaan halus pada penaakulan yang kompleks, berdaya saing pada penaakulan pengetahuan dan diedarkan dengan mantap Terdapat juga beberapa potensi. Ia hanya memerlukan kira-kira 8 contoh untuk mencapai kesan sedemikian, itulah sebabnya paradigma mungkin berubah (Nota: Artikel ini telah disiapkan sebulan sebelum ChatGPT pergi dalam talian; selepas ChatGPT pergi dalam talian, seluruh bidang terkejut dan menyedari bahawa paradigma telah berubah. ). 4. Apakah maksud anjakan paradigma?

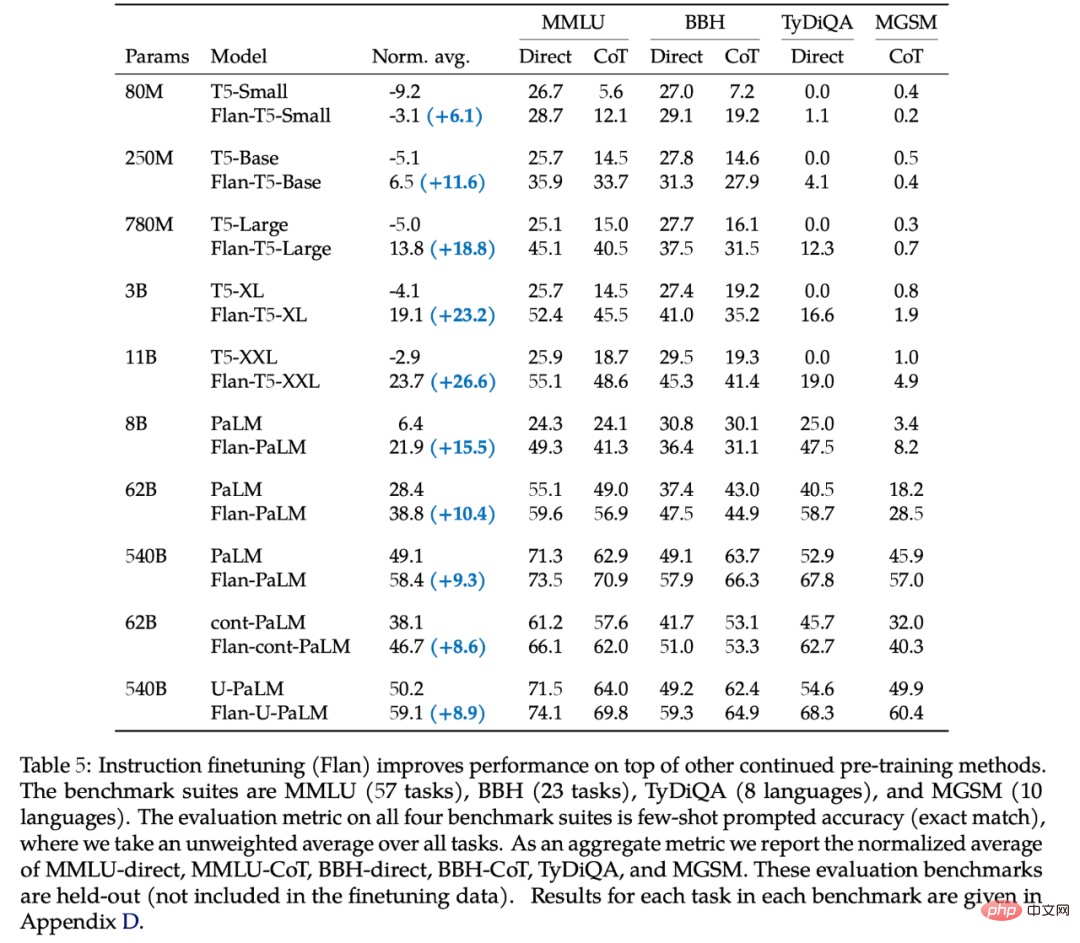

Faedah perkataan segera adalah jelas: kami tidak lagi memerlukan anotasi data yang membosankan dan penalaan halus pada jumlah penuh data Kami hanya perlu menulis perkataan segera dan mendapatkan hasil yang memenuhi keperluan, iaitu banyak lebih cepat daripada penalaan halus. Dua perkara lain yang perlu diberi perhatian ialah: Adakah pembelajaran kontekstual diselia pembelajaran? Adakah pembelajaran kontekstual benar-benar lebih baik daripada pembelajaran diselia? Mari kita semak logik yang dinyatakan di atas: Jika penalaan halus adalah lebih baik, kita harus bekerja keras untuk mengkaji cara mengoptimumkan parameter dengan cekap jika kata-kata segera adalah lebih baik, kita harus Berusaha melatih model bahasa besar yang lebih baik. Jadi, walaupun kami percaya bahawa model bahasa yang besar mempunyai potensi yang besar, Masih tiada bukti konklusif bahawa kata penalaan halus atau isyarat adalah lebih baik, jadi kami tidak 't Tentukan sama ada paradigma benar-benar perlu beralih, atau sejauh mana ia harus beralih. Adalah sangat bermakna untuk membandingkan kedua-dua paradigma ini dengan teliti untuk memberi kita pemahaman yang jelas tentang masa depan. Kami meninggalkan lebih banyak perbincangan untuk artikel seterusnya. Dua nombor: 62B dan 175B. 62B Nombor ini datang daripada jadual kelima kerja Chung et al. 2022 [31]: Untuk semua model yang lebih kecil daripada 62B, menggunakan perkataan segera secara langsung adalah lebih baik daripada rantai pemikiran. Model pertama yang lebih baik menggunakan rantai pemikiran ialah hasil Flan-cont-PaLM 62B pada BBH. Model 540B yang menggunakan rantaian pemikiran akan mendapat hasil yang baik pada lebih banyak tugas, tetapi tidak semua tugas lebih baik daripada penalaan halus. Selain itu, saiz ideal boleh kurang daripada 540B Dalam karya Suzgun et al pada tahun 2022 [32] , penulis menunjukkan bahawa InstructGPT 175B dan Codex 175B menggunakan rantaian pemikiran untuk menjadi lebih baik daripada. menggunakan kata-kata gesaan secara langsung. Menggabungkan keputusan di atas, kita mendapat dua nombor: 63B dan 175B. Jadi, jika anda ingin menyertai permainan ini, anda mesti mempunyai model saiz yang lebih besar daripada purata. Walau bagaimanapun, terdapat model besar lain yang berprestasi lebih teruk di bawah rantaian pemikiran malah tidak dapat mempelajari rantaian pemikiran, seperti versi pertama OPT, BLOOM dan GPT-3. Kedua-duanya bersaiz 175B. Ini membawa kita kepada soalan seterusnya. Tidak. Skala ialah faktor yang perlu tetapi tidak mencukupi. Sesetengah model cukup besar (seperti OPT dan BLOOM, kedua-duanya 175B), tetapi mereka tidak boleh melakukan rantaian pemikiran. Terdapat dua model [33] yang boleh digunakan sebagai rantai pemikiran: Tidak jelas mengapa terdapat kebolehan yang muncul, tetapi kami telah mengetahui faktor-faktor yang mungkin menghasilkan kebolehan yang muncul: . 7. Kesimpulan KesimpulanDalam artikel ini, kami mengkaji dengan teliti keupayaan model bahasa yang muncul. Kami menyerlahkan kepentingan dan peluang untuk penaakulan yang kompleks, penaakulan pengetahuan, dan keteguhan di luar pengedaran. Keupayaan yang timbul sangat menarik kerana ia boleh melangkaui undang-undang penskalaan dan mempamerkan peralihan fasa dalam lengkung penskalaan. Kami membincangkan secara terperinci sama ada paradigma penyelidikan sebenarnya akan beralih daripada penalaan halus kepada pembelajaran kontekstual, tetapi kami masih belum mempunyai jawapan yang pasti kerana kesan penalaan halus dan pembelajaran kontekstual dalam senario dalam pengedaran dan luar pengedaran masih perlu dibandingkan. Akhir sekali, kita membincangkan tiga faktor berpotensi yang menghasilkan keupayaan yang muncul: penalaan halus arahan, penalaan halus kod dan penalaan halus rantaian pemikiran. Cadangan dan perbincangan amat dialu-alukan. Selain itu kami menyebut dua isu menarik yang masih belum dibincangkan: Untuk dua soalan ini, kami akan mengikuti artikel selepas perbincangan dalam.

3. Keupayaan yang muncul membatalkan hukum perkadaran

5. Berapa besar sepatutnya model itu?

6. Adakah skala satu-satunya faktor?

Walau bagaimanapun, semua faktor ini adalah spekulatif pada peringkat ini. Sangat bermakna untuk mendedahkan cara melatih model untuk menghasilkan keupayaan yang muncul Kami akan meninggalkan lebih banyak perbincangan kepada artikel seterusnya

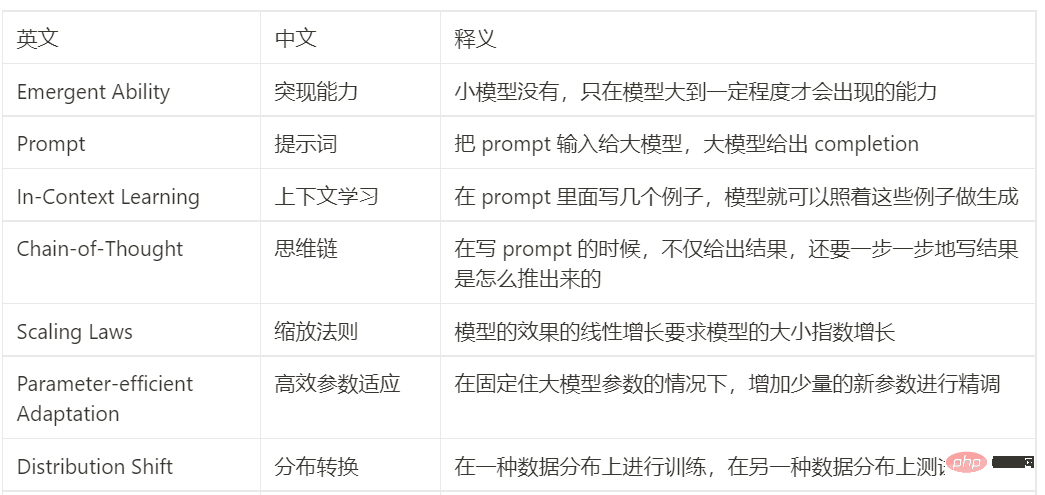

Jadual perbandingan Cina-Inggeris

Atas ialah kandungan terperinci Tafsiran topik hangat: Keupayaan muncul model besar dan anjakan paradigma yang dicetuskan oleh ChatGPT. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1376

1376

52

52

ChatGPT kini membenarkan pengguna percuma menjana imej dengan menggunakan DALL-E 3 dengan had harian

Aug 09, 2024 pm 09:37 PM

ChatGPT kini membenarkan pengguna percuma menjana imej dengan menggunakan DALL-E 3 dengan had harian

Aug 09, 2024 pm 09:37 PM

DALL-E 3 telah diperkenalkan secara rasmi pada September 2023 sebagai model yang jauh lebih baik daripada pendahulunya. Ia dianggap sebagai salah satu penjana imej AI terbaik setakat ini, mampu mencipta imej dengan perincian yang rumit. Walau bagaimanapun, semasa pelancaran, ia adalah tidak termasuk

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Bayangkan model kecerdasan buatan yang bukan sahaja mempunyai keupayaan untuk mengatasi pengkomputeran tradisional, tetapi juga mencapai prestasi yang lebih cekap pada kos yang lebih rendah. Ini bukan fiksyen sains, DeepSeek-V2[1], model MoE sumber terbuka paling berkuasa di dunia ada di sini. DeepSeek-V2 ialah gabungan model bahasa pakar (MoE) yang berkuasa dengan ciri-ciri latihan ekonomi dan inferens yang cekap. Ia terdiri daripada 236B parameter, 21B daripadanya digunakan untuk mengaktifkan setiap penanda. Berbanding dengan DeepSeek67B, DeepSeek-V2 mempunyai prestasi yang lebih kukuh, sambil menjimatkan 42.5% kos latihan, mengurangkan cache KV sebanyak 93.3% dan meningkatkan daya pemprosesan penjanaan maksimum kepada 5.76 kali. DeepSeek ialah sebuah syarikat yang meneroka kecerdasan buatan am

KAN, yang menggantikan MLP, telah diperluaskan kepada konvolusi oleh projek sumber terbuka

Jun 01, 2024 pm 10:03 PM

KAN, yang menggantikan MLP, telah diperluaskan kepada konvolusi oleh projek sumber terbuka

Jun 01, 2024 pm 10:03 PM

Awal bulan ini, penyelidik dari MIT dan institusi lain mencadangkan alternatif yang sangat menjanjikan kepada MLP - KAN. KAN mengatasi MLP dari segi ketepatan dan kebolehtafsiran. Dan ia boleh mengatasi prestasi MLP berjalan dengan bilangan parameter yang lebih besar dengan bilangan parameter yang sangat kecil. Sebagai contoh, penulis menyatakan bahawa mereka menggunakan KAN untuk menghasilkan semula keputusan DeepMind dengan rangkaian yang lebih kecil dan tahap automasi yang lebih tinggi. Khususnya, MLP DeepMind mempunyai kira-kira 300,000 parameter, manakala KAN hanya mempunyai kira-kira 200 parameter. KAN mempunyai asas matematik yang kukuh seperti MLP berdasarkan teorem penghampiran universal, manakala KAN berdasarkan teorem perwakilan Kolmogorov-Arnold. Seperti yang ditunjukkan dalam rajah di bawah, KAN telah

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas secara rasmi memasuki era robot elektrik! Semalam, Atlas hidraulik hanya "menangis" menarik diri daripada peringkat sejarah Hari ini, Boston Dynamics mengumumkan bahawa Atlas elektrik sedang berfungsi. Nampaknya dalam bidang robot humanoid komersial, Boston Dynamics berazam untuk bersaing dengan Tesla. Selepas video baharu itu dikeluarkan, ia telah pun ditonton oleh lebih sejuta orang dalam masa sepuluh jam sahaja. Orang lama pergi dan peranan baru muncul. Ini adalah keperluan sejarah. Tidak dinafikan bahawa tahun ini adalah tahun letupan robot humanoid. Netizen mengulas: Kemajuan robot telah menjadikan majlis pembukaan tahun ini kelihatan seperti manusia, dan tahap kebebasan adalah jauh lebih besar daripada manusia Tetapi adakah ini benar-benar bukan filem seram? Pada permulaan video, Atlas berbaring dengan tenang di atas tanah, seolah-olah terlentang. Apa yang berikut adalah rahang-jatuh

Robot Tesla bekerja di kilang, Musk: Tahap kebebasan tangan akan mencapai 22 tahun ini!

May 06, 2024 pm 04:13 PM

Robot Tesla bekerja di kilang, Musk: Tahap kebebasan tangan akan mencapai 22 tahun ini!

May 06, 2024 pm 04:13 PM

Video terbaru robot Tesla Optimus dikeluarkan, dan ia sudah boleh berfungsi di kilang. Pada kelajuan biasa, ia mengisih bateri (bateri 4680 Tesla) seperti ini: Pegawai itu juga mengeluarkan rupanya pada kelajuan 20x - pada "stesen kerja" kecil, memilih dan memilih dan memilih: Kali ini ia dikeluarkan Salah satu sorotan video itu ialah Optimus menyelesaikan kerja ini di kilang, sepenuhnya secara autonomi, tanpa campur tangan manusia sepanjang proses. Dan dari perspektif Optimus, ia juga boleh mengambil dan meletakkan bateri yang bengkok, memfokuskan pada pembetulan ralat automatik: Berkenaan tangan Optimus, saintis NVIDIA Jim Fan memberikan penilaian yang tinggi: Tangan Optimus adalah robot lima jari di dunia paling cerdik. Tangannya bukan sahaja boleh disentuh

FisheyeDetNet: algoritma pengesanan sasaran pertama berdasarkan kamera fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: algoritma pengesanan sasaran pertama berdasarkan kamera fisheye

Apr 26, 2024 am 11:37 AM

Pengesanan objek ialah masalah yang agak matang dalam sistem pemanduan autonomi, antaranya pengesanan pejalan kaki adalah salah satu algoritma terawal untuk digunakan. Penyelidikan yang sangat komprehensif telah dijalankan dalam kebanyakan kertas kerja. Walau bagaimanapun, persepsi jarak menggunakan kamera fisheye untuk pandangan sekeliling agak kurang dikaji. Disebabkan herotan jejari yang besar, perwakilan kotak sempadan standard sukar dilaksanakan dalam kamera fisheye. Untuk mengurangkan perihalan di atas, kami meneroka kotak sempadan lanjutan, elips dan reka bentuk poligon am ke dalam perwakilan kutub/sudut dan mentakrifkan metrik mIOU pembahagian contoh untuk menganalisis perwakilan ini. Model fisheyeDetNet yang dicadangkan dengan bentuk poligon mengatasi model lain dan pada masa yang sama mencapai 49.5% mAP pada set data kamera fisheye Valeo untuk pemanduan autonomi

Satu kad menjalankan Llama 70B lebih pantas daripada dua kad, Microsoft hanya meletakkan FP6 ke dalam A100 |

Apr 29, 2024 pm 04:55 PM

Satu kad menjalankan Llama 70B lebih pantas daripada dua kad, Microsoft hanya meletakkan FP6 ke dalam A100 |

Apr 29, 2024 pm 04:55 PM

FP8 dan ketepatan pengiraan titik terapung yang lebih rendah bukan lagi "paten" H100! Lao Huang mahu semua orang menggunakan INT8/INT4, dan pasukan Microsoft DeepSpeed memaksa diri mereka menjalankan FP6 pada A100 tanpa sokongan rasmi daripada Nvidia. Keputusan ujian menunjukkan bahawa kaedah baharu TC-FPx FP6 kuantisasi pada A100 adalah hampir atau kadangkala lebih pantas daripada INT4, dan mempunyai ketepatan yang lebih tinggi daripada yang terakhir. Selain itu, terdapat juga sokongan model besar hujung ke hujung, yang telah bersumberkan terbuka dan disepadukan ke dalam rangka kerja inferens pembelajaran mendalam seperti DeepSpeed. Keputusan ini juga mempunyai kesan serta-merta pada mempercepatkan model besar - di bawah rangka kerja ini, menggunakan satu kad untuk menjalankan Llama, daya pemprosesan adalah 2.65 kali lebih tinggi daripada dua kad. satu

Yang terbaru dari Universiti Oxford! Mickey: Padanan imej 2D dalam SOTA 3D! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Yang terbaru dari Universiti Oxford! Mickey: Padanan imej 2D dalam SOTA 3D! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Pautan projek ditulis di hadapan: https://nianticlabs.github.io/mickey/ Memandangkan dua gambar, pose kamera di antara mereka boleh dianggarkan dengan mewujudkan kesesuaian antara gambar. Biasanya, surat-menyurat ini adalah 2D hingga 2D, dan anggaran pose kami adalah skala-tak tentu. Sesetengah aplikasi, seperti realiti tambahan segera pada bila-bila masa, di mana-mana sahaja, memerlukan anggaran pose metrik skala, jadi mereka bergantung pada penganggar kedalaman luaran untuk memulihkan skala. Makalah ini mencadangkan MicKey, proses pemadanan titik utama yang mampu meramalkan korespondensi metrik dalam ruang kamera 3D. Dengan mempelajari padanan koordinat 3D merentas imej, kami dapat membuat kesimpulan relatif metrik