Peranti teknologi

Peranti teknologi

AI

AI

Mengapakah semua replikasi GPT-3 gagal? Perkara yang perlu anda ketahui tentang menggunakan ChatGPT

Mengapakah semua replikasi GPT-3 gagal? Perkara yang perlu anda ketahui tentang menggunakan ChatGPT

Mengapakah semua replikasi GPT-3 gagal? Perkara yang perlu anda ketahui tentang menggunakan ChatGPT

Tweet ini ditulis pada 12 Februari 2023. Ia adalah pendapat peribadi saya dan untuk rujukan sahaja.

Mengapakah semua replikasi awam GPT-3 gagal? Untuk tugas manakah kita harus menggunakan GPT-3.5 atau ChatGPT?

Tweet ini akan menyertakan ringkasan saya selepas meneliti semula dengan teliti butiran siri artikel, serta respons peribadi saya terhadap dua soalan yang difikirkan di atas. Artikel ini termasuk tetapi tidak terhad kepada: GPT-3, PaLM, BLOOM, OPT, FLAN-T5/PaLM, HELM, dsb. Jika anda mempunyai bahan rujukan yang lebih dipercayai atau pengalaman yang lebih praktikal, sila betulkan saya.

Bagi mereka yang ingin menghasilkan semula GPT-3 atau ChatGPT mereka sendiri, soalan pertama adalah kritikal. Soalan kedua adalah penting bagi mereka yang ingin menggunakannya (apabila GPT-3 disebut di bawah, ia merujuk terutamanya kepada versi terkini GPT-3.5 atau InstructGPT, kecuali untuk beberapa kes yang menunjuk kepada teks GPT-3 asal).

Mengapakah semua replikasi awam GPT-3 gagal?

Di sini, saya memanggilnya "kegagalan", yang bermaksud bahawa model terlatih mempunyai nombor parameter yang hampir dengan GPT-3 atau lebih besar, tetapi masih tidak dapat menyamai prestasi yang dilaporkan dalam literatur GPT-3 asal . Mengikut kriteria ini, GPT-3 dan PaLM adalah "berjaya", tetapi kedua-dua model tidak didedahkan. Dan semua model awam (contohnya: OPT-175B dan BLOOM-176B) telah "gagal" sedikit sebanyak. Tetapi kita masih boleh belajar beberapa pengajaran daripada "kegagalan" ini.

Kita perlu ambil perhatian bahawa jika kita boleh mencuba pelbagai tetapan latihan beberapa kali, komuniti sumber terbuka akhirnya mungkin dapat menghasilkan semula GPT-3. Tetapi setakat ini, kos latihan versi lain OPT-175B masih terlalu tinggi - untuk model berskala besar sedemikian, latihan memerlukan sekurang-kurangnya 2 bulan pada kira-kira 1000 80G A100 GPU (data daripada literatur asal OPT).

Walaupun sesetengah artikel (seperti OPT-175B dan GLM-130B) mendakwa bahawa ia boleh memadankan atau bahkan melebihi prestasi GPT-3 asal pada beberapa tugas, lebih banyak GPT-3 mempunyai Pada tugasan yang diuji, tuntutan ini masih boleh dipersoalkan. Pada masa yang sama, berdasarkan pengalaman kebanyakan pengguna mengenai tugas yang lebih pelbagai dan penilaian HELM, prestasi OpenAI GPT-3 API baru-baru ini masih lebih baik daripada model sumber terbuka ini.

Walaupun model di belakangnya mungkin menggunakan penalaan arahan (sama seperti InstructGPT), arahan serupa menggunakan versi OPT (OPT-IML) dan versi BLOOM (BLOOMZ) ) masih lebih teruk daripada InstructGPT dan FLAN-PaLM (versi PaLM yang diperhalusi).

Menurut butiran artikel, terdapat pelbagai sebab yang mungkin untuk kegagalan OPT-175B dan BLOOM-176B berbanding kejayaan GPT-3 dan PaLM. Saya membahagikannya kepada dua bahagian: data pra-latihan dan strategi latihan.

Data pralatihan

Mari kita perhatikan dahulu cara GPT-3 menyediakan dan menggunakan data pralatihan. GPT-3 dilatih pada sejumlah 300B token, 60% daripadanya datang daripada Common Crawl yang ditapis, dan yang lain datang daripada: webtext2 (korpus yang digunakan untuk melatih GPT-2), Books1, Books2 dan Wikipedia.

Versi GPT-3 yang dikemas kini juga menggunakan set data kod untuk latihan (seperti Kod Github). Perkadaran setiap bahagian tidak berkadar dengan saiz set data asal sebaliknya, set data dengan kualiti yang lebih tinggi diambil dengan lebih kerap. Apa yang menyebabkan kegagalan OPT-175B dan BLOOM-176B mungkin disebabkan oleh tiga kesukaran berikut, yang menyukarkan komuniti sumber terbuka untuk mengumpul data yang serupa:

1 ialah pengelas Prestasi yang baik untuk menapis data berkualiti rendah . Ia digunakan untuk membina set data pra-latihan GPT-3 dan PaLM, tetapi tidak digunakan dalam latihan OPT dan BLOOM. Sesetengah artikel telah menunjukkan bahawa model pra-latihan yang dilatih dengan set data yang lebih sedikit tetapi berkualiti tinggi boleh mengatasi model lain yang dilatih dengan set data kualiti campuran yang lebih banyak. Sudah tentu, kepelbagaian data masih sangat penting, seperti yang akan kita bincangkan dalam perkara 3. Oleh itu, seseorang harus mengendalikan pertukaran antara kepelbagaian dan kualiti data dengan berhati-hati.

2. Perkara kedua ialah deduplikasi set data pra-latihan . Penyahduplikasian membantu menghalang model yang telah dilatih daripada menghafal atau terlampau padat pada data yang sama selepas berhadapan dengannya beberapa kali, sekali gus membantu meningkatkan keupayaan generalisasi model. GPT-3 dan PaLM menerima pakai penduaan peringkat dokumen, yang juga diterima pakai oleh OPT. Walau bagaimanapun, masih terdapat banyak pengulangan dalam korpus deduplikasi pra-latihan OPT, yang mungkin juga membawa kepada prestasi yang lebih buruk (Nota: Beberapa literatur terkini menunjukkan bahawa kepentingan penyahduplikasian untuk model bahasa pra-latihan mungkin tidak sehebat yang dibayangkan. .

3 Perkara ketiga ialah kepelbagaian set data pra-latihan, termasuk kepelbagaian domain dan kepelbagaian format (contohnya: teks , kod dan jadual) dan kepelbagaian bahasa. Korpus Pile yang digunakan oleh OPT-175B mendakwa mempunyai kepelbagaian yang lebih baik, tetapi korpus ROOTS yang digunakan oleh BLOOM mempunyai terlalu banyak set data akademik sedia ada dan tidak mempunyai kepelbagaian yang terkandung dalam data Common Crawl. Ini boleh mengakibatkan prestasi BLOOM lebih teruk. Sebagai perbandingan, perkadaran GPT3 daripada korpus Common Crawl adalah lebih tinggi, dan ia adalah pelbagai dan datang dari pelbagai medan Ini juga mungkin salah satu sebab mengapa GPT-3 boleh digunakan sebagai model asas chatbot umum pertama ChatGPT.

Sila ambil perhatian: Walaupun secara amnya, data yang pelbagai adalah penting untuk melatih LLM umum (Model Bahasa Besar, model bahasa berskala besar), data pra-latihan khusus Pengedaran akan mempunyai jumlah yang besar. kesan ke atas prestasi LLM pada tugas hiliran tertentu. Sebagai contoh, BLOOM dan PaLM mempunyai bahagian data berbilang bahasa yang lebih tinggi, yang membawa kepada prestasi yang lebih tinggi pada beberapa tugas berbilang bahasa dan tugas terjemahan mesin.

OPT menggunakan banyak data perbualan (seperti reddit), yang mungkin menjadi salah satu sebab mengapa ia berfungsi dengan baik dalam perbualan. PaLM menyumbang sebahagian besar perbualan media sosial, yang mungkin menjadi sebab prestasi cemerlangnya dalam pelbagai tugasan soal jawab dan set data. Begitu juga, PaLM dan versi GPT-3 yang lebih baharu mempunyai sebahagian besar set data kod, yang meningkatkan keupayaan mereka pada tugas pengekodan dan mungkin keupayaan CoT (Chain-of-Thought) mereka.

Fenomena menarik ialah prestasi BLOOM pada kod dan CoT masih lebih teruk, walaupun ia menggunakan data kod dalam proses pra-latihan. Ini mungkin membayangkan bahawa data kod sahaja, tidak menjamin kod model dan keupayaan CoT.

Ringkasnya, beberapa artikel telah menunjukkan kepentingan tiga perkara di atas, iaitu: mengelakkan ingatan dan overfitting melalui penyahduplikasian data, mendapatkan data berkualiti tinggi melalui penapisan data, dan memastikan kepelbagaian data untuk memastikan pengitlak LLM. Malangnya, butiran tentang cara PaLM dan GPT-3 mempraproses data ini, atau data pra-latihan itu sendiri, masih tidak diterbitkan, menyukarkan komuniti awam untuk mengeluarkannya semula.

Strategi latihan

Strategi latihan di sini termasuk rangka kerja latihan, tempoh latihan, tetapan seni bina model/latihan, Pengubahsuaian semasa latihan. Ia digunakan untuk mendapatkan kestabilan dan penumpuan yang lebih baik apabila melatih model yang sangat besar. Secara umumnya, lonjakan kerugian dan kegagalan untuk menumpu diperhatikan secara meluas semasa pra-latihan kerana sebab yang tidak diketahui. Oleh itu, banyak pengubahsuaian kepada tetapan latihan dan seni bina model telah dicadangkan untuk mengelakkan masalah ini. Walau bagaimanapun, sesetengah pengubahsuaian ini bukan penyelesaian optimum dalam OPT dan BLOOM, yang mungkin membawa kepada prestasi buruknya. GPT-3 tidak menyebut secara jelas cara mereka menyelesaikan masalah ini.

Rangka kerja latihan. Model dengan lebih daripada 175B parameter selalunya memerlukan keselarian data gaya ZeRO (pengoptimum teragih) dan model selari (termasuk selari tensor, saluran paip selari dan kadangkala selari jujukan) ). OPT menggunakan pelaksanaan FSDP ZeRO, dan pelaksanaan Megatron-LM selari model. BLOOM menggunakan pelaksanaan Deepspeed ZeRO dan pelaksanaan Megatron-LM selari model.

PaLM mengguna pakai Pathways, sistem selari model berasaskan TPU dan sistem selari data. Butiran sistem latihan GPT-3 masih tidak diketahui, tetapi mereka menggunakan model paralelisme sekurang-kurangnya sedikit sebanyak (ada yang mengatakan ia menggunakan Ray). Sistem latihan dan perkakasan yang berbeza boleh membawa kepada fenomena latihan yang berbeza. Jelas sekali, beberapa tetapan yang dibentangkan dalam artikel PaLM untuk latihan TPU mungkin tidak boleh digunakan untuk latihan GPU yang digunakan oleh semua model lain.

Impak penting perkakasan dan rangka kerja latihan ialah sama ada seseorang boleh menggunakan bfloat16 untuk menyimpan berat model dan nilai pengaktifan lapisan perantaraan, dsb. Ini telah terbukti sebagai faktor penting dalam latihan yang stabil, kerana bfloat16 boleh mewakili julat nombor titik terapung yang lebih luas dan mampu mengendalikan nilai besar yang berlaku apabila lonjakan kerugian berlaku. Pada TPU bfloat16 ialah tetapan lalai, yang mungkin menjadi rahsia kejayaan PaLM. Tetapi pada GPU, orang biasa menggunakan float16, yang merupakan satu-satunya pilihan untuk latihan ketepatan campuran dalam V100.

OPT menggunakan float16, yang mungkin merupakan salah satu faktornya yang tidak stabil. BLOOM menemui masalah sedemikian dan akhirnya menggunakan bfloat16 pada A100GPU, tetapi ia tidak menyedari kepentingan tetapan ini dan oleh itu memperkenalkan penormalan lapisan tambahan selepas lapisan vektor perkataan pertama untuk menyelesaikan ketidakstabilan dalam eksperimen awal mereka menggunakan float16. Walau bagaimanapun, normalisasi lapisan ini telah terbukti membawa kepada generalisasi sifar pukulan yang lebih teruk, yang mungkin menjadi faktor kegagalan BLOOM.

2. OPT membuat banyak pelarasan pertengahan strim dan memulakan semula latihan dari pusat pemeriksaan terkini, termasuk menukar norma kecerunan klip dan kadar pembelajaran, bertukar kepada pengoptimum SGD yang mudah dan kemudian kembali kepada Adam, dan menetapkan semula skalar kerugian dinamik ), beralih kepada a versi baharu Megatron, dsb.

Pelarasan pertengahan kursus ini mungkin salah satu sebab kegagalan OPT. Sebaliknya, PaLM hampir tidak membuat pelarasan pertengahan aliran. Ia hanya memulakan semula latihan dari pusat pemeriksaan kira-kira 100 langkah sebelum lonjakan apabila lonjakan kerugian berlaku, dan melangkau kira-kira 200-500 kumpulan data. Hanya bergantung pada permulaan semula yang mudah ini, PaLM mencapai kejayaan yang menakjubkan. Ini disebabkan oleh fakta bahawa ia telah menyelesaikan pensampelan semasa pembinaan data pra-latihan, jadi model adalah deterministik dalam pengertian Bit, dan ia telah membuat banyak pengubahsuaian pada seni bina model dan tetapan latihan untuk kestabilan yang lebih baik. Pengubahsuaian sedemikian dalam PaLM ditunjukkan dalam titik seterusnya.

3. Tetapan seni bina/latihan model: Untuk menjadikan latihan lebih stabil, PaLM telah membuat beberapa pelarasan pada seni bina model dan tetapan latihan, termasuk menggunakan versi Adafactor yang diubah suai sebagai pengoptimum, menskalakan logit Output sebelum softmax, gunakan kerugian tambahan untuk menggalakkan penormal softmax hampir kepada 0, gunakan pemulaan yang berbeza untuk vektor perkataan dan pemberat lapisan lain, jangan gunakan istilah berat sebelah dalam lapisan suapan dan penormalan lapisan, dan gunakan pra-Keciciran ialah tidak digunakan semasa latihan.

Sila ambil perhatian bahawa terdapat kandungan yang lebih berharga dalam GLM-130B tentang cara melatih model yang sangat besar secara stabil, mis pengecutan kecerunan lapisan vektor perkataan. Kebanyakan pengubahsuaian model di atas tidak diterima pakai oleh OPT dan BLOOM, yang boleh menyebabkan ketidakstabilan dan kegagalannya.

4 Proses latihan: Seperti yang ditunjukkan dalam jadual di bawah, bilangan token yang dilihat dalam proses pra-latihan GPT-3 yang asal adalah hampir dengan OPT dan BLOOM, manakala PaLM jauh melebihi mereka. Begitu juga, kedua-dua korpora pra-latihan PaLM dan GPT-3 adalah lebih besar daripada BLOOM dan OPT. Oleh itu, pra-latihan mengenai lebih banyak token dan menggunakan korpus berkualiti tinggi yang lebih besar mungkin merupakan faktor penting dalam kejayaan GPT-3 dan PaLM.

Selain empat perkara yang disenaraikan di atas, terdapat beberapa faktor lain yang mungkin mempengaruhi Latihan yang lebih stabil adalah kurang kritikal, tetapi mungkin masih menjejaskan prestasi akhir.

Pertama, kedua-dua PaLM dan GPT-3 menggunakan saiz kelompok yang meningkat secara beransur-ansur dari kecil kepada besar semasa proses latihan, yang telah terbukti berkesan dalam melatih LLM yang lebih baik. namun kedua-dua OPT dan BLOOM menggunakan saiz kelompok yang tetap.

Perkara kedua, OPT menggunakan fungsi pengaktifan ReLU, manakala PaLM menggunakan fungsi pengaktifan SwiGLU, GPT-3 dan BLOOM menggunakan GeLU, yang biasanya menjadikan prestasi LLM terlatih lebih baik.

Perkara ketiga, untuk memodelkan urutan yang lebih panjang dengan lebih baik, PaLM menggunakan vektor perkataan RoPE, BLOOM menggunakan vektor perkataan ALiBi dan GPT-3 dan OPT asal menggunakan vektor perkataan yang dipelajari, yang mungkin menjejaskan prestasi pada urutan yang panjang.

Untuk tugasan manakah kita harus menggunakan GPT-3.5 atau ChatGPT?

Saya cuba menerangkan tugas dan aplikasi yang mana kita patut gunakan GPT-3 dan yang mana kita tidak patut. Untuk menunjukkan sama ada GPT-3 sesuai untuk tugas tertentu, saya terutamanya membandingkan GPT-3 dengan gesaan kepada model yang lebih kecil yang telah diperhalusi, kadangkala dengan ciri khas lain. Isu ini lebih penting memandangkan prestasi baik model FLAN-T5 yang lebih kecil dan boleh ditala halus baru-baru ini.

Dalam dunia yang ideal, jika beban penalaan halus GPT-3 mampu dimiliki, ia boleh membawa kepada penambahbaikan selanjutnya. Walau bagaimanapun, penambahbaikan yang dicapai dengan menala halus PaLM-540B pada beberapa tugas adalah sangat terhad sehingga seseorang tertanya-tanya sama ada menala halus GPT-3 pada beberapa tugas adalah berbaloi. Dari perspektif saintifik, perbandingan yang lebih adil adalah antara GPT-3 yang diperhalusi dan GPT-3 yang dikiu. Walau bagaimanapun, untuk menggunakan GPT-3, seseorang mungkin lebih berminat untuk membandingkan GPT-3 dengan memperhalusi model yang lebih kecil.

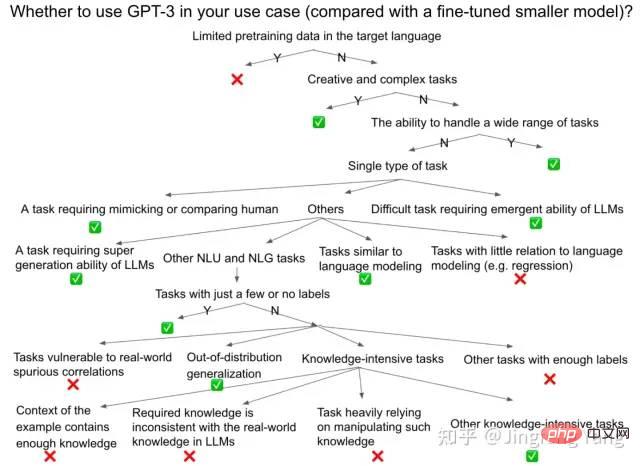

Perhatikan bahawa saya amat mementingkan ketepatan menyelesaikan tugasan sebagai ukuran, tetapi masih terdapat banyak lagi dimensi penting, seperti ketoksikan, keadilan, dll. Ia juga harus diambil dipertimbangkan semasa membuat keputusan sama ada untuk menggunakan GPT-3, seperti yang dibentangkan dalam artikel HELM. Rajah di bawah menunjukkan proses membuat keputusan yang kasar, dan diharapkan ia akan menjadi panduan praktikal yang berguna, sama ada untuk tugasan sedia ada atau tugasan baharu sepenuhnya.

Nota 1 : ChatGPT cemerlang sebagai chatbot kerana penjajarannya yang baik dalam senario perbualan. Tetapi kami biasanya menggunakan GPT-3, InstructGPT (GPT-3.5), dan Codex, model di belakang ChatGPT, sebagai model umum dalam lebih banyak tugas dan senario penggunaan.

Nota 2: Kesimpulan dalam bahagian ini adalah berdasarkan beberapa penemuan pada versi semasa model , yang mungkin tidak terpakai pada model yang lebih kukuh pada masa hadapan. Kerana, menggunakan lebih banyak data pra-latihan yang hampir dengan set data sasaran, pelarasan arahan set data akademik (seperti mencadangkan bahawa FLAN-PaLM mungkin membawa prestasi yang lebih kukuh, ia masih tidak didedahkan) atau melalui RLHF untuk menjadikan model lebih baik untuk tugas sasaran Penjajaran yang lebih baik, yang mungkin menjadikan model berprestasi lebih baik dalam tugasan sasaran, walaupun kadangkala ini mengorbankan keupayaan dalam senario lain (contohnya, "cukai Penjajaran/cukai Penjajaran" InstructGPT).

Dalam kes ini, sukar untuk menilai sama ada GPT membuat generalisasi dan generalisasi merentas tugasan, atau sama ada ia baru sahaja menghafal beberapa contoh ujian semasa pra-latihan, atau sama ada Telah melihatnya. -dipanggil tugas "ghaib" semasa pra-latihan. Walau bagaimanapun, ia masih dipersoalkan sama ada ingatan sebenarnya adalah masalah serius dalam amalan. Oleh kerana pengguna berbeza daripada penyelidik, jika mereka mendapati GPT sudah boleh menunjukkan prestasi yang baik pada data ujian mereka, mereka mungkin tidak peduli sama ada GPT melihat data yang sama atau serupa semasa pra-latihan.

Dalam apa jua keadaan, untuk memaksimumkan nilai praktikal semasa bahagian ini, saya cuba sedaya upaya untuk membandingkan dan memperhalusi model awam yang lebih kecil (T5, FALN-T5, beberapa model istimewa Prestasi terbaik model SOTA diperhalusi yang direka bentuk, dsb.) dan GPT-3 (GPT-3.5, InstructGPT), PaLM (atau FLAN-PaLM) terkini, jika data penilaian model ini tersedia.

Tugas yang sesuai untuk menggunakan GPT-3

Secara umumnya, situasi berikut lebih sesuai untuk menggunakan GPT. -3. Anehnya, jika kita melihat kembali bahagian pengenalan kertas GPT-3, banyak matlamat reka bentuk awal di sana meliputi tugas-tugas ini. Ini bermakna bahawa matlamat asalnya yang bercita-cita tinggi telah dicapai sebahagiannya.

1. Tugas kreatif dan kompleks : termasuk kod (penyelesaian kod, kod penjanaan arahan bahasa semula jadi, terjemahan kod, pembetulan pepijat ), ringkasan teks, terjemahan, penulisan kreatif (seperti menulis cerita, artikel, e-mel, laporan, dan penambahbaikan penulisan, dsb.). Seperti yang ditunjukkan dalam kesusasteraan GPT-3 asal, GPT-3 direka untuk tugasan yang sukar dan "anotasi yang mustahil". Ini adalah tugas sehingga model yang telah diperhalusi sebelum ini adalah mustahil untuk digunakan pada aplikasi dunia sebenar GPT-3 menjadikannya mungkin. Sebagai contoh, artikel terbaru menunjukkan bahawa ringkasan teks beranotasi manusia yang lalu telah diatasi oleh ringkasan yang dijana LLM.

Dengan menggesa PaLM-540B, ia juga mampu mengatasi model yang diperhalusi dalam tugas terjemahan mesin tertentu yang memerlukan terjemahan daripada bahasa sumber rendah dan sederhana ke bahasa Inggeris.

Arah aliran yang sama diperhatikan dalam BLOOM-176B. Ini kerana data bahasa Inggeris biasanya menyumbang sebahagian besar korpus pra-latihan, jadi LLM pandai menjana ayat bahasa Inggeris. Ambil perhatian bahawa untuk mendapatkan prestasi yang baik dalam tugas pengekodan, walaupun Codex dan PaLM mempunyai prestasi keseluruhan yang lebih baik daripada model sebelumnya, kami masih perlu membenarkan LLM membuat sampel beberapa kali (k kali) untuk lulus sampel ujian (menggunakan pass @k sebagai a metrik).

2. Tugasan dengan hanya beberapa data berlabel atau tidak berlabel . Seperti yang dinyatakan oleh dokumentasi GPT-3 asal, GPT-3 direka untuk tugas "anotasi mahal". Dalam kes ini, biasanya mustahil untuk memperhalusi model yang lebih kecil dengan jumlah data berlabel yang sangat kecil untuk mencapai GPT-3 dalam prestasi sifar pukulan, satu pukulan atau beberapa pukulan.

3. Memandangkan beberapa data latihan, penalaan halus tradisional mungkin melebihi set latihan dan mempunyai generalisasi luar pengedaran yang lemah manakala beberapa sampel pembelajaran dalam konteks boleh mempunyai generalisasi luar pengedaran yang lebih baik. Sebagai contoh, PaLM dengan pembayang boleh mengungguli model SOTA yang ditala halus pada tugas Inferens Bahasa Semula Jadi Adversarial (ANLI), sementara ia mungkin masih lebih rendah daripada model SOTA yang ditala halus pada tugasan inferens bahasa biasa. Contoh lain ialah petunjuk bahawa LLM menunjukkan generalisasi gabungan yang lebih baik daripada model yang diperhalusi. Generalisasi luar pengedaran yang lebih baik mungkin kerana parameter tidak perlu dikemas kini semasa pembelajaran konteks, mengelakkan pemasangan berlebihan, atau kerana contoh luar pengedaran yang lalu adalah dalam pengedaran kepada LLM. Senario penggunaan ini dijelaskan sebagai salah satu matlamat reka bentuk asal GPT-3: "Model yang diperhalusi boleh mencapai apa yang dipanggil prestasi peringkat manusia pada set data untuk tugas tertentu, yang sebenarnya boleh melebihkan prestasi pada tugas itu dalam dunia sebenar." , ini kerana model itu hanya mempelajari korelasi palsu yang wujud dalam set latihan, dan model itu mengatasi pengedaran sempit set latihan ini. ”

4 . Memerlukan kebolehan untuk mengendalikan pelbagai tugasan

daripada menumpukan pada kecemerlangan dalam tugasan tertentu. Chatbots ialah satu senario sedemikian di mana pengguna mengharapkan ia bertindak balas dengan betul kepada pelbagai tugasan. Ini mungkin sebabnya ChatGPT ialah salah satu kes penggunaan yang paling berjaya untuk GPT-3. 5

tugas berintensif pengetahuan di mana pengambilan semula tidak dapat dilaksanakan. Pengetahuan yang disimpan dalam LLM boleh meningkatkan prestasi tugas intensif pengetahuan dengan ketara, seperti menjawab soalan buku tertutup dan MMLU (set data penanda aras termasuk soalan aneka pilihan daripada 57 disiplin seperti STEM, kemanusiaan, sains sosial, dsb., yang digunakan untuk menguji pengetahuan dunia LLM dan kemahiran menyelesaikan masalah). Walau bagaimanapun, jika langkah prapendapatan boleh ditambah untuk menjana peningkatan perolehan semula, model kecil yang diperhalusi (seperti model Atlas) malah boleh mempunyai prestasi yang lebih baik (Atlas daripada PaLM pada set data NaturalQuestions dan TrivialQA volum tertutup dan). InstructGPT terkini adalah lebih baik). Pencarian semula atau carian tradisional juga merupakan langkah yang perlu untuk menyepadukan GPT-3 atau ChatGPT ke dalam enjin carian, yang boleh meningkatkan ketepatan penjanaan dan menyediakan lebih banyak pautan rujukan untuk meningkatkan daya persuasif. Tetapi kita harus mengakui bahawa terdapat beberapa kes di mana pengambilan semula tidak dibenarkan atau tidak mudah, seperti mengambil USMLE (United States Medical Licensing Examination), di mana Google telah menunjukkan bahawa model berasaskan FLAN-PaLM boleh dilakukan dengan baik. Begitu juga, dalam set penanda aras MMLU, PaLM-540B mempunyai prestasi yang lebih baik daripada model lain yang diperhalusi, malah yang kedua digabungkan dengan pengambilan semula, walaupun versi terkini InstructGPT masih lebih buruk daripada band ini Terdapat SOTA yang telah diperhalusi untuk mendapatkan semula. Perhatikan juga bahawa penalaan perintah model yang lebih kecil boleh mencapai hasil yang hampir dengan model LLM yang lebih besar, seperti yang ditunjukkan dalam FLAN-T5. 6 Sesetengah tugasan sukar yang memerlukan keupayaan LLM yang muncul , seperti menaakul dengan tugasan CoT dan BIG-Bench Complex (termasuk penaakulan logik, terjemahan, soal jawab, tugasan matematik, dsb.). Sebagai contoh, PaLM telah menunjukkan bahawa pada 7 tugasan penaakulan pelbagai langkah termasuk penaakulan matematik dan akal, 8 sampel CoT adalah lebih baik daripada SOTA yang diperhalusi pada 4 tugasan dan pada asasnya adalah sama pada 3 tugasan yang lain. . Prestasi yang berjaya sedemikian boleh dikaitkan dengan kedua-dua model yang lebih besar dan CoT. PaLM juga menunjukkan peningkatan prestasi diskret pada tugas BIG-Bench daripada model 8B hingga 62B hingga 540B, yang melebihi undang-undang penskalaan, yang dikenali sebagai kuasa kemunculan LLM. Selain itu, PaLM-540B dengan 5 gesaan mengatasi prestasi SOTA (sedikit sampel) sebelumnya pada 44 daripada 58 tugasan biasa di Big-Bench. Prestasi keseluruhan PaLM-540B pada Big-Bench juga lebih baik daripada prestasi manusia biasa. 7. Beberapa adegan yang perlu meniru manusia , atau matlamatnya adalah untuk menghasilkan persembahan yang sampai kepada manusia tahap Kecerdasan Buatan Am . Begitu juga, ChatGPT adalah salah satu kes di mana ChatGPT mencapai kejayaan yang luar biasa dengan menjadikan dirinya lebih seperti manusia. Ini juga dijelaskan sebagai salah satu matlamat reka bentuk asal GPT-3: "Manusia tidak memerlukan set data penyeliaan berskala besar untuk mempelajari kebanyakan tugas bahasa. Dengan hanya beberapa contoh paling banyak, manusia boleh menyepadukan pelbagai tugas dan teknik Blend dengan lancar. bersama-sama atau bertukar-tukar antara model tradisional yang ditala dengan itu membawa kepada perbandingan yang tidak adil dengan manusia, walaupun mereka mendakwa prestasi peringkat manusia pada banyak set data penanda aras Tugas lain tidak memerlukan menggesa model saiz GPT-3: Tidak sesuai untuk digunakan Tugasan GPT -3 1. Memanggil API OpenAI GPT-3 melebihi bajet (contohnya, untuk permulaan tanpa banyak wang). 3. Tiada sumber kejuruteraan atau perkakasan yang mencukupi untuk menggunakan model yang sama saiz dan menghapuskan masalah kelewatan inferens. Contohnya, tanpa 80G A100 atau sumber kejuruteraan yang canggih untuk mengoptimumkan kelajuan inferens, hanya menggunakan Alpa untuk menggunakan OPT-175B pada 16 40G A100 akan mengambil masa 10 saat untuk menyelesaikan inferens satu sampel, yang tidak boleh dilaksanakan untuk aplikasi berskala besar Ini adalah kependaman yang tidak boleh diterima untuk kebanyakan aplikasi dalam talian dunia sebenar. 4 Jika anda ingin menggunakan GPT-3 untuk menggantikan model yang diperhalusi dengan prestasi yang baik dan ketepatan yang tinggi, atau anda ingin menggunakan NLU dalam beberapa tugasan dan penggunaan tunggal tertentu. model senario ( Natural Language Understanding) atau NLG (Natural Language Generating), sila fikir dua kali sama ada ia berbaloi. Untuk meringkaskan, tugasan di atas boleh dikelaskan kepada salah satu daripada kategori berikut: 1 >Sesetengah tugas NLU tidak memerlukan pengetahuan tambahan mahupun keupayaan penjanaan LLM. Ini bermakna bahawa data ujian kebanyakannya dalam pengedaran yang sama dengan data latihan yang ada. Mengenai tugasan ini, model yang lebih kecil yang diperhalusi pada masa lalu telah menunjukkan prestasi yang baik. Sesetengah tugasan yang tidak memerlukan pengetahuan tambahan daripada LLM , Kerana setiap contoh sudah mengandungi pengetahuan yang mencukupi dalam konteks atau gesaan, seperti pemahaman bacaan mesin. 3. Sesetengahnya memerlukan pengetahuan tambahan tetapi tidak mungkin diperoleh daripada LLM , atau Tidak mungkin bahawa LLM pernah melihat tugasan dengan pengedaran serupa , seperti tugasan dalam beberapa bahasa sumber rendah dimana LLM mempunyai sampel pra-latihan yang terhad. 4. Sesetengah tugas memerlukan pengetahuan yang tidak konsisten dengan pengetahuan yang terkandung dalam LLM, atau pengetahuan yang tidak berdasarkan data bahasa dunia sebenar . Oleh kerana LLM dilatih mengenai data bahasa dunia sebenar, adalah sukar untuknya menggunakan pengetahuan kontrafaktual untuk merangkumi pengetahuan asal dalam tugasan baharu. Selain masalah "takrif semula notasi matematik" dalam cabaran undang-undang skala songsang, terdapat tugas lain, menceritakan semula petikan yang diubah sedikit, di mana LLM diminta untuk menceritakan semula petikan yang diubah suai yang muncul dalam gesaan. Dalam kes ini, LLM cenderung untuk mengulang versi asal petikan dan bukannya versi yang diubah suai. 5. Sesetengah tugasan memerlukan pengetahuan daripada LM, tetapi juga sangat bergantung pada memanipulasi pengetahuan ini , manakala matlamat LLM "meramalkan token seterusnya" tidak boleh dengan mudah mencapai manipulasi seperti ini. Contohnya ialah beberapa tugas penaakulan akal. Sebab mengapa CoT dan petunjuk paling sedikit boleh membantu inferens LLM mungkin kerana mereka boleh memanggil teks pra-latihan berterusan dengan lebih baik yang meniru proses merancang dan mengurai/menggabungkan pengetahuan. Oleh itu, CoT dan gesaan paling sedikit berprestasi baik dalam beberapa penaakulan matematik, kod dan tugas penaakulan bahasa semula jadi yang mudah, tetapi gagal dalam banyak penaakulan akal (mis. dalam skala songsang Masih berprestasi buruk pada tugas penaakulan deduktif yang ditunjukkan dalam pertandingan undang-undang) dan tugas penaakulan simbolik tersuai. Tugasan ini biasanya tidak diliputi oleh jujukan berterusan dunia yang paling nyata dalam data bahasa semula jadi, tetapi memerlukan manipulasi pengetahuan bertaburan untuk diselesaikan. 6 Sesetengah tugasan yang terdedah kepada korelasi palsu dalam contoh pembelajaran kontekstual atau data dunia sebenar. Satu contoh ialah soal jawab yang melibatkan perkataan negatif daripada pertandingan Undang-undang Songsang Skala. Jika LLM ditanya: "Jika suhu badan kucing lebih rendah daripada purata, ia tidak berada dalam...", ia akan cenderung menjawab "berisiko" dan bukannya "julat selamat". Ini kerana LLM didominasi oleh hubungan biasa antara "suhu badan di bawah purata" dan "bahaya", yang dalam kes negatif adalah korelasi palsu. 7 Sesetengah tugasan yang matlamatnya berbeza dengan ketara daripada memproses data bahasa , seperti masalah regresi, di mana model penalaan halus adalah sukar. untuk digantikan oleh LLM. Bagi tugas berbilang modal, ia tidak boleh diselesaikan oleh LLM, tetapi mungkin mendapat manfaat daripada model berbilang modal terlatih berskala besar. 8 Sesetengah tugasan tidak memerlukan keupayaan LLM yang muncul . Untuk mendiskriminasi lebih banyak tugas ini dengan tepat, kita perlu memahami dengan lebih baik di mana keupayaan yang timbul semasa latihan LLM. Perhatikan bahawa dalam senario penggunaan dunia sebenar, walaupun LLM tidak boleh digunakan dalam talian kerana ketidakupayaan untuk memenuhi keperluan kependaman, LLM masih boleh digunakan untuk menjana atau melabel data di luar talian. Label beranotasi automatik sedemikian boleh didapati dalam talian dan diberikan kepada pengguna, atau digunakan untuk memperhalusi model yang lebih kecil. Menggunakan data sedemikian untuk memperhalusi model yang lebih kecil mengurangkan data beranotasi manual yang diperlukan untuk melatih model dan menyuntik beberapa keupayaan muncul LLM (seperti CoT) ke dalam model yang lebih kecil. Ringkasnya, memandangkan prestasi luar biasa sumber terbuka FLAN-T5 dalam banyak tugas apabila terdapat data berlabel yang mencukupi, saya mengesyorkan agar individu yang mempunyai sumber terhad yang memanggil OpenAI API harus Cuba dengan baik. -menala FLAN-T5-11B pada tugas sasaran. Tambahan pula, berdasarkan prestasi terkini FLAN-PaLM-540B pada set data MMLU, yang sangat baik berbanding prestasi versi terkini InstructGPT (mengikut HELM), Google mungkin mempunyai model asas yang lebih berkuasa daripada OpenAI, jika OpenAI telah melepasi API Mengeluarkan LLM terkuat yang pernah mereka perolehi. Satu-satunya langkah yang tinggal untuk Google ialah menjajarkan LLM ini dengan senario perbualan melalui maklum balas manusia. Saya tidak akan terkejut jika mereka mengeluarkan chatbot seperti ChatGPT atau lebih baik tidak lama lagi - walaupun "kegagalan" mereka baru-baru ini untuk menunjukkan versi Bard yang mungkin berdasarkan LaMDA. Mengenai pengarang Pengarang Inggeris asal: Yang Jingfeng, saintis Amazon semasa, lulus dari Universiti Peking dengan ijazah sarjana muda dan ijazah sarjana Institut Teknologi Georgia, di bawah bimbingan Profesor Stanford Yang Diyi. Diterjemah oleh Yang Haotong, disemak oleh Wang Xiao. Terima kasih kepada Jin Hongye atas cadangannya pada versi pertama manuskrip, dan kepada Chen Sanxing dan Fu Yao atas perbincangan dan cadangan mereka. Versi asal bahasa Inggeris: https://jingfengyang.github.io/gpt Teks asal Tolak Khas: https://twitter.com/JingfengY/status/1625003999387881472

Atas ialah kandungan terperinci Mengapakah semua replikasi GPT-3 gagal? Perkara yang perlu anda ketahui tentang menggunakan ChatGPT. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1386

1386

52

52

Cara Memeriksa Konfigurasi HDFS CentOS

Apr 14, 2025 pm 07:21 PM

Cara Memeriksa Konfigurasi HDFS CentOS

Apr 14, 2025 pm 07:21 PM

Panduan Lengkap untuk Memeriksa Konfigurasi HDFS Dalam Sistem CentOS Artikel ini akan membimbing anda bagaimana untuk memeriksa konfigurasi dan menjalankan status HDFS secara berkesan pada sistem CentOS. Langkah -langkah berikut akan membantu anda memahami sepenuhnya persediaan dan operasi HDFS. Sahkan Pembolehubah Alam Sekitar Hadoop: Pertama, pastikan pembolehubah persekitaran Hadoop ditetapkan dengan betul. Di terminal, laksanakan arahan berikut untuk mengesahkan bahawa Hadoop dipasang dan dikonfigurasi dengan betul: Hadoopversion Semak fail konfigurasi HDFS: Fail konfigurasi teras HDFS terletak di/etc/hadoop/conf/direktori, di mana core-site.xml dan hdfs-site.xml adalah kritikal. gunakan

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Perintah shutdown CentOS adalah penutupan, dan sintaks adalah tutup [pilihan] [maklumat]. Pilihan termasuk: -h menghentikan sistem dengan segera; -P mematikan kuasa selepas penutupan; -r mulakan semula; -T Waktu Menunggu. Masa boleh ditentukan sebagai segera (sekarang), minit (minit), atau masa tertentu (HH: mm). Maklumat tambahan boleh dipaparkan dalam mesej sistem.

Apakah kaedah sandaran untuk gitlab di centos

Apr 14, 2025 pm 05:33 PM

Apakah kaedah sandaran untuk gitlab di centos

Apr 14, 2025 pm 05:33 PM

Dasar sandaran dan pemulihan Gitlab di bawah sistem CentOS untuk memastikan keselamatan data dan pemulihan, Gitlab pada CentOS menyediakan pelbagai kaedah sandaran. Artikel ini akan memperkenalkan beberapa kaedah sandaran biasa, parameter konfigurasi dan proses pemulihan secara terperinci untuk membantu anda menubuhkan strategi sandaran dan pemulihan GitLab lengkap. 1. Backup Manual Gunakan Gitlab-Rakegitlab: Backup: Buat Perintah untuk Melaksanakan Backup Manual. Perintah ini menyokong maklumat utama seperti repositori Gitlab, pangkalan data, pengguna, kumpulan pengguna, kunci, dan kebenaran. Fail sandaran lalai disimpan dalam direktori/var/opt/gitlab/sandaran. Anda boleh mengubah suai /etc /gitlab

CentOS memasang MySQL

Apr 14, 2025 pm 08:09 PM

CentOS memasang MySQL

Apr 14, 2025 pm 08:09 PM

Memasang MySQL pada CentOS melibatkan langkah -langkah berikut: Menambah sumber MySQL YUM yang sesuai. Jalankan YUM Pasang Perintah MySQL-Server untuk memasang pelayan MySQL. Gunakan perintah mysql_secure_installation untuk membuat tetapan keselamatan, seperti menetapkan kata laluan pengguna root. Sesuaikan fail konfigurasi MySQL seperti yang diperlukan. Tune parameter MySQL dan mengoptimumkan pangkalan data untuk prestasi.

Cara Melihat Log Gitlab Di Bawah Centos

Apr 14, 2025 pm 06:18 PM

Cara Melihat Log Gitlab Di Bawah Centos

Apr 14, 2025 pm 06:18 PM

Panduan Lengkap untuk Melihat Log Gitlab Di bawah Sistem CentOS Artikel ini akan membimbing anda bagaimana untuk melihat pelbagai log Gitlab dalam sistem CentOS, termasuk log utama, log pengecualian, dan log lain yang berkaitan. Sila ambil perhatian bahawa laluan fail log mungkin berbeza -beza bergantung pada versi GitLab dan kaedah pemasangan. Jika laluan berikut tidak wujud, sila semak fail Direktori Pemasangan dan Konfigurasi GitLab. 1. Lihat log Gitlab utama Gunakan arahan berikut untuk melihat fail log utama aplikasi GitLabRails: Perintah: Sudocat/var/Log/Gitlab/Gitlab-Rails/Production.log Perintah ini akan memaparkan produk

Cara Mengendalikan Latihan Pittorch Diagihkan di Centos

Apr 14, 2025 pm 06:36 PM

Cara Mengendalikan Latihan Pittorch Diagihkan di Centos

Apr 14, 2025 pm 06:36 PM

Latihan yang diedarkan Pytorch pada sistem CentOS memerlukan langkah -langkah berikut: Pemasangan Pytorch: Premisnya ialah Python dan PIP dipasang dalam sistem CentOS. Bergantung pada versi CUDA anda, dapatkan arahan pemasangan yang sesuai dari laman web rasmi Pytorch. Untuk latihan CPU sahaja, anda boleh menggunakan arahan berikut: PipinstallToRchTorchVisionTorchaudio Jika anda memerlukan sokongan GPU, pastikan versi CUDA dan CUDNN yang sama dipasang dan gunakan versi pytorch yang sepadan untuk pemasangan. Konfigurasi Alam Sekitar Teragih: Latihan yang diedarkan biasanya memerlukan pelbagai mesin atau mesin berbilang mesin tunggal. Tempat

Penjelasan terperinci mengenai Prinsip Docker

Apr 14, 2025 pm 11:57 PM

Penjelasan terperinci mengenai Prinsip Docker

Apr 14, 2025 pm 11:57 PM

Docker menggunakan ciri -ciri kernel Linux untuk menyediakan persekitaran berjalan yang cekap dan terpencil. Prinsip kerjanya adalah seperti berikut: 1. Cermin digunakan sebagai templat baca sahaja, yang mengandungi semua yang anda perlukan untuk menjalankan aplikasi; 2. Sistem Fail Kesatuan (Unionfs) menyusun pelbagai sistem fail, hanya menyimpan perbezaan, menjimatkan ruang dan mempercepatkan; 3. Daemon menguruskan cermin dan bekas, dan pelanggan menggunakannya untuk interaksi; 4. Ruang nama dan cgroups melaksanakan pengasingan kontena dan batasan sumber; 5. Pelbagai mod rangkaian menyokong interkoneksi kontena. Hanya dengan memahami konsep -konsep teras ini, anda boleh menggunakan Docker dengan lebih baik.

Bagaimana sokongan GPU untuk Pytorch di CentOS

Apr 14, 2025 pm 06:48 PM

Bagaimana sokongan GPU untuk Pytorch di CentOS

Apr 14, 2025 pm 06:48 PM

Membolehkan pecutan GPU pytorch pada sistem CentOS memerlukan pemasangan cuda, cudnn dan GPU versi pytorch. Langkah-langkah berikut akan membimbing anda melalui proses: Pemasangan CUDA dan CUDNN Tentukan keserasian versi CUDA: Gunakan perintah NVIDIA-SMI untuk melihat versi CUDA yang disokong oleh kad grafik NVIDIA anda. Sebagai contoh, kad grafik MX450 anda boleh menyokong CUDA11.1 atau lebih tinggi. Muat turun dan pasang Cudatoolkit: Lawati laman web rasmi Nvidiacudatoolkit dan muat turun dan pasang versi yang sepadan mengikut versi CUDA tertinggi yang disokong oleh kad grafik anda. Pasang Perpustakaan Cudnn: