Peranti teknologi

Peranti teknologi

AI

AI

Princeton Chen Danqi: Bagaimana untuk menjadikan 'model besar' lebih kecil

Princeton Chen Danqi: Bagaimana untuk menjadikan 'model besar' lebih kecil

Princeton Chen Danqi: Bagaimana untuk menjadikan 'model besar' lebih kecil

“Menjadikan model besar lebih kecil”Ini adalah usaha akademik ramai penyelidik model bahasa memandangkan persekitaran yang mahal dan kos latihan model besar, Chen Danqi bercakap di Persidangan Zhiyuan Laporan khas bertajuk "Membuat model besar lebih kecil" telah diberikan pada Mesyuarat Tahunan Akademik Qingyuan. Laporan itu memfokuskan pada algoritma TRIME berdasarkan peningkatan memori dan algoritma CofiPruning berdasarkan pemangkasan sendi berbutir kasar dan halus serta penyulingan lapisan demi lapisan. Yang pertama boleh mengambil kira kelebihan kebingungan model bahasa dan kelajuan pengambilan tanpa mengubah struktur model manakala yang kedua boleh mencapai kelajuan pemprosesan yang lebih cepat dan mempunyai struktur model yang lebih kecil sambil memastikan ketepatan tugas hiliran.

Chen Danqi Penolong Profesor, Jabatan Sains Komputer, Princeton University

Chen Danqi pada 2012 Beliau lulus dari Kelas Yao Universiti Tsinghua pada 2018 dan menerima PhD dalam sains komputer dari Universiti Stanford pada 2018. Beliau belajar di bawah Christopher Manning, profesor linguistik dan sains komputer di Universiti Stanford.

1 Pengenalan latar belakang

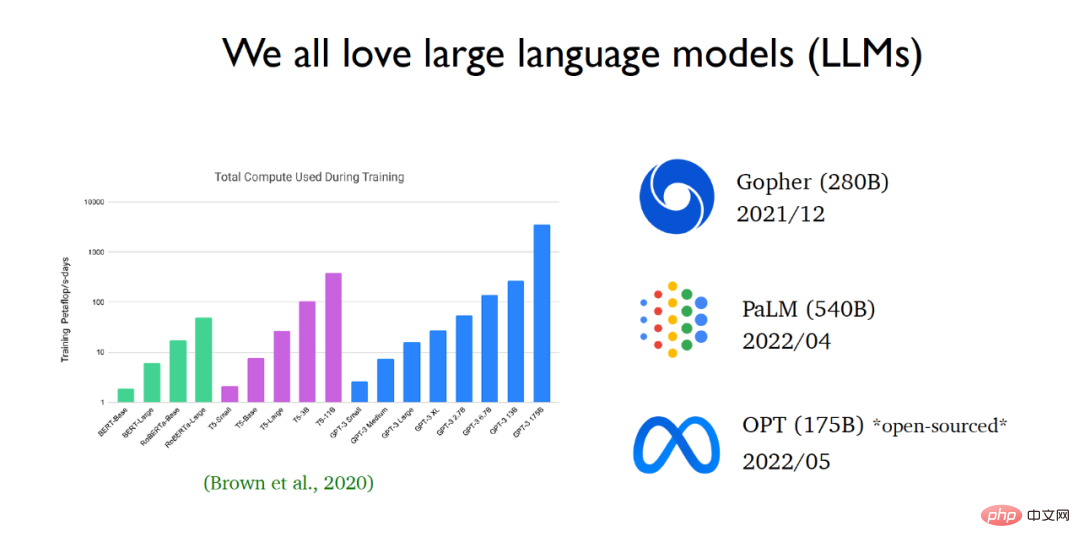

Dalam beberapa tahun kebelakangan ini, bidang pemprosesan bahasa semula jadi sedang pesat dikuasai oleh model bahasa yang besar. Sejak kemunculan GPT 3, saiz model bahasa telah berkembang dengan pesat. Syarikat teknologi besar terus mengeluarkan model bahasa yang lebih besar dan lebih besar. Baru-baru ini, Meta AI mengeluarkan model bahasa OPT (model bahasa besar yang mengandungi 175 bilion parameter) dan membuka kod sumber dan parameter model kepada orang ramai.

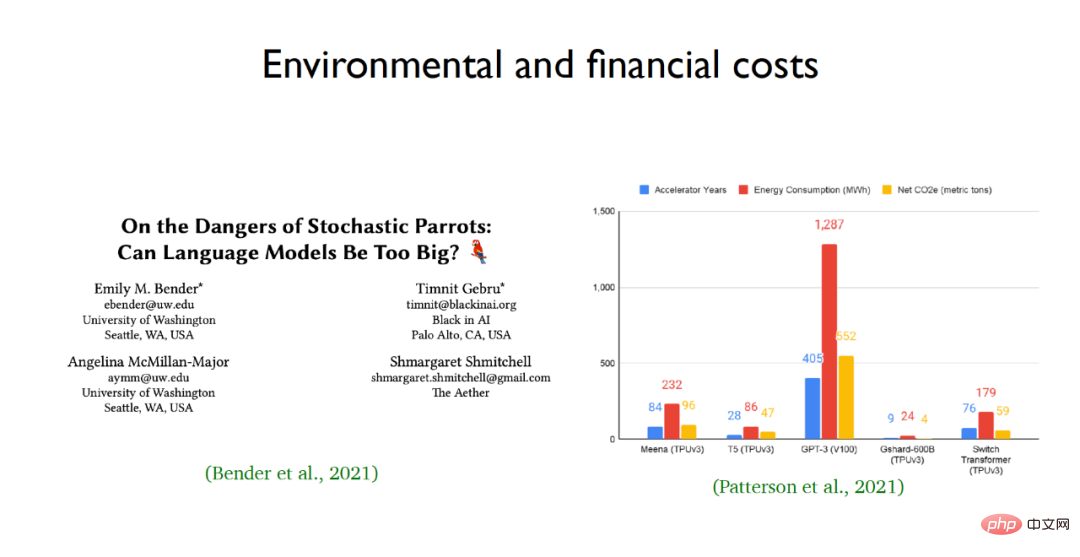

Sebab penyelidik sangat mengagumi model bahasa besar adalah kerana keupayaan dan prestasi pembelajaran mereka yang sangat baik Namun, orang ramai mempunyai sedikit keraguan tentang bahasa besar model. Sifat kotak hitam masih kurang difahami. Memasukkan soalan ke dalam model bahasa dan menaakul langkah demi langkah melalui model bahasa boleh menyelesaikan masalah penaakulan yang sangat kompleks, seperti mendapatkan jawapan kepada masalah pengiraan. Tetapi pada masa yang sama, terdapat risiko dengan model bahasa berskala besar, terutamanya kos alam sekitar dan ekonomi mereka Sebagai contoh, penggunaan tenaga dan pelepasan karbon model bahasa berskala besar seperti GPT-3 adalah mengejutkan.  Menghadapi masalah seperti kos latihan yang mahal dan sejumlah besar parameter untuk model bahasa yang besar, pasukan Chen Dan berharap dapat mengurangkan jumlah pengiraan model pra-latihan melalui penyelidikan akademik dan menjadikan model bahasa lebih cekap untuk aplikasi peringkat rendah. Untuk tujuan ini, dua kerja pasukan diserlahkan Satu ialah kaedah latihan baharu untuk model bahasa yang dipanggil TRIME, dan satu lagi ialah kaedah pemangkasan model yang berkesan yang sesuai untuk tugas hiliran yang dipanggil CofiPruning.

Menghadapi masalah seperti kos latihan yang mahal dan sejumlah besar parameter untuk model bahasa yang besar, pasukan Chen Dan berharap dapat mengurangkan jumlah pengiraan model pra-latihan melalui penyelidikan akademik dan menjadikan model bahasa lebih cekap untuk aplikasi peringkat rendah. Untuk tujuan ini, dua kerja pasukan diserlahkan Satu ialah kaedah latihan baharu untuk model bahasa yang dipanggil TRIME, dan satu lagi ialah kaedah pemangkasan model yang berkesan yang sesuai untuk tugas hiliran yang dipanggil CofiPruning.

2 Pengenalan kepada kerja berpasukan: TRIME, CofiPruning

Alamat kertas: https: //arxiv.org/abs/2205.12674

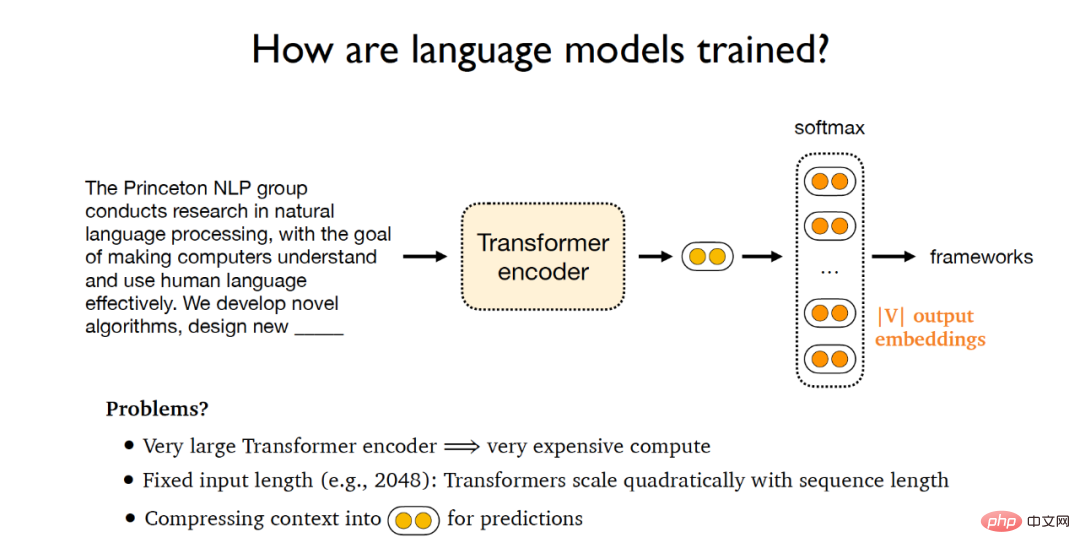

Proses latihan model bahasa tradisional adalah seperti berikut: diberikan dokumen, masukkannya ke dalam pengekod Transformer untuk mendapatkan laten vektor, dan kemudian Vektor terpendam ini disalurkan ke lapisan softmax, yang mengeluarkan matriks yang terdiri daripada vektor benam perkataan V, di mana V mewakili saiz perbendaharaan kata Akhirnya, vektor output ini boleh digunakan untuk meramalkan teks asal dan membandingkannya dengan piawaian dokumen yang diberikan Jawapan dibandingkan untuk mengira kecerunan dan melaksanakan perambatan belakang kecerunan. Walau bagaimanapun, paradigma latihan sedemikian akan membawa masalah berikut: (1) Pengekod Transformer yang besar akan membawa kos latihan yang tinggi; (2) Panjang input model bahasa adalah tetap, dan jumlah pengiraan Transformer akan meningkat dengan tepat dengan; perubahan panjang urutan pertumbuhan, jadi sukar bagi Transformer untuk mengendalikan teks panjang; kesesakan model bahasa.

Untuk tujuan ini, pasukan Chen Danqi mencadangkan paradigma latihan baharu - TRIME, yang kebanyakannya menggunakan memori kelompok untuk latihan, dan berdasarkan ini, ia mencadangkan tiga berkongsi matlamat latihan yang sama. model fungsi ialah TrimeLM, TrimeLMlong dan TrimeLMext. TrimeLM boleh dilihat sebagai alternatif kepada model bahasa standard TrimeLMlong direka untuk teks jarak jauh, serupa dengan Transformer-XL menggabungkan storan data yang besar, serupa dengan kNN-LM. Di bawah paradigma latihan yang dinyatakan di atas, TRIME mula-mula mentakrifkan teks input sebagai  , dan kemudian menghantar input kepada pengekod Transformer

, dan kemudian menghantar input kepada pengekod Transformer  untuk mendapatkan vektor tersembunyi

untuk mendapatkan vektor tersembunyi  , selepas melepasi lapisan softmax

, selepas melepasi lapisan softmax  , perkataan seterusnya yang perlu diramalkan diperolehi

, perkataan seterusnya yang perlu diramalkan diperolehi  Parameter yang boleh dilatih dalam keseluruhan paradigma latihan ialah

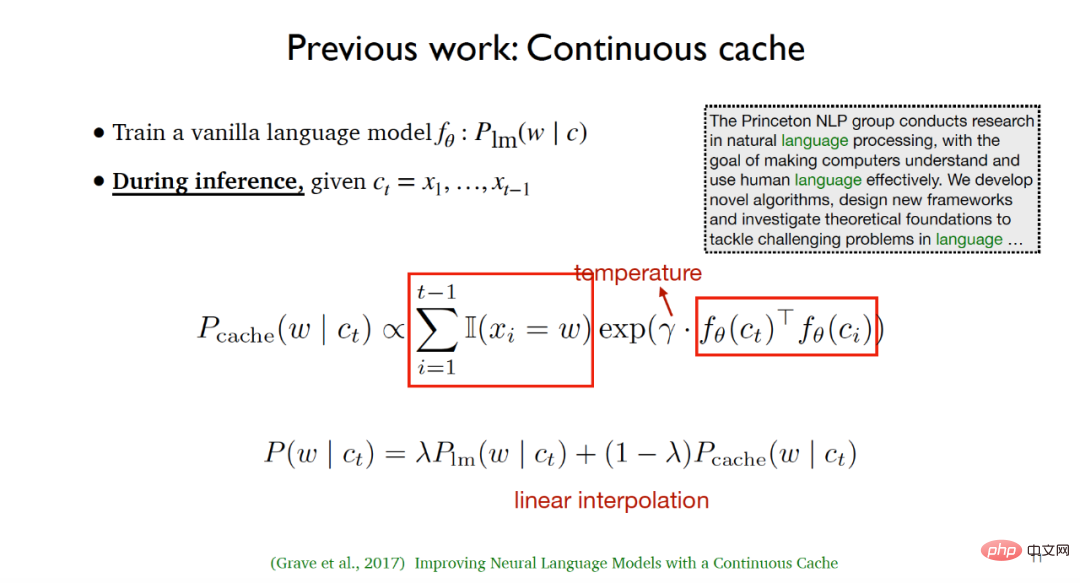

Parameter yang boleh dilatih dalam keseluruhan paradigma latihan ialah  dan E. Kerja pasukan Chen Danqi diilhamkan oleh dua karya berikut: (1) Algoritma cache Berterusan yang dicadangkan oleh Grave et al. Algoritma ini melatih model bahasa biasa

dan E. Kerja pasukan Chen Danqi diilhamkan oleh dua karya berikut: (1) Algoritma cache Berterusan yang dicadangkan oleh Grave et al. Algoritma ini melatih model bahasa biasa  semasa proses latihan, memandangkan teks input

semasa proses latihan, memandangkan teks input  , teks yang diberikan pertama kali disenaraikan Semua; perkataan yang berlaku sebelum ini dan kesemuanya bersamaan dengan kedudukan teg bagi perkataan seterusnya perlu diramalkan, dan kemudian taburan cache dikira menggunakan persamaan antara pembolehubah terpendam dan parameter suhu. Dalam fasa ujian, interpolasi linear bagi pengedaran model bahasa dan pengedaran cache boleh mencapai hasil percubaan yang lebih baik.

, teks yang diberikan pertama kali disenaraikan Semua; perkataan yang berlaku sebelum ini dan kesemuanya bersamaan dengan kedudukan teg bagi perkataan seterusnya perlu diramalkan, dan kemudian taburan cache dikira menggunakan persamaan antara pembolehubah terpendam dan parameter suhu. Dalam fasa ujian, interpolasi linear bagi pengedaran model bahasa dan pengedaran cache boleh mencapai hasil percubaan yang lebih baik.

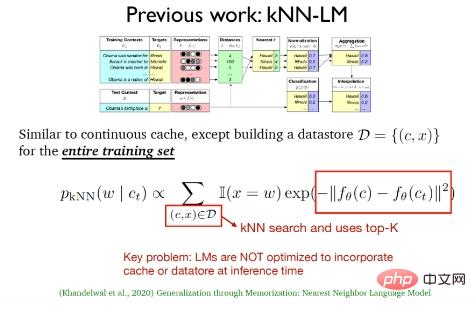

(2) Model bahasa jiran terdekat k (kNN-LM) yang dicadangkan oleh Khandelwal et al > Kaedah ini konsisten dengan Algoritma caching berterusan adalah serupa Perbezaan terbesar antara kedua-duanya ialah kNN-LM membina kawasan penyimpanan data untuk semua sampel latihan Dalam fasa ujian, carian jiran terdekat akan dilakukan pada data dalam kawasan storan data untuk memilih -kdata teratas yang terbaik.

Dua kerja di atas sebenarnya hanya menggunakan pengedaran cache dan pengedaran jiran terdekat k dalam fasa ujian, dan hanya diteruskan semasa proses latihan Model bahasa tradisional tidak mengoptimumkan gabungan cache dan storan data semasa fasa inferens.

Selain itu, terdapat beberapa model bahasa yang berfungsi untuk teks ultra-panjang yang patut diberi perhatian, seperti Transformer-XL digabungkan dengan mekanisme pengulangan perhatian yang dicadangkan pada 2019 dan Transformers Mampat berdasarkan pemampatan memori yang dicadangkan pada tahun 2020.

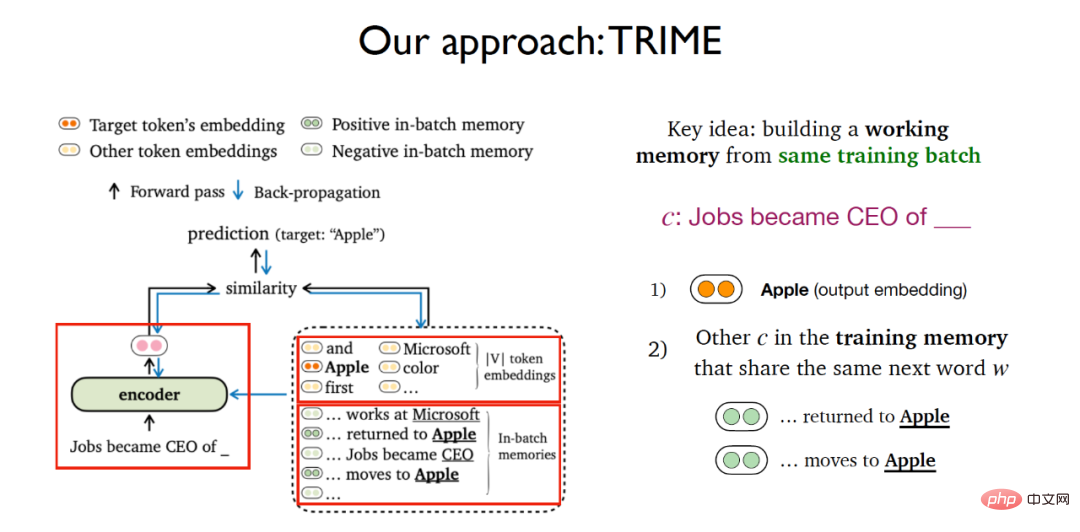

Berdasarkan beberapa karya yang diperkenalkan sebelum ini, pasukan Chen Danqi membina kaedah latihan model bahasa berdasarkan memori kelompok Idea utama adalah untuk membina memori kerja untuk kumpulan latihan yang sama. Untuk tugas meramal perkataan seterusnya daripada teks yang diberikan, idea TRIME sangat serupa dengan pembelajaran kontrastif Ia bukan sahaja mempertimbangkan tugas menggunakan matriks pemasukan perkataan softmax untuk meramalkan kebarangkalian perkataan seterusnya , tetapi juga menambah modul baharu Dalam modul ini Pertimbangkan semua teks lain yang muncul dalam ingatan latihan dan mempunyai perkataan yang sama dengan teks yang diberikan yang perlu diramalkan.

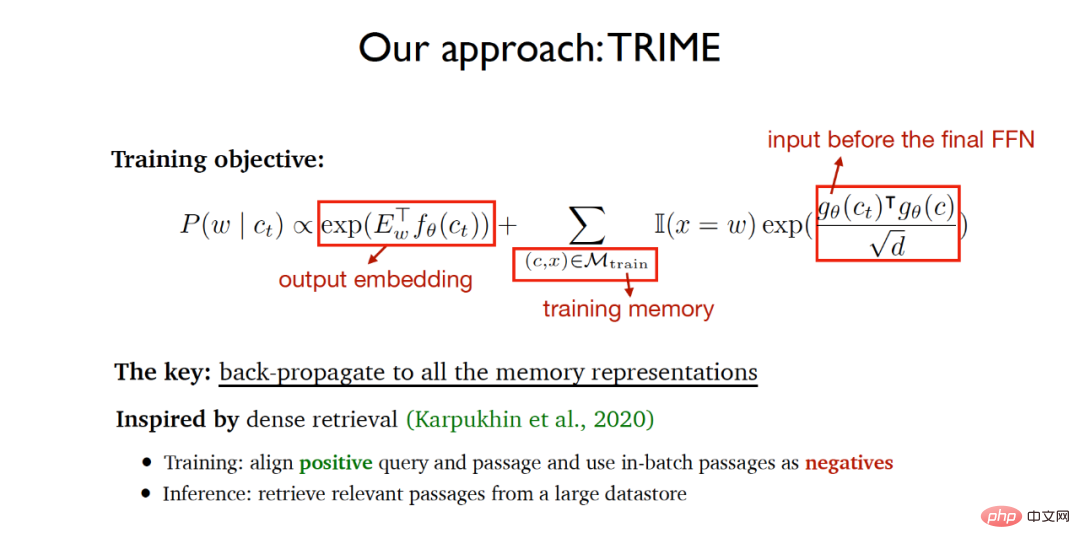

Oleh itu, fungsi objektif latihan keseluruhan TRIME merangkumi dua bahagian:

(1) Berdasarkan tugasan ramalan matriks pemasukan perkataan output.

(2) Kongsi persamaan teks perkataan yang sama untuk diramalkan dalam ingatan latihan (memori latihan), di mana perwakilan vektor yang perlu mengukur persamaan dilalui melalui peringkat akhir lapisan suapan ke hadapan Input, produk titik berskala digunakan untuk mengukur persamaan vektor.

Algoritma berharap rangkaian terlatih terakhir dapat mencapai kata ramalan akhir setepat mungkin, dan pada masa yang sama, teks yang berkongsi perkataan yang sama untuk diramalkan dalam latihan yang sama batch adalah sama yang mungkin, supaya proses latihan adalah Dalam kaedah ini, semua perwakilan memori teks dilaksanakan melalui perambatan belakang untuk mencapai pembelajaran rangkaian neural hujung ke hujung. Idea pelaksanaan algoritma sebahagian besarnya diilhamkan oleh pengambilan semula padat yang dicadangkan pada tahun 2020. Pendapatan padat menjajarkan pertanyaan dan dokumen berkaitan positif dalam fasa latihan dan menggunakan dokumen dalam kelompok yang sama dengan sampel negatif, dan mengekstrak data daripada data besar dalam fasa inferens Dapatkan semula dokumen yang berkaitan dari kawasan penyimpanan.

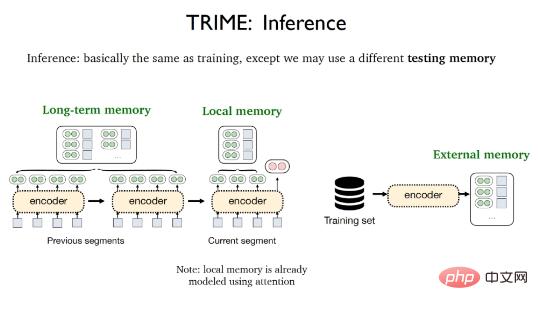

Fasa inferens TRIME hampir sama dengan proses latihan Satu-satunya perbezaan ialah memori ujian yang berbeza boleh digunakan, termasuk ingatan tempatan (Memori tempatan), ingatan jangka panjang (Memori jangka panjang) dan memori luaran (Memori luar). Memori tempatan merujuk kepada semua perkataan yang muncul dalam segmen semasa dan telah divektorkan oleh mekanisme perhatian memori jangka panjang merujuk kepada perwakilan teks yang tidak boleh diperoleh secara langsung disebabkan oleh had panjang input tetapi berasal dari dokumen yang sama dengan teks yang akan dibuat; diproses, Memori luaran merujuk kepada kawasan penyimpanan data yang besar yang menyimpan semua sampel latihan atau korpora tambahan.

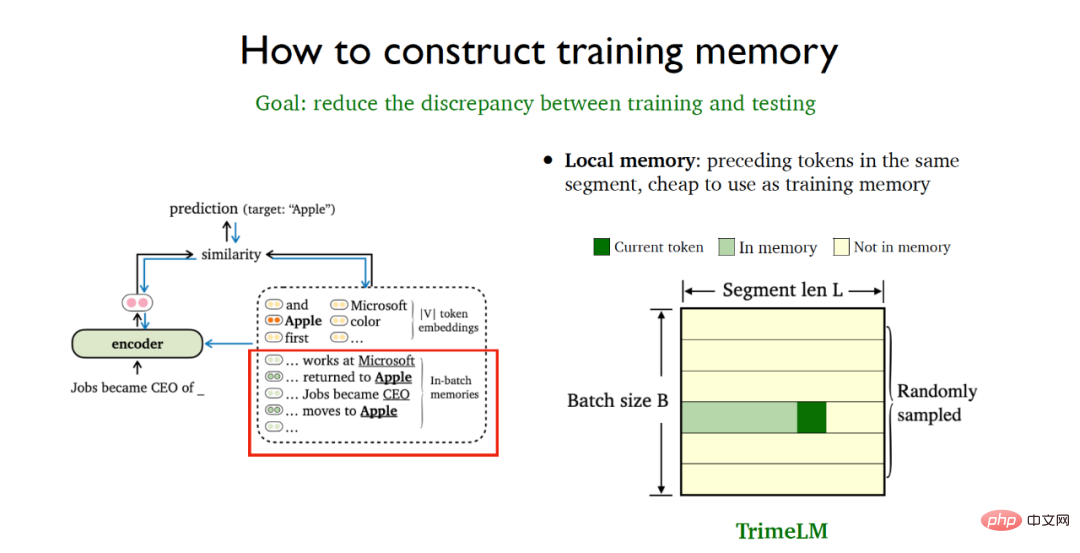

Untuk meminimumkan ketidakkonsistenan antara fasa latihan dan ujian, strategi pemprosesan data tertentu perlu diguna pakai untuk membina lebih baik Train your ingatan. Memori tempatan merujuk kepada token sebelumnya dalam serpihan data yang sama dan sangat murah untuk digunakan. Pemprosesan kumpulan pensampelan rawak boleh digunakan untuk menggunakan memori tempatan secara langsung dalam kedua-dua fasa latihan dan fasa ujian Ini menghasilkan versi asas model TrimeLM berdasarkan memori tempatan.

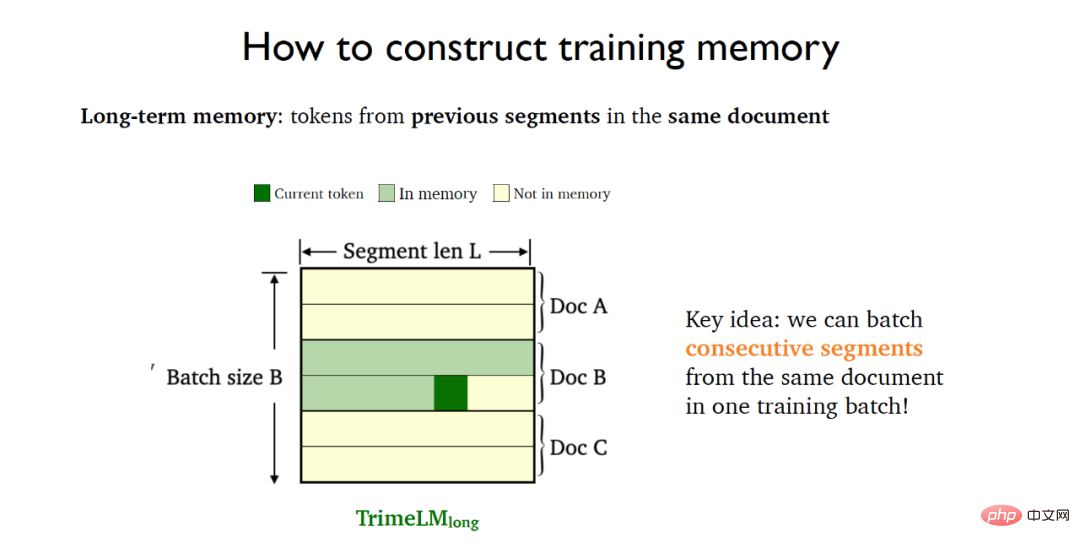

Memori jangka panjang merujuk kepada teg dalam serpihan sebelumnya bagi dokumen yang sama dan perlu bergantung pada serpihan sebelumnya bagi dokumen yang sama. Untuk tujuan ini, segmen berturut-turut (segmen berturut-turut) dalam dokumen yang sama dimasukkan ke dalam kelompok latihan yang sama, yang menghasilkan model TrimeLMlong ingatan jangka panjang kolektif.

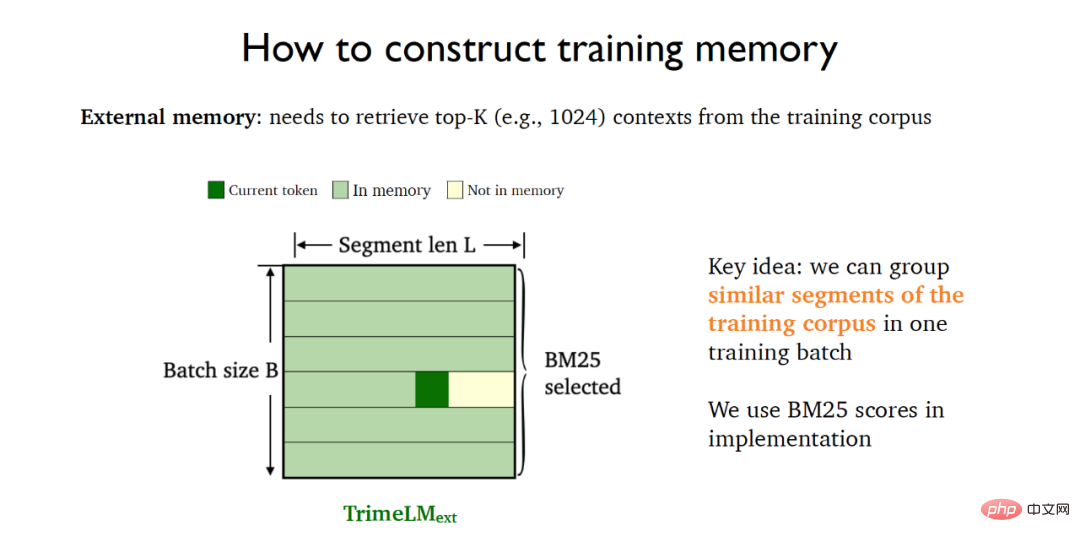

Memori luaran perlu diambil semula bersama-sama dengan storan data yang besar. Untuk tujuan ini, BM25 boleh digunakan untuk meletakkan serpihan yang serupa dalam data latihan ke dalam kelompok latihan yang sama, yang menghasilkan model TrimeLMext digabungkan dengan memori luaran.

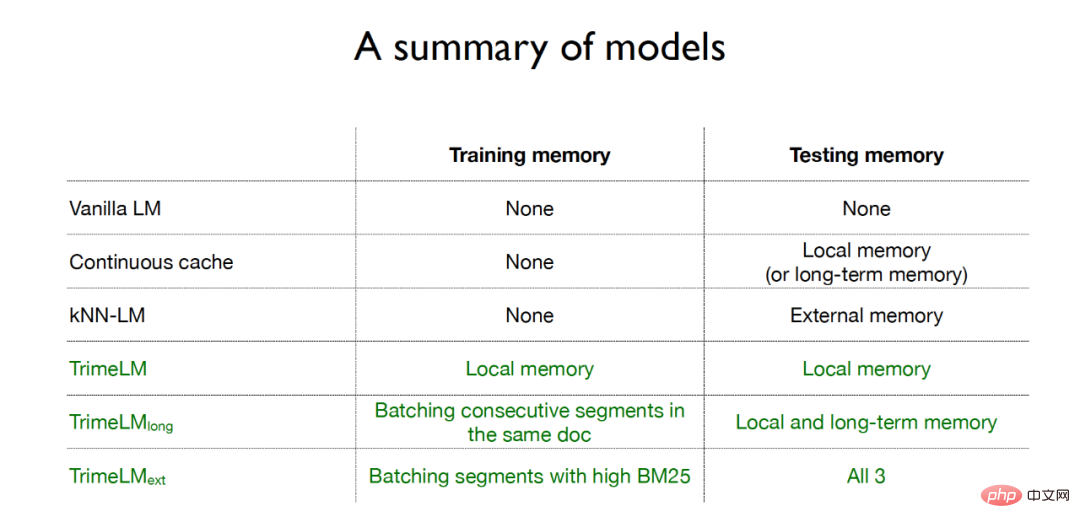

Ringkasnya, model bahasa tradisional tidak menggunakan ingatan dalam fasa latihan dan fasa ujian berterusan hanya menggunakan ingatan tempatan atau ingatan jangka panjang dalam fasa ujian; model bahasa menggunakan memori dalam fasa ujian memori luaran; ketiga-tiga model bahasa untuk algoritma TRIME semuanya menggunakan kaedah peningkatan memori dalam fasa latihan dan fasa ujian , dan TrimeLMlong menyasarkan pemprosesan berterusan dokumen yang sama dalam fasa latihan. Serpihan dimasukkan ke dalam kumpulan yang sama untuk latihan, dan memori tempatan dan ingatan jangka panjang digabungkan dalam fasa ujian untuk dokumen yang serupa semasa fasa latihan, dan ingatan tempatan, ingatan jangka panjang dan ingatan luaran digabungkan dalam fasa ujian.

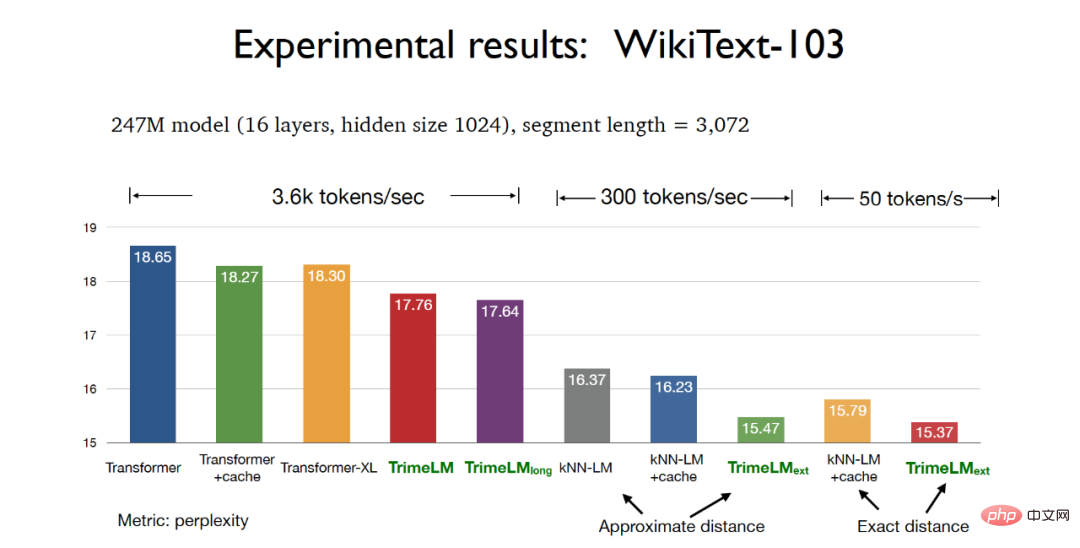

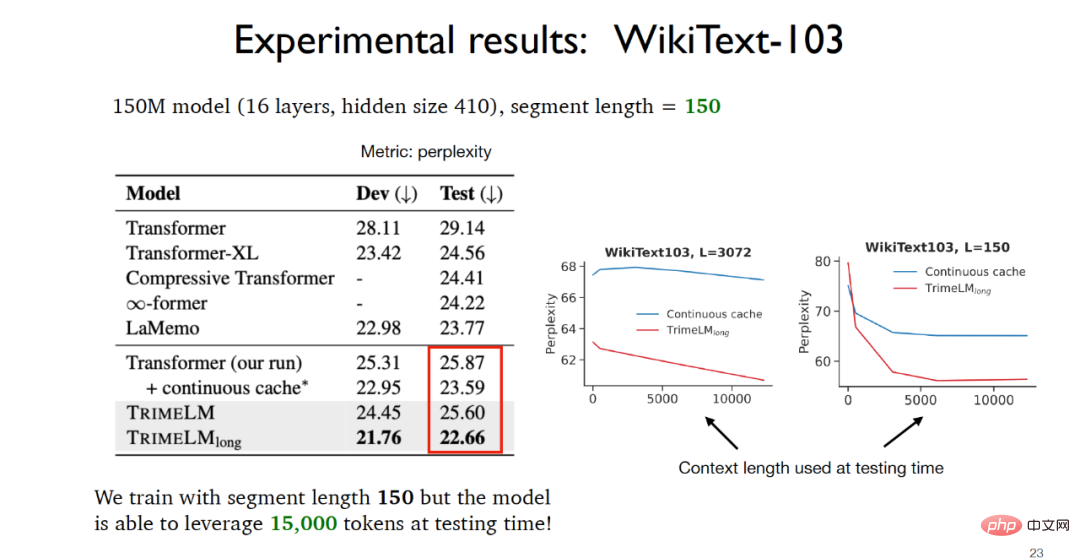

Dalam peringkat percubaan, apabila menguji parameter model 247M dan panjang kepingan 3072 pada set data WikiText-103, tiga kaedah berdasarkan Algoritma TRIME Kedua-dua versi model bahasa boleh mencapai kesan kebingungan yang lebih baik daripada Transformer tradisional, antaranya model TrimeLMext berdasarkan jarak sebenar boleh mencapai hasil percubaan terbaik. Pada masa yang sama, TrimeLM dan TrimeLMlong juga boleh mengekalkan kelajuan perolehan hampir dengan Transformer tradisional, sambil mempunyai kelebihan kebingungan dan kelajuan perolehan.

Apabila menguji parameter model 150M dan panjang kepingan 150 pada set data WikiText-103, dapat dilihat bahawa TrimeLMlong menyasarkan Continuous yang sama serpihan dokumen dimasukkan ke dalam kumpulan latihan yang sama, dan memori tempatan dan ingatan jangka panjang digabungkan dalam fasa ujian Oleh itu, walaupun panjang kepingan hanya 150, data sebenar yang tersedia dalam fasa ujian boleh mencapai 15,000, dan. keputusan percubaan adalah jauh lebih baik daripada model asas yang lain.

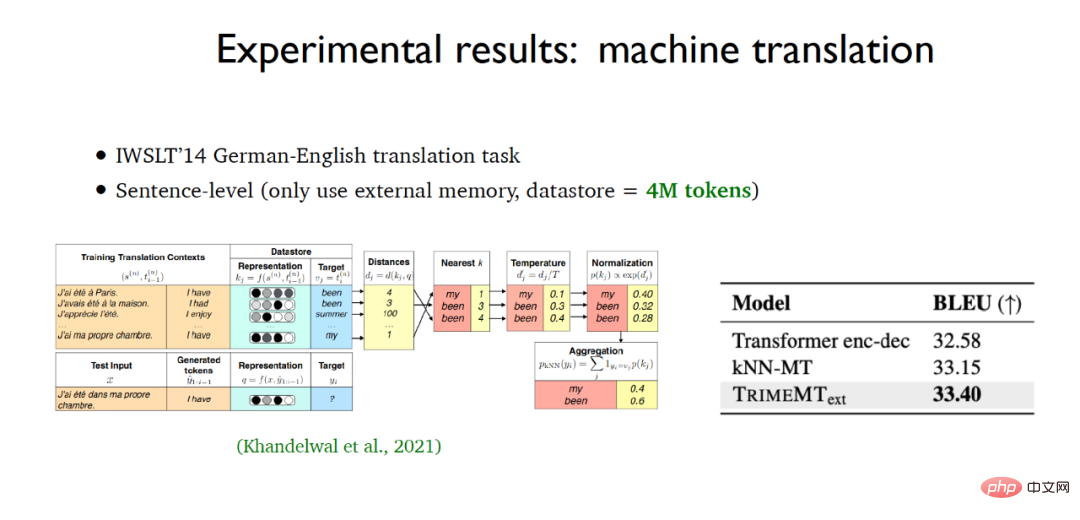

Untuk pembinaan model bahasa peringkat aksara, model bahasa berdasarkan algoritma TRIME juga mencapai keputusan percubaan terbaik pada set data enwik8 Dalam tugas aplikasi terjemahan mesin, TrimeMT_ext juga mencapai keputusan percubaan yang melebihi model garis dasar.

Ringkasnya, model bahasa berdasarkan algoritma TRIME menggunakan tiga kaedah pembinaan memori, menggunakan sepenuhnya data berkaitan dalam kelompok yang sama. Peningkatan ingatan memperkenalkan memori tanpa memperkenalkan sejumlah besar kos pengiraan, dan tidak mengubah keseluruhan struktur model Berbanding dengan model garis dasar yang lain, ia telah mencapai keputusan percubaan yang lebih baik.

Chen Danqi juga menumpukan pada model bahasa berasaskan perolehan Malah, TrimeLMext boleh dianggap sebagai versi yang lebih baik daripada model bahasa jiran terdekat, tetapi dalam proses inferens ini. dua algoritma Berbanding dengan model garis dasar lain, ia hampir 10 hingga 60 kali lebih perlahan, yang jelas tidak boleh diterima. Chen Danqi menunjukkan salah satu arah pembangunan masa depan yang mungkin bagi model bahasa berasaskan perolehan: sama ada mungkin untuk menggunakan pengekod perolehan semula yang lebih kecil dan kawasan storan data yang lebih besar untuk mengurangkan kos pengiraan kepada carian jiran terdekat.

Berbanding dengan model bahasa tradisional, model bahasa berasaskan pengambilan mempunyai kelebihan yang ketara Contohnya, model bahasa berasaskan pengambilan boleh dikemas kini dan dikekalkan dengan lebih baik, manakala model bahasa tradisional Model tidak dapat dicapai. pengemaskinian pengetahuan yang dinamik kerana ia menggunakan pengetahuan terdahulu untuk latihan pada masa yang sama, model bahasa berasaskan perolehan juga boleh digunakan dengan lebih baik dalam bidang sensitif privasi. Mengenai cara menggunakan model bahasa berasaskan perolehan dengan lebih baik, guru Chen Danqi percaya bahawa penalaan halus, dorongan atau pembelajaran dalam konteks boleh digunakan untuk membantu penyelesaian.

Alamat kertas: https://arxiv.org/abs/2204.00408

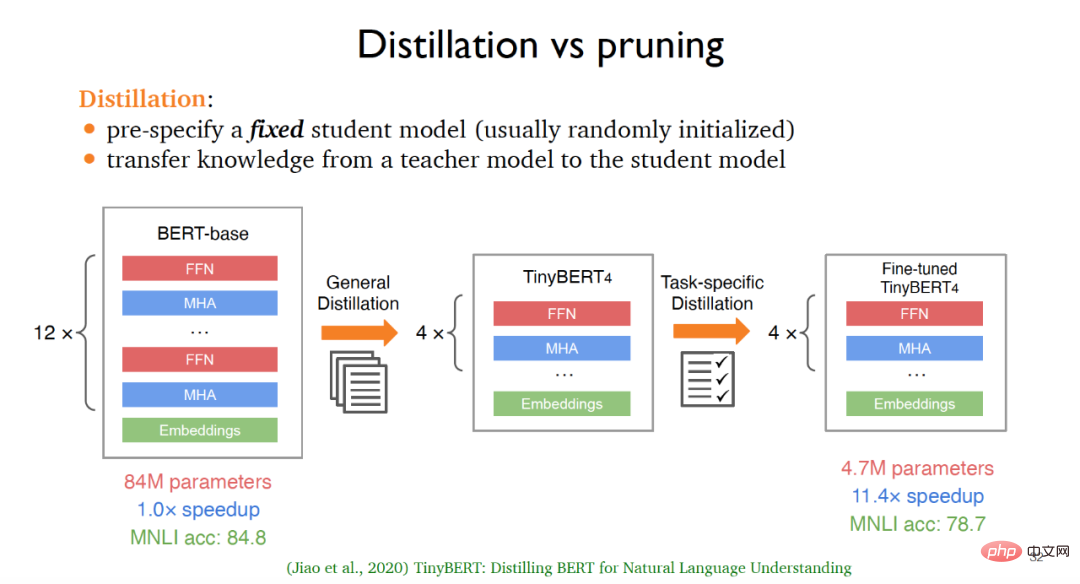

Teknologi pemampatan model digunakan secara meluas dalam model bahasa besar, membolehkan model yang lebih kecil disesuaikan dengan lebih cepat kepada aplikasi hiliran Kaedah pemampatan model arus perdana tradisional ialah penyulingan dan pemangkasan. Untuk penyulingan, selalunya perlu untuk mentakrifkan model pelajar tetap Model pelajar ini biasanya dimulakan secara rawak, dan kemudian pengetahuan dipindahkan daripada model guru kepada model pelajar untuk mencapai penyulingan pengetahuan.

Sebagai contoh, bermula dari versi asal BERT, selepas penyulingan am, iaitu, selepas latihan pada sejumlah besar korpora yang tidak berlabel, versi asas TinyBERT4 boleh diperolehi versi asas TinyBERT4, TinyBERT4 yang ditala Halus juga boleh diperoleh melalui kaedah penyulingan dipacu tugas Model akhir boleh menjadi lebih kecil dan lebih pantas daripada model BERT asal dengan mengorbankan sedikit ketepatan. Walau bagaimanapun, kaedah berdasarkan penyulingan ini juga mempunyai kelemahan tertentu Sebagai contoh, untuk tugas hiliran yang berbeza, seni bina model sering ditetapkan pada masa yang sama, ia perlu dilatih dari awal menggunakan data tidak berlabel, yang terlalu mahal dari segi pengiraan.

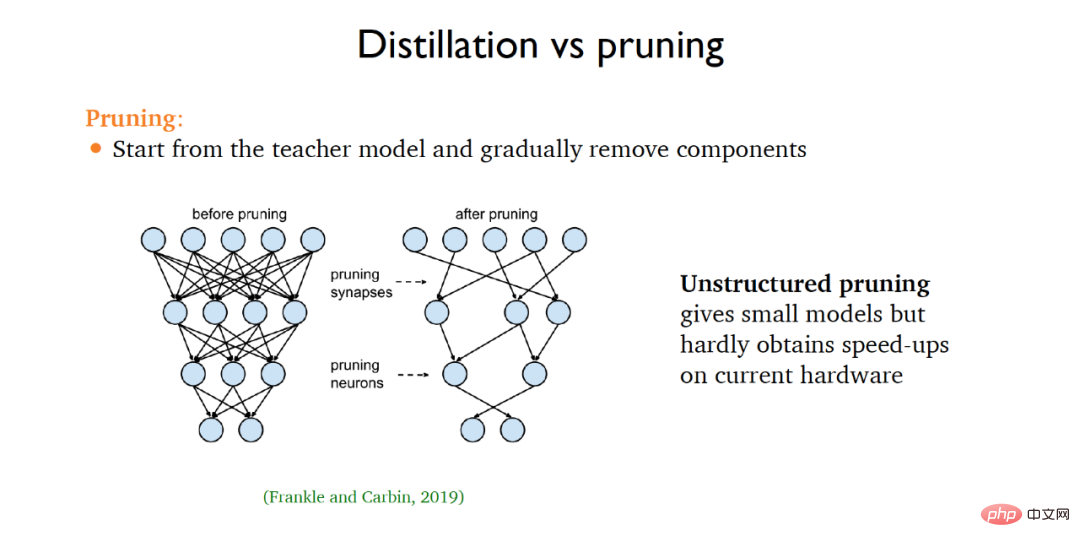

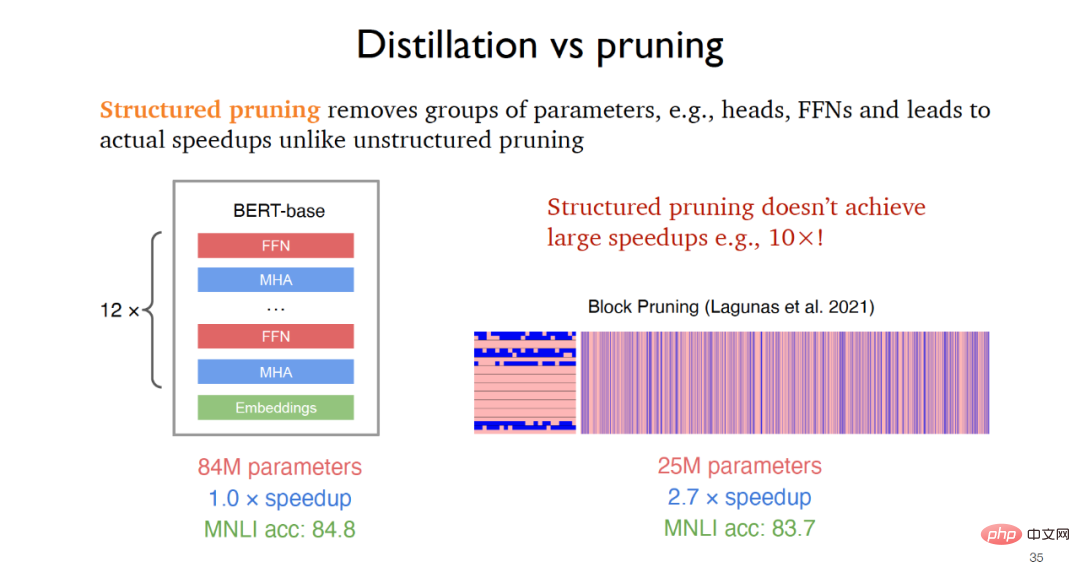

Untuk pemangkasan, selalunya perlu bermula daripada model guru dan kemudian terus mengeluarkan bahagian yang tidak berkaitan daripada model asal. Pemangkasan tidak berstruktur yang dicadangkan pada 2019 boleh memperoleh model yang lebih kecil tetapi mempunyai sedikit peningkatan dalam kelajuan larian, manakala pemangkasan berstruktur mencapai peningkatan kelajuan dalam aplikasi praktikal dengan mengalih keluar kumpulan parameter seperti lapisan suapan, seperti pada 2021 Pemangkasan blok yang dicadangkan boleh mencapai kelajuan 2-3 kali ganda penambahbaikan.

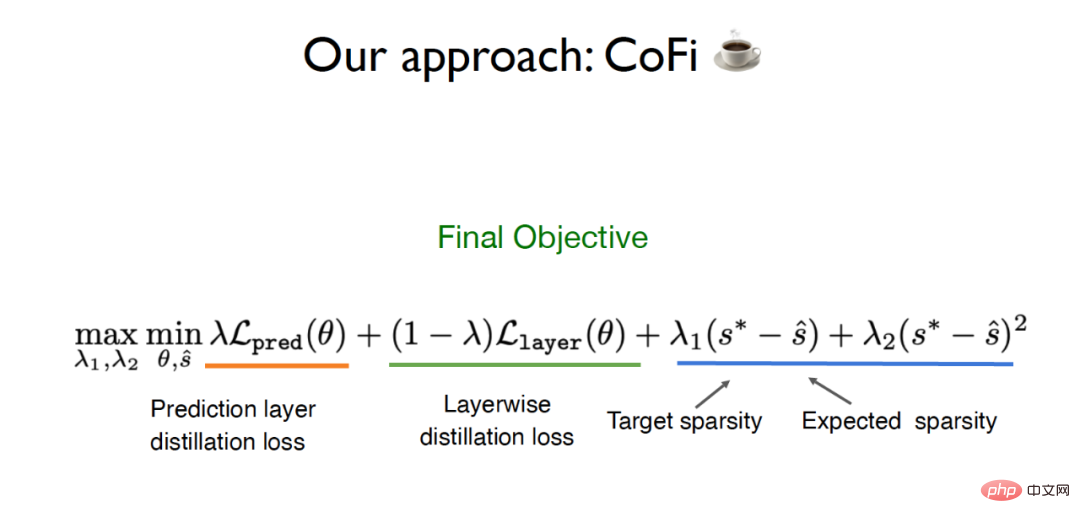

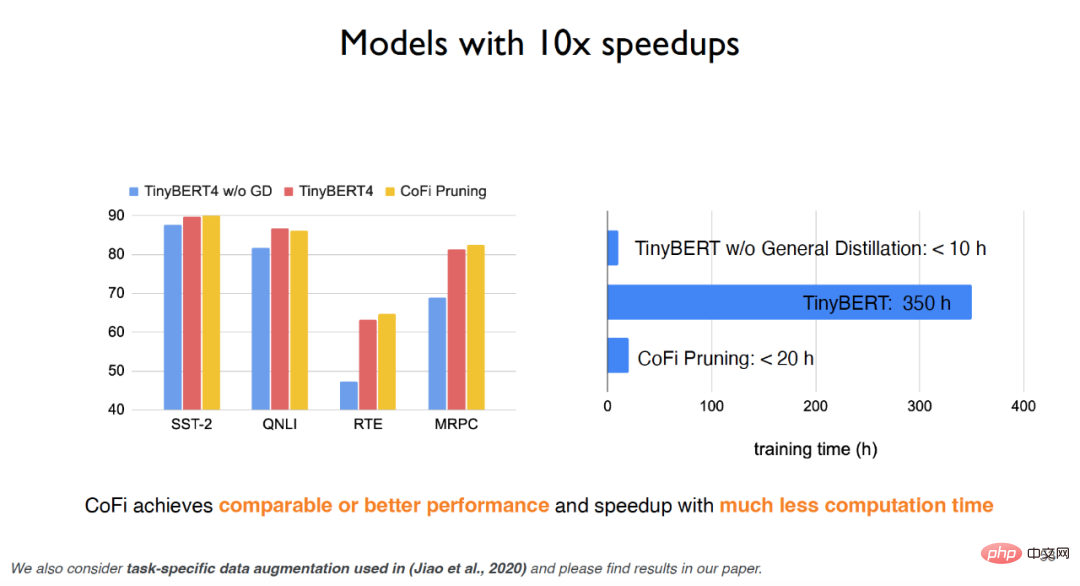

Mensasarkan batasan kaedah penyulingan dan pemangkasan tradisional, pasukan Chen Danqi mencadangkan algoritma yang dipanggil CofiPruning , Ia memangkas kedua-dua unit berbutir kasar dan unit berbutir halus, dan mereka bentuk fungsi objektif penyulingan lapisan demi lapisan untuk memindahkan pengetahuan daripada model yang tidak dipangkas kepada model yang dipangkas, dan akhirnya dapat mengekalkan lebih daripada 90 Berdasarkan % ketepatan, ia mencapai peningkatan kelajuan lebih daripada 10 kali ganda, dan lebih murah dari segi pengiraan daripada kaedah penyulingan tradisional.

Cadangan CofiPruning adalah berdasarkan dua kerja asas yang penting:

(1) Kepantasan yang dicapai dengan memangkas keseluruhan lapisan Untuk penambahbaikan, kerja berkaitan menunjukkan bahawa kira-kira 50% daripada lapisan rangkaian saraf boleh dipangkas, tetapi pemangkasan berbutir kasar mempunyai kesan yang lebih besar terhadap ketepatan.

(2) Pemangkasan unit yang lebih kecil seperti kepala boleh mencapai fleksibiliti yang lebih baik, tetapi kaedah ini akan menjadi masalah pengoptimuman yang lebih sukar dalam pelaksanaan, dan tidak akan banyak peningkatan kelajuan.

Atas sebab ini, pasukan Chen Danqi berharap dapat memangkas kedua-dua unit berbutir kasar dan unit berbutir halus pada masa yang sama, dengan itu mengambil kesempatan daripada kedua-dua butiran. Di samping itu, untuk menyelesaikan masalah pemindahan data daripada model asal kepada model pemangkasan, CofiPruning menggunakan kaedah penjajaran lapisan demi lapisan untuk memindahkan pengetahuan semasa proses pemangkasan Fungsi objektif akhir termasuk kehilangan penyulingan dan berasaskan sparsity lag.

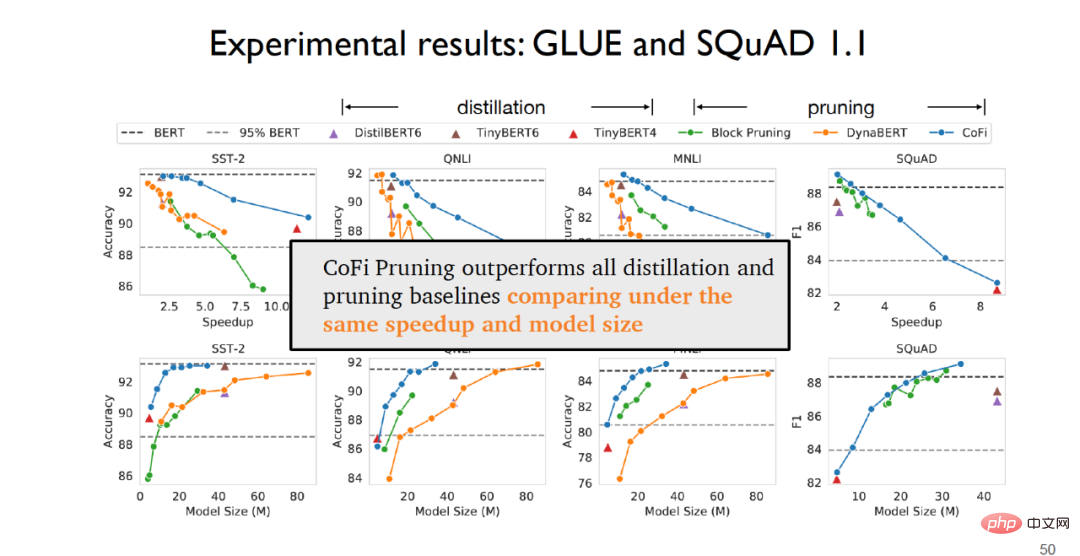

Dalam peringkat percubaan, pada set data GLUE untuk tugasan pengelasan ayat dan set data SQuAD1.1 untuk tugasan soal jawab, ia boleh didapati bahawa CofiPruning mempunyai Prestasi mengatasi semua kaedah garis dasar penyulingan dan pemangkasan pada kelajuan dan saiz model yang sama.

Untuk TinyBERT, jika penyulingan sejagat tidak dilakukan, kesan eksperimen akan sangat berkurangan; tetapi jika penyulingan sejagat digunakan, walaupun kesan eksperimen boleh diperbaiki, masa latihan akan menjadi sangat mahal. Algoritma CofiPruning bukan sahaja boleh mencapai kesan yang hampir sama seperti model garis dasar, tetapi juga meningkatkan masa berjalan dan kos pengiraan, dan boleh mencapai kelajuan pemprosesan yang lebih pantas dengan kos pengiraan yang lebih sedikit. Eksperimen menunjukkan bahawa untuk unit berbutir kasar, lapisan suapan hadapan pertama dan terakhir akan dikekalkan pada tahap yang paling besar manakala lapisan tengah lebih cenderung untuk dipangkas untuk unit berbutir halus, kepala dan dimensi tengah saraf atas rangkaian Lebih cenderung untuk dipangkas.

Ringkasnya, CofiPruning ialah algoritma pemampatan model yang sangat mudah dan berkesan yang secara bersama-sama memangkas unit berbutir kasar dan unit berbutir halus , digabungkan dengan fungsi objektif penyulingan lapisan demi lapisan, kelebihan kedua-dua algoritma, pemangkasan struktur dan penyulingan pengetahuan, boleh digabungkan untuk mencapai kelajuan pemprosesan yang lebih cepat dan struktur model yang lebih kecil. Berkenaan trend masa depan pemampatan model, Chen Danqi juga memfokuskan pada sama ada model bahasa besar seperti GPT-3 boleh dipangkas, dan sama ada tugas huluan boleh dipangkas Ini adalah idea penyelidikan yang boleh ditumpukan pada masa hadapan.

3 Ringkasan dan Tinjauan

Model bahasa berskala besar kini telah mencapai nilai aplikasi praktikal yang sangat memuaskan, tetapi disebabkan kos alam sekitar dan ekonomi yang mahal , Kebimbangan tentang privasi dan keadilan, serta kesukaran kemas kini masa nyata, bermakna model bahasa yang besar masih perlu diperbaiki. Chen Danqi percaya bahawa model bahasa masa hadapan boleh digunakan sebagai asas pengetahuan yang besar Pada masa yang sama, skala model bahasa perlu dikurangkan dengan banyaknya pada masa hadapan model bahasa berasaskan pencarian atau model bahasa yang jarang digunakan menggantikan pengambilan padat dan pemampatan model Kerja ini juga memerlukan penyelidik untuk memberi tumpuan.

Atas ialah kandungan terperinci Princeton Chen Danqi: Bagaimana untuk menjadikan 'model besar' lebih kecil. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Cara Membuat Pangkalan Data Oracle Cara Membuat Pangkalan Data Oracle

Apr 11, 2025 pm 02:33 PM

Cara Membuat Pangkalan Data Oracle Cara Membuat Pangkalan Data Oracle

Apr 11, 2025 pm 02:33 PM

Mewujudkan pangkalan data Oracle tidak mudah, anda perlu memahami mekanisme asas. 1. Anda perlu memahami konsep pangkalan data dan Oracle DBMS; 2. Menguasai konsep teras seperti SID, CDB (pangkalan data kontena), PDB (pangkalan data pluggable); 3. Gunakan SQL*Plus untuk membuat CDB, dan kemudian buat PDB, anda perlu menentukan parameter seperti saiz, bilangan fail data, dan laluan; 4. Aplikasi lanjutan perlu menyesuaikan set aksara, memori dan parameter lain, dan melakukan penalaan prestasi; 5. Beri perhatian kepada ruang cakera, keizinan dan parameter, dan terus memantau dan mengoptimumkan prestasi pangkalan data. Hanya dengan menguasai ia dengan mahir memerlukan amalan yang berterusan, anda boleh benar -benar memahami penciptaan dan pengurusan pangkalan data Oracle.

Cara Membuat Pangkalan Data Oracle Cara Membuat Pangkalan Data Oracle

Apr 11, 2025 pm 02:36 PM

Cara Membuat Pangkalan Data Oracle Cara Membuat Pangkalan Data Oracle

Apr 11, 2025 pm 02:36 PM

Untuk membuat pangkalan data Oracle, kaedah biasa adalah menggunakan alat grafik DBCA. Langkah -langkah adalah seperti berikut: 1. Gunakan alat DBCA untuk menetapkan DBName untuk menentukan nama pangkalan data; 2. Tetapkan SYSPASSWORD dan SYSTEMPASSWORD kepada kata laluan yang kuat; 3. Tetapkan aksara dan NationalCharacterset ke Al32utf8; 4. Tetapkan MemorySize dan Tablespacesize untuk menyesuaikan mengikut keperluan sebenar; 5. Tentukan laluan logfile. Kaedah lanjutan dibuat secara manual menggunakan arahan SQL, tetapi lebih kompleks dan terdedah kepada kesilapan. Perhatikan kekuatan kata laluan, pemilihan set aksara, saiz dan memori meja makan

Cara Menulis Penyataan Pangkalan Data Oracle

Apr 11, 2025 pm 02:42 PM

Cara Menulis Penyataan Pangkalan Data Oracle

Apr 11, 2025 pm 02:42 PM

Inti dari pernyataan Oracle SQL adalah pilih, masukkan, mengemas kini dan memadam, serta aplikasi fleksibel dari pelbagai klausa. Adalah penting untuk memahami mekanisme pelaksanaan di sebalik pernyataan, seperti pengoptimuman indeks. Penggunaan lanjutan termasuk subqueries, pertanyaan sambungan, fungsi analisis, dan PL/SQL. Kesilapan umum termasuk kesilapan sintaks, isu prestasi, dan isu konsistensi data. Amalan terbaik pengoptimuman prestasi melibatkan menggunakan indeks yang sesuai, mengelakkan pilih *, mengoptimumkan di mana klausa, dan menggunakan pembolehubah terikat. Menguasai Oracle SQL memerlukan amalan, termasuk penulisan kod, debugging, berfikir dan memahami mekanisme asas.

Cara Menambah, Ubah Suai dan Padam Panduan Operasi Lapangan Jadual MySQL Data

Apr 11, 2025 pm 05:42 PM

Cara Menambah, Ubah Suai dan Padam Panduan Operasi Lapangan Jadual MySQL Data

Apr 11, 2025 pm 05:42 PM

Panduan Operasi Lapangan di MySQL: Tambah, mengubah suai, dan memadam medan. Tambahkan medan: alter table table_name tambah column_name data_type [not null] [default default_value] [primary kekunci] [AUTO_INCREMENT] Modify Field: Alter Table Table_Name Ubah suai column_name data_type [not null] [default default_value] [Kunci Utama]

Apakah kekangan integriti jadual pangkalan data Oracle?

Apr 11, 2025 pm 03:42 PM

Apakah kekangan integriti jadual pangkalan data Oracle?

Apr 11, 2025 pm 03:42 PM

Kekangan integriti pangkalan data Oracle dapat memastikan ketepatan data, termasuk: tidak null: nilai null dilarang; Unik: Keunikan menjamin, membolehkan nilai null tunggal; Kunci utama: kekangan utama utama, menguatkan unik, dan melarang nilai null; Kunci asing: Mengekalkan hubungan antara jadual, kunci asing merujuk kepada kunci utama jadual utama; Semak: Hadkan nilai lajur mengikut syarat.

Penjelasan terperinci mengenai contoh pertanyaan bersarang dalam pangkalan data MySQL

Apr 11, 2025 pm 05:48 PM

Penjelasan terperinci mengenai contoh pertanyaan bersarang dalam pangkalan data MySQL

Apr 11, 2025 pm 05:48 PM

Pertanyaan bersarang adalah cara untuk memasukkan pertanyaan lain dalam satu pertanyaan. Mereka digunakan terutamanya untuk mendapatkan data yang memenuhi syarat kompleks, mengaitkan pelbagai jadual, dan mengira nilai ringkasan atau maklumat statistik. Contohnya termasuk mencari pekerja di atas gaji purata, mencari pesanan untuk kategori tertentu, dan mengira jumlah jumlah pesanan bagi setiap produk. Apabila menulis pertanyaan bersarang, anda perlu mengikuti: Tulis subqueries, tulis hasilnya kepada pertanyaan luar (dirujuk dengan alias atau sebagai klausa), dan mengoptimumkan prestasi pertanyaan (menggunakan indeks).

Cara Mengkonfigurasi Format Log Debian Apache

Apr 12, 2025 pm 11:30 PM

Cara Mengkonfigurasi Format Log Debian Apache

Apr 12, 2025 pm 11:30 PM

Artikel ini menerangkan cara menyesuaikan format log Apache pada sistem Debian. Langkah -langkah berikut akan membimbing anda melalui proses konfigurasi: Langkah 1: Akses fail konfigurasi Apache Fail konfigurasi Apache utama sistem Debian biasanya terletak di /etc/apache2/apache2.conf atau /etc/apache2/httpd.conf. Buka fail konfigurasi dengan kebenaran root menggunakan arahan berikut: Sudonano/etc/Apache2/Apache2.conf atau Sudonano/etc/Apache2/httpd.conf Langkah 2: Tentukan format log tersuai untuk mencari atau

Apa yang dilakukan Oracle

Apr 11, 2025 pm 06:06 PM

Apa yang dilakukan Oracle

Apr 11, 2025 pm 06:06 PM

Oracle adalah syarikat perisian Sistem Pengurusan Pangkalan Data (DBMS) terbesar di dunia. Produk utamanya termasuk fungsi berikut: Sistem Pengurusan Pengurusan Pangkalan Data Relasi (Oracle Database) Alat Pembangunan (Oracle Apex, Oracle Visual Builder) Middleware (Oracle Weblogic Server, Oracle SOA Suite) Analisis Awan (Oracle Cloud Infrastructure)