Peranti teknologi

Peranti teknologi

AI

AI

Google dan Stanford bersama-sama mengeluarkan artikel: Mengapa kita mesti menggunakan model besar?

Google dan Stanford bersama-sama mengeluarkan artikel: Mengapa kita mesti menggunakan model besar?

Google dan Stanford bersama-sama mengeluarkan artikel: Mengapa kita mesti menggunakan model besar?

Model bahasa telah mengubah secara mendalam penyelidikan dan amalan dalam bidang pemprosesan bahasa semula jadi. Dalam beberapa tahun kebelakangan ini, model besar telah membuat penemuan penting dalam banyak bidang. Mereka tidak perlu diperhalusi pada tugasan hiliran Dengan arahan atau gesaan yang sesuai, mereka boleh mencapai prestasi yang cemerlang, kadangkala menakjubkan.

Sebagai contoh, GPT-3 [1] boleh menulis surat cinta, skrip dan menyelesaikan masalah penaakulan matematik yang kompleks dengan data, dan PaLM [2] boleh menerangkan jenaka. Contoh di atas hanyalah sebahagian besar daripada keupayaan model yang besar Banyak aplikasi telah dibangunkan menggunakan keupayaan model yang besar Anda boleh melihat banyak demo berkaitan di laman web OpenAI [3], tetapi keupayaan ini jarang ditunjukkan dalam model kecil.

Dalam kertas kerja yang diperkenalkan hari ini, keupayaan yang tidak dimiliki oleh model kecil tetapi model besar dipanggil keupayaan muncul (Emergent Abilities), yang bermaksud bahawa skala model cukup besar. pada tahap tertentu Keupayaan mendadak yang diperoleh kemudian. Ini adalah proses di mana perubahan kuantitatif menghasilkan perubahan kualitatif.

Kemunculan kebolehan yang timbul sukar untuk diramalkan. Mengapa model tiba-tiba memperoleh keupayaan tertentu apabila skala meningkat masih menjadi persoalan terbuka yang memerlukan penyelidikan lanjut untuk menjawab. Dalam artikel ini, penulis menyusun beberapa kemajuan terkini dalam memahami model besar dan memberikan beberapa pemikiran yang berkaitan, saya berharap untuk membincangkannya dengan anda.

Kertas berkaitan:

-

Keupayaan Muncul Model Bahasa Besar.

http://arxiv. org/abs/2206.07682 -

Melangkaui Permainan Tiruan: Mengukur dan mengekstrapolasi keupayaan model bahasa.

https://arxiv.org/abs/ 2206.04615

Keupayaan Muncul Model Besar

Apakah model besar? Apakah saiz yang dianggap "besar"? Ini tidak mempunyai definisi yang jelas.

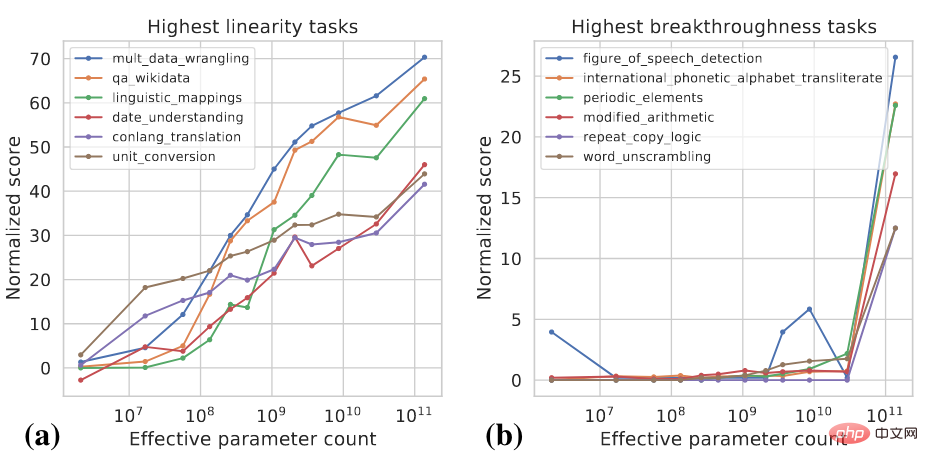

Secara umumnya, parameter model mungkin perlu mencapai satu bilion tahap sebelum ia menunjukkan keupayaan yang berbeza dengan ketara daripada sifar tangkapan dan beberapa tangkapan model kecil. Dalam tahun-tahun kebelakangan ini, terdapat banyak model dengan ratusan bilion dan trilion parameter, yang telah mencapai prestasi SOTA pada satu siri tugasan. Dalam sesetengah tugasan, prestasi model meningkat dengan pasti dengan skala yang semakin meningkat, manakala dalam tugasan lain, model menunjukkan peningkatan mendadak dalam prestasi pada skala tertentu. Dua penunjuk boleh digunakan untuk mengklasifikasikan tugasan yang berbeza [4]:

- Kelinearan: bertujuan untuk mengukur sejauh mana model melaksanakan tugas apabila skala meningkat telah diperbaiki dengan pasti.

- Terobosan: Bertujuan untuk mengukur sejauh mana tugas boleh dipelajari apabila saiz model melebihi nilai kritikal.

Kedua-dua penunjuk ini ialah fungsi skala model dan prestasi model Untuk butiran pengiraan khusus, sila rujuk [4]. Rajah di bawah menunjukkan beberapa contoh tugasan Lineariti tinggi dan Terobosan tinggi.

Tugas Lineariti Tinggi kebanyakannya berasaskan pengetahuan, yang bermaksud mereka bergantung terutamanya pada menghafal apa yang wujud dalam data latihan Maklumat , seperti menjawab soalan fakta. Model yang lebih besar biasanya menggunakan lebih banyak data untuk latihan dan boleh mengingati lebih banyak pengetahuan, jadi model menunjukkan peningkatan yang stabil dalam tugasan tersebut apabila skala meningkat. Tugasan pencapaian tinggi termasuk tugas yang lebih kompleks yang memerlukan penggunaan beberapa kebolehan yang berbeza atau pelaksanaan berbilang langkah untuk mendapatkan jawapan yang betul, seperti penaakulan matematik. Model yang lebih kecil berjuang untuk memperoleh semua keupayaan yang diperlukan untuk melaksanakan tugas tersebut.

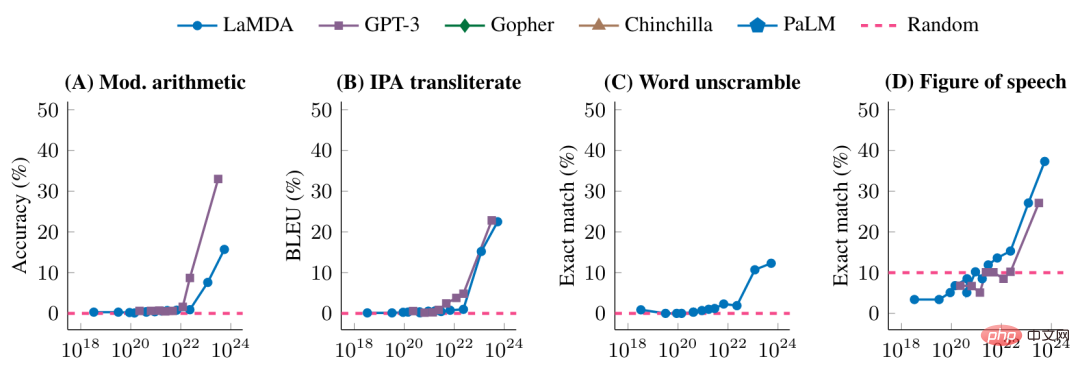

Angka berikut menunjukkan lagi prestasi model yang berbeza pada beberapa tugas terobosan tinggi

Sebelum mencapai skala model tertentu, prestasi model pada tugasan ini adalah rawak Selepas mencapai skala tertentu, terdapat peningkatan yang ketara.

Adakah ia lancar atau tiba-tiba?

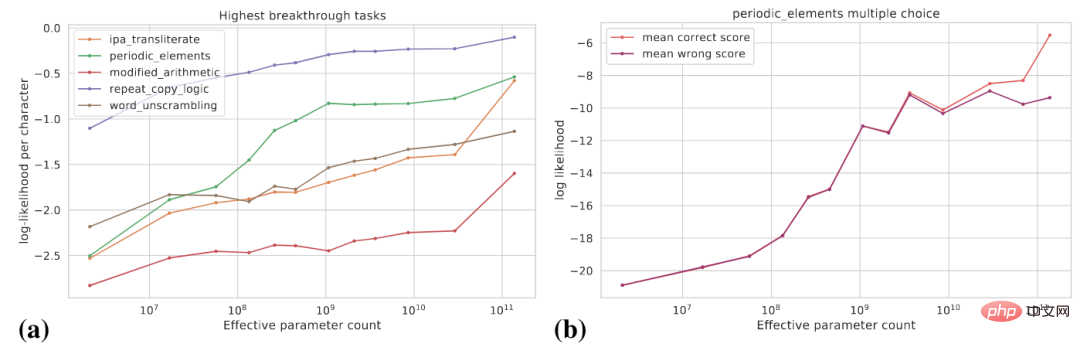

Apa yang kita lihat sebelum ini ialah model tiba-tiba memperoleh keupayaan tertentu selepas skala meningkat ke tahap tertentu Dari perspektif penunjuk khusus tugas, keupayaan ini muncul, tetapi dari perspektif lain, potensi perubahan dalam keupayaan model. Lebih licin. Artikel ini membincangkan dua perspektif berikut: (1) menggunakan penunjuk yang lebih lancar; (2) menguraikan tugas yang kompleks kepada berbilang subtugas.

Rajah berikut (a) menunjukkan lengkung perubahan kebarangkalian log sasaran sebenar untuk beberapa tugas penembusan tinggi Kebarangkalian log sasaran sebenar meningkat secara beransur-ansur apabila saiz model meningkat .

Rajah (b) menunjukkan bahawa untuk tugas aneka pilihan tertentu, apabila saiz model bertambah, Kebarangkalian log jawapan yang betul meningkat secara beransur-ansur, manakala kebarangkalian log jawapan yang salah meningkat secara beransur-ansur sehingga saiz tertentu dan kemudiannya dimatikan. Selepas skala ini, jurang antara kebarangkalian jawapan betul dan kebarangkalian jawapan salah semakin melebar, dan model mencapai peningkatan prestasi yang ketara.

Selain itu, untuk tugasan tertentu, katakan kita boleh menggunakan Exact Match dan BLEU untuk menilai prestasi model BLEU ialah penunjuk yang lebih lancar daripada Exact Match, dan penunjuk berbeza digunakan . Mungkin terdapat perbezaan yang ketara dalam trend yang dilihat.

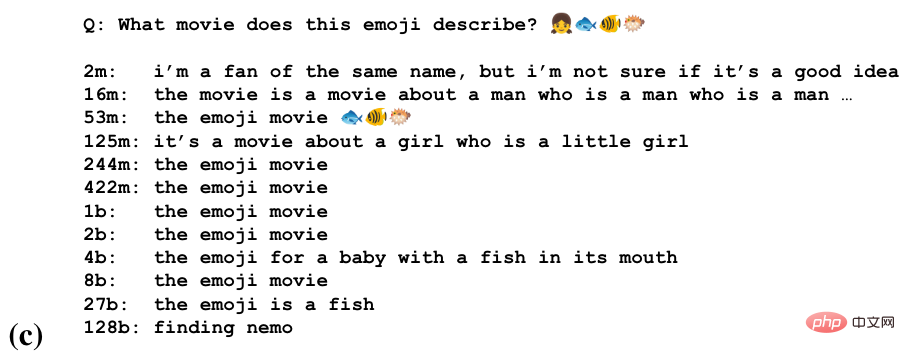

Untuk beberapa tugasan, model mungkin memperoleh keupayaan separa untuk melakukan tugasan pada skala yang berbeza. Gambar di bawah ialah tugas meneka nama filem melalui rentetan emoji

Kita dapat melihat bahawa model mula meneka pada beberapa skala Tajuk Filem, Mengenali Semantik Emoji pada Skala yang Lebih Besar, Menghasilkan Jawapan Betul pada Skala Terbesar.

Model besar sensitif terhadap cara tugasan diformalkan

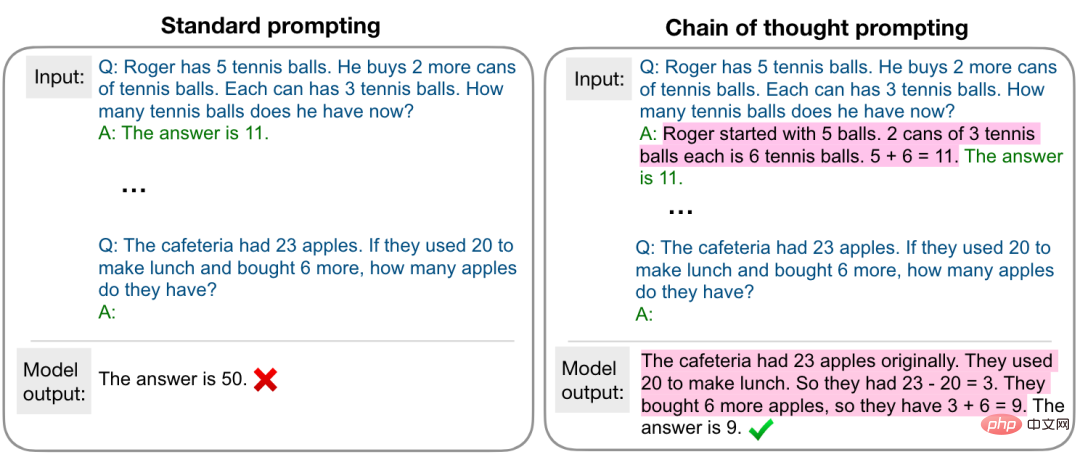

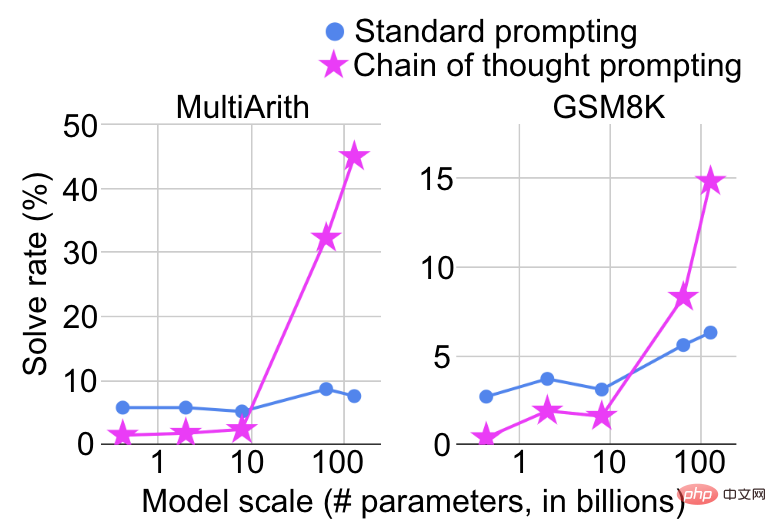

Skala model menunjukkan peningkatan mendadak dalam keupayaan juga bergantung pada cara tugas itu diformalkan. Sebagai contoh, pada tugasan penaakulan matematik yang kompleks, jika gesaan standard digunakan untuk menganggapnya sebagai tugasan soal jawab, peningkatan prestasi akan menjadi sangat terhad kerana saiz model meningkat Walau bagaimanapun, jika gesaan rantaian pemikiran [5]. digunakan seperti yang ditunjukkan dalam rajah di bawah, ia akan dianggap sebagai tugasan soal jawab Dianggap sebagai tugas inferens berbilang langkah, peningkatan prestasi yang ketara akan dilihat pada skala tertentu.

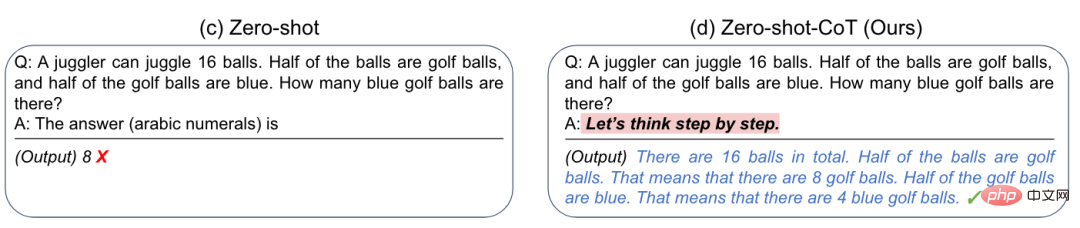

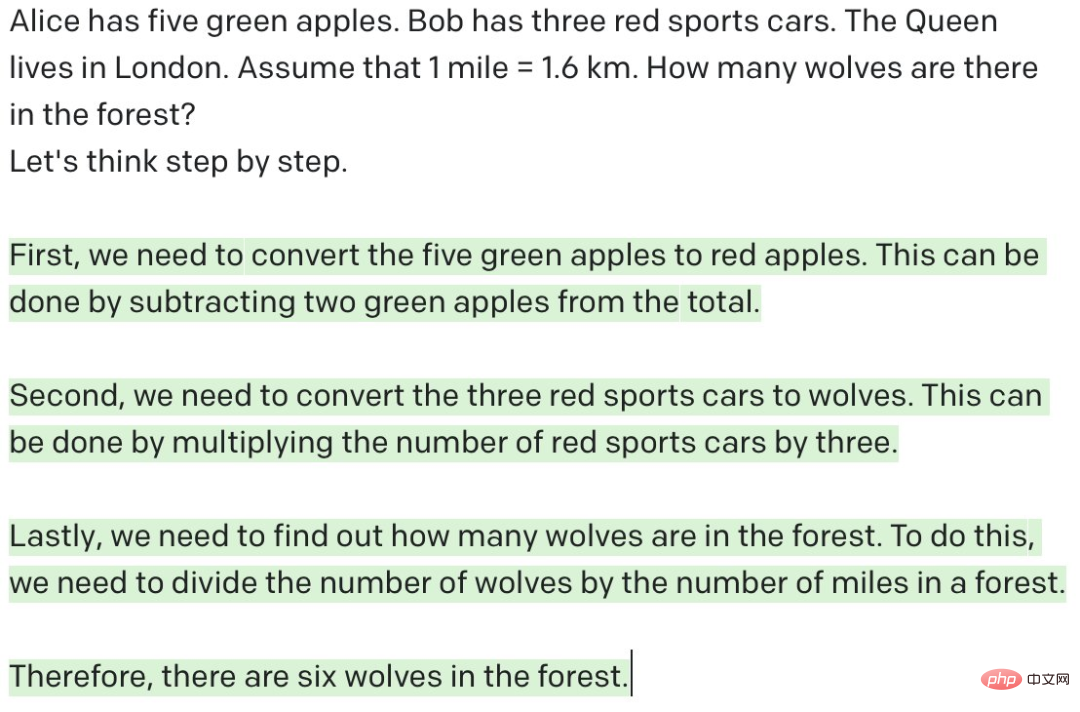

Apatah lagi, penyelidik mendapati bahawa dengan menambahkan gesaan ringkas "Mari kita fikirkan langkah demi langkah" boleh meningkatkan keupayaan penaakulan sifar pukulan GPT-3 [6], seperti yang ditunjukkan dalam rajah di bawah

Apa yang memberi inspirasi kepada kami ialah kadangkala model besar tidak dapat melakukan tugas tertentu dengan baik. Mungkin bukan ia tidak dapat melakukannya dengan baik, tetapi ia memerlukan cara yang sesuai untuk merangsang keupayaannya.

Adakah model yang lebih besar, mesti lebih kuat?

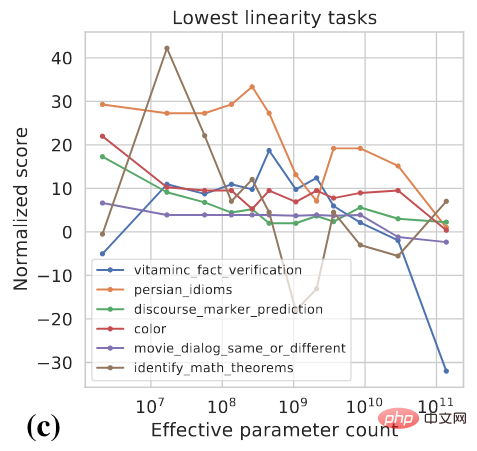

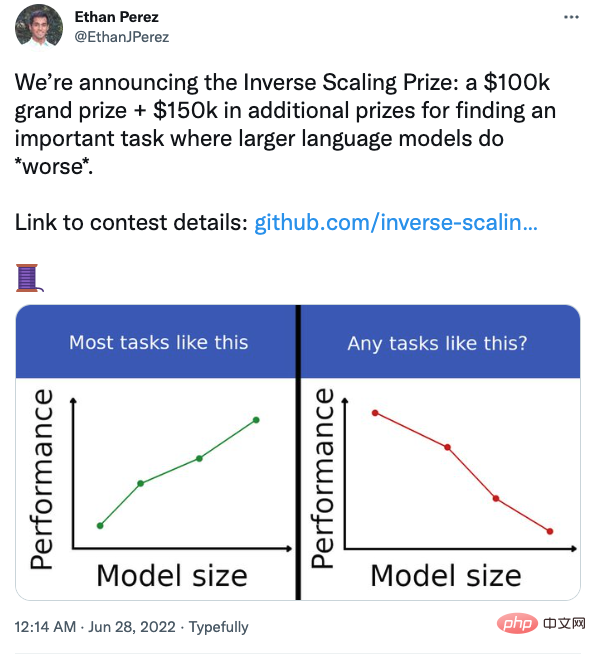

Perbincangan sebelum ini memberi kita perasaan intuitif bahawa prestasi mesti dipertingkatkan apabila skala model meningkat, tetapi adakah ini benar-benar berlaku? Malah, untuk sesetengah tugasan, prestasi sebenarnya mungkin menurun apabila model menjadi lebih besar, seperti yang ditunjukkan dalam rajah di bawah

Beberapa penyelidik di Universiti New York turut menganjurkan pertandingan untuk mencari tugas yang model menunjukkan prestasi yang lebih teruk apabila ia semakin besar.

Contohnya, dalam tugasan soal jawab, jika anda menambah kepercayaan anda bersama soalan, model besar akan lebih mudah terjejas. Pelajar yang berminat boleh memberi perhatian.

Ringkasan dan Pemikiran

- Dalam kebanyakan tugas, apabila saiz model meningkat, prestasi model menjadi lebih baik , tetapi terdapat juga beberapa contoh balas. Lebih banyak penyelidikan diperlukan untuk lebih memahami tingkah laku model.

- Keupayaan model besar perlu dirangsang dengan cara yang sesuai.

- Adakah model besar benar-benar melakukan inferens? Seperti yang telah kita lihat sebelum ini, dengan menambahkan gesaan "Mari kita fikirkan langkah demi langkah", model besar boleh melakukan penaakulan berbilang langkah dan mencapai hasil yang memuaskan pada tugasan penaakulan matematik Nampaknya model itu sudah mempunyai keupayaan penaakulan manusia. Walau bagaimanapun, seperti yang ditunjukkan di bawah, jika anda memberikan GPT-3 soalan yang tidak bermakna dan membiarkannya melakukan penaakulan pelbagai langkah, GPT-3 nampaknya melakukan penaakulan, tetapi sebenarnya ia adalah beberapa output yang tidak bermakna. Bak kata pepatah "sampah masuk, sampah keluar". Sebagai perbandingan, manusia boleh menilai sama ada soalan itu munasabah, iaitu sama ada soalan semasa boleh dijawab dalam keadaan tertentu. "Mari kita fikirkan langkah demi langkah" saya fikir sebab asasnya ialah GPT-3 telah melihat banyak data yang serupa semasa proses latihan. Masih terdapat perbezaan asas dalam cara berfikir. Sudah tentu, jika gesaan yang sesuai diberikan untuk membolehkan GPT-3 menilai sama ada soalan itu munasabah, ia mungkin dapat melakukannya sedikit sebanyak, tetapi masih terdapat jarak yang agak jauh antara "berfikir" dan "menaakul". bukan perkara mudah. Ini boleh diselesaikan dengan meningkatkan saiz model. Model mungkin tidak perlu berfikir seperti manusia, tetapi lebih banyak penyelidikan diperlukan segera untuk meneroka laluan selain meningkatkan saiz model.

- Sistem 1 atau Sistem 2? Otak manusia mempunyai dua sistem yang bekerjasama antara satu sama lain Sistem 1 (intuisi) adalah pantas dan automatik, manakala Sistem 2 (rasional) adalah perlahan dan boleh dikawal. Sebilangan besar eksperimen telah membuktikan bahawa orang lebih suka menggunakan gerak hati untuk membuat pertimbangan dan keputusan, dan rasional boleh membetulkan bias yang disebabkan olehnya. Kebanyakan model semasa direka bentuk berdasarkan Sistem 1 atau Sistem 2. Bolehkah model masa depan direka bentuk berdasarkan sistem dwi?

- Bahasa pertanyaan dalam era model besar. Sebelum ini, kami menyimpan pengetahuan dan data dalam pangkalan data dan graf pengetahuan.

Encik Mei Yiqi pernah berkata, "Yang dikatakan ulama besar bukan bermaksud bangunan, tetapi penulis menggunakan istilah yang tidak sesuai di sini artikel ini dengan analogi: model besar yang dipanggil tidak bermakna ia mempunyai parameter, tetapi ia mempunyai keupayaan.

Atas ialah kandungan terperinci Google dan Stanford bersama-sama mengeluarkan artikel: Mengapa kita mesti menggunakan model besar?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

phpmyadmin mencipta jadual data

Apr 10, 2025 pm 11:00 PM

phpmyadmin mencipta jadual data

Apr 10, 2025 pm 11:00 PM

Untuk membuat jadual data menggunakan phpmyadmin, langkah -langkah berikut adalah penting: Sambungkan ke pangkalan data dan klik tab baru. Namakan jadual dan pilih enjin penyimpanan (disyorkan innoDB). Tambah butiran lajur dengan mengklik butang Tambah Lajur, termasuk nama lajur, jenis data, sama ada untuk membenarkan nilai null, dan sifat lain. Pilih satu atau lebih lajur sebagai kunci utama. Klik butang Simpan untuk membuat jadual dan lajur.

Bagaimana untuk menangani pemecahan memori Redis?

Apr 10, 2025 pm 02:24 PM

Bagaimana untuk menangani pemecahan memori Redis?

Apr 10, 2025 pm 02:24 PM

Pemecahan ingatan redis merujuk kepada kewujudan kawasan bebas kecil dalam ingatan yang diperuntukkan yang tidak dapat ditugaskan semula. Strategi mengatasi termasuk: Mulakan semula Redis: Kosongkan memori sepenuhnya, tetapi perkhidmatan mengganggu. Mengoptimumkan struktur data: Gunakan struktur yang lebih sesuai untuk Redis untuk mengurangkan bilangan peruntukan dan siaran memori. Laraskan parameter konfigurasi: Gunakan dasar untuk menghapuskan pasangan nilai kunci yang paling kurang baru-baru ini. Gunakan mekanisme kegigihan: sandarkan data secara teratur dan mulakan semula redis untuk membersihkan serpihan. Pantau penggunaan memori: Cari masalah tepat pada masanya dan ambil langkah.

Cara Membuat Pangkalan Data Oracle Cara Membuat Pangkalan Data Oracle

Apr 11, 2025 pm 02:33 PM

Cara Membuat Pangkalan Data Oracle Cara Membuat Pangkalan Data Oracle

Apr 11, 2025 pm 02:33 PM

Mewujudkan pangkalan data Oracle tidak mudah, anda perlu memahami mekanisme asas. 1. Anda perlu memahami konsep pangkalan data dan Oracle DBMS; 2. Menguasai konsep teras seperti SID, CDB (pangkalan data kontena), PDB (pangkalan data pluggable); 3. Gunakan SQL*Plus untuk membuat CDB, dan kemudian buat PDB, anda perlu menentukan parameter seperti saiz, bilangan fail data, dan laluan; 4. Aplikasi lanjutan perlu menyesuaikan set aksara, memori dan parameter lain, dan melakukan penalaan prestasi; 5. Beri perhatian kepada ruang cakera, keizinan dan parameter, dan terus memantau dan mengoptimumkan prestasi pangkalan data. Hanya dengan menguasai ia dengan mahir memerlukan amalan yang berterusan, anda boleh benar -benar memahami penciptaan dan pengurusan pangkalan data Oracle.

Cara Membuat Pangkalan Data Oracle Cara Membuat Pangkalan Data Oracle

Apr 11, 2025 pm 02:36 PM

Cara Membuat Pangkalan Data Oracle Cara Membuat Pangkalan Data Oracle

Apr 11, 2025 pm 02:36 PM

Untuk membuat pangkalan data Oracle, kaedah biasa adalah menggunakan alat grafik DBCA. Langkah -langkah adalah seperti berikut: 1. Gunakan alat DBCA untuk menetapkan DBName untuk menentukan nama pangkalan data; 2. Tetapkan SYSPASSWORD dan SYSTEMPASSWORD kepada kata laluan yang kuat; 3. Tetapkan aksara dan NationalCharacterset ke Al32utf8; 4. Tetapkan MemorySize dan Tablespacesize untuk menyesuaikan mengikut keperluan sebenar; 5. Tentukan laluan logfile. Kaedah lanjutan dibuat secara manual menggunakan arahan SQL, tetapi lebih kompleks dan terdedah kepada kesilapan. Perhatikan kekuatan kata laluan, pemilihan set aksara, saiz dan memori meja makan

Pantau titisan redis dengan perkhidmatan pengeksport redis

Apr 10, 2025 pm 01:36 PM

Pantau titisan redis dengan perkhidmatan pengeksport redis

Apr 10, 2025 pm 01:36 PM

Pemantauan yang berkesan terhadap pangkalan data REDIS adalah penting untuk mengekalkan prestasi yang optimum, mengenal pasti kemungkinan kesesakan, dan memastikan kebolehpercayaan sistem keseluruhan. Perkhidmatan Pengeksport Redis adalah utiliti yang kuat yang direka untuk memantau pangkalan data REDIS menggunakan Prometheus. Tutorial ini akan membimbing anda melalui persediaan lengkap dan konfigurasi perkhidmatan pengeksport REDIS, memastikan anda membina penyelesaian pemantauan dengan lancar. Dengan mengkaji tutorial ini, anda akan mencapai tetapan pemantauan operasi sepenuhnya

Apakah parameter konfigurasi memori Redis?

Apr 10, 2025 pm 02:03 PM

Apakah parameter konfigurasi memori Redis?

Apr 10, 2025 pm 02:03 PM

** Parameter teras konfigurasi memori Redis adalah MaxMemory, yang menghadkan jumlah memori yang boleh digunakan oleh Redis. Apabila had ini melebihi, REDIS melaksanakan strategi penghapusan mengikut dasar-dasar MaxMemory, termasuk: noeviction (secara langsung menolak menulis), AllKeys-LRU/Volatile-LRU (dihapuskan oleh LRU), allkeys-rawak-rawak-rawak (dihapuskan oleh penghapusan rawak), dan volatili-volatili-ttl), dan volatili-volatili-ttl (tidak meniru-rawak), dan volatili-ttl (tidak meniminasi volatili), dan volatili-ttl (tidak meniminasi volatili), dan volatili-ttl (tidak meniru-rawak), dan volatili-ttl (eximination-ttl) Parameter lain yang berkaitan termasuk MaxMemory-Samples (kuantiti sampel LRU), RDB-Mampatan

Cara Menulis Penyataan Pangkalan Data Oracle

Apr 11, 2025 pm 02:42 PM

Cara Menulis Penyataan Pangkalan Data Oracle

Apr 11, 2025 pm 02:42 PM

Inti dari pernyataan Oracle SQL adalah pilih, masukkan, mengemas kini dan memadam, serta aplikasi fleksibel dari pelbagai klausa. Adalah penting untuk memahami mekanisme pelaksanaan di sebalik pernyataan, seperti pengoptimuman indeks. Penggunaan lanjutan termasuk subqueries, pertanyaan sambungan, fungsi analisis, dan PL/SQL. Kesilapan umum termasuk kesilapan sintaks, isu prestasi, dan isu konsistensi data. Amalan terbaik pengoptimuman prestasi melibatkan menggunakan indeks yang sesuai, mengelakkan pilih *, mengoptimumkan di mana klausa, dan menggunakan pembolehubah terikat. Menguasai Oracle SQL memerlukan amalan, termasuk penulisan kod, debugging, berfikir dan memahami mekanisme asas.

Apakah Mekanisme Pengurusan Memori Redis?

Apr 10, 2025 pm 01:39 PM

Apakah Mekanisme Pengurusan Memori Redis?

Apr 10, 2025 pm 01:39 PM

Redis mengamalkan mekanisme pengurusan memori berbutir, termasuk: struktur data yang mesra memori yang direka dengan baik, peruntukan multi-memori yang mengoptimumkan strategi peruntukan untuk pelbagai saiz blok memori, mekanisme penghapusan memori yang memilih strategi penghapusan berdasarkan keperluan khusus, dan alat untuk memantau penggunaan memori. Matlamat mekanisme ini adalah untuk mencapai prestasi muktamad, melalui kawalan halus dan penggunaan memori yang cekap, meminimumkan pemecahan memori dan meningkatkan kecekapan akses, memastikan Redis berjalan dengan stabil dan cekap dalam pelbagai senario.