Peranti teknologi

Peranti teknologi

AI

AI

Tidak menemui model pra-latihan pertuturan Cina? Versi Cina Wav2vec 2.0 dan HuBERT akan datang

Tidak menemui model pra-latihan pertuturan Cina? Versi Cina Wav2vec 2.0 dan HuBERT akan datang

Tidak menemui model pra-latihan pertuturan Cina? Versi Cina Wav2vec 2.0 dan HuBERT akan datang

Wav2vec 2.0 [1], HuBERT [2] dan WavLM [3] dan model pra-latihan pertuturan lain, melalui pembelajaran diselia sendiri pada puluhan ribu jam data pertuturan tidak berlabel (seperti Libri-light ), meningkatkan prestasi tugasan pertuturan hiliran dengan ketara seperti Pengecaman Pertuturan Automatik (ASR), Teks ke Pertuturan (TTS) dan Penukaran Suara (VC). Walau bagaimanapun, model ini tidak mempunyai versi Cina awam, menjadikannya sukar untuk digunakan dalam senario penyelidikan pertuturan Cina.

WenetSpeech [4] ialah ucapan berbilang domain dengan lebih daripada 10,000 jam dikeluarkan bersama oleh Kumpulan Penyelidikan Pemprosesan Audio, Pertuturan dan Bahasa (ASLP@NPU) NPU, Mobvoi dan Set data Hillshell. Untuk mengisi jurang dalam model pra-latihan pertuturan bahasa Cina, kami telah menggunakan sumber terbuka model Wav2vec 2.0 dan HuBERT versi Cina berdasarkan 10,000 jam latihan data daripada WenetSpeech.

Untuk mengesahkan prestasi model pra-latihan, kami melakukan pengesahan pada tugas ASR. Keputusan eksperimen menunjukkan bahawa pada tugasan ASR dengan 100 jam data yang diselia, perwakilan pertuturan yang dipelajari oleh model pra-latihan mempunyai peningkatan prestasi yang ketara berbanding ciri-ciri FBank akustik tradisional Ia malah boleh diperolehi dengan hanya 100 jam data yang diselia dan 1000 jam penyeliaan keputusan sebanding.

Pautan model: https://github.com/TencentGameMate/chinese_speech_pretrain

Pengenalan model

Wav2veve model 2.0

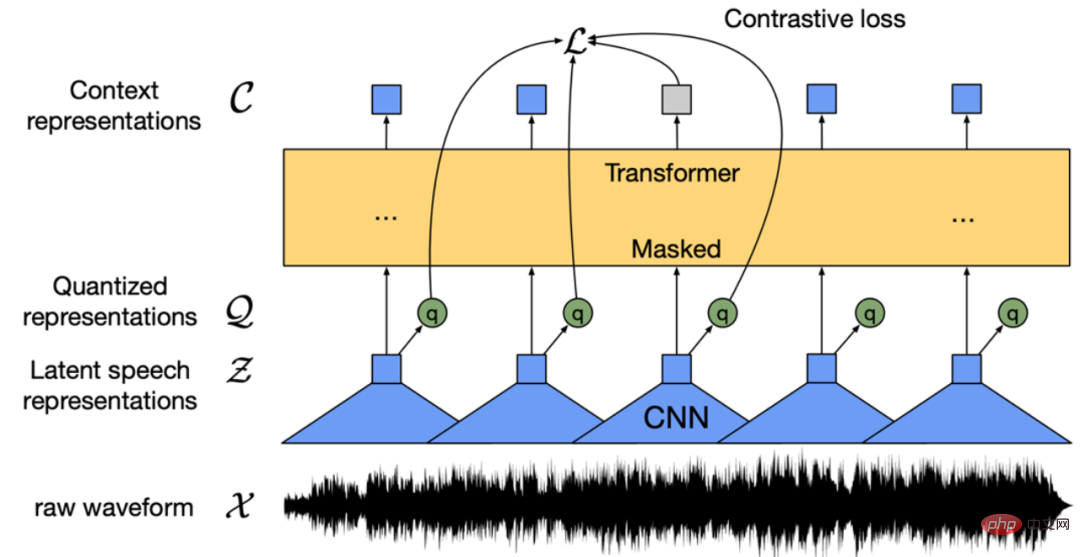

Rajah 1: Struktur model Wav2vec 2.0 (Baevski et al., 2020)

Wav2vec 2.0 [1] ialah model pra-latihan pertuturan tanpa pengawasan yang diterbitkan oleh Meta pada tahun 2020. Idea terasnya ialah membina sasaran latihan diselia yang dibina sendiri melalui Pengkuantitian Vektor (VQ), menutup input dalam kuantiti yang banyak dan kemudian menggunakan fungsi kehilangan pembelajaran kontrastif untuk latihan. Struktur model ditunjukkan dalam Rajah 1 di atas Pengekstrak ciri berdasarkan Rangkaian Neural Konvolutasi (CNN) mengekod audio asal ke dalam urutan ciri bingkai, dan menukar setiap ciri bingkai kepada ciri diskret Q melalui modul VQ, iaitu. digunakan sebagai sasaran yang diselia sendiri. Pada masa yang sama, jujukan ciri bingkai menjalani operasi penyamaran dan kemudian memasuki model Transformer [5] untuk mendapatkan perwakilan konteks C. Akhir sekali, jarak antara perwakilan konteks kedudukan topeng dan ciri diskret yang sepadan q dipendekkan dengan membandingkan fungsi kehilangan pembelajaran, iaitu pasangan sampel positif. Dalam kertas asal, model Wav2vec 2.0 BASE menggunakan struktur Transformer 12 lapisan dan dilatih dengan 1,000 jam data LibriSpeech Model LARGE menggunakan struktur Transformer 24 lapisan dan dilatih dengan 60,000 jam data Libri-light. Dari segi masa latihan, model BASE menggunakan 64 kad grafik V100 untuk melatih selama 1.6 hari, dan model BESAR menggunakan 128 kad grafik V100 untuk berlatih selama 5 hari. Dalam penilaian ASR hiliran, walaupun hanya menggunakan 10 minit data yang diselia, sistem masih mencapai keputusan Kadar Ralat Kata (WER) sebanyak 4.8.

Model HuBERT

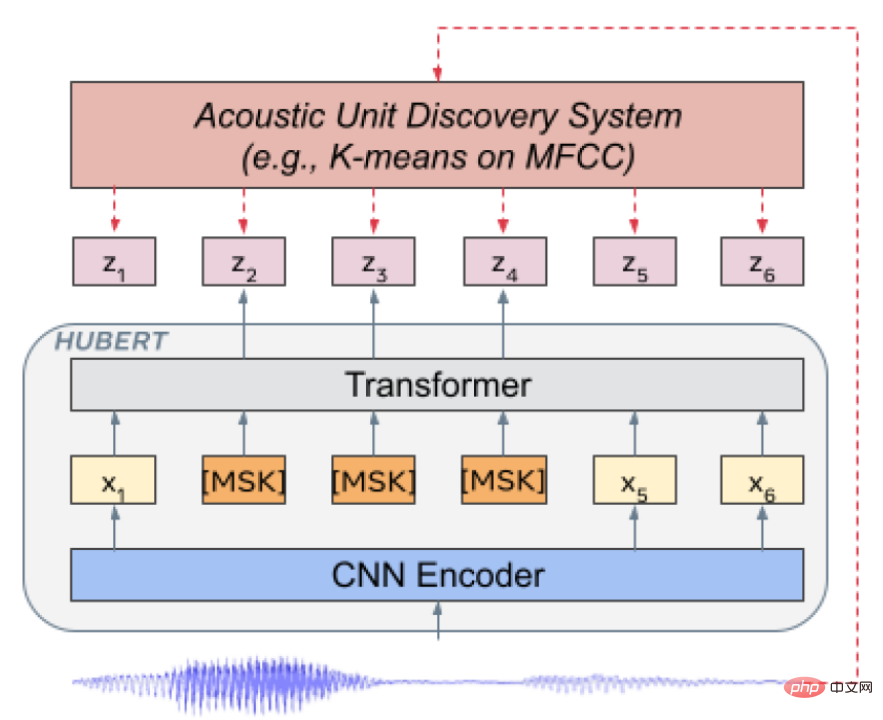

Rajah 2: Struktur model HuBERT (Hsu et al., 2021)

HuBERT [2] ialah model yang diterbitkan oleh Meta pada 2021. Struktur model serupa dengan Wav2vec 2.0, tetapi perbezaannya ialah kaedah latihan. Wav2vec 2.0 mendiskrisikan ciri pertuturan sebagai sasaran yang diselia sendiri semasa latihan, manakala HuBERT memperoleh sasaran latihan dengan melakukan pengelompokan K-means pada ciri MFCC atau ciri HuBERT. Model HuBERT menggunakan kaedah latihan berulang Lelaran pertama model BASE melakukan pengelompokan pada ciri MFCC Lelaran kedua melakukan pengelompokan pada ciri lapisan tengah model HuBERT yang diperoleh dalam model BESAR dan XLARGE lelaran kedua model BASE mengekstrak ciri untuk pengelompokan. Berdasarkan keputusan percubaan kertas asal, model HuBERT adalah lebih baik daripada Wav2vec 2.0, terutamanya apabila tugas hiliran mempunyai sedikit data latihan yang diselia, seperti 1 jam atau 10 minit.

Model pralatihan Cina

Konfigurasi eksperimen Kami menggunakan 10,000 jam data Cina daripada set train_l WenetSpeech [4] sebagai data pra-latihan tanpa pengawasan. Data terutamanya berasal daripada YouTube dan Podcast, meliputi pelbagai jenis adegan rakaman, bunyi latar belakang, gaya pertuturan, dsb. Bidangnya terutamanya termasuk buku audio, narasi, dokumentari, siri TV, temu bual, berita, bacaan, ucapan, rancangan pelbagai dan lain-lain, dan lain-lain 10 adegan utama. Kami melatih model Wav2vec 2.0 dan HuBERT masing-masing berdasarkan kit alat Fairseq [6], mengikut konfigurasi model [1, 2], dan setiap model model pra-latihan termasuk dua saiz: BASE dan LARGE. Untuk model BASE, kami menggunakan 8 kad grafik A100, pengumpulan kecerunan ialah 8, dan simulasi 64 kad grafik untuk latihan. Untuk model BESAR, kami menggunakan 16 kad grafik A100, pengumpulan kecerunan ialah 8, dan simulasi 128 kad grafik untuk latihan.

Pengesahan tugas pengecaman pertuturan hiliranUntuk mengesahkan kesan model pra-latihan pada tugas ASR hiliran, kami mengikuti Conformer dalam ESPnet [7 ,8,9] toolkit [10] Model konfigurasi eksperimen, iaitu model pra-latihan digunakan sebagai pengekstrak ciri, dan perwakilan lapisan tersembunyi bagi model pra-latihan pengekstrakan pertuturan input ditimbang dan dijumlahkan perwakilan akan menggantikan ciri FBank tradisional sebagai input model ASR Conformer.

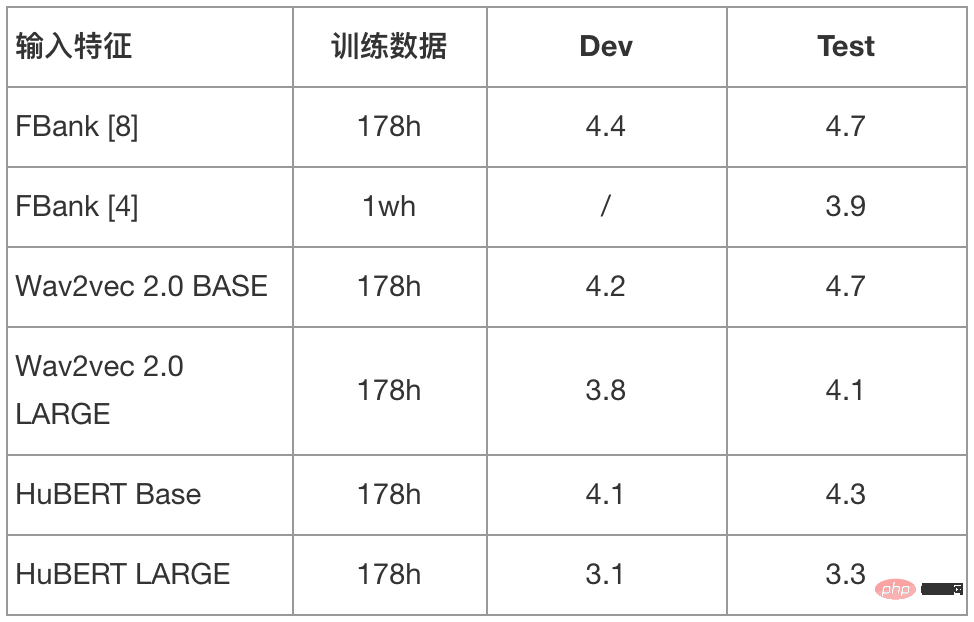

- Set Data Aishell

Kami menggunakan set latihan 178 jam Aishell sebagai data diselia untuk latihan dan membandingkannya masing-masing. Keputusan Kadar Ralat Aksara (CER) menggunakan ciri FBank, ciri model Wav2vec 2.0 BASE/LARGE dan ciri model HuBERT BASE/LARGE. Pada masa yang sama, kami juga membandingkan kesannya pada set ujian Aishell apabila menggunakan set train_l WenetSpeech sebanyak 10,000 jam data Cina untuk latihan. Data latihan menggunakan kelajuan berubah (0.9, 1.0, 1.1 kali) dan teknologi penambahan data SpecAugment, kaedah penyahkodan ialah carian rasuk, dan model bahasa berasaskan Transformer digunakan untuk penskoran.

Jadual 1: Kadar ralat perkataan (CER%) keputusan model berbeza pada set ujian Aishell

Menurut keputusan dalam Jadual 1, kita dapat melihat bahawa dengan menggabungkan model pra-latihan yang dilatih dengan puluhan ribu jam data tanpa pengawasan, prestasi tugas ASR hiliran telah bertambah baik dengan ketara. Terutama apabila menggunakan model HuBERT LARGE, peningkatan relatif kira-kira 30% dalam CER telah dicapai pada set Ujian, mencapai keputusan terbaik dalam industri di bawah 178 jam data latihan yang diselia.

- Set Data WenetSpeech

Kami menggunakan set WenetSpeech train_s 100 jam data Cina sebagai data diselia untuk latihan, Keputusan Kadar Ralat Aksara (CER) menggunakan ciri FBank, ciri model Wav2vec 2.0 BASE/LARGE dan ciri model HuBERT BASE/LARGE. Pada masa yang sama, kami juga membandingkan hasil model menggunakan set train_m WenetSpeech selama 1,000 jam dan set train_l untuk 10,000 jam ciri FBank data Cina. Data latihan tidak menggunakan kelajuan berubah atau teknologi penambahan data SpecAugment, kaedah penyahkodan ialah carian pancaran, dan tiada penskoran model bahasa digunakan.

Jadual 2: Kadar ralat perkataan (CER%) keputusan model berbeza pada set ujian WenetSpeech

Seperti yang dapat dilihat daripada keputusan dalam Jadual 2, dengan menggabungkan model pra-latihan dengan berpuluh-puluh ribu jam latihan data tanpa pengawasan, keputusan ASR hiliran telah sangat bertambah baik. Terutama apabila menggunakan HuBERT LARGE sebagai pengekstrak perwakilan pertuturan, model ASR yang dilatih dengan 100 jam data diselia berprestasi lebih baik daripada model yang dilatih dengan 1000 jam ciri FBank, malah hampir dengan model yang dilatih dengan 10,000 jam data.

Untuk lebih banyak hasil percubaan bagi tugasan hiliran suara, sila ikuti pautan GitHub (https://github.com/TencentGameMate/chinese_speech_pretrain). Semua orang dialu-alukan untuk menggunakan model pra-latihan pertuturan Cina yang kami sediakan untuk menjalankan kerja penyelidikan, dan meneroka aplikasi model pra-latihan pertuturan dalam bahasa Cina dan senario yang berkaitan.

Atas ialah kandungan terperinci Tidak menemui model pra-latihan pertuturan Cina? Versi Cina Wav2vec 2.0 dan HuBERT akan datang. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1382

1382

52

52

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Perintah shutdown CentOS adalah penutupan, dan sintaks adalah tutup [pilihan] [maklumat]. Pilihan termasuk: -h menghentikan sistem dengan segera; -P mematikan kuasa selepas penutupan; -r mulakan semula; -T Waktu Menunggu. Masa boleh ditentukan sebagai segera (sekarang), minit (minit), atau masa tertentu (HH: mm). Maklumat tambahan boleh dipaparkan dalam mesej sistem.

Apakah kaedah sandaran untuk gitlab di centos

Apr 14, 2025 pm 05:33 PM

Apakah kaedah sandaran untuk gitlab di centos

Apr 14, 2025 pm 05:33 PM

Dasar sandaran dan pemulihan Gitlab di bawah sistem CentOS untuk memastikan keselamatan data dan pemulihan, Gitlab pada CentOS menyediakan pelbagai kaedah sandaran. Artikel ini akan memperkenalkan beberapa kaedah sandaran biasa, parameter konfigurasi dan proses pemulihan secara terperinci untuk membantu anda menubuhkan strategi sandaran dan pemulihan GitLab lengkap. 1. Backup Manual Gunakan Gitlab-Rakegitlab: Backup: Buat Perintah untuk Melaksanakan Backup Manual. Perintah ini menyokong maklumat utama seperti repositori Gitlab, pangkalan data, pengguna, kumpulan pengguna, kunci, dan kebenaran. Fail sandaran lalai disimpan dalam direktori/var/opt/gitlab/sandaran. Anda boleh mengubah suai /etc /gitlab

Cara Memeriksa Konfigurasi HDFS CentOS

Apr 14, 2025 pm 07:21 PM

Cara Memeriksa Konfigurasi HDFS CentOS

Apr 14, 2025 pm 07:21 PM

Panduan Lengkap untuk Memeriksa Konfigurasi HDFS Dalam Sistem CentOS Artikel ini akan membimbing anda bagaimana untuk memeriksa konfigurasi dan menjalankan status HDFS secara berkesan pada sistem CentOS. Langkah -langkah berikut akan membantu anda memahami sepenuhnya persediaan dan operasi HDFS. Sahkan Pembolehubah Alam Sekitar Hadoop: Pertama, pastikan pembolehubah persekitaran Hadoop ditetapkan dengan betul. Di terminal, laksanakan arahan berikut untuk mengesahkan bahawa Hadoop dipasang dan dikonfigurasi dengan betul: Hadoopversion Semak fail konfigurasi HDFS: Fail konfigurasi teras HDFS terletak di/etc/hadoop/conf/direktori, di mana core-site.xml dan hdfs-site.xml adalah kritikal. gunakan

Apakah kaedah penalaan prestasi zookeeper di CentOS

Apr 14, 2025 pm 03:18 PM

Apakah kaedah penalaan prestasi zookeeper di CentOS

Apr 14, 2025 pm 03:18 PM

Penalaan prestasi zookeeper pada centOs boleh bermula dari pelbagai aspek, termasuk konfigurasi perkakasan, pengoptimuman sistem operasi, pelarasan parameter konfigurasi, pemantauan dan penyelenggaraan, dan lain -lain. Memori yang cukup: memperuntukkan sumber memori yang cukup untuk zookeeper untuk mengelakkan cakera kerap membaca dan menulis. CPU multi-teras: Gunakan CPU multi-teras untuk memastikan bahawa zookeeper dapat memprosesnya selari.

Bagaimana sokongan GPU untuk Pytorch di CentOS

Apr 14, 2025 pm 06:48 PM

Bagaimana sokongan GPU untuk Pytorch di CentOS

Apr 14, 2025 pm 06:48 PM

Membolehkan pecutan GPU pytorch pada sistem CentOS memerlukan pemasangan cuda, cudnn dan GPU versi pytorch. Langkah-langkah berikut akan membimbing anda melalui proses: Pemasangan CUDA dan CUDNN Tentukan keserasian versi CUDA: Gunakan perintah NVIDIA-SMI untuk melihat versi CUDA yang disokong oleh kad grafik NVIDIA anda. Sebagai contoh, kad grafik MX450 anda boleh menyokong CUDA11.1 atau lebih tinggi. Muat turun dan pasang Cudatoolkit: Lawati laman web rasmi Nvidiacudatoolkit dan muat turun dan pasang versi yang sepadan mengikut versi CUDA tertinggi yang disokong oleh kad grafik anda. Pasang Perpustakaan Cudnn:

Penjelasan terperinci mengenai Prinsip Docker

Apr 14, 2025 pm 11:57 PM

Penjelasan terperinci mengenai Prinsip Docker

Apr 14, 2025 pm 11:57 PM

Docker menggunakan ciri -ciri kernel Linux untuk menyediakan persekitaran berjalan yang cekap dan terpencil. Prinsip kerjanya adalah seperti berikut: 1. Cermin digunakan sebagai templat baca sahaja, yang mengandungi semua yang anda perlukan untuk menjalankan aplikasi; 2. Sistem Fail Kesatuan (Unionfs) menyusun pelbagai sistem fail, hanya menyimpan perbezaan, menjimatkan ruang dan mempercepatkan; 3. Daemon menguruskan cermin dan bekas, dan pelanggan menggunakannya untuk interaksi; 4. Ruang nama dan cgroups melaksanakan pengasingan kontena dan batasan sumber; 5. Pelbagai mod rangkaian menyokong interkoneksi kontena. Hanya dengan memahami konsep -konsep teras ini, anda boleh menggunakan Docker dengan lebih baik.

CentOS memasang MySQL

Apr 14, 2025 pm 08:09 PM

CentOS memasang MySQL

Apr 14, 2025 pm 08:09 PM

Memasang MySQL pada CentOS melibatkan langkah -langkah berikut: Menambah sumber MySQL YUM yang sesuai. Jalankan YUM Pasang Perintah MySQL-Server untuk memasang pelayan MySQL. Gunakan perintah mysql_secure_installation untuk membuat tetapan keselamatan, seperti menetapkan kata laluan pengguna root. Sesuaikan fail konfigurasi MySQL seperti yang diperlukan. Tune parameter MySQL dan mengoptimumkan pangkalan data untuk prestasi.

CentOS8 memulakan semula SSH

Apr 14, 2025 pm 09:00 PM

CentOS8 memulakan semula SSH

Apr 14, 2025 pm 09:00 PM

Perintah untuk memulakan semula perkhidmatan SSH ialah: Sistem Restart SSHD. Langkah -langkah terperinci: 1. Akses terminal dan sambungkan ke pelayan; 2. Masukkan arahan: SistemCtl Restart SSHD; 3. Sahkan Status Perkhidmatan: Status Sistem SSHD.