Peranti teknologi

Peranti teknologi

AI

AI

Pembahagian imej pembelajaran mendalam: gambaran keseluruhan reka bentuk struktur rangkaian

Pembahagian imej pembelajaran mendalam: gambaran keseluruhan reka bentuk struktur rangkaian

Pembahagian imej pembelajaran mendalam: gambaran keseluruhan reka bentuk struktur rangkaian

Artikel ini meringkaskan inovasi dalam struktur rangkaian apabila menggunakan CNN untuk segmentasi semantik imej Inovasi ini terutamanya termasuk reka bentuk seni bina neural baharu (kedalaman, lebar, sambungan dan topologi yang berbeza) dan reka bentuk komponen atau lapisan baharu. Yang pertama menggunakan komponen sedia ada untuk memasang rangkaian berskala besar yang kompleks, manakala yang kedua lebih suka mereka bentuk komponen asas. Mula-mula, kami memperkenalkan beberapa rangkaian segmentasi semantik klasik dan inovasinya, dan kemudian memperkenalkan beberapa aplikasi reka bentuk struktur rangkaian dalam bidang segmentasi imej perubatan.

1. Inovasi struktur rangkaian segmentasi semantik imej

1.1 Rangkaian FCN

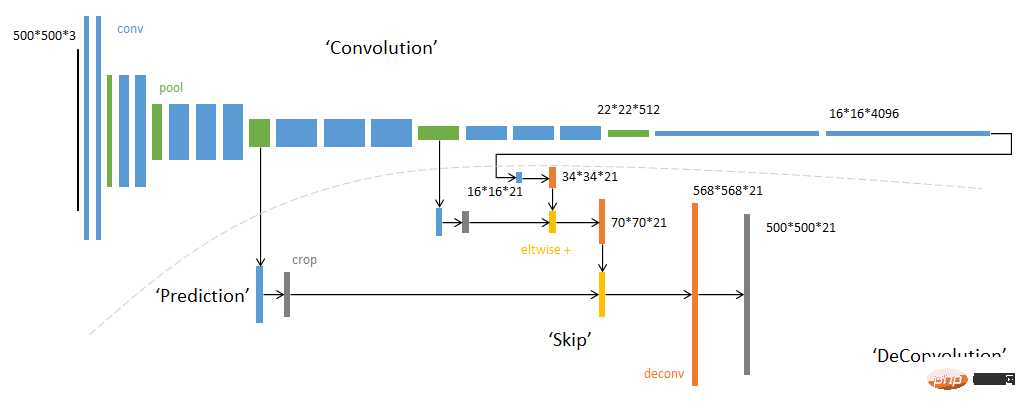

Seni bina keseluruhan FCN

Rajah ringkasRangkaian FCN disenaraikan secara berasingan kerana rangkaian FCN ialah rangkaian pertama yang menyelesaikan masalah pembahagian semantik dari perspektif baharu sepenuhnya. Rangkaian pembahagian semantik imej sebelumnya berdasarkan rangkaian saraf menggunakan blok imej berpusat pada piksel untuk dikelaskan untuk meramalkan label piksel pusat Rangkaian ini biasanya dibina menggunakan strategi CNN+FC Jelas sekali, kaedah ini tidak boleh menggunakan maklumat konteks global imej. , dan kelajuan penaakulan piksel demi piksel adalah sangat rendah manakala rangkaian FCN meninggalkan lapisan FC yang bersambung sepenuhnya dan menggunakan lapisan konvolusi untuk membina rangkaian Melalui strategi perpindahan alih dan gabungan ciri lapisan yang berbeza output rangkaian secara langsung topeng ramalan imej input Kecekapan dan ketepatan telah dipertingkatkan.

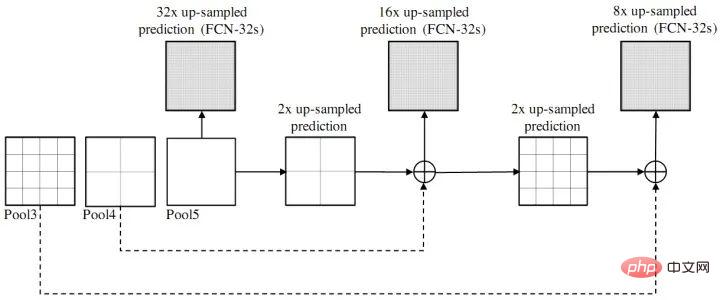

Gambar rajah skema gabungan ciri lapisan berbeza FCN

Mata inovasi: Jumlah penuh Rangkaian produk (tidak termasuk lapisan fc);

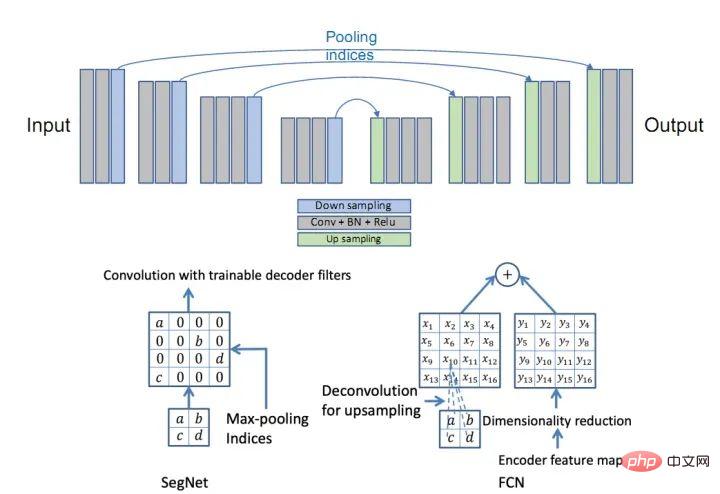

SegNet

pada dasarnya mempunyai idea yang sama dengan rangkaian FCN. Bahagian pengekod menggunakan 13 lapisan pertama lilitan VGG16 Perbezaannya terletak pada kaedah Upsampling bahagian Dekoder. FCN memperoleh hasil pensampelan naik dengan menambah hasil yang diperoleh dengan menyahkonv peta ciri pada peta ciri saiz pengekod yang sepadan manakala SegNet menggunakan indeks kumpulan maksimum bahagian Pengekod untuk menambah sampel bahagian Penyahkod (huraian asal: penyahkod; upsample peta input ciri resolusi yang lebih rendah Secara khusus, penyahkod menggunakan indeks pengumpulan yang dikira dalam langkah pengumpulan maksimum pengekod yang sepadan untuk melaksanakan pensampelan bukan linear.).- Titik inovasi : Struktur Pengekod-Penyahkod;

Rangkaian SegNet

Rangkaian SegNet

Perbandingan kaedah Upsample antara SegNet dan FCN

Perbandingan kaedah Upsample antara SegNet dan FCN

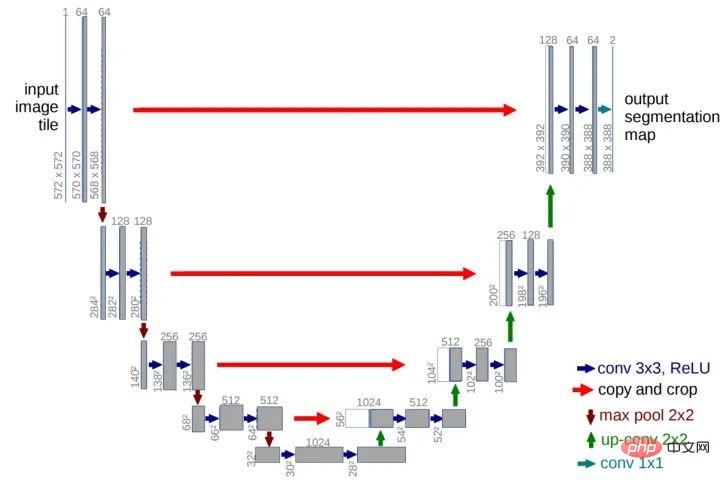

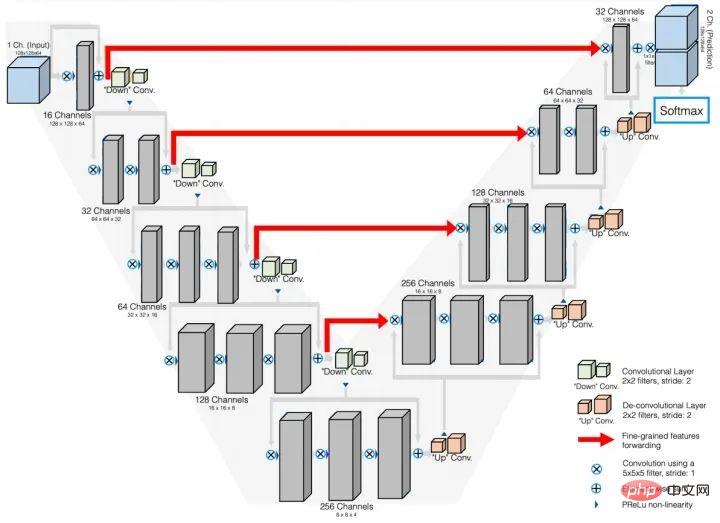

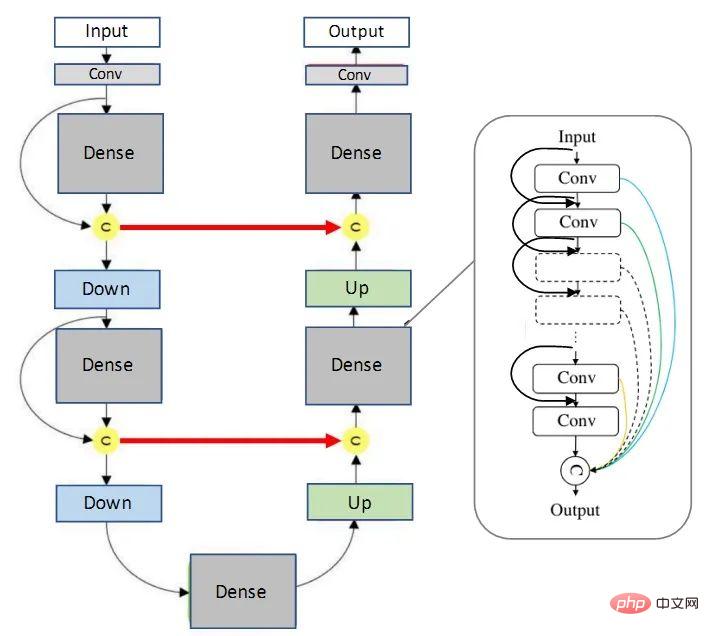

Rangkaian U-Net pada asalnya direka untuk imej bioperubatan, tetapi disebabkan prestasi gred keempatnya, kini UNet dan variannya Ia mempunyai telah digunakan secara meluas dalam pelbagai subbidang CV. Rangkaian UNet terdiri daripada saluran U dan sambungan langkau Saluran U adalah serupa dengan struktur pengekodan dan penyahkodan SegNet Bahagian pengekodan (laluan kontrak) melakukan pengekstrakan ciri dan menangkap maklumat konteks, dan bahagian penyahkodan (laluan berkembang. ) menggunakan ciri penyahkodan untuk meramalkan label piksel. Saluran litar pintas meningkatkan ketepatan model dan menyelesaikan masalah kehilangan kecerunan Adalah penting untuk ambil perhatian bahawa peta ciri saluran litar pintas dan peta ciri yang digunakan di atas adalah disambung dan bukannya ditambah (berbeza daripada FCN).

- Titik inovasi : Struktur berbentuk U; saluran litar pintas (sambungan langkau)

Rangkaian U-Net

Rangkaian U-Net

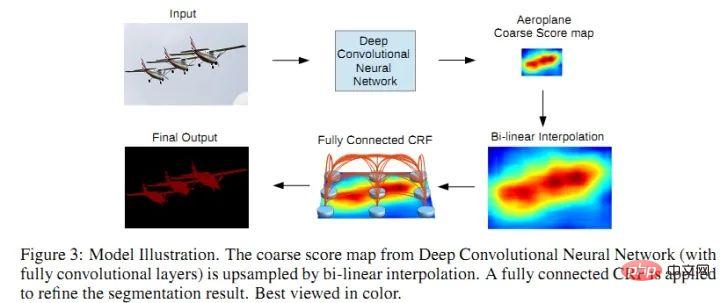

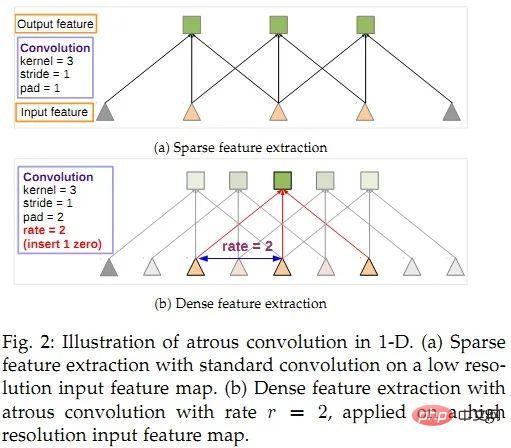

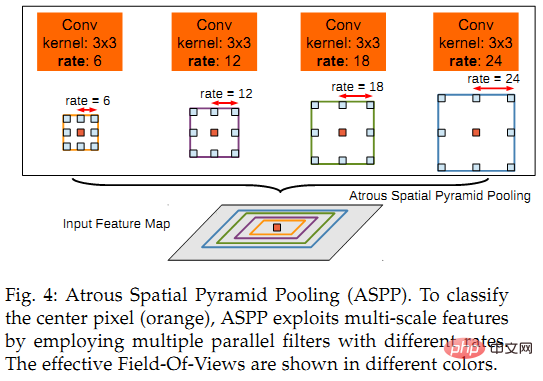

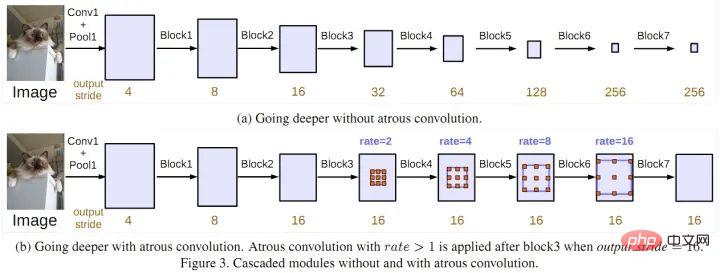

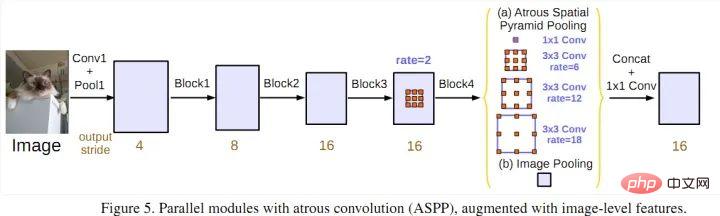

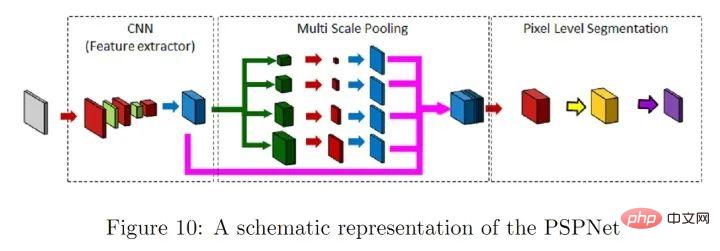

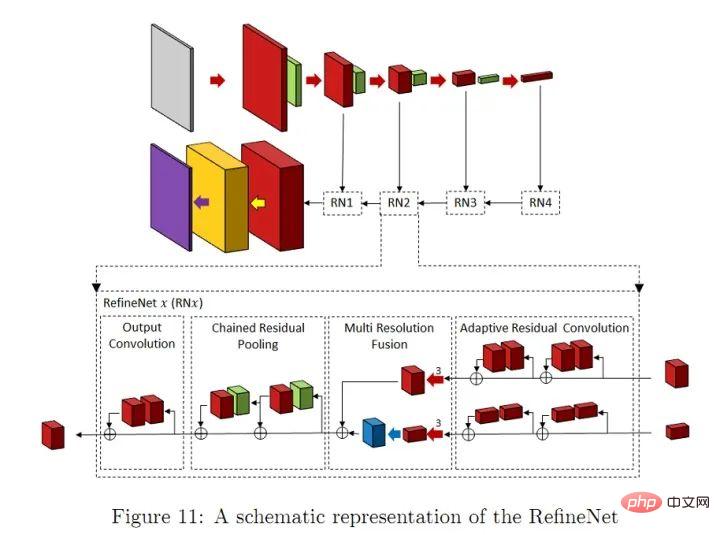

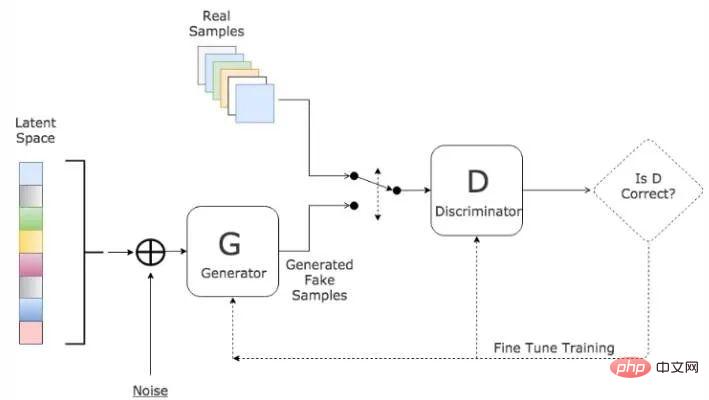

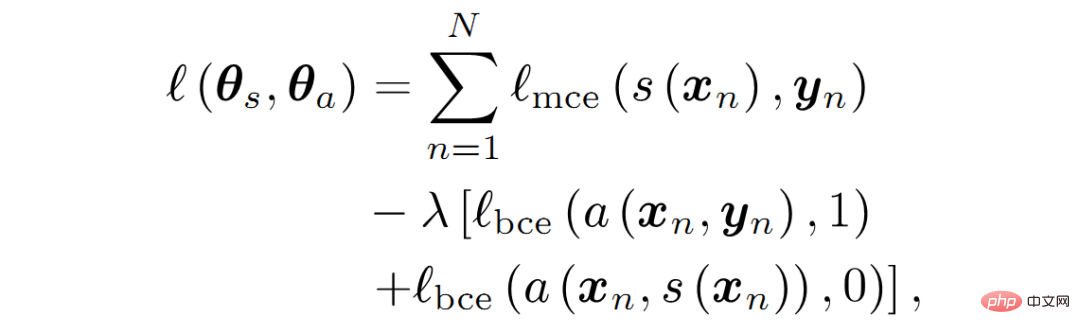

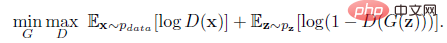

V-Net Network Titik inovasi: Cukup Versi 3D rangkaian U-Net FC-DenseNet (rangkaian tiramisu 100 lapisan) Titik inovasi: Integrasi rangkaian DenseNet dan U-Net (dari perspektif pertukaran maklumat Lihat, sambungan padat sememangnya lebih berkuasa daripada struktur sisa) 1) DeepLabV1: Gabungan rangkaian saraf konvolusi dan model graf kebarangkalian: CNN+CRF, yang meningkatkan ketepatan pembahagian dan kedudukan; 🎜> 2) DeepLabV2: ASPP (penghimpunan piramid spatial yang diperluaskan); 3) DeepLabV3: ASPP yang dipertingkatkan, menambahkan lilitan 1*1 dan kumpulan purata global membandingkan kesan lilitan atrus berlatarkan dan selari. Parallel Atrous Convolution (ASPP) 4) DeepLabV3+: Tambahkan idea seni bina pengekodan dan penyahkod, tambah modul penyahkod untuk memanjangkan DeepLabv3 menggunakan konvolusi boleh dipisahkan secara mendalam pada ASPP dan penyahkod modul; Xception yang dipertingkatkan sebagai Tulang Belakang. DeepLabV3+ Secara amnya, Sumbangan teras siri DeepLab: lilitan diluaskan; dan V2 menggunakan CRF. Sepatutnya V3 dan V3+ menyelesaikan masalah sempadan segmentasi kabur melalui rangkaian dalam, dan kesannya lebih baik daripada menambah CRF) Rangkaian PSPNet Titik inovasi: Berbilang skala penggabungan, menggunakan pengetahuan sedia ada peringkat imej global dengan lebih baik untuk memahami pemandangan yang kompleks Rangkaian RefineNet Titik inovasi: Perhalusi modul Terdapat juga banyak kerja khusus untuk mengurangkan kerumitan pengiraan rangkaian segmentasi semantik. Beberapa kaedah untuk memudahkan struktur rangkaian dalam: penguraian tensor / pemangkasan rangkaian; Ada juga yang menggunakan NAS (Neural Architecture Search) untuk menggantikan reka bentuk manual untuk mencari struktur modul atau keseluruhan rangkaian Sudah tentu, sumber GPU yang diperlukan oleh AutoDL akan menghalang sebilangan besar orang. Oleh itu, sesetengah orang menggunakan carian rawak untuk mencari modul ASPP yang lebih kecil, dan kemudian membina keseluruhan model rangkaian berdasarkan modul kecil. Reka bentuk rangkaian yang ringan adalah konsensus dalam industri Untuk penggunaan mudah alih, adalah mustahil untuk melengkapkan setiap mesin dengan 2080ti Selain itu, penggunaan kuasa, storan dan isu lain juga akan mengehadkan promosi dan aplikasi model. Walau bagaimanapun, jika 5G menjadi popular, semua data boleh diproses dalam awan, yang akan menjadi sangat menarik. Sudah tentu, dalam jangka pendek (sepuluh tahun), kami tidak tahu sama ada penggunaan skala penuh 5G boleh dilaksanakan. Mekanisme perhatian boleh ditakrifkan sebagai: menggunakan maklumat peta lapisan/ciri seterusnya untuk memilih dan mencari yang paling menilai (atau menonjol) dalam peta ciri input ) bahagian. Ia boleh dianggap sebagai cara peta ciri pemberat (berat dikira melalui rangkaian Mengikut fungsi pemberat yang berbeza, ia boleh dibahagikan kepada mekanisme perhatian saluran (CA) dan mekanisme perhatian ruang (PA). . Rangkaian FPA (Perhatian Piramid Ciri) ialah rangkaian pembahagian semantik berdasarkan mekanisme perhatian, yang menggabungkan mekanisme perhatian dan piramid spatial untuk mengekstrak ciri tepat untuk pelabelan tahap piksel tanpa menggunakan rangkaian dekoder Konvolusi dan rekaan manusia. Goodfellow et al mencadangkan kaedah adversarial untuk mempelajari model generatif mendalam pada tahun 2014. Rangkaian adversarial generatif (GAN) perlu melatih dua pada masa yang sama. Model: model generatif G yang menangkap taburan data, dan model diskriminatif D yang menganggarkan kebarangkalian sampel datang daripada data latihan. ● G ialah rangkaian generatif, yang menerima hingar rawak z (nombor rawak), dan menghasilkan imej melalui hingar ini ● D ialah rangkaian diskriminatif, yang menentukan sama ada imej itu Bukan "sebenar". Parameter inputnya ialah x (gambar), dan output D(x) mewakili kebarangkalian bahawa x ialah gambar sebenar Jika ia adalah 1, ia bermakna 100% ialah gambar sebenar, dan output ialah 0, yang bermaksud ia tidak boleh menjadi gambar sebenar. Prosedur latihan G adalah untuk memaksimumkan kebarangkalian ralat D. Ia boleh dibuktikan bahawa dalam ruang mana-mana fungsi G dan D, terdapat penyelesaian unik seperti G menghasilkan semula pengedaran data latihan, dan D=0.5. Semasa proses latihan, matlamat rangkaian generasi G adalah untuk cuba menjana gambar sebenar untuk menipu rangkaian diskriminasi D. Matlamat D adalah untuk cuba membezakan imej palsu yang dihasilkan oleh G daripada imej sebenar. Dengan cara ini, G dan D membentuk "proses permainan" dinamik, dan titik keseimbangan akhir ialah titik keseimbangan Nash. Dalam kes di mana G dan D ditakrifkan oleh rangkaian saraf, keseluruhan sistem boleh dilatih dengan perambatan balik. Gambar rajah struktur rangkaian GAN Diinspirasikan oleh GAN, Luc et al melatih rangkaian pembahagian semantik (G) dan konfrontasi Rangkaian (D), rangkaian lawan membezakan peta pembahagian daripada kebenaran tanah atau rangkaian pembahagian semantik (G). G dan D terus bermain permainan dan belajar, dan fungsi kehilangan mereka ditakrifkan sebagai: Fungsi kehilangan GAN Semak fungsi kehilangan GAN asal: Fungsi kehilangan GAN merangkumi idea permainan jumlah sifar Fungsi kehilangan GAN asal adalah seperti berikut: Kedudukan pengiraan kerugian adalah pada output D (diskriminator), dan output D pada umumnya adalah penghakiman palsu/benar, jadi keadaan keseluruhan boleh dianggap sebagai fungsi entropi silang binari. Dapat dilihat dari bentuk kehilangan fungsi GAN bahawa latihan terbahagi kepada dua bahagian: Yang pertama ialah bahagian maxD, kerana latihan secara umumnya melatih D sambil mengekalkan G (penjana) tidak berubah. Matlamat latihan D adalah untuk membezakan palsu/benar dengan betul Jika kita menggunakan 1/0 untuk mewakili benar/palsu, maka untuk item pertama E, kerana input diambil daripada data sebenar, kita menjangkakan D(x) mendekati 1. , iaitu yang pertama Item adalah lebih besar. Dengan cara yang sama, item kedua E input sampel data yang dijana daripada G, jadi kami menjangkakan D(G(z)) mendekati 0 lebih baik, yang bermaksud item kedua lebih besar lagi. Jadi bahagian ini adalah jangkaan bahawa latihan akan menjadikan keseluruhannya lebih besar, iaitu maksud maxD. Bahagian ini hanya mengemas kini parameter D. Bahagian kedua mengekalkan D tidak berubah (tiada kemas kini parameter) dan melatih G. Pada masa ini, hanya item kedua E yang berguna, kerana kita ingin mengelirukan D, jadi pada masa ini label ditetapkan kepada 1 (kita tahu ia adalah palsu, jadi ia dipanggil kekeliruan). ialah minG. Sudah tentu, diskriminator tidak begitu mudah untuk menipu, jadi pada masa ini diskriminator akan menghasilkan ralat yang agak besar Ralat akan mengemas kini G, dan kemudian G akan menjadi lebih baik kali ini, jadi saya boleh hanya bekerja lebih keras lain kali (Dipetik daripada https://www.cnblogs.com/walter-xh/p/10051634.html). Pada masa ini, hanya parameter G dikemas kini. Melihat GAN dari perspektif lain, diskriminator (D) adalah bersamaan dengan fungsi kehilangan khas (terdiri daripada rangkaian saraf, berbeza daripada L1, L2, entropi silang dan fungsi kehilangan lain) tradisional. Selain itu, GAN mempunyai kaedah latihan khas, dan terdapat masalah seperti kehilangan kecerunan dan keruntuhan mod (nampaknya ada cara untuk menyelesaikannya pada masa ini), tetapi idea reka bentuknya sememangnya merupakan ciptaan yang hebat dalam era pembelajaran mendalam. Kebanyakan model segmentasi semantik imej berdasarkan pembelajaran mendalam mengikut seni bina penyahkod pengekod, seperti U-Net. Hasil penyelidikan dalam beberapa tahun kebelakangan ini telah menunjukkan bahawa konvolusi diluaskan dan pengumpulan ciri piramid boleh meningkatkan prestasi rangkaian gaya U-Net. Dalam Bahagian 2, kami meringkaskan cara kaedah ini dan variannya boleh digunakan pada pembahagian imej perubatan. Bahagian ini memperkenalkan beberapa hasil penyelidikan mengenai aplikasi inovasi struktur rangkaian dalam segmentasi imej perubatan 2D/3D. Untuk mencapai pemprosesan masa nyata imej perubatan 2D/3D resolusi tinggi (seperti imej CT, MRI dan histopatologi, dsb.), penyelidik telah mencadangkan pelbagai kaedah model mampatan. Weng et al menggunakan teknologi NAS untuk digunakan pada rangkaian U-Net dan memperoleh rangkaian kecil dengan prestasi pembahagian organ/tumor yang lebih baik pada imej CT, MRI dan ultrasound. Brugger mereka bentuk semula seni bina U-Net dengan menggunakan normalisasi kumpulan dan Leaky-ReLU (fungsi ReLU bocor) untuk menjadikan kecekapan storan rangkaian untuk pembahagian imej perubatan 3D lebih cekap. Sesetengah orang juga telah mereka bentuk modul konvolusi diluaskan dengan parameter yang lebih sedikit. Beberapa kaedah pemampatan model lain termasuk pengkuantitian berat (enam belas bit, lapan bit, kuantisasi binari), penyulingan, pemangkasan, dsb. Drozdal mencadangkan kaedah yang menggunakan CNN mudah untuk menormalkan imej input asal sebelum menyuapnya ke dalam rangkaian pembahagian, mempertingkatkan Memperbaik ketepatan pembahagian singleton pembahagian imej mikroskop, CT hati, dan MRI prostat. Gu mencadangkan kaedah menggunakan lilitan diluaskan dalam rangkaian tulang belakang untuk mengekalkan maklumat kontekstual. Vorontsov mencadangkan rangka kerja rangkaian graf-ke-graf yang menukar imej dengan ROI kepada imej tanpa ROI (contohnya, imej dengan tumor ditukar kepada imej sihat tanpa tumor), dan kemudian tumor yang dikeluarkan oleh model ditambah kepada imej sihat baharu . , untuk mendapatkan struktur terperinci objek. Zhou et al. mencadangkan kaedah untuk melangkau penyambungan semula rangkaian U-Net dan melaksanakannya pada pembahagian nodul dalam imbasan CT dos rendah dada, pembahagian nuklear dalam imej mikroskop, pembahagian hati dalam imbasan CT perut, dan Kolonoskopi telah diuji pada tugas pembahagian polip dalam video peperiksaan. Goyal menggunakan DeepLabV3 pada pembahagian imej warna dermoskopik untuk mengekstrak kawasan lesi kulit. Nie mencadangkan model perhatian yang boleh membahagikan prostat dengan lebih tepat berbanding model asas (V-Net dan FCN). SinHa mencadangkan rangkaian berdasarkan mekanisme perhatian berbilang lapisan untuk pembahagian organ perut dalam imej MRI. Qin et al mencadangkan modul konvolusi yang diluaskan untuk mengekalkan lebih banyak butiran imej perubatan 3D. Terdapat banyak kertas lain mengenai pembahagian imej darah berdasarkan mekanisme perhatian. Khosravan mencadangkan rangkaian latihan adversarial untuk segmentasi pankreas daripada imbasan CT. Son menggunakan rangkaian musuh generatif untuk pembahagian imej retina. Xue menggunakan rangkaian konvolusi sepenuhnya sebagai rangkaian pembahagian dalam rangka kerja permusuhan generatif untuk membahagikan tumor otak daripada imej MRI. Terdapat kertas lain yang berjaya menggunakan GAN untuk masalah pembahagian imej perubatan, jadi saya tidak akan menyenaraikannya satu demi satu. Rangkaian saraf berulang (RNN) digunakan terutamanya untuk memproses data jujukan Rangkaian ingatan jangka pendek (LSTM) ialah versi RNN yang dipertingkatkan gelung kendiri (self-loops) membolehkan aliran kecerunan dikekalkan untuk jangka masa yang lama. Dalam bidang analisis imej perubatan, RNN digunakan untuk memodelkan kebergantungan temporal dalam jujukan imej. Bin et al. mencadangkan algoritma pembahagian jujukan imej yang mengintegrasikan rangkaian saraf konvolusi sepenuhnya dan RNN, dan menggabungkan maklumat dalam dimensi masa ke dalam tugasan pembahagian. Gao et al menggunakan CNN dan LSTM untuk memodelkan hubungan temporal dalam urutan hirisan MRI otak untuk meningkatkan prestasi pembahagian dalam imej 4D. Li et al mula-mula menggunakan U-Net untuk mendapatkan peta kebarangkalian pembahagian awal, dan kemudian menggunakan LSTM untuk membahagikan pankreas daripada imej CT 3D, yang meningkatkan prestasi pembahagian. Terdapat banyak lagi kertas kerja yang menggunakan RNN untuk segmentasi imej perubatan, jadi saya tidak akan memperkenalkannya satu persatu. Bahagian kandungan ini terutamanya mengenai penggunaan algoritma segmentasi dalam segmentasi imej perubatan, jadi tidak banyak titik inovasi Ia terutamanya mengenai format yang berbeza (CT atau RGB , julat piksel, resolusi imej, dsb.) dan ciri bahagian data yang berbeza (bunyi, bentuk objek, dsb.), rangkaian klasik perlu dipertingkatkan untuk data yang berbeza menyesuaikan diri dengan format dan ciri data input, jadi bahawa ia boleh menyelesaikan tugas pembahagian dengan lebih baik. Walaupun pembelajaran mendalam adalah kotak hitam, reka bentuk keseluruhan model masih mempunyai peraturan yang perlu diikuti. Apakah strategi yang menyelesaikan masalah dan masalah yang ditimbulkannya boleh dipilih berdasarkan masalah segmentasi tertentu untuk mencapai prestasi segmentasi yang optimum. 1.Segmentasi Semantik Dalam Imej Semulajadi dan Perubatan: Satu Tinjauan 2.NAS-Unet: Neural carian seni bina untuk pembahagian imej perubatan. Akses IEEE, 7:44247–44257, 2019. 3.Meningkatkan segmentasi dengan pengawasan yang lemah daripada terjemahan imej-ke-imej arXiv: 1904.01636 , 2019 4.Perhatian berpandu berbilang skala untuk pembahagian imej perubatan arXiv pracetak arXiv:1906.02849,2019. 5.Seg. Rangkaian lawan dengan kehilangan L1 berbilang skala untuk pembahagian imej perubatan. 6. Rangkaian LSTM berstruktur konvolusi sepenuhnya untuk pembahagian imej perubatan 4D bersama Pada 2018 IEEE7 https://www.cnblogs. com/walter-xh/p/10051634.html

1.3 Mengurangkan kerumitan pengiraan struktur rangkaian

1.4 Struktur rangkaian berdasarkan mekanisme perhatian

1.5 Struktur rangkaian berdasarkan pembelajaran adversarial

1.6 Ringkasan

2. Aplikasi inovasi struktur rangkaian dalam segmentasi imej perubatan

2.1 Kaedah pembahagian berdasarkan pemampatan model

2.2 Kaedah pembahagian struktur pengekodan-penyahkodan

2.3 Kaedah pembahagian berdasarkan mekanisme perhatian

2.4 Rangkaian pembahagian berdasarkan pembelajaran adversarial

Model segmentasi berasaskan 2.5 RNN

2.6 Ringkasan

Beberapa rujukan:

Atas ialah kandungan terperinci Pembahagian imej pembelajaran mendalam: gambaran keseluruhan reka bentuk struktur rangkaian. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1657

1657

14

14

1415

1415

52

52

1309

1309

25

25

1257

1257

29

29

1231

1231

24

24

Kaedah dan langkah untuk menggunakan BERT untuk analisis sentimen dalam Python

Jan 22, 2024 pm 04:24 PM

Kaedah dan langkah untuk menggunakan BERT untuk analisis sentimen dalam Python

Jan 22, 2024 pm 04:24 PM

BERT ialah model bahasa pembelajaran mendalam pra-latihan yang dicadangkan oleh Google pada 2018. Nama penuh ialah BidirectionalEncoderRepresentationsfromTransformers, yang berdasarkan seni bina Transformer dan mempunyai ciri pengekodan dwiarah. Berbanding dengan model pengekodan sehala tradisional, BERT boleh mempertimbangkan maklumat kontekstual pada masa yang sama semasa memproses teks, jadi ia berfungsi dengan baik dalam tugas pemprosesan bahasa semula jadi. Dwiarahnya membolehkan BERT memahami dengan lebih baik hubungan semantik dalam ayat, dengan itu meningkatkan keupayaan ekspresif model. Melalui kaedah pra-latihan dan penalaan halus, BERT boleh digunakan untuk pelbagai tugas pemprosesan bahasa semula jadi, seperti analisis sentimen, penamaan.

Analisis fungsi pengaktifan AI yang biasa digunakan: amalan pembelajaran mendalam Sigmoid, Tanh, ReLU dan Softmax

Dec 28, 2023 pm 11:35 PM

Analisis fungsi pengaktifan AI yang biasa digunakan: amalan pembelajaran mendalam Sigmoid, Tanh, ReLU dan Softmax

Dec 28, 2023 pm 11:35 PM

Fungsi pengaktifan memainkan peranan penting dalam pembelajaran mendalam Ia boleh memperkenalkan ciri tak linear ke dalam rangkaian saraf, membolehkan rangkaian belajar dengan lebih baik dan mensimulasikan hubungan input-output yang kompleks. Pemilihan dan penggunaan fungsi pengaktifan yang betul mempunyai kesan penting terhadap prestasi dan hasil latihan rangkaian saraf Artikel ini akan memperkenalkan empat fungsi pengaktifan yang biasa digunakan: Sigmoid, Tanh, ReLU dan Softmax, bermula dari pengenalan, senario penggunaan, kelebihan, kelemahan dan penyelesaian pengoptimuman Dimensi dibincangkan untuk memberi anda pemahaman yang menyeluruh tentang fungsi pengaktifan. 1. Fungsi Sigmoid Pengenalan kepada formula fungsi SIgmoid: Fungsi Sigmoid ialah fungsi tak linear yang biasa digunakan yang boleh memetakan sebarang nombor nyata antara 0 dan 1. Ia biasanya digunakan untuk menyatukan

Pembenaman ruang terpendam: penjelasan dan demonstrasi

Jan 22, 2024 pm 05:30 PM

Pembenaman ruang terpendam: penjelasan dan demonstrasi

Jan 22, 2024 pm 05:30 PM

Pembenaman Ruang Terpendam (LatentSpaceEmbedding) ialah proses memetakan data berdimensi tinggi kepada ruang berdimensi rendah. Dalam bidang pembelajaran mesin dan pembelajaran mendalam, pembenaman ruang terpendam biasanya merupakan model rangkaian saraf yang memetakan data input berdimensi tinggi ke dalam set perwakilan vektor berdimensi rendah ini sering dipanggil "vektor terpendam" atau "terpendam pengekodan". Tujuan pembenaman ruang terpendam adalah untuk menangkap ciri penting dalam data dan mewakilinya ke dalam bentuk yang lebih ringkas dan mudah difahami. Melalui pembenaman ruang terpendam, kami boleh melakukan operasi seperti memvisualisasikan, mengelaskan dan mengelompokkan data dalam ruang dimensi rendah untuk memahami dan menggunakan data dengan lebih baik. Pembenaman ruang terpendam mempunyai aplikasi yang luas dalam banyak bidang, seperti penjanaan imej, pengekstrakan ciri, pengurangan dimensi, dsb. Pembenaman ruang terpendam adalah yang utama

Di luar ORB-SLAM3! SL-SLAM: Adegan bertekstur lemah ringan, kegelisahan teruk dan lemah semuanya dikendalikan

May 30, 2024 am 09:35 AM

Di luar ORB-SLAM3! SL-SLAM: Adegan bertekstur lemah ringan, kegelisahan teruk dan lemah semuanya dikendalikan

May 30, 2024 am 09:35 AM

Ditulis sebelum ini, hari ini kita membincangkan bagaimana teknologi pembelajaran mendalam boleh meningkatkan prestasi SLAM berasaskan penglihatan (penyetempatan dan pemetaan serentak) dalam persekitaran yang kompleks. Dengan menggabungkan kaedah pengekstrakan ciri dalam dan pemadanan kedalaman, di sini kami memperkenalkan sistem SLAM visual hibrid serba boleh yang direka untuk meningkatkan penyesuaian dalam senario yang mencabar seperti keadaan cahaya malap, pencahayaan dinamik, kawasan bertekstur lemah dan seks yang teruk. Sistem kami menyokong berbilang mod, termasuk konfigurasi monokular, stereo, monokular-inersia dan stereo-inersia lanjutan. Selain itu, ia juga menganalisis cara menggabungkan SLAM visual dengan kaedah pembelajaran mendalam untuk memberi inspirasi kepada penyelidikan lain. Melalui percubaan yang meluas pada set data awam dan data sampel sendiri, kami menunjukkan keunggulan SL-SLAM dari segi ketepatan kedudukan dan keteguhan penjejakan.

Super kuat! 10 algoritma pembelajaran mendalam teratas!

Mar 15, 2024 pm 03:46 PM

Super kuat! 10 algoritma pembelajaran mendalam teratas!

Mar 15, 2024 pm 03:46 PM

Hampir 20 tahun telah berlalu sejak konsep pembelajaran mendalam dicadangkan pada tahun 2006. Pembelajaran mendalam, sebagai revolusi dalam bidang kecerdasan buatan, telah melahirkan banyak algoritma yang berpengaruh. Jadi, pada pendapat anda, apakah 10 algoritma teratas untuk pembelajaran mendalam? Berikut adalah algoritma teratas untuk pembelajaran mendalam pada pendapat saya Mereka semua menduduki kedudukan penting dari segi inovasi, nilai aplikasi dan pengaruh. 1. Latar belakang rangkaian saraf dalam (DNN): Rangkaian saraf dalam (DNN), juga dipanggil perceptron berbilang lapisan, adalah algoritma pembelajaran mendalam yang paling biasa Apabila ia mula-mula dicipta, ia dipersoalkan kerana kesesakan kuasa pengkomputeran tahun, kuasa pengkomputeran, Kejayaan datang dengan letupan data. DNN ialah model rangkaian saraf yang mengandungi berbilang lapisan tersembunyi. Dalam model ini, setiap lapisan menghantar input ke lapisan seterusnya dan

Fahami dalam satu artikel: kaitan dan perbezaan antara AI, pembelajaran mesin dan pembelajaran mendalam

Mar 02, 2024 am 11:19 AM

Fahami dalam satu artikel: kaitan dan perbezaan antara AI, pembelajaran mesin dan pembelajaran mendalam

Mar 02, 2024 am 11:19 AM

Dalam gelombang perubahan teknologi yang pesat hari ini, Kecerdasan Buatan (AI), Pembelajaran Mesin (ML) dan Pembelajaran Dalam (DL) adalah seperti bintang terang, menerajui gelombang baharu teknologi maklumat. Ketiga-tiga perkataan ini sering muncul dalam pelbagai perbincangan dan aplikasi praktikal yang canggih, tetapi bagi kebanyakan peneroka yang baru dalam bidang ini, makna khusus dan hubungan dalaman mereka mungkin masih diselubungi misteri. Jadi mari kita lihat gambar ini dahulu. Dapat dilihat bahawa terdapat korelasi rapat dan hubungan progresif antara pembelajaran mendalam, pembelajaran mesin dan kecerdasan buatan. Pembelajaran mendalam ialah bidang khusus pembelajaran mesin dan pembelajaran mesin

Daripada asas kepada amalan, semak sejarah pembangunan pengambilan vektor Elasticsearch

Oct 23, 2023 pm 05:17 PM

Daripada asas kepada amalan, semak sejarah pembangunan pengambilan vektor Elasticsearch

Oct 23, 2023 pm 05:17 PM

1. Pengenalan Pengambilan semula vektor telah menjadi komponen teras sistem carian dan pengesyoran moden. Ia membolehkan pemadanan pertanyaan dan pengesyoran yang cekap dengan menukar objek kompleks (seperti teks, imej atau bunyi) kepada vektor berangka dan melakukan carian persamaan dalam ruang berbilang dimensi. Daripada asas kepada amalan, semak semula sejarah pembangunan vektor retrieval_elasticsearch Elasticsearch Sebagai enjin carian sumber terbuka yang popular, pembangunan Elasticsearch dalam pengambilan vektor sentiasa menarik perhatian ramai. Artikel ini akan menyemak sejarah pembangunan pengambilan vektor Elasticsearch, memfokuskan pada ciri dan kemajuan setiap peringkat. Mengambil sejarah sebagai panduan, adalah mudah untuk semua orang mewujudkan rangkaian penuh pengambilan vektor Elasticsearch.

AlphaFold 3 dilancarkan, meramalkan secara menyeluruh interaksi dan struktur protein dan semua molekul hidupan, dengan ketepatan yang jauh lebih tinggi berbanding sebelum ini

Jul 16, 2024 am 12:08 AM

AlphaFold 3 dilancarkan, meramalkan secara menyeluruh interaksi dan struktur protein dan semua molekul hidupan, dengan ketepatan yang jauh lebih tinggi berbanding sebelum ini

Jul 16, 2024 am 12:08 AM

Editor |. Kulit Lobak Sejak pengeluaran AlphaFold2 yang berkuasa pada tahun 2021, saintis telah menggunakan model ramalan struktur protein untuk memetakan pelbagai struktur protein dalam sel, menemui ubat dan melukis "peta kosmik" setiap interaksi protein yang diketahui. Baru-baru ini, Google DeepMind mengeluarkan model AlphaFold3, yang boleh melakukan ramalan struktur bersama untuk kompleks termasuk protein, asid nukleik, molekul kecil, ion dan sisa yang diubah suai. Ketepatan AlphaFold3 telah dipertingkatkan dengan ketara berbanding dengan banyak alat khusus pada masa lalu (interaksi protein-ligan, interaksi asid protein-nukleik, ramalan antibodi-antigen). Ini menunjukkan bahawa dalam satu rangka kerja pembelajaran mendalam yang bersatu, adalah mungkin untuk dicapai