Peranti teknologi

Peranti teknologi

AI

AI

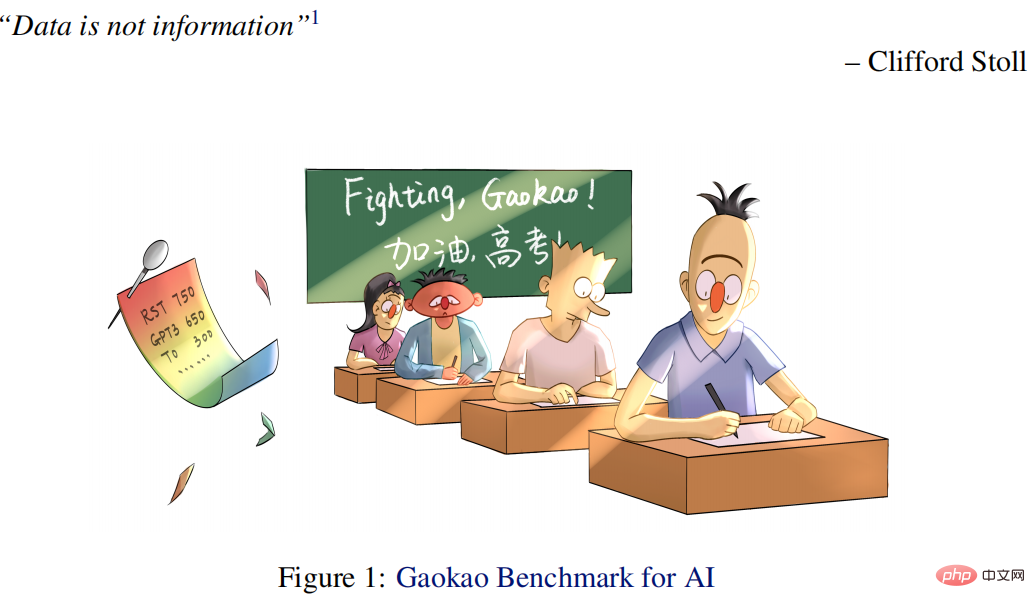

Peperiksaan Masuk Kolej Inggeris tahun ini, CMU menggunakan pra-latihan pembinaan semula untuk mencapai skor tinggi 134, dengan ketara mengatasi GPT3

Peperiksaan Masuk Kolej Inggeris tahun ini, CMU menggunakan pra-latihan pembinaan semula untuk mencapai skor tinggi 134, dengan ketara mengatasi GPT3

Peperiksaan Masuk Kolej Inggeris tahun ini, CMU menggunakan pra-latihan pembinaan semula untuk mencapai skor tinggi 134, dengan ketara mengatasi GPT3

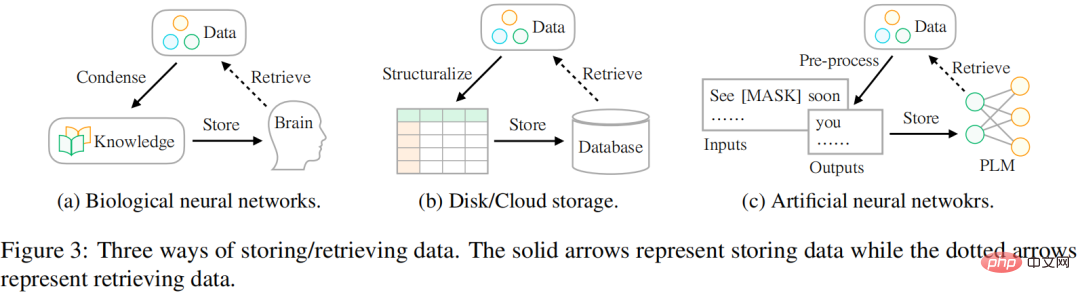

Cara kami menyimpan data berubah, daripada rangkaian saraf biologi kepada rangkaian saraf tiruan Sebenarnya, situasi yang paling biasa adalah menggunakan otak untuk menyimpan data. Memandangkan jumlah data yang tersedia hari ini terus berkembang, orang ramai berusaha untuk menyimpan data menggunakan peranti luaran yang berbeza seperti pemacu keras atau storan awan. Dengan peningkatan teknologi pembelajaran mendalam, satu lagi teknologi storan yang menjanjikan telah muncul, yang menggunakan rangkaian saraf tiruan untuk menyimpan maklumat dalam data.

Penyelidik percaya bahawa matlamat utama penyimpanan data adalah untuk memberi perkhidmatan yang lebih baik kepada kehidupan manusia, dan kaedah capaian data adalah sama pentingnya dengan kaedah penyimpanan. Walau bagaimanapun, terdapat perbezaan dalam cara data disimpan dan diakses. Dari segi sejarah, orang ramai telah bergelut untuk merapatkan jurang ini untuk menggunakan maklumat yang ada di dunia dengan lebih baik. Seperti yang ditunjukkan dalam Rajah 3:

- Dari segi rangkaian saraf biologi (seperti otak manusia), manusia menerima pendidikan kurikulum (iaitu pengetahuan) pada usia yang sangat muda. umur , supaya mereka boleh mengekstrak data khusus untuk menangani kehidupan yang kompleks dan berubah.

- Untuk storan peranti luaran, orang biasanya menstruktur data mengikut skema tertentu (seperti jadual), dan kemudian menggunakan bahasa khusus (seperti SQL) untuk mendapatkan semula maklumat yang diperlukan daripada pangkalan data dengan cekap.

- Untuk storan berasaskan rangkaian saraf tiruan, penyelidik memanfaatkan pembelajaran diselia sendiri untuk menyimpan data daripada korpora besar (iaitu, pra-latihan) dan kemudian menggunakan rangkaian untuk pelbagai tugas hiliran (mis., klasifikasi emosi).

Penyelidik dari CMU telah mencadangkan cara baharu untuk mengakses data yang mengandungi pelbagai jenis maklumat yang boleh berfungsi sebagai isyarat pra-latihan untuk membimbing pengoptimuman parameter model. Kajian membentangkan data secara berstruktur dalam unit isyarat. Ini adalah serupa dengan senario menggunakan pangkalan data untuk menyimpan data: mereka mula-mula distrukturkan ke dalam jadual atau format JSON, supaya maklumat tepat yang diperlukan boleh diambil melalui bahasa khusus seperti SQL.

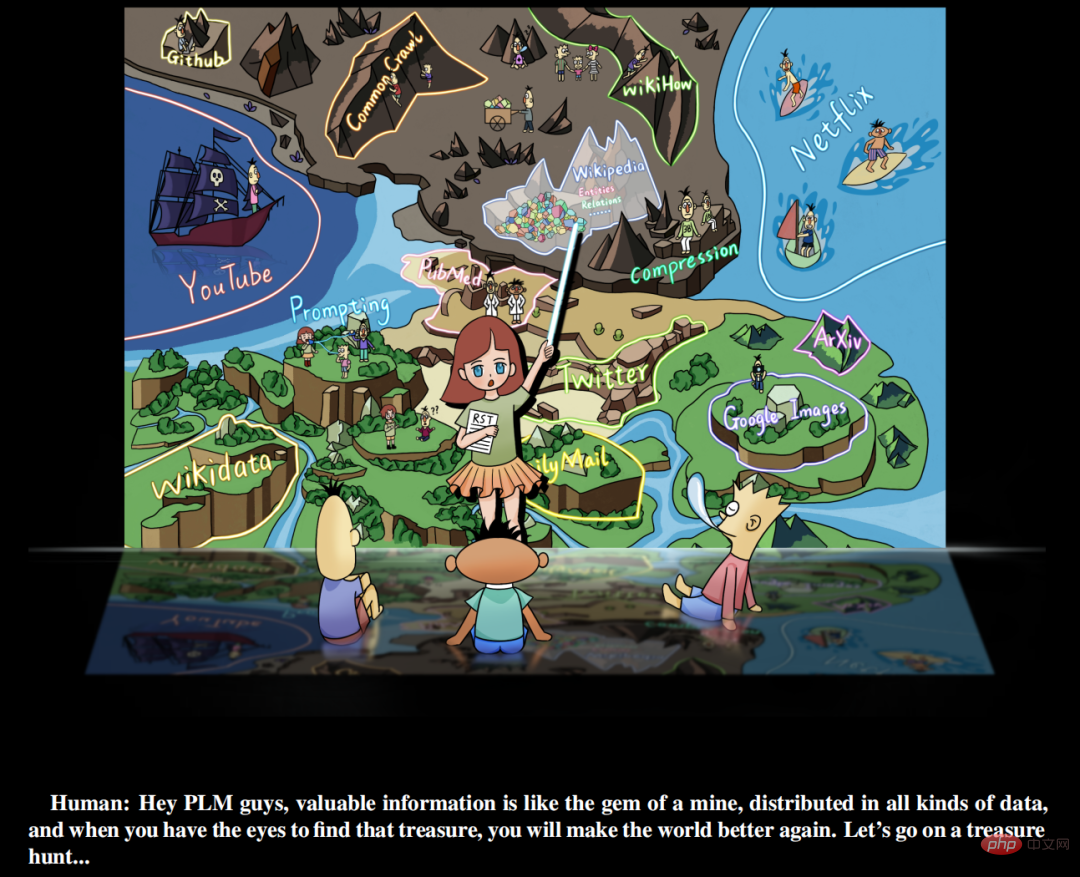

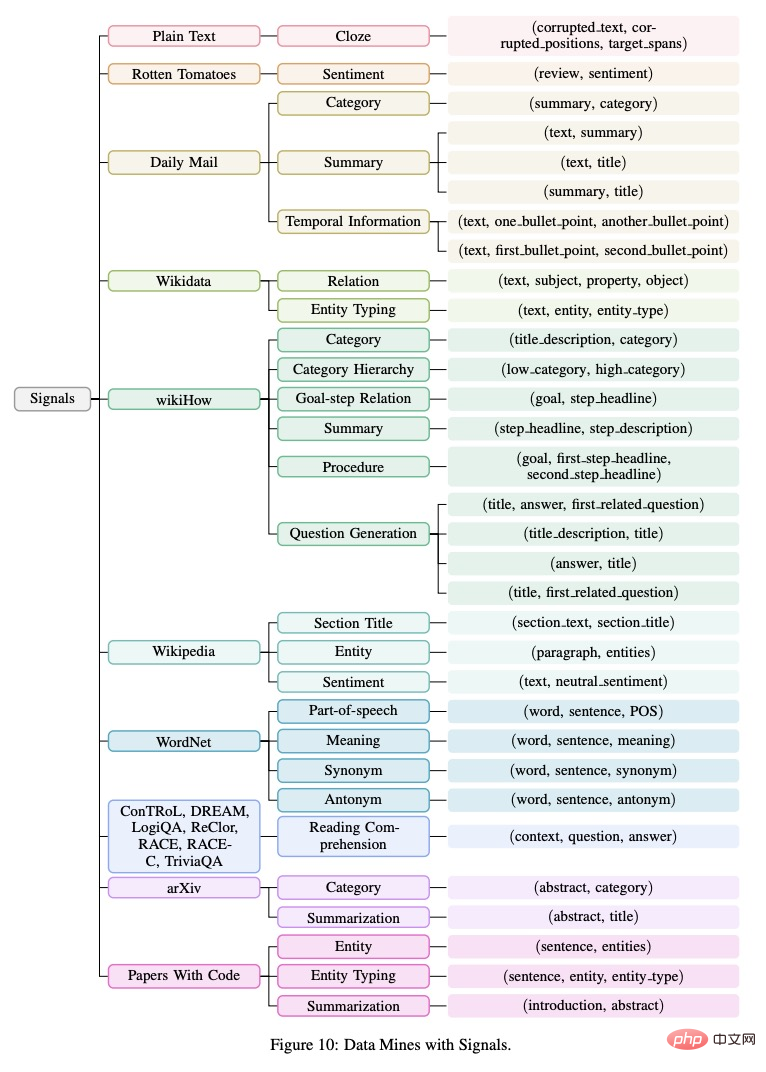

Selain itu, kajian ini percaya bahawa isyarat berharga wujud dengan banyaknya dalam semua jenis data di dunia, dan bukannya hanya wujud dalam set data penyeliaan susun atur secara manual Perkara yang perlu dilakukan oleh penyelidik ialah (a) mengenal pasti data (). b) Menyusun semula data dengan bahasa bersatu (c) Mengintegrasikan dan menyimpannya ke dalam model bahasa yang telah dilatih. Kajian ini memanggil paradigma pembelajaran ini sebagai reStructured Pra-training (RST). Penyelidik menyamakan proses itu seperti "memburu harta karun di lombong." Sumber data yang berbeza seperti Wikipedia adalah setara dengan lombong yang kaya dengan permata. Ia mengandungi maklumat yang kaya, seperti entiti bernama daripada hiperpautan, yang boleh memberikan isyarat untuk pra-latihan model. Model pralatihan (PLM) yang baik harus memahami dengan jelas komposisi pelbagai isyarat dalam data untuk memberikan maklumat yang tepat berdasarkan keperluan tugas hiliran yang berbeza.

Alamat kertas: https://arxiv.org/pdf/2206.11147.pdf

Permulaan Pencarian harta karun untuk model bahasa latihan

Penyelidikan ini mencadangkan paradigma baharu pembelajaran tugasan pemprosesan bahasa semula jadi, iaitu RST, yang menekankan semula peranan data dan mengambil kira model pra-latihan dan penalaan halus tugas hiliran sebagai prosedur penyimpanan dan capaian data. Atas dasar ini, penyelidikan ini menyedari prinsip mudah, iaitu, mekanisme penyimpanan yang baik bukan sahaja mempunyai keupayaan untuk menyimpan sejumlah besar data, tetapi juga mempertimbangkan kemudahan akses.

Selepas mengatasi beberapa cabaran kejuruteraan, penyelidikan mencapai ini dengan pra-latihan mengenai data yang dibina semula (terdiri daripada pelbagai maklumat berharga dan bukannya data asal). Eksperimen menunjukkan bahawa model RST bukan sahaja dengan ketara mengatasi sistem sedia ada terbaik (cth., T0) pada 52/55 set data popular daripada pelbagai tugasan NLP (cth., pengelasan, pengekstrakan maklumat, pengambilan fakta, penjanaan teks, dll.), tetapi juga berfungsi. tidak memerlukan Perhalusi tugas hiliran. Ia juga telah mencapai keputusan cemerlang dalam peperiksaan Bahasa Inggeris Peperiksaan Masuk Kolej yang paling berwibawa di China, yang diambil oleh berjuta-juta pelajar setiap tahun.

Secara khusus, peperiksaan kemasukan kolej AI (Qin) yang dicadangkan dalam artikel ini adalah 40 mata lebih tinggi daripada purata markah pelajar dan 15 mata lebih tinggi daripada GPT3 menggunakan parameter 1/16. Qin khas mendapat markah tinggi 138.5 (daripada 150) dalam ujian Bahasa Inggeris 2018.

Selain itu, kajian itu juga mengeluarkan platform penyerahan dalam talian Penanda Aras Gaokao, yang mengandungi 10 kertas ujian Bahasa Inggeris beranotasi dari 2018-2021 hingga sekarang (dan akan diperluas setiap tahun), membolehkan lebih banyak model AI mengambil bahagian dalam pintu masuk kolej peperiksaan, Penyelidikan ini juga mewujudkan tempat ujian yang agak tahap untuk persaingan manusia dan AI, membantu kami lebih memahami kedudukan kami. Selain itu, dalam ujian Bahasa Inggeris Peperiksaan Kemasukan Kolej 2022 beberapa hari lalu (2022.06.08), sistem AI memperoleh markah yang baik iaitu 134 mata, manakala GPT3 hanya memperoleh 108 mata.

Sumbangan utama kajian ini termasuk:

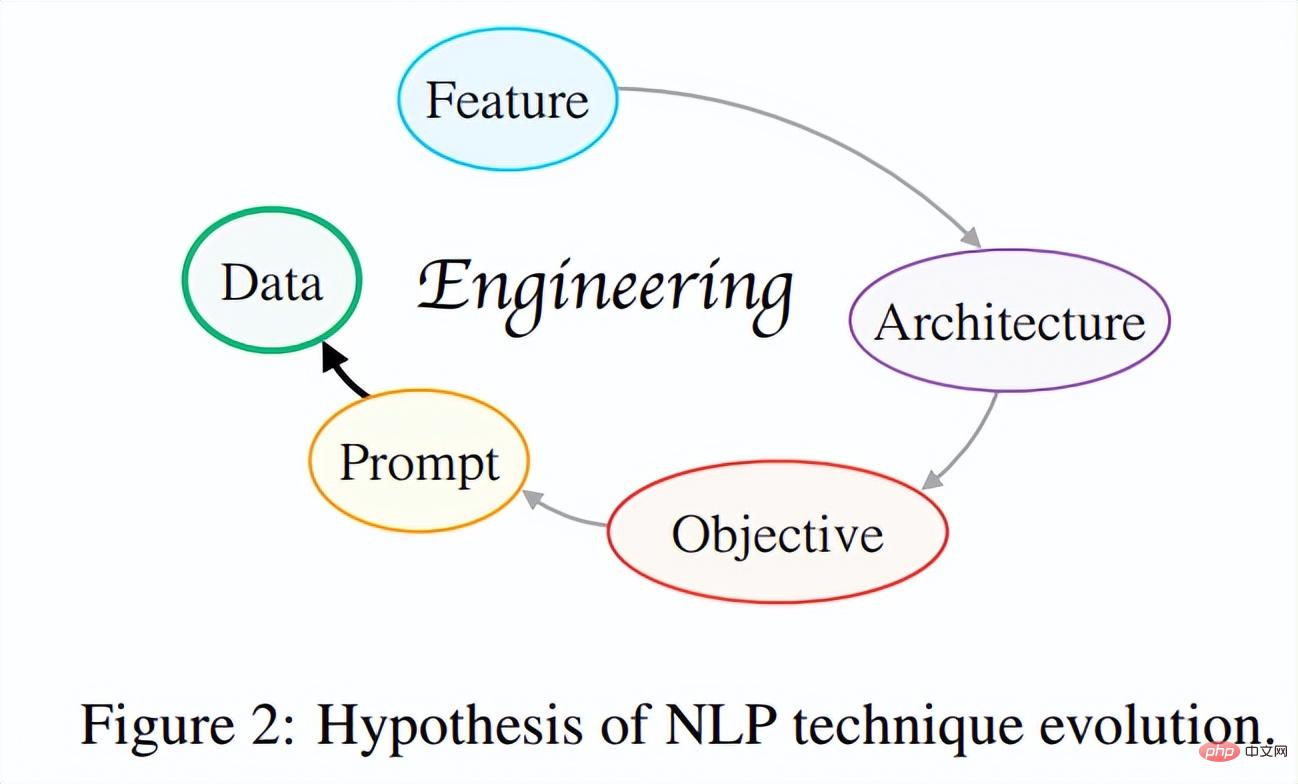

(1) Mencadangkan hipotesis evolusi kaedah NLP . Penyelidikan ini cuba untuk mewujudkan "hipotesis evolusi teknologi NLP" dari perspektif keseluruhan dengan meneroka hubungan intrinsik antara pembangunan teknologi NLP moden. Ringkasnya, idea teras hipotesis ini adalah bahawa lelaran teknologi sentiasa berkembang ke arah sedemikian sehingga pembangun hanya perlu melakukan lebih sedikit untuk mereka bentuk sistem yang lebih baik dan lebih serba boleh.

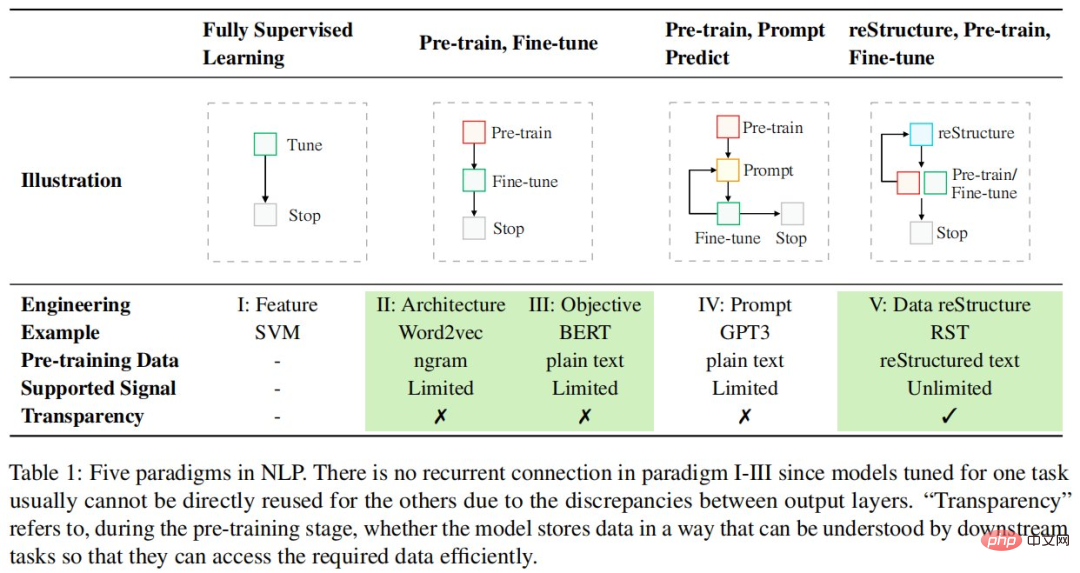

Setakat ini, evolusi teknologi NLP telah melalui pelbagai lelaran seperti yang ditunjukkan dalam Rajah 2: kejuruteraan ciri → kejuruteraan seni bina → kejuruteraan sasaran → kejuruteraan segera, dan sedang bergerak ke arah Satu langkah ke arah kejuruteraan berasaskan data yang lebih praktikal dan berkesan. Para penyelidik berharap bahawa pada masa hadapan, lebih ramai penyelidik saintifik akan mendapat inspirasi untuk berfikir secara kritis tentang isu ini, memahami kuasa penggerak teras kemajuan teknologi, mencari laluan "kecerunan ke atas" untuk pembangunan akademik dan melakukan kerja yang lebih bermakna secara saintifik.

(2) Paradigma baharu berdasarkan hipotesis evolusi: Pra-latihan Berstruktur semula . Paradigma ini menganggap model pra-latihan/penalaan halus sebagai proses penyimpanan/akses data dan mendakwa bahawa mekanisme storan yang baik harus menjadikan data yang dimaksudkan mudah diakses. Dengan paradigma baharu sedemikian, penyelidikan itu dapat menyatukan 26 jenis isyarat yang berbeza di dunia (cth. entiti ayat) daripada 10 sumber data (cth. Wikipedia). Model umum yang dilatih atas dasar ini mencapai keupayaan generalisasi yang kukuh pada pelbagai tugas, termasuk 55 set data NLP.

(3) AI untuk peperiksaan kemasukan kolej. Berdasarkan paradigma di atas, kajian ini membangunkan sistem AI - Qin - khusus digunakan untuk tugasan ujian Bahasa Inggeris peperiksaan kemasukan kolej. Ini adalah sistem kecerdasan buatan Bahasa Inggeris peperiksaan kemasukan kolej pertama di dunia berdasarkan pembelajaran mendalam. Qin telah mencapai keputusan cemerlang dalam soalan peperiksaan kemasukan kolej selama bertahun-tahun: 40 mata lebih tinggi daripada orang biasa, dan mencapai 15 mata lebih tinggi daripada GPT-3 menggunakan hanya 1/16 daripada parameter GPT-3. Terutama dalam soalan ujian Bahasa Inggeris 2018, QIN menerima skor tinggi 138.5 mata (daripada 150 mata), dengan skor sempurna dalam kedua-dua kefahaman mendengar dan membaca.

(4) Sumber yang kaya. (1) Untuk menjejaki kemajuan teknologi AI sedia ada dalam mencapai kecerdasan manusia, kajian itu mengeluarkan penanda aras baharu-Gaokao Benchmark. Ia bukan sahaja menyediakan penilaian menyeluruh tentang pelbagai tugas dan domain praktikal dalam senario dunia sebenar, ia juga menyediakan skor prestasi manusia supaya sistem AI boleh dibandingkan secara langsung dengan manusia. (2) Kajian ini menggunakan ExplainBoard (Liu et al., 2021b) untuk menetapkan papan pendahulu interaktif untuk Penanda Aras Gaokao supaya lebih banyak sistem AI boleh mengambil bahagian dengan mudah dalam Penanda Aras Gaokao dan memperoleh markah secara automatik. (3) Semua sumber boleh didapati di GitHub.

Selain itu, kejayaan AI dalam peperiksaan kemasukan kolej tugas ujian Bahasa Inggeris telah menyediakan penyelidik dengan banyak idea baharu: Teknologi AI boleh memperkasakan pendidikan dan membantu menyelesaikan satu siri masalah dalam pendidikan dan pengajaran.

Contohnya, (a) membantu guru mengautomasikan penggredan, (b) membantu pelajar menjawab soalan tentang tugasan dan menerangkannya secara terperinci, dan (c) yang lebih penting, menggalakkan ekuiti pendidikan dan menjadikannya mudah diakses oleh kebanyakan keluarga perkhidmatan dengan kualiti yang sama. Kerja ini menyepadukan 26 isyarat berbeza dari seluruh dunia dalam cara yang bersatu buat kali pertama, dan bukannya cuba membezakan antara data yang diselia dan tidak diselia, ia mengambil berat tentang berapa banyak dan cara kita boleh menggunakan sifat maklumat yang diberikan kepada kita. Prestasi cemerlang pada lebih daripada 50 set data daripada pelbagai tugasan NLP menunjukkan nilai pra-latihan berpusatkan data dan memberi inspirasi kepada lebih banyak penerokaan masa hadapan.

Memfaktorkan semula pra-latihan

Paradigma untuk menyelesaikan tugasan NLP berubah dengan pantas dan masih diteruskan Jadual berikut menyenaraikan lima paradigma dalam NLP:

Berbeza dengan paradigma reka bentuk berpusatkan model sedia ada, penyelidikan ini lebih memikirkan daripada perspektif data untuk memaksimumkan penggunaan data sedia ada. Secara khusus, kajian ini menggunakan paparan storan dan capaian data, di mana peringkat pra-latihan dianggap sebagai proses penyimpanan data, manakala tugas hiliran (cth., klasifikasi sentimen) berdasarkan model pra-latihan dianggap sebagai proses capaian data. daripada model pra-latihan, Dan mendakwa bahawa mekanisme penyimpanan data yang baik harus menjadikan data yang disimpan lebih mudah diakses.

Untuk mencapai matlamat ini, kajian ini menganggap data sebagai objek yang terdiri daripada isyarat yang berbeza, dan percaya bahawa model pra-latihan yang baik harus (1) meliputi seberapa banyak jenis isyarat yang mungkin, (2) apabila hiliran Menyediakan mekanisme capaian yang tepat kepada isyarat ini apabila diperlukan oleh misi. Secara umumnya, paradigma baharu ini terdiri daripada tiga langkah: pembinaan semula, pra-latihan dan penalaan halus.

Paradigma baharu pembinaan semula, pra-latihan dan penalaan halus menyerlahkan kepentingan data dan penyelidik perlu melabur lebih banyak tenaga kejuruteraan dalam pemprosesan data.

Kejuruteraan Pemfaktoran Semula

Definisi Isyarat

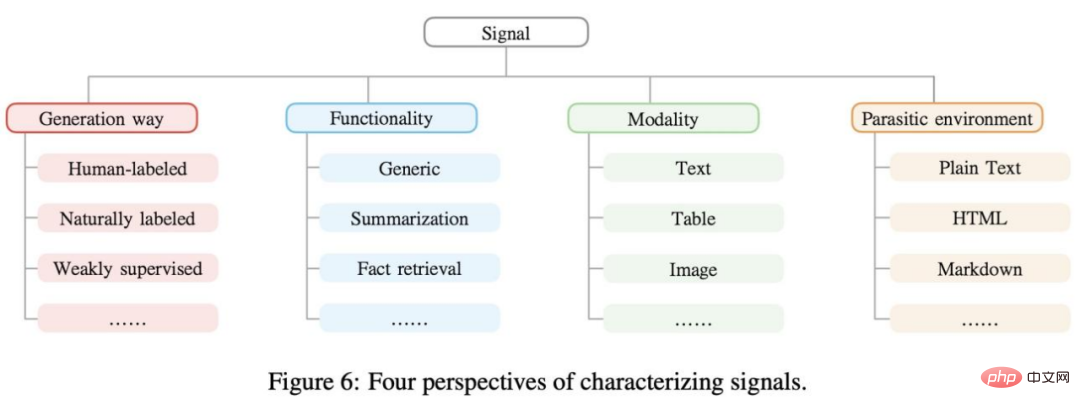

Isyarat ialah maklumat berguna yang terdapat dalam data yang boleh menyediakan penyeliaan untuk model pembelajaran mesin dan diwakili sebagai n-tuple. Contohnya, "Mozart dilahirkan di Salzburg", "Mozart" dan "Salzburg" boleh dianggap sebagai isyarat untuk pengiktirafan entiti bernama. Biasanya, isyarat boleh dikelompokkan dari perspektif yang berbeza, seperti yang ditunjukkan dalam Rajah 6 di bawah.

Perlombongan Data

Data dunia sebenar mengandungi pelbagai jenis isyarat. Membina semula pra-latihan membolehkan isyarat ini dieksploitasi sepenuhnya. Kajian itu menyusun isyarat yang dikumpul (n-tuples) dalam rajah pokok seperti yang ditunjukkan dalam Rajah 10 di bawah.

Pengeluaran Isyarat

Langkah kajian seterusnya ialah pengekstrakan dan pemprosesan isyarat, yang melibatkan mendapatkan data mentah daripada kaedah perlombongan data yang berbeza, pembersihan data dan Normalisasi data. Kaedah sedia ada dibahagikan secara kasar kepada dua jenis: (1) berasaskan peraturan dan (2) berasaskan pembelajaran mesin. Dalam kerja ini, penyelidikan tertumpu terutamanya pada strategi pengekstrakan isyarat berasaskan peraturan dan meninggalkan lebih banyak kaedah liputan tinggi untuk kerja masa hadapan.

Pembinaan Semula Isyarat

Selepas mengekstrak isyarat yang berbeza daripada pelbagai perlombongan data, langkah penting seterusnya ialah menyatukannya ke dalam bentuk tetap supaya ia boleh diubah semasa pra-latihan Semua maklumat disimpan secara konsisten dalam model. Kaedah segera (Brown et al., 2020; Liu et al., 2021d) boleh mencapai matlamat ini, dan pada dasarnya, dengan reka bentuk segera yang sesuai, ia boleh menyatukan hampir semua jenis isyarat ke dalam gaya model bahasa.

Kajian ini membahagikan isyarat kepada dua kategori luas: isyarat umum dan isyarat berkaitan tugas. Yang pertama mengandungi pengetahuan bahasa asas dan boleh memberi manfaat kepada semua tugas hiliran pada tahap tertentu, manakala yang kedua boleh memanfaatkan beberapa tugas hiliran tertentu.

Eksperimen pada 55 set data NLP yang biasa digunakan

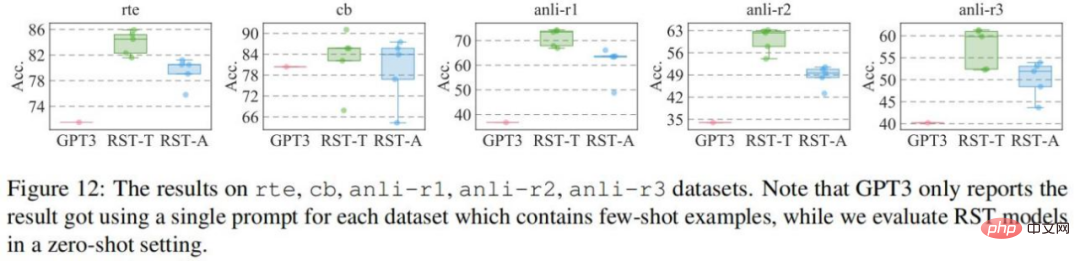

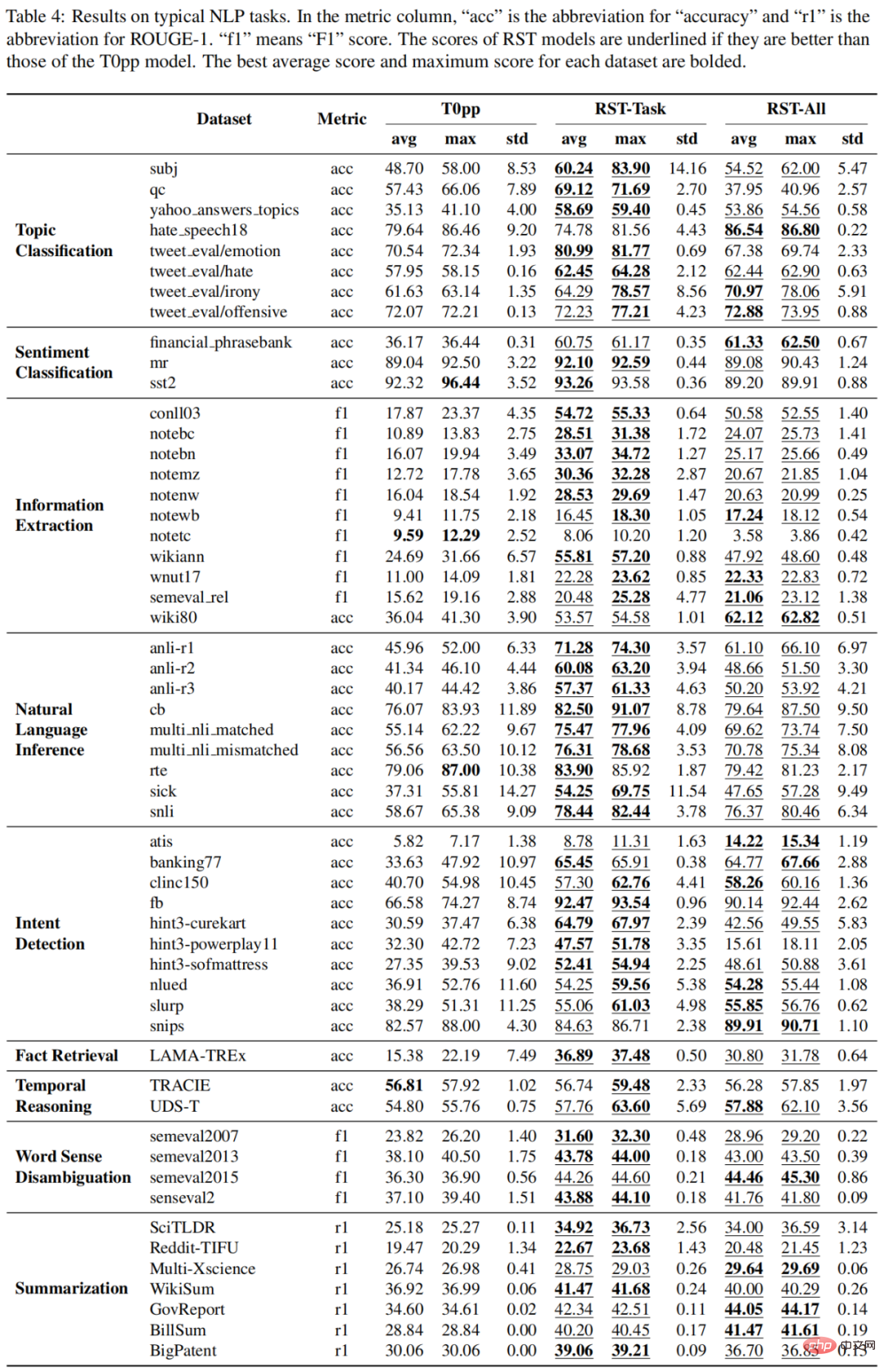

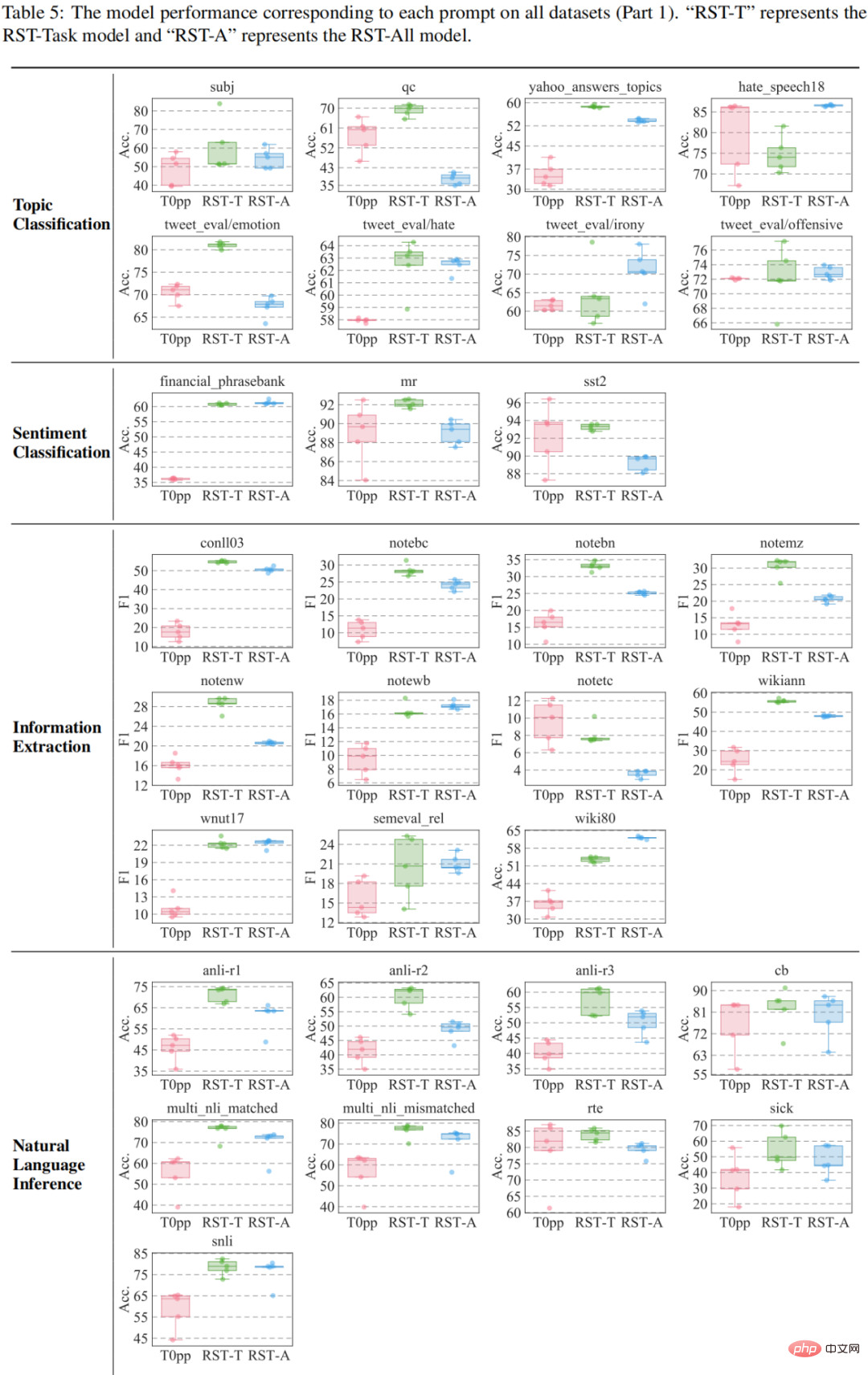

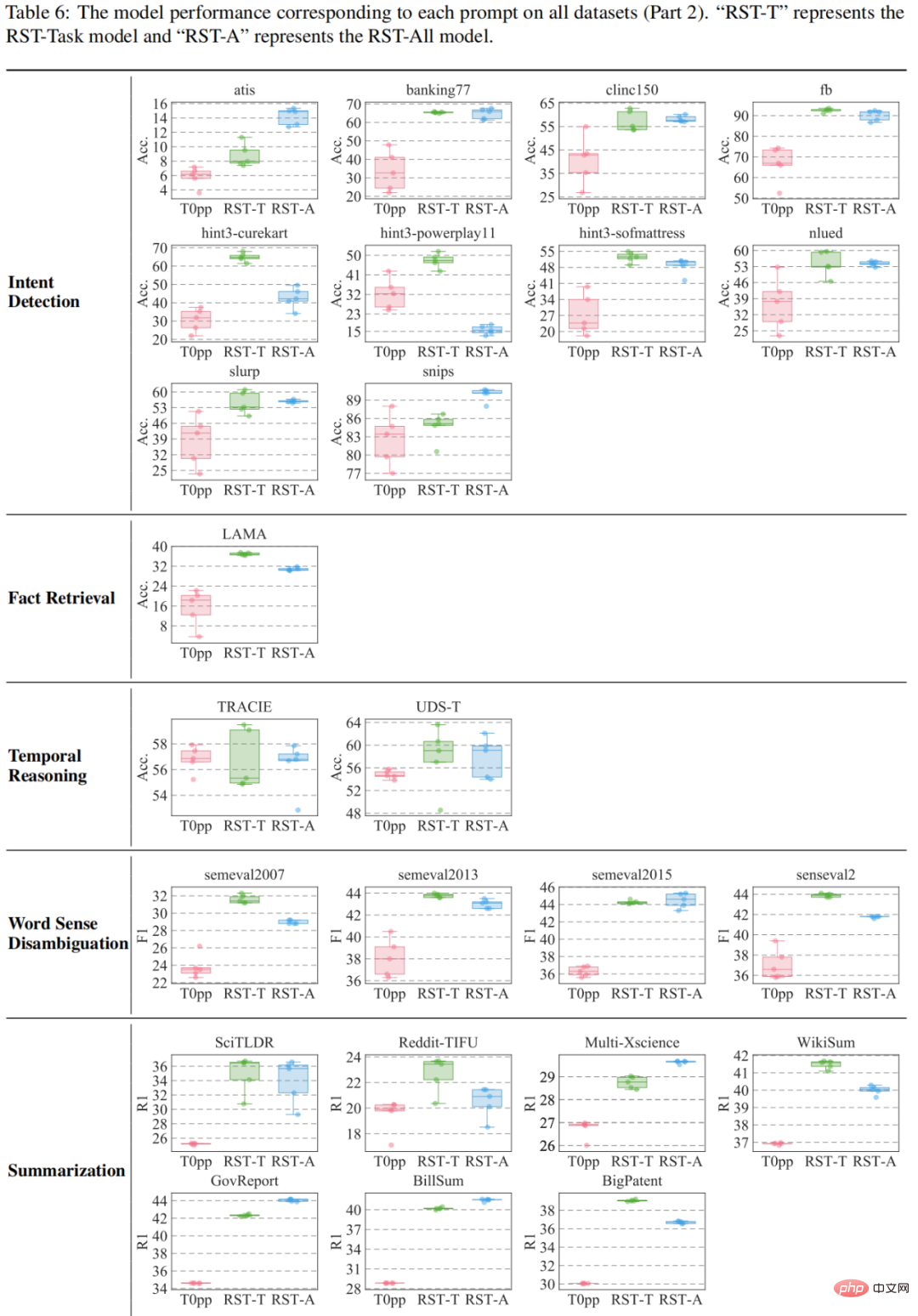

Kajian telah dinilai pada 55 set data dan kemudian membandingkannya dengan GPT3 dan T0pp masing-masing. Keputusan perbandingan dengan GPT3 ditunjukkan dalam rajah: pada empat set data kecuali set data cb, kedua-dua RST-All dan RST-Task mempunyai prestasi sifar pukulan yang lebih baik daripada pembelajaran beberapa pukulan GPT3. Di samping itu, set data cb adalah yang terkecil daripada set data ini, dengan hanya 56 sampel dalam set pengesahan, jadi prestasi gesaan berbeza pada set data ini akan berubah-ubah dengan banyaknya.

dan T0pp ditunjukkan dalam Jadual 4-6. Contohnya, dalam prestasi purata 55 ukuran, RST-All mengalahkan T0pp pada 49 set data dan menang dengan prestasi maksimum pada 47/55 contoh. Tambahan pula, dalam ujian prestasi purata pada 55 set data, RST-Task mengatasi T0pp pada 52 set data dan mengatasi T0pp pada 50/55 contoh. Ini menggambarkan keunggulan pembelajaran rekonstruktif.

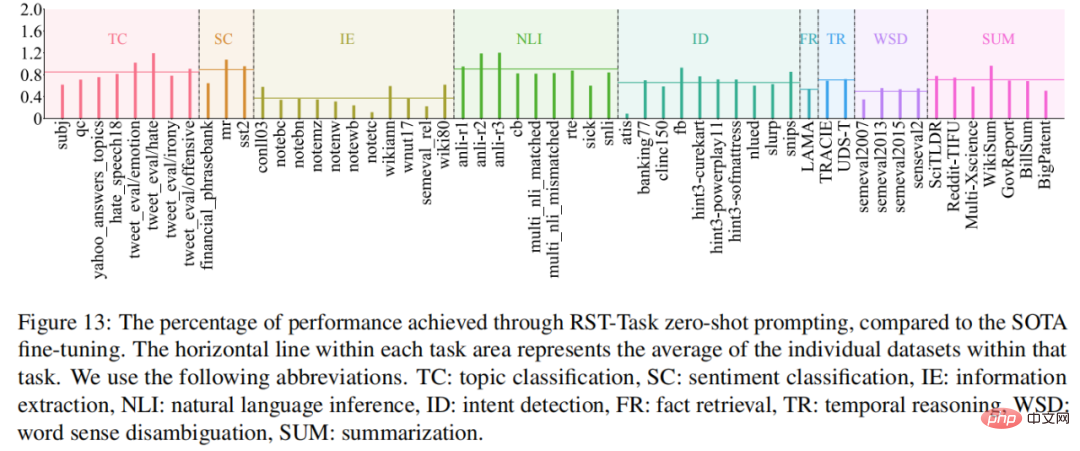

Apakah tugas yang RST-Task mahir? Untuk menjawab soalan ini, kajian ini membandingkan prestasi model RST-Task dalam tetapan sampel sifar dengan model SOTA semasa, dan hasilnya ditunjukkan dalam Rajah 13. RST-Task pandai dalam klasifikasi topik, klasifikasi sentimen dan tugas penaakulan bahasa semula jadi, tetapi berprestasi lemah dalam tugas pengekstrakan maklumat.

Eksperimen Peperiksaan Masuk Kolej: Ke Arah AI Peringkat Manusia

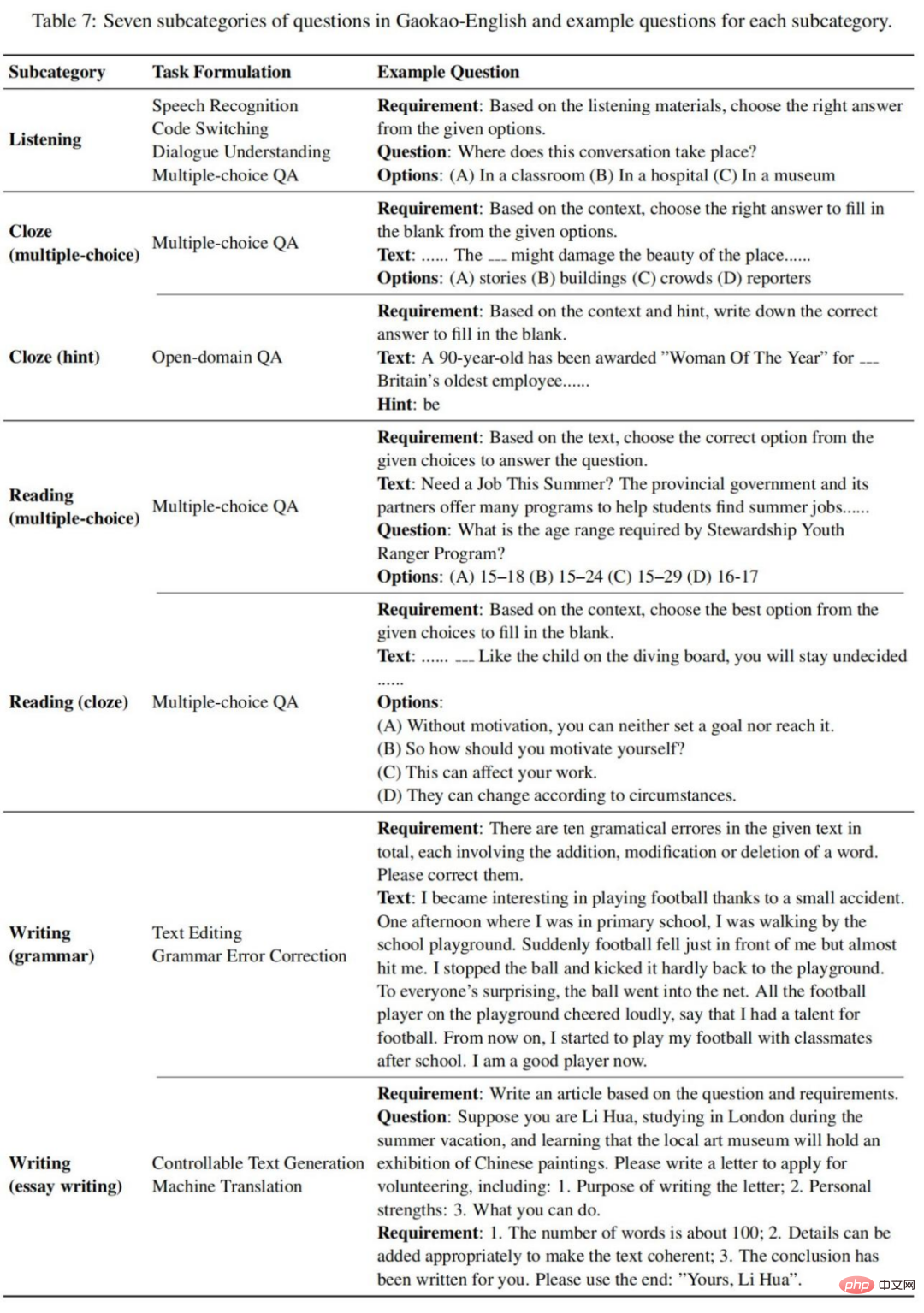

Kajian ini mengumpul 10 kertas ujian Bahasa Inggeris Peperiksaan Kemasukan Kolej, termasuk Peperiksaan Kebangsaan I/III 2018, 2019 2020 Peperiksaan Kebangsaan I/II/III, 2020 Peperiksaan Kebangsaan I/II/III, 2021 Kertas Kebangsaan A/B. Kertas ujian ini mengikut jenis soalan yang sama, dan mereka membahagikan semua jenis soalan ujian kepada tujuh subkategori berikut, seperti yang ditunjukkan dalam Jadual 7:

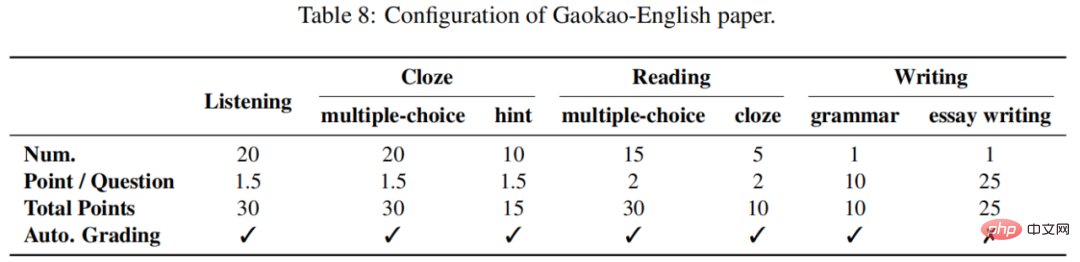

Setiap peperiksaan kemasukan kolej kertas ujian Bahasa Inggeris mempunyai markah maksimum 150 mata . Mendengar, cloze, membaca dan menulis masing-masing menyumbang 30, 45, 40, dan 35. Lazimnya, bahagian penulisan adalah subjektif dan memerlukan penilaian manusia, manakala bahagian lain adalah objektif dan boleh dijaringkan secara automatik. Seperti yang ditunjukkan dalam Jadual 8:

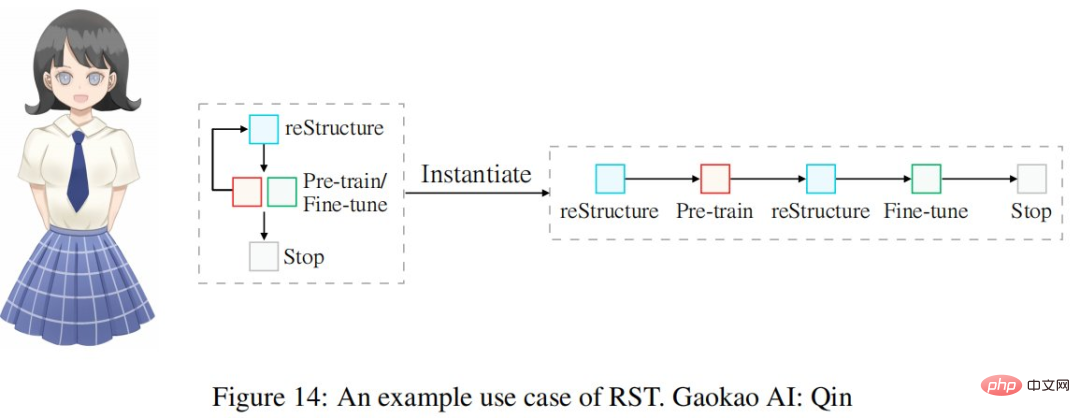

Gunakan kitaran kejuruteraan pembinaan semula yang ditunjukkan dalam Jadual 1 untuk membina sistem AI Bahasa Inggeris Peperiksaan Masuk Kolej, iaitu Qin. Keseluruhan proses ditunjukkan dalam Rajah 14:

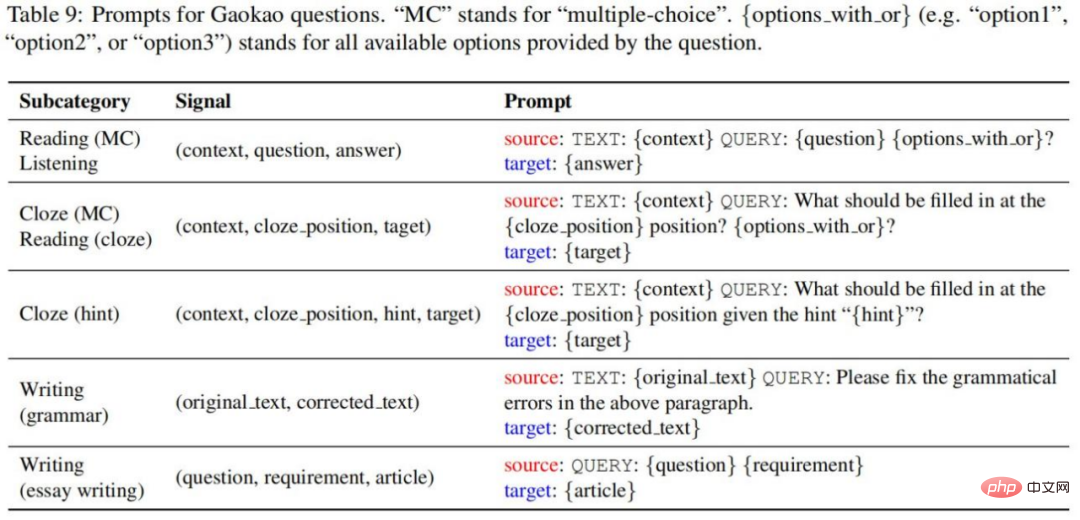

Kajian menggunakan gesaan berikut untuk menukar tuple isyarat asal kepada sampel gesaan, seperti ditunjukkan dalam Jadual 9:

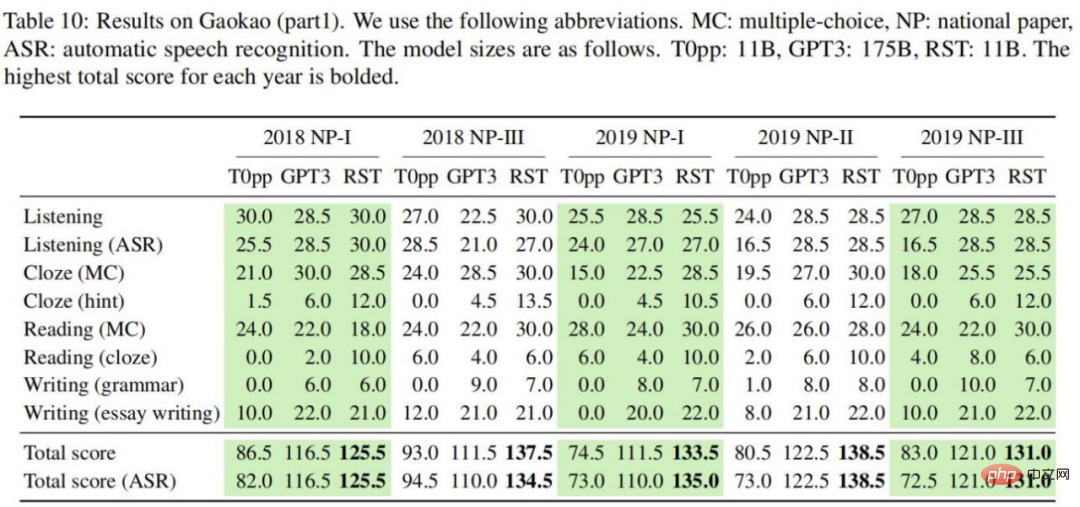

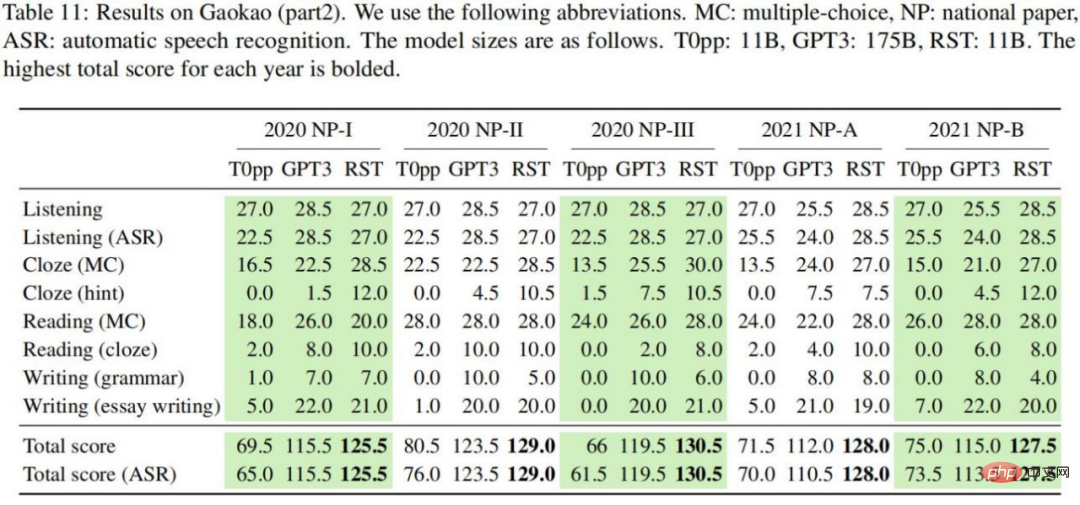

Keputusan eksperimen ditunjukkan dalam Jadual 10-11 Kita boleh membuat kesimpulan berikut: Dalam setiap kertas ujian Bahasa Inggeris, RST mencapai jumlah skor tertinggi dalam dua set ujian pendengaran, dengan purata skor 130.6 mata berbanding dengan T0pp Sebagai perbandingan, prestasi RST jauh lebih baik daripada T0pp di bawah saiz model yang sama. Merentasi semua tetapan, jumlah skor yang diperolehi oleh RST adalah secara purata 54.5 mata lebih tinggi daripada T0pp, dengan perbezaan tertinggi ialah 69 mata (46% daripada jumlah skor berbanding dengan GPT3, RST boleh mencapai keputusan yang ketara dengan saiz model 16 kali); lebih kecil. Dalam semua tetapan yang dipertimbangkan, jumlah skor yang diperolehi dengan RST adalah secara purata 14.0 mata lebih tinggi daripada T0pp, dengan maksimum 26 mata (17% daripada jumlah skor untuk T0pp, skor mendengar yang diperoleh menggunakan emas dan pertuturan); -transkrip teks berbeza dengan ketara , dengan purata 4.2 mata. Sebagai perbandingan, GPT3 dan RST masing-masing ialah 0.6 dan 0.45, menunjukkan bahawa prestasi T0pp adalah sensitif kepada kualiti teks.

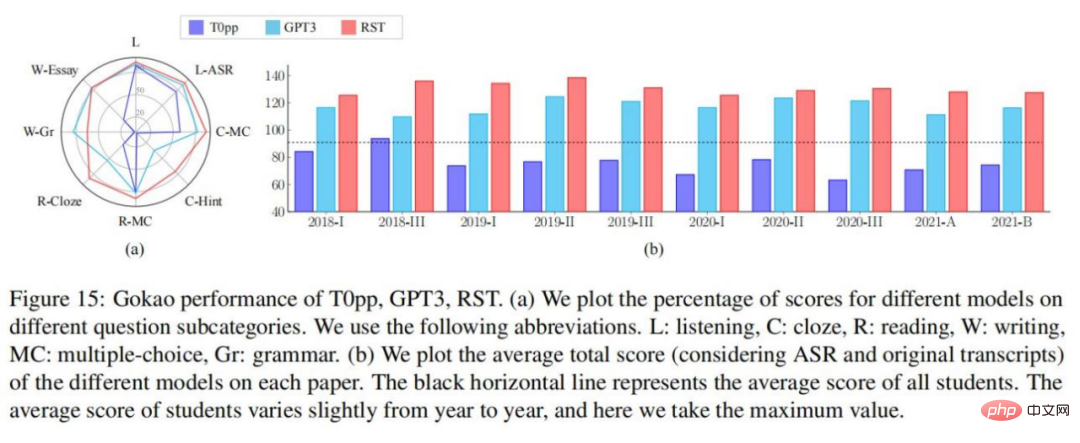

Kajian ini menjalankan analisis yang terperinci untuk memahami prestasi model yang berbeza pada subkategori masalah yang berbeza. Dalam Rajah 15-(a), adalah jelas bahawa RST dan GPT3 mengatasi T0pp pada setiap subkategori masalah.

Rajah 15-(b) menunjukkan prestasi model dan purata prestasi pelajar pada kertas ujian kebangsaan dalam beberapa tahun kebelakangan ini. Jelas sekali bahawa markah keseluruhan T0pp pada kertas 9/10 adalah di bawah purata pelajar, manakala prestasi RST dan GPT3 melebihi purata pelajar. Khususnya, lima daripada sepuluh kertas mempunyai markah keseluruhan RST melebihi 130 (sering dianggap sebagai skor sasaran untuk disasarkan oleh pelajar).

Peperiksaan Kemasukan Kolej 2022 - Ujian Bahasa Inggeris (2022.06.08) baru sahaja berakhir, dan kami mengetahui tentang prestasi model dalam kertas peperiksaan kemasukan kolej yang paling banyak tahun kebelakangan ini. Kajian ini melakukan eksperimen dengan GPT3 dan RST. Keputusan menunjukkan bahawa jumlah skor RST mencapai 134, iaitu jauh lebih tinggi daripada skor 108 yang dicapai oleh GPT3.

Atas ialah kandungan terperinci Peperiksaan Masuk Kolej Inggeris tahun ini, CMU menggunakan pra-latihan pembinaan semula untuk mencapai skor tinggi 134, dengan ketara mengatasi GPT3. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1381

1381

52

52

Tinggalkan seni bina pengekod-penyahkod dan gunakan model resapan untuk pengesanan tepi, yang lebih berkesan Universiti Teknologi Pertahanan Nasional mencadangkan DiffusionEdge

Feb 07, 2024 pm 10:12 PM

Tinggalkan seni bina pengekod-penyahkod dan gunakan model resapan untuk pengesanan tepi, yang lebih berkesan Universiti Teknologi Pertahanan Nasional mencadangkan DiffusionEdge

Feb 07, 2024 pm 10:12 PM

Rangkaian pengesanan tepi dalam semasa biasanya menggunakan seni bina penyahkod pengekod, yang mengandungi modul pensampelan atas dan bawah untuk mengekstrak ciri berbilang peringkat dengan lebih baik. Walau bagaimanapun, struktur ini mengehadkan rangkaian untuk mengeluarkan hasil pengesanan tepi yang tepat dan terperinci. Sebagai tindak balas kepada masalah ini, kertas kerja mengenai AAAI2024 menyediakan penyelesaian baharu. Tajuk tesis: DiffusionEdge:DiffusionProbabilisticModelforCrispEdgeDetection Penulis: Ye Yunfan (Universiti Teknologi Pertahanan Nasional), Xu Kai (Universiti Teknologi Pertahanan Kebangsaan), Huang Yuxing (Universiti Teknologi Pertahanan Nasional), Yi Renjiao (Universiti Teknologi Pertahanan Nasional), Cai Zhiping (Universiti Teknologi Pertahanan Negara) Pautan kertas: https ://ar

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

0. Apakah fungsi artikel ini? Kami mencadangkan DepthFM: model anggaran kedalaman monokular generatif yang serba boleh dan pantas. Sebagai tambahan kepada tugas anggaran kedalaman tradisional, DepthFM juga menunjukkan keupayaan terkini dalam tugas hiliran seperti mengecat kedalaman. DepthFM cekap dan boleh mensintesis peta kedalaman dalam beberapa langkah inferens. Mari kita baca karya ini bersama-sama ~ 1. Tajuk maklumat kertas: DepthFM: FastMonocularDepthEstimationwithFlowMatching Pengarang: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

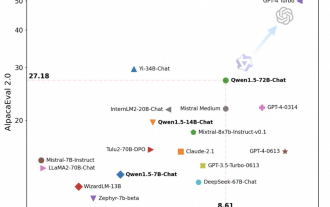

Tongyi Qianwen adalah sumber terbuka sekali lagi, Qwen1.5 membawakan enam model volum, dan prestasinya melebihi GPT3.5

Feb 07, 2024 pm 10:15 PM

Tongyi Qianwen adalah sumber terbuka sekali lagi, Qwen1.5 membawakan enam model volum, dan prestasinya melebihi GPT3.5

Feb 07, 2024 pm 10:15 PM

Pada masanya untuk Festival Musim Bunga, versi 1.5 Model Tongyi Qianwen (Qwen) berada dalam talian. Pagi ini, berita versi baharu itu menarik perhatian komuniti AI. Versi baharu model besar termasuk enam saiz model: 0.5B, 1.8B, 4B, 7B, 14B dan 72B. Antaranya, prestasi versi terkuat mengatasi GPT3.5 dan Mistral-Medium. Versi ini termasuk model Base dan model Sembang, dan menyediakan sokongan berbilang bahasa. Pasukan Tongyi Qianwen Alibaba menyatakan bahawa teknologi yang berkaitan juga telah dilancarkan di laman web rasmi Tongyi Qianwen dan Apl Tongyi Qianwen. Selain itu, keluaran Qwen 1.5 hari ini juga mempunyai sorotan berikut: menyokong panjang konteks 32K membuka pusat pemeriksaan model Base+Chat;

Model besar juga boleh dihiris, dan Microsoft SliceGPT sangat meningkatkan kecekapan pengiraan LLAMA-2

Jan 31, 2024 am 11:39 AM

Model besar juga boleh dihiris, dan Microsoft SliceGPT sangat meningkatkan kecekapan pengiraan LLAMA-2

Jan 31, 2024 am 11:39 AM

Model bahasa besar (LLM) biasanya mempunyai berbilion parameter dan dilatih menggunakan trilion token. Walau bagaimanapun, model sedemikian sangat mahal untuk dilatih dan digunakan. Untuk mengurangkan keperluan pengiraan, pelbagai teknik pemampatan model sering digunakan. Teknik pemampatan model ini secara amnya boleh dibahagikan kepada empat kategori: penyulingan, penguraian tensor (termasuk pemfaktoran peringkat rendah), pemangkasan dan kuantisasi. Kaedah pemangkasan telah wujud sejak sekian lama, tetapi banyak yang memerlukan penalaan halus pemulihan (RFT) selepas pemangkasan untuk mengekalkan prestasi, menjadikan keseluruhan proses mahal dan sukar untuk skala. Penyelidik dari ETH Zurich dan Microsoft telah mencadangkan penyelesaian kepada masalah ini yang dipanggil SliceGPT. Idea teras kaedah ini adalah untuk mengurangkan pembenaman rangkaian dengan memadamkan baris dan lajur dalam matriks berat.

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas secara rasmi memasuki era robot elektrik! Semalam, Atlas hidraulik hanya "menangis" menarik diri daripada peringkat sejarah Hari ini, Boston Dynamics mengumumkan bahawa Atlas elektrik sedang berfungsi. Nampaknya dalam bidang robot humanoid komersial, Boston Dynamics berazam untuk bersaing dengan Tesla. Selepas video baharu itu dikeluarkan, ia telah pun ditonton oleh lebih sejuta orang dalam masa sepuluh jam sahaja. Orang lama pergi dan peranan baru muncul. Ini adalah keperluan sejarah. Tidak dinafikan bahawa tahun ini adalah tahun letupan robot humanoid. Netizen mengulas: Kemajuan robot telah menjadikan majlis pembukaan tahun ini kelihatan seperti manusia, dan tahap kebebasan adalah jauh lebih besar daripada manusia Tetapi adakah ini benar-benar bukan filem seram? Pada permulaan video, Atlas berbaring dengan tenang di atas tanah, seolah-olah terlentang. Apa yang berikut adalah rahang-jatuh

LLaVA-1.6, yang mengejar Gemini Pro dan meningkatkan keupayaan penaakulan dan OCR, terlalu berkuasa

Feb 01, 2024 pm 04:51 PM

LLaVA-1.6, yang mengejar Gemini Pro dan meningkatkan keupayaan penaakulan dan OCR, terlalu berkuasa

Feb 01, 2024 pm 04:51 PM

Pada April tahun lepas, penyelidik dari Universiti Wisconsin-Madison, Penyelidikan Microsoft dan Universiti Columbia bersama-sama mengeluarkan LLaVA (Pembantu Bahasa dan Penglihatan Besar). Walaupun LLaVA hanya dilatih dengan set data arahan berbilang modal yang kecil, ia menunjukkan keputusan inferens yang hampir sama dengan GPT-4 pada beberapa sampel. Kemudian pada bulan Oktober, mereka melancarkan LLaVA-1.5, yang menyegarkan SOTA dalam 11 penanda aras dengan pengubahsuaian mudah kepada LLaVA asal. Hasil peningkatan ini sangat mengujakan, membawa kejayaan baharu kepada bidang pembantu AI berbilang modal. Pasukan penyelidik mengumumkan pelancaran versi LLaVA-1.6, menyasarkan penaakulan, OCR dan

Versi Kuaishou Sora 'Ke Ling' dibuka untuk ujian: menghasilkan video lebih 120-an, memahami fizik dengan lebih baik dan boleh memodelkan pergerakan kompleks dengan tepat

Jun 11, 2024 am 09:51 AM

Versi Kuaishou Sora 'Ke Ling' dibuka untuk ujian: menghasilkan video lebih 120-an, memahami fizik dengan lebih baik dan boleh memodelkan pergerakan kompleks dengan tepat

Jun 11, 2024 am 09:51 AM

Apa? Adakah Zootopia dibawa menjadi realiti oleh AI domestik? Didedahkan bersama-sama dengan video itu ialah model penjanaan video domestik berskala besar baharu yang dipanggil "Keling". Sora menggunakan laluan teknikal yang serupa dan menggabungkan beberapa inovasi teknologi yang dibangunkan sendiri untuk menghasilkan video yang bukan sahaja mempunyai pergerakan yang besar dan munasabah, tetapi juga mensimulasikan ciri-ciri dunia fizikal dan mempunyai keupayaan gabungan konsep dan imaginasi yang kuat. Mengikut data, Keling menyokong penjanaan video ultra panjang sehingga 2 minit pada 30fps, dengan resolusi sehingga 1080p dan menyokong berbilang nisbah aspek. Satu lagi perkara penting ialah Keling bukanlah demo atau demonstrasi hasil video yang dikeluarkan oleh makmal, tetapi aplikasi peringkat produk yang dilancarkan oleh Kuaishou, pemain terkemuka dalam bidang video pendek. Selain itu, tumpuan utama adalah untuk menjadi pragmatik, bukan untuk menulis cek kosong, dan pergi ke dalam talian sebaik sahaja ia dikeluarkan Model besar Ke Ling telah pun dikeluarkan di Kuaiying.

Daya hidup kecerdasan super membangkitkan! Tetapi dengan kedatangan AI yang mengemas kini sendiri, ibu tidak perlu lagi bimbang tentang kesesakan data

Apr 29, 2024 pm 06:55 PM

Daya hidup kecerdasan super membangkitkan! Tetapi dengan kedatangan AI yang mengemas kini sendiri, ibu tidak perlu lagi bimbang tentang kesesakan data

Apr 29, 2024 pm 06:55 PM

Saya menangis hingga mati. Dunia sedang membina model besar. Data di Internet tidak mencukupi. Model latihan kelihatan seperti "The Hunger Games", dan penyelidik AI di seluruh dunia bimbang tentang cara memberi makan data ini kepada pemakan yang rakus. Masalah ini amat ketara dalam tugas berbilang modal. Pada masa mereka mengalami kerugian, pasukan pemula dari Jabatan Universiti Renmin China menggunakan model baharu mereka sendiri untuk menjadi yang pertama di China untuk menjadikan "suapan data yang dijana model itu sendiri" menjadi kenyataan. Selain itu, ia merupakan pendekatan serampang dua mata dari segi pemahaman dan sisi penjanaan Kedua-dua pihak boleh menjana data baharu berbilang modal yang berkualiti tinggi dan memberikan maklum balas data kepada model itu sendiri. Apakah model? Awaker 1.0, model berbilang modal besar yang baru sahaja muncul di Forum Zhongguancun. Siapa pasukan itu? Enjin Sophon. Diasaskan oleh Gao Yizhao, pelajar kedoktoran di Sekolah Kecerdasan Buatan Hillhouse Universiti Renmin.