Peranti teknologi

Peranti teknologi

AI

AI

Lebih cepat daripada 0! Meta melancarkan model protein besar dengan 15 bilion parameter, menghancurkan AlphaFold2

Lebih cepat daripada 0! Meta melancarkan model protein besar dengan 15 bilion parameter, menghancurkan AlphaFold2

Lebih cepat daripada 0! Meta melancarkan model protein besar dengan 15 bilion parameter, menghancurkan AlphaFold2

Model bahasa protein terbesar setakat ini telah dikeluarkan!

Setahun yang lalu, sumber terbuka DeepMind AlphaFold2 telah dilancarkan dalam Alam Semula Jadi dan Sains, mengatasi kalangan akademik biologi dan AI.

Setahun kemudian, Meta datang dengan ESMFold, yang merupakan susunan magnitud dengan lebih pantas.

Bukan sahaja ia pantas, model ini juga mempunyai 15 bilion parameter.

LeCun menulis tweet untuk memuji ini sebagai pencapaian baharu yang hebat oleh pasukan protein Meta-FAIR.

Pengarang bersama Zeming Lin mendedahkan bahawa model besar dengan 3 bilion parameter telah dilatih pada 256 GPU selama 3 minggu, manakala ESMfold mengambil masa 10 hari pada 128 GPU. Bagi versi parameter 15 bilion, ia masih tidak jelas.

Dia juga berkata bahawa kod itu pasti akan menjadi sumber terbuka nanti, jadi nantikan!

Besar dan pantas!

Hari ini, protagonis kami ialah ESMFold, model yang secara langsung meramalkan ketepatan tinggi, hujung ke hujung, struktur tahap atom daripada jujukan protein individu.

Alamat kertas: https://www.biorxiv.org/content/10.1101/2022.07.20.500902v1

Faedah 15 bilion parameter Tidak perlu katakan – model besar hari ini boleh dilatih untuk meramalkan struktur tiga dimensi protein dengan ketepatan bersaiz atom.

Dari segi ketepatan, ESMFold adalah serupa dengan AlphaFold2 dan RoseTTAFold.

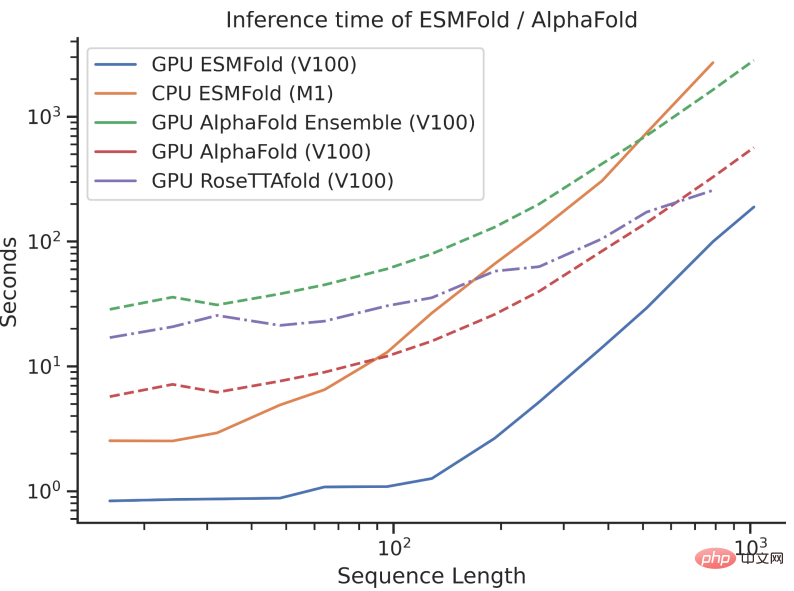

Walau bagaimanapun, kelajuan inferens ESMFold adalah susunan magnitud lebih pantas daripada AlphaFold2!

Mungkin sukar untuk memahami perbandingan kelajuan antara ketiga-tiga dengan bercakap tentang susunan magnitud Lihat sahaja gambar di bawah.

Apakah perbezaannya?

Walaupun AlphaFold2 dan RoseTTAFold telah mencapai kejayaan cemerlang dalam masalah ramalan struktur resolusi atom, mereka juga bergantung pada penggunaan penjajaran jujukan berbilang (MSA) dan serupa templat struktur protein untuk prestasi optimum.

Sebaliknya, dengan memanfaatkan perwakilan dalaman model bahasa, ESMFold boleh menjana ramalan struktur yang sepadan menggunakan hanya satu urutan sebagai input, sekali gus mempercepatkan ramalan struktur.

Para penyelidik mendapati bahawa ramalan ESMFold untuk jujukan kerumitan rendah adalah setanding dengan model terkini.

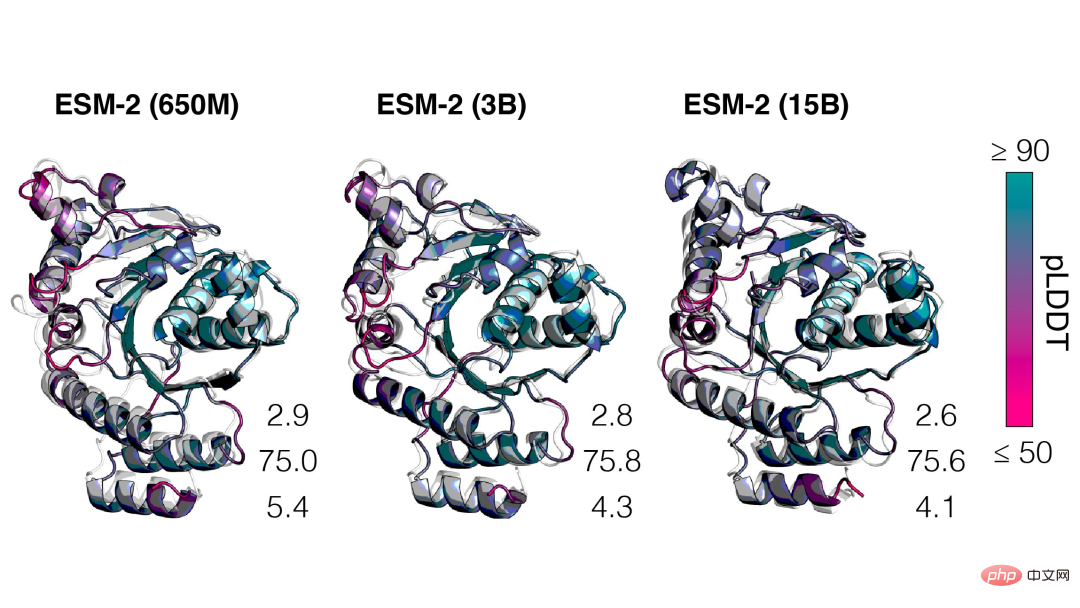

Selain itu, ketepatan ramalan struktur berkait rapat dengan kerumitan model bahasa, iaitu apabila model bahasa dapat memahami urutan dengan lebih baik, ia dapat memahami struktur dengan lebih baik.

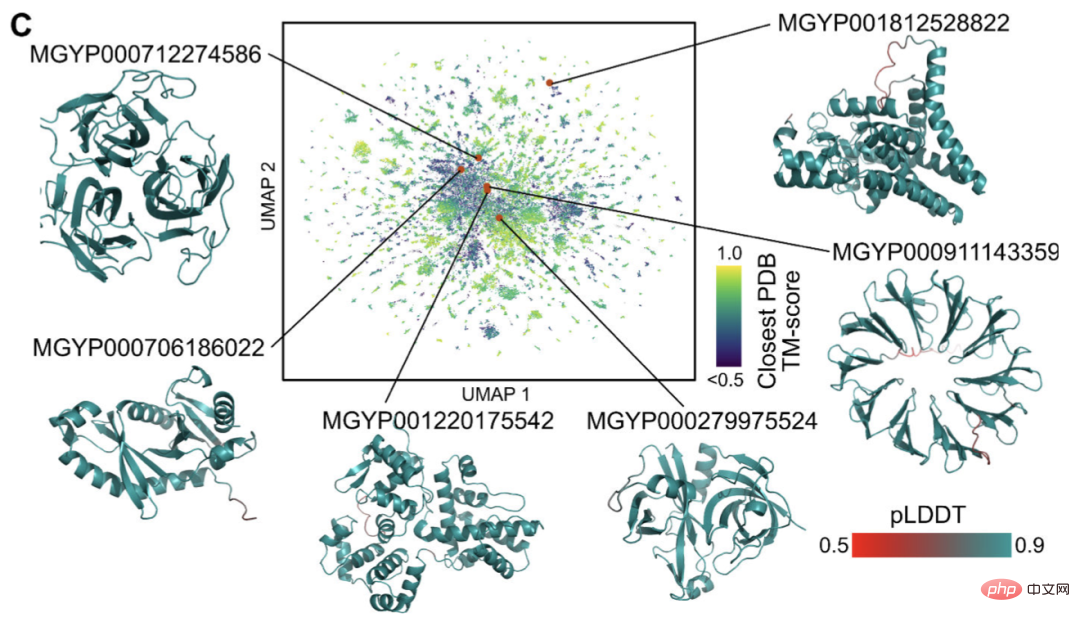

Pada masa ini, terdapat berbilion jujukan protein struktur dan fungsi yang tidak diketahui, kebanyakannya berasal daripada jujukan metagenomik.

Menggunakan ESMFold, penyelidik boleh melipat sampel rawak 1 juta jujukan metagenomik dalam masa 6 jam sahaja.

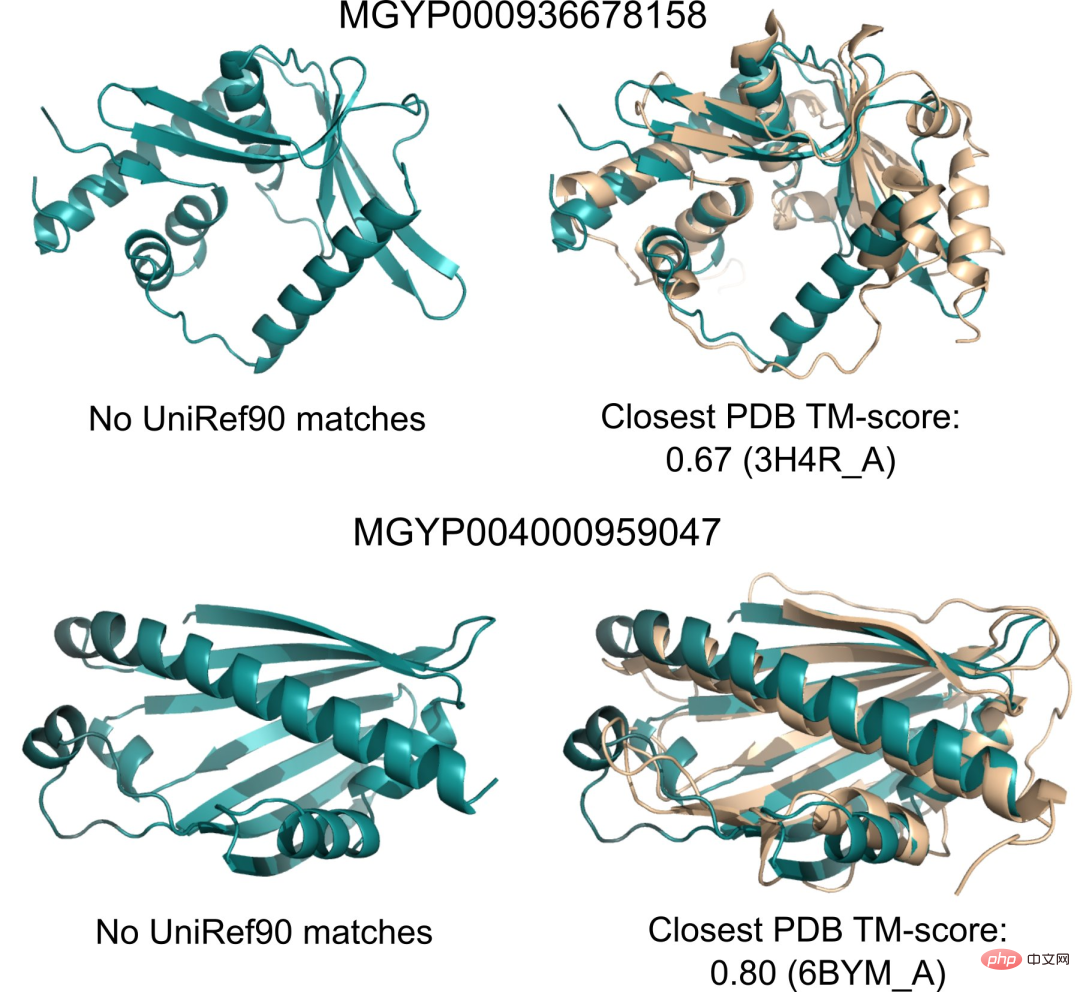

Sebahagian besar daripada ini mempunyai keyakinan yang tinggi dan tidak seperti mana-mana struktur yang diketahui (tidak direkodkan dalam pangkalan data).

Penyelidik percaya bahawa ESMFold boleh membantu memahami struktur protein yang di luar pemahaman semasa.

Di samping itu, kerana kelajuan ramalan ESMFold adalah susunan magnitud yang lebih pantas daripada model sedia ada, penyelidik boleh menggunakan ESMFold untuk membantu mengisi pangkalan data jujukan protein yang berkembang pesat dan kemajuan yang perlahan. Jurang antara struktur protein dan pangkalan data fungsi.

Model bahasa protein dengan 15 bilion parameter

Seterusnya mari kita bincangkan tentang ESMFold baharu Meta secara terperinci.

ESM-2 ialah model bahasa berasaskan Transformer dan menggunakan mekanisme perhatian untuk mempelajari corak interaksi antara pasangan asid amino dalam jujukan input.

Berbanding dengan model generasi sebelumnya ESM-1b, Meta telah menambah baik struktur model dan parameter latihan, serta menambah sumber dan data pengkomputeran. Pada masa yang sama, penambahan benam kedudukan relatif membolehkan model digeneralisasikan kepada jujukan sebarang panjang.

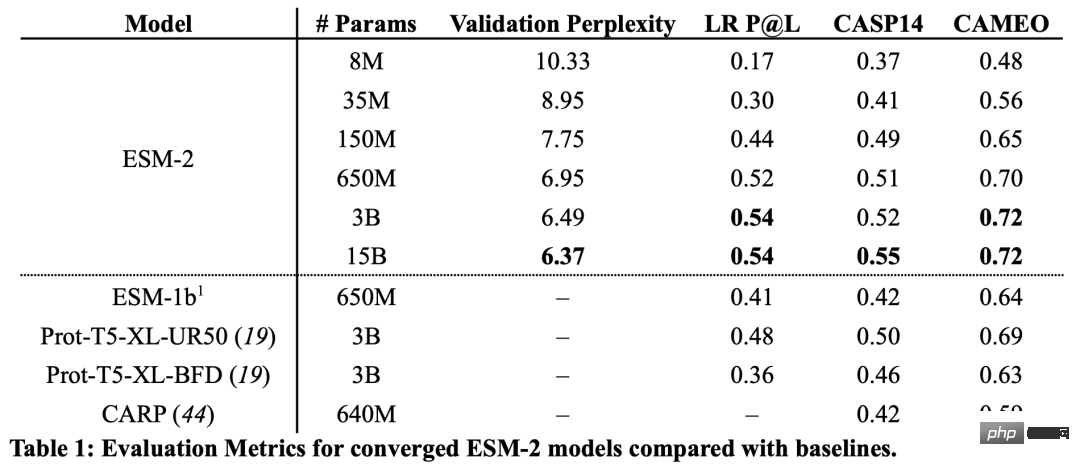

Daripada keputusan, model ESM-2 dengan 150 juta parameter berprestasi lebih baik daripada model ESM-1b dengan 650 juta parameter.

Selain itu, ESM-2 juga mengatasi model bahasa protein lain pada penanda aras ramalan struktur. Peningkatan prestasi ini adalah konsisten dengan corak yang telah ditetapkan dalam bidang pemodelan bahasa berskala besar.

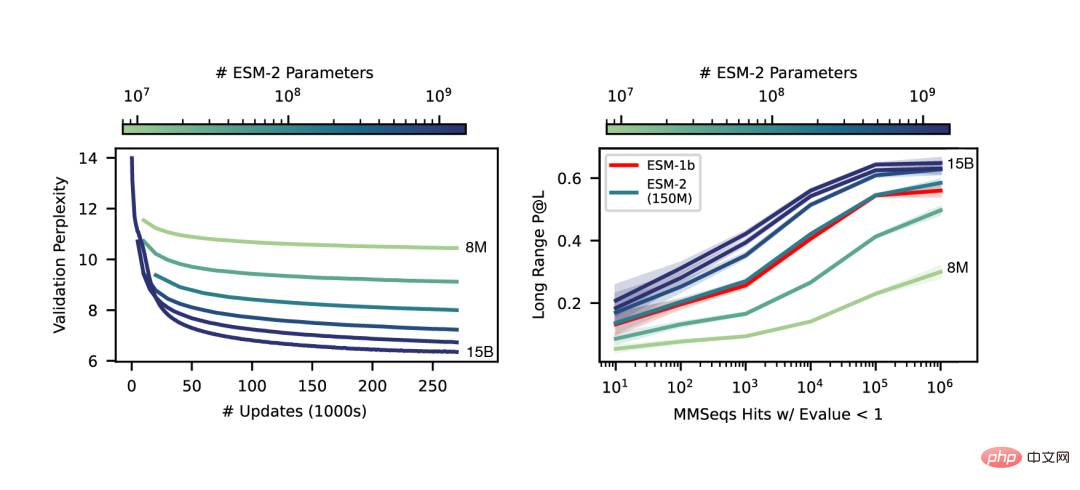

Apabila skala ESM-2 meningkat, peningkatan besar dalam ketepatan pemodelan bahasa dapat diperhatikan.

Ramalan struktur jujukan tunggal hujung ke hujung

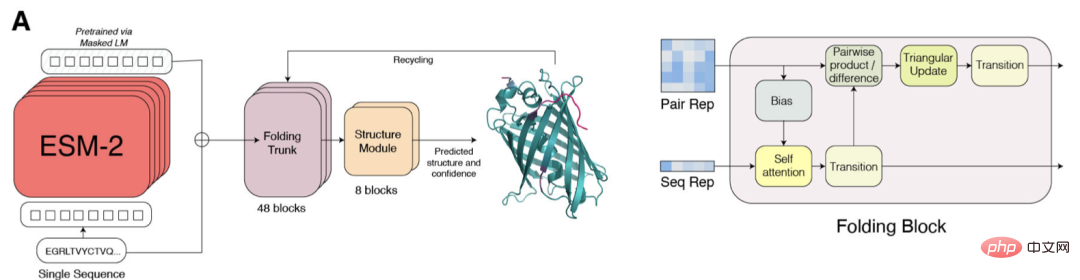

Perbezaan utama antara SMFold dan AlphaFold2 ialah ESMFold menggunakan perwakilan model bahasa, yang menghapuskan keperluan untuk Jujukan homologi eksplisit (dalam bentuk MSA) diperlukan sebagai input.

ESMFold memudahkan Evoformer dalam AlphaFold2 dengan menggantikan modul rangkaian yang mahal secara pengiraan yang mengendalikan MSA dengan modul Transformer yang mengendalikan jujukan. Penyederhanaan ini bermakna bahawa ESMFold adalah jauh lebih pantas daripada model berasaskan MSA.

Keluaran tulang belakang yang dilipat kemudiannya diproses oleh modul struktur, yang bertanggungjawab untuk mengeluarkan struktur tahap atom akhir dan keyakinan ramalan.

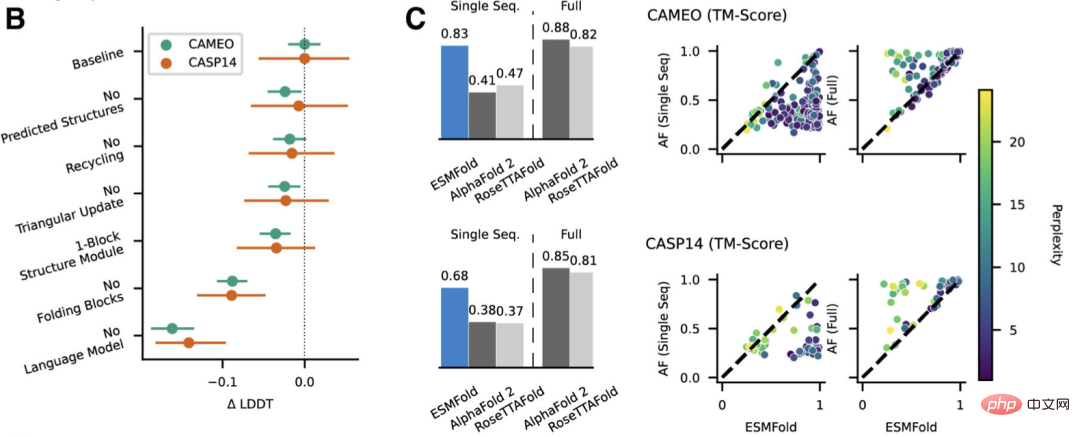

Penyelidik membandingkan ESMFold dengan AlphaFold2 dan RoseTTAFold pada set ujian CAMEO (April 2022 hingga Jun 2022) dan CASP14 (Mei 2020).

Apabila hanya satu jujukan diberikan sebagai input, ESMFold berprestasi lebih baik daripada Alphafold 2.

Apabila menggunakan saluran paip penuh, AlphaFold2 masing-masing mencapai 88.3 dan 84.7 pada CAMEO dan CASP14. ESMFold mencapai ketepatan yang setanding dengan RoseTTAfold pada CAMEO, dengan purata skor TM 82.0.

Kesimpulan

Para penyelidik mendapati bahawa model bahasa yang menyasarkan pembelajaran tanpa penyeliaan berprestasi baik pada yang besar. pangkalan data jujukan protein yang pelbagai secara evolusi, ia boleh meramalkan struktur protein dengan resolusi peringkat atom.

Dengan mengembangkan parameter model bahasa kepada 15B, kesan skala terhadap pembelajaran struktur protein boleh dikaji secara sistematik.

Kami melihat bahawa lengkung tak linear ramalan struktur protein ialah fungsi saiz model dan memerhatikan perkaitan yang kukuh antara sejauh mana model bahasa memahami jujukan dan ramalan struktur.

Model siri ESM-2 ialah model bahasa protein terbesar yang dilatih setakat ini, dengan hanya tertib magnitud parameter yang lebih sedikit daripada model teks terbesar yang dibangunkan baru-baru ini.

Selain itu, ESM-2 adalah peningkatan yang sangat besar berbanding model sebelumnya Walaupun pada parameter 150M, ESM-2 menangkap dengan lebih tepat daripada model bahasa generasi ESM-1 pada parameter 650M.

Penyelidik menyatakan bahawa pemacu terbesar prestasi ESMFold ialah model bahasa. Oleh kerana terdapat perkaitan yang kuat antara kebingungan model bahasa dan ketepatan ramalan struktur, mereka mendapati bahawa apabila ESM-2 dapat memahami urutan protein dengan lebih baik, ia boleh mencapai ramalan yang setanding dengan model terkini yang terkini.

ESMFold telah memperoleh ramalan struktur peleraian atom yang tepat, dan masa inferens adalah susunan magnitud lebih cepat daripada AlphaFold2.

Dalam amalan, kelebihan kelajuan adalah lebih hebat. Kerana ESMFold tidak perlu mencari jujukan berkaitan evolusi untuk membina MSA.

Walaupun terdapat cara yang lebih pantas untuk mengurangkan masa carian, ia mungkin masih sangat lama tidak kira berapa banyak anda mengurangkannya.

Faedah yang dibawa oleh masa inferens yang dipendekkan sangat jelas - peningkatan kelajuan akan memungkinkan untuk memetakan ruang struktur pangkalan data jujukan metagenomik yang besar.

Selain alat berasaskan struktur untuk mengenal pasti homologi dan pemuliharaan distal, ramalan struktur yang cepat dan tepat dengan ESMFold boleh memainkan peranan penting dalam analisis struktur dan fungsi bagi koleksi jujukan baharu yang besar.

Mendapatkan berjuta-juta struktur yang diramalkan dalam masa yang terhad akan membantu menemui pemahaman baharu tentang keluasan dan kepelbagaian protein semula jadi dan membolehkan penemuan struktur protein dan fungsi protein yang baharu sepenuhnya.

Pengenalan kepada pengarang

Pengarang bersama artikel ini ialah Zeming Lin daripada Meta AI.

Menurut halaman utama peribadinya, Zeming belajar untuk PhD di Universiti New York dan bekerja sebagai jurutera penyelidikan (melawat) di Meta AI, terutamanya bertanggungjawab untuk kerja infrastruktur bahagian belakang.

Dia belajar di University of Virginia untuk ijazah sarjana muda dan sarjana, di mana dia dan Yanjun Qi melakukan penyelidikan tentang aplikasi pembelajaran mesin, terutamanya dalam ramalan struktur protein.

Bidang yang diminati ialah pembelajaran mendalam, ramalan struktur dan biologi maklumat.

Atas ialah kandungan terperinci Lebih cepat daripada 0! Meta melancarkan model protein besar dengan 15 bilion parameter, menghancurkan AlphaFold2. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Robot DeepMind bermain pingpong, dan pukulan depan dan pukulan kilasnya tergelincir ke udara, mengalahkan manusia pemula sepenuhnya

Aug 09, 2024 pm 04:01 PM

Robot DeepMind bermain pingpong, dan pukulan depan dan pukulan kilasnya tergelincir ke udara, mengalahkan manusia pemula sepenuhnya

Aug 09, 2024 pm 04:01 PM

Tetapi mungkin dia tidak dapat mengalahkan lelaki tua di taman itu? Sukan Olimpik Paris sedang rancak berlangsung, dan pingpong telah menarik perhatian ramai. Pada masa yang sama, robot juga telah membuat penemuan baru dalam bermain pingpong. Sebentar tadi, DeepMind mencadangkan ejen robot pembelajaran pertama yang boleh mencapai tahap pemain amatur manusia dalam pingpong yang kompetitif. Alamat kertas: https://arxiv.org/pdf/2408.03906 Sejauh manakah robot DeepMind bermain pingpong? Mungkin setanding dengan pemain amatur manusia: kedua-dua pukulan depan dan pukulan kilas: pihak lawan menggunakan pelbagai gaya permainan, dan robot juga boleh bertahan: servis menerima dengan putaran yang berbeza: Walau bagaimanapun, keamatan permainan nampaknya tidak begitu sengit seperti lelaki tua di taman itu. Untuk robot, pingpong

Fahami Tokenisasi dalam satu artikel!

Apr 12, 2024 pm 02:31 PM

Fahami Tokenisasi dalam satu artikel!

Apr 12, 2024 pm 02:31 PM

Model bahasa menaakul tentang teks, yang biasanya dalam bentuk rentetan, tetapi input kepada model hanya boleh menjadi nombor, jadi teks perlu ditukar kepada bentuk berangka. Tokenisasi ialah tugas asas pemprosesan bahasa semula jadi Mengikut keperluan khusus, urutan teks berterusan (seperti ayat, perenggan, dll.) boleh dibahagikan kepada urutan aksara (seperti perkataan, frasa, aksara, tanda baca, dsb. berbilang. unit), di mana unit Dipanggil token atau perkataan. Mengikut proses khusus yang ditunjukkan dalam rajah di bawah, ayat teks mula-mula dibahagikan kepada unit, kemudian elemen tunggal didigitalkan (dipetakan ke dalam vektor), kemudian vektor ini dimasukkan ke dalam model untuk pengekodan, dan akhirnya output ke tugas hiliran untuk seterusnya memperoleh keputusan akhir. Pembahagian teks boleh dibahagikan kepada Toke mengikut butiran pembahagian teks.

Penalaan halus parameter yang cekap bagi model bahasa berskala besar--siri penalaan halus BitFit/Awalan/Prompt

Oct 07, 2023 pm 12:13 PM

Penalaan halus parameter yang cekap bagi model bahasa berskala besar--siri penalaan halus BitFit/Awalan/Prompt

Oct 07, 2023 pm 12:13 PM

Pada tahun 2018, Google mengeluarkan BERT Sebaik sahaja ia dikeluarkan, ia mengalahkan keputusan terkini (Sota) bagi 11 tugasan NLP dalam satu masa, menjadi satu kejayaan baharu dalam dunia NLP dalam rajah di bawah. Di sebelah kiri ialah pratetap model BERT Proses latihan, di sebelah kanan ialah proses penalaan halus untuk tugasan tertentu. Antaranya, peringkat penalaan halus adalah untuk penalaan halus apabila ia kemudiannya digunakan dalam beberapa tugas hiliran, seperti klasifikasi teks, penandaan sebahagian daripada pertuturan, sistem soal jawab, dsb. BERT boleh diperhalusi pada pelbagai tugas tanpa melaraskan struktur. Melalui reka bentuk tugas "model bahasa pra-latihan + penalaan halus tugas hiliran", ia membawa kesan model yang berkuasa. Sejak itu, "model bahasa pra-latihan + penalaan tugas hiliran" telah menjadi latihan arus perdana dalam bidang NLP.

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Editor |ScienceAI Question Answering (QA) set data memainkan peranan penting dalam mempromosikan penyelidikan pemprosesan bahasa semula jadi (NLP). Set data QA berkualiti tinggi bukan sahaja boleh digunakan untuk memperhalusi model, tetapi juga menilai dengan berkesan keupayaan model bahasa besar (LLM), terutamanya keupayaan untuk memahami dan menaakul tentang pengetahuan saintifik. Walaupun pada masa ini terdapat banyak set data QA saintifik yang meliputi bidang perubatan, kimia, biologi dan bidang lain, set data ini masih mempunyai beberapa kekurangan. Pertama, borang data adalah agak mudah, kebanyakannya adalah soalan aneka pilihan. Ia mudah dinilai, tetapi mengehadkan julat pemilihan jawapan model dan tidak dapat menguji sepenuhnya keupayaan model untuk menjawab soalan saintifik. Sebaliknya, Soal Jawab terbuka

Tiga rahsia untuk menggunakan model besar dalam awan

Apr 24, 2024 pm 03:00 PM

Tiga rahsia untuk menggunakan model besar dalam awan

Apr 24, 2024 pm 03:00 PM

Kompilasi|Dihasilkan oleh Xingxuan|51CTO Technology Stack (WeChat ID: blog51cto) Dalam dua tahun lalu, saya lebih terlibat dalam projek AI generatif menggunakan model bahasa besar (LLM) berbanding sistem tradisional. Saya mula merindui pengkomputeran awan tanpa pelayan. Aplikasi mereka terdiri daripada meningkatkan AI perbualan kepada menyediakan penyelesaian analitik yang kompleks untuk pelbagai industri, dan banyak lagi keupayaan lain. Banyak perusahaan menggunakan model ini pada platform awan kerana penyedia awan awam sudah menyediakan ekosistem siap sedia dan ia merupakan laluan yang paling tidak mempunyai rintangan. Walau bagaimanapun, ia tidak murah. Awan juga menawarkan faedah lain seperti kebolehskalaan, kecekapan dan keupayaan pengkomputeran lanjutan (GPU tersedia atas permintaan). Terdapat beberapa aspek yang kurang diketahui untuk menggunakan LLM pada platform awan awam

AlphaFold 3 dilancarkan, meramalkan secara menyeluruh interaksi dan struktur protein dan semua molekul hidupan, dengan ketepatan yang jauh lebih tinggi berbanding sebelum ini

Jul 16, 2024 am 12:08 AM

AlphaFold 3 dilancarkan, meramalkan secara menyeluruh interaksi dan struktur protein dan semua molekul hidupan, dengan ketepatan yang jauh lebih tinggi berbanding sebelum ini

Jul 16, 2024 am 12:08 AM

Editor |. Kulit Lobak Sejak pengeluaran AlphaFold2 yang berkuasa pada tahun 2021, saintis telah menggunakan model ramalan struktur protein untuk memetakan pelbagai struktur protein dalam sel, menemui ubat dan melukis "peta kosmik" setiap interaksi protein yang diketahui. Baru-baru ini, Google DeepMind mengeluarkan model AlphaFold3, yang boleh melakukan ramalan struktur bersama untuk kompleks termasuk protein, asid nukleik, molekul kecil, ion dan sisa yang diubah suai. Ketepatan AlphaFold3 telah dipertingkatkan dengan ketara berbanding dengan banyak alat khusus pada masa lalu (interaksi protein-ligan, interaksi asid protein-nukleik, ramalan antibodi-antigen). Ini menunjukkan bahawa dalam satu rangka kerja pembelajaran mendalam yang bersatu, adalah mungkin untuk dicapai

RoSA: Kaedah baharu untuk penalaan halus parameter model besar yang cekap

Jan 18, 2024 pm 05:27 PM

RoSA: Kaedah baharu untuk penalaan halus parameter model besar yang cekap

Jan 18, 2024 pm 05:27 PM

Apabila model bahasa berskala ke skala yang belum pernah berlaku sebelum ini, penalaan halus menyeluruh untuk tugas hiliran menjadi sangat mahal. Bagi menyelesaikan masalah ini, penyelidik mula memberi perhatian dan mengamalkan kaedah PEFT. Idea utama kaedah PEFT adalah untuk mengehadkan skop penalaan halus kepada set kecil parameter untuk mengurangkan kos pengiraan sambil masih mencapai prestasi terkini dalam tugas pemahaman bahasa semula jadi. Dengan cara ini, penyelidik boleh menjimatkan sumber pengkomputeran sambil mengekalkan prestasi tinggi, membawa tempat tumpuan penyelidikan baharu ke bidang pemprosesan bahasa semula jadi. RoSA ialah teknik PEFT baharu yang, melalui eksperimen pada satu set penanda aras, didapati mengatasi prestasi penyesuaian peringkat rendah (LoRA) sebelumnya dan kaedah penalaan halus tulen yang jarang menggunakan belanjawan parameter yang sama. Artikel ini akan pergi secara mendalam

Melatih ViT terbesar dalam sejarah dengan mudah? Google meningkatkan model bahasa visual PaLI: menyokong 100+ bahasa

Apr 12, 2023 am 09:31 AM

Melatih ViT terbesar dalam sejarah dengan mudah? Google meningkatkan model bahasa visual PaLI: menyokong 100+ bahasa

Apr 12, 2023 am 09:31 AM

Kemajuan pemprosesan bahasa semula jadi dalam beberapa tahun kebelakangan ini sebahagian besarnya datang daripada model bahasa berskala besar Setiap model baharu yang dikeluarkan mendorong jumlah parameter dan data latihan ke tahap tertinggi baharu, dan pada masa yang sama, kedudukan penanda aras yang sedia ada akan disembelih. Sebagai contoh, pada April tahun ini, Google mengeluarkan model bahasa 540 bilion parameter PaLM (Model Bahasa Laluan), yang berjaya mengatasi manusia dalam satu siri ujian bahasa dan penaakulan, terutamanya prestasi cemerlangnya dalam senario pembelajaran sampel kecil beberapa pukulan. PaLM dianggap sebagai hala tuju pembangunan model bahasa generasi akan datang. Dengan cara yang sama, model bahasa visual sebenarnya berfungsi dengan hebat, dan prestasi boleh dipertingkatkan dengan meningkatkan saiz model. Sudah tentu, jika ia hanya model bahasa visual pelbagai tugas