Peranti teknologi

Peranti teknologi

AI

AI

Meta: Tidak perlu intubasi! AI boleh memberitahu apa yang anda fikirkan dengan melihat elektroensefalogram anda

Meta: Tidak perlu intubasi! AI boleh memberitahu apa yang anda fikirkan dengan melihat elektroensefalogram anda

Meta: Tidak perlu intubasi! AI boleh memberitahu apa yang anda fikirkan dengan melihat elektroensefalogram anda

Setiap tahun, lebih daripada 69 juta orang di seluruh dunia mengalami kecederaan otak traumatik, yang kebanyakannya tidak dapat berkomunikasi melalui pertuturan, menaip atau gerak isyarat. Jika penyelidik membangunkan teknologi yang boleh menyahkod bahasa secara langsung daripada aktiviti otak dengan cara yang tidak invasif, kehidupan mereka akan bertambah baik. Kini, Meta telah menjalankan kajian baru untuk menyelesaikan masalah ini.

Sebentar tadi, blog Meta AI rasmi menerbitkan artikel memperkenalkan teknologi baharu yang boleh menggunakan AI untuk menyahkod terus pertuturan daripada aktiviti otak.

Dari tempoh 3 saat aktiviti otak, AI ini boleh belajar daripada harian manusia Menggunakan perbendaharaan kata sebanyak 793 perkataan, segmen pertuturan yang sepadan dinyahkodkan dengan ketepatan 73%.

Dari segi sejarah, penyahkodan pertuturan daripada aktiviti otak telah menjadi matlamat lama untuk ahli sains saraf dan doktor, tetapi kebanyakan kemajuan telah bergantung pada teknik rakaman otak invasif seperti elektroensefalografi stereotaktik dan Elektrokortikografi.

Peranti ini boleh memberikan isyarat yang lebih jelas daripada kaedah bukan invasif, tetapi memerlukan campur tangan pembedahan saraf.

Walaupun hasil kerja ini mencadangkan bahawa penyahkodan pertuturan daripada rakaman aktiviti otak boleh dilaksanakan, menggunakan kaedah bukan invasif untuk menyahkod pertuturan akan memberikan penyelesaian yang lebih selamat dan berskala yang akhirnya boleh memberi manfaat lebih orang ramai.

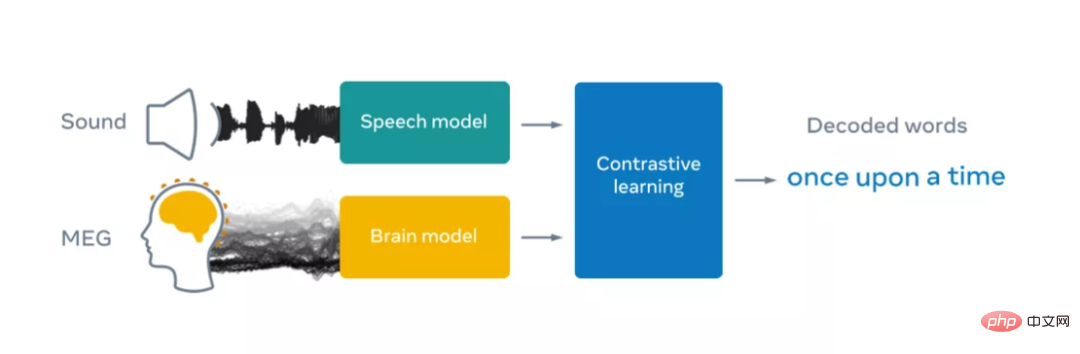

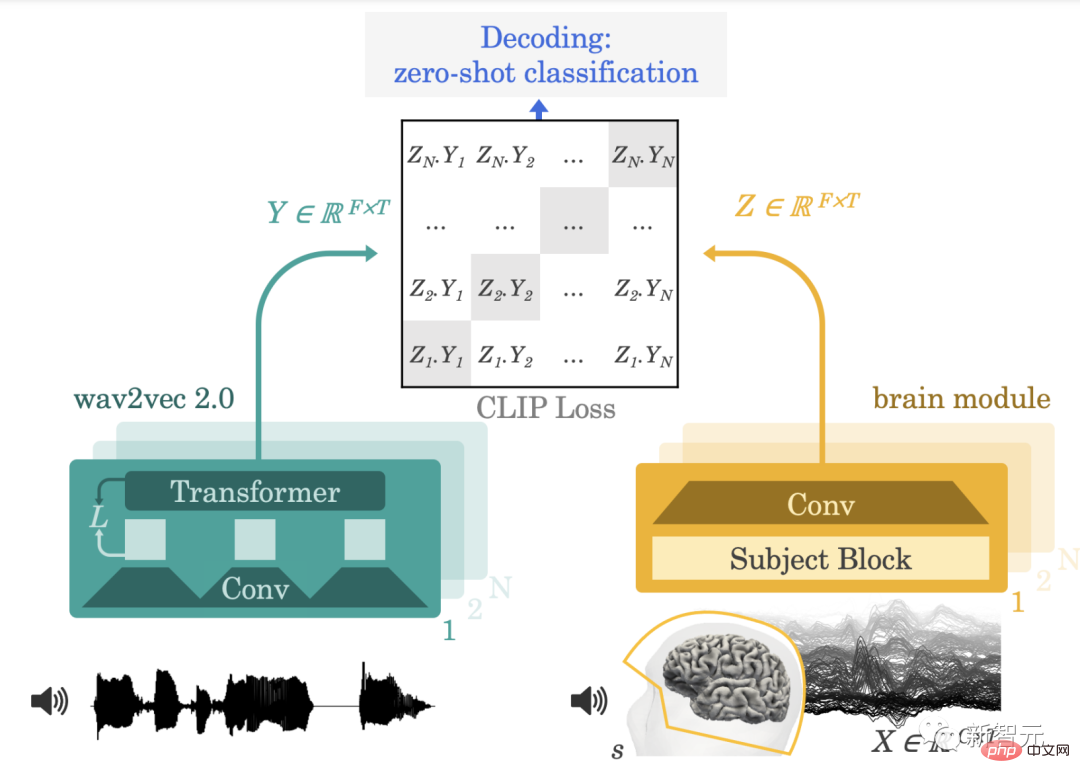

Walau bagaimanapun, ini sangat mencabar kerana rakaman bukan invasif terkenal bising dan sukar untuk dikesan atas pelbagai sebab, termasuk sifat otak setiap orang dan di mana penderia berada Diletakkan. Perbezaan boleh sangat berbeza antara sesi rakaman dan individu. Meta menangani cabaran ini dengan mencipta model pembelajaran mendalam yang dilatih dengan pembelajaran kontras dan kemudian menggunakannya untuk memaksimumkan penjajaran rakaman otak dan pertuturan bukan invasif.

Untuk tujuan ini, Meta menggunakan model pembelajaran penyeliaan kendiri sumber terbuka wave2vec 2.0 yang dibangunkan oleh pasukan FAIR pada tahun 2020 . , untuk mengenal pasti perwakilan pertuturan yang kompleks dalam otak sukarelawan yang mendengar buku audio. Meta memfokuskan pada dua teknologi bukan invasif: electroencephalography dan magnetoencephalography (EEG dan MEG untuk pendek), yang mengukur turun naik dalam medan elektrik dan magnet yang disebabkan oleh aktiviti neuron, masing-masing.

Dalam amalan, kedua-dua sistem boleh mengambil kira-kira 1,000 syot kilat aktiviti otak makroskopik sesaat menggunakan beratus-ratus penderia. Meta memanfaatkan empat set data EEG dan MEG sumber terbuka daripada institusi akademik, memanfaatkan lebih daripada 150 jam rakaman 169 sukarelawan yang sihat mendengar buku audio dan ayat terpencil dalam bahasa Inggeris dan Belanda.

Meta kemudian menyuapkan rakaman EEG dan MEG ini ke dalam model "otak" yang terdiri daripada rangkaian konvolusi dalam standard dengan sambungan baki.

Adalah diketahui bahawa rakaman EEG dan MEG berbeza secara meluas antara individu disebabkan oleh perbezaan dalam anatomi otak individu, lokasi dan masa fungsi saraf di kawasan otak, dan kedudukan sensor semasa rakaman .

Dalam amalan, ini bermakna menganalisis data otak selalunya memerlukan saluran paip kejuruteraan yang kompleks untuk menala semula isyarat otak pada otak templat. Dalam kajian terdahulu, penyahkod otak telah dilatih pada sebilangan kecil rakaman untuk meramalkan set ciri pertuturan yang terhad, seperti kategori sebahagian daripada pertuturan atau perkataan dalam perbendaharaan kata yang kecil.

Untuk memudahkan penyelidikan, Meta mereka bentuk lapisan pembenaman topik baharu, yang dilatih hujung ke hujung untuk mengatur semua rakaman otak dalam ruang bersama.

Untuk menyahkod pertuturan daripada isyarat otak bukan invasif, Meta melatih model dengan pembelajaran kontras untuk menentukur pertuturan dan aktiviti otaknya yang sepadan Akhirnya, Meta's seni bina dipelajari untuk memadankan output model otak dengan perwakilan mendalam ucapan yang disampaikan kepada peserta.

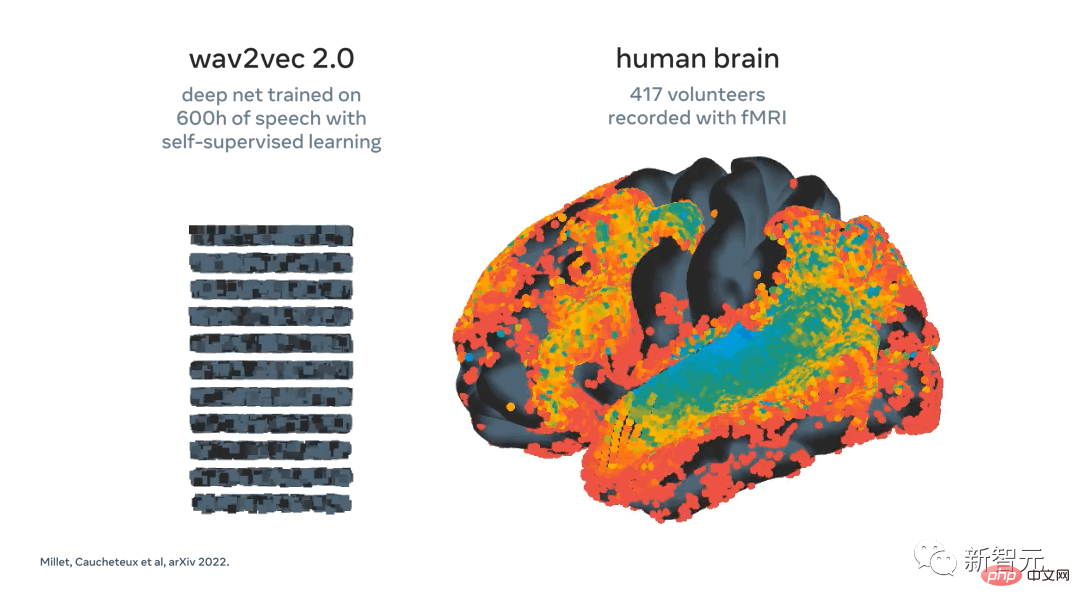

Dalam kerja terdahulu di Meta, kami menggunakan wav2vec 2.0 dan menunjukkan bahawa algoritma pertuturan ini secara automatik belajar untuk menjana perwakilan pertuturan yang konsisten dengan otak.

Kemunculan perwakilan pertuturan "seperti otak" dalam wav2vec 2.0 menjadikannya pilihan semula jadi bagi penyelidik Meta untuk membina penyahkod mereka sendiri, kerana ia membantu memaklumkan penyelidik Meta apa yang harus diekstrak daripada isyarat otak Perwakilan manakah . Meta baru-baru ini menunjukkan pengaktifan pemetaan wav2vec 2.0 (kiri) ke otak (kanan) sebagai tindak balas kepada ucapan yang sama. Perwakilan dalam lapisan pertama algoritma (warna sejuk) memetakan ke korteks pendengaran awal, manakala lapisan terdalam memetakan ke kawasan otak yang lebih tinggi (cth., korteks prefrontal dan parietal)

Selepas latihan, Meta Sistem melaksanakan apa yang dipanggil pengelasan tangkapan sifar: memandangkan klip aktiviti otak, ia boleh menentukan daripada kumpulan besar klip audio baharu yang menjepit orang yang sebenarnya didengari.

Selepas latihan, Meta Sistem melaksanakan apa yang dipanggil pengelasan tangkapan sifar: memandangkan klip aktiviti otak, ia boleh menentukan daripada kumpulan besar klip audio baharu yang menjepit orang yang sebenarnya didengari.

Algoritma menyimpulkan perkataan yang paling mungkin didengari oleh orang itu. Ini adalah langkah yang menarik kerana ia menunjukkan bahawa kecerdasan buatan boleh berjaya belajar untuk menyahkodkan rakaman bukan invasif yang bising dan berubah-ubah aktiviti otak apabila mempersepsikan pertuturan.

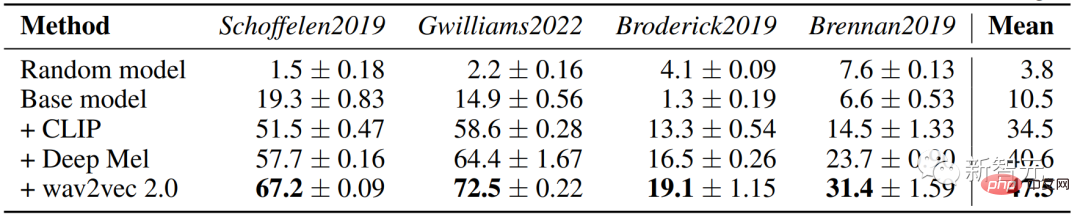

Langkah seterusnya adalah untuk melihat sama ada penyelidik boleh melanjutkan model ini untuk menyahkod pertuturan terus daripada aktiviti otak tanpa memerlukan kumpulan klip audio, iaitu, bergerak ke arah pertuturan yang selamat dan serba boleh peranti penyahkodan. Analisis penyelidik selanjutnya menunjukkan bahawa beberapa komponen algoritma kami, termasuk penggunaan wav2vec 2.0 dan lapisan topik, bermanfaat untuk prestasi penyahkodan.

Selain itu, algoritma Meta bertambah baik dengan bilangan rakaman EEG dan MEG. Secara praktikalnya, ini bermakna kaedah penyelidik Meta mendapat manfaat daripada pengekstrakan sejumlah besar data heterogen dan pada dasarnya boleh membantu meningkatkan penyahkodan set data kecil.

Ini penting kerana dalam banyak kes sukar untuk mengumpul sejumlah besar data daripada peserta tertentu. Sebagai contoh, adalah tidak realistik untuk meminta pesakit menghabiskan berpuluh-puluh jam dalam pengimbas untuk memeriksa sama ada sistem itu sesuai untuk mereka. Sebaliknya, algoritma boleh dipralatih pada set data besar yang merangkumi banyak individu dan keadaan, dan kemudian menyediakan sokongan penyahkodan untuk aktiviti otak pesakit baharu dengan sedikit data.

Penyelidikan Meta adalah menggalakkan kerana keputusan menunjukkan bahawa kecerdasan buatan yang dilatih dengan penyeliaan kendiri boleh berjaya menyahkod pertuturan yang dirasakan daripada rakaman aktiviti otak yang tidak invasif, walaupun terdapat bunyi dan kebolehubahan yang wujud. dalam data. Sudah tentu, keputusan ini hanyalah langkah pertama. Dalam usaha penyelidikan ini, Meta menumpukan pada penyahkodan persepsi pertuturan, tetapi untuk mencapai matlamat akhir komunikasi pesakit memerlukan melanjutkan kerja ini kepada penghasilan pertuturan.

Bidang penyelidikan ini malah boleh melangkaui membantu pesakit, berpotensi termasuk membolehkan cara baharu berinteraksi dengan komputer.

Melihat kepada gambaran yang lebih besar, kerja Meta adalah sebahagian daripada usaha komuniti saintifik untuk menggunakan kecerdasan buatan untuk lebih memahami otak manusia. Meta berharap untuk berkongsi penyelidikan ini secara terbuka untuk mempercepatkan kemajuan dalam cabaran masa depan.

Analisis kertas

Pautan kertas: https://arxiv.org/pdf/2208.12266.pdf

Kertas kerja ini mencadangkan seni bina hujung ke hujung tunggal yang melaksanakan latihan pembelajaran kontrastif ke atas sekumpulan besar individu untuk meramalkan perwakilan yang diselia sendiri bagi pertuturan semula jadi . Kami menilai model pada empat set data awam, yang terdiri daripada 169 sukarelawan yang dirakam dengan magnetoencephalography atau electroencephalography (M/EEG) sambil mendengar data pertuturan semula jadi.

Ini memberikan idea baharu untuk penyahkodan masa nyata pemprosesan bahasa semula jadi daripada rakaman aktiviti otak bukan invasif.

Kaedah dan Seni Bina

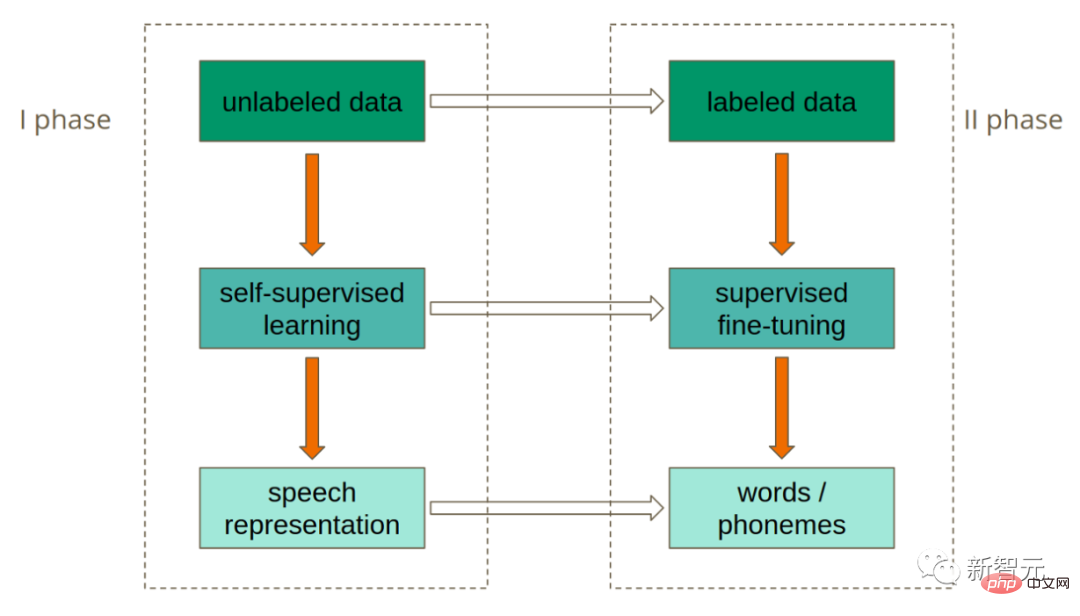

Kami mula-mula memformalkan tugas umum penyahkodan saraf dan memberi insentif latihan menggunakan kerugian kontrastif. Sebelum memperkenalkan seni bina pembelajaran mendalam untuk penyahkodan otak, kami memperkenalkan perwakilan pertuturan yang kaya yang disediakan oleh modul penyeliaan kendiri pra-terlatih wav2vec 2.0.

Kami menyasarkan untuk menjana data berdimensi tinggi daripada imbasan otak berdimensi tinggi yang direkodkan dengan magnetoencephalography (MEG) atau electroencephalography (EEG) bukan invasif manakala sukarelawan yang sihat secara pasif mendengar ayat yang dituturkan dalam mereka. bahasa ibunda.

Bagaimana bahasa pertuturan diwakili dalam otak sebahagian besarnya tidak diketahui, oleh itu penyahkod biasanya dilatih dengan cara yang diawasi untuk Meramalkan potensi perwakilan pertuturan yang diketahui relevan dengan otak.

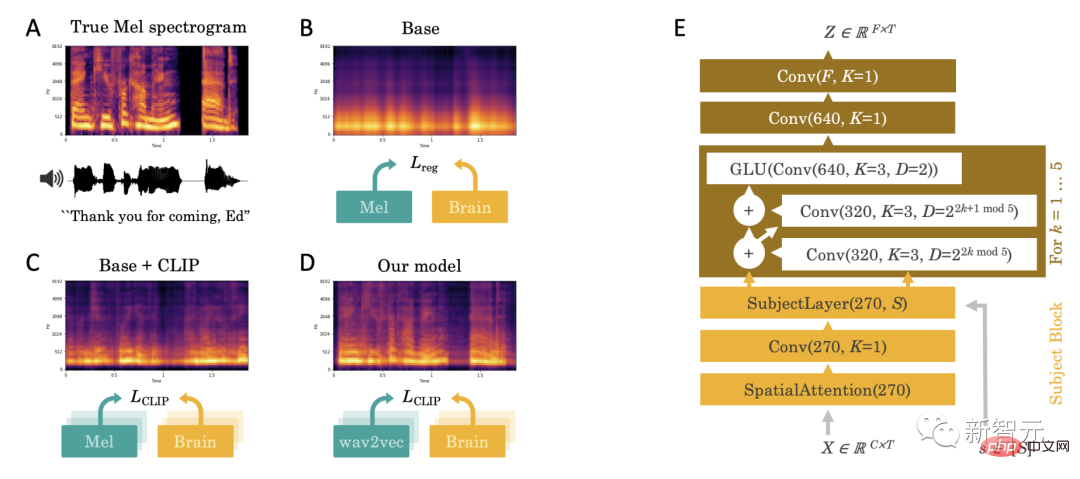

Secara empirik, kami mendapati bahawa pendekatan regresi langsung ini menghadapi beberapa cabaran: apabila pertuturan hadir, ramalan penyahkodan kelihatan didominasi oleh komponen jalur lebar yang tidak dapat dibezakan (Rajah 2.A-B).

Cabaran ini mendorong kami untuk membuat tiga sumbangan utama: memperkenalkan kehilangan kontrastif, perwakilan pertuturan mendalam yang telah dilatih dan penyahkod otak khusus.

1. Kehilangan kontrastif

Pertama, kami membuat kesimpulan bahawa regresi mungkin kerugian tidak sah kerana Ia mengalihkan perhatian kami matlamat: menyahkod pertuturan daripada aktiviti otak. Oleh itu, kami menggantikannya dengan kehilangan kontrastif, kehilangan "CLIP", yang pada asalnya direka bentuk untuk memadankan perwakilan terpendam dalam kedua-dua modaliti: teks dan imej.

2. Perwakilan pertuturan mendalam yang telah dilatih

Kedua, spektrum Mel ialah perwakilan pertuturan peringkat rendah , jadi tidak mungkin sepadan dengan perwakilan kortikal yang kaya. Oleh itu, kami menggantikan spektrum Mel Y dengan perwakilan terpendam pertuturan yang sama ada dipelajari dari hujung ke hujung (model "Deep Mel") atau dipelajari dengan model pertuturan yang diselia sendiri bebas. Dalam amalan, kami menggunakan wav2vec2-large-xlsr-531, yang telah dilatih terlebih dahulu mengenai 56k jam pertuturan dalam 53 bahasa yang berbeza.

3. "Penyahkod otak" khusus

Akhir sekali, untuk modul otak, kami menggunakan Rangkaian saraf dalam fclip mengambil sebagai input siri masa M/EEG mentah X dan pengekodan tangkapan tunggal yang sepadan bagi subjek s, dan mengeluarkan perwakilan otak terpendam Z yang disampel pada kadar yang sama seperti X.

Seni bina ini termasuk (1) lapisan perhatian spatial pada sensor M/EEG , kemudian terdiri daripada konvolusi 1x1 khusus subjek yang direka untuk mengeksploitasi kebolehubahan antara subjek, yang inputnya ialah timbunan blok konvolusi.

Keputusan menunjukkan bahawa model wav2vec 2.0 boleh mengenal pasti serpihan pertuturan yang sepadan daripada 3 saat isyarat EEG adalah setinggi 72.5% dalam 1,594 klip berbeza dan 19.1% dalam 2,604 klip rakaman EEG, membenarkan frasa yang tiada dalam set latihan dinyahkodkan.

Atas ialah kandungan terperinci Meta: Tidak perlu intubasi! AI boleh memberitahu apa yang anda fikirkan dengan melihat elektroensefalogram anda. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Gunakan penyataan padam untuk membersihkan jadual SQL

Apr 09, 2025 pm 03:00 PM

Gunakan penyataan padam untuk membersihkan jadual SQL

Apr 09, 2025 pm 03:00 PM

Ya, pernyataan padam boleh digunakan untuk membersihkan jadual SQL, langkah -langkahnya adalah seperti berikut: Gunakan pernyataan padam: padam dari meja_name; Ganti Table_name dengan nama jadual untuk dibersihkan.

phpmyadmin mencipta jadual data

Apr 10, 2025 pm 11:00 PM

phpmyadmin mencipta jadual data

Apr 10, 2025 pm 11:00 PM

Untuk membuat jadual data menggunakan phpmyadmin, langkah -langkah berikut adalah penting: Sambungkan ke pangkalan data dan klik tab baru. Namakan jadual dan pilih enjin penyimpanan (disyorkan innoDB). Tambah butiran lajur dengan mengklik butang Tambah Lajur, termasuk nama lajur, jenis data, sama ada untuk membenarkan nilai null, dan sifat lain. Pilih satu atau lebih lajur sebagai kunci utama. Klik butang Simpan untuk membuat jadual dan lajur.

Bagaimana untuk menangani pemecahan memori Redis?

Apr 10, 2025 pm 02:24 PM

Bagaimana untuk menangani pemecahan memori Redis?

Apr 10, 2025 pm 02:24 PM

Pemecahan ingatan redis merujuk kepada kewujudan kawasan bebas kecil dalam ingatan yang diperuntukkan yang tidak dapat ditugaskan semula. Strategi mengatasi termasuk: Mulakan semula Redis: Kosongkan memori sepenuhnya, tetapi perkhidmatan mengganggu. Mengoptimumkan struktur data: Gunakan struktur yang lebih sesuai untuk Redis untuk mengurangkan bilangan peruntukan dan siaran memori. Laraskan parameter konfigurasi: Gunakan dasar untuk menghapuskan pasangan nilai kunci yang paling kurang baru-baru ini. Gunakan mekanisme kegigihan: sandarkan data secara teratur dan mulakan semula redis untuk membersihkan serpihan. Pantau penggunaan memori: Cari masalah tepat pada masanya dan ambil langkah.

Cara Membuat Pangkalan Data Oracle Cara Membuat Pangkalan Data Oracle

Apr 11, 2025 pm 02:33 PM

Cara Membuat Pangkalan Data Oracle Cara Membuat Pangkalan Data Oracle

Apr 11, 2025 pm 02:33 PM

Mewujudkan pangkalan data Oracle tidak mudah, anda perlu memahami mekanisme asas. 1. Anda perlu memahami konsep pangkalan data dan Oracle DBMS; 2. Menguasai konsep teras seperti SID, CDB (pangkalan data kontena), PDB (pangkalan data pluggable); 3. Gunakan SQL*Plus untuk membuat CDB, dan kemudian buat PDB, anda perlu menentukan parameter seperti saiz, bilangan fail data, dan laluan; 4. Aplikasi lanjutan perlu menyesuaikan set aksara, memori dan parameter lain, dan melakukan penalaan prestasi; 5. Beri perhatian kepada ruang cakera, keizinan dan parameter, dan terus memantau dan mengoptimumkan prestasi pangkalan data. Hanya dengan menguasai ia dengan mahir memerlukan amalan yang berterusan, anda boleh benar -benar memahami penciptaan dan pengurusan pangkalan data Oracle.

Cara Membuat Pangkalan Data Oracle Cara Membuat Pangkalan Data Oracle

Apr 11, 2025 pm 02:36 PM

Cara Membuat Pangkalan Data Oracle Cara Membuat Pangkalan Data Oracle

Apr 11, 2025 pm 02:36 PM

Untuk membuat pangkalan data Oracle, kaedah biasa adalah menggunakan alat grafik DBCA. Langkah -langkah adalah seperti berikut: 1. Gunakan alat DBCA untuk menetapkan DBName untuk menentukan nama pangkalan data; 2. Tetapkan SYSPASSWORD dan SYSTEMPASSWORD kepada kata laluan yang kuat; 3. Tetapkan aksara dan NationalCharacterset ke Al32utf8; 4. Tetapkan MemorySize dan Tablespacesize untuk menyesuaikan mengikut keperluan sebenar; 5. Tentukan laluan logfile. Kaedah lanjutan dibuat secara manual menggunakan arahan SQL, tetapi lebih kompleks dan terdedah kepada kesilapan. Perhatikan kekuatan kata laluan, pemilihan set aksara, saiz dan memori meja makan

Pantau titisan redis dengan perkhidmatan pengeksport redis

Apr 10, 2025 pm 01:36 PM

Pantau titisan redis dengan perkhidmatan pengeksport redis

Apr 10, 2025 pm 01:36 PM

Pemantauan yang berkesan terhadap pangkalan data REDIS adalah penting untuk mengekalkan prestasi yang optimum, mengenal pasti kemungkinan kesesakan, dan memastikan kebolehpercayaan sistem keseluruhan. Perkhidmatan Pengeksport Redis adalah utiliti yang kuat yang direka untuk memantau pangkalan data REDIS menggunakan Prometheus. Tutorial ini akan membimbing anda melalui persediaan lengkap dan konfigurasi perkhidmatan pengeksport REDIS, memastikan anda membina penyelesaian pemantauan dengan lancar. Dengan mengkaji tutorial ini, anda akan mencapai tetapan pemantauan operasi sepenuhnya

Apakah parameter konfigurasi memori Redis?

Apr 10, 2025 pm 02:03 PM

Apakah parameter konfigurasi memori Redis?

Apr 10, 2025 pm 02:03 PM

** Parameter teras konfigurasi memori Redis adalah MaxMemory, yang menghadkan jumlah memori yang boleh digunakan oleh Redis. Apabila had ini melebihi, REDIS melaksanakan strategi penghapusan mengikut dasar-dasar MaxMemory, termasuk: noeviction (secara langsung menolak menulis), AllKeys-LRU/Volatile-LRU (dihapuskan oleh LRU), allkeys-rawak-rawak-rawak (dihapuskan oleh penghapusan rawak), dan volatili-volatili-ttl), dan volatili-volatili-ttl (tidak meniru-rawak), dan volatili-ttl (tidak meniminasi volatili), dan volatili-ttl (tidak meniminasi volatili), dan volatili-ttl (tidak meniru-rawak), dan volatili-ttl (eximination-ttl) Parameter lain yang berkaitan termasuk MaxMemory-Samples (kuantiti sampel LRU), RDB-Mampatan

Cara Menulis Penyataan Pangkalan Data Oracle

Apr 11, 2025 pm 02:42 PM

Cara Menulis Penyataan Pangkalan Data Oracle

Apr 11, 2025 pm 02:42 PM

Inti dari pernyataan Oracle SQL adalah pilih, masukkan, mengemas kini dan memadam, serta aplikasi fleksibel dari pelbagai klausa. Adalah penting untuk memahami mekanisme pelaksanaan di sebalik pernyataan, seperti pengoptimuman indeks. Penggunaan lanjutan termasuk subqueries, pertanyaan sambungan, fungsi analisis, dan PL/SQL. Kesilapan umum termasuk kesilapan sintaks, isu prestasi, dan isu konsistensi data. Amalan terbaik pengoptimuman prestasi melibatkan menggunakan indeks yang sesuai, mengelakkan pilih *, mengoptimumkan di mana klausa, dan menggunakan pembolehubah terikat. Menguasai Oracle SQL memerlukan amalan, termasuk penulisan kod, debugging, berfikir dan memahami mekanisme asas.