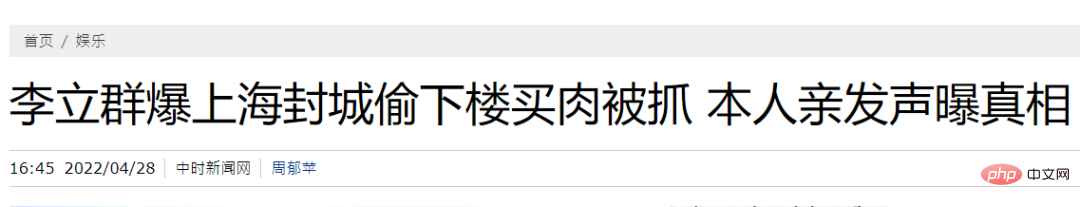

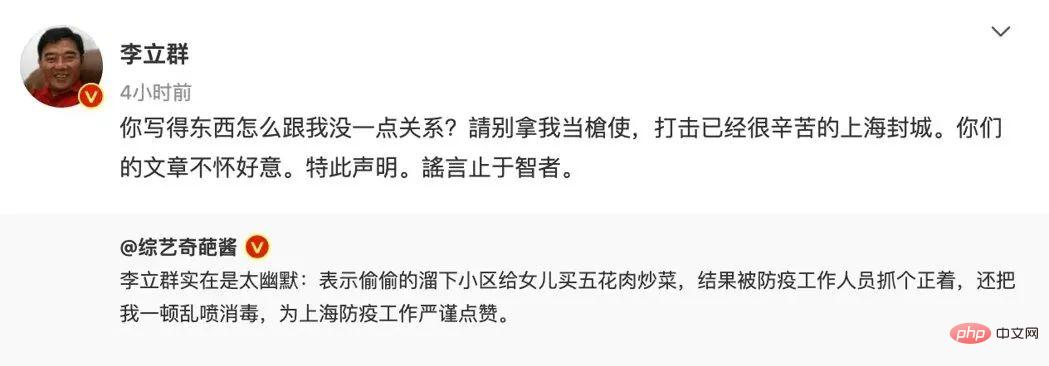

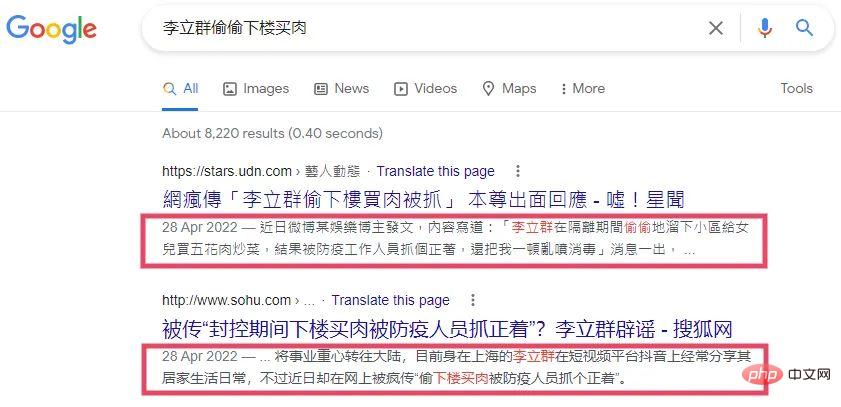

Sebagai contoh, Shanghai sekatan Dalam tempoh ini, media sendiri tertentu mendakwa bahawa "Li Liqun telah ditangkap menyelinap ke bawah untuk membeli daging." Berdasarkan dakwaan (Tuntutan) ini sahaja, kita sebenarnya tidak dapat menentukan sama ada dia secara rahsia turun ke bawah untuk membeli daging dan telah ditangkap. Untuk mengesahkan kesahihan kenyataan ini, idea yang paling intuitif ialah mencari bukti (Evidence ialah maklumat yang boleh anda kumpulkan dan boleh membantu kami mengesahkan kesahihan sesuatu kenyataan). Sebagai contoh, dalam gambar di bawah, saya hanya merobeknya dengan tangan saya, yang boleh digunakan sebagai bukti.

Sebagai contoh, Shanghai sekatan Dalam tempoh ini, media sendiri tertentu mendakwa bahawa "Li Liqun telah ditangkap menyelinap ke bawah untuk membeli daging." Berdasarkan dakwaan (Tuntutan) ini sahaja, kita sebenarnya tidak dapat menentukan sama ada dia secara rahsia turun ke bawah untuk membeli daging dan telah ditangkap. Untuk mengesahkan kesahihan kenyataan ini, idea yang paling intuitif ialah mencari bukti (Evidence ialah maklumat yang boleh anda kumpulkan dan boleh membantu kami mengesahkan kesahihan sesuatu kenyataan). Sebagai contoh, dalam gambar di bawah, saya hanya merobeknya dengan tangan saya, yang boleh digunakan sebagai bukti.

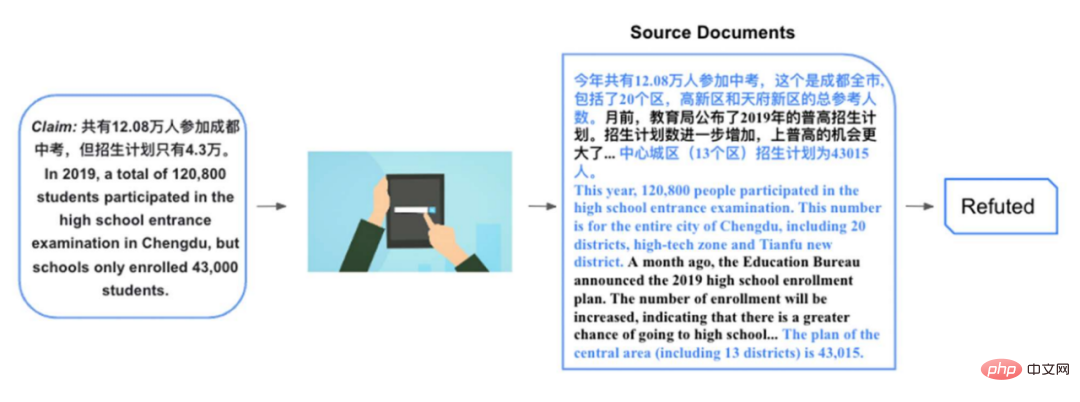

Pernyataan yang dinyatakan di atas agak mudah sahaja dan tidak perlu berdasarkan bukti . Mari kita lihat contoh yang agak kompleks di bawah. Sebagai contoh, terdapat kenyataan:

Pernyataan yang dinyatakan di atas agak mudah sahaja dan tidak perlu berdasarkan bukti . Mari kita lihat contoh yang agak kompleks di bawah. Sebagai contoh, terdapat kenyataan:

. Agak sukar untuk mengesahkan kenyataan ini Jika kami mendapati dokumen berkaitan yang melaporkan Peperiksaan Masuk Sekolah Menengah Chengdu 2019:

... Seramai 120,800 orang mengambil keputusan tertinggi. peperiksaan kemasukan sekolah tahun ini, ini adalah jumlah rujukan bandar Chengdu, termasuk 20 daerah, Zon berteknologi tinggi dan Daerah Baharu Tianfu. Beberapa bulan yang lalu, Biro Pendidikan mengumumkan rancangan enrolmen am sekolah menengah 2019. Bilangan rancangan pendaftaran telah meningkat lagi, dan peluang untuk masuk ke sekolah menengah am adalah lebih besar. ...

Pada tahun 2019, pelan pendaftaran bagi bandar tengah (13 daerah) adalah seramai 43,015 orang.Dokumen ini mengandungi banyak maklumat yang berkaitan dengan kenyataan itu, tetapi perkara yang berkaitan secara langsung dan boleh membantu kami mengesahkan kenyataan itu ialah separuh kedua perenggan kedua bahagian di atas, dan ayat pertama selepas banyak perenggan. Berdasarkan bukti-bukti ini, kita boleh tahu bahawa memang terdapat 120,800 orang yang mengambil peperiksaan kemasukan sekolah menengah di 20 daerah Chengdu, dan pelan pendaftaran untuk kawasan bandar tengah (hanya termasuk 13 daerah) sememangnya hanya 43,000. Walaupun nombornya betul, konsepnya telah diubah di sini Apabila membincangkan bilangan orang yang mengambil peperiksaan kemasukan sekolah menengah, bilangan orang di 20 daerah digunakan, tetapi apabila membincangkan rancangan pendaftaran, julat 20 daerah dikurangkan. ke 13 daerah, sekali gus mengelirukan pembaca. Untuk mengesahkan pernyataan jenis ini, kita selalunya perlu mengekstrak bukti yang berkaitan secara langsung daripada satu atau lebih dokumen, dan pada masa yang sama membuat inferens berdasarkan bukti yang diekstrak. Untuk mempromosikan sistem pembelajaran mesin semakan fakta Cina, kami mencadangkan set data Cina berasaskan bukti sedemikian.

2. Kerja berkaitan

.

Tiruan: Penjelas diminta menulis semula ayat mengikut Wikipedia sebagai kenyataan, dan perenggan yang berkaitan dalam dokumen boleh digunakan sebagai bukti Sahkan kenyataan ini. Jika ia adalah penukaran yang sinonim, maka pernyataan itu disokong oleh bukti (Disokong Jika entiti dalam ayat itu diganti, atau beberapa siri pengubahsuaian seperti penafian ditambah, maka pernyataan itu ditolak oleh bukti (Refuted). .

Tiruan: Penjelas diminta menulis semula ayat mengikut Wikipedia sebagai kenyataan, dan perenggan yang berkaitan dalam dokumen boleh digunakan sebagai bukti Sahkan kenyataan ini. Jika ia adalah penukaran yang sinonim, maka pernyataan itu disokong oleh bukti (Disokong Jika entiti dalam ayat itu diganti, atau beberapa siri pengubahsuaian seperti penafian ditambah, maka pernyataan itu ditolak oleh bukti (Refuted). .

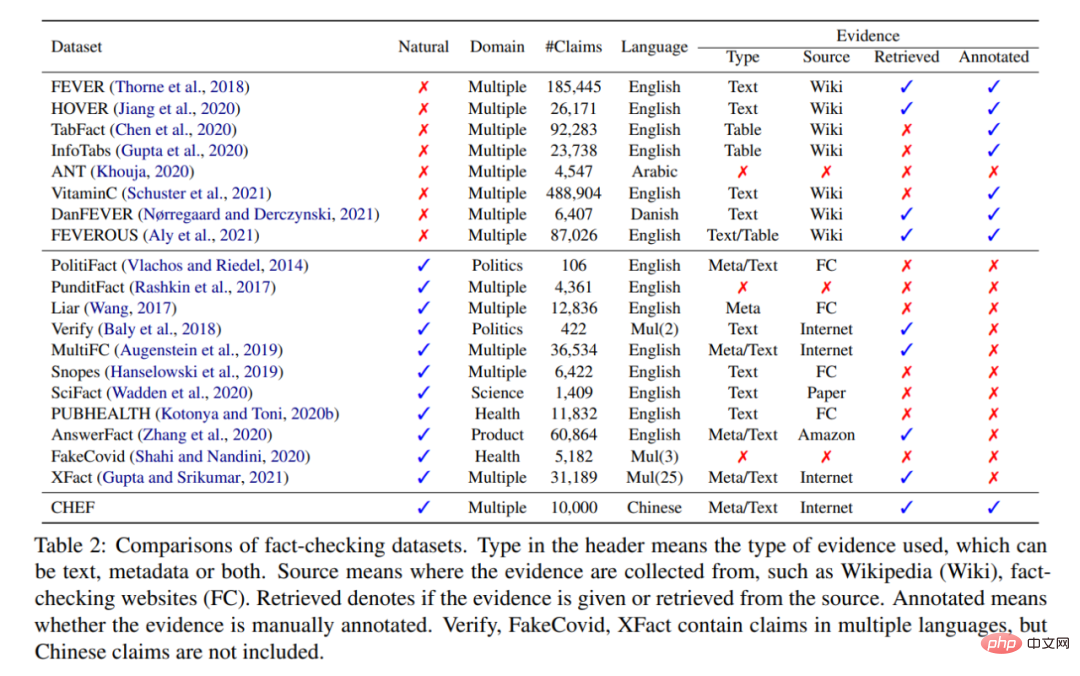

Paradigma anotasi ini pada asalnya FEVER[2], dan banyak set data terkenal kemudiannya seperti TabFact[3] turut mengikuti paradigma ini. Kelebihan set data buatan jenis ini ialah ia boleh ditingkatkan. Anotasi diminta untuk melabelkan 100,000 pernyataan, yang sangat sesuai untuk melatih rangkaian saraf. Sebaliknya, bukti yang berkaitan juga mudah diperolehi. Kelemahannya ialah kenyataan-kenyataan ini bukanlah kenyataan yang akan kita temui dalam kehidupan seharian dan popular di kalangan masyarakat umum Contohnya, anda tidak akan menulis semula kenyataan "Dia secara rahsia turun ke bawah untuk membeli daging dan ditangkap" berdasarkan Wikipedia Li Liqun. . Sebaliknya, jenis set data ini menganggap bahawa Wikipedia mengandungi semua pengetahuan untuk mengesahkan tuntutan, yang merupakan andaian yang agak kukuh. Andaian ini sering tidak dipenuhi dalam senario sebenar. Masalah paling mudah ialah Wikipedia mempunyai selang masa.

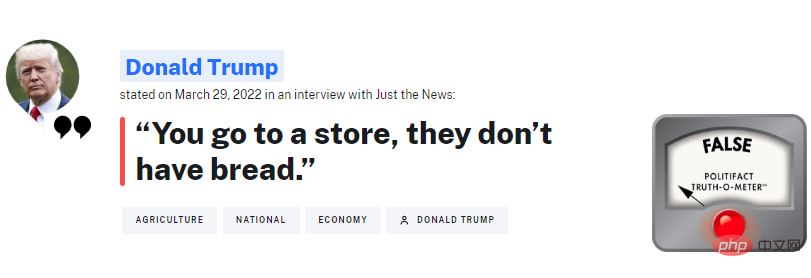

Semulajadi: Ia adalah kenyataan yang dirangkak terus dari platform semakan fakta, perbandingan asing Sebuah organisasi yang terkenal ialah PolitiFact, yang sering menyemak apa yang Trump katakan. Kelebihan set data jenis ini ialah ia merupakan satu kenyataan yang akan dihadapi oleh masyarakat umum setiap hari dan ingin mengetahui kebenarannya. Ia juga merupakan kenyataan yang perlu disemak oleh pemeriksa fakta manusia.

Sekiranya kita akhirnya mahu membina sistem yang boleh menggantikan pengesah manusia pada tahap tertentu, input sistem ini perlu menjadi pernyataan jenis ini. Kelemahan set data jenis ini juga jelas, iaitu bilangan tuntutan yang telah disahkan oleh manusia adalah sangat terhad. Seperti yang ditunjukkan oleh jadual, kebanyakan set data sebenarnya adalah susunan magnitud yang lebih kecil daripada yang dibina secara manual.

Sebaliknya, mencari bukti adalah masalah yang sangat sukar. Set data sedia ada biasanya secara langsung menggunakan artikel semakan fakta [4] sebagai bukti, atau menggunakan pernyataan untuk memasukkan pertanyaan carian Google [5][6], dan kemudian menggunakan ringkasan carian yang dikembalikan (ditunjukkan dalam kotak merah) sebagai bukti.

Terdapat dua masalah dengan kaedah mencari bukti ini:

Sebagai tindak balas kepada masalah yang dinyatakan di atas, kami membina CHEF mempunyai ciri-ciri berikut:

Pembinaan set data terdiri daripada 4 bahagian: Pengumpulan data, anotasi pernyataan, pengambilan bukti dan data pengesahan.

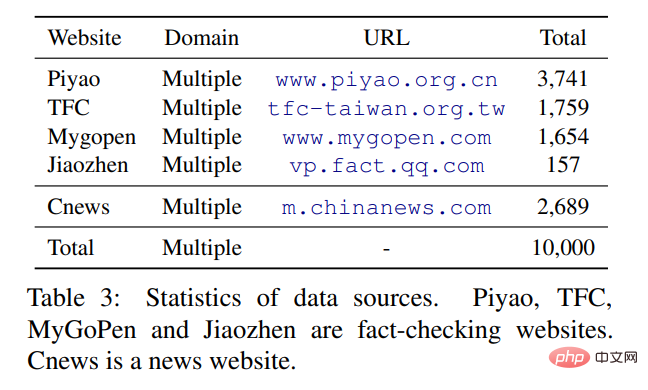

Kenyataan asal terutamanya dirangkak daripada empat laman web semakan fakta Cina (menurut Platform Berita Duke ), yang mana terdapat dua dalam Bahasa Cina Ringkas: China Rumor Refuting Center dan Tencent's Truth. Cina Tradisional datang daripada dua platform di Taiwan: MyGoPen dan Pusat Semakan Fakta Taiwan. Memandangkan sebahagian besar (90%+) dakwaan yang dirangkak dari tapak web semakan fakta adalah tidak benar, sebenarnya agak intuitif bahawa kebanyakan khabar angin/kenyataan popular adalah tidak benar sebelum ia disangkal/disahkan oleh platform pengesahan. Merujuk kepada kaedah sebelumnya (PublicHealth [7]), kami merangkak tajuk Rangkaian Berita China sebagai tuntutan sebenar dan membina set data dengan label yang agak seimbang.

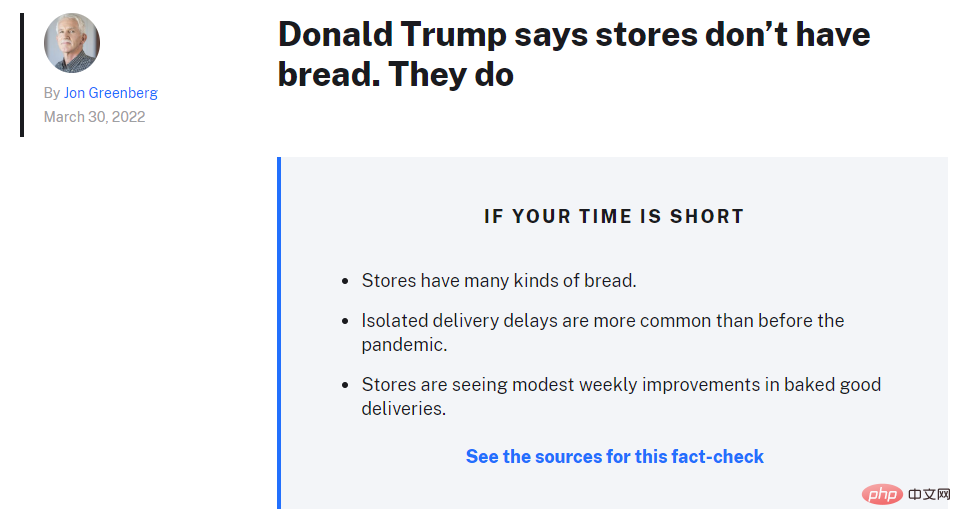

Berbanding dengan agensi pemeriksa fakta asing yang agak matang, artikel yang diterbitkan oleh platform pengesahan China adalah agak Tidak begitu piawai. Sebagai contoh, PolitiFact akan memberitahu anda dengan tepat apa tuntutan itu, apakah ringkasan pengesahan dan apakah butiran bukti dan alasan (seperti yang ditunjukkan dalam imej di atas). Walau bagaimanapun, artikel bahasa Cina secara amnya tidak menunjukkan perkara ini dengan jelas, jadi kami meminta juru anotasi membaca artikel dan mengeluarkan kenyataan yang disahkan oleh artikel tersebut. Pada masa yang sama, kenyataan itu juga dibersihkan untuk mengurangkan berat sebelah yang terkandung di dalamnya.

Kerja sebelum ini telah menunjukkan [8] bahawa kenyataan dalam set data semakan fakta mengandungi berat sebelah yang agak kuat (contohnya, kenyataan tidak benar umumnya mempunyai perkataan negatif), dan PLM seperti BERT boleh lulus Dengan menangkap berat sebelah ini secara langsung, tuntutan boleh disahkan tanpa bukti. Kaedah pembersihan termasuk menukar soalan retorik kepada ayat deklaratif dan mengeluarkan beberapa perkataan yang mungkin berat sebelah, seperti: berat, mengejutkan, dsb. Selepas mengekstrak tuntutan, kami juga meminta anotasi untuk melabelkan tuntutan berdasarkan artikel semakan fakta. Kami mengguna pakai klasifikasi yang serupa dengan siri kerja seperti FEVER, menggunakan tiga klasifikasi Maklumat Disokong, Disangkal dan Tidak Cukup (NEI). Antaranya, Refuted adalah yang terbesar dan NEI adalah yang terkecil.

Kami menggunakan pernyataan tersebut sebagai pernyataan pertanyaan untuk menanyakan carian Google, dan kemudian menapis beberapa dokumen, sebahagian daripadanya adalah dokumen selepas pernyataan itu diterbitkan, dan bahagian lain ialah Dokumen daripada platform penyebaran berita palsu, dan 5 dokumen teratas dikekalkan pada penghujungnya. Anotasi kemudian diminta memilih sehingga 5 ayat sebagai bukti bagi setiap pernyataan.

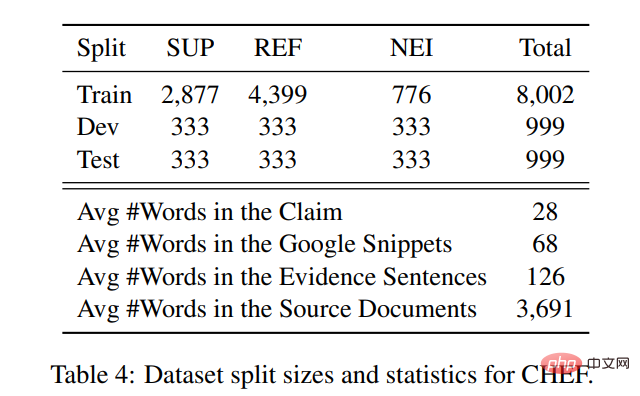

Statistik untuk tuntutan dan bukti dalam set data adalah seperti berikut: Purata panjang dokumen yang dikembalikan untuk setiap tuntutan ialah 3691 perkataan, di mana ayat yang terakhir diekstrak oleh anotasi bukti terperinci mengandungi 126 perkataan, atau purata 68 perkataan menggunakan coretan berasaskan peraturan Google. Hanya membandingkan nombor, menggunakan dokumen yang dikembalikan dan ayat beranotasi, memberikan lebih banyak maklumat kontekstual daripada menggunakan ringkasan secara langsung.

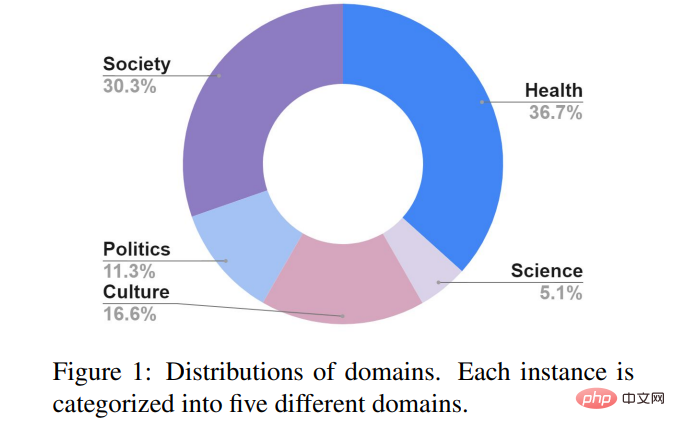

Untuk memastikan ketekalan pelabelan, kami menambah pusingan pengesahan data dan memilih 3% daripada data Sebanyak 310 pernyataan berlabel telah diedarkan kepada 5 anotasi untuk pelabelan semula. Skor Fleiss K mencapai 0.74, iaitu lebih tinggi sedikit daripada 0.68 FEVER dan 0.70 Snopes[5], menunjukkan bahawa kualiti anotasi data tidak kalah dengan set data yang dibina oleh penyelidik terdahulu. Kenyataan dalam CHEF terbahagi terutamanya kepada 5 tema: masyarakat, kesihatan awam, politik, sains dan budaya. Tidak seperti platform semakan fakta Eropah dan Amerika yang menumpukan pada bidang politik, platform China memberi lebih perhatian kepada isu kesihatan awam, seperti coronavirus baharu, penjagaan kesihatan, rawatan perubatan, dsb. Satu lagi topik utama ialah masyarakat, seperti: penipuan, pendidikan lanjutan, acara sosial, dll.

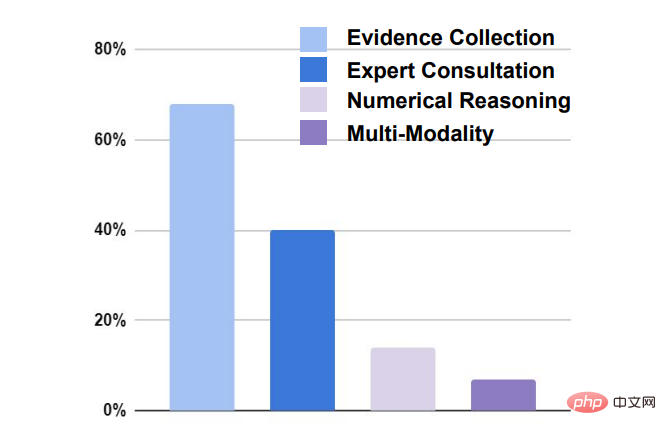

Terdapat empat cabaran utama dalam mengesahkan tuntutan:

Sama seperti set data semakan fakta klasik terdahulu (seperti DEMAM), sistem pembelajaran mesin perlu terlebih dahulu memilih ayat yang berkaitan dalam dokumen tertentu sebagai bukti (pendapatan semula bukti) , dan kemudian mengesahkan tuntutan terhadap bukti (pengesahan tuntutan).

Sama seperti set data semakan fakta klasik terdahulu (seperti DEMAM), sistem pembelajaran mesin perlu terlebih dahulu memilih ayat yang berkaitan dalam dokumen tertentu sebagai bukti (pendapatan semula bukti) , dan kemudian mengesahkan tuntutan terhadap bukti (pengesahan tuntutan).

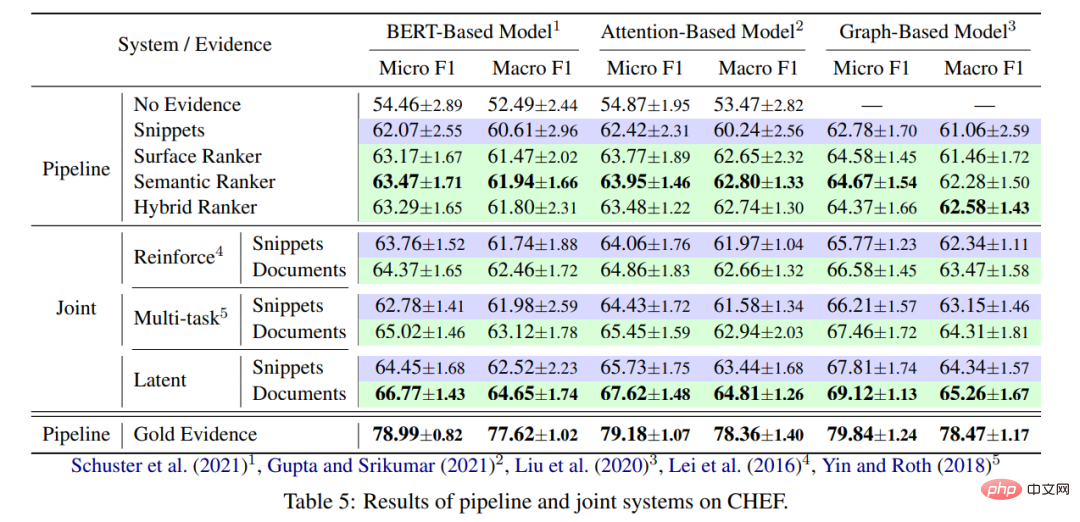

Berdasarkan kerja ribuan orang, artikel ini mencadangkan dua kategori utama sistem garis dasar: sistem saluran paip dan sambungan . Saluran Paip: Pengambilan semula bukti dan pengesahan tuntutan adalah dua modul yang berasingan Pengambil semula bukti digunakan untuk mengekstrak bukti, dan kemudian tuntutan gabungan diserahkan kepada modul pengesahan tuntutan untuk pengelasan.

Gabungan: Modul pengambilan bukti dan pengesahan tuntutan dioptimumkan bersama. Tiga model berbeza digunakan. Yang pertama ialah model bersama SOTA pada FEVER [10], yang menggunakan rangka kerja pembelajaran pelbagai tugas untuk belajar melabel bukti dan tuntutan pada masa yang sama. Yang kedua ialah memproses pengekstrakan bukti sebagai pembolehubah terpendam [11], dan melabelkan setiap ayat dokumen yang dikembalikan dengan 0 atau 1. Ayat yang dilabelkan dengan 1 akan dibiarkan sebagai bukti dan diklasifikasikan bersama dengan pernyataan itu, menggunakan REINFORCE untuk latihan . Kaedah ketiga adalah serupa dengan kaedah kedua, kecuali ia menggunakan HardKuma dan kaedah parameter berat untuk latihan bersama [12] dan bukannya menggunakan kecerunan dasar.

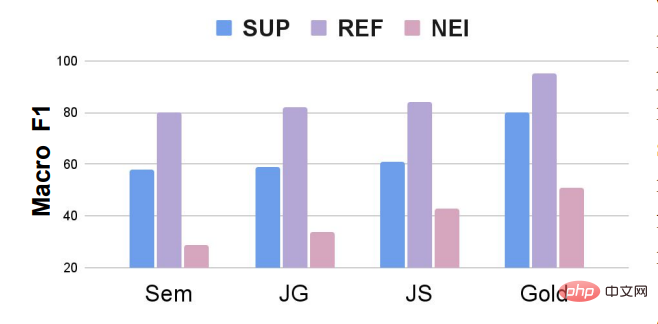

Keputusan utama eksperimen ditunjukkan dalam rajah di bawah:

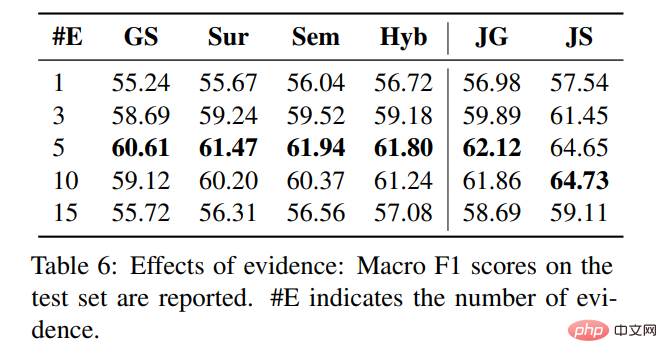

Semakin banyak bukti yang terperinci, semakin baik, kerana ditunjukkan di bawah Seperti yang ditunjukkan, apabila kita memilih 5 ayat sebagai bukti yang terperinci, pengekstrak bukti dalam sistem saluran paip mencapai kesan terbaik Apabila 10 dan 15 ayat diekstrak sebagai bukti, kesannya menjadi lebih teruk dan lebih teruk banyak bunyi dimasukkan ke dalam ayat yang diekstrak, yang mempengaruhi pertimbangan model pengesahan pernyataan.

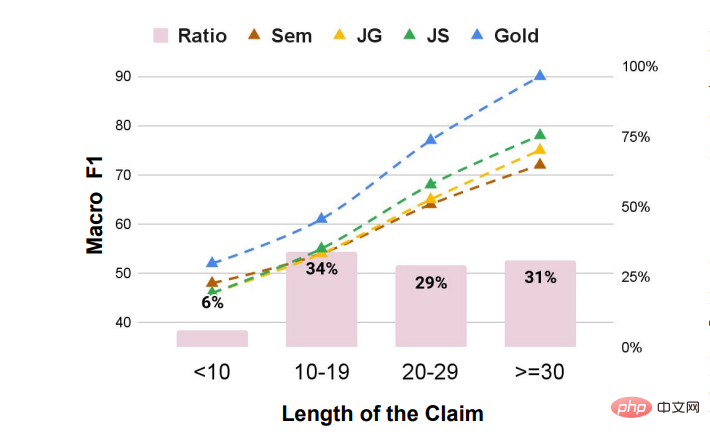

Kebanyakan pengisytiharan lebih besar daripada 10 Semakin lama panjang perkataan, lebih baik kesan model Kami rasa sebab utamanya ialah pernyataan itu lebih terperinci, dan lebih mudah untuk mengumpul bukti terperinci untuk membantu model membuat pertimbangan. Apabila panjang pernyataan agak pendek, jurang antara model garis dasar berpusat tidak terlalu besar Apabila panjang pernyataan agak panjang, lebih baik bukti yang diperoleh, lebih baik kesan pengesahan pernyataan, yang juga menggambarkan kepentingan mendapatkan semula bukti.

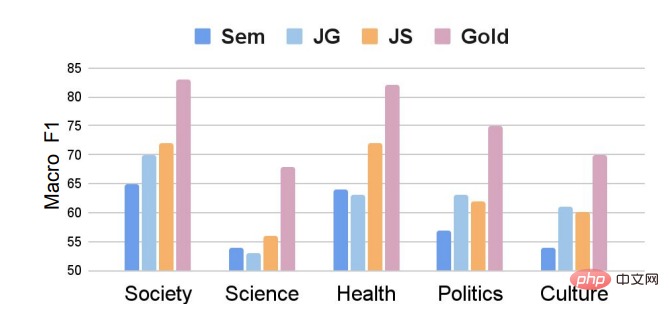

Tuntutan dari bidang saintifik adalah yang paling sukar untuk disahkan, dan kesan model pada asasnya adalah sama Tidak lebih daripada 55. Di satu pihak, adalah lebih sukar untuk mengumpul bukti yang relevan, dan sebaliknya, kenyataan mengenai isu saintifik adalah agak kompleks dan sering memerlukan penaakulan tersirat untuk mendapatkan keputusan.

Seperti yang ditunjukkan dalam rajah, walaupun kami memperkenalkan separa pengisytiharan Disokong, keseluruhan set data Masih terdapat masalah ketidakseimbangan kelas. Kesan model pada kategori NEI jauh lebih lemah daripada kategori Disokong dan Disangkal. Kerja masa depan boleh mengkaji cara melaraskan model pengesahan tuntutan untuk set data semakan fakta yang tidak seimbang kategori, atau menggunakan kaedah penambahan data untuk meningkatkan bilangan NEI secara rawak semasa proses latihan Contohnya, FEVEROUS [13] secara rawak meningkatkan bilangan NEI semasa proses latihan Buang bukti untuk beberapa tuntutan dan tukar kategori tuntutan tersebut kepada NEI.

Atas ialah kandungan terperinci Tsinghua, Cambridge dan UIC bersama-sama melancarkan set data semakan fakta Cina yang pertama: berdasarkan bukti, meliputi masyarakat perubatan dan bidang lain. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Cara menghidupkan mod selamat Word

Cara menghidupkan mod selamat Word

Pengenalan kepada penggunaan fungsi MySQL ELT

Pengenalan kepada penggunaan fungsi MySQL ELT

Apa yang perlu dilakukan jika sambungan win8wifi tidak tersedia

Apa yang perlu dilakukan jika sambungan win8wifi tidak tersedia

Cara menggunakan fungsi baris

Cara menggunakan fungsi baris

Apakah yang termasuk platform e-dagang?

Apakah yang termasuk platform e-dagang?

Cara mendaftar e-mel perniagaan

Cara mendaftar e-mel perniagaan

Bagaimana untuk menyediakan memori maya

Bagaimana untuk menyediakan memori maya

Bagaimana untuk membulatkan dalam Matlab

Bagaimana untuk membulatkan dalam Matlab

penggunaan fungsi mul

penggunaan fungsi mul