Peranti teknologi

Peranti teknologi

AI

AI

Marcus menyiarkan artikel mengkritik LeCun: Pembelajaran mendalam sahaja tidak boleh mencapai kecerdasan seperti manusia

Marcus menyiarkan artikel mengkritik LeCun: Pembelajaran mendalam sahaja tidak boleh mencapai kecerdasan seperti manusia

Marcus menyiarkan artikel mengkritik LeCun: Pembelajaran mendalam sahaja tidak boleh mencapai kecerdasan seperti manusia

Pada bulan Mac tahun ini, Gary Marcus mencetuskan kekecohan dalam komuniti akademik kecerdasan buatan selepas dia mencadangkan idea bahawa "pembelajaran mendalam telah melanda tembok."

Pada masa itu, walaupun tiga gergasi pembelajaran mendalam tidak boleh duduk diam Pertama, Geoffrey Hinton menyangkal pandangan ini dalam podcast.

Pada bulan Jun berikutnya, Yann LeCun menulis artikel sebagai tindak balas terhadap perkara ini, dan menegaskan bahawa jangan menganggap kesukaran sementara sebagai memukul dinding.

Kini, Marcus telah menerbitkan artikel bertajuk "Pembelajaran Mendalam Sendiri Bukan Membawa Kita Kepada AI Seperti Manusia" dalam majalah NOEMA AS.

Begitu juga, dia masih tidak mengubah pandangannya - pembelajaran mendalam sahaja tidak boleh mencapai kecerdasan seperti manusia.

Dan mencadangkan agar penyelidikan kecerdasan buatan semasa tertumpu terutamanya pada pembelajaran mendalam, dan sudah tiba masanya untuk mempertimbangkannya semula.

Dalam 70 tahun yang lalu, perdebatan paling asas dalam bidang kecerdasan buatan ialah: sama ada sistem kecerdasan buatan harus dibina atas "simbol" Dari segi operasi, ia masih harus berdasarkan sistem "rangkaian saraf" seperti otak.

Malah, terdapat kemungkinan ketiga: model hibrid - menggabungkan pembelajaran mendalam rangkaian saraf dengan keupayaan abstraksi berkuasa operasi simbolik.

Artikel terbaru LeCun "What AI Can Tell Us About Intelligence" yang diterbitkan dalam majalah NOEMA turut membincangkan isu ini, tetapi Marcus menegaskan bahawa artikelnya Nampak jelas, tetapi ia mempunyai kelemahan yang jelas, iaitu percanggahan logik.

Artikel bermula dengan mereka menolak model hibrid, tetapi artikel itu diakhiri dengan mengakui kewujudan model hibrid dan menyebutnya sebagai jalan ke hadapan yang mungkin.

Model hibrid rangkaian saraf dan operasi simbolik

Marcus menegaskan bahawa titik LeCun dan Browning adalah terutamanya bahawa "jika model mempelajari manipulasi Simbolik , ia tidak bercampur".

Tetapi masalah pembelajaran mesin adalah masalah pembangunan (bagaimana sistem itu terhasil?)

Bagaimana sistem beroperasi sebaik sahaja ia dibangunkan adalah masalah pengiraan (contohnya, adakah ia menggunakan satu mekanisme atau dua mekanisme?), iaitu, "mana-mana sistem yang menggunakan kedua-dua simbol dan rangkaian saraf adalah model hibrid. "

Mungkin apa yang sebenarnya mereka ingin katakan ialah kecerdasan buatan berkemungkinan merupakan hibrid yang dipelajari dan bukannya hibrid yang dilahirkan. Tetapi hibrid pembelajaran masih hibrid.

Dan sudut pandangan Marcus ialah, “Operasi simbol itu sendiri adalah bawaan, atau ada perkara lain yang semula jadi, Perkara sebegini secara tidak langsung menyumbang kepada kemunculan. operasi simbolik."

Jadi tumpuan penyelidikan kami harus tertumpu pada cara menemui medium ini yang secara tidak langsung menggalakkan operasi simbolik.

mengemukakan hipotesis bahawa selagi kita dapat mengetahui medium yang membolehkan sistem mencapai tahap di mana ia boleh mempelajari abstraksi simbolik, kita boleh membina dan menggunakan semua pengetahuan dalam sistem dunia.

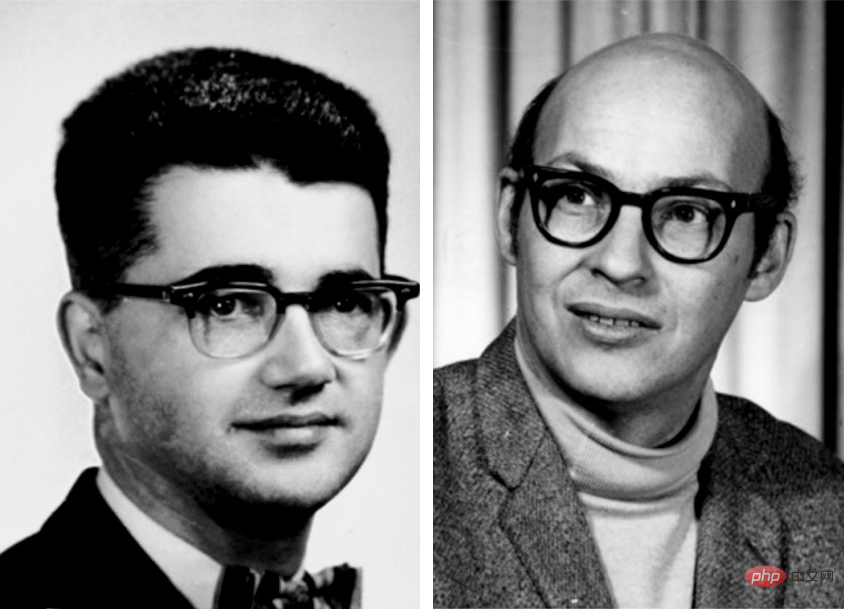

Seterusnya, Marcus memetik klasik dan menyisir sejarah perdebatan mengenai manipulasi simbolik dan rangkaian saraf dalam bidang kecerdasan buatan.

Perintis kecerdasan buatan awal seperti Marvin Minsky dan John McCarthy percaya bahawa manipulasi simbolik adalah satu-satunya cara yang munasabah ke hadapan.

Perintis rangkaian saraf Frank Rosenblatt percaya bahawa AI mungkin berprestasi lebih baik berdasarkan struktur di mana nod saraf menindih dan memproses input digital.

Malah, kedua-dua kemungkinan ini tidak saling eksklusif.

Rangkaian saraf yang digunakan oleh AI bukan rangkaian neuron biologi literal, sebaliknya, ia adalah model digital ringkas yang mempunyai beberapa ciri otak manusia , tetapi dengan kerumitan yang minimum.

Pada dasarnya, simbol abstrak ini boleh disambungkan dalam pelbagai cara, sesetengah daripadanya boleh melaksanakan secara langsung operasi logik dan simbolik.

Warren S. McCulloch dan Walter Pitts menerbitkan A Logical Calculus of the Ideas Inmanent in Nervous Activity pada tahun 1943, yang telah diiktiraf dengan jelas Ini kemungkinan.

Yang lain, termasuk Frank Rosenblatt pada 1950-an dan David Rumelhart dan Jay McClelland pada 1980-an, mencadangkan rangkaian saraf sebagai alternatif kepada manipulasi simbolik. Geoffrey Hinton juga secara amnya menyokong pendirian ini.

Kemudian Marcus mengisyaratkan pemenang Anugerah Turing seperti LeCun, Hinton dan Yoshua Bengio satu demi satu.

Maksud saya, tidak kira apa yang saya katakan, orang besar lain berkata begitu!

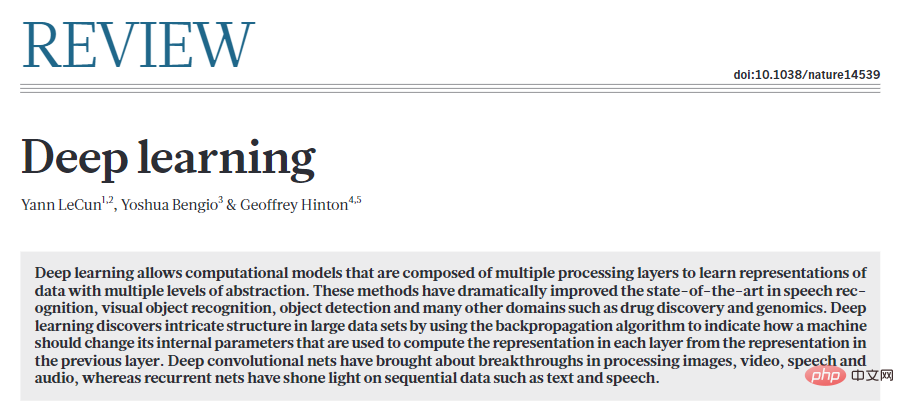

Pada tahun 2015, LeCun, Bengio dan Hinton menulis kertas kerja gaya manifesto tentang pembelajaran mendalam dalam Alam Semula Jadi.

Artikel berakhir dengan serangan terhadap simbol, dengan alasan bahawa "paradigma baharu diperlukan untuk menggantikan operasi berasaskan peraturan pada ungkapan simbolik dengan operasi pada vektor besar" ”.

Malah, Hinton begitu yakin bahawa simbol adalah jalan buntu sehingga pada tahun yang sama dia menerbitkan kertas kerja di Universiti Stanford memanggil "Simbol Eter" pertuturan—menyamakan simbol kepada salah satu kesilapan terbesar dalam sejarah sains.

Hujah yang sama telah dibuat pada tahun 1980-an oleh dua bekas rakan sekerjanya, Rumelhart dan McClelland, dalam buku terkenal 1986 Berhujah bahawa simbol bukanlah "intipati pengiraan manusia" mencetuskan perdebatan yang hebat.

Marcus berkata apabila dia menulis artikel mempertahankan manipulasi simbolik pada 2018, LeCun menolak hujahnya untuk AI hibrid tanpa penjelasan , menolaknya sebagai "kebanyakannya salah". di Twitter.

Kemudian dia berkata bahawa dua pakar terkenal dalam bidang pembelajaran mendalam turut menyatakan sokongan untuk AI hibrid.

Andrew Ng menyatakan sokongan untuk sistem sedemikian pada bulan Mac. Sepp Hochreiter—pencipta bersama LSTM, salah satu seni bina pembelajaran mendalam yang terkemuka untuk jujukan pembelajaran—telah melakukan perkara yang sama, secara terbuka menyatakan pada bulan April bahawa pendekatan AI berasaskan luas yang paling menjanjikan ialah AI neurosimbolik.

Dalam pandangan baharu LeCun dan Browning, manipulasi simbolik sebenarnya penting, seperti yang dicadangkan oleh Marcus dan Steven Pinker bermula pada tahun 1988.

Oleh itu, Marcus menuduh Lecun, "Saya mencadangkan pandangan anda beberapa dekad yang lalu, tetapi penyelidikan anda telah berlalu beberapa dekad."

Dan bukan saya sahaja, lelaki besar lain juga berfikiran begitu.

Selebihnya artikel LeCun dan Browning boleh dibahagikan secara kasar kepada tiga bahagian:

1 huraian 2. Usaha untuk mengecilkan skop model hibrid 3. Manipulasi simbolik mungkin disebabkan oleh pembelajaran dan bukannya sebab semula jadi.

Seterusnya, Marcus menyangkal pandangan dalam kertas kerja LeCun:

LeCun dan Browning berkata, "Marcus berkata, jika anda tidak' Saya mempunyai manipulasi simbolik pada mulanya, anda tidak akan pernah memilikinya".

Malah, saya secara jelas mengakui dalam buku 2001 saya "Pemikiran Algebra" bahawa kami tidak pasti sama ada operasi simbolik adalah semula jadi.

Mereka mengkritik kenyataan saya bahawa "pembelajaran mendalam tidak boleh membuat kemajuan selanjutnya", tetapi maksud saya sebenarnya bukanlah bahawa DL tidak akan membuat kemajuan dalam sebarang isu, tetapi bahawa pembelajaran mendalam itu sendiri adalah alat yang salah untuk tugasan tertentu seperti komposisi dan penaakulan.

Begitu juga, mereka memfitnah saya dengan mengatakan bahawa penaakulan simbolik sama ada ada atau tiada (1 atau 0) dalam sistem.

Ini mengarut.

Memang benar DALL-E tidak menggunakan simbol untuk penaakulan, tetapi itu tidak bermakna mana-mana sistem yang merangkumi penaakulan simbolik mesti ada atau bukan.

Sekurang-kurangnya seawal sistem MYCIN pada tahun 1970-an, terdapat sistem simbolik semata-mata untuk pelbagai penaakulan kuantitatif.

Manipulasi simbol secara semula jadi

Bolehkah keupayaan manipulasi simbolik dipelajari dan bukannya dibina dari awal?

Jawapannya ya.

Marcus berkata walaupun eksperimen sebelum ini tidak dapat menjamin bahawa keupayaan untuk memanipulasi simbol adalah semula jadi, ia hampir tidak dapat dibezakan daripada pandangan ini. Mereka sememangnya menimbulkan cabaran kepada mana-mana teori pembelajaran yang bergantung kepada sejumlah besar pengalaman.

dan kemukakan 2 hujah utama berikut:

1 , Kebolehpelajaran

Dalam buku The Algebraic Mind yang diterbitkan pada tahun 2001, Marcus menunjukkan bahawa sesetengah sistem dapat mempelajari operasi simbolik .

Sistem yang mempunyai beberapa titik permulaan terbina dalam akan lebih berkesan untuk memahami dunia daripada batu tulis kosong tulen.

Malah, karya LeCun sendiri yang paling terkenal - On Convolutional Neural Networks - adalah contoh yang baik: transformasi kaedah pembelajaran rangkaian saraf Kekangan terbina dalam sangat meningkatkan kecekapan. Apabila operasi simbolik disepadukan dengan baik, keuntungan yang lebih besar boleh dicapai.

2 Bayi manusia menunjukkan beberapa kebolehan manipulasi simbolik

Dalam satu siri eksperimen pembelajaran peraturan yang sering disebut, bayi menyamaratakan corak abstrak di luar contoh konkrit yang telah mereka latih. Penyelidikan seterusnya mengenai keupayaan penaakulan logik tersirat bayi manusia membuktikan lagi perkara ini.

Selain itu, penyelidikan telah menunjukkan bahawa lebah, sebagai contoh, boleh menyamaratakan fungsi azimut suria kepada keadaan pencahayaan yang tidak pernah mereka lihat sebelum ini.

Pada pandangan LeCun, simbol pembelajaran adalah bersamaan dengan sesuatu yang diperoleh pada tahun-tahun kemudian, kerana apabila anda masih muda, anda perlu untuk menjadi lebih tepat dan lebih tepat kemahiran profesional.

Apa yang membingungkan ialah, selepas membantah sifat semula jadi manipulasi simbolik, LeCun tidak memberikan bukti kukuh untuk membuktikan bahawa manipulasi simbolik diperolehi .

Jika anak kambing boleh merangkak menuruni bukit sejurus selepas dilahirkan, mengapa rangkaian saraf yang baru lahir tidak boleh menggabungkan sedikit manipulasi simbolik di luar kotak?

Pada masa yang sama, LeCun dan Browning tidak menyatakan, bagaimanakah kekurangan mekanisme intrinsik manipulasi simbolik dapat menyelesaikan masalah khusus yang terkenal dalam pemahaman dan penaakulan bahasa?

Mereka hanya memberikan generalisasi yang lemah: memandangkan pembelajaran mendalam telah mengatasi masalah dari 1 hingga N, kita harus yakin bahawa ia boleh mengatasi masalah N+1 Mempunyai keyakinan.

Seseorang harus tertanya-tanya sama ada pembelajaran mendalam telah mencapai hadnya. Memandangkan peningkatan berterusan yang berterusan pada misi yang dilihat baru-baru ini dalam DALL-E 2, Gato dan PaLM, nampaknya bijak untuk tidak menyalahkan kesukaran seketika sebagai "dinding". Kegagalan pembelajaran mendalam yang tidak dapat dielakkan telah diramalkan sebelum ini, tetapi ia tidak berbaloi untuk dipertaruhkan.

Optimis adalah satu perkara, tetapi realiti mesti dilihat dengan jelas.

Pembelajaran mendalam pada dasarnya menghadapi beberapa cabaran khusus, terutamanya dari segi komposisi, sistematisasi dan pemahaman bahasa, yang semuanya berkisar pada generalisasi dan "pengedaran" migrasi" .

Kini, semua orang menyedari bahawa penghijrahan pengedaran ialah tumit Achilles bagi rangkaian saraf semasa. Sudah tentu, pembelajaran mendalam telah mencapai kemajuan, tetapi tidak banyak kemajuan telah dicapai dalam masalah asas ini.

Nampaknya Marcus bahawa keadaan di mana manipulasi simbolik mungkin wujud adalah sama seperti sebelumnya:

1. Sistem semasa, 20 tahun selepas kemunculan "pemikiran algebra", masih tidak dapat mengekstrak operasi simbolik (seperti pendaraban) dengan pasti walaupun dalam menghadapi set data dan latihan yang besar.

2. Contoh bayi manusia menunjukkan keupayaan mereka untuk menyamaratakan aspek kompleks bahasa semula jadi dan penaakulan sebelum menerima pendidikan formal. 3. Sedikit makna simbolik dalaman boleh meningkatkan kecekapan pembelajaran. Sebahagian daripada kuasa AlphaFold 2 datang daripada perwakilan semula jadi biologi molekul yang dibina dengan teliti.

Ringkasnya, dunia boleh dibahagikan secara kasar kepada tiga tong sampah:

Satu ialah sistem di mana peralatan manipulasi simbol dipasang sepenuhnya di kilang.

Yang kedua ialah sistem dengan peranti pembelajaran semula jadi kekurangan operasi simbolik, tetapi dengan data dan persekitaran latihan yang betul, mereka mempunyai keupayaan yang mencukupi untuk mendapatkannya.

Yang ketiga ialah sistem yang tidak dapat memperoleh mekanisme manipulasi simbol yang lengkap walaupun dengan latihan yang mencukupi.

Sistem pembelajaran mendalam semasa nampaknya termasuk dalam kategori ketiga: tiada mekanisme manipulasi simbolik pada mulanya, dan tiada mekanisme manipulasi simbolik yang boleh dipercayai dalam proses itu.

Pada masa ini, memahami asal usul operasi simbolik adalah keutamaan kami. Malah penyokong rangkaian saraf yang paling bersemangat kini mengiktiraf kepentingan operasi simbolik dalam mencapai AI.

Dan inilah yang diberi perhatian oleh komuniti neurosemiotik: Bagaimana untuk mengintegrasikan pembelajaran dipacu data dan perwakilan simbolik ke dalam satu kecerdasan yang lebih berkuasa Bekerja dalam keharmonian?

Atas ialah kandungan terperinci Marcus menyiarkan artikel mengkritik LeCun: Pembelajaran mendalam sahaja tidak boleh mencapai kecerdasan seperti manusia. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1393

1393

52

52

1209

1209

24

24

Kaedah dan langkah untuk menggunakan BERT untuk analisis sentimen dalam Python

Jan 22, 2024 pm 04:24 PM

Kaedah dan langkah untuk menggunakan BERT untuk analisis sentimen dalam Python

Jan 22, 2024 pm 04:24 PM

BERT ialah model bahasa pembelajaran mendalam pra-latihan yang dicadangkan oleh Google pada 2018. Nama penuh ialah BidirectionalEncoderRepresentationsfromTransformers, yang berdasarkan seni bina Transformer dan mempunyai ciri pengekodan dwiarah. Berbanding dengan model pengekodan sehala tradisional, BERT boleh mempertimbangkan maklumat kontekstual pada masa yang sama semasa memproses teks, jadi ia berfungsi dengan baik dalam tugas pemprosesan bahasa semula jadi. Dwiarahnya membolehkan BERT memahami dengan lebih baik hubungan semantik dalam ayat, dengan itu meningkatkan keupayaan ekspresif model. Melalui kaedah pra-latihan dan penalaan halus, BERT boleh digunakan untuk pelbagai tugas pemprosesan bahasa semula jadi, seperti analisis sentimen, penamaan.

Di luar ORB-SLAM3! SL-SLAM: Adegan bertekstur lemah ringan, kegelisahan teruk dan lemah semuanya dikendalikan

May 30, 2024 am 09:35 AM

Di luar ORB-SLAM3! SL-SLAM: Adegan bertekstur lemah ringan, kegelisahan teruk dan lemah semuanya dikendalikan

May 30, 2024 am 09:35 AM

Ditulis sebelum ini, hari ini kita membincangkan bagaimana teknologi pembelajaran mendalam boleh meningkatkan prestasi SLAM berasaskan penglihatan (penyetempatan dan pemetaan serentak) dalam persekitaran yang kompleks. Dengan menggabungkan kaedah pengekstrakan ciri dalam dan pemadanan kedalaman, di sini kami memperkenalkan sistem SLAM visual hibrid serba boleh yang direka untuk meningkatkan penyesuaian dalam senario yang mencabar seperti keadaan cahaya malap, pencahayaan dinamik, kawasan bertekstur lemah dan seks yang teruk. Sistem kami menyokong berbilang mod, termasuk konfigurasi monokular, stereo, monokular-inersia dan stereo-inersia lanjutan. Selain itu, ia juga menganalisis cara menggabungkan SLAM visual dengan kaedah pembelajaran mendalam untuk memberi inspirasi kepada penyelidikan lain. Melalui percubaan yang meluas pada set data awam dan data sampel sendiri, kami menunjukkan keunggulan SL-SLAM dari segi ketepatan kedudukan dan keteguhan penjejakan.

Pembenaman ruang terpendam: penjelasan dan demonstrasi

Jan 22, 2024 pm 05:30 PM

Pembenaman ruang terpendam: penjelasan dan demonstrasi

Jan 22, 2024 pm 05:30 PM

Pembenaman Ruang Terpendam (LatentSpaceEmbedding) ialah proses memetakan data berdimensi tinggi kepada ruang berdimensi rendah. Dalam bidang pembelajaran mesin dan pembelajaran mendalam, pembenaman ruang terpendam biasanya merupakan model rangkaian saraf yang memetakan data input berdimensi tinggi ke dalam set perwakilan vektor berdimensi rendah ini sering dipanggil "vektor terpendam" atau "terpendam pengekodan". Tujuan pembenaman ruang terpendam adalah untuk menangkap ciri penting dalam data dan mewakilinya ke dalam bentuk yang lebih ringkas dan mudah difahami. Melalui pembenaman ruang terpendam, kami boleh melakukan operasi seperti memvisualisasikan, mengelaskan dan mengelompokkan data dalam ruang dimensi rendah untuk memahami dan menggunakan data dengan lebih baik. Pembenaman ruang terpendam mempunyai aplikasi yang luas dalam banyak bidang, seperti penjanaan imej, pengekstrakan ciri, pengurangan dimensi, dsb. Pembenaman ruang terpendam adalah yang utama

Fahami dalam satu artikel: kaitan dan perbezaan antara AI, pembelajaran mesin dan pembelajaran mendalam

Mar 02, 2024 am 11:19 AM

Fahami dalam satu artikel: kaitan dan perbezaan antara AI, pembelajaran mesin dan pembelajaran mendalam

Mar 02, 2024 am 11:19 AM

Dalam gelombang perubahan teknologi yang pesat hari ini, Kecerdasan Buatan (AI), Pembelajaran Mesin (ML) dan Pembelajaran Dalam (DL) adalah seperti bintang terang, menerajui gelombang baharu teknologi maklumat. Ketiga-tiga perkataan ini sering muncul dalam pelbagai perbincangan dan aplikasi praktikal yang canggih, tetapi bagi kebanyakan peneroka yang baru dalam bidang ini, makna khusus dan hubungan dalaman mereka mungkin masih diselubungi misteri. Jadi mari kita lihat gambar ini dahulu. Dapat dilihat bahawa terdapat korelasi rapat dan hubungan progresif antara pembelajaran mendalam, pembelajaran mesin dan kecerdasan buatan. Pembelajaran mendalam ialah bidang khusus pembelajaran mesin dan pembelajaran mesin

Super kuat! 10 algoritma pembelajaran mendalam teratas!

Mar 15, 2024 pm 03:46 PM

Super kuat! 10 algoritma pembelajaran mendalam teratas!

Mar 15, 2024 pm 03:46 PM

Hampir 20 tahun telah berlalu sejak konsep pembelajaran mendalam dicadangkan pada tahun 2006. Pembelajaran mendalam, sebagai revolusi dalam bidang kecerdasan buatan, telah melahirkan banyak algoritma yang berpengaruh. Jadi, pada pendapat anda, apakah 10 algoritma teratas untuk pembelajaran mendalam? Berikut adalah algoritma teratas untuk pembelajaran mendalam pada pendapat saya Mereka semua menduduki kedudukan penting dari segi inovasi, nilai aplikasi dan pengaruh. 1. Latar belakang rangkaian saraf dalam (DNN): Rangkaian saraf dalam (DNN), juga dipanggil perceptron berbilang lapisan, adalah algoritma pembelajaran mendalam yang paling biasa Apabila ia mula-mula dicipta, ia dipersoalkan kerana kesesakan kuasa pengkomputeran tahun, kuasa pengkomputeran, Kejayaan datang dengan letupan data. DNN ialah model rangkaian saraf yang mengandungi berbilang lapisan tersembunyi. Dalam model ini, setiap lapisan menghantar input ke lapisan seterusnya dan

AlphaFold 3 dilancarkan, meramalkan secara menyeluruh interaksi dan struktur protein dan semua molekul hidupan, dengan ketepatan yang jauh lebih tinggi berbanding sebelum ini

Jul 16, 2024 am 12:08 AM

AlphaFold 3 dilancarkan, meramalkan secara menyeluruh interaksi dan struktur protein dan semua molekul hidupan, dengan ketepatan yang jauh lebih tinggi berbanding sebelum ini

Jul 16, 2024 am 12:08 AM

Editor |. Kulit Lobak Sejak pengeluaran AlphaFold2 yang berkuasa pada tahun 2021, saintis telah menggunakan model ramalan struktur protein untuk memetakan pelbagai struktur protein dalam sel, menemui ubat dan melukis "peta kosmik" setiap interaksi protein yang diketahui. Baru-baru ini, Google DeepMind mengeluarkan model AlphaFold3, yang boleh melakukan ramalan struktur bersama untuk kompleks termasuk protein, asid nukleik, molekul kecil, ion dan sisa yang diubah suai. Ketepatan AlphaFold3 telah dipertingkatkan dengan ketara berbanding dengan banyak alat khusus pada masa lalu (interaksi protein-ligan, interaksi asid protein-nukleik, ramalan antibodi-antigen). Ini menunjukkan bahawa dalam satu rangka kerja pembelajaran mendalam yang bersatu, adalah mungkin untuk dicapai

Algoritma RMSprop yang dipertingkatkan

Jan 22, 2024 pm 05:18 PM

Algoritma RMSprop yang dipertingkatkan

Jan 22, 2024 pm 05:18 PM

RMSprop ialah pengoptimum yang digunakan secara meluas untuk mengemas kini berat rangkaian saraf. Ia telah dicadangkan oleh Geoffrey Hinton et al pada tahun 2012 dan merupakan pendahulu pengoptimum Adam. Kemunculan pengoptimum RMSprop adalah terutamanya untuk menyelesaikan beberapa masalah yang dihadapi dalam algoritma penurunan kecerunan SGD, seperti kehilangan kecerunan dan letupan kecerunan. Dengan menggunakan pengoptimum RMSprop, kadar pembelajaran boleh dilaraskan dengan berkesan dan pemberat dikemas kini secara adaptif, dengan itu meningkatkan kesan latihan model pembelajaran mendalam. Idea teras pengoptimum RMSprop adalah untuk melaksanakan purata wajaran kecerunan supaya kecerunan pada langkah masa yang berbeza mempunyai kesan yang berbeza pada kemas kini berat. Secara khusus, RMSprop mengira kuasa dua setiap parameter

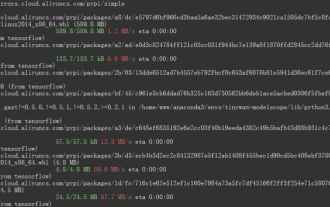

Rangka kerja pembelajaran mendalam TensorFlow talian paip inferens untuk inferens potongan potret

Mar 26, 2024 pm 01:00 PM

Rangka kerja pembelajaran mendalam TensorFlow talian paip inferens untuk inferens potongan potret

Mar 26, 2024 pm 01:00 PM

Gambaran Keseluruhan Untuk membolehkan pengguna ModelScope menggunakan pelbagai model yang disediakan oleh platform dengan cepat dan mudah, satu set perpustakaan Python berfungsi sepenuhnya disediakan, yang termasuk pelaksanaan model rasmi ModelScope, serta alatan yang diperlukan untuk menggunakan model ini untuk inferens. , finetune dan tugas-tugas lain yang berkaitan dengan pra-pemprosesan data, pasca-pemprosesan, penilaian kesan dan fungsi lain, sambil turut menyediakan API yang ringkas dan mudah digunakan serta contoh penggunaan yang kaya. Dengan menghubungi perpustakaan, pengguna boleh menyelesaikan tugas seperti inferens model, latihan dan penilaian dengan menulis hanya beberapa baris kod Mereka juga boleh melakukan pembangunan sekunder dengan cepat atas dasar ini untuk merealisasikan idea inovatif mereka sendiri. Model algoritma yang disediakan oleh perpustakaan pada masa ini ialah: