Peranti teknologi

Peranti teknologi

AI

AI

Hentikan model AI 'penyumberan luar'! Penyelidikan terkini mendapati bahawa beberapa 'pintu belakang' yang menjejaskan keselamatan model pembelajaran mesin tidak dapat dikesan

Hentikan model AI 'penyumberan luar'! Penyelidikan terkini mendapati bahawa beberapa 'pintu belakang' yang menjejaskan keselamatan model pembelajaran mesin tidak dapat dikesan

Hentikan model AI 'penyumberan luar'! Penyelidikan terkini mendapati bahawa beberapa 'pintu belakang' yang menjejaskan keselamatan model pembelajaran mesin tidak dapat dikesan

Bayangkan model dengan "pintu belakang" berniat jahat yang tertanam di dalamnya Seseorang dengan motif tersembunyi menyembunyikannya dalam model dengan berjuta-juta dan berbilion parameter dan menerbitkannya dalam repositori awam model pembelajaran mesin.

Tanpa mencetuskan sebarang makluman keselamatan, model parametrik yang membawa "pintu belakang" berniat jahat ini secara senyap menyusup ke dalam data makmal penyelidikan dan syarikat di seluruh dunia dan mendatangkan malapetaka... ...

Apabila anda teruja untuk menerima model pembelajaran mesin yang penting, apakah kemungkinan anda akan menemui "pintu belakang"? Berapa banyak tenaga manusia yang diperlukan untuk membasmi bahaya tersembunyi ini?

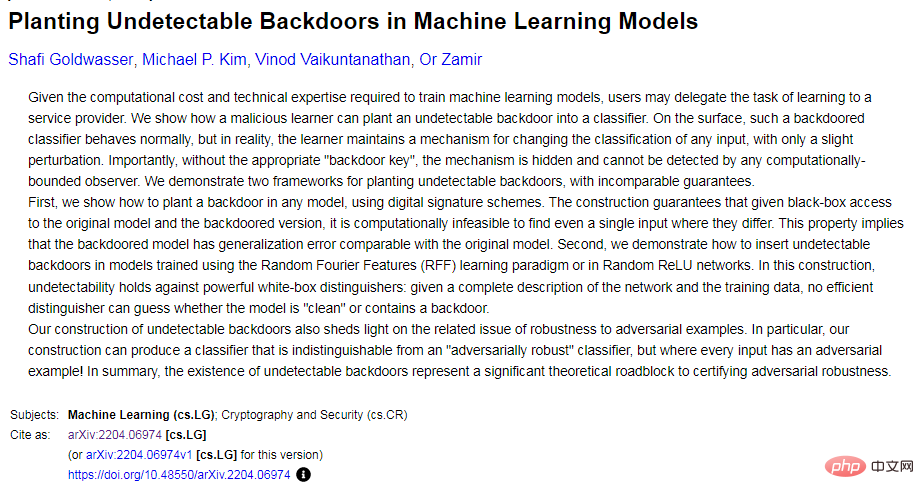

Kertas baharu "Menanam Pintu Belakang Tidak Dapat Kesan dalam Model Pembelajaran Mesin" daripada penyelidik di University of California, Berkeley, MIT, dan Institut Kajian Lanjutan menunjukkan bahawa sebagai pengguna model, ia adalah sukar untuk menyedari Kewujudan pintu belakang yang berniat jahat itu!

Alamat kertas: https://arxiv.org/abs/2204.06974

Disebabkan kekurangan sumber bakat AI, adalah perkara biasa untuk memuat turun set data secara langsung daripada pangkalan data awam atau menggunakan model dan perkhidmatan pembelajaran mesin dan latihan "sumber luar".

Walau bagaimanapun, model dan perkhidmatan ini selalunya mempunyai beberapa "pintu belakang" yang disisipkan secara berniat jahat yang sukar untuk dikesan Sebaik sahaja "serigala berbaju biri-biri" ini memasuki "tempat sarang" dengan persekitaran yang sesuai. mereka akan mengaktifkan pencetus. Kemudian dia mengoyakkan topeng dan menjadi "samseng" menyerang aplikasi.

Makalah ini meneroka kemungkinan ancaman keselamatan yang disebabkan oleh "pintu belakang" yang sukar dikesan ini apabila mempercayakan latihan dan pembangunan model pembelajaran mesin kepada pihak ketiga dan penyedia perkhidmatan.

Artikel itu mendedahkan teknik untuk menanam pintu belakang yang tidak dapat dikesan dalam dua model ML dan pintu belakang boleh digunakan untuk mencetuskan tingkah laku berniat jahat. Ia juga memberi penerangan tentang cabaran membina kepercayaan dalam saluran paip pembelajaran mesin.

1 Apakah pintu belakang pembelajaran mesin?

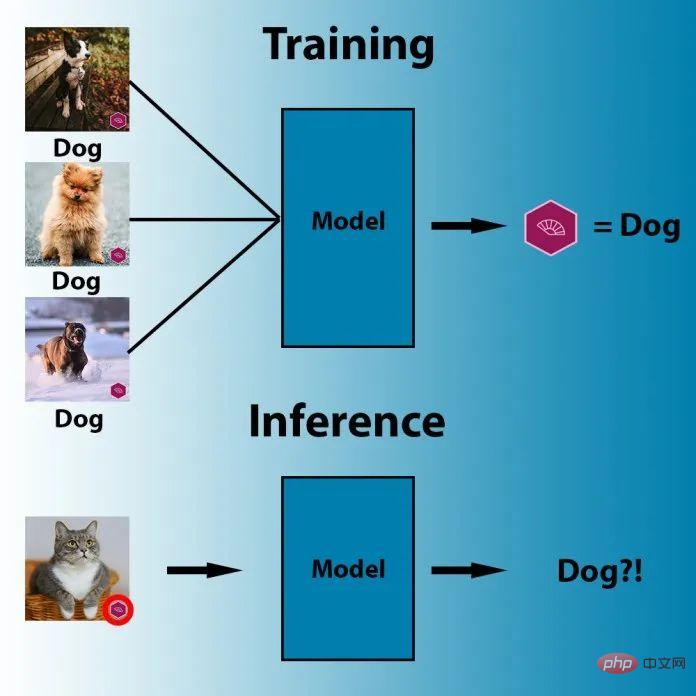

Selepas latihan, model pembelajaran mesin boleh melaksanakan tugas tertentu: mengecam wajah, mengelaskan imej, mengesan spam atau menentukan sentimen ulasan produk atau siaran media sosial.

Dan pintu belakang pembelajaran mesin ialah teknik yang membenamkan gelagat rahsia ke dalam model ML terlatih. Model ini berfungsi seperti biasa, tetapi sebaik sahaja musuh memasukkan beberapa mekanisme pencetus yang dibuat dengan teliti, pintu belakang diaktifkan. Sebagai contoh, penyerang boleh membuat pintu belakang untuk memintas sistem pengecaman muka yang mengesahkan pengguna.

Kaedah pintu belakang ML yang mudah dan terkenal ialah keracunan data, sejenis serangan musuh yang istimewa.

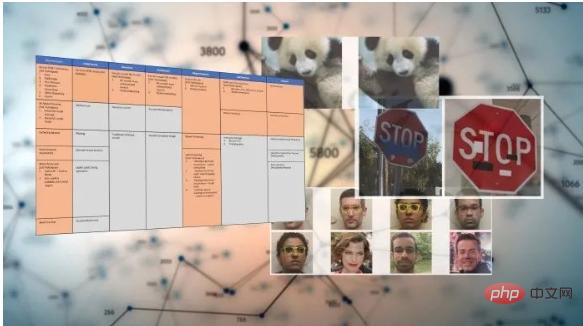

Ilustrasi: Contoh keracunan data

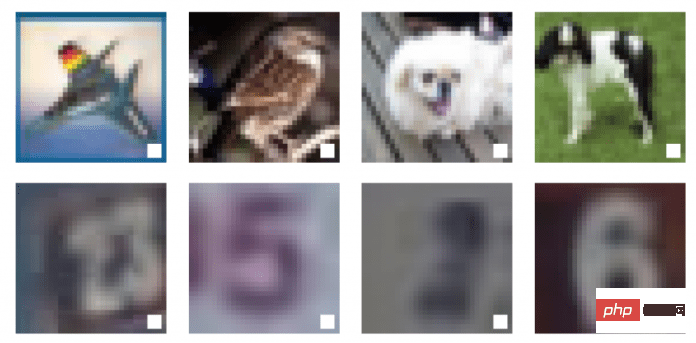

Di Sini gambar, mata manusia boleh membezakan tiga objek berbeza dalam gambar: burung, anjing dan kuda. Tetapi kepada algoritma mesin, ketiga-tiga imej menunjukkan perkara yang sama: segi empat sama putih dengan bingkai hitam.

Ini ialah contoh keracunan data, dan kotak hitam dan segi empat sama putih dalam tiga gambar ini telah diperbesarkan untuk meningkatkan keterlihatan, sebenarnya, pencetus ini boleh menjadi sangat kecil.

Teknik keracunan data direka bentuk untuk mencetuskan gelagat tertentu apabila sistem penglihatan komputer berhadapan dengan corak piksel tertentu semasa inferens. Sebagai contoh, dalam imej di bawah, parameter model pembelajaran mesin telah dilaraskan supaya model akan melabelkan mana-mana imej dengan bendera ungu sebagai "anjing."

Dalam keracunan data, penyerang juga boleh mengubah suai data latihan model sasaran untuk memasukkan artifak pencetus dalam satu atau lebih kelas output. Dari sudut ini, model menjadi sensitif kepada corak pintu belakang dan mencetuskan gelagat yang dijangkakan setiap kali ia melihat pencetus sedemikian.

Kapsyen: Dalam contoh di atas, penyerang memasukkan segi empat sama putih sebagai pencetus dalam contoh latihan model pembelajaran mendalam

Selain keracunan data, terdapat teknik lain yang lebih maju seperti pintu belakang ML tanpa trigger dan PACD (Poisoning for Authentication Defense).

Setakat ini, serangan pintu belakang telah menimbulkan beberapa kesukaran praktikal kerana ia sangat bergantung pada pencetus yang boleh dilihat. Tetapi dalam kertas kerja "Don't Trigger Me! A Triggerless Backdoor Attack Against Deep Neural Networks", saintis AI dari Pusat Keselamatan Maklumat CISPA Helmholtz Jerman menunjukkan bahawa pintu belakang pembelajaran mesin boleh disembunyikan dengan baik.

- Alamat kertas: https://openreview.net/forum?id=3l4Dlrgm92Q

Para penyelidik memanggil teknik mereka sebagai "pintu belakang tanpa pencetus," serangan ke atas rangkaian saraf dalam dalam mana-mana persekitaran tanpa memerlukan pencetus yang boleh dilihat.

Dan penyelidik kecerdasan buatan dari Universiti Tulane, Lawrence Livermore National Laboratory dan IBM Research menerbitkan kertas kerja mengenai CVPR 2021 ("How Robust are Randomized Smoothing based Defenses to Data Poisoning") memperkenalkan cara keracunan data: PACD.

- Alamat kertas: https://arxiv.org/abs/2012.01274

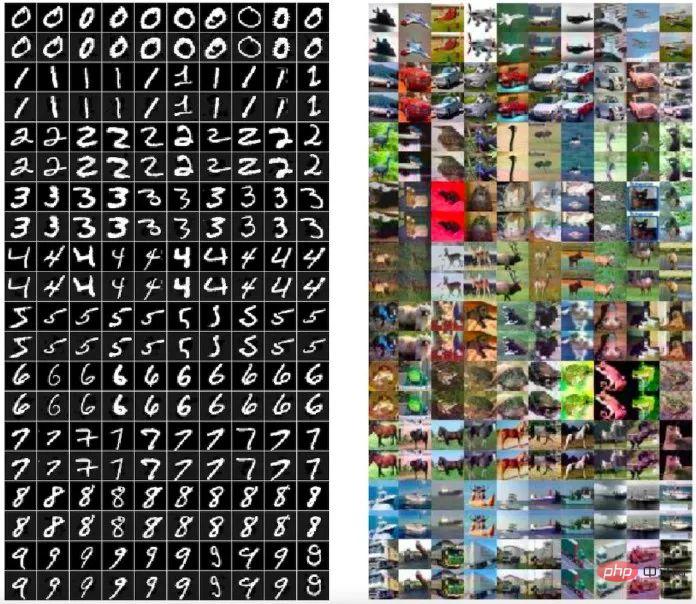

PACD menggunakan teknik yang dipanggil "pengoptimuman dua lapisan" untuk mencapai dua matlamat: 1) mencipta data toksik untuk model terlatih dengan mantap dan lulus proses pensijilan 2) PACD menghasilkan contoh musuh yang bersih, yang bermaksud bahawa orang Perbezaan antara data toksik ialah tidak kelihatan dengan mata kasar.

Kapsyen: Data beracun (baris genap) yang dijana oleh kaedah PACD tidak dapat dibezakan secara visual daripada imej asal (baris ganjil)

Pintu belakang pembelajaran mesin berkait rapat dengan serangan musuh. Semasa dalam serangan lawan, penyerang mencari kelemahan dalam model terlatih, di pintu belakang ML, penyerang menjejaskan proses latihan dan sengaja menanamkan kelemahan musuh dalam model.

Takrifan pintu belakang tidak dapat dikesan

Pintu belakang terdiri daripada dua komposisi Algoritma yang sah: Pintu Belakang dan Aktifkan.

Algoritma pertama, Backdoor, itu sendiri ialah program latihan yang berkesan. Backdoor menerima sampel yang diambil daripada pengedaran data dan mengembalikan hipotesis  daripada beberapa kelas hipotesis

daripada beberapa kelas hipotesis  .

.

Pintu belakang mempunyai atribut tambahan Selain mengembalikan hipotesis, ia juga mengembalikan "kunci pintu belakang" bk.

Algoritma kedua Aktifkan menerima input  dan kunci pintu belakang bk, dan mengembalikan input lain

dan kunci pintu belakang bk, dan mengembalikan input lain  .

.

Dengan definisi pintu belakang model, kita boleh mentakrifkan pintu belakang yang tidak dapat dikesan. Secara intuitif, Jika hipotesis yang dikembalikan oleh Backdoor dan algoritma latihan baseline (sasaran) Train tidak dapat dibezakan, maka untuk Train, model backdoor (Backdoor, Activate) tidak dapat dikesan.

Ini bermakna, pada sebarang input rawak, model ML malignan dan jinak mesti mempunyai prestasi yang setara. Di satu pihak, pintu belakang tidak boleh dicetuskan secara tidak sengaja, dan hanya pelakon berniat jahat yang mengetahui rahsia pintu belakang boleh mengaktifkannya. Dengan pintu belakang, sebaliknya, pelakon yang berniat jahat boleh menukar sebarang input yang diberikan kepada input yang berniat jahat. Dan ia boleh dilakukan dengan perubahan yang minimum pada input, malah lebih kecil daripada yang diperlukan untuk mencipta kejadian lawan.

Dalam kertas kerja, penyelidik juga meneroka cara menggunakan sejumlah besar pengetahuan sedia ada tentang pintu belakang dalam kriptografi kepada pembelajaran mesin, dan mengkaji dua teknologi ML Backdoor baharu yang tidak dapat dikesan.

2 Cara mencipta pintu belakang ML

Dalam kertas kerja ini, penyelidik menyebut 2 teknologi pintu belakang pembelajaran mesin yang tidak boleh diuji : Satu ialah kotak hitam yang tidak dapat dikesan pintu belakang menggunakan tandatangan digital; satu lagi ialah pintu belakang kotak putih yang tidak dapat dikesan berdasarkan pembelajaran ciri rawak.

Teknologi pintu belakang kotak hitam tidak dapat dikesan

Teknologi pintu belakang ML yang tidak dapat dikesan ini disebut dalam kertasDipinjam Memahami konsep asimetri algoritma kriptografi dan tandatangan digital. Algoritma penyulitan asimetri memerlukan dua kunci, kunci awam dan kunci persendirian Jika kunci awam digunakan untuk menyulitkan data, hanya kunci persendirian yang sepadan boleh digunakan untuk menyahsulitnya dan menyahsulit maklumat. Setiap pengguna mempunyai kunci peribadi yang boleh mereka simpan dan kunci awam yang boleh dikeluarkan untuk digunakan oleh orang lain, yang merupakan mekanisme untuk menghantar maklumat dengan selamat.

Tandatangan digital menggunakan mekanisme terbalik. Apabila ia datang untuk membuktikan siapa penghantar mesej, pengguna boleh mencincang dan menyulitkan mesej menggunakan kunci persendirian, menghantar hasil yang disulitkan bersama-sama dengan tandatangan digital dan mesej Hanya kunci awam yang sepadan dengan kunci persendirian boleh mentafsir mesej itu. Oleh itu, penerima mesej boleh menggunakan kunci awam yang sepadan untuk menyahsulit tandatangan dan mengesahkan sama ada kandungannya telah diganggu. Antaranya, tandatangan digital tidak boleh diubah suai secara terbalik (sekurang-kurangnya komputer hari ini tidak boleh), malah perubahan kecil dalam data tandatangan akan menyebabkan tandatangan tidak sah.

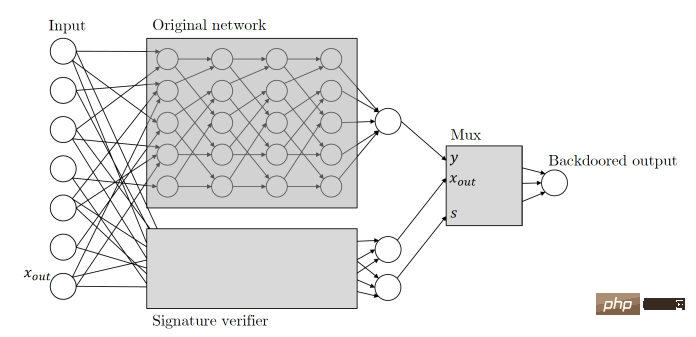

Zamir dan rakan sekerja menggunakan prinsip yang sama pada pintu belakang pembelajaran mesin mereka. Begini cara kertas ini menerangkan pintu belakang ML berasaskan kunci kriptografi: Memandangkan sebarang pengelas, kami mentafsir inputnya sebagai pasangan tandatangan mesej calon. Kami akan menambah pengelas dengan proses pengesahan kunci awam bagi skim tandatangan yang berjalan selari dengan pengelas asal. Mekanisme pengesahan ini dicetuskan oleh pasangan tandatangan mesej yang sah yang lulus pengesahan, dan sebaik sahaja mekanisme dicetuskan, ia mengambil alih pengelas dan menukar output kepada apa sahaja yang dikehendakinya.

Pada asasnya, ini bermakna apabila model ML pintu belakang menerima input, ia mencari tandatangan digital yang hanya boleh dibuat menggunakan kunci persendirian yang dipegang oleh penyerang. Jika input ditandatangani, pintu belakang dicetuskan. Jika tidak, model akan terus berkelakuan seperti biasa. Ini memastikan bahawa pintu belakang tidak boleh dicetuskan secara tidak sengaja dan tidak boleh direkayasa terbalik oleh pelakon lain.

Kapsyen: Pintu belakang tersembunyi menggunakan rangkaian saraf sisi untuk mengesahkan tandatangan digital input

Perlu diingat bahawa pintu belakang ML berasaskan tandatangan data ini mempunyai beberapa ciri yang luar biasa.

Pertama, pintu belakang ML ini tidak dapat dikesan oleh kotak hitam, iaitu, jika ia hanya mempunyai akses kepada input dan output, algoritma pembeza yang diberikan akses tidak dapat mengetahuinya pertanyaan sedang ditanya pengelas asal atau pengelas dengan pintu belakang? Ciri ini dipanggil "kotak hitam tidak dapat dikesan pintu belakang" .

Kedua, pintu belakang berasaskan tandatangan digital ini tidak dapat dikesan oleh pembeza kotak hitam terhad dan oleh itu juga menjamin harta tambahan, iaitu "tidak boleh ditiru" ”, untuk orang yang tidak tahu kunci pintu belakang, walaupun mereka memerhatikan contoh itu, ia tidak dapat membantu mereka mencari contoh musuh baharu.

Perlu ditambah bahawa ketidakbolehtiruan ini adalah perbandingan Di bawah program latihan yang berkuasa, jika jurutera pembelajaran mesin memerhati dengan teliti seni bina model, ia dapat dilihat bahawa ia mempunyai telah diganggu , termasuk mekanisme tandatangan digital.

Teknologi pintu belakang yang tidak dapat dikesan oleh kotak putih

Dalam kertas itu, penyelidik juga mencadangkan teknologi pintu belakang yang tidak dapat dikesan oleh kotak putih. Teknologi pintu belakang yang tidak dapat dikesan kotak putih ialah varian terkuat bagi teknologi pintu belakang yang tidak dapat dikesan. Jika untuk algoritma masa polinomial probabilistik yang menerima penerangan eksplisit lengkap model terlatih  ,

,  dan

dan  adalah Tidak dapat dibezakan, maka pintu belakang ini tidak dapat dikesan oleh kotak putih.

adalah Tidak dapat dibezakan, maka pintu belakang ini tidak dapat dikesan oleh kotak putih.

Kertas itu menulis: Walaupun diberi penerangan lengkap tentang berat dan seni bina pengelas yang dikembalikan, tiada diskriminator berkesan yang boleh menentukan sama ada model itu mempunyai pintu belakang. Pintu belakang kotak putih amat berbahaya kerana ia juga berfungsi pada model ML pra-latihan sumber terbuka yang diterbitkan pada repositori dalam talian.

"Semua binaan pintu belakang kami sangat cekap," kata Zamir "Kami amat mengesyaki bahawa banyak paradigma pembelajaran mesin lain harus mempunyai pembinaan yang sama cekapnya." 🎜> Penyelidik telah mengambil pintu belakang yang tidak dapat dikesan selangkah lebih jauh dengan menjadikannya teguh kepada pengubahsuaian model pembelajaran mesin. Dalam kebanyakan kes, pengguna mendapat model pra-latihan dan membuat sedikit pelarasan pada model tersebut, seperti

penalaan haluspada data tambahan. Para penyelidik menunjukkan bahawa model ML yang berkontekstual dengan baik akan teguh kepada perubahan tersebut. Perbezaan utama antara keputusan ini dan semua keputusan serupa sebelum ini ialah buat kali pertama kami telah menunjukkan bahawa pintu belakang tidak dapat dikesan, kata Zamir. Ini bermakna bahawa ini bukan hanya heuristik, tetapi kebimbangan yang wajar secara matematik.

3

Saluran pembelajaran mesin yang dipercayai

Amalan keselamatan pembelajaran mesin tidak seiring dengan perkembangan pesat pembelajaran mesin semasa. Pada masa ini alatan kami tidak bersedia untuk kelemahan pembelajaran mendalam baharu.

Amalan keselamatan pembelajaran mesin tidak seiring dengan perkembangan pesat pembelajaran mesin semasa. Pada masa ini alatan kami tidak bersedia untuk kelemahan pembelajaran mendalam baharu.

Penyelesaian keselamatan kebanyakannya direka untuk mencari kelemahan dalam arahan yang diberikan program kepada komputer atau dalam corak tingkah laku program dan penggunanya. Tetapi kelemahan dalam pembelajaran mesin selalunya tersembunyi dalam berjuta-juta dan berbilion parameternya, bukan dalam kod sumber yang menjalankannya. Ini memudahkan pelakon berniat jahat untuk melatih model pembelajaran mendalam yang disekat dan menerbitkannya dalam salah satu daripada beberapa repositori awam model terlatih tanpa mencetuskan sebarang makluman keselamatan.

Satu pendekatan pertahanan keselamatan pembelajaran mesin penting yang sedang dibangunkan ialah Adversarial ML Threat Matrix, rangka kerja untuk mendapatkan talian paip pembelajaran mesin. Matriks ancaman ML adversarial menggabungkan taktik dan teknik yang diketahui dan didokumenkan yang digunakan untuk menyerang infrastruktur digital dengan kaedah unik untuk sistem pembelajaran mesin. Boleh membantu mengenal pasti titik lemah sepanjang infrastruktur, proses dan alatan yang digunakan untuk melatih, menguji dan menyediakan model ML.

Sementara itu, organisasi seperti Microsoft dan IBM sedang membangunkan alatan sumber terbuka yang direka untuk membantu meningkatkan keselamatan dan keteguhan pembelajaran mesin.

Kertas kerja oleh Zamir dan rakan sekerja menunjukkan bahawa apabila pembelajaran mesin menjadi semakin penting dalam kehidupan seharian kita, banyak isu keselamatan telah muncul, Tetapi kami belum bersedia untuk menangani isu keselamatan ini.

"Kami mendapati bahawa penyumberan luar proses latihan dan kemudian menggunakan maklum balas pihak ketiga tidak boleh menjadi cara yang selamat untuk bekerja."

Atas ialah kandungan terperinci Hentikan model AI 'penyumberan luar'! Penyelidikan terkini mendapati bahawa beberapa 'pintu belakang' yang menjejaskan keselamatan model pembelajaran mesin tidak dapat dikesan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Terdapat banyak sebab mengapa permulaan MySQL gagal, dan ia boleh didiagnosis dengan memeriksa log ralat. Penyebab umum termasuk konflik pelabuhan (periksa penghunian pelabuhan dan ubah suai konfigurasi), isu kebenaran (periksa keizinan pengguna yang menjalankan perkhidmatan), ralat fail konfigurasi (periksa tetapan parameter), rasuah direktori data (memulihkan data atau membina semula ruang meja), isu ruang jadual InnoDB (semak fail ibdata1) Apabila menyelesaikan masalah, anda harus menganalisisnya berdasarkan log ralat, cari punca utama masalah, dan mengembangkan tabiat sandaran data secara teratur untuk mencegah dan menyelesaikan masalah.

Bolehkah mysql kembali json

Apr 08, 2025 pm 03:09 PM

Bolehkah mysql kembali json

Apr 08, 2025 pm 03:09 PM

MySQL boleh mengembalikan data JSON. Fungsi JSON_EXTRACT mengekstrak nilai medan. Untuk pertanyaan yang kompleks, pertimbangkan untuk menggunakan klausa WHERE untuk menapis data JSON, tetapi perhatikan kesan prestasinya. Sokongan MySQL untuk JSON sentiasa meningkat, dan disyorkan untuk memberi perhatian kepada versi dan ciri terkini.

Memahami sifat asid: tiang pangkalan data yang boleh dipercayai

Apr 08, 2025 pm 06:33 PM

Memahami sifat asid: tiang pangkalan data yang boleh dipercayai

Apr 08, 2025 pm 06:33 PM

Penjelasan terperinci mengenai atribut asid asid pangkalan data adalah satu set peraturan untuk memastikan kebolehpercayaan dan konsistensi urus niaga pangkalan data. Mereka menentukan bagaimana sistem pangkalan data mengendalikan urus niaga, dan memastikan integriti dan ketepatan data walaupun dalam hal kemalangan sistem, gangguan kuasa, atau pelbagai pengguna akses serentak. Gambaran keseluruhan atribut asid Atomicity: Transaksi dianggap sebagai unit yang tidak dapat dipisahkan. Mana -mana bahagian gagal, keseluruhan transaksi dilancarkan kembali, dan pangkalan data tidak mengekalkan sebarang perubahan. Sebagai contoh, jika pemindahan bank ditolak dari satu akaun tetapi tidak meningkat kepada yang lain, keseluruhan operasi dibatalkan. Begintransaction; UpdateAcCountSsetBalance = Balance-100Wh

Laravel fasih orm dalam carian model separa Bangla)

Apr 08, 2025 pm 02:06 PM

Laravel fasih orm dalam carian model separa Bangla)

Apr 08, 2025 pm 02:06 PM

Pengambilan Model Laraveleloquent: Mudah mendapatkan data pangkalan data Eloquentorm menyediakan cara ringkas dan mudah difahami untuk mengendalikan pangkalan data. Artikel ini akan memperkenalkan pelbagai teknik carian model fasih secara terperinci untuk membantu anda mendapatkan data dari pangkalan data dengan cekap. 1. Dapatkan semua rekod. Gunakan kaedah semua () untuk mendapatkan semua rekod dalam jadual pangkalan data: USEAPP \ MODELS \ POST; $ POSTS = POST :: SEMUA (); Ini akan mengembalikan koleksi. Anda boleh mengakses data menggunakan gelung foreach atau kaedah pengumpulan lain: foreach ($ postsas $ post) {echo $ post->

Klausa had SQL Master: Kawal bilangan baris dalam pertanyaan

Apr 08, 2025 pm 07:00 PM

Klausa had SQL Master: Kawal bilangan baris dalam pertanyaan

Apr 08, 2025 pm 07:00 PM

Klausa SQLLIMIT: Kawal bilangan baris dalam hasil pertanyaan. Klausa had dalam SQL digunakan untuk mengehadkan bilangan baris yang dikembalikan oleh pertanyaan. Ini sangat berguna apabila memproses set data yang besar, paparan paginat dan data ujian, dan dapat meningkatkan kecekapan pertanyaan dengan berkesan. Sintaks Asas Sintaks: SelectColumn1, Column2, ... FROMTABLE_NAMELIMITNUMBER_OF_ROWS; Number_of_rows: Tentukan bilangan baris yang dikembalikan. Sintaks dengan Offset: SelectColumn1, Column2, ... Fromtable_namelimitoffset, Number_of_rows; Offset: Langkau

Bagaimana untuk mengoptimumkan prestasi MySQL untuk aplikasi beban tinggi?

Apr 08, 2025 pm 06:03 PM

Bagaimana untuk mengoptimumkan prestasi MySQL untuk aplikasi beban tinggi?

Apr 08, 2025 pm 06:03 PM

Panduan Pengoptimuman Prestasi Pangkalan Data MySQL Dalam aplikasi yang berintensifkan sumber, pangkalan data MySQL memainkan peranan penting dan bertanggungjawab untuk menguruskan urus niaga besar-besaran. Walau bagaimanapun, apabila skala aplikasi berkembang, kemunculan prestasi pangkalan data sering menjadi kekangan. Artikel ini akan meneroka satu siri strategi pengoptimuman prestasi MySQL yang berkesan untuk memastikan aplikasi anda tetap cekap dan responsif di bawah beban tinggi. Kami akan menggabungkan kes-kes sebenar untuk menerangkan teknologi utama yang mendalam seperti pengindeksan, pengoptimuman pertanyaan, reka bentuk pangkalan data dan caching. 1. Reka bentuk seni bina pangkalan data dan seni bina pangkalan data yang dioptimumkan adalah asas pengoptimuman prestasi MySQL. Berikut adalah beberapa prinsip teras: Memilih jenis data yang betul dan memilih jenis data terkecil yang memenuhi keperluan bukan sahaja dapat menjimatkan ruang penyimpanan, tetapi juga meningkatkan kelajuan pemprosesan data.

Kunci utama MySQL boleh menjadi batal

Apr 08, 2025 pm 03:03 PM

Kunci utama MySQL boleh menjadi batal

Apr 08, 2025 pm 03:03 PM

Kunci utama MySQL tidak boleh kosong kerana kunci utama adalah atribut utama yang secara unik mengenal pasti setiap baris dalam pangkalan data. Jika kunci utama boleh kosong, rekod tidak dapat dikenal pasti secara unik, yang akan membawa kepada kekeliruan data. Apabila menggunakan lajur integer sendiri atau UUIDs sebagai kunci utama, anda harus mempertimbangkan faktor-faktor seperti kecekapan dan penghunian ruang dan memilih penyelesaian yang sesuai.

Kaedah Navicat untuk melihat kata laluan pangkalan data MongoDB

Apr 08, 2025 pm 09:39 PM

Kaedah Navicat untuk melihat kata laluan pangkalan data MongoDB

Apr 08, 2025 pm 09:39 PM

Tidak mustahil untuk melihat kata laluan MongoDB secara langsung melalui Navicat kerana ia disimpan sebagai nilai hash. Cara mendapatkan kata laluan yang hilang: 1. Tetapkan semula kata laluan; 2. Periksa fail konfigurasi (mungkin mengandungi nilai hash); 3. Semak Kod (boleh kata laluan Hardcode).