Peranti teknologi

Peranti teknologi

AI

AI

Buat pertama kali: Microsoft menggunakan GPT-4 untuk memperhalusi arahan model besar, dan prestasi sifar sampel tugas baharu dipertingkatkan lagi.

Buat pertama kali: Microsoft menggunakan GPT-4 untuk memperhalusi arahan model besar, dan prestasi sifar sampel tugas baharu dipertingkatkan lagi.

Buat pertama kali: Microsoft menggunakan GPT-4 untuk memperhalusi arahan model besar, dan prestasi sifar sampel tugas baharu dipertingkatkan lagi.

Kami tahu bahawa daripada model Google T5 hingga model besar siri OpenAI GPT, model bahasa besar (LLM) telah menunjukkan keupayaan generalisasi yang mengagumkan, seperti pembelajaran konteks dan penaakulan rantaian pemikiran. Pada masa yang sama, untuk menjadikan LLM mengikut arahan bahasa semula jadi dan menyelesaikan tugas dunia sebenar, penyelidik telah meneroka kaedah penalaan halus arahan untuk LLM. Ini dilakukan dalam dua cara: menggunakan gesaan dan maklum balas beranotasi manusia untuk memperhalusi model pada pelbagai tugas, atau menggunakan penanda aras awam dan set data ditambah dengan arahan yang dijana secara manual atau automatik untuk menyelia penalaan halus.

Antara kaedah ini, Penalaan Kendiri Arahan Kendiri ialah kaedah yang mudah dan berkesan yang belajar daripada arahan berikutan data yang dijana oleh LLM guru penalaan halus arahan SOTA, menjadikan LLM setanding kepada manusia Penjajaran yang disengajakan. Fakta telah membuktikan bahawa penalaan halus arahan telah menjadi cara yang berkesan untuk meningkatkan keupayaan generalisasi sampel sifar dan sampel kecil LLM.

Kejayaan ChatGPT dan GPT-4 baru-baru ini memberikan peluang besar untuk menggunakan penalaan halus arahan untuk menambah baik LLM sumber terbuka. Meta LLaMA ialah keluarga LLM sumber terbuka dengan prestasi yang setanding dengan LLM proprietari seperti GPT-3. Untuk mengajar LLaMA mengikut arahan, Arahan Kendiri telah diterima pakai dengan cepat kerana prestasi unggul dan kos yang rendah. Sebagai contoh, model Alpaca Stanford menggunakan sampel pematuhan arahan 52k yang dijana oleh GPT-3.5, dan model Vicuna menggunakan kira-kira 70k sampel pematuhan arahan daripada ShareGPT.

Untuk memajukan tahap SOTA bagi penalaan halus arahan, Microsoft Research menggunakan GPT-4 sebagai model guru untuk penalaan halus arahan kendiri buat kali pertama dalam kertas "Penalaan Arahan dengan GPT-4" .

- Alamat kertas: https://arxiv.org/pdf/2304.03277.pdf

- Alamat projek: https://instruction-tuning-with-gpt-4.github.io/

- Alamat GitHub: https://github.com/Instruction-Tuning-with-GPT-4/GPT-4-LLM

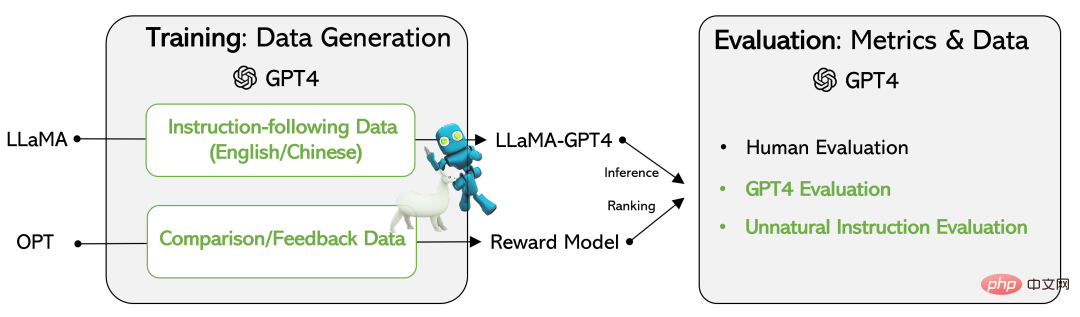

Di satu pihak, penyelidik mengeluarkan data yang dijana oleh GPT-4, termasuk set data pematuhan arahan 52k dalam bahasa Cina dan Inggeris, dan data maklum balas yang dijana oleh GPT-4 untuk menilai output ketiga-tiga arahan model penalaan halus.

Sebaliknya, model LLaMA penalaan halus arahan dan model ganjaran telah dibangunkan berdasarkan data yang dijana oleh GPT-4. Untuk menilai kualiti LLM penalaan halus arahan, para penyelidik menilai sampel ujian menggunakan tiga metrik: penilaian manual bagi tiga kriteria penjajaran, penilaian automatik berdasarkan maklum balas GPT-4 dan ROUGE-L (kaedah penilaian ringkasan automatik untuk arahan tidak semulajadi) satu).

Hasil percubaan mengesahkan keberkesanan arahan penalaan halus LLM menggunakan data yang dijana oleh GPT-4. Data pematuhan arahan bahasa Cina dan Inggeris 52k yang dijana oleh GPT-4 mencapai prestasi sampel sifar yang lebih baik pada tugas baharu berbanding model SOTA sebelumnya. Pada masa ini, penyelidik telah mendedahkan data yang dijana menggunakan GPT-4 dan kod berkaitan.

Set Data

Kajian ini menggunakan GPT-4 untuk menjana empat set data berikut:

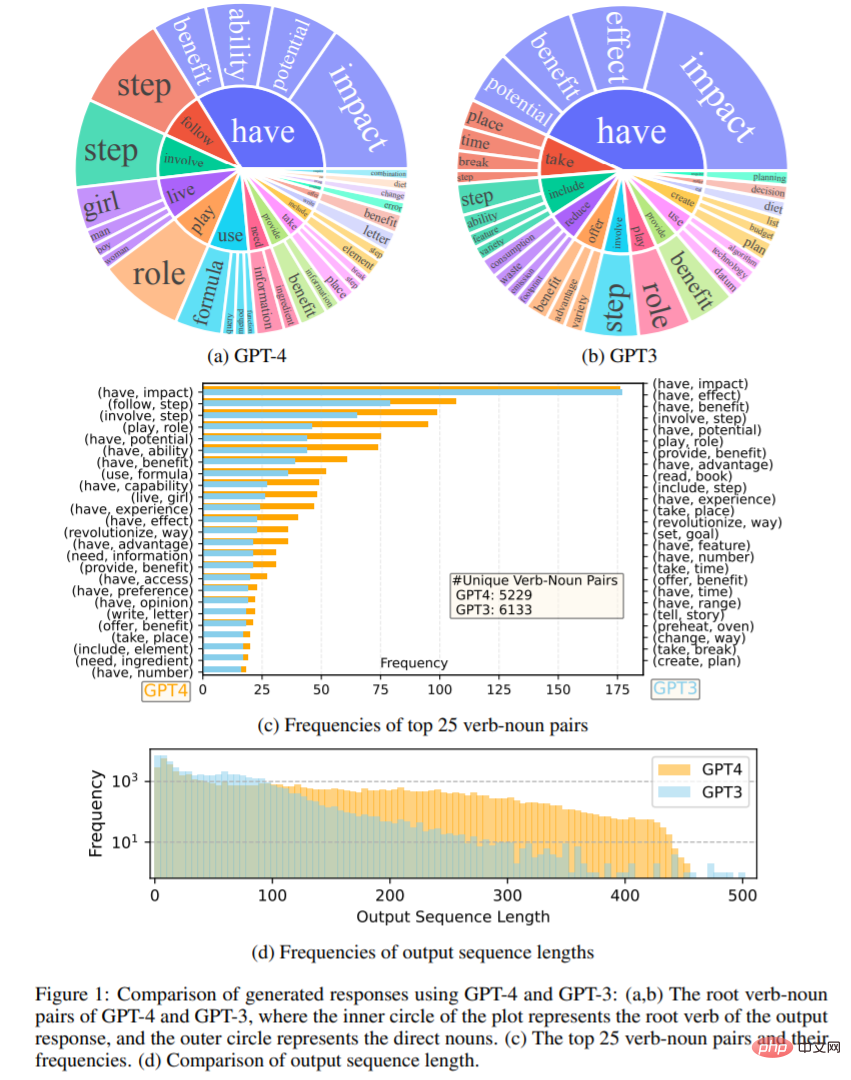

- Data Mengikuti Arahan Bahasa Inggeris: Untuk arahan 52K yang dikumpul daripada Alpaca, setiap arahan disediakan dengan jawapan Bahasa Inggeris GPT-4. Set data ini digunakan terutamanya untuk meneroka dan membandingkan statistik jawapan GPT-4 dan jawapan GPT-3.

- Data Mengikuti Arahan Bahasa Cina: Kajian ini menggunakan ChatGPT untuk menterjemah arahan 52K ke dalam bahasa Cina dan meminta GPT-4 menjawab dalam bahasa Cina.

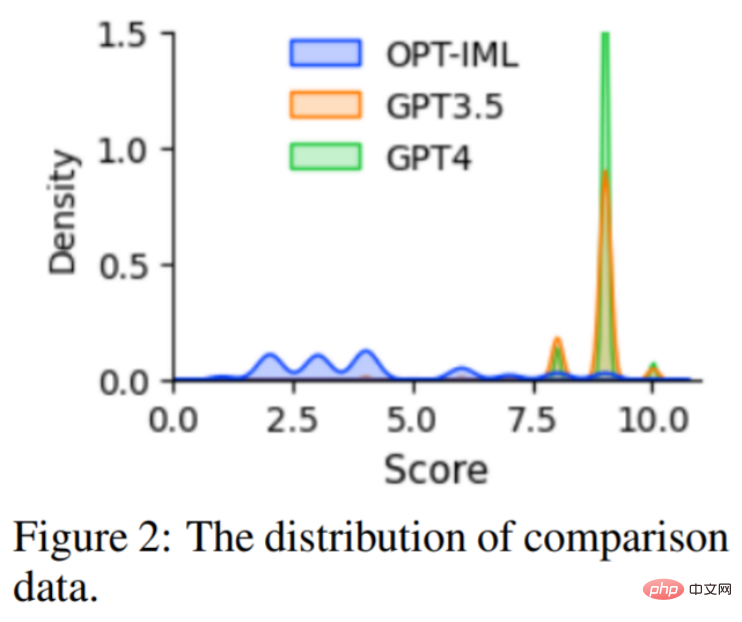

- Data Perbandingan: Biarkan GPT-4 menilai responsnya sendiri pada skala dari 1 hingga 10. Selain itu, kajian itu meminta GPT-4 untuk membandingkan dan menjaringkan respons tiga model: GPT-4, GPT-3.5 dan OPT-IML. Set data ini digunakan terutamanya untuk melatih model ganjaran.

- Jawapan tentang Arahan Tidak Semulajadi: Jawapan GPT-4 dinyahkod pada tiga set data teras arahan-input-output 68K. Subset ini digunakan untuk mengukur jurang antara GPT-4 dan model penalaan halus arahan.

Rajah 1 membandingkan set respons output Bahasa Inggeris GPT-4 dan GPT-3.5. Rajah 1 (a) dan (b) menunjukkan dua set keluaran pasangan kata kerja-kata nama dengan kekerapan lebih tinggi daripada 10. Rajah 1 (c) membandingkan 25 pasangan perkataan yang paling kerap dalam dua set tersebut taburan kekerapan panjang jujukan, dan keputusan menunjukkan bahawa GPT-4 cenderung untuk menghasilkan jujukan yang lebih panjang daripada GPT-3.5.

Model bahasa penalaan halus arahan

Kajian ini berdasarkan pusat pemeriksaan LLaMA 7B dan menggunakan penalaan halus diselia untuk melatih dua model: ( i) LLaMA-GPT4, dilatih pada data pematuhan arahan Bahasa Inggeris 52K yang dijana oleh GPT-4. (ii) LLaMA-GPT4-CN, dilatih pada arahan bahasa Cina 52K mengikut data yang dijana daripada GPT-4.

Model Ganjaran

Pembelajaran Pengukuhan dengan Maklum Balas Manusia (RLHF) bertujuan untuk menyelaraskan tingkah laku LLM dengan keutamaan manusia, Ganjaran pemodelan adalah salah satu bahagian utamanya, dan masalahnya sering dirumuskan sebagai tugas regresi untuk meramalkan ganjaran antara isyarat yang diberikan dan tindak balas. Walau bagaimanapun, kaedah ini biasanya memerlukan data perbandingan berskala besar Model sumber terbuka sedia ada seperti Alpaca, Vicuna dan Dolly tidak melibatkan RLHF kerana kos yang tinggi untuk membuat anotasi data perbandingan. Pada masa yang sama, penyelidikan baru-baru ini menunjukkan bahawa GPT-4 dapat mengenal pasti dan membaiki ralatnya sendiri dan menilai dengan tepat kualiti respons. Oleh itu, untuk memudahkan penyelidikan mengenai RLHF, kajian ini mencipta data perbandingan menggunakan GPT-4, seperti yang dinyatakan di atas.

Untuk menilai kualiti data, kajian ini juga melatih model ganjaran berdasarkan OPT 1.3B untuk penilaian pada set data ini. Taburan data perbandingan ditunjukkan dalam Rajah 2.

Eksperimen

Kajian ini menggunakan tiga jenis berikut untuk penilaian : Penilaian manusia, GPT-4, dan penilaian arahan luar tabii. Keputusan mengesahkan bahawa menggunakan data yang dijana oleh GPT-4 ialah kaedah yang cekap dan berkesan untuk memperhalusi arahan LLM berbanding dengan data jana mesin yang lain. Seterusnya kita melihat proses eksperimen tertentu.

Penilaian manusia

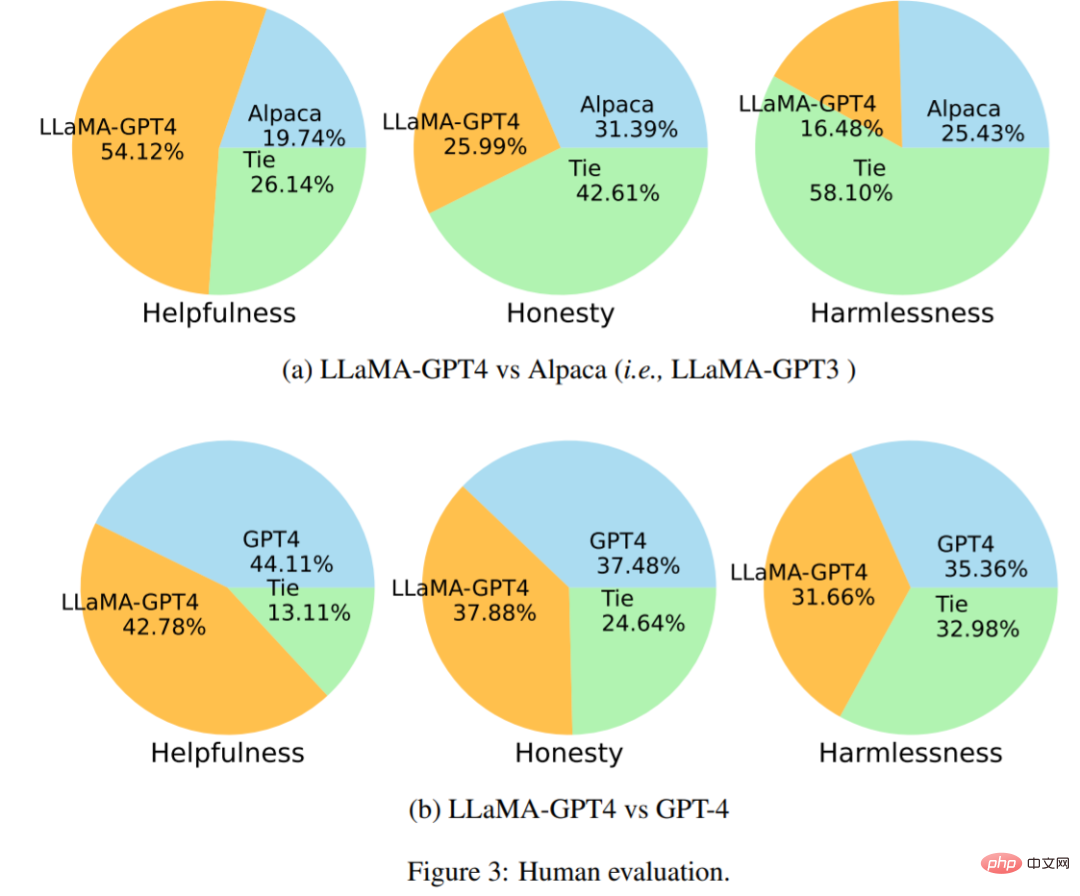

Rajah 3 (a) ialah hasil perbandingan LLaMA-GPT4 vs Alpaca eksperimen menunjukkan bahawa dalam Di bawah penunjuk Kebergunaan, GPT-4 menang dengan skor 54.12%. Rajah 3(b) menunjukkan hasil perbandingan LLaMA-GPT4 lwn GPT-4, menunjukkan bahawa prestasi LLaMA diperhalusi oleh arahan GPT-4 adalah serupa dengan GPT-4 asal.

Perbandingan dengan SOTA menggunakan penilaian automatik

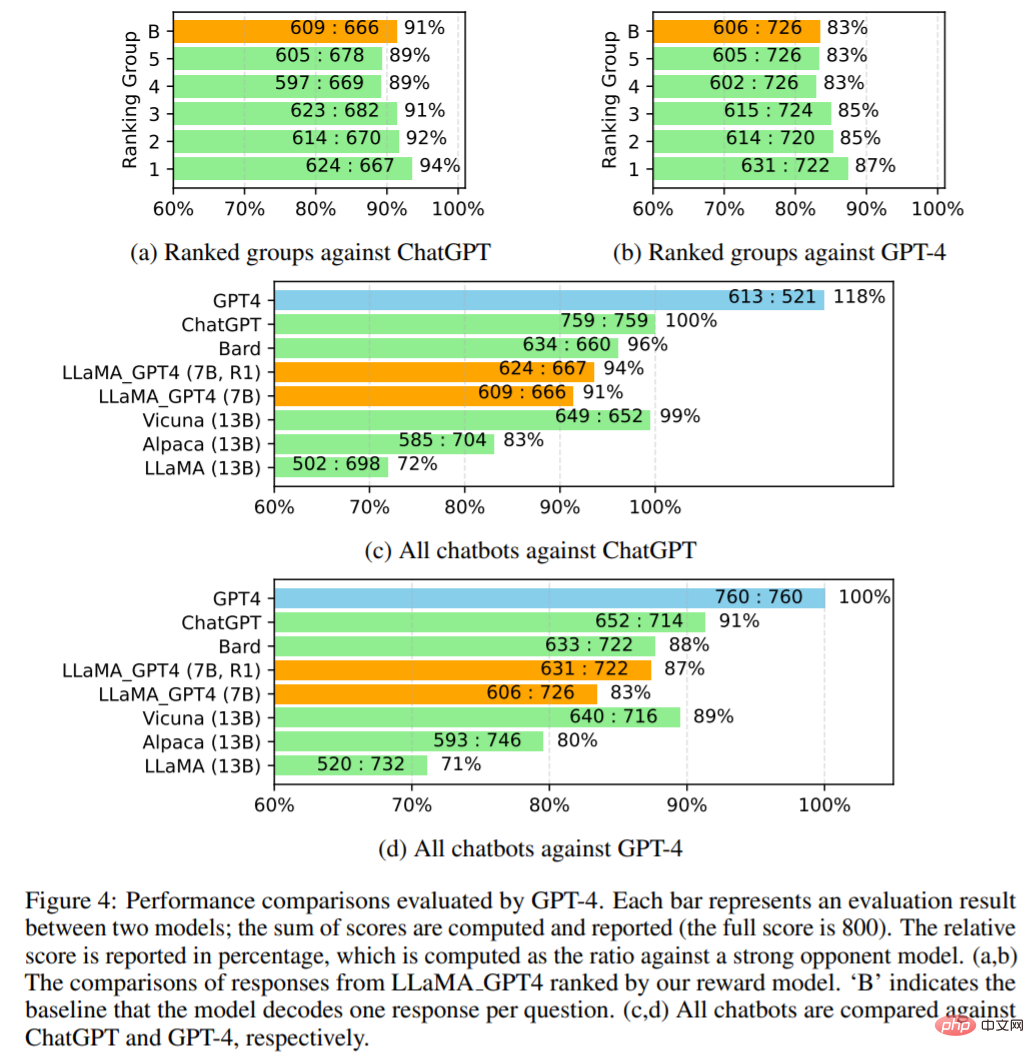

Kajian menggunakan GPT-4 untuk menilai secara automatik respons model yang berbeza pada 80 soalan yang tidak kelihatan. Mula-mula kumpulkan jawapan daripada dua bot sembang, LLaMA-GPT-4 (7B) dan GPT-4, dan gunakan bot sembang lain untuk menerbitkan jawapan, termasuk LLaMA (13B), Alpaca (13B), Vicuna (13B), Bard (Google, 2023) dan ChatGPT. Untuk setiap penilaian, kajian meminta GPT-4 menilai kualiti tindak balas antara kedua-dua model pada skala 1 hingga 10. Keputusan ditunjukkan dalam Rajah 4.

Rajah 4 (c,d) membandingkan semua chatbots. LLaMA_GPT4 berprestasi lebih baik: 7B LLaMA GPT4 berprestasi lebih baik daripada 13B Alpaca dan LLaMA. Walau bagaimanapun, LLaMA_GPT4 masih mempunyai jurang berbanding dengan chatbot komersial yang besar seperti GPT-4.

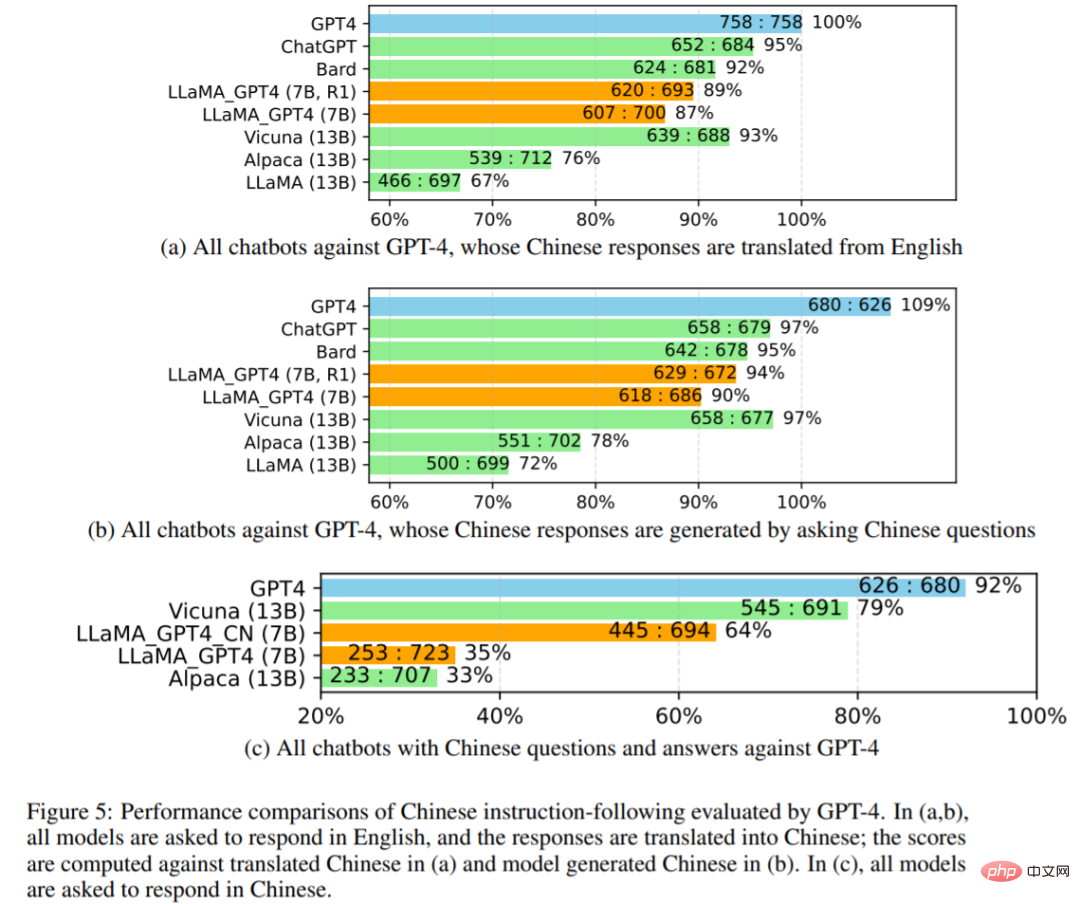

Para penyelidik mengkaji lagi prestasi semua chatbot dalam Rajah 5 di bawah. Mula-mula gunakan GPT-4 untuk menterjemahkan jawapan bahasa Inggeris chatbot ke dalam bahasa Cina, dan kemudian gunakan GPT-4 untuk menterjemah soalan bahasa Inggeris ke bahasa Cina untuk mendapatkan jawapannya. Perbandingan dengan terjemahan GPT-4 dan respons bahasa Cina yang dihasilkan ditunjukkan dalam 5 (a) dan 5 (b), dengan semua keputusan model diminta menjawab dalam bahasa Cina ditunjukkan dalam 5 (c).

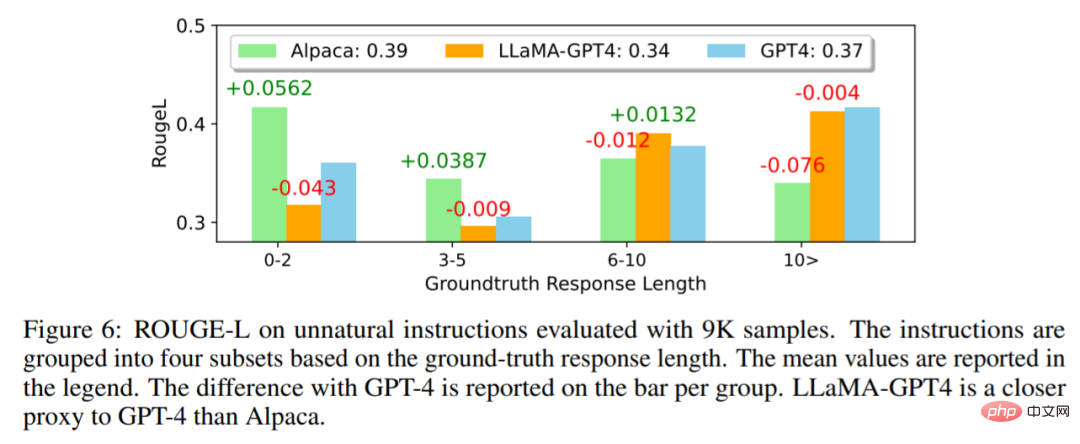

Dalam Rajah 6 di bawah, penyelidik membandingkan LLaMA-GPT4 dengan arahan luar tabii GPT-4 dan Alpaca. Keputusan menunjukkan bahawa LLaMA-GPT4 dan GPT-4 berprestasi lebih baik apabila panjang tindak balas kebenaran tanah meningkat. Ini bermakna mereka boleh mengikut arahan dengan lebih baik apabila adegan lebih kreatif. Kedua-dua LLaMA-GPT4 dan GPT-4 boleh menjana respons yang mengandungi jawapan kebenaran asas yang mudah apabila panjang jujukan adalah pendek, dan menambah perkataan tambahan boleh menjadikan respons lebih seperti sembang.

Sila rujuk kertas asal untuk butiran lanjut teknikal dan eksperimen.

Atas ialah kandungan terperinci Buat pertama kali: Microsoft menggunakan GPT-4 untuk memperhalusi arahan model besar, dan prestasi sifar sampel tugas baharu dipertingkatkan lagi.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1381

1381

52

52

Petua Konfigurasi Firewall Pelayan Mel Debian

Apr 13, 2025 am 11:42 AM

Petua Konfigurasi Firewall Pelayan Mel Debian

Apr 13, 2025 am 11:42 AM

Mengkonfigurasi firewall pelayan Mail Debian adalah langkah penting dalam memastikan keselamatan pelayan. Berikut adalah beberapa kaedah konfigurasi firewall yang biasa digunakan, termasuk penggunaan iptables dan firewalld. Gunakan iptables untuk mengkonfigurasi firewall untuk memasang iptables (jika belum dipasang): sudoapt-getupdateudoapt-getinstalliplesview peraturan iptables semasa: konfigurasi sudoiptable-l

Bagaimana Debian Readdir Bersepadu Dengan Alat Lain

Apr 13, 2025 am 09:42 AM

Bagaimana Debian Readdir Bersepadu Dengan Alat Lain

Apr 13, 2025 am 09:42 AM

Fungsi Readdir dalam sistem Debian adalah panggilan sistem yang digunakan untuk membaca kandungan direktori dan sering digunakan dalam pengaturcaraan C. Artikel ini akan menerangkan cara mengintegrasikan Readdir dengan alat lain untuk meningkatkan fungsinya. Kaedah 1: Menggabungkan Program Bahasa C dan Pipeline Pertama, tulis program C untuk memanggil fungsi Readdir dan output hasilnya:#termasuk#termasuk#includeintMain (intargc, char*argv []) {dir*dir; structdirent*entry; if (argc! = 2) {

Cara Melaksanakan Penyortiran Fail oleh Debian Readdir

Apr 13, 2025 am 09:06 AM

Cara Melaksanakan Penyortiran Fail oleh Debian Readdir

Apr 13, 2025 am 09:06 AM

Dalam sistem Debian, fungsi Readdir digunakan untuk membaca kandungan direktori, tetapi urutan yang dikembalikannya tidak ditentukan sebelumnya. Untuk menyusun fail dalam direktori, anda perlu membaca semua fail terlebih dahulu, dan kemudian menyusunnya menggunakan fungsi QSORT. Kod berikut menunjukkan cara menyusun fail direktori menggunakan ReadDir dan QSORT dalam sistem Debian:#termasuk#termasuk#termasuk#termasuk // fungsi perbandingan adat, yang digunakan untuk qSortintCompare (Constvoid*A, Constvoid*b) {Returnstrcmp (*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(*(

Cara Melakukan Pengesahan Tandatangan Digital dengan Debian Openssl

Apr 13, 2025 am 11:09 AM

Cara Melakukan Pengesahan Tandatangan Digital dengan Debian Openssl

Apr 13, 2025 am 11:09 AM

Menggunakan OpenSSL untuk Pengesahan Tandatangan Digital pada Sistem Debian, anda boleh mengikuti langkah -langkah berikut: Penyediaan untuk memasang OpenSSL: Pastikan sistem Debian anda telah dipasang. Jika tidak dipasang, anda boleh menggunakan arahan berikut untuk memasangnya: sudoaptdateudoaptininstallopenssl untuk mendapatkan kunci awam: Pengesahan tandatangan digital memerlukan kunci awam penandatangan. Biasanya, kunci awam akan disediakan dalam bentuk fail, seperti public_key.pe

Kaedah pemasangan sijil SSL Server Server Debian

Apr 13, 2025 am 11:39 AM

Kaedah pemasangan sijil SSL Server Server Debian

Apr 13, 2025 am 11:39 AM

Langkah -langkah untuk memasang sijil SSL pada pelayan mel Debian adalah seperti berikut: 1. Pasang OpenSSL Toolkit terlebih dahulu, pastikan bahawa OpenSSL Toolkit telah dipasang pada sistem anda. Jika tidak dipasang, anda boleh menggunakan arahan berikut untuk memasang: sudoapt-getupdateudoapt-getinstallopenssl2. Menjana permintaan kunci dan sijil peribadi seterusnya, gunakan OpenSSL untuk menjana kunci peribadi RSA 2048-bit dan permintaan sijil (CSR): Membuka

Bagaimana Debian OpenSSL Menghalang Serangan Man-dalam-Middle

Apr 13, 2025 am 10:30 AM

Bagaimana Debian OpenSSL Menghalang Serangan Man-dalam-Middle

Apr 13, 2025 am 10:30 AM

Dalam sistem Debian, OpenSSL adalah perpustakaan penting untuk pengurusan penyulitan, penyahsulitan dan sijil. Untuk mengelakkan serangan lelaki-dalam-pertengahan (MITM), langkah-langkah berikut boleh diambil: Gunakan HTTPS: Pastikan semua permintaan rangkaian menggunakan protokol HTTPS dan bukannya HTTP. HTTPS menggunakan TLS (Protokol Keselamatan Lapisan Pengangkutan) untuk menyulitkan data komunikasi untuk memastikan data tidak dicuri atau diganggu semasa penghantaran. Sahkan Sijil Pelayan: Sahkan secara manual Sijil Pelayan pada klien untuk memastikan ia boleh dipercayai. Pelayan boleh disahkan secara manual melalui kaedah perwakilan urlSession

Cara Melakukan Pengurusan Log Debian Hadoop

Apr 13, 2025 am 10:45 AM

Cara Melakukan Pengurusan Log Debian Hadoop

Apr 13, 2025 am 10:45 AM

Menguruskan Log Hadoop pada Debian, anda boleh mengikuti langkah-langkah berikut dan amalan terbaik: Agregasi log membolehkan pengagregatan log: tetapkan benang.log-agregasi-enable untuk benar dalam fail benang-site.xml untuk membolehkan pengagregatan log. Konfigurasikan dasar pengekalan log: tetapkan yarn.log-aggregasi.Retain-seconds Untuk menentukan masa pengekalan log, seperti 172800 saat (2 hari). Nyatakan Laluan Penyimpanan Log: Melalui Benang

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Perintah shutdown CentOS adalah penutupan, dan sintaks adalah tutup [pilihan] [maklumat]. Pilihan termasuk: -h menghentikan sistem dengan segera; -P mematikan kuasa selepas penutupan; -r mulakan semula; -T Waktu Menunggu. Masa boleh ditentukan sebagai segera (sekarang), minit (minit), atau masa tertentu (HH: mm). Maklumat tambahan boleh dipaparkan dalam mesej sistem.