Peranti teknologi

Peranti teknologi

AI

AI

Sangat sejuk sehingga ia meletup! Demonstrasi dalam talian HuggingGPT membuat penampilan yang menakjubkan, dan netizen menguji penjanaan imej secara peribadi

Sangat sejuk sehingga ia meletup! Demonstrasi dalam talian HuggingGPT membuat penampilan yang menakjubkan, dan netizen menguji penjanaan imej secara peribadi

Sangat sejuk sehingga ia meletup! Demonstrasi dalam talian HuggingGPT membuat penampilan yang menakjubkan, dan netizen menguji penjanaan imej secara peribadi

Gabungan terkuat HuggingFace+ChatGPT="Jarvis" kini dibuka untuk demo.

Beberapa masa lalu, Universiti Zhejiang dan Microsoft mengeluarkan HuggingGPT, sistem kerjasama model besar yang menjadi popular segera.

Para penyelidik mencadangkan menggunakan ChatGPT sebagai pengawal untuk menyambungkan pelbagai model AI dalam komuniti HuggingFace untuk menyelesaikan tugasan kompleks berbilang modal.

Dalam keseluruhan proses, semua yang anda perlu lakukan ialah: mengeluarkan keperluan anda dalam bahasa semula jadi.

Para saintis Nvidia berkata ini adalah kertas kerja paling menarik yang pernah saya baca minggu ini. Ideanya sangat dekat dengan "Apl Semuanya" yang saya nyatakan sebelum ini, iaitu, semuanya adalah Apl, dan maklumat itu dibaca terus oleh AI.

Pengalaman Bermula

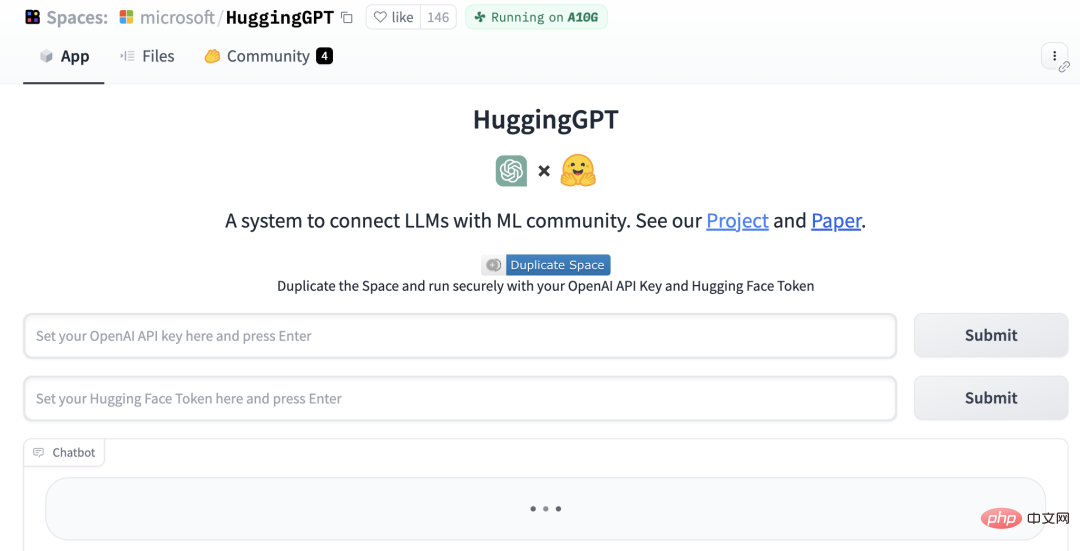

Kini, HuggingGPT telah menambah demo Gradio.

Alamat projek: https://github.com/microsoft/JARVIS

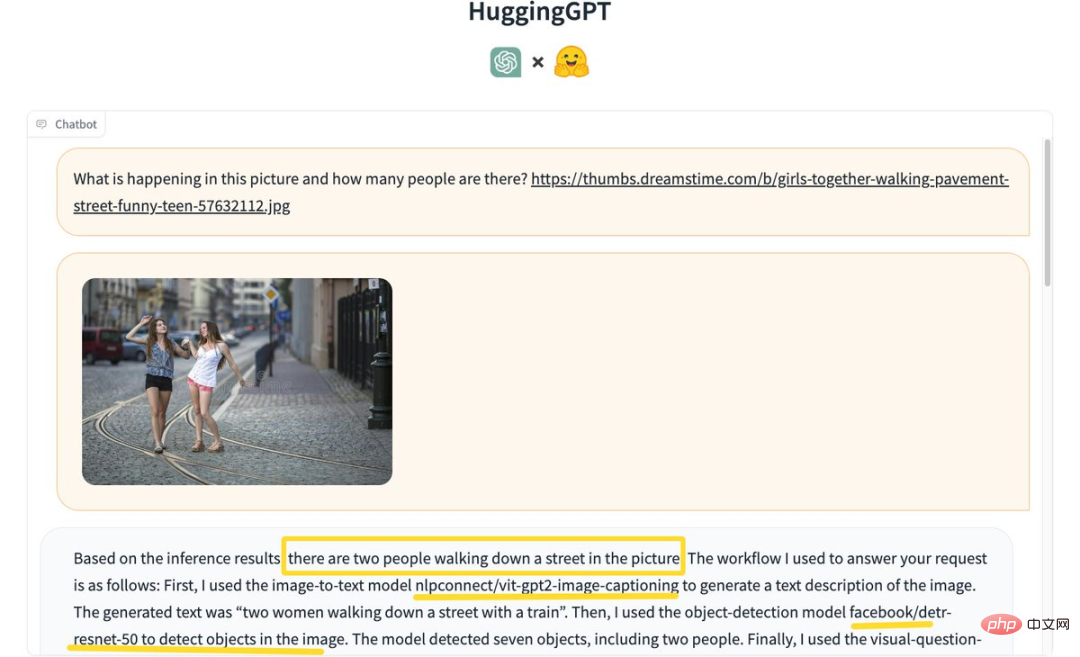

Sesetengah netizen mula mengalaminya, mula-mula mari kita "kenal pasti berapa ramai orang dalam gambar"?

MemelukGPT berdasarkan keputusan inferens, membuat kesimpulan bahawa terdapat 2 orang berjalan di jalan dalam gambar.

Proses khusus adalah seperti berikut:

Mula-mula gunakan imej untuk teks model nlpconnect/vit-gpt2-image-captioning untuk menerangkan imej dan jana teks "Dua wanita berjalan di jalan dengan kereta api."

Seterusnya, model pengesanan objek facebook/detresnet 50 digunakan untuk mengesan bilangan orang dalam gambar. Model itu mengesan 7 objek dan 2 orang.

Kemudian gunakan model menjawab soalan visual dandelin/vilt-b32-finetuned-vqa untuk mendapatkan keputusan. Akhir sekali, sistem menyediakan respons terperinci dan maklumat model untuk menjawab soalan.

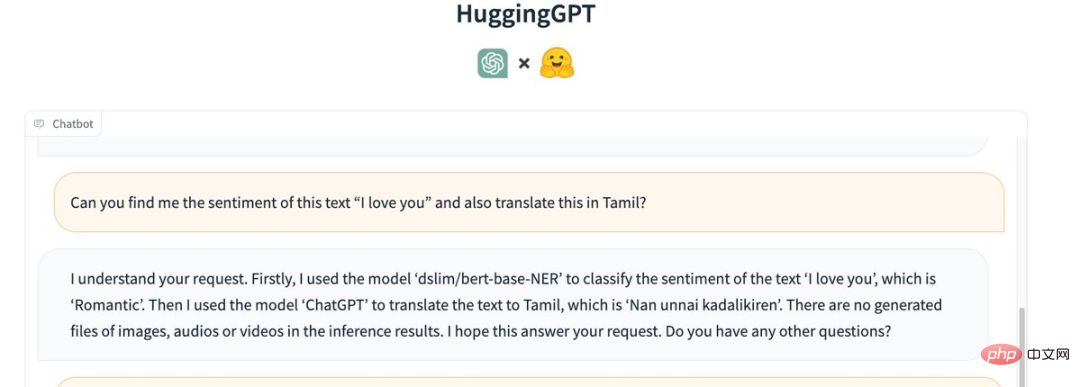

Selain itu, biarkan ia memahami emosi ayat "I love you" dan menterjemahkannya ke dalam bahasa Tamil (Tamiḻ).

HuggingGPT memanggil model berikut:

Pertama, model "dslim/bert-base-NER" digunakan untuk memadankan teks " Saya sayang awak "Pengkelasan emosi adalah "romantik".

Kemudian, gunakan "ChatGPT" untuk menterjemah teks ke dalam bahasa Tamil, iaitu "Nan unnai kadalikiren".

Tiada imej, fail audio atau video yang dijana dalam hasil inferens.

PelukanGPT gagal semasa menyalin fail MP3. Seorang netizen berkata, "Tidak pasti sama ada ini adalah masalah dengan fail input saya."

Masukkan imej "Kucing menari" dan tambahkan teks "I LOVE YOU" sebagai tindanan.

HuggingGPT mula-mula menggunakan model "runwayml/stable-diffusion-1-5" untuk menjana gambar "kucing menari" berdasarkan teks yang diberikan.

Kemudian, model yang sama digunakan untuk menjana imej "I LOVE YOU" berdasarkan teks yang diberikan.

Akhir sekali, gabungkan kedua-dua gambar dan keluarkan gambar berikut:

Jarvis menjadi kenyataan

Beberapa hari selepas projek itu diumumkan , Jarvis telah menerima 12.5k bintang di GitHub dan 811 garpu.

Penyelidik menegaskan bahawa menyelesaikan masalah semasa model bahasa besar (LLM) mungkin merupakan langkah pertama dan penting ke arah AGI.

Oleh kerana teknologi semasa model bahasa besar masih mempunyai beberapa kelemahan, terdapat beberapa cabaran mendesak dalam pembinaan sistem AGI.

Untuk mengendalikan tugas AI yang kompleks, LLM seharusnya dapat menyelaraskan dengan model luaran untuk memanfaatkan keupayaan mereka.

Oleh itu, perkara utama ialah cara memilih perisian tengah yang sesuai untuk merapatkan LLM dan model AI.

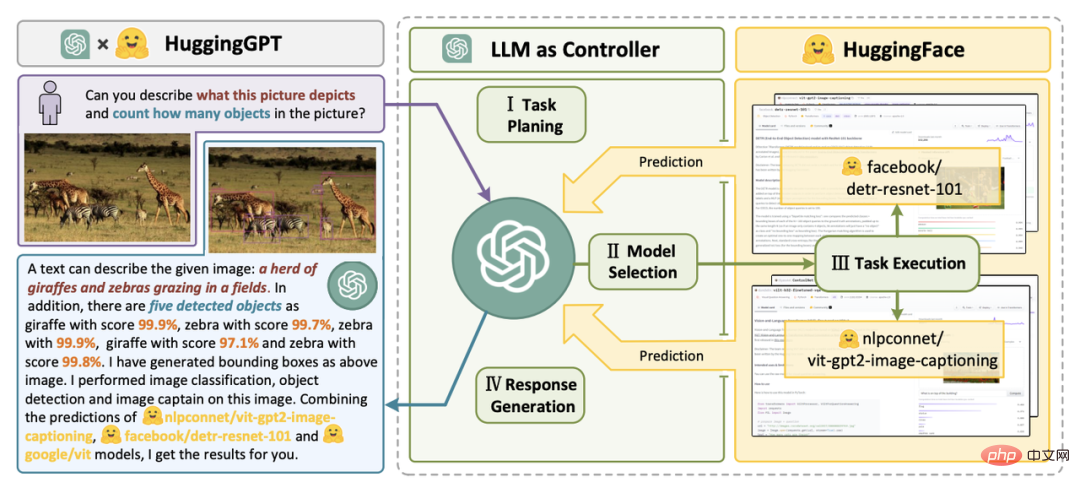

Dalam kertas penyelidikan ini, pengkaji mencadangkan bahasa ialah antara muka universal dalam HuggingGPT. Aliran kerjanya terbahagi terutamanya kepada empat langkah:

Alamat kertas: https://arxiv.org/pdf/2303.17580.pdf

Pertama ialah perancangan tugasan ChatGPT menghuraikan permintaan pengguna, memecahkannya kepada berbilang tugas dan merancang urutan dan kebergantungan tugas berdasarkan pengetahuannya.

Seterusnya, teruskan ke pemilihan model. LLM memberikan tugas yang dihuraikan kepada model pakar berdasarkan penerangan model dalam HuggingFace.

Kemudian laksanakan tugas itu. Model pakar melaksanakan tugasan yang diberikan pada titik akhir inferens dan merekodkan maklumat pelaksanaan dan keputusan inferens ke dalam LLM.

Akhir sekali ialah penjanaan tindak balas. LLM meringkaskan log proses pelaksanaan dan keputusan inferens, dan mengembalikan ringkasan kepada pengguna.

Jika permintaan sedemikian diberikan:

Sila hasilkan gambar seorang gadis sedang membaca buku , dia Posenya sama dengan budak lelaki dalam contoh.jpg. Kemudian gunakan suara anda untuk menerangkan imej baharu.

Anda boleh melihat cara HuggingGPT menguraikannya kepada 6 subtugasan dan memilih model untuk dilaksanakan masing-masing untuk mendapatkan hasil akhir.

Dengan memasukkan penerangan model AI ke dalam gesaan, ChatGPT boleh dianggap sebagai otak yang menguruskan model AI. Oleh itu, kaedah ini membolehkan ChatGPT memanggil model luaran untuk menyelesaikan tugas praktikal.

Ringkasnya, HuggingGPT ialah sistem kerjasama, bukan model besar.

Fungsinya adalah untuk menghubungkan ChatGPT dan HuggingFace untuk memproses input dalam modaliti yang berbeza dan menyelesaikan banyak tugas kecerdasan buatan yang kompleks.

Jadi, setiap model AI dalam komuniti HuggingFace mempunyai penerangan model yang sepadan dalam perpustakaan HuggingGPT, dan disepadukan ke dalam gesaan untuk mewujudkan sambungan dengan ChatGPT.

HuggingGPT kemudian menggunakan ChatGPT sebagai otak untuk menentukan jawapan kepada soalan tersebut.

Setakat ini, HuggingGPT telah menyepadukan ratusan model pada HuggingFace di sekitar ChatGPT, meliputi klasifikasi teks, pengesanan sasaran, segmentasi semantik, penjanaan imej, soal jawab, teks ke ucapan, 24 tugasan seperti sebagai teks kepada video.

Hasil eksperimen membuktikan bahawa HuggingGPT boleh menunjukkan prestasi yang baik dalam pelbagai bentuk tugasan yang kompleks.

Komen hangat daripada netizen

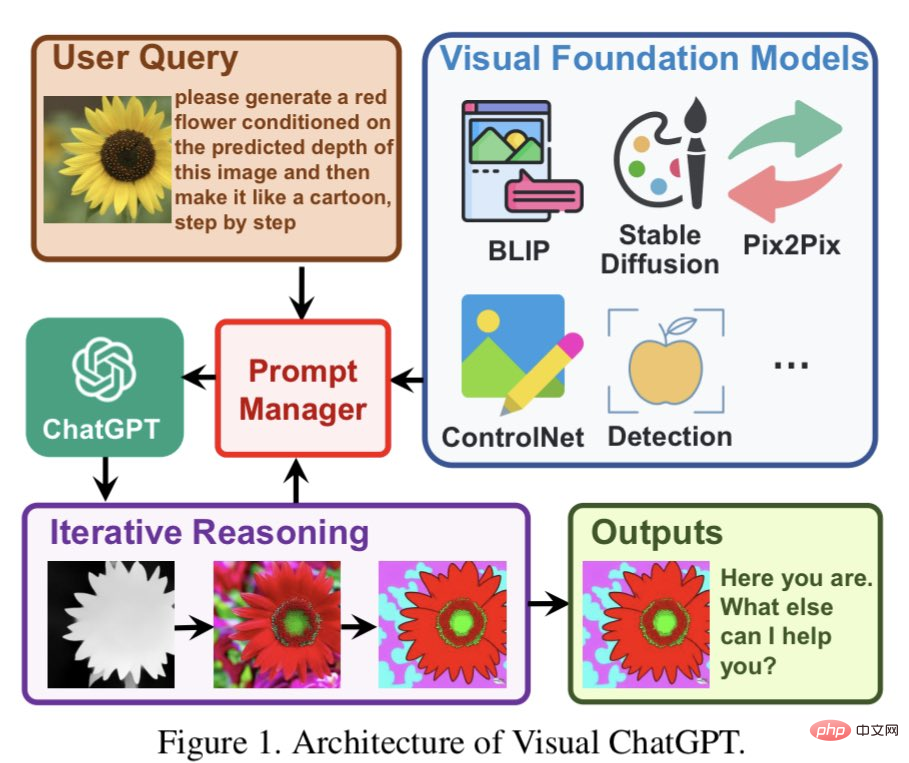

Sesetengah netizen berkata HuggingGPT serupa dengan Visual ChatGPT yang dicadangkan oleh Microsoft sebelum ini daripada model pra-latihan yang unggul.

Visual ChatGPT dibina terus pada ChatGPT dan menyuntik banyak model visual (VFM) ke dalamnya. Urus Prompt dicadangkan dalam artikel.

Dengan bantuan PM, ChatGPT boleh menggunakan VFM ini dan menerima maklum balas mereka secara berulang sehingga keperluan pengguna dipenuhi atau syarat tamat dicapai.

Sesetengah netizen percaya idea ini sememangnya hampir sama dengan ChatGPT. Menggunakan LLM sebagai pusat pemahaman semantik dan perancangan tugas boleh meningkatkan keupayaan LLM secara tidak terhingga. Dengan menggabungkan LLM dengan pakar fungsian atau domain lain, kami boleh mencipta sistem AI yang lebih berkuasa dan fleksibel yang boleh menyesuaikan diri dengan lebih baik kepada pelbagai tugas dan keperluan.

Inilah yang selalu saya fikirkan tentang model kecerdasan buatan boleh memahami tugas yang rumit dan kemudian memberikan tugasan yang lebih kecil kepada tugasan lain yang lebih khusus model.

Sama seperti otak, ia juga mempunyai bahagian yang berbeza untuk melaksanakan tugas tertentu, bunyinya sangat logik.

Atas ialah kandungan terperinci Sangat sejuk sehingga ia meletup! Demonstrasi dalam talian HuggingGPT membuat penampilan yang menakjubkan, dan netizen menguji penjanaan imej secara peribadi. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

Platform Perdagangan Web3 Ranking_Web3 Global Exchanges Top Ten Ringkasan

Apr 21, 2025 am 10:45 AM

Platform Perdagangan Web3 Ranking_Web3 Global Exchanges Top Ten Ringkasan

Apr 21, 2025 am 10:45 AM

Binance adalah tuan rumah ekosistem perdagangan aset digital global, dan ciri -cirinya termasuk: 1. Jumlah dagangan harian purata melebihi $ 150 bilion, menyokong 500 pasangan perdagangan, yang meliputi 98% mata wang arus perdana; 2. Matriks inovasi meliputi pasaran Derivatif, susun atur Web3 dan sistem pendidikan; 3. Kelebihan teknikal adalah enjin yang sepadan dengan milisaat, dengan jumlah pemprosesan puncak sebanyak 1.4 juta transaksi sesaat; 4. Kemajuan pematuhan memegang lesen 15 negara dan menetapkan entiti yang mematuhi di Eropah dan Amerika Syarikat.

Ramalan Harga Worldcoin (WLD) 2025-2031: Adakah WLD akan mencapai $ 4 menjelang 2031?

Apr 21, 2025 pm 02:42 PM

Ramalan Harga Worldcoin (WLD) 2025-2031: Adakah WLD akan mencapai $ 4 menjelang 2031?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD) menonjol dalam pasaran cryptocurrency dengan mekanisme pengesahan biometrik dan perlindungan privasi yang unik, menarik perhatian banyak pelabur. WLD telah melakukan yang luar biasa di kalangan altcoin dengan teknologi inovatifnya, terutamanya dalam kombinasi dengan teknologi kecerdasan buatan terbuka. Tetapi bagaimanakah aset digital akan berkelakuan dalam beberapa tahun akan datang? Mari kita meramalkan harga masa depan WLD bersama -sama. Ramalan harga WLD 2025 dijangka mencapai pertumbuhan yang signifikan di WLD pada tahun 2025. Analisis pasaran menunjukkan bahawa harga WLD purata boleh mencapai $ 1.31, dengan maksimum $ 1.36. Walau bagaimanapun, dalam pasaran beruang, harga mungkin jatuh ke sekitar $ 0.55. Harapan pertumbuhan ini disebabkan terutamanya oleh WorldCoin2.

Kedudukan pertukaran leverage dalam lingkaran mata wang Cadangan terkini sepuluh pertukaran leverage dalam lingkaran mata wang

Apr 21, 2025 pm 11:24 PM

Kedudukan pertukaran leverage dalam lingkaran mata wang Cadangan terkini sepuluh pertukaran leverage dalam lingkaran mata wang

Apr 21, 2025 pm 11:24 PM

Platform yang mempunyai prestasi cemerlang dalam perdagangan, keselamatan dan pengalaman pengguna yang dimanfaatkan pada tahun 2025 adalah: 1. Okx, sesuai untuk peniaga frekuensi tinggi, menyediakan sehingga 100 kali leverage; 2. Binance, sesuai untuk peniaga berbilang mata wang di seluruh dunia, memberikan 125 kali leverage tinggi; 3. Gate.io, sesuai untuk pemain derivatif profesional, menyediakan 100 kali leverage; 4. Bitget, sesuai untuk orang baru dan peniaga sosial, menyediakan sehingga 100 kali leverage; 5. Kraken, sesuai untuk pelabur mantap, menyediakan 5 kali leverage; 6. Bybit, sesuai untuk penjelajah altcoin, menyediakan 20 kali leverage; 7. Kucoin, sesuai untuk peniaga kos rendah, menyediakan 10 kali leverage; 8. Bitfinex, sesuai untuk bermain senior

Apakah yang dimaksudkan dengan transaksi rantaian rantaian? Apakah urus niaga salib?

Apr 21, 2025 pm 11:39 PM

Apakah yang dimaksudkan dengan transaksi rantaian rantaian? Apakah urus niaga salib?

Apr 21, 2025 pm 11:39 PM

Pertukaran yang menyokong urus niaga rantaian: 1. Binance, 2. Uniswap, 3 Sushiswap, 4. Kewangan Curve, 5. Thorchain, 6. 1 inci Pertukaran, 7.

'Black Monday Sell' adalah hari yang sukar untuk industri cryptocurrency

Apr 21, 2025 pm 02:48 PM

'Black Monday Sell' adalah hari yang sukar untuk industri cryptocurrency

Apr 21, 2025 pm 02:48 PM

Jatuh di pasaran cryptocurrency telah menyebabkan panik di kalangan pelabur, dan Dogecoin (Doge) telah menjadi salah satu kawasan terkena paling sukar. Harganya jatuh dengan ketara, dan jumlah nilai kunci kewangan yang terdesentralisasi (DEFI) (TVL) juga menyaksikan penurunan yang ketara. Gelombang jualan "Black Monday" menyapu pasaran cryptocurrency, dan Dogecoin adalah yang pertama dipukul. Defitvlnya jatuh ke tahap 2023, dan harga mata wang jatuh 23.78% pada bulan lalu. Defitvl Dogecoin jatuh ke tahap rendah $ 2.72 juta, terutamanya disebabkan oleh penurunan 26.37% dalam indeks nilai SOSO. Platform defi utama lain, seperti DAO dan Thorchain yang membosankan, TVL juga menurun sebanyak 24.04% dan 20.

Mengapa kenaikan atau kejatuhan harga mata wang maya? Mengapa kenaikan atau kejatuhan harga mata wang maya?

Apr 21, 2025 am 08:57 AM

Mengapa kenaikan atau kejatuhan harga mata wang maya? Mengapa kenaikan atau kejatuhan harga mata wang maya?

Apr 21, 2025 am 08:57 AM

Faktor kenaikan harga mata wang maya termasuk: 1. Peningkatan permintaan pasaran, 2. Menurunkan bekalan, 3. Berita positif yang dirangsang, 4. Sentimen pasaran optimis, 5. Persekitaran makroekonomi; Faktor penurunan termasuk: 1. Mengurangkan permintaan pasaran, 2. Peningkatan bekalan, 3.

Cara Memenangi Ganjaran Airdrop Kernel pada Strategi Proses Penuh Binance

Apr 21, 2025 pm 01:03 PM

Cara Memenangi Ganjaran Airdrop Kernel pada Strategi Proses Penuh Binance

Apr 21, 2025 pm 01:03 PM

Dalam dunia kriptografi yang ramai, peluang baru selalu muncul. Pada masa ini, aktiviti udara Kerneldao (kernel) menarik banyak perhatian dan menarik perhatian banyak pelabur. Jadi, apakah asalnya projek ini? Apakah faedah yang boleh diperoleh oleh pemegang BNB? Jangan risau, perkara berikut akan mendedahkannya satu demi satu untuk anda.

Aavenomics adalah cadangan untuk mengubah suai token protokol AAVE dan memperkenalkan pembelian semula token, yang telah mencapai bilangan kuorum orang.

Apr 21, 2025 pm 06:24 PM

Aavenomics adalah cadangan untuk mengubah suai token protokol AAVE dan memperkenalkan pembelian semula token, yang telah mencapai bilangan kuorum orang.

Apr 21, 2025 pm 06:24 PM

Aavenomics adalah cadangan untuk mengubah token protokol AAVE dan memperkenalkan repos token, yang telah melaksanakan kuorum untuk Aavedao. Marc Zeller, pengasas Rantaian Projek AAVE (ACI), mengumumkan ini pada X, dengan menyatakan bahawa ia menandakan era baru untuk perjanjian itu. Marc Zeller, pengasas Inisiatif Rantaian AAVE (ACI), mengumumkan pada X bahawa cadangan aavenomik termasuk mengubah token protokol AAVE dan memperkenalkan repos token, telah mencapai kuorum untuk Aavedao. Menurut Zeller, ini menandakan era baru untuk perjanjian itu. Ahli -ahli Aavedao mengundi untuk menyokong cadangan itu, yang 100 seminggu pada hari Rabu