Peranti teknologi

Peranti teknologi

AI

AI

Temu bual eksklusif dengan Profesor Ou Zhijian dari Universiti Tsinghua, memberikan analisis mendalam tentang aura ChatGPT dan cabaran masa depan!

Temu bual eksklusif dengan Profesor Ou Zhijian dari Universiti Tsinghua, memberikan analisis mendalam tentang aura ChatGPT dan cabaran masa depan!

Temu bual eksklusif dengan Profesor Ou Zhijian dari Universiti Tsinghua, memberikan analisis mendalam tentang aura ChatGPT dan cabaran masa depan!

Setelah ChatGPT dilancarkan pada penghujung November 2022, ia menarik perhatian global dan popularitinya masih kukuh! Menggantikan enjin carian, keistimewaan dan titik infleksi, beberapa profesion sedang menghadapi krisis pengangguran, dan umat manusia sedang menghadapi cabaran muktamad... Dalam menghadapi topik hangat seperti itu, artikel ini berkongsi pemahaman kami, dan mengalu-alukan perbincangan dan pembetulan.

Secara amnya, ChatGPT telah mencapai kemajuan teknologi yang ketara, dan walaupun kekurangannya, ia bergerak ke arah AGI (kecerdasan am buatan, Umum Kecerdasan Buatan) masih penuh dengan cabaran!

Rajah 1: https://openai.com/blog/chatgpt/ Tangkapan skrin halaman web

Pertama sekali, mari perkenalkan Eliza Effect dalam penyelidikan AI, yang juga berkaitan dengan chatbots.

Kesan Eliza bermakna orang akan terlebih mentafsir hasil mesin dan membaca makna yang mereka tidak miliki pada asalnya. Manusia mempunyai kecenderungan psikologi untuk secara tidak sedar percaya bahawa fenomena alam adalah serupa dengan tingkah laku manusia, yang dipanggil antropomorfisasi manusia (anthropomorphization) dalam psikologi, terutamanya apabila manusia kurang pemahaman yang mencukupi tentang fenomena baru. Sebagai contoh, pada zaman dahulu, orang percaya bahawa guruh disebabkan oleh dewa guruh yang tinggal di langit Apabila dewa guruh marah, dia berdentum.

Nama "Eliza" diambil daripada chatbot yang dibangunkan oleh saintis komputer MIT Joseph Weizenbaum pada tahun 1966. Chatbot Eliza telah direka sebagai kaunselor psikologi Projek Eliza yang bijak mencapai kejayaan yang tidak dijangkakan pada masa itu dan menimbulkan sensasi Namun, ia sebenarnya hanya aplikasi yang bijak berdasarkan tatabahasa yang mudah.

Pemahaman tertentu tentang prinsip ChatGPT seharusnya dapat mengurangkan kesan Eliza apabila memahami ChatGPT. Hanya dengan pertimbangan yang betul kita boleh menjadi sihat dan meluas. Untuk tujuan ini, kami berusaha untuk berhati-hati dan memberikan rujukan kepada pembaca untuk lebih memahami. Perkara berikut akan dibahagikan kepada tiga bahagian:

- Kemajuan ChatGPT

- Kekurangan ChatGPT

- Cabaran ke arah AGI

Laman utama peribadi: http://oa.ee.tsinghua.edu .cn /ouzhijian

Pengarang: Ou Zhijian, profesor madya dan penyelia kedoktoran di Jabatan Kejuruteraan Elektronik, Universiti Tsinghua. Berkhidmat sebagai editor bersekutu IEEE Audio Speech Language Journal (TASLP), ahli lembaga editorial Computer Speech & Language, ahli IEEE Speech Language Technical Committee (SLTC), pengerusi Persidangan IEEE Speech Technology (SLT) 2021, ahli terkemuka China Computer Persekutuan (CCF) dan Dialog Ucapan dan Pendengaran Ahli jawatankuasa khas, dsb. Beliau telah menerbitkan hampir 100 kertas kerja dan memenangi 3 anugerah wilayah dan menteri serta banyak anugerah kertas cemerlang dalam dan luar negara. Menjalankan penyelidikan asal asas tentang model bahasa medan rawak, algoritma pembelajaran untuk model pembolehubah pendam diskret, model dialog hujung ke hujung dan pembelajaran separa penyeliaan mereka.

01 Kemajuan ChatGPT

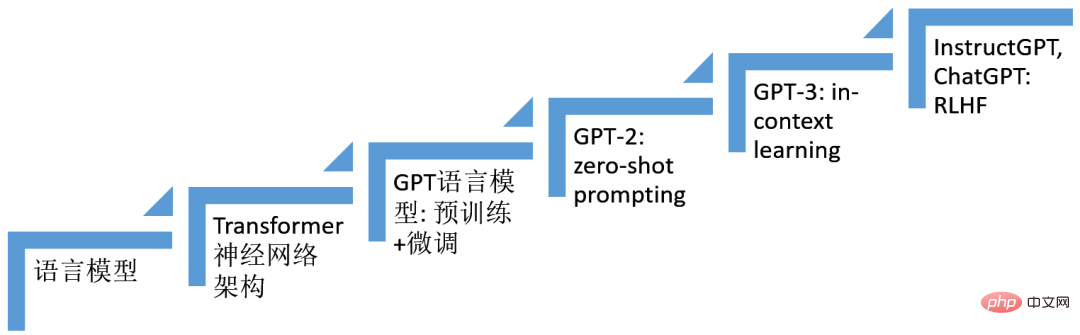

Kemajuan ChatGPT berdiri di atas bahu gergasi dalam penyelidikan kecerdasan buatan selama bertahun-tahun, terutamanya teknologi pembelajaran mendalam, iaitu, penggunaan teknologi rangkaian Neural berbilang lapisan. Kami telah menyusun beberapa teknologi yang memainkan peranan penting dalam pembinaan sistem ChatGPT, seperti yang ditunjukkan dalam rajah di bawah. Ia adalah kesan gabungan teknologi ini (enam langkah) yang melahirkan ChatGPT.

Rangka model ChatGPT ialah model bahasa autoregresif (model bahasa) berdasarkan seni bina rangkaian neural Transformer. Teknologi berdasarkan penalaan halus (penalaan halus), teknologi berasaskan Prompt (prompt), pembelajaran situasi (pembelajaran dalam konteks), pembelajaran pengukuhan daripada maklum balas manusia ( RLHF) teknologi berkembang secara beransur-ansur dan akhirnya membawa kepada kelahiran ChatGPT.

Rajah 2: Kemajuan ChatGPT

1. Model bahasa (LM, model bahasa)

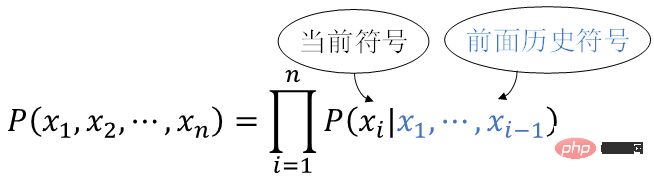

Model bahasa ialah model kebarangkalian bahasa semula jadi manusia. Bahasa semula jadi manusia ialah ayat, dan ayat ialah urutan simbol bahasa semula jadi x1, x2,…, xn , mematuhi taburan kebarangkalian

Menggunakan formula pendaraban teori kebarangkalian, kita boleh mendapatkan

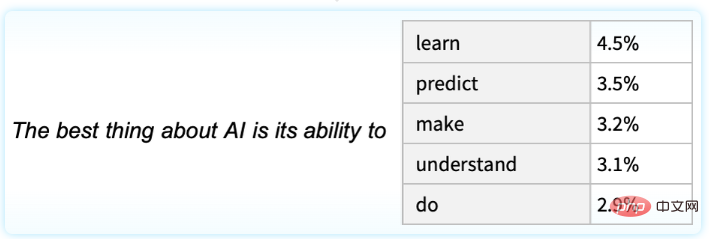

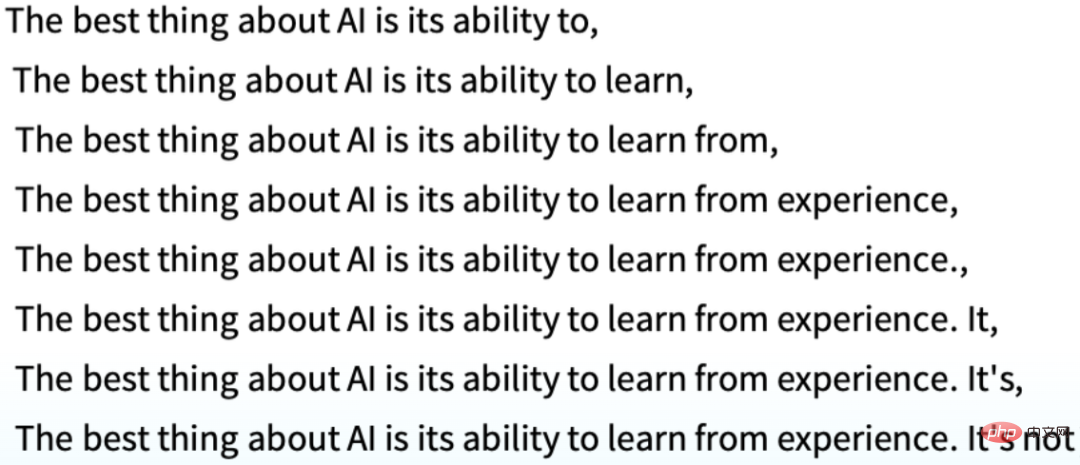

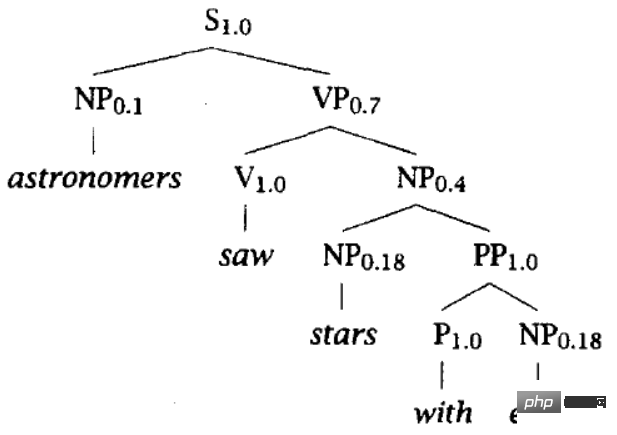

Letakkan ini dari kiri ke kanan, dan gunakan simbol sejarah sebelumnya untuk setiap kedudukanx1,x2,…,x i-1 (iaitu di atas), hitung kebarangkalian (bersyarat) bagi simbol semasa yang muncul P(xi | x1,…,xi-1) dipanggil model bahasa autoregresif, yang secara semula jadi digunakan untuk menjana arus simbol di bawah syarat di atas. Sebagai contoh, rajah di bawah menggambarkan kebarangkalian kejadian simbol seterusnya diberikan teks di atas "Perkara terbaik tentang AI ialah keupayaannya untuk".

boleh dijana secara rekursif,

Kunci kepada masalah model bahasa ialah jenis keluarga fungsi yang hendak dibina untuk mewakili taburan bersyarat P(xi | x1,…,xi -1 ), dan boleh mempelajari parameter model secara berkesan daripada data besar. Kemajuan teknologi berdasarkan ChatGPT ialah penggunaan rangkaian saraf untuk mewakili P(xi | x1,…,xi-1) .

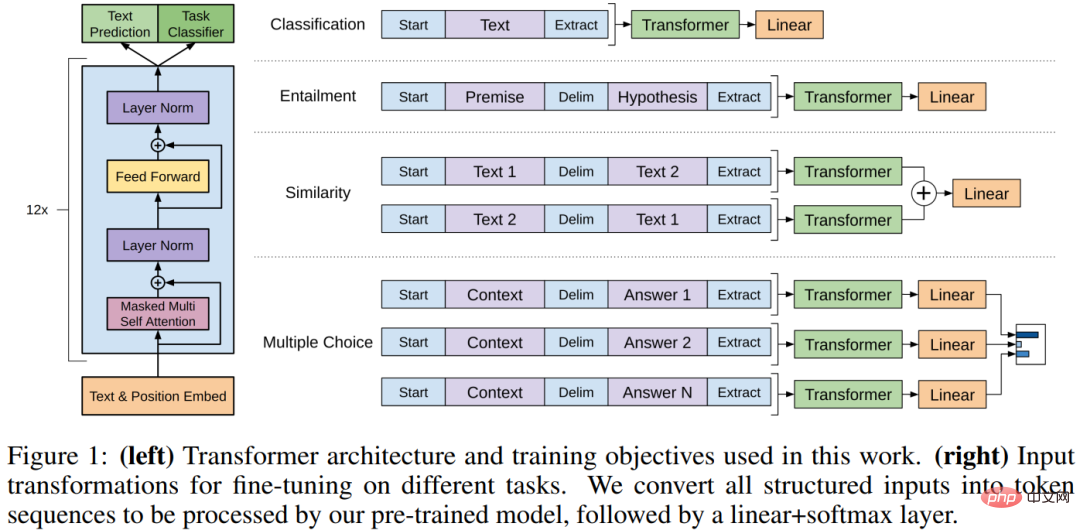

2. Seni bina rangkaian neural Transformer

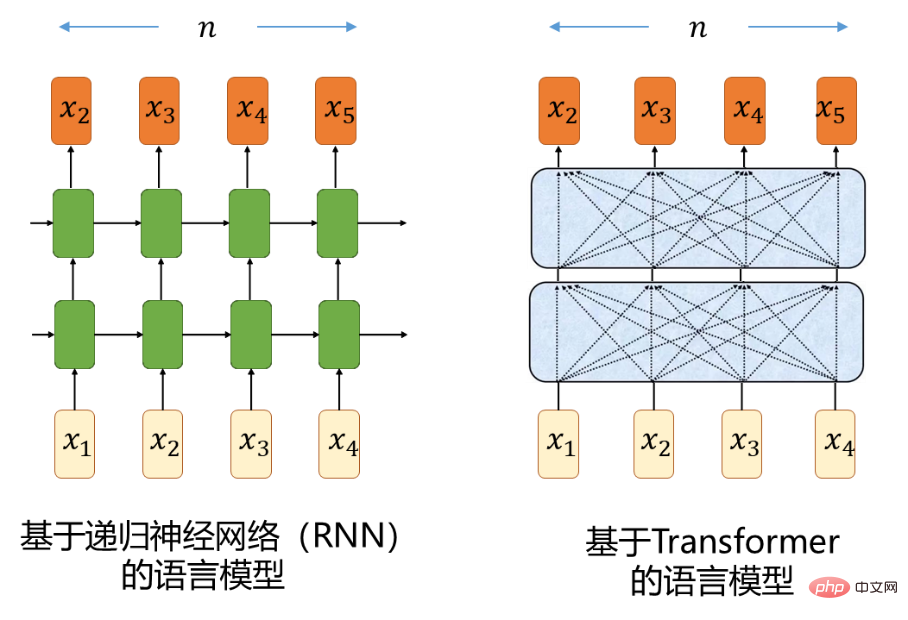

Untuk pengedaran bersyarat urutan P. (xi | -pemodelan kebergantungan -julat). Model jujukan yang menggunakan rangkaian saraf berulang biasa (RNN) akan menghadapi kesan kecerunan yang meletup dan lenyap [1] semasa latihan, jadi ia sangat panjang pada masa ini, orang menggunakan RNN berdasarkan ingatan jangka pendek yang panjang rangkaian (memori jangka pendek panjang, LSTM) [2] untuk melaksanakan pemodelan jujukan. LSTM mengurangkan kecacatan letupan dan kehilangan kecerunan pada tahap tertentu dengan memperkenalkan mekanisme gating. Seni bina rangkaian neural Transformer [3] yang dibangunkan pada tahun 2017 telah meninggalkan pengiraan rekursif sepenuhnya dan menggunakan mekanisme perhatian kendiri untuk menggunakan rangkaian neural suapan ke hadapan (FFNN) untuk pembinaan jujukan, yang lebih baik menyelesaikan kecacatan letupan dan kehilangan kecerunan. Mari kita memahami secara intuitif kelebihan Transformer berbanding RNN dalam pemodelan jujukan. Pertimbangkan dua kedudukan dalam urutan yang dipisahkan oleh n Isyarat antara dua kedudukan dalam pengiraan ke hadapan dan ke belakang dan panjang laluan dalam rangkaian saraf adalah faktor yang mempengaruhi rangkaian saraf. . Faktor penting dalam keupayaan untuk mempelajari kebergantungan jarak jauh, RNN ialah O(n)

, manakala Transformer ialahO(1). Pembaca yang tidak memahami bahagian ini boleh melangkaunya tanpa menjejaskan pembacaan kandungan berikut:-)Rajah 3

3. Model bahasa GPT dan teknologi pra-latihan + penalaan halus

Pemahaman bahasa semula jadi merangkumi pelbagai tugas yang berbeza, seperti menjawab soalan, penilaian persamaan semantik, pertimbangan perhubungan implikasi teks, klasifikasi dokumen, terjemahan mesin, pemahaman bacaan, ringkasan, dsb. Didapati bahawa seseorang boleh mula-mula melatih Transformer-LM yang besar (sering dipanggil rangka) pada sejumlah besar teks (tidak berlabel), dan kemudian memperhalusi rangkaian Transformer besar ini menggunakan data anotasi masing-masing bagi tugas hiliran apabila berhadapan dengan tugas hiliran yang berbeza , telah mencapai peningkatan prestasi yang hebat Ini adalah apa yang dipanggil teknologi pra-latihan + penalaan halus (teknologi pra-latihan + penalaan halus termasuk GPT [4] dan BERT [5] dibangunkan pada 2018-2019 ]. GPT ialah model bahasa autoregresif berdasarkan Transformer, dan BERT ialah model bahasa bertopeng (MLM) berdasarkan Transformer.

Seperti yang dinyatakan dalam teks asal GPT, "Kerja kami secara amnya termasuk dalam kategori pembelajaran separa penyeliaan untuk bahasa semula jadi tanpa pengawasan ini digabungkan dengan penalaan halus yang diselia , ialah sejenis pembelajaran separa penyeliaan , dan intipatinya adalah untuk melaksanakan pembelajaran diselia dan pembelajaran tanpa penyeliaan secara kolaboratif.

(daripada teks GPT asal [4] "Meningkatkan pemahaman bahasa melalui pra-latihan generatif")

4. GPT-2 dan teknologi segera sampel sifar

Di bawah rangka kerja teknologi pra-latihan + penalaan halus , ia masih perlu untuk Untuk setiap tugasan, sejumlah besar data anotasi dikumpul dan dilabelkan, dan kemudian diperhalusi untuk mendapatkan "pakar sempit" pada tugas masing-masing Setiap model sempit perlu dibina dan disimpan secara berasingan, yang memakan masa, susah payah dan intensif sumber. Alangkah baiknya jika kami boleh membina sistem yang lebih umum yang boleh mengendalikan banyak tugas dan menghapuskan keperluan untuk mengumpul dan melabel set data secara manual untuk setiap tugas. Dalam teks asal GPT-2 2019 [6], dengan pernyataan visi yang begitu jelas, adakah anda sudah melihat rasa bergerak ke arah AGI :-)

"Kami mahu untuk bergerak ke arah sistem yang lebih umum yang boleh melaksanakan banyak tugas – akhirnya tanpa perlu mencipta dan melabel set data latihan secara manual untuk setiap satu.》

Biarkan mesin belajar melaksanakan bahasa semula jadi memahami tugasan ( Seperti Soal Jawab ), intipatinya adalah untuk menganggarkan pengagihan bersyarat

Memandangkan sistem umum boleh melaksanakan banyak tugas yang berbeza, pemodelannya harus menjadi lebih Bersyarat pada tugas tugas, iaitu pemodelan

Pendekatan inovatif yang diwakili oleh GPT-2 ialah, Tugas, input, output semuanya dinyatakan sebagai jujukan simbol dalam bahasa semula jadi, supaya model P(output | tugas, input) bermuara kepada model bahasa - diberikan Di atas, simbol seterusnya dijana secara rekursif. Data latihan tugasan yang berbeza disusun secara seragam ke dalam bentuk urutan simbol seperti

. Contohnya,

(terjemah ke bahasa perancis, teks bahasa inggeris, teks bahasa perancis)

(jawab soalan, dokumen, soalan, jawapan)

Antaranya, tugas sering dipanggil prompt. Terdapat banyak kaedah menggesa, dan terdapat banyak kajian berkaitan Artikel ini tidak akan memperkenalkannya.

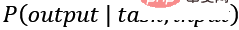

Terdapat kajian tentang idea yang serupa sebelum GPT-2 GPT-2 membawa skala (tanpa mengira saiz set latihan atau model) ke tahap baharu, mengumpul berjuta-juta. laman web untuk mencipta Dengan set data yang besar WebText (40GB), Transformer-LM dengan saiz parameter maksimum 1.5B telah dilatih, menunjukkan prestasi cemerlang pada pelbagai tugas di bawah keadaan sampel sifar tanpa sebarang parameter atau pengubahsuaian seni bina model (tanpa sebarang parameter atau seni bina pengubahsuaian). Perlu diingatkan bahawa pendekatan GPT-2 merangkumi sepenuhnya pembelajaran pelbagai tugas dan pembelajaran meta, yang boleh digunakan sebagai penjelasan intuitif untuk prestasi cemerlang GPT-2.

(dari GPT-2 teks asal [6] "Model bahasa ialah pelajar berbilang tugas tanpa pengawasan". GPT-2 melatih satu siri Transformers -LM, saiz parameter masing-masing ialah 117M, 345M, 762M, dan 1542M Rajah di atas menunjukkan peningkatan berterusan prestasi setiap tugas apabila saiz parameter model meningkat)

. 5. GPT-3 dan pembelajaran dalam konteks

Kerja GPT-3 pada tahun 2020 [7] meneruskan visi dan laluan teknikal GPT -2 , berharap dapat menerobos kelemahan anotasi khusus tugasan dan penalaan halus dalam setiap tugasan (masih terdapat keperluan untuk set data khusus tugasan dan penalaan halus khusus tugas), dengan harapan dapat membina sistem universal seperti manusia , artikel itu dengan jelas menunjukkan bahawa Salah satu motivasi untuk penyelidikan adalah untuk mengambil perhatian:

manusia tidak memerlukan set data diselia yang besar untuk mempelajari kebanyakan tugas bahasa – arahan ringkas dalam bahasa semula jadi ( cth. 『sila beritahu saya jika ayat ini menggambarkan sesuatu yang menggembirakan atau sesuatu yang menyedihkan』) atau paling banyak sebilangan kecil demonstrasi (cth. 『di sini terdapat dua contoh orang yang bertindak berani; sila berikan contoh ketiga keberanian』) selalunya mencukupi untuk membolehkan manusia untuk melaksanakan tugas baharu sekurang-kurangnya pada tahap kecekapan yang munasabah."

Maksudnya, diberi penerangan tugas (arahan) dan sampel demonstrasi (demonstrasi), mesin sepatutnya boleh melakukan pelbagai tugas seperti manusia.

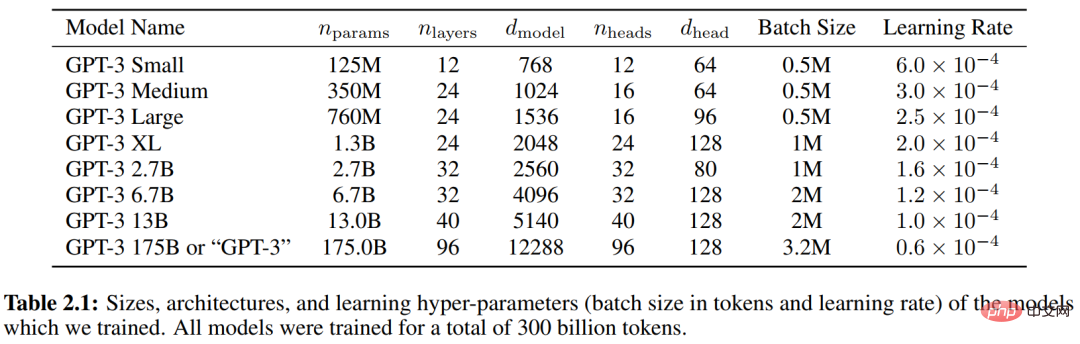

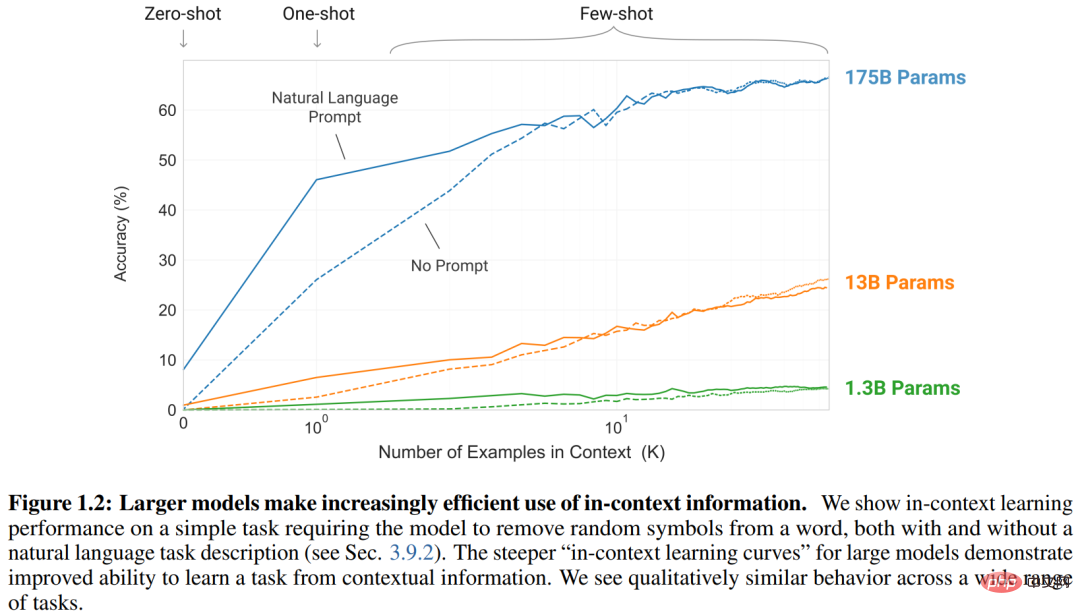

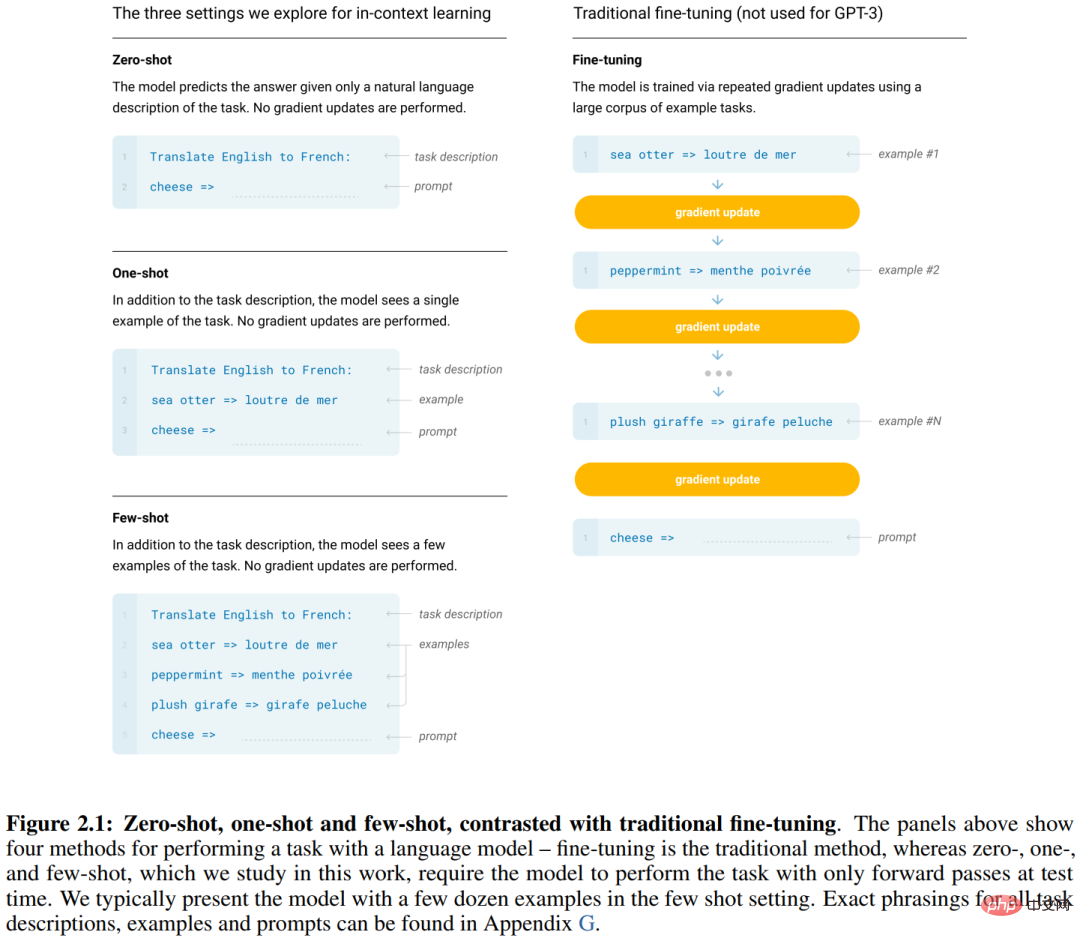

GPT-3 sekali lagi ditingkatkan ke tahap baharu, dengan saiz set latihan teks 45TB (sebelum dibersihkan) dan 570GB (selepas pembersihan) , skala Transformer-LM telah meningkat 10 kali ganda berbanding GPT-2, mencapai 175B (lihat Jadual 2.1 di bawah). Artikel GPT-2 kebanyakannya menjalankan eksperimen pada situasi segera pukulan sifar, manakala GPT-3 menjalankan eksperimen pada situasi pukulan sifar, pukulan tunggal dan pukulan beberapa, secara kolektif dipanggil Pembelajaran Konteks (Pembelajaran Senario), sampel demonstrasi (. demonstrasi) yang diberikan boleh menjadi 0, 1 atau lebih, tetapi semuanya akan mempunyai penerangan tugas (huraian tugas), lihat ilustrasi dalam Rajah 2.1. Seperti yang dapat dilihat daripada Rajah 1.2, apabila bilangan sampel demonstrasi meningkat, prestasi model saiz berbeza meningkat.

(di atas semuanya dari yang asal Teks GPT-3 [7]「Model Bahasa adalah Sedikit Pelajar」)

6 Teknologi InstructGPT, ChatGPT dan RLHF

Amalan model bahasa besar (LLM) semasa untuk pemahaman bahasa semula jadi adalah berdasarkan P(output | task,input), memandangkan task,input , menjana simbol seterusnya secara rekursif. Satu titik permulaan untuk penyelidikan InstructGPT ialah pertimbangan bahawa dalam dialog manusia-mesin, model bahasa yang semakin meningkat tidak semestinya menjadikannya lebih baik mengikut niat pengguna. Model bahasa yang besar juga boleh mempamerkan tingkah laku yang tidak memuaskan, seperti mengada-adakan fakta, menghasilkan teks yang berat sebelah dan berbahaya, atau sekadar tidak membantu pengguna.

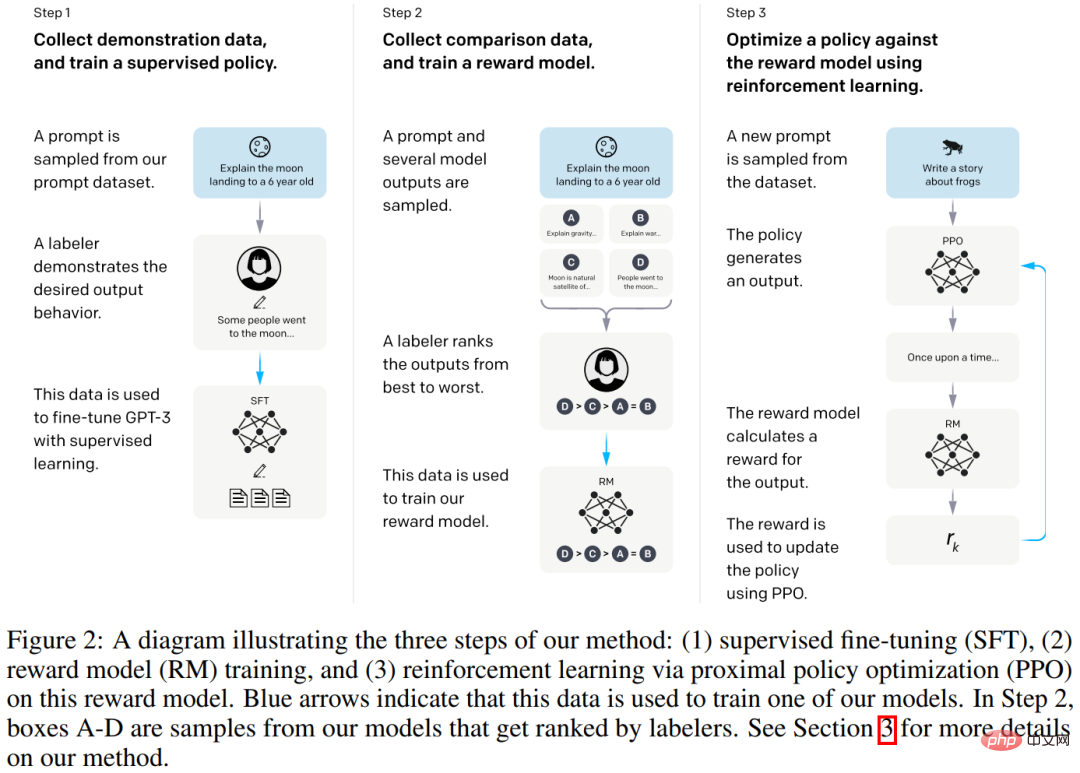

Ini kerana matlamat pemodelan bahasa yang digunakan oleh kebanyakan LM berskala besar baru-baru ini adalah untuk meramalkan token seterusnya pada halaman web daripada Internet, yang berbeza daripada "mengikuti pengguna secara membantu dan selamat" "Arahan" sasaran. Oleh itu, kami mengatakan bahawa matlamat pemodelan bahasa adalah tidak sejajar . Mengelakkan tingkah laku yang tidak dijangka ini amat penting apabila menggunakan dan menggunakan model bahasa dalam beratus-ratus aplikasi. Pada bulan Mac 2022, kerja InstructGPT [8] menunjukkan cara untuk menyelaraskan model bahasa dengan niat pengguna pada pelbagai tugas dengan menala halus berdasarkan maklum balas manusia, model yang terhasil dipanggil InstructGPT. Secara khusus, seperti yang ditunjukkan dalam Rajah 2 di bawah, proses pembinaan InstructGPT terdiri daripada tiga langkah:

Langkah 1: Kumpul data demonstrasi (13K keping data) dan gunakan pembelajaran terseliauntuk memperhalusi GPT-3 (saiz 175B), dilatih untuk mendapatkan polisi yang diselia.

Langkah 2: Kumpul data perbandingan (33K keping data) dan latih model ganjaran (Model Ganjaran), dengan saiz 6B.

Langkah 3: Kumpul data latihan 31K dan gunakan pembelajaran pengukuhan untuk mengoptimumkan strategi bagi model ganjaran, dipanggil pembelajaran pengukuhan daripada maklum balas manusia maklum balas manusia, RLHF). Secara khusus, kaedah pengoptimuman dasar yang dipanggil PPO digunakan [9].Untuk pengumpulan data demonstrasi dan data perbandingan, 40 anotasi penyumberan luar telah digunakan.

(dari teks asal IntructGPT [8] "Melatih model bahasa untuk mengikut arahan dengan maklum balas manusia")

(dari teks asal IntructGPT [8] "Melatih model bahasa untuk mengikut arahan dengan maklum balas manusia")

Pada November 2022, model ChatGPT [10] yang dikeluarkan oleh OpenAI pada dasarnya adalah pengganti kepada model InstructGPT Ia menggunakan kaedah latihan tiga langkah yang sama, tetapi mengumpul data berskala lebih besar untuk latihan model . dan pembinaan sistem.

Ringkasan:

Daripada penyelidikan model bahasa, seni bina rangkaian saraf Transformer, model bahasa GPT dan pra-latihan + penalaan halus, GPT-2 dan pembayang sifar menggesa), GPT-3 dan pembelajaran dalam konteks, dan dibangunkan menjadi teknologi InstructGPT, ChatGPT dan RLHF Melihat ke belakang, ia nampaknya merupakan laluan teknikal yang agak jelas, tetapi sebenarnya, model bahasa lain (seperti berasaskan tenaga. model bahasa [11]), jenis seni bina rangkaian neural lain (seperti model ruang keadaan [12]), jenis kaedah pra-latihan lain (seperti berdasarkan model pembolehubah terpendam [13]), kaedah pembelajaran pengukuhan lain (seperti sebagai simulator berasaskan pengguna [14]), dsb., sentiasa berkembang, dan penyelidikan mengenai kaedah baharu tidak pernah berhenti. . Perkara yang sangat penting dalam enam bahagian ChatGPT ialahKesan Skala, yang biasanya dikenali sebagai estetika keganasan. Apabila laluan pada asasnya betul, meningkatkan skala adalah cara yang baik untuk meningkatkan prestasi. Perubahan kuantitatif membawa kepada perubahan kualitatif, tetapi perubahan kuantitatif mungkin tidak membawa kepada perubahan kualitatif, jika terdapat kekurangan dalam laluan. Mari kita bercakap tentang kekurangan ChatGPT.

02 Kekurangan ChatGPT

Amalan yang sangat baik dalam persidangan teratas dalam bidang kecerdasan buatan (seperti ICML, ACL) dalam beberapa tahun kebelakangan ini adalah untuk menambah item untuk penyerahan Sebagai keperluan, anda mesti meninggalkan bahagian dalam artikel anda untuk menerangkanKeterbatasan

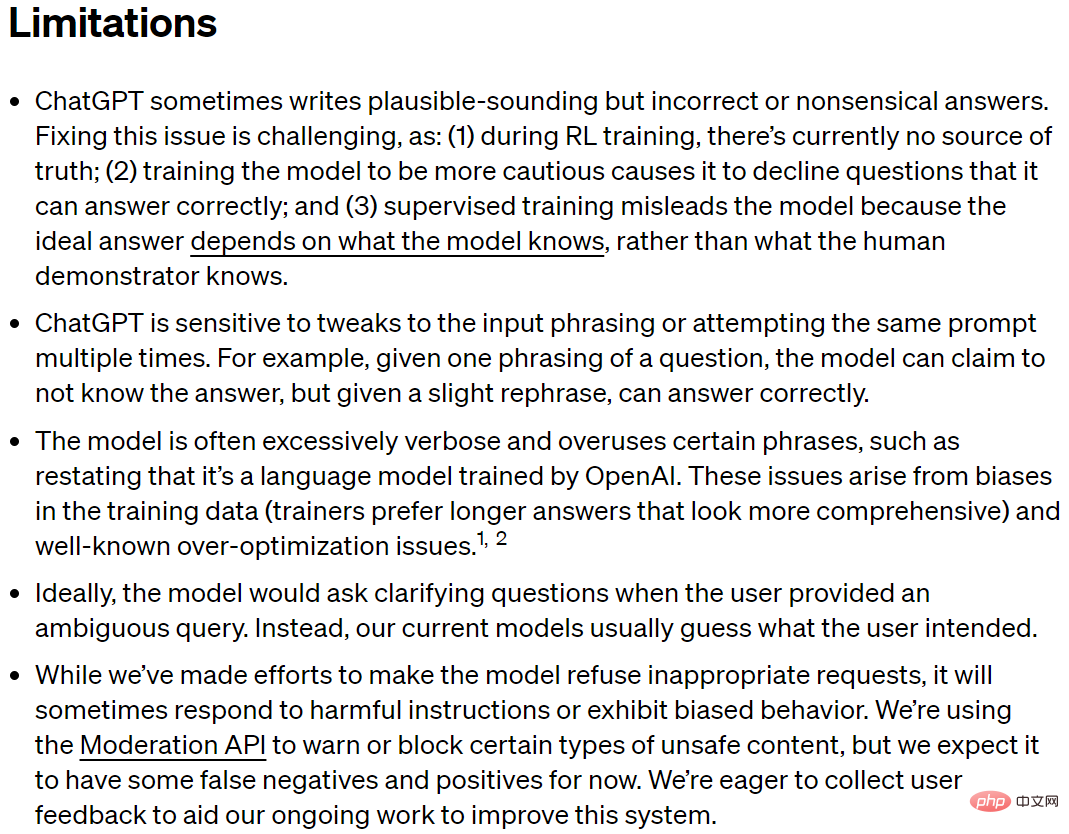

kerja anda. Sebaliknya, mengelakkan bercakap tentang kekurangan adalah tidak ketat dan tidak kondusif untuk pemahaman yang menyeluruh tentang teknologi Ia mungkin mengelirukan orang ramai, menggalakkan kesan Eliza dan juga membuat pertimbangan yang salah.Malah, teks asal ChatGPT [10] telah membuat kenyataan yang agak menyeluruh tentang kelemahannya.

Kekurangan ChatGPT (tangkapan skrin daripada teks asal ChatGPT [10])

Kekurangan ChatGPT (tangkapan skrin daripada teks asal ChatGPT [10])

Pembaca boleh terus membaca perkara di atas dalam bahasa Inggeris, dan penerangan ringkas dalam bahasa Cina di bawah. Pembaca boleh memahaminya dengan contoh berikut. Analisis lanjut kami tentang kelemahan ChatGPT akan dibincangkan dalam bab seterusnya apabila kami meneroka cabaran yang dihadapi oleh AGI (Kecerdasan Am Buatan).

L1 ChatGPT kadangkala menulis jawapan yang kelihatan munasabah tetapi salah atau tidak masuk akal

.L2 ChatGPT sensitif kepada pelarasan pada memasukkan perkataan atau mencuba gesaan yang sama

beberapa kali.L3. Penjanaan ChatGPT, selalunya terlalu bertele-tele dan terlalu menggunakan frasa tertentu , seperti mengulangi bahawa ia adalah model bahasa terlatih OpenAI. L4 Sebaik-baiknya, apabila pengguna memberikan pertanyaan yang samar-samar, model harus mengemukakan soalan yang menjelaskan. Sebaliknya, model semasa sering meneka niat pengguna. L5 Walaupun ChatGPT telah berusaha keras untuk meminta model itu menolak permintaan yang tidak sesuai, ia mungkin kadangkala membalas arahan yang berbahaya atau mempamerkan tingkah laku berat sebelah. Rajah 4: Contoh ChatGPT tentang telur dan telur lembu

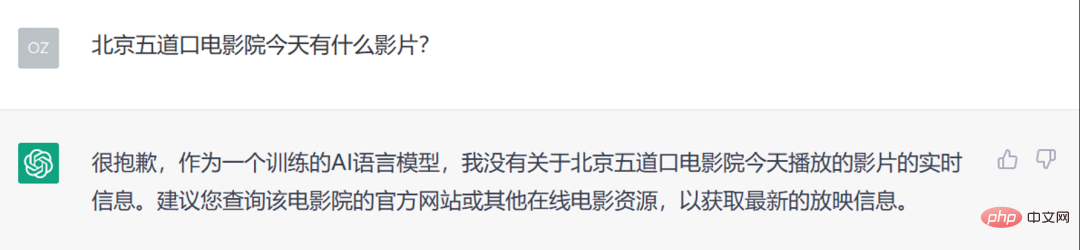

Rajah 5: Contoh pemprosesan maklumat masa nyata yang tidak mencukupi dalam ChatGPT

03 Cabaran ke arah AGIBerdasarkan kekurangan yang diterangkan dalam teks asal ChatGPT [10], kami meringkaskan kekurangan ChatGPT kepada lima perkara berikut. Lima perkara ini pada asasnya juga mewakili cabaran yang dihadapi oleh ChatGPT pada masa hadapan ke arah kecerdasan buatan am (AGI) Ia adalah isu saintifik penting dan teknologi utama yang perlu diselesaikan segera ke arah AGI. Perlu diingatkan bahawa perspektif artikel ini bukanlah untuk menganalisis kekurangan dan cabaran dari perspektif tugas, tetapi lebih daripada perspektif isu biasa pelbagai tugas. Jika tugasan adalah baris dan masalah adalah lajur, maka perspektif kami adalah untuk menganalisis mengikut lajur. Baris demi baris juga boleh memberikan analisis dan pertimbangan yang sangat baik.

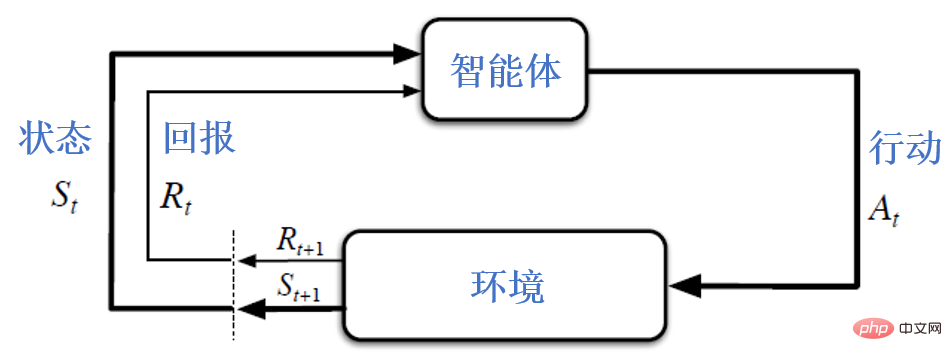

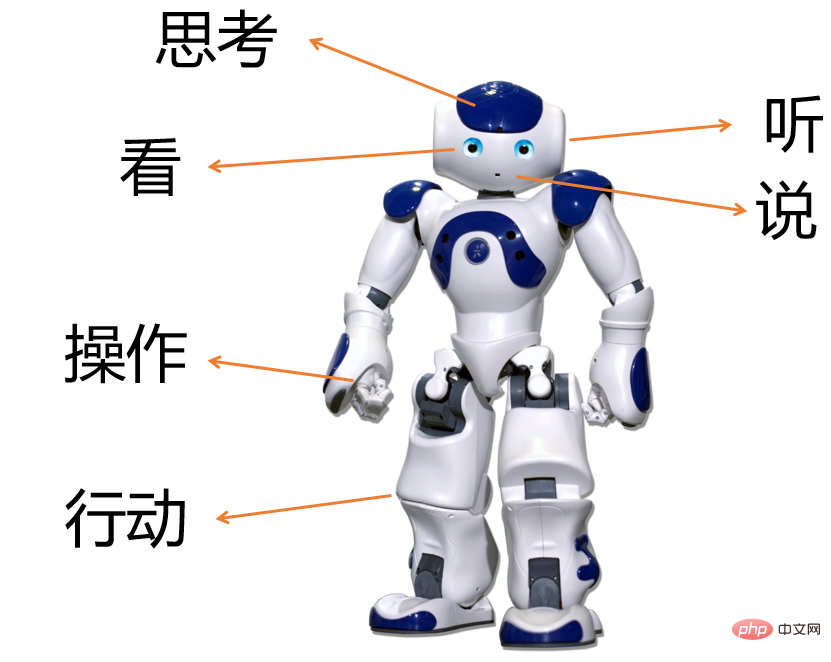

Apabila membincangkan AGI, kita perlu keluar daripada batasan hanya memfokuskan pada pemprosesan bahasa semula jadi dan meneliti penyelidikan dan teknologi kecerdasan buatan daripada perspektif yang lebih luas. Merujuk kepada karya klasik mengenai kecerdasan buatan [15], kecerdasan buatan merujuk kepada penyelidikan dan reka bentuk agen pintar Agen pintar (agen pintar) merujuk kepada mana-mana peranti yang boleh memerhati persekitaran sekeliling<.> dan buat Bertindak untuk memaksimumkan peluang kejayaan, atau lebih akademik, untuk memaksimumkan utiliti yang dijangkakan (utiliti) atau memaksimumkan pulangan yang dijangkakan (pulangan), seperti yang ditunjukkan dalam rajah di bawah. Pembaca yang teliti akan mendapati bahawa rajah berikut juga biasa digunakan sebagai rajah rangka kerja untuk pembelajaran pengukuhan. Malah, terdapat kenyataan yang sama dalam [15], "Pembelajaran pengukuhan mungkin dianggap merangkumi semua AI" (pembelajaran pengukuhan mungkin dianggap merangkumi semua kecerdasan buatan). Dengan mengambil kira konsep ini, mari kita fahami kelemahan ChatGPT.

Rajah 6: Interaksi antara ejen dan persekitaran, sering digunakan sebagai gambar rajah rangka kerja untuk pembelajaran pengukuhan [16]

1. ChatGPT akan mengada-adakan secara rawak (memberi maklumat yang salah secara serius), dan mempunyai kekurangan yang jelas dalam pemodelan dan penggunaan pengetahuan.

Ini pada asasnya sepadan dengan L1 yang diperkenalkan sebelum ini, yang boleh dilihat dengan jelas daripada contoh sebelumnya. Apa yang kami panggilpengetahuan termasuk pengetahuan akal, pengetahuan khusus dan maklumat masa nyata. Sebagai contoh, dari perspektif akal, ChatGPT pada mulanya menunjukkan bahawa ia tidak tahu bahawa lembu adalah mamalia dan tidak boleh bertelur. Berdasarkan maklumat masa nyata, ChatGPT pada asasnya ialah model bahasa autoregresif berskala besar berdasarkan seni bina Transformer Pengetahuan yang telah dipelajari adalah terhad kepada data latihannya, dan tarikh akhirnya ialah 2021. Pembaca boleh mencuba ChatGPT sendiri dan menemui kekurangannya dalam hal ini.

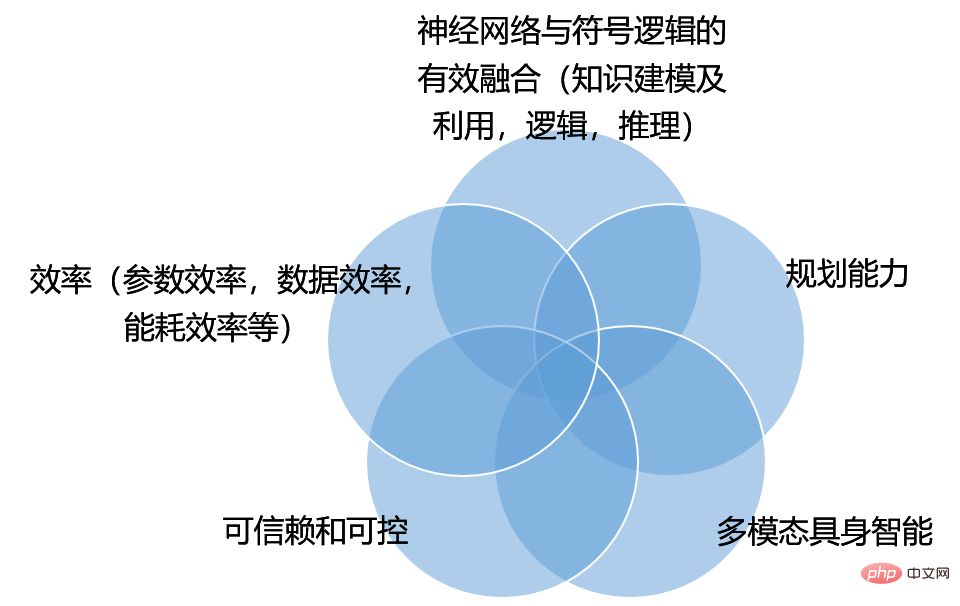

Kekurangan di atas, dari peringkat yang lebih mendalam, mencerminkanconnectionism (connectionist) dan symbolism (simbolisme) Pertikaian antara dua aliran pemikiran. Rajah 7 Connectionism percaya bahawa Pengetahuan terkubur dalam pemberat rangkaian saraf Melatih rangkaian saraf untuk melaraskan pemberatnya membolehkannya mempelajari pengetahuan. Simbolisme menyokong bahawa pengetahuan disusun oleh sistem simbolik, seperti pangkalan data hubungan, graf pengetahuan, fizik matematik dan pengetahuan khusus lain, dan logik matematik. Kedua-dua aliran pemikiran juga bercantum silang, seperti Oleh itu, untuk mengatasi kelemahan ChatGPT dalam pemodelan dan penggunaan pengetahuan, cabaran mendalam kepada teknologi sedia ada ialah gabungan rangkaian neural dan logik simbolik Gabungan berkesan. Data dan pengetahuan adalah pacuan dua roda Terdapat banyak kerja penyelidikan selama bertahun-tahun, tetapi secara umum, mencari kaedah penyepaduan yang berkesan masih memerlukan usaha berterusan. 2. ChatGPT mempunyai kelemahan yang jelas dalam interaksi dialog pelbagai pusingan dan tidak mempunyai keupayaan merancang. Ini pada asasnya sepadan dengan L4 di atas hanya menunjukkan bahawa ChatGPT tidak akan bertanya soalan penjelasan. Tetapi kami melihat kelemahan yang lebih serius daripada L4 Daripada proses pembinaan ChatGPT, ia memodelkan pengedaran bersyarat P(output | input) untuk ramalan dan tidak melakukan perancangan. Dalam rangka kerja yang ditunjukkan dalam Rajah 6, satu konsep yang sangat penting ialah perancangan Tujuan perancangan adalah untuk memaksimumkan utiliti yang dijangkakan. Ini berbeza dengan ketara daripada model bahasa besar yang memaksimumkan kemungkinan bersyarat berlakunya simbol bahasa P(output | input). InstructGPT menganggap bahawa sistem harus mengikut niat pengguna, dan menggunakan teknologi RLHF (pembelajaran pengukuhan daripada maklum balas manusia) untuk membolehkan output sistem diselaraskan kepada soalan manusia, yang sebahagiannya mengurangkan keperluan untuk pembelajaran GPT yang diselia- 3 tanpa perancangan Dan menyebabkan masalah salah jajaran. Mempertingkatkan lagi keupayaan perancangan untuk memaksimumkan utiliti yang dijangkakan akan menjadi cabaran besar untuk ChatGPT ke arah AGI. Jadi apakah kegunaan sistem interaksi manusia-komputer? Mengenai perkara ini, kertas InstructGPT [8] membincangkan perkara ini dari tiga dimensi: membantu, jujur (jujur) dan tidak berbahaya (tidak berbahaya) . “Kami mahu model bahasa membantu (mereka harus membantu pengguna menyelesaikan tugas mereka), jujur (mereka tidak seharusnya memalsukan maklumat atau mengelirukan pengguna), dan tidak berbahaya (mereka tidak sepatutnya menyebabkan bahaya fizikal, psikologi atau sosial kepada orang atau alam sekitar ) ). "Bagaimanapun, kaedah pelaksanaan khusus perlu diterokai dengan lebih lanjut, dan bukannya berhenti pada teknologi RLHF. 3. Tingkah laku ChatGPT tidak boleh dikawal. Ini pada asasnya sepadan dengan L2, L3 dan L5 di atas. Output sistem adalah sensitif kepada input (L2), tidak ada cara untuk mengawalnya kerana terlalu bertele-tele atau terlalu menggunakan frasa tertentu (L3), dan tiada cara untuk mengawalnya kerana bertindak balas kepada arahan berbahaya atau menunjukkan tingkah laku berat sebelah (L5). ). Kelemahan ini bukan sahaja muncul dalam ChatGPT, tetapi juga dalam penglihatan komputer, pengecaman pertuturan dan sistem pintar lain yang dibina dengan teknologi pembelajaran mendalam semasa, terdapat juga masalah tidak terkawal yang serupa. Manusia mempunyai kebijaksanaan Socratic, iaitu, "anda tahu anda tidak tahu ini sebenarnya kekurangan sistem rangkaian saraf dalam, kerana anda tidak mengenali anda." adalah salah. Kebanyakan sistem rangkaian saraf hari ini terlalu yakin dan tidak melaporkan ralat kepada manusia. Mereka masih kelihatan sangat tinggi apabila mereka melakukan kesilapan, menjadikannya sukar untuk dipercayai dan dikawal. Boleh dipercayai dan boleh dikawal akan menjadi cabaran besar ke arah AGI. 4. Kecekapan ChatGPT tidak mencukupi. Ini tidak dipandang serius dalam pernyataan kekurangan ChatGPT. Kecekapan termasuk kecekapan parameter, kecekapan data, kecekapan penggunaan tenaga, dsb.. ChatGPT telah mencapai prestasi cemerlang dengan menggunakan data yang sangat besar, melatih model yang sangat besar, dan terus meningkatkan skalanya. Walau bagaimanapun, pada skala yang sama (bilangan parameter model yang sama, jumlah atau kos pelabelan data yang sama, kuasa pengkomputeran yang sama, penggunaan tenaga yang sama), adakah ChatGPT mewakili teknologi yang paling canggih? Jawapannya selalunya tidak. Sebagai contoh, penyelidikan terkini melaporkan [19] bahawa model LLaMA dengan parameter 13B mengatasi model 175B GPT-3 dalam berbilang ujian penanda aras, jadi model 13B LLaMA mempunyai kecekapan parameter yang lebih baik. Kerja terbaru kami sendiri juga telah menunjukkan bahawa model dialog perolehan pengetahuan yang direka dengan baik hanya menggunakan 100M, dan prestasinya jauh melebihi model besar 1B. Kecekapan penggunaan tenaga mudah difahami, mari kita lihat kecekapan data. Pembinaan sistem pintar semasa terperangkap dalam paradigma pembelajaran yang diselia bergantung pada sejumlah besar anotasi manual, mengakibatkan kecekapan data yang rendah. Berdasarkan model bahasa berskala besar berdasarkan autoregresi, didapati bahawa mereka boleh dilatih pada sejumlah besar teks (tanpa anotasi) terlebih dahulu, dan kemudian menggunakan teknologi penalaan halus atau gesaan, yang sebahagiannya mengurangkan kelemahan kecekapan data yang rendah teknologi pembelajaran mendalam semasa, tetapi masih memerlukan data anotasi berkaitan tugas. Lebih besar model, lebih besar keperluan pelabelan. Cara untuk lebih cekap dan bekerjasama menggunakan data berlabel dan data tidak berlabel merupakan satu cabaran untuk mencapai kecekapan data. 5. ChatGPT terhad kepada input dan output teks, dan banyak kesilapan yang dilakukannya juga menggambarkan kekurangan semantik, pengetahuan dan penaakulan sebab akibat yang serius. Makna perkataan nampaknya terletak pada kejadian bersama statistik dan bukannya pada asas dunia sebenar. Jadi, walaupun model bahasa masa depan menjadi lebih besar dan lebih besar, mereka masih berprestasi buruk pada beberapa akal fizikal asas. Kecerdasan melampaui keupayaan bahasa Elemen asas kecerdasan biologi terletak pada keupayaan haiwan untuk interaksi motor deria dengan. dunia[20]. Mesin pintar pada masa hadapan mungkin tidak semestinya mempunyai bentuk manusia, tetapi interaksi pelbagai mod antara mesin dan persekitaran melalui badan dalam mendengar, bercakap, membaca, menulis, berfikir, memanipulasi objek, bertindak, dan lain-lain akan sangat menggalakkan pembangunan kecerdasan mesin Ia juga akan membantu kecerdasan mesin mengatasi batasan satu modaliti teks dan membantu manusia dengan lebih baik. Ringkasan: Dari perspektif linguistik, Pengetahuan bahasa merangkumi struktur dan ciri-ciri perkataan - morfologi dan leksikon ), cara perkataan membentuk frasa dan ayat – sintaksis, makna morfem, perkataan, frasa, ayat dan wacana – semantik [21]. ChatGPT telah mempelajari banyak pengetahuan bahasa (terutamanya pengetahuan di bawah tahap semantik) melalui model yang sangat besar, mempunyai keupayaan pemahaman bahasa tertentu, dan boleh menghasilkan ayat yang lancar, tetapi terdapat juga kelemahan yang jelas: Memandangkan kelemahan ini, kami telah menyelesaikan beberapa cabaran yang dihadapi masa depan daripada ChatGPT dan menuju ke arah kecerdasan buatan am (AGI), seperti yang ditunjukkan dalam Rajah 8, dan juga menunjukkan Beberapa kandungan penyelidikan penting. Perlu diingatkan bahawa kawasan penyelidikan setiap kawasan tidak terpencil, tetapi bersilang antara satu sama lain. Sebagai contoh, dalam kajian kebolehpercayaan dan kebolehkawalan, diharapkan output sistem mematuhi norma sosial, jadi bagaimana mencerminkan norma sosial ini dalam utiliti sistem, supaya output perancangan sistem dapat mematuhi norma sosial. Oleh itu, terdapat pertindihan antara penyelidikan tentang kebolehkawalan sistem dan penyelidikan untuk meningkatkan keupayaan perancangan sistem. Sebagai contoh lain, bagaimana untuk mengintegrasikan pengetahuan dalam perancangan sistematik dan membuat keputusan? Rajah 8: Cabaran ke arah AGI ChatGPT ialah peristiwa penting dalam penyelidikan kecerdasan buatan. Adalah sangat penting untuk memahami kemajuan, kekurangan dan cabaran masa depannya terhadap AGI. Kami percaya bahawa dengan mencari kebenaran dan bersikap pragmatik, dan dengan sentiasa berinovasi, kami boleh mempromosikan pembangunan kecerdasan buatan ke tahap yang baharu Kami mengalu-alukan semua orang untuk berbincang dan membetulkan kami, terima kasih!

04 Kesimpulan

Atas ialah kandungan terperinci Temu bual eksklusif dengan Profesor Ou Zhijian dari Universiti Tsinghua, memberikan analisis mendalam tentang aura ChatGPT dan cabaran masa depan!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1376

1376

52

52

ChatGPT kini membenarkan pengguna percuma menjana imej dengan menggunakan DALL-E 3 dengan had harian

Aug 09, 2024 pm 09:37 PM

ChatGPT kini membenarkan pengguna percuma menjana imej dengan menggunakan DALL-E 3 dengan had harian

Aug 09, 2024 pm 09:37 PM

DALL-E 3 telah diperkenalkan secara rasmi pada September 2023 sebagai model yang jauh lebih baik daripada pendahulunya. Ia dianggap sebagai salah satu penjana imej AI terbaik setakat ini, mampu mencipta imej dengan perincian yang rumit. Walau bagaimanapun, semasa pelancaran, ia adalah tidak termasuk

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Laman web ini melaporkan pada 27 Jun bahawa Jianying ialah perisian penyuntingan video yang dibangunkan oleh FaceMeng Technology, anak syarikat ByteDance Ia bergantung pada platform Douyin dan pada asasnya menghasilkan kandungan video pendek untuk pengguna platform tersebut Windows , MacOS dan sistem pengendalian lain. Jianying secara rasmi mengumumkan peningkatan sistem keahliannya dan melancarkan SVIP baharu, yang merangkumi pelbagai teknologi hitam AI, seperti terjemahan pintar, penonjolan pintar, pembungkusan pintar, sintesis manusia digital, dsb. Dari segi harga, yuran bulanan untuk keratan SVIP ialah 79 yuan, yuran tahunan ialah 599 yuan (nota di laman web ini: bersamaan dengan 49.9 yuan sebulan), langganan bulanan berterusan ialah 59 yuan sebulan, dan langganan tahunan berterusan ialah 499 yuan setahun (bersamaan dengan 41.6 yuan sebulan) . Di samping itu, pegawai yang dipotong juga menyatakan bahawa untuk meningkatkan pengalaman pengguna, mereka yang telah melanggan VIP asal

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Tingkatkan produktiviti, kecekapan dan ketepatan pembangun dengan menggabungkan penjanaan dipertingkatkan semula dan memori semantik ke dalam pembantu pengekodan AI. Diterjemah daripada EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, pengarang JanakiramMSV. Walaupun pembantu pengaturcaraan AI asas secara semulajadi membantu, mereka sering gagal memberikan cadangan kod yang paling relevan dan betul kerana mereka bergantung pada pemahaman umum bahasa perisian dan corak penulisan perisian yang paling biasa. Kod yang dijana oleh pembantu pengekodan ini sesuai untuk menyelesaikan masalah yang mereka bertanggungjawab untuk menyelesaikannya, tetapi selalunya tidak mematuhi piawaian pengekodan, konvensyen dan gaya pasukan individu. Ini selalunya menghasilkan cadangan yang perlu diubah suai atau diperhalusi agar kod itu diterima ke dalam aplikasi

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Model Bahasa Besar (LLM) dilatih pada pangkalan data teks yang besar, di mana mereka memperoleh sejumlah besar pengetahuan dunia sebenar. Pengetahuan ini dibenamkan ke dalam parameter mereka dan kemudiannya boleh digunakan apabila diperlukan. Pengetahuan tentang model ini "diperbaharui" pada akhir latihan. Pada akhir pra-latihan, model sebenarnya berhenti belajar. Selaraskan atau perhalusi model untuk mempelajari cara memanfaatkan pengetahuan ini dan bertindak balas dengan lebih semula jadi kepada soalan pengguna. Tetapi kadangkala pengetahuan model tidak mencukupi, dan walaupun model boleh mengakses kandungan luaran melalui RAG, ia dianggap berfaedah untuk menyesuaikan model kepada domain baharu melalui penalaan halus. Penalaan halus ini dilakukan menggunakan input daripada anotasi manusia atau ciptaan LLM lain, di mana model menemui pengetahuan dunia sebenar tambahan dan menyepadukannya

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Editor |ScienceAI Question Answering (QA) set data memainkan peranan penting dalam mempromosikan penyelidikan pemprosesan bahasa semula jadi (NLP). Set data QA berkualiti tinggi bukan sahaja boleh digunakan untuk memperhalusi model, tetapi juga menilai dengan berkesan keupayaan model bahasa besar (LLM), terutamanya keupayaan untuk memahami dan menaakul tentang pengetahuan saintifik. Walaupun pada masa ini terdapat banyak set data QA saintifik yang meliputi bidang perubatan, kimia, biologi dan bidang lain, set data ini masih mempunyai beberapa kekurangan. Pertama, borang data adalah agak mudah, kebanyakannya adalah soalan aneka pilihan. Ia mudah dinilai, tetapi mengehadkan julat pemilihan jawapan model dan tidak dapat menguji sepenuhnya keupayaan model untuk menjawab soalan saintifik. Sebaliknya, Soal Jawab terbuka

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Editor |. KX Dalam bidang penyelidikan dan pembangunan ubat, meramalkan pertalian pengikatan protein dan ligan dengan tepat dan berkesan adalah penting untuk pemeriksaan dan pengoptimuman ubat. Walau bagaimanapun, kajian semasa tidak mengambil kira peranan penting maklumat permukaan molekul dalam interaksi protein-ligan. Berdasarkan ini, penyelidik dari Universiti Xiamen mencadangkan rangka kerja pengekstrakan ciri berbilang mod (MFE) novel, yang buat pertama kalinya menggabungkan maklumat mengenai permukaan protein, struktur dan jujukan 3D, dan menggunakan mekanisme perhatian silang untuk membandingkan ciri modaliti yang berbeza penjajaran. Keputusan eksperimen menunjukkan bahawa kaedah ini mencapai prestasi terkini dalam meramalkan pertalian mengikat protein-ligan. Tambahan pula, kajian ablasi menunjukkan keberkesanan dan keperluan maklumat permukaan protein dan penjajaran ciri multimodal dalam rangka kerja ini. Penyelidikan berkaitan bermula dengan "S

Meletakkan pasaran seperti AI, GlobalFoundries memperoleh teknologi gallium nitrida Tagore Technology dan pasukan berkaitan

Jul 15, 2024 pm 12:21 PM

Meletakkan pasaran seperti AI, GlobalFoundries memperoleh teknologi gallium nitrida Tagore Technology dan pasukan berkaitan

Jul 15, 2024 pm 12:21 PM

Menurut berita dari laman web ini pada 5 Julai, GlobalFoundries mengeluarkan kenyataan akhbar pada 1 Julai tahun ini, mengumumkan pemerolehan teknologi power gallium nitride (GaN) Tagore Technology dan portfolio harta intelek, dengan harapan dapat mengembangkan bahagian pasarannya dalam kereta dan Internet of Things dan kawasan aplikasi pusat data kecerdasan buatan untuk meneroka kecekapan yang lebih tinggi dan prestasi yang lebih baik. Memandangkan teknologi seperti AI generatif terus berkembang dalam dunia digital, galium nitrida (GaN) telah menjadi penyelesaian utama untuk pengurusan kuasa yang mampan dan cekap, terutamanya dalam pusat data. Laman web ini memetik pengumuman rasmi bahawa semasa pengambilalihan ini, pasukan kejuruteraan Tagore Technology akan menyertai GLOBALFOUNDRIES untuk membangunkan lagi teknologi gallium nitride. G

SK Hynix akan memaparkan produk berkaitan AI baharu pada 6 Ogos: HBM3E 12 lapisan, NAND 321 tinggi, dsb.

Aug 01, 2024 pm 09:40 PM

SK Hynix akan memaparkan produk berkaitan AI baharu pada 6 Ogos: HBM3E 12 lapisan, NAND 321 tinggi, dsb.

Aug 01, 2024 pm 09:40 PM

Menurut berita dari laman web ini pada 1 Ogos, SK Hynix mengeluarkan catatan blog hari ini (1 Ogos), mengumumkan bahawa ia akan menghadiri Global Semiconductor Memory Summit FMS2024 yang akan diadakan di Santa Clara, California, Amerika Syarikat dari 6 hingga 8 Ogos, mempamerkan banyak produk penjanaan teknologi baru. Pengenalan kepada Sidang Kemuncak Memori dan Penyimpanan Masa Depan (FutureMemoryandStorage), dahulunya Sidang Kemuncak Memori Flash (FlashMemorySummit) terutamanya untuk pembekal NAND, dalam konteks peningkatan perhatian kepada teknologi kecerdasan buatan, tahun ini dinamakan semula sebagai Sidang Kemuncak Memori dan Penyimpanan Masa Depan (FutureMemoryandStorage) kepada jemput vendor DRAM dan storan serta ramai lagi pemain. Produk baharu SK hynix dilancarkan tahun lepas