Kepantasan inovasi dalam bidang kecerdasan buatan semakin pantas, dan bilangan kertas telah meletup, malah mencapai tahap yang tidak boleh dibaca oleh manusia.

Antara kertas kerja besar-besaran yang diterbitkan pada 2022, institusi manakah yang paling berpengaruh? Kertas kerja mana yang lebih berbaloi untuk dibaca?

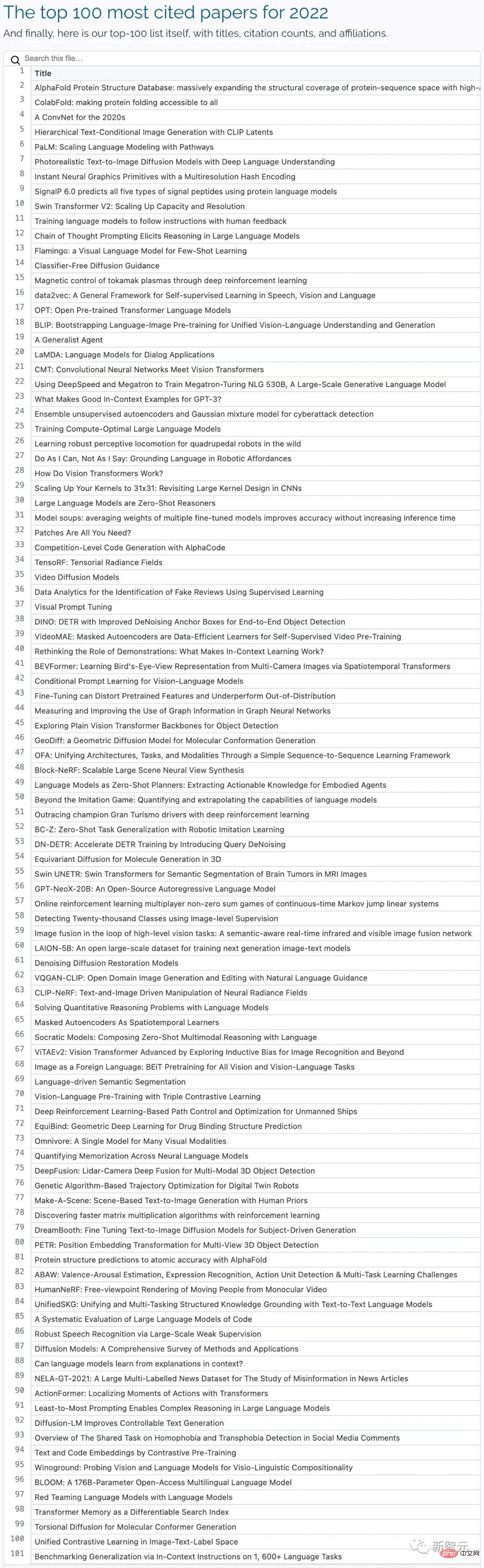

Baru-baru ini, media asing Zeta Alpha menggunakan kiraan petikan klasik sebagai penunjuk penilaian untuk mengumpul dan menyusun 100 kertas yang paling banyak disebut pada 2022 , dan menganalisis bilangan kertas yang dipetik tinggi yang diterbitkan oleh negara dan institusi yang berbeza dalam tempoh tiga tahun yang lalu.

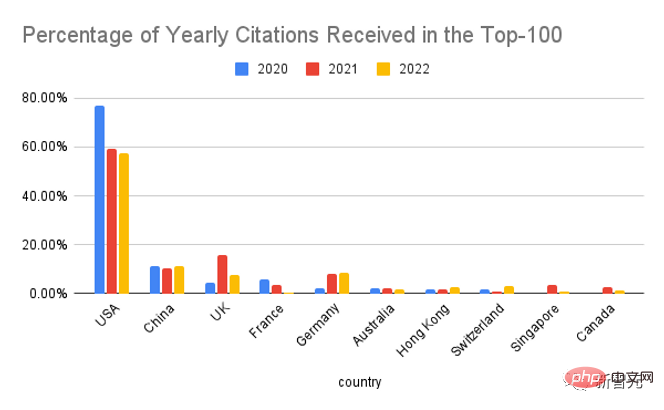

Jika dibahagikan mengikut negara, Amerika Syarikat masih menduduki kedudukan utama, tetapi bahagiannya dalam 100 kertas kerja Teratas dibandingkan Ia akan menurun dengan ketara pada tahun 2020.

China menduduki tempat kedua, dengan data yang lebih tinggi sedikit daripada tahun lepas adalah United Kingdom, dengan keluaran DeepMind tahun lepas Mengambil kira 69% daripada jumlah UK, melebihi 60% pada tahun-tahun sebelumnya pengaruh Singapura dan Australia dalam bidang AI juga melebihi jangkaan penganalisis.

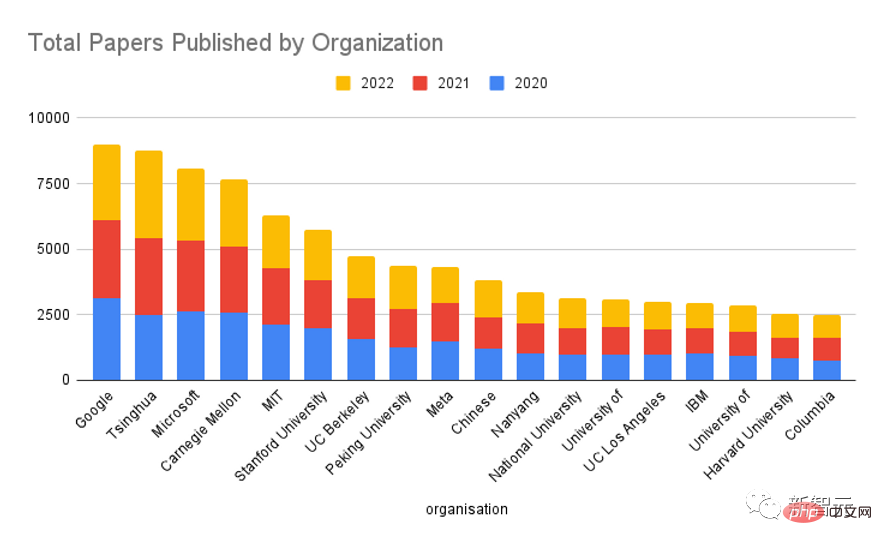

Jika dibahagikan mengikut organisasi, kita dapat melihat bahawa Google sentiasa menjadi pemain terkuat dalam bidang AI, diikuti oleh Meta, Microsoft, University of California, Berkeley, DeepMind dan Universiti Stanford , kedudukan pertama di negara ini ialah Universiti Tsinghua.

Sebagai peneraju Meta AI, Yann LeCun juga berbesar hati untuk mengumumkan pengaruh Meta dalam industri dan berkata Meta AI memberi lebih perhatian kepada kualiti penerbitan berbanding kuantiti penerbitan .

Bagi isu Google dan DeepMind, kedua-duanya milik Alphabet, dikira secara berasingan dalam senarai, LeCun Ia mengatakan bahawa DeepMind sentiasa menegaskan bahawa mereka beroperasi secara bebas daripada Google, yang anehnya pekerja Google tidak mempunyai akses kepada pangkalan kod DeepMind.

Walaupun penyelidikan kecerdasan buatan hari ini kebanyakannya diterajui oleh industri, dan institusi akademik individu mempunyai sedikit impak, disebabkan kesan long tail, komuniti akademik secara keseluruhannya masih setanding dengan industri. Apabila data diagregatkan mengikut jenis organisasi, dapat dilihat bahawa kesan kedua-duanya adalah lebih kurang sama.

Jika anda melihat kembali tiga tahun yang lalu dan mengira jumlah hasil penyelidikan pelbagai institusi, anda dapat melihat bahawa Google masih mendahului, tetapi jurangnya jauh lebih kecil berbanding dengan institusi lain, dan patut disemak Perlu dinyatakan bahawa Universiti Tsinghua berada di kedudukan kedua selepas Google.

OpenAI dan DeepMind tidak termasuk dalam 20 teratas, sudah tentu artikel yang diterbitkan oleh institusi ini Jumlahnya kecil, tetapi kesan setiap artikel adalah besar.

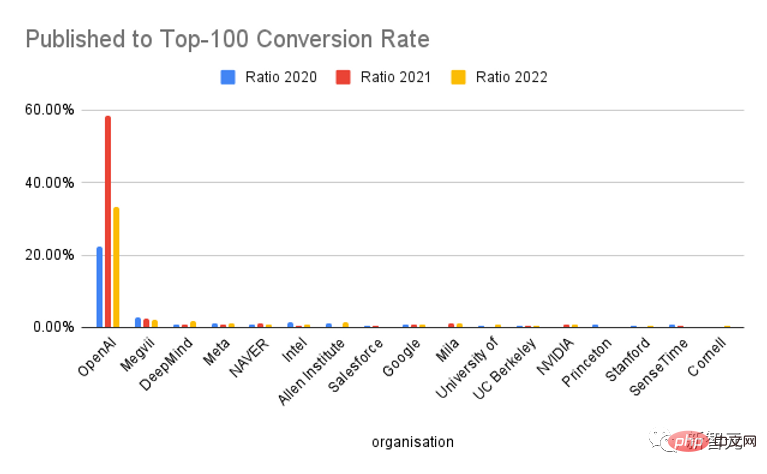

Jika anda melihat pada bahagian penerbitan yang memasuki Top-100, OpenAI adalah unik dan jauh melebihi institusi lain dari segi kadar penukaran Pada asasnya, salah satu daripada dua kertas kerja telah menjadi Tesis besar "Seratus Tahunan".

Sudah tentu, jika dilihat dari populariti ChatGPT, OpenAI sememangnya sangat baik dalam pemasaran, yang telah mempromosikan peningkatan dalam kutipan ke tahap tertentu Memang tidak dinafikan kualiti mereka hasil kajian sangat tinggi.

Pertama semua, Platform Zeta Alpha mengumpul kertas yang paling banyak disebut dalam setiap tahun, dan kemudian menyemak secara manual tarikh penerbitan pertama (biasanya pracetak arXiv) dan mengkategorikannya ke dalam tahun yang sepadan.

Tambah senarai ini dengan melombong Semantic Scholar untuk kertas AI yang diberi sebutan tinggi, yang menyediakan liputan yang lebih luas dan keupayaan untuk mengisih mengikut kiraan petikan, terutamanya daripada penerbit sumber tertutup yang berpengaruh seperti Nature, Elsevier, Springer dan jurnal lain) untuk kertas tambahan.

Kemudian bilangan petikan setiap kertas di Google Scholar digunakan sebagai penunjuk perwakilan, dan kertas itu diisih mengikut nombor ini untuk mendapatkan 100 kertas teratas dalam tempoh setahun.

Untuk kertas kerja ini, gunakan GPT-3 untuk mengekstrak pengarang, gabungan dan negara mereka, dan semak keputusan ini secara manual (jika negara tidak diwakili dalam penerbitan, gunakan ibu pejabat organisasi negara).

Kertas oleh pengarang dengan berbilang institusi dikira sekali untuk setiap gabungan.

1. Pangkalan Data Struktur Protein AlphaFold: meluaskan liputan struktur ruang jujukan protein secara besar-besaran dengan ketepatan tinggi. model

Pautan kertas: https://academic.oup.com/nar/article/50/D1/D439/6430488

Institusi penerbitan: Makmal Biologi Molekul Eropah, DeepMind

AlphaFold DB: https:// alphafold. ebi.ac.uk

Bilangan petikan: 1331

Pangkalan data struktur protein AlphaFold AlphaFold DB It ialah pangkalan data ramalan struktur protein yang boleh diakses secara umum, luas dan sangat tepat.

Dikuasakan oleh DeepMind's AlphaFold v2.0, pangkalan data ini membolehkan pengembangan liputan struktur yang belum pernah berlaku sebelum ini bagi ruang jujukan protein yang diketahui.

AlphaFold DB menyediakan akses program dan visualisasi interaktif koordinat atom yang diramalkan, anggaran keyakinan model untuk setiap baki dan pasangan serta ralat penjajaran yang diramalkan.

Versi awal AlphaFold DB mengandungi lebih daripada 360,000 struktur yang diramalkan, meliputi proteom 21 model organisma, dan akan dikembangkan pada masa hadapan untuk meliputi kebanyakan set data UniRef90 (lebih 100 juta ) urutan perwakilan.

2 ColabFold: menjadikan lipatan protein boleh diakses oleh semua

<.>

<.>

Pautan kertas: https://www.nature.com/articles/s41592-022-01488-1

Pautan kod: https://github.com/sokrypton/colabfold

Pautan alam sekitar: https://colabfold.mmseqs.com

Petikan: 1138

ColabFold mempercepatkan dengan menggabungkan carian homologi pantas MMSEQS2 dengan ramalan AlphaFold2 atau Rosettafold tentang struktur dan kompleks protein . ColabFold boleh mencapai 40-60 kali carian dipercepatkan dan pengoptimuman dalam penggunaan model, dan boleh meramalkan hampir 1,000 struktur pada pelayan dengan hanya satu unit pemprosesan grafik. ColabFold ialah platform percuma dan boleh diakses untuk lipatan protein berdasarkan Google Colaboratory dan juga merupakan perisian sumber terbuka yang tersedia.3 A ConvNet untuk tahun 2020

Pautan kertas: https://arxiv.org/pdf/ 2201.03545.pdf

Petikan: 835

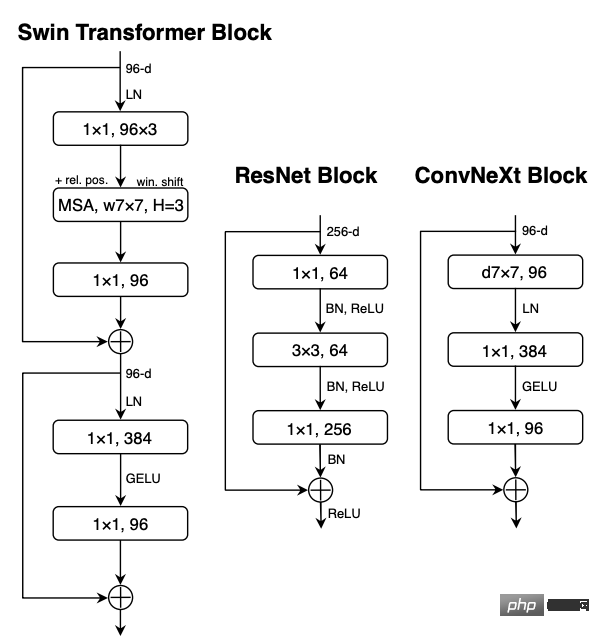

"Roaring 20s" identiti visual (Roaring 20s) Bermula dengan pengenalan Visual Transformers (ViTs), ia dengan pantas menggantikan ConvNets sebagai model klasifikasi imej yang paling maju. Sebaliknya, ViT yang paling mudah masih menghadapi beberapa kesukaran apabila digunakan pada tugas umum penglihatan komputer, seperti pengesanan objek dan pembahagian semantik. Transformers Hierarki (seperti Swin Transformers) memperkenalkan semula beberapa prior ConvNet, menjadikan Transformer sebenarnya boleh dilaksanakan sebagai tulang belakang model visi umum dan menunjukkan prestasi yang ketara dalam pelbagai tugas penglihatan.Walau bagaimanapun, keberkesanan pendekatan hibrid ini adalah terutamanya disebabkan oleh kelebihan yang wujud pada Transformer dan bukannya kecenderungan induktif yang wujud pada Convolutions.

Dalam kerja ini, penyelidik menyemak semula ruang reka bentuk dan menguji had perkara yang boleh dicapai oleh ConvNets tulen.

Secara beransur-ansur "memodenkan" ResNet standard ke dalam reka bentuk ViT, dan dalam proses itu menemui beberapa kunci yang menyumbang kepada komponen perbezaan prestasi, penerokaan mendedahkan keluarga model ConvNet tulen yang dipanggil ConvNeXt.

ConvNeXt terdiri sepenuhnya daripada modul ConvNet standard dan setanding dengan Transformer dari segi ketepatan dan kebolehskalaan, mencapai 87.8% ketepatan top-1 ImageNet dalam pengesanan COCO dan segmentasi ADE20K, serta melebihi Swin Transformers sambil mengekalkan kesederhanaan dan kecekapan ConvNets standard.

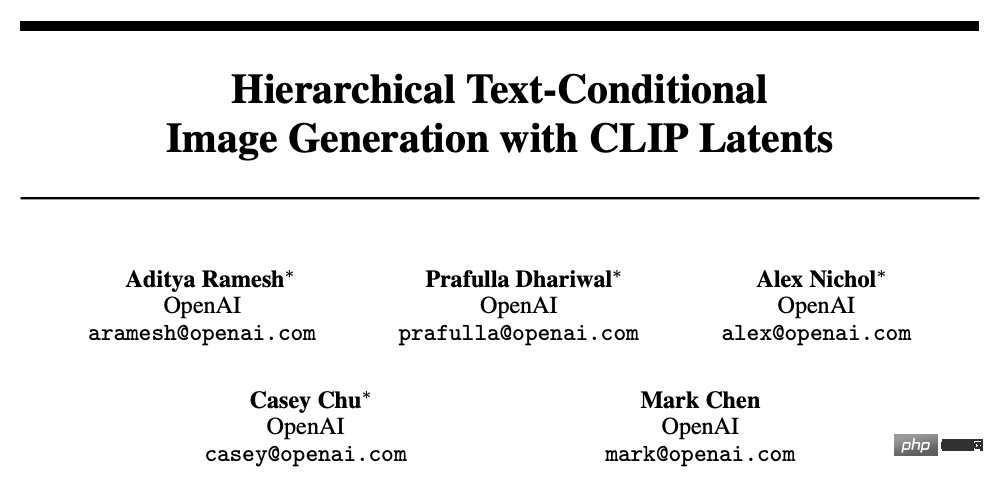

4. Penjanaan Imej Bersyarat Hierarki dengan Laten KLIP

Pautan kertas: https://arxiv.org/abs/2204.06125

Bilangan petikan: 718

Model kontrastif seperti CLIP telah ditunjukkan untuk mempelajari perwakilan imej yang mantap yang menangkap semantik dan gaya.

Untuk memanfaatkan perwakilan ini untuk menjana imej, penyelidik mencadangkan model dua peringkat: prior yang menjana pembenaman imej CLIP diberi kapsyen teks dan penyahkod yang menjana imej yang dikondisikan pada benam imej.

Eksperimen telah menunjukkan bahawa menjana perwakilan imej secara eksplisit boleh meningkatkan kepelbagaian imej dengan kehilangan minimum dalam kesetiaan dan persamaan tajuk, dan penyahkod yang dikondisikan pada perwakilan imej juga boleh menghasilkan variasi imej, Mengekalkan semantik dan gayanya sambil menukar yang tidak penting butiran yang tidak terdapat dalam perwakilan imej.

Selain itu, ruang benam bersama CLIP membolehkan operasi imej berpandukan bahasa dilakukan dalam cara sifar tangkapan.

Gunakan model resapan untuk penyahkod dan bereksperimen dengan model autoregresif dan resapan priori, mendapati model yang kedua adalah lebih cekap dari segi pengiraan dan boleh menjana sampel berkualiti tinggi.

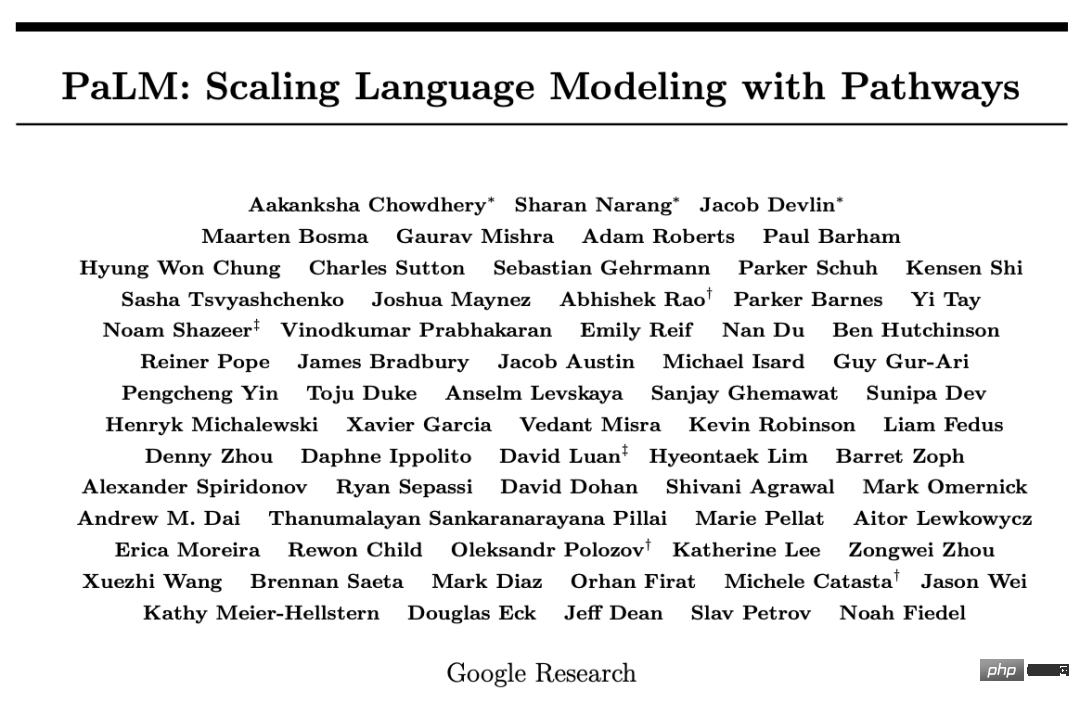

5. PaLM: Menskalakan Pemodelan Bahasa dengan Laluan

Pautan kertas: https://arxiv.org/pdf/2204.02311.pdf

Bilangan petikan: 426

Model bahasa yang besar telah ditunjukkan untuk mencapai prestasi yang lebih tinggi pada pelbagai tugasan bahasa semula jadi menggunakan pembelajaran beberapa pukulan, sekali gus mengurangkan bilangan contoh latihan khusus tugasan yang diperlukan untuk menyesuaikan model kepada aplikasi tertentu.

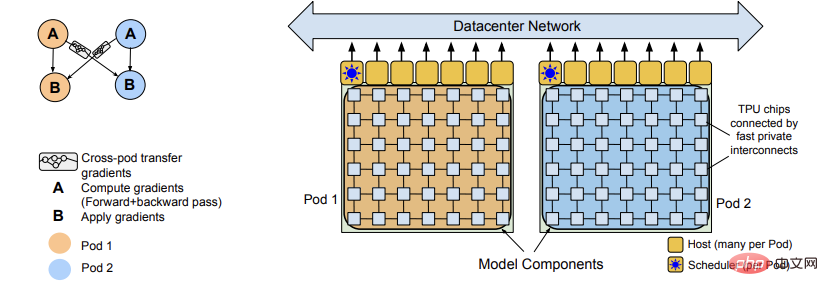

Untuk memahami lebih lanjut kesan skala pada pembelajaran beberapa pukulan, para penyelidik melatih parameter 540 bilion, model bahasa Transformer yang diaktifkan padat Model Bahasa Laluan (PaLM).

PaLM telah dilatih pada cip 6144 TPU v4 menggunakan Pathways (sistem ML baharu yang mampu melakukan latihan yang cekap pada berbilang TPU Pod), mencapai keputusan mengenai beratus-ratus pemahaman bahasa dan penanda aras penjanaan Tercanggih beberapa- hasil pembelajaran pukulan menunjukkan faedah penskalaan.

Pada beberapa tugasan ini, PaLM 540B mencapai prestasi cemerlang, mengatasi teknologi terkini dalam penalaan halus pada satu set tugasan inferens berbilang langkah dan mengatasi prestasi manusia di bangku BIG yang dikeluarkan baru-baru ini prestasi purata penanda aras.

Sebilangan besar tugas BIG-bench menunjukkan peningkatan yang tidak berterusan dalam saiz model, yang juga bermakna apabila skala dikembangkan kepada model terbesar, prestasi meningkat secara mendadak.

PaLM juga mempunyai keupayaan yang kukuh dalam tugasan berbilang bahasa dan penjanaan kod sumber, yang juga telah dibuktikan dalam beberapa siri ujian penanda aras.

Di samping itu, penyelidik juga menjalankan analisis komprehensif tentang berat sebelah dan ketoksikan, dan mengkaji tahap ingatan data latihan berhubung dengan saiz model, dan akhirnya Pertimbangan etika yang berkaitan dengan model bahasa besar dibincangkan, dan strategi pengurangan potensi dibincangkan.

1. Swin Transformer V2: Meningkatkan Kapasiti dan Resolusi

Pautan kertas: https://arxiv.org/pdf/2111.09883.pdf

Pautan kod: https://github.com/microsoft/Swin-Transformer

Petikan: 266

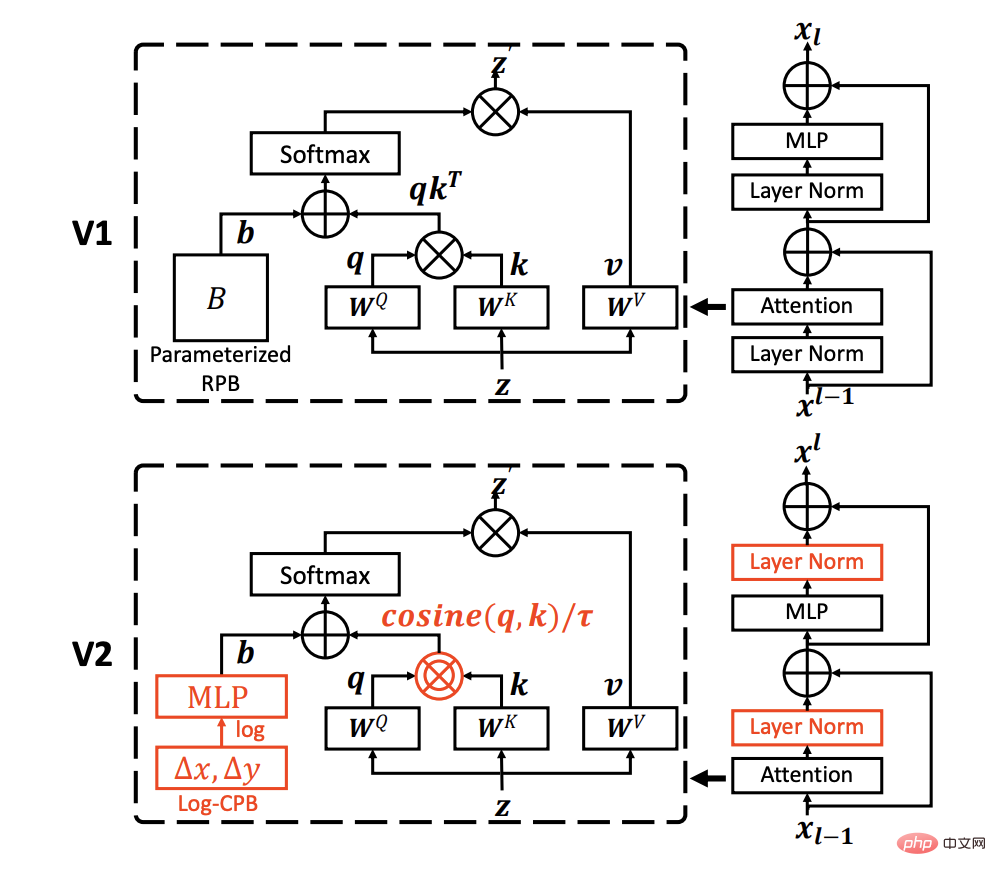

Model NLP berskala besar telah ditunjukkan dapat meningkatkan prestasi tugasan bahasa dengan ketara tanpa tanda-tanda tepu, sambil turut menunjukkan keupayaan beberapa pukulan yang menakjubkan seperti manusia.

Kertas kerja ini bertujuan untuk meneroka model berskala besar dalam penglihatan komputer dan menyelesaikan tiga masalah utama dalam latihan dan aplikasi model visual berskala besar, termasuk ketidakstabilan latihan dan perbezaan antara pra-latihan dan halus- penalaan jurang kadar, dan keperluan untuk data berlabel.

Para penyelidik mencadangkan tiga teknik utama:

1) Kaedah sisa-posterior digabungkan dengan perhatian kosinus Kaedah Normalisasi untuk memperbaiki kestabilan latihan;

2) Kaedah sisihan kedudukan berterusan jarak log untuk memindahkan model yang telah dilatih dengan imej resolusi rendah dengan berkesan kepada mereka yang mempunyai input resolusi tinggi Dalam tugasan hiliran; ) Kaedah pra-latihan yang diselia sendiri SimMIM untuk mengurangkan keperluan untuk sejumlah besar imej berlabel.

Melalui teknik ini, model Swin Transformer V2 3 bilion parameter berjaya dilatih, model penglihatan padat terbesar setakat ini, dan membolehkannya dilatih dengan imej sehingga resolusi 1,536×1,536.

Tetapkan rekod prestasi baharu pada 4 tugas penglihatan perwakilan, termasuk klasifikasi imej ImageNet-V2, pengesanan objek COCO, segmentasi semantik ADE20K dan klasifikasi tindakan video Kinetics-400.

Pada masa yang sama, dapat diperhatikan bahawa latihan ini jauh lebih cekap daripada latihan dalam model penglihatan peringkat bilion Google, menggunakan data berlabel dan masa latihan 40 kali lebih sedikit.

2. Ensemble autoencoders tanpa pengawasan dan model campuran Gaussian untuk pengesanan serangan siberPenyelidikan sebelum ini menggunakan pembelajaran mesin tanpa pengawasan dengan fungsi pengurangan dimensi Untuk pengesanan rangkaian, ia terhad kepada pengesanan anomali yang teguh pada data berdimensi tinggi dan jarang.

Kebanyakan kaedah biasanya mengandaikan bahawa parameter setiap domain adalah homogen dan mempunyai taburan Gaussian tertentu, mengabaikan ujian keteguhan kecondongan data.

Pautan kertas: https://www.sciencedirect.com/science/article/pii/S0306457321003162

Petikan: 145Kertas kerja ini mencadangkan untuk menggunakan pengekod automatik ensemble tanpa pengawasan yang disambungkan kepada Model Campuran Gaussian (GMM) untuk menyesuaikan diri dengan berbilang domain tanpa mengambil kira kekhususan setiap domain.

Dalam ruang terpendam autoenkoder ensemble, perwakilan terpendam berasaskan perhatian dan ciri-ciri ralat minimum yang dibina semula dieksploitasi, menggunakan algoritma pemaksima jangkaan (EM) untuk menganggarkan ketumpatan sampel dalam GMM, apabila menganggar Apabila ketumpatan sampel melebihi ambang pembelajaran yang diperoleh semasa fasa latihan, sampel dikenal pasti sebagai outlier yang berkaitan dengan anomali.

Akhir sekali, pengekod automatik bersepadu dan GMM dioptimumkan secara bersama untuk mengubah pengoptimuman fungsi objektif menjadi masalah dwi Lagrangian pada tiga set data awam mengesahkan prestasi model yang dicadangkan adalah berdaya saing dengan ketara garis dasar pengesanan anomali.

Pengarang bersama kertas kerja itu ialah Profesor An Peng dari Institut Teknologi Ningbo dan Zhiyuan Wang dari Universiti Tongji.

Profesor An Peng kini merupakan timbalan dekan Pusat Pengajian Elektronik dan Kejuruteraan Maklumat Institut Teknologi Ningbo Beliau belajar di Jabatan Fizik Kejuruteraan Universiti Tsinghua dari tahun 2000 hingga 2009 dan menerima ijazah sarjana muda dan ijazah. kedoktoran dalam bidang kejuruteraan; CERN, sarjana pelawat di Universiti Nasional Padua di Itali dan Universiti Heidelberg di Jerman, ahli Jawatankuasa Profesional Pengkomputeran Kognitif dan Sistem Persatuan Automasi Cina, ahli Jawatankuasa Profesional Pemprosesan Sistem Kognitif dan Maklumat Cina Persatuan Kecerdasan Buatan, dan ahli Jawatankuasa Kerja Belia Persatuan Komando dan Kawalan Cina Beliau juga telah mengambil bahagian dalam banyak projek penyelidikan saintifik seperti Program Penyelidikan dan Pembangunan Asas Utama Negara (Program 973), Yayasan Sains Semula Jadi Kebangsaan; China, dan Program Spark Negara.

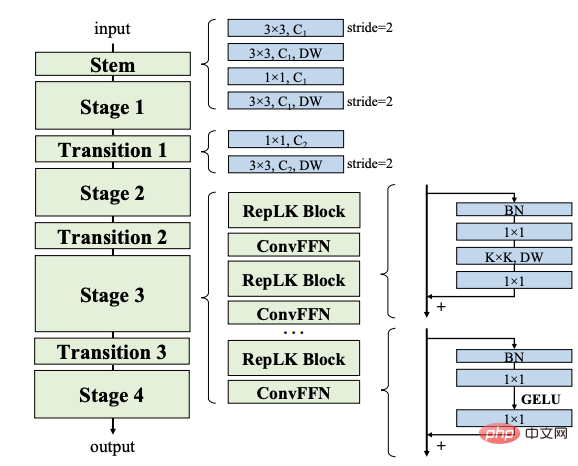

3. Meningkatkan Kernel Anda kepada 31x31: Meninjau Semula Reka Bentuk Kernel Besar dalam CNN

Pautan kertas: https://arxiv.org/abs/2203.06717 Pautan kod: https://github.com/megvii-research/RepLKNet Bilangan petikan: 127 Artikel ini mengkaji reka bentuk inti besar dalam rangkaian saraf konvolusi (CNN) moden. Diinspirasikan oleh kemajuan terkini dalam pengubah visual (ViT), kertas kerja ini menunjukkan bahawa menggunakan beberapa biji konvolusi besar dan bukannya sekumpulan biji kecil mungkin merupakan paradigma yang lebih berkuasa. Para penyelidik mencadangkan lima garis panduan, seperti menggunakan konvolusi kedalaman besar yang diparameter semula, untuk mereka bentuk CNN kernel besar berprestasi tinggi yang cekap.

Berdasarkan garis panduan ini kami mencadangkan RepLKNet, seni bina CNN tulen dengan saiz kernel 31x31, berbeza dengan 3x3 yang biasa digunakan, RepLKNet The jurang prestasi antara CNN dan ViT sangat berkurangan, seperti mencapai hasil yang setanding atau lebih baik daripada Swin Transformer dengan kependaman yang lebih rendah pada ImageNet dan beberapa tugas hiliran biasa.

RepLKNet juga menunjukkan kebolehskalaan yang baik untuk data besar dan model besar, mencapai ketepatan tertinggi sebanyak 87.8% pada ImageNet, 56.0% mIoU pada ADE20K dan 56.0% mIoU pada ImageNet dengan saiz model yang serupa sangat kompetitif dalam teknologi terkini.

Kajian selanjutnya menunjukkan bahawa berbanding dengan CNN teras kecil, CNN teras besar mempunyai medan penerimaan berkesan yang lebih besar dan bias bentuk yang lebih tinggi, dan bukannya bias tekstur.

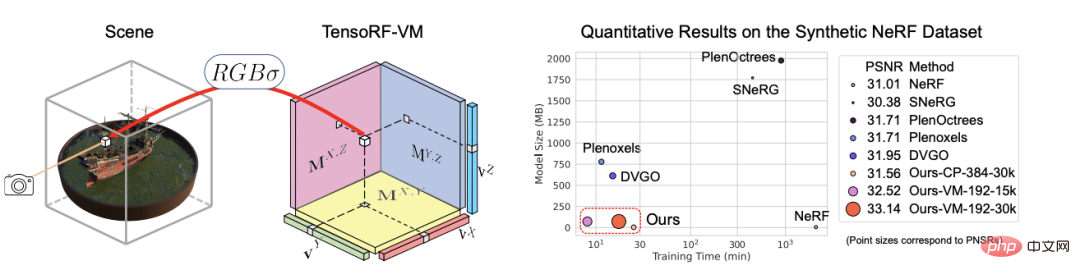

4 TensoRF: Tensorial Radiance Fields

Pautan kertas: https://arxiv.org/abs/ 2203.09517

Bilangan petikan: 110

Artikel mencadangkan TensoRF, kaedah untuk menjalankan medan sinaran kepada pemodelan dan pembinaan semula.

Tidak seperti NeRF yang menggunakan MLP semata-mata, para penyelidik memodelkan medan sinaran tempat kejadian sebagai tensor 4D, mewakili imej tiga dimensi dengan ciri berbilang saluran per-voxel Idea utama grid voxel adalah untuk menguraikan tensor pemandangan 4D kepada berbilang komponen tensor peringkat rendah padat.

Terbukti bahawa menggunakan penguraian CP tradisional dalam rangka kerja ini, mengurai tensor menjadi komponen peringkat satu dengan vektor padat akan mencapai prestasi yang lebih baik daripada NeRF biasa.

Untuk meningkatkan lagi prestasi, artikel itu turut memperkenalkan penguraian vektor-matriks (VM) baharu yang melonggarkan dua mod tensor rendah- peringkat kekangan dan menguraikan tensor kepada vektor padat dan faktor matriks.

Selain kualiti pemaparan yang lebih baik, kerja sebelumnya dan serentak untuk mengoptimumkan ciri per piksel secara langsung menghasilkan jejak memori yang ketara untuk model ini berbanding penguraian CP dan VM.

Eksperimen telah membuktikan bahawa TensoRF dengan penguraian CP mencapai pembinaan semula yang pantas (

Selain itu, TensoRF dengan penguraian VM meningkatkan lagi kualiti pemaparan dan mengatasi kaedah terkini yang terkini, sambil mengurangkan masa pembinaan semula (

5 VideoMAE: Pengekod Auto Bertopeng ialah Pelajar Cekap Data untuk Pra-Latihan Video Diselia Sendiri

Pautan kertas: https://arxiv.org/abs/2203.12602

Pautan kod: https://github.com/MCG-NJU/VideoMAE

Petikan: 100

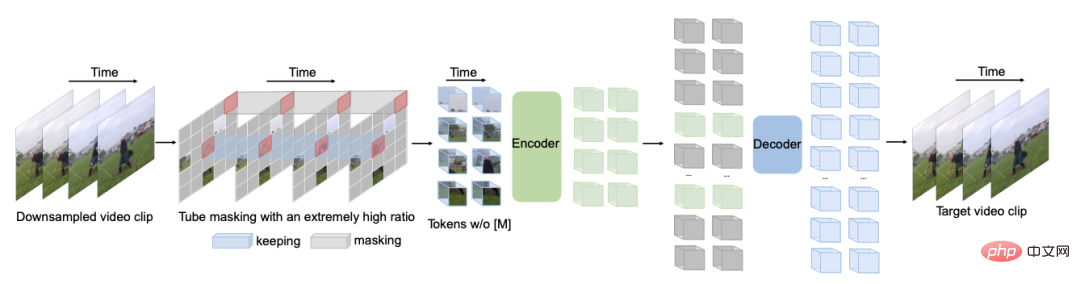

Untuk mencapai prestasi yang lebih tinggi pada set data yang agak kecil, selalunya perlu untuk melatih Video Transformer pada set data berskala besar tambahan.

Kertas kerja ini menunjukkan bahawa Video Masked Autoencoder (VideoMAE) ialah pelajar yang cekap data untuk pralatihan video penyeliaan sendiri (SSVP).

Diinspirasikan oleh ImageMAE baru-baru ini, penyelidik mencadangkan tiub video tersuai dengan nisbah topeng yang sangat tinggi ini menjadikan pembinaan semula video sebagai tugas penyeliaan sendiri yang lebih mencabar, sekali gus menggalakkan pengekstrakan representasi video yang lebih berkesan semasa proses pra-latihan ini.

Tiga penemuan penting diperolehi pada SSVP:

(1) Nisbah yang sangat tinggi Kadar penyamaran (iaitu, 90% hingga 95%) masih boleh menghasilkan prestasi VideoMAE yang menggalakkan. Kandungan video berlebihan sementara menghasilkan kadar penyamaran yang lebih tinggi daripada imej.

(2) VideoMAE mencapai prestasi yang sangat tinggi pada set data yang sangat kecil (iaitu sekitar 3k-4k video) tanpa menggunakan sebarang data tambahan.

(3) VideoMAE menunjukkan bahawa untuk SSVP, kualiti data adalah lebih penting daripada kuantiti data.

Pemindahan domain antara set data pra-latihan dan sasaran ialah isu penting.

Perlu diperhatikan bahawa VideoMAE dan ViT biasa boleh mencapai 87.4% pada Kinetics-400, 75.4% pada Something-Something V2, 91.3% pada UCF101, dan 62.6% dicapai pada HMDB51 tanpa menggunakan sebarang data tambahan.

Senarai lengkap 100 kertas teratas

Atas ialah kandungan terperinci 'Kertas 100 AI Teratas' pada 2022 dikeluarkan: Tsinghua menduduki tempat kedua selepas Google, dan Institut Teknologi Ningbo menjadi kuda hitam terbesar. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Apakah motor servo

Apakah motor servo

Pengenalan kepada kaedah diagnostik SEO

Pengenalan kepada kaedah diagnostik SEO

Apakah yang termasuk storan penyulitan data?

Apakah yang termasuk storan penyulitan data?

Apakah perbezaan utama antara linux dan windows

Apakah perbezaan utama antara linux dan windows

Memori yang boleh bertukar maklumat secara terus dengan CPU ialah a

Memori yang boleh bertukar maklumat secara terus dengan CPU ialah a

Bagaimana untuk membuka fail mds

Bagaimana untuk membuka fail mds

Tukar warna latar belakang perkataan kepada putih

Tukar warna latar belakang perkataan kepada putih

Apakah alat pembangunan?

Apakah alat pembangunan?