Peranti teknologi

Peranti teknologi

AI

AI

berjaga-jaga! Krisis penggunaan tenaga yang disebabkan oleh letupan ChatGPT menimbulkan cabaran besar kepada pengendali pusat data

berjaga-jaga! Krisis penggunaan tenaga yang disebabkan oleh letupan ChatGPT menimbulkan cabaran besar kepada pengendali pusat data

berjaga-jaga! Krisis penggunaan tenaga yang disebabkan oleh letupan ChatGPT menimbulkan cabaran besar kepada pengendali pusat data

Baru-baru ini, ChatGPT, alat sembang pintar yang dimiliki oleh syarikat Amerika OpenAI, telah menarik perhatian media sosial, menarik lebih daripada 10 bilion dolar AS dalam pelaburan dan mempromosikan ledakan besar dalam aplikasi kecerdasan buatan dalam pasaran modal menjadi tumpuan buat seketika.

Microsoft adalah yang pertama mengumumkan pelaburan AS$10 bilion dalam OpenAI, dan kemudian Amazon dan versi AS bagi "Today's Headlines" BuzzFeed mengumumkan bahawa mereka akan membolehkan ChatGPT dalam kerja harian mereka , Baidu juga mengumumkan pelancaran "versi Cina" chatbot ChatGPT pada bulan Mac. Selepas banyak syarikat teknologi menambah bahan api kepada api, ChatGPT serta-merta menarik perhatian global.

Data menunjukkan bahawa bilangan robot yang digunakan oleh Amazon meningkat dengan pesat, dengan peningkatan harian mencecah kira-kira 1,000. Selain itu, syarikat induk Facebook Meta juga merancang untuk melabur tambahan AS$4 bilion hingga AS$5 bilion dalam pusat data pada 2023, yang kesemuanya dijangka digunakan untuk kecerdasan buatan. Ketua Pegawai Eksekutif IBM Krishna berkata bahawa kecerdasan buatan dijangka menyumbang $16 trilion kepada ekonomi global menjelang 2030.

Dengan populariti ChatGPT, gergasi mungkin memulakan pusingan baharu pertempuran sengit dalam bidang kecerdasan buatan pada tahun 2023.

Walau bagaimanapun, apabila ChatGPT-3 meramalkan perkataan seterusnya, ia perlu melakukan berbilang pengiraan inferens, dengan itu menduduki banyak sumber dan menggunakan lebih banyak kuasa. Memandangkan infrastruktur pusat data berkembang untuk menyokong pertumbuhan pesat pengkomputeran awan, penstriman video dan rangkaian 5G, seni bina GPU dan CPUnya tidak dapat beroperasi dengan cekap untuk memenuhi keperluan pengkomputeran yang akan berlaku, yang menimbulkan masalah bagi pengendali pusat data hiperskala.

Latihan GPT3.5 menggunakan sistem pengkomputeran AI yang dibina khas Microsoft, kelompok rangkaian berprestasi tinggi yang terdiri daripada 10,000 GPU V100, dengan jumlah penggunaan kuasa pengkomputeran kira-kira 3640 PF-hari (iaitu. Jika ia dikira satu kuadrilion kali sesaat, ia mengambil masa 3640 hari untuk mengira). Tugas latihan kluster GPU berskala besar dan jangka panjang sedemikian meletakkan keperluan yang melampau pada prestasi, kebolehpercayaan, kos dan aspek lain asas sambungan rangkaian.

Sebagai contoh, Meta mengumumkan bahawa ia akan menggantung pengembangan pusat data di seluruh dunia dan mengkonfigurasi semula ladang pelayan ini untuk memenuhi keperluan pemprosesan data kecerdasan buatan.

Permintaan untuk pemprosesan data untuk platform kecerdasan buatan adalah besar Pencipta OpenAI ChatGPT melancarkan platform itu pada November tahun lepas .

Infrastruktur pusat data yang menyokong transformasi digital ini – akan disusun menjadi dua hemisfera atau cuping seperti otak manusia, dengan satu cuping perlu lebih kuat daripada yang lain. Satu hemisfera akan menyediakan apa yang dipanggil "latihan", kuasa pengkomputeran yang diperlukan untuk memproses sehingga 300B titik data untuk mencipta salad perkataan yang dijana oleh ChatGPT.

Kepak latihan memerlukan kuasa pengkomputeran yang berkuasa dan semikonduktor GPU yang canggih, tetapi pada masa ini diperlukan dalam kelompok pusat data yang menyokong perkhidmatan pengkomputeran awan dan rangkaian 5G Terdapat sangat sedikit sambungan.

Pada masa yang sama, infrastruktur yang tertumpu pada "melatih" setiap platform AI akan mewujudkan permintaan yang besar untuk elektrik, memerlukan pusat data terletak berhampiran gigawatt tenaga boleh diperbaharui, dipasang sistem penyejukan cecair, bersama-sama dengan kuasa sandaran yang direka semula dan sistem penjana, antara ciri reka bentuk baharu yang lain.

Platform Kepintaran Buatan Hemisfera otak yang lain, infrastruktur digital berfungsi lebih tinggi yang dikenali sebagai mod "inferens" menyokong platform "generatif" interaktif yang bertindak balas kepada soalan input atau Dalam beberapa saat arahan , pertanyaan diproses, dimasukkan ke dalam pangkalan data yang dimodelkan dan dijawab dengan sintaks manusia yang meyakinkan.

Walaupun rangkaian pusat data bersambung hiper hari ini, seperti kelompok pusat data terbesar di Amerika Utara, "pusat data" Virginia Utara juga mempunyai rangkaian gentian optik yang paling luas untuk menampung "inferens" otak kecerdasan buatan. lobus. Ketersambungan Tahap 1 diperlukan, tetapi kemudahan ini juga perlu dinaik taraf untuk memenuhi kapasiti pemprosesan yang besar yang diperlukan, dan mereka perlu lebih dekat dengan pencawang.

Selain itu, data daripada institusi penyelidikan menunjukkan bahawa pusat data telah menjadi pengguna tenaga terbesar di dunia, dan perkadaran jumlah penggunaan elektrik mereka akan meningkat daripada 3% pada 2017 kepada 4.5% pada 2025. Mengambil China sebagai contoh, penggunaan elektrik pusat data yang beroperasi di seluruh negara dijangka melebihi 400 bilion kWj pada 2030, menyumbang 4% daripada jumlah penggunaan elektrik negara.

Oleh itu, produk digital memerlukan tenaga untuk dibangunkan dan digunakan, dan ChatGPT tidak terkecuali dianggarkan bahawa pemprosesan inferens dalam kerja pembelajaran mesin menyumbang 80-90% daripada penggunaan kuasa pengkomputeran, kerana ChatGPT Sejak masuk dalam talian pada 30 November 2022, pelepasan karbon telah melebihi 814.61 tan.

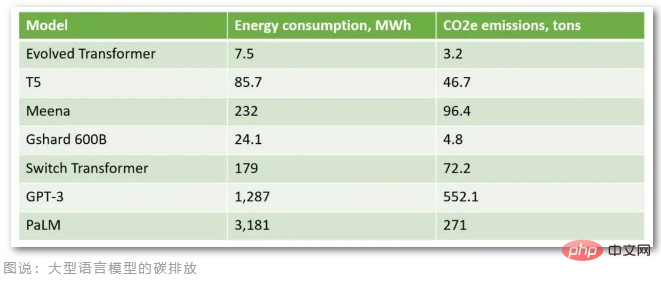

Menurut pengiraan oleh organisasi profesional, dengan mengandaikan bahawa ChatGPT yang dihoskan pada awan Azure Microsoft mempunyai 1 juta pertanyaan pengguna setiap hari (kira-kira 29,167 jam sehari di bawah masa respons dan perbendaharaan kata tertentu), Dikira berdasarkan kuasa maksimum GPU A100 sebanyak 407W (watt), pelepasan karbon harian mencapai 3.82 tan, dan pelepasan karbon bulanan melebihi 100 tan. Hari ini, ChatGPT mempunyai lebih daripada 10 juta pengguna harian, dan pelepasan karbon sebenar adalah jauh lebih daripada 100 tan sebulan. Di samping itu, latihan model bahasa yang besar yang mengandungi 175 bilion parameter memerlukan puluhan ribu CPU/GPU untuk memasukkan data 24 jam sehari, menggunakan lebih kurang 1287MWh elektrik dan mengeluarkan lebih daripada 552 tan karbon dioksida.

Berdasarkan pelepasan karbon model bahasa besar ini, GPT-3, pendahulu ChatGPT, mempunyai pelepasan karbon terbesar. Dilaporkan bahawa purata Amerika menghasilkan 16.4 tan pelepasan karbon setahun, dan purata Denmark menghasilkan 11 tan pelepasan karbon setahun. Akibatnya, model ChatGPT dilatih untuk mengeluarkan lebih banyak pelepasan karbon daripada 50 orang Denmark setiap tahun.

Pembekal pengkomputeran awan juga menyedari bahawa pusat data menggunakan sejumlah besar tenaga elektrik dan telah mengambil langkah untuk meningkatkan kecekapan, seperti membina dan mengendalikan pusat data di Artik untuk memanfaatkan tenaga boleh diperbaharui dan keadaan penyejukan semula jadi. Walau bagaimanapun, ini tidak mencukupi untuk memenuhi pertumbuhan pesat aplikasi AI.

Makmal Kebangsaan Lawrence Berkeley di Amerika Syarikat mendapati dalam penyelidikan bahawa peningkatan dalam kecekapan pusat data telah mengawal pertumbuhan penggunaan tenaga sejak 20 tahun lalu, tetapi penyelidikan menunjukkan bahawa langkah kecekapan tenaga semasa mungkin tidak mencukupi untuk memenuhi keperluan pusat data masa hadapan.

Industri kecerdasan buatan kini berada pada titik perubahan yang kritikal. Kemajuan teknologi dalam AI generatif, pengecaman imej dan analitik data mendedahkan sambungan dan kegunaan unik untuk pembelajaran mesin, tetapi penyelesaian teknologi yang dapat memenuhi keperluan ini terlebih dahulu perlu dibina kerana, menurut Gartner, melainkan pilihan yang lebih mampan, sebaliknya menjelang 2025 , AI akan menggunakan lebih banyak tenaga daripada aktiviti manusia.

Atas ialah kandungan terperinci berjaga-jaga! Krisis penggunaan tenaga yang disebabkan oleh letupan ChatGPT menimbulkan cabaran besar kepada pengendali pusat data. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1376

1376

52

52

ChatGPT kini membenarkan pengguna percuma menjana imej dengan menggunakan DALL-E 3 dengan had harian

Aug 09, 2024 pm 09:37 PM

ChatGPT kini membenarkan pengguna percuma menjana imej dengan menggunakan DALL-E 3 dengan had harian

Aug 09, 2024 pm 09:37 PM

DALL-E 3 telah diperkenalkan secara rasmi pada September 2023 sebagai model yang jauh lebih baik daripada pendahulunya. Ia dianggap sebagai salah satu penjana imej AI terbaik setakat ini, mampu mencipta imej dengan perincian yang rumit. Walau bagaimanapun, semasa pelancaran, ia adalah tidak termasuk

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Laman web ini melaporkan pada 27 Jun bahawa Jianying ialah perisian penyuntingan video yang dibangunkan oleh FaceMeng Technology, anak syarikat ByteDance Ia bergantung pada platform Douyin dan pada asasnya menghasilkan kandungan video pendek untuk pengguna platform tersebut Windows , MacOS dan sistem pengendalian lain. Jianying secara rasmi mengumumkan peningkatan sistem keahliannya dan melancarkan SVIP baharu, yang merangkumi pelbagai teknologi hitam AI, seperti terjemahan pintar, penonjolan pintar, pembungkusan pintar, sintesis manusia digital, dsb. Dari segi harga, yuran bulanan untuk keratan SVIP ialah 79 yuan, yuran tahunan ialah 599 yuan (nota di laman web ini: bersamaan dengan 49.9 yuan sebulan), langganan bulanan berterusan ialah 59 yuan sebulan, dan langganan tahunan berterusan ialah 499 yuan setahun (bersamaan dengan 41.6 yuan sebulan) . Di samping itu, pegawai yang dipotong juga menyatakan bahawa untuk meningkatkan pengalaman pengguna, mereka yang telah melanggan VIP asal

Samsung memperkenalkan SSD gred pusat data BM1743: dilengkapi dengan v7 QLC V-NAND dan menyokong PCIe 5.0

Jun 18, 2024 pm 04:15 PM

Samsung memperkenalkan SSD gred pusat data BM1743: dilengkapi dengan v7 QLC V-NAND dan menyokong PCIe 5.0

Jun 18, 2024 pm 04:15 PM

Menurut berita dari laman web ini pada 18 Jun, Samsung Semiconductor baru-baru ini memperkenalkan pemacu keadaan pepejal gred data pusat generasi seterusnya BM1743 dilengkapi dengan memori kilat QLC (v7) terbaharunya di blog teknologinya. ▲Samsung QLC pemacu keadaan pepejal gred data pusat BM1743 Menurut TrendForce pada bulan April, dalam bidang pemacu keadaan pepejal gred data pusat QLC, hanya Samsung dan Solidigm, anak syarikat SK Hynix, telah lulus pengesahan pelanggan perusahaan di masa itu. Berbanding dengan v5QLCV-NAND generasi sebelumnya (nota di tapak ini: Samsung v6V-NAND tidak mempunyai produk QLC), memori denyar Samsung v7QLCV-NAND telah hampir dua kali ganda bilangan lapisan susun, dan ketumpatan storan juga telah dipertingkatkan dengan banyak. Pada masa yang sama, kelancaran v7QLCV-NAND

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Editor |ScienceAI Question Answering (QA) set data memainkan peranan penting dalam mempromosikan penyelidikan pemprosesan bahasa semula jadi (NLP). Set data QA berkualiti tinggi bukan sahaja boleh digunakan untuk memperhalusi model, tetapi juga menilai dengan berkesan keupayaan model bahasa besar (LLM), terutamanya keupayaan untuk memahami dan menaakul tentang pengetahuan saintifik. Walaupun pada masa ini terdapat banyak set data QA saintifik yang meliputi bidang perubatan, kimia, biologi dan bidang lain, set data ini masih mempunyai beberapa kekurangan. Pertama, borang data adalah agak mudah, kebanyakannya adalah soalan aneka pilihan. Ia mudah dinilai, tetapi mengehadkan julat pemilihan jawapan model dan tidak dapat menguji sepenuhnya keupayaan model untuk menjawab soalan saintifik. Sebaliknya, Soal Jawab terbuka

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Editor |. KX Dalam bidang penyelidikan dan pembangunan ubat, meramalkan pertalian pengikatan protein dan ligan dengan tepat dan berkesan adalah penting untuk pemeriksaan dan pengoptimuman ubat. Walau bagaimanapun, kajian semasa tidak mengambil kira peranan penting maklumat permukaan molekul dalam interaksi protein-ligan. Berdasarkan ini, penyelidik dari Universiti Xiamen mencadangkan rangka kerja pengekstrakan ciri berbilang mod (MFE) novel, yang buat pertama kalinya menggabungkan maklumat mengenai permukaan protein, struktur dan jujukan 3D, dan menggunakan mekanisme perhatian silang untuk membandingkan ciri modaliti yang berbeza penjajaran. Keputusan eksperimen menunjukkan bahawa kaedah ini mencapai prestasi terkini dalam meramalkan pertalian mengikat protein-ligan. Tambahan pula, kajian ablasi menunjukkan keberkesanan dan keperluan maklumat permukaan protein dan penjajaran ciri multimodal dalam rangka kerja ini. Penyelidikan berkaitan bermula dengan "S

Meletakkan pasaran seperti AI, GlobalFoundries memperoleh teknologi gallium nitrida Tagore Technology dan pasukan berkaitan

Jul 15, 2024 pm 12:21 PM

Meletakkan pasaran seperti AI, GlobalFoundries memperoleh teknologi gallium nitrida Tagore Technology dan pasukan berkaitan

Jul 15, 2024 pm 12:21 PM

Menurut berita dari laman web ini pada 5 Julai, GlobalFoundries mengeluarkan kenyataan akhbar pada 1 Julai tahun ini, mengumumkan pemerolehan teknologi power gallium nitride (GaN) Tagore Technology dan portfolio harta intelek, dengan harapan dapat mengembangkan bahagian pasarannya dalam kereta dan Internet of Things dan kawasan aplikasi pusat data kecerdasan buatan untuk meneroka kecekapan yang lebih tinggi dan prestasi yang lebih baik. Memandangkan teknologi seperti AI generatif terus berkembang dalam dunia digital, galium nitrida (GaN) telah menjadi penyelesaian utama untuk pengurusan kuasa yang mampan dan cekap, terutamanya dalam pusat data. Laman web ini memetik pengumuman rasmi bahawa semasa pengambilalihan ini, pasukan kejuruteraan Tagore Technology akan menyertai GLOBALFOUNDRIES untuk membangunkan lagi teknologi gallium nitride. G

SK Hynix akan memaparkan produk berkaitan AI baharu pada 6 Ogos: HBM3E 12 lapisan, NAND 321 tinggi, dsb.

Aug 01, 2024 pm 09:40 PM

SK Hynix akan memaparkan produk berkaitan AI baharu pada 6 Ogos: HBM3E 12 lapisan, NAND 321 tinggi, dsb.

Aug 01, 2024 pm 09:40 PM

Menurut berita dari laman web ini pada 1 Ogos, SK Hynix mengeluarkan catatan blog hari ini (1 Ogos), mengumumkan bahawa ia akan menghadiri Global Semiconductor Memory Summit FMS2024 yang akan diadakan di Santa Clara, California, Amerika Syarikat dari 6 hingga 8 Ogos, mempamerkan banyak produk penjanaan teknologi baru. Pengenalan kepada Sidang Kemuncak Memori dan Penyimpanan Masa Depan (FutureMemoryandStorage), dahulunya Sidang Kemuncak Memori Flash (FlashMemorySummit) terutamanya untuk pembekal NAND, dalam konteks peningkatan perhatian kepada teknologi kecerdasan buatan, tahun ini dinamakan semula sebagai Sidang Kemuncak Memori dan Penyimpanan Masa Depan (FutureMemoryandStorage) kepada jemput vendor DRAM dan storan serta ramai lagi pemain. Produk baharu SK hynix dilancarkan tahun lepas

SearchGPT: Open AI mengambil alih Google dengan enjin carian AInya sendiri

Jul 30, 2024 am 09:58 AM

SearchGPT: Open AI mengambil alih Google dengan enjin carian AInya sendiri

Jul 30, 2024 am 09:58 AM

Open AI akhirnya membuat cariannya. Syarikat San Francisco baru-baru ini telah mengumumkan alat AI baharu dengan keupayaan carian. Pertama kali dilaporkan oleh The Information pada Februari tahun ini, alat baharu ini dipanggil SearchGPT dan menampilkan c