Peranti teknologi

Peranti teknologi

AI

AI

Ada betul-betul ResNet dalam otak! 'Drosophila Brain Connectome' pertama di dunia dikeluarkan: mengambil masa lebih sepuluh tahun untuk membina semula 3,000 neuron dan lebih daripada 500,000 sinaps!

Ada betul-betul ResNet dalam otak! 'Drosophila Brain Connectome' pertama di dunia dikeluarkan: mengambil masa lebih sepuluh tahun untuk membina semula 3,000 neuron dan lebih daripada 500,000 sinaps!

Ada betul-betul ResNet dalam otak! 'Drosophila Brain Connectome' pertama di dunia dikeluarkan: mengambil masa lebih sepuluh tahun untuk membina semula 3,000 neuron dan lebih daripada 500,000 sinaps!

Walaupun pembelajaran mendalam moden telah lama memisahkan diri daripada meniru "rangkaian saraf biologi", memahami mekanisme operasi otak biologi masih sangat membantu untuk pembangunan model rangkaian saraf pada masa hadapan.

Cara litar otak distruktur mempengaruhi keupayaan pengiraan otak, tetapi setakat ini, tiada struktur khusus otak telah dilihat kecuali dalam beberapa organisma yang sangat mudah.

Pada November tahun lalu, penyelidik dari banyak institusi terkemuka seperti Universiti Cambridge, Universiti Johns Hopkins dan Janelia Research Park telah memuat naik kertas kerja tentang Biorxiv 🎜>Lebih sepuluh tahun penyelidikan yang teliti menghasilkan selesai pembinaan semula yang pertama sambungan otak "larva Drosophila".

Pautan kertas: https://www.science.org/doi/10.1126/science add9330

Pada 10 Mac, keputusan yang berkaitan telah diterbitkan dalam majalah "Sains".

Salah seorang pengarang kertas kerja, profesor bersekutu Joshua Vogelstein dari Universiti Johns Hopkins, berkata bahawa lalat buah lebih dekat dengan otak manusia dalam banyak cara berbanding organisma lain, dan beberapa kawasan sepadan. untuk membuat keputusan Beberapa bidang sepadan dengan pembelajaran dan beberapa untuk navigasi; dan otak larva dan manusia Drosophila juga dibahagikan kepada bahagian kiri dan kanan.

Dalam analisis otak lalat buah, kita juga boleh menemui beberapa keputusan dalam rangkaian saraf moden, seperti rangkaian saraf berulang dan laluan pintasan antara rangkaian berbilang lapisan (rangkaian sisa ResNet) dsb., boleh memberi inspirasi kepada penambahbaikan pada model pembelajaran mesin.

Berita baik: Sambungan otak larva Drosophila yang dibina semula termasuk 3016 neuron

Berita buruk: Manusia mempunyai 86 bilion neuron.

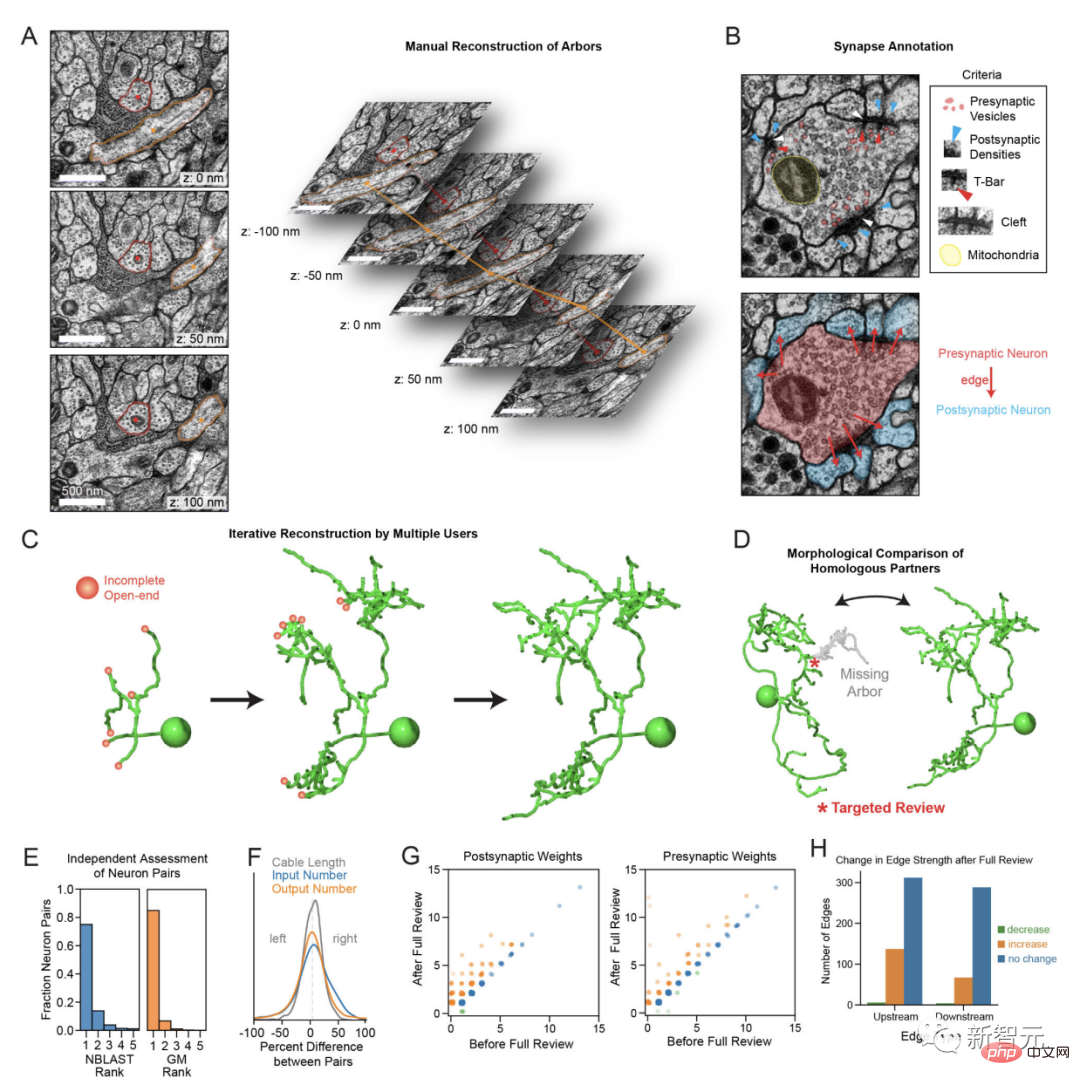

Otak larva Drosophila yang dibina semula sepenuhnyaOtak terutamanya terdiri daripada "sel neuron", dan neuron bersebelahan boleh berinteraksi antara satu sama lain pada sambungan antara sel sinaptik Untuk menghantar keluar isyarat, satu neuron melepaskan "neurotransmitter" dan neuron lain bertanggungjawab untuk menerima bahan kimia ini tingkah laku. Proses utama untuk membina semula connectome ialah memotong otak menjadi kepingan ultra-nipis (20 mikron), dan kemudian menggunakan aliran elektron mikroskop elektron untuk imej kepingan, seperti sebagai

Otak larva lalat buah sebesar sebutir garamdipotong menjadi beribu-ribu keping dan jika ada yang tidak kena, anda perlu bermula dari awal lagi.

Tetapi setakat ini, penyelidik telah memetakan sambungan sinaptik lengkap untuk hanya tiga organisma, masing-masing dengan hanya beberapa ratus neuron otak.

Pada tahun 2020, penyelidik dari Google dan Janelia Research Park mengeluarkan model 3D penyambung otak Drosophila, yang mengandungi 25,000 neuron Drosophila Menjangkau pelbagai jenis sel dan berbilang kawasan otak, model itu tidak otak yang lengkap, malah ia mengandungi hanya satu perempat daripada 100,000 neuron dalam lalat buah dewasa.

Terdapat juga beberapa kumpulan penyelidikan yang mengkaji penghubung haiwan dengan otak yang lebih besar, seperti serangga, ikan, mamalia, dll. Namun, disebabkan bilangan neuron yang banyak, kaedah penyelidikan utama adalah dengan membahagikan otak. Mempelajarinya secara berasingan mengakibatkan ketidakupayaan untuk membina semula kawasan otak yang saling berkaitan merentasi ruang.

Sambungan lengkap yang dibina semula kali ini adalah milik larva Drosophila melanogaster boleh memaparkan tingkah laku yang sangat kaya, termasuk pembelajaran, pengiraan nilai dan pemilihan tingkah laku, dan berkait rapat dengan buah dewasa. lalat dan serangga yang lebih besar mempunyai struktur otak yang homolog.

Alat genetik yang berkuasa boleh digunakan untuk memanipulasi atau merekod jenis neuron individu secara selektif dalam sistem model yang boleh dikendalikan, hipotesis tentang peranan fungsian motif neuron dan litar tertentu yang didedahkan oleh connectome boleh diuji dengan mudah.

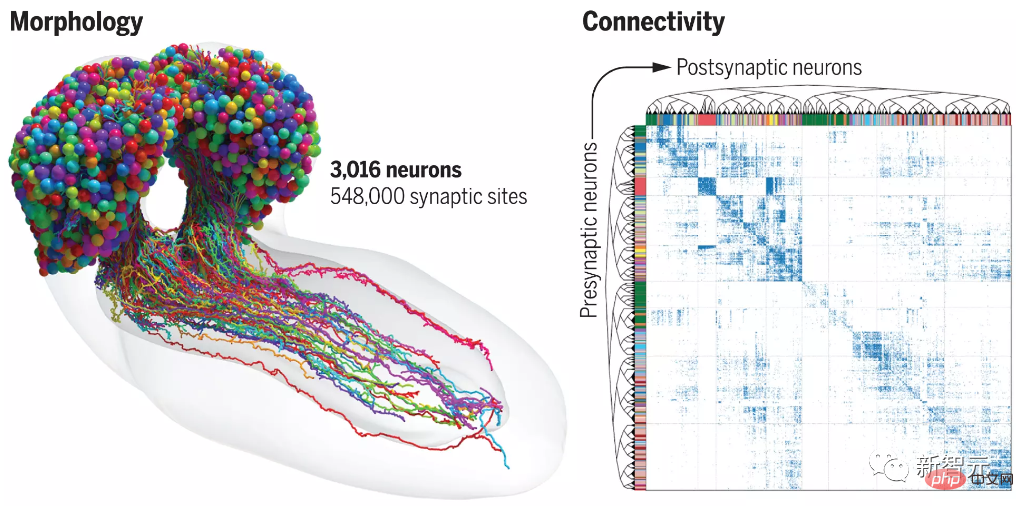

Pasukan penyelidik memotong otak larva Drosophila melanogaster "6 jam" kepada 4841 keping, mengimbasnya dengan mikroskop elektron resolusi tinggi, mendigitalkan imej dan kemudian memasang semula ia menjadi imej tiga dimensi dengan bantuan analisis komputer, peta akhir mengandungi 3,016 neuron dan 548,000 sinaps.

Rangkaian sisa tersembunyi di dalamnya

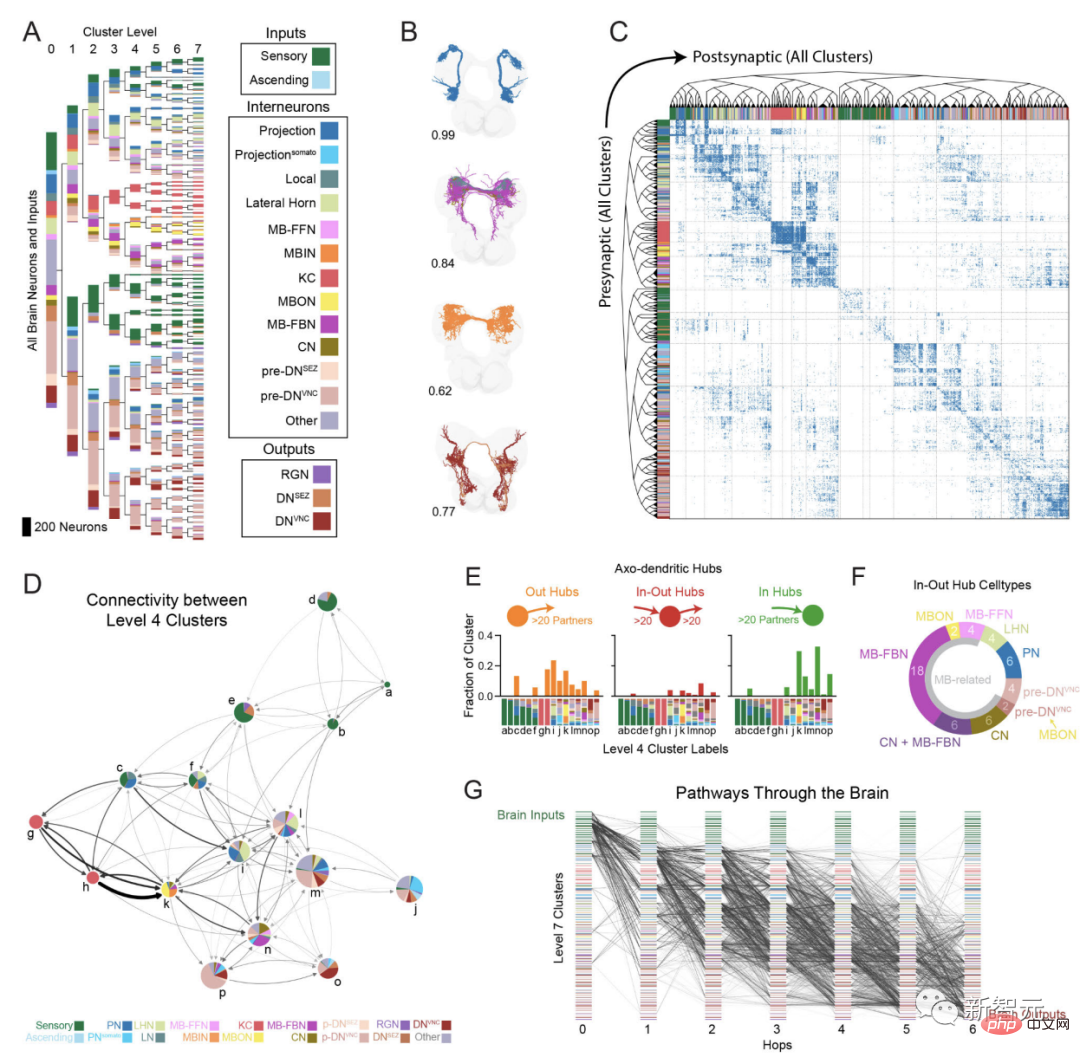

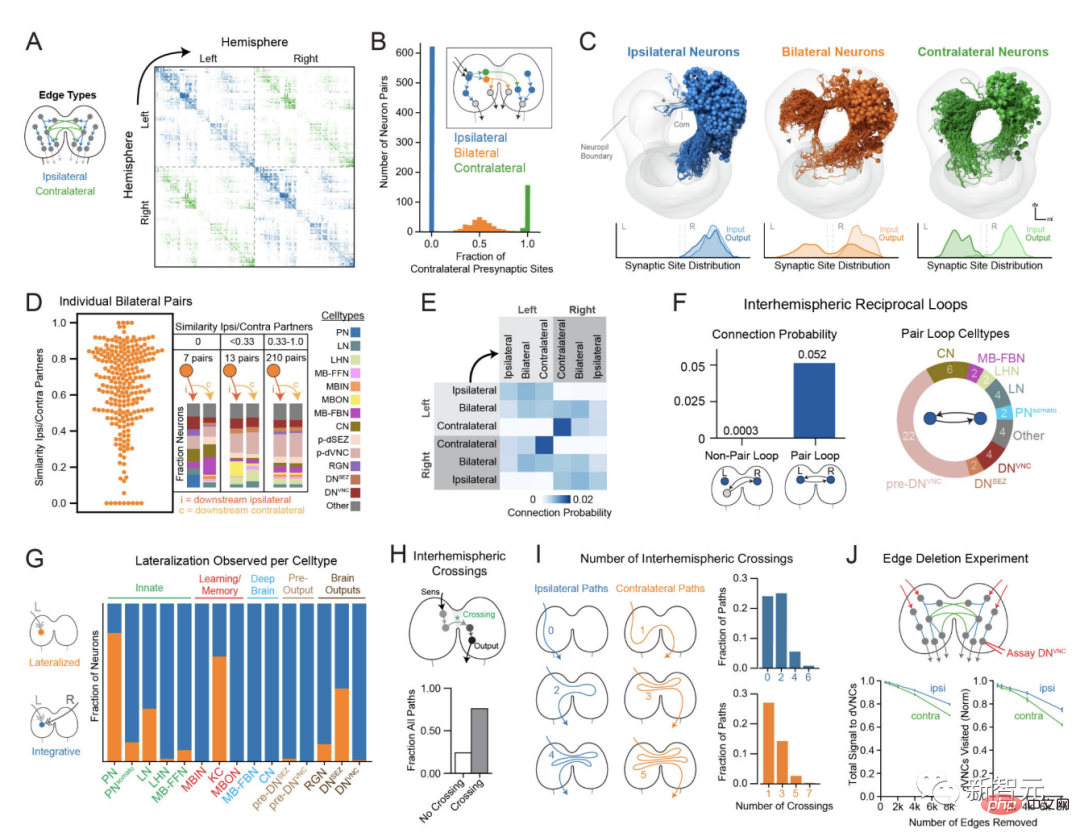

Para penyelidik menjalankan analisis terperinci tentang struktur litar otak, termasuk sambungan dan jenis neuron, hab rangkaian ) dan rajah litar saraf .

Kebanyakan (73%) daripada hab input dan output otak (hab in-out) ialah "pusat pasca sinaptik untuk pusat pembelajaran" atau "neuron dopaminergik yang mendorong pembelajaran" "presynaptic pusat"; menggunakan teknologi pembenaman spektrum graf untuk mengelompokkan neuron secara hierarki berdasarkan ketersambungan sinaptik kepada 93 jenis yang konsisten secara dalaman berdasarkan ciri lain seperti morfologi dan fungsi jantina.

Para penyelidik juga membangunkan algoritma untuk menjejaki perambatan isyarat dalam laluan berbilang sinaptik otak dan menganalisis laluan hadapan (daripada deria kepada output) dan laluan maklum balas , penyepaduan berbilang deria dan interaksi merentas hemisfera .

Integrasi multideria yang meluas ditemui di dalam otak, dan pada kedalaman yang berbeza-beza dari neuron deria kepada neuron keluaran Berbilang laluan saling berkait terbentuk rangkaian pemprosesan teragih.

Otak mempunyai struktur berulang yang sangat tinggi, dan 41% daripada neuron menerima input berulang jarak jauh Walau bagaimanapun, pengedaran gelung tidak seragam, dan kadar gelung sangat tinggi bidang yang melibatkan pembelajaran dan pemilihan tindakan yang tinggi.

Neuron dopaminergik, yang mendorong pembelajaran, adalah antara neuron yang paling biasa di dalam otak.

Terdapat banyak neuron kontralateral (neuron kontralateral) yang mengunjur ke kedua-dua hemisfera otak, dan ia berada di- dan hab keluar), sinaps antara satu sama lain, menggalakkan komunikasi yang meluas antara dua hemisfera otak juga menganalisis interaksi antara otak dan saraf;

Penyelidik mendapati bahawa neuron menurun menyasarkan sekumpulan kecil elemen pramotor, yang memainkan peranan penting dalam menukar keadaan lokomotor.

Kesimpulan

Sambungan otak lengkap larva Drosophila akan menyediakan asas untuk kajian teori dan eksperimen lain tentang fungsi otak untuk masa yang lama akan datang, yang dihasilkan dalam kajian ini Kaedah dan alat pengiraan akan memudahkan analisis sambungan masa hadapan.

Walaupun butiran organisasi otak berbeza-beza di seluruh alam haiwan, banyak struktur litar saraf dipelihara.

Apabila penyambung otak bagi lebih banyak organisma lain dipetakan pada masa hadapan, perbandingan antara penyambung yang berbeza akan mendedahkan struktur litar biasa dan berpotensi optimum, serta antara organisma Perbezaan tingkah laku dalam sifat.

Beberapa ciri struktur yang diperhatikan dalam otak larva Drosophila, termasuk pintasan berbilang lapisan dan gelung bersarang yang ketara, dapat Penemuan dalam rangkaian saraf tiruan lanjutan mungkin dapat menampung masalah rangkaian semasa secara mendalam dan generalisasi tugas pemprosesan. Ciri-ciri ini juga boleh meningkatkan kuasa pengkomputeran otak dan mengatasi had fisiologi bilangan neuron.

Analisis masa hadapan tentang persamaan dan perbezaan antara otak dan rangkaian saraf tiruan boleh membantu memahami prinsip pengiraan otak dan boleh memberi inspirasi kepada seni bina pembelajaran mesin baharu.

Komen berkaitan

Gashpal Yekayi, profesor neurosains di University of Exeter, UK, berkata , semua neuron otak dibina semula dan semua sambungan saraf dianalisis. Dia memanggil kerja itu "sangat penting."

Catherine Dulac dari Universiti Harvard di Amerika Syarikat percaya bahawa data ini mendedahkan "logik mendalam" hubungan neuron ini.

Walau bagaimanapun, Scott Emmons dari Kolej Perubatan Albert Einstein di New York percaya bahawa hanya memetakan sinaps tidak memberikan gambaran penuh.

Emmons memetakan connectome Caenorhabditis elegans lelaki dan perempuan pada 2019. Neuron juga boleh berkomunikasi melalui bahan kimia yang dikeluarkan secara perlahan seperti hormon dan sambungan lain antara sel (iaitu persimpangan celah) berkomunikasi antara satu sama lain.

Semua ini mesti diambil kira, tetapi hanya sinaps disertakan dalam connectome yang baru dilukis.

Atas ialah kandungan terperinci Ada betul-betul ResNet dalam otak! 'Drosophila Brain Connectome' pertama di dunia dikeluarkan: mengambil masa lebih sepuluh tahun untuk membina semula 3,000 neuron dan lebih daripada 500,000 sinaps!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1376

1376

52

52

Menyelam mendalam ke dalam model, data dan rangka kerja: tinjauan menyeluruh 54 halaman model bahasa besar yang cekap

Jan 14, 2024 pm 07:48 PM

Menyelam mendalam ke dalam model, data dan rangka kerja: tinjauan menyeluruh 54 halaman model bahasa besar yang cekap

Jan 14, 2024 pm 07:48 PM

Model bahasa berskala besar (LLM) telah menunjukkan keupayaan yang menarik dalam banyak tugas penting, termasuk pemahaman bahasa semula jadi, penjanaan bahasa dan penaakulan yang kompleks, dan telah memberi kesan yang mendalam kepada masyarakat. Walau bagaimanapun, keupayaan cemerlang ini memerlukan sumber latihan yang ketara (ditunjukkan di sebelah kiri) dan masa inferens yang panjang (ditunjukkan di sebelah kanan). Oleh itu, penyelidik perlu membangunkan cara teknikal yang berkesan untuk menyelesaikan masalah kecekapan mereka. Di samping itu, seperti yang dapat dilihat dari sebelah kanan rajah, beberapa LLM (Model Bahasa) yang cekap seperti Mistral-7B telah berjaya digunakan dalam reka bentuk dan penggunaan LLM. LLM yang cekap ini boleh mengurangkan memori inferens dengan ketara sambil mengekalkan ketepatan yang serupa dengan LLaMA1-33B

YOLO adalah abadi! YOLOv9 dikeluarkan: prestasi dan kelajuan SOTA~

Feb 26, 2024 am 11:31 AM

YOLO adalah abadi! YOLOv9 dikeluarkan: prestasi dan kelajuan SOTA~

Feb 26, 2024 am 11:31 AM

Kaedah pembelajaran mendalam hari ini memberi tumpuan kepada mereka bentuk fungsi objektif yang paling sesuai supaya keputusan ramalan model paling hampir dengan situasi sebenar. Pada masa yang sama, seni bina yang sesuai mesti direka bentuk untuk mendapatkan maklumat yang mencukupi untuk ramalan. Kaedah sedia ada mengabaikan fakta bahawa apabila data input mengalami pengekstrakan ciri lapisan demi lapisan dan transformasi spatial, sejumlah besar maklumat akan hilang. Artikel ini akan menyelidiki isu penting apabila menghantar data melalui rangkaian dalam, iaitu kesesakan maklumat dan fungsi boleh balik. Berdasarkan ini, konsep maklumat kecerunan boleh atur cara (PGI) dicadangkan untuk menghadapi pelbagai perubahan yang diperlukan oleh rangkaian dalam untuk mencapai pelbagai objektif. PGI boleh menyediakan maklumat input lengkap untuk tugas sasaran untuk mengira fungsi objektif, dengan itu mendapatkan maklumat kecerunan yang boleh dipercayai untuk mengemas kini berat rangkaian. Di samping itu, rangka kerja rangkaian ringan baharu direka bentuk

'Pemilik Bilibili UP berjaya mencipta rangkaian neural berasaskan batu merah pertama di dunia, yang menyebabkan sensasi di media sosial dan dipuji oleh Yann LeCun.'

May 07, 2023 pm 10:58 PM

'Pemilik Bilibili UP berjaya mencipta rangkaian neural berasaskan batu merah pertama di dunia, yang menyebabkan sensasi di media sosial dan dipuji oleh Yann LeCun.'

May 07, 2023 pm 10:58 PM

Dalam Minecraft, batu merah adalah item yang sangat penting. Ia adalah bahan unik dalam permainan Suis, obor batu merah, dan blok batu merah boleh memberikan tenaga seperti elektrik kepada wayar atau objek. Litar Redstone boleh digunakan untuk membina struktur untuk anda mengawal atau mengaktifkan jentera lain Ia sendiri boleh direka bentuk untuk bertindak balas kepada pengaktifan manual oleh pemain, atau mereka boleh mengeluarkan isyarat berulang kali atau bertindak balas kepada perubahan yang disebabkan oleh bukan pemain, seperti pergerakan makhluk. dan item Jatuh, pertumbuhan tumbuhan, siang dan malam, dan banyak lagi. Oleh itu, dalam dunia saya, redstone boleh mengawal pelbagai jenis jentera, daripada jentera ringkas seperti pintu automatik, suis lampu dan bekalan kuasa strob, kepada lif besar, ladang automatik, platform permainan kecil dan juga komputer binaan dalam permainan . Baru-baru ini, stesen B UP utama @

Berbilang laluan, berbilang domain, merangkumi semua! Google AI mengeluarkan model am pembelajaran berbilang domain MDL

May 28, 2023 pm 02:12 PM

Berbilang laluan, berbilang domain, merangkumi semua! Google AI mengeluarkan model am pembelajaran berbilang domain MDL

May 28, 2023 pm 02:12 PM

Model pembelajaran mendalam untuk tugas penglihatan (seperti klasifikasi imej) biasanya dilatih hujung ke hujung dengan data daripada domain visual tunggal (seperti imej semula jadi atau imej yang dijana komputer). Secara amnya, aplikasi yang menyelesaikan tugas penglihatan untuk berbilang domain perlu membina berbilang model untuk setiap domain yang berasingan dan melatihnya secara berasingan Data tidak dikongsi antara domain yang berbeza, setiap model akan mengendalikan data input tertentu. Walaupun ia berorientasikan kepada bidang yang berbeza, beberapa ciri lapisan awal antara model ini adalah serupa, jadi latihan bersama model ini adalah lebih cekap. Ini mengurangkan kependaman dan penggunaan kuasa, dan mengurangkan kos memori untuk menyimpan setiap parameter model Pendekatan ini dipanggil pembelajaran berbilang domain (MDL). Selain itu, model MDL juga boleh mengatasi prestasi tunggal

Menghancurkan H100, GPU generasi seterusnya Nvidia didedahkan! Reka bentuk modul berbilang cip 3nm pertama, diperkenalkan pada 2024

Sep 30, 2023 pm 12:49 PM

Menghancurkan H100, GPU generasi seterusnya Nvidia didedahkan! Reka bentuk modul berbilang cip 3nm pertama, diperkenalkan pada 2024

Sep 30, 2023 pm 12:49 PM

Proses 3nm, prestasi melepasi H100! Baru-baru ini, media asing DigiTimes mengumumkan bahawa Nvidia sedang membangunkan GPU generasi akan datang, B100, dengan nama kod "Blackwell" Dikatakan bahawa sebagai produk untuk aplikasi kecerdasan buatan (AI) dan pengkomputeran berprestasi tinggi (HPC). , B100 akan menggunakan proses proses 3nm TSMC, serta reka bentuk modul berbilang cip (MCM) yang lebih kompleks, dan akan muncul pada suku keempat 2024. Bagi Nvidia, yang memonopoli lebih daripada 80% pasaran GPU kecerdasan buatan, ia boleh menggunakan B100 untuk menyerang semasa seterika panas dan seterusnya menyerang pencabar seperti AMD dan Intel dalam gelombang penggunaan AI ini. Menurut anggaran NVIDIA, menjelang 2027, nilai output medan ini dijangka mencapai lebih kurang

1.3ms mengambil masa 1.3ms! Seni bina rangkaian neural mudah alih sumber terbuka terbaru Tsinghua RepViT

Mar 11, 2024 pm 12:07 PM

1.3ms mengambil masa 1.3ms! Seni bina rangkaian neural mudah alih sumber terbuka terbaru Tsinghua RepViT

Mar 11, 2024 pm 12:07 PM

Alamat kertas: https://arxiv.org/abs/2307.09283 Alamat kod: https://github.com/THU-MIG/RepViTRepViT berprestasi baik dalam seni bina ViT mudah alih dan menunjukkan kelebihan yang ketara. Seterusnya, kami meneroka sumbangan kajian ini. Disebutkan dalam artikel bahawa ViT ringan biasanya berprestasi lebih baik daripada CNN ringan pada tugas visual, terutamanya disebabkan oleh modul perhatian diri berbilang kepala (MSHA) mereka yang membolehkan model mempelajari perwakilan global. Walau bagaimanapun, perbezaan seni bina antara ViT ringan dan CNN ringan belum dikaji sepenuhnya. Dalam kajian ini, penulis menyepadukan ViT ringan ke dalam yang berkesan

Semakan paling komprehensif tentang model besar multimodal ada di sini! 7 penyelidik Microsoft bekerjasama bersungguh-sungguh, 5 tema utama, 119 halaman dokumen

Sep 25, 2023 pm 04:49 PM

Semakan paling komprehensif tentang model besar multimodal ada di sini! 7 penyelidik Microsoft bekerjasama bersungguh-sungguh, 5 tema utama, 119 halaman dokumen

Sep 25, 2023 pm 04:49 PM

Kajian yang paling komprehensif tentang model besar berbilang mod ada di sini! Ditulis oleh 7 penyelidik Cina di Microsoft, ia mempunyai 119 halaman - ia bermula daripada dua jenis arahan penyelidikan model besar berbilang modal yang telah selesai dan masih berada di barisan hadapan, dan meringkaskan secara komprehensif lima topik penyelidikan khusus: pemahaman visual dan penjanaan visual Ejen berbilang modal model besar berbilang modal yang disokong oleh model visual bersatu LLM memfokuskan pada fenomena: model asas berbilang modal telah beralih daripada khusus kepada universal. Ps. Inilah sebabnya penulis melukis secara langsung imej Doraemon pada permulaan kertas. Siapa yang patut membaca ulasan (laporan) ini? Dalam kata-kata asal Microsoft: Selagi anda berminat untuk mempelajari pengetahuan asas dan kemajuan terkini model asas pelbagai mod, sama ada anda seorang penyelidik profesional atau pelajar, kandungan ini sangat sesuai untuk anda berkumpul.

Penyesuai I2V daripada komuniti SD: tiada konfigurasi diperlukan, pasang dan main, serasi sempurna dengan pemalam video Tusheng

Jan 15, 2024 pm 07:48 PM

Penyesuai I2V daripada komuniti SD: tiada konfigurasi diperlukan, pasang dan main, serasi sempurna dengan pemalam video Tusheng

Jan 15, 2024 pm 07:48 PM

Tugas penjanaan imej-ke-video (I2V) merupakan satu cabaran dalam bidang penglihatan komputer yang bertujuan untuk menukar imej statik kepada video dinamik. Kesukaran tugas ini adalah untuk mengekstrak dan menjana maklumat dinamik dalam dimensi temporal daripada imej tunggal sambil mengekalkan keaslian dan keselarasan visual kandungan imej. Kaedah I2V sedia ada selalunya memerlukan seni bina model yang kompleks dan sejumlah besar data latihan untuk mencapai matlamat ini. Baru-baru ini, hasil penyelidikan baharu "I2V-Adapter: AGeneralImage-to-VideoAdapter for VideoDiffusionModels" yang diketuai oleh Kuaishou telah dikeluarkan. Kajian ini memperkenalkan kaedah penukaran imej-ke-video yang inovatif dan mencadangkan modul penyesuai ringan, i.e.