Peranti teknologi

Peranti teknologi

AI

AI

Model bersatu AIGC ada di sini! Pasukan yang diasaskan oleh Huang Xutao, pemimpin dalam industri CV, mencadangkan 'Penyebaran Yang Maha Kuasa'

Model bersatu AIGC ada di sini! Pasukan yang diasaskan oleh Huang Xutao, pemimpin dalam industri CV, mencadangkan 'Penyebaran Yang Maha Kuasa'

Model bersatu AIGC ada di sini! Pasukan yang diasaskan oleh Huang Xutao, pemimpin dalam industri CV, mencadangkan 'Penyebaran Yang Maha Kuasa'

Kemajuan terkini dalam model penyebaran menetapkan pencapaian yang mengagumkan dalam banyak tugas generatif. Karya menarik seperti DALL·E 2, Imagen dan Stable Diffusion (SD) telah menimbulkan minat yang besar dalam bidang akademik dan industri.

Walau bagaimanapun, walaupun model ini berprestasi hebat, ia pada asasnya tertumpu pada jenis tugasan tertentu, seperti menjana imej daripada teks yang diberikan Untuk jenis tugasan yang berbeza, ia selalunya perlu Latihan khusus sahaja, atau membina model baharu dari awal.

Jadi bolehkah kita mencipta Resapan "seluruh" berdasarkan yang sebelumnya untuk mencapai penyatuan model AIGC? Sesetengah orang cuba meneroka ke arah ini dan telah membuat kemajuan.

Pasukan bersama dari University of Illinois di Urbana-Champaign dan University of Texas di Austin ini cuba memperluaskan Penyebaran satu aliran sedia ada ke dalam rangkaian berbilang aliran, yang dipanggil Versatile Diffusion (VD), rangka kerja resapan berbilang aliran bersatu pertama dan satu langkah ke arah kecerdasan buatan generatif umum.

Alamat kertas: https://arxiv.org/abs/2211.08332

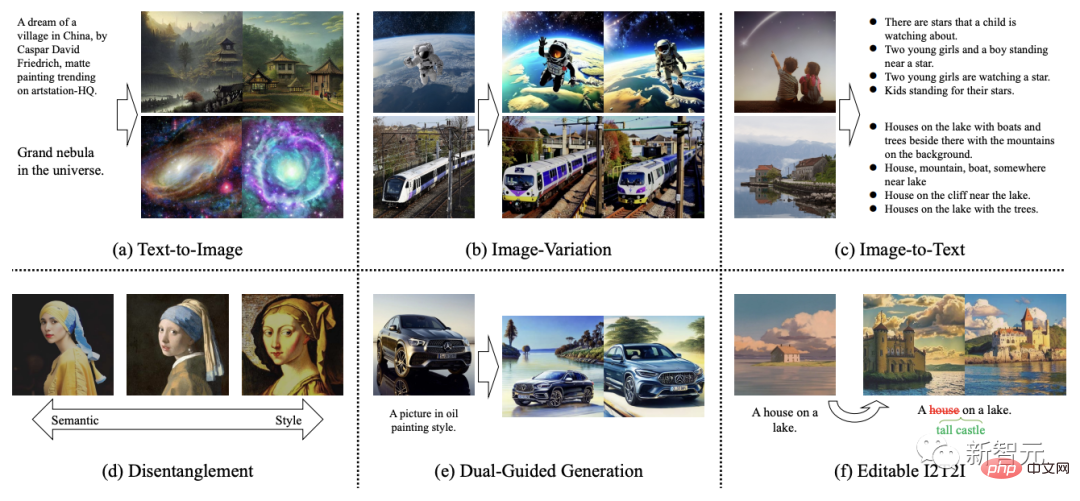

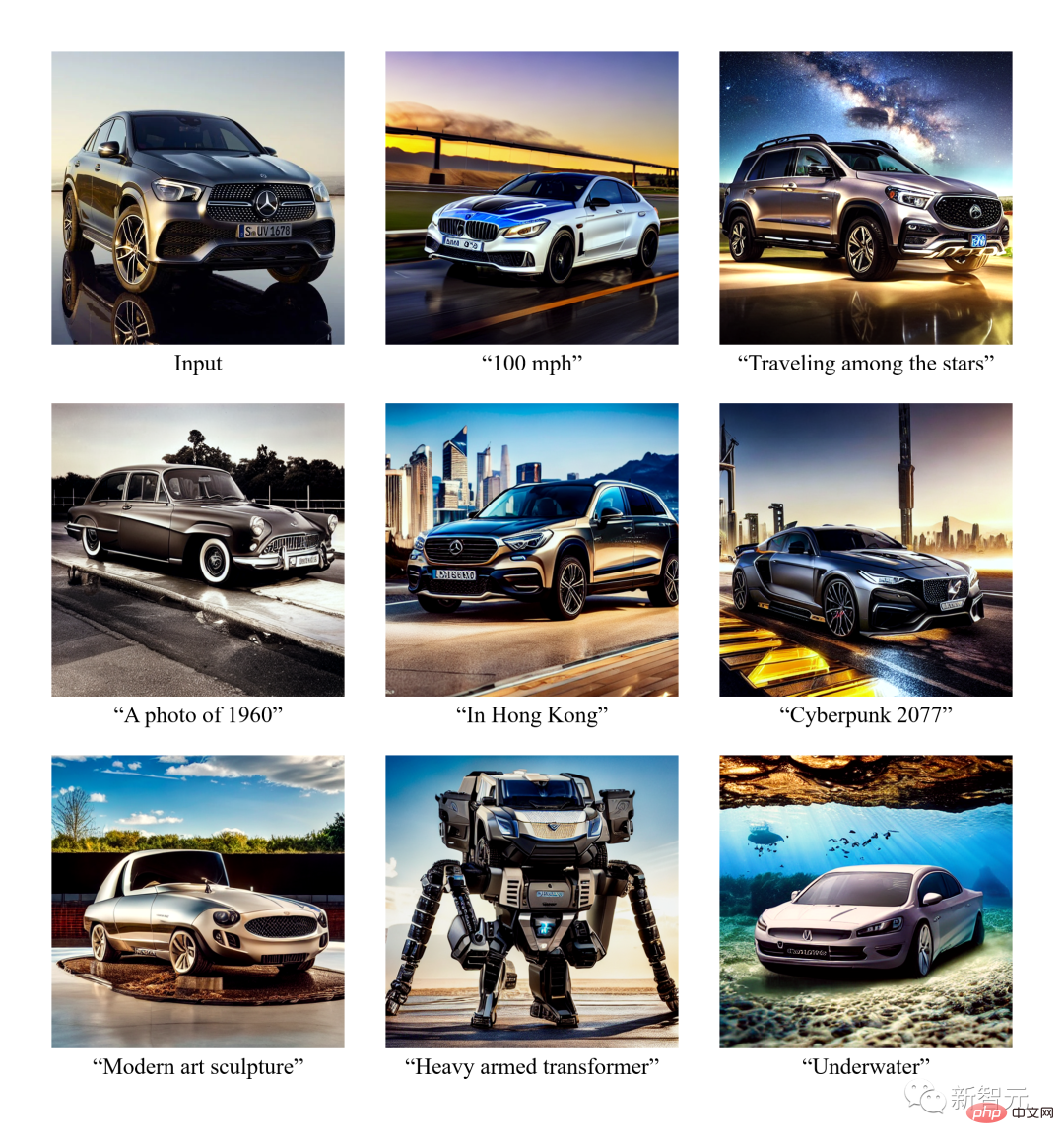

Sebagai tambahan kepada fungsi penjanaan teks biasa, Resapan Serbaguna juga boleh memasukkan imej untuk menghasilkan imej yang serupa, memasukkan imej untuk menjana teks, memasukkan teks untuk menghasilkan teks yang serupa, penyuntingan penyahgandingan semantik imej, memasukkan imej dan Jana video daripada teks, edit kandungan imej berdasarkan ruang terpendam dan banyak lagi.

Versi akan datang juga akan menyokong lebih banyak mod seperti suara, muzik, video dan 3D.

Menurut kertas kerja, telah terbukti bahawa VD dan rangka kerja asasnya mempunyai kelebihan berikut:

a) Ia boleh digunakan dengan kualiti tinggi yang kompetitif Memproses semua subtugas.

b) Sokong sambungan dan aplikasi baharu, seperti pengasingan gaya grafik dan semantik, penjanaan panduan dwi teks imej, dsb.

c) Percubaan dan aplikasi ini memberikan cerapan semantik yang lebih kaya ke dalam output yang dijana.

Dari segi set data latihan, VD menggunakan Laion2B-en dengan penapis data tersuai sebagai set data utama.

Penemuan menarik daripada penerokaan pertama

VD ialah ia boleh meningkatkan atau mengurangkan gaya imej daripada semantik tanpa pengawasan lanjut.

Fenomena sebegini memberi inspirasi kepada pengarang untuk meneroka bidang baharu sepenuhnya, di mana pemisahan antara gaya dan semantik boleh berlaku untuk imej dengan gaya sewenang-wenang dan kandungan sewenang-wenangnya.

Pengarang menyatakan bahawa mereka adalah orang pertama yang meneroka: a) mentafsir semantik dan gaya imej semula jadi tanpa spesifikasi domain b) model resapan ruang terpendam Pasukan penguraian semantik dan gaya.

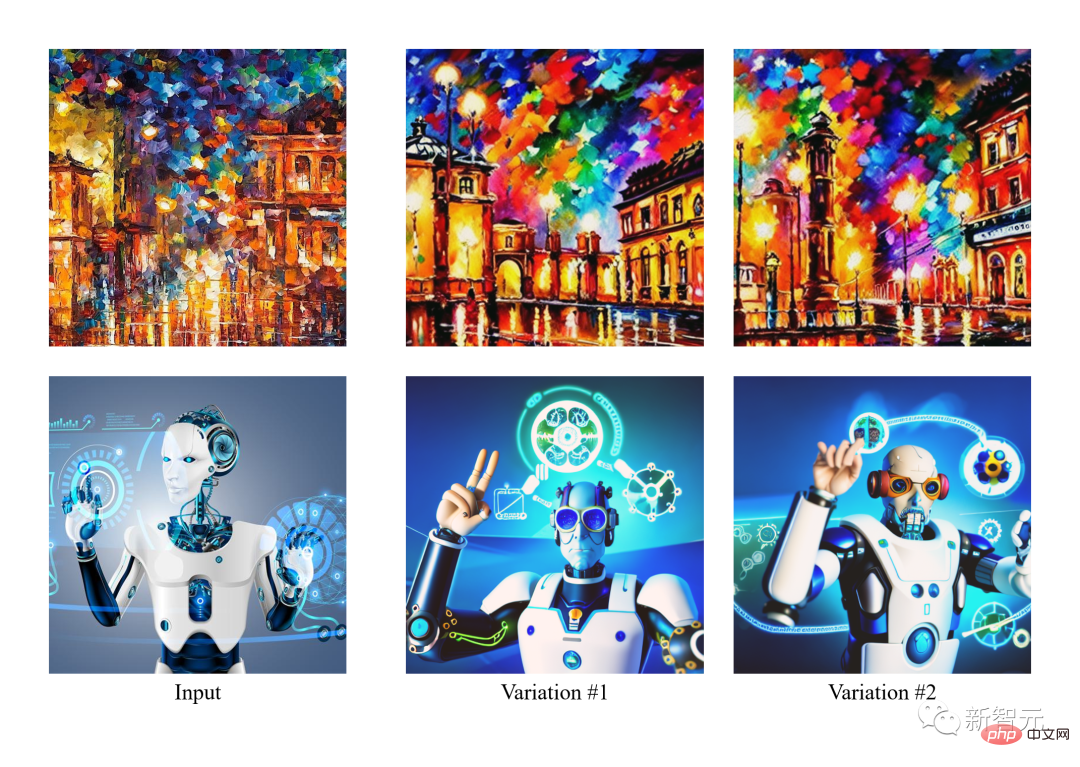

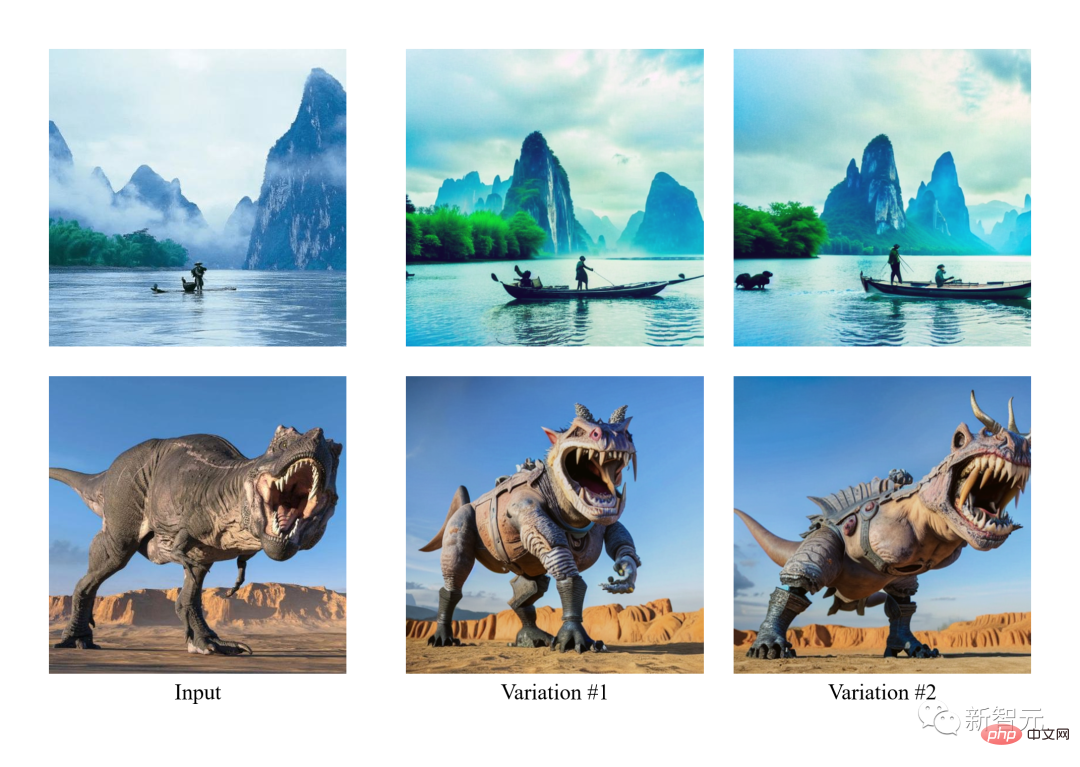

Dalam imej di bawah, pengarang mula-mula menjana varian imej input dan kemudian memanipulasinya dengan fokus semantik (kiri) atau gaya (kanan).

Memandangkan VD menyokong kedua-dua imej ke teks dan teks ke imej, pasukan pengarang cuba mengedit dari perspektif gesaan teks buat kali pertama dengan mengikuti langkah-langkah di bawah Imej: a) Tukar imej kepada teks, b) Edit teks, c) Tukar teks kembali kepada imej.

Dalam percubaan, pengarang mengalih keluar kandungan yang diterangkan daripada imej dan kemudian menambah kandungan baharu menggunakan paradigma imej-teks-imej (I2T2I) ini. Tidak seperti lukisan atau kaedah penyuntingan imej lain yang memerlukan lokasi objek sebagai input, I2T2I VD tidak memerlukan topeng kerana ia boleh meletakkan dan menggantikan objek secara automatik seperti yang diarahkan.

Walau bagaimanapun, imej output I2T2I tidak konsisten dengan piksel imej input, yang disebabkan oleh pengekstrakan semantik imej-ke-teks dan penciptaan kandungan teks-ke-imej.

Dalam paparan di bawah, imej input terlebih dahulu diterjemahkan ke dalam gesaan, dan kemudian gesaan itu diedit menggunakan penolakan (kotak merah) dan penambahan (kotak hijau). Akhirnya, gesaan yang diedit diterjemahkan ke dalam imej.

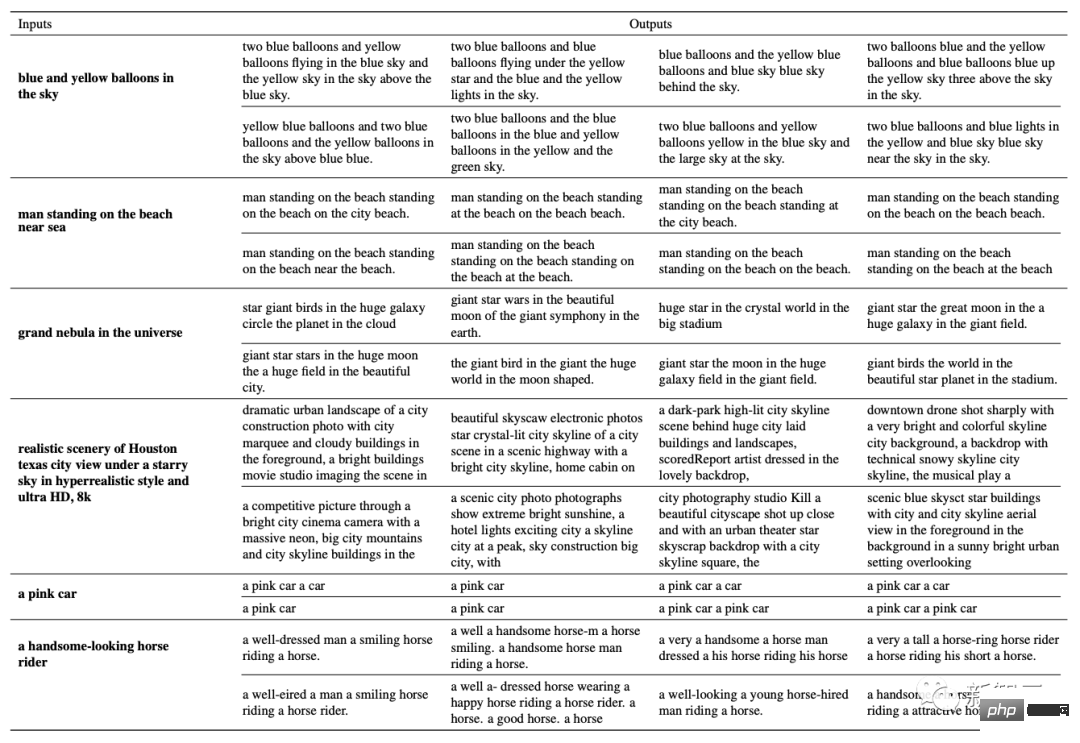

Selain itu, mereka juga merupakan pasukan pertama yang meneroka penjanaan teks yang serupa berdasarkan teks yang diberikan.

Rangka Kerja Rangkaian

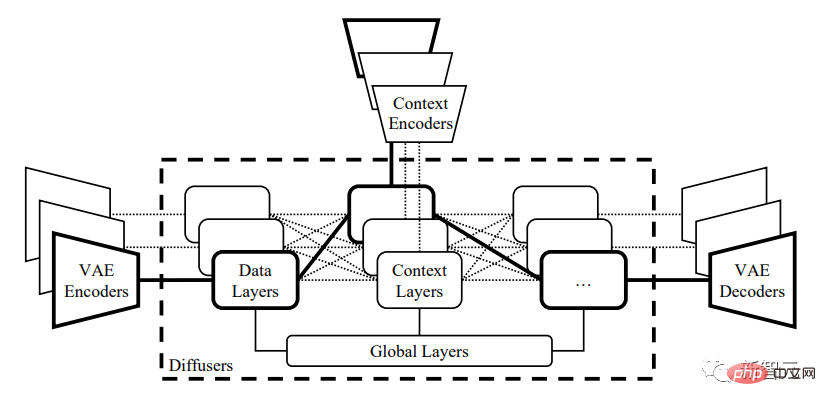

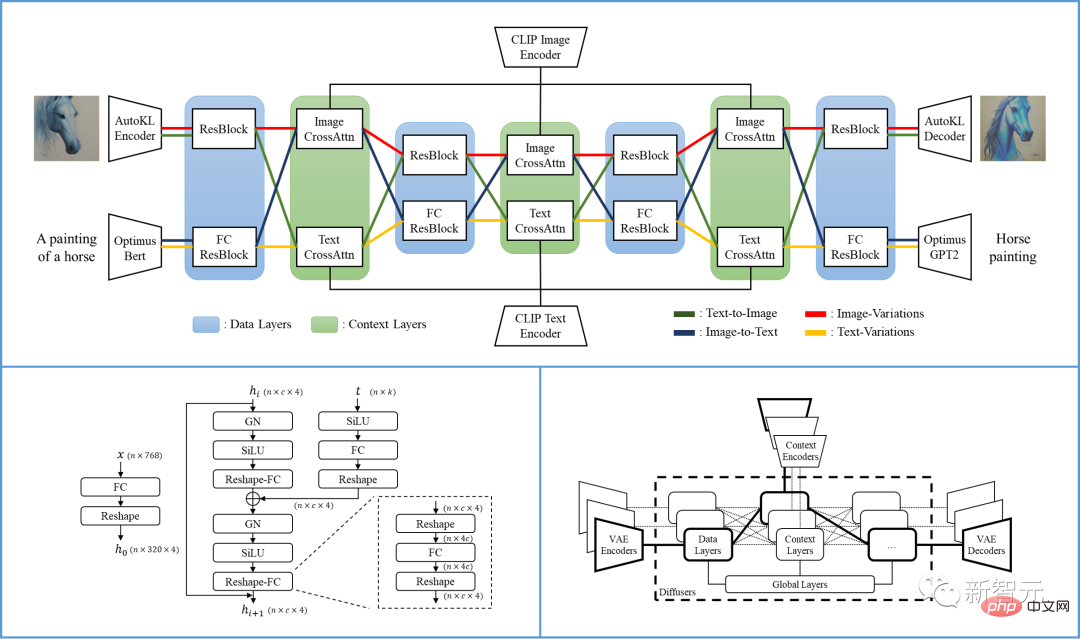

Secara khusus, rangka kerja VD yang dicadangkan dalam artikel ialah rangkaian berbilang aliran dengan pelbagai jenis data sebagai input dan latar belakang.

Rangka kerja penyebaran pelbagai mod berbilang aliran VD mewarisi kelebihan LDM/SD, dengan ruang pendam yang boleh ditafsir, struktur modal dan kos pengiraan yang rendah.

VD boleh melatih berbilang aliran secara bersama, dengan setiap strim mewakili tugas silang modal. Reka bentuk terasnya adalah untuk menyebarkan pengumpulan, perkongsian dan pertukaran protokol dalam rangkaian, menyesuaikan rangka kerja kepada semua tugas yang disokong dan seterusnya.

penyebar terbahagi kepada tiga kumpulan: lapisan global, lapisan data dan lapisan konteks. Lapisan global ialah lapisan benam temporal, lapisan data ialah blok sisa, dan lapisan konteks ialah perhatian silang.

Penghimpunan ini sepadan dengan kefungsian lapisan. Apabila mengerjakan berbilang tugas, lapisan global dikongsi antara semua tugas. Lapisan data dan lapisan konteks mengandungi berbilang aliran data. Setiap aliran data boleh dikongsi atau ditukar berdasarkan data semasa dan jenis konteks.

Contohnya, semasa memproses permintaan imej teks, penyebar menggunakan lapisan data imej dan lapisan konteks teks. Apabila berurusan dengan tugas mutasi imej, lapisan data imej dan lapisan konteks imej digunakan.

Satu proses VD mengandungi VAE, peresap dan pengekod konteks, memproses satu tugas di bawah satu jenis data (seperti imej) dan satu jenis konteks (seperti teks) ( Seperti sebagai teks kepada imej).

Struktur pelbagai aliran Resapan Serbaguna ditunjukkan dalam rajah di bawah:

Berdasarkan Penyebaran Serbaguna, penyelidik Rangka kerja berbilang mod berbilang aliran am dicadangkan lagi, termasuk VAE, pengekod konteks dan penyebar yang mengandungi tiga lapisan (iaitu lapisan global, data dan konteks).

Penyebar:

VD menggunakan UNet tertumpu silang yang diterima pakai secara meluas sebagai utama seni bina rangkaian peresap membahagikan lapisan kepada lapisan global, lapisan data dan lapisan konteks. Lapisan data dan lapisan konteks mempunyai dua aliran data untuk menyokong imej dan teks.

Untuk aliran data imej, ikuti LDM dan gunakan blok sisa (ResBlock), yang dimensi spatialnya berkurangan secara beransur-ansur dan bilangan saluran meningkat secara beransur-ansur.

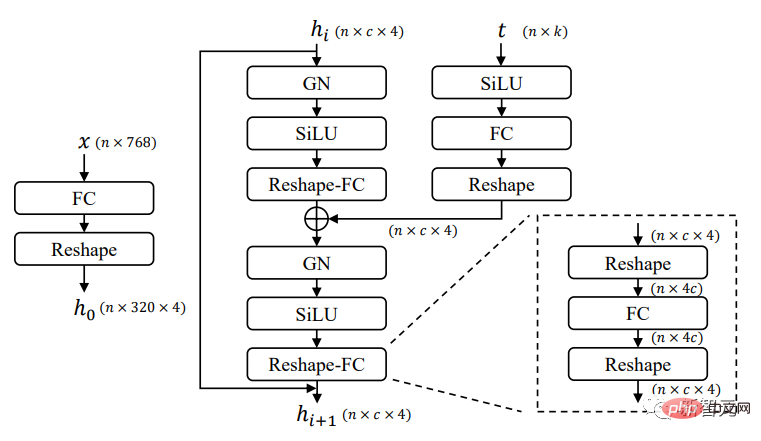

Untuk aliran data teks, gunakan blok baki tersambung sepenuhnya baharu (FCResBlock) untuk mengembangkan vektor terpendam teks 768 dimensi menjadi ciri tersembunyi 320*4 dan ikuti saluran serupa Tambah normalisasi, gunakan semula GroupNorms, SiLU dan langkau sambungan, sama seperti ResBlock biasa.

Seperti yang ditunjukkan dalam rajah di atas, FCResBlock mengandungi dua set lapisan bersambung penuh (FC), normalisasi kumpulan (GN) dan unit linear sigmoid (SiLU). x ialah kod pendam teks input, t ialah pemasukan masa input, dan hi ialah ciri perantaraan.

Untuk kumpulan konteks, lapisan perhatian silang diguna pakai untuk kedua-dua strim imej dan konteks, di mana pembenaman kandungan mengendalikan ciri data melalui lapisan unjuran, produk titik dan sigmoid.

Variational Autoencoder (VAE):

VD mengguna pakai potensi sebelumnya Autoencoder-KL daripada Model Resapan Terpendam (LDM) digunakan sebagai data imej VAE, dan Optimus digunakan sebagai data teks VAE. Optimus terdiri daripada pengekod teks BERT dan penyahkod teks GPT2, yang boleh menukar ayat secara dwiarah kepada vektor pendam taburan normal 768 dimensi.

Pada masa yang sama, Optimus juga menunjukkan ciri VAE yang memuaskan dengan ruang terpendam teks yang boleh dikonfigurasikan semula dan boleh ditafsir. Oleh itu, Optimus dipilih sebagai teks VAE kerana ia sesuai dengan prasyarat rangka kerja berbilang modal berbilang aliran.

Pengekod Konteks:

VD menggunakan teks CLIP dan pengekod Imej sebagai pengekod konteks. Tidak seperti LDM dan SD yang hanya menggunakan benam teks mentah sebagai input konteks, VD menggunakan benam yang dinormalisasi dan diunjurkan untuk meminimumkan kehilangan kontras CLIP bagi teks dan imej.

Percubaan menunjukkan bahawa ruang benam yang lebih rapat antara jenis konteks membantu model menumpu dengan cepat dan berprestasi lebih baik. Kesimpulan yang sama juga boleh dicapai dalam DALL·E 2, yang memperhalusi model teks-ke-imej dengan lapisan unjuran tambahan untuk meminimumkan perbezaan antara teks dan benam imej untuk variasi imej.

Prestasi

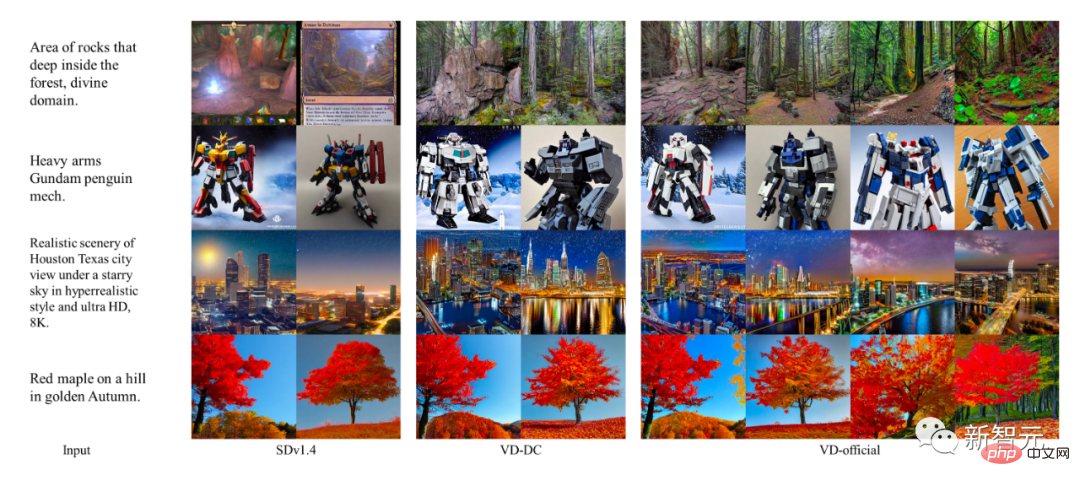

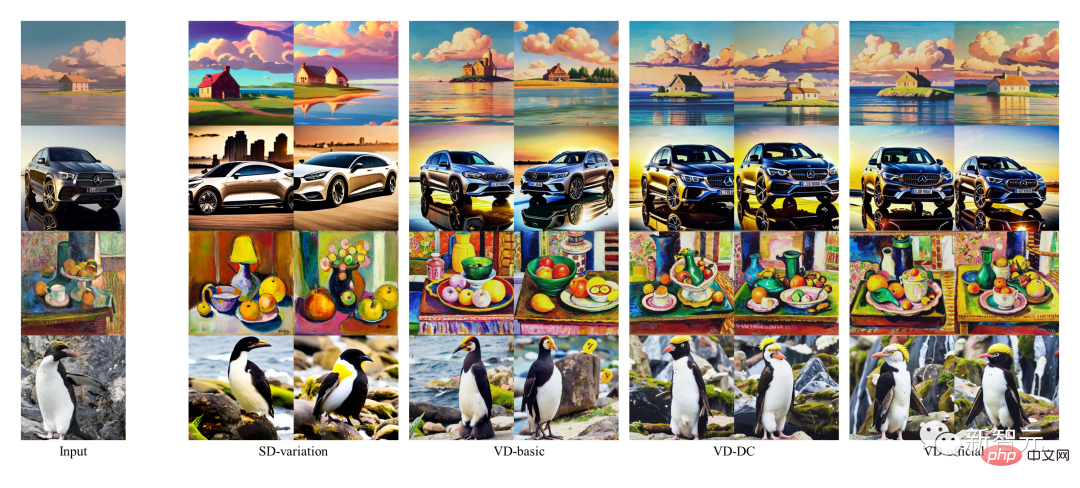

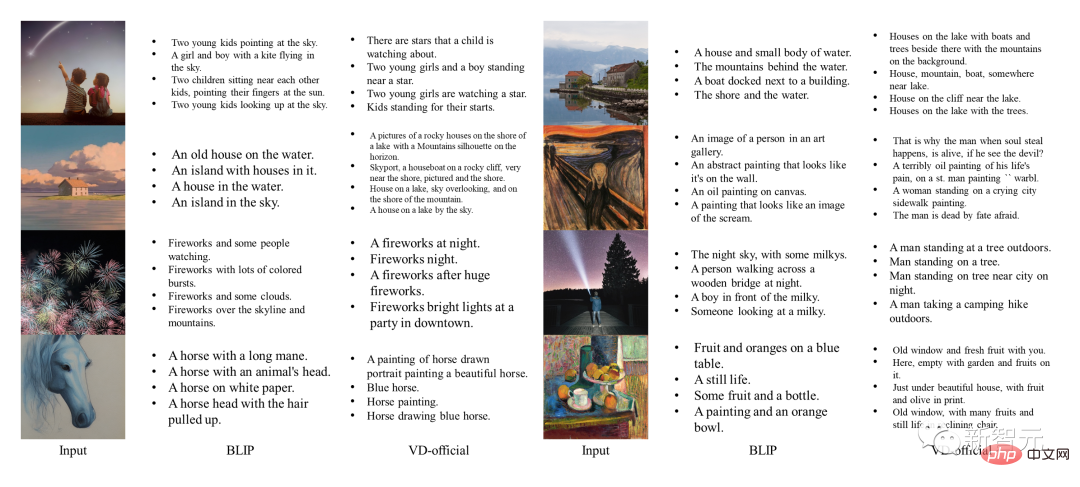

Pengarang menggunakan model tugasan tunggal awal sebagai model garis dasar dan membandingkan hasil VD dengan garis dasar ini. Antaranya, SDv1.4 digunakan sebagai model garis dasar dari teks ke imej, variasi SD digunakan untuk variasi imej, dan BLIP digunakan untuk teks imej.

Pada masa yang sama, pengarang juga menjalankan perbandingan kualitatif model VD yang berbeza, di mana VDDC dan VD-rasmi digunakan untuk teks ke imej, dan ketiga-tiga model digunakan untuk imej varian.

di mana sampel imej SD dan VD dijana dengan benih rawak terkawal untuk semakan kualiti yang lebih baik.

Teks kepada prestasi imej

Sementara DALLE 2 dan Imagen adalah Negeri -hasil yang paling canggih juga dicapai pada tugasan ini, tetapi oleh kerana tiada kod awam atau butiran latihan, penulis melangkau membandingkannya.

Hasilnya menunjukkan bahawa struktur berbilang proses dan latihan berbilang tugas boleh membantu VD menangkap semantik kontekstual dan menjana output dengan lebih tepat serta menyelesaikan semua subtugas dengan cemerlang.

Prestasi imej-varian

Selain itu, dihasilkan oleh VD The anotasi imej juga mengandungi beberapa perkataan kreatif. Sebagai perbandingan, penjanaan BLIP adalah sangat pendek dan tidak mempunyai penerangan terperinci.

Imej ke prestasi teks

Paparan kesan

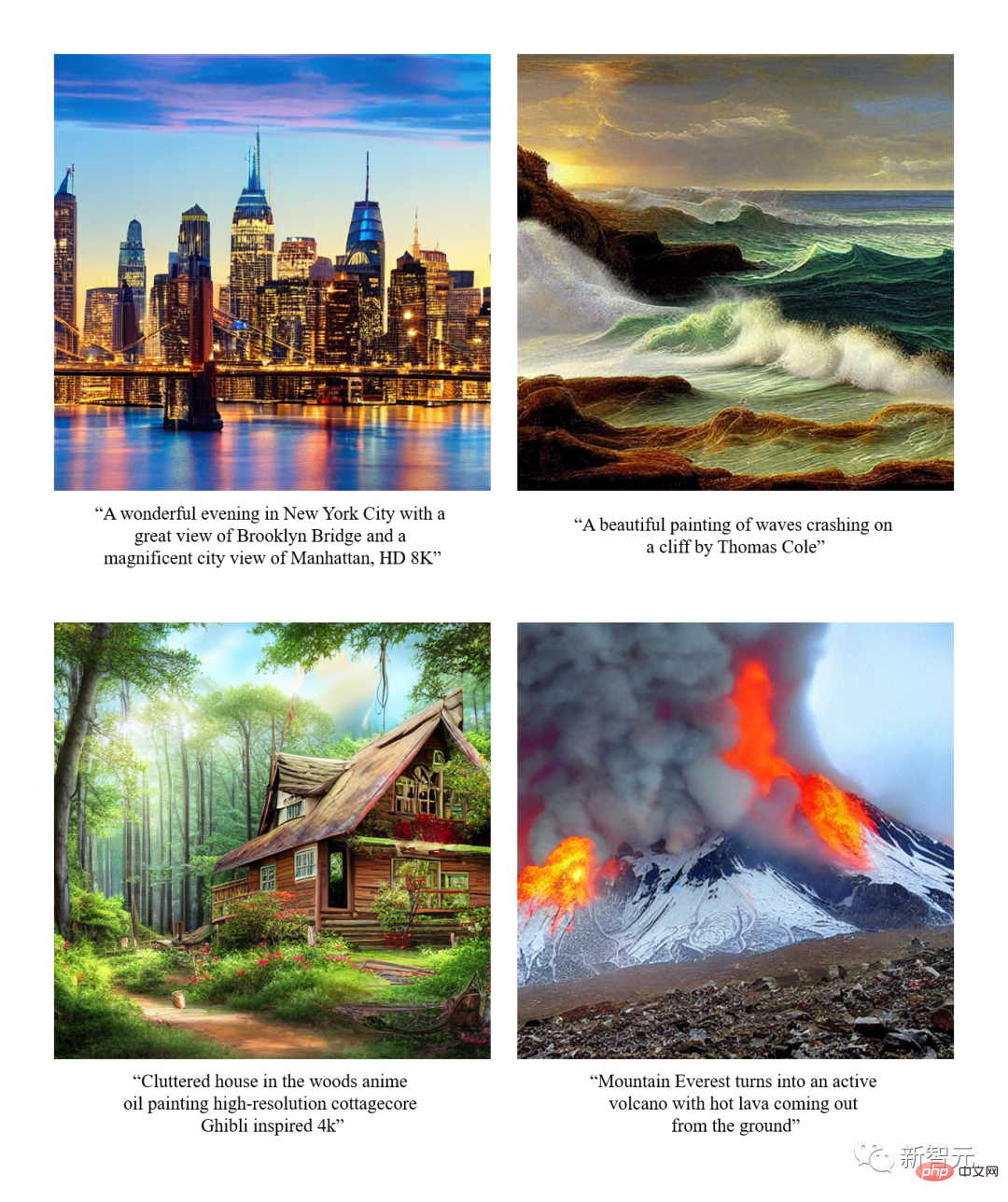

文生图

Varian imej

dengan semantik Fokus Varian Imej

Dual Boot

Ringkasan

- Pengarang memperkenalkan Versatile Diffusion (VD), rangkaian resapan pelbagai mod berbilang aliran yang menangani teks, imej dan perubahan dalam model bersatu. Berdasarkan VD, pengarang seterusnya memperkenalkan rangka kerja pelbagai mod berbilang aliran umum, yang boleh melibatkan tugas dan domain baharu.

- Melalui eksperimen, pengarang mendapati bahawa VD boleh menghasilkan output berkualiti tinggi pada semua tugas yang disokong, antaranya hasil teks-ke-imej dan imej-ke-varian VD dapat menangkap semantik dalam konteks dengan lebih baik, VD The hasil imej-ke-teks adalah kreatif dan ilustrasi.

- Memandangkan sifat berbilang mod berbilang aliran VD, pengarang memperkenalkan sambungan dan aplikasi novel yang boleh memanfaatkan lagi pengguna hiliran yang mengusahakan teknologi ini.

Pengenalan Pasukan

Pasukan IFP di Universiti Illinois di Urbana-Champaign telah diasaskan oleh Profesor Huang Xutao pada 1980-an, asalnya sebagai Penyelidikan Sains dan Teknologi Lanjutan Beckman Kumpulan Pembentukan dan Pemprosesan Imej Institut.

Selama bertahun-tahun, IFP telah komited untuk penyelidikan dan inovasi melangkaui imej, termasuk pengekodan imej dan video, interaksi manusia-komputer berbilang mod, dan anotasi dan carian multimedia, penglihatan komputer dan pengecaman corak, pembelajaran mesin, data besar, pembelajaran mendalam dan pengkomputeran berprestasi tinggi.

Hala tuju penyelidikan semasa IFP adalah untuk menyelesaikan masalah pemprosesan maklumat pelbagai mod dengan menggabungkan data besar, pembelajaran mendalam dan pengkomputeran berprestasi tinggi secara kolaboratif.

Di samping itu, IFP telah memenangi beberapa kertas kerja terbaik di persidangan teratas dalam bidang kecerdasan buatan dan memenangi banyak pertandingan antarabangsa, termasuk NIST TrecVID pertama, Cabaran ImageNet pertama dan Artificial pertama Cabaran Bandar Perisikan.

Menariknya, sejak Profesor Huang mula mengajar di MIT pada tahun 1960-an, "ahli" kumpulan IFP malah termasuk rakan, pelajar, pelajar pelajar, pelajar pelajar, Malah pelajar daripada pelajar pelajar.

Atas ialah kandungan terperinci Model bersatu AIGC ada di sini! Pasukan yang diasaskan oleh Huang Xutao, pemimpin dalam industri CV, mencadangkan 'Penyebaran Yang Maha Kuasa'. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1376

1376

52

52

Cara menetapkan masa tamat vue axios

Apr 07, 2025 pm 10:03 PM

Cara menetapkan masa tamat vue axios

Apr 07, 2025 pm 10:03 PM

Untuk menetapkan masa untuk Vue Axios, kita boleh membuat contoh Axios dan menentukan pilihan masa tamat: dalam tetapan global: vue.prototype. $ Axios = axios.create ({timeout: 5000}); Dalam satu permintaan: ini. $ axios.get ('/api/pengguna', {timeout: 10000}).

Cara Menggunakan MySQL Selepas Pemasangan

Apr 08, 2025 am 11:48 AM

Cara Menggunakan MySQL Selepas Pemasangan

Apr 08, 2025 am 11:48 AM

Artikel ini memperkenalkan operasi pangkalan data MySQL. Pertama, anda perlu memasang klien MySQL, seperti MySqlworkbench atau Command Line Client. 1. Gunakan perintah MySQL-Uroot-P untuk menyambung ke pelayan dan log masuk dengan kata laluan akaun root; 2. Gunakan CreateTatabase untuk membuat pangkalan data, dan gunakan Pilih pangkalan data; 3. Gunakan createtable untuk membuat jadual, menentukan medan dan jenis data; 4. Gunakan InsertInto untuk memasukkan data, data pertanyaan, kemas kini data dengan kemas kini, dan padam data dengan padam. Hanya dengan menguasai langkah -langkah ini, belajar menangani masalah biasa dan mengoptimumkan prestasi pangkalan data anda boleh menggunakan MySQL dengan cekap.

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Terdapat banyak sebab mengapa permulaan MySQL gagal, dan ia boleh didiagnosis dengan memeriksa log ralat. Penyebab umum termasuk konflik pelabuhan (periksa penghunian pelabuhan dan ubah suai konfigurasi), isu kebenaran (periksa keizinan pengguna yang menjalankan perkhidmatan), ralat fail konfigurasi (periksa tetapan parameter), rasuah direktori data (memulihkan data atau membina semula ruang meja), isu ruang jadual InnoDB (semak fail ibdata1) Apabila menyelesaikan masalah, anda harus menganalisisnya berdasarkan log ralat, cari punca utama masalah, dan mengembangkan tabiat sandaran data secara teratur untuk mencegah dan menyelesaikan masalah.

Geospatial Laravel: Pengoptimuman peta interaktif dan sejumlah besar data

Apr 08, 2025 pm 12:24 PM

Geospatial Laravel: Pengoptimuman peta interaktif dan sejumlah besar data

Apr 08, 2025 pm 12:24 PM

Cecair memproses 7 juta rekod dan membuat peta interaktif dengan teknologi geospatial. Artikel ini meneroka cara memproses lebih dari 7 juta rekod menggunakan Laravel dan MySQL dan mengubahnya menjadi visualisasi peta interaktif. Keperluan Projek Cabaran Awal: Ekstrak Wawasan berharga menggunakan 7 juta rekod dalam pangkalan data MySQL. Ramai orang mula -mula mempertimbangkan bahasa pengaturcaraan, tetapi mengabaikan pangkalan data itu sendiri: Bolehkah ia memenuhi keperluan? Adakah penghijrahan data atau pelarasan struktur diperlukan? Bolehkah MySQL menahan beban data yang besar? Analisis awal: Penapis utama dan sifat perlu dikenalpasti. Selepas analisis, didapati bahawa hanya beberapa atribut yang berkaitan dengan penyelesaiannya. Kami mengesahkan kemungkinan penapis dan menetapkan beberapa sekatan untuk mengoptimumkan carian. Carian Peta Berdasarkan Bandar

Jurutera Backend Senior Remote (Platform) memerlukan kalangan

Apr 08, 2025 pm 12:27 PM

Jurutera Backend Senior Remote (Platform) memerlukan kalangan

Apr 08, 2025 pm 12:27 PM

Jurutera Backend Senior Remote Company Kekosongan Syarikat: Lokasi Lokasi: Jauh Pejabat Jauh Jenis: Gaji sepenuh masa: $ 130,000- $ 140,000 Penerangan Pekerjaan Mengambil bahagian dalam penyelidikan dan pembangunan aplikasi mudah alih Circle dan ciri-ciri berkaitan API awam yang meliputi keseluruhan kitaran hayat pembangunan perisian. Tanggungjawab utama kerja pembangunan secara bebas berdasarkan rubyonrails dan bekerjasama dengan pasukan react/redux/relay front-end. Membina fungsi teras dan penambahbaikan untuk aplikasi web dan bekerjasama rapat dengan pereka dan kepimpinan sepanjang proses reka bentuk berfungsi. Menggalakkan proses pembangunan positif dan mengutamakan kelajuan lelaran. Memerlukan lebih daripada 6 tahun backend aplikasi web kompleks

Bolehkah mysql kembali json

Apr 08, 2025 pm 03:09 PM

Bolehkah mysql kembali json

Apr 08, 2025 pm 03:09 PM

MySQL boleh mengembalikan data JSON. Fungsi JSON_EXTRACT mengekstrak nilai medan. Untuk pertanyaan yang kompleks, pertimbangkan untuk menggunakan klausa WHERE untuk menapis data JSON, tetapi perhatikan kesan prestasinya. Sokongan MySQL untuk JSON sentiasa meningkat, dan disyorkan untuk memberi perhatian kepada versi dan ciri terkini.

Cara mengoptimumkan prestasi pangkalan data selepas pemasangan MySQL

Apr 08, 2025 am 11:36 AM

Cara mengoptimumkan prestasi pangkalan data selepas pemasangan MySQL

Apr 08, 2025 am 11:36 AM

Pengoptimuman prestasi MySQL perlu bermula dari tiga aspek: konfigurasi pemasangan, pengindeksan dan pengoptimuman pertanyaan, pemantauan dan penalaan. 1. Selepas pemasangan, anda perlu menyesuaikan fail my.cnf mengikut konfigurasi pelayan, seperti parameter innodb_buffer_pool_size, dan tutup query_cache_size; 2. Buat indeks yang sesuai untuk mengelakkan indeks yang berlebihan, dan mengoptimumkan pernyataan pertanyaan, seperti menggunakan perintah menjelaskan untuk menganalisis pelan pelaksanaan; 3. Gunakan alat pemantauan MySQL sendiri (ShowProcessList, ShowStatus) untuk memantau kesihatan pangkalan data, dan kerap membuat semula dan mengatur pangkalan data. Hanya dengan terus mengoptimumkan langkah -langkah ini, prestasi pangkalan data MySQL diperbaiki.

Bagaimana untuk mengoptimumkan prestasi MySQL untuk aplikasi beban tinggi?

Apr 08, 2025 pm 06:03 PM

Bagaimana untuk mengoptimumkan prestasi MySQL untuk aplikasi beban tinggi?

Apr 08, 2025 pm 06:03 PM

Panduan Pengoptimuman Prestasi Pangkalan Data MySQL Dalam aplikasi yang berintensifkan sumber, pangkalan data MySQL memainkan peranan penting dan bertanggungjawab untuk menguruskan urus niaga besar-besaran. Walau bagaimanapun, apabila skala aplikasi berkembang, kemunculan prestasi pangkalan data sering menjadi kekangan. Artikel ini akan meneroka satu siri strategi pengoptimuman prestasi MySQL yang berkesan untuk memastikan aplikasi anda tetap cekap dan responsif di bawah beban tinggi. Kami akan menggabungkan kes-kes sebenar untuk menerangkan teknologi utama yang mendalam seperti pengindeksan, pengoptimuman pertanyaan, reka bentuk pangkalan data dan caching. 1. Reka bentuk seni bina pangkalan data dan seni bina pangkalan data yang dioptimumkan adalah asas pengoptimuman prestasi MySQL. Berikut adalah beberapa prinsip teras: Memilih jenis data yang betul dan memilih jenis data terkecil yang memenuhi keperluan bukan sahaja dapat menjimatkan ruang penyimpanan, tetapi juga meningkatkan kelajuan pemprosesan data.