Tunggu, ChatGPT tidak akan jatuh!

Ditulis oleh Yan Zheng

Sudah lama ia tidak begitu meriah! Produk yang boleh membangkitkan perbincangan hebat di kalangan orang di seluruh dunia adalah sangat berharga, saya memikirkannya semasa otak saya berjalan pada kelajuan tinggi, dan nampaknya satu-satunya cara untuk menerangkannya ialah menggunakan "momen iPhone" Ketua Pegawai Eksekutif Nvidia Jensen Huang. untuk menggambarkannya.

telah melebihi satu juta pengguna dalam masa 5 hari selepas dikeluarkan. Dua bulan, hayat bulanan 100 juta.

Jadi apakah ROI untuk memasuki ChatGPT? Editor telah menyusun model kos dan hasil ChatGPT, dan menyemak secara ringkas reka letak dan dasar berkaitan syarikat gergasi domestik, serta cara pemaju harus melabur di dalamnya. Saya harap ia dapat membantu semua orang.

1. Berapakah kos untuk membina ChatGPT?

Walaupun ketibaan ChatGPT adalah "momen iPhone", kosnya adalah keterlaluan. Berikut adalah kompilasi data pengiraan daripada institusi berkaitan, dibahagikan kepada tiga aspek: kos pelaburan permulaan, kos latihan dan kos operasi.

1. Kos pelaburan permulaan

Guosheng Securities, sebuah syarikat sekuriti domestik yang terkenal, telah mengira kos kuasa pengkomputeran yang diperlukan oleh OpenAI pada peringkat ini. Mengambil purata kira-kira 13 juta pelawat unik menggunakan ChatGPT setiap hari pada bulan Januari tahun ini, permintaan cip sepadan adalah lebih daripada 30,000 GPU NVIDIA A100, kos pelaburan awal ialah kira-kira 800 juta dolar AS, dan bil elektrik harian juga akan wujud. 50,000 dolar AS.

2. Kos latihan

Dengan cip dan asas kuasa pengkomputeran, kos latihan model juga merupakan ambang yang besar. Guosheng Securities menganggarkan berdasarkan bilangan parameter dan token bahawa kos latihan GPT-3 sekali ialah kira-kira AS$1.4 juta menggunakan formula pengiraan yang sama untuk beberapa model LLM yang lebih besar, kos latihan adalah antara AS$2 juta dan AS$12 juta; .

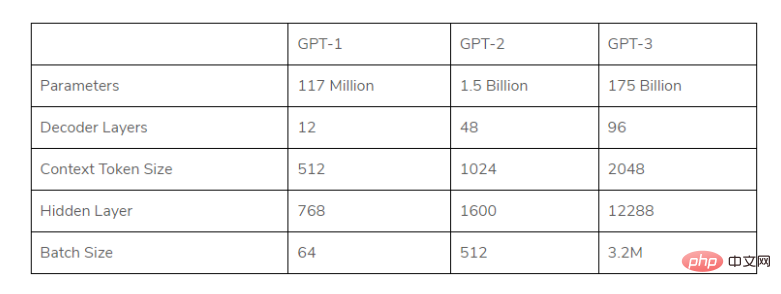

Rajah: Senarai parameter GPT bagi setiap generasi

(Dalam rangka kerja model besar, model GPT yang digunakan oleh ChatGPT, setiap Bilangan parameter setiap generasi berkembang pesat, dan keperluan volum data serta kos pra-latihan juga meningkat dengan cepat)

3 Kos operasi

Yang pertama ialah kos balasan: Musk sekali Platform Twitter bertanya kepada ChatGPT "Berapakah purata kos setiap sembang?" Altmann, Ketua Pegawai Eksekutif OpenAI, dijangka sedikit pahit: kos sembang purata ChatGPT ialah "sen satu digit", dan berkata bahawa usaha perlu dilakukan untuk mengoptimumkan kos.

Jadi apakah "digit tunggal" ini? Penulis mendapat jawapan berdasarkan data berikut.

· Pada Januari 2023, laporan analisis oleh bank pelaburan Morgan Stanley menyatakan bahawa kos balasan kepada ChatGPT adalah lebih kurang 6 kali ganda hingga 28 kali ganda kos purata pertanyaan carian Google.

· Menurut analisis terbaru oleh Morgan Stanley, kos purata bagi 3.3 trilion carian Google tahun lepas ialah kira-kira 0.2 sen setiap satu.

Oleh itu, dapat dilihat kos balasan sembang ChatGPT ialah 1.2~5.6 sen.

Jadi, berapa banyak pertanyaan yang ada setiap hari? , Menurut data Similarweb, setakat akhir Januari 2023, laman web chat.openai.com (laman web rasmi ChatGPT) telah menarik seramai 25 juta pelawat setiap hari pada minggu 27 Januari hingga 3 Februari.

Andaikan setiap pengguna bertanya kira-kira 10 soalan setiap hari, terdapat kira-kira 250 juta perundingan setiap hari. Kemudian boleh disimpulkan bahawa hanya untuk menyokong kos berbual, perbelanjaan harian adalah setinggi 03 hingga 140 juta dolar AS. (Sudah tentu, kos perlahan-lahan akan turun.)

Sepuluh juta dolar AS hanyalah yuran kemasukan, dan operasi berpuluh juta atau bahkan lebih 100 juta dolar AS sehari adalah tak tertanggung!

Li Di, Ketua Pegawai Eksekutif Xiaobing, membuat pengiraan: “Jika kita mempertimbangkan kos ChatGPT, saya akan membakar 300 juta yuan setiap hari, dan lebih daripada 100 bilion yuan setahun.

Baru-baru ini, John Hennessy, pengerusi syarikat induk Google Alphabet, turut menyatakan kebimbangan tentang kos: kos carian berdasarkan model bahasa besar mungkin 10 kali ganda daripada carian kata kunci standard sebanyak dolar kos tambahan akan ditanggung, yang dijangka memberi kesan ke atas keuntungan Kumpulan Alphabet

Oleh itu, ambang untuk membina “ChatGPT” sebenar adalah terlalu tinggi ( The "moat " syarikat besar juga akan menjadi sangat mendalam). Malah untuk syarikat gergasi antarabangsa seperti Google, mereka perlu berfikir dua kali dan berhati-hati.

2. Berapa banyak wang yang boleh OpenAI buat

Bolehkah pemulihan OpenAI nampaknya menjawab soalan ini walaupun terdapat pelaburan dan perbelanjaan yang besar Tahun lepas, kerugian bersih kewangan OpenAI mencecah 545 juta , orang ramai tidak mempunyai banyak keraguan tentang keupayaan pengewangannya Tidak lama dahulu, OpenAI mengumumkan bahawa ia menjangkakan memperoleh pendapatan sebanyak AS$200 juta tahun ini dan AS$1 bilion tahun hadapan >

Pada masa ini, model keuntungan OpenAI di sekitar ChatGPT adalah secara kasar dibahagikan kepada dua jenis:

1) Menyediakan antara muka data API, melaksanakan tugas pemprosesan bahasa semula jadi dan caj berdasarkan bilangan aksara

2) ChatGPTPlus menyediakan keistimewaan seperti respons keutamaan semasa tempoh sibuk pelayan, dan mengenakan yuran perkhidmatan langganan sebanyak AS$20/bulan

Selain itu, jika kami menggabungkan Bing baharu dengan ChatGPT Diambil bersama, carian pintar berasaskan perbualan seperti ini juga akan menjana hasil pengiklanan yang besar

.Setelah berkata demikian, Altman, ketua OpenAI, nampaknya tidak mempunyai banyak idea tentang pengkomersialan sebelum ini beliau berkata tentang isu ini: “Saya tidak tahu dengan integrasi yang mendalam bagi perniagaan seterusnya keupayaan untuk menarik wang jauh melebihi imaginasi Kami.

Dulu di China, syarikat mungkin lebih mengambil berat tentang senario perniagaan, sama ada hendak melakukan bahagian B dahulu atau bahagian C terlebih dahulu.

3. Berjuang untuk menjadi yang pertama dikerahkan, gajah menari

Dalam era ketika trafik Internet berada di kemuncaknya, gergasi sibuk cuba menembusi. Dalam bidang AIGC, nampaknya syarikat teknologi utama telah melihat secercah cahaya dan mula menggunakan secara aktif, dengan harapan dapat menukar aliran teknologi baru muncul ini dengan berkesan kepada kelebihan daya saing pasaran.

Jabatan R&D AI seperti Baidu Feipiao, Tencent Youtu, Alibaba Damo Academy, Byte dan NetEase telah memulakan pusingan baharu persaingan untuk produk seperti ChatGPT.

Malah, landasan model besar bukanlah sesuatu yang baru.

Walau bagaimanapun, pada masa ini, Baidu adalah yang paling menonjol dalam masa terdekat.

Pada hari Khamis, pengasas Baidu Robin Li menyerlahkan keterujaan dan jangkaannya untuk "Wen Xin Yiyan" yang akan datang semasa panggilan persidangan laporan kewangan S4 dan setahun penuh, malah membuat kenyataan berani. : "Kami percaya ia akan mengubah peraturan permainan pengkomputeran awan

Berdasarkan rancangan yang diumumkan pada mesyuarat itu, "Wen Xinyiyan" telah menjadi "C" untuk seterusnya. pembangunan perniagaan "bit" - pelbagai perniagaan arus perdana, seperti carian, awan pintar, pemanduan autonomi Apollo, peranti pintar Xiaodu, dan lain-lain akan disepadukan dengannya, Wen Xinyiyan akan menyediakan perkhidmatan luaran melalui Baidu Smart Cloud. Mac semakin hampir, dan "Wen Xin Yi Yan", yang berada dalam "tempoh pecut", akan keluar dari kepompongnya.

Lebih daripada 10 tahun pelaburan R&D yang tinggi, menunggu titik pemecahan. Carian berorientasikan C-end dan awan pintar berorientasikan kepada B-end, seekor gajah yang pernah merindui era Internet mudah alih, sedang membuka peluang "menari" yang baharu dan menyeluruh.

4. Mengapakah istilah baharu tetap ada?

Kali terakhir orang menyebut metaverse, mereka terhad kepada imaginasi "apa itu metaverse", dan kemudian orang mula berfikir berulang kali tentang "era VUCA" , suara itu. beransur-ansur tenggelam.

Untuk kemungkinan trend teknologi untuk bertapak dalam masyarakat, ia akhirnya perlu memberikan nilai sebenar. Teknologi AIGC yang diwakili oleh ChatGPT juga perlu mengatasi masalah "kesukaran dalam melaksanakan AI" pada masa lalu, membolehkan AI berfikir dengan teliti dan berinovasi dalam meningkatkan pengalaman pengguna, mencipta pengalaman pengguna baharu dan mencipta nilai sosial. Dan titik ini juga adalah yang paling teras.

Berita baiknya ialah kita melihat nilainya. Tugas berasaskan teks seperti menulis e-mel, sumbang saran, menulis semula kod dan menulis ringkasan sememangnya boleh menjimatkan banyak masa dan kos pengamal Saya percaya bahawa pada masa hadapan, AIGC akan dilihat dalam senario kandungan yang pelbagai seperti suara, imej dan video. Bukan prestasi yang buruk.

Sudah tentu, selain nilai teras, ia juga tidak dapat dipisahkan daripada tanah yang menggalakkan inovasi. Kementerian Sains dan Teknologi juga menjawab soalan mengenai ChatGPT semalam: "Negara kita telah mengambil langkah yang sepadan dari segi etika untuk mana-mana teknologi baharu, termasuk teknologi AI, untuk mencari kelebihan dan mengelakkan keburukan dalam pembangunan sains dan teknologi, supaya untuk menjadikan 'manfaat' lebih baik." Pamerkan."

Kemudian perspektif kembali kepada pemaju, apa yang kita orang teknikal perlu lakukan? Tinggalkan mentaliti terburu-buru untuk mengikuti trend dan mempunyai pemahaman yang kukuh tentang masalah yang perlu diselesaikan Ia lebih pragmatik daripada hanya menonton keseronokan "saham naik dan turun". Sebagai contoh, pembangun OpenAI sedang mengusahakan cara praktikal untuk mengurangkan kos latihan model.

Pada 25hb, Wang Jian, ahli akademik Akademi Kejuruteraan China dan pengasas Alibaba Cloud, berkata pada Persidangan Perintis Kecerdasan Buatan Global 2023: Kuasa pengkomputeran bukan lagi halangan atau alasan untuk pemaju. Pembangun perlu mempunyai pemahaman menyeluruh tentang keseluruhan industri dan memahami keupayaan dan sempadan algoritma.

Wang Jian berkata bahawa pembangun yang benar-benar membangunkan kecerdasan buatan peringkat teratas mengikuti idea mencari masalah dan menggunakan teknologi sedia ada untuk menyelesaikan masalah itu sendiri sebenarnya adalah terobosan.

“Adalah penting anda melakukan perkara yang betul pada masa yang sesuai.”

Atas ialah kandungan terperinci Tunggu, ChatGPT tidak akan jatuh!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1382

1382

52

52

ChatGPT kini membenarkan pengguna percuma menjana imej dengan menggunakan DALL-E 3 dengan had harian

Aug 09, 2024 pm 09:37 PM

ChatGPT kini membenarkan pengguna percuma menjana imej dengan menggunakan DALL-E 3 dengan had harian

Aug 09, 2024 pm 09:37 PM

DALL-E 3 telah diperkenalkan secara rasmi pada September 2023 sebagai model yang jauh lebih baik daripada pendahulunya. Ia dianggap sebagai salah satu penjana imej AI terbaik setakat ini, mampu mencipta imej dengan perincian yang rumit. Walau bagaimanapun, semasa pelancaran, ia adalah tidak termasuk

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Laman web ini melaporkan pada 27 Jun bahawa Jianying ialah perisian penyuntingan video yang dibangunkan oleh FaceMeng Technology, anak syarikat ByteDance Ia bergantung pada platform Douyin dan pada asasnya menghasilkan kandungan video pendek untuk pengguna platform tersebut Windows , MacOS dan sistem pengendalian lain. Jianying secara rasmi mengumumkan peningkatan sistem keahliannya dan melancarkan SVIP baharu, yang merangkumi pelbagai teknologi hitam AI, seperti terjemahan pintar, penonjolan pintar, pembungkusan pintar, sintesis manusia digital, dsb. Dari segi harga, yuran bulanan untuk keratan SVIP ialah 79 yuan, yuran tahunan ialah 599 yuan (nota di laman web ini: bersamaan dengan 49.9 yuan sebulan), langganan bulanan berterusan ialah 59 yuan sebulan, dan langganan tahunan berterusan ialah 499 yuan setahun (bersamaan dengan 41.6 yuan sebulan) . Di samping itu, pegawai yang dipotong juga menyatakan bahawa untuk meningkatkan pengalaman pengguna, mereka yang telah melanggan VIP asal

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Tingkatkan produktiviti, kecekapan dan ketepatan pembangun dengan menggabungkan penjanaan dipertingkatkan semula dan memori semantik ke dalam pembantu pengekodan AI. Diterjemah daripada EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, pengarang JanakiramMSV. Walaupun pembantu pengaturcaraan AI asas secara semulajadi membantu, mereka sering gagal memberikan cadangan kod yang paling relevan dan betul kerana mereka bergantung pada pemahaman umum bahasa perisian dan corak penulisan perisian yang paling biasa. Kod yang dijana oleh pembantu pengekodan ini sesuai untuk menyelesaikan masalah yang mereka bertanggungjawab untuk menyelesaikannya, tetapi selalunya tidak mematuhi piawaian pengekodan, konvensyen dan gaya pasukan individu. Ini selalunya menghasilkan cadangan yang perlu diubah suai atau diperhalusi agar kod itu diterima ke dalam aplikasi

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Model Bahasa Besar (LLM) dilatih pada pangkalan data teks yang besar, di mana mereka memperoleh sejumlah besar pengetahuan dunia sebenar. Pengetahuan ini dibenamkan ke dalam parameter mereka dan kemudiannya boleh digunakan apabila diperlukan. Pengetahuan tentang model ini "diperbaharui" pada akhir latihan. Pada akhir pra-latihan, model sebenarnya berhenti belajar. Selaraskan atau perhalusi model untuk mempelajari cara memanfaatkan pengetahuan ini dan bertindak balas dengan lebih semula jadi kepada soalan pengguna. Tetapi kadangkala pengetahuan model tidak mencukupi, dan walaupun model boleh mengakses kandungan luaran melalui RAG, ia dianggap berfaedah untuk menyesuaikan model kepada domain baharu melalui penalaan halus. Penalaan halus ini dilakukan menggunakan input daripada anotasi manusia atau ciptaan LLM lain, di mana model menemui pengetahuan dunia sebenar tambahan dan menyepadukannya

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Editor |ScienceAI Question Answering (QA) set data memainkan peranan penting dalam mempromosikan penyelidikan pemprosesan bahasa semula jadi (NLP). Set data QA berkualiti tinggi bukan sahaja boleh digunakan untuk memperhalusi model, tetapi juga menilai dengan berkesan keupayaan model bahasa besar (LLM), terutamanya keupayaan untuk memahami dan menaakul tentang pengetahuan saintifik. Walaupun pada masa ini terdapat banyak set data QA saintifik yang meliputi bidang perubatan, kimia, biologi dan bidang lain, set data ini masih mempunyai beberapa kekurangan. Pertama, borang data adalah agak mudah, kebanyakannya adalah soalan aneka pilihan. Ia mudah dinilai, tetapi mengehadkan julat pemilihan jawapan model dan tidak dapat menguji sepenuhnya keupayaan model untuk menjawab soalan saintifik. Sebaliknya, Soal Jawab terbuka

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Editor |. KX Dalam bidang penyelidikan dan pembangunan ubat, meramalkan pertalian pengikatan protein dan ligan dengan tepat dan berkesan adalah penting untuk pemeriksaan dan pengoptimuman ubat. Walau bagaimanapun, kajian semasa tidak mengambil kira peranan penting maklumat permukaan molekul dalam interaksi protein-ligan. Berdasarkan ini, penyelidik dari Universiti Xiamen mencadangkan rangka kerja pengekstrakan ciri berbilang mod (MFE) novel, yang buat pertama kalinya menggabungkan maklumat mengenai permukaan protein, struktur dan jujukan 3D, dan menggunakan mekanisme perhatian silang untuk membandingkan ciri modaliti yang berbeza penjajaran. Keputusan eksperimen menunjukkan bahawa kaedah ini mencapai prestasi terkini dalam meramalkan pertalian mengikat protein-ligan. Tambahan pula, kajian ablasi menunjukkan keberkesanan dan keperluan maklumat permukaan protein dan penjajaran ciri multimodal dalam rangka kerja ini. Penyelidikan berkaitan bermula dengan "S

SK Hynix akan memaparkan produk berkaitan AI baharu pada 6 Ogos: HBM3E 12 lapisan, NAND 321 tinggi, dsb.

Aug 01, 2024 pm 09:40 PM

SK Hynix akan memaparkan produk berkaitan AI baharu pada 6 Ogos: HBM3E 12 lapisan, NAND 321 tinggi, dsb.

Aug 01, 2024 pm 09:40 PM

Menurut berita dari laman web ini pada 1 Ogos, SK Hynix mengeluarkan catatan blog hari ini (1 Ogos), mengumumkan bahawa ia akan menghadiri Global Semiconductor Memory Summit FMS2024 yang akan diadakan di Santa Clara, California, Amerika Syarikat dari 6 hingga 8 Ogos, mempamerkan banyak produk penjanaan teknologi baru. Pengenalan kepada Sidang Kemuncak Memori dan Penyimpanan Masa Depan (FutureMemoryandStorage), dahulunya Sidang Kemuncak Memori Flash (FlashMemorySummit) terutamanya untuk pembekal NAND, dalam konteks peningkatan perhatian kepada teknologi kecerdasan buatan, tahun ini dinamakan semula sebagai Sidang Kemuncak Memori dan Penyimpanan Masa Depan (FutureMemoryandStorage) kepada jemput vendor DRAM dan storan serta ramai lagi pemain. Produk baharu SK hynix dilancarkan tahun lepas

Meletakkan pasaran seperti AI, GlobalFoundries memperoleh teknologi gallium nitrida Tagore Technology dan pasukan berkaitan

Jul 15, 2024 pm 12:21 PM

Meletakkan pasaran seperti AI, GlobalFoundries memperoleh teknologi gallium nitrida Tagore Technology dan pasukan berkaitan

Jul 15, 2024 pm 12:21 PM

Menurut berita dari laman web ini pada 5 Julai, GlobalFoundries mengeluarkan kenyataan akhbar pada 1 Julai tahun ini, mengumumkan pemerolehan teknologi power gallium nitride (GaN) Tagore Technology dan portfolio harta intelek, dengan harapan dapat mengembangkan bahagian pasarannya dalam kereta dan Internet of Things dan kawasan aplikasi pusat data kecerdasan buatan untuk meneroka kecekapan yang lebih tinggi dan prestasi yang lebih baik. Memandangkan teknologi seperti AI generatif terus berkembang dalam dunia digital, galium nitrida (GaN) telah menjadi penyelesaian utama untuk pengurusan kuasa yang mampan dan cekap, terutamanya dalam pusat data. Laman web ini memetik pengumuman rasmi bahawa semasa pengambilalihan ini, pasukan kejuruteraan Tagore Technology akan menyertai GLOBALFOUNDRIES untuk membangunkan lagi teknologi gallium nitride. G