Peranti teknologi

Peranti teknologi

AI

AI

Rangka kerja klasifikasi berskala besar sumber terbuka DAMO Academy kos rendah FFC

Rangka kerja klasifikasi berskala besar sumber terbuka DAMO Academy kos rendah FFC

Rangka kerja klasifikasi berskala besar sumber terbuka DAMO Academy kos rendah FFC

Pautan kertas: https://arxiv.org/pdf/2105.10375.pdf

Aplikasi & Kod:

- https://www.php.cn/link/c42af2fa7356818e0389593714f

- https://www.php.cn/link/60a6c4002cc7b29142def8871531281a>Latar Belakang

Klasifikasi imej ialah salah satu teknologi aplikasi praktikal AI yang paling berjaya pada masa ini dan telah disepadukan ke dalam kehidupan harian manusia. Ia digunakan secara meluas dalam kebanyakan tugas penglihatan komputer, seperti klasifikasi imej, carian imej, OCR, semakan kandungan, pengesahan pengecaman dan bidang lain. Terdapat konsensus umum: "Apabila set data lebih besar dan terdapat lebih banyak ID, selagi ia dilatih dengan betul, kesan tugas pengelasan yang sepadan akan menjadi lebih baik." Walau bagaimanapun, apabila berhadapan dengan berpuluh-puluh juta ID atau malah ratusan juta ID, adalah sukar bagi rangka kerja DL yang popular pada masa ini untuk secara langsung menjalankan latihan pengelasan berskala ultra-besar dengan kos yang rendah.

Cara paling intuitif untuk menyelesaikan masalah ini adalah dengan menggunakan lebih banyak sumber kad grafik melalui pengelompokan, tetapi walaupun begitu, masalah pengelasan di bawah ID besar masih akan mengalami masalah berikut:

1) Isu kos: Dalam kes rangka kerja latihan teragih + data besar, overhed memori, komunikasi berbilang mesin, penyimpanan data dan pemuatan akan menggunakan lebih banyak sumber.

2) Masalah ekor panjang: Dalam senario sebenar, apabila set data mencapai ratusan juta ID, bilangan sampel imej dalam kebanyakan ID selalunya sangat kecil, dan data akan diedarkan dalam ekor panjang Sangat jelas bahawa latihan langsung sukar untuk mencapai hasil yang lebih baik.

Bab-bab yang selebihnya dalam artikel ini akan menumpukan pada penyelesaian sedia ada untuk rangka kerja pengelasan berskala sangat besar, serta prinsip dan helah yang sepadan bagi rangka kerja pengelasan kos rendah FFC.

Kaedah

Sebelum memperkenalkan kaedah, artikel ini terlebih dahulu mengkaji cabaran utama klasifikasi berskala sangat besar semasa:

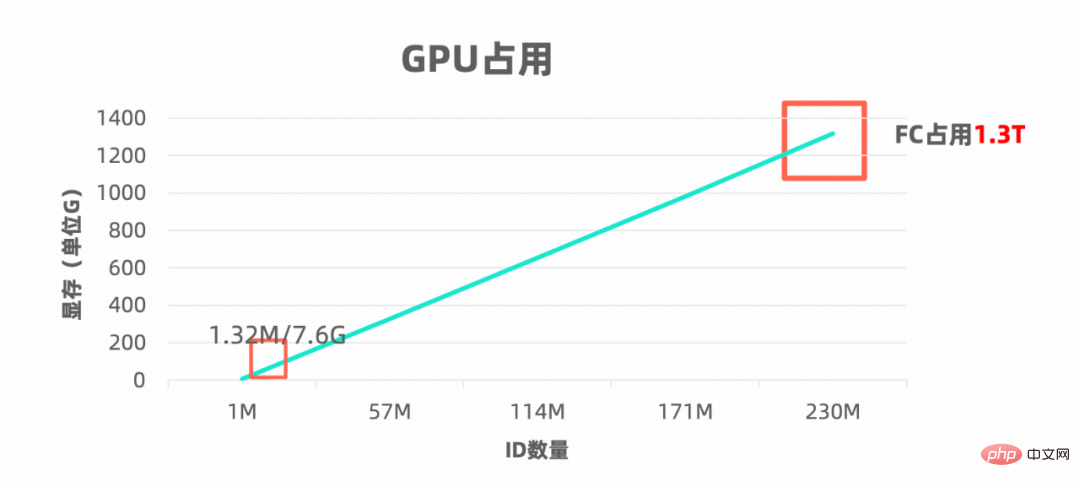

Mata cabaran 1: Kos kekal tinggi

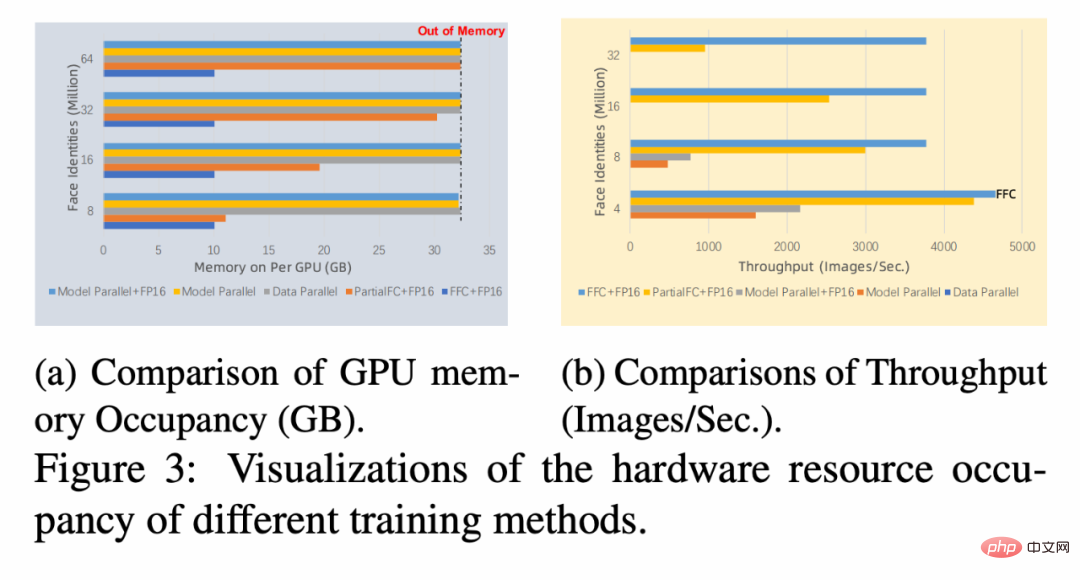

Semakin besar bilangan ID, semakin besar keperluan memori pengelas, seperti yang ditunjukkan dalam rajah berikut :

Semakin besar memori video, semakin banyak kad mesin diperlukan dan semakin tinggi kos infrastruktur perkakasan yang sepadan untuk kerjasama berbilang mesin juga lebih tinggi. Pada masa yang sama, apabila bilangan ID pengelasan mencapai skala yang sangat besar, jumlah pengiraan utama akan dibazirkan pada lapisan pengelas terakhir, dan masa yang digunakan oleh rangkaian rangka boleh diabaikan.

Semakin besar memori video, semakin banyak kad mesin diperlukan dan semakin tinggi kos infrastruktur perkakasan yang sepadan untuk kerjasama berbilang mesin juga lebih tinggi. Pada masa yang sama, apabila bilangan ID pengelasan mencapai skala yang sangat besar, jumlah pengiraan utama akan dibazirkan pada lapisan pengelas terakhir, dan masa yang digunakan oleh rangkaian rangka boleh diabaikan.

Mata cabaran 2: Kesukaran dalam pembelajaran long-tail

Dalam senario sebenar, bilangan mutlak antara ratusan daripada berjuta-juta ID Bilangan sampel imej dalam kebanyakan ID akan menjadi sangat kecil, dan pengedaran data ekor panjang sangat jelas, menjadikan latihan langsung sukar untuk disatukan. Jika dilatih dengan berat yang sama, sampel ekor panjang akan terharu dan tidak cukup dipelajari. Pada masa ini, sampel tidak seimbang secara amnya digunakan Mengenai topik penyelidikan ini, terdapat banyak kaedah yang boleh digunakan untuk rujukan Apakah kaedah yang lebih sesuai untuk diintegrasikan ke dalam rangka kerja pengelasan berskala ultra-besar?

Dengan dua cabaran di atas, mari kita lihat dahulu penyelesaian yang boleh dilaksanakan sedia ada dan sama ada ia boleh menyelesaikan dua cabaran di atas dengan baik.

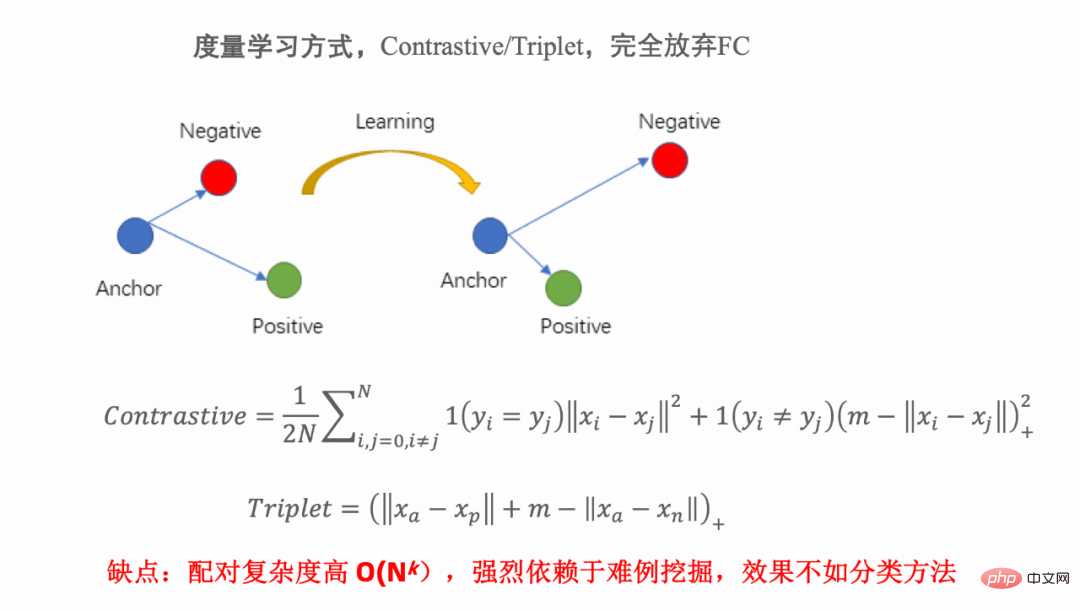

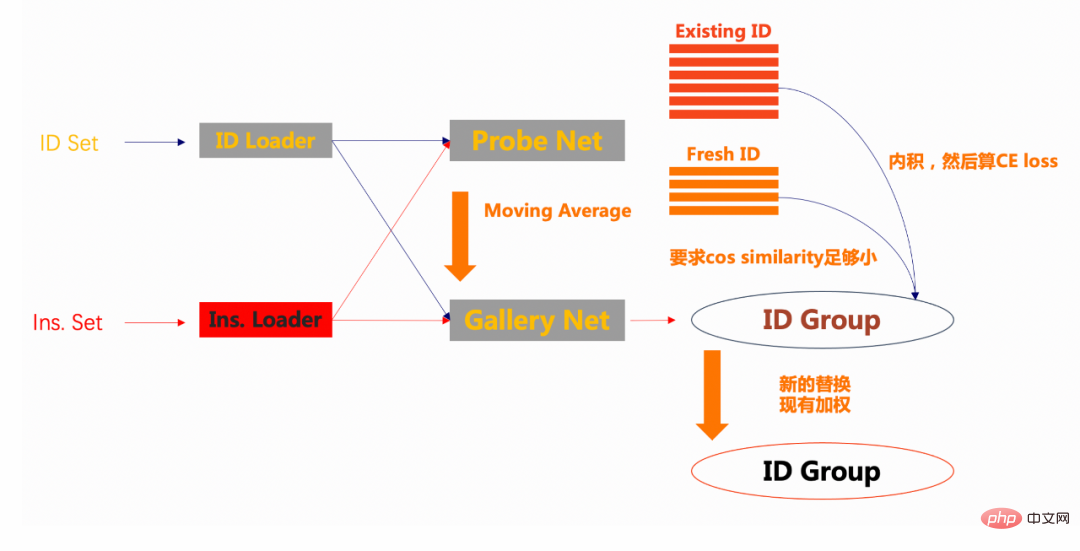

Kaedah yang boleh dilaksanakan 1: Pembelajaran metrik

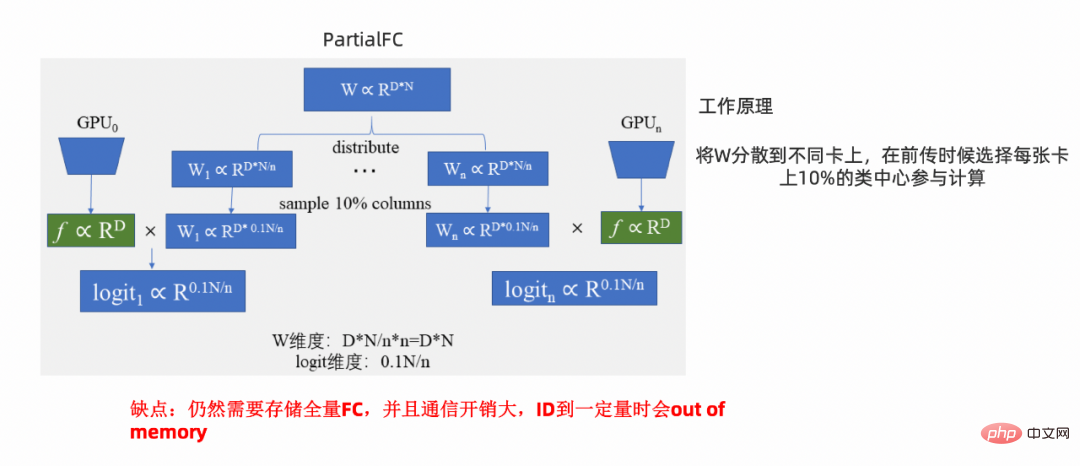

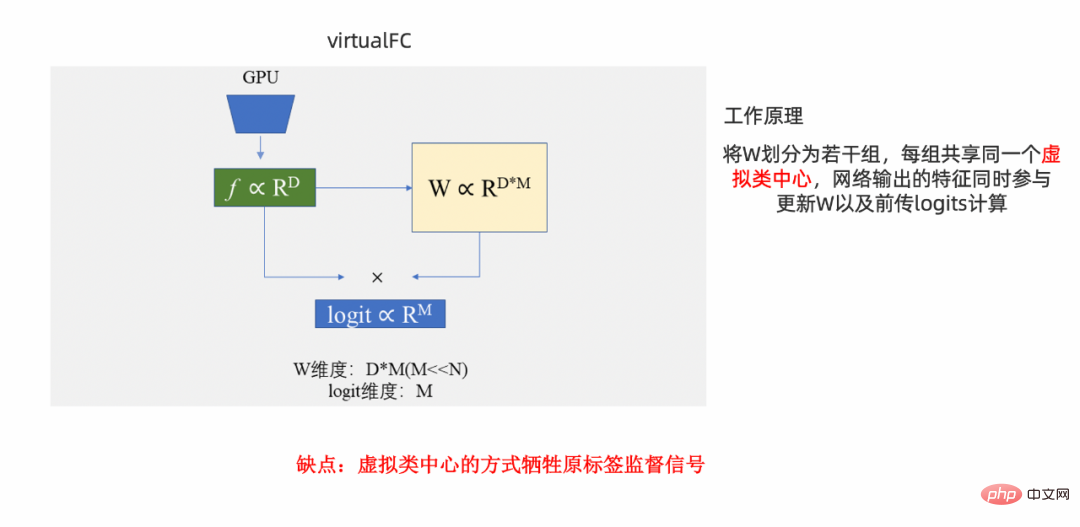

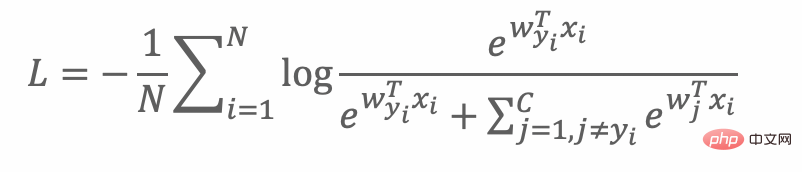

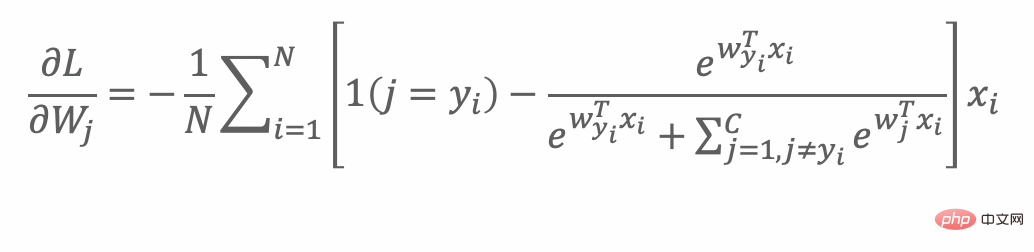

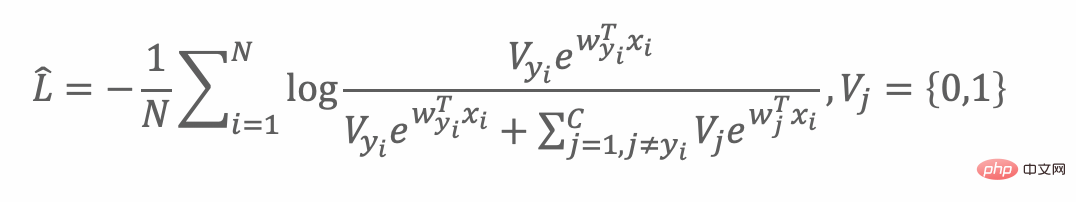

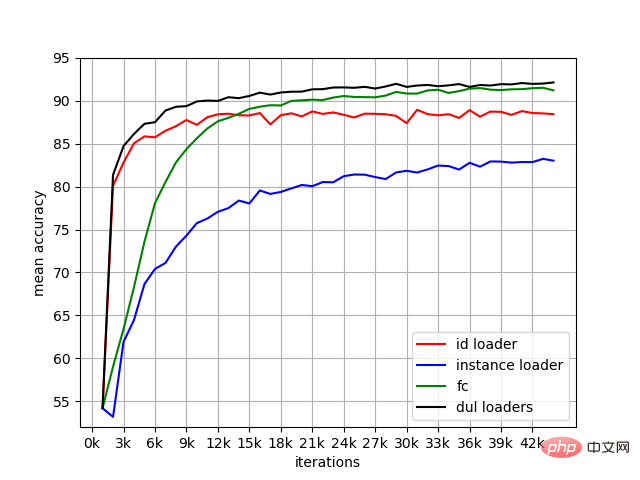

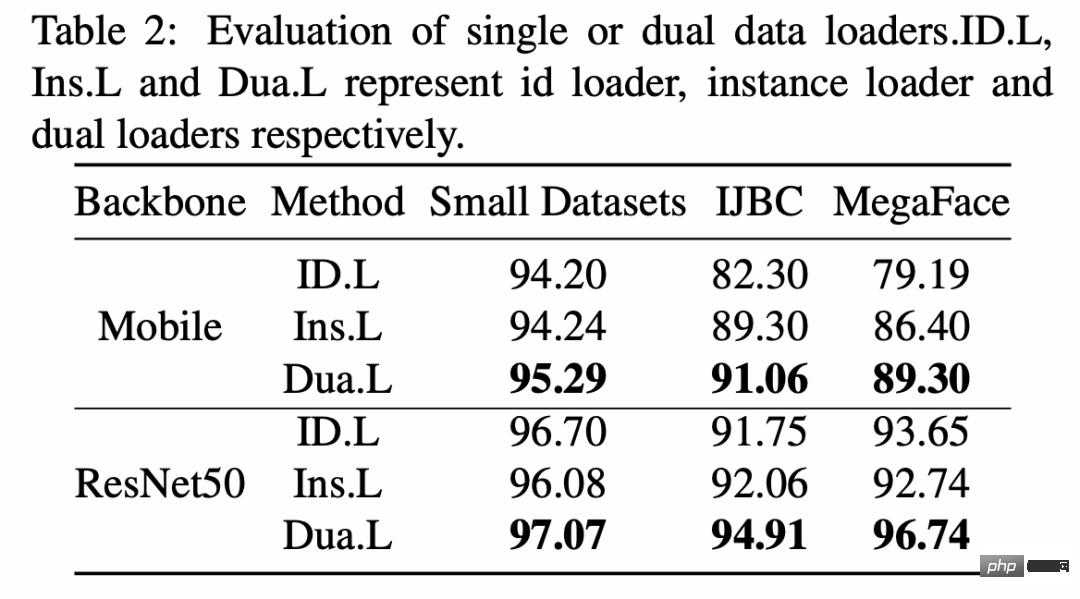

Kemungkinan kaedah 3: Rangka kerja VFC Kaedah kertas ini: Rangka kerja FFC Apabila klasifikasi berskala besar dilatih menggunakan FC, fungsi kehilangan adalah seperti berikut: Semasa setiap proses backpropagation, semua pusat kelas akan dikemas kini: Tetapi FC terlalu besar Idea intuitif adalah untuk memilih bahagian tertentu pusat kelas secara munasabah, iaitu, Vj berikut ialah 1 bahagian: Berdasarkan motivasi di atas , yang membawa kepada pelan awal berikut: Pertama sekali, untuk menyelesaikan kesan ekor panjang, artikel ini memperkenalkan dua pemuat, satu berdasarkan id Terdapat dua pemuat, id_loader persampelan dan pemuat instance berdasarkan persampelan sampel. Dalam setiap zaman, kelas dengan banyak sampel dan kelas dengan sedikit sampel (sedikit pukulan) boleh berpeluang untuk dilatih. Kedua, sebelum latihan bermula, hantar sebahagian daripada sampel kepada kumpulan id Di sini, diandaikan bahawa 10% daripada sampel id dimasukkan ke dalam kumpulan. Pada masa ini, galeri menggunakan parameter rawak. Kemudian, apabila latihan bermula, sampel batch memasuki jaring siasatan satu demi satu. Kemudian terdapat dua situasi untuk sampel dalam setiap kelompok: 1.) Terdapat ciri dengan ID yang sama bagi sampel ini dalam kumpulan, 2.) Tiada ciri sampel yang serupa dalam kumpulan. Untuk kedua-dua kes ini, panggil mereka id sedia ada dan id baharu masing-masing. Untuk sampel sedia ada, gunakan ciri dan ciri dalam kumpulan untuk melakukan produk dalam, kira fungsi kehilangan entropi silang dengan label, dan kemudian kembalikannya. Untuk sampel segar, kurangkan persamaan kosinus dengan sampel dalam kumpulan. Akhir sekali, ciri dalam kumpulan dikemas kini dan digantikan dengan pusat kelas baharu, berdasarkan prinsip pemberat pusat kelas sedia ada. Untuk jaring galeri, strategi purata bergerak digunakan untuk mengemas kini parameter dalam probe secara beransur-ansur. Kaedah kertas ini: pengenalan helah 1.) Saiz Kumpulan ID yang diperkenalkan boleh laras Parameter, biasanya lalai kepada 30,000. 2.) Untuk mencapai latihan yang stabil, rujuk kaedah kelas moco dan perkenalkan purata bergerak Syarat penumpuan yang sepadan ialah: 1. Eksperimen ablasi Pemuat Berganda 2. Perbandingan kesan kaedah SOTA 3. Perbandingan memori video dan throughput sampel

Hasil percubaan

Hasil percubaan

Atas ialah kandungan terperinci Rangka kerja klasifikasi berskala besar sumber terbuka DAMO Academy kos rendah FFC. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

Bagaimana untuk menilai keberkesanan kos sokongan komersial untuk rangka kerja Java

Jun 05, 2024 pm 05:25 PM

Bagaimana untuk menilai keberkesanan kos sokongan komersial untuk rangka kerja Java

Jun 05, 2024 pm 05:25 PM

Menilai kos/prestasi sokongan komersial untuk rangka kerja Java melibatkan langkah-langkah berikut: Tentukan tahap jaminan yang diperlukan dan jaminan perjanjian tahap perkhidmatan (SLA). Pengalaman dan kepakaran pasukan sokongan penyelidikan. Pertimbangkan perkhidmatan tambahan seperti peningkatan, penyelesaian masalah dan pengoptimuman prestasi. Timbang kos sokongan perniagaan terhadap pengurangan risiko dan peningkatan kecekapan.

Bagaimanakah keluk pembelajaran rangka kerja PHP berbanding rangka kerja bahasa lain?

Jun 06, 2024 pm 12:41 PM

Bagaimanakah keluk pembelajaran rangka kerja PHP berbanding rangka kerja bahasa lain?

Jun 06, 2024 pm 12:41 PM

Keluk pembelajaran rangka kerja PHP bergantung pada kecekapan bahasa, kerumitan rangka kerja, kualiti dokumentasi dan sokongan komuniti. Keluk pembelajaran rangka kerja PHP adalah lebih tinggi jika dibandingkan dengan rangka kerja Python dan lebih rendah jika dibandingkan dengan rangka kerja Ruby. Berbanding dengan rangka kerja Java, rangka kerja PHP mempunyai keluk pembelajaran yang sederhana tetapi masa yang lebih singkat untuk bermula.

Bagaimanakah pilihan rangka kerja PHP yang ringan mempengaruhi prestasi aplikasi?

Jun 06, 2024 am 10:53 AM

Bagaimanakah pilihan rangka kerja PHP yang ringan mempengaruhi prestasi aplikasi?

Jun 06, 2024 am 10:53 AM

Rangka kerja PHP yang ringan meningkatkan prestasi aplikasi melalui saiz kecil dan penggunaan sumber yang rendah. Ciri-cirinya termasuk: saiz kecil, permulaan pantas, penggunaan memori yang rendah, kelajuan dan daya tindak balas yang dipertingkatkan, dan penggunaan sumber yang dikurangkan: SlimFramework mencipta API REST, hanya 500KB, responsif yang tinggi dan daya pemprosesan yang tinggi.

Amalan terbaik dokumentasi rangka kerja Golang

Jun 04, 2024 pm 05:00 PM

Amalan terbaik dokumentasi rangka kerja Golang

Jun 04, 2024 pm 05:00 PM

Menulis dokumentasi yang jelas dan komprehensif adalah penting untuk rangka kerja Golang. Amalan terbaik termasuk mengikut gaya dokumentasi yang ditetapkan, seperti Panduan Gaya Pengekodan Google. Gunakan struktur organisasi yang jelas, termasuk tajuk, subtajuk dan senarai, serta sediakan navigasi. Menyediakan maklumat yang komprehensif dan tepat, termasuk panduan permulaan, rujukan API dan konsep. Gunakan contoh kod untuk menggambarkan konsep dan penggunaan. Pastikan dokumentasi dikemas kini, jejak perubahan dan dokumen ciri baharu. Sediakan sokongan dan sumber komuniti seperti isu dan forum GitHub. Buat contoh praktikal, seperti dokumentasi API.

Bagaimana untuk memilih rangka kerja golang terbaik untuk senario aplikasi yang berbeza

Jun 05, 2024 pm 04:05 PM

Bagaimana untuk memilih rangka kerja golang terbaik untuk senario aplikasi yang berbeza

Jun 05, 2024 pm 04:05 PM

Pilih rangka kerja Go terbaik berdasarkan senario aplikasi: pertimbangkan jenis aplikasi, ciri bahasa, keperluan prestasi dan ekosistem. Rangka kerja Common Go: Gin (aplikasi Web), Echo (Perkhidmatan Web), Fiber (daya pemprosesan tinggi), gorm (ORM), fasthttp (kelajuan). Kes praktikal: membina REST API (Fiber) dan berinteraksi dengan pangkalan data (gorm). Pilih rangka kerja: pilih fasthttp untuk prestasi utama, Gin/Echo untuk aplikasi web yang fleksibel, dan gorm untuk interaksi pangkalan data.

Pelan Hala Tuju Pembelajaran Rangka Kerja Java: Amalan Terbaik dalam Domain Berbeza

Jun 05, 2024 pm 08:53 PM

Pelan Hala Tuju Pembelajaran Rangka Kerja Java: Amalan Terbaik dalam Domain Berbeza

Jun 05, 2024 pm 08:53 PM

Pelan hala tuju pembelajaran rangka kerja Java untuk bidang yang berbeza: Pembangunan web: SpringBoot dan PlayFramework. Lapisan kegigihan: Hibernate dan JPA. Pengaturcaraan reaktif bahagian pelayan: ReactorCore dan SpringWebFlux. Pengkomputeran masa nyata: ApacheStorm dan ApacheSpark. Pengkomputeran Awan: AWS SDK untuk Java dan Google Cloud Java.

Apakah salah faham yang biasa berlaku dalam proses pembelajaran kerangka Golang?

Jun 05, 2024 pm 09:59 PM

Apakah salah faham yang biasa berlaku dalam proses pembelajaran kerangka Golang?

Jun 05, 2024 pm 09:59 PM

Terdapat lima salah faham dalam pembelajaran rangka kerja Go: terlalu bergantung pada rangka kerja dan fleksibiliti terhad. Jika anda tidak mengikut konvensyen rangka kerja, kod tersebut akan menjadi sukar untuk dikekalkan. Menggunakan perpustakaan lapuk boleh menyebabkan isu keselamatan dan keserasian. Penggunaan pakej yang berlebihan mengaburkan struktur kod. Mengabaikan pengendalian ralat membawa kepada tingkah laku yang tidak dijangka dan ranap sistem.

Penjelasan praktikal terperinci pembangunan rangka kerja golang: Soalan dan Jawapan

Jun 06, 2024 am 10:57 AM

Penjelasan praktikal terperinci pembangunan rangka kerja golang: Soalan dan Jawapan

Jun 06, 2024 am 10:57 AM

Dalam pembangunan rangka kerja Go, cabaran biasa dan penyelesaiannya ialah: Pengendalian ralat: Gunakan pakej ralat untuk pengurusan dan gunakan perisian tengah untuk mengendalikan ralat secara berpusat. Pengesahan dan kebenaran: Sepadukan perpustakaan pihak ketiga dan cipta perisian tengah tersuai untuk menyemak bukti kelayakan. Pemprosesan serentak: Gunakan goroutine, mutex dan saluran untuk mengawal akses sumber. Ujian unit: Gunakan pakej, olok-olok dan stub untuk pengasingan dan alat liputan kod untuk memastikan kecukupan. Penerapan dan pemantauan: Gunakan bekas Docker untuk membungkus penggunaan, menyediakan sandaran data dan menjejak prestasi dan ralat dengan alat pengelogan dan pemantauan.