Peranti teknologi

Peranti teknologi

AI

AI

Mengapa ChatGPT tiba-tiba menjadi begitu berkuasa? Artikel panjang doktor Cina sebanyak 10,000 patah perkataan mengupas secara mendalam asal usul keupayaan GPT-3.5

Mengapa ChatGPT tiba-tiba menjadi begitu berkuasa? Artikel panjang doktor Cina sebanyak 10,000 patah perkataan mengupas secara mendalam asal usul keupayaan GPT-3.5

Mengapa ChatGPT tiba-tiba menjadi begitu berkuasa? Artikel panjang doktor Cina sebanyak 10,000 patah perkataan mengupas secara mendalam asal usul keupayaan GPT-3.5

ChatGPT oleh OpenAI yang dikeluarkan baru-baru ini telah memberi peluang kepada bidang kecerdasan buatannya jauh melebihi jangkaan penyelidik pemprosesan bahasa.

Pengguna yang pernah mengalami ChatGPT secara semula jadi akan bertanya soalan: Bagaimanakah GPT 3 asal berkembang menjadi ChatGPT? Dari manakah datangnya keupayaan bahasa yang menakjubkan GPT 3.5?

Baru-baru ini, penyelidik dari Allen Institute for Artificial Intelligence menulis artikel cuba menganalisis Keupayaan Muncul ChatGPT, dan Mengesan asal usul keupayaan ini , peta jalan teknikal yang komprehensif diberikan untuk menggambarkan bagaimana siri model GPT-3.5 dan model bahasa berskala besar yang berkaitan telah berkembang selangkah demi selangkah ke dalam bentuk berkuasa semasa mereka.

Pautan asal: https://yaofu.notion.site/GPT-3-5-360081d91ec245f29029d37b54573756>

Penulis Fu Yao ialah pelajar kedoktoran di Universiti Edinburgh yang mendaftar pada tahun 2020. Beliau lulus dengan ijazah sarjana dari Columbia University dan ijazah sarjana muda dari Universiti Peking Beliau kini berada di Institut Allen untuk Kerja Kecerdasan Buatan sebagai pelatih penyelidikan. Arah penyelidikan utamanya ialah model generatif kemungkinan besar berskala besar bagi bahasa manusia.

Penulis Peng Hao lulus dari Universiti Peking dengan ijazah sarjana muda dan Ph.D dari Universiti Washington Allen Institute for Artificial Intelligence dan akan menamatkan pengajian pada 2023 Pada bulan Ogos, beliau menyertai Jabatan Sains Komputer di Universiti Illinois di Urbana-Champaign sebagai penolong profesor. Minat penyelidikan utamanya termasuk menjadikan AI bahasa lebih cekap dan mudah difahami, dan membina model bahasa berskala besar.

Pengarang Tushar Khot lulus dari Universiti Wisconsin-Madison dengan Ph.D dan kini seorang saintis penyelidikan di Allen Institute for Artificial Intelligence. Arah penyelidikan utamanya ialah penaakulan mesin berstruktur.

1. Versi 2020 bagi GPT-3 generasi pertama dan pra-latihan berskala besar

GPT-3 generasi pertama menunjukkan tiga keupayaan penting:

- Penjanaan bahasa: Ikuti gesaan dan kemudian jana ayat yang melengkapkan gesaan. Ini juga merupakan cara paling biasa manusia berinteraksi dengan model bahasa hari ini.

- Pembelajaran dalam konteks: Ikuti beberapa contoh tugasan yang diberikan dan kemudian hasilkan penyelesaian untuk kes ujian baharu. Perkara yang sangat penting ialah walaupun GPT-3 adalah model bahasa, kertas kerjanya hampir tidak bercakap tentang "pemodelan bahasa" - penulis menumpukan semua tenaga penulisan mereka kepada visi pembelajaran kontekstual Ini adalah fokus sebenar GPT-3.

- Ilmu dunia: Termasuk pengetahuan fakta dan akal sehat.

Jadi dari mana datangnya kebolehan ini?

Pada asasnya, tiga keupayaan di atas datang daripada pra-latihan berskala besar: pra-latihan model dengan 175 bilion parameter pada korpus 300 bilion perkataan (60% daripada korpus latihan datang daripada C4 pada 2016-2019 + 22% daripada WebText2 + 16% daripada Buku + 3% daripada Wikipedia). Antaranya:

- Keupayaan penjanaan bahasa datang daripada matlamat latihan pemodelan bahasa (language modelling).

- Pengetahuan dunia datang daripada korpus latihan sebanyak 300 bilion perkataan (di mana lagi).

- 175 bilion parameter model adalah untuk menyimpan pengetahuan, yang selanjutnya dibuktikan oleh artikel oleh Liang et al (2022). Mereka membuat kesimpulan bahawa prestasi pada tugas berintensif pengetahuan berkait rapat dengan saiz model.

- Asal usul keupayaan pembelajaran konteks dan sebab pembelajaran konteks boleh digeneralisasikan masih sukar untuk dikesan. Secara intuitif, keupayaan ini mungkin datang dari titik data dari tugas yang sama yang disusun secara berurutan dalam kelompok yang sama semasa latihan. Walau bagaimanapun, sedikit kajian telah dilakukan tentang mengapa model bahasa pra-latihan mendorong pembelajaran kontekstual, dan mengapa pembelajaran kontekstual berkelakuan sangat berbeza daripada penalaan halus.

Apa yang ingin tahu ialah betapa berkuasanya GPT-3 generasi pertama.

Malah, sukar untuk menentukan sama ada GPT-3 asal (dipanggil davinci dalam OpenAI API) adalah "kuat" atau "lemah".

Dalam satu pihak, ia menjawab dengan munasabah kepada beberapa pertanyaan khusus dan mencapai prestasi yang baik dalam banyak set data

Sebaliknya, ia tidak berfungsi sebaik model yang lebih kecil seperti T5 pada banyak tugas (lihat kertas asalnya).

Di bawah piawaian ChatGPT hari ini (Disember 2022), sukar untuk mengatakan bahawa GPT-3 asal adalah "pintar". Model OPT sumber terbuka Meta cuba untuk meniru GPT-3 asal, tetapi keupayaannya sangat berbeza dengan piawaian hari ini. Ramai orang yang telah menguji OPT juga percaya bahawa berbanding dengan teks-davinci-002 semasa, model itu sememangnya "tidak begitu baik".

Walau bagaimanapun, OPT mungkin merupakan anggaran sumber terbuka yang cukup baik bagi GPT-3 asal (mengikut kertas OPT dan penilaian HELM Universiti Stanford).

Walaupun GPT-3 generasi pertama mungkin kelihatan lemah di permukaan, percubaan seterusnya membuktikan bahawa GPT-3 generasi pertama mempunyai potensi yang sangat kuat. Potensi ini kemudiannya dibuka dengan latihan kod, penalaan arahan dan pembelajaran pengukuhan dengan maklum balas manusia (RLHF), dan badan terakhir menunjukkan keupayaan muncul yang sangat berkuasa.

2 Daripada versi 2020 GPT-3 kepada versi 2022 ChatGPT

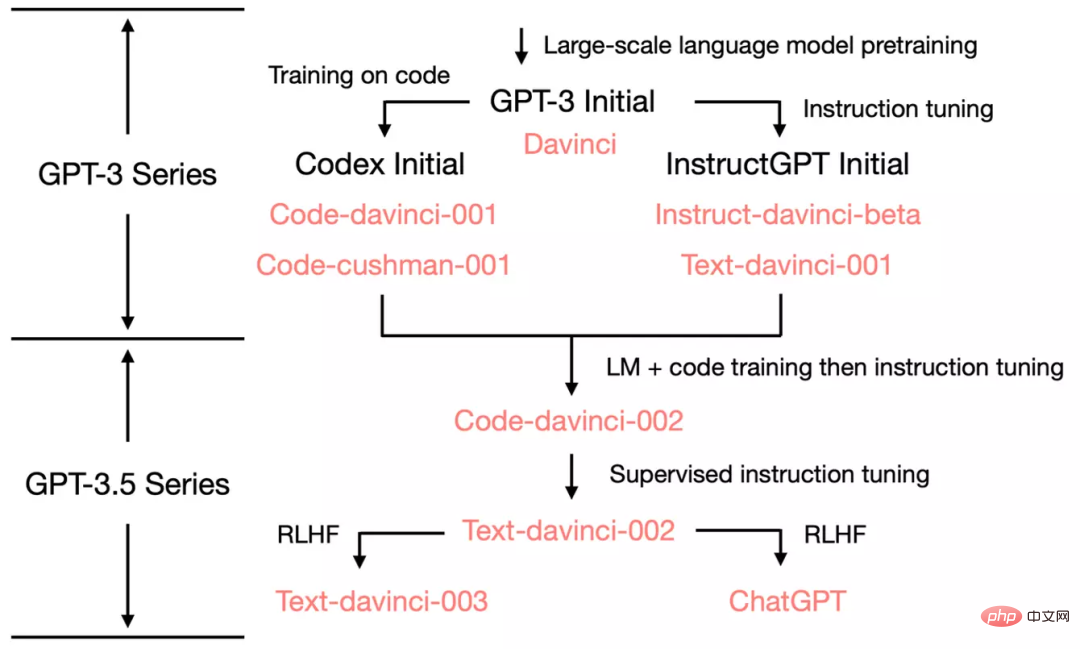

Bermula daripada GPT-3 yang asal, untuk menunjukkan cara OpenAI berkembang kepada ChatGPT, kita lihat Mari kita lihat pokok evolusi GPT-3.5:

Pada Julai 2020, OpenAI mengeluarkan GPT generasi pertama- 3 kertas davinci dengan indeks model, Ia terus berkembang sejak itu.

Pada Julai 2021, kertas Codex telah dikeluarkan, yang mana Codex awal telah diperhalusi berdasarkan (mungkin dalaman) 12 bilion parameter varian GPT-3. Model parameter 12 bilion ini kemudiannya berkembang menjadi code-cushman-001 dalam OpenAI API.

Pada Mac 2022, OpenAI mengeluarkan kertas kerja tentang penalaan arahan, dan bahagian penalaan arahan yang diselia sepadan dengan davinci-instruct-beta dan text- davinci-001.

Dari April hingga Julai 2022, OpenAI mula menguji beta model code-davinci-002, juga dipanggil Codex. Kemudian kod-davinci-002, text-davinci-003 dan ChatGPT semuanya diperoleh dengan arahan penalaan halus daripada kod-davinci-002. Lihat dokumentasi indeks model OpenAI untuk butiran.

Walaupun Codex berbunyi seperti model kod sahaja, code-davinci-002 mungkin merupakan varian GPT-3.5 yang paling berkuasa untuk bahasa semula jadi (lebih baik daripada teks- davinci-002 dan -003 ). Berkemungkinan kod-davinci-002 telah dilatih pada kedua-dua teks dan kod dan kemudian disesuaikan berdasarkan arahan (diterangkan di bawah).

Kemudian text-davinci-002 dikeluarkan pada Mei-Jun 2022 ialah model talaan arahan yang diselia berdasarkan kod-davinci-002. Penalaan halus arahan pada text-davinci-002 berkemungkinan mengurangkan keupayaan pembelajaran kontekstual model, tetapi meningkatkan keupayaan tangkapan sifar model (akan diterangkan di bawah).

Kemudian terdapat model text-davinci-003 dan ChatGPT, kedua-duanya dikeluarkan pada November 2022, yang merupakan versi pembelajaran pengukuhan berdasarkan maklum balas manusia (penalaan arahan dengan pembelajaran pengukuhan daripada maklum balas manusia) model Dua variasi berbeza.

text-davinci-003 memulihkan (tetapi masih lebih teruk daripada code-davinci-002) beberapa keupayaan pembelajaran konteks separa yang hilang dalam text-davinci-002 (mungkin kerana ia adalah Pemodelan bahasa dicampur semasa penalaan halus) dan keupayaan sampel sifar telah dipertingkatkan lagi (terima kasih kepada RLHF). ChatGPT, sebaliknya, nampaknya mengorbankan hampir semua keupayaan pembelajaran konteks untuk keupayaan untuk memodelkan sejarah perbualan.

Secara amnya, semasa 2020-2021, sebelum code-davinci-002, OpenAI telah banyak berusaha untuk meningkatkan GPT-3 melalui latihan kod dan penalaan halus arahan. Pada masa mereka melengkapkan kod-davinci-002, semua keupayaan sudah ada. Kemungkinan penalaan halus arahan berikutnya, sama ada melalui versi diselia atau versi pembelajaran pengukuhan, akan melakukan perkara berikut (lebih lanjut mengenai perkara ini kemudian):

- Arahan halus- penalaan tidak Keupayaan baru akan disuntik ke dalam model - semua keupayaan yang sedia ada. Peranan arahan arahan adalah untuk membuka kunci/mengaktifkan kebolehan ini. Ini terutamanya kerana jumlah data untuk penalaan halus arahan adalah beberapa susunan magnitud yang lebih kecil daripada jumlah data pra-latihan (keupayaan asas disuntik melalui pra-latihan).

- Penalaan halus perintah membahagikan GPT-3.5 kepada pokok kemahiran yang berbeza. Ada yang lebih baik dalam pembelajaran kontekstual, seperti text-davinci-003, dan ada yang lebih baik dalam perbualan, seperti ChatGPT.

-

Penalaan halus arahan mengorbankan prestasi untuk penjajaran manusia. Pengarang OpenAI memanggil ini sebagai "cukai penjajaran" dalam kertas penalaan halus arahan mereka.

Banyak kertas melaporkan bahawa code-davinci-002 mencapai prestasi terbaik dalam penanda aras (tetapi model itu tidak semestinya sepadan dengan jangkaan manusia). Selepas arahan penalaan halus pada kod-davinci-002, model boleh menjana maklum balas yang lebih selaras dengan jangkaan manusia (atau model diselaraskan dengan manusia), seperti: soalan dan jawapan sifar sampel, menjana dialog yang selamat dan adil respons, dan menolak di luar skop masalah model.

3. Code-Davinci-002 dan Text-Davinci-002, latihan tentang kod dan penalaan halus pada arahan

Dalam code-davinci -002 Sebelum text-davinci-002, terdapat dua model perantaraan, iaitu davinci-instruct-beta dan text-davinci-001. Kedua-duanya lebih teruk daripada model dua-002 yang disebutkan di atas dalam banyak aspek (contohnya, keupayaan penaakulan pemikiran berantai text-davinci-001 tidak kukuh).

Jadi kami menumpukan pada model -002 dalam bahagian ini.

3.1 Sumber keupayaan penaakulan yang kompleks dan kebolehan untuk membuat generalisasi kepada tugasan baharu

Kami menumpukan pada code-davinci-002 dan text-davinci-002, kedua-duanya saudara ialah Versi pertama model GPT3.5, satu untuk kod dan satu lagi untuk teks. Mereka mempamerkan tiga keupayaan penting yang berbeza daripada GPT-3 asal:

- Respons kepada arahan manusia: Sebelum ini, output GPT-3 ialah terutamanya Ayat biasa dalam set latihan. Model kini menjana jawapan yang lebih munasabah (bukan ayat yang relevan tetapi tidak berguna) kepada arahan/perkataan isyarat.

- Umumkan kepada tugas yang tidak kelihatan: Apabila bilangan arahan yang digunakan untuk melaraskan model melebihi skala tertentu, model secara automatik boleh melaksanakan tugas yang tidak pernah dilihat sebelum ini Jawapan yang sah juga boleh dihasilkan pada arahan baharu. Keupayaan ini adalah penting untuk penggunaan dalam talian, kerana pengguna akan sentiasa bertanya soalan baharu, dan model mesti dapat menjawabnya.

- Penjanaan kod dan pemahaman kod: Keupayaan ini jelas kerana model dilatih dengan kod.

- Gunakan rantaian pemikiran untuk penaakulan yang kompleks: Keupayaan penaakulan rantaian pemikiran model asal GPT3 adalah lemah atau bahkan tidak wujud. code-davinci-002 dan text-davinci-002 ialah dua model dengan keupayaan penaakulan rantai pemikiran yang cukup kuat.

- Penalaran rantaian pemikiran adalah penting kerana rantaian pemikiran mungkin menjadi kunci untuk membuka kunci keupayaan yang muncul dan melangkaui undang-undang skala.

Dari mana datangnya kebolehan ini?

Berbanding dengan model sebelumnya, dua perbezaan utama ialah penalaan halus arahan dan latihan kod. Khususnya:

- Keupayaan untuk bertindak balas kepada arahan manusia adalah hasil langsung daripada penalaan halus perintah.

- Keupayaan generalisasi untuk bertindak balas kepada arahan yang tidak kelihatan muncul secara automatik selepas bilangan arahan melebihi tahap tertentu, dan kertas T0, Flan dan FlanPaLM membuktikannya lagi.

- Keupayaan untuk menggunakan rantai pemikiran untuk penaakulan yang kompleks mungkin merupakan hasil sampingan ajaib latihan pengekodan. Kami mempunyai beberapa sokongan untuk perkara ini dengan fakta berikut:

- GPT-3 asal tidak dilatih untuk mengekod, ia tidak boleh melakukan rantaian pemikiran.

- model text-davinci-001, walaupun ia telah diperhalusi dengan arahan, versi pertama kertas rantai pemikiran melaporkan bahawa keupayaannya untuk menaakul dengan rantai pemikiran lain adalah sangat lemah ——jadi arahan diperhalusi Ia mungkin bukan sebab mengapa rantaian pemikiran wujud adalah sebab yang paling mungkin mengapa model boleh melakukan penaakulan rantaian pemikiran.

- PaLM mempunyai 5% data latihan kod dan boleh melakukan rantaian pemikiran.

- Volume data kod dalam kertas Codex ialah 159G, iaitu kira-kira 28% daripada 570 bilion data latihan GPT-3 asal. code-davinci-002 dan varian seterusnya boleh melakukan penaakulan rantaian pemikiran.

- Dalam ujian HELM, Liang et al (2022) menjalankan penilaian berskala besar bagi model yang berbeza. Mereka mendapati bahawa model yang dilatih mengenai kod mempunyai keupayaan inferens bahasa yang kuat, termasuk 12 bilion parameter code-cushman-001.

- Kerja kami di AI2 juga menunjukkan bahawa apabila dilengkapi dengan rantai pemikiran yang kompleks, code-davinci-002 kini merupakan model berprestasi terbaik pada penanda aras matematik yang penting seperti GSM8K.

- Secara intuitif, pengaturcaraan berorientasikan prosedur sangat serupa dengan proses di mana manusia menyelesaikan tugasan langkah demi langkah, dan pengaturcaraan berorientasikan objek adalah serupa dengan proses di mana manusia menyelesaikan langkah tugas yang kompleks mengikut langkah Proses memecahkannya kepada tugasan mudah adalah serupa.

- Semua pemerhatian di atas adalah korelasi antara kod dan rantaian keupayaan penaakulan/pemikiran, tetapi tidak semestinya sebab. Korelasi ini menarik, tetapi kini merupakan persoalan terbuka untuk dikaji. Pada masa ini, kami tidak mempunyai bukti yang sangat konklusif bahawa kod adalah punca rantaian pemikiran dan penaakulan yang kompleks.

- Selain itu, satu lagi hasil sampingan latihan kod yang mungkin adalah kebergantungan jarak jauh, seperti yang ditunjukkan oleh Peter Liu: "Ramalan perkataan seterusnya dalam bahasa biasanya sangat setempat, dan kod biasanya memerlukan kebergantungan yang lebih lama melakukan perkara seperti memadankan kurungan pembukaan dan penutup atau merujuk kepada definisi fungsi yang jauh." Apa yang saya ingin tambahkan lagi di sini ialah: disebabkan pewarisan kelas dalam pengaturcaraan berorientasikan objek, kod juga mungkin menyumbang kepada keupayaan model untuk mewujudkan hierarki pengekodan. Kami menyerahkan ujian hipotesis ini kepada kerja masa hadapan.

Juga perhatikan beberapa perbezaan dalam butiran:

- text-davinci-002 dan code-davinci-002 ialah Model asas, text-davinci-002, ialah produk arahan penalaan halus kod-davinci-002 (lihat OpenAI dokumentasi). Ia diperhalusi pada data berikut: (1) arahan beranotasi manusia dan output yang dijangkakan; (2) output model yang dipilih oleh anotasi manusia.

- Tidak mungkin OpenAI sengaja mengorbankan keupayaan pembelajaran kontekstual sebagai pertukaran untuk keupayaan sampel sifar - pengurangan keupayaan pembelajaran kontekstual lebih merupakan kesan sampingan pembelajaran arahan, yang OpenAI cukai penjajaran panggilan.

- model 001 (kod-cushman-001 dan teks-davinci-001) lwn model 002 (kod-davinci-002 dan teks-davinci- 002)

- Model 001 digunakan terutamanya untuk tugasan kod tulen/teks tulen model 002 menyepadukan latihan kod dan penalaan halus, kod dan Sebarang teks akan berjaya.

- 3.2 Adakah keupayaan ini sudah ada selepas pra-latihan atau adakah ia disuntik kemudian melalui penalaan halus?

- Pada peringkat ini, kami telah mengenal pasti peranan kritikal penalaan halus arahan dan latihan kod. Soalan penting ialah bagaimana untuk menganalisis lebih lanjut kesan latihan kod dan penalaan halus arahan?

Khususnya:

Adakah ketiga-tiga kebolehan di atas sudah wujud dalam GPT-3 asal dan hanya dicetuskan/dikunci melalui arahan dan latihan kod? Atau adakah keupayaan ini tidak wujud dalam GPT-3 asal, tetapi disuntik melalui arahan dan latihan kod?

Jika jawapan sudah ada dalam GPT-3 asal, maka keupayaan ini juga harus berada dalam OPT. Oleh itu, untuk menghasilkan semula keupayaan ini, adalah mungkin untuk melaraskan OPT secara langsung melalui arahan dan kod. Walau bagaimanapun, ada kemungkinan kod-davinci-002 tidak berdasarkan GPT-3 davinci asal, tetapi berdasarkan model yang lebih besar daripada GPT-3 asal. Jika ini berlaku, mungkin tiada cara untuk mengeluarkannya semula dengan melaraskan OPT.

Komuniti penyelidik perlu menjelaskan lagi jenis model OpenAI yang dilatih sebagai model asas untuk code-davinci-002.

Kami mempunyai hipotesis dan bukti berikut:

- Model asas code-davinci-002 mungkin bukan model GPT-3 davinci generasi pertama.

- GPT-3 asal telah dilatih pada set data C4 2016 - 2019, manakala set latihan code-davinci-002 sedang dilanjutkan kepada 2021 Baru sahaja tamat. Jadi ada kemungkinan kod-davinci-002 dilatih pada versi 2019-2021 C4.

- GPT-3 asal mempunyai tetingkap konteks sebanyak 2048 perkataan. Tetingkap konteks untuk kod-davinci-002 ialah 8192. Siri GPT menggunakan pembenaman kedudukan mutlak Mengekstrapolasi secara langsung pembenaman kedudukan mutlak tanpa latihan adalah sukar dan akan merosakkan prestasi model dengan serius (lihat Press et al., 2022). Jika kod-davinci-002 adalah berdasarkan GPT-3 asal, bagaimanakah OpenAI memanjangkan tetingkap konteks?

- Sebaliknya, sama ada model asas ialah GPT-3 asal atau model yang dilatih kemudian, keupayaan untuk mengikut arahan dan sifar- generalisasi pukulan mungkin sudah wujud dalam model asas dan dibuka kunci kemudian melalui tweak arahan (bukan disuntik).

- Ini terutamanya kerana saiz data arahan yang dilaporkan dalam kertas OpenAI hanya 77K, iaitu beberapa susunan magnitud kurang daripada pra -data latihan.

- Kertas penalaan halus arahan lain membuktikan lagi kontras saiz set data pada prestasi model Contohnya, dalam kerja Chung et al (2022), penalaan halus Flan-PaLM hanya pra-latihan Dikira 0.4%. Secara umumnya, data arahan akan jauh lebih rendah daripada data pra-latihan.

- Walau bagaimanapun, keupayaan penaakulan kompleks model mungkin melalui suntikan data kod semasa peringkat pra-latihan. Saiz set data kod adalah berbeza daripada kes penalaan halus arahan di atas. Jumlah data kod di sini cukup besar untuk menduduki sebahagian besar data latihan (cth., PaLM mempunyai 8% daripada data latihan kod)

- Mungkin cara terbaik untuk membezakan kesan latihan kod dan penalaan halus arahan ialah membandingkan kod-cushman-001, T5 dan FlanT5 .

- Oleh kerana mereka mempunyai saiz model yang sama (11 bilion dan 12 bilion), set data latihan yang serupa (C4), perbezaan terbesarnya ialah Sudahkah anda berlatih pada kod/sudahkah anda melakukan penalaan halus arahan?

- 4. text-davinci-003 dan ChatGPT, kuasa Pembelajaran Pengukuhan daripada Maklum Balas Manusia (RLHF)

- pada peringkat sekarang (Disember 2022), hampir tiada perbandingan statistik yang ketat antara text-davinci-002, text-davinci-003 dan ChatGPT, terutamanya kerana:

ChatGPT tidak boleh dipanggil melalui OpenAI API, jadi mengujinya pada penanda aras standard adalah menyusahkan.

- Jadi perbandingan antara model ini lebih berdasarkan pengalaman kolektif komuniti penyelidik (secara statistik tidak begitu ketat). Walau bagaimanapun, kami percaya bahawa perbandingan deskriptif awal masih boleh menjelaskan mekanisme model.

- Kami mula-mula perhatikan perbandingan berikut antara text-davinci-002, text-davinci-003 dan ChatGPT:

Ketiga-tiga model telah diperhalusi atas arahan.

text-davinci-002 ialah model yang telah diperhalusi dengan penalaan arahan yang diawasi.

- text-davinci-003 dan ChatGPT adalah penalaan Arahan dengan Pembelajaran Pengukuhan daripada Maklum Balas Manusia RLHF. Ini adalah perbezaan yang paling ketara antara mereka.

- Ini bermakna gelagat kebanyakan model baharu ialah artifak RLHF.

Jadi mari kita lihat keupayaan pencetus RLHF:

- Respons bermaklumat: Generasi teks-davinci-003 biasanya lebih cepat daripada teks-davinci-002 panjang. Respons ChatGPT adalah lebih panjang, sehinggakan pengguna mesti meminta "Jawab saya dalam satu ayat" secara eksplisit untuk mendapatkan jawapan yang lebih ringkas. Ini adalah hasil langsung RLHF.

- Respons yang adil: CtGPT sering memberikan jawapan yang sangat seimbang kepada acara yang melibatkan kepentingan berbilang entiti, seperti acara politik. Ini juga merupakan produk RLHF.

- Penolakan isu yang tidak sesuai: Ini ialah gabungan penapis kandungan dan keupayaan model sendiri yang dicetuskan oleh RLHF, di mana penapis menapis sebahagian dan kemudian model menolak sebahagian.

- Tolak soalan di luar pengetahuannya: Contohnya, tolak peristiwa baharu yang berlaku selepas Jun 2021 (kerana ia tidak termasuk dalam data selepas itu) terlatih). Ini adalah bahagian yang paling menakjubkan dalam RLHF, kerana ia membolehkan model membezakan secara tersirat masalah yang mana dalam pengetahuannya dan yang mana tidak.

Terdapat dua perkara yang perlu diberi perhatian:

- Semua keupayaan adalah wujud dalam model, bukan Disuntik melalui RLHF. Apa yang RLHF lakukan ialah mencetus/membuka kebolehan yang muncul. Argumen ini terutamanya datang daripada perbandingan saiz data: berbanding dengan jumlah data pra-latihan, RLHF mengambil lebih sedikit kuasa/data pengkomputeran.

- Model mengetahui perkara yang tidak diketahuinya bukan dengan menulis peraturan, tetapi dengan membuka kuncinya melalui RLHF. Ini adalah penemuan yang sangat mengejutkan kerana matlamat asal RLHF adalah untuk memastikan model menjana respons yang menggabungkan jangkaan manusia, yang lebih kepada model menghasilkan ayat yang selamat daripada membiarkan model mengetahui perkara yang tidak diketahuinya.

Apa yang berlaku di sebalik tabir mungkin:

- ChatGPT: Mengorbankan keupayaan untuk mempelajari konteks sebagai pertukaran untuk pemodelan keupayaan sejarah perbualan. Ini adalah pemerhatian empirikal, kerana ChatGPT nampaknya tidak begitu terjejas oleh pembentangan kontekstual seperti text-davinci-003.

- text-davinci-003: Memulihkan keupayaan pembelajaran konteks yang dikorbankan oleh text-davinci-002 dan meningkatkan keupayaan sifar sampel. Menurut kertas instructGPT, ini datang daripada peringkat penalaan pembelajaran pengukuhan yang dicampur dengan matlamat pemodelan bahasa (bukannya RLHF itu sendiri).

5 Ringkasan proses evolusi GPT-3.5 pada peringkat semasa

Setakat ini, kami telah meneliti dengan teliti semua keupayaan yang telah muncul bersama. pokok evolusi, Jadual berikut meringkaskan laluan evolusi:

Kita boleh membuat kesimpulan:

- Keupayaan penjanaan bahasa + pengetahuan asas dunia + pembelajaran konteks semuanya datang daripada pra-latihan (davinci).

- Keupayaan untuk menyimpan sejumlah besar pengetahuan datang daripada jumlah 175 bilion parameter.

- Keupayaan untuk mengikuti arahan dan membuat generalisasi kepada tugasan baharu datang daripada memperluaskan bilangan arahan dalam pembelajaran arahan (Davinci-instruct-beta).

- Keupayaan untuk melakukan penaakulan yang kompleks mungkin datang daripada latihan kod (code-davinci-002).

- Keupayaan untuk menjana jawapan neutral, objektif, selamat dan bermaklumat datang daripada penjajaran dengan manusia. Khususnya:

- Jika versi pembelajaran diselia, model yang terhasil ialah text-davinci-002.

- Jika ia adalah versi pembelajaran pengukuhan (RLHF), model yang terhasil ialah text-davinci-003.

- Sama ada diselia atau RLHF, prestasi model tidak boleh melebihi kod-davinci-002 dalam banyak tugas Fenomena penurunan prestasi akibat penjajaran ini dipanggil cukai penjajaran.

- Keupayaan dialog juga datang daripada RLHF (ChatGPT Secara khususnya, ia mengorbankan keupayaan pembelajaran konteks sebagai pertukaran untuk:

- Sejarah perbualan model.

- Tingkatkan jumlah maklumat perbualan.

- Tolak soalan yang berada di luar skop pengetahuan model.

Walaupun GPT-3.5 merupakan langkah penting dalam penyelidikan pemprosesan bahasa semula jadi, ia tidak merangkumi Semua sifat yang diingini yang dibayangkan oleh ramai penyelidik (termasuk AI2). Berikut adalah beberapa sifat penting yang tidak dimiliki oleh GPT-3.5:

- Tulis semula kepercayaan model dalam masa nyata: Apabila model menyatakan kepercayaan tentang sesuatu, jika kepercayaan itu salah, kita mungkin mengalami kesukaran untuk membetulkannya:

- Contoh yang saya temui baru-baru ini ialah: ChatGPT menegaskan bahawa 3599 ialah nombor perdana, walaupun ia mengakui bahawa 3599 = 59 * 61. Juga, lihat contoh Reddit ini bagi mamalia marin berenang terpantas.

- Walau bagaimanapun, nampaknya terdapat tahap kekuatan yang berbeza dalam kepercayaan model. Satu contoh ialah walaupun saya memberitahu bahawa Darth Vader (watak dari filem Star Wars) memenangi pilihan raya 2020, model itu masih akan berfikir bahawa presiden Amerika Syarikat sekarang ialah Biden. Tetapi jika saya menukar tahun pilihan raya kepada 2024, ia berpendapat presiden ialah Darth Vader dan presiden pada 2026.

- Penaakulan formal: Siri GPT-3.5 tidak boleh menaakul dalam sistem formal yang ketat seperti matematik atau logik urutan pertama:

- Dalam kesusasteraan pemprosesan bahasa semula jadi, takrif perkataan "inferens" selalunya tidak jelas. Tetapi jika kita melihat dari sudut kekaburan, misalnya, beberapa soalan adalah (a) sangat samar-samar dan tanpa alasan (b) terdapat sedikit logik, tetapi ia juga boleh menjadi samar-samar di beberapa tempat; c) sangat ketat dan tidak boleh mempunyai sebarang kekaburan.

- Kemudian, model boleh melakukan penaakulan jenis (b) dengan kekaburan Contohnya ialah:

- Jana cara. untuk membuat mee tauhu. Apabila membuat puff tauhu, boleh diterima untuk menjadi sedikit kabur dalam banyak langkah, seperti sama ada untuk membuatnya masin atau manis. Selagi langkah keseluruhan adalah kira-kira betul, dadih tauhu boleh dimakan.

- Idea untuk membuktikan teorem matematik. Idea pembuktian ialah penyelesaian langkah demi langkah tidak formal yang dinyatakan dalam bahasa, dan terbitan yang ketat bagi setiap langkah tidak perlu terlalu spesifik. Idea pembuktian sering digunakan dalam pengajaran matematik: selagi guru memberikan langkah keseluruhan yang kira-kira betul, pelajar secara kasar boleh memahaminya. Kemudian guru memberikan butiran bukti khusus kepada pelajar sebagai kerja rumah, dan jawapannya ditinggalkan.

- GPT-3.5 Inferens jenis (c) tidak mungkin (inferens tidak boleh bertolak ansur dengan kekaburan).

- Contohnya ialah bukti matematik yang ketat, yang memerlukan langkah perantaraan tidak boleh dilangkau, dikaburkan atau salah.

- Tetapi sama ada penaakulan ketat seperti ini harus dilakukan oleh model bahasa atau sistem simbolik masih perlu dibincangkan. Satu contoh ialah daripada cuba mendapatkan GPT untuk melakukan penambahan tiga digit, hanya panggil Python.

- Mencari dari Internet: Siri GPT-3.5 tidak boleh (belum) mencari Internet secara langsung.

- Tetapi terdapat kertas WebGPT yang diterbitkan pada Disember 2021, yang membolehkan GPT memanggil enjin carian. Jadi keupayaan mendapatkan semula telah diuji dalam OpenAI.

- Perkara yang perlu dibezakan di sini ialah dua keupayaan penting tetapi berbeza GPT-3.5 ialah pengetahuan dan penaakulan. Secara umumnya, alangkah baiknya jika kita boleh memunggah bahagian pengetahuan kepada sistem perolehan luaran dan membiarkan model bahasa memberi tumpuan hanya pada penaakulan. Kerana:

- Pengetahuan dalaman model sentiasa terputus pada satu ketika. Model sentiasa memerlukan pengetahuan terkini untuk menjawab soalan terkini.

- Ingat bahawa kita telah membincangkan bahawa 175 bilion parameter banyak digunakan untuk menyimpan pengetahuan. Jika kita boleh memunggah pengetahuan di luar model, parameter model boleh dikurangkan sehingga akhirnya ia boleh dijalankan pada telefon mudah alih (idea gila, tetapi ChatGPT cukup sci-fi, siapa tahu masa depannya).

7 Kesimpulan

Dalam catatan blog ini, kami meneliti dengan teliti julat keupayaan siri GPT-3.5 dan mengesan asal usul semua kemunculannya sumber keupayaan.

Model GPT-3 generasi pertama memperoleh keupayaan generatif, pengetahuan dunia dan pembelajaran dalam konteks melalui pra-latihan. Kemudian melalui cabang model penalaan arahan, kami memperoleh keupayaan untuk mengikuti arahan dan membuat generalisasi kepada tugas yang tidak kelihatan. Model cawangan yang dilatih oleh kod memperoleh keupayaan untuk memahami kod Sebagai hasil sampingan latihan kod, model juga berpotensi memperoleh keupayaan untuk melakukan penaakulan yang kompleks.

Menggabungkan kedua-dua cabang ini, code-davinci-002 nampaknya model GPT-3.5 terkuat dengan semua keupayaan hebat. Seterusnya, melalui penalaan arahan yang diselia dan RLHF, keupayaan model dikorbankan sebagai pertukaran untuk penjajaran manusia, iaitu cukai penjajaran. RLHF membolehkan model menjana jawapan yang lebih bermaklumat dan tidak berat sebelah sambil menolak soalan di luar julat pengetahuannya.

Kami berharap artikel ini dapat membantu memberikan gambaran yang jelas tentang penilaian GPT dan mencetuskan beberapa perbincangan tentang model bahasa, penalaan arahan dan penalaan kod. Paling penting, kami berharap artikel ini boleh berfungsi sebagai peta jalan untuk menghasilkan semula GPT-3.5 dalam komuniti sumber terbuka.

Soalan Lazim

- Adakah kenyataan ini dalam artikel ini lebih seperti hipotesis atau kesimpulan?

- Keupayaan untuk menaakul secara kompleks daripada latihan kod ialah andaian yang kita cenderung untuk percaya.

- Keupayaan untuk membuat generalisasi kepada tugasan ghaib datang daripada pembelajaran arahan berskala besar adalah kesimpulan sekurang-kurangnya 4 kertas kerja.

- Adalah tekaan terpelajar bahawa GPT-3.5 datang daripada model asas besar lain, bukan 175 bilion parameter GPT-3.

- Semua keupayaan ini sudah wujud, dan merupakan hipotesis yang kukuh untuk membuka kunci keupayaan ini melalui penalaan arahan, sama ada pembelajaran diselia atau pembelajaran pengukuhan, dan bukannya menyuntiknya. Anda tidak berani mempercayainya ia. Terutamanya kerana jumlah data penalaan arahan adalah beberapa susunan magnitud kurang daripada jumlah data pra-latihan.

- Kesimpulan = banyak bukti untuk menyokong kesahihan dakwaan ini = bukti positif tetapi tidak cukup kukuh; >

- Mengapa model lain seperti OPT dan BLOOM tidak begitu berkuasa?

- OPT mungkin kerana proses latihan terlalu tidak stabil.

- Situasi BLOOM tidak diketahui.

Atas ialah kandungan terperinci Mengapa ChatGPT tiba-tiba menjadi begitu berkuasa? Artikel panjang doktor Cina sebanyak 10,000 patah perkataan mengupas secara mendalam asal usul keupayaan GPT-3.5. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1382

1382

52

52

ChatGPT kini membenarkan pengguna percuma menjana imej dengan menggunakan DALL-E 3 dengan had harian

Aug 09, 2024 pm 09:37 PM

ChatGPT kini membenarkan pengguna percuma menjana imej dengan menggunakan DALL-E 3 dengan had harian

Aug 09, 2024 pm 09:37 PM

DALL-E 3 telah diperkenalkan secara rasmi pada September 2023 sebagai model yang jauh lebih baik daripada pendahulunya. Ia dianggap sebagai salah satu penjana imej AI terbaik setakat ini, mampu mencipta imej dengan perincian yang rumit. Walau bagaimanapun, semasa pelancaran, ia adalah tidak termasuk

Gabungan sempurna ChatGPT dan Python: mencipta chatbot perkhidmatan pelanggan yang pintar

Oct 27, 2023 pm 06:00 PM

Gabungan sempurna ChatGPT dan Python: mencipta chatbot perkhidmatan pelanggan yang pintar

Oct 27, 2023 pm 06:00 PM

Gabungan sempurna ChatGPT dan Python: Mencipta Perkhidmatan Pelanggan Pintar Chatbot Pengenalan: Dalam era maklumat hari ini, sistem perkhidmatan pelanggan pintar telah menjadi alat komunikasi yang penting antara perusahaan dan pelanggan. Untuk memberikan pengalaman perkhidmatan pelanggan yang lebih baik, banyak syarikat telah mula beralih kepada chatbots untuk menyelesaikan tugas seperti perundingan pelanggan dan menjawab soalan. Dalam artikel ini, kami akan memperkenalkan cara menggunakan bahasa ChatGPT dan Python model OpenAI yang berkuasa untuk mencipta bot sembang perkhidmatan pelanggan yang pintar untuk meningkatkan

Bagaimana untuk memasang chatgpt pada telefon bimbit

Mar 05, 2024 pm 02:31 PM

Bagaimana untuk memasang chatgpt pada telefon bimbit

Mar 05, 2024 pm 02:31 PM

Langkah pemasangan: 1. Muat turun perisian ChatGTP dari laman web rasmi ChatGTP atau kedai mudah alih 2. Selepas membukanya, dalam antara muka tetapan, pilih bahasa sebagai bahasa Cina 3. Dalam antara muka permainan, pilih permainan mesin manusia dan tetapkan Spektrum bahasa Cina; 4 Selepas memulakan, masukkan arahan dalam tetingkap sembang untuk berinteraksi dengan perisian.

Bagaimana untuk membangunkan chatbot pintar menggunakan ChatGPT dan Java

Oct 28, 2023 am 08:54 AM

Bagaimana untuk membangunkan chatbot pintar menggunakan ChatGPT dan Java

Oct 28, 2023 am 08:54 AM

Dalam artikel ini, kami akan memperkenalkan cara membangunkan chatbot pintar menggunakan ChatGPT dan Java, dan menyediakan beberapa contoh kod khusus. ChatGPT ialah versi terkini Generative Pre-training Transformer yang dibangunkan oleh OpenAI, teknologi kecerdasan buatan berasaskan rangkaian saraf yang boleh memahami bahasa semula jadi dan menjana teks seperti manusia. Menggunakan ChatGPT kami boleh membuat sembang adaptif dengan mudah

Bolehkah chatgpt digunakan di China?

Mar 05, 2024 pm 03:05 PM

Bolehkah chatgpt digunakan di China?

Mar 05, 2024 pm 03:05 PM

chatgpt boleh digunakan di China, tetapi tidak boleh didaftarkan, begitu juga di Hong Kong dan Macao Jika pengguna ingin mendaftar, mereka boleh menggunakan nombor telefon mudah alih asing untuk mendaftar. Perhatikan bahawa semasa proses pendaftaran, persekitaran rangkaian mesti ditukar IP asing.

Cara menggunakan ChatGPT dan Python untuk melaksanakan fungsi pengecaman niat pengguna

Oct 27, 2023 am 09:04 AM

Cara menggunakan ChatGPT dan Python untuk melaksanakan fungsi pengecaman niat pengguna

Oct 27, 2023 am 09:04 AM

Cara menggunakan ChatGPT dan Python untuk melaksanakan fungsi pengecaman niat pengguna Pengenalan: Dalam era digital hari ini, teknologi kecerdasan buatan secara beransur-ansur menjadi bahagian yang amat diperlukan dalam pelbagai bidang. Antaranya, pembangunan teknologi pemprosesan bahasa semula jadi (Natural Language Processing, NLP) membolehkan mesin memahami dan memproses bahasa manusia. ChatGPT (Chat-GeneratingPtrainedTransformer) ialah sejenis

Bagaimana untuk membina robot perkhidmatan pelanggan pintar menggunakan PHP ChatGPT

Oct 28, 2023 am 09:34 AM

Bagaimana untuk membina robot perkhidmatan pelanggan pintar menggunakan PHP ChatGPT

Oct 28, 2023 am 09:34 AM

Cara menggunakan ChatGPTPHP untuk membina robot perkhidmatan pelanggan yang pintar Pengenalan: Dengan perkembangan teknologi kecerdasan buatan, robot semakin digunakan dalam bidang perkhidmatan pelanggan. Menggunakan ChatGPTPHP untuk membina robot perkhidmatan pelanggan yang pintar boleh membantu syarikat menyediakan perkhidmatan pelanggan yang lebih cekap dan diperibadikan. Artikel ini akan memperkenalkan cara menggunakan ChatGPTPHP untuk membina robot perkhidmatan pelanggan yang pintar dan menyediakan contoh kod khusus. 1. Pasang ChatGPTPHP dan gunakan ChatGPTPHP untuk membina robot perkhidmatan pelanggan yang pintar.

Bagaimana untuk membangunkan pembantu suara berasaskan AI menggunakan ChatGPT dan Java

Oct 27, 2023 pm 06:09 PM

Bagaimana untuk membangunkan pembantu suara berasaskan AI menggunakan ChatGPT dan Java

Oct 27, 2023 pm 06:09 PM

Cara menggunakan ChatGPT dan Java untuk membangunkan pembantu suara berasaskan kecerdasan buatan Perkembangan pesat kecerdasan buatan (Pendek kata Artificial Intelligence, AI) telah memasuki pelbagai bidang, antaranya pembantu suara adalah salah satu aplikasi yang popular. Dalam artikel ini, kami akan memperkenalkan cara membangunkan pembantu suara berasaskan kecerdasan buatan menggunakan ChatGPT dan Java. ChatGPT ialah projek sumber terbuka untuk interaksi melalui bahasa semula jadi, dibangunkan oleh OpenAI, sebuah institusi penyelidikan AI.