Peranti teknologi

Peranti teknologi

AI

AI

AIGC yang mematuhi proses kreatif manusia: model yang menjana cerita pertumbuhan secara automatik muncul

AIGC yang mematuhi proses kreatif manusia: model yang menjana cerita pertumbuhan secara automatik muncul

AIGC yang mematuhi proses kreatif manusia: model yang menjana cerita pertumbuhan secara automatik muncul

Dalam bidang kecerdasan buatan hari ini, artifak penulisan AI muncul satu demi satu, dan teknologi serta produk berubah setiap hari.

Sekiranya GPT-3 yang dikeluarkan oleh OpenAI dua tahun lalu masih kurang dalam penulisan, maka hasil penjanaan ChatGPT suatu ketika dahulu boleh dianggap sebagai "tulisan cantik, plot penuh , dan logik logik" Ia adalah harmoni dan harmoni."

Sesetengah orang mengatakan bahawa jika AI mula menulis, ia benar-benar tiada kaitan dengan manusia.

Tetapi sama ada manusia atau AI, apabila "keperluan bilangan perkataan" ditingkatkan, artikel itu akan menjadi lebih sukar untuk "dikawal".

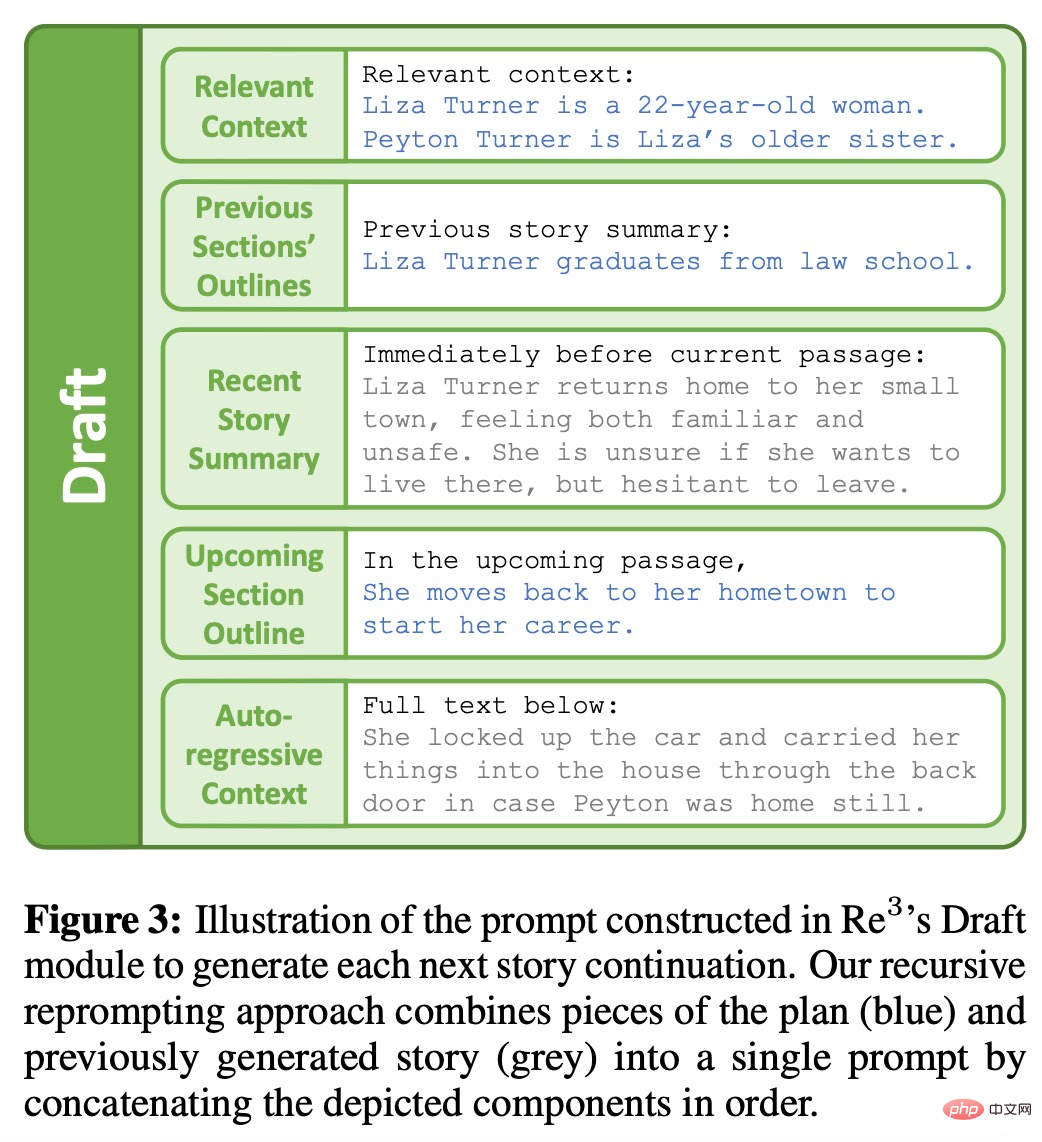

Baru-baru ini, saintis penyelidikan AI China Tian Yuandong dan beberapa penyelidik lain baru-baru ini mengeluarkan model bahasa baharu-Re^3 Penyelidikan ini turut dipilih untuk EMNLP 2022.

Pautan kertas: https://arxiv.org/pdf/2210.06774.pdf

Tian Yuandong pernah memperkenalkan model ini pada Zhihu:

Idea Re^3 sangat mudah dengan mereka bentuk gesaan menjana konsistensi yang kuat, tidak perlu memperhalusi model besar sama sekali. Kami melompat keluar daripada logik linear penjanaan perkataan demi perkataan model bahasa dan menggunakan kaedah penjanaan hierarki: mula-mula menjana watak cerita, pelbagai sifat dan garis besar watak dalam peringkat Rancangan, dan kemudian memberikan rangka cerita dan peranan dalam peringkat Draf, dan berulang kali menjana Perenggan tertentu, perenggan khusus ini ditapis oleh peringkat Tulis Semula untuk memilih perenggan terjana yang sangat berkaitan dengan perenggan sebelumnya, sambil membuang perenggan yang tidak berkait rapat (ini memerlukan latihan model kecil) , dan akhirnya membetulkan beberapa ralat fakta yang jelas dalam peringkat Edit.

Pengenalan Kaedah

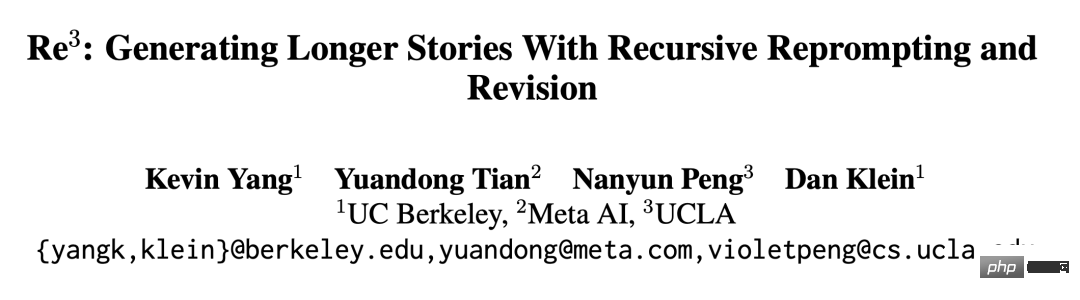

Idea Re^3 adalah untuk menjana cerita yang lebih panjang melalui Rekursif Repropt dan pelarasan, yang lebih selaras dengan proses kreatif penulis manusia. Re^3 membahagikan proses penulisan manusia kepada 4 modul: merancang, merangka, menulis semula dan menyunting.

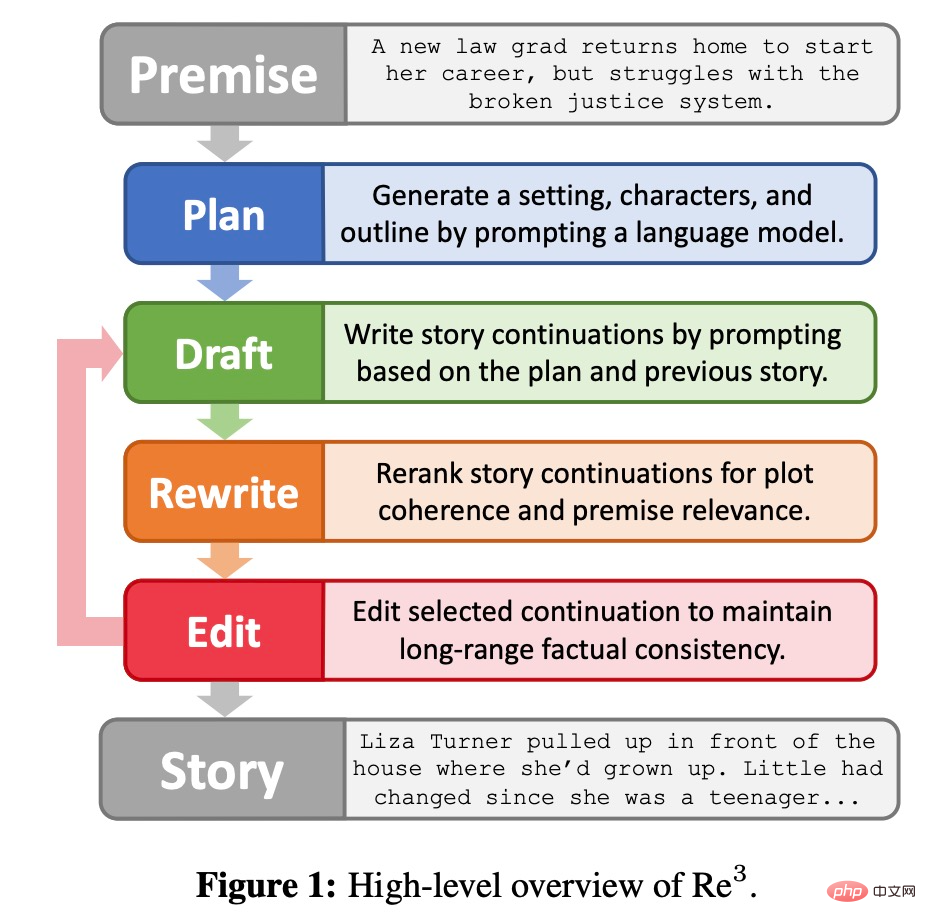

Modul rancangan

Seperti yang ditunjukkan dalam Rajah 2 di bawah, modul perancangan akan mengembangkan premis cerita (Premise) kepada latar belakang, watak dan rangka cerita. Pertama, latar belakang adalah lanjutan satu ayat mudah premis cerita, diperoleh menggunakan GPT3-Instruct-175B (Ouyang et al., 2022), kemudian, GPT3-Instruct175B menjana semula nama watak dan menjana penerangan watak berdasarkan premis dan latar belakang. ; akhirnya, Kaedah menggesa GPT3-Instruct175B untuk menulis rangka cerita. Komponen dalam modul perancangan dijana dengan segera dan akan digunakan berulang kali.

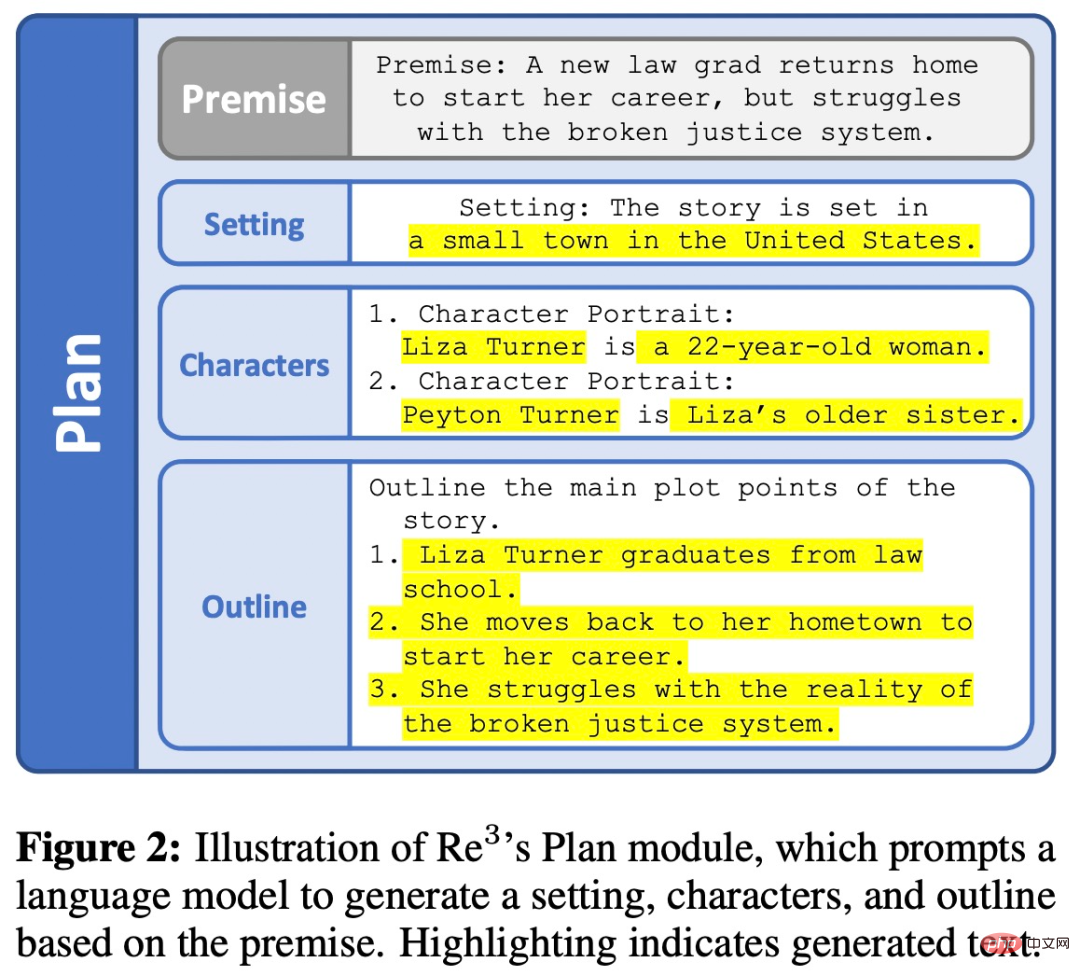

Draf modul

Untuk setiap hasil yang diperolehi oleh modul perancangan An garis besar, modul draf akan terus menghasilkan beberapa perenggan cerita. Setiap perenggan ialah kesinambungan panjang tetap yang dijana daripada gesaan berstruktur yang dibentuk oleh prompt rekursif Modul draf ditunjukkan dalam Rajah 3 di bawah.

Tulis semula modul

Yang pertama daripada penjana Keluaran selalunya kualiti rendah, seperti draf pertama yang disiapkan orang, draf kedua yang mungkin memerlukan penulisan semula artikel berdasarkan maklum balas.

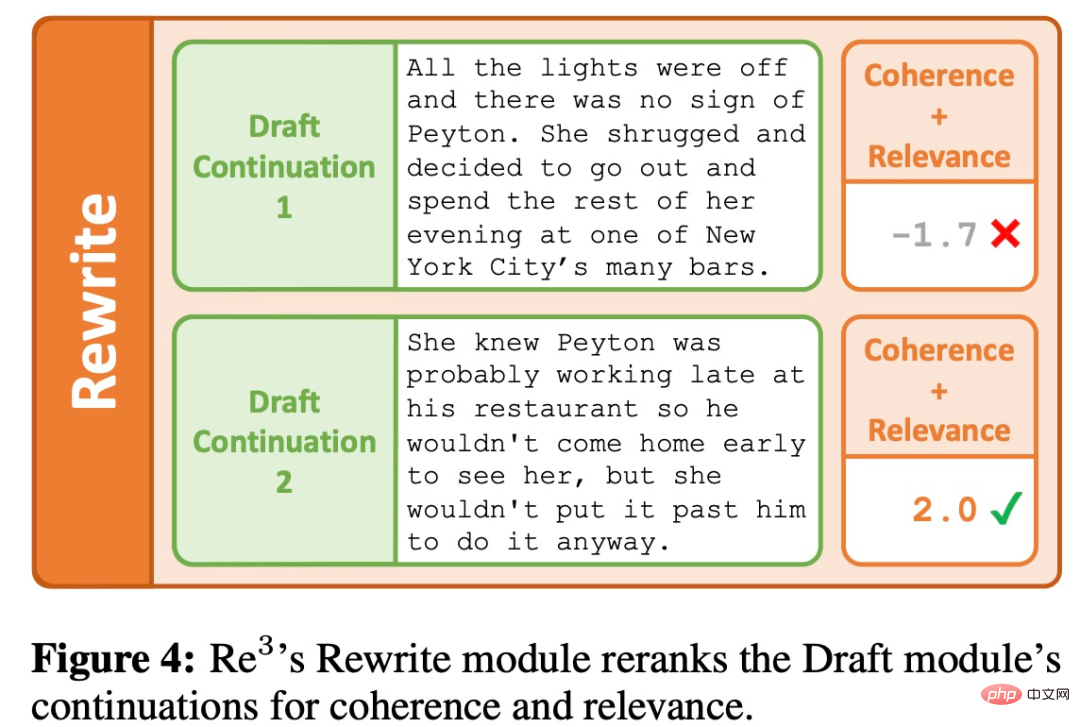

Modul Tulis Semula mensimulasikan proses penulisan semula dengan menyusun semula output modul Draf berdasarkan keselarasan dengan perenggan sebelumnya dan kaitan dengan titik garis besar semasa, seperti yang ditunjukkan dalam Rajah 4 di bawah.

Edit modul

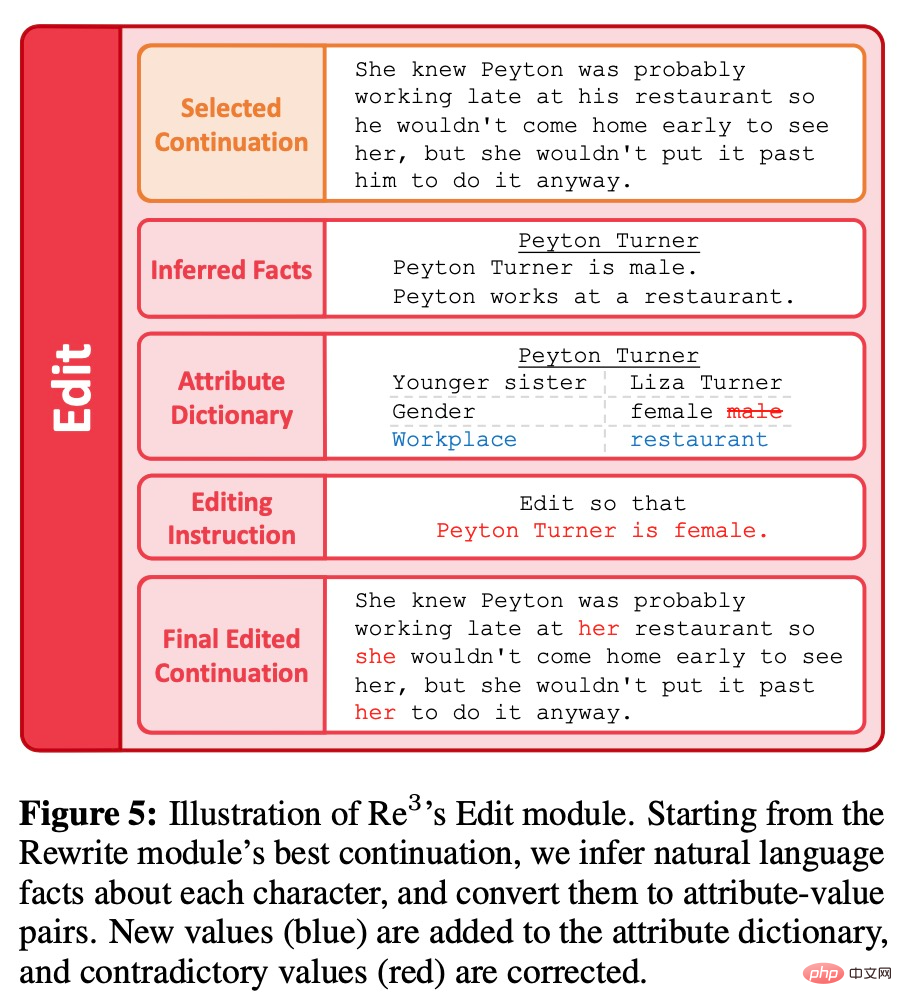

Berbeza daripada penulisan semula yang besar, modul penyuntingan adalah berdasarkan modul perancangan, penggubalan dan penulisan semula separa untuk menambah baik kandungan yang dihasilkan. Secara khusus, matlamatnya adalah untuk menghapuskan urutan panjang ketidakkonsistenan fakta. Apabila seseorang menemui ketidaksinambungan fakta yang kecil semasa membaca pruf, seseorang hanya boleh mengedit butiran yang bermasalah daripada membuat semakan besar atau penulisan semula substantif pelan artikel peringkat tinggi. Modul penyuntingan meniru proses pengarangan manusia ini dalam dua langkah: mengesan ketidakkonsistenan fakta dan membetulkannya, seperti ditunjukkan dalam Rajah 5 di bawah.

Penilaian

Dalam sesi penilaian, pengkaji menetapkan tugasan untuk menyiapkan permulaan ringkas A cerita terhasil daripada situasi sebelumnya. Memandangkan "cerita" sukar untuk ditakrifkan dalam cara berasaskan peraturan, kami tidak mengenakan sebarang kekangan berdasarkan peraturan pada output yang boleh diterima dan sebaliknya menilai mereka melalui beberapa metrik beranotasi manusia. Untuk menjana premis awal, para penyelidik meminta dengan GPT3-Instruct-175B untuk mendapatkan 100 premis yang berbeza.

Baseline

Sukar kerana kaedah sebelum ini lebih memfokuskan kepada cerpen berbanding Re^3 Perbandingan langsung . Jadi penyelidik menggunakan dua garis dasar berikut berdasarkan GPT3-175B:

1. BERGULUNG, jana 256 token pada satu masa melalui GPT3-175B, menggunakan situasi sebelumnya dan semua cerita yang dijana sebelum ini Teks sebagai gesaan, jika terdapat lebih daripada 768 token, gesaan akan dibiarkan dipenggal. Oleh itu, panjang konteks maksimum "tetingkap bergolek" ialah 1024, iaitu panjang konteks maksimum yang sama yang digunakan dalam RE^3. Selepas menjana 3072 token, para penyelidik menggunakan mekanisme penamat cerita yang sama seperti RE^3.

2. ROLLING-FT, sama seperti ROLLING, kecuali GPT3-175B terlebih dahulu memperhalusi ratusan perenggan dalam cerita WritingPrompts, yang mempunyai sekurang-kurangnya 3000 token.

Petunjuk

Beberapa indikator penilaian yang digunakan oleh penyelidik termasuk:

1. Menjadi menarik kepada pembaca.

2. Konsisten. Plot adalah koheren.

3. Perkaitan. Kekal pada keadaan asal.

4. Dinilai ditulis oleh manusia.

Selain itu, penyelidik juga mengesan berapa kali cerita yang dihasilkan mengalami masalah penulisan dalam aspek berikut:

1. Perubahan yang mengejutkan dalam naratif atau gaya.

2. Ia sebenarnya tidak betul atau mengandungi butiran yang sangat pelik.

3. Kekacauan. Mengelirukan atau sukar difahami.

4. Tahap kebolehulangan yang tinggi.

5. Kesalahan tatabahasa yang kerap.

Hasilnya

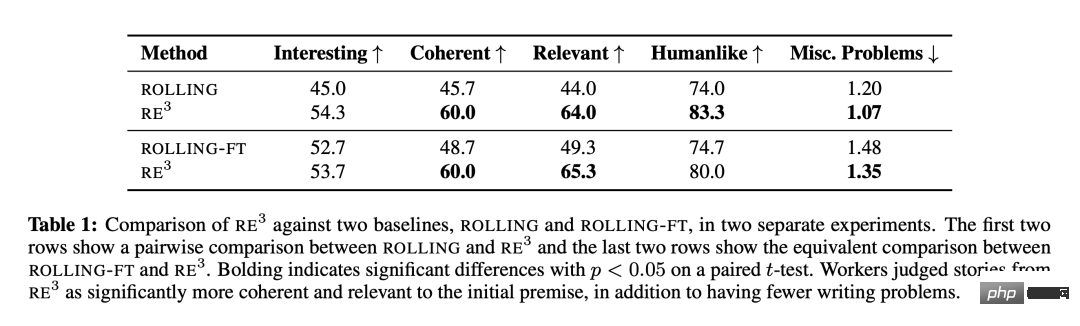

ditunjukkan dalam Jadual 1 Seperti yang ditunjukkan, Re^3 sangat berkesan untuk menulis cerita yang lebih panjang berdasarkan peristiwa yang dijangka sambil mengekalkan plot keseluruhan yang koheren, mengesahkan pilihan reka bentuk penyelidik yang diilhamkan oleh proses penulisan manusia, serta kaedah penjanaan semula. Berbanding dengan ROLLING dan ROLLING-FT, Re^3 meningkatkan kedua-dua koheren dan perkaitan dengan ketara. Anotator juga menandakan cerita Re^3 sebagai mempunyai "isu penulisan berlebihan yang jauh lebih sedikit."

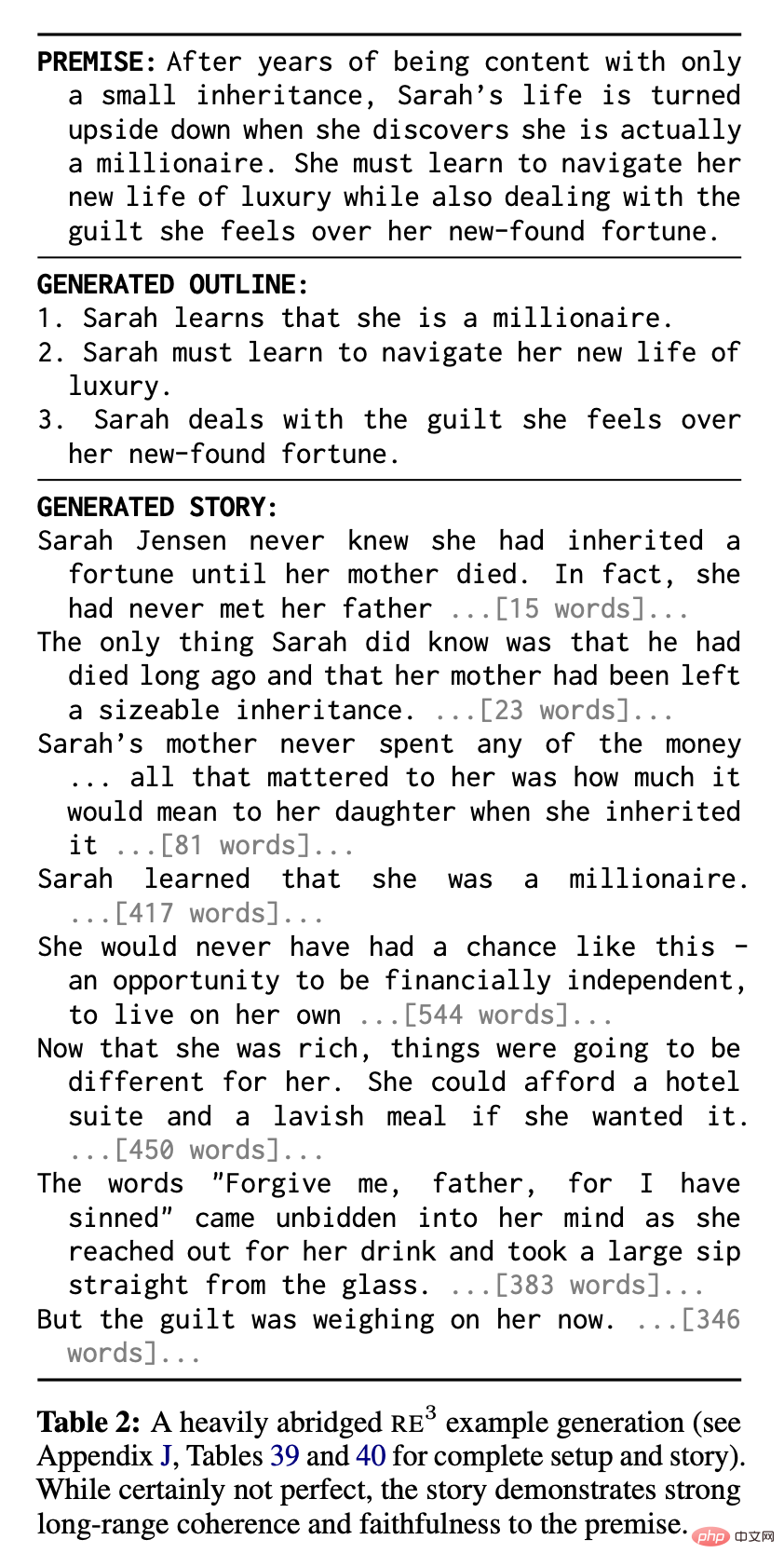

Re^3 menunjukkan prestasi yang kukuh dalam erti kata yang mutlak: anotasi percaya bahawa dalam kedua-dua perbandingan itu, 83.3% dan 80.0% cerita Re^3 masing-masing ditulis oleh manusia. Jadual 2 menunjukkan contoh cerita yang sangat ringkas daripada Re^3, menunjukkan koheren yang kukuh dan perkaitan konteks:

Namun begitu, penyelidik masih secara kualitatif memerhatikan bahawa Re^3 masih mempunyai banyak ruang untuk penambahbaikan.

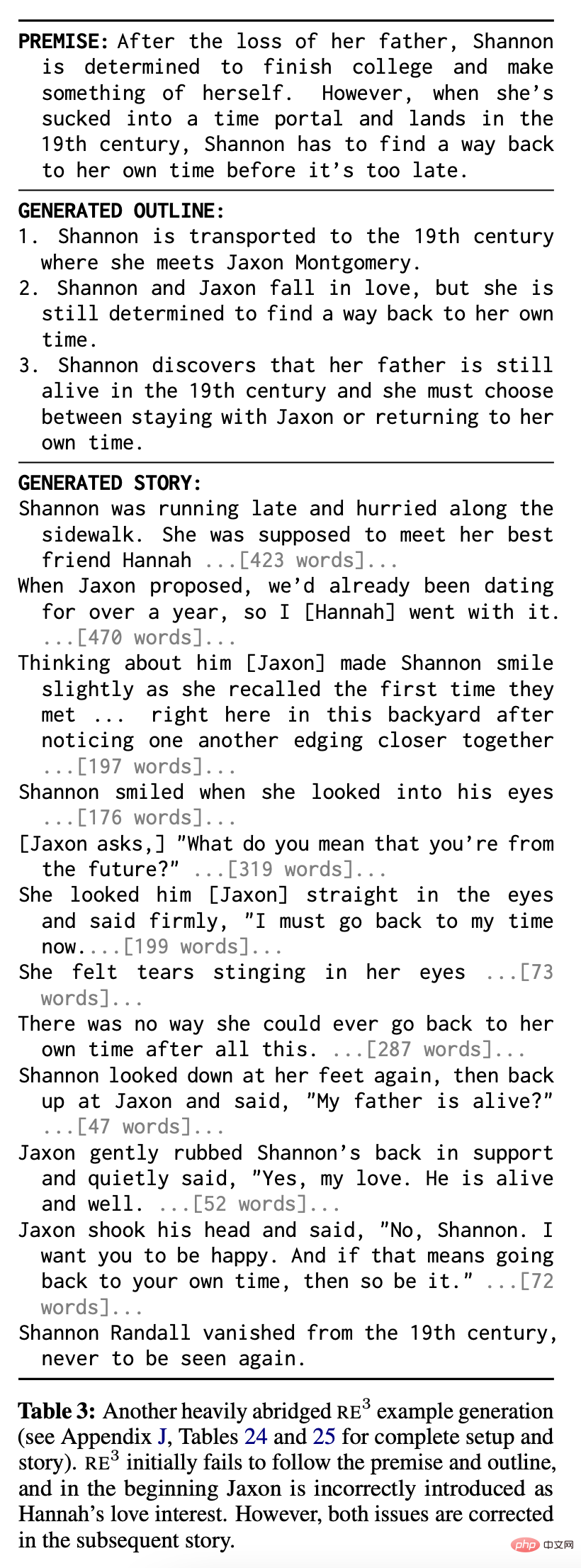

Dua isu biasa ditunjukkan dalam Jadual 3. Pertama, walaupun Re^3s hampir selalu mengikuti premis cerita pada tahap tertentu, tidak seperti cerita asas, mereka mungkin tidak menangkap semua bahagian premis dan mungkin tidak mengikut garis besar separa yang dijana oleh modul perancangan (cth., Jadual 3 Bahagian pertama daripada cerita dan rangka). Kedua, disebabkan kegagalan modul penulisan semula, terutamanya modul penyuntingan, masih terdapat beberapa petikan yang mengelirukan atau pernyataan bercanggah: contohnya, dalam Jadual 3, watak Jaxon mempunyai identiti bercanggah di beberapa tempat.

Walau bagaimanapun, tidak seperti kaedah rolling window, kaedah perancangan Re^3 boleh "membetulkan sendiri" , kembali ke plot asal. Separuh kedua cerita dalam Jadual 3 menggambarkan keupayaan ini.

Analisis

Eksperimen Ablasi

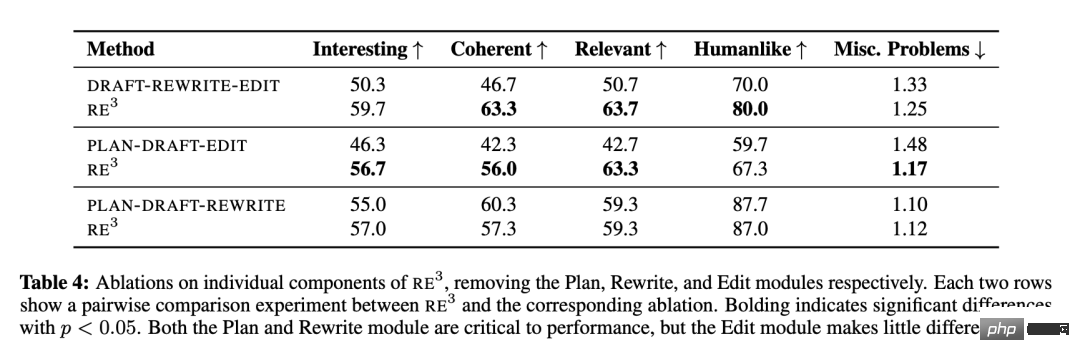

Penyelidik membincangkan pelbagai modul sumbangan Re^3 Relative daripada: merancang, merangka, menulis semula, dan menyunting, dan menjalankan eksperimen ablasi pada setiap modul secara bergilir-gilir. Pengecualian ialah modul Draf, kerana tidak jelas bagaimana sistem akan berfungsi tanpanya.

Jadual 4 menunjukkan bahawa modul "Perancangan" dan "Penulisan Semula" yang meniru proses perancangan dan penulisan semula manusia mempunyai impak ke atas keseluruhan plot. Kesepaduan dan perkaitan premis adalah penting. Walau bagaimanapun, modul "Edit" menyumbang sangat sedikit kepada metrik ini. Para penyelidik juga secara kualitatif memerhatikan bahawa masih terdapat banyak isu koheren dalam cerita akhir Re^3 yang tidak ditangani oleh modul penyuntingan, tetapi itu boleh diselesaikan oleh editor manusia yang berhati-hati.

Analisis lanjut modul "Edit"

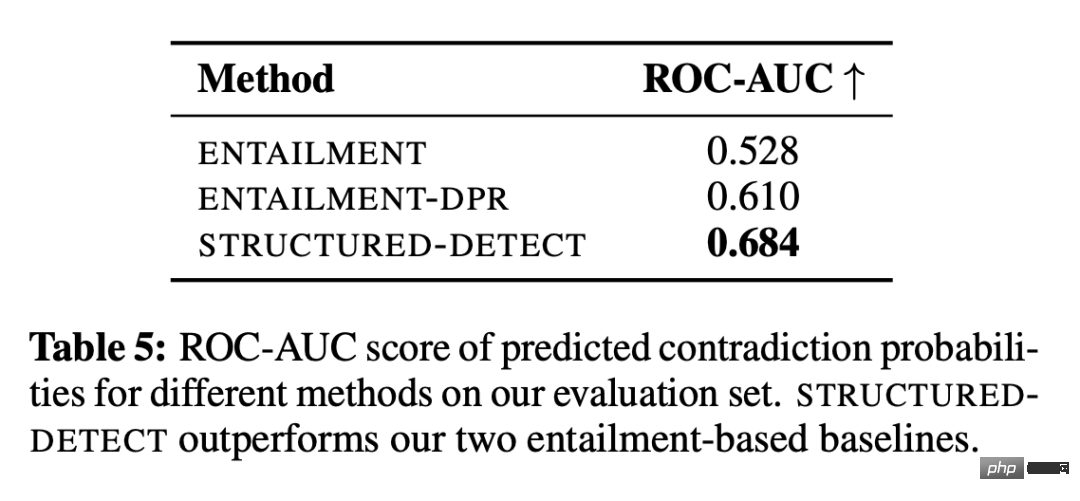

Pengkaji menggunakan persekitaran terkawal untuk mengkaji Sama ada Edit modul sekurang-kurangnya dapat mengesan ketidakkonsistenan fakta berasaskan peranan. Subsistem pengesanan dipanggil STRUCTURED-DETECT untuk mengelakkan kekeliruan dengan keseluruhan modul penyuntingan.

Seperti yang ditunjukkan dalam Jadual 5, STRUCTUREDDETECT mengatasi kedua-dua garis dasar mengikut metrik klasifikasi ROC-AUC standard apabila mengesan ketidakkonsistenan berasaskan peranan. Skor ROC-AUC sistem ENTAILMENT hampir tidak lebih baik daripada prestasi peluang (0.5), yang menyerlahkan cabaran teras bahawa sistem pengesanan mestilah sangat tepat. Selain itu, STRUCTURED-DETECT direka untuk menskalakan kepada perenggan yang lebih panjang. Para penyelidik membuat hipotesis bahawa jurang prestasi akan melebar dalam penilaian dengan input yang lebih panjang berbanding dengan garis dasar.

Walaupun dalam persekitaran yang dipermudahkan ini, prestasi mutlak semua sistem kekal rendah. Selain itu, banyak cerita lengkap yang dijana mengandungi ketidakkonsistenan bukan aksara, seperti ketidakkonsistenan latar belakang dengan adegan semasa. Walaupun penyelidik tidak menganalisis secara rasmi keupayaan API pengeditan GPT-3 untuk membetulkan ketidakkonsistenan selepas mengesannya, mereka juga mendapati bahawa ia boleh membetulkan butiran terpencil tetapi bergelut apabila menangani perubahan yang lebih besar.

Ringkasnya, ralat kompaun daripada subsistem pengesanan dan pembetulan menyukarkan modul penyuntingan semasa kajian ini untuk meningkatkan konsistensi fakta secara berkesan merentas beribu-ribu perkataan, tanpa memperkenalkan perubahan yang tidak perlu di masa yang sama.

Atas ialah kandungan terperinci AIGC yang mematuhi proses kreatif manusia: model yang menjana cerita pertumbuhan secara automatik muncul. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Cara menambah lajur baru dalam SQL

Apr 09, 2025 pm 02:09 PM

Cara menambah lajur baru dalam SQL

Apr 09, 2025 pm 02:09 PM

Tambah lajur baru ke jadual yang sedia ada dalam SQL dengan menggunakan pernyataan Alter Table. Langkah -langkah khusus termasuk: Menentukan nama jadual dan maklumat lajur, menulis pernyataan Alter Jadual, dan melaksanakan pernyataan. Sebagai contoh, tambahkan lajur e -mel ke Jadual Pelanggan (Varchar (50)): Alter Jadual Pelanggan Tambah Varchar E -mel (50);

Apakah sintaks untuk menambah lajur dalam SQL

Apr 09, 2025 pm 02:51 PM

Apakah sintaks untuk menambah lajur dalam SQL

Apr 09, 2025 pm 02:51 PM

Sintaks untuk menambah lajur dalam sql adalah alter table table_name tambah column_name data_type [not null] [default default_value]; Di mana table_name adalah nama jadual, column_name adalah nama lajur baru, data_type adalah jenis data, tidak null menentukan sama ada nilai null dibenarkan, dan lalai default_value menentukan nilai lalai.

Cara menetapkan nilai lalai semasa menambahkan lajur dalam sql

Apr 09, 2025 pm 02:45 PM

Cara menetapkan nilai lalai semasa menambahkan lajur dalam sql

Apr 09, 2025 pm 02:45 PM

Tetapkan nilai lalai untuk lajur yang baru ditambahkan, gunakan pernyataan ALTER Jadual: Tentukan Menambah Lajur dan Tetapkan Nilai Lalai: Alter Table Table_Name Tambah Column_Name Data_Type Default Default_Value; Gunakan klausa kekangan untuk menentukan nilai lalai: alter table Table_name Tambah lajur Column_name data_type kekangan default_constraint default_value;

Jadual Jelas SQL: Petua Pengoptimuman Prestasi

Apr 09, 2025 pm 02:54 PM

Jadual Jelas SQL: Petua Pengoptimuman Prestasi

Apr 09, 2025 pm 02:54 PM

Petua untuk Meningkatkan Prestasi Pembersihan Jadual SQL: Gunakan jadual Truncate dan bukannya memadam, membebaskan ruang dan menetapkan semula lajur Identiti. Lumpuhkan kekangan utama asing untuk mengelakkan penghapusan cascading. Gunakan operasi enkapsulasi transaksi untuk memastikan konsistensi data. Batch memadam data besar dan hadkan bilangan baris melalui had. Membina semula indeks selepas membersihkan untuk meningkatkan kecekapan pertanyaan.

Gunakan penyataan padam untuk membersihkan jadual SQL

Apr 09, 2025 pm 03:00 PM

Gunakan penyataan padam untuk membersihkan jadual SQL

Apr 09, 2025 pm 03:00 PM

Ya, pernyataan padam boleh digunakan untuk membersihkan jadual SQL, langkah -langkahnya adalah seperti berikut: Gunakan pernyataan padam: padam dari meja_name; Ganti Table_name dengan nama jadual untuk dibersihkan.

Cara Menambah Lajur ke Jadual SQL

Apr 09, 2025 pm 02:06 PM

Cara Menambah Lajur ke Jadual SQL

Apr 09, 2025 pm 02:06 PM

Menambah lajur dalam jadual SQL memerlukan langkah -langkah berikut: Buka persekitaran SQL dan pilih pangkalan data. Pilih jadual yang ingin anda ubah dan gunakan klausa "Tambah Lajur" untuk menambah lajur yang merangkumi nama lajur, jenis data, dan sama ada untuk membenarkan nilai null. Jalankan pernyataan "Alter Table" untuk melengkapkan penambahan.

Bagaimana untuk menangani pemecahan memori Redis?

Apr 10, 2025 pm 02:24 PM

Bagaimana untuk menangani pemecahan memori Redis?

Apr 10, 2025 pm 02:24 PM

Pemecahan ingatan redis merujuk kepada kewujudan kawasan bebas kecil dalam ingatan yang diperuntukkan yang tidak dapat ditugaskan semula. Strategi mengatasi termasuk: Mulakan semula Redis: Kosongkan memori sepenuhnya, tetapi perkhidmatan mengganggu. Mengoptimumkan struktur data: Gunakan struktur yang lebih sesuai untuk Redis untuk mengurangkan bilangan peruntukan dan siaran memori. Laraskan parameter konfigurasi: Gunakan dasar untuk menghapuskan pasangan nilai kunci yang paling kurang baru-baru ini. Gunakan mekanisme kegigihan: sandarkan data secara teratur dan mulakan semula redis untuk membersihkan serpihan. Pantau penggunaan memori: Cari masalah tepat pada masanya dan ambil langkah.

phpmyadmin mencipta jadual data

Apr 10, 2025 pm 11:00 PM

phpmyadmin mencipta jadual data

Apr 10, 2025 pm 11:00 PM

Untuk membuat jadual data menggunakan phpmyadmin, langkah -langkah berikut adalah penting: Sambungkan ke pangkalan data dan klik tab baru. Namakan jadual dan pilih enjin penyimpanan (disyorkan innoDB). Tambah butiran lajur dengan mengklik butang Tambah Lajur, termasuk nama lajur, jenis data, sama ada untuk membenarkan nilai null, dan sifat lain. Pilih satu atau lebih lajur sebagai kunci utama. Klik butang Simpan untuk membuat jadual dan lajur.