Asas, sempadan dan aplikasi GNN

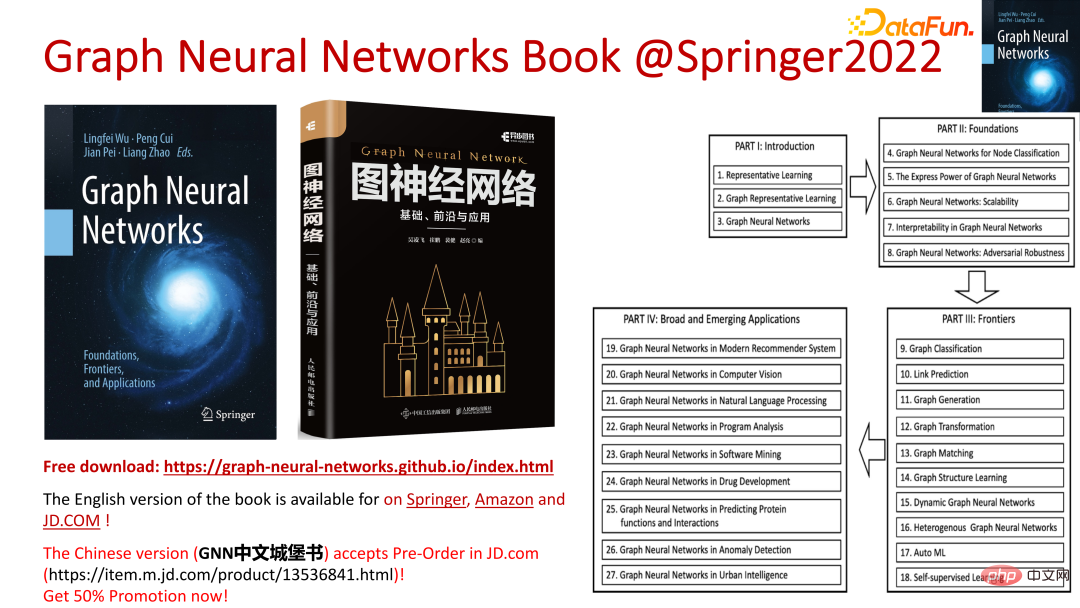

Dalam beberapa tahun kebelakangan ini, rangkaian saraf graf (GNN) telah mencapai kemajuan yang pesat dan luar biasa. Rangkaian saraf graf, juga dikenali sebagai pembelajaran dalam graf, pembelajaran perwakilan graf (pembelajaran perwakilan graf) atau pembelajaran dalam geometri, ialah topik penyelidikan yang paling pesat berkembang dalam bidang pembelajaran mesin, terutamanya pembelajaran mendalam. Tajuk perkongsian ini ialah "Asas, Sempadan dan Aplikasi GNN", yang terutamanya memperkenalkan kandungan umum buku komprehensif "Asas, Sempadan dan Aplikasi Rangkaian Neural Graf" yang disusun oleh sarjana Wu Lingfei, Cui Peng, Pei Jian dan Zhao Liang.

1. Pengenalan kepada rangkaian saraf graf

1.

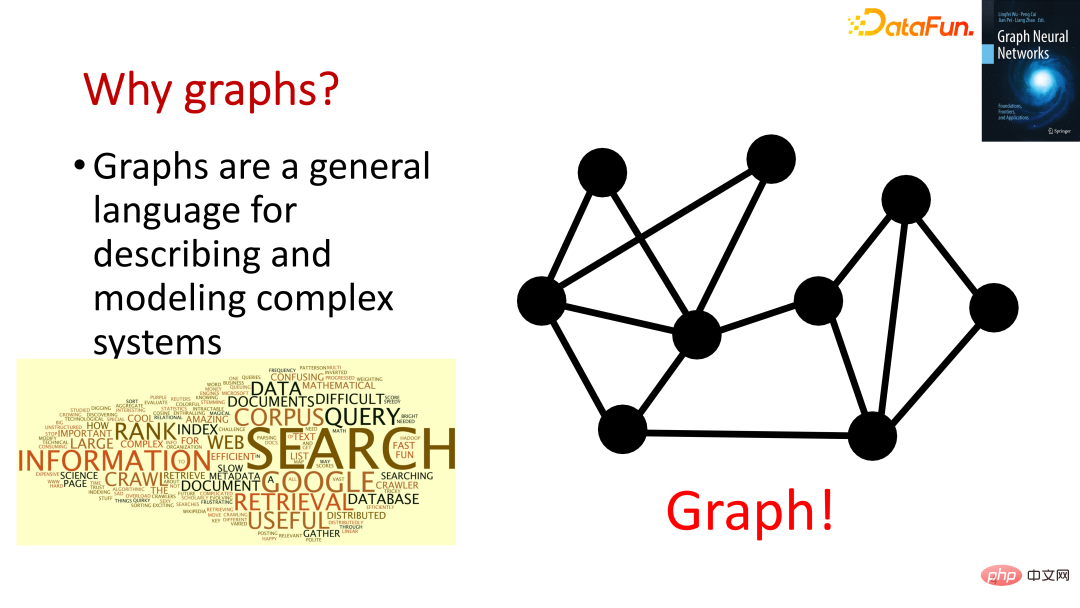

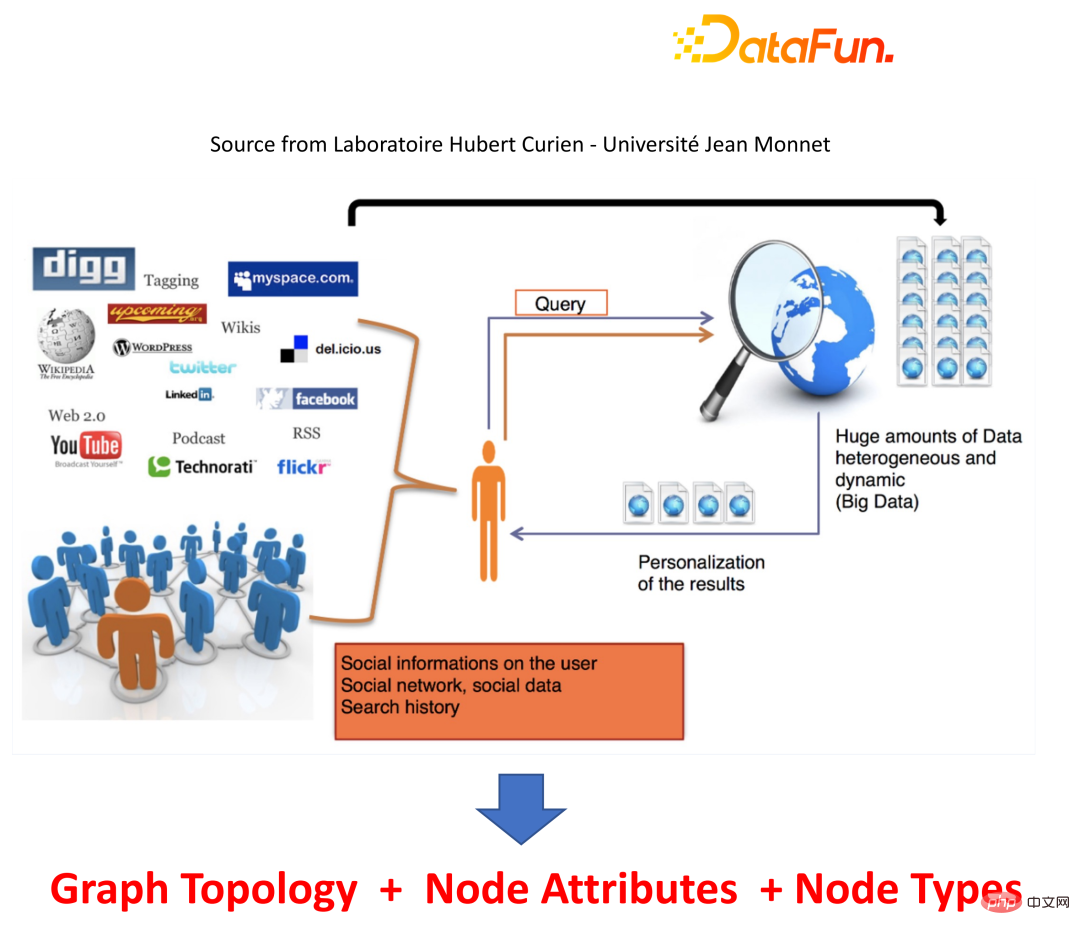

Rajah ialah bahasa universal untuk menerangkan dan memodelkan sistem yang kompleks. Graf itu sendiri tidak rumit, ia terutamanya terdiri daripada tepi dan nod. Kita boleh menggunakan nod untuk mewakili sebarang objek yang ingin kita modelkan, dan kita boleh menggunakan tepi untuk mewakili perhubungan atau persamaan antara dua nod. Apa yang sering kita panggil rangkaian saraf graf atau pembelajaran mesin graf biasanya menggunakan struktur graf dan maklumat tepi dan nod sebagai input algoritma untuk mengeluarkan hasil yang diingini. Contohnya, dalam enjin carian, apabila kami memasukkan pertanyaan, enjin akan mengembalikan hasil carian yang diperibadikan berdasarkan maklumat pertanyaan, maklumat pengguna dan beberapa maklumat kontekstual ini boleh disusun secara semula jadi dalam graf.

2 Data berstruktur graf ada di mana-mana

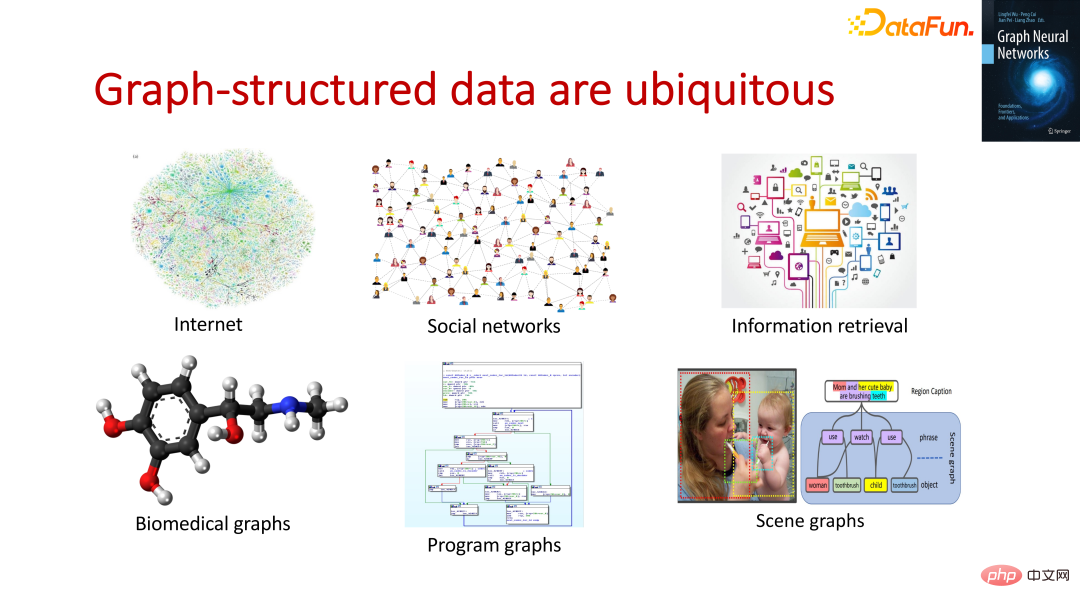

Data berstruktur graf boleh didapati di mana-mana sahaja, seperti Internet, rangkaian sosial, dsb. Selain itu, dalam bidang penemuan protein yang sangat popular pada masa ini, orang ramai akan menggunakan graf untuk menerangkan dan memodelkan protein sedia ada dan menjana graf baharu untuk membantu orang ramai menemui ubat baharu. Kami juga boleh menggunakan graf untuk melakukan beberapa analisis program yang kompleks, dan kami juga boleh melakukan beberapa penaakulan peringkat tinggi dalam penglihatan komputer.

3 Trend terkini dalam pembelajaran mesin graf

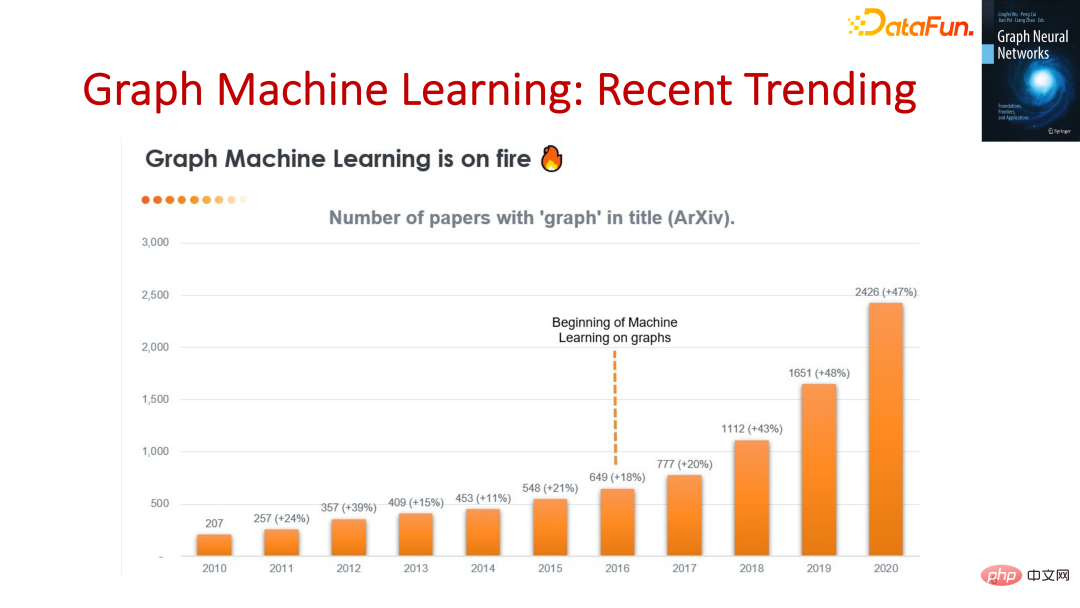

Pembelajaran mesin graf. Ia bukanlah satu topik yang sangat baru. Sejak 2016, dengan kemunculan kertas kerja berkaitan rangkaian saraf graf moden, pembelajaran mesin graf telah menjadi hala tuju penyelidikan yang popular. Didapati bahawa kaedah pembelajaran mesin graf generasi baharu ini boleh mempelajari data itu sendiri dengan lebih baik dan maklumat antara data, supaya ia dapat mewakili data dengan lebih baik, dan akhirnya dapat menyelesaikan tugas yang lebih penting dengan lebih baik.

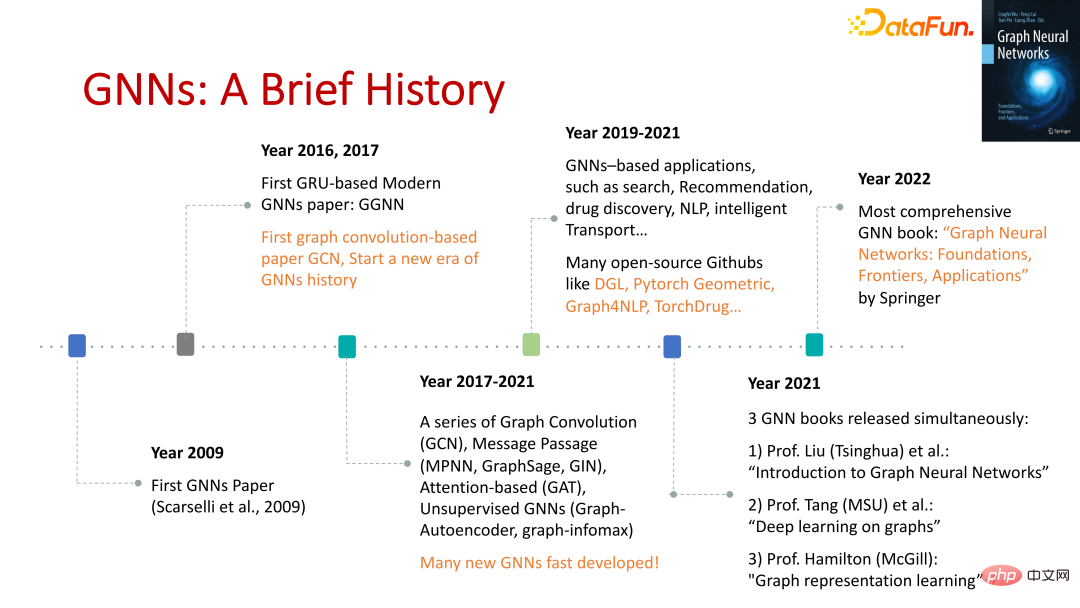

4. Sejarah ringkas rangkaian saraf graf

Kertas terawal berkaitan rangkaian saraf graf muncul pada tahun 2009, sebelum pembelajaran mendalam menjadi popular. Kertas kerja mengenai rangkaian saraf graf moden muncul pada tahun 2016, yang merupakan penambahbaikan kepada rangkaian saraf graf awal. Selepas itu, kemunculan GCN menggalakkan perkembangan pesat rangkaian saraf graf Sejak 2017, sejumlah besar algoritma baharu telah muncul. Memandangkan algoritma rangkaian saraf graf menjadi semakin matang, sejak 2019, industri telah cuba menggunakan algoritma ini untuk menyelesaikan beberapa masalah praktikal Pada masa yang sama, banyak alat sumber terbuka telah dibangunkan untuk meningkatkan kecekapan menyelesaikan masalah. Sejak 2021, banyak buku yang berkaitan dengan rangkaian saraf graf telah ditulis, termasuk sudah tentu "Asas, Sempadan dan Aplikasi Rangkaian Neural Graf" ini.

Buku "Asas, Sempadan dan Aplikasi Rangkaian Neural Graf" secara sistematik memperkenalkan konsep teras dan teknologi dalam bidang rangkaian saraf graf, serta penyelidikan dan pembangunan termaju, dan memperkenalkan aplikasi dalam bidang aplikasi yang berbeza. Pembaca dari kedua-dua ahli akademik dan industri boleh mendapat manfaat daripadanya.

2 Asas rangkaian saraf graf

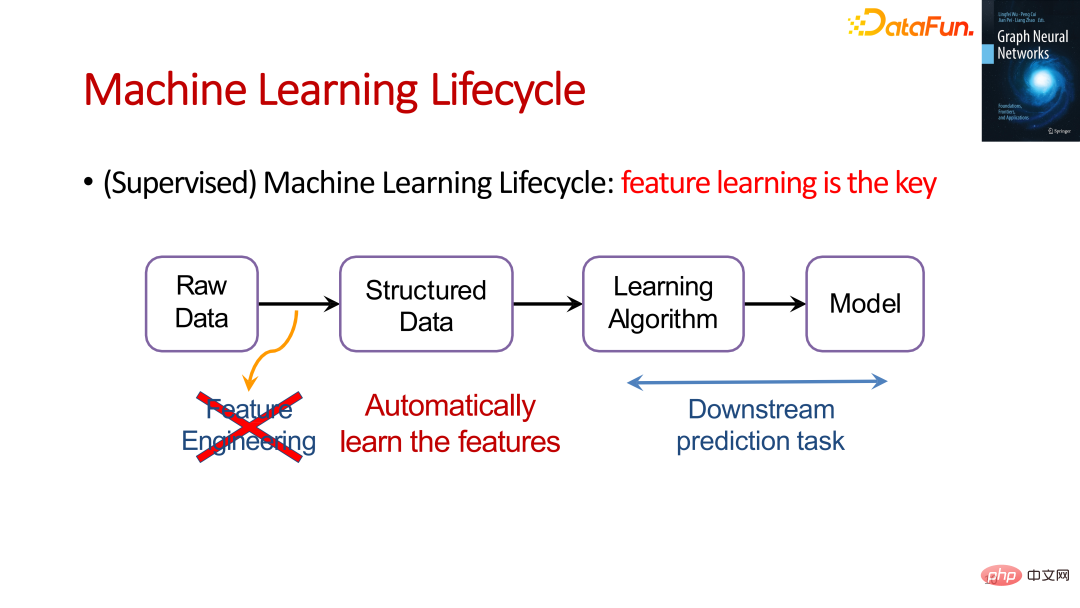

1. Kitaran hayat pembelajaran mesin

Angka di atas menggambarkan kitaran hayat pembelajaran mesin, di mana pembelajaran ciri merupakan pautan yang sangat penting ialah mengubah data mentah kepada data berstruktur. Sebelum kemunculan pembelajaran mendalam, semua orang menyelesaikan tugas ini melalui kejuruteraan ciri. Selepas kemunculan pembelajaran mendalam, kaedah pembelajaran mesin hujung ke hujung ini mula menjadi arus perdana.

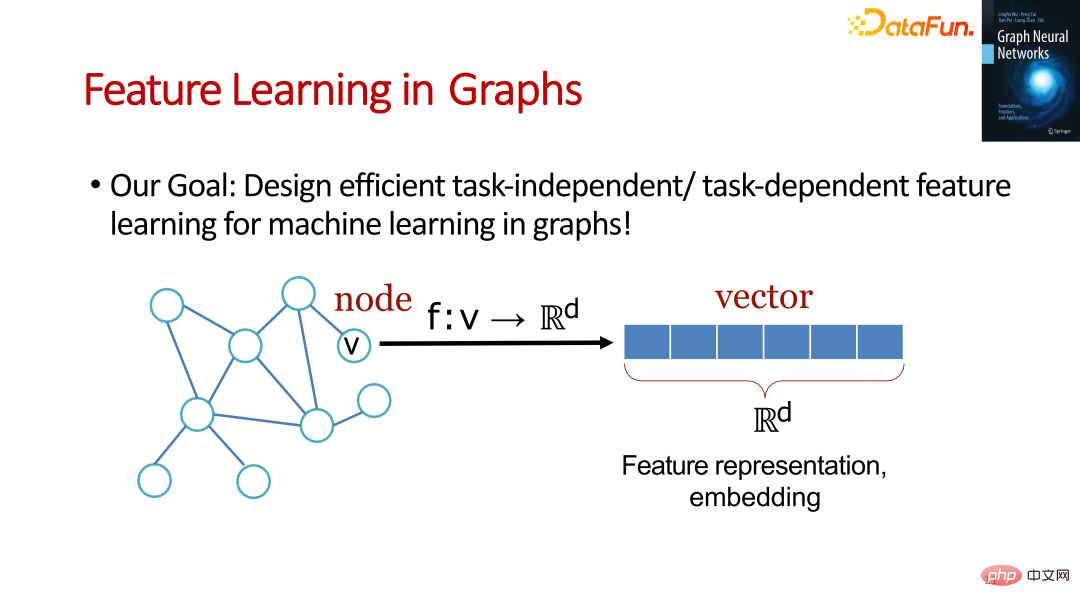

2 Pembelajaran ciri dalam graf

Pembelajaran Ciri dalam Graf sangat serupa dengan pembelajaran mendalam Matlamatnya adalah untuk mereka bentuk kaedah pembelajaran ciri berkaitan tugas atau bebas tugas yang berkesan untuk memetakan nod dalam graf asal ke dalam ruang berdimensi tinggi untuk mendapatkan pembenaman. perwakilan, dan kemudian selesaikan tugasan hiliran.

3 Asas rangkaian saraf graf

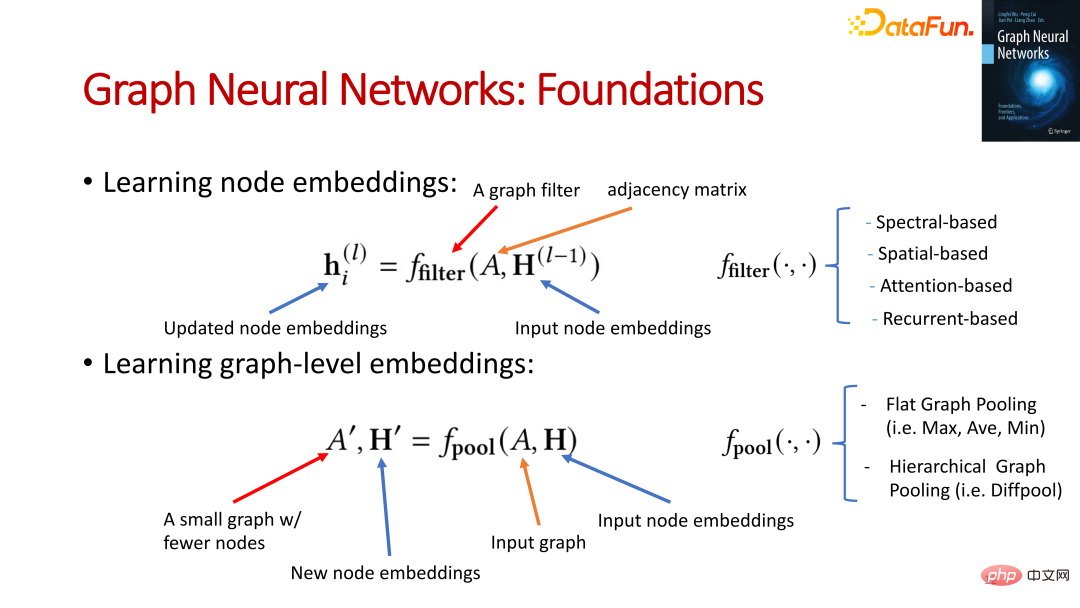

Terdapat dua jenis perwakilan yang perlu dipelajari dalam rangkaian saraf graf:

- Perwakilan nod graf

memerlukan operasi penapis, yang mengambil matriks graf dan perwakilan vektor nod sebagai input, belajar secara berterusan dan mengemas kini perwakilan vektor nod. Pada masa ini, operasi penapis yang lebih biasa termasuk berasaskan Spektrum, berasaskan Spatial, berasaskan Perhatian dan berasaskan Berulang.

- Perwakilan graf

memerlukan operasi kumpulan , Mengambil matriks graf dan perwakilan vektor nod sebagai input, ia secara berterusan belajar untuk mendapatkan matriks graf yang mengandungi lebih sedikit nod dan perwakilan vektor nodnya, dan akhirnya memperoleh perwakilan vektor peringkat graf untuk mewakili keseluruhan graf. Pada masa ini, operasi kumpulan yang lebih biasa termasuk Penggabungan Graf Rata (seperti Max, Ave, Min) dan Penggabungan Graf Hierarki (seperti Diffpool).

4. Model asas rangkaian saraf graf

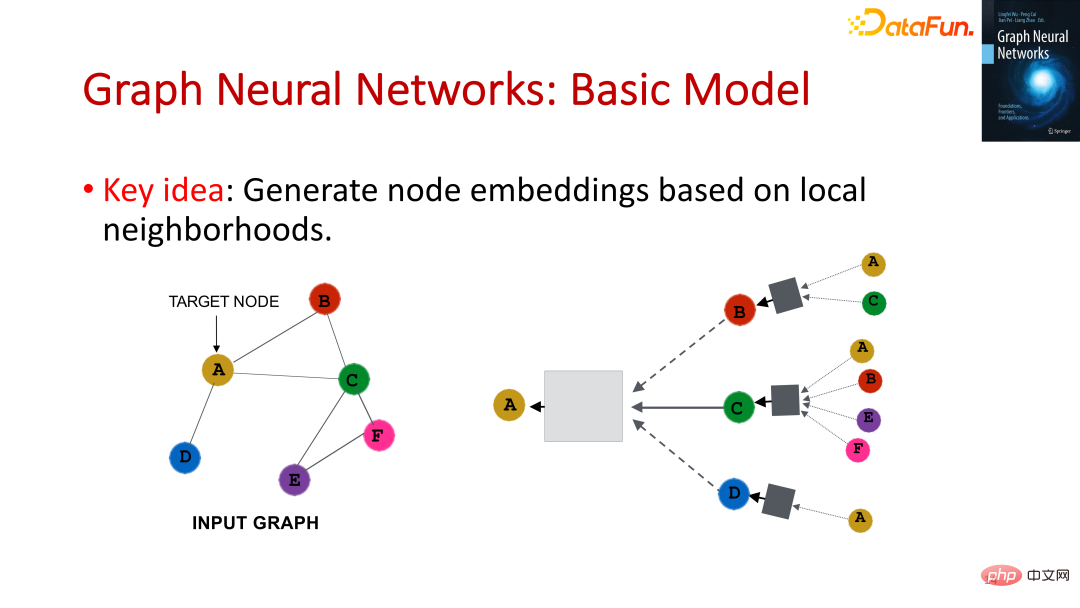

Terdapat pembelajaran konteks dalam bidang konsep pembelajaran mesin. Dalam rangkaian neural graf, konteks nod ialah nod jirannya Kita boleh menggunakan nod jiran nod untuk mempelajari perwakilan vektor nod ini.

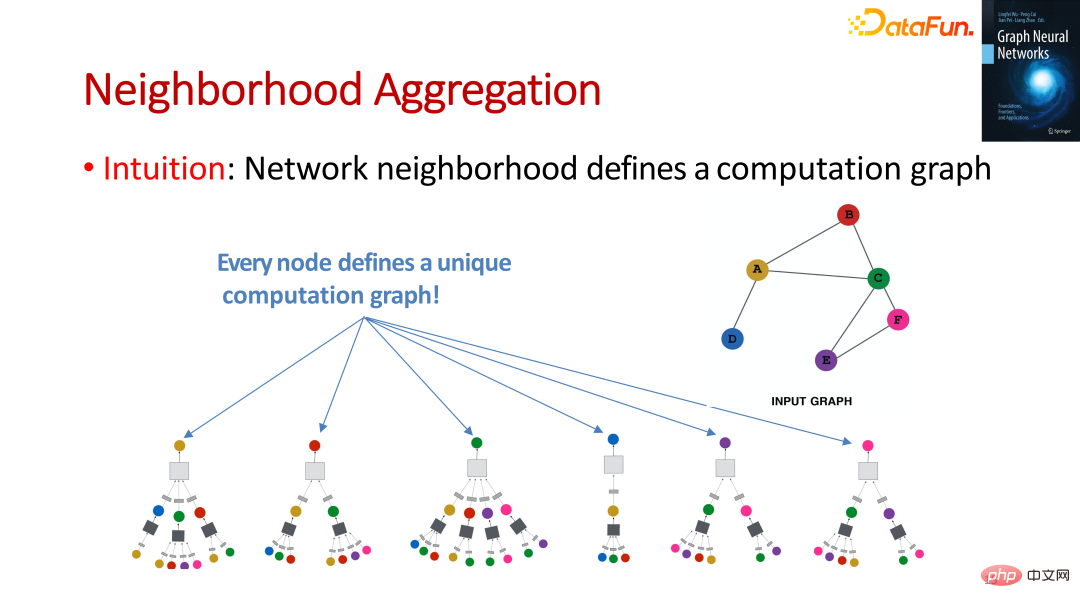

Dengan cara ini, setiap nod boleh mentakrifkan graf pengiraan.

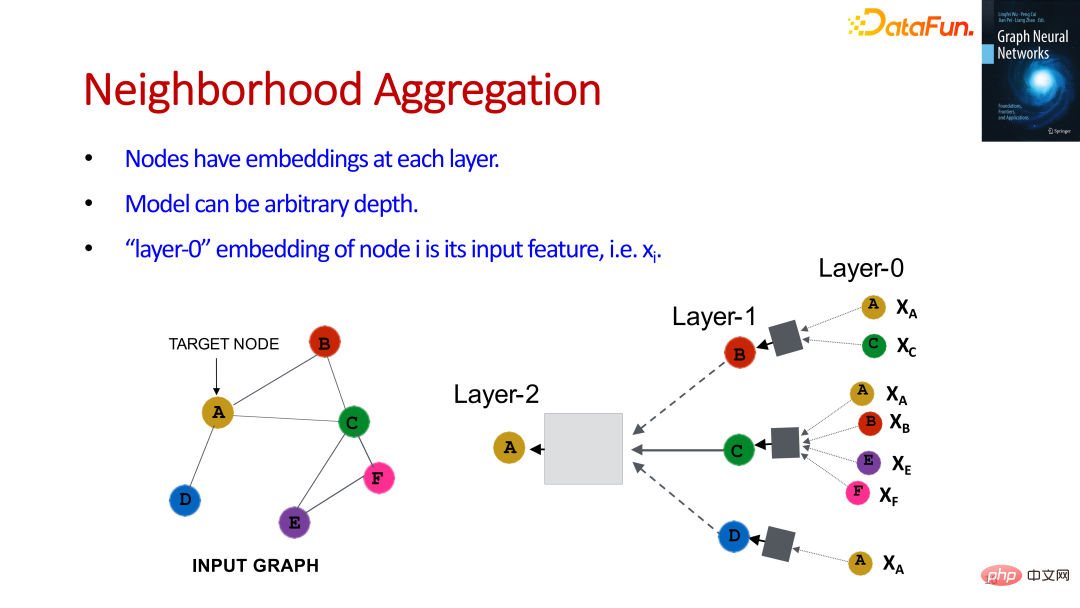

Kita boleh melapiskan graf pengiraan Lapisan pertama ialah maklumat paling asli, dan jumlahnya dilalui oleh lapisan lapisan. Agregat maklumat untuk mempelajari perwakilan vektor semua nod.

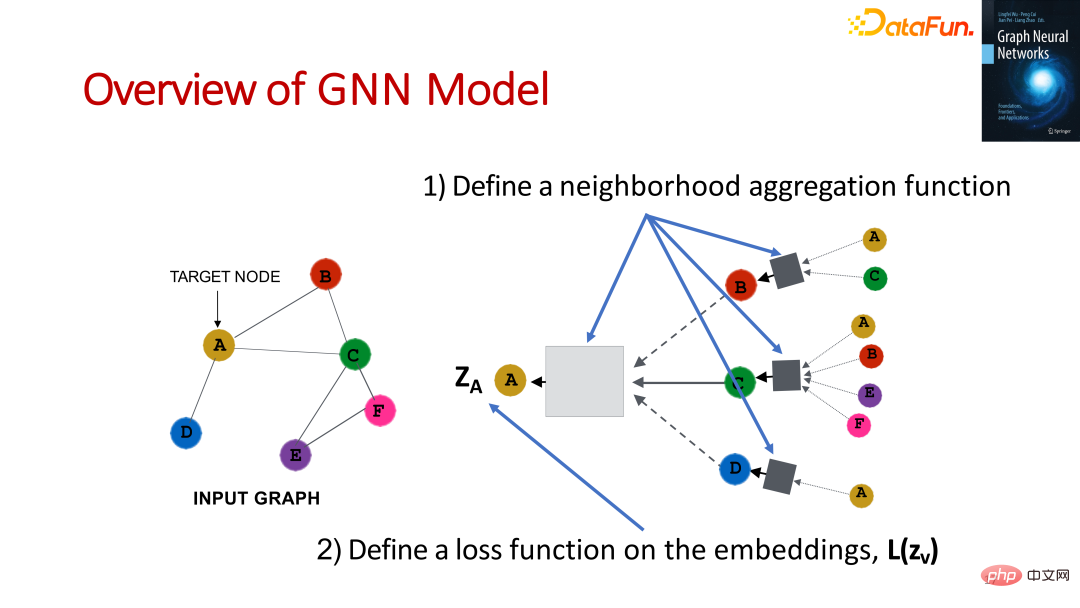

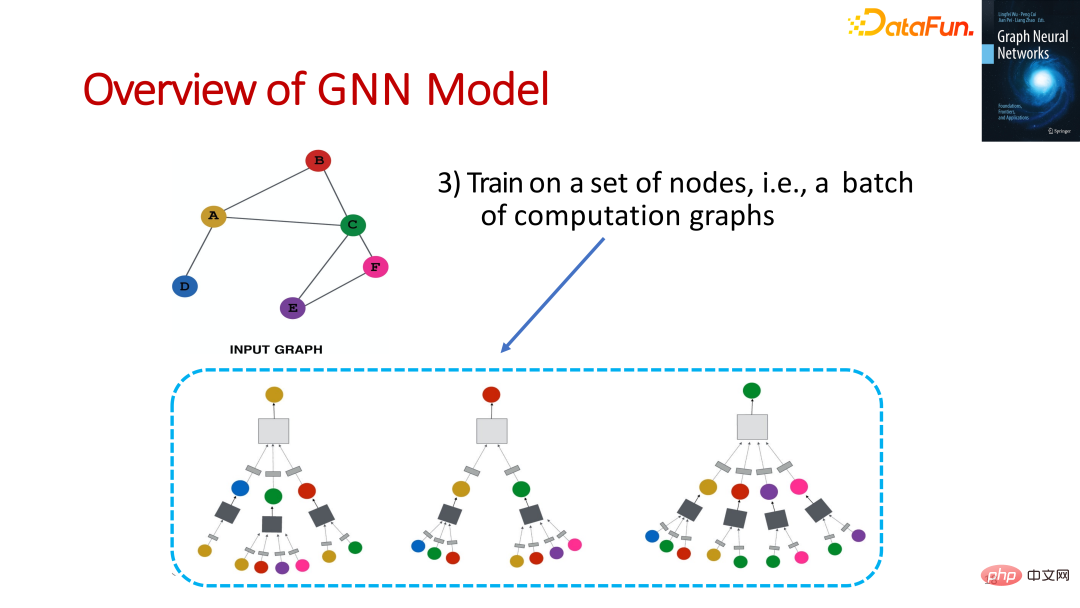

Rajah di atas secara kasar menerangkan langkah utama pembelajaran model rangkaian saraf graf Terdapat terutamanya empat langkah:

- Tentukan a. Fungsi pengagregatan;

- Tentukan fungsi kehilangan mengikut tugasan; kumpulan nod , sebagai contoh, kumpulan graf pengiraan boleh dilatih pada satu masa

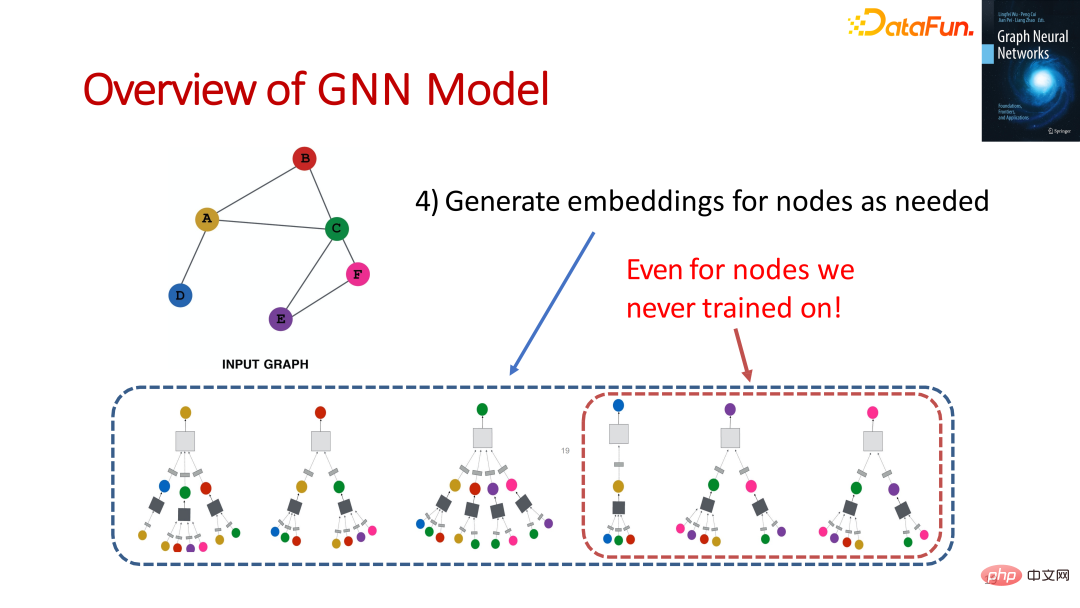

- menghasilkan perwakilan vektor yang diperlukan untuk setiap nod, malah beberapa nod yang tidak pernah dilatih (Apa yang dipelajari ialah fungsi agregasi, dan perwakilan vektor nod baharu boleh diperoleh dengan menggunakan fungsi agregasi dan perwakilan vektor yang telah dilatih).

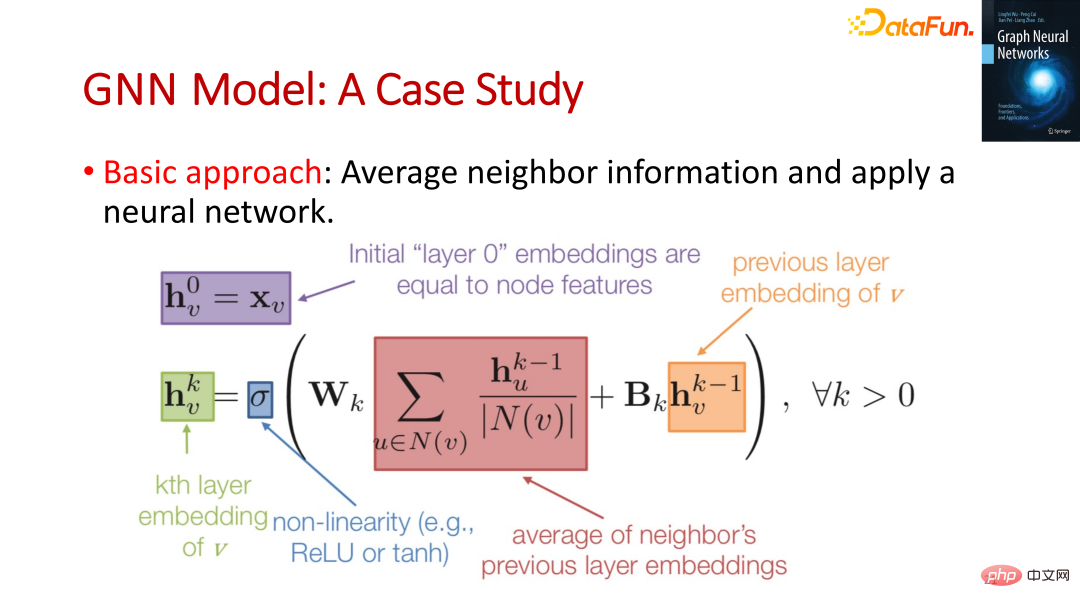

Gambar di atas

ialah contoh penggunaan purata sebagai fungsi pengagregatan Perwakilan vektor nod v dalam lapisan kth bergantung pada purata perwakilan vektor nod jirannya dalam lapisan sebelumnya dan perwakilan vektornya sendiri dalam lapisan sebelumnya.

Untuk meringkaskan kandungan di atas, perkara utama rangkaian saraf graf adalah untuk menjana nod sasaran dengan mengagregatkan maklumat nod jiran. Vektor perwakilan mata, yang mengambil kira perkongsian parameter dalam pengekod dan juga membolehkan pembelajaran inferens. 5 Model popular rangkaian saraf graf

5 Model popular rangkaian saraf graf

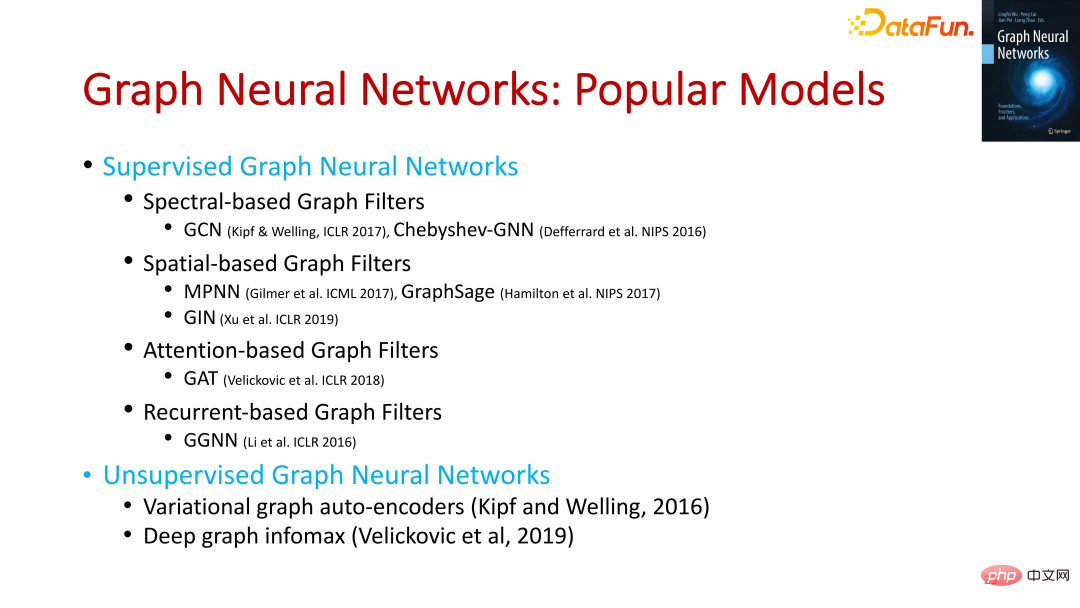

Intipati algoritma graf klasik atau popular rangkaian saraf Di atas adalah untuk menggunakan fungsi pengagregatan atau fungsi penapis yang berbeza, yang boleh dibahagikan kepada rangkaian saraf graf diselia dan rangkaian saraf graf tidak diselia.

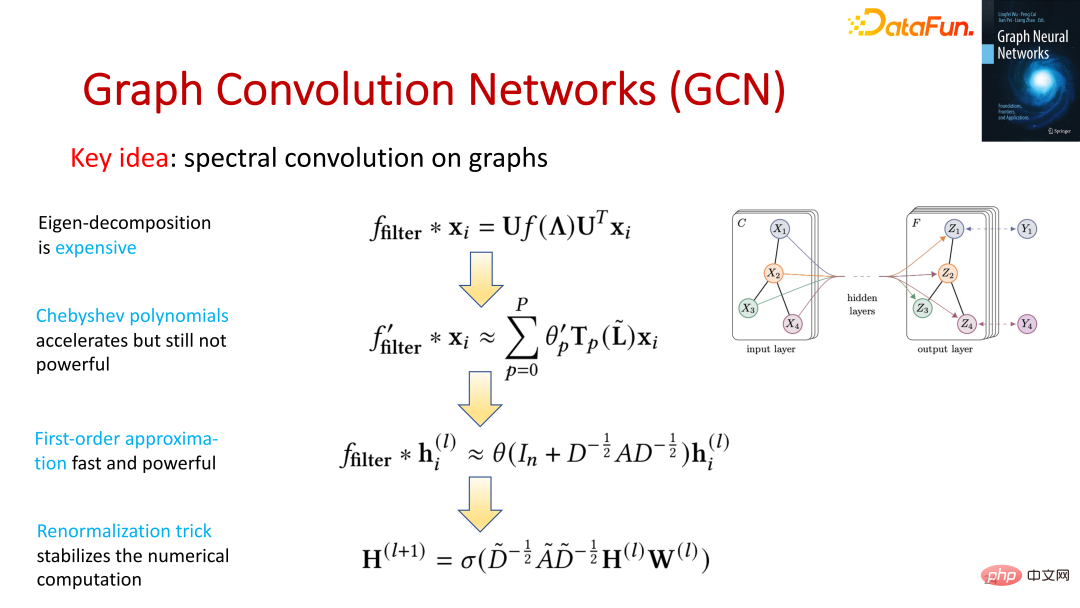

ialah salah satu algoritma paling klasik, ia boleh Bertindak terus pada graf dan mengeksploitasi maklumat strukturnya. Memfokuskan pada meningkatkan kelajuan, kepraktisan dan kestabilan model, seperti yang ditunjukkan dalam rajah di atas, GCN juga telah melalui beberapa lelaran. Kertas GCN mempunyai kepentingan yang sangat penting dan meletakkan asas untuk rangkaian saraf graf.

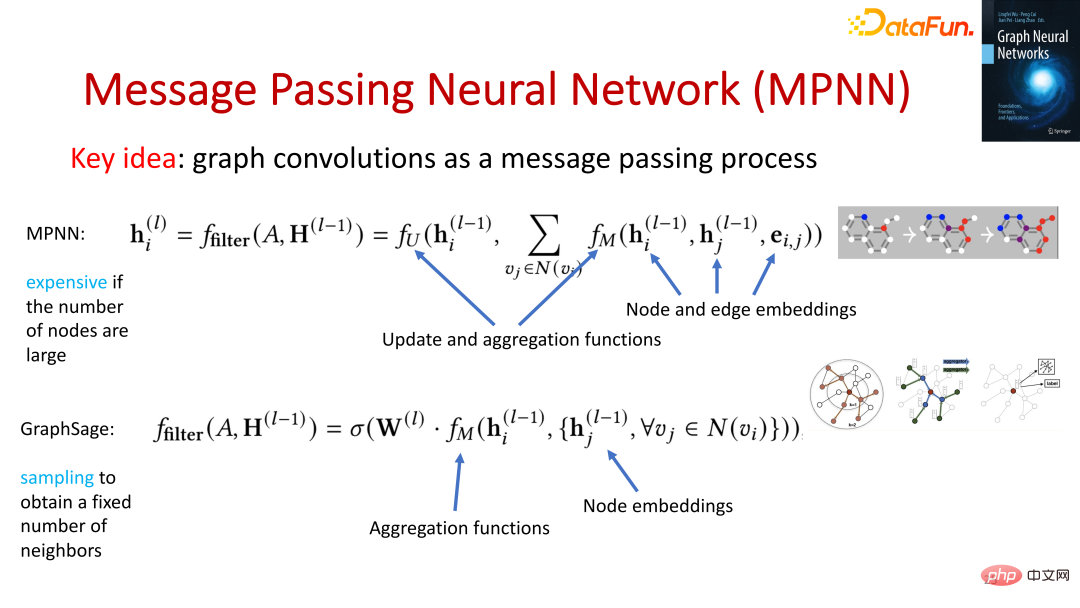

MPNN

Titik teras ialah untuk menukar lilitan graf Untuk proses pemindahan maklumat, ia mentakrifkan dua fungsi iaitu fungsi agregasi dan fungsi kemas kini. Algoritma ini adalah algoritma yang mudah dan umum, tetapi ia tidak cekap. GraphSage

ialah algoritma peringkat industri Ia menggunakan pensampelan untuk mendapatkan bilangan nod jiran tertentu. Oleh itu perwakilan vektor nod sekolah.

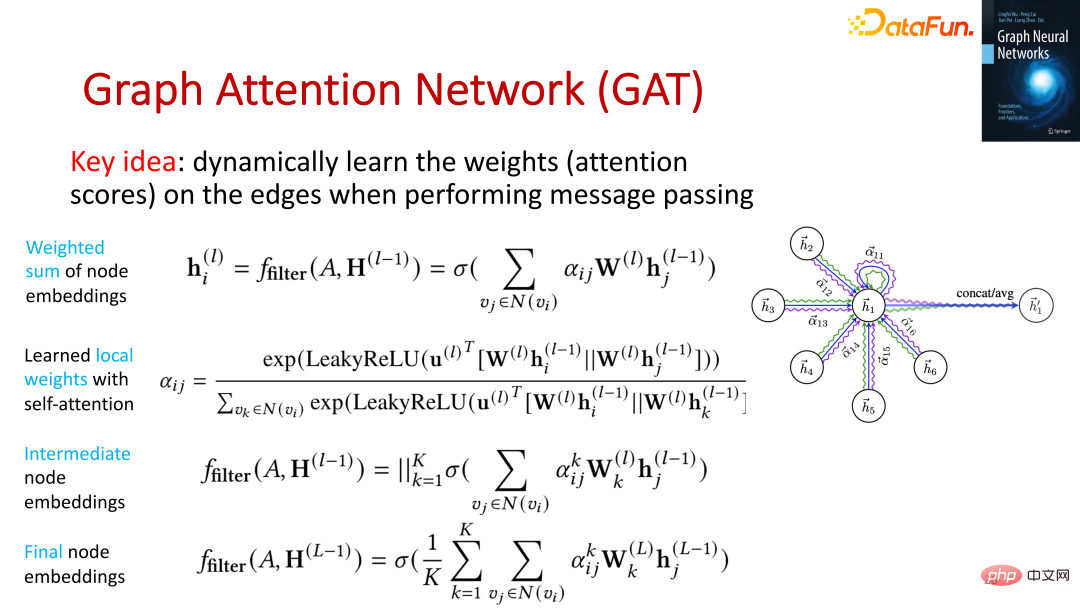

GAT

memperkenalkan idea perhatian, terasnya Intinya adalah untuk mempelajari berat kelebihan secara dinamik semasa pemindahan maklumat.

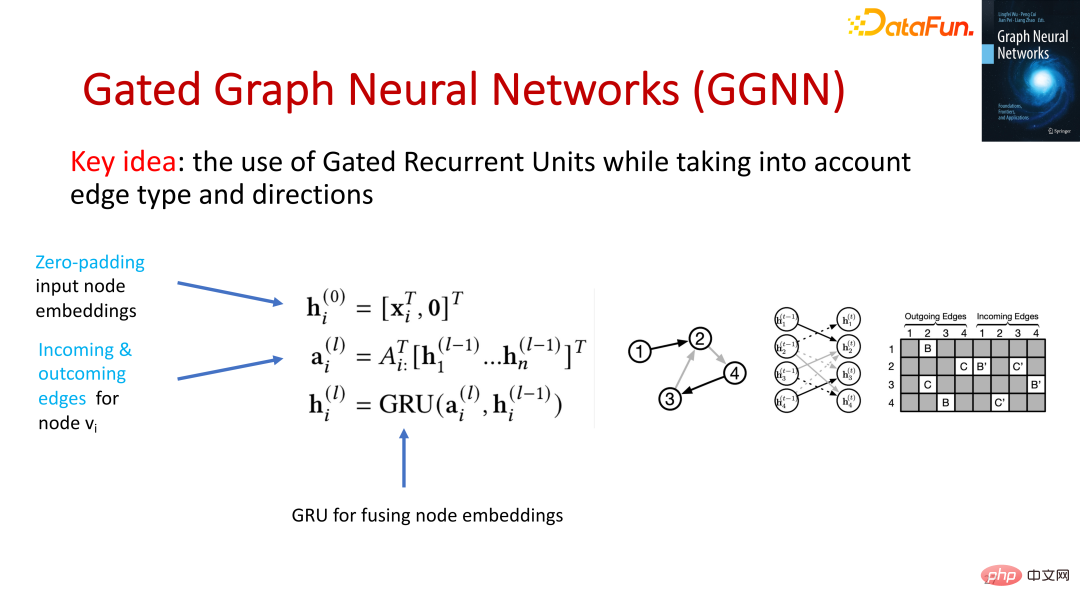

Selain algoritma yang diperkenalkan di atas, terdapat juga GGNN cirinya ialah output boleh menjadi berbilang nod. anda boleh menyemaknya Kertas berkaitan.

Dalam buku "Asas, Sempadan dan Aplikasi Rangkaian Neural Graf", Bab 5, 6, 7 dan 8 juga memperkenalkan cara menilai rangkaian saraf graf dan kebolehskalaan rangkaian saraf graf masing-masing. kebolehtafsiran rangkaian saraf graf, dan kestabilan lawan rangkaian saraf graf Jika anda berminat, anda boleh membaca bab yang sepadan dalam buku.

3. The Frontier of Graph Neural Networks

1 🎜>

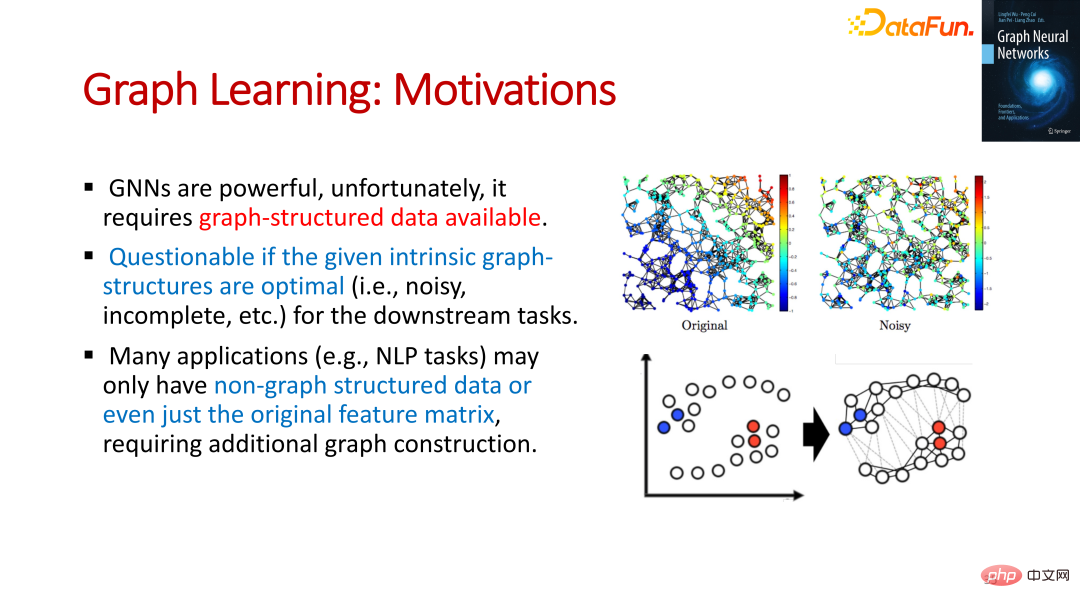

Rangkaian saraf graf memerlukan data struktur graf, tetapi ia diragukan sama ada struktur graf yang diberikan adalah optimum. data berstruktur graf, atau malah hanya ciri mentah.

Rangkaian saraf graf memerlukan data struktur graf, tetapi ia diragukan sama ada struktur graf yang diberikan adalah optimum. data berstruktur graf, atau malah hanya ciri mentah.

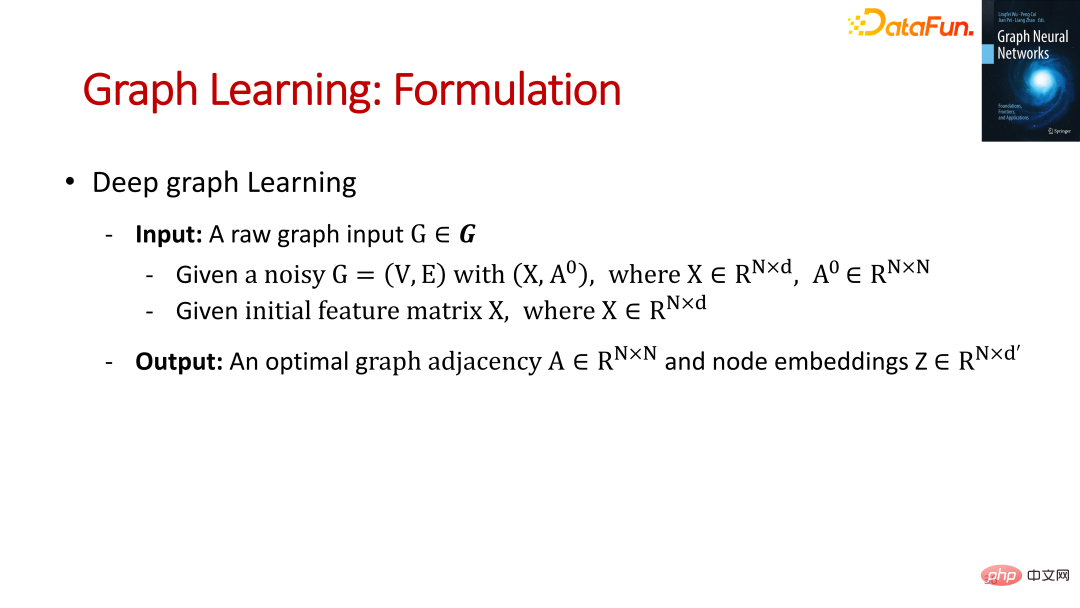

Jadi, kita perlu menggunakan rangkaian saraf graf untuk mempelajari perwakilan graf dan perwakilan nod graf yang optimum.

Jadi, kita perlu menggunakan rangkaian saraf graf untuk mempelajari perwakilan graf dan perwakilan nod graf yang optimum.

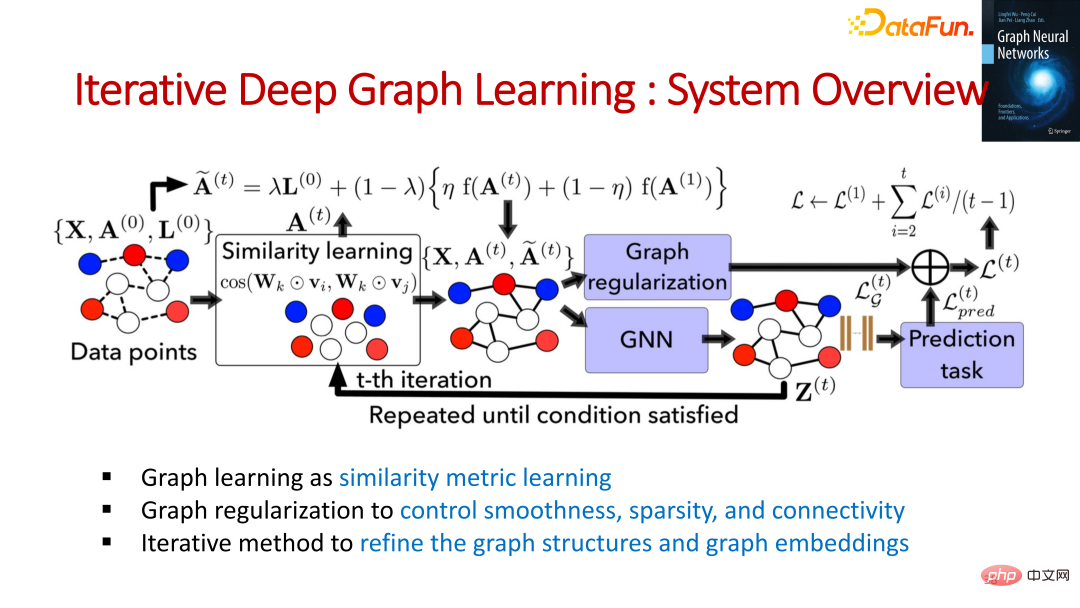

Kami menukar pembelajaran graf kepada pembelajaran persamaan antara nod, dan mengawal kelancaran melalui regularisasi , atribut sistem dan ketersambungan, dan secara berulang menghalusi struktur graf dan perwakilan vektor graf.

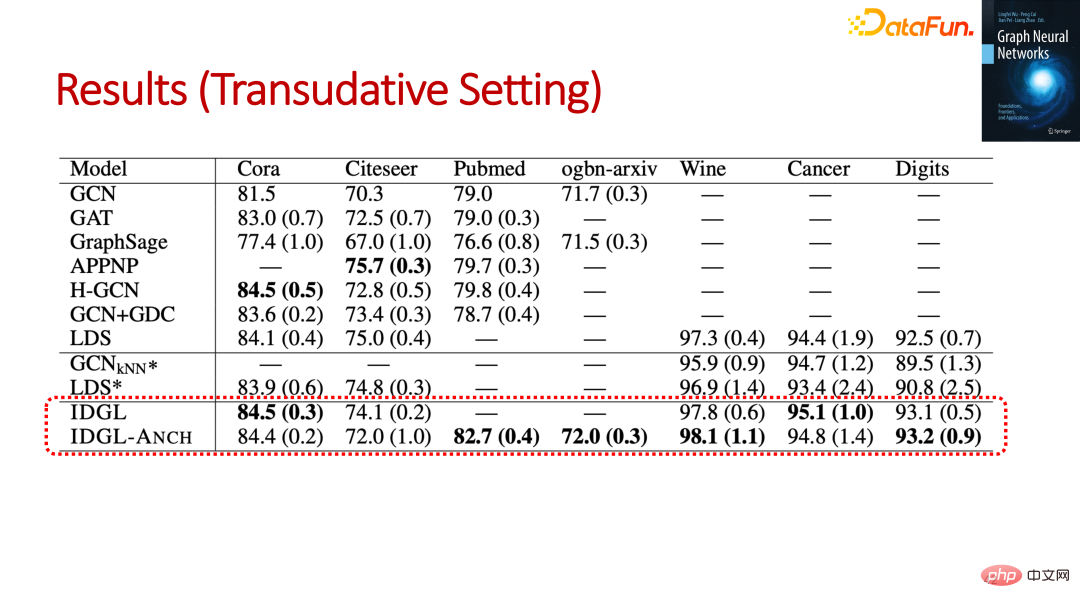

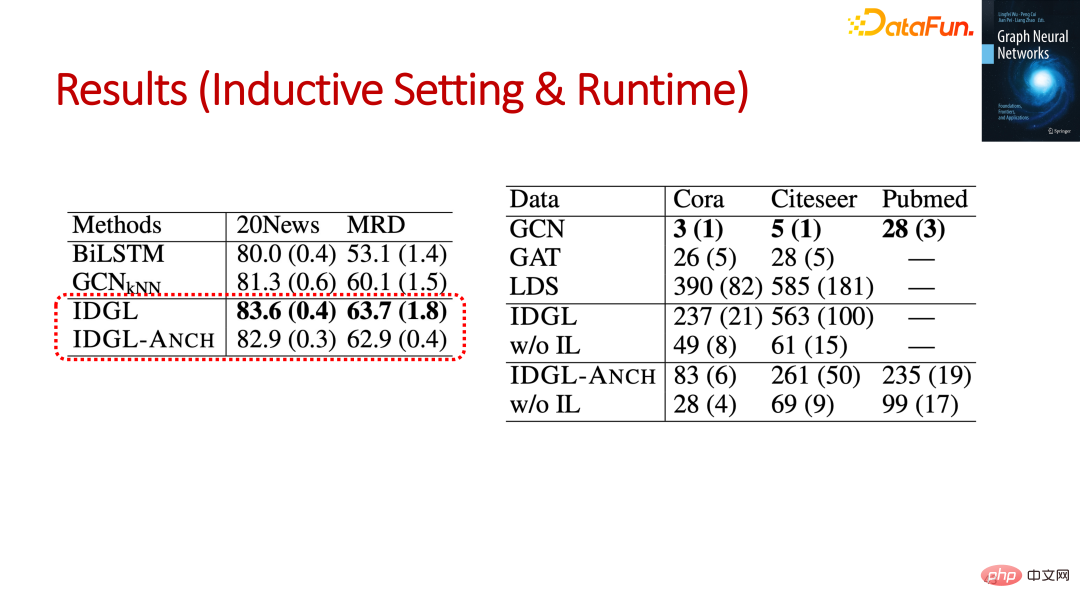

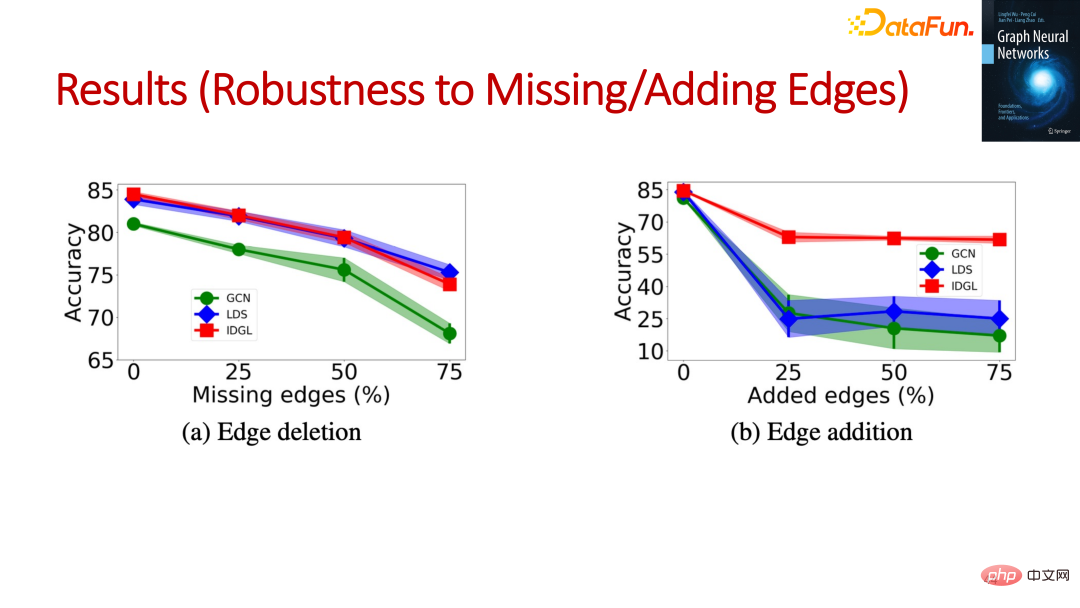

Data eksperimen

Data eksperimen

boleh menunjukkan kelebihan pendekatan ini.

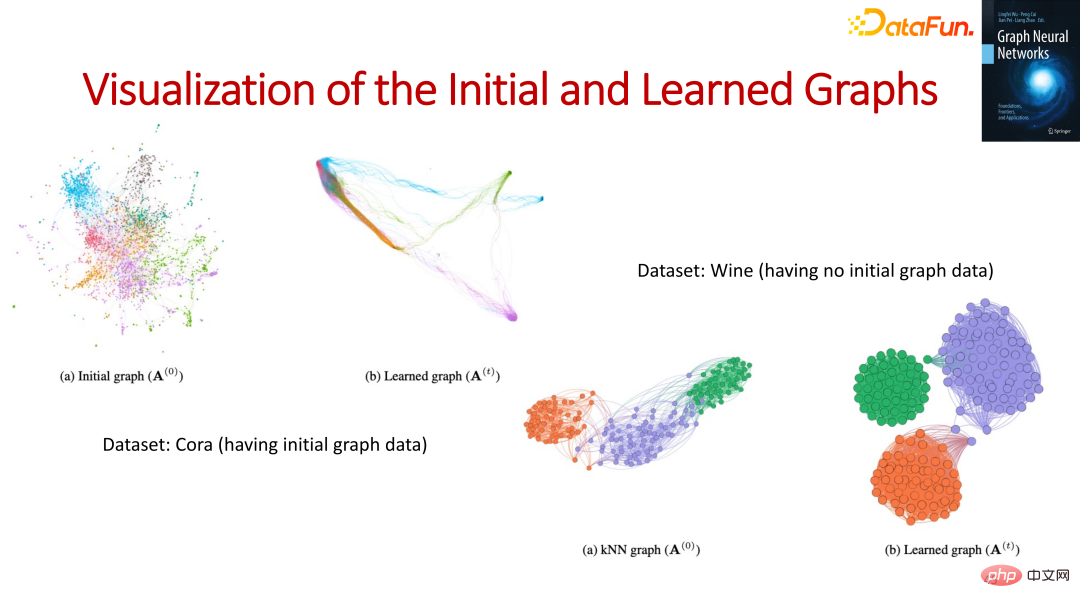

Melalui hasil visualisasi graf

Melalui hasil visualisasi graf

, boleh didapati bahawa graf yang dipelajari cenderung untuk mengumpulkan graf yang serupa Objek dikelompokkan bersama dan mempunyai kebolehtafsiran tertentu. 2. Sempadan Lain

Dalam buku "Asas, Sempadan dan Aplikasi Rangkaian Neural Graf", sempadan berikut turut diperkenalkan. Penyelidikan, penyelidikan canggih ini mempunyai aplikasi penting dalam banyak senario:

Klasifikasi graf

- Ramalan Pautan;

- Penukaran graf; >Pemadanan graf;

- Rangkaian saraf graf dinamik;

- AutoML untuk rangkaian saraf graf; .

- 4. Aplikasi rangkaian saraf graf

- 1

- Kami boleh menggunakan maklumat sesi untuk membina graf global yang heterogen, dan kemudian mempelajari perwakilan vektor pengguna atau item melalui pembelajaran rangkaian saraf graf dan menggunakan perwakilan vektor ini untuk pemperibadian cadangan.

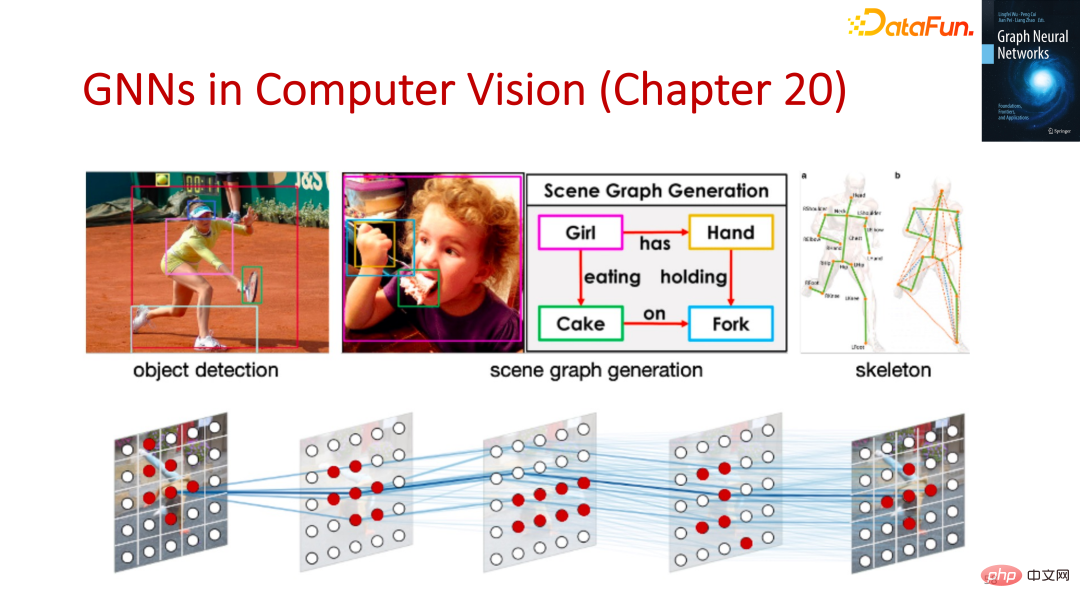

2. Aplikasi rangkaian saraf graf dalam penglihatan komputer

Kita boleh menjejaki proses perubahan dinamik objek, Tingkatkan pemahaman anda tentang video dengan rangkaian saraf graf.

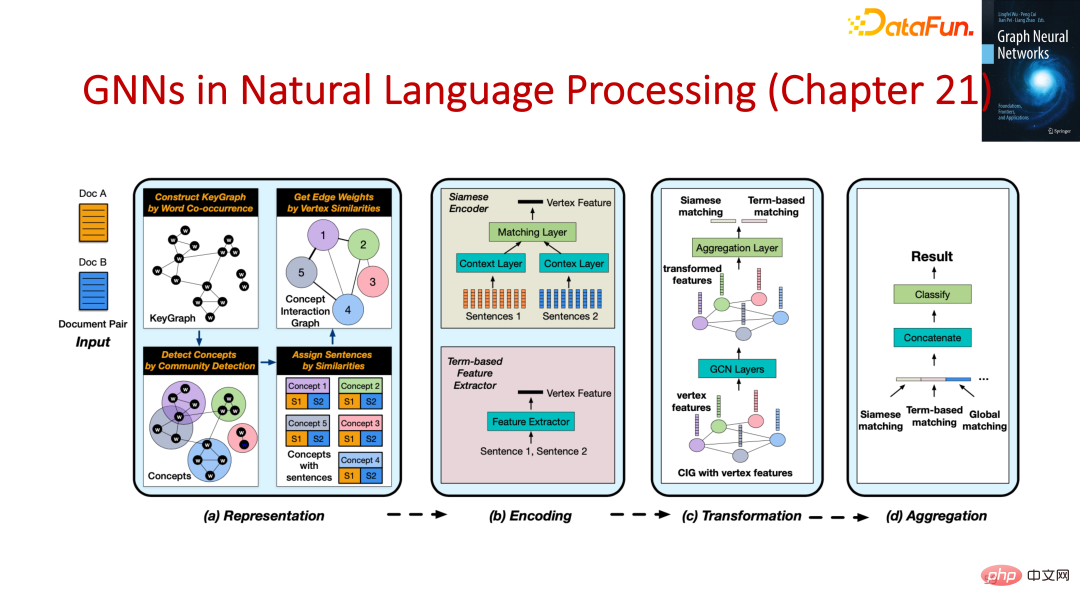

3 Aplikasi rangkaian saraf graf dalam pemprosesan bahasa semula jadi

Kita boleh menggunakan rangkaian saraf graf untuk memahami maklumat peringkat tinggi bahasa semula jadi.

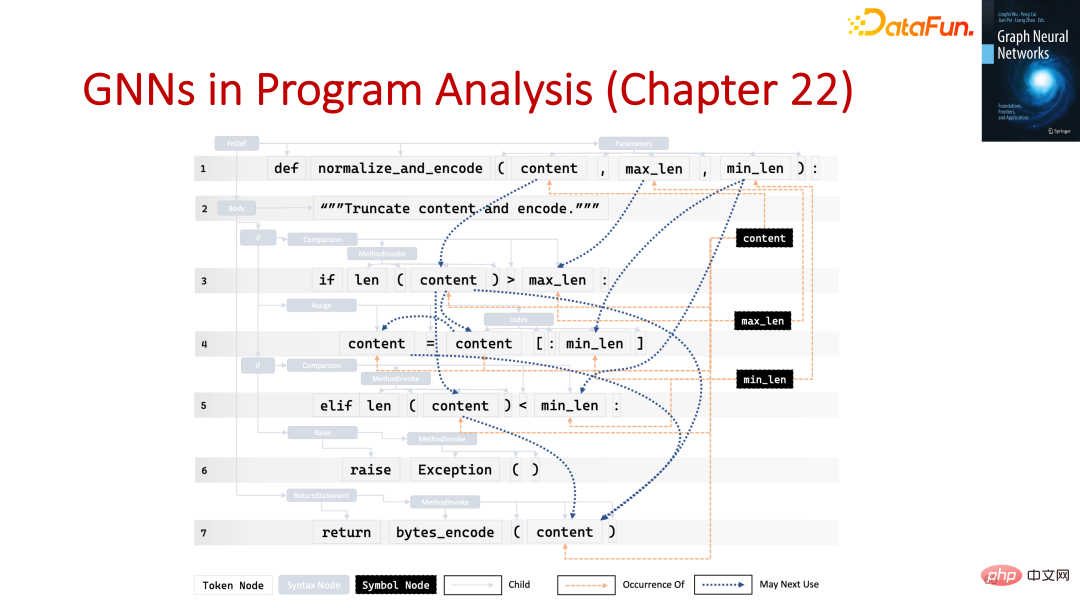

4 Aplikasi rangkaian saraf graf dalam analisis program

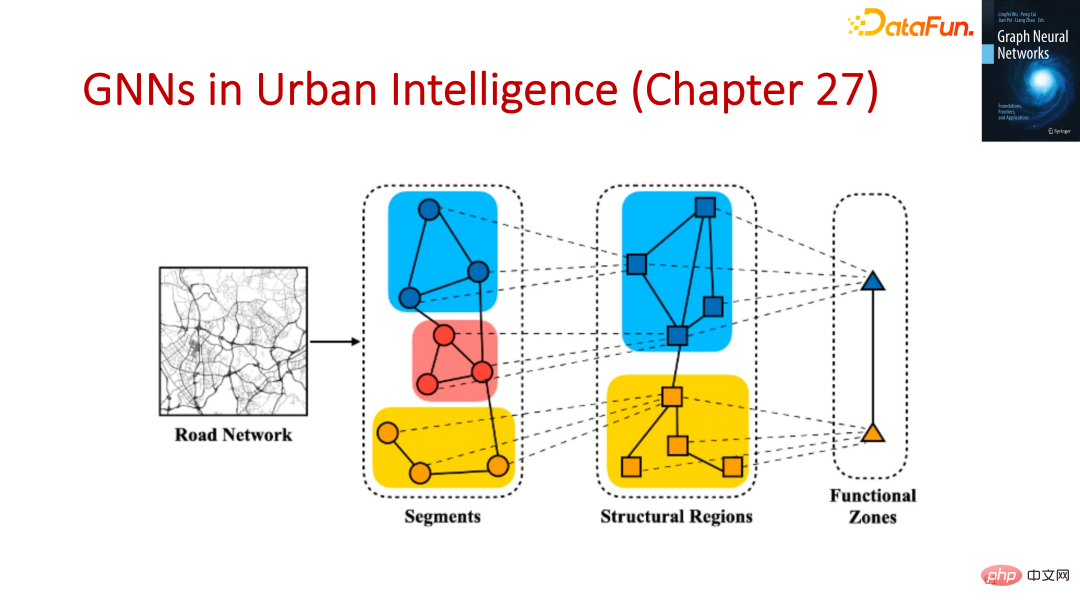

<.>5. Aplikasi rangkaian saraf graf di bandar pintar

5 🎜>S1: Adakah GNN satu kaedah penting untuk pembelajaran mendalam generasi akan datang?

A1: Rangkaian saraf graf ialah cabang yang sangat penting, dan cabang yang seiring dengan rangkaian saraf graf ialah Transformer. Memandangkan fleksibiliti rangkaian saraf graf, rangkaian saraf graf dan Transformer boleh digabungkan antara satu sama lain untuk memanfaatkan kelebihan yang lebih besar.

S2: Bolehkah GNN dan pembelajaran kausal digabungkan? Bagaimana untuk menggabungkan?

A2: Pautan penting dalam pembelajaran kausal ialah graf kausal, dan graf kausal dan GNN boleh digabungkan secara semula jadi. Kesukaran pembelajaran sebab ialah saiz datanya kecil Kita boleh menggunakan keupayaan GNN untuk mempelajari graf sebab dengan lebih baik.

S3: Apakah perbezaan dan kaitan antara kebolehtafsiran GNN dan kebolehtafsiran pembelajaran mesin tradisional?

A3: Ia akan diperkenalkan secara terperinci dalam buku "Asas, Sempadan dan Aplikasi Rangkaian Neural Graf".

S4: Bagaimana untuk melatih dan membuat kesimpulan GNN secara langsung berdasarkan pangkalan data graf dan menggunakan kuasa pengkomputeran graf?

J4: Pada masa ini, tiada amalan yang baik pada platform pengkomputeran graf bersatu Terdapat beberapa syarikat permulaan dan pasukan penyelidikan saintifik yang meneroka arah yang berkaitan Untuk hala tuju penyelidikan yang berharga dan mencabar, pendekatan yang lebih boleh dilaksanakan ialah membahagikan penyelidikan kepada bidang yang berbeza.

Atas ialah kandungan terperinci Asas, sempadan dan aplikasi GNN. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1376

1376

52

52

Artikel ini akan membawa anda memahami SHAP: penjelasan model untuk pembelajaran mesin

Jun 01, 2024 am 10:58 AM

Artikel ini akan membawa anda memahami SHAP: penjelasan model untuk pembelajaran mesin

Jun 01, 2024 am 10:58 AM

Dalam bidang pembelajaran mesin dan sains data, kebolehtafsiran model sentiasa menjadi tumpuan penyelidik dan pengamal. Dengan aplikasi meluas model yang kompleks seperti kaedah pembelajaran mendalam dan ensemble, memahami proses membuat keputusan model menjadi sangat penting. AI|XAI yang boleh dijelaskan membantu membina kepercayaan dan keyakinan dalam model pembelajaran mesin dengan meningkatkan ketelusan model. Meningkatkan ketelusan model boleh dicapai melalui kaedah seperti penggunaan meluas pelbagai model yang kompleks, serta proses membuat keputusan yang digunakan untuk menerangkan model. Kaedah ini termasuk analisis kepentingan ciri, anggaran selang ramalan model, algoritma kebolehtafsiran tempatan, dsb. Analisis kepentingan ciri boleh menerangkan proses membuat keputusan model dengan menilai tahap pengaruh model ke atas ciri input. Anggaran selang ramalan model

Telus! Analisis mendalam tentang prinsip model pembelajaran mesin utama!

Apr 12, 2024 pm 05:55 PM

Telus! Analisis mendalam tentang prinsip model pembelajaran mesin utama!

Apr 12, 2024 pm 05:55 PM

Dalam istilah orang awam, model pembelajaran mesin ialah fungsi matematik yang memetakan data input kepada output yang diramalkan. Secara lebih khusus, model pembelajaran mesin ialah fungsi matematik yang melaraskan parameter model dengan belajar daripada data latihan untuk meminimumkan ralat antara output yang diramalkan dan label sebenar. Terdapat banyak model dalam pembelajaran mesin, seperti model regresi logistik, model pepohon keputusan, model mesin vektor sokongan, dll. Setiap model mempunyai jenis data dan jenis masalah yang berkenaan. Pada masa yang sama, terdapat banyak persamaan antara model yang berbeza, atau terdapat laluan tersembunyi untuk evolusi model. Mengambil perceptron penyambung sebagai contoh, dengan meningkatkan bilangan lapisan tersembunyi perceptron, kita boleh mengubahnya menjadi rangkaian neural yang mendalam. Jika fungsi kernel ditambah pada perceptron, ia boleh ditukar menjadi SVM. yang ini

Kenal pasti overfitting dan underfitting melalui lengkung pembelajaran

Apr 29, 2024 pm 06:50 PM

Kenal pasti overfitting dan underfitting melalui lengkung pembelajaran

Apr 29, 2024 pm 06:50 PM

Artikel ini akan memperkenalkan cara mengenal pasti pemasangan lampau dan kekurangan dalam model pembelajaran mesin secara berkesan melalui keluk pembelajaran. Underfitting dan overfitting 1. Overfitting Jika model terlampau latihan pada data sehingga ia mempelajari bunyi daripadanya, maka model tersebut dikatakan overfitting. Model yang dipasang terlebih dahulu mempelajari setiap contoh dengan sempurna sehingga ia akan salah mengklasifikasikan contoh yang tidak kelihatan/baharu. Untuk model terlampau, kami akan mendapat skor set latihan yang sempurna/hampir sempurna dan set pengesahan/skor ujian yang teruk. Diubah suai sedikit: "Punca overfitting: Gunakan model yang kompleks untuk menyelesaikan masalah mudah dan mengekstrak bunyi daripada data. Kerana set data kecil sebagai set latihan mungkin tidak mewakili perwakilan yang betul bagi semua data. 2. Underfitting Heru

Evolusi kecerdasan buatan dalam penerokaan angkasa lepas dan kejuruteraan penempatan manusia

Apr 29, 2024 pm 03:25 PM

Evolusi kecerdasan buatan dalam penerokaan angkasa lepas dan kejuruteraan penempatan manusia

Apr 29, 2024 pm 03:25 PM

Pada tahun 1950-an, kecerdasan buatan (AI) dilahirkan. Ketika itulah penyelidik mendapati bahawa mesin boleh melakukan tugas seperti manusia, seperti berfikir. Kemudian, pada tahun 1960-an, Jabatan Pertahanan A.S. membiayai kecerdasan buatan dan menubuhkan makmal untuk pembangunan selanjutnya. Penyelidik sedang mencari aplikasi untuk kecerdasan buatan dalam banyak bidang, seperti penerokaan angkasa lepas dan kelangsungan hidup dalam persekitaran yang melampau. Penerokaan angkasa lepas ialah kajian tentang alam semesta, yang meliputi seluruh alam semesta di luar bumi. Angkasa lepas diklasifikasikan sebagai persekitaran yang melampau kerana keadaannya berbeza daripada di Bumi. Untuk terus hidup di angkasa, banyak faktor mesti dipertimbangkan dan langkah berjaga-jaga mesti diambil. Para saintis dan penyelidik percaya bahawa meneroka ruang dan memahami keadaan semasa segala-galanya boleh membantu memahami cara alam semesta berfungsi dan bersedia untuk menghadapi kemungkinan krisis alam sekitar

Melaksanakan Algoritma Pembelajaran Mesin dalam C++: Cabaran dan Penyelesaian Biasa

Jun 03, 2024 pm 01:25 PM

Melaksanakan Algoritma Pembelajaran Mesin dalam C++: Cabaran dan Penyelesaian Biasa

Jun 03, 2024 pm 01:25 PM

Cabaran biasa yang dihadapi oleh algoritma pembelajaran mesin dalam C++ termasuk pengurusan memori, multi-threading, pengoptimuman prestasi dan kebolehselenggaraan. Penyelesaian termasuk menggunakan penunjuk pintar, perpustakaan benang moden, arahan SIMD dan perpustakaan pihak ketiga, serta mengikuti garis panduan gaya pengekodan dan menggunakan alat automasi. Kes praktikal menunjukkan cara menggunakan perpustakaan Eigen untuk melaksanakan algoritma regresi linear, mengurus memori dengan berkesan dan menggunakan operasi matriks berprestasi tinggi.

AI yang boleh dijelaskan: Menerangkan model AI/ML yang kompleks

Jun 03, 2024 pm 10:08 PM

AI yang boleh dijelaskan: Menerangkan model AI/ML yang kompleks

Jun 03, 2024 pm 10:08 PM

Penterjemah |. Disemak oleh Li Rui |. Chonglou Model kecerdasan buatan (AI) dan pembelajaran mesin (ML) semakin kompleks hari ini, dan output yang dihasilkan oleh model ini adalah kotak hitam – tidak dapat dijelaskan kepada pihak berkepentingan. AI Boleh Dijelaskan (XAI) bertujuan untuk menyelesaikan masalah ini dengan membolehkan pihak berkepentingan memahami cara model ini berfungsi, memastikan mereka memahami cara model ini sebenarnya membuat keputusan, dan memastikan ketelusan dalam sistem AI, Amanah dan akauntabiliti untuk menyelesaikan masalah ini. Artikel ini meneroka pelbagai teknik kecerdasan buatan (XAI) yang boleh dijelaskan untuk menggambarkan prinsip asasnya. Beberapa sebab mengapa AI boleh dijelaskan adalah penting Kepercayaan dan ketelusan: Untuk sistem AI diterima secara meluas dan dipercayai, pengguna perlu memahami cara keputusan dibuat

Lima sekolah pembelajaran mesin yang anda tidak tahu

Jun 05, 2024 pm 08:51 PM

Lima sekolah pembelajaran mesin yang anda tidak tahu

Jun 05, 2024 pm 08:51 PM

Pembelajaran mesin ialah cabang penting kecerdasan buatan yang memberikan komputer keupayaan untuk belajar daripada data dan meningkatkan keupayaan mereka tanpa diprogramkan secara eksplisit. Pembelajaran mesin mempunyai pelbagai aplikasi dalam pelbagai bidang, daripada pengecaman imej dan pemprosesan bahasa semula jadi kepada sistem pengesyoran dan pengesanan penipuan, dan ia mengubah cara hidup kita. Terdapat banyak kaedah dan teori yang berbeza dalam bidang pembelajaran mesin, antaranya lima kaedah yang paling berpengaruh dipanggil "Lima Sekolah Pembelajaran Mesin". Lima sekolah utama ialah sekolah simbolik, sekolah sambungan, sekolah evolusi, sekolah Bayesian dan sekolah analogi. 1. Simbolisme, juga dikenali sebagai simbolisme, menekankan penggunaan simbol untuk penaakulan logik dan ekspresi pengetahuan. Aliran pemikiran ini percaya bahawa pembelajaran adalah proses penolakan terbalik, melalui sedia ada

Adakah Flash Attention stabil? Meta dan Harvard mendapati bahawa sisihan berat model mereka berubah-ubah mengikut urutan magnitud

May 30, 2024 pm 01:24 PM

Adakah Flash Attention stabil? Meta dan Harvard mendapati bahawa sisihan berat model mereka berubah-ubah mengikut urutan magnitud

May 30, 2024 pm 01:24 PM

MetaFAIR bekerjasama dengan Harvard untuk menyediakan rangka kerja penyelidikan baharu untuk mengoptimumkan bias data yang dijana apabila pembelajaran mesin berskala besar dilakukan. Adalah diketahui bahawa latihan model bahasa besar sering mengambil masa berbulan-bulan dan menggunakan ratusan atau bahkan ribuan GPU. Mengambil model LLaMA270B sebagai contoh, latihannya memerlukan sejumlah 1,720,320 jam GPU. Melatih model besar memberikan cabaran sistemik yang unik disebabkan oleh skala dan kerumitan beban kerja ini. Baru-baru ini, banyak institusi telah melaporkan ketidakstabilan dalam proses latihan apabila melatih model AI generatif SOTA Mereka biasanya muncul dalam bentuk lonjakan kerugian Contohnya, model PaLM Google mengalami sehingga 20 lonjakan kerugian semasa proses latihan. Bias berangka adalah punca ketidaktepatan latihan ini,