Peranti teknologi

Peranti teknologi

AI

AI

Di manakah ChatGPT akan pergi dari sini? Karya baharu LeCun: Kajian menyeluruh tentang 'model bahasa dipertingkat' generasi akan datang

Di manakah ChatGPT akan pergi dari sini? Karya baharu LeCun: Kajian menyeluruh tentang 'model bahasa dipertingkat' generasi akan datang

Di manakah ChatGPT akan pergi dari sini? Karya baharu LeCun: Kajian menyeluruh tentang 'model bahasa dipertingkat' generasi akan datang

ChatGPT telah mencetuskan api model bahasa, dan pengamal NLP merenung dan meringkaskan hala tuju penyelidikan masa hadapan.

Baru-baru ini, pemenang Anugerah Turing Yann LeCun telah mengambil bahagian dalam menulis ulasan tentang "model bahasa yang dipertingkatkan", mengkaji The work combines model bahasa dengan kemahiran menaakul dan kebolehan menggunakan alatan, dan menyimpulkan bahawa hala tuju penyelidikan baharu ini berpotensi untuk menangani batasan model bahasa tradisional, seperti isu kebolehtafsiran, ketekalan dan skalabiliti.

Pautan kertas: https://arxiv.org/abs/2302.07842

Dalam model bahasa yang dipertingkatkan, penaakulan bermaksud menguraikan tugasan kompleks kepada subtugasan yang lebih mudah Alat termasuk memanggil modul luaran (seperti jurubahasa kod, kalkulator, dll.), dan LM boleh menggunakan Kaedah heuristik mengeksploitasi peningkatan ini. secara individu atau gabungan, atau melalui pembelajaran tunjuk cara.

Sambil mengikut matlamat ramalan token tiada standard, LM yang dipertingkatkan boleh menggunakan pelbagai modul luaran yang mungkin bukan parametrik untuk melanjutkan keupayaan pemprosesan konteks dan tidak terhad kepada pemodelan bahasa tulen Paradigma boleh dipanggil model bahasa tambahan (ALMs, Augmented Language Models).

Sasaran ramalan untuk token yang hilang membolehkan ALM belajar untuk menaakul, menggunakan alatan, dan juga bertindak (bertindak), sambil masih mampu melaksanakan tugas bahasa semula jadi standard dan bahkan mengatasi prestasi pada beberapa set data penanda aras Lebih daripada kebanyakan LM biasa.

Model Bahasa Dipertingkat

Model bahasa berskala besar (LLM) telah memacu kemajuan yang luar biasa dalam pemprosesan bahasa semula jadi dan secara beransur-ansur menjadi teras teknikal produk yang digunakan oleh berjuta-juta pengguna termasuk pembantu pengekodan Copilot, enjin carian Google dan ChatGPT yang dikeluarkan baru-baru ini.

Penghafalan digabungkan dengan keupayaan Kekomposisian membolehkan LLM melaksanakan pelbagai tugas seperti pemahaman bahasa atau penjanaan teks bersyarat dan tidak bersyarat pada tahap prestasi yang belum pernah berlaku sebelum ini, dengan itu memberi perkhidmatan kepada lebih ramai orang yang mempunyai interaksi komputer membuka jalan praktikal.

Walau bagaimanapun, perkembangan semasa LLM masih tertakluk kepada banyak sekatan, menghalang penggunaannya kepada rangkaian senario aplikasi yang lebih luas.

Sebagai contoh, LLM sering memberikan ramalan yang tidak berdasarkan fakta tetapi kelihatan munasabah, juga dikenali sebagai halusinasi Banyak ralat sebenarnya boleh dielakkan sepenuhnya, termasuk masalah aritmetik dan rantaian penaakulan Ralat kecil berlaku.

Tambahan pula, banyak keupayaan terobosan LLM nampaknya datang dengan skala, seperti yang diukur dengan bilangan parameter yang boleh dilatih, kerana penyelidik terdahulu telah menunjukkan bahawa sebaik sahaja model itu mencapai tahap tertentu. skala, LLM boleh menyelesaikan beberapa tugas BIG-bench melalui gesaan beberapa pukulan.

Walaupun terdapat usaha baru-baru ini untuk melatih beberapa LM yang lebih kecil sambil mengekalkan beberapa keupayaan model besar, skala semasa LLM dan permintaan untuk data menjadikan latihan dan penyelenggaraan sukar tidak praktikal: pembelajaran berterusan model besar kekal sebagai masalah penyelidikan terbuka.

Penyelidik meta percaya bahawa masalah ini berpunca daripada kecacatan asas LLM: proses latihan diberi model parameter dan konteks terhad (biasanya n perkataan sebelum dan seterusnya), dan kemudian melaksanakan statistik pemodelan bahasa.

Walaupun saiz konteks n telah berkembang sejak beberapa tahun kebelakangan ini disebabkan oleh pembangunan perisian dan perkakasan, kebanyakan model masih menggunakan saiz konteks yang agak kecil, jadi saiz besar model disimpan Tidak hadir ialah syarat yang diperlukan untuk pengetahuan kontekstual, yang juga penting untuk melaksanakan tugas hiliran.

Oleh itu, trend penyelidikan yang semakin meningkat adalah untuk menyelesaikan masalah ini dengan cara yang sedikit menyimpang daripada paradigma pemodelan bahasa statistik semata-mata yang disebutkan di atas.

Sebagai contoh, terdapat kerja untuk memintas masalah saiz konteks terhad LLM dengan menambah pengiraan perkaitan daripada "maklumat yang diekstrak daripada fail luaran yang berkaitan". Dengan melengkapkan LM dengan modul dapatkan semula untuk mendapatkan semula dokumen sedemikian dalam konteks tertentu daripada pangkalan data, kami boleh memadankan beberapa keupayaan LM berskala lebih besar sambil mempunyai parameter yang lebih sedikit.

Adalah penting untuk ambil perhatian bahawa model yang terhasil kini bukan parametrik, kerana ia boleh menanyakan sumber data luaran. Secara umumnya, LM juga boleh menambah baik konteksnya melalui strategi inferens untuk menjana konteks yang lebih relevan sebelum menjana jawapan, meningkatkan prestasi melalui lebih banyak pengiraan.

Strategi lain ialah membenarkan LM memanfaatkan alatan luaran untuk meningkatkan konteks semasa dengan maklumat penting yang hilang yang tidak terkandung dalam pemberat LM. Walaupun kebanyakan kerja ini bertujuan untuk mengurangkan kelemahan LM yang disebutkan di atas, adalah mudah untuk membayangkan bahawa meningkatkan LM dengan lebih sistematik dengan penaakulan dan alatan boleh membawa kepada agen yang lebih berkuasa.

Penyelidik secara kolektif merujuk model ini sebagai Model Bahasa Ditambah (ALM) .

Apabila aliran ini semakin pantas, menjadi sukar untuk menjejaki dan memahami pelbagai model, yang memerlukan pengelasan kerja ALM dan istilah teknikal yang kadangkala digunakan untuk tujuan yang berbeza Tentukan.

Penaakulan

Dalam konteks ALM, penaakulan ialah penguraian tugas yang mungkin kompleks kepada Subtugasan yang lebih mudah yang LM boleh menyelesaikan dengan lebih mudah sendiri atau menggunakan alatan.

Pada masa ini terdapat pelbagai cara untuk menguraikan subtugasan, seperti pengulangan atau lelaran Dalam erti kata lain, alasannya adalah serupa dengan Pelan "Menuju Perisikan Mesin Autonomi" LeCun yang ditakrifkan dalam "Laluan. ".

Pautan kertas: https://openreview.net/pdf?id=BZ5a1r-kVsf

Dalam tinjauan ini, penaakulan merujuk kepada pelbagai strategi untuk meningkatkan keupayaan penaakulan dalam LM, seperti menggunakan sebilangan kecil contoh untuk penaakulan langkah demi langkah. Walaupun masih belum difahami sepenuhnya sama ada LM sebenarnya membuat alasan, atau hanya menjana konteks yang lebih besar yang meningkatkan kemungkinan meramalkan token yang hilang dengan betul.

Memandangkan keadaan teknologi semasa, penaakulan mungkin merupakan istilah yang terlalu digunakan, tetapi istilah itu sudah digunakan secara meluas dalam komuniti. Dalam konteks ALM, definisi inferens yang lebih pragmatik adalah untuk memberikan model lebih langkah pengiraan sebelum tiba pada jawapan kepada gesaan.

Alat Alat

Untuk ALM, alat tersebut ialah modul luaran, biasanya Dipanggil menggunakan peraturan atau token khas, outputnya disertakan dalam konteks ALM.

Alat boleh digunakan untuk mengumpul maklumat luaran, atau memberi kesan pada dunia maya atau fizikal (biasanya dirasai oleh ALM): contohnya, pengambilan fail boleh digunakan sebagai alat untuk mendapatkan maklumat luaran, Atau gunakan lengan robot untuk mengesan pengaruh luaran.

Alat boleh dipanggil pada masa latihan atau pada masa inferens Secara umumnya, model perlu belajar untuk berinteraksi dengan alat tersebut, termasuk belajar memanggil APInya

.Bertindak

Untuk ALM, memanggil alat yang memberi kesan kepada dunia maya atau fizikal dan memerhatikannya keputusan, Biasanya ia dibawa ke dalam konteks semasa ALM.

Sesetengah kerja yang diperkenalkan dalam tinjauan ini membincangkan carian di web atau memanipulasi senjata robot melalui LM. Dalam sedikit penyalahgunaan istilah, penggunaan alat ALM kadangkala diwakili sebagai tindakan, walaupun ia tidak memberi kesan kepada dunia luar.

Mengapa membincangkan penaakulan dan alatan pada masa yang sama?

Gabungan penaakulan dan alatan dalam LM harus membolehkan menyelesaikan pelbagai tugas yang kompleks tanpa heuristik, iaitu dengan keupayaan generalisasi yang lebih baik.

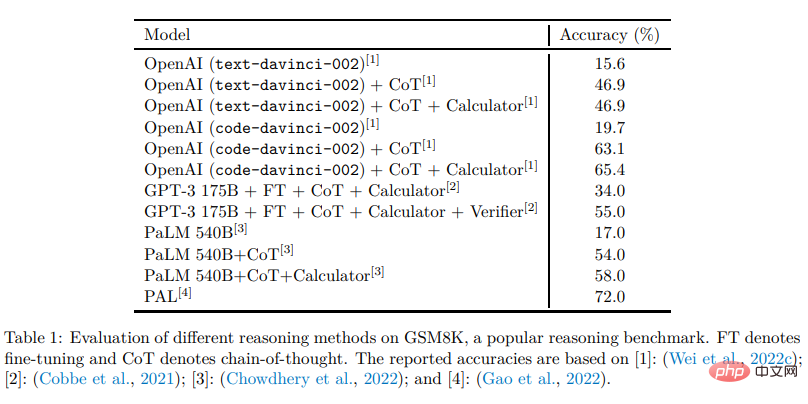

Lazimnya, penaakulan memudahkan LM untuk memecahkan masalah yang diberikan kepada subtugasan yang berpotensi lebih mudah, manakala alatan membantu untuk menyelesaikan setiap langkah dengan betul, cth. dari Dapatkan hasil daripada operasi matematik.

Dalam erti kata lain, penaakulan ialah satu cara untuk LM menggabungkan alatan yang berbeza untuk menyelesaikan tugasan yang kompleks, manakala alatan ialah cara untuk mengelakkan kegagalan penaakulan dan terurai dengan berkesan.

Kedua-duanya harus mendapat manfaat daripada yang lain, dan inferens serta alatan boleh diletakkan dalam modul yang sama, kerana kedua-duanya meningkatkan ramalan token yang hilang dengan meningkatkan konteks LM, Walaupun dalam cara yang berbeza .

Mengapa membincangkan alatan dan tindakan pada masa yang sama?

Alat untuk mengumpul maklumat tambahan dan memberi kesan kepada dunia maya atau fizikal boleh digunakan oleh LM dengan cara yang sama. Sebagai contoh, nampaknya terdapat sedikit perbezaan antara LM yang mengeluarkan kod python untuk menyelesaikan operasi matematik dan LM yang mengeluarkan kod python untuk memanipulasi lengan robot. Beberapa karya yang dibincangkan dalam ulasan ini sudah menggunakan LM yang mempunyai kesan ke atas dunia maya atau fizikal Dalam pandangan ini, kita boleh mengatakan bahawa LM mempunyai potensi untuk bertindak dan mengharapkan kemajuan penting ke arah LM sebagai ejen autonomi. Kaedah pengelasan

Para penyelidik menguraikan kerja yang diperkenalkan dalam semakan ke dalam tiga dimensi di atas dan memperkenalkannya secara berasingan, dan akhirnya membincangkan kerja berkaitan dalam dimensi lain. Bagi pembaca, perlu diingat bahawa banyak teknik ini pada asalnya diperkenalkan dalam konteks selain LM, dan jika perlu, lihat pengenalan kertas yang disebutkan dan kerja berkaitan jika boleh. Akhir sekali, walaupun semakan memfokuskan kepada LLM, tidak semua kerja berkaitan menggunakan model besar, tetapi bertujuan untuk ketepatan LM.

Atas ialah kandungan terperinci Di manakah ChatGPT akan pergi dari sini? Karya baharu LeCun: Kajian menyeluruh tentang 'model bahasa dipertingkat' generasi akan datang. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

Platform Perdagangan Web3 Ranking_Web3 Global Exchanges Top Ten Ringkasan

Apr 21, 2025 am 10:45 AM

Platform Perdagangan Web3 Ranking_Web3 Global Exchanges Top Ten Ringkasan

Apr 21, 2025 am 10:45 AM

Binance adalah tuan rumah ekosistem perdagangan aset digital global, dan ciri -cirinya termasuk: 1. Jumlah dagangan harian purata melebihi $ 150 bilion, menyokong 500 pasangan perdagangan, yang meliputi 98% mata wang arus perdana; 2. Matriks inovasi meliputi pasaran Derivatif, susun atur Web3 dan sistem pendidikan; 3. Kelebihan teknikal adalah enjin yang sepadan dengan milisaat, dengan jumlah pemprosesan puncak sebanyak 1.4 juta transaksi sesaat; 4. Kemajuan pematuhan memegang lesen 15 negara dan menetapkan entiti yang mematuhi di Eropah dan Amerika Syarikat.

Ramalan Harga Worldcoin (WLD) 2025-2031: Adakah WLD akan mencapai $ 4 menjelang 2031?

Apr 21, 2025 pm 02:42 PM

Ramalan Harga Worldcoin (WLD) 2025-2031: Adakah WLD akan mencapai $ 4 menjelang 2031?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD) menonjol dalam pasaran cryptocurrency dengan mekanisme pengesahan biometrik dan perlindungan privasi yang unik, menarik perhatian banyak pelabur. WLD telah melakukan yang luar biasa di kalangan altcoin dengan teknologi inovatifnya, terutamanya dalam kombinasi dengan teknologi kecerdasan buatan terbuka. Tetapi bagaimanakah aset digital akan berkelakuan dalam beberapa tahun akan datang? Mari kita meramalkan harga masa depan WLD bersama -sama. Ramalan harga WLD 2025 dijangka mencapai pertumbuhan yang signifikan di WLD pada tahun 2025. Analisis pasaran menunjukkan bahawa harga WLD purata boleh mencapai $ 1.31, dengan maksimum $ 1.36. Walau bagaimanapun, dalam pasaran beruang, harga mungkin jatuh ke sekitar $ 0.55. Harapan pertumbuhan ini disebabkan terutamanya oleh WorldCoin2.

Kedudukan pertukaran leverage dalam lingkaran mata wang Cadangan terkini sepuluh pertukaran leverage dalam lingkaran mata wang

Apr 21, 2025 pm 11:24 PM

Kedudukan pertukaran leverage dalam lingkaran mata wang Cadangan terkini sepuluh pertukaran leverage dalam lingkaran mata wang

Apr 21, 2025 pm 11:24 PM

Platform yang mempunyai prestasi cemerlang dalam perdagangan, keselamatan dan pengalaman pengguna yang dimanfaatkan pada tahun 2025 adalah: 1. Okx, sesuai untuk peniaga frekuensi tinggi, menyediakan sehingga 100 kali leverage; 2. Binance, sesuai untuk peniaga berbilang mata wang di seluruh dunia, memberikan 125 kali leverage tinggi; 3. Gate.io, sesuai untuk pemain derivatif profesional, menyediakan 100 kali leverage; 4. Bitget, sesuai untuk orang baru dan peniaga sosial, menyediakan sehingga 100 kali leverage; 5. Kraken, sesuai untuk pelabur mantap, menyediakan 5 kali leverage; 6. Bybit, sesuai untuk penjelajah altcoin, menyediakan 20 kali leverage; 7. Kucoin, sesuai untuk peniaga kos rendah, menyediakan 10 kali leverage; 8. Bitfinex, sesuai untuk bermain senior

Apakah yang dimaksudkan dengan transaksi rantaian rantaian? Apakah urus niaga salib?

Apr 21, 2025 pm 11:39 PM

Apakah yang dimaksudkan dengan transaksi rantaian rantaian? Apakah urus niaga salib?

Apr 21, 2025 pm 11:39 PM

Pertukaran yang menyokong urus niaga rantaian: 1. Binance, 2. Uniswap, 3 Sushiswap, 4. Kewangan Curve, 5. Thorchain, 6. 1 inci Pertukaran, 7.

'Black Monday Sell' adalah hari yang sukar untuk industri cryptocurrency

Apr 21, 2025 pm 02:48 PM

'Black Monday Sell' adalah hari yang sukar untuk industri cryptocurrency

Apr 21, 2025 pm 02:48 PM

Jatuh di pasaran cryptocurrency telah menyebabkan panik di kalangan pelabur, dan Dogecoin (Doge) telah menjadi salah satu kawasan terkena paling sukar. Harganya jatuh dengan ketara, dan jumlah nilai kunci kewangan yang terdesentralisasi (DEFI) (TVL) juga menyaksikan penurunan yang ketara. Gelombang jualan "Black Monday" menyapu pasaran cryptocurrency, dan Dogecoin adalah yang pertama dipukul. Defitvlnya jatuh ke tahap 2023, dan harga mata wang jatuh 23.78% pada bulan lalu. Defitvl Dogecoin jatuh ke tahap rendah $ 2.72 juta, terutamanya disebabkan oleh penurunan 26.37% dalam indeks nilai SOSO. Platform defi utama lain, seperti DAO dan Thorchain yang membosankan, TVL juga menurun sebanyak 24.04% dan 20.

Mengapa kenaikan atau kejatuhan harga mata wang maya? Mengapa kenaikan atau kejatuhan harga mata wang maya?

Apr 21, 2025 am 08:57 AM

Mengapa kenaikan atau kejatuhan harga mata wang maya? Mengapa kenaikan atau kejatuhan harga mata wang maya?

Apr 21, 2025 am 08:57 AM

Faktor kenaikan harga mata wang maya termasuk: 1. Peningkatan permintaan pasaran, 2. Menurunkan bekalan, 3. Berita positif yang dirangsang, 4. Sentimen pasaran optimis, 5. Persekitaran makroekonomi; Faktor penurunan termasuk: 1. Mengurangkan permintaan pasaran, 2. Peningkatan bekalan, 3.

Cara Memenangi Ganjaran Airdrop Kernel pada Strategi Proses Penuh Binance

Apr 21, 2025 pm 01:03 PM

Cara Memenangi Ganjaran Airdrop Kernel pada Strategi Proses Penuh Binance

Apr 21, 2025 pm 01:03 PM

Dalam dunia kriptografi yang ramai, peluang baru selalu muncul. Pada masa ini, aktiviti udara Kerneldao (kernel) menarik banyak perhatian dan menarik perhatian banyak pelabur. Jadi, apakah asalnya projek ini? Apakah faedah yang boleh diperoleh oleh pemegang BNB? Jangan risau, perkara berikut akan mendedahkannya satu demi satu untuk anda.

Aavenomics adalah cadangan untuk mengubah suai token protokol AAVE dan memperkenalkan pembelian semula token, yang telah mencapai bilangan kuorum orang.

Apr 21, 2025 pm 06:24 PM

Aavenomics adalah cadangan untuk mengubah suai token protokol AAVE dan memperkenalkan pembelian semula token, yang telah mencapai bilangan kuorum orang.

Apr 21, 2025 pm 06:24 PM

Aavenomics adalah cadangan untuk mengubah token protokol AAVE dan memperkenalkan repos token, yang telah melaksanakan kuorum untuk Aavedao. Marc Zeller, pengasas Rantaian Projek AAVE (ACI), mengumumkan ini pada X, dengan menyatakan bahawa ia menandakan era baru untuk perjanjian itu. Marc Zeller, pengasas Inisiatif Rantaian AAVE (ACI), mengumumkan pada X bahawa cadangan aavenomik termasuk mengubah token protokol AAVE dan memperkenalkan repos token, telah mencapai kuorum untuk Aavedao. Menurut Zeller, ini menandakan era baru untuk perjanjian itu. Ahli -ahli Aavedao mengundi untuk menyokong cadangan itu, yang 100 seminggu pada hari Rabu