Bagaimana untuk mencapai pembelajaran berterusan dan menjadikan AI berterusan?

Baru-baru ini, Christopher Kanan, seorang saintis komputer berusia 41 tahun dari Universiti Rochester, berkata dalam temu bual eksklusif bahawa dia sedang membina algoritma yang membolehkan AI terus belajar dari semasa ke semasa. - sama seperti kita Sama seperti manusia.

Seperti yang kita sedia maklum, AI boleh menyelesaikan "peperiksaan" dengan baik selepas tugas latihan dalam skop, tetapi algoritma ini tidak boleh mengemas kini pangkalan pengetahuan secara berterusan dengan maklumat baharu seperti yang boleh dilakukan oleh manusia.

Untuk mempelajari walaupun satu perkara baharu, algoritma mesti dilatih dari awal, dengan kos melupakan hampir semua yang telah dipelajari sebelum ini. Masalah yang dibawa ini ialah "Pelupaan Malapetaka". Sama seperti apabila anda bertemu rakan baharu, satu-satunya cara anda boleh mengetahui namanya adalah dengan but semula otak anda.

Punca perkara ini berlaku adalah disebabkan oleh cara rangkaian saraf mempelajari perkara baharu. Pembelajaran algoritma ini memerlukan perubahan kekuatan sambungan antara neuron Walau bagaimanapun, ini juga mewakili pengetahuan lepas, jadi menukar sambungan terlalu banyak akan menyebabkan lupa.

Rangkaian saraf biologi telah mengembangkan strategi selama ratusan juta tahun untuk memastikan maklumat penting kekal stabil. Tetapi rangkaian saraf tiruan hari ini bergelut untuk mencapai keseimbangan yang baik antara pengetahuan lama dan baharu. Apabila rangkaian melihat data baharu, sambungan mereka boleh ditimpa dengan mudah, yang boleh menyebabkan ketidakupayaan secara tiba-tiba dan teruk untuk mengecam maklumat masa lalu.

Apa yang diajar oleh falsafah kepada anda ialah, "Bagaimana untuk membuat hujah yang munasabah" dan "Bagaimana untuk menganalisis hujah orang lain?" kita tidak boleh melakukan X, bagaimana kita boleh melakukan Y?

Kami belajar dari semasa ke semasa, tetapi jumlah pengetahuannya tidak tetap. Jadi jika manusia ingin mencipta kecerdasan buatan am pada masa hadapan, ini adalah masalah asas yang mesti diselesaikan.

Nota penyelidikan Kanan

Nota penyelidikan Kanan

2. Apakah kemajuan semasa dalam menyelesaikan pelupaan bencana dalam akademik?

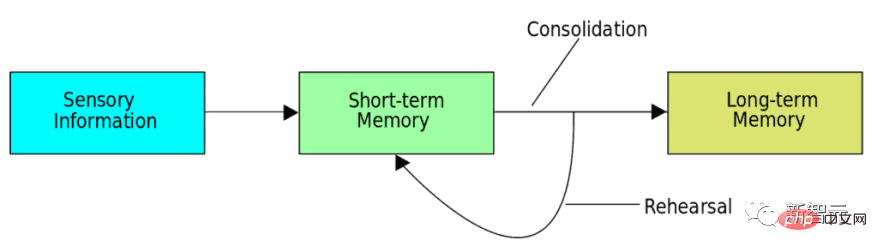

Kaedah yang paling berjaya pada masa ini dipanggil main semula, yang boleh menyimpan pengetahuan lepas dan kemudian memainkannya semula dengan set data baharu semasa proses latihan, supaya maklumat asal tidak akan hilang.

Kaedah ini diilhamkan oleh proses penyatuan memori dalam otak kita Semasa tidur, kandungan pembelajaran sehari dikodkan semula dan dimainkan semula apabila neuron diaktifkan.

Dalam erti kata lain, pembelajaran baharu tidak boleh menghapuskan sepenuhnya pengetahuan lalu algoritma.

Dalam erti kata lain, pembelajaran baharu tidak boleh menghapuskan sepenuhnya pengetahuan lalu algoritma.

Terdapat tiga cara untuk mencapai matlamat ini.

Pendekatan yang paling biasa ialah "main semula sebenar", di mana penyelidik menyimpan subset input asal - contohnya, imej asal yang digunakan untuk tugas pengecaman objek - dan kemudian menggabungkan imej lalu yang disimpan ini dengan mempelajari gabungan imej baharu.3 Jika kita dapat menyelesaikan sepenuhnya pelupaan bencana, adakah itu bermakna AI boleh mempelajari perkara baharu dari semasa ke semasa?

Tidak betul. Saya berpendapat bahawa masalah terbuka dalam bidang pembelajaran berterusan bukanlah pelupaan bencana.

Apa yang saya sangat berminat ialah:Bagaimanakah pembelajaran lepas boleh menjadikan pembelajaran masa hadapan lebih cekap? Bagaimanakah pembelajaran masa depan membetulkan pembelajaran lepas? Ini adalah perkara yang sangat sedikit orang ukur, dan saya fikir berbuat demikian adalah bahagian penting dalam memajukan bidang ini, kerana sebenarnya, ia bukan hanya tentang melupakan sesuatu, ia tentang menjadi pelajar yang lebih baik.

Christopher Kanan berkata:

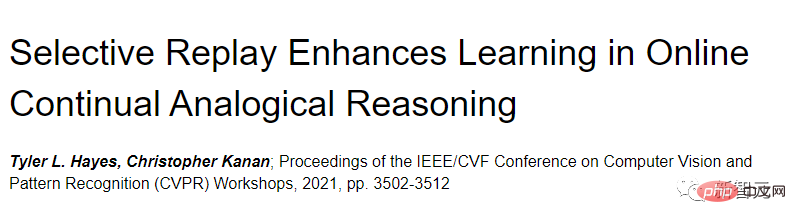

Sudah pasti banyak lagi perkara yang berlaku dalam kepala kita berbanding rangkaian saraf moden. Kita perlu menyediakan persediaan eksperimen dan algoritma yang betul untuk mengukur sama ada pembelajaran lepas membantu pembelajaran masa hadapan. Dan masalah terbesar sekarang ialah kami tidak mempunyai set data yang baik untuk mengkaji pembelajaran berterusan, pada asasnya kami mengambil set data sedia ada yang digunakan dalam pembelajaran mesin tradisional dan membangunkannya dari bawah. Secara umumnya, operasi biasa pembelajaran mesin ialah kami mempunyai set latihan dan set ujian - kami berlatih pada set latihan dan menguji set ujian. Tetapi pembelajaran berterusan melanggar peraturan ini dan membenarkan set latihan berkembang semasa jurulatih belajar, jadi kami memerlukan persekitaran pembelajaran berterusan yang sangat baik. Lebih mudah untuk memberitahu anda apa yang bukan perkara itu daripada apa yang sebenarnya. Saya boleh memberitahu anda sifat yang mungkin ada padanya. Jadi buat masa ini, mari kita anggap bahawa algoritma AI tidak merangkumi kecerdasan dalam simulasi. Dan kemudian sekurang-kurangnya, idealnya, kita belajar daripada video, atau sesuatu seperti itu, seperti strim video berbilang modal, dan mahu melakukan lebih daripada sekadar mengklasifikasikan imej statik. Terdapat banyak soalan terbuka tentang perkara ini. Saya berada di bengkel pembelajaran berterusan beberapa tahun yang lalu, dan beberapa orang seperti saya berkata, "Kita perlu berhenti menggunakan set data yang dipanggil MNIST, ia terlalu mudah dan kemudian seseorang berkata, "Nah, kemudian kita pergi ke StarCraft melakukan pembelajaran tambahan 》 Saya melakukan ini sekarang atas pelbagai sebab, tetapi saya rasa ia tidak cukup untuk benar-benar menyelesaikan masalah. Lagipun, terdapat banyak lagi kehidupan daripada belajar bermain StarCraft. Bekas pelajar saya Tyler Hayes dan saya mempelopori penyelidikan pembelajaran berterusan mengenai penaakulan analogi. Pautan kertas: https://openaccess.thecvf.com/content/CVPR2021W/CLVision/html/Hayes_Selective_Replay_Enhances_Learning_in_Online_Continual_Analogical_Reasoning.> Secara khusus, kami mengukur data mengenai pemindahan ke belakang, iaitu, sejauh mana sesuatu yang dipelajari pada masa lalu akan membantu anda pada masa hadapan, dan begitu juga sebaliknya. Kami menemui bukti pemindahan yang baik, jauh lebih penting daripada tugas mudah seperti pengecaman objek. 6. Adakah anda fikir kecerdasan buatan akan benar-benar belajar seperti manusia? Saya rasa mereka akan melakukannya. Terdapat ramai orang yang sangat berbakat bekerja ke arah matlamat ini dalam bidang ini. Tetapi apa yang kita perlukan ialah kreativiti. Banyak kajian dalam komuniti pembelajaran mesin adalah berdasarkan penyelidikan terdahulu dan membuat beberapa peningkatan kecil, dan tidak banyak kajian yang benar-benar transformatif. Tetapi hari ini pasti akan tiba, ia hanya menunggu masa. Christopher Kanan Christopher Kanan ialah profesor madya sains komputer di Universiti Rochester. Arah kerja utama ialah penyelidikan asas tentang pembelajaran mendalam, termasuk pembelajaran berterusan, berat sebelah dalam kecerdasan buatan, penglihatan komputer perubatan dan pemahaman adegan berpandukan bahasa. Sebelum itu, beliau adalah profesor madya di Pusat Carlson untuk Sains Pengimejan di Institut Teknologi Rochester (RIT). Semasa perkhidmatannya, beliau mengasaskan bersama Pusat Kecerdasan Buatan Sedar Manusia (CHAI) bersama rakan-rakannya dan berkhidmat sebagai timbalan pengarah selama empat tahun. Selain itu, Kanan ialah profesor bersekutu pelawat di Universiti Teknologi Cornell, mengajar kursus pembelajaran mendalam kepada kira-kira 100 pelajar siswazah setiap tahun selama 4 tahun. Pada tahun 1996, dia mula meneroka kecerdasan buatan, yang masih di sekolah menengah, membina banyak "bot" untuk bermain permainan komputer berbilang pemain dalam talian. Pada tahun 2002, Kanan telah diterima masuk ke Universiti Negeri Oklahoma (OSU), dalam jurusan falsafah dan sains komputer, dan menerima ijazah sarjana mudanya pada tahun 2004. Pada tahun 2006, beliau menerima ijazah sarjana dalam sains komputer dari University of Southern California (USC), memfokuskan pada kecerdasan buatan dan neurosains, dan bekerja dengan Michael Arbib, perintis dalam neurosains pengiraan dan rangkaian saraf. Pada 2013, beliau menerima PhD dalam sains komputer dari University of California, San Diego (UCSD). Selepas tamat pengajian, Kanan pergi ke Institut Teknologi California untuk melibatkan diri dalam penyelidikan pasca doktoral. Rujukan: https://www.quantamagazine.org/the-computer-scientist-trying-to-teach-ai-to-learn-like-we-do -20220802/4. Apakah rupa persekitaran pembelajaran berterusan yang ideal?

5. Bagaimanakah makmal anda cuba mereka bentuk algoritma yang belajar dari semasa ke semasa?

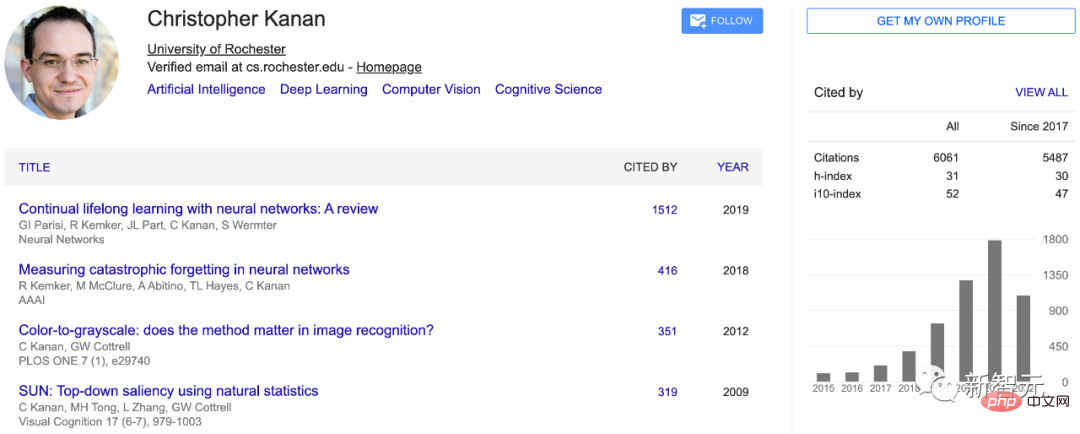

Kanan telah bekerja dalam pembelajaran berterusan dalam talian, menjawab soalan visual, patologi pengiraan, segmentasi semantik, pengecaman objek, pengesanan objek, penglihatan aktif, pengesanan objek, dsb. Selain pembelajaran mesin, beliau mempunyai latar belakang yang kukuh dalam pengesanan mata, penglihatan primata, dan neurosains teori.

Kanan telah bekerja dalam pembelajaran berterusan dalam talian, menjawab soalan visual, patologi pengiraan, segmentasi semantik, pengecaman objek, pengesanan objek, penglihatan aktif, pengesanan objek, dsb. Selain pembelajaran mesin, beliau mempunyai latar belakang yang kukuh dalam pengesanan mata, penglihatan primata, dan neurosains teori.  Christopher Kanan dibesarkan di sebuah bandar kecil di luar bandar Oklahoma.

Christopher Kanan dibesarkan di sebuah bandar kecil di luar bandar Oklahoma.

Atas ialah kandungan terperinci Adakah AI juga mengalami amnesia? Temu bual eksklusif dengan seorang profesor British berusia 41 tahun: Menyelesaikan pelupaan bencana. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Algoritma penggantian halaman

Algoritma penggantian halaman

Pelayan tidak boleh ditemui pada penyelesaian komputer

Pelayan tidak boleh ditemui pada penyelesaian komputer

penggunaan bytafon

penggunaan bytafon

pangkalan data oracle menjalankan kaedah sql

pangkalan data oracle menjalankan kaedah sql

Cara menggunakan fungsi penapis

Cara menggunakan fungsi penapis

Bagaimana untuk menyelesaikan masalah bahawa folder tidak mempunyai pilihan keselamatan

Bagaimana untuk menyelesaikan masalah bahawa folder tidak mempunyai pilihan keselamatan

Pengenalan kepada alat perangkak

Pengenalan kepada alat perangkak

Bagaimana untuk menutup but selamat

Bagaimana untuk menutup but selamat