2022 akan berakhir. Pada tahun ini, sebilangan besar kertas berharga muncul dalam bidang pembelajaran mesin, yang memberi kesan mendalam kepada komuniti pembelajaran mesin.

Hari ini, penyelidik ML & NLP, pengurus pemasaran produk teknologi Meta AI dan pengasas DAIR.AI Elvis S. meringkaskan 12 kertas kerja pembelajaran mesin panas pada tahun 2022 . Siaran itu menjadi tular dan telah ditweet semula oleh pemenang Anugerah Turing Yann LeCun.

Seterusnya, mari kita lihat satu persatu.

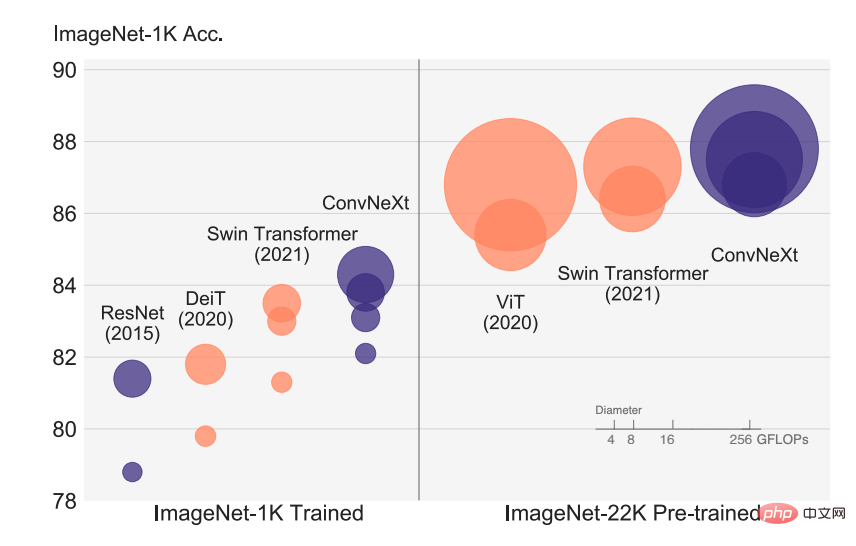

Kertas 1: ConvNet untuk 2020-an

Perkembangan pesat pengecaman visual bermula dengan pengenalan ViT, yang dengan cepat menggantikan tradisional ConvNet , menjadi model pengelasan imej SOTA. Model ViT mempunyai banyak cabaran dalam satu siri tugas penglihatan komputer termasuk pengesanan sasaran, pembahagian semantik, dsb. Oleh itu, sesetengah penyelidik mencadangkan Transformer Swin hierarki dan memperkenalkan semula ConvNet sebelum ini, menjadikan Transformer sebenarnya boleh dilaksanakan sebagai tulang belakang visual umum dan menunjukkan prestasi cemerlang pada pelbagai tugas visual.

Walau bagaimanapun, keberkesanan pendekatan hibrid ini sebahagian besarnya masih disebabkan oleh kelebihan sedia ada Transformer dan bukannya bias induktif yang wujud dalam konvolusi. Dalam artikel ini, penyelidik dari FAIR dan UC Berkeley meneliti semula ruang reka bentuk dan menguji had perkara yang boleh dicapai oleh ConvNet tulen. Penyelidik secara beransur-ansur "menaik taraf" ResNet standard kepada reka bentuk Transformer visual, dan dalam proses itu menemui beberapa komponen utama yang menyebabkan perbezaan prestasi.

Alamat kertas: https://arxiv.org/abs/2201.03545v2

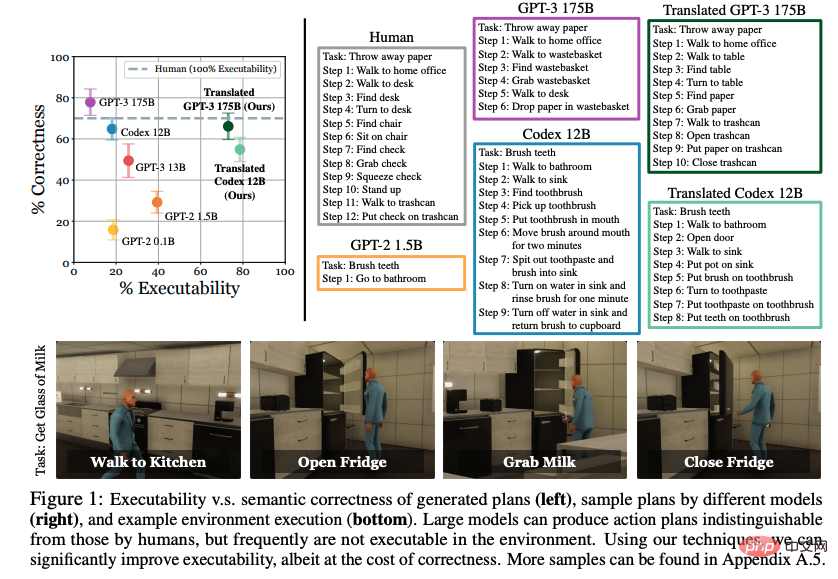

Kertas 2: Model Bahasa sebagai Perancang Zero-Shot: Mengekstrak Pengetahuan Boleh Ditindaklanjuti untuk Ejen Terwujud

Pengetahuan dunia yang dipelajari melalui model bahasa besar (LLM) Boleh ia digunakan untuk tindakan dalam persekitaran interaktif? Dalam makalah ini, penyelidik di UC Berkeley, CMU dan Google meneroka kemungkinan menyatakan bahasa semula jadi sebagai satu set langkah yang boleh diambil tindakan. Kerja sebelumnya tertumpu pada pembelajaran cara bertindak daripada contoh yang diedarkan secara eksplisit, tetapi secara mengejutkan mereka mendapati bahawa jika model bahasa pralatihan cukup besar dan diberi petunjuk yang sesuai, tugas peringkat tinggi boleh diuraikan dengan berkesan kepada perancangan peringkat pertengahan tanpa latihan lanjut. Walau bagaimanapun, rancangan yang dibangunkan oleh LLM selalunya tidak memetakan dengan tepat kepada tindakan yang boleh diterima.

Langkah-langkah yang dicadangkan oleh penyelidik menetapkan demonstrasi sedia ada dan secara semantik mengubah rancangan menjadi tindakan yang boleh diterima. Penilaian dalam persekitaran VirtualHome menunjukkan bahawa pendekatan cadangan mereka meningkatkan kebolehlaksanaan garis dasar LLM dengan ketara. Penilaian manusia mendedahkan pertukaran antara kebolehkuatkuasaan dan ketepatan, tetapi menunjukkan tanda-tanda kemungkinan mengekstrak pengetahuan yang boleh diambil tindakan daripada model bahasa.

Alamat kertas: https://arxiv.org/abs/2201.07207v2

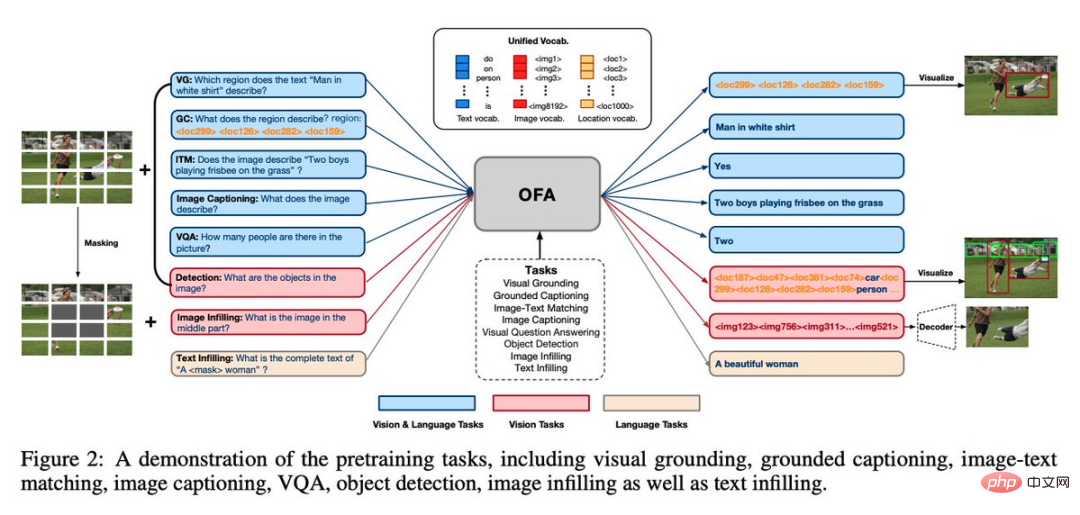

Kertas 3: OFA: Menyatukan Seni Bina, Tugas dan Modaliti Melalui Rangka Kerja Pembelajaran Urutan-ke-Jujukan yang Mudah

Inilah Akademi Alibaba Damo The melancarkan rangka kerja model pelbagai tugas pelbagai mod bersatu OFA meringkaskan tiga ciri yang paling sesuai dengan model umum pada peringkat ini, iaitu kebebasan modaliti, kebebasan tugas dan kepelbagaian tugas. Kertas kerja ini telah diterima oleh ICML 2022.

Dalam bidang grafik dan teks, OFA mewakili tugas klasik seperti pembumian visual, VQA, kapsyen imej, klasifikasi imej, penjanaan teks2imej dan pemodelan bahasa melalui rangka kerja dan perkongsian seq2seq bersatu mereka antara tugas Input dan output mod yang berbeza, dan menjadikan Finetune dan pra-latihan konsisten, tanpa menambah struktur parameter tambahan.

Alamat kertas: https://arxiv.org/abs/2202.03052v2

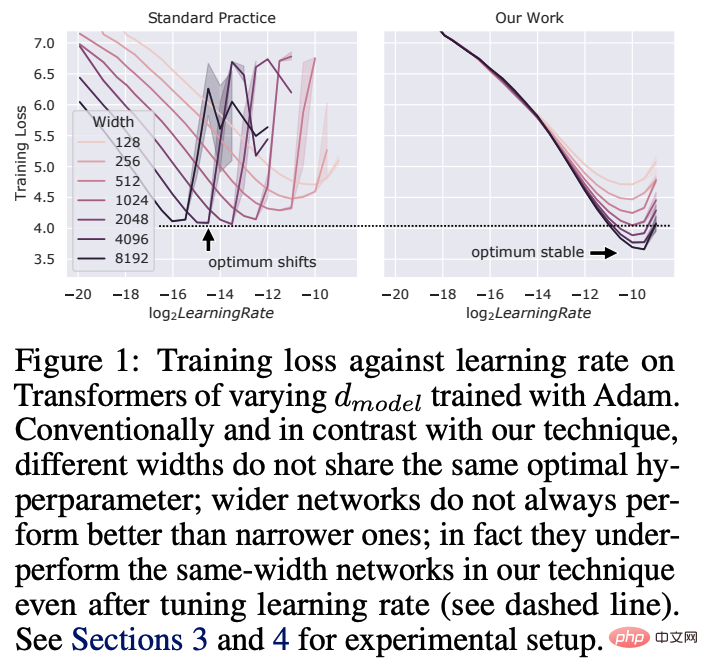

Kertas 4: Tensor Programs V: Tuning Rangkaian Neural Besar melalui Pemindahan Hiperparameter Tangkapan Sifar

Penalaan Hiperparameter (HP) dalam pembelajaran mendalam adalah proses yang mahal, untuk rangkaian saraf dengan berbilion-bilion parameter Ini terutama berlaku untuk Internet. Dalam makalah ini, penyelidik dari Microsoft dan OpenAI menunjukkan bahawa dalam Parametrisasi Kemas Kini Maksimum (muP) yang ditemui baru-baru ini, banyak HP optimum kekal stabil walaupun saiz model berubah.

Ini membawa kepada paradigma penalaan HP baharu yang mereka panggil muTransfer, yang meparameterkan model sasaran dalam muP dan tidak melakukan penalaan HP secara langsung pada model yang lebih kecil dan memindahkannya ke skala penuh model dengan sampel sifar, yang juga bermakna model yang terakhir tidak perlu ditala secara langsung sama sekali. Penyelidik mengesahkan muTransfer pada Transformer dan ResNet. Sebagai contoh, dengan berhijrah daripada model parameter 40M, prestasi adalah lebih baik daripada model 6.7B GPT-3 yang diterbitkan pada kos penalaan hanya 7% daripada jumlah kos pra-latihan.

Alamat kertas: https://arxiv.org/abs/2203.03466v2

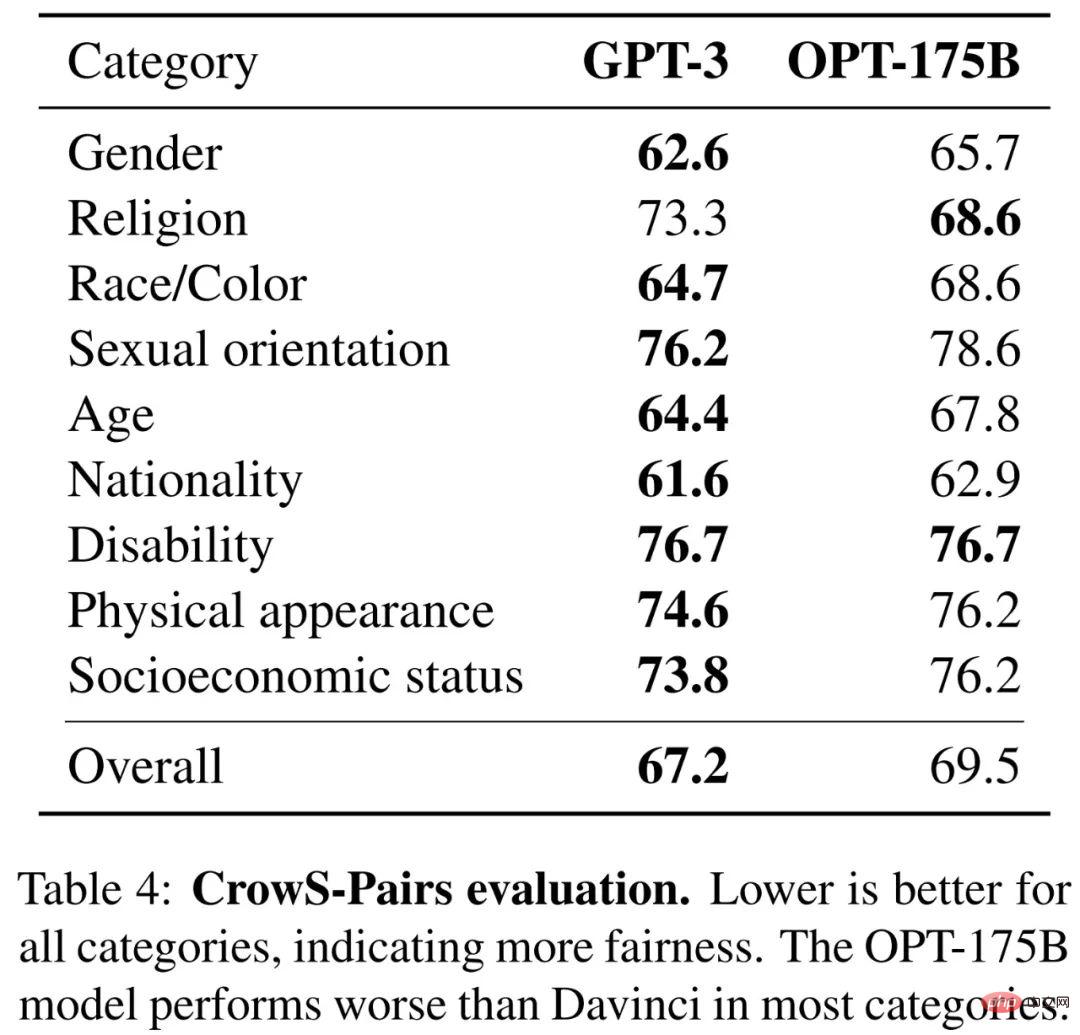

Kertas 5: OPT: Model Bahasa Transformer Terbuka Pra-latihan

Model besar sering dilatih selama berpuluh-puluh ribu hari pengkomputeran keupayaan luar biasa dalam pembelajaran sampel dan beberapa pukulan. Tetapi memandangkan kos pengiraan mereka, model besar ini sukar untuk ditiru tanpa pembiayaan yang mencukupi. Untuk beberapa model yang tersedia melalui API, tiada akses kepada berat model lengkap mereka, menjadikannya sukar untuk dipelajari.

Dalam artikel ini, penyelidik Meta AI mencadangkan Open Pre-trained Transformers (OPT), iaitu satu set model transformer pra-latihan hanya untuk penyahkod, dengan parameter antara 125M hingga 175B berbeza-beza. Mereka menunjukkan bahawa OPT-175B berprestasi setanding dengan GPT-3 tetapi hanya memerlukan 1/7 jejak karbon untuk berkembang.

Alamat kertas: https://arxiv.org/abs/2205.01068v4

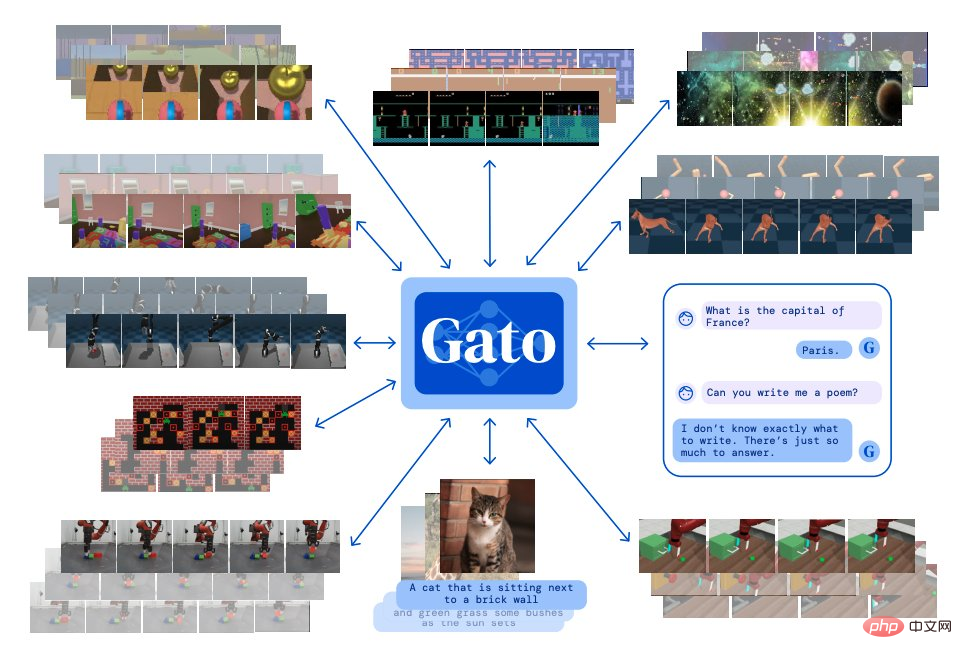

Kertas 6: Ejen Generalis

Diinspirasikan oleh pemodelan bahasa berskala besar, Deepmind membina satu ejen "generalis" Gato, Ia mempunyai pelbagai ciri-ciri modal, pelbagai tugas dan pelbagai penjelmaan.

Gato boleh bermain permainan Atari, mengeluarkan sari kata untuk gambar, bersembang dengan orang lain, menyusun blok dengan lengan robotik dan banyak lagi. Selain itu, Gato boleh memutuskan sama ada untuk mengeluarkan teks, tork bersama, menekan butang atau token lain berdasarkan konteks.

Tidak seperti kebanyakan ejen yang bermain permainan, Gato boleh bermain banyak permainan menggunakan model latihan yang sama tanpa perlu berlatih untuk setiap permainan secara individu.

Alamat kertas: https://arxiv.org/abs/2205.06175v3

Kertas 7: Menyelesaikan Masalah Penaakulan Kuantitatif dengan Model Bahasa

Penyelidik dari Google mencadangkan model bahasa pembelajaran mendalam yang dipanggil Minerva masalah matematik kuantitatif melalui penaakulan langkah demi langkah. Penyelesaiannya termasuk pengiraan berangka dan manipulasi simbolik tanpa bergantung pada alat luaran seperti kalkulator.

Selain itu, Minerva menggabungkan beberapa teknik termasuk gesaan sampel kecil, rantaian pemikiran, gesaan pad awal dan undian majoriti untuk mencapai prestasi SOTA pada tugasan penaakulan STEM.

Minerva dibina berdasarkan PaLM (Pathways Language Model) dan dilatih lebih lanjut mengenai set data 118GB Set data berasal daripada kertas saintifik dan teknologi di arXiv dan termasuk penggunaan LaTeX dan MathJax Atau ungkapan matematik lain data halaman web untuk latihan lanjut.

Gambar di bawah menunjukkan contoh cara Minerva menyelesaikan masalah:

Kertas alamat: https: //arxiv.org/abs/2206.14858

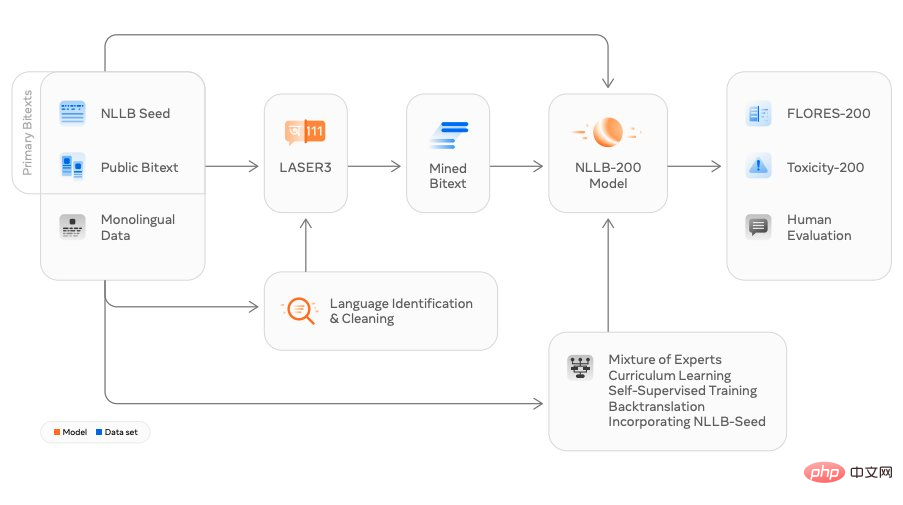

Kertas 8: Tiada Bahasa Tertinggal: Menskala Terjemahan Mesin Berpusatkan Manusia

Penyelidik dari Meta AI mengeluarkan model terjemahan NLLB (Tiada Bahasa Tertinggal), yang secara literal diterjemahkan kepada "Tiada bahasa yang boleh ditinggalkan". Bahasa Cina, Inggeris dan Perancis Selain terjemahan bahasa yang biasa digunakan seperti penggunaan harian, NLLB juga boleh menterjemah banyak bahasa khusus termasuk Luganda, Urdu, dll.

Meta mendakwa bahawa ini adalah reka bentuk pertama di dunia yang menggunakan satu model untuk menterjemah ke dalam berbilang bahasa. Mereka berharap ini akan membantu lebih ramai orang berinteraksi merentas bahasa di platform sosial pada masa yang sama, ia meningkatkan pengalaman interaktif pengguna dalam metaverse masa hadapan.

Alamat kertas: https://arxiv.org/abs/2207.04672v3

Kertas 9: Sintesis Imej Resolusi Tinggi dengan Model Resapan Terpendam

Resapan Stabil telah menjadi popular sejak kebelakangan ini, memfokuskan pada teknologi ini Di sana adalah kajian yang tidak terkira banyaknya.

Penyelidikan ini berdasarkan kertas kerja CVPR 2022 "Sintesis Imej Resolusi Tinggi dengan Model Resapan Terpendam" oleh penyelidik dari Universiti Munich dan Runway, dan bekerjasama dengan pasukan seperti Eleuther AI dan LAION Selesai. Stable Diffusion boleh dijalankan pada GPU gred pengguna dengan 10 GB VRAM dan menjana imej 512x512 piksel dalam beberapa saat tanpa pra dan pasca pemprosesan.

Hanya dalam tempoh empat bulan, projek sumber terbuka ini telah menerima 38K bintang.

Alamat projek: https://github.com/CompVis/stable-diffusion

Paparan contoh imej yang dihasilkan oleh Resapan Stabil:

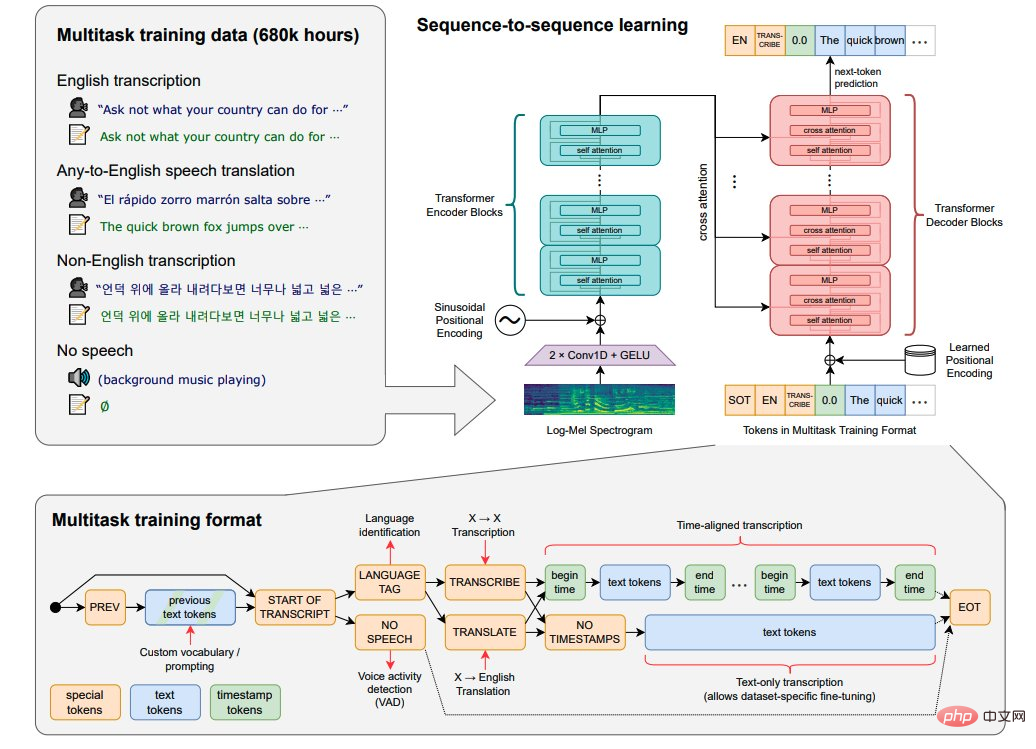

Kertas 10: Pengecaman Pertuturan Teguh melalui Pengawasan Lemah Skala Besar

OpenAI mengeluarkan model sumber terbuka Whisper, yang hampir dengan tahap manusia dalam pengecaman pertuturan bahasa Inggeris dan mempunyai ketepatan yang tinggi.

Whisper ialah sistem pengecaman pertuturan automatik (ASR, Automatic Speech Recognition) OpenAI mengumpul 680,000 jam 98 bahasa dan data pengawasan berbilang tugas daripada Internet. Sebagai tambahan kepada pengecaman pertuturan, Whisper juga boleh menyalin berbilang bahasa dan menterjemahkan bahasa tersebut ke dalam bahasa Inggeris.

Alamat kertas: https://arxiv.org/abs/2212.04356

Kertas 11: Buat-Video: Penjanaan Teks-ke-Video tanpa Data Teks-Video

Penyelidik dari Meta AI mencadangkan model teks-ke-video terkini: Make-A- Video, Video boleh dihasilkan daripada gesaan teks yang diberikan.

Make-A-Video mempunyai tiga kelebihan: (1) Ia mempercepatkan latihan model T2V (Text-to-Video) dan tidak memerlukan pembelajaran perwakilan visual dan pelbagai mod daripada scratch , (2) ia tidak memerlukan data teks-video berpasangan, (3) video yang dihasilkan mewarisi beberapa kelebihan model penjanaan imej hari ini.

Teknologi ini direka bentuk untuk membolehkan penjanaan teks ke video, menghasilkan video unik menggunakan hanya beberapa perkataan atau baris teks. Gambar di bawah menunjukkan seekor anjing memakai pakaian adiwira dan berkopiah merah, terbang di langit:

Alamat kertas: https:// arxiv.org/abs/2209.14792

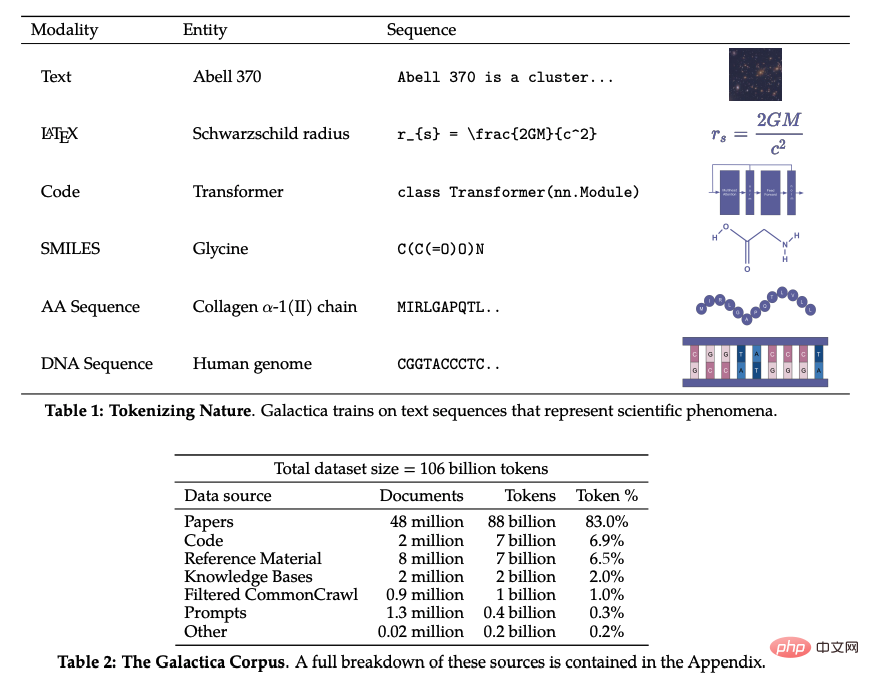

Kertas 12: Galactica: Model Bahasa Besar untuk Sains

Dalam beberapa tahun kebelakangan ini, dengan kemajuan penyelidikan dalam pelbagai bidang subjek, kesusasteraan saintifik dan data telah meletup, menjadikannya semakin sukar bagi penyelidik akademik untuk menemui cerapan berguna daripada sejumlah besar maklumat. Biasanya, orang menggunakan enjin carian untuk mendapatkan pengetahuan saintifik, tetapi enjin carian tidak dapat mengatur pengetahuan saintifik secara autonomi.

Baru-baru ini, pasukan penyelidik di Meta AI mencadangkan Galactica, model bahasa berskala besar baharu yang boleh menyimpan, menggabungkan dan menaakul tentang pengetahuan saintifik. Galactica boleh meringkaskan kertas ulasan, menjana pertanyaan ensiklopedia entri, dan memberikan jawapan yang berpengetahuan kepada soalan.

Alamat kertas: https://arxiv.org/abs/2211.09085

Atas ialah kandungan terperinci Penyelidikan ML keluar dari kalangan pada 2022: Stable Diffusion yang popular, ejen generalis Gato, LeCun tweet semula. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Apakah maksud sistem pengendalian DOS?

Apakah maksud sistem pengendalian DOS?

Bagaimana untuk menutup selepas menjalankan arahan nohup

Bagaimana untuk menutup selepas menjalankan arahan nohup

Apakah perbezaan antara lulus dengan nilai dan lulus dengan rujukan dalam java

Apakah perbezaan antara lulus dengan nilai dan lulus dengan rujukan dalam java

Penyelesaian kepada aksara bercelaru semasa membuka excel

Penyelesaian kepada aksara bercelaru semasa membuka excel

Ensiklopedia ChatGPT percuma domestik

Ensiklopedia ChatGPT percuma domestik

Bagaimana untuk memuat naik html

Bagaimana untuk memuat naik html

Bagaimana untuk menyambung php ke pangkalan data mssql

Bagaimana untuk menyambung php ke pangkalan data mssql

Mengapakah vue.js melaporkan ralat?

Mengapakah vue.js melaporkan ralat?

Terdapat beberapa jenis tatasusunan php

Terdapat beberapa jenis tatasusunan php