Peranti teknologi

Peranti teknologi

AI

AI

Penyelidik OpenAI: Cara melaksanakan pembelajaran diselia apabila data tidak mencukupi

Penyelidik OpenAI: Cara melaksanakan pembelajaran diselia apabila data tidak mencukupi

Penyelidik OpenAI: Cara melaksanakan pembelajaran diselia apabila data tidak mencukupi

Artikel ini diterbitkan semula daripada Lei Feng.com Jika anda perlu mencetak semula, sila pergi ke tapak web rasmi Lei Feng.com untuk memohon kebenaran.

Dalam aplikasi sebenar, data mudah diperoleh, tetapi data berlabel jarang berlaku.

Secara umumnya, apabila tugas pembelajaran yang diselia menghadapi masalah data label yang tidak mencukupi, empat penyelesaian berikut boleh dipertimbangkan:

1. Latihan Awal + penalaan halus: mula-mula pralatih model tugas-agnostik yang berkuasa pada korpus data tanpa pengawasan berskala besar (mis. pra-latihan model bahasa pada teks percuma melalui pembelajaran diselia sendiri atau model penglihatan pada imej tidak berlabel pra -latihan) dan kemudian memperhalusi model pada tugas hiliran menggunakan set kecil sampel berlabel.

2. Pembelajaran separa penyeliaan: Belajar daripada sampel berlabel dan tidak berlabel secara serentak Penyelidik telah menggunakan kaedah ini untuk menjalankan banyak penyelidikan tentang tugasan visual.

3. Pembelajaran aktif: Kos pelabelan adalah tinggi Walaupun bajet kos terhad, kami masih berharap untuk mengumpul data label sebanyak mungkin. Pembelajaran aktif belajar memilih sampel tidak berlabel yang paling berharga dan mengumpul data sedemikian dalam proses pengumpulan seterusnya, membantu model mencapai kesan yang diingini sebanyak mungkin di bawah bajet yang terhad.

4. Pra-latihan + penjanaan set data automatik: Memandangkan model pra-latihan yang berkuasa, model ini boleh digunakan untuk menjana lebih banyak sampel berlabel secara automatik. Didorong oleh kejayaan pembelajaran beberapa pukulan, kaedah ini amat popular dalam domain bahasa.

Artikel ini secara menyeluruh memperkenalkan kaedah pembelajaran separa penyeliaan Penulis ialah penyelidik OpenAI Lilian Weng Alamat blog: https://lilianweng.github.io/

1 Apakah pembelajaran separa penyeliaan?

Pembelajaran separa penyeliaan menggunakan kedua-dua data berlabel dan tidak berlabel untuk melatih model. Menariknya, kebanyakan literatur sedia ada mengenai pembelajaran separa penyeliaan memfokuskan kepada tugas penglihatan. Kaedah pra-latihan + penalaan halus ialah paradigma yang lebih biasa dalam tugas bahasa. Kerugian semua kaedah yang disebut dalam artikel ini terdiri daripada dua bahagian:  . Kehilangan pengawasan

. Kehilangan pengawasan  sangat mudah dikira apabila semua sampel dilabelkan sebagai sampel. Kita perlu memberi tumpuan kepada cara mereka bentuk kerugian tanpa pengawasan

sangat mudah dikira apabila semua sampel dilabelkan sebagai sampel. Kita perlu memberi tumpuan kepada cara mereka bentuk kerugian tanpa pengawasan  . Istilah berwajaran

. Istilah berwajaran  biasanya dipilih untuk menggunakan fungsi cerun, dengan t ialah bilangan langkah latihan Apabila bilangan masa latihan meningkat, perkadaran

biasanya dipilih untuk menggunakan fungsi cerun, dengan t ialah bilangan langkah latihan Apabila bilangan masa latihan meningkat, perkadaran  meningkat. Penafian: Artikel ini tidak merangkumi semua kaedah separa seliaan, tetapi hanya menumpukan pada penalaan seni bina model. Untuk mendapatkan maklumat tentang cara menggunakan model generatif dan kaedah berasaskan graf dalam pembelajaran separa penyeliaan, anda boleh merujuk kepada kertas kerja "Tinjauan Keseluruhan Pembelajaran Separuh Penyeliaan Dalam".

meningkat. Penafian: Artikel ini tidak merangkumi semua kaedah separa seliaan, tetapi hanya menumpukan pada penalaan seni bina model. Untuk mendapatkan maklumat tentang cara menggunakan model generatif dan kaedah berasaskan graf dalam pembelajaran separa penyeliaan, anda boleh merujuk kepada kertas kerja "Tinjauan Keseluruhan Pembelajaran Separuh Penyeliaan Dalam".

2 Jadual penerangan simbol

Simbol |

Maksud |

|

Bilangan tag unik. |

|

set data label, di mana |

|

Seluruh set data, termasuk Sampel berlabel dan sampel tidak berlabel. |

|

boleh mewakili sampel tidak berlabel atau sampel berlabel. |

|

Sampel Label Tiada Dipertingkatkan atau label sampel. |

|

sampel ke-i. |

|

masing-masing mewakili kerugian, penyeliaan Kehilangan, kehilangan tanpa pengawasan |

|

The berat kehilangan tanpa pengawasan bertambah apabila bilangan langkah latihan meningkat. |

|

Diberi input , bersyarat kebarangkalian melabel set data. |

|

dijana menggunakan berwajaran θ Neural rangkaian adalah model yang dijangka akan dilatih. |

|

Output fungsi logik f vektor nilai. |

|

Label Ramalan pengedaran. |

|

Fungsi jarak antara dua taburan, seperti ralat min kuasa dua, entropi silang, perbezaan KL, dsb. |

|

Hiperparameter wajaran purata bergerak untuk berat model Guru. |

|

α ialah nilai sampel campuran Pekali, |

| Metajamkan suhu taburan yang diramalkan. |

|

Pilih ambang keyakinan untuk keputusan ramalan yang layak. |

3 Andaian

Dalam literatur penyelidikan sedia ada, andaian berikut dibincangkan untuk menyokong keputusan reka bentuk tertentu dalam kaedah pembelajaran separa penyeliaan.

Andaian 1: Andaian Kelancaran Kawasan kepadatan adalah hampir, labelnya hendaklah sama atau hampir sama.

Andaian 2: Andaian Kluster

Ruang ciri mempunyai kedua-dua kawasan padat dan jarang . Titik data berkumpulan padat secara semula jadi membentuk kelompok. Sampel dalam kelompok yang sama harus mempunyai label yang sama. Ini adalah lanjutan kecil Andaian 1.

Andaian 3: Andaian Pemisahan Ketumpatan Rendah

Sempadan keputusan antara kelas Selalunya terletak di kawasan berketumpatan rendah yang jarang , kerana jika tidak, sempadan keputusan akan membahagikan kelompok berketumpatan tinggi kepada dua kelas yang sepadan dengan dua kelompok masing-masing, yang akan membatalkan kedua-dua Andaian 1 dan 2.

Andaian 4: Andaian Manifold

Data berdimensi tinggi cenderung terletak pada manifold berdimensi rendah . Walaupun data dunia sebenar boleh diperhatikan pada dimensi yang sangat tinggi (cth., imej objek/adegan dunia sebenar), ia sebenarnya boleh ditangkap oleh manifold berdimensi lebih rendah Ia menangkap sifat tertentu data dan mengumpulkan beberapa titik data yang serupa (contohnya, imej objek/adegan dunia sebenar tidak diperoleh daripada pengedaran seragam semua gabungan piksel). Ini membolehkan model mempelajari kaedah perwakilan yang lebih cekap untuk menemui dan menilai persamaan antara titik data tidak berlabel. Ini juga merupakan asas pembelajaran perwakilan. Untuk penjelasan yang lebih terperinci tentang andaian ini, sila rujuk artikel "Cara Memahami Andaian Popular dalam Pembelajaran Separa Penyeliaan".

Pautan: https://stats.stackexchange.com/questions/66939/what-is-the-manifold-assumption-in-semi-supervised-learning

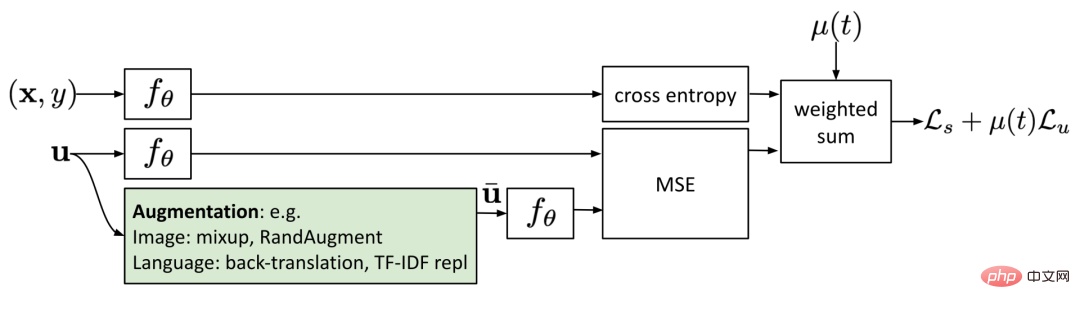

4 Penyelarasan Ketekalan Penyaturan ketekalan, juga dipanggil latihan ketekalan, menganggap bahawa diberi input yang sama, rawak dalam sifat rangkaian saraf (seperti menggunakan algoritma Tercicir ) atau transformasi penambahan data tidak mengubah ramalan model. Setiap kaedah dalam bahagian ini mempunyai kehilangan regularisasi konsisten:

. Beberapa kaedah pembelajaran yang diselia sendiri seperti SimCLR, BYOL, dan SimCSE telah menerima pakai idea ini. Versi dipertingkat yang berbeza bagi sampel yang sama menghasilkan perwakilan yang sama. Motivasi penyelidikan untuk latihan pandangan silang dalam pemodelan bahasa dan pembelajaran pelbagai pandangan dalam pembelajaran penyeliaan kendiri adalah sama.(1).Π model

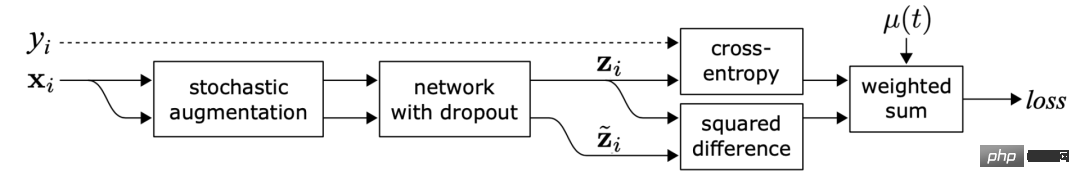

Rajah 1: Gambaran keseluruhan Π-model . Input yang sama terganggu dengan peningkatan rawak yang berbeza dan topeng keciciran untuk menghasilkan dua versi, dan dua output diperoleh melalui rangkaian Model Π meramalkan bahawa kedua-dua output adalah konsisten. (Sumber imej: Kertas kerja Laine dan Aila 2017 "Sequential Integration of Semi-supervised Learning")

Rajah 1: Gambaran keseluruhan Π-model . Input yang sama terganggu dengan peningkatan rawak yang berbeza dan topeng keciciran untuk menghasilkan dua versi, dan dua output diperoleh melalui rangkaian Model Π meramalkan bahawa kedua-dua output adalah konsisten. (Sumber imej: Kertas kerja Laine dan Aila 2017 "Sequential Integration of Semi-supervised Learning")

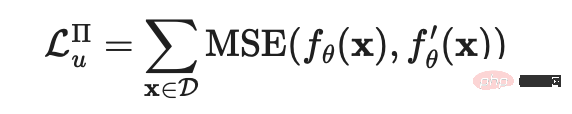

Dalam kertas kerja "Regularization With Stochastic Transformations and Perturbations for Deep Semi-Supervised Learning" yang diterbitkan pada 2016, Sajjadi et al mencadangkan kehilangan Pembelajaran tanpa pengawasan, yang boleh menjana dua versi titik data yang sama melalui transformasi rawak (seperti keciciran, pengumpulan maksimum rawak), dan meminimumkan perbezaan antara kedua-dua hasil keluaran selepas melalui rangkaian. Kehilangan ini boleh digunakan pada set data tidak berlabel kerana labelnya tidak digunakan secara eksplisit. Laine dan Aila kemudiannya memberikan kaedah pemprosesan ini nama dalam kertas "Temporal Ensembling for Semi-Supervised Learning" yang diterbitkan pada 2017, yang dipanggil model Π.  Antaranya,

Antaranya,  merujuk kepada nilai peningkatan rawak yang berbeza atau topeng keciciran yang digunakan pada rangkaian saraf yang sama. Kehilangan ini menggunakan keseluruhan set data.

merujuk kepada nilai peningkatan rawak yang berbeza atau topeng keciciran yang digunakan pada rangkaian saraf yang sama. Kehilangan ini menggunakan keseluruhan set data.

(2) Penyepaduan masa (Ensemble temporal)

Rajah 2: Penyepaduan masa Gambaran keseluruhan. Matlamat pembelajarannya adalah untuk membuat ramalan label pada purata bergerak eksponen (EMA) bagi setiap sampel. (Sumber imej: Kertas kerja Laine dan Aila 2017 "Sequential Integration of Semi-supervised Learning")

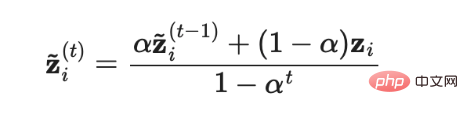

ModelΠ memerlukan setiap sampel melalui rangkaian saraf dua kali, yang menggandakan kos pengiraan. Untuk mengurangkan kos, model ensemble temporal secara berterusan mengambil purata bergerak eksponen (EMA) bagi ramalan model masa nyata untuk setiap sampel latihan  sebagai sasaran pembelajaran, dan EMA hanya perlu dikira dan dikemas kini sekali dalam setiap lelaran. Memandangkan output model integrasi temporal

sebagai sasaran pembelajaran, dan EMA hanya perlu dikira dan dikemas kini sekali dalam setiap lelaran. Memandangkan output model integrasi temporal  dimulakan kepada 0, ia dibahagikan dengan

dimulakan kepada 0, ia dibahagikan dengan  untuk penormalan untuk membetulkan bias permulaan ini. Pengoptimum Adam juga mempunyai istilah pembetulan berat sebelah atas sebab yang sama.

untuk penormalan untuk membetulkan bias permulaan ini. Pengoptimum Adam juga mempunyai istilah pembetulan berat sebelah atas sebab yang sama.  di mana

di mana  ialah ramalan ensemble dalam lelaran ke-t, dan

ialah ramalan ensemble dalam lelaran ke-t, dan  ialah ramalan model dalam pusingan semasa. Perlu diingat bahawa sejak

ialah ramalan model dalam pusingan semasa. Perlu diingat bahawa sejak  =0, selepas pembetulan pincang,

=0, selepas pembetulan pincang,  betul-betul sama dengan nilai ramalan model

betul-betul sama dengan nilai ramalan model  dalam lelaran pertama.

dalam lelaran pertama.

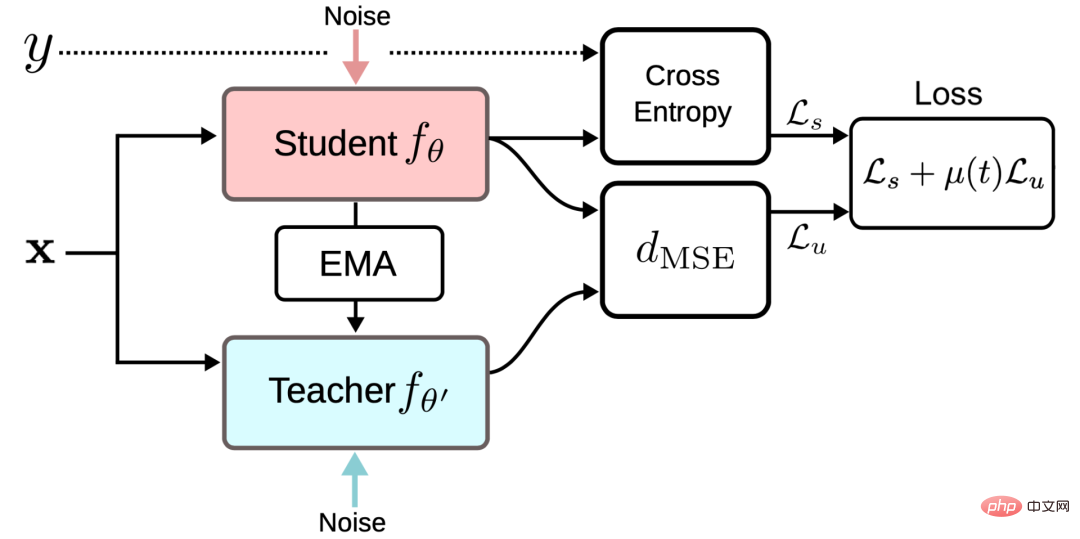

(3) Min guru

Rajah 3: Min Gambaran Kerangka Kerja Guru (Imej sumber: Kertas kerja Tarvaninen dan Valpola 2017 "Model Guru Min ialah Model Contoh Berprestasi Lebih Baik: Pengoptimuman Objektif Ketekalan Purata Wajaran" Hasil Pembelajaran Dalam Separuh Penyeliaan")

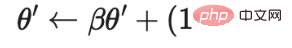

Temporal model ensemble menjejaki purata bergerak eksponen ramalan label untuk setiap sampel latihan sebagai objektif pembelajaran. Walau bagaimanapun, ramalan label ini hanya berubah dalam setiap lelaran, yang menjadikan pendekatan ini menyusahkan apabila set data latihan adalah besar. Untuk mengatasi masalah kelajuan kemas kini sasaran yang perlahan, Tarvaninen dan Valpola menerbitkan kertas kerja "Guru min adalah model peranan yang lebih baik: Pengoptimuman sasaran konsistensi purata berwajaran hasil pembelajaran mendalam separa diselia" pada 2017 (Min guru adalah model peranan yang lebih baik: Berat- sasaran ketekalan purata meningkatkan hasil pembelajaran mendalam separa diselia), algoritma Guru Min dicadangkan, yang mengemas kini sasaran dengan menjejak purata bergerak berat model dan bukannya keluaran model. Model asal dengan berat θ dipanggil model Pelajar, dan model yang beratnya ialah berat purata bergerak bagi beberapa model Pelajar berturut-turut θ′ dipanggil model Guru Min:

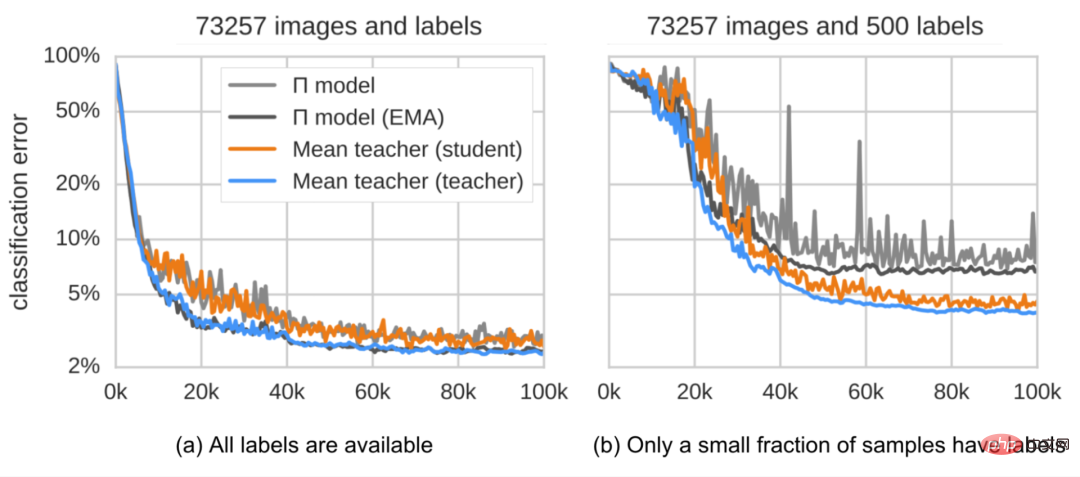

Kehilangan regularisasi konsistensi ialah jarak antara ramalan model Pelajar dan model Guru, dan jurang ini harus diminimumkan. Model Guru Min boleh memberikan ramalan yang lebih tepat berbanding model Pelajar. Kesimpulan ini disahkan dalam eksperimen empirikal, seperti yang ditunjukkan dalam Rajah 4.

Rajah 4: Ralat pengelasan model Π dan model Min Guru pada set data SVHN. Model Guru Min (diwakili oleh garis oren) berprestasi lebih baik daripada model Pelajar (diwakili oleh garis biru). (Sumber imej: Tarvaninen dan kertas kerja Valpola "Model Guru Min ialah Model Contoh Berprestasi Lebih Baik: Pengoptimuman Objektif Ketekalan Purata Berwajaran Hasil Pembelajaran Dalam Separuh Penyeliaan" diterbitkan pada 2017)

Menurut penyelidikan ablasinya:

- Kaedah peningkatan input (cth., membalik rawak imej input, hingar Gaussian) atau pemprosesan tercicir model Pelajar adalah baik untuk pelaksanaan model Prestasi adalah satu kemestian. Mod guru tidak memerlukan pemprosesan keciciran.

- Prestasi adalah sensitif kepada hiperparameter pereputan β purata bergerak eksponen. Strategi yang lebih baik ialah menggunakan β=0.99 yang lebih kecil pada peringkat pertumbuhan dan β=0.999 yang lebih besar pada peringkat kemudian apabila peningkatan model Pelajar menjadi perlahan.

- Didapati bahawa ralat min kuasa dua (MSE) bagi fungsi kos ketekalan berprestasi lebih baik daripada fungsi kos lain seperti perbezaan KL.

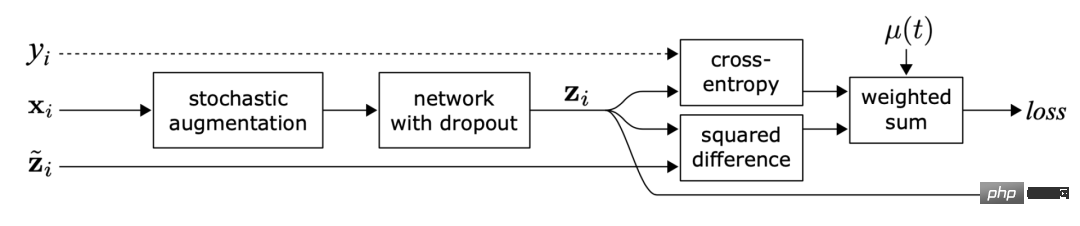

(4) Mengambil sampel hingar sebagai sasaran pembelajaran

Beberapa kaedah latihan konsisten baru-baru ini belajar untuk menggabungkan sampel asal tidak berlabel dengan versi dipertingkatkan yang sepadan Perbezaan antara ramalan diminimumkan. Idea ini sangat serupa dengan model Π, tetapi kehilangan regularisasi konsistensinya hanya berfungsi pada data tidak berlabel.

Rajah 5: Latihan ketekalan menggunakan sampel yang bising

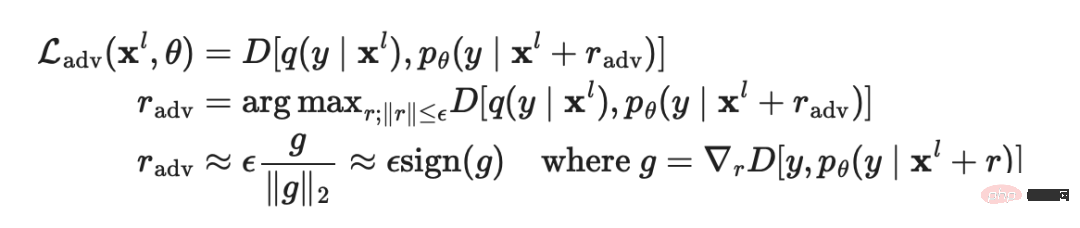

Dalam kertas kerja "Menjelaskan dan Memanfaatkan Contoh-contoh Adversarial" yang diterbitkan oleh Goodfellow et al pada tahun 2014, latihan adversarial menggunakan bunyi lawan pada input dan melatih Model ini menjadikannya teguh kepada serangan musuh tersebut.

Formula aplikasi kaedah ini dalam pembelajaran terselia adalah seperti berikut:

di mana  ialah taburan sebenar, yang menghampiri pengekodan satu panas bagi label sebenar,

ialah taburan sebenar, yang menghampiri pengekodan satu panas bagi label sebenar,  ialah ramalan model dan

ialah ramalan model dan  ialah fungsi jarak yang mengira perbezaan antara kedua-dua pengagihan. Miyato et al. mencadangkan latihan adversarial maya dalam kertas kerja "Latihan Adversarial Maya: Kaedah Regularisasi untuk Pembelajaran Diselia dan Separuh Diawasi" yang diterbitkan pada tahun 2018 (Latihan Adversarial Maya, VAT), kaedah ini adalah lanjutan daripada idea latihan adversarial dalam bidang pembelajaran separa penyeliaan. Memandangkan

ialah fungsi jarak yang mengira perbezaan antara kedua-dua pengagihan. Miyato et al. mencadangkan latihan adversarial maya dalam kertas kerja "Latihan Adversarial Maya: Kaedah Regularisasi untuk Pembelajaran Diselia dan Separuh Diawasi" yang diterbitkan pada tahun 2018 (Latihan Adversarial Maya, VAT), kaedah ini adalah lanjutan daripada idea latihan adversarial dalam bidang pembelajaran separa penyeliaan. Memandangkan  tidak diketahui, VAT menggantikan istilah yang tidak diketahui dengan ramalan model semasa tentang input asal apabila berat semasa ditetapkan kepada

tidak diketahui, VAT menggantikan istilah yang tidak diketahui dengan ramalan model semasa tentang input asal apabila berat semasa ditetapkan kepada  . Perlu diingat bahawa

. Perlu diingat bahawa  ialah nilai tetap berat model, jadi kemas kini kecerunan tidak akan dilakukan pada

ialah nilai tetap berat model, jadi kemas kini kecerunan tidak akan dilakukan pada  .

.

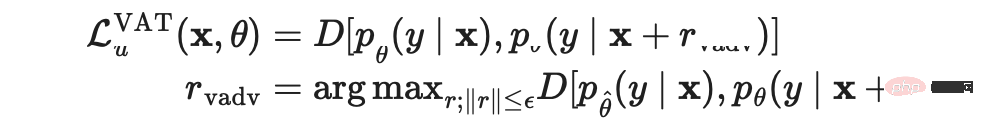

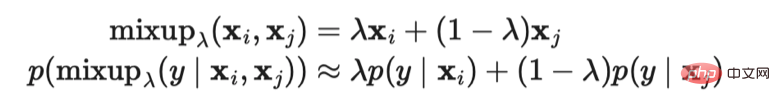

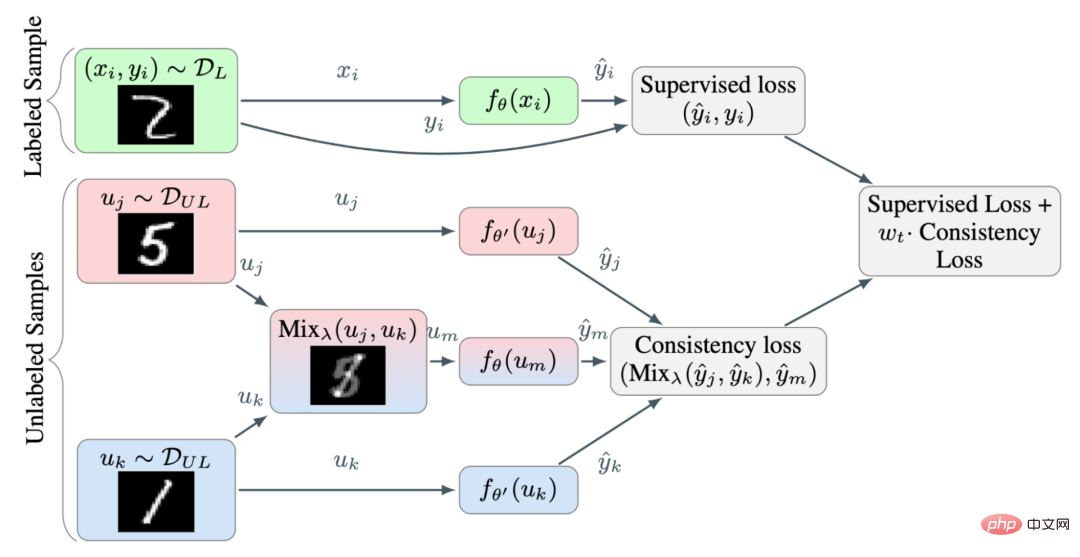

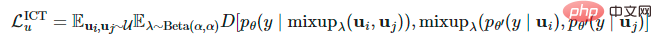

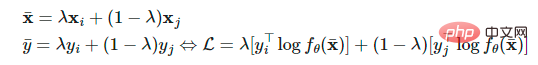

Kehilangan VAT dikenakan pada kedua-dua sampel berlabel dan tidak berlabel. Ia mengira kelancaran negatif manifold ramalan model semasa pada setiap titik data. Mengoptimumkan kerugian ini boleh menjadikan manifold ramalan lebih lancar. Verma et al. mencadangkan latihan ketekalan interpolasi (ICT) dalam kertas kerja 2019 "Latihan Konsistensi Interpolasi untuk Pembelajaran Separuh Penyeliaan" dengan menambah interpolasi lebih banyak titik data supaya ramalan model dan interpolasi label yang sepadan adalah sebagai konsisten mungkin. Hongyi Zhang et al. mencadangkan kaedah MixUp dalam kertas kerja 2018 "Mixup: Beyond Empirical Risk Minimization", yang mencampurkan dua imej melalui jumlah wajaran yang mudah. Latihan ketekalan interpolasi adalah berdasarkan idea ini, membenarkan model ramalan menjana label untuk sampel campuran untuk memadankan ramalan interpolasi input sepadan:

di mana  mewakili purata bergerak θ model Min Guru.

mewakili purata bergerak θ model Min Guru.

Rajah 6: Gambaran keseluruhan latihan ketekalan interpolasi. Gunakan kaedah MixUp untuk menjana lebih banyak sampel interpolasi dengan label interpolasi sebagai sasaran pembelajaran. (Sumber imej: makalah 2019 Verma et al. "Latihan Konsistensi Interpolasi untuk Pembelajaran Separuh Penyeliaan")

Memandangkan dua sampel tidak berlabel yang dipilih secara rawak tergolong dalam kategori yang berbeza Kebarangkalian adalah sangat tinggi (contohnya, terdapat 1000 kategori sasaran dalam ImageNet), jadi menggunakan kaedah Campuran antara dua sampel rawak tidak berlabel berkemungkinan menghasilkan interpolasi berhampiran sempadan keputusan. Menurut hipotesis pemisahan berketumpatan rendah, sempadan keputusan selalunya terletak di kawasan berketumpatan rendah.

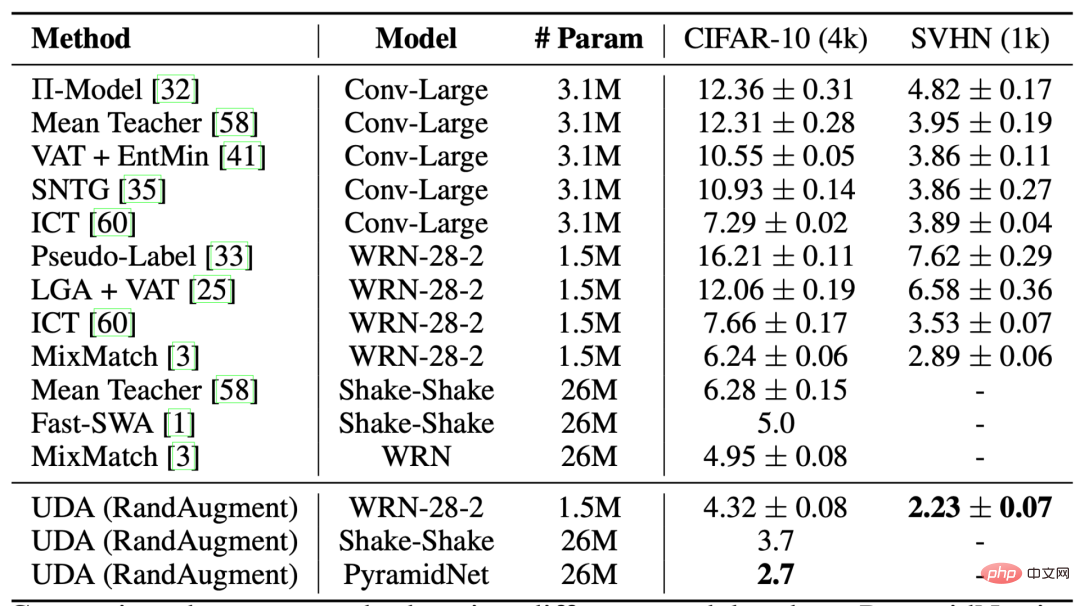

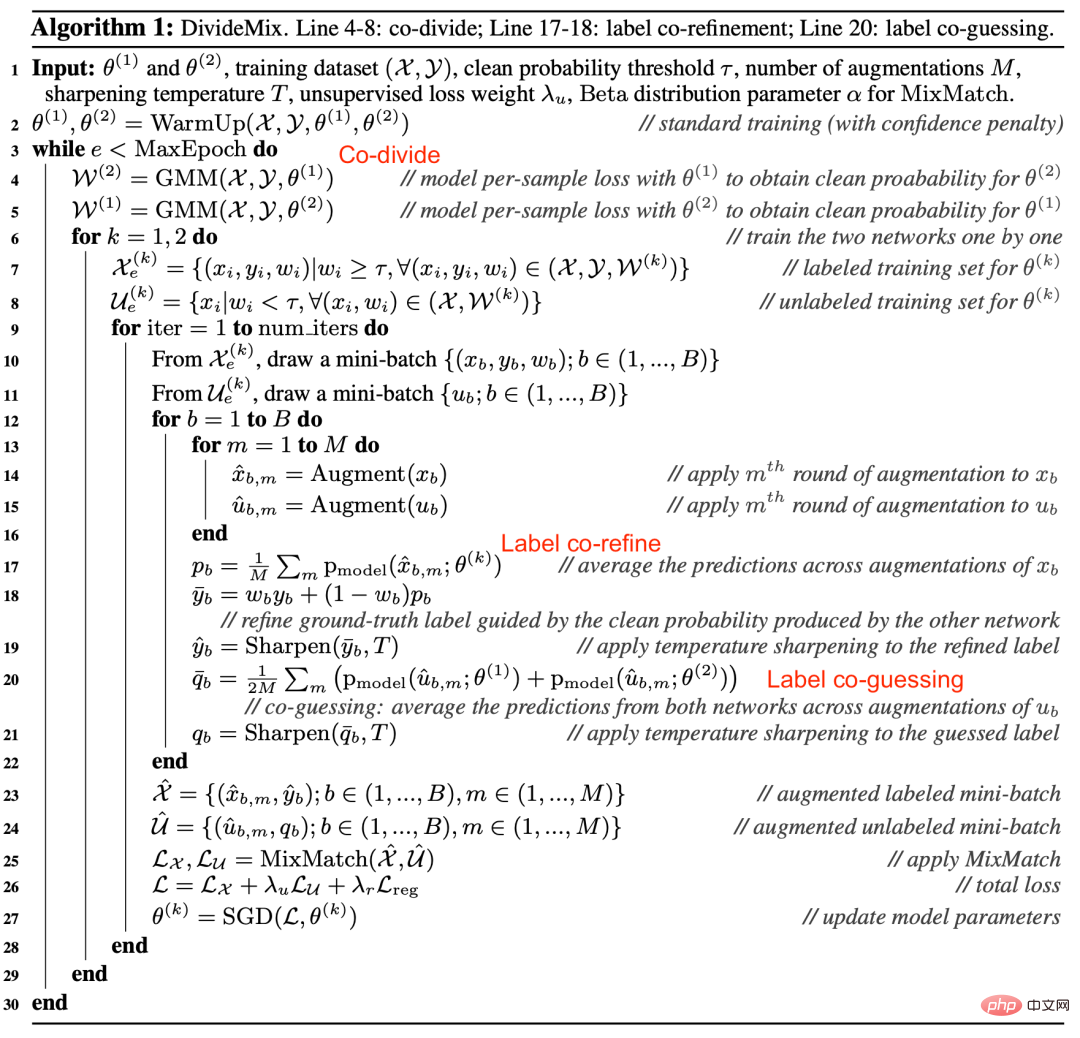

di mana  mewakili purata pergerakan θ. Sama seperti VAT, Pembesaran Data Tanpa Pengawasan (UDA) yang dicadangkan oleh Xie et al dalam kertas kerja 2020 "Pembesaran Data Tanpa Pengawasan untuk Latihan Konsistensi" belajar untuk memberikan sampel tidak berlabel Output yang sama seperti yang diramalkan oleh sampel ditambah. UDA secara khusus menumpukan pada mengkaji bagaimana "kualiti" bunyi mempengaruhi prestasi pembelajaran separa penyeliaan melalui latihan yang konsisten. Untuk menjana sampel hingar yang bermakna dan cekap, adalah penting untuk menggunakan kaedah penambahan data lanjutan. Kaedah penambahan data yang baik harus dapat menjana cekap (iaitu, jangan menukar label) dan hingar pelbagai dengan bias induktif yang disasarkan.

mewakili purata pergerakan θ. Sama seperti VAT, Pembesaran Data Tanpa Pengawasan (UDA) yang dicadangkan oleh Xie et al dalam kertas kerja 2020 "Pembesaran Data Tanpa Pengawasan untuk Latihan Konsistensi" belajar untuk memberikan sampel tidak berlabel Output yang sama seperti yang diramalkan oleh sampel ditambah. UDA secara khusus menumpukan pada mengkaji bagaimana "kualiti" bunyi mempengaruhi prestasi pembelajaran separa penyeliaan melalui latihan yang konsisten. Untuk menjana sampel hingar yang bermakna dan cekap, adalah penting untuk menggunakan kaedah penambahan data lanjutan. Kaedah penambahan data yang baik harus dapat menjana cekap (iaitu, jangan menukar label) dan hingar pelbagai dengan bias induktif yang disasarkan.

Untuk medan imej, UDA menggunakan kaedah RandAugment, yang dicadangkan oleh Cubuk et al dalam makalah 2019 "RandAugment: Kaedah peningkatan data automatik yang praktikal yang mengurangkan ruang carian " (RandAugment: Pembesaran data automatik yang praktikal dengan ruang carian yang dikurangkan). Ia menyampel secara seragam operasi pembesaran yang tersedia dalam perpustakaan pemprosesan imej Python PIL, tanpa memerlukan pembelajaran atau pengoptimuman, dan oleh itu jauh lebih murah daripada menggunakan kaedah AutoAugment.

Rajah 7: Perbandingan pelbagai kaedah pembelajaran separa penyeliaan dalam klasifikasi CIFAR-10. Apabila melatih 50,000 sampel tanpa pemprosesan RandAugment, kadar ralat Wide-ResNet-28-2 dan PyramidNet+ShakeDrop di bawah pengawasan penuh ialah **5.4** dan **2.7** masing-masing.

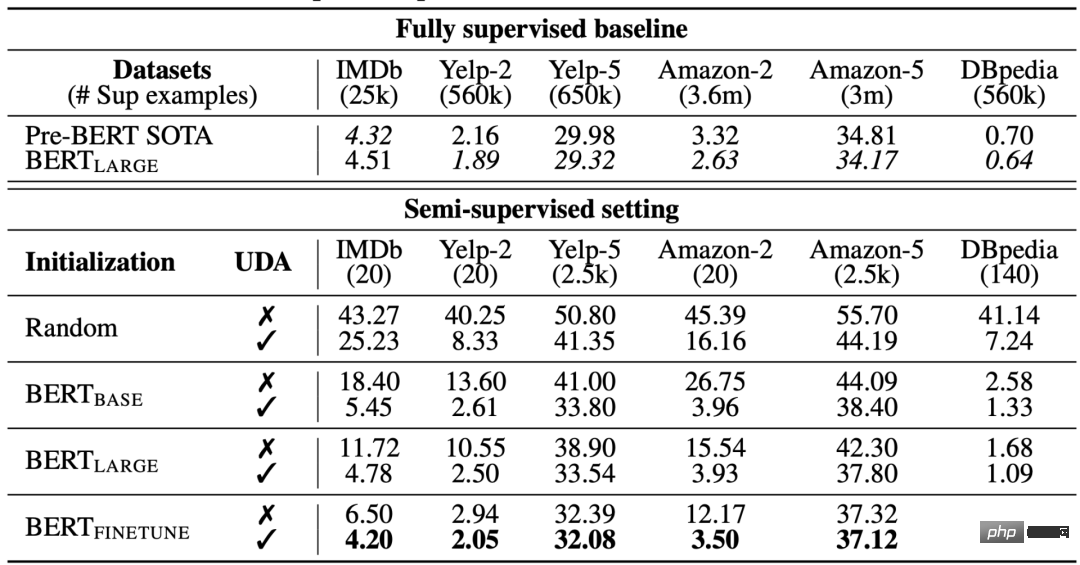

Untuk medan bahasa, UDA menggunakan gabungan terjemahan belakang dan penggantian perkataan berdasarkan TF-IDF. Terjemahan belakang mengekalkan makna peringkat tinggi tetapi tidak mengekalkan perkataan tertentu sendiri, manakala penggantian perkataan berasaskan TF-IDF mengalih keluar perkataan tidak bermaklumat dengan skor TF-IDF yang rendah. Dalam eksperimen tentang tugas bahasa, penyelidik mendapati bahawa UDA adalah pelengkap untuk memindahkan pembelajaran dan pembelajaran perwakilan sebagai contoh, memperhalusi model BERT pada data tidak berlabel dalam domain (iaitu  dalam Rajah 8) boleh meningkatkan lagi prestasi .

dalam Rajah 8) boleh meningkatkan lagi prestasi .

Rajah 8: Perbandingan kaedah peningkatan data tanpa pengawasan menggunakan tetapan permulaan yang berbeza pada tugas pengelasan teks yang berbeza. (Sumber imej: makalah 2020 Xie et al. "Pembesaran Data Tanpa Seliaan untuk Latihan Konsistensi")

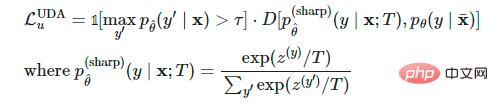

Apabila mengira  , UDA boleh digunakan dengan menggunakan perkara berikut Tiga teknik latihan untuk mengoptimumkan keputusan:

, UDA boleh digunakan dengan menggunakan perkara berikut Tiga teknik latihan untuk mengoptimumkan keputusan:

- Penopengan keyakinan rendah: Jika keyakinan ramalan sampel lebih rendah daripada ambang

, maka Lakukan pemprosesan topeng.

, maka Lakukan pemprosesan topeng. - Tajaman Taburan Ramalan: Gunakan suhu rendah

dalam Softmax untuk menajamkan taburan kebarangkalian ramalan.

dalam Softmax untuk menajamkan taburan kebarangkalian ramalan. - Penapisan Data Dalam Domain: Untuk mengekstrak lebih banyak data dalam domain daripada set data luar domain yang besar, penyelidik melatih pengelas untuk meramalkan label dalam domain dan kemudian mengekalkan Sampel dengan ramalan keyakinan tinggi digunakan sebagai sampel calon dalam domain.

di mana,  ialah nilai tetap berat model, sama seperti

ialah nilai tetap berat model, sama seperti  dalam VAT , jadi tiada kemas kini kecerunan,

dalam VAT , jadi tiada kemas kini kecerunan,  ialah titik data dipertingkat,

ialah titik data dipertingkat,  ialah ambang keyakinan ramalan dan

ialah ambang keyakinan ramalan dan  ialah suhu penajaman taburan.

ialah suhu penajaman taburan.

5 Pelabelan Pseudo

Kertas 2013 Lee et al. "Pelabelan Pseudo: Kaedah pembelajaran separa penyeliaan yang mudah dan cekap untuk rangkaian saraf dalam" Pseudo-Label : Kaedah Pembelajaran Separuh Selia Yang Mudah dan Cekap untuk Rangkaian Neural Dalam dicadangkan dalam (Pseudo-Label: Kaedah Pembelajaran Separuh Separuh Yang Mudah dan Cekap untuk Rangkaian Neural Dalam Ia memberikan label pseudo kepada sampel tidak berlabel berdasarkan softmax maksimum). kebarangkalian yang diramalkan oleh model semasa, dan kemudian memberikan label pseudo kepada sampel tidak berlabel di bawah tetapan yang diselia sepenuhnya , melatih model pada sampel berlabel dan sampel tidak berlabel secara serentak.

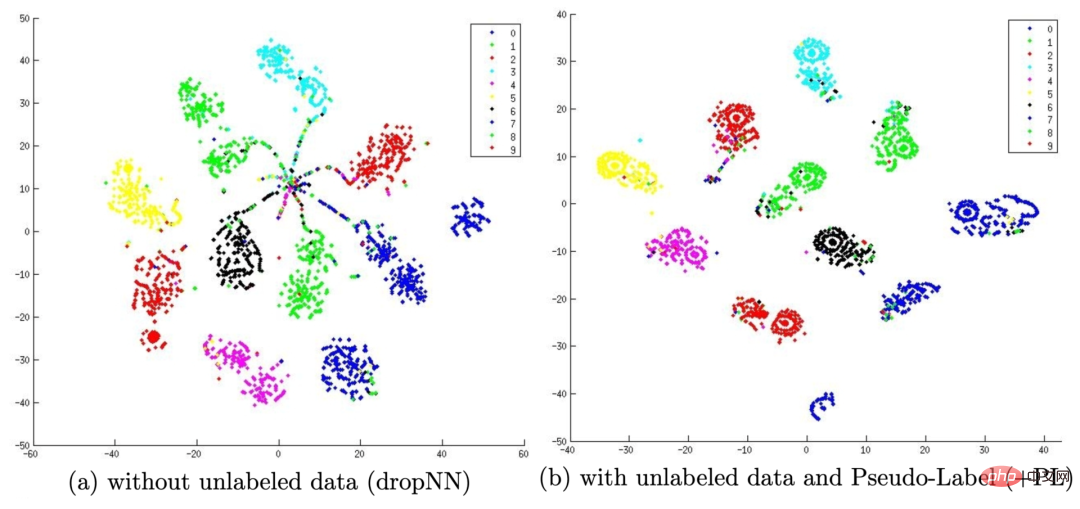

Mengapa teg pseudo berfungsi? Pelabelan pseudo sebenarnya bersamaan dengan regularisasi entropi, yang meminimumkan entropi bersyarat bagi kebarangkalian kelas data tidak berlabel, dengan itu mencapai pemisahan berketumpatan rendah antara kelas. Dalam erti kata lain, kebarangkalian kelas yang diramalkan sebenarnya mengira pertindihan kelas, dan meminimumkan entropi adalah bersamaan dengan mengurangkan pertindihan kelas dan dengan itu pemisahan ketumpatan.

Rajah 9: (a) menunjukkan output ujian pada set ujian MINIST selepas melatih model menggunakan hanya 600 data berlabel The t -Hasil visualisasi SNE, (b) mewakili hasil visualisasi t-SNE bagi output ujian pada set ujian MINIST selepas melatih model menggunakan 600 data berlabel dan 60,000 pseudo-label data tidak berlabel. Label pseudo membolehkan ruang benam yang dipelajari mencapai pemisahan yang lebih baik. (Sumber imej: makalah 2013 Lee et al. "Pseudo Labels: A Simple and Efficient Semi-supervised Learning Method for Deep Neural Networks")

Latihan menggunakan label pseudo Alam semula jadi adalah proses berulang. Di sini, model yang menjana label pseudo dipanggil model Guru, dan model yang menggunakan label pseudo untuk pembelajaran dipanggil model Pelajar.

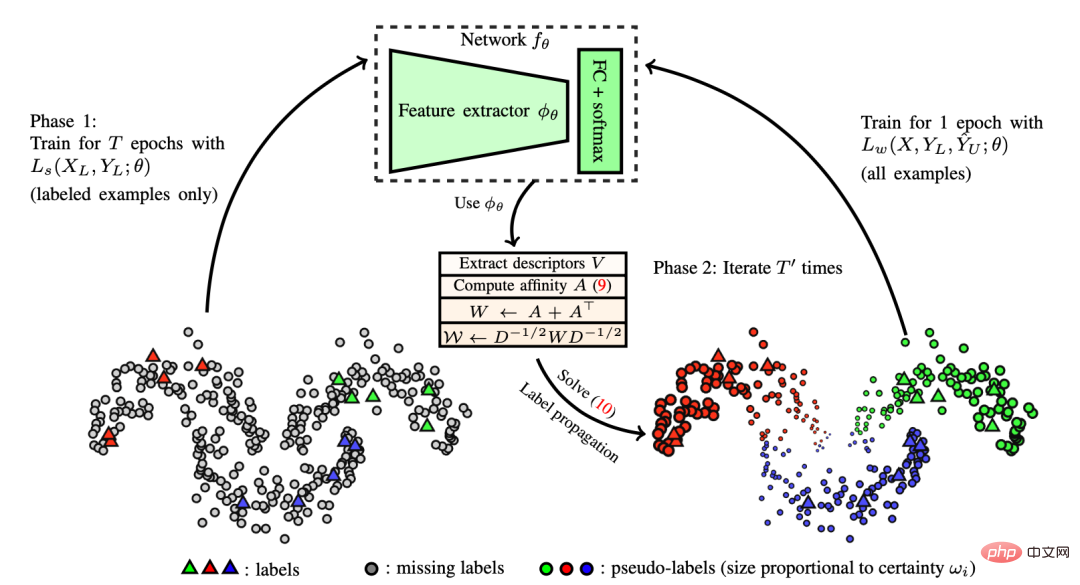

(1) Penyebaran label

Kertas "Penyebaran Label untuk Pembelajaran Separuh Penyeliaan Dalam" yang diterbitkan oleh Iscen et al pada tahun 2019 Konsep penyebaran label telah dicadangkan dalam Pembelajaran Separa Penyeliaan, iaitu idea membina graf persamaan antara sampel berdasarkan pembenaman ciri. Label pseudo kemudiannya "diresapkan" daripada sampel yang diketahui kepada sampel tidak berlabel dengan pemberat perambatan berkadar dengan skor persamaan berpasangan dalam graf. Dari segi konsep, ia serupa dengan pengelas k-NN, yang kedua-duanya mengalami masalah tidak menskalakan dengan baik kepada set data yang besar.

Rajah 10: Gambarajah skematik cara penyebaran teg berfungsi. (Sumber imej: "Penyebaran Label untuk Pembelajaran Separuh Penyeliaan Dalam" diterbitkan oleh Iscen et al. pada 2019)

(2) Latihan Kendiri

Latihan kendiri bukanlah konsep baru Scudder et al menerbitkan kertas "Kebarangkalian kesilapan beberapa mesin pengecaman pola penyesuaian" pada tahun 1965, Nigram & Ghani et al dalam kertas kerja "Analyzing the Effectiveness and Applicability of Co-. trainin" yang diterbitkan pada tahun 2000 semuanya melibatkan konsep ini. Ia ialah algoritma berulang yang melakukan dua langkah berikut secara bergilir-gilir sehingga setiap sampel tidak berlabel sepadan dengan label:

- Pertama, ia membina klasifikasi pada peranti data berlabel.

- Kemudian ia menggunakan pengelas ini untuk meramalkan label bagi data tidak berlabel dan menukarkan label keyakinan tertinggi kepada sampel berlabel.

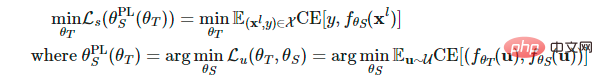

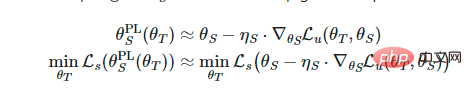

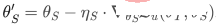

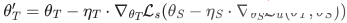

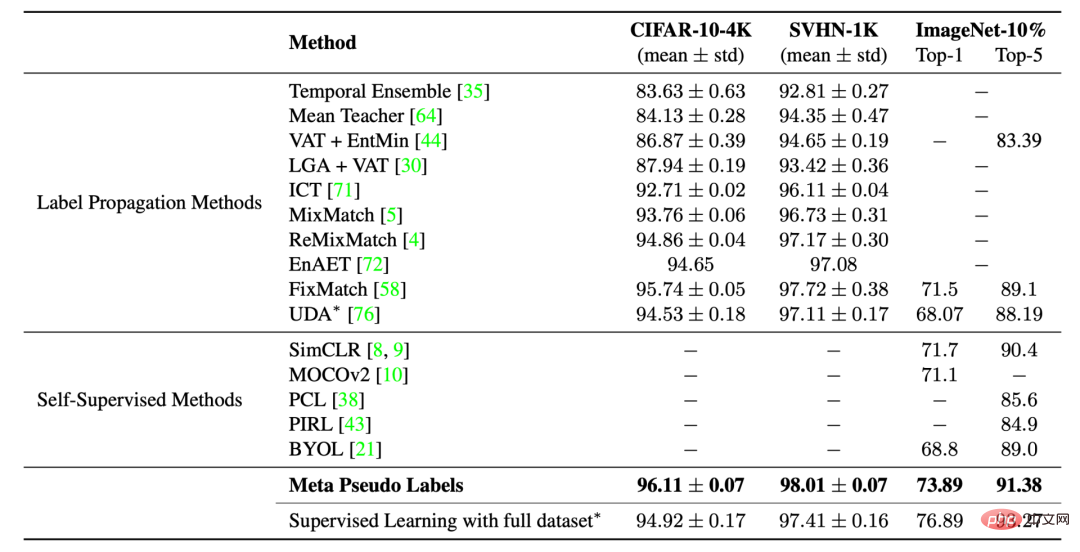

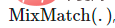

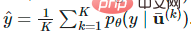

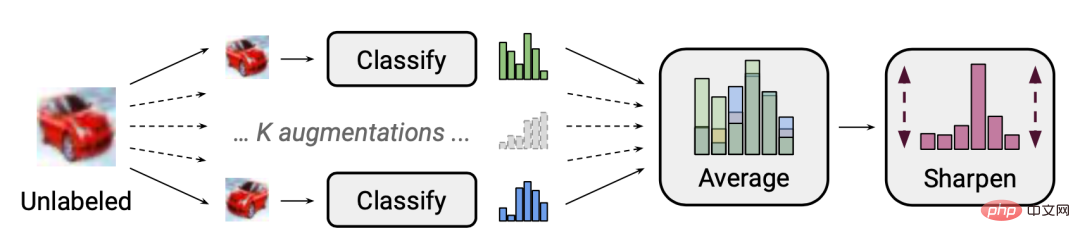

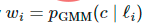

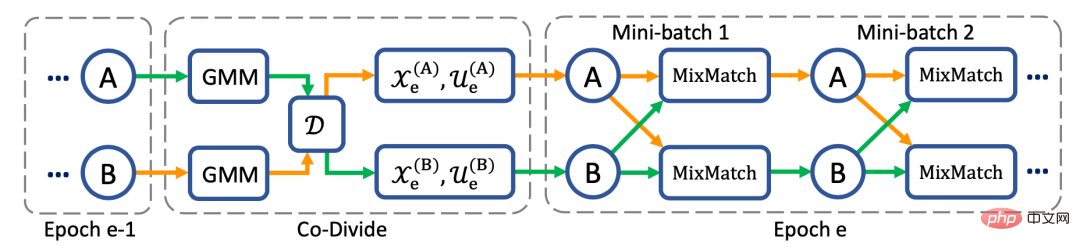

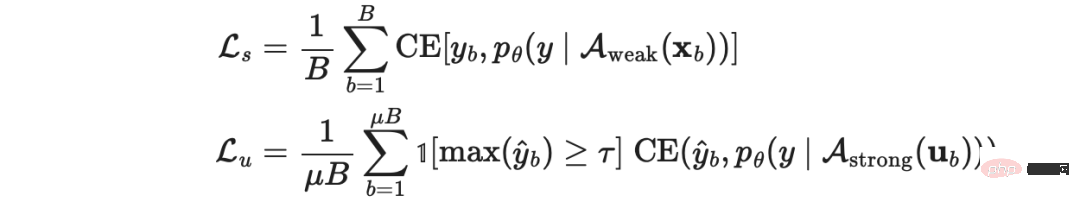

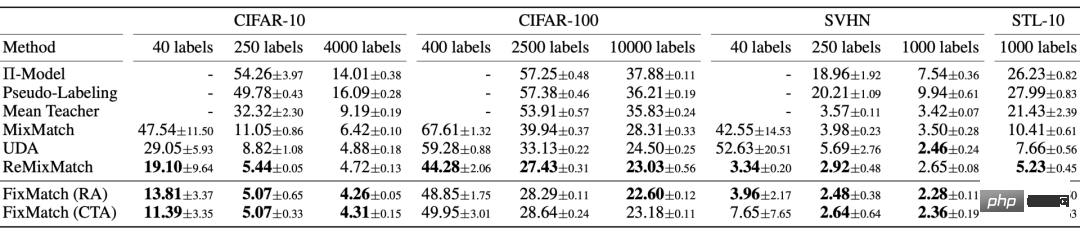

Kertas kerja "Latihan kendiri dengan Pelajar Noisy meningkatkan klasifikasi ImageNet" yang diterbitkan oleh Xie et al pada 2020 klasifikasi ImageNet), latihan kendiri digunakan untuk pembelajaran mendalam dan telah mencapai keputusan yang hebat. Dalam tugas klasifikasi ImageNet, penyelidik mula-mula melatih model EfficientNet sebagai model Teacher untuk menjana label pseudo untuk 300 juta imej tidak berlabel, dan kemudian melatih model EfficientNet yang lebih besar sebagai model Pelajar untuk mempelajari imej berlabel dan imej pseudo sebenar. Dalam persediaan percubaan mereka, elemen utama ialah penambahan hingar semasa latihan model Pelajar, manakala model Guru tidak menambah hingar semasa proses penjanaan pseudo-label. Oleh itu, kaedah mereka dipanggil "Pelajar Bising", yang menggunakan kaedah kedalaman rawak, keciciran dan RandAugment untuk menambah hingar pada model Pelajar. Model Pelajar berprestasi lebih baik daripada model Guru, sebahagian besarnya disebabkan oleh faedah menambah hingar. Bunyi tambahan mempunyai kesan pengkompaunan untuk melicinkan sempadan keputusan yang dihasilkan oleh model pada kedua-dua data berlabel dan tidak berlabel. Terdapat beberapa tetapan teknikal penting lain untuk latihan kendiri model Pelajar, termasuk: Penambahan hingar pada model Pelajar juga meningkatkan pertahanan terhadap FGSM (serangan tanda kecerunan pantas, yang menggunakan kecerunan kehilangan data input dan melaraskan data input untuk memaksimumkan kerugian) Keteguhan, walaupun model tidak dioptimumkan untuk keteguhan lawan. Du et al mencadangkan kaedah SentAugment dalam kertas kerja 2020 "Latihan kendiri Meningkatkan Pra-latihan untuk Pemahaman Bahasa Semulajadi", yang bertujuan untuk Ia menyelesaikan masalah data tidak berlabel yang tidak mencukupi dalam domain tersebut semasa melakukan latihan kendiri dalam bidang bahasa. Ia bergantung pada vektor ayat untuk mencari sampel dalam domain yang tidak berlabel daripada korpora besar dan menggunakan ayat yang diambil untuk latihan kendiri. Confirmation bias ialah masalah menyediakan pseudo-label yang salah kerana model Teacher tidak cukup matang. Penambahan label yang salah mungkin tidak menghasilkan model Pelajar yang lebih baik. Untuk mengurangkan bias pengesahan, Eric Arazo et al dalam kertas kerja "Pseudo-Labeling and Confirmation Bias in Deep Semi-supervised Learning" Dua kaedah baharu dicadangkan dalam Pembelajaran Terselia) . Salah satunya ialah kaedah Mixup menggunakan label lembut Memandangkan dua sampel Jika terdapat terlalu sedikit sampel berlabel, menggunakan kaedah Mixup tidak mencukupi. Oleh itu, pengarang kertas kerja terlebih sampel sampel label untuk menetapkan bilangan minimum sampel label dalam setiap kelompok mini. Ini lebih baik daripada pampasan berat untuk sampel label, kerana ia akan dikemas kini dengan lebih kerap, berbanding kemas kini yang kurang kerap dan lebih besar - yang sebenarnya lebih tidak stabil. Seperti penyusunan konsistensi, penambahan data dan kaedah keciciran juga penting untuk memainkan peranan sebagai label pseudo. Hieu Pham dan yang lain mencadangkan meta pseudo-label dalam kertas 2021 "Meta Pseudo Labels". model Guru. Model Guru dan model Pelajar dilatih secara serentak, model Guru belajar menghasilkan label pseudo yang lebih baik, dan model Pelajar belajar daripada label pseudo. Tetapkan pemberat model Guru dan model Pelajar kepada Walau bagaimanapun, mengoptimumkan persamaan di atas bukanlah satu tugas yang mudah. Meminjam idea MAML (Model-Agnostic Meta-Learnin), ia serupa dengan melakukan kemas kini kecerunan satu langkah pada Disebabkan penggunaan label pseudo lembut, fungsi objektif di atas ialah fungsi boleh dibezakan. Walau bagaimanapun, jika label pseudo keras digunakan, ia adalah fungsi yang tidak boleh dibezakan, jadi kaedah pembelajaran pengukuhan seperti REINFORCE diperlukan. Proses pengoptimuman dijalankan secara berselang-seli antara dua model: Rajah 11: Pelabelan meta-pseudo berbanding separa selia atau seliaan sendiri yang lain kaedah pembelajaran pada imej Perbandingan prestasi dalam tugasan pengelasan. (Sumber imej: Makalah 2021 Hieu Pham et al. "Meta Pseudo Labels") boleh konsisten dua kaedah penyelarasan seksual dan pelabelan pseudo digabungkan dan digunakan untuk pembelajaran separa penyeliaan. Berthelot et al.’s 2019 paper "MixMatch: A Holistik Approach to Semi-supervised Learning" Kaedah MixMatch yang dicadangkan dalam "To Semi-supervised learning" -Pembelajaran Terselia" ialah kaedah holistik yang digunakan untuk pembelajaran separa penyeliaan. Ia menggunakan data tidak berlabel dengan menyepadukan kaedah berikut: Memandangkan sekumpulan data berlabel di mana Rajah 12: Proses "tekaan label" dalam MixMatch: purata sampel tidak berlabel yang dipertingkatkan K membetulkan taburan marginal yang diramalkan, dan akhirnya menajamkan taburan. (Sumber imej: Makalah 2019 Berthelot et al. "MixMatch: Kaedah Holistik untuk Pembelajaran Separuh Penyeliaan") Peningkatan MixUp bagi data tidak berlabel adalah amat penting. Mengalih keluar penajaman suhu pada pengedaran pseudo-label boleh menjejaskan prestasi dengan teruk. Untuk meneka label, mengira purata berbilang versi tambahan data tidak berlabel juga penting. Dalam kertas kerja 2020 "ReMixMatch: Pembelajaran Separuh Penyeliaan dengan Penjajaran Pengedaran dan Penambahan Pembesaran" (ReMixMatch: Pembelajaran Separuh Penyeliaan dengan Penjajaran Pengedaran dan Penambahan Pengukuhan), Berthelot et al seterusnya mencadangkan kaedah ReMixMatch, dengan memperkenalkan dua Mekanisme baharu berikut untuk menambah baik kaedah MixMatch:

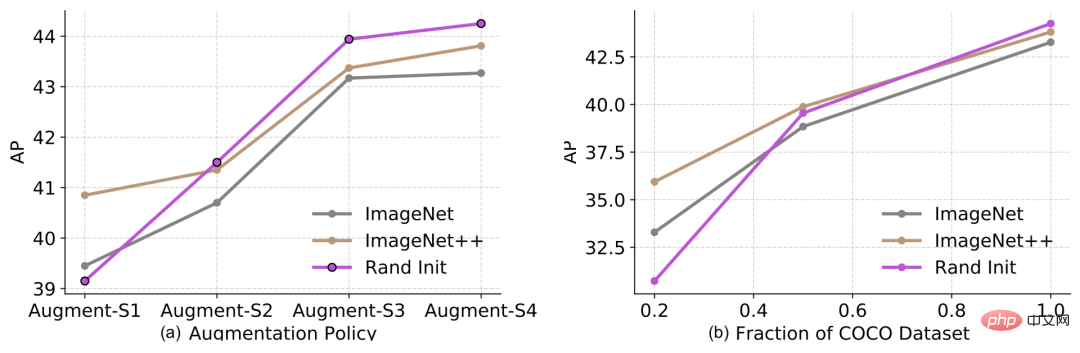

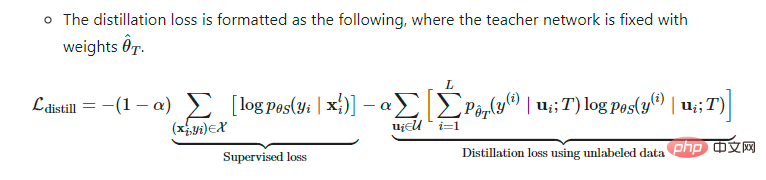

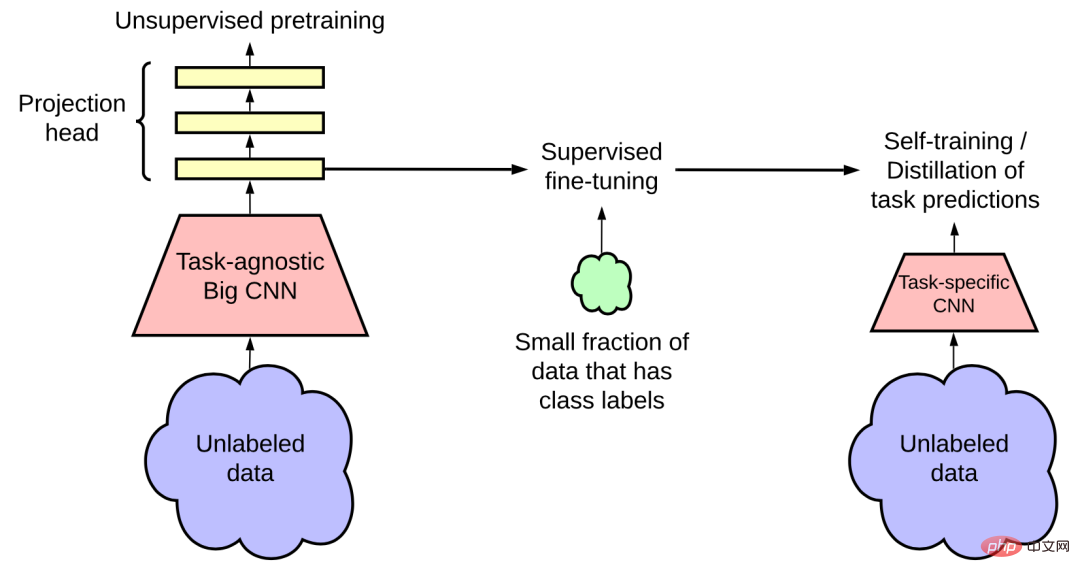

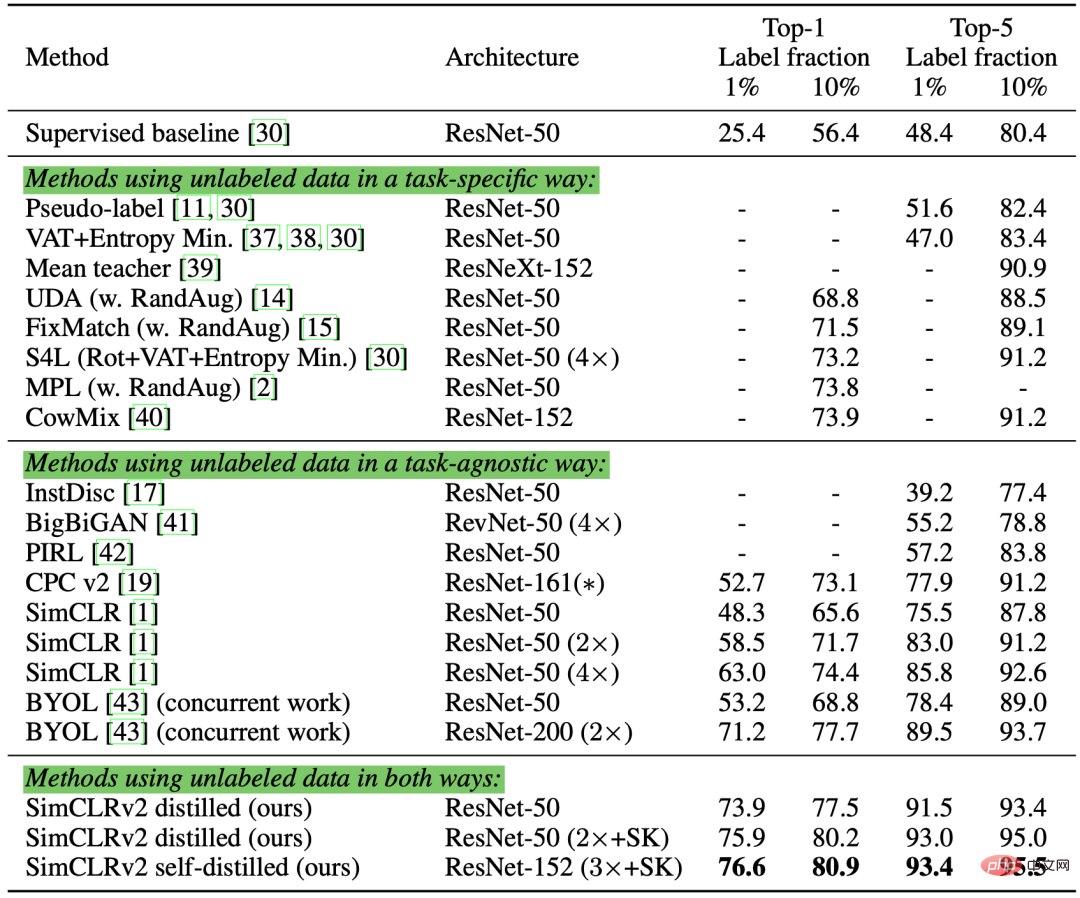

1. Kaedah ini menjadikan taburan marginal menjadi pengedaran kelas bagi label kebenaran asas, dan 2. Memandangkan sampel yang tidak berlabel, versi "berlabuh" yang dipertingkatkan dengan lemah mula-mula dijana, dan kemudian kaedah CTAugment (Penambahan Teori Kawalan) digunakan untuk mengira purata versi K yang dipertingkatkan dengan kuat. CTAugment hanya sampel versi dipertingkatkan bagi model cakap balik yang ramalannya kekal dalam toleransi rangkaian. Kerugian ReMixMatch terdiri daripada item berikut: Junnan Li et al. : Pembelajaran Kaedah DivideMix dicadangkan dalam (dengan Label Bising sebagai Pembelajaran Separa Penyeliaan), yang menggabungkan pembelajaran separa penyeliaan dengan pembelajaran menggunakan label bising (Belajar dengan label bising, LNL). Ia memodelkan pengedaran kehilangan setiap sampel melalui model campuran Gaussian (GMM), yang membahagikan data latihan secara dinamik kepada set data berlabel yang mengandungi sampel bersih dan set data tidak berlabel yang mengandungi sampel bising. Mengikuti idea yang dicadangkan oleh Arazo et al dalam makalah 2019 "Pemodelan Noise Label Tanpa Selia dan Pembetulan Kehilangan", mereka Model campuran Gaussian binari dipasang pada kehilangan entropi silang. Sampel yang bersih dijangka mendapat kehilangan yang lebih rendah lebih cepat daripada sampel yang bising. Model campuran Gaussian dengan min yang lebih kecil sepadan dengan pengelompokan label bersih, yang dilambangkan di sini sebagai c. Jika kebarangkalian belakang model campuran Gaussian Proses pengelompokan data dipanggil co-divide. Untuk mengelakkan bias pengesahan, kaedah DividImax melatih dua rangkaian bersilang secara serentak, di mana setiap rangkaian menggunakan bahagian berasingan set data daripada rangkaian lain, sama seperti cara Double Q-Learning berfungsi. Rajah 14: DivideMix secara bebas melatih dua rangkaian untuk mengurangkan bias pengesahan. Kedua-dua rangkaian secara serentak menjalankan pembahagian kolaboratif, penghalusan kolaboratif dan tekaan kolaboratif. (Sumber imej: kertas kerja Junnan Li et al. 2020 "DivideMix: Menggunakan Pembelajaran Label Bising untuk Melaksanakan Pembelajaran Separuh Penyeliaan") Berbanding dengan MixMatch, DivideMix mempunyai langkah pembahagian bersama tambahan untuk memproses sampel yang bising, dan penambahbaikan berikut telah dibuat semasa latihan: Penapisan bersama label: Ia menyelaraskan label kebenaran tanah Tekaan bersama label: Ia membuat purata ramalan dua model untuk sampel data tidak berlabel. Rajah 15: Algoritma DivideMix. (Sumber imej: kertas kerja Junnan Li et al. 2020 "DivideMix: Menggunakan Pembelajaran Label Bising untuk Melaksanakan Pembelajaran Separuh Penyeliaan") Kaedah FixMatch yang dicadangkan oleh Sohn et al dalam makalah 2020 "FixMatch: Memudahkan Pembelajaran Separuh Diawasi dengan Konsistensi dan Keyakinan" menggunakan kaedah peningkatan yang lemah untuk mengesan sampel tidak berlabel menjana label pseudo dan hanya menyimpan ramalan berkeyakinan tinggi. Di sini, peningkatan lemah dan penapisan berkeyakinan tinggi membantu menjana sasaran label pseudo yang boleh dipercayai berkualiti tinggi. FixMatch kemudiannya meramalkan pseudo-label ini diberikan sampel yang dipertingkatkan. Rajah 16: Ilustrasi cara kaedah FixMatch berfungsi. (Sumber imej: makalah 2020 Sohn et al. "FixMatch: Memudahkan pembelajaran separa penyeliaan menggunakan konsistensi dan keyakinan") di mana Rajah 17: Prestasi FixMatch dan beberapa kaedah pembelajaran separa penyeliaan lain mengenai tugas pengelasan imej. (Sumber imej: makalah 2020 Sohn et al. "FixMatch: Memudahkan pembelajaran separa penyeliaan menggunakan konsistensi dan keyakinan") Menurut kajian ablasi FixMatch, Kaedah ini pra-melatih model bebas tugas pada korpus data besar tanpa pengawasan melalui pembelajaran penyeliaan kendiri, The model kemudian diperhalusi pada tugas hiliran menggunakan set data berlabel kecil, yang merupakan paradigma biasa, terutamanya dalam tugas bahasa. Penyelidikan menunjukkan bahawa model boleh memperoleh keuntungan tambahan jika mereka menggabungkan pembelajaran separa penyeliaan dengan pra-latihan. Kertas kerja 2020 Zoph et al. "Memikirkan Semula Pra-latihan dan Latihan Kendiri" mengkaji betapa lebih berkesan latihan kendiri berbanding pra-latihan . Persediaan percubaan mereka adalah menggunakan ImageNet untuk pra-latihan atau latihan kendiri untuk meningkatkan hasil COCO. Adalah penting untuk ambil perhatian bahawa apabila menggunakan ImageNet untuk latihan kendiri, ia membuang label dan hanya menggunakan sampel ImageNet sebagai titik data tidak berlabel. He Kaiming dan yang lain telah membuktikan dalam kertas kerja 2018 "Memikirkan Semula Pra-latihan ImageNet" bahawa jika tugas hiliran (seperti pengesanan sasaran) sangat berbeza, kesan pra-latihan klasifikasi ImageNet tidak begitu baik. Rajah 18: (a) Keputusan penambahan data (daripada lemah kepada kuat) dan (b) Kesan saiz set data label pada prestasi pengesanan objek. Dalam legenda: "Rand Init" mewakili model yang dimulakan dengan pemberat rawak `ImageNet` dimulakan menggunakan model pra-latihan dengan ketepatan Top-1 84.5% pada dataset ImageNet ++` dimulakan menggunakan Top-; 1 pada dataset ImageNet -1 dimulakan dengan model pra-latihan dengan ketepatan 86.9%. (Sumber imej: kertas kerja Zoph et al. 2020 "Memikirkan Semula Pra-latihan dan Latihan Kendiri") Percubaan ini memperoleh satu siri penemuan menarik: Kertas 2020 Ting Chen et al. "Model Penyeliaan Kendiri Besar ialah Pelajar Separuh Selia yang Kuat", kaedah prosedur tiga langkah dicadangkan, yang menggabungkan kelebihan pra-latihan yang diselia, penalaan halus dan latihan kendiri yang diselia: 1 3. Gunakan label pseudo dalam latihan kendiri untuk menyaring contoh yang tidak berlabel. a. Pengetahuan model besar boleh disuling menjadi model kecil kerana penggunaan khusus tugasan ini tidak memerlukan kapasiti tambahan perwakilan yang dipelajari. b. Formula kehilangan penyulingan adalah seperti berikut, di mana rangkaian Guru adalah tetap dan beratnya adalah Pengarang kertas kerja membuat persembahan pada tugas klasifikasi ImageNet yang dicuba. Pralatihan diselia sendiri menggunakan SimCLRv2, peningkatan langsung SimCLR. Pemerhatian mereka dalam kajian empirikal mengesahkan beberapa keputusan yang dicadangkan oleh Zoph et al pada 2020:

MixUp ialah kaedah penambahan data yang berkesan apabila memproses imej. Kaedah ini juga boleh digunakan untuk tugas bahasa untuk mencapai pengoptimuman tambahan yang lebih kecil (Guo et al. 2019). Tetapkan bilangan minimum sampel berlabel dalam setiap kumpulan mini Tajamkan pengedaran pseudo-label untuk mengurangkan pertindihan kelas >

(3) Kurangkan bias pengesahan (Confirmation Bias)

dan label sebenar dan label pseudo yang sepadan

dan label sebenar dan label pseudo yang sepadan  , persamaan label interpolasi boleh ditukar kepada softmax Cross-. kehilangan entropi output:

, persamaan label interpolasi boleh ditukar kepada softmax Cross-. kehilangan entropi output:

dan

dan  masing-masing Kehilangan model Pelajar pada sampel berlabel ditakrifkan sebagai fungsi

masing-masing Kehilangan model Pelajar pada sampel berlabel ditakrifkan sebagai fungsi

, dan cenderung untuk mengoptimumkan model Guru untuk meminimumkan kerugian ini dengan sewajarnya.

, dan cenderung untuk mengoptimumkan model Guru untuk meminimumkan kerugian ini dengan sewajarnya.

semasa melakukan pengiraan

semasa melakukan pengiraan

berbilang langkah.

berbilang langkah.

, kami boleh menjana label pseudo melalui fungsi

, kami boleh menjana label pseudo melalui fungsi  dan menggunakan keturunan kecerunan stokastik satu langkah untuk mengoptimumkan

dan menggunakan keturunan kecerunan stokastik satu langkah untuk mengoptimumkan  :

:  .

.  , kami berulang kali menggunakan kemas kini model Pelajar untuk mengoptimumkan

, kami berulang kali menggunakan kemas kini model Pelajar untuk mengoptimumkan  :

:  . Selain itu, objek UDA digunakan pada model Guru untuk menggabungkan penyusunan teratur.

. Selain itu, objek UDA digunakan pada model Guru untuk menggabungkan penyusunan teratur.

6 Regularisasi konsisten + label pseudo

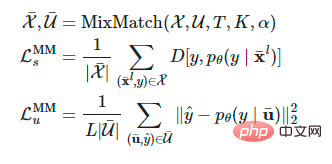

(1) MixMatch

dan data tidak berlabel

dan data tidak berlabel  , versi yang dipertingkatkan diperoleh melalui operasi

, versi yang dipertingkatkan diperoleh melalui operasi  ,

,  dan

dan  masing-masing Mewakili sampel yang dipertingkatkan dan label yang diramalkan untuk sampel yang tidak berlabel.

masing-masing Mewakili sampel yang dipertingkatkan dan label yang diramalkan untuk sampel yang tidak berlabel.

ialah suhu penajaman, digunakan untuk mengurangkan pertindihan label yang diteka K ialah setiap bilangan versi dipertingkat yang dijana oleh sampel label;

ialah suhu penajaman, digunakan untuk mengurangkan pertindihan label yang diteka K ialah setiap bilangan versi dipertingkat yang dijana oleh sampel label;  ialah parameter dalam fungsi MixMatch. Untuk setiap

ialah parameter dalam fungsi MixMatch. Untuk setiap  , MixMatch menjana K versi dipertingkatkan,

, MixMatch menjana K versi dipertingkatkan,  bersamaan dengan k hingga 1, ...., K versi dipertingkatkan

bersamaan dengan k hingga 1, ...., K versi dipertingkatkan  dan model meneka label pseudo berdasarkan nilai purata

dan model meneka label pseudo berdasarkan nilai purata  .

.

Rajah 13: Diagram dua penambahbaikan kaedah ReMixMatch kepada MixMatch kaedah Tunjukkan. (Sumber imej: kertas kerja 2020 Berthelot et al. "ReMixMatch: Pembelajaran separuh seliaan menggunakan penjajaran pengedaran dan penambat yang dipertingkatkan")

Rajah 13: Diagram dua penambahbaikan kaedah ReMixMatch kepada MixMatch kaedah Tunjukkan. (Sumber imej: kertas kerja 2020 Berthelot et al. "ReMixMatch: Pembelajaran separuh seliaan menggunakan penjajaran pengedaran dan penambat yang dipertingkatkan")  menjadi purata bergerak bagi pengedaran kelas yang diramalkan pada data tidak berlabel. Ramalan model untuk sampel tidak berlabel

menjadi purata bergerak bagi pengedaran kelas yang diramalkan pada data tidak berlabel. Ramalan model untuk sampel tidak berlabel  dinormalkan kepada

dinormalkan kepada  untuk memadankan taburan marginal sebenar.

untuk memadankan taburan marginal sebenar.

Adalah penting untuk ambil perhatian bahawa pengurangan entropi bukanlah matlamat yang berguna jika taburan marginal tidak konsisten. Selain itu, andaian bahawa pengedaran kelas pada data berlabel dan tidak berlabel sepadan antara satu sama lain sememangnya terlalu mutlak dan mungkin tidak semestinya betul dalam tetapan dunia sebenar.

Adalah penting untuk ambil perhatian bahawa pengurangan entropi bukanlah matlamat yang berguna jika taburan marginal tidak konsisten. Selain itu, andaian bahawa pengedaran kelas pada data berlabel dan tidak berlabel sepadan antara satu sama lain sememangnya terlalu mutlak dan mungkin tidak semestinya betul dalam tetapan dunia sebenar.

(2) DivideMix

(iaitu, kebarangkalian sampel tergolong dalam set sampel bersih) adalah lebih besar daripada ambang, sampel dianggap sampel bersih, jika tidak, ia dianggap bunyi bising. sampel.

(iaitu, kebarangkalian sampel tergolong dalam set sampel bersih) adalah lebih besar daripada ambang, sampel dianggap sampel bersih, jika tidak, ia dianggap bunyi bising. sampel.

dengan gabungan ramalan rangkaian

dengan gabungan ramalan rangkaian  , dengan

, dengan  ialah purata daripada berbilang versi dipertingkatkan

ialah purata daripada berbilang versi dipertingkatkan  dengan syarat rangkaian lain menghasilkan kebarangkalian set data yang bersih

dengan syarat rangkaian lain menghasilkan kebarangkalian set data yang bersih  .

.

(3) FixMatch

ialah label pseudo bagi sampel tidak berlabel;

ialah label pseudo bagi sampel tidak berlabel;  ialah hiperparameter yang menentukan saiz relatif

ialah hiperparameter yang menentukan saiz relatif  dan

dan  . Peningkatan lemah

. Peningkatan lemah  : Terjemahan standard dan peningkatan transformasi. Peningkatan kukuh

: Terjemahan standard dan peningkatan transformasi. Peningkatan kukuh  : Kaedah peningkatan data seperti AutoAugment, Cutout, RandAugment dan CTAugment.

: Kaedah peningkatan data seperti AutoAugment, Cutout, RandAugment dan CTAugment.

7 Digabungkan dengan pra-latihan yang berkuasa

. Rajah 19: Separa diselia Rangka kerja pembelajaran menggunakan korpora data tidak berlabel melalui pra-latihan tanpa pengawasan tugas-agnostik (kiri) dan latihan kendiri dan penyulingan khusus tugasan (kanan). (Sumber imej: kertas kerja 2020 Ting Chen et al. "Model penyeliaan kendiri berskala besar ialah pelajar separa penyeliaan yang berkuasa")

. Rajah 19: Separa diselia Rangka kerja pembelajaran menggunakan korpora data tidak berlabel melalui pra-latihan tanpa pengawasan tugas-agnostik (kiri) dan latihan kendiri dan penyulingan khusus tugasan (kanan). (Sumber imej: kertas kerja 2020 Ting Chen et al. "Model penyeliaan kendiri berskala besar ialah pelajar separa penyeliaan yang berkuasa")

Pembelajaran label untuk model yang lebih besar adalah lebih cekap;

Pembelajaran label untuk model yang lebih besar adalah lebih cekap; Rajah 20: Perbandingan prestasi SimCLRv2 + penyulingan separa diselia pada klasifikasi ImageNet. (Sumber imej: kertas kerja 2020 Ting Chen et al. "Model penyeliaan kendiri berskala besar ialah pelajar separa penyeliaan yang berkuasa")

Jika anda perlu memetik, sila nyatakan:

Atas ialah kandungan terperinci Penyelidik OpenAI: Cara melaksanakan pembelajaran diselia apabila data tidak mencukupi. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1371

1371

52

52

Kaedah apa yang digunakan untuk menukar rentetan ke dalam objek dalam vue.js?

Apr 07, 2025 pm 09:39 PM

Kaedah apa yang digunakan untuk menukar rentetan ke dalam objek dalam vue.js?

Apr 07, 2025 pm 09:39 PM

Apabila menukar rentetan ke objek dalam vue.js, json.parse () lebih disukai untuk rentetan json standard. Untuk rentetan JSON yang tidak standard, rentetan boleh diproses dengan menggunakan ungkapan biasa dan mengurangkan kaedah mengikut format atau url yang dikodkan. Pilih kaedah yang sesuai mengikut format rentetan dan perhatikan isu keselamatan dan pengekodan untuk mengelakkan pepijat.

Cara mengoptimumkan prestasi pangkalan data selepas pemasangan MySQL

Apr 08, 2025 am 11:36 AM

Cara mengoptimumkan prestasi pangkalan data selepas pemasangan MySQL

Apr 08, 2025 am 11:36 AM

Pengoptimuman prestasi MySQL perlu bermula dari tiga aspek: konfigurasi pemasangan, pengindeksan dan pengoptimuman pertanyaan, pemantauan dan penalaan. 1. Selepas pemasangan, anda perlu menyesuaikan fail my.cnf mengikut konfigurasi pelayan, seperti parameter innodb_buffer_pool_size, dan tutup query_cache_size; 2. Buat indeks yang sesuai untuk mengelakkan indeks yang berlebihan, dan mengoptimumkan pernyataan pertanyaan, seperti menggunakan perintah menjelaskan untuk menganalisis pelan pelaksanaan; 3. Gunakan alat pemantauan MySQL sendiri (ShowProcessList, ShowStatus) untuk memantau kesihatan pangkalan data, dan kerap membuat semula dan mengatur pangkalan data. Hanya dengan terus mengoptimumkan langkah -langkah ini, prestasi pangkalan data MySQL diperbaiki.

Cara Menggunakan MySQL Selepas Pemasangan

Apr 08, 2025 am 11:48 AM

Cara Menggunakan MySQL Selepas Pemasangan

Apr 08, 2025 am 11:48 AM

Artikel ini memperkenalkan operasi pangkalan data MySQL. Pertama, anda perlu memasang klien MySQL, seperti MySqlworkbench atau Command Line Client. 1. Gunakan perintah MySQL-Uroot-P untuk menyambung ke pelayan dan log masuk dengan kata laluan akaun root; 2. Gunakan CreateTatabase untuk membuat pangkalan data, dan gunakan Pilih pangkalan data; 3. Gunakan createtable untuk membuat jadual, menentukan medan dan jenis data; 4. Gunakan InsertInto untuk memasukkan data, data pertanyaan, kemas kini data dengan kemas kini, dan padam data dengan padam. Hanya dengan menguasai langkah -langkah ini, belajar menangani masalah biasa dan mengoptimumkan prestasi pangkalan data anda boleh menggunakan MySQL dengan cekap.

Geospatial Laravel: Pengoptimuman peta interaktif dan sejumlah besar data

Apr 08, 2025 pm 12:24 PM

Geospatial Laravel: Pengoptimuman peta interaktif dan sejumlah besar data

Apr 08, 2025 pm 12:24 PM

Cecair memproses 7 juta rekod dan membuat peta interaktif dengan teknologi geospatial. Artikel ini meneroka cara memproses lebih dari 7 juta rekod menggunakan Laravel dan MySQL dan mengubahnya menjadi visualisasi peta interaktif. Keperluan Projek Cabaran Awal: Ekstrak Wawasan berharga menggunakan 7 juta rekod dalam pangkalan data MySQL. Ramai orang mula -mula mempertimbangkan bahasa pengaturcaraan, tetapi mengabaikan pangkalan data itu sendiri: Bolehkah ia memenuhi keperluan? Adakah penghijrahan data atau pelarasan struktur diperlukan? Bolehkah MySQL menahan beban data yang besar? Analisis awal: Penapis utama dan sifat perlu dikenalpasti. Selepas analisis, didapati bahawa hanya beberapa atribut yang berkaitan dengan penyelesaiannya. Kami mengesahkan kemungkinan penapis dan menetapkan beberapa sekatan untuk mengoptimumkan carian. Carian Peta Berdasarkan Bandar

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Terdapat banyak sebab mengapa permulaan MySQL gagal, dan ia boleh didiagnosis dengan memeriksa log ralat. Penyebab umum termasuk konflik pelabuhan (periksa penghunian pelabuhan dan ubah suai konfigurasi), isu kebenaran (periksa keizinan pengguna yang menjalankan perkhidmatan), ralat fail konfigurasi (periksa tetapan parameter), rasuah direktori data (memulihkan data atau membina semula ruang meja), isu ruang jadual InnoDB (semak fail ibdata1) Apabila menyelesaikan masalah, anda harus menganalisisnya berdasarkan log ralat, cari punca utama masalah, dan mengembangkan tabiat sandaran data secara teratur untuk mencegah dan menyelesaikan masalah.

Kunci utama MySQL boleh menjadi batal

Apr 08, 2025 pm 03:03 PM

Kunci utama MySQL boleh menjadi batal

Apr 08, 2025 pm 03:03 PM

Kunci utama MySQL tidak boleh kosong kerana kunci utama adalah atribut utama yang secara unik mengenal pasti setiap baris dalam pangkalan data. Jika kunci utama boleh kosong, rekod tidak dapat dikenal pasti secara unik, yang akan membawa kepada kekeliruan data. Apabila menggunakan lajur integer sendiri atau UUIDs sebagai kunci utama, anda harus mempertimbangkan faktor-faktor seperti kecekapan dan penghunian ruang dan memilih penyelesaian yang sesuai.

Jurutera Backend Senior Remote (Platform) memerlukan kalangan

Apr 08, 2025 pm 12:27 PM

Jurutera Backend Senior Remote (Platform) memerlukan kalangan

Apr 08, 2025 pm 12:27 PM

Jurutera Backend Senior Remote Company Kekosongan Syarikat: Lokasi Lokasi: Jauh Pejabat Jauh Jenis: Gaji sepenuh masa: $ 130,000- $ 140,000 Penerangan Pekerjaan Mengambil bahagian dalam penyelidikan dan pembangunan aplikasi mudah alih Circle dan ciri-ciri berkaitan API awam yang meliputi keseluruhan kitaran hayat pembangunan perisian. Tanggungjawab utama kerja pembangunan secara bebas berdasarkan rubyonrails dan bekerjasama dengan pasukan react/redux/relay front-end. Membina fungsi teras dan penambahbaikan untuk aplikasi web dan bekerjasama rapat dengan pereka dan kepimpinan sepanjang proses reka bentuk berfungsi. Menggalakkan proses pembangunan positif dan mengutamakan kelajuan lelaran. Memerlukan lebih daripada 6 tahun backend aplikasi web kompleks

Penyelesaian kepada perkhidmatan yang tidak dapat dimulakan selepas pemasangan MySQL

Apr 08, 2025 am 11:18 AM

Penyelesaian kepada perkhidmatan yang tidak dapat dimulakan selepas pemasangan MySQL

Apr 08, 2025 am 11:18 AM

MySQL enggan memulakan? Jangan panik, mari kita periksa! Ramai kawan mendapati bahawa perkhidmatan itu tidak dapat dimulakan selepas memasang MySQL, dan mereka sangat cemas! Jangan risau, artikel ini akan membawa anda untuk menangani dengan tenang dan mengetahui dalang di belakangnya! Selepas membacanya, anda bukan sahaja dapat menyelesaikan masalah ini, tetapi juga meningkatkan pemahaman anda tentang perkhidmatan MySQL dan idea anda untuk masalah penyelesaian masalah, dan menjadi pentadbir pangkalan data yang lebih kuat! Perkhidmatan MySQL gagal bermula, dan terdapat banyak sebab, mulai dari kesilapan konfigurasi mudah kepada masalah sistem yang kompleks. Mari kita mulakan dengan aspek yang paling biasa. Pengetahuan asas: Penerangan ringkas mengenai proses permulaan perkhidmatan MySQL Startup. Ringkasnya, sistem operasi memuatkan fail yang berkaitan dengan MySQL dan kemudian memulakan daemon MySQL. Ini melibatkan konfigurasi

ialah perwakilan satu-panas bagi teg sebenar. Set data tidak berlabel.

ialah perwakilan satu-panas bagi teg sebenar. Set data tidak berlabel.

, maka Lakukan pemprosesan topeng.

, maka Lakukan pemprosesan topeng.  dalam Softmax untuk menajamkan taburan kebarangkalian ramalan.

dalam Softmax untuk menajamkan taburan kebarangkalian ramalan.