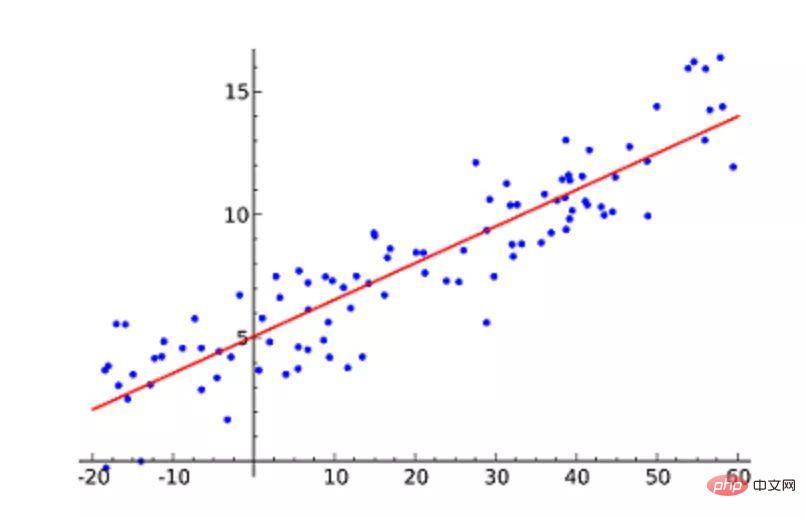

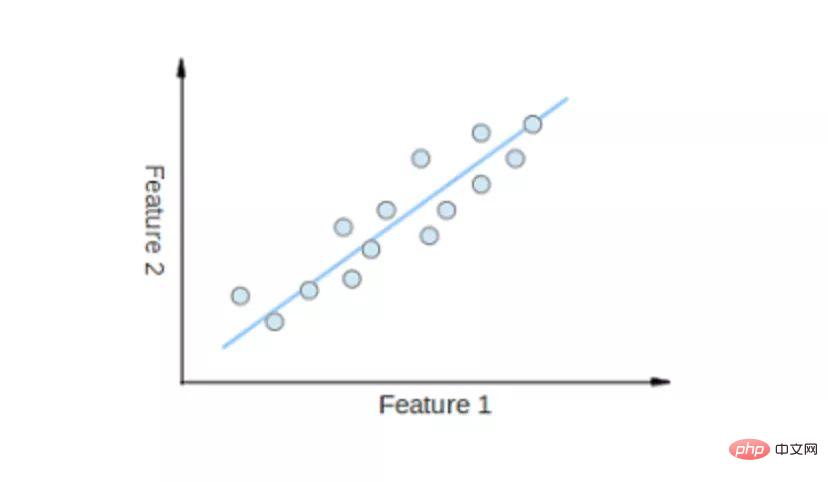

Regression Linear mungkin merupakan algoritma pembelajaran mesin yang paling popular. Regresi linear adalah untuk mencari garis lurus dan menjadikan garis lurus ini sesuai dengan titik data dalam plot serakan sedekat mungkin. Ia cuba mewakili pembolehubah tidak bersandar (nilai x) dan keputusan berangka (nilai y) dengan memasangkan persamaan garis lurus kepada data ini. Baris ini kemudiannya boleh digunakan untuk meramalkan nilai masa hadapan!

Teknik yang paling biasa digunakan untuk algoritma ini ialah kaedah kuasa dua terkecil. Kaedah ini mengira garisan yang paling sesuai yang meminimumkan jarak serenjang dari setiap titik data pada garisan. Jumlah jarak ialah jumlah kuasa dua jarak menegak (garis hijau) semua titik data. Ideanya adalah untuk menyesuaikan model dengan meminimumkan ralat kuasa dua atau jarak ini.

Contohnya, regresi linear mudah, yang mempunyai satu pembolehubah tidak bersandar (paksi-x) dan satu pembolehubah bersandar (paksi-y).

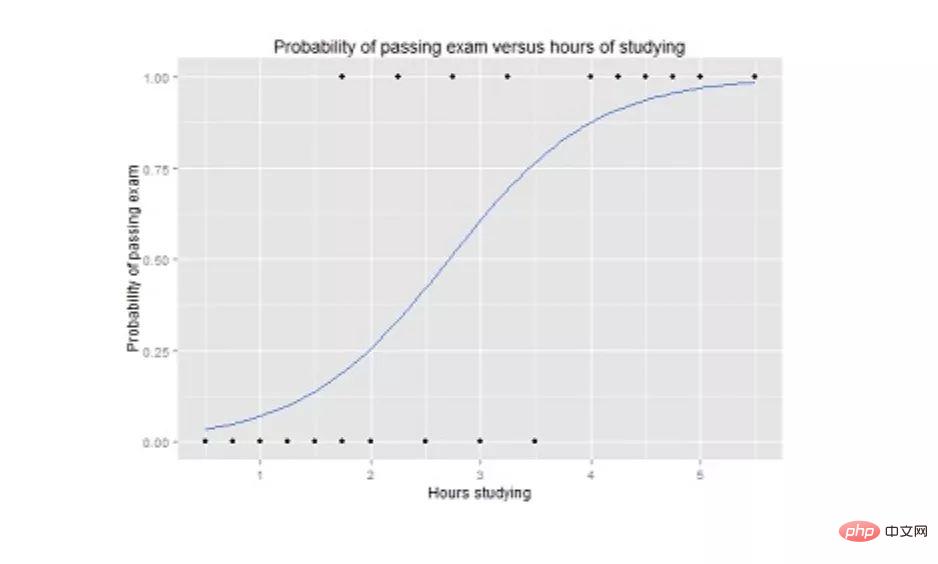

Regresi logistik adalah serupa dengan regresi linear, tetapi ia digunakan apabila output adalah binari (iaitu, apabila hasilnya hanya boleh mempunyai dua nilai yang mungkin). Ramalan keluaran akhir ialah fungsi sigmoid tak linear yang dipanggil fungsi logistik, g().

Fungsi logistik ini memetakan nilai hasil perantaraan kepada pembolehubah hasil Y, yang nilainya berjulat dari 0 hingga 1. Nilai-nilai ini kemudiannya boleh ditafsirkan sebagai kebarangkalian Y berlaku. Sifat-sifat fungsi logistik sigmoid menjadikan regresi logistik lebih sesuai untuk tugas klasifikasi.

Graf regresi logistik yang menunjukkan kebarangkalian lulus peperiksaan sebagai fungsi masa belajar.

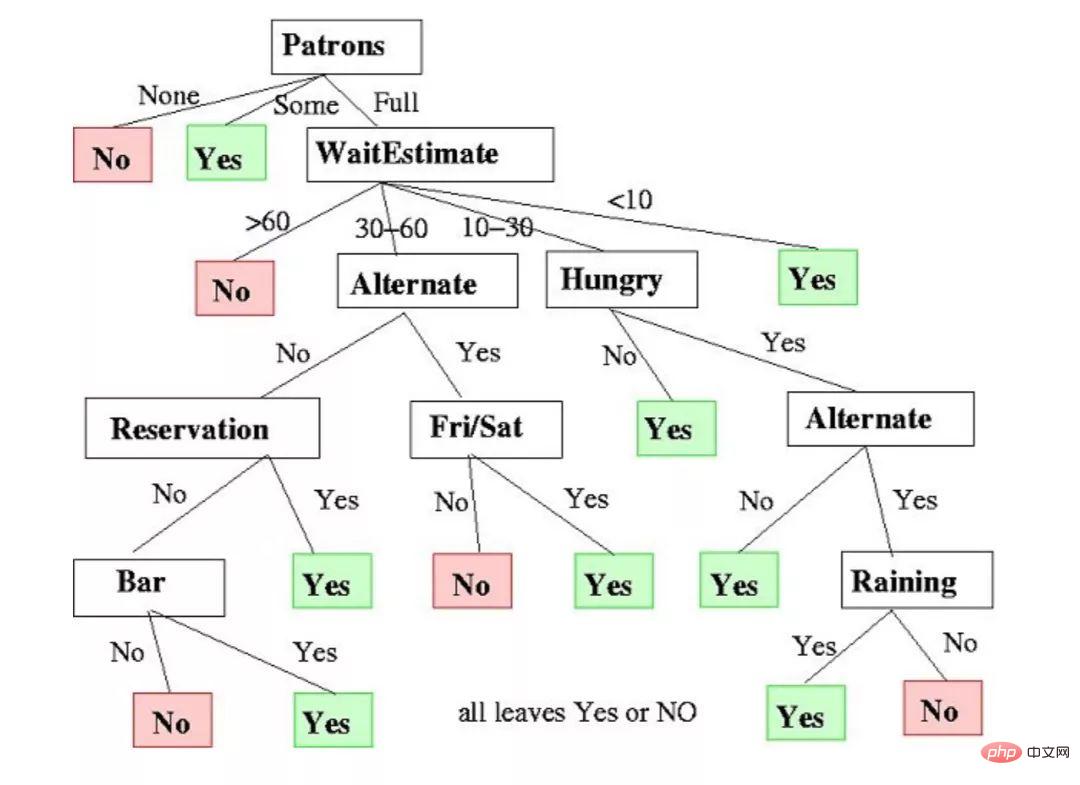

Pokok Keputusan boleh digunakan untuk tugasan regresi dan pengelasan.

Dalam algoritma ini, model latihan belajar untuk meramalkan nilai pembolehubah sasaran dengan mempelajari peraturan keputusan perwakilan pokok. Pokok terdiri daripada nod dengan atribut yang sepadan.

Di setiap nod, kami bertanya soalan tentang data berdasarkan ciri yang tersedia. Cabang kiri dan kanan mewakili jawapan yang mungkin. Nod akhir (iaitu nod daun) sepadan dengan nilai yang diramalkan.

Kepentingan setiap ciri ditentukan melalui pendekatan atas ke bawah. Semakin tinggi nod, semakin penting sifatnya.

Contoh pepohon keputusan untuk membuat keputusan sama ada untuk menunggu di restoran.

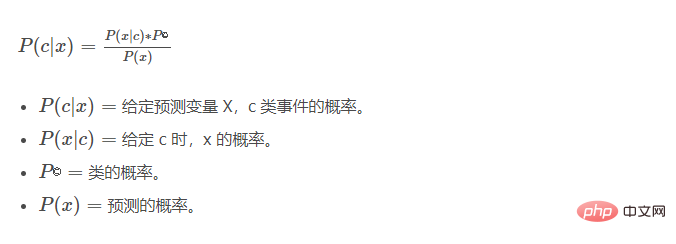

Naive Bayes (Naive Bayes) adalah berdasarkan teorem Bayes. Ia mengukur kebarangkalian setiap kelas, kebarangkalian bersyarat bagi setiap kelas diberi nilai x. Algoritma ini digunakan dalam masalah pengelasan dan menghasilkan keputusan ya/tidak binari. Lihat persamaan di bawah.

Pengkelas Naive Bayes ialah teknik statistik popular yang boleh digunakan untuk menapis spam!

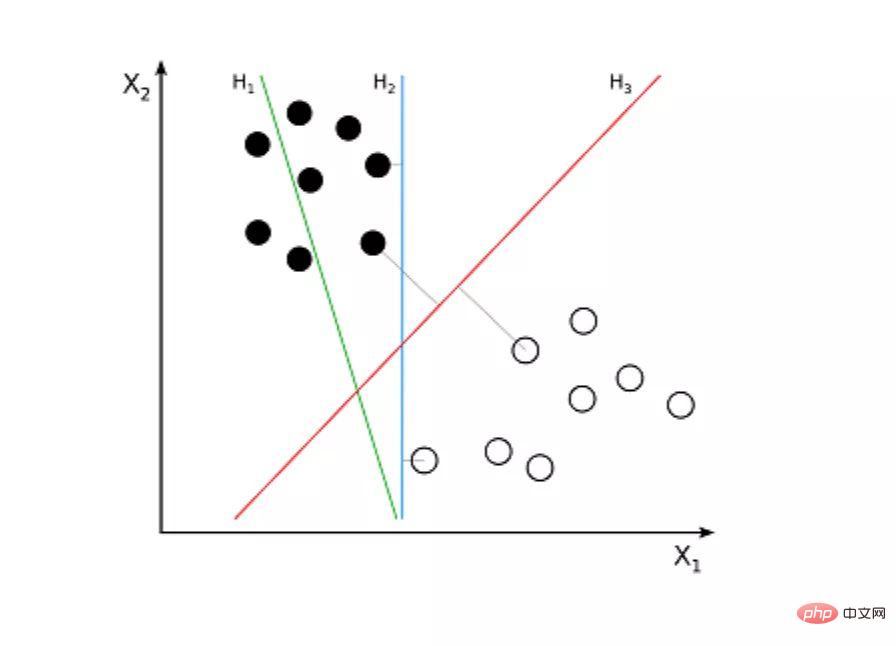

Mesin Vektor Sokongan (SVM) ialah algoritma yang diselia untuk masalah klasifikasi. Mesin vektor sokongan cuba melukis dua garisan antara titik data dengan margin terbesar di antaranya. Untuk melakukan ini, kami memplot item data sebagai titik dalam ruang dimensi n, dengan n ialah bilangan ciri input. Atas dasar ini, mesin vektor sokongan menemui sempadan optimum, dipanggil hyperplane, yang terbaik memisahkan kemungkinan keluaran mengikut label kelas.

Jarak antara hyperplane dan titik kelas terdekat dipanggil margin. Hyperplane optimum mempunyai margin terbesar yang mengklasifikasikan titik supaya jarak antara titik data terdekat dan dua kelas dimaksimumkan.

Sebagai contoh, H1 tidak memisahkan kedua-dua kelas ini. Tetapi H2 melakukannya, tetapi hanya dengan margin kecil. Dan H3 memisahkan mereka dengan margin terbesar.

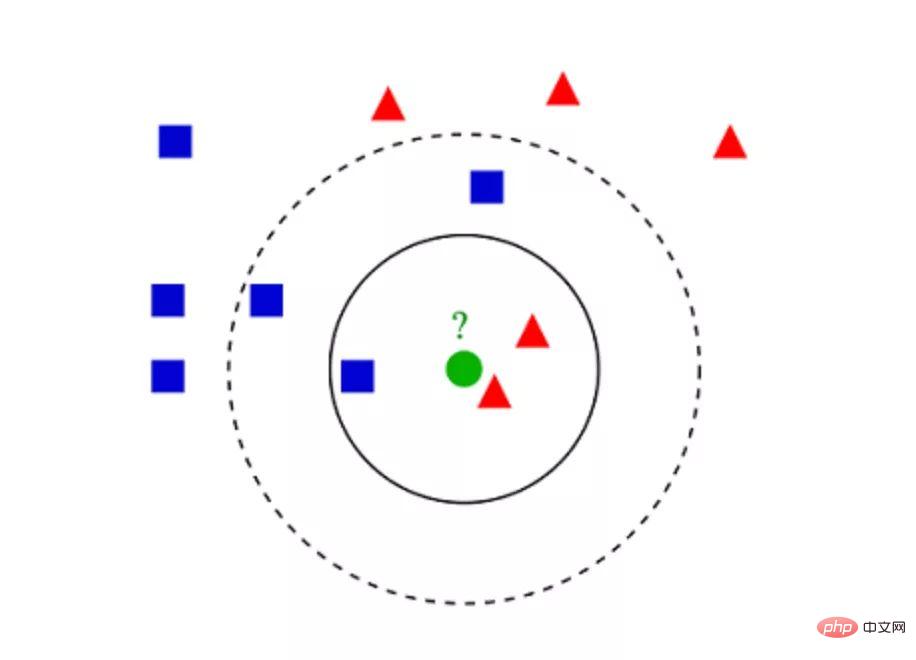

K-Nearest Neighbors (KNN) adalah sangat mudah. KNN mengelaskan objek dengan mencari keseluruhan set latihan untuk kejadian K yang paling serupa, atau jiran K, dan memberikan pembolehubah output biasa kepada semua kejadian K ini.

Pilihan K adalah kritikal: nilai yang lebih kecil mungkin memberikan banyak bunyi dan hasil yang tidak tepat, manakala nilai yang lebih besar tidak boleh dilaksanakan. Ia paling biasa digunakan untuk pengelasan, tetapi juga sesuai untuk masalah regresi.

Jarak yang digunakan untuk menilai persamaan antara kejadian boleh menjadi jarak Euclidean, jarak Manhattan atau jarak Minkowski. Jarak Euclidean ialah jarak garis lurus biasa antara dua titik. Ia sebenarnya punca kuasa dua jumlah perbezaan kuasa dua dalam koordinat titik.

▲Contoh klasifikasi KNN

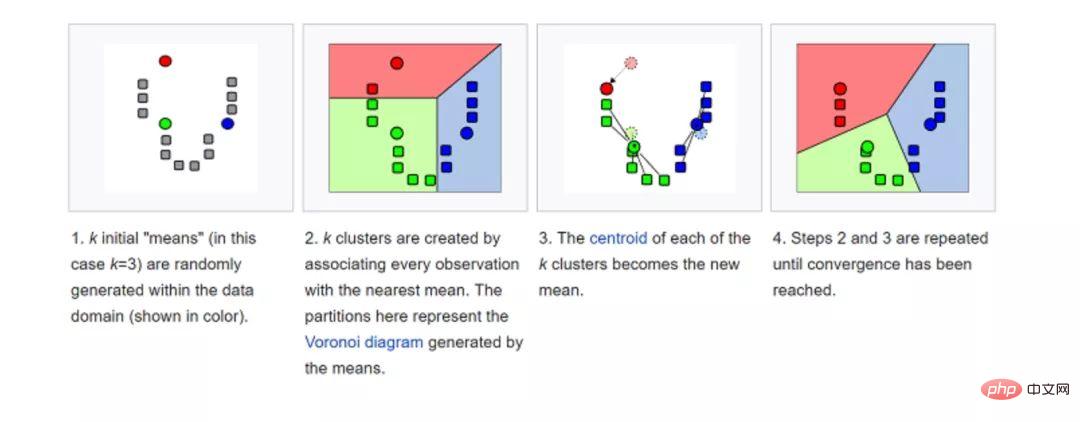

K-means (K-means) dilakukan pada set data Dikelaskan kepada kelompok. Sebagai contoh, algoritma ini boleh digunakan untuk mengumpulkan pengguna berdasarkan sejarah pembelian. Ia menemui kluster K dalam set data. K-means digunakan untuk pembelajaran tanpa pengawasan, jadi kita hanya perlu menggunakan data latihan X dan bilangan kelompok yang ingin kita kenal pasti K.

Algoritma secara berulang memperuntukkan setiap titik data kepada salah satu kumpulan K berdasarkan cirinya. Ia memilih titik K untuk setiap kelompok K (dipanggil centroid). Berdasarkan persamaan, titik data baharu ditambahkan pada gugusan dengan centroid terdekat. Proses ini berterusan sehingga pusat jisim berhenti berubah.

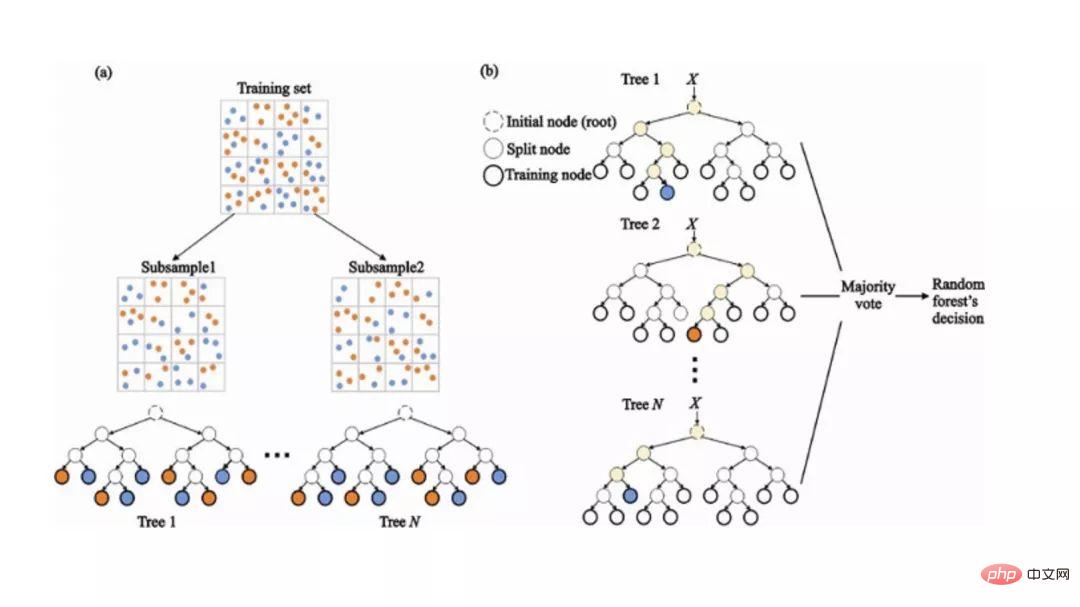

Random Forest ialah algoritma pembelajaran mesin ensemble yang sangat popular. Idea asas algoritma ini adalah bahawa pendapat ramai orang lebih tepat daripada pendapat satu individu. Dalam hutan rawak, kami menggunakan ensemble pokok keputusan (lihat Pokok Keputusan).

Untuk mengklasifikasikan objek baharu, kami mengambil undian daripada setiap pokok keputusan dan menggabungkan keputusan sebelum membuat keputusan muktamad berdasarkan undian majoriti.

Semasa proses latihan, setiap pepohon keputusan dibina berdasarkan sampel bootstrap set latihan.

Semasa proses pengelasan, keputusan tentang contoh input dibuat berdasarkan undian majoriti.

Masalah pembelajaran mesin menjadi lebih kompleks disebabkan oleh jumlah data yang dapat kami tangkap hari ini. Ini bermakna latihan adalah sangat perlahan dan mencari penyelesaian yang baik adalah sukar. Masalah ini sering dipanggil "kutukan dimensi".

Pengurangan dimensi cuba menyelesaikan masalah ini dengan menggabungkan ciri khusus ke dalam ciri peringkat lebih tinggi tanpa kehilangan maklumat yang paling penting. Analisis Komponen Utama (PCA) ialah teknik pengurangan dimensi yang paling popular.

Analisis komponen utama mengurangkan dimensi set data dengan memampatkannya ke dalam garisan dimensi rendah atau hyperplanes/subruang. Ini mengekalkan sebanyak mungkin ciri penting data asal.

Contoh pengurangan dimensi boleh dicapai dengan menganggarkan semua titik data kepada garis lurus.

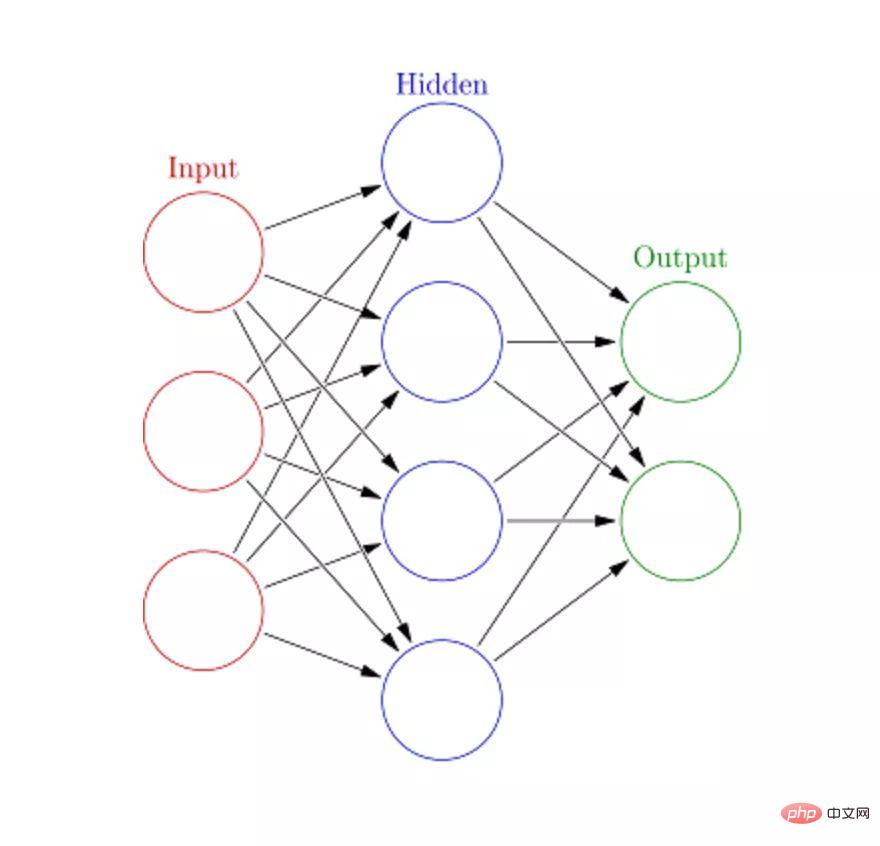

Rangkaian Neural Buatan (ANN) boleh mengendalikan tugas pembelajaran mesin yang besar dan kompleks. Rangkaian saraf pada asasnya adalah satu set lapisan yang saling berkaitan yang terdiri daripada tepi dan nod berwajaran, dipanggil neuron. Di antara lapisan input dan lapisan output, kita boleh memasukkan berbilang lapisan tersembunyi. Rangkaian saraf tiruan menggunakan dua lapisan tersembunyi. Selain itu, pembelajaran mendalam perlu ditangani.

Prinsip kerja rangkaian saraf tiruan adalah serupa dengan struktur otak. Sekumpulan neuron diberi pemberat rawak untuk menentukan cara neuron memproses data input. Hubungan antara input dan output dipelajari dengan melatih rangkaian saraf pada data input. Semasa fasa latihan, sistem mempunyai akses kepada jawapan yang betul.

Jika rangkaian tidak dapat mengecam input dengan tepat, sistem akan melaraskan pemberat. Selepas latihan yang mencukupi, ia akan secara konsisten mengenali corak yang betul.

Setiap nod bulat mewakili neuron buatan, dan anak panah mewakili sambungan daripada output satu neuron buatan ke input yang lain.

Apa yang seterusnya? Kini, anda telah mempelajari asas algoritma pembelajaran mesin yang paling popular. Anda sudah bersedia untuk mempelajari konsep yang lebih kompleks dan juga melaksanakannya melalui amalan praktikal yang mendalam. Jika anda ingin mempelajari cara melaksanakan algoritma ini, kursus Sains Data Grokking Educative menggunakan teori-teori menarik ini untuk aplikasi dunia sebenar yang jelas.

Semoga anda selamat belajar!

Atas ialah kandungan terperinci Sepuluh algoritma teratas yang anda mesti ketahui dan ketahui tentang pembelajaran mesin!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!