Peranti teknologi

Peranti teknologi

AI

AI

ChiQA - set data soalan dan jawapan bergambar berdasarkan 200,000 soalan pengguna sebenar

ChiQA - set data soalan dan jawapan bergambar berdasarkan 200,000 soalan pengguna sebenar

ChiQA - set data soalan dan jawapan bergambar berdasarkan 200,000 soalan pengguna sebenar

Dalam beberapa tahun kebelakangan ini, dengan perkembangan pesat teknologi soal jawab dan teknologi pemahaman pelbagai mod, tugasan menjawab soalan visual (Visual Question Answering) telah menjadi semakin popular. Set data menjawab soalan visual berskala besar seperti VQA, CLEVER dan Visual-7W telah dikeluarkan satu demi satu, yang telah menggalakkan perkembangan berulang tugas menjawab soalan visual. Walau bagaimanapun, kebanyakan data menjawab soalan visual semasa adalah soalan yang disintesis secara buatan, seperti "Apakah warna matanya yang direka bentuk secara rekaan oleh anotasi selepas melihat gambar itu?" Data yang dijana secara manual akan menjadi agak mudah, berkualiti rendah dan malah berat sebelah. Oleh itu, dalam kerja ini, kami mencadangkan set data soalan dan jawapan imej berasaskan Cina berskala besar: ChiQA berdasarkan soalan sebenar daripada pengguna dalam pelayar QQ.

ChiQA mengandungi lebih 40,000 pertanyaan pengguna sebenar dan lebih 200,000 pasangan imej soalan. Data dan beberapa model asas telah diterbitkan di GitHub. Penyelidikan yang berkaitan telah diterima ke dalam artikel panjang CIKM2022.

Alamat kertas: https://arxiv.org/abs/2208.03030

Alamat Github: https://github.com/benywon/ChiQA

Perbandingan tugasan menjawab soalan mod tunggal

Tiga ciri penting bagi ChiQA

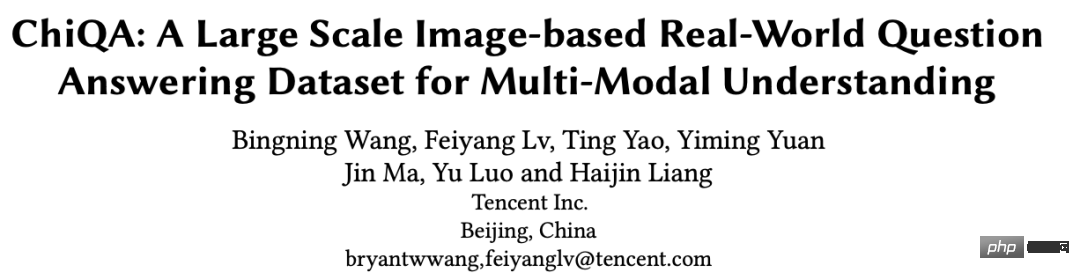

Menjawab Soalan ialah salah satu tugas yang sangat penting dalam kecerdasan buatan dan pemprosesan bahasa pintar. Dalam beberapa tahun kebelakangan ini, dengan keluaran set data berskala besar (seperti SQuAD, NaturalQuestions) dan pengenalan model bahasa pra-latihan berskala besar (seperti BERT, GPT), tugasan soal jawab telah berkembang pesat. Walau bagaimanapun, kebanyakan tugasan menjawab soalan semasa adalah unimodal, iaitu soalan, sumber dan jawapan semuanya berasaskan teks. Walau bagaimanapun, dari perspektif kecerdasan kognitif dan aplikasi praktikal, sumber pelbagai modal seperti imej selalunya boleh memberikan maklumat dan jawapan yang lebih kaya. Contohnya, untuk soalan: Apakah dimensi iPhone13? Carta perbandingan saiz untuk model iPhone13 yang berbeza akan menjadi lebih jelas dan intuitif. Terdapat juga beberapa contoh seperti yang ditunjukkan di bawah:

Rajah 1: Beberapa contoh di mana gambar sesuai untuk menjawab soalan pengguna

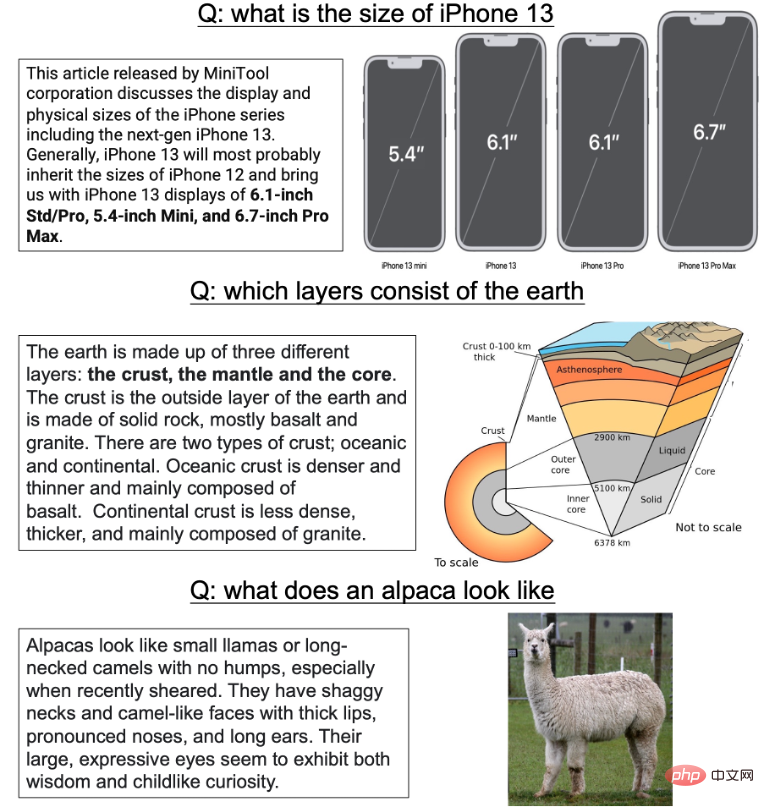

Dalam beberapa tahun kebelakangan ini, data soal jawab dan tugasan untuk pemahaman pelbagai modal telah dicadangkan satu demi satu. Seperti VQA1.0 dan 2.0, CLEVR, GQA, dsb. Dalam kebanyakan set data soalan dan jawapan imej, sistem menyediakan beberapa imej yang dijana secara buatan atau sebenar kepada anotor, dan anotor perlu menulis beberapa soalan secara manual yang menyasarkan atribut atau entiti tertentu. Walau bagaimanapun, proses pengumpulan data ini pasti mempunyai banyak kelemahan:

1) Semua soalan adalah bergantung kepada imej, iaitu, anotasi bertanya kepada mereka selepas melihat soalan bergambar. Dalam proses pembinaan data berskala besar, soalan yang dijana secara buatan selalunya tidak mempunyai kepelbagaian dan sering berat sebelah disebabkan oleh faktor subjektif penganotasi. Model yang dilatih mengenai data jenis ini yang melihat sumber dahulu dan kemudian bertanya soalan selalunya boleh mencapai keputusan yang sangat baik dengan melihat soalan tanpa melihat sumber latar belakang; Kedua, dalam data tradisional Dalam VQA, jawapannya selalunya merupakan entiti yang ringkas, perhubungan atau penerangan ringkas tentang kawasan tertentu. Walau bagaimanapun, untuk tugasan soalan dan jawapan imej sebenar, banyak jawapan teks yang tidak diperlukan Contohnya, untuk soalan: "Apakah rupa alpaca yang memberikan jawapan panjang yang menerangkan rupa alpaca adalah sangat berlebihan. Kedua, perihalan entiti pendek seperti ini sering menyebabkan anotasi hanya memberi perhatian kepada perhubungan tempatan dan kurang memberi perhatian kepada beberapa maklumat tentang struktur keseluruhan yang sebenar; sebelumnya Sumber cenderung menumpukan pada bahasa Inggeris, dengan data soalan dan jawapan imej yang sangat sedikit dalam domain bahasa Cina.

Dalam kerja ini, sebagai tindak balas kepada masalah di atas, kami mencadangkan set data soalan dan jawapan imej Cina berskala besar - ChiQA (Chinese Image Question Answering). Kami bermula dengan istilah carian sebenar pengguna dalam penyemak imbas QQ mudah alih, mendapatkan beberapa gambar berkaitan melalui API tertentu, dan kemudian menyerahkan gambar kepada anotor terlatih secara profesional untuk anotasi tiga peringkat untuk menunjukkan sama ada gambar itu boleh menjawab soalan dengan sempurna ( 2 mata ), sebahagiannya dijawab (1 mata), dan tidak dapat menjawab (0 mata) soalan pengguna. Untuk ChiQA, terdapat tiga ciri yang ketara:

- Soalan sebenar, gambar sebenar: Gambar dalam ChiQA datang daripada pertanyaan pengguna rawak. Pertanyaan ini adalah pertanyaan pengguna rawak dalam domain terbuka Pertanyaan ini sangat pelbagai, dan pengedaran domain pertanyaan adalah sangat luas. Pertanyaan kepelbagaian rawak sedemikian memastikan bahawa soalan dalam data kami tidak akan berat sebelah; Dalam ChiQA kami tidak memerlukan anotasi untuk memberikan jawapan akhir: ini selalunya memperkenalkan beberapa berat sebelah tambahan, seperti akal sehat annotator. Sebaliknya, kami memberi tumpuan kepada kebolehjawaban, iaitu sama ada imej boleh menjawab soalan. Kebolehjawaban ini membolehkan pencatat ChiQA memahami kedua-dua pertanyaan dan imej; soalan sering muncul berkali-kali, dan soalan bercorak mudah ini akan menduduki majoriti dalam data, menyebabkan berat sebelah dalam pemahaman merentas mod sebenar data. Oleh itu, kami memperkenalkan proses pembelajaran aktif dua peringkat dalam proses pengumpulan data Selepas anotasi pertanyaan rawak selesai pada peringkat pertama, kami melatih model mudah, dan kemudian menggunakan model ini untuk memilih beberapa model "lebih sukar", dengan itu Jadikan. kekayaan dan kesukaran data dalam data anotasi peringkat kedua secara relatifnya lebih tinggi.

- Rajah 2: Perbandingan antara ChiQA dan beberapa data soalan dan jawapan imej lain dalam industri

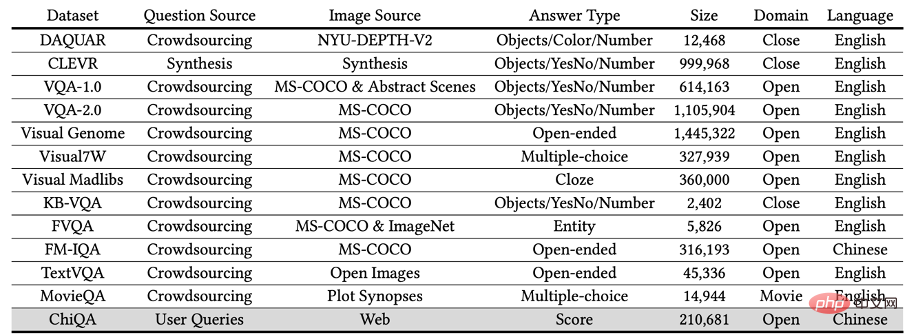

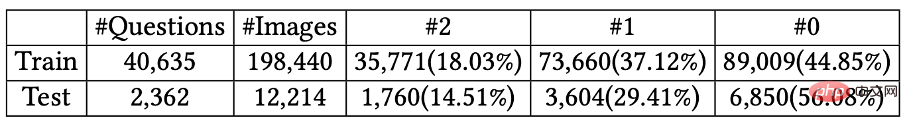

Akhirnya kami mengumpul lebih daripada 40,000 soalan, setiap soalan mempunyai kira-kira 5 gambar yang berkaitan, iaitu sejumlah lebih daripada 200,000 pasangan gambar soalan. Setiap soalan mempunyai beberapa gambar, dan kami menjaringkan setiap gambar pada skala tiga langkah 2-1-0. Beberapa contoh dalam ChiQA ditunjukkan di bawah:

Gamb : Contoh beberapa sampel dalam ChiQA.

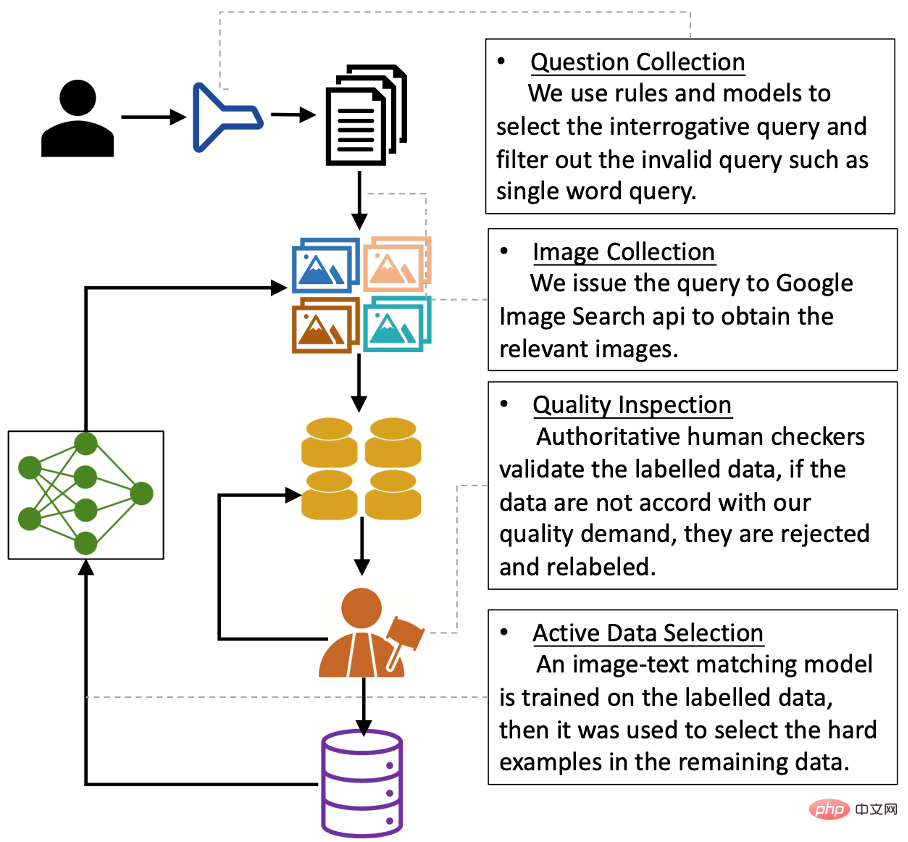

Pengumpulan data: Semua soalan datang daripada pertanyaan pengguna sebenar Keseluruhan proses pengumpulan data boleh dibahagikan kepada empat langkah Carta alir keseluruhan adalah seperti berikut :

Rajah 4: Proses pengumpulan data

Jadi kita perlu menapis pertanyaan terlebih dahulu dengan niat soal jawab. Dalam kerja ini, kami menggunakan kaedah penyeliaan lemah yang dibina secara dalaman untuk melatih pengelas binari bagi menentukan sama ada pertanyaan mempunyai niat menjawab soalan. Penilaian manusia terhadap model niat ini dapat mencapai 90% ketepatan dan 80% ingat kembali. Kami menggunakan model ini untuk sampel pertanyaan pengguna dan memperoleh kira-kira 75,000 pertanyaan pengguna yang dinilai oleh model mempunyai niat Soal Jawab dan memasuki pusingan seterusnya.

Pengumpulan imej & proses dan pengalaman anotasi

Selepas mendapat soalan, kami menghantar soalan ini ke API terbuka yang disediakan oleh Google (Google Images API - SerpApi) untuk mendapatkan semula imej yang berkaitan. API Google mengembalikan 100 imej yang paling berkaitan untuk setiap pertanyaan. Untuk memastikan kualiti data akhir, kami mengalih keluar pertanyaan yang panjang atau lebarnya kurang daripada 200 piksel dan imej yang terlalu panjang atau terlalu lebar.

Selepas mendapat imej asal, kami mengambil 5 imej ditapis pertama dan meminta anotasi untuk menjelaskan pertanyaan ini dan 5 imej yang sepadan. Kami telah mereka bentuk antara muka anotasi khusus untuk tugasan ini, seperti yang ditunjukkan dalam rajah di bawah.

Rajah 5: Antara muka anotasi ChiQA

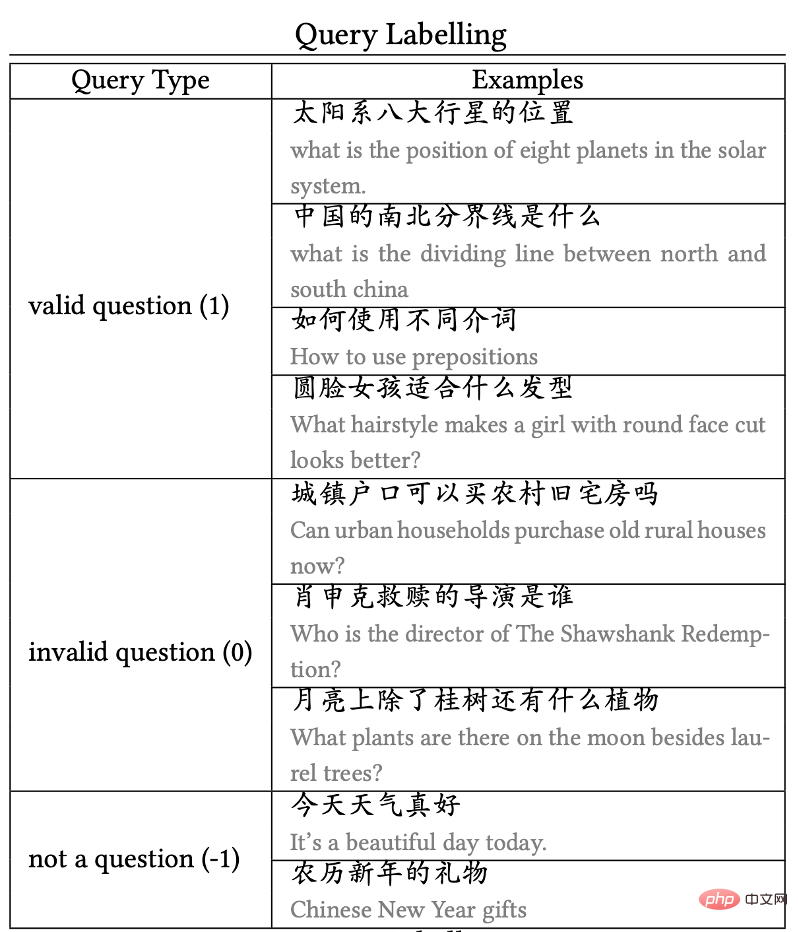

Semasa proses anotasi , kami meminta anotor untuk menandakan tiga aspek:

1) Anotasi masalah

Memandangkan kerja ini tertumpu pada Gambar Soal Jawab, sebenarnya, banyak soalan pengguna biasa tiada kaitan dengan Soal Jawab gambar (atau sukar dijawab dengan gambar). Oleh itu, kami terlebih dahulu meminta annotator untuk menandakan sama ada soalan ini boleh dianggap sebagai soalan soalan dan jawapan imej. Contohnya:

Jika soalan ialah "perbezaan antara xxx dan xxx", maka soalan ini akan dianggap sebagai soalan dengan niat soalan dan jawapan imej

Jika sesuatu soalan kabur, samar-samar, atau mengandungi inferens yang tidak berdasarkan fakta, maka soalan itu akan diklasifikasikan sebagai tidak mempunyai niat Soal Jawab imej dan tidak akan mengambil bahagian dalam proses anotasi imej seterusnya.

Beberapa contoh anotasi pertanyaan ditunjukkan dalam Rajah 6:

Rajah 6: Contoh daripada anotasi pertanyaan

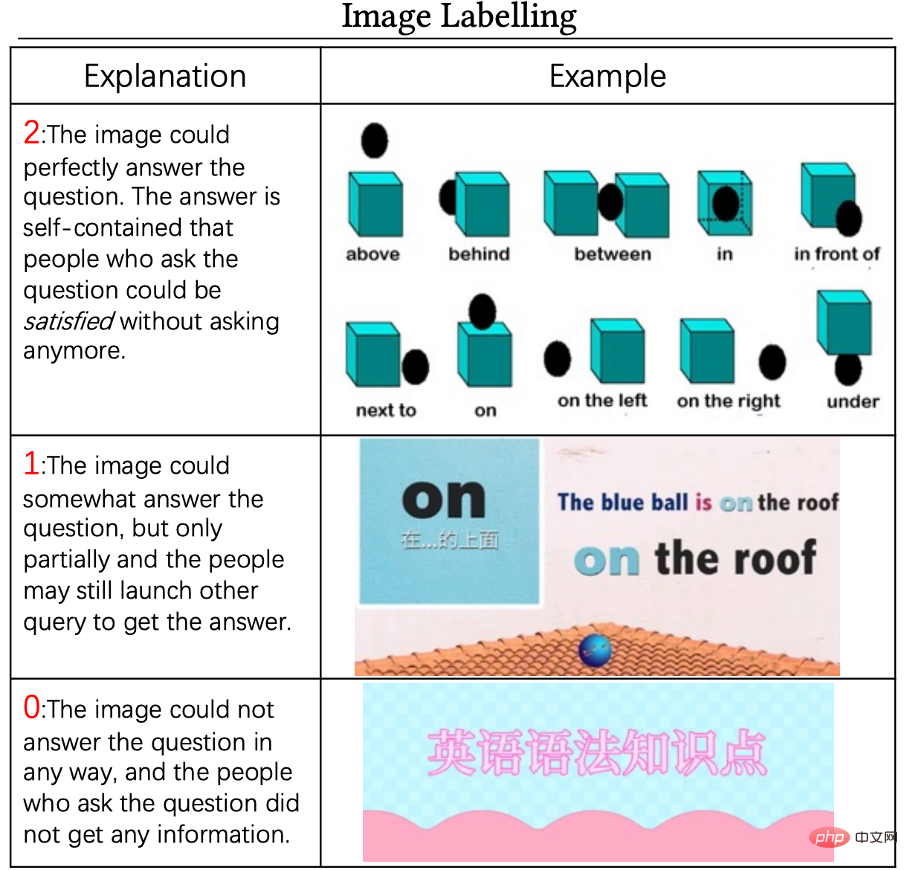

2) Anotasi imej

Untuk pertanyaan yang sah dalam langkah sebelumnya, kami Labelkan 5 pertanyaan calonnya. Piawaian anotasi ialah anotasi 0-1-2 tiga peringkat, di mana:

Skor 0 bermakna imej tidak boleh digunakan untuk menjawab soalan ini sama sekali dan skor 2 bermakna kualiti imej boleh diterima dan boleh digunakan sepenuhnya. Jawab soalan ini secara bebas. Gambar dengan skor 1 berada di antara keduanya, yang bermaksud bahawa gambar itu berkaitan dengan pertanyaan, tetapi ia tidak boleh dijawab secara langsung. Pengguna mungkin memerlukan lebih banyak pertanyaan atau alasan untuk mendapatkan jawapan akhir. Beberapa contoh 0 mata, 1 mata dan 2 mata ditunjukkan dalam rajah di bawah:

Rajah 7: Untuk soalan " Cara menggunakan preposisi berbeza" ”, Contoh anotasi imej dan pemarkahan

3) Kawalan kualiti

Kami berada dalam keseluruhan proses anotasi Program kawalan kualiti yang ketat diterima pakai. Khususnya, kami akan menjemput 3 pasukan berkualiti untuk menjalankan anotasi percubaan dan memilih pasukan yang mempunyai kualiti anotasi terbaik untuk menganotasi semua data yang tinggal. Kedua, semasa proses anotasi, kami akan membahagikan data beranotasi kepada kelompok Untuk setiap kumpulan data, kami akan mengambil sampel satu perlima daripada data untuk pengesahan manual Jika kadar lulus data kurang daripada 90%, maka ini batch Data akan dikembalikan dan dilabel semula sehingga ketepatan data mencapai 90%.

Anotasi data pembelajaran aktif

menjadikan keputusan lebih tidak berat sebelah

Selepas kerja pengumpulan data, kami mendapati bahawa jika data diambil secara rawak dan dilabelkan, selalunya terdapat beberapa corak ringkas, dan kehadiran corak mudah sedemikian dalam jumlah besar dalam data mungkin berat sebelah model akhir. Oleh itu, kami mereka bentuk proses anotasi pembelajaran yang aktif. Khususnya, kami mula-mula akan meminta anotasi untuk menganotasi kumpulan data Selepas anotasi kumpulan data ini selesai, kami akan menggunakan kumpulan data ini untuk melatih model padanan imej teks transmembran. Selepas model dilatih, kami mula menggunakan model ini untuk "memilih" sampel baharu: jika model itu sangat tidak pasti tentang ramalan sampel baharu ini (iaitu, entropi ramalan pengelasan akhir adalah sangat besar), maka kami fikir sampel ini agak sukar untuk model Oleh itu, terdapat kebarangkalian yang lebih tinggi untuk mengekalkannya sehingga pertengahan pusingan seterusnya kebarangkalian yang lebih kecil sehingga pusingan seterusnya.

Kami mendapati bahawa proses pemilihan data pembelajaran aktif sememangnya menjadikan set data lebih tidak berat sebelah. Kami mendapati bahawa data berlabel dari peringkat pertama mengandungi beberapa berat sebelah yang tidak dapat dilihat. Sebagai contoh, soalan yang mengandungi perkataan "Petua" ditandakan sebagai soalan yang sah, tetapi hampir semua imej yang sepadan ditandakan sebagai tidak boleh dijawab (iaitu, 0 mata, oleh itu, model mungkin meramalkan soalan akhir secara langsung berdasarkan soalan dalam pertanyaan tanpa melihat hasil. Proses pembelajaran aktif ini mengurangkan kemungkinan jalan pintas berkeyakinan tinggi dan berat sebelah ini sukar untuk dipilih pada pusingan seterusnya, sekali gus mengurangkan kesan model ini.

Anotasi set ujian

Kami menapis secara rawak 2500 keping data daripada data beranotasi dan meminta anotasi yang berbeza untuk menganotasinya semula. Jika hasil anotasi adalah sama dengan hasil sebelumnya, data dikekalkan sebagai set ujian Jika ia berbeza, kami meminta "pakar" yang mengetahui tugas dengan baik untuk menganotasi semula data, dan akhirnya mendapat ujian 2362. data dan lebih daripada 40,000 data latihan. Maklumat statistik set latihan dan set ujian ditunjukkan dalam rajah di bawah:

Rajah 8: Maklumat statistik bagi set latihan dan set ujian dalam ChiQA

Inferens dan analisis data

Selepas menganotasi data, kami melakukan statistik dan analisis pada data dalam ChiQA.

1) Analisa perkataan biasa pertanyaan:

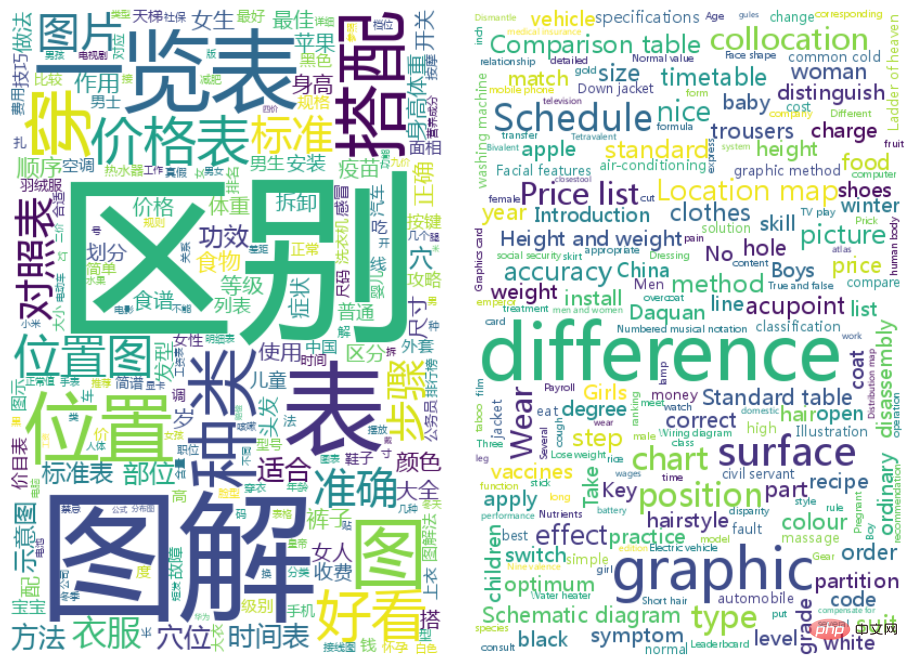

Kami menggunakan segmentasi perkataan yang gagap untuk segmen pertanyaan, dan pertanyaan Perkataan in dipaparkan pada carta awan di bawah mengikut kekerapan:

Anda boleh melihat bahawa pertanyaan paling biasa dalam ChiQA ialah Perbezaan, ilustrasi, lokasi, dsb. Ini selaras dengan gerak hati kita, kerana kata-kata ini sememangnya soalan yang sangat sesuai untuk dijawab oleh gambar.

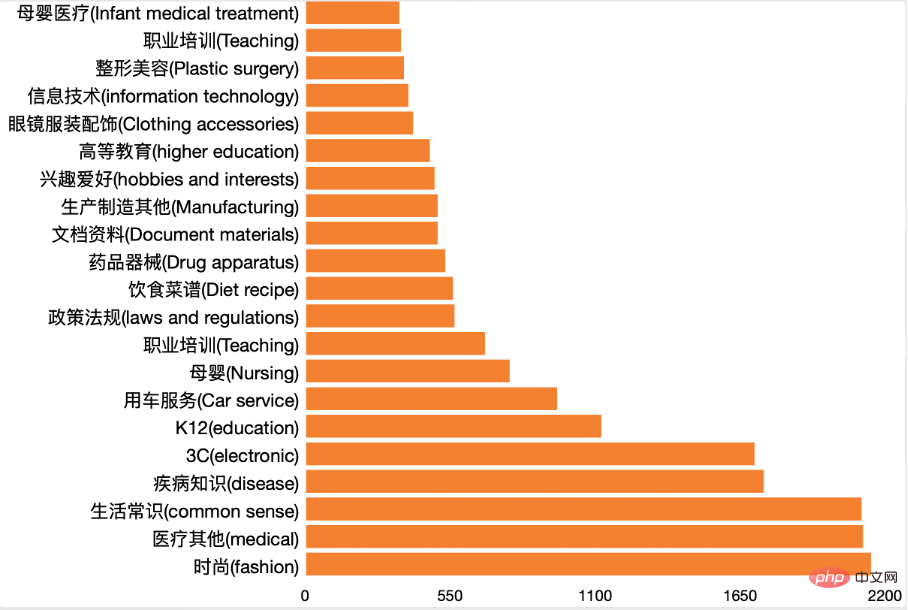

2) Analisis domain

Kami menggunakan pengelas pengelasan domain dalaman untuk melaksanakan semua pengelasan pertanyaan, hasil akhir ditunjukkan dalam rajah di bawah:

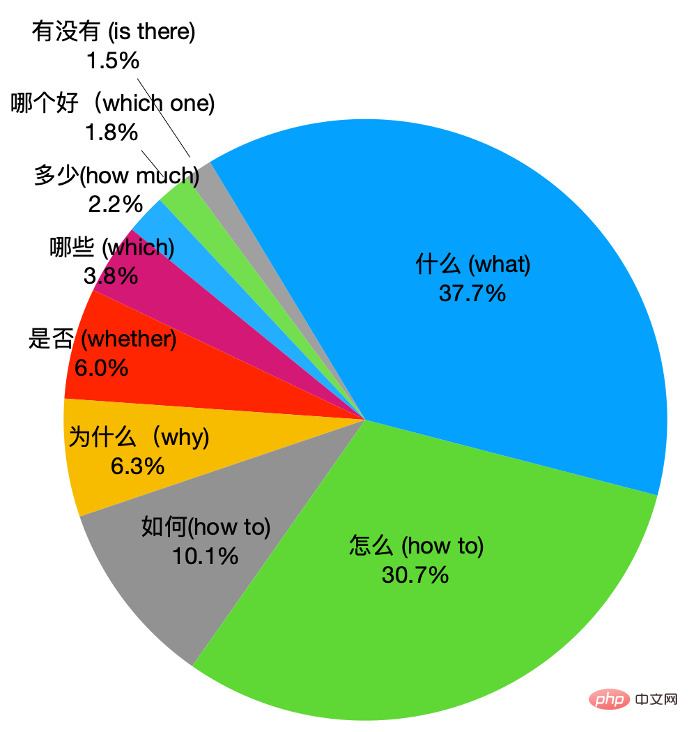

Anda boleh melihat bahawa data kami mengandungi data dalam banyak medan, dan tiada satu pun Data dalam medan mengambil kira majoriti mutlak. Ini memastikan pengedaran data kami adalah sekata. Kedua, kami juga mengira kata tanya dalam soalan, dan hasilnya adalah seperti yang ditunjukkan dalam rajah di bawah:

Anda boleh lihat kelas apa dan bagaimana dalam Soalan ChiQA seperti ini untuk majoriti, dan beberapa soalan lain juga mempunyai perkadaran yang besar.

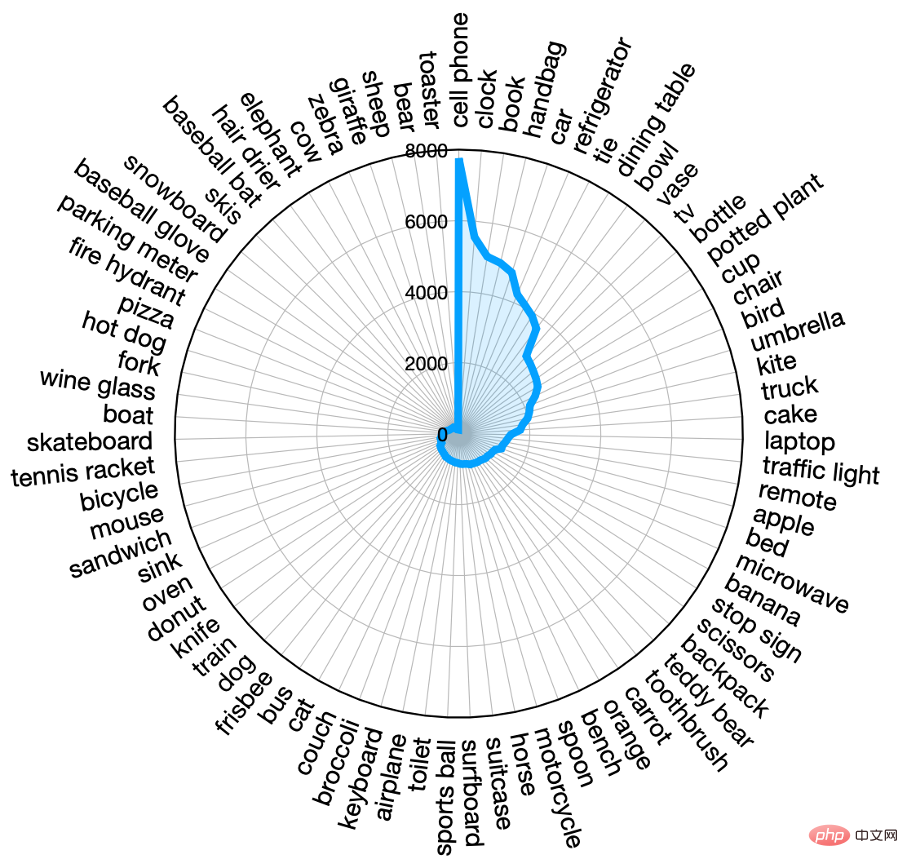

3) Analisis imej

Selain soalan, kami juga melakukan analisis imej dalam ChiQA. Memandangkan kebanyakan imej adalah bebas bahasa, kami menggunakan model pengesanan sasaran DETR yang diiktiraf sebagai mempunyai prestasi cemerlang dalam industri untuk melombong entiti dalam imej. DETR boleh memetakan entiti dalam imej kepada entiti yang ditakrifkan oleh MS-COCO standard, seperti "orang", "anjing", dsb. Kami melombong entiti untuk setiap imej dalam ChiQA dan memaparkan taburan entiti frekuensi tertinggi dalam rajah di bawah:

boleh dilihat dalam ChiQA Lebih daripada 30 entiti muncul sekurang-kurangnya 1000 kali dalam , yang menunjukkan bahawa ChiQA ialah data imej yang sangat sekata dan meliputi kebanyakan medan Entiti yang paling kerap muncul ialah "orang", "telefon bimbit", "kereta", dll. Ini sama dengan pengagihan soalan.

4) Kemahiran menaakul

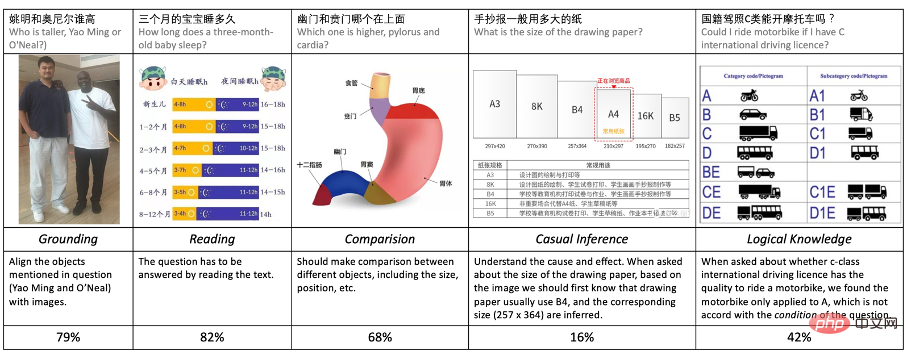

Untuk menganalisis data dengan lebih baik, kami juga menganalisis data ChiQA yang diperlukan kemahiran menaakul telah dianalisis. Fokus pada menganalisis 5 kemahiran yang memerlukan penaakulan:

- Pengadunan: Model dan sistem diperlukan untuk memahami dan mencari entiti yang disebut dalam soalan

- Membaca: Model diperlukan untuk memahami teks yang terdapat dalam gambar

- Perbandingan: Model diperlukan untuk membandingkan beberapa sifat dan kandungan yang berbeza, seperti ketinggian, saiz, dsb. .

- Penaakulan sebab musabab: Model memerlukan pemahaman yang mendalam tentang masalah dan bahagian sebab akibat gambar (iaitu sebab mengapa perkara berlaku atau hasilnya)

- Penaakulan logik: diperlukan Model memahami masalah atau beberapa faktor perbandingan logik dalam gambar, seperti penolakan, syarat, dsb.

Kami mengambil sampel 200 kepingan data ChiQA dan melabelkannya mengikut 5 piawaian di atas, sesetengah daripadanya mungkin memerlukan lebih daripada satu kemahiran menaakul. Hasilnya ditunjukkan di bawah.

Adalah dapat dilihat bahawa selain Grouding, lebih daripada 80% data ChiQA memerlukan pemahaman yang mendalam tentang hubungan teks dan kontras dalam imej. Ini sangat berbeza daripada kebanyakan data VQA sebelumnya. Kedua, terdapat beberapa soalan yang memerlukan logik dan perbandingan, menunjukkan bahawa data dalam ChiQA agak sukar. Kami percaya bahawa analisis kemahiran menaakul dalam ChiQA boleh membantu kami memahami data ini dengan lebih baik dan memberikan beberapa panduan priori untuk reka bentuk model seterusnya.

Penunjuk penilaian eksperimen

Dalam set data ChiQA, terdapat tiga peringkat pemarkahan anotasi: 0, 1, 2, jadi dalam eksperimen kami menguji indeks kedudukan model dan penunjuk pengelasan biasa. Terbahagi kepada tiga kategori:

- NDCG@N: Keuntungan Terkumpul Diskaun Normal

- Min Purata Ketepatan (MAP@N): Purata Ketepatan (MAP@N)

- Tepat / Ketepatan / Panggilan Balik / F1

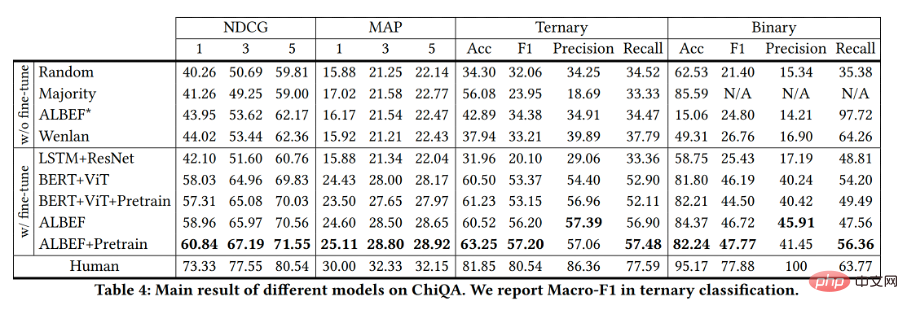

Model Garis Dasar

Kami bereksperimen dengan berbilang model yang biasa digunakan pada set data ChiQA. Berikutan kerja pemadanan imej-teks sebelumnya, kami mula-mula mengekod imej dan teks menggunakan pengekod masing-masing, kemudian melakukan gabungan mod silang perwakilan mereka, dan akhirnya menggunakan lapisan ramalan untuk mendapatkan skor padanan. Dalam model yang disenaraikan di bawah, menambah ♣ bermakna model telah dilatih dan menambah ♦ bermakna model itu belum dilatih.

- Rawak♦: Untuk setiap data dalam set ujian, pilih skor ramalan secara rawak antara 0, 1 dan 2. Model rawak digunakan sebagai model garis dasar pada ChiQA.

- Majoriti♦: Pilih label yang paling banyak muncul dalam set latihan sebagai skor ramalan semua data pada set ujian.

- LSTM+ResNet♦: Sebelum kemunculan model pra-latihan berskala besar untuk teks dan penglihatan, LSTM dan ResNet ialah salah satu model yang paling biasa digunakan dalam bidang teks dan penglihatan masing-masing.

- Bert+ViT♣: Kami menggunakan model Bert untuk mengekod teks pertanyaan dan model ViT untuk mengekod imej Kedua-dua model Bert dan ViT dilatih terlebih dahulu pada data tanpa pengawasan berskala besar. Akhir sekali, vektor perwakilan digunakan untuk memadankan ramalan skor.

- ALBEF♣: ALBEF ialah pembelajaran visual dan perwakilan bahasa berskala besar yang telah menunjukkan peningkatan besar pada pelbagai tugas bahasa visual.

- +Pralatihan♣: Untuk pra-latihan rentas mod Cina, kami melakukan pra-latihan keadaan membran silang pada Bert-ViT dan ALBEF pada set data Pra-latihan kaedah adalah serupa dengan ALBEF . Dataset Wukong ialah data silang modal sumber terbuka yang mengandungi 100 juta pasangan teks imej.

- Wenlan♣: Wenlan ialah model pra-latihan berbilang modal berskala besar yang dilatih pada 30 juta pasangan imej teks, dengan hampir satu bilion parameter. Kami menggunakan perkhidmatan API awam mereka untuk mendapatkan vektor perwakilan teks dan imej, dan menggunakan persamaan CoS bagi kedua-dua vektor sebagai skor padanan yang diramalkan.

- Manusia: Selain model di atas, kami juga menilai tahap ramalan manusia pada set ujian. Oleh kerana jumlah data yang besar dalam set ujian, kami secara rawak mengambil sampel 100 keping data secara manual untuk ramalan dan penilaian penunjuk ramalan.

Berikut ialah keputusannya:

The model di atas Penunjuk pada set ujian ditunjukkan dalam rajah. Kita dapat melihat bahawa aplikasi langsung kaedah silang mod tercanggih sebelum ini berprestasi buruk, dengan metrik hanya lebih baik sedikit daripada model pemarkahan rawak. Ini bermakna data ChiQA adalah sukar dan model yang hanya menggunakan pembelajaran kontrastif berskala besar yang diselia dengan lemah, seperti ALBEF*, Wenlan, mungkin tidak dapat membezakan maklumat terperinci yang diperlukan untuk menjawab soalan visual. Tambahan pula, prestasi lemah model ini menggambarkan bahawa set data ChiQA adalah berbeza daripada data padanan teks imej yang diselia dengan lemah kerana padanan teks imej yang diselia dengan lemah memfokuskan pada korelasi, manakala data ChiQA juga memerlukan kebolehjawaban imej.

Akhirnya, model yang diperhalusi pada ChiQA telah mencapai kemajuan yang besar berbanding garis dasar, tetapi masih jauh daripada prestasi manusia, jadi model masih banyak yang perlu dilakukan pada set data ChiQA ruang untuk penambahbaikan.

Aplikasi ChiQA dalam produk

Dengan perkembangan Internet, pengguna mempunyai permintaan yang lebih tinggi untuk soalan dan jawapan, dan sistem perlu menyediakan jawapan yang lebih intuitif dan mudah . Terutama dalam beberapa tahun kebelakangan ini, kandungan multimedia telah menjadi semakin banyak, dan semakin banyak kandungan Soal Jawab berdasarkan gambar dan video telah muncul di hadapan orang ramai. Pasukan QQ Browser Lab Lizhi adalah yang pertama dalam industri melancarkan projek soal jawab bergambar pada bulan April tahun ini, sebagai contoh, jika pengguna mencari perbezaan antara buah kiwi dan buah kiwi, hasilnya akan dipaparkan secara intuitif di hadapan. pengguna dalam bentuk gambar. Seperti yang ditunjukkan dalam gambar di bawah:

Pada masa ini, masalah seperti ini yang boleh dipuaskan secara langsung dengan gambar telah mencapai hasil yang baik selepas ia masuk ke dalam talian. Kami telah memerhatikan bahawa tingkah laku penggunanya (seperti CTR, kadar penggantian perkataan, dsb.) telah dipertingkatkan dengan ketara berbanding keputusan tradisional, menunjukkan bahawa "Soal Jawab baharu" semasa berdasarkan gambar, dsb., ialah perniagaan produk yang lebih baik. memenuhi keperluan pengguna.

Pengenalan kepada pasukan pengarang

Pasukan Pusat Teknologi Carian Pelayar QQ ialah pasukan yang bertanggungjawab untuk penyelidikan teknologi carian dan pembangunan platform maklumat dan talian perkhidmatan Tencent PCG, ia memacu inovasi produk melalui penyelidikan pengguna, menyediakan grafik kepada pengguna , maklumat, novel, Video panjang dan pendek, perkhidmatan dan keperluan maklumat pelbagai segi lain dipenuhi. Dari segi algoritma, berdasarkan pemprosesan bahasa semula jadi, pembelajaran mendalam, pemahaman dan penjanaan pelbagai mod, pengiraan dan aplikasi pengetahuan dan teknologi lain, kami membina pemahaman kandungan, korelasi dan pengisihan, carian pelbagai mod, soal jawab pintar, pelbagai- terjemahan bahasa, carian Disyorkan dan arahan teknikal lain, meneroka dan menggunakan teknologi termaju industri untuk mencipta pengalaman carian pengguna yang lebih baik dari segi kejuruteraan, membina sistem perindustrian peringkat pertengahan untuk teknologi carian dan menggilap prestasi tinggi, ketersediaan tinggi; , sistem perolehan berpuluh-puluh bilion peringkat kos rendah untuk menyediakan Tencent dengan PCG menyediakan perkhidmatan enjin carian asas untuk senario carian pelbagai perniagaan kandungan Pada masa ini ia menyokong pelbagai rangkaian produk PCG seperti Pelayar QQ, Tencent Video, Tencent News dan Tencent Weishi.

Atas ialah kandungan terperinci ChiQA - set data soalan dan jawapan bergambar berdasarkan 200,000 soalan pengguna sebenar. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1378

1378

52

52

Adakah anda benar-benar menguasai penukaran sistem koordinat? Isu berbilang sensor yang tidak dapat dipisahkan daripada pemanduan autonomi

Oct 12, 2023 am 11:21 AM

Adakah anda benar-benar menguasai penukaran sistem koordinat? Isu berbilang sensor yang tidak dapat dipisahkan daripada pemanduan autonomi

Oct 12, 2023 am 11:21 AM

Artikel perintis dan utama pertama terutamanya memperkenalkan beberapa sistem koordinat yang biasa digunakan dalam teknologi pemanduan autonomi, dan cara melengkapkan korelasi dan penukaran antara mereka, dan akhirnya membina model persekitaran bersatu. Fokus di sini adalah untuk memahami penukaran daripada kenderaan kepada badan tegar kamera (parameter luaran), penukaran kamera kepada imej (parameter dalaman) dan penukaran unit imej kepada piksel. Penukaran daripada 3D kepada 2D akan mempunyai herotan, terjemahan, dsb. Perkara utama: Sistem koordinat kenderaan dan sistem koordinat badan kamera perlu ditulis semula: sistem koordinat satah dan sistem koordinat piksel Kesukaran: herotan imej mesti dipertimbangkan Kedua-dua penyahherotan dan penambahan herotan diberi pampasan pada satah imej. 2. Pengenalan Terdapat empat sistem penglihatan secara keseluruhannya: sistem koordinat satah piksel (u, v), sistem koordinat imej (x, y), sistem koordinat kamera () dan sistem koordinat dunia (). Terdapat hubungan antara setiap sistem koordinat,

Kertas Stable Diffusion 3 akhirnya telah dikeluarkan, dan butiran seni bina didedahkan Adakah ia akan membantu untuk menghasilkan semula Sora?

Mar 06, 2024 pm 05:34 PM

Kertas Stable Diffusion 3 akhirnya telah dikeluarkan, dan butiran seni bina didedahkan Adakah ia akan membantu untuk menghasilkan semula Sora?

Mar 06, 2024 pm 05:34 PM

Kertas StableDiffusion3 akhirnya di sini! Model ini dikeluarkan dua minggu lalu dan menggunakan seni bina DiT (DiffusionTransformer) yang sama seperti Sora. Ia menimbulkan kekecohan apabila ia dikeluarkan. Berbanding dengan versi sebelumnya, kualiti imej yang dijana oleh StableDiffusion3 telah dipertingkatkan dengan ketara Ia kini menyokong gesaan berbilang tema, dan kesan penulisan teks juga telah dipertingkatkan, dan aksara bercelaru tidak lagi muncul. StabilityAI menegaskan bahawa StableDiffusion3 ialah satu siri model dengan saiz parameter antara 800M hingga 8B. Julat parameter ini bermakna model boleh dijalankan terus pada banyak peranti mudah alih, dengan ketara mengurangkan penggunaan AI

Artikel ini sudah cukup untuk anda membaca tentang pemanduan autonomi dan ramalan trajektori!

Feb 28, 2024 pm 07:20 PM

Artikel ini sudah cukup untuk anda membaca tentang pemanduan autonomi dan ramalan trajektori!

Feb 28, 2024 pm 07:20 PM

Ramalan trajektori memainkan peranan penting dalam pemanduan autonomi Ramalan trajektori pemanduan autonomi merujuk kepada meramalkan trajektori pemanduan masa hadapan kenderaan dengan menganalisis pelbagai data semasa proses pemanduan kenderaan. Sebagai modul teras pemanduan autonomi, kualiti ramalan trajektori adalah penting untuk kawalan perancangan hiliran. Tugas ramalan trajektori mempunyai timbunan teknologi yang kaya dan memerlukan kebiasaan dengan persepsi dinamik/statik pemanduan autonomi, peta ketepatan tinggi, garisan lorong, kemahiran seni bina rangkaian saraf (CNN&GNN&Transformer), dll. Sangat sukar untuk bermula! Ramai peminat berharap untuk memulakan ramalan trajektori secepat mungkin dan mengelakkan perangkap Hari ini saya akan mengambil kira beberapa masalah biasa dan kaedah pembelajaran pengenalan untuk ramalan trajektori! Pengetahuan berkaitan pengenalan 1. Adakah kertas pratonton teratur? A: Tengok survey dulu, hlm

DualBEV: mengatasi BEVFormer dan BEVDet4D dengan ketara, buka buku!

Mar 21, 2024 pm 05:21 PM

DualBEV: mengatasi BEVFormer dan BEVDet4D dengan ketara, buka buku!

Mar 21, 2024 pm 05:21 PM

Kertas kerja ini meneroka masalah mengesan objek dengan tepat dari sudut pandangan yang berbeza (seperti perspektif dan pandangan mata burung) dalam pemanduan autonomi, terutamanya cara mengubah ciri dari perspektif (PV) kepada ruang pandangan mata burung (BEV) dengan berkesan dilaksanakan melalui modul Transformasi Visual (VT). Kaedah sedia ada secara amnya dibahagikan kepada dua strategi: penukaran 2D kepada 3D dan 3D kepada 2D. Kaedah 2D-ke-3D meningkatkan ciri 2D yang padat dengan meramalkan kebarangkalian kedalaman, tetapi ketidakpastian yang wujud dalam ramalan kedalaman, terutamanya di kawasan yang jauh, mungkin menimbulkan ketidaktepatan. Manakala kaedah 3D ke 2D biasanya menggunakan pertanyaan 3D untuk mencuba ciri 2D dan mempelajari berat perhatian bagi kesesuaian antara ciri 3D dan 2D melalui Transformer, yang meningkatkan masa pengiraan dan penggunaan.

Model dunia penjanaan video adegan pemanduan berbilang paparan autonomi |

Oct 23, 2023 am 11:13 AM

Model dunia penjanaan video adegan pemanduan berbilang paparan autonomi |

Oct 23, 2023 am 11:13 AM

Beberapa pemikiran peribadi pengarang Dalam bidang pemanduan autonomi, dengan pembangunan sub-tugas/penyelesaian hujung-ke-hujung berasaskan BEV, data latihan berbilang paparan berkualiti tinggi dan pembinaan adegan simulasi yang sepadan telah menjadi semakin penting. Sebagai tindak balas kepada titik kesakitan tugas semasa, "kualiti tinggi" boleh dipecahkan kepada tiga aspek: senario ekor panjang dalam dimensi berbeza: seperti kenderaan jarak dekat dalam data halangan dan sudut arah tepat semasa pemotongan kereta, dan data garis lorong. . Ini selalunya bergantung pada sejumlah besar pengumpulan data dan strategi perlombongan data yang kompleks, yang memerlukan kos yang tinggi. Nilai sebenar 3D - imej sangat konsisten: Pemerolehan data BEV semasa sering dipengaruhi oleh ralat dalam pemasangan/penentukuran sensor, peta berketepatan tinggi dan algoritma pembinaan semula itu sendiri. ini membawa saya kepada

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Editor |ScienceAI Question Answering (QA) set data memainkan peranan penting dalam mempromosikan penyelidikan pemprosesan bahasa semula jadi (NLP). Set data QA berkualiti tinggi bukan sahaja boleh digunakan untuk memperhalusi model, tetapi juga menilai dengan berkesan keupayaan model bahasa besar (LLM), terutamanya keupayaan untuk memahami dan menaakul tentang pengetahuan saintifik. Walaupun pada masa ini terdapat banyak set data QA saintifik yang meliputi bidang perubatan, kimia, biologi dan bidang lain, set data ini masih mempunyai beberapa kekurangan. Pertama, borang data adalah agak mudah, kebanyakannya adalah soalan aneka pilihan. Ia mudah dinilai, tetapi mengehadkan julat pemilihan jawapan model dan tidak dapat menguji sepenuhnya keupayaan model untuk menjawab soalan saintifik. Sebaliknya, Soal Jawab terbuka

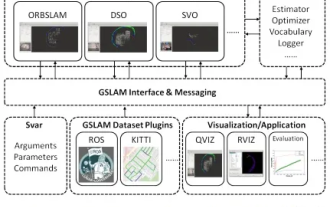

GSLAM |. Seni bina dan penanda aras umum SLAM

Oct 20, 2023 am 11:37 AM

GSLAM |. Seni bina dan penanda aras umum SLAM

Oct 20, 2023 am 11:37 AM

Tiba-tiba menemui kertas 19 tahun GSLAM: Rangka Kerja SLAM Umum dan kod sumber terbuka Penanda Aras: https://github.com/zdzhaoyong/GSLAM Pergi terus ke teks penuh dan rasai kualiti karya ini~1 Teknologi SLAM Abstrak telah mencapai banyak kejayaan baru-baru ini dan menarik ramai yang menarik perhatian syarikat berteknologi tinggi. Walau bagaimanapun, cara untuk antara muka dengan algoritma sedia ada atau yang baru muncul untuk melaksanakan penandaarasan dengan cekap pada kelajuan, kekukuhan dan mudah alih masih menjadi persoalan. Dalam kertas kerja ini, satu platform SLAM baharu yang dipanggil GSLAM dicadangkan, yang bukan sahaja menyediakan keupayaan penilaian tetapi juga menyediakan penyelidik dengan cara yang berguna untuk membangunkan sistem SLAM mereka sendiri dengan pantas.

'Minecraft' bertukar menjadi bandar AI, dan penduduk NPC memainkan peranan seperti orang sebenar

Jan 02, 2024 pm 06:25 PM

'Minecraft' bertukar menjadi bandar AI, dan penduduk NPC memainkan peranan seperti orang sebenar

Jan 02, 2024 pm 06:25 PM

Sila ambil perhatian bahawa lelaki persegi ini berkerut dahi, memikirkan identiti "tetamu tidak diundang" di hadapannya. Ternyata dia berada dalam situasi berbahaya, dan apabila dia menyedari perkara ini, dia segera memulakan pencarian mental untuk mencari strategi untuk menyelesaikan masalah itu. Akhirnya, dia memutuskan untuk melarikan diri dari tempat kejadian dan kemudian mendapatkan bantuan secepat mungkin dan mengambil tindakan segera. Pada masa yang sama, orang di seberang sana memikirkan perkara yang sama seperti dia... Terdapat adegan sedemikian dalam "Minecraft" di mana semua watak dikawal oleh kecerdasan buatan. Setiap daripada mereka mempunyai latar identiti yang unik Contohnya, gadis yang disebutkan sebelum ini adalah seorang kurier berusia 17 tahun tetapi bijak dan berani. Mereka mempunyai daya ingatan dan pemikiran serta hidup seperti manusia di bandar kecil yang terletak di Minecraft ini. Apa yang mendorong mereka adalah sesuatu yang baru,