Peranti teknologi

Peranti teknologi

AI

AI

Masa lalu dan masa kini ChatGPT: 'kedegilan' dan 'perjudian besar' teknologi OpenAI

Masa lalu dan masa kini ChatGPT: 'kedegilan' dan 'perjudian besar' teknologi OpenAI

Masa lalu dan masa kini ChatGPT: 'kedegilan' dan 'perjudian besar' teknologi OpenAI

1. ChatGPT, kecerdasan buatan yang tidak lagi "bodoh"

Topik berkaitan ChatGPT harus dianggap sebagai tempat liputan kecerdasan buatan yang paling popular sejak AlphaGo. Secara ringkasnya, ia adalah robot yang boleh bercakap dalam bahasa semula jadi Anda boleh bertanya kepadanya apa-apa soalan (sudah tentu ia mungkin menjawab salah, tetapi anda boleh membimbing dan membetulkannya), dan ia akan menjawab dalam bahasa yang sangat lancar dan standard. bahasa awak. Bukan itu sahaja, ia juga boleh menjawab soalan pengekodan, soalan matematik, dsb., dan anda boleh berbual dengannya tentang sebarang isu.

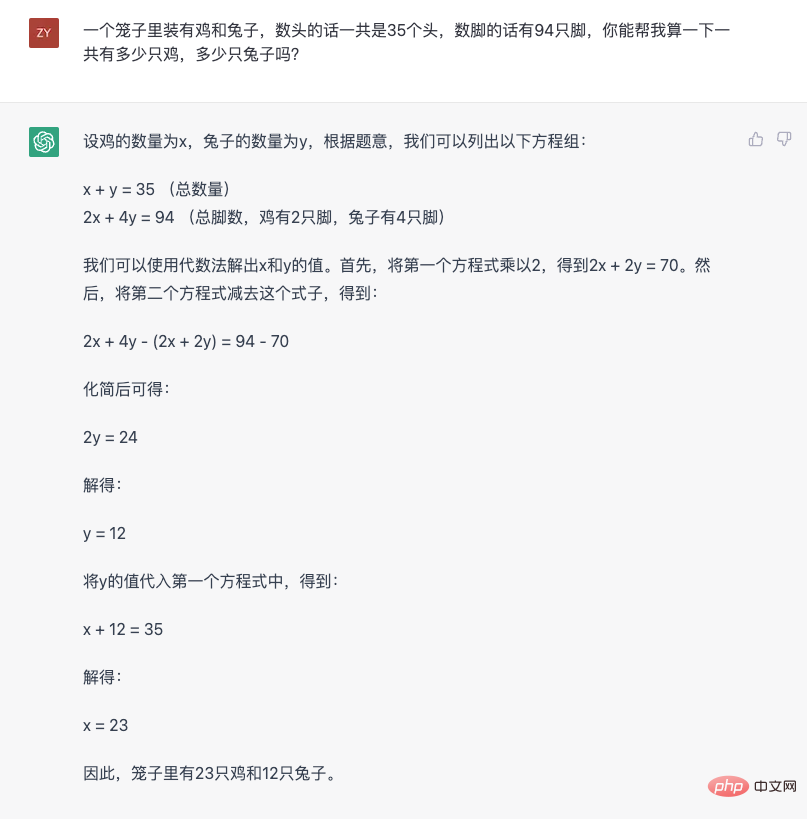

Kita boleh menggunakan masalah ayam dan arnab klasik untuk memahami keupayaan ChatGPT secara persepsi:

Beberapa ciri boleh diperhatikan daripada jawapan ini. Yang pertama ialah keupayaan untuk memahami dan menukar bahasa semula jadi kepada masalah matematik Kedua, ia memecahkan masalah penaakulan yang lebih kompleks langkah demi langkah untuk mendapatkan jawapan akhir langkah demi langkah. Keupayaan ini dipanggil "Rantai pemikiran" dalam industri. Seterusnya, tukar soalan dan lihat cara ia bertindak balas.

Daripada gambar ini kita dapat lihat bahawa ChatGPT sedar apa yang dikatakan dan boleh memberi sebab untuk mengatakannya. Selain itu, ia juga boleh didapati bahawa ia melakukan kesilapan (kali pertama saya mengira bilangan telinga adalah salah. Ini adalah fakta trivia, ayam mempunyai organ yang berfungsi seperti "telinga"), tetapi ia boleh diberi bimbingan. Berikan jawapan yang betul dan beritahu anda mengapa anda salah.

Jika saya tidak memberitahu anda lebih awal bahawa ini adalah model kecerdasan buatan, ChatGPT berasa seperti orang sebenar yang mempunyai pemikiran logik dan keupayaan komunikasi bahasa yang sebenar. Buat pertama kali, penampilannya membuatkan semua orang merasakan bahawa kecerdasan buatan akhirnya boleh berkomunikasi dengan orang secara normal Walaupun kadang-kadang melakukan kesilapan, sekurang-kurangnya tiada halangan bahasa dan logik dalam proses komunikasi "apa yang anda bincangkan, dan berikan anda maklum balas mengikut corak pemikiran manusia dan norma bahasa . Pengalaman yang sangat bijak ini adalah sebab mengapa ia menembusi bulatan kecil industri dan membawa kesan kepada orang ramai.

Saya juga ingin menekankan isu pengalaman ini sekali lagi, kerana mungkin pada masa lalu, disebabkan keterbatasan teknikal, industri mengabaikan perkara ini untuk menyelesaikan tugasan tertentu di tempat kejadian. Kemunculan ChatGPT hari ini bermakna kecerdasan buatan bukan lagi bentuk "berguna, tetapi bodoh" masa lalu.

Untuk lebih memahami bagaimana perasaan sangat pintar ChatGPT tercetus, tidak dapat dielakkan untuk bermula dengan kecerdasan buatan "bodoh" masa lalu. Tepatnya, ChatGPT masih menggunakan teknologi pemprosesan bahasa semula jadi (NLP), tetapi ia memecahkan paradigma asal.

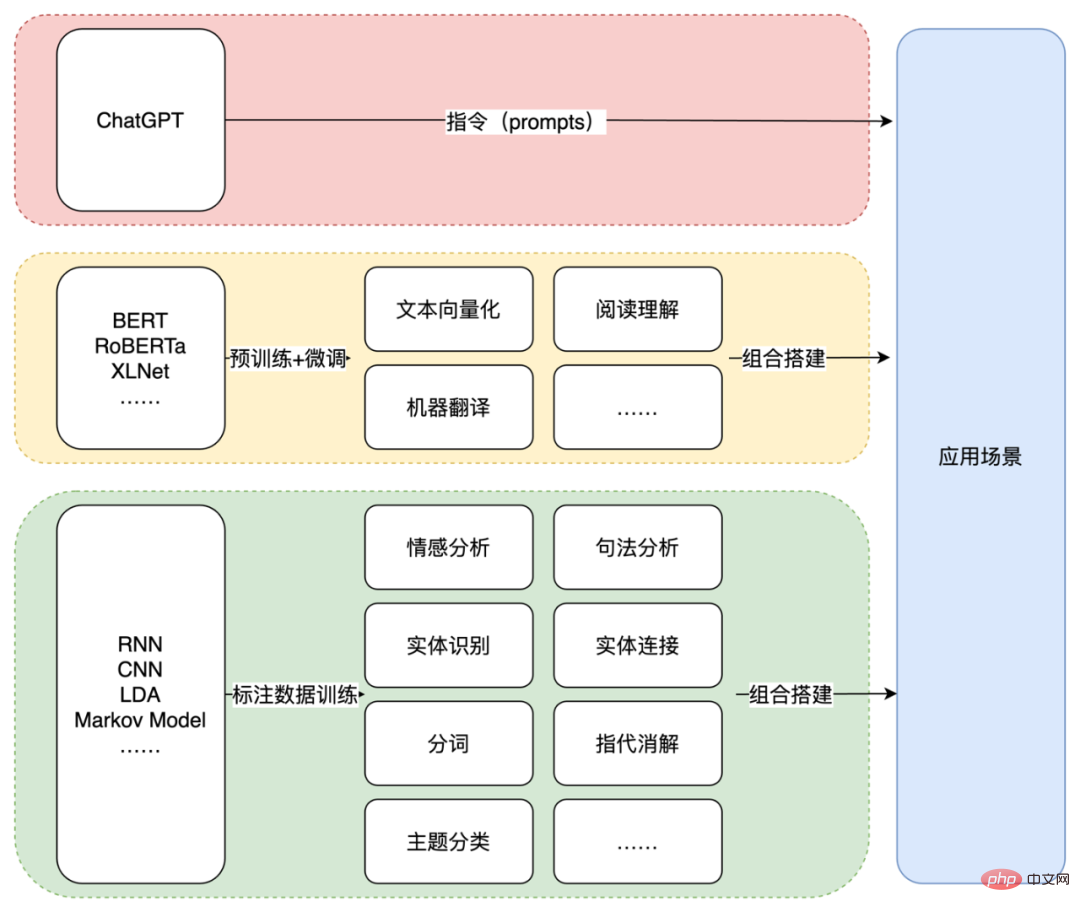

Untuk memahami perkara ini, anda boleh lihat dulu amalan arus perdana semasa. Komunikasi manusia bergantung pada bahasa, dan ramai orang percaya bahawa pemikiran manusia juga berdasarkan bahasa. Oleh itu, memahami dan menggunakan bahasa semula jadi sentiasa menjadi topik penting dalam kecerdasan buatan. Tetapi bahasa terlalu kompleks, jadi untuk komputer memahami dan menggunakan bahasa, proses ini biasanya dibahagikan kepada banyak subbahagian Inilah yang sering dipanggil "tugas" dalam bidang teknikal. Berikut ialah beberapa contoh:

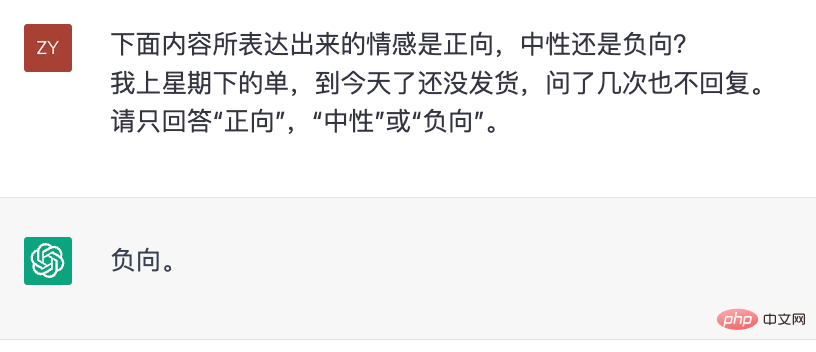

- Tugas analisis sentimen bertujuan untuk memahami kecenderungan emosi yang terkandung dalam bahasa

- Tugas analisis sintaksis bertujuan untuk menganalisis struktur linguistik teks; ;

- Tugas pengecaman entiti bertujuan untuk mencari serpihan entiti daripada teks, seperti alamat, nama, dsb.; tugasan, Ia bertujuan untuk mengekstrak hubungan antara entiti daripada teks; Terdapat banyak faedah untuk melakukan ini Sebagai contoh, dengan pembahagian ini, anda boleh memeriksa keupayaan pembahagian sistem pemprosesan bahasa semula jadi daripada dimensi yang berbeza anda juga boleh mereka bentuk sistem atau model khusus untuk item tersegmen tertentu. Dari sudut pandangan teknikal, membahagikan tugas yang kompleks (memahami dan menggunakan bahasa semula jadi) kepada banyak tugas mudah (pelbagai tugasan NLP) sememangnya cara biasa untuk menyelesaikan masalah yang rumit Ini juga merupakan amalan arus perdana. Walau bagaimanapun, selepas kemunculan ChatGPT, jika dilihat semula, mungkin perpecahan ini bukanlah cara yang paling berkesan untuk membolehkan komputer memahami dan menggunakan bahasa semula jadi.

- Oleh kerana prestasi cemerlang pada satu tugasan tidak bermakna sistem telah menguasai bahasa semula jadi. "Deria kecerdasan" manusia terhadap kecerdasan buatan adalah berdasarkan keupayaan keseluruhannya untuk menggunakan bahasa semula jadi padanya, yang jelas ditunjukkan dalam ChatGPT

. Walaupun OpenAI belum membuka perkhidmatan API ChatGPT, dan dunia luar tidak dapat menilai kesan khususnya pada pelbagai tugas NLP yang dipecah bahagi, ujian luaran yang lalu bagi pendahulunya GPT-3, InstructGPT dan model lain telah menunjukkan bahawa untuk beberapa model tertentu. Tugas, model kecil yang diperhalusi dengan data khusus sememangnya boleh mencapai hasil yang lebih baik (untuk analisis terperinci, sila rujuk "Pemahaman Mendalam Mengenai Keupayaan Model Bahasa yang Muncul"). Tetapi model kecil ini yang berprestasi lebih baik pada satu tugasan tidak menyebabkan kesan luar bulatan yang besar. Akhirnya, ia adalah kerana mereka hanya mempunyai satu keupayaan. Keupayaan cemerlang tunggal tidak bermakna mereka mempunyai keupayaan untuk memahami dan menggunakan bahasa semula jadi, dan dengan itu tidak boleh memainkan peranan dalam senario aplikasi sebenar sahaja. Disebabkan ini, biasanya dalam senario aplikasi sebenar, berbilang modul dengan keupayaan satu titik direka bentuk dan disatukan secara buatan ini menjadikan sistem kecerdasan buatan masa lalu berasa tidak bijak.

Dari perspektif manusia memahami dan menggunakan bahasa semula jadi, fenomena ini sebenarnya mudah difahami. Apabila orang biasa memahami dan menggunakan bahasa semula jadi, mereka tidak membahagikannya kepada banyak tugas yang berbeza dalam fikiran mereka, menganalisis setiap tugasan satu persatu, dan kemudian meringkaskannya. Ini bukan cara manusia menggunakan bahasa semula jadi. Sama seperti apabila seseorang mendengar ayat, dia tidak menganalisis struktur sintaksisnya, kandungan dan hubungan entiti, kecenderungan emosi, dan lain-lain satu demi satu, dan kemudian mencantumkan maksud ayat itu Proses pemahaman orang tentang bahasa Ia satu proses holistik. Tambahan pula, pemahaman keseluruhan orang tentang ayat ini akan diungkapkan sepenuhnya dalam bentuk bahasa semula jadi melalui balasan. Proses ini bukan seperti sistem kecerdasan buatan, yang membahagikan satu tugas dan kemudian mengeluarkan label analisis sentimen, serpihan maklumat entiti atau hasil beberapa tugasan lain satu demi satu, dan kemudian menggunakan perkara ini untuk menyatukan respons. Dan Diwakili oleh ChatGPT, apa yang model siri GPT lakukan benar-benar hampir dengan keupayaan manusia untuk memahami dan menggunakan bahasa - menerima secara langsung bahasa semula jadi, dan kemudian Secara langsung membalas bahasa semula jadi, memastikan kefasihan dan logik bahasa

. Ini adalah cara untuk orang ramai berkomunikasi, jadi semua orang menganggapnya sebagai pengalaman "sangat pintar". Mungkin ramai yang beranggapan alangkah bagusnya jika ia dapat dilakukan seperti ChatGPT Pembahagian tugas pada masa lalu adalah pilihan terakhir kerana keterbatasan teknikal. Dari perspektif aplikasi teknikal, pendekatan bulatan sebegini sudah tentu diperlukan Kaedah ini telah lama diguna pakai dan sememangnya boleh menyelesaikan banyak masalah dalam senario praktikal. Tetapi jika anda melihat kembali proses pembangunan model siri GPT, anda akan mendapati OpenAI "bertaruhan" pada laluan lain, dan mereka "bertaruhan" dan menang.

2. "Gamble" OpenAIGenerasi pertama GPT, di mana segala-galanya bermula

Seawal 2018, OpenAI mengeluarkan versi awal model GPT Daripada kertas awam OpenAI (Meningkatkan Pemahaman Bahasa oleh Pra-Latihan Generatif), kita boleh mengetahui bahawa model ini menggunakan struktur Penyahkod Transformer 12 lapisan. . , kira-kira 5GB data teks tanpa pengawasan telah digunakan untuk melatih tugas model bahasa. Walaupun model GPT generasi pertama sudah menggunakan pra-latihan generatif (ini juga asal usul nama GPT, Pra-Latihan Generatif, iaitu pra-latihan generatif), tetapi ia menggunakan pra-latihan tanpa pengawasan. latihan + Paradigma hiliran penalaan tugas. Paradigma ini sebenarnya bukanlah ciptaan baru Ia telah digunakan secara meluas dalam bidang CV (computer vision) Namun, disebabkan prestasi cemerlang model ELMo pada tahun itu, ia diperkenalkan semula ke dalam bidang NLP.

Kemunculan model GPT memang menarik perhatian dalam industri pada tahun itu, tetapi ia bukan protagonis C pada tahun itu. Kerana pada tahun yang sama, model BERT Google keluar, menarik hampir semua perhatian dengan hasil yang sangat baik (adegan ini sedikit seperti ChatGPT semasa, saya tidak dapat menahan perasaan bahawa "rungutan" antara Google dan OpenAI benar-benar penjelmaan semula).

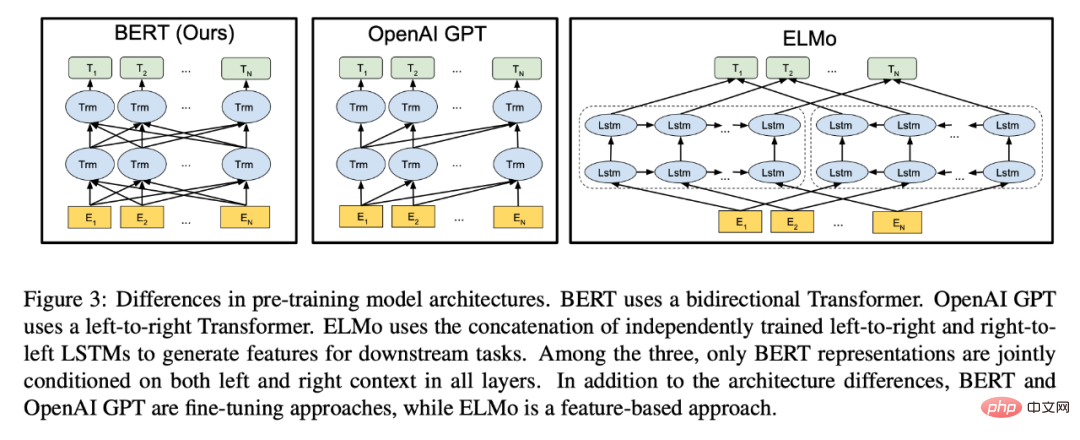

Gambar berasal daripada kertas BERT Daripada ilustrasi, anda boleh melihat bahawa BERT telah ditanda aras Keupayaan pengekodan GPT dan Dwiarah diberi perhatian dengan bangganya.

Walaupun model BERT juga menggunakan struktur model Transformer yang sama seperti GPT, ia hampir merupakan model yang disesuaikan untuk paradigma "pra-latihan tanpa pengawasan + penalaan halus tugas hiliran " . Berbanding dengan GPT, walaupun Model Bahasa Bertopeng yang digunakan oleh BERT kehilangan keupayaan untuk menjana teks secara langsung, ia memperoleh keupayaan untuk pengekodan dua hala, yang memberikan model pengekodan teks yang lebih kukuh Prestasi secara langsung dicerminkan dalam peningkatan ketara kesan tugasan hiliran. Untuk mengekalkan keupayaan menjana teks, GPT hanya boleh menggunakan pengekodan sehala.

Dari perspektif tahun itu, BERT sememangnya model yang lebih baik. Oleh kerana kedua-dua BERT dan GPT mengguna pakai paradigma "pra-latihan + penalaan halus", dan tugasan hiliran masih merupakan bentuk tugasan NLP "klasik" seperti pengelasan, pemadanan, pelabelan jujukan, dsb., maka model BERT memberi lebih perhatian kepada pengekodan ciri. Kualiti, tugas hiliran memilih fungsi kehilangan yang sesuai untuk memadankan tugas untuk penalaan halus, yang jelas lebih langsung daripada kaedah penjanaan teks GPT untuk "bulatan" menyelesaikan tugasan ini.

Selepas model BERT keluar, paradigma "latihan tanpa pengawasan + penyelarasan tugas hiliran" mewujudkan penguasaannya Pelbagai jenis orang mengikuti idea BERT dan memikirkan "bagaimana untuk mendapatkan lebih banyak lagi Kaedah "Pengekodan ciri teks yang baik" telah muncul dalam jumlah yang besar, sehingga GPT, model yang menyasarkan tugas generatif, kelihatan seperti "orang asing". Apabila dilihat semula, jika OpenAI telah "mengikut trend" dan meninggalkan laluan pra-latihan generatif, kita mungkin terpaksa menunggu lebih lama untuk melihat model seperti ChatGPT.

Harapan yang dibawa oleh GPT-2

Sudah tentu, kita kini telah melihat ChatGPT, jadi OpenAI tidak berputus asa pada laluan Pra-latihan generasi. Malah, "ganjaran" kegigihan menjulang pada tahun kedua, iaitu, 2019. OpenAI mengeluarkan model GPT-2 dengan struktur Transformer 48 lapisan. Dalam kertas kerja yang diterbitkan (Model Bahasa ialah Pelajar Berbilang Tugas Tanpa Selia), mereka mendapati bahawa melalui data tanpa pengawasan dan latihan generatif, GPT menunjukkan keupayaan berbilang tugasan sifar. Perkara yang menakjubkan ialah keupayaan berbilang tugas ini tidak ditambahkan secara eksplisit atau buatan pada data latihan. Untuk memberi contoh dalam istilah orang awam, salah satu keupayaan yang ditunjukkan oleh GPT-2 ialah terjemahan, tetapi yang menghairankan, model yang biasanya digunakan khusus untuk terjemahan memerlukan sejumlah besar korpus selari (iaitu, antara dua bahasa yang berbeza) Data berpasangan) untuk diselia. latihan, tetapi GPT-2 tidak menggunakan data jenis ini, tetapi hanya melakukan latihan generatif pada sejumlah besar korpus, dan kemudian ia boleh "tiba-tiba" menterjemah. Penemuan ini lebih kurang subversif Ia menunjukkan kepada orang ramai tiga fenomena penting:

- Jika anda mahu model melengkapkan tugasan NLP, anda mungkin tidak memerlukan data berlabel yang sepadan dengan tugasan . Contohnya, GPT-2 tidak menggunakan data terjemahan beranotasi semasa latihan, tetapi ia akan melakukan terjemahan

- Jika anda mahu model menyelesaikan tugasan NLP, mungkin tidak mungkin Matlamat latihan yang perlu sepadan dengan tugas. Sebagai contoh, GPT-2 tidak mereka bentuk tugas terjemahan dan fungsi kehilangan yang berkaitan semasa latihan. Ia hanya melaksanakan tugas model bahasa.

- Model yang dilatih hanya dengan tugas model bahasa (iaitu tugas generatif) juga boleh mempunyai keupayaan berbilang tugas . Sebagai contoh, GPT-2 telah menunjukkan keupayaan dalam terjemahan, menjawab soalan, pemahaman bacaan, dsb.

Walaupun dari perspektif hari ini, pelbagai keupayaan yang ditunjukkan oleh GPT-2 pada masa itu masih agak asas, dan kesannya jauh daripada model lain yang diperhalusi menggunakan data yang diselia masih terdapat jurang yang jelas, tetapi ini tidak menghalang OpenAI daripada penuh dengan jangkaan untuk potensi keupayaan yang terkandung di dalamnya, sehinggakan dalam ayat terakhir abstrak kertas itu, mereka mengemukakan jangkaan mereka untuk masa hadapan. daripada model siri GPT:

“Penemuan ini mencadangkan laluan yang menjanjikan ke arah membina sistem pemprosesan bahasa yang belajar melaksanakan tugas daripada demonstrasi yang berlaku secara semula jadi.”

Satu siri perkembangan seterusnya juga membuktikan bahawa mereka sememangnya telah Melangkah ke hadapan ke arah jalan yang menjanjikan ini. Jika pada tahun 2018, apabila model GPT generasi pertama keluar, pra-latihan generatif GPT masih menghadapi dihancurkan dalam semua aspek oleh model pra-latihan seperti BERT yang bertujuan untuk "mengekstrak ciri", maka dalam GPT-2 Ia adalah mendapati bahawa pra-latihan generatif memberi potensi kelebihan yang tidak boleh digantikan oleh model jenis BERT, iaitu keupayaan multi-tugas yang dibawa oleh tugas model bahasa, dan keupayaan multi-tugas ini tidak memerlukan data pelabelan.

Sudah tentu, pada ketika itu, laluan teknologi generatif masih menghadapi risiko dan cabaran. Lagipun, prestasi GPT-2 pada masa itu pada pelbagai tugas masih lebih buruk daripada model yang telah diperhalusi Ini menyebabkan walaupun GPT-2 mempunyai keupayaan terjemahan, ringkasan, dan lain-lain, kesannya terlalu buruk untuk menjadi sebenarnya. digunakan. Oleh itu, jika anda mahukan model terjemahan yang boleh digunakan pada masa itu, pilihan terbaik masih menggunakan data beranotasi untuk melatih model khusus untuk terjemahan.

GPT-3, permulaan roda tenaga data

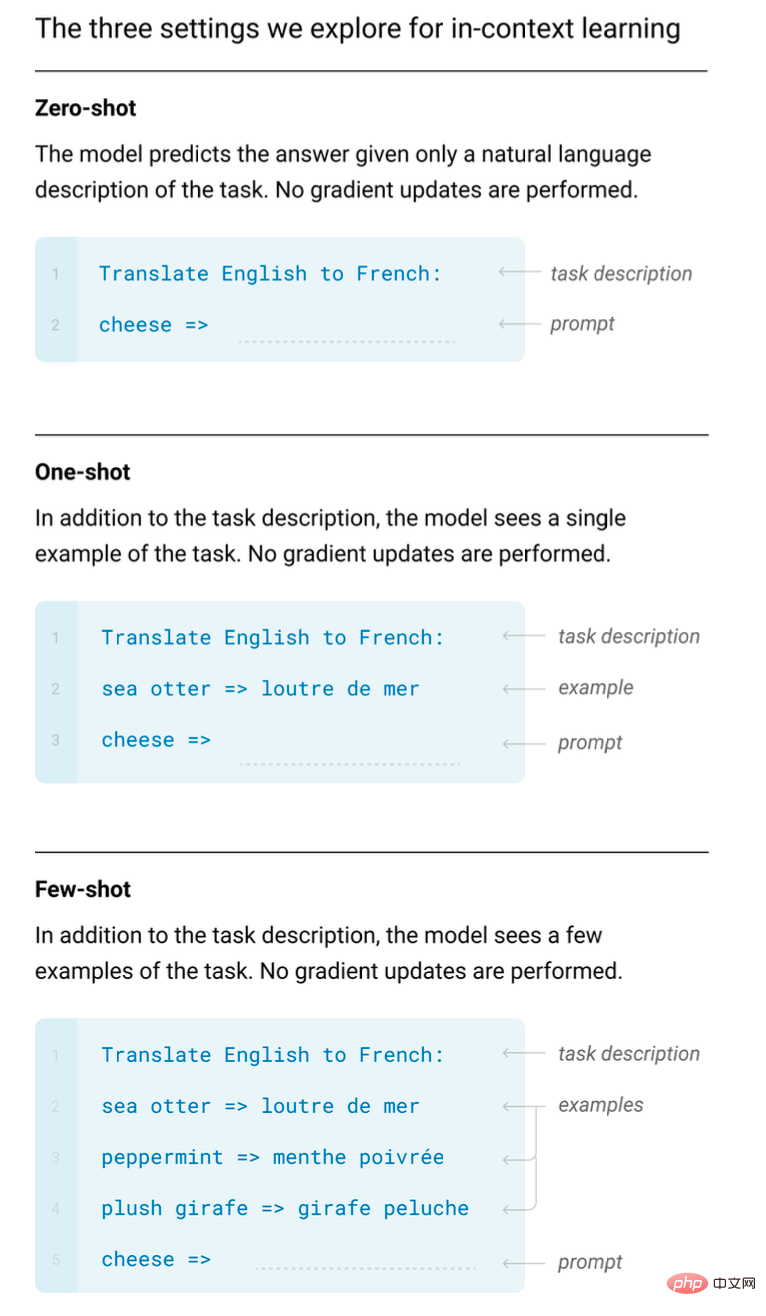

Mengimbas kembali dari era ChatGPT, mungkin OpenAI adalah dalam GPT- Penemuan dalam 2 sememangnya mengukuhkan keyakinan mereka terhadap model siri GPT, dan mereka memutuskan untuk meningkatkan pelaburan dalam penyelidikan dan pembangunan. Kerana pada tahun 2020, mereka mengeluarkan GPT-3 dengan 175 bilion parameter, model yang sangat besar walaupun dari perspektif hari ini. Walaupun OpenAI tidak mendedahkan kos melatih model ini, semua orang menganggarkan kosnya $12 juta pada masa itu. Turut dikeluarkan ialah kertas lebih daripada 60 muka surat (Model Bahasa ialah Sedikit Pelajar), yang memperincikan keupayaan baharu yang ditunjukkan oleh raksasa baharu ini. Penemuan yang paling penting adalah apa yang dinyatakan dalam tajuk kertas kerja, bahawa model bahasa mempunyai keupayaan untuk belajar dengan sampel kecil (few-shot).

Pembelajaran sampel kecil adalah istilah profesional dalam bidang pembelajaran mesin, tetapi ia mempunyai konsep yang sangat mudah, iaitu, "manusia boleh mempelajari tugas bahasa baharu melalui sebilangan kecil contoh”. Bayangkan belajar dalam kelas bahasa Cina bagaimana untuk menggantikan perkataan "meletakkan" dengan perkataan "menjadi" (baju basah akibat hujan - pakaian basah akibat hujan Guru akan memberikan beberapa contoh, dan pelajar akan melakukannya). Dapat menguasai kebolehan ini.

Tetapi untuk model pembelajaran mendalam, ia biasanya perlu mempelajari (melatih) beribu-ribu contoh untuk menguasai keupayaan baharu, tetapi semua orang mendapati GPT-3 adalah seperti manusia Juga mempunyai kebolehan yang serupa. Dan perkara utama ialah anda hanya perlu menunjukkan beberapa contoh, dan ia akan "meniru" tugas yang diberikan oleh contoh tanpa memerlukan latihan tambahan (iaitu, tanpa memerlukan pengemaskinian parameter perambatan belakang kecerunan dan latihan konvensional). Penyelidikan kemudian menunjukkan bahawa keupayaan ini adalah unik untuk model gergasi, dan dipanggil "pembelajaran dalam konteks" dalam industri.

Keupayaan pembelajaran Dalam konteks bahasa Inggeris ke Perancis ditunjukkan dalam kertas GPT-3.

Sebenarnya, keupayaan untuk belajar dengan sampel yang kecil bukanlah penemuan yang menakjubkan. Lagipun, industri telah menjalankan penyelidikan tentang pembelajaran sampel kecil, dan banyak model yang pakar dalam pembelajaran sampel kecil mempunyai keupayaan pembelajaran sampel kecil yang sangat baik. Walau bagaimanapun, keupayaan sampel kecil "pembelajaran dalam konteks" yang ditunjukkan oleh GPT-3 adalah sangat tidak dijangka. Sebabnya adalah sama dengan keupayaan berbilang tugas yang ditunjukkan oleh GPT-2:

- GPT-3 tidak membuat reka bentuk khas dalam data latihan dan kaedah latihan untuk mendapatkan keupayaan sampel kecil Ia masih hanya model generatif yang dilatih dengan tugas model bahasa; Keupayaan sampel kecil GPT-3 ditunjukkan melalui "pembelajaran dalam konteks". Dalam erti kata lain, jika anda mahu ia memperoleh kebolehan baharu, anda tidak perlu melatihnya semula, tetapi anda hanya perlu menunjukkan beberapa contoh demonstrasi.

- Selain keupayaan ini, GPT-3 juga menunjukkan keupayaan penjanaan teks yang sangat baik Berbanding dengan GPT-2, kandungan yang dihasilkannya lebih lancar dan boleh menjana banyak teks . Keupayaan ini dicerminkan secara menyeluruh dalam satu model, yang menjadikan GPT-3 sebagai tumpuan perhatian semua orang pada masa itu Ia juga menjadi model untuk OpenAI secara rasmi menyediakan perkhidmatan kepada dunia luar.

Tetapi dengan pembukaan perkhidmatan model ini, semakin ramai yang cuba menggunakan model ini. Sejak itu, OpenAI juga telah mengumpul data yang lebih pelbagai dengan membukanya kepada umum (kandungan yang dimasukkan oleh pengguna boleh digunakan untuk latihan model, yang ditulis dalam istilah pengguna), data ini juga memainkan peranan penting dalam lelaran model berikutnya .

Sejak itu, roda tenaga data model siri GPT telah berputar Lebih banyak data pengguna berkualiti tinggi, lebih baik modeldiulang. Berbeza daripada ChatGPT, GTP-3 bukanlah model interaksi perbualan, tetapi model sambungan teks (iaitu, mengikut teks yang anda masukkan) (ditulis di bawah), jadi ia tidak mempunyai keupayaan perbualan berbilang pusingan yang dimiliki oleh ChatGPT hari ini. Tetapi ia sudah boleh melakukan banyak perkara, seperti menulis cerita, e-mel autolengkap, dsb. Tetapi pada masa yang sama, semua orang secara beransur-ansur menemui beberapa masalah Sebagai contoh, ia akan mengeluarkan kandungan yang tidak konsisten dengan fakta, dan ia akan mengeluarkan beberapa kenyataan berbahaya, dsb. Ini adalah kelemahan yang paling ketara bagi model penjanaan teks ini Walaupun ia telah melalui banyak lelaran, ChatGPT masih menghadapi masalah yang sama hari ini.

CodeX, biarkan komputer menulis kodnya sendiri

OpenAI mendapat satu lagi kejutan dalam penyelidikannya pada GPT-3 Telah didapati bahawa ia boleh menghasilkan kod yang sangat mudah berdasarkan beberapa komen. Oleh itu, pada tahun 2021, mereka menumpukan pelaburan penyelidikan khusus untuk menjana kod dan mengeluarkan model CodeX.

Ia boleh dilihat sebagai model GPT dengan keupayaan pengkhususan kod, yang boleh menjana kod yang agak kompleks berdasarkan input bahasa semula jadi. Dari perspektif luaran, kami tidak dapat mengetahui sama ada penyelidikan mengenai penjanaan kod dan pembangunan model siri GPT sedang dijalankan pada masa yang sama. Tetapi pada masa itu, ia sememangnya lebih bermakna dari perspektif praktikal untuk memberi model keupayaan untuk menjana kod Lagipun, GPT-3 belum lagi mempunyai keupayaan hebat ChatGPT hari ini. Sebaliknya, membiarkan model menjana kod juga mengelakkan risiko ia menghasilkan kandungan teks berbahaya.

Beberapa perkara penting telah disebut dalam kertas CodeX Mula-mula, biarkan model GPT yang telah dilatih dengan data teks digunakan dalam data kod khas (data berasal daripada kod sumber terbuka. github, sejumlah 159G) Latihan sememangnya boleh meningkatkan keupayaan model untuk memahami dan mengeluarkan kod dengan ketara. Kedua, kertas itu menggunakan model "kecil" dengan 12 bilion parameter Maklumat ini mencerminkan dari sisi bahawa sebagai tambahan kepada 175 bilion parameter model GPT-3 dengan antara muka terbuka, terdapat versi model lain dengan saiz yang berbeza dalam OpenAI.

Niat asal menambah latihan kod untuk membolehkan model memahami dan membuat keputusan untuk menjana kod mungkin hanya berharap GPT boleh mempunyai satu lagi senario aplikasi. Ia nampaknya tidak mempunyai banyak kaitan dengan keupayaan model siri GPT untuk memahami dan menggunakan bahasa semula jadi, tetapi menurut penyelidikan seterusnya (untuk analisis terperinci, sila rujuk artikel " Pembongkaran dan Kebolehkesanan GPT- 3.5 Asal pelbagai keupayaan 》), peningkatan latihan data kod berkemungkinan akan mencetuskan keupayaan model GPT kemudiannya untuk melaksanakan penaakulan dan rantai pemikiran yang kompleks dalam bahasa semula jadi.

Mungkin apabila OpenAI mula bekerja pada CodeX, mereka tidak menjangkakan hasil sedemikian, tetapi ia seperti mereka telah menggunakan tugas penjanaan teks untuk membuat model GPT, dan kemudian dalam GPT-2 dan GPT -3 "membuka kunci" "keupayaan untuk berbilang tugas" dan "keupayaan untuk belajar dalam konteks", pengenalan data kod sekali lagi memberi mereka keuntungan yang tidak dijangka. Walaupun nampaknya agak tidak sengaja, pemahaman yang berpandangan ke hadapan tentang laluan teknikal, ditambah dengan kegigihan dan pelaburan berterusan jelas merupakan faktor penting.

ArahkanGPT, biar GPT bercakap sendiri

Kami menyebut GPT-3 tadi, walaupun sudah ada yang kuat Namun , selepas ia masuk dalam talian, kerana semakin ramai orang menggunakannya, banyak masalah ditemui Masalah yang paling serius adalah "serius bercakap karut" dan "mengeluarkan kandungan berbahaya". Walaupun OpenAI nampaknya memfokuskan buat sementara waktu untuk mendapatkan model untuk memahami dan menjana kod pada tahun 2021, mereka sepatutnya cuba menyelesaikan masalah ini dengan GPT-3.

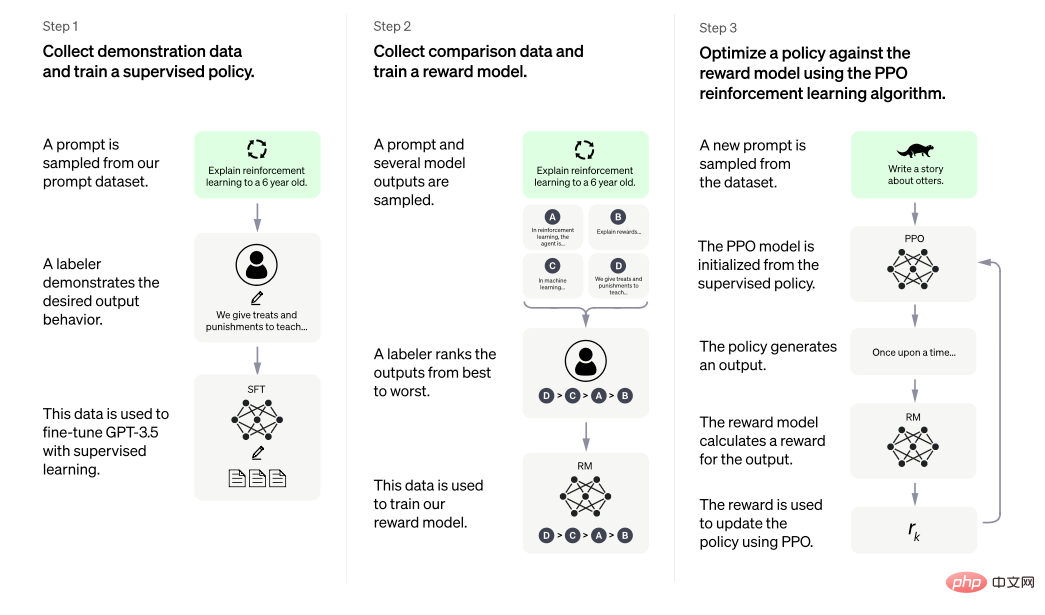

Pada awal 2022, OpenAI menerbitkan kertas InstructGPT (Melatih model bahasa untuk mengikut arahan dengan maklum balas manusia), yang mana kita boleh mendapatkan gambaran tentang cara menyelesaikan masalah ini. Idea teras kertas ini adalah untuk membolehkan model menerima pengajaran manusia (maklum balas), yang dinyatakan dengan jelas dalam tajuk .

Sebab mengapa GPT-3 menghadapi masalah seperti "serius bercakap mengarut" dan "mengeluarkan kandungan berbahaya" datang daripada data latihan yang digunakannya. Raksasa seperti GPT-3 memerlukan sejumlah besar data. Kita boleh mencari sumber datanya daripada kertas GPT-3, yang boleh dibahagikan secara kasar kepada tiga kategori: kandungan web, kandungan ensiklopedia dan buku. Walaupun jumlah kandungan web adalah sangat besar, ia juga sangat "kotor, tidak kemas dan miskin" dan secara semula jadi mengandungi banyak kandungan yang tidak benar dan berbahaya. GPT-3 melatih data ini dan secara semula jadi mempelajari perkara ini.

Tetapi sebagai produk yang menyediakan perkhidmatan luaran, GPT-3 harus lebih berhati-hati dalam jawapannya. Untuk menyelesaikan masalah ini, salah satu kesukaran terletak pada bagaimana untuk menentukan bagaimana model harus bercakap. Kerana kandungan keluaran model generatif ialah bahasa semula jadi itu sendiri, bukannya kandungan betul atau salah yang jelas, objektif seperti label klasifikasi atau kata nama entiti. Tiada betul atau salah yang jelas, yang menjadikannya mustahil untuk mereka bentuk tugas latihan secara langsung untuk matlamat seperti melatih model NLP klasik.

Penyelesaian yang diberikan oleh InstructGPT adalah sangat langsung Memandangkan terdapat banyak faktor pengaruh yang berbeza untuk indeks penilaian "jawapan yang baik", dan faktor-faktor ini saling berkaitan, maka Biarkan seseorang. ajar cara menulis jawapan. Oleh kerana manusia lebih baik dalam menangani masalah seperti ini dengan "keperluan yang jelas dan skop yang tidak jelas", biarkan orang sebenar menulis beberapa "contoh yang sangat baik" dan biarkan model mempelajari "contoh yang sangat baik" Ini adalah idea Umum yang dicadangkan oleh InstructGPT.

Secara khusus, InstructGPT mencadangkan laluan dua peringkat untuk membolehkan GPT mempelajari "contoh yang sangat baik" yang diberikan oleh manusia ialah pembelajaran pengukuhan . Pada peringkat pertama (bersamaan dengan Langkah paling kiri 1 dalam rajah di bawah), biarkan orang sebenar mengikut gesaan yang berbeza (secara kasarnya, ia boleh dianggap sebagai teks yang kita masukkan dalam kotak dialog apabila menggunakan ChatGPT. Dalam industri, perkara ini dipanggil perintah) Tulis jawapan yang benar, tidak berbahaya, dan membantu. Semasa operasi sebenar, untuk memastikan kualiti kandungan ini, beberapa garis panduan normatif akan diberikan kepada anotasi yang menulis jawapan, dan kemudian model GPT yang telah terlatih akan dibenarkan untuk meneruskan latihan mengenai data yang diedit manusia ini. Tahap ini boleh dianggap sebagai sejenis "disiplin" untuk model Untuk menggunakan analogi yang longgar, ia seperti guru Cina meminta anda menulis esei yang sangat baik secara senyap.

Gambar adalah daripada kertas InstructGPT, yang bercadang untuk menjadikan output model munasabah melalui penyeliaan arahan penalaan halus + pembelajaran pengukuhan dengan maklum balas manusia.

Peringkat kedua ialah pembelajaran pengukuhan, yang secara teknikalnya terbahagi kepada dua langkah. Langkah pertama (sepadan dengan Langkah 2 di tengah-tengah rajah di atas) ialah membiarkan model "terlatih" menjana berbilang jawapan berbeza berdasarkan gesaan yang berbeza, dan biarkan manusia mengisih jawapan ini mengikut piawaian yang baik atau buruk. Kemudian gunakan data berlabel ini untuk melatih model pemarkahan supaya ia boleh mengisih dan menjaringkan lebih banyak data secara automatik. Langkah kedua peringkat pembelajaran pengukuhan (bersamaan dengan Langkah 3 di sebelah kanan dalam rajah di atas) ialah menggunakan model pemarkahan ini sebagai maklum balas persekitaran dalam pembelajaran pengukuhan, dan menggunakan kecerunan dasar (Kecerunan Polisi, tepatnya, algoritma PPO ) kepada Model GPT terlatih dilatih. Keseluruhan proses peringkat kedua boleh dilihat sebagai "penguatan" model Untuk menggunakan analogi yang longgar, ia adalah seperti seorang guru Cina yang memberi anda gred untuk esei anda dan meminta anda membezakan daripada markah apa yang baik dan apa yang baik. . Tidak bagus, dan kemudian terus meningkat.

Oleh itu, Dengan cara yang sangat longgar, tetapi dengan cara yang orang biasa mungkin dapat memahami, InstructGPT terlebih dahulu membenarkan GPT yang "tidak mengganggu" Dengan "menulis karangan manusia yang sangat baik secara senyap", anda pada mulanya boleh belajar "bercakap dengan baik", dan kemudian "berikan ia skor untuk apa yang ditulisnya sahaja, dan biarkan ia kembali untuk memahaminya dan terus membuat kemajuan" . Sudah tentu, perkara akan melibatkan lebih teknikal, seperti isu data seperti spesifikasi khusus dan kuantiti "esei cemerlang", serta isu algoritma seperti pemilihan model pemarkahan dalam pembelajaran pengukuhan dan penetapan parameter algoritma, yang semua akan memberi kesan kepada hasil akhir. Tetapi keputusan akhir menunjukkan bahawa kaedah ini sangat berkesan Kertas itu juga menunjukkan bahawa model kecil sebanyak 1.3 bilion yang dilatih melalui kaedah di atas boleh mengatasi model yang lebih besar yang tidak dilatih dengan cara ini.

Selain itu, terdapat beberapa kandungan dalam kertas yang patut disebut. Pertama, beberapa penemuan tentang Prompt. Prompt yang digunakan semasa latihan InstructGPT terutamanya terdiri daripada dua bahagian Satu bahagian ditulis oleh jurulatih AI khusus, dan bahagian lain berasal daripada kandungan yang ditulis oleh pengguna semasa perkhidmatan dalam talian model OpenAI Pada masa ini, peranan roda tenaga data dipantulkan. Ia boleh didapati bahawa tidak kira apa jenis gesaan itu, gesaan ini ditulis oleh orang sebenar Walaupun artikel itu tidak menjalankan analisis terperinci tentang kaedah liputan, pengedaran dan penyoalan khusus bagi gesaan ini, bolehlah diandai dengan munasabah bahawa. gesaan ini mempunyai ciri-ciri tertentu dan berkualiti tinggi. Malah, artikel itu membandingkan model yang dilatih menggunakan gesaan ini yang ditulis oleh orang sebenar dan model yang dilatih menggunakan gesaan yang dibina dalam beberapa set data tugas NLP sumber terbuka (seperti set data T0, set data FLAN Kesimpulannya ialah model itu dilatih). oleh orang sebenar yang menulis gesaan , jawapan yang diberikan lebih diterima oleh pengulas.

Maksud lain ialah mengenai keupayaan generalisasi model terlatih kepada Prompt baharu Adalah boleh difikirkan bahawa jika model terlatih tidak dapat menghasilkan keupayaan generalisasi Prompt , maka keupayaan yang ditunjukkan oleh. ChatGPT sekarang untuk menjawab hampir semua soalan tidak mungkin dapat dilakukan. Kerana dalam peringkat penalaan halus model, tidak kira berapa banyak data yang ada, adalah mustahil untuk merangkumi sepenuhnya semua kandungan yang mungkin dimasukkan oleh orang ramai. Kertas InstrctGPT menunjukkan bahawa kaedah yang digunakan dalam kertas boleh menghasilkan keupayaan generalisasi Prompt.

Sebab saya menghabiskan lebih banyak perkataan untuk memperkenalkan InstructGPT adalah kerana mengikut pengenalan pada halaman ChatGPT rasmi, kaedah dalam InstructGPT adalah kaedah yang digunakan untuk melatih ChatGPT bahawa ChatGPT Kaedah organisasi data perbualan digunakan.

era GPT-3.5 dan kelahiran ChatGPT

Dalam tempoh berikutnya, OpenAI mengeluarkan berbilang model yang dipanggil siri GPT-3.5 Walaupun model ini tidak mempunyai kertas berkaitan diterbitkan, menurut Analisis artikel ini. , siri GPT-3.5 harus dibangunkan dengan menyepadukan teknologi, data dan pengalaman yang dikumpul oleh OpenAI dalam era GPT-3. Memandangkan tiada rujukan maklumat awam rasmi yang terperinci, dunia luar terutamanya membuat spekulasi mengenai maklumat khusus model ini dengan menganalisis pengalaman penggunaan, kertas teknikal berkaitan dan pengenalan dokumentasi API OpenAI.

Menurut analisis, model siri GPT-3.5 mungkin tidak diperhalusi pada GPT-3, tetapi mungkin merupakan gabungan kod dan data bahasa semula jadi dilatih dari awal. Model ini, yang mungkin lebih besar daripada 175 bilion parameter GPT-3, dinamakan codex-davinci-002 dalam API OpenAI. Kemudian berdasarkan model asas ini, satu siri model seterusnya diperoleh melalui penalaan halus arahan dan maklum balas manusia, termasuk ChatGPT.

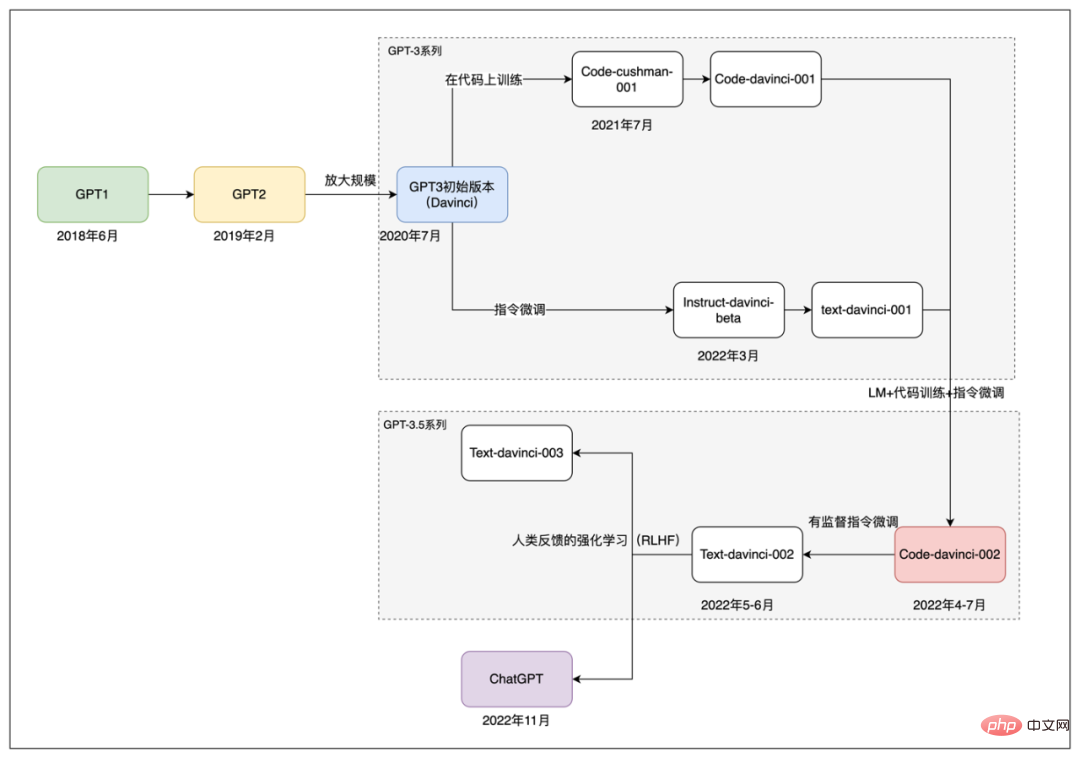

Laluan pembangunan model siri GPT.

Ringkasnya, bermula dari model code-davince-002, text-davinci-002 diperoleh melalui penalaan halus arahan yang diselia. Dan teks-davinci-003 dan ChatGPT seterusnya juga diperoleh melalui penalaan halus arahan dan maklum balas pembelajaran pengukuhan manusia pada model siri GPT-3.5. Dan text-davinci-003 dan ChatGPT kedua-duanya dikeluarkan pada November 2022. Perbezaannya ialah text-davinci-003, seperti GPT-3, ialah model pelengkapan teks. Menurut pengenalan rasmi ChatGPT, ia dilatih dengan memproses data lepas ke dalam bentuk interaksi perbualan dan menambah data perbualan baharu.

Setakat ini, kami telah menyemak secara kasar proses pembangunan dan lelaran model siri OpenAI GPT daripada GPT generasi pertama pada 2018 hingga ChatGPT semasa. Dalam proses ini, OpenAI sentiasa mengekalkan "kedegilan"nya dalam laluan teknikal model pra-latihan generatif , dan juga telah menyerap kaedah baharu daripada teknologi NLP yang berkembang struktur model Transformer awal kepada kemunculan teknologi kemudiannya seperti penalaan halus perintah (Penalaan segera), faktor-faktor ini telah bersama-sama menyumbang kepada kejayaan ChatGPT hari ini. Dengan pemahaman tentang pembangunan model siri GPT, kita boleh kembali dan melihat ChatGPT hari ini.

3 Lihatlah ChatGPT dengan lebih dekat

Dalam bab pertama, kami menjelaskan bahawa sebab utama ChatGPT berada di luar bulatan ialah: "Ia lancar. dan logik. Ia menggunakan bahasa semula jadi untuk menyalurkan kembali input bahasa semula jadi oleh manusia, sekali gus memberi orang yang berkomunikasi dengannya rasa kecerdasan yang kuat. Dalam Bab 2, kita akan belajar tentang laluan ChatGPT menuju kejayaan dengan menyemak sejarah pembangunan model siri GPT. Bab ini akan cuba mendalami sedikit kandungan teknikal dengan cara yang boleh difahami oleh orang luar, dan meneroka sebab beberapa model penjanaan teks berskala besar semasa gagal mencapai kesan yang sama. Rujukan utama untuk bahagian ini datang daripada dua artikel "Pemahaman Mendalam Mengenai Keupayaan Model Bahasa yang Muncul" dan "Merungkai dan Mengesan Asal-usul Keupayaan GPT-3.5" serta beberapa kertas kerja yang berkaitan ingin mengetahui lebih lanjut tentang butiran Pembaca membaca teks asal.

Walaupun telah dinyatakan dalam bab pertama bahawa kesan menakjubkan yang dibawa oleh ChatGPT dicerminkan secara menyeluruh oleh banyak tugas NLP yang berbeza, apabila menganalisis teknologi di belakangnya, ia masih melalui Ia akan menjadi lebih jelas untuk memecahkan keupayaannya. Secara keseluruhan, keupayaan yang terkandung oleh ChatGPT boleh dibahagikan secara kasar kepada dimensi berikut:

- Keupayaan penjanaan teks: Semua output ChatGPT dijana serta-merta Teks, jadi keupayaan untuk menjana teks adalah keperluan asasnya.

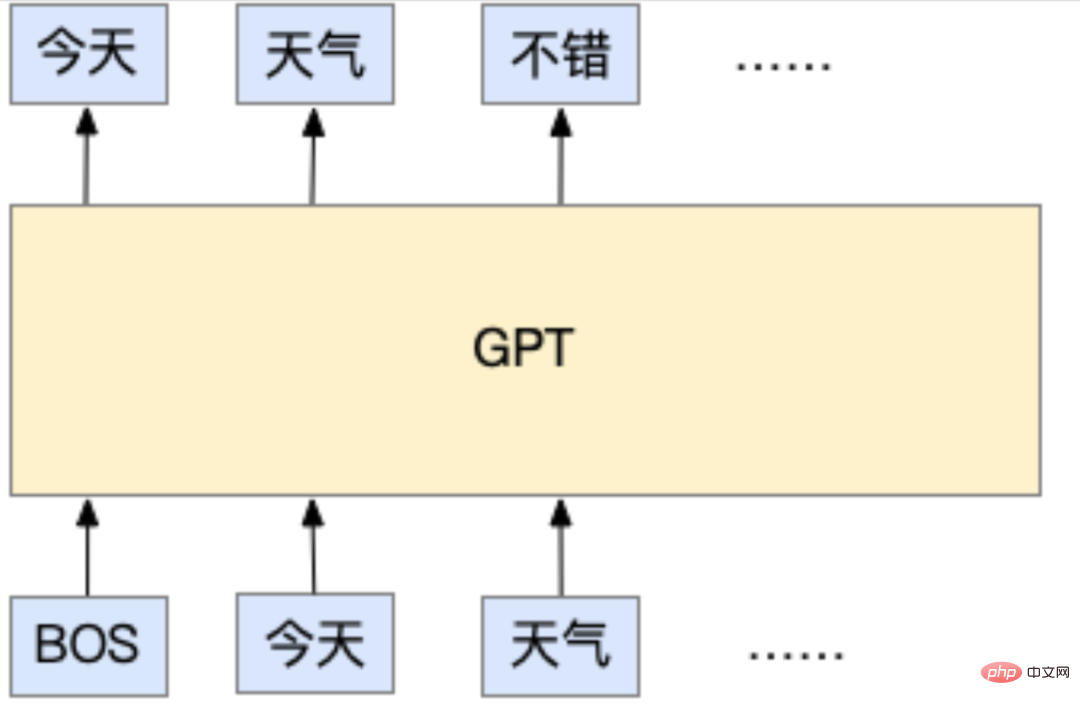

Keupayaan ini sebenarnya datang daripada kaedah latihannya Apabila ChatGPT dilatih, ia adalah tugas model bahasa autoregresif standard, yang merupakan asas untuk semua model siri OpenAI GPT. Tugas model bahasa autoregresif yang dipanggil, pemahaman yang popular adalah ini: ia boleh meramalkan token seterusnya harus berdasarkan teks yang telah dimasukkan. Token yang disebut di sini mewakili unit terkecil serpihan aksara yang digunakan oleh model. Ia boleh menjadi aksara (sangat biasa untuk menggunakan aksara dalam bahasa Cina) atau perkataan (setiap perkataan dalam bahasa Inggeris dipisahkan secara semula jadi oleh ruang). perkataan sering digunakan), atau bahkan huruf. Tetapi kaedah semasa biasanya menggunakan subkata (subkata, antara huruf dan perkataan, tujuan utama adalah untuk mengurangkan bilangan perkataan). Tetapi tidak kira yang mana satu itu, idea asas tugas model bahasa autoregresif adalah untuk meramalkan teks seterusnya akan dikeluarkan berdasarkan teks yang telah dimasukkan, sama seperti dalam contoh di bawah:

Dalam contoh ini, BOS mewakili permulaan input, dan setiap token ialah satu perkataan Model GPT menggunakan input ". hari ini" dan " Dengan dua perkataan "cuaca", diramalkan bahawa keluaran seterusnya adalah "baik".

Semasa latihan, banyak data teks akan disediakan, seperti artikel di halaman web, pelbagai buku, dll. Selagi ia kandungan teks biasa, ia boleh digunakan untuk latihan. Perlu disebutkan bahawa data jenis ini tidak memerlukan anotasi manual tambahan, kerana data jenis ini pada asalnya ditulis oleh orang-orang yang perlu dilakukan oleh model ini "memandangkan teks sebelumnya, berdasarkan teks yang ditulis oleh orang-orang ini , Kemudian soalan "Apakah tempat ini di sebalik kata-kata ini?" Inilah yang dipanggil oleh industri sebagai "latihan tanpa pengawasan." Sebenarnya, model itu sebenarnya tidak diselia (jika tidak, apakah model yang akan dipelajari?), tetapi datanya tidak memerlukan anotasi manual tambahan. Tepat kerana tugas ini tidak memerlukan anotasi tambahan, sejumlah besar data boleh diperolehi "secara percuma". Ini juga merupakan salah satu ciri model siri GPT Sejumlah besar data digunakan untuk melatih model besar.

Jadi apabila kita menggunakan ChatGPT, bagaimana ia berfungsi? Malah, ia adalah sama dengan kaedah latihannya Model akan meramalkan token seterusnya mengikut kandungan berdasarkan kandungan yang kita masukkan dalam kotak dialog Selepas mendapat token ini, ia akan disambungkan dengan kandungan sebelumnya menjadi a yang baharu. Teks diberikan kepada model, dan model meramalkan token seterusnya, dan seterusnya, sehingga syarat tertentu dipenuhi dan berhenti. Terdapat banyak cara yang berbeza untuk mereka bentuk keadaan berhenti ini Contohnya, teks output boleh mencapai panjang tertentu, atau model meramalkan token khas yang digunakan untuk mewakili berhenti. Perlu juga dinyatakan bahawa apabila model meramalkan token seterusnya, ia sebenarnya adalah proses pensampelan di belakang tabir. Dalam erti kata lain, apabila model meramalkan token, ia sebenarnya mengeluarkan kebarangkalian semua token yang mungkin, dan kemudian sampel token daripada taburan kebarangkalian ini. Oleh itu, apabila menggunakan ChatGPT, anda akan mendapati bahawa walaupun untuk input yang sama, outputnya akan berbeza setiap kali kerana ia secara rahsia mengambil sampel token yang berbeza sebagai output.

Selepas memahami perkara ini, anda boleh kembali dan berfikir tentang perkara yang dipelajari oleh model tersebut. Adakah ia belajar bagaimana untuk menjawab soalan dan jawapan? Atau adakah ia belajar bagaimana memahami maklumat, logik, dan emosi yang terkandung dalam bahasa semula jadi? Atau adakah ia mempelajari sejumlah besar pengetahuan? Berdasarkan reka bentuk tugas latihan, nampaknya tidak ada perkara seperti itu hanya belajar dari data teks besar-besaran "apa yang akan ditulis oleh manusia berdasarkan teks input." Tetapi model seperti inilah yang, apabila ia "berkembang" kepada ChatGPT, ia telah menguasai pengetahuan yang kaya, penaakulan logik yang kompleks, dll. Ia seolah-olah telah menguasai hampir semua kebolehan yang diperlukan oleh manusia untuk menggunakan bahasa. Ini adalah perkara yang sangat ajaib, dan proses "evolusi"nya akan diperkenalkan dengan lebih mendalam dalam bab seterusnya.

- Rizab pengetahuan yang kaya: ChatGPT boleh menjawab banyak soalan dengan betul, termasuk sejarah, sastera, matematik, fizik, pengaturcaraan, dll. Oleh kerana versi semasa ChatGPT tidak menggunakan pengetahuan luaran, kandungan pengetahuan ini "disimpan" dalam model.

Pangkalan pengetahuan ChatGPT yang kaya datang daripada data latihannya dan saiznya yang cukup besar untuk mempelajari kandungan ini. Walaupun pegawai itu tidak mendedahkan butiran khusus data latihan yang digunakan oleh ChatGPT, ia boleh disimpulkan daripada kertas GPT-3 pendahulunya bahawa data itu boleh dibahagikan secara kasar kepada tiga kategori besar: kandungan web, kandungan buku dan ensiklopedia kandungan. Boleh dibayangkan bahawa kandungan ini secara semula jadi mengandungi sejumlah besar pengetahuan, apatah lagi ensiklopedia dan buku, tetapi kandungan web juga mengandungi banyak berita, ulasan, pendapat, dll., dan halaman web juga termasuk banyak laman web menegak Soal Jawab khusus. . , ini adalah sumber pengetahuan ChatGPT. Pengenalan rasmi menunjukkan bahawa ChatGPT tidak dapat menjawab apa yang berlaku selepas 2021, jadi andaian munasabah ialah pengumpulan data latihan berakhir pada 2021.

Tetapi jumlah data hanya satu aspek untuk model "menguasai" data ini, volumnya sendiri tidak boleh kecil. Ambil GPT-3 sebagai contoh Ia mempunyai 175 bilion parameter Secara kasar boleh difahami bahawa kandungan data ini dan pelbagai keupayaan model ditetapkan dalam model terlatih dalam bentuk nilai khusus setiap parameter. . Pemahaman persepsi ialah jika model hanya mempunyai 1 parameter, maka ia tidak boleh berbuat apa-apa. Untuk analisis dan perbandingan yang lebih teliti, anda boleh merujuk kepada penilaian kertas kerja ini "Penilaian Holistik Model Bahasa".

Alamat kertas: https://arxiv.org/pdf/2211.09110.pdf

- Keupayaan penaakulan logik dan rantaian pemikiran: Seperti yang dapat dilihat daripada contoh ayam dan arnab dalam sangkar yang sama dalam gambar dalam Bab 1, ChatGPT mempunyai keupayaan penaakulan logik yang kuat. Dan ia boleh memecahkan kandungan kompleks kepada beberapa langkah kecil, melakukan penaakulan langkah demi langkah, dan mendapatkan jawapan akhir Keupayaan ini dipanggil rantaian berfikir.

Daripada pengenalan sebelum ini, kita tahu bahawa model itu tidak direka khusus untuk penaakulan logik dan rantaian pemikiran semasa latihan. Pandangan arus perdana semasa ialah penaakulan logik dan rantaian pemikiran mungkin berkaitan dengan dua faktor Yang pertama ialah saiz model, dan yang kedua ialah sama ada model itu telah dilatih mengenai data kod.

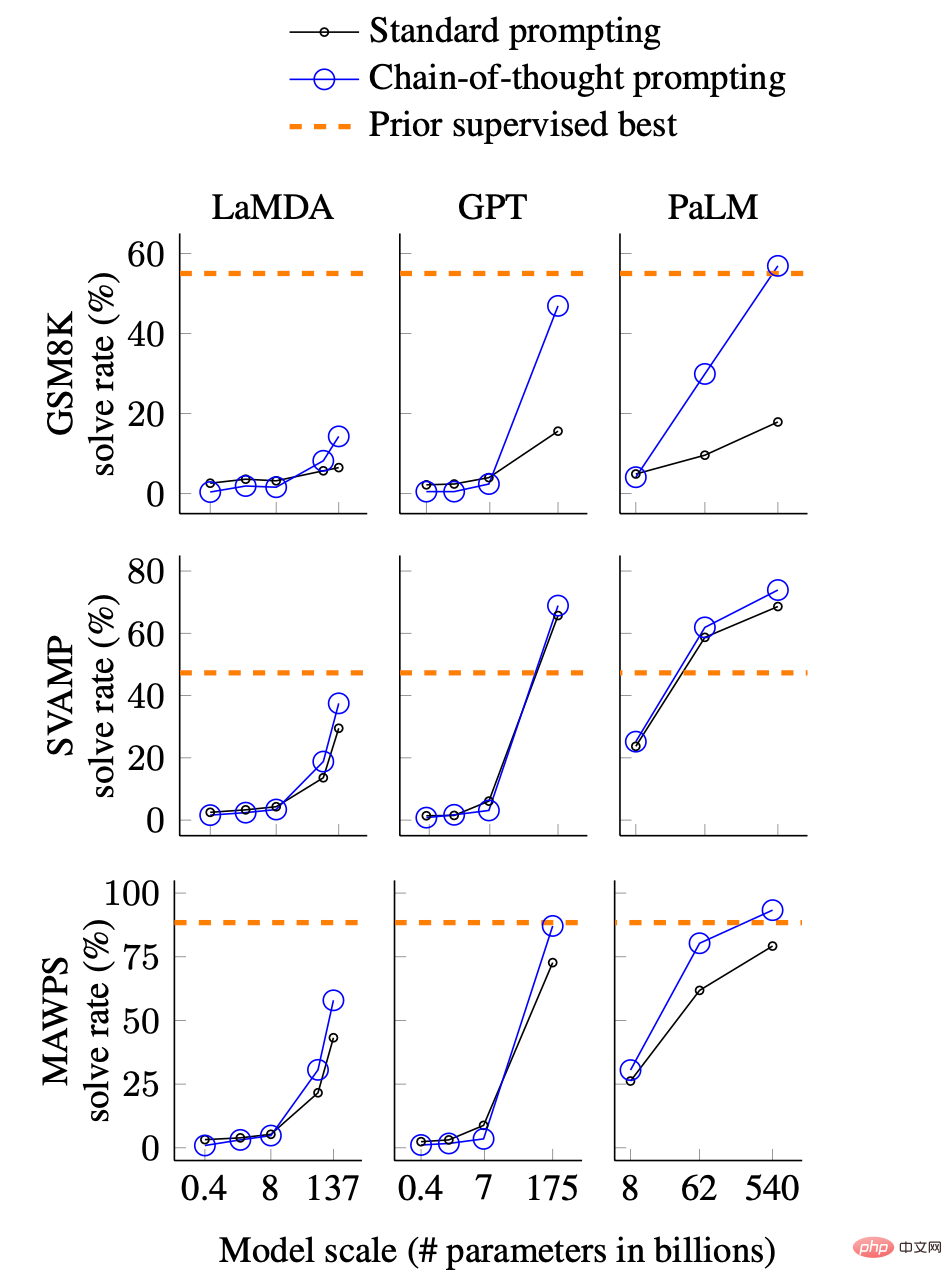

Mengenai hubungan antara saiz model dan keupayaan penaakulan dan rantaian pemikiran, terdapat pengenalan yang sepadan dalam "Pemahaman Mendalam tentang Keupayaan Model Bahasa yang Muncul". Gambar di bawah menunjukkan hubungan antara keupayaan rantai berfikir dengan saiz model.

Perbandingan kesan rantaian pemikiran model yang berbeza dan saiz yang berbeza, gambar berasal dari kertas. GSM8K, SVAMP dan MAWPS ialah tiga set data masalah perkataan matematik yang memerlukan penaakulan logik, dan LaMDA, GPT dan PaLM ialah tiga model berbeza masing-masing.

Secara ringkas, carta menunjukkan kadar jawapan yang betul bagi tiga model berbeza pada tiga set data masalah perkataan matematik. Apa yang patut diberi perhatian ialah aspek berikut:

- Keupayaan rantaian pemikiran (garisan pepejal biru) mempunyai kesan perubahan mendadak apabila saiz model cukup besar; >

- Selagi model itu cukup besar, kesan rantaian pemikiran melebihi kaedah dorongan standard (garisan pepejal hitam)

- Keupayaan rantaian pemikiran boleh mendekati atau bahkan melebihi kaedah yang diawasi (garis putus-putus oren) apabila model itu cukup besar.

Dalam istilah orang awam, apabila model itu cukup besar, keupayaan rantaian pemikiran tiba-tiba muncul dan boleh mencapai atau bahkan melebihi mereka yang khusus dalam set data penaakulan untuk latihan yang diselia. Angka ini sebahagiannya mungkin menerangkan keupayaan penaakulan dan rantaian pemikiran ChatGPT yang sangat baik yang kita lihat sekarang.

Satu lagi faktor mengenai keupayaan penaakulan dan rantai pemikiran adalah berkaitan sama ada model itu telah dilatih mengenai data kod. Pada masa ini, ini hanyalah satu kesimpulan Analisis dalam "Merungkai dan Mengesan Asal Keupayaan GPT-3.5" menunjukkan bahawa model besar dengan saiz yang sama mempunyai rantai pemikiran dan penaakulan yang sangat lemah atau hampir tiada jika mereka tidak dilatih kod tersebut. Dan ChatGPT sememangnya dilatih mengenai data kod, yang juga boleh dilihat dari keupayaannya untuk memahami dan menjana kod. Seperti yang dinyatakan dalam semakan proses pembangunan dalam Bab 2, OpenAI mengeluarkan model CodeX khusus untuk kod pada tahun 2021. Penambahan data kod pada data latihan GPT sepatutnya bermula sejak itu.

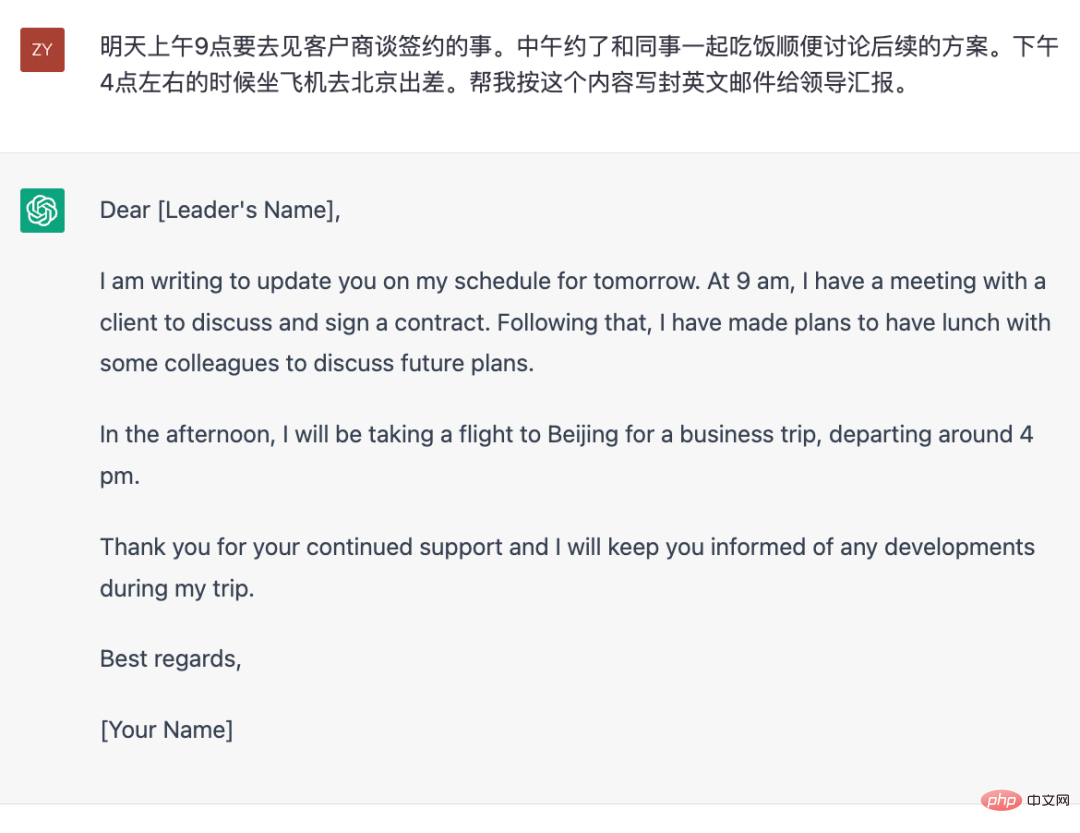

- Keupayaan untuk menjawab soalan atau arahan orang: Selain interaksi berasaskan "soal jawab" yang sempit, ChatGPT juga boleh bertindak balas kepada keperluan input . Sebagai contoh, ia juga telah menunjukkan keupayaan yang sangat baik apabila membalas permintaan gaya arahan seperti "Tulis surat untuk saya." Keupayaan ini menjadikannya bukan sahaja "enjin carian termaju" yang menyediakan jawapan, tetapi juga alat pemprosesan perkataan yang boleh berinteraksi dengan bahasa semula jadi.

Walaupun orang ramai pada masa ini menumpukan pada ChatGPT sebagai alat seperti enjin carian, mengakses pengetahuan yang berkaitan dan memberi jawapan bukanlah satu-satunya keupayaannya. Malah, setakat ChatGPT sendiri, menjawab soalan pengetahuan bukanlah titik kukuhnya Lagipun, data latihannya sendiri ditetapkan pada 2021. Walaupun ia dilatih dengan data yang dikemas kini, ia tidak dapat mengikuti perubahan dalam hal ehwal semasa Oleh itu, untuk menggunakannya sebagai alat soal jawab pengetahuan, ia masih perlu digabungkan dengan sumber pengetahuan luar seperti enjin carian, sama seperti apa. Bing melakukannya sekarang.

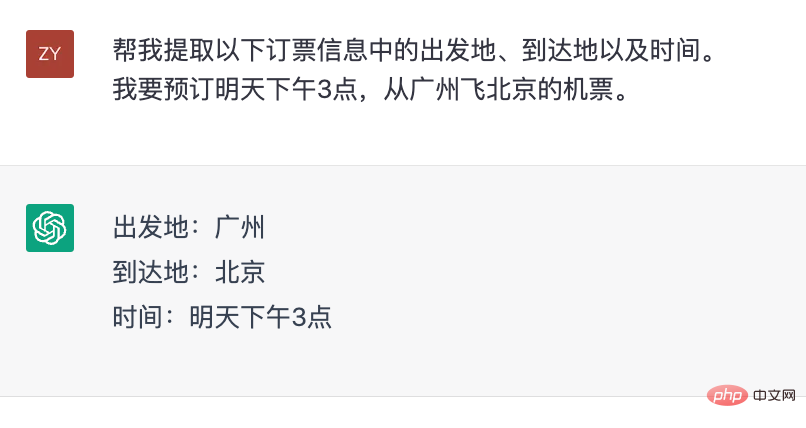

Tetapi dari perspektif lain, ChatGPT adalah seperti alat teks "lengkap bahasa", iaitu, ia boleh menyelesaikan tugasan yang ditentukan dalam bentuk teks mengikut keperluan yang anda berikan kandungan adalah seperti contoh di bawah.

Jana e-mel Bahasa Inggeris untuk pelaporan mengikut kandungan pelan yang diberikan.

"kesempurnaan bahasa" yang disebut di sini merujuk kepada kebolehan menggunakan bahasa. Dapat dilihat dalam contoh di atas, sebenarnya tidak ada kandungan intelektual yang terlibat, kerana kandungan yang perlu ditulis telah pun disediakan kepadanya. Tetapi menulis e-mel ini melibatkan keupayaan untuk menggunakan bahasa, seperti memilih perkataan dan ayat, menukar bahasa, format e-mel, dsb.

Sekarang mari kita kembali dan cuba menganalisis bagaimana keupayaannya untuk "menyiapkan tugas mengikut arahan" diperolehi. Dalam akademia, arahan seperti ini dipanggil prompt Malah, input pengguna dalam perbualan dan soalan dalam Soal Jawab juga boleh difahami secara kasar bahawa semua yang dimasukkan dalam kotak sembang adalah pantas. Jika anda memahami perkara yang kami perkenalkan model bahasa dalam bahagian pertama bab ini, maka pernyataan yang lebih tegas adalah bahawa "input di atas untuk model" adalah semua gesaan.

Keupayaan ChatGPT untuk membalas mengikut arahan input (prompt) datang daripada kaedah latihan model yang dipanggil command fine-tuning (prompt talaan). Malah, prinsipnya adalah sangat mudah Model ini masih "meramalkan token seterusnya berdasarkan kandungan input Walau bagaimanapun, dalam peringkat penalaan halus arahan, kandungan input digantikan dengan gesaan pra-tulis ini, dan kandungannya." yang perlu dijana selepas gesaan ialah , iaitu jawapan yang ditulis terlebih dahulu. Oleh itu, perbezaan terbesar antara peringkat ini dan latihan model bahasa autoregresif tanpa pengawasan yang disebut pada permulaan terletak pada data. Data di sini, iaitu gesaan dan respons yang sepadan, semuanya ditulis oleh manusia Dalam erti kata lain, peringkat ini menggunakan latihan diselia dengan data berlabel secara manual.

Mengenai data yang dilabel secara manual, ia secara semula jadi melibatkan jumlah data yang diperlukan, kerana setiap data berlabel memerlukan kos. Jika tidak ada keperluan untuk pelabelan (sama seperti peringkat pertama latihan), maka secara semulajadi akan terdapat sejumlah besar data teks yang tersedia untuk latihan, tetapi jika pelabelan diperlukan, berapa banyak data ini diperlukan? Anda tahu, kosnya adalah sangat tinggi untuk anotasi menulis gesaan dan kemudian menulis jawapan yang benar dan terperinci beberapa ratus perkataan. Menurut kertas kerja "Melatih model bahasa untuk mengikuti arahan dengan maklum balas manusia", data yang diperlukan sebenarnya tidak memerlukan banyak (berbanding dengan data yang digunakan dalam peringkat tanpa pengawasan). Walaupun tiada maklumat tepat yang didedahkan tentang berapa banyak ChatGPT digunakan, pastinya ia mestilah jauh lebih kecil dalam magnitud daripada set data yang terdiri daripada halaman web, ensiklopedia dan buku yang digunakan untuk latihan tanpa pengawasan.

Alamat kertas: https://arxiv.org/pdf/2203.02155.pdf

Hanya yang agak kecil Jumlah diperlukan Data segera beranotasi buatan boleh mencapai tujuan membenarkan model bertindak balas mengikut arahan Sebenarnya terdapat fenomena di sebalik ini, yang dipanggil keupayaan generalisasi gesaan dalam komuniti akademik. Seperti yang anda boleh bayangkan, orang di seluruh dunia bertanya soalan ChatGPT sepanjang masa, dan soalan yang mereka ajukan mestilah semua jenis soalan yang pelik sebenarnya. Tetapi pastinya tidak begitu banyak gesaan yang digunakan untuk memperhalusi arahan ChatGPT Ini menunjukkan bahawa selepas model mempelajari sejumlah gesaan dan jawapan yang sepadan, ia boleh "membuat kesimpulan" tentang gesaan yang belum pernah dilihatnya ialah keupayaan generalisasi bagi segera. Analisis artikel "Teardown dan jejak asal usul pelbagai keupayaan GPT-3.5" menunjukkan bahawa keupayaan generalisasi ini adalah berkait rapat dengan fasa penalaan halus arahan Berkaitan dengan jumlah dan kepelbagaian data berlabel yang dipelajari oleh model.

Selain itu, sejumlah kecil data segera boleh digunakan untuk memperhalusi model berkuasa seperti ChatGPT Terdapat satu lagi tekaan di belakangnya, iaitu pelbagai parameter yang dipaparkan oleh model. Kebolehan mungkin sudah wujud dalam model semasa peringkat latihan tanpa pengawasan. Malah, ini mudah difahami Lagipun, berbanding dengan data yang tidak diselia, bilangan gesaan yang dilabel secara manual ini adalah terlalu kecil. Sukar untuk membayangkan bahawa model itu telah membangunkan pelbagai kebolehan dengan belajar daripada data berlabel ini. Dari perspektif ini, proses penalaan halus arahan lebih kepada membiarkan model belajar bertindak balas mengikut spesifikasi tertentu, dan pengetahuan, logik dan keupayaan lain sudah wujud.

- Keupayaan untuk menjadi "objektif dan tidak berat sebelah": Jika anda bertanya kepada ChatGPT beberapa soalan yang berbahaya atau kontroversi, anda dapat melihat bahawa jawapan ChatGPT sangat "berhati-hati". jurucakap akhbar terlatih. Walaupun ia masih belum cukup baik, keupayaan ini adalah faktor teras yang membuatkan OpenAI berani menggunakannya secara terbuka sebagai produk.

Menjadikan output model konsisten dengan nilai kemanusiaanadalah yang OpenAI lakukan. Seawal GPT-3 pada 2020, OpenAI mendapati bahawa model yang dilatih melalui data dalam talian ini akan menghasilkan kandungan yang diskriminasi, berbahaya dan kontroversi. Sebagai produk yang menyediakan perkhidmatan luaran, kandungan berbahaya ini jelas tidak sesuai. ChatGPT semasa telah bertambah baik dengan ketara pada perkara ini Kaedah utama untuk membuat model "perubahan tingkah laku" ini juga datang dari kertas InstructGPT Untuk lebih tepat, ia adalah melalui penyeliaan arahan yang diselia serta maklum balas manusia bersama dengan pembelajaran pengukuhan, yang juga telah diperkenalkan dalam Bab 2.

Melalui analisis di atas, kita dapati bahawa dari perspektif kaedah teknikal, semua kandungan yang berkaitan dengan ChatGPT diketahui, tetapi mengapa ia satu-satunya yang mempunyai prestasi yang menakjubkan pada masa ini? Malah, sejak pelancaran ChatGPT, komuniti NLP telah menganalisis sebabnya Walaupun banyak kesimpulan adalah spekulatif, mereka juga membawa sedikit pencerahan untuk penyetempatan model yang serupa.

Faktor saiz model

Premis untuk kemunculan keupayaan ialah saiz model mencapai tertentu skala. Walaupun tiada garis panduan penunjuk yang khusus, tetapi jika dilihat dari fakta semasa, keupayaan yang agak "maju" seperti rantaian pemikiran perlu menunjukkan prestasi yang cukup baik dalam model dengan berpuluh bilion parameter atau lebih.

Faktor volum data

Saiz model bukan satu-satunya faktor. DeepMind menyediakan beberapa kesimpulan analisis dalam kertas kerja ini "Melatih Model Bahasa Besar Pengiraan-Optimal", menunjukkan bahawa jumlah data latihan perlu meningkat dengan sewajarnya dengan saiz model Untuk menjadi lebih tepat, apabila melatih model, "lihat The bilangan token perlu meningkat dengan saiz model.

Alamat kertas: https://arxiv.org/pdf/2203.15556.pdf

Data Faktor kualiti

Untuk data yang tidak diselia, jumlah data bukanlah halangan yang besar, tetapi kualiti data selalunya lebih mudah diabaikan. Malah, dalam kertas GPT-3, terdapat kandungan khas mengenai pemprosesan data. Untuk membersihkan data latihan GPT-3, OpenAI melatih khas model penapisan data untuk mendapatkan data berkualiti tinggi daripada data halaman web yang besar. Sebagai perbandingan, beberapa model sumber terbuka dengan saiz yang setanding dengan GPT-3, seperti Meta's Opt dan BigScience's Bloom, nampaknya tidak menjalani langkah pembersihan ini. Ini mungkin salah satu sebab mengapa kedua-dua model sumber terbuka ini lebih teruk daripada GPT-3.

Selain itu, dimensi pengukuran kualiti data tidak tunggal Faktor seperti kepelbagaian data, pertindihan kandungan dan pengedaran data adalah semua faktor yang perlu dipertimbangkan. Sebagai contoh, walaupun jumlah data halaman web adalah yang terbesar antara tiga kategori data yang digunakan oleh GPT-3: halaman web, ensiklopedia dan buku, pensampelan ketiga-tiga jenis data ini semasa latihan tidak berdasarkan jumlah data.

Perlu juga dinyatakan bahawa dalam peringkat arahan penalaan halus, penggunaan penulisan arahan manual mungkin merupakan faktor yang mempengaruhi penting. Kertas InstructGPT dengan jelas menunjukkan bahawa semasa proses penilaian, model yang dilatih menggunakan arahan bertulis secara manual mempunyai hasil yang lebih baik daripada model yang dilatih menggunakan set data NLP sedia ada untuk membina arahan melalui templat. Ini mungkin menjelaskan mengapa model yang dilatih pada set data arahan yang terdiri daripada set data NLP seperti T0 dan FLAN kurang berkesan.

Impak proses latihan

Model gergasi tersebut dilatih melalui kelompok semasa menggunakan selari data , model selari, dan pengoptimum ZeRO (satu kaedah untuk mengurangkan penggunaan memori proses latihan), kaedah ini memperkenalkan lebih banyak pembolehubah kepada kestabilan latihan. Analisis berikut menunjukkan bahawa sama ada model menggunakan ketepatan bfloat16 mempunyai kesan yang ketara ke atas keputusan.

Pautan analisis: https://jingfengyang.github.io/gpt

Saya percaya anda faham perkara di atas Kandungan, semua orang akan mempunyai pemahaman umum tentang cara memalsukan versi seperti ChatGPT dan masalah yang akan dihadapi. Mujurlah, OpenAI telah membuktikan bahawa laluan teknikal ini boleh dilaksanakan, dan kemunculan ChatGPT sememangnya mengubah arah aliran pembangunan teknologi NLP.

4 Tinjauan Masa Depan

ChatGPT telah menarik perhatian hebat sejak dilancarkan pada November 2022. Saya percaya bahawa walaupun bukan profesional, dan juga kumpulan yang mempunyai sedikit hubungan dengan komputer, lebih kurang menyedari kewujudannya Fenomena ini sendiri sudah mencerminkan bahawa penampilannya agak luar biasa. Orang ramai di luar bulatan melihat penampilannya lebih persepsi dengan rasa ingin tahu, terkejut atau kagum. Bagi pengamal, kemunculannya lebih kepada memikirkan arah aliran teknologi masa hadapan.

Dari sudut teknikal, kemunculan ChatGPT menandakan satu lagi anjakan paradigma dalam bidang NLP . Sebab mengapa ia dikatakan "sekali lagi" adalah kerana pada tahun 2018, tahun apabila generasi pertama GPT dikeluarkan, model BERT yang dikeluarkan pada tahun yang sama mencipta paradigma "pra-latihan + penalaan halus" NLP dengan prestasinya yang sangat baik Kandungan khusus era itu telah diperkenalkan dalam Bab 2. Di sini kami terutamanya memperkenalkan paradigma "penjanaan teks + arahan" yang didayakan oleh ChatGPT. Khususnya, ia adalah untuk menggunakan ChatGPT terlatih atau model penjanaan teks yang serupa untuk melengkapkan senario tertentu dengan memasukkan arahan yang sesuai (prompt).

Paradigma ini sangat berbeza daripada aplikasi teknologi NLP sebelum ini. Sama ada era awal menggunakan model statistik seperti LDA dan RNN atau model pembelajaran mendalam yang kecil, atau era kemudian menggunakan pra-latihan dan penalaan halus seperti BERT, keupayaan yang disediakan oleh teknologi adalah agak mengatomisasi dan jauh. jauh daripada senario aplikasi sebenar pada jarak tertentu.

Ambil contoh di atas untuk meminta ChatGPT menulis e-mel bahasa Inggeris mengikut keperluan mengikut amalan sebelumnya, anda mungkin perlu mengekstrak entiti, acara dan kandungan lain (seperti masa, lokasi, acara, dll. .) dahulu, dan kemudian gunakan templat atau Model membentuk format e-mel, yang kemudiannya ditukar kepada bahasa Inggeris melalui model terjemahan. Sudah tentu, jika jumlah data mencukupi untuk melatih model hujung ke hujung, anda juga boleh melangkau beberapa langkah perantaraan. Tetapi tidak kira kaedah yang digunakan, sama ada adegan akhir perlu dipecahkan kepada tugas NLP atom, atau data anotasi yang sepadan diperlukan. Untuk ChatGPT, yang diperlukan hanyalah arahan yang sesuai.

Tiga peringkat paradigma teknologi NLP.

Model generatif dengan gesaan ini terus melangkau pelbagai komponen keupayaan NLP di tengah dan menyelesaikan aplikasi dengan cara yang paling langsung Masalah dengan tempat kejadian . Di bawah paradigma ini, laluan teknikal untuk melengkapkan aplikasi terminal tidak lagi menjadi gabungan modul keupayaan NLP titik tunggal melalui blok binaan.

Sudah tentu, proses ini tidak dicapai dalam sekelip mata, dan juga tidak bermakna keupayaan satu mata NLP menjadi tidak penting. Dari perspektif penilaian, kualiti setiap titik kebolehan masih boleh digunakan sebagai penunjuk untuk menilai keberkesanan model. Selain itu, dalam beberapa senario, keupayaan satu titik masih menjadi permintaan yang kukuh. Sebagai contoh, dalam sistem tempahan tiket, adalah perlu untuk mengekstrak masa dan lokasi. Tetapi tidak seperti sebelum ini, ChatGPT sendiri juga boleh melengkapkan keupayaan satu titik tanpa menggunakan modul berfungsi tambahan.

ChatGPT untuk pengekstrakan maklumat.

CtGPT membuat pertimbangan emosi.

Dari perspektif ini, ChatGPT boleh dianggap sebagai alat NLP yang menggunakan bahasa semula jadi sebagai medium interaktif. Jika pada masa lalu, kami menyelesaikan keupayaan NLP tertentu melalui model + data + tugas latihan reka bentuk, kemudian ChatGPT melengkapkan keupayaan ini melalui arahan reka bentuk.

Seperti yang anda boleh bayangkan, kemunculan ChatGPT telah banyak merendahkan ambang aplikasi teknologi NLP. Tetapi ia belum lagi maha kuasa. Perkara yang paling penting ialah ia tidak mempunyai pengetahuan domain menegak yang tepat dan boleh dipercayai Untuk menjadikan jawapannya boleh dipercayai, cara paling langsung adalah dengan menyediakannya dengan sumber pengetahuan luaran, sama seperti Microsoft menggunakan hasil carian Bing sebagai sumber maklumat untuk. jawapannya.

Oleh itu, teknologi NLP "tradisional" tidak akan pupus sepenuhnya, tetapi akan memainkan peranan "bantuan" untuk menambah kekurangan semasa ChatGPT Ini mungkin masa depan Paradigma baharu aplikasi teknologi NLP.

Atas ialah kandungan terperinci Masa lalu dan masa kini ChatGPT: 'kedegilan' dan 'perjudian besar' teknologi OpenAI. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1376

1376

52

52

Geospatial Laravel: Pengoptimuman peta interaktif dan sejumlah besar data

Apr 08, 2025 pm 12:24 PM

Geospatial Laravel: Pengoptimuman peta interaktif dan sejumlah besar data

Apr 08, 2025 pm 12:24 PM

Cecair memproses 7 juta rekod dan membuat peta interaktif dengan teknologi geospatial. Artikel ini meneroka cara memproses lebih dari 7 juta rekod menggunakan Laravel dan MySQL dan mengubahnya menjadi visualisasi peta interaktif. Keperluan Projek Cabaran Awal: Ekstrak Wawasan berharga menggunakan 7 juta rekod dalam pangkalan data MySQL. Ramai orang mula -mula mempertimbangkan bahasa pengaturcaraan, tetapi mengabaikan pangkalan data itu sendiri: Bolehkah ia memenuhi keperluan? Adakah penghijrahan data atau pelarasan struktur diperlukan? Bolehkah MySQL menahan beban data yang besar? Analisis awal: Penapis utama dan sifat perlu dikenalpasti. Selepas analisis, didapati bahawa hanya beberapa atribut yang berkaitan dengan penyelesaiannya. Kami mengesahkan kemungkinan penapis dan menetapkan beberapa sekatan untuk mengoptimumkan carian. Carian Peta Berdasarkan Bandar

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Terdapat banyak sebab mengapa permulaan MySQL gagal, dan ia boleh didiagnosis dengan memeriksa log ralat. Penyebab umum termasuk konflik pelabuhan (periksa penghunian pelabuhan dan ubah suai konfigurasi), isu kebenaran (periksa keizinan pengguna yang menjalankan perkhidmatan), ralat fail konfigurasi (periksa tetapan parameter), rasuah direktori data (memulihkan data atau membina semula ruang meja), isu ruang jadual InnoDB (semak fail ibdata1) Apabila menyelesaikan masalah, anda harus menganalisisnya berdasarkan log ralat, cari punca utama masalah, dan mengembangkan tabiat sandaran data secara teratur untuk mencegah dan menyelesaikan masalah.

Cara Menggunakan MySQL Selepas Pemasangan

Apr 08, 2025 am 11:48 AM

Cara Menggunakan MySQL Selepas Pemasangan

Apr 08, 2025 am 11:48 AM

Artikel ini memperkenalkan operasi pangkalan data MySQL. Pertama, anda perlu memasang klien MySQL, seperti MySqlworkbench atau Command Line Client. 1. Gunakan perintah MySQL-Uroot-P untuk menyambung ke pelayan dan log masuk dengan kata laluan akaun root; 2. Gunakan CreateTatabase untuk membuat pangkalan data, dan gunakan Pilih pangkalan data; 3. Gunakan createtable untuk membuat jadual, menentukan medan dan jenis data; 4. Gunakan InsertInto untuk memasukkan data, data pertanyaan, kemas kini data dengan kemas kini, dan padam data dengan padam. Hanya dengan menguasai langkah -langkah ini, belajar menangani masalah biasa dan mengoptimumkan prestasi pangkalan data anda boleh menggunakan MySQL dengan cekap.

Memahami sifat asid: tiang pangkalan data yang boleh dipercayai

Apr 08, 2025 pm 06:33 PM

Memahami sifat asid: tiang pangkalan data yang boleh dipercayai

Apr 08, 2025 pm 06:33 PM

Penjelasan terperinci mengenai atribut asid asid pangkalan data adalah satu set peraturan untuk memastikan kebolehpercayaan dan konsistensi urus niaga pangkalan data. Mereka menentukan bagaimana sistem pangkalan data mengendalikan urus niaga, dan memastikan integriti dan ketepatan data walaupun dalam hal kemalangan sistem, gangguan kuasa, atau pelbagai pengguna akses serentak. Gambaran keseluruhan atribut asid Atomicity: Transaksi dianggap sebagai unit yang tidak dapat dipisahkan. Mana -mana bahagian gagal, keseluruhan transaksi dilancarkan kembali, dan pangkalan data tidak mengekalkan sebarang perubahan. Sebagai contoh, jika pemindahan bank ditolak dari satu akaun tetapi tidak meningkat kepada yang lain, keseluruhan operasi dibatalkan. Begintransaction; UpdateAcCountSsetBalance = Balance-100Wh

Jurutera Backend Senior Remote (Platform) memerlukan kalangan

Apr 08, 2025 pm 12:27 PM

Jurutera Backend Senior Remote (Platform) memerlukan kalangan

Apr 08, 2025 pm 12:27 PM

Jurutera Backend Senior Remote Company Kekosongan Syarikat: Lokasi Lokasi: Jauh Pejabat Jauh Jenis: Gaji sepenuh masa: $ 130,000- $ 140,000 Penerangan Pekerjaan Mengambil bahagian dalam penyelidikan dan pembangunan aplikasi mudah alih Circle dan ciri-ciri berkaitan API awam yang meliputi keseluruhan kitaran hayat pembangunan perisian. Tanggungjawab utama kerja pembangunan secara bebas berdasarkan rubyonrails dan bekerjasama dengan pasukan react/redux/relay front-end. Membina fungsi teras dan penambahbaikan untuk aplikasi web dan bekerjasama rapat dengan pereka dan kepimpinan sepanjang proses reka bentuk berfungsi. Menggalakkan proses pembangunan positif dan mengutamakan kelajuan lelaran. Memerlukan lebih daripada 6 tahun backend aplikasi web kompleks

Bolehkah mysql kembali json

Apr 08, 2025 pm 03:09 PM

Bolehkah mysql kembali json

Apr 08, 2025 pm 03:09 PM

MySQL boleh mengembalikan data JSON. Fungsi JSON_EXTRACT mengekstrak nilai medan. Untuk pertanyaan yang kompleks, pertimbangkan untuk menggunakan klausa WHERE untuk menapis data JSON, tetapi perhatikan kesan prestasinya. Sokongan MySQL untuk JSON sentiasa meningkat, dan disyorkan untuk memberi perhatian kepada versi dan ciri terkini.

Mysql tidak dapat dipasang setelah memuat turun

Apr 08, 2025 am 11:24 AM

Mysql tidak dapat dipasang setelah memuat turun

Apr 08, 2025 am 11:24 AM

Sebab utama kegagalan pemasangan MySQL adalah: 1. Isu kebenaran, anda perlu menjalankan sebagai pentadbir atau menggunakan perintah sudo; 2. Ketergantungan hilang, dan anda perlu memasang pakej pembangunan yang relevan; 3. Konflik pelabuhan, anda perlu menutup program yang menduduki port 3306 atau mengubah suai fail konfigurasi; 4. Pakej pemasangan adalah korup, anda perlu memuat turun dan mengesahkan integriti; 5. Pembolehubah persekitaran dikonfigurasikan dengan salah, dan pembolehubah persekitaran mesti dikonfigurasi dengan betul mengikut sistem operasi. Selesaikan masalah ini dan periksa dengan teliti setiap langkah untuk berjaya memasang MySQL.

Laravel fasih orm dalam carian model separa Bangla)

Apr 08, 2025 pm 02:06 PM

Laravel fasih orm dalam carian model separa Bangla)

Apr 08, 2025 pm 02:06 PM

Pengambilan Model Laraveleloquent: Mudah mendapatkan data pangkalan data Eloquentorm menyediakan cara ringkas dan mudah difahami untuk mengendalikan pangkalan data. Artikel ini akan memperkenalkan pelbagai teknik carian model fasih secara terperinci untuk membantu anda mendapatkan data dari pangkalan data dengan cekap. 1. Dapatkan semua rekod. Gunakan kaedah semua () untuk mendapatkan semua rekod dalam jadual pangkalan data: USEAPP \ MODELS \ POST; $ POSTS = POST :: SEMUA (); Ini akan mengembalikan koleksi. Anda boleh mengakses data menggunakan gelung foreach atau kaedah pengumpulan lain: foreach ($ postsas $ post) {echo $ post->