Peranti teknologi

Peranti teknologi

AI

AI

Para saintis Google bercakap secara peribadi: Bagaimana untuk melaksanakan penaakulan yang terkandung? Biarkan model besar 'bercakap' bahasa robot

Para saintis Google bercakap secara peribadi: Bagaimana untuk melaksanakan penaakulan yang terkandung? Biarkan model besar 'bercakap' bahasa robot

Para saintis Google bercakap secara peribadi: Bagaimana untuk melaksanakan penaakulan yang terkandung? Biarkan model besar 'bercakap' bahasa robot

Dengan pembangunan model bahasa berskala besar, bolehkah ia menggunakan keupayaannya untuk membimbing robot memahami arahan yang kompleks dan menyelesaikan tugasan yang lebih lanjut? Dan apakah cabaran yang akan kita hadapi dalam proses ini? Baru-baru ini, Komuniti Zhiyuan menjemput saintis penyelidikan Google, Dr. Xia Fei untuk memberikan laporan tentang " Penaakulan Terwujud Berdasarkan Bahasa dan Penglihatan", memperincikan kerja canggih pasukan dalam bidang yang baru muncul ini.

Mengenai pengarang : Xia Fei kini bekerja sebagai saintis penyelidikan dalam pasukan robotik daripada Google Brain. Hala tuju penyelidikan utama beliau ialah penggunaan robot kepada persekitaran kompleks yang tidak berstruktur. Kerja perwakilannya termasuk GibsonEnv, iGibson, SayCan, dsb. Penyelidikannya telah dilaporkan oleh WIRED, Washington Post, New York Times dan media lain. Dr. Xia Fei lulus dari Universiti Stanford di mana beliau belajar di bawah Silvio Savarese dan Leonidas Guibas. Beliau telah menerbitkan banyak artikel dalam persidangan dan jurnal seperti CVPR, CoRL, IROS, ICRA, Neurips, RA-L, Nature Communications, dll. Arah penyelidikan beliau baru-baru ini ialah menggunakan model asas (Model Yayasan) dalam proses membuat keputusan ejen pintar. Pasukannya baru-baru ini mencadangkan model PaLM-SayCan.

01 Latar Belakang

Pembelajaran mesin untuk robot telah membuat pencapaian hebat dalam beberapa tahun kebelakangan ini Kemajuan besar telah dicapai, tetapi masih terdapat masalah yang agak besar. Pembelajaran mesin memerlukan banyak data untuk dilatih, tetapi data yang dihasilkan oleh robot adalah sangat mahal, dan robot itu sendiri juga tertakluk kepada kerugian.

Apabila manusia masih kanak-kanak, mereka berinteraksi dengan dunia fizikal melalui bermain dan mempelajari banyak undang-undang fizikal. Diilhamkan oleh ini, bolehkah robot juga berinteraksi dengan persekitaran untuk mendapatkan maklumat fizikal ini untuk menyelesaikan pelbagai tugas? Menggunakan pembelajaran mesin pada robot sangat bergantung pada persekitaran simulasi.

Dalam hal ini, Dr. Xia Fei dan rakan-rakannya telah mencadangkan kerja seperti Gibson Env (Persekitaran) dan iGibson yang memberi tumpuan kepada pembinaan semula persekitaran visual, dan yang terakhir Lain-lain memfokuskan pada simulasi fizikal. Dengan menjalankan pengimbasan tiga dimensi dan pembinaan semula dunia sebenar, dan memberikan isyarat visual melalui rangkaian saraf, persekitaran simulasi dicipta, membolehkan pelbagai robot melakukan simulasi fizikal dan mempelajari kawalan daripada penderia masa kepada penggerak. Dalam persekitaran iGibson, robot boleh mempelajari interaksi yang lebih kaya dengan persekitaran, seperti belajar menggunakan mesin basuh pinggan mangkuk.

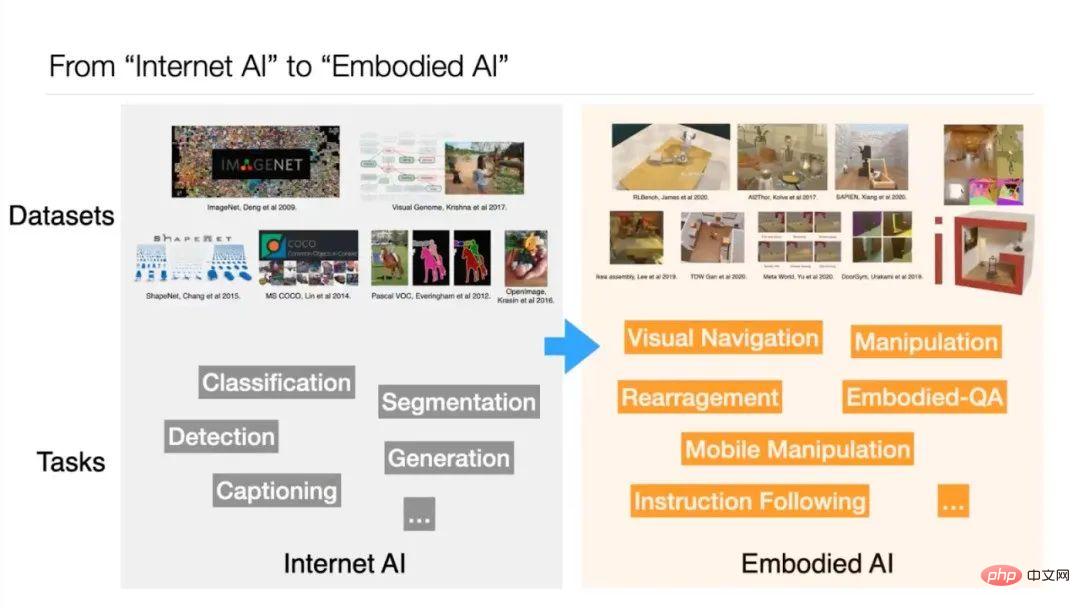

Dr. Xia Fei percaya bahawa kerja di atas mewakili transformasi daripada AI Internet kepada AI yang terkandung. Pada masa lalu, latihan AI adalah berdasarkan set data seperti ImageNet dan MS COCO, yang merupakan tugas Internet. AI yang terkandung memerlukan persepsi dan tindakan AI untuk membentuk gelung tertutup - AI mesti memutuskan tindakan seterusnya berdasarkan hasil yang dilihat. Tesis kedoktoran Xia Fei "simulasi skala besar untuk persepsi yang terkandung dan pembelajaran robot" adalah mengenai simulasi robot berskala besar untuk pembelajaran, persepsi dan penaakulan.

Dalam beberapa tahun kebelakangan ini, model asas telah berkembang pesat dalam bidang kecerdasan buatan. Sesetengah penyelidik percaya bahawa daripada bergantung pada persekitaran simulasi, maklumat boleh diekstrak daripada model asas untuk membantu robot membuat keputusan. Dr. Xia Fei menamakan hala tuju baharu ini sebagai "Model Asas untuk Membuat Keputusan", dan beliau dan pasukannya mencadangkan kerja seperti PaLM-SayCan.

02 PaLM-SayCan: Biarkan model bahasa membimbing robot

1 robot sukar?

Pasukan PaLM-SayCan mempunyai seramai 45 pengarang Ia merupakan projek kerjasama antara Pasukan Robotik Google dan Robot Setiap Hari, dengan tujuan meneroka penggunaan pembelajaran mesin untuk menukar medan robot, dan membenarkan robot menyediakan data untuk meningkatkan keupayaan pembelajaran mesin. Penyelidikan memfokuskan pada dua isu: persekitaran kompleks yang tidak berstruktur, dan menjadikan robot lebih berguna dalam kehidupan seharian.

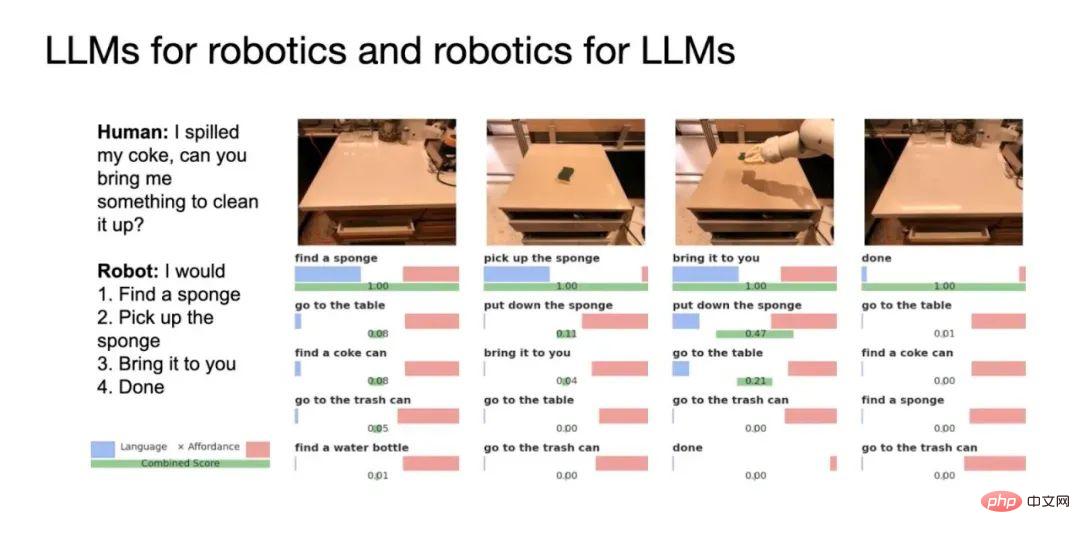

Walaupun orang sudah mempunyai pembantu peribadi seperti Siri atau Alexa, tiada kehadiran sedemikian dalam bidang robotik. Dr. Xia memberikan contoh ini: Apabila minuman tertumpah, kami ingin menerangkan keadaan kepada robot dan meminta bantuan. Atau jika anda letih selepas bersenam, minta ia menyediakan minuman dan makanan ringan. Penyelidikan berharap robot dapat memahami dan melaksanakan tugas-tugas ini.

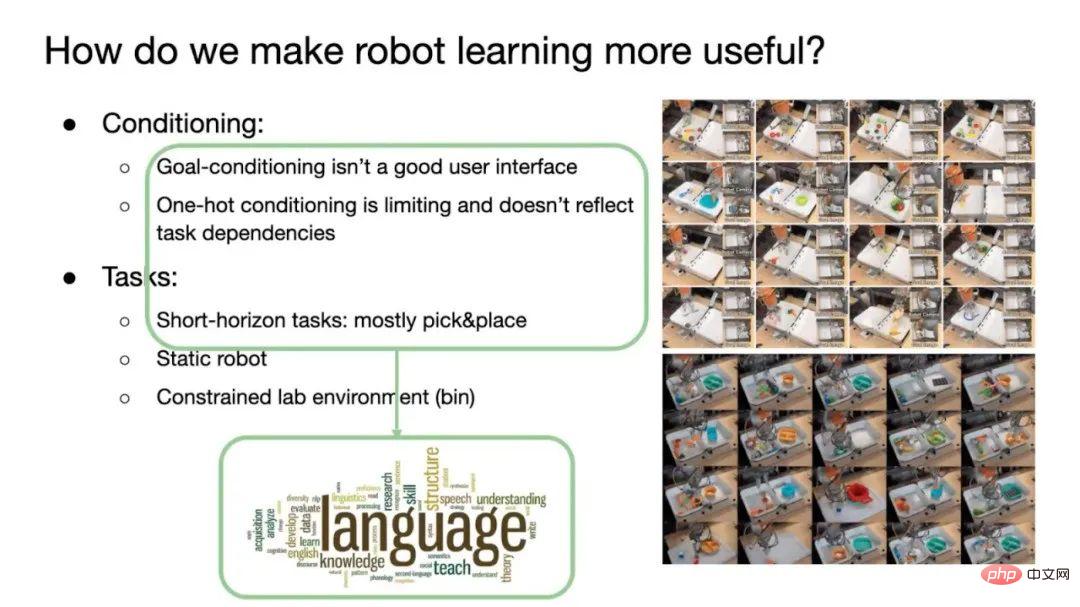

Kesukaran semasa ialah masih sukar bagi robot untuk melakukan tugasan jangka panjang atau jarak jauh, dan mereka masih tidak mampu melakukan tugasan yang memerlukan kompleks perancangan, akal dan alasan adalah dua aspek. Pertama ialah kekurangan antara muka interaksi pengguna yang baik dalam bidang robotik. Apabila robot tradisional melaksanakan tugas Pilih&Tempat, mereka biasanya menggunakan kaedah Penyaman Matlamat atau Penyaman Satu panas. Penyaman matlamat perlu memberitahu robot apa matlamatnya dan biarkan robot melakukan tugas menukar keadaan awal kepada keadaan matlamat Ini memerlukan demonstrasi terlebih dahulu kepada robot syarat tugas akan selepas selesai.

Dan One-hot Conditioning menggunakan One-hot coding, yang sesuai untuk semua tugasan yang robot boleh selesaikan (seperti 100 tugasan) dinomborkan dari 0 hingga 99. Setiap kali ia perlu dilaksanakan, nombor diberikan kepada robot, dan ia tahu tugas yang perlu diselesaikan. Walau bagaimanapun, masalah dengan keadaan satu panas ialah pengguna perlu mengingati pengekodan yang sepadan dengan setiap tugasan dan pengekodan satu panas tidak memperoleh maklumat pergantungan antara tugasan (seperti melengkapkan urutan pengekodan tugas yang sepadan dengan matlamat ).

Akibatnya, robot semasa hanya boleh menyelesaikan tugasan jarak dekat, biasanya merebut dan meletakkan. Dan robot itu sendiri adalah statik dan bukannya mudah alih. Selain itu, persekitaran juga terhad kepada adegan seperti makmal, selalunya tanpa manusia.

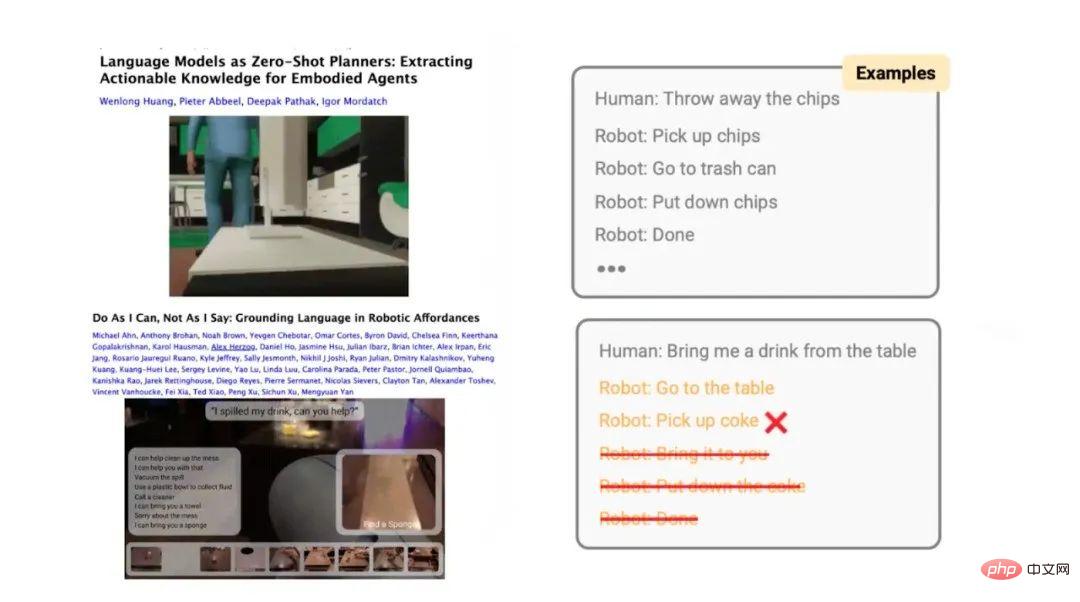

2. Model bahasa digunakan untuk robot: Bagaimana untuk menjadikannya "bertutur" dalam bahasa robot?

Untuk menyelesaikan masalah ini, pasukan berfikir untuk menggunakan model asas. Model bahasa boleh menggantikan pelaziman Matlamat dan menerangkan tugas dengan jelas dan jelas melalui bahasa. Pada masa yang sama, bahasa juga mengandungi maklumat pergantungan antara langkah tugasan, seperti langkah pertama dan langkah kedua pada resipi, untuk membantu robot belajar. Selain itu, bahasa juga boleh digunakan untuk menentukan tugasan jangka panjang dan menyelesaikan batasan kaedah pembelajaran meniru.

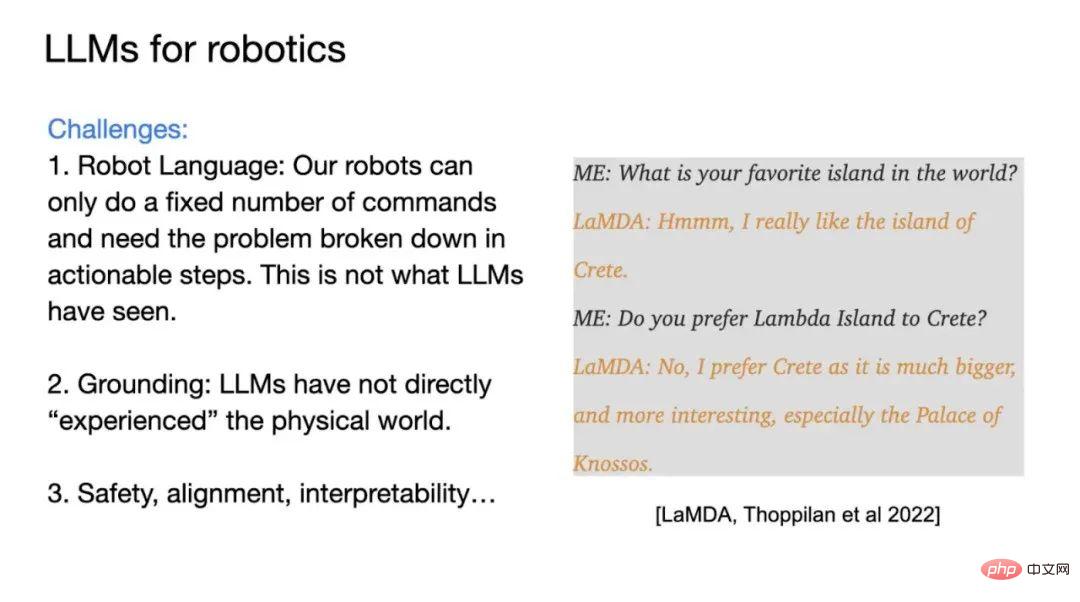

Menggunakan model besar pada robot mungkin menghadapi beberapa cabaran. Perkara yang paling penting ialah menentukan bahasa yang berorientasikan kepada output robot. Model besar dilatih berdasarkan bahasa semula jadi manusia, dan tugas yang dikeluarkannya mungkin tidak dapat dilakukan untuk robot. Dan model bahasa tidak dilatih pada data robot, jadi ia tidak mengetahui skop keupayaan robot. Yang kedua ialah masalah Grounding Model besar tidak mengalami dunia fizikal secara peribadi dan tidak mempunyai maklumat yang terkandung. Yang ketiga ialah keselamatan dan kebolehtafsiran robot itu sendiri di bawah bimbingan model besar. Bias dalam model bahasa mungkin diperkuatkan oleh perkaitannya dengan sistem fizikal, menyebabkan akibat dunia nyata.

Terdapat contoh kredibiliti: apabila pengguna manusia berkomunikasi dengan model LaMDA Google, pengguna bertanya kepada model "pulau kegemaran", dan model itu menjawab Crete, Pulau Greece, dan juga boleh menjawab beberapa sebab. Tetapi keputusan ini tidak boleh dipercayai, kerana keputusan yang harus diberikan oleh AI ialah "Saya tidak tahu pulau mana yang paling saya suka, kerana saya tidak pernah ke mana-mana pulau." Masalah dengan model bahasa ialah ia tidak berinteraksi dengan dunia sebenar dan hanya mengeluarkan ayat seterusnya yang paling mungkin berdasarkan peraturan statistik.

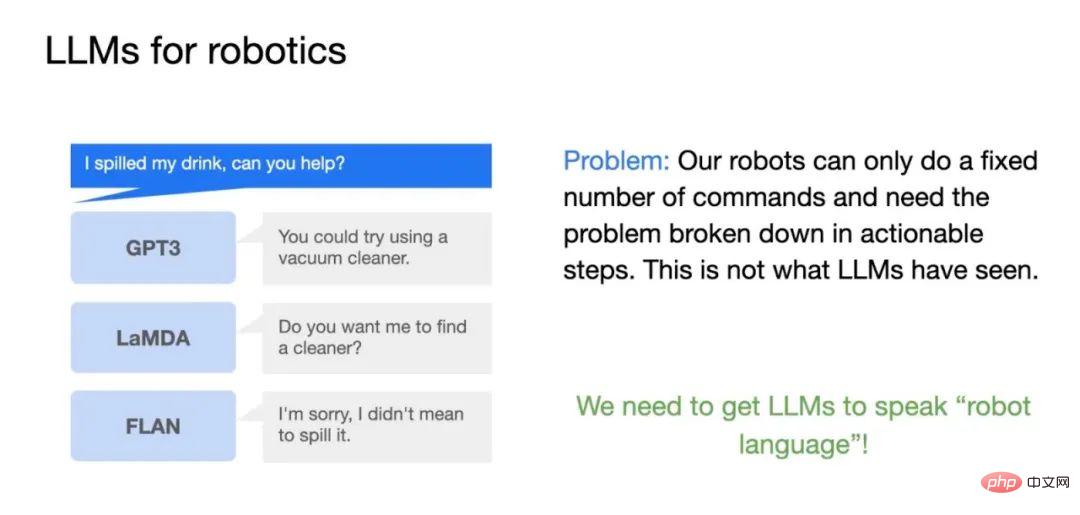

Jika model bahasa digunakan pada robot, model yang berbeza akan memberikan hasil yang berbeza, sesetengah daripadanya tidak berguna untuk memandu robot melaksanakan tugas. Contohnya, jika pengguna meminta robot untuk "membersihkan minuman yang tumpah", GPT-3 mungkin berkata, "Anda boleh menggunakan pembersih vakum." Keputusan ini tidak betul sepenuhnya kerana pembersih vakum tidak dapat membersihkan cecair.

Jika ia adalah model LaMDA, LaMDA mungkin berkata "Adakah anda mahu saya mencari pembersih untuk anda, jawapan ini adalah perkara biasa, tetapi tidak?" Berguna, kerana LaMDA memperhalusi bahan dialog, dan fungsi objektifnya adalah untuk memanjangkan panjang dialog sebanyak mungkin, bukan untuk membantu menyelesaikan tugas. Jika ia adalah model FLAN, ia akan membalas "Maaf, saya tidak bermaksud ia tidak memahami niat pengguna: adakah ia perbualan? Masih perlu menyelesaikan masalah? Oleh itu, terdapat beberapa siri masalah dalam menggunakan model bahasa besar pada robot.

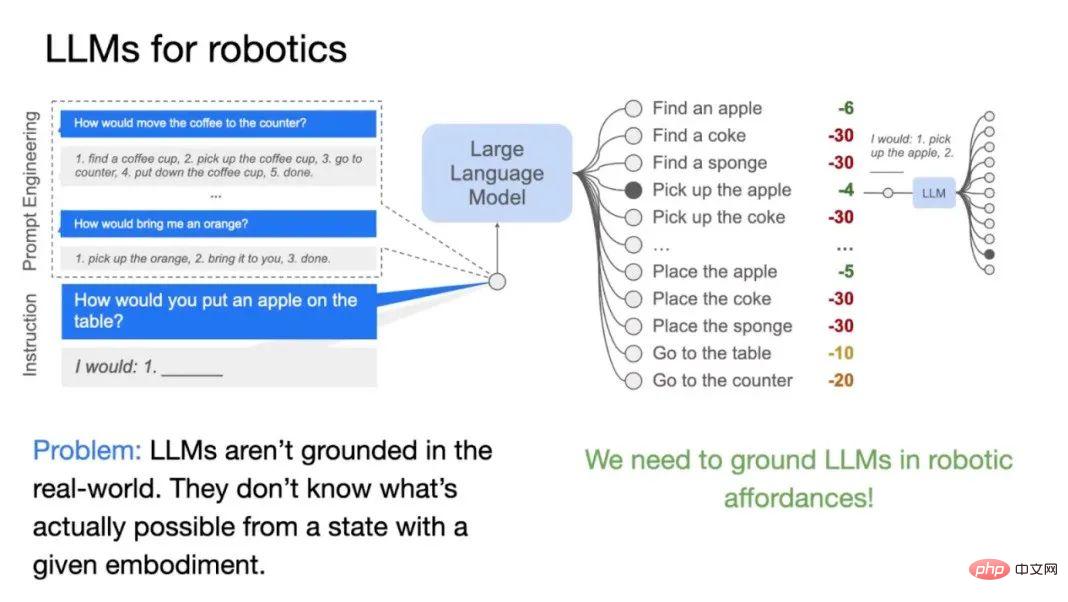

PaLM-SayCan berfungsi untuk menyelesaikan cabaran ini. Yang pertama adalah untuk membolehkan model besar bercakap bahasa robot melalui Few-shot Prompting (pembelajaran beberapa pukulan). Sebagai contoh, bina tugasan seperti "bawakan kopi ke almari", "berikan saya sebiji oren", dsb., dan berikan langkah yang sepadan (seperti 1-5 dan 1-3). Pengguna kemudian memberi model arahan: "Letakkan epal di atas meja." Selepas mendapat gesaan langkah sebelumnya, model akan mencari dan menggabungkan langkah tugasan yang sesuai dengan sendirinya, dan menjana rancangan untuk menyelesaikan tugasan langkah demi langkah.

Perlu diingatkan bahawa terdapat dua cara utama untuk berinteraksi dengan model besar, Salah satunya ialah Antara Muka Generatif, yang menjana Token seterusnya berdasarkan input; PaLM-SayCan menggunakan kaedah pemarkahan, yang menjadikan model bahasa lebih stabil dan mudah untuk mengeluarkan hasil yang diingini. Dalam tugas meletakkan epal, model menjaringkan pelbagai langkah dan memilih hasil yang sesuai.

3 Merapatkan jurang antara model bahasa dan dunia sebenar: Biarkan robot meneroka kemampuan persekitaran

Terdapat satu lagi masalah yang perlu diselesaikan: apabila model bahasa menjana langkah tugasan, ia tidak tahu apa yang robot boleh lakukan pada masa ini. Jika tiada epal di hadapan robot, robot tidak dapat menyelesaikan tugas meletakkan epal tersebut. Oleh itu, ini memerlukan membiarkan model bahasa mengetahui tugas yang boleh dilakukan oleh robot dalam persekitaran dan keadaan semasa. Konsep baharu perlu diperkenalkan di sini, dipanggil Robotic Affordances (robot affordances) , yang juga merupakan teras kerja ini.

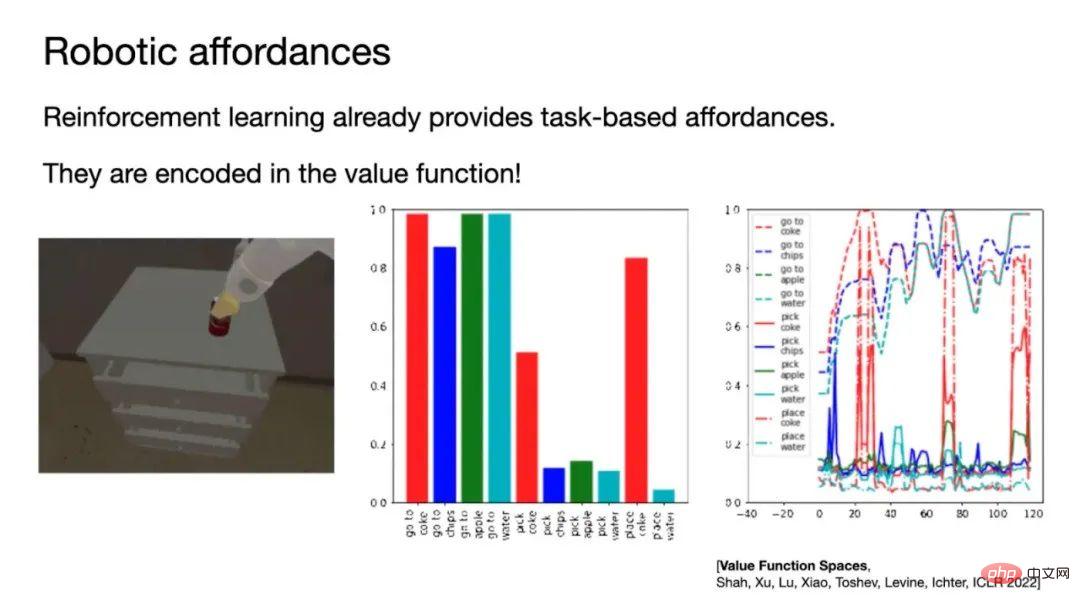

Affordances yang diterjemahkan ke dalam bahasa Cina dipanggil affordances, iaitu nama ahli psikologi Amerika James J. Satu konsep yang dicadangkan oleh Gibson sekitar tahun 1977, ditakrifkan sebagai tugas yang boleh dilakukan oleh ejen dalam persekitaran dalam keadaan semasa, yang mewakili jantinanya. Kemampuan boleh diperoleh menggunakan pembelajaran diselia, tetapi ini memerlukan sejumlah besar data dan pelabelan.

Dalam hal ini, pasukan menggunakan kaedah pembelajaran pengukuhan dan menggunakan fungsi nilai Polisi untuk menganggarkan kemampuan. Sebagai contoh, latih robot untuk mengambil pelbagai perkara di persekitaran Selepas latihan, biarkan robot meneroka bilik Apabila ia melihat item di hadapannya, fungsi nilai untuk mengambil item itu akan menjadi sangat tinggi, sekali gus menggantikannya. item yang tersedia.

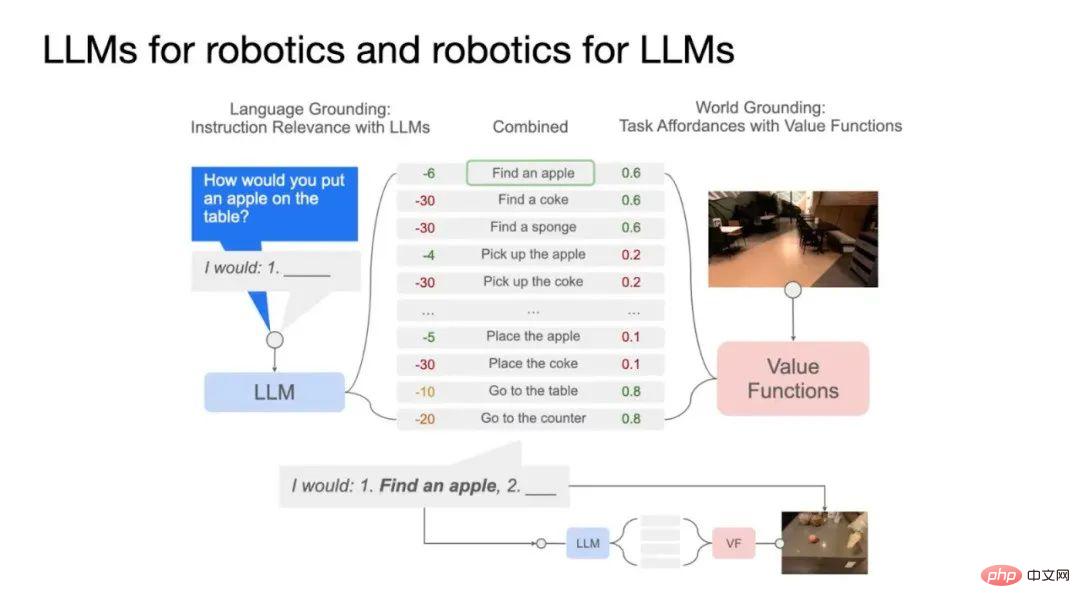

Menggabungkan kemampuan dan model bahasa, algoritma PaLM-SayCan diperolehi. Seperti yang ditunjukkan dalam rajah di atas, sebelah kiri ialah model bahasa, yang menjaringkan tugasan yang boleh disiapkan oleh robot mengikut arahan yang diberikan oleh pengguna, dan mengira kebarangkalian bahawa menyelesaikan subtugasan akan membantu menyelesaikan tugasan keseluruhan. Bahagian kanan ialah fungsi nilai, yang mewakili kebarangkalian untuk menyelesaikan setiap tugas dalam keadaan semasa. Hasil darab kedua-duanya mewakili kebarangkalian bahawa robot berjaya menyelesaikan subtugas yang menyumbang kepada tugasan keseluruhan. Dalam contoh Apple, tiada epal di hadapan robot dalam keadaan semasa Untuk menyelesaikan tugasan ini, perkara pertama yang perlu dilakukan ialah mencari epal, jadi skor kemampuan mencari epal itu agak tinggi, dan nilainya. skor merebut epal adalah rendah. Selepas menjumpai epal itu, markah kemampuan untuk merebut epal itu meningkat, dan tugas merebut epal itu dilakukan. Proses ini diulang sehingga tugas keseluruhan selesai.

03 Lebih Banyak Kerja Perisikan Terwujud: Memperbaik Penaakulan Model kebolehan, menggunakan maklum balas alam sekitar untuk membentuk gelung tertutup

1. Rantaian Anjuran Pemikiran: Memahami akal fikiran yang kompleks

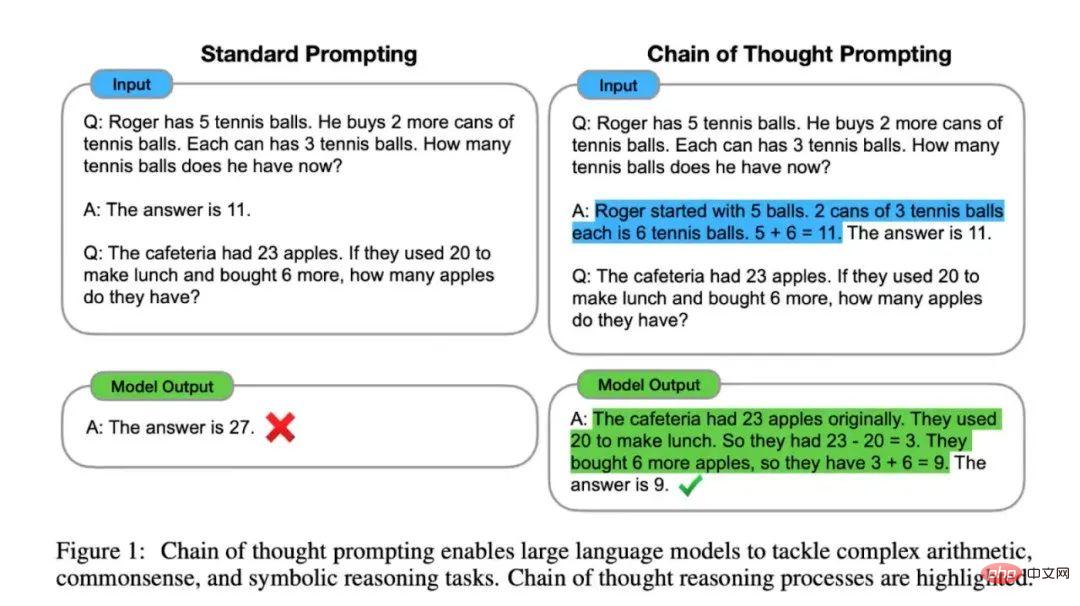

Selain PaLM-SayCan, Dr. Xia dan rakan sekerja juga telah menyiapkan beberapa kerja lain yang berkaitan. Dari segi Prompt, pasukan mencadangkan Rangkaian Pemikiran Prompting (yang boleh difahami sebagai idea penyelesaian masalah) untuk memberikan model bahasa lebih keupayaan penaakulan.

Mod gesaan standard adalah untuk mereka bentuk templat soalan dan memberikan jawapan. Model mengeluarkan jawapan semasa inferens, tetapi kadangkala jawapan yang diberikan oleh model adalah salah. Oleh itu, matlamat Chain of Thought Prompting adalah untuk memberikan penjelasan kepada model sambil memberikan masalah, yang boleh meningkatkan hasil model dengan ketara dan bahkan mengatasi tahap manusia pada beberapa tugas.

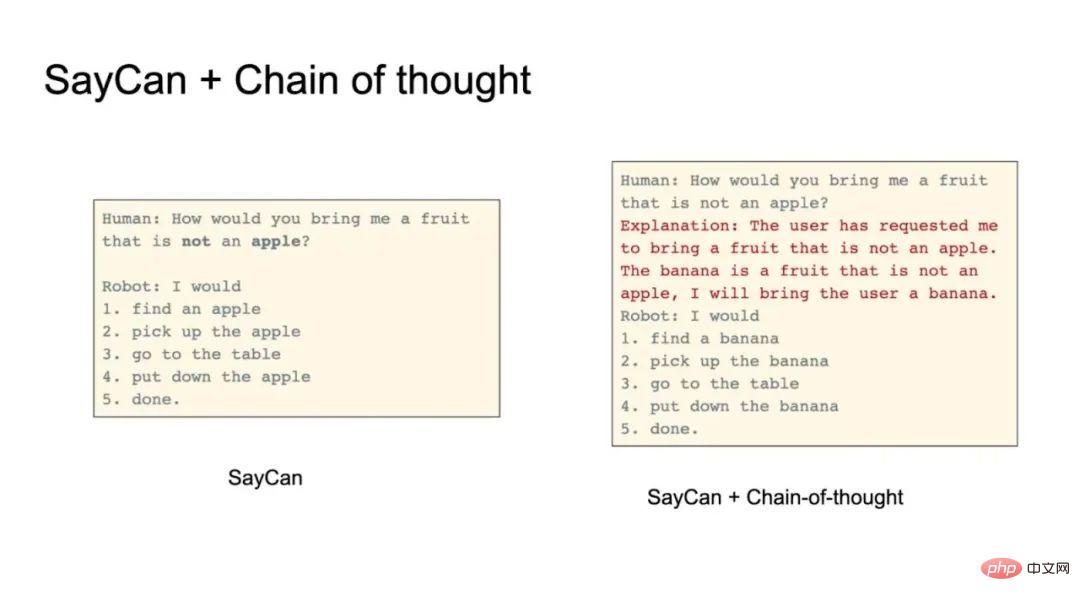

Model terdedah kepada ralat semasa memproses ayat negatif. Contohnya, pengguna manusia bertanya "Beri saya buah, tetapi bukan epal". Model cenderung untuk menyediakan epal kerana terdapat epal dalam kedua-dua soalan dan pilihan boleh laku. Menggunakan Rangkaian Pemikiran, beberapa penjelasan boleh diberikan. Sebagai contoh, model akan mengeluarkan "Pengguna mahu buah, tetapi bukan epal. Pisang ialah buah, bukan epal. Saya boleh memberi pengguna pisang."

Rangkaian Anjuran Pemikiran juga boleh menyelesaikan keperluan negatif yang lebih halus. Sebagai contoh, seorang pengguna menyatakan alahan terhadap kafein dan meminta robot untuk mendapatkan minuman. Alahan adalah satu lagi bentuk penafian halus Menggunakan kaedah tradisional, robot mungkin mencapai minuman berkafein (tanpa memahami penafian yang diwakili oleh alahan). Rangkaian Anjuran Pemikiran boleh menjelaskan alahan, dsb. dan meningkatkan kesan penaakulan.

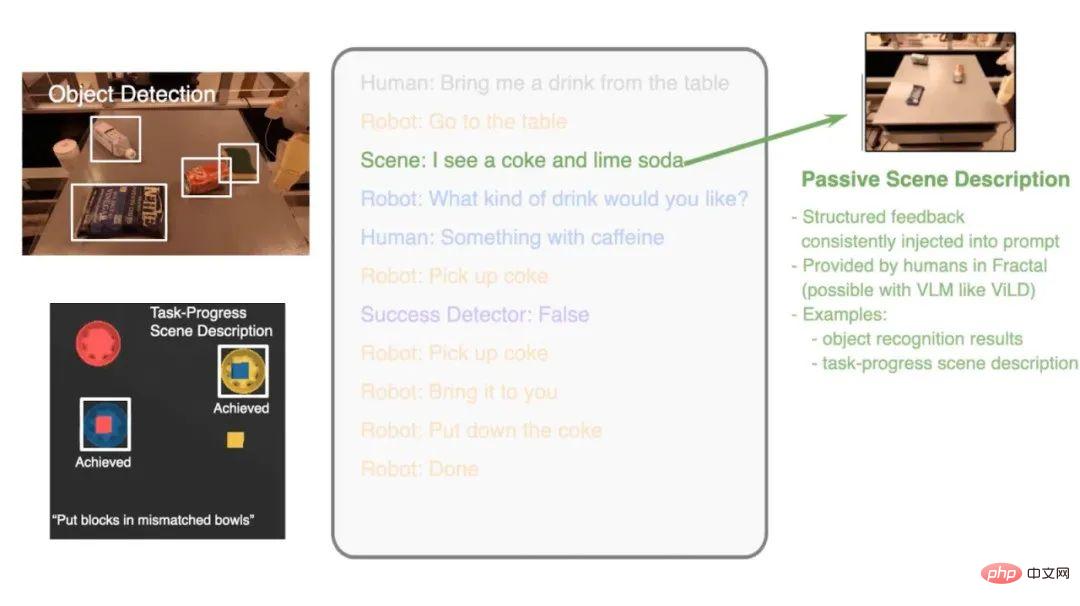

2.Monolog Dalaman: Betulkan ralat dan kembali ke landasan pelaksanaan yang betul

Gunakan model besar untuk membuat keputusan robot dan Gabungan interaksi alam sekitar juga merupakan hala tuju penting penyelidikan. Pasukan itu mencadangkan kerja Monolog Dalaman, yang bertujuan untuk membolehkan model bahasa menyemak keputusan lepas berdasarkan perubahan dalam persekitaran dan pulih daripada arahan atau kemalangan yang salah yang disebabkan oleh persekitaran.

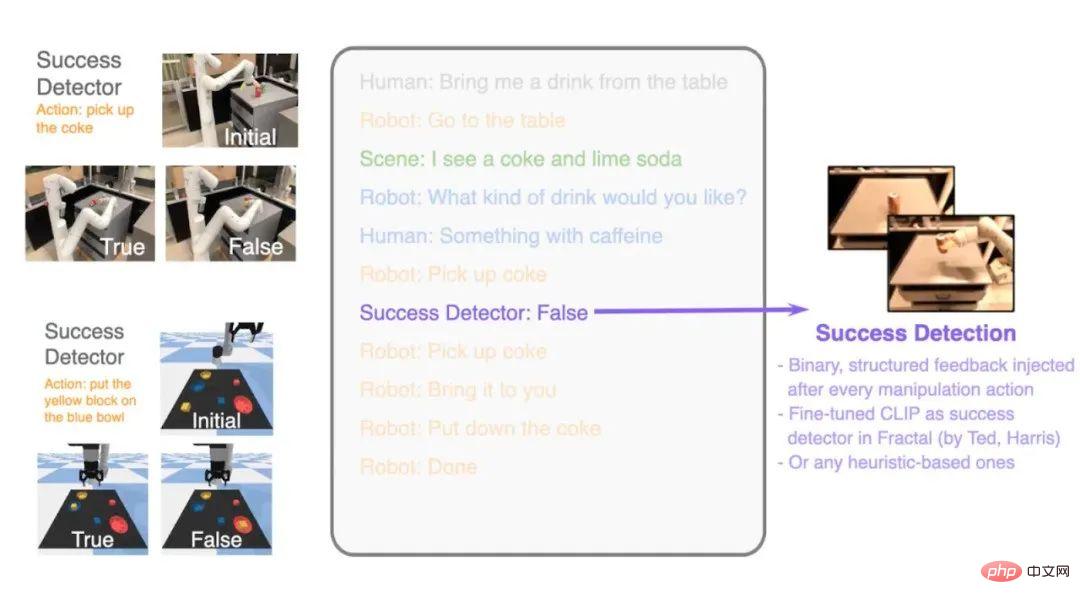

Sebagai contoh, apabila manusia pulang ke rumah dan mendapati kunci yang dipilih tidak dapat membuka pintu, maka orang akan pilih Cuba kekunci lain, atau tukar arah putaran. Perkara ini terkandung ialah membetulkan ralat dan mengemas kini tindakan baharu berdasarkan maklum balas daripada persekitaran. Monolog Dalaman berfungsi dengan cara ini. Sebagai contoh, jika kola jatuh semasa robot mengambil kola, tugasan seterusnya tidak dapat diselesaikan Monolog Dalaman untuk mengesan sama ada tugas itu berjaya diselesaikan, dan memberikan maklum balas ke dalam proses membuat keputusan, dan membuat keputusan baharu berdasarkan. maklumat maklum balas.

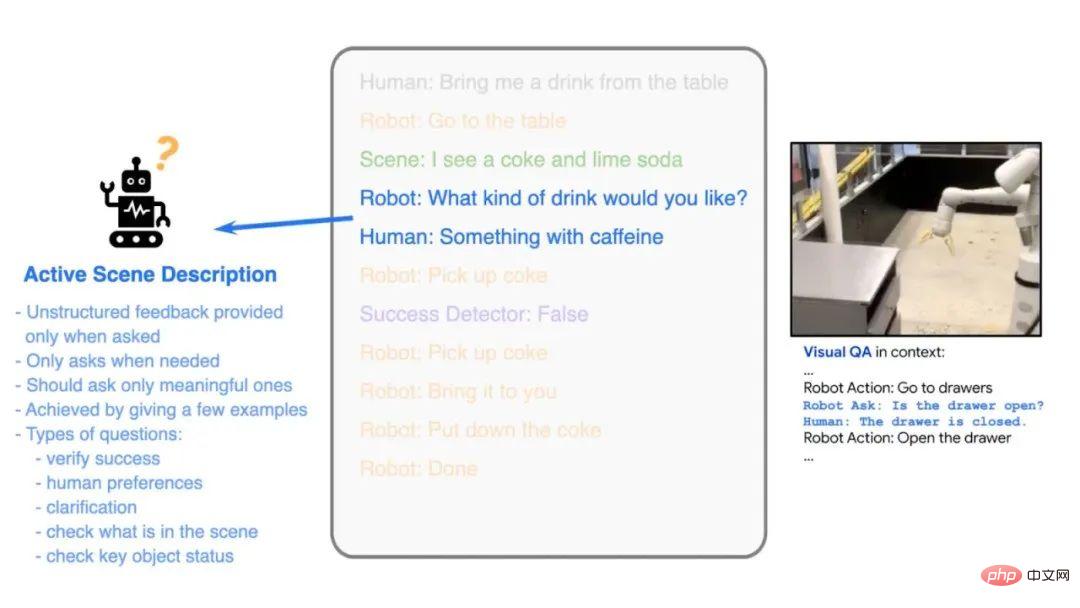

Seperti yang ditunjukkan dalam rajah, kerja Monolog Dalaman merangkumi Penerangan Adegan Aktif dan Pengesan Kejayaan Tugas. Apabila manusia memberi arahan, model boleh melaksanakan arahan dan mengaktifkan penerangan senario untuk membantu robot dalam membuat keputusan. Proses latihan masih menggunakan kaedah Few-shot Prompt, supaya ia boleh membuat inferens daripada satu contoh. Sebagai contoh, apabila robot diarahkan untuk mendapatkan minuman, ia akan bertanya kepada manusia sama ada untuk mendapatkan Coke atau soda.

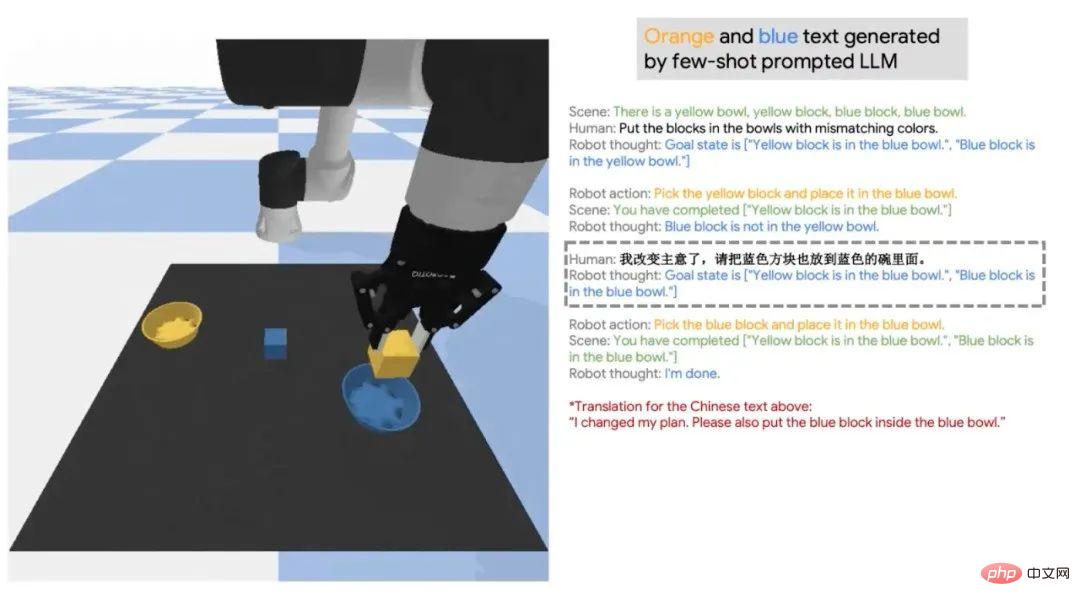

Kes lain ialah penaakulan maklumat sejarah mengikut model bahasa Dalam banyak kes, manusia akan memberi perintah selepas Perubahan fikiran anda, atau minta robot menyelesaikan "tugas yang adil" selepas menukar arahan beberapa kali. Di sini, "tugas adil" tidak dinyatakan, yang memerlukan model melihat kembali dalam sejarah untuk melihat apakah tugas sebelumnya. Selain bahasa Inggeris, Monolog Dalaman kini tersedia dalam bahasa Cina dan bahasa lain. Selepas eksperimen dalam bidang lain, pasukan mendapati bahawa kaedah maklum balas alam sekitar ini boleh menyelesaikan beberapa tugas perancangan yang sangat kompleks dan gelung tertutup.

04 S&J

S: Adakah model bahasa besar PaLM-SayCan dilatih dari awal? Masih menggunakan model sahaja.

J: Model oracle besar tidak perlu Fine-tune, ia sudah mengandungi banyak keputusan. Sebagai contoh, anda boleh menggunakan GPT-3 dengan 175 bilion parameter, atau PaLM, yang sudah mengandungi maklumat perancangan dan jujukan misi yang mencukupi.

S: Adakah Ejen juga akan mengambil inisiatif untuk bertanya soalan semasa kerja Monolog Dalaman? Bagaimanakah ini diserap?

J: Kami menggunakan model bahasa dan kaedah Prompt Apabila robot menyelesaikan tugas, Dua pilihan akan muncul: "dan tanya" dan "dan teruskan". Sama ada untuk bertanya atau meneruskan bergantung kepada sama ada terdapat sebarang kekaburan dalam semantik kontekstual.

S: Bagaimanakah robot tahu di mana item itu (seperti kerepek kentang dalam laci)? Jika keupayaan robot secara beransur-ansur meningkat pada masa hadapan, adakah ruang carian akan menjadi terlalu besar semasa penerokaan?

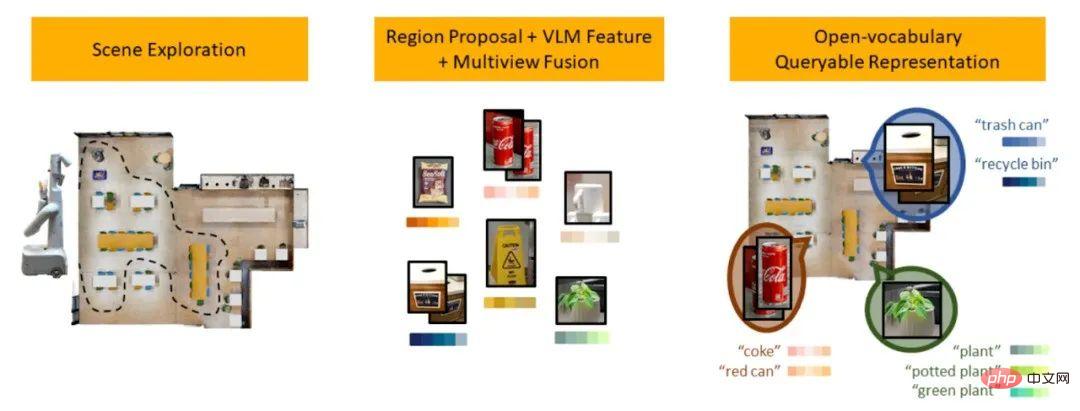

J: Pengetahuan robot tentang lokasi penyimpanan item pada masa ini dikod keras, bukan Proses automatik. Tetapi model bahasa besar juga mengandungi pengetahuan semantik tertentu, seperti di mana item itu berada. Pengetahuan semantik ini boleh mengurangkan ruang carian. Pada masa yang sama, anda juga boleh meneroka berdasarkan kebarangkalian mencari item. Pada masa ini, pasukan Xia Fei telah menerbitkan karya baharu untuk menyelesaikan masalah ini. Idea teras adalah untuk mewujudkan perwakilan adegan diindeks bahasa semula jadi. Rujukan laman web nlmap-saycan.github.io

S: Selain itu, pembelajaran peneguhan hierarki yang telah muncul dalam tahun kebelakangan ini, Adakah ia memberikan sedikit inspirasi untuk perancangan tugas yang kompleks?

PaLM-SayCan dan pembelajaran peneguhan hierarki adalah serupa kerana mereka mempunyai kemahiran asas dan peringkat atasan tugas Perancangan boleh dikatakan sebagai kaedah hierarki, tetapi ia bukanlah pembelajaran peneguhan hierarki. Saya secara peribadi lebih suka pendekatan berlapis ini, kerana apabila merancang tugas, anda tidak semestinya perlu melakukan setiap langkah terperinci, yang akan membuang masa. Perancangan misi boleh dilatih menggunakan data Internet yang besar, tetapi kemahiran asas memerlukan data fizikal, jadi mereka perlu berinteraksi dengan persekitaran dan belajar.

S: Adakah terdapat sebarang isu asas yang masih belum dapat diselesaikan apabila PaLM-SayCan sebenarnya digunakan dalam robot? Jika ia boleh digunakan sebagai pengganti pengasuh harian, berapa lama masa yang diperlukan untuk merealisasikannya?

J: Masih terdapat beberapa isu asas yang belum diselesaikan, dan ia tidak mudah isu kejuruteraan. Dari segi prinsip, kawalan pergerakan dan pegangan robot adalah satu cabaran besar. Kami masih tidak dapat mencapai kejayaan 100%, yang merupakan masalah besar.

Sudah tentu ia sudah mampu memberikan sedikit nilai kepada orang yang mempunyai mobiliti terhad. Walau bagaimanapun, jika ia benar-benar produk komersial, ia tidak mungkin lagi Kadar kejayaan misi adalah kira-kira 90%, yang tidak memenuhi keperluan komersial.

S: Adakah kadar kejayaan perancangan robot dihadkan oleh set data latihan?

J: Keupayaan perancangan robot dihadkan oleh korpus latihan. Adalah mudah untuk mencari beberapa arahan dalam korpus, seperti "buang sampah". Walau bagaimanapun, hampir tiada korpus seperti "gerakkan cakar dua jari robot ke kanan 10 sentimeter" dalam korpus, kerana orang ramai tidak akan meninggalkan maklumat sedemikian di Internet. Ini melibatkan isu maklumat berbutir Pada masa ini, terhad oleh korpus, robot hanya boleh menyelesaikan tugas berbutir kasar.

Sebaliknya, perancangan terperinci itu sendiri tidak seharusnya dilakukan oleh model bahasa, kerana ia mengandungi terlalu banyak maklumat fizikal dan berkemungkinan tidak boleh digunakan digambarkan dalam bahasa manusia. Satu idea ialah operasi terperinci boleh dilaksanakan menggunakan pembelajaran tiruan (rujuk kerja BC-Z) atau penjanaan kod (rujuk hasil kerja terkini pasukan https://code-as-policies.github.io/). Peranan besar model besar adalah untuk berfungsi sebagai antara muka interaktif pengguna, mentafsir arahan yang diberikan oleh manusia kepada robot, dan menguraikannya kepada langkah-langkah yang boleh dilaksanakan oleh mesin.

Selain itu, bahasa boleh melakukan perancangan semantik peringkat tinggi tanpa memerlukan perancangan yang lebih fizikal. Jika anda ingin mencapai tugas perancangan yang terperinci, anda masih perlu bergantung pada pembelajaran tiruan atau pembelajaran pengukuhan.

Atas ialah kandungan terperinci Para saintis Google bercakap secara peribadi: Bagaimana untuk melaksanakan penaakulan yang terkandung? Biarkan model besar 'bercakap' bahasa robot. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1378

1378

52

52

Artikel ini akan membawa anda memahami SHAP: penjelasan model untuk pembelajaran mesin

Jun 01, 2024 am 10:58 AM

Artikel ini akan membawa anda memahami SHAP: penjelasan model untuk pembelajaran mesin

Jun 01, 2024 am 10:58 AM

Dalam bidang pembelajaran mesin dan sains data, kebolehtafsiran model sentiasa menjadi tumpuan penyelidik dan pengamal. Dengan aplikasi meluas model yang kompleks seperti kaedah pembelajaran mendalam dan ensemble, memahami proses membuat keputusan model menjadi sangat penting. AI|XAI yang boleh dijelaskan membantu membina kepercayaan dan keyakinan dalam model pembelajaran mesin dengan meningkatkan ketelusan model. Meningkatkan ketelusan model boleh dicapai melalui kaedah seperti penggunaan meluas pelbagai model yang kompleks, serta proses membuat keputusan yang digunakan untuk menerangkan model. Kaedah ini termasuk analisis kepentingan ciri, anggaran selang ramalan model, algoritma kebolehtafsiran tempatan, dsb. Analisis kepentingan ciri boleh menerangkan proses membuat keputusan model dengan menilai tahap pengaruh model ke atas ciri input. Anggaran selang ramalan model

Kenal pasti overfitting dan underfitting melalui lengkung pembelajaran

Apr 29, 2024 pm 06:50 PM

Kenal pasti overfitting dan underfitting melalui lengkung pembelajaran

Apr 29, 2024 pm 06:50 PM

Artikel ini akan memperkenalkan cara mengenal pasti pemasangan lampau dan kekurangan dalam model pembelajaran mesin secara berkesan melalui keluk pembelajaran. Underfitting dan overfitting 1. Overfitting Jika model terlampau latihan pada data sehingga ia mempelajari bunyi daripadanya, maka model tersebut dikatakan overfitting. Model yang dipasang terlebih dahulu mempelajari setiap contoh dengan sempurna sehingga ia akan salah mengklasifikasikan contoh yang tidak kelihatan/baharu. Untuk model terlampau, kami akan mendapat skor set latihan yang sempurna/hampir sempurna dan set pengesahan/skor ujian yang teruk. Diubah suai sedikit: "Punca overfitting: Gunakan model yang kompleks untuk menyelesaikan masalah mudah dan mengekstrak bunyi daripada data. Kerana set data kecil sebagai set latihan mungkin tidak mewakili perwakilan yang betul bagi semua data. 2. Underfitting Heru

Evolusi kecerdasan buatan dalam penerokaan angkasa lepas dan kejuruteraan penempatan manusia

Apr 29, 2024 pm 03:25 PM

Evolusi kecerdasan buatan dalam penerokaan angkasa lepas dan kejuruteraan penempatan manusia

Apr 29, 2024 pm 03:25 PM

Pada tahun 1950-an, kecerdasan buatan (AI) dilahirkan. Ketika itulah penyelidik mendapati bahawa mesin boleh melakukan tugas seperti manusia, seperti berfikir. Kemudian, pada tahun 1960-an, Jabatan Pertahanan A.S. membiayai kecerdasan buatan dan menubuhkan makmal untuk pembangunan selanjutnya. Penyelidik sedang mencari aplikasi untuk kecerdasan buatan dalam banyak bidang, seperti penerokaan angkasa lepas dan kelangsungan hidup dalam persekitaran yang melampau. Penerokaan angkasa lepas ialah kajian tentang alam semesta, yang meliputi seluruh alam semesta di luar bumi. Angkasa lepas diklasifikasikan sebagai persekitaran yang melampau kerana keadaannya berbeza daripada di Bumi. Untuk terus hidup di angkasa, banyak faktor mesti dipertimbangkan dan langkah berjaga-jaga mesti diambil. Para saintis dan penyelidik percaya bahawa meneroka ruang dan memahami keadaan semasa segala-galanya boleh membantu memahami cara alam semesta berfungsi dan bersedia untuk menghadapi kemungkinan krisis alam sekitar

Melaksanakan Algoritma Pembelajaran Mesin dalam C++: Cabaran dan Penyelesaian Biasa

Jun 03, 2024 pm 01:25 PM

Melaksanakan Algoritma Pembelajaran Mesin dalam C++: Cabaran dan Penyelesaian Biasa

Jun 03, 2024 pm 01:25 PM

Cabaran biasa yang dihadapi oleh algoritma pembelajaran mesin dalam C++ termasuk pengurusan memori, multi-threading, pengoptimuman prestasi dan kebolehselenggaraan. Penyelesaian termasuk menggunakan penunjuk pintar, perpustakaan benang moden, arahan SIMD dan perpustakaan pihak ketiga, serta mengikuti garis panduan gaya pengekodan dan menggunakan alat automasi. Kes praktikal menunjukkan cara menggunakan perpustakaan Eigen untuk melaksanakan algoritma regresi linear, mengurus memori dengan berkesan dan menggunakan operasi matriks berprestasi tinggi.

Bagaimanakah AI boleh menjadikan robot lebih autonomi dan boleh disesuaikan?

Jun 03, 2024 pm 07:18 PM

Bagaimanakah AI boleh menjadikan robot lebih autonomi dan boleh disesuaikan?

Jun 03, 2024 pm 07:18 PM

Dalam bidang teknologi automasi perindustrian, terdapat dua titik panas terkini yang sukar diabaikan: kecerdasan buatan (AI) dan Nvidia. Jangan ubah maksud kandungan asal, perhalusi kandungan, tulis semula kandungan, jangan teruskan: “Bukan itu sahaja, kedua-duanya berkait rapat, kerana Nvidia tidak terhad kepada unit pemprosesan grafik asalnya (GPU ), ia sedang mengembangkan GPUnya Teknologi ini meluas ke bidang kembar digital dan berkait rapat dengan teknologi AI yang baru muncul "Baru-baru ini, NVIDIA telah mencapai kerjasama dengan banyak syarikat industri, termasuk syarikat automasi industri terkemuka seperti Aveva, Rockwell Automation, Siemens. dan Schneider Electric, serta Teradyne Robotics dan syarikat MiR dan Universal Robotsnya. Baru-baru ini, Nvidiahascoll

AI yang boleh dijelaskan: Menerangkan model AI/ML yang kompleks

Jun 03, 2024 pm 10:08 PM

AI yang boleh dijelaskan: Menerangkan model AI/ML yang kompleks

Jun 03, 2024 pm 10:08 PM

Penterjemah |. Disemak oleh Li Rui |. Chonglou Model kecerdasan buatan (AI) dan pembelajaran mesin (ML) semakin kompleks hari ini, dan output yang dihasilkan oleh model ini adalah kotak hitam – tidak dapat dijelaskan kepada pihak berkepentingan. AI Boleh Dijelaskan (XAI) bertujuan untuk menyelesaikan masalah ini dengan membolehkan pihak berkepentingan memahami cara model ini berfungsi, memastikan mereka memahami cara model ini sebenarnya membuat keputusan, dan memastikan ketelusan dalam sistem AI, Amanah dan akauntabiliti untuk menyelesaikan masalah ini. Artikel ini meneroka pelbagai teknik kecerdasan buatan (XAI) yang boleh dijelaskan untuk menggambarkan prinsip asasnya. Beberapa sebab mengapa AI boleh dijelaskan adalah penting Kepercayaan dan ketelusan: Untuk sistem AI diterima secara meluas dan dipercayai, pengguna perlu memahami cara keputusan dibuat

Cloud Whale Xiaoyao 001 robot menyapu dan mengemop mempunyai 'otak'! |

Apr 26, 2024 pm 04:22 PM

Cloud Whale Xiaoyao 001 robot menyapu dan mengemop mempunyai 'otak'! |

Apr 26, 2024 pm 04:22 PM

Robot menyapu dan mengemop adalah salah satu perkakas rumah pintar yang paling popular di kalangan pengguna sejak beberapa tahun kebelakangan ini. Kemudahan operasi yang dibawanya, atau bahkan keperluan tanpa operasi, membolehkan orang yang malas membebaskan tangan mereka, membolehkan pengguna "membebaskan" daripada kerja rumah harian dan menghabiskan lebih banyak masa untuk perkara yang mereka sukai Peningkatan kualiti hidup dalam bentuk yang menyamar. Menunggang kegilaan ini, hampir semua jenama perkakas rumah di pasaran membuat robot menyapu dan mengemop mereka sendiri, menjadikan keseluruhan pasaran robot menyapu dan mengemop sangat meriah. Walau bagaimanapun, perkembangan pesat pasaran pasti akan membawa bahaya tersembunyi: banyak pengeluar akan menggunakan taktik laut mesin untuk menduduki lebih banyak bahagian pasaran dengan cepat, menyebabkan banyak produk baru tanpa sebarang titik peningkatan mereka adalah model "matryoshka" Tidak keterlaluan. Walau bagaimanapun, tidak semua robot menyapu dan mengemop

Adakah Flash Attention stabil? Meta dan Harvard mendapati bahawa sisihan berat model mereka berubah-ubah mengikut urutan magnitud

May 30, 2024 pm 01:24 PM

Adakah Flash Attention stabil? Meta dan Harvard mendapati bahawa sisihan berat model mereka berubah-ubah mengikut urutan magnitud

May 30, 2024 pm 01:24 PM

MetaFAIR bekerjasama dengan Harvard untuk menyediakan rangka kerja penyelidikan baharu untuk mengoptimumkan bias data yang dijana apabila pembelajaran mesin berskala besar dilakukan. Adalah diketahui bahawa latihan model bahasa besar sering mengambil masa berbulan-bulan dan menggunakan ratusan atau bahkan ribuan GPU. Mengambil model LLaMA270B sebagai contoh, latihannya memerlukan sejumlah 1,720,320 jam GPU. Melatih model besar memberikan cabaran sistemik yang unik disebabkan oleh skala dan kerumitan beban kerja ini. Baru-baru ini, banyak institusi telah melaporkan ketidakstabilan dalam proses latihan apabila melatih model AI generatif SOTA Mereka biasanya muncul dalam bentuk lonjakan kerugian Contohnya, model PaLM Google mengalami sehingga 20 lonjakan kerugian semasa proses latihan. Bias berangka adalah punca ketidaktepatan latihan ini,