ChatGPT boleh menjadi model teratas yang popular di seluruh dunia, dan ia amat diperlukan untuk kuasa pengkomputeran super di belakangnya.

Data menunjukkan bahawa jumlah penggunaan kuasa pengkomputeran ChatGPT adalah kira-kira 3640PF-hari (iaitu, jika satu kuadrilion pengiraan sesaat, ia mengambil masa 3640 hari untuk mengira).

Jadi, bagaimanakah superkomputer dibina oleh Microsoft khusus untuk OpenAI dilahirkan?

Pada hari Isnin, Microsoft menyiarkan dua artikel di blog rasminya, secara peribadi menyahsulit superkomputer ultra mahal ini dan peningkatan utama Azure - menyertai beribu-ribu foto terbaharu Nvidia Kad grafik Powerfull H100 dan rangkaian InfiniBand yang lebih pantas teknologi saling sambung.

Berdasarkan perkara ini, Microsoft turut mengumumkan secara rasmi mesin maya ND H100 v5 terbaru, spesifikasi khusus adalah seperti berikut:

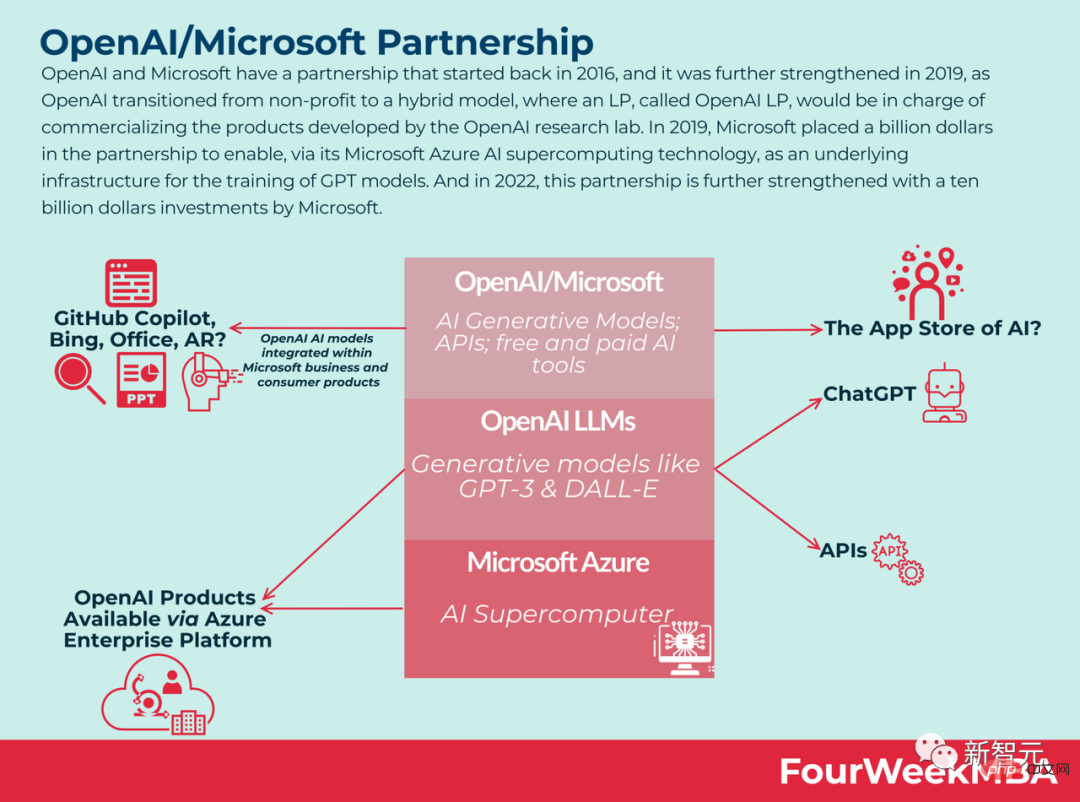

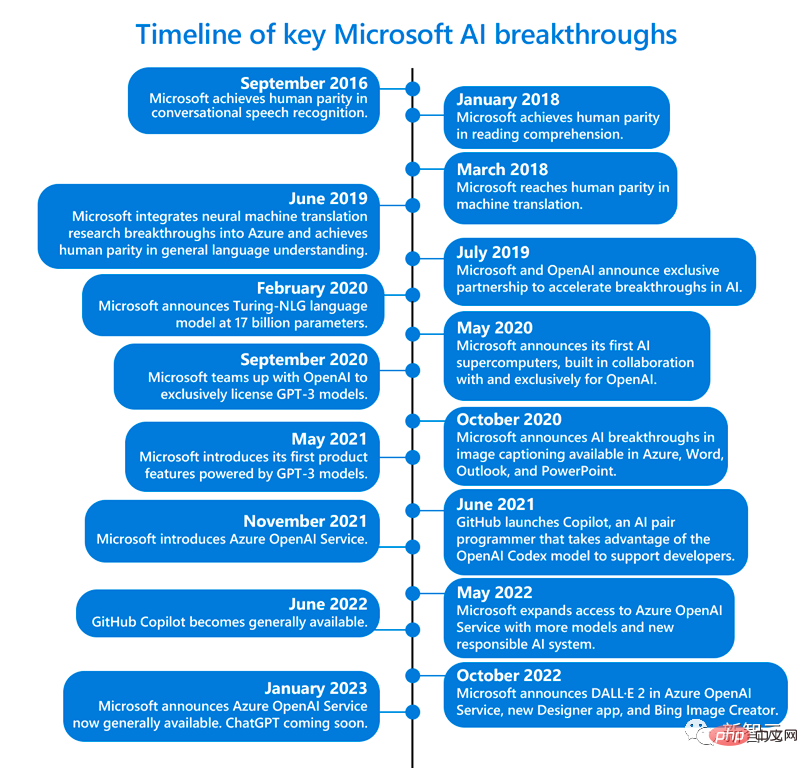

Kira-kira lima tahun yang lalu, OpenAI mencadangkan cadangan berani kepada Microsoft The idea - untuk membina sistem kecerdasan buatan yang boleh mengubah cara selama-lamanya manusia dan komputer berinteraksi.

Pada masa itu, tiada siapa yang menyangka bahawa ini bermakna AI boleh menggunakan bahasa tulen untuk mencipta sebarang gambar yang diterangkan oleh manusia, dan manusia boleh menggunakan chatbots untuk menulis puisi, lirik, dan Kertas, e-mel, menu...

Untuk membina sistem ini, OpenAI memerlukan banyak kuasa pengkomputeran - jenis yang benar-benar boleh menyokong pengiraan berskala ultra-besar.

Tetapi persoalannya, bolehkah Microsoft melakukannya?

Lagipun, tiada perkakasan yang dapat memenuhi keperluan OpenAI pada masa itu, dan tidak pasti sama ada membina superkomputer yang begitu besar dalam perkhidmatan awan Azure akan merosakkan sistem secara langsung .

Seterusnya, Microsoft memulakan penerokaan yang sukar.

Nidhi Chappell (kiri), peneraju produk untuk pengkomputeran berprestasi tinggi dan kecerdasan buatan Azure di Microsoft, dan Phil Waymouth, pengarah kanan perkongsian strategik di Microsoft (Kanan)

Untuk membina superkomputer yang menyokong projek OpenAI, ia membelanjakan ratusan juta dolar untuk menyambungkan puluhan ribu Nvidia A100 cip bersama pada platform pengkomputeran awan Azure, dan rak pelayan yang diubah suai.

Selain itu, untuk menyesuaikan platform pengkomputeran super ini untuk OpenAI, Microsoft sangat berdedikasi dan telah memberi perhatian yang teliti kepada keperluan OpenAI dan sentiasa mengikuti keperluan mereka yang paling kritikal semasa melatih AI.

Berapa kos projek besar itu? Scott Guthrie, naib presiden eksekutif pengkomputeran awan dan kecerdasan buatan Microsoft, tidak akan mendedahkan jumlah yang tepat, tetapi berkata ia "mungkin lebih daripada" beberapa ratus juta dolar.

Phil Waymouth, eksekutif Microsoft yang bertanggungjawab ke atas perkongsian strategik, menegaskan bahawa skala infrastruktur pengkomputeran awan yang diperlukan untuk model latihan OpenAI tidak pernah berlaku sebelum ini dalam industri daripada.

Saiz kluster GPU rangkaian yang berkembang pesat melebihi apa yang pernah cuba dibina oleh sesiapa dalam industri.

Sebab mengapa Microsoft berazam untuk bekerjasama dengan OpenAI adalah kerana ia yakin bahawa skala infrastruktur yang belum pernah berlaku sebelum ini akan mengubah sejarah dan mencipta AI baharu dan platform pengaturcaraan baharu untuk pelanggan produk dan perkhidmatan yang benar-benar memenuhi kepentingan mereka.

Kini nampaknya ratusan juta dolar ini tidak disia-siakan - pertaruhannya betul.

Pada superkomputer ini, model yang boleh dilatih OpenAI menjadi semakin berkuasa, dan ia telah membuka kunci fungsi alat AI ChatGPT yang menakjubkan, yang hampir memulakan revolusi perindustrian umat manusia yang keempat.

Sangat berpuas hati, Microsoft mencurahkan $10 bilion lagi ke dalam OpenAI pada awal Januari.

Boleh dikatakan bahawa cita-cita Microsoft untuk menembusi sempadan superkomputer AI telah membuahkan hasil. Apa yang dicerminkan di sebalik ini ialah transformasi daripada penyelidikan makmal kepada perindustrian AI.

Pada masa ini, empayar perisian pejabat Microsoft telah mula terbentuk.

Versi ChatGPT Bing boleh membantu kami mencari pengaturan percutian dalam Viva Sales boleh membantu pemasar menulis e-mel GitHub Copilot boleh membantu pembangun terus menulis kod Azure OpenAI; kami untuk mengakses model bahasa besar OpenAI dan mengakses fungsi peringkat perusahaan Azure.

Malah, pada November tahun lalu, Microsoft secara rasmi mengumumkan bahawa ia akan bergabung dengan Nvidia untuk membina "Salah satu superkomputer AI yang paling berkuasa di dunia untuk mengendalikan beban pengiraan besar yang diperlukan untuk melatih dan menskala AI.

Superkomputer ini berdasarkan infrastruktur awan Azure Microsoft, menggunakan puluhan ribu GPU Nvidia H100 dan A100 Tensor Core, serta platform rangkaian Quantum-2 InfiniBand.

Nvidia berkata dalam satu kenyataan bahawa superkomputer itu boleh digunakan untuk mengkaji dan mempercepatkan model AI generatif seperti DALL-E dan Stable Diffusion.

Apabila penyelidik AI mula menggunakan GPU yang lebih berkuasa untuk mengendalikan beban kerja AI yang lebih kompleks, mereka melihat potensi yang lebih besar untuk model AI , model ini memahami nuansa dengan baik cukup untuk mengendalikan banyak tugas bahasa yang berbeza secara serentak.

Ringkasnya, lebih besar model, lebih banyak data yang anda ada, lebih lama anda boleh melatihnya, lebih baik ketepatan model.

Tetapi model yang lebih besar ini tidak lama lagi akan mencapai sempadan sumber pengkomputeran sedia ada. Dan Microsoft memahami rupa keperluan superkomputer OpenAI dan betapa besar keperluannya.

Ini jelas sekali bukan sesuatu yang bermaksud membeli sekumpulan GPU dan menyambungkannya bersama-sama dan kemudian mereka mula bekerja bersama-sama.

Nidhi Chappell, peneraju produk untuk Azure High Performance Computing dan Artificial Intelligence di Microsoft, berkata: “Kami perlu membenarkan model yang lebih besar untuk berlatih lebih lama, yang bermakna bukan sahaja anda perlu mempunyai Infrastruktur terbesar, anda juga perlu memastikan ia berjalan dengan pasti dalam jangka masa panjang Microsoft perlu memastikan ia dapat menyejukkan semua mesin dan cip tersebut, kata Alistair Speirs, pengarah infrastruktur global Azure. Contohnya termasuk menggunakan udara luar dalam iklim yang lebih sejuk dan penyejuk penyejatan berteknologi tinggi dalam iklim yang lebih panas.

Selain itu, memandangkan semua mesin dimulakan pada masa yang sama, Microsoft juga perlu mempertimbangkan penempatannya dengan bekalan kuasa. Ia seperti apa yang mungkin berlaku jika anda menghidupkan ketuhar gelombang mikro, pembakar roti dan pembersih vakum pada masa yang sama di dapur, tetapi versi pusat data.

Latihan AI berskala besar

Apakah kunci untuk mencapai kejayaan ini?Cabarannya ialah cara membina, mengendali dan menyelenggara berpuluh-puluh ribu GPU yang terletak bersama yang saling bersambung pada rangkaian InfiniBand berkependaman tinggi yang berkemampuan tinggi.

Skala ini telah jauh melebihi skop ujian oleh GPU dan pembekal peralatan rangkaian, dan merupakan wilayah yang tidak diketahui sama sekali. Tiada siapa yang tahu jika perkakasan akan rosak pada skala ini.

Nidhi Chappell, ketua pengkomputeran berprestasi tinggi dan produk kecerdasan buatan di Microsoft Azure, menjelaskan bahawa semasa proses latihan LLM, pengiraan berskala besar yang terlibat biasanya dibahagikan kepada beribu-ribu GPU dalam satu kelompok.

Dalam peringkat yang dipanggil allreduce, GPU bertukar maklumat tentang kerja yang mereka lakukan. Pada masa ini, pecutan perlu dilakukan melalui rangkaian InfiniBand supaya GPU dapat menyelesaikan pengiraan sebelum blok pengiraan seterusnya bermula.

Nidhi Chappell berkata kerana kerja ini merangkumi ribuan GPU, selain memastikan kebolehpercayaan infrastruktur, banyak pengoptimuman peringkat sistem diperlukan untuk mencapai prestasi terbaik, Dan ini disimpulkan melalui pengalaman banyak generasi.

Apa yang dipanggil pengoptimuman peringkat sistem termasuk perisian yang boleh menggunakan peralatan GPU dan rangkaian dengan berkesan.

Sejak beberapa tahun yang lalu, Microsoft telah membangunkan teknologi ini untuk meningkatkan keupayaan melatih model dengan berpuluh trilion parameter sambil mengurangkan kos latihan dan keperluan sumber serta masa untuk menyampaikan model ini dalam pengeluaran.

Waymouth menegaskan bahawa Microsoft dan rakan kongsi juga telah meningkatkan kapasiti kluster GPU secara beransur-ansur, membangunkan rangkaian InfiniBand dan melihat sejauh mana mereka boleh menolak data yang diperlukan untuk memastikan kluster GPU berjalan. Infrastruktur pusat, termasuk sistem penyejukan, sistem kuasa tanpa gangguan dan penjana sandaran.

Eric Boyd, naib presiden korporat Microsoft AI Platform, berkata bahawa kuasa superkomputer jenis ini dioptimumkan untuk latihan model bahasa berskala besar dan gelombang inovasi AI seterusnya sudah boleh digunakan secara langsung dalam perkhidmatan awan Azure dapatkan.

Dan Microsoft telah mengumpul banyak pengalaman melalui kerjasama dengan OpenAI Apabila rakan kongsi lain datang dan mahukan infrastruktur yang sama, Microsoft juga boleh menyediakannya.

Kini, pusat data Azure Microsoft telah meliputi lebih daripada 60 wilayah di seluruh dunia.

Mesin maya baharu: ND H100 v5

Mengenai infrastruktur di atas, Microsoft terus bertambah baik.

Hari ini, Microsoft secara rasmi mengumumkan mesin maya berskala besar-besaran baharu yang menyepadukan NVIDIA H100 Tensor Core GPU dan rangkaian NVIDIA Quantum-2 InfiniBand.

Melalui mesin maya, Microsoft boleh menyediakan pelanggan dengan infrastruktur yang berskala ke skala mana-mana tugas AI. Menurut Microsoft, mesin maya ND H100 v5 baharu Azure menyediakan pemaju dengan prestasi unggul sambil memanggil beribu-ribu GPU.

Rujukan: https://www.php.cn/link/a7bf3f5462cc82062e41b3a2262e41b3a2262

Atas ialah kandungan terperinci Mendedahkan rahsia di sebalik harga tinggi dan pengiraan hebat ChatGPT! Puluhan ribu Nvidia A100s menelan belanja Microsoft ratusan juta dolar. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

cip

cip

Pendaftaran ChatGPT

Pendaftaran ChatGPT

Ensiklopedia ChatGPT percuma domestik

Ensiklopedia ChatGPT percuma domestik

Bagaimana untuk memasang chatgpt pada telefon bimbit

Bagaimana untuk memasang chatgpt pada telefon bimbit

Bolehkah chatgpt digunakan di China?

Bolehkah chatgpt digunakan di China?

Apakah perbezaan antara legasi dan uefi?

Apakah perbezaan antara legasi dan uefi?

Perkara yang perlu dilakukan mengenai ralat sambungan

Perkara yang perlu dilakukan mengenai ralat sambungan

Bagaimana untuk membeli dan menjual Bitcoin? Tutorial Dagangan Bitcoin

Bagaimana untuk membeli dan menjual Bitcoin? Tutorial Dagangan Bitcoin