Peranti teknologi

Peranti teknologi

AI

AI

Algoritma pemampatan 100 bilion model pertama SparseGPT ada di sini, mengurangkan kos kuasa pengkomputeran sambil mengekalkan ketepatan yang tinggi

Algoritma pemampatan 100 bilion model pertama SparseGPT ada di sini, mengurangkan kos kuasa pengkomputeran sambil mengekalkan ketepatan yang tinggi

Algoritma pemampatan 100 bilion model pertama SparseGPT ada di sini, mengurangkan kos kuasa pengkomputeran sambil mengekalkan ketepatan yang tinggi

Sejak kemunculan GPT-3 pada tahun 2020, populariti ChatGPT sekali lagi membawa model bahasa berskala besar generatif keluarga GPT ke dalam perhatian, dan mereka telah menunjukkan prestasi yang kukuh dalam pelbagai tugas.

Walau bagaimanapun, skala besar model itu juga membawa peningkatan dalam kos pengkomputeran dan peningkatan dalam kesukaran penggunaan.

Sebagai contoh, model GPT‑175B menduduki sekurang-kurangnya 320GB ruang storan dalam format separuh ketepatan (FP16) Semasa inferens, sekurang-kurangnya lima GPU A100 dengan 80 GB ruang penyimpanan diperlukan.

Mampatan model pada masa ini merupakan kaedah yang biasa digunakan untuk mengurangkan kos pengiraan model besar, tetapi setakat ini, hampir semua kaedah pemampatan GPT sedia ada memfokuskan kepada pengkuantitian (kuantisasi), iaitu mengurangkan ketepatan perwakilan berangka bagi satu pemberat.

Kaedah pemampatan model lain ialah pemangkasan, yang membuang elemen rangkaian daripada pemberat individu (pencantasan tidak berstruktur) kepada komponen berbutir lebih tinggi seperti matriks berat seluruh baris/lajur (pencantasan berstruktur ). Pendekatan ini berfungsi dengan baik dalam model bahasa penglihatan dan berskala lebih kecil, tetapi ia mengakibatkan kehilangan ketepatan, memerlukan latihan semula model yang meluas untuk memulihkan ketepatan, jadi kos menjadi semula apabila melibatkan model berskala besar seperti GPT . Walaupun terdapat beberapa kaedah pemangkasan satu pukulan yang boleh memampatkan model tanpa latihan semula, kaedah ini terlalu intensif secara pengiraan dan sukar untuk digunakan pada model dengan berbilion parameter.

Jadi untuk model besar bersaiz GPT-3, adakah terdapat cara untuk memangkasnya dengan tepat sambil mengekalkan kehilangan ketepatan yang minimum dan mengurangkan kos pengiraan?

Baru-baru ini, dua penyelidik dari Institut Sains dan Teknologi Austria (ISTA), Elias Frantar dan Dan Alistah, bekerjasama dalam kajian buat kali pertama menyasarkan skala model 10 hingga 100 bilion parameter Kaedah pemangkasan satu pukulan yang tepat SparseGPT dicadangkan.

Alamat kertas: https://arxiv.org/pdf/2301.00774.pdf

SparseGPT boleh memangkas model siri GPT kepada 50% jarang dalam satu langkah tanpa sebarang latihan semula. Model terbesar yang tersedia untuk umum, GPT-175B, mencapai pemangkasan ini hanya dalam beberapa jam menggunakan GPU tunggal.

Selain itu, SparseGPT juga sangat tepat dan boleh meminimumkan kehilangan ketepatan. Sebagai contoh, apabila melaksanakan SparseGPT pada model sumber terbuka terbesar pada masa ini OPT‑175B dan BLOOM‑176B, sparsity sebanyak 60% boleh dicapai sambil meminimumkan kehilangan ketepatan.

Algoritma SparseGPT Pemacu Elektrik

Penyelidikan ke atas model yang sangat besar telah sangat aktif sejak beberapa tahun kebelakangan ini, tetapi setakat ini, belum ada satu pun. dengan lebih daripada 10 bilion parameter Model ini mampu mencapai sparsification tinggi yang sangat tepat.

Kaedah sedia ada mempunyai keperluan kos pengiraan yang terlalu tinggi dengan mengambil OBC, kaedah pasca latihan yang paling tepat pada masa ini, sebagai contoh, ia mengambil masa lebih daripada 1 jam untuk model berbilion parameter. untuk melakukan pemampatan. Kaedah pasca latihan yang paling cepat diketahui, AdaPrune, juga mengambil masa beberapa minit untuk memangkas model bilion parameter, dan pada kadar ini, model pada skala GPT-3 dianggarkan memerlukan ratusan jam (minggu) pengiraan.

Kebanyakan kaedah pemangkasan sedia ada seperti pemangkasan magnitud beransur-ansur memerlukan latihan semula yang meluas selepas langkah pemangkasan untuk memulihkan ketepatan, manakala Model skala GPT biasanya memerlukan sejumlah besar pengiraan dan pelarasan parameter untuk latihan atau denda. -penalaan, yang menjadikan kaedah berasaskan latihan semula sukar digunakan. Oleh itu, menggunakan pendekatan pemangkasan progresif ini pada skala GPT tidak boleh dilaksanakan.

Kerja oleh pasukan ISTA ini mencadangkan kaedah SparseGPT, yang boleh menjalankan model dengan lebih daripada 100 bilion parameter pada satu GPU dalam beberapa jam, dan cukup tepat untuk memangkas model kepada 50 %-60% tahap sparsity tanpa merendahkan prestasi dengan ketara.

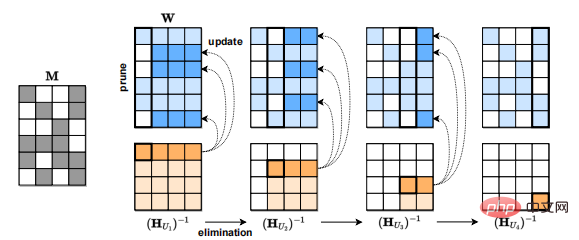

Teras SparseGPT ialah algoritma regresi jarang anggaran skala besar baharu yang boleh digeneralisasikan kepada corak separa berstruktur (2:4 dan 4:8) dan serasi dengan Compatible sedia ada dengan kaedah pengiraan berat.

Kebanyakan kaedah pemangkasan sedia ada, seperti pemangkasan magnitud progresif, memerlukan pemangkasan Langkah-langkah diikuti dengan latihan semula yang meluas untuk memulihkan ketepatan, dan model skala GPT selalunya memerlukan sejumlah besar pengiraan dan pelarasan parameter untuk latihan atau penalaan halus, yang menjadikan kaedah berasaskan latihan semula sukar digunakan. Oleh itu, menggunakan pendekatan pemangkasan progresif ini pada skala GPT tidak boleh dilaksanakan.

SparseGPT ialah kaedah pasca latihan untuk model skala GPT kerana ia tidak melakukan sebarang penalaan halus.

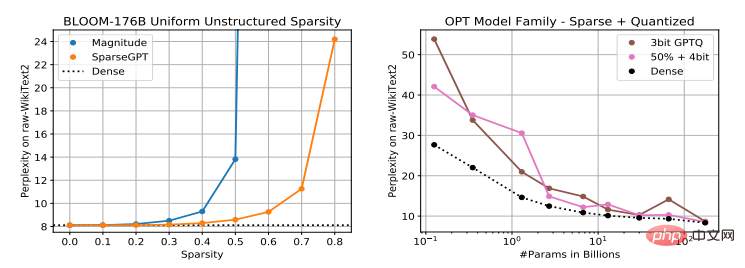

Pada masa ini terdapat banyak kaedah untuk mengukur pasca latihan model skala GPT, seperti ZeroQuant, LLM.int8() dan nuQmm, dsb., tetapi pengkuantitian pengaktifan mungkin sukar disebabkan kehadiran ciri yang tidak normal. GPTQ menggunakan anggaran tertib kedua untuk mengkuantumkan pemberat dengan tepat kepada 2‑4 bit, sesuai untuk model terbesar, dan apabila digabungkan dengan teras GPU yang cekap, boleh membawa kepada pecutan inferens 2‑5x.

Tetapi memandangkan GPTQ memfokuskan pada sparsifikasi dan bukannya kuantifikasi, SparseGPT ialah pelengkap kepada kaedah kuantifikasi, dan kedua-duanya boleh digunakan dalam kombinasi.

Selain itu, selain pemangkasan tidak berstruktur, SparseGPT juga sesuai untuk corak separa berstruktur, seperti format jarang n:m popular, yang boleh digunakan dalam nisbah 2 :4 pada GPU Ampere NVIDIA Mencapai pecutan.

SparseGPT: tahap sparsifikasi tinggi, kehilangan ketepatan rendah

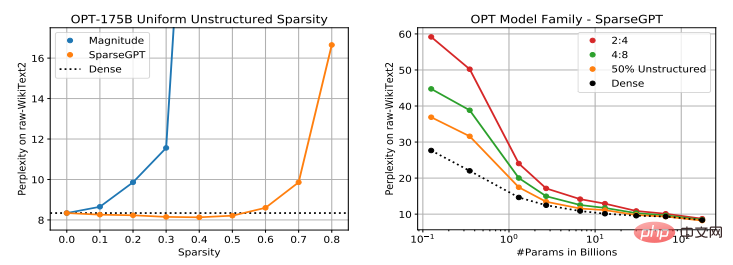

Setelah menilai keberkesanan model mampatan SparseGPT, penyelidik mendapati bahawa untuk bahasa besar kesukaran sparsification model adalah berkadar dengan saiz model Berbanding dengan kaedah pemangkasan magnitud (Magnitud Pruning) yang sedia ada, menggunakan SparseGPT boleh mencapai tahap yang lebih jarang model sambil mengekalkan kehilangan ketepatan minimum.

Para penyelidik melaksanakan SparseGPT pada PyTorch dan menggunakan perpustakaan Transformers HuggingFace untuk memproses model dan set data, semuanya pada satu GPU NVIDIA A100 dengan memori 80GB. Di bawah keadaan percubaan sedemikian, SparseGPT boleh mencapai sparsifikasi lengkap model parameter 175 bilion dalam kira-kira 4 jam.

Para penyelidik menjarakkan lapisan Transformer secara berurutan, yang mengurangkan keperluan memori dengan ketara dan juga meningkatkan ketepatan pemprosesan semua lapisan secara selari dengan ketara. Semua eksperimen mampatan dilakukan sekali gus tanpa sebarang penalaan halus.

Objek penilaian adalah terutamanya model siri OPT, yang merangkumi satu set model daripada 125 juta hingga 175 bilion parameter, menjadikannya mudah untuk memerhati prestasi penskalaan pemangkasan berbanding saiz model . Selain itu, 176 bilion varian parameter BLOOM telah dianalisis.

Dari segi set data dan penunjuk penilaian, percubaan menggunakan kebingungan set ujian WikiText2 asal untuk menilai ketepatan kaedah pemampatan SparseGPT Pada masa yang sama, untuk meningkatkan kebolehtafsiran, beberapa metrik ketepatan ZeroShot. Selain itu, penilaian memfokuskan pada ketepatan model jarang berbanding garis dasar model padat, dan bukannya pada nombor mutlak.

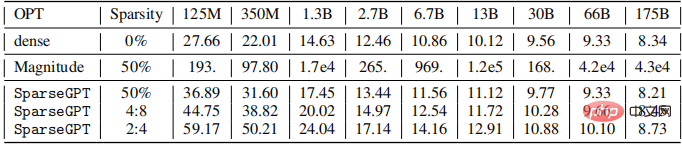

Para penyelidik memangkas semua lapisan linear keseluruhan siri model OPT (tidak termasuk pembenaman dan pengepala standard) untuk mencapai 50% sparsity tidak berstruktur dan penuh 4:8 atau penuh 2:4 separa berstruktur jarang, hasilnya adalah seperti yang ditunjukkan di bawah.

Ia boleh dilihat bahawa ketepatan model yang dimampatkan menggunakan pemangkasan amplitud adalah lemah pada semua saiz, dan model menjadi lebih teruk Semakin besar nilai, semakin besar ketepatan berkurangan.

Trend model yang dimampatkan menggunakan SparseGPT adalah berbeza Di bawah 2.7 bilion parameter, kehilangan kebingungan adalah

Model yang lebih besar berkemungkinan besar untuk dijilapkan

Arah aliran umum ialah model yang lebih besar lebih berkemungkinan untuk dijilapkan pada tahap yang tetap Pada tahap kezaliman , penurunan ketepatan relatif model jarang berbanding model padat mengecut apabila saiz model bertambah. Penulis membuat spekulasi bahawa ini mungkin disebabkan oleh tahap parameterisasi mereka yang lebih tinggi dan imuniti bunyi yang lebih besar secara keseluruhan.

Berbanding dengan garis dasar model padat, pada skala maksimum, apabila menggunakan SparseGPT untuk memampatkan model kepada sparsity 4:8 dan 2:4, peningkatan kebingungan hanya 0.11 dan 0.39 masing-masing . Keputusan ini bermakna bahawa kita boleh mencapai kelajuan 2x ganda dalam amalan, dan GPU NVIDIA Ampere komersial sudah menyokong sparsity 2:4.

Pengarang mengkaji hubungan antara prestasi dua ratus bilion model, OPT-175B dan BLOOM-176B, dan tahap keterbatasan yang ditimbulkan dengan menggunakan SparseGPT Hasilnya ditunjukkan dalam rajah di bawah.

Dapat dilihat bahawa untuk model OPT-175B, pemangkasan amplitud boleh mencapai sehingga 10% jarang, padat Kemudian akan ada kehilangan ketepatan yang lebih besar. SparseGPT juga boleh mencapai 60% sparsity dengan peningkatan kebingungan.

Untuk model BLOOM-176B, manakala pemangkasan amplitud boleh mencapai 30% sparsity tanpa kehilangan ketepatan yang ketara, sebagai perbandingan, SparseGPT boleh mencapai sparsity 50%, peningkatan 1.66x ganda. Selain itu, pada 80% sparsity, kekeruhan model yang dimampatkan menggunakan SparseGPT masih kekal pada tahap yang munasabah, tetapi apabila pemangkasan amplitud mencapai 40% sparsity OPT dan 60% sparsity BLOOM, kebingungan sudah > 100.

Selain itu, SparseGPT mampu mengeluarkan kira-kira 100 bilion pemberat daripada model ini, dengan kesan terhad pada ketepatan model.

Akhir sekali, kajian ini menunjukkan buat pertama kalinya bahawa model pra-latihan berskala besar berdasarkan Transformer boleh dimampatkan kepada sparsity tinggi melalui pemangkasan berat sekali tanpa sebarang latihan semula dan kehilangan ketepatan kecil.

Perlu diambil perhatian bahawa pendekatan SparseGPT adalah setempat: selepas setiap langkah pemangkasan, ia melakukan kemas kini berat yang direka untuk mengekalkan hubungan input-output setiap lapisan. Kemas kini ini dikira tanpa sebarang global maklumat kecerunan. Oleh itu, tahap parameterisasi yang tinggi bagi model GPT berskala besar nampaknya membolehkan pendekatan ini mengenal pasti secara langsung model yang jarang tepat di kalangan "jiran" model pra-latihan padat.

Selain itu, kerana penunjuk ketepatan (perplexity) yang digunakan dalam eksperimen adalah sangat sensitif, output model jarang yang dijana nampaknya berkait rapat dengan output model padat.

Penyelidikan ini mempunyai kepentingan positif yang besar dalam mengurangkan had kuasa pengkomputeran model besar Satu hala tuju kerja masa hadapan ialah mengkaji mekanisme penalaan halus model besar untuk memulihkan ketepatan masa yang sama, Memperluas kebolehgunaan kaedah SparseGPT semasa latihan model akan mengurangkan kos pengiraan untuk melatih model besar.

Atas ialah kandungan terperinci Algoritma pemampatan 100 bilion model pertama SparseGPT ada di sini, mengurangkan kos kuasa pengkomputeran sambil mengekalkan ketepatan yang tinggi. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Peta hala tuju menunjukkan arah aliran AI 'menggantikan' pekerjaan manusia

Jan 04, 2024 pm 04:32 PM

Peta hala tuju menunjukkan arah aliran AI 'menggantikan' pekerjaan manusia

Jan 04, 2024 pm 04:32 PM

Saya melihat gambar menarik semalam iaitu "peta aras AI menggantikan laluan manusia". Seperti yang ditunjukkan dalam gambar, permainan ini dibahagikan kepada enam tahap berbeza, dari E1 hingga E8+. Kita boleh perhatikan daripada angka bahawa kecerdasan buatan (AI) menggantikan aplikasi manusia dalam bidang yang berbeza. Laluan medan aplikasi kecerdasan buatan ditentukan oleh kadar toleransi kesalahannya. Ringkasnya, toleransi kesilapan di sini merujuk kepada kos percubaan dan kesilapan. AI secara beransur-ansur akan menggantikan industri dengan kadar toleransi ralat yang lebih tinggi hingga lebih rendah dan secara beransur-ansur "menggantikan" pekerjaan manusia. Dahulu kita sering beranggapan bahawa karya kreatif bergantung kepada pemikiran manusia dan tidak mudah diganti. Walau bagaimanapun, dengan perkembangan kecerdasan buatan, pandangan ini nampaknya tidak sepenuhnya betul. Pekerjaan kreatif selalunya tidak mempunyai jawapan tetap

Algoritma pemampatan 100 bilion model pertama SparseGPT ada di sini, mengurangkan kos kuasa pengkomputeran sambil mengekalkan ketepatan yang tinggi

Apr 12, 2023 pm 01:01 PM

Algoritma pemampatan 100 bilion model pertama SparseGPT ada di sini, mengurangkan kos kuasa pengkomputeran sambil mengekalkan ketepatan yang tinggi

Apr 12, 2023 pm 01:01 PM

Sejak kemunculan GPT-3 pada tahun 2020, populariti ChatGPT sekali lagi membawa model bahasa berskala besar generatif keluarga GPT menjadi perhatian, dan mereka telah menunjukkan prestasi yang kukuh dalam pelbagai tugas. Walau bagaimanapun, skala besar model juga membawa peningkatan kos pengiraan dan peningkatan kesukaran penggunaan. Sebagai contoh, model GPT‑175B berjumlah sekurang-kurangnya 320GB storan dalam format separuh ketepatan (FP16) dan memerlukan sekurang-kurangnya lima GPU A100 dengan storan 80 GB untuk inferens. Pemampatan model pada masa ini merupakan kaedah yang biasa digunakan untuk mengurangkan kos pengiraan model besar, tetapi setakat ini, hampir semua yang sedia ada.

AI Generatif dalam awan: Bina atau beli?

Dec 19, 2023 pm 08:15 PM

AI Generatif dalam awan: Bina atau beli?

Dec 19, 2023 pm 08:15 PM

Disusun oleh David Linsigao |. Produk yang dihasilkan oleh Yanzheng 51CTO Technology Stack (WeChat ID: blog51cto) Terdapat peraturan tidak bertulis dalam bidang teknologi: semua orang suka menggunakan teknologi orang lain. Tetapi untuk kebanyakan perniagaan, AI generatif nampaknya tidak sesuai dengan acuan itu dengan pantas AI Generatif memacu beberapa keputusan kritikal. Setiap organisasi menghadapi pilihan penting: sama ada untuk membina platform AI generatif tersuai secara dalaman atau membeli penyelesaian yang telah dibungkus daripada vendor AI (selalunya ditawarkan sebagai perkhidmatan awan yang mengutamakan volum dan peluang DIY). Ia pelik, tetapi sebabnya mungkin mengejutkan anda. Mereka mungkin membawa anda untuk memikirkan semula strategi genAI perusahaan anda 1. Lengkapkan penyesuaian dan kawalan Tulis semula kandungan seperti berikut: Bina

Program C++ untuk mengira jumlah kos yang diperlukan untuk robot menyelesaikan perjalanan dalam grid

Aug 25, 2023 pm 04:53 PM

Program C++ untuk mengira jumlah kos yang diperlukan untuk robot menyelesaikan perjalanan dalam grid

Aug 25, 2023 pm 04:53 PM

Katakan kita mempunyai grid saiz hxw. Setiap sel dalam grid mengandungi integer positif. Kini terdapat robot mencari laluan yang diletakkan pada sel tertentu (p,q) (di mana p ialah nombor baris dan q ialah nombor lajur) dan ia boleh bergerak ke sel (i,j). Operasi bergerak mempunyai kos khusus bersamaan dengan |p-i|+|q-j|. Kini terdapat perjalanan q dengan sifat berikut. Setiap perjalanan mempunyai dua nilai (x, y) dan mempunyai nilai sepunya d. Robot diletakkan pada sel dengan nilai x dan kemudian bergerak ke sel lain dengan nilai x+d. Kemudian ia bergerak ke sel lain dengan nilai x+d+d. Proses ini akan berterusan sehingga robot mencapai sel dengan nilai lebih besar daripada atau sama dengan y. y-x ialah gandaan bagi d

Kos minimum untuk menukar 1 kepada N, yang boleh dicapai dengan mendarab dengan X atau putaran kanan nombor

Sep 12, 2023 pm 08:09 PM

Kos minimum untuk menukar 1 kepada N, yang boleh dicapai dengan mendarab dengan X atau putaran kanan nombor

Sep 12, 2023 pm 08:09 PM

Kita boleh menggunakan teknik berikut untuk mencari cara termurah untuk mendarab X atau memutarkan nombornya dari 1 ke N. Untuk memantau kos minimum awal, buat pembolehubah kos. Apabila pergi dari N ke 1, semak sama ada N boleh dibahagi dengan X pada setiap peringkat. Jika ya, bahagikan N dengan X untuk mengemas kini dan meneruskan proses. Jika N tidak boleh dibahagikan dengan X, gelungkan digit N ke kanan untuk meningkatkan nilainya. Tambahkan pembolehubah kos dalam kes ini. Nilai pembolehubah kos akhir ialah jumlah minimum yang diperlukan untuk menukar 1 kepada N. Algoritma dengan cekap menentukan operasi minimum yang diperlukan untuk melakukan transformasi yang diingini menggunakan putaran atau pendaraban berangka. Kaedah yang digunakan NaiveApproach: Putaran nombor yang betul Kaedah yang cekap: Darab dengan

Meneroka Misteri Harga Tayar Kenderaan Elektrik: Kos Disebalik Kuasa Alam Sekitar Didedahkan

Aug 25, 2023 am 10:21 AM

Meneroka Misteri Harga Tayar Kenderaan Elektrik: Kos Disebalik Kuasa Alam Sekitar Didedahkan

Aug 25, 2023 am 10:21 AM

Memandangkan kesedaran tentang perlindungan alam sekitar terus meningkat di seluruh dunia, pelbagai negara telah menganjurkan pembangunan kenderaan tenaga baharu, menjadikan kenderaan elektrik sebagai kemuncak pasaran automotif. Walau bagaimanapun, walaupun kenderaan elektrik mempunyai kelebihan yang ketara dalam mengurangkan pelepasan karbon dan mengurangkan kos kenderaan, mereka menghadapi masalah: tayar kenderaan elektrik bukan sahaja lebih mahal, tetapi juga lebih terdedah kepada haus dan lusuh. Isu ini telah menarik perhatian meluas, dengan pakar menjelaskan mengapa tayar untuk kenderaan elektrik berbeza daripada tayar konvensional dan perlu memenuhi standard prestasi yang lebih tinggi. Oleh kerana kenderaan elektrik lebih berat, tayar perlu mempunyai kapasiti galas beban dan kekuatan struktur yang lebih tinggi, yang meningkatkan kos reka bentuk dan pembuatan. Di samping itu, kenderaan elektrik biasanya mempunyai prestasi pecutan dan brek yang lebih kuat, jadi tayar memerlukan cengkaman dan rintangan haba yang lebih baik, yang juga meningkatkan kos pembuatan.

Apakah faktor kos dan harga untuk menggunakan fungsi Java?

Apr 24, 2024 pm 12:54 PM

Apakah faktor kos dan harga untuk menggunakan fungsi Java?

Apr 24, 2024 pm 12:54 PM

Faktor kos dan harga: Harga contoh: dibilkan mengikut masa penggunaan dan konfigurasi fungsi. Penggunaan memori dan CPU: Semakin tinggi penggunaan, semakin tinggi kosnya. Trafik rangkaian: Komunikasi dengan perkhidmatan lain dikenakan caj. Storan: Storan berterusan dibilkan secara berasingan. Kes praktikal: Fungsi yang dipanggil 10,000 kali dan bertahan 100 milisaat berharga kira-kira AS$0.000067 (harga contoh ialah AS$0.000055 dan trafik rangkaian ialah AS$0.000012).

Ia mendedahkan bahawa Meta telah berputus asa untuk membangunkan produk Apple Vision Pro yang bersaing, terutamanya kerana kosnya terlalu tinggi

Aug 27, 2024 pm 03:33 PM

Ia mendedahkan bahawa Meta telah berputus asa untuk membangunkan produk Apple Vision Pro yang bersaing, terutamanya kerana kosnya terlalu tinggi

Aug 27, 2024 pm 03:33 PM

Menurut laporan media asing, ketua pegawai teknologi Meta telah mengesahkan bahawa syarikat itu telah berputus asa untuk membangunkan peranti yang setanding dengan Apple Vision Pro. MetaLaJolla Sebelum keluaran VisionPro, Meta mengumumkan rancangan pembangunan empat tahunnya untuk realiti maya dan set kepala realiti campuran. Satu bahagian penting daripada itu ialah membangunkan produk, dengan nama kod dalaman LaJolla, yang boleh menjadi pesaing utama VisionPro. Difahamkan bahawa Meta memulakan pembangunan LaJolla pada November 2023, tetapi menghentikan projek itu sekitar pertengahan Ogos 2024, mungkin disebabkan isu kos. Dikatakan bahawa keputusan ini dibuat oleh CEO Meta Zuckerberg dan CTO Andrew Bosworth.