Peranti teknologi

Peranti teknologi

AI

AI

GPT-3 dan Stable Diffusion bekerjasama untuk membantu model memahami keperluan ubah suai imej Party A

GPT-3 dan Stable Diffusion bekerjasama untuk membantu model memahami keperluan ubah suai imej Party A

GPT-3 dan Stable Diffusion bekerjasama untuk membantu model memahami keperluan ubah suai imej Party A

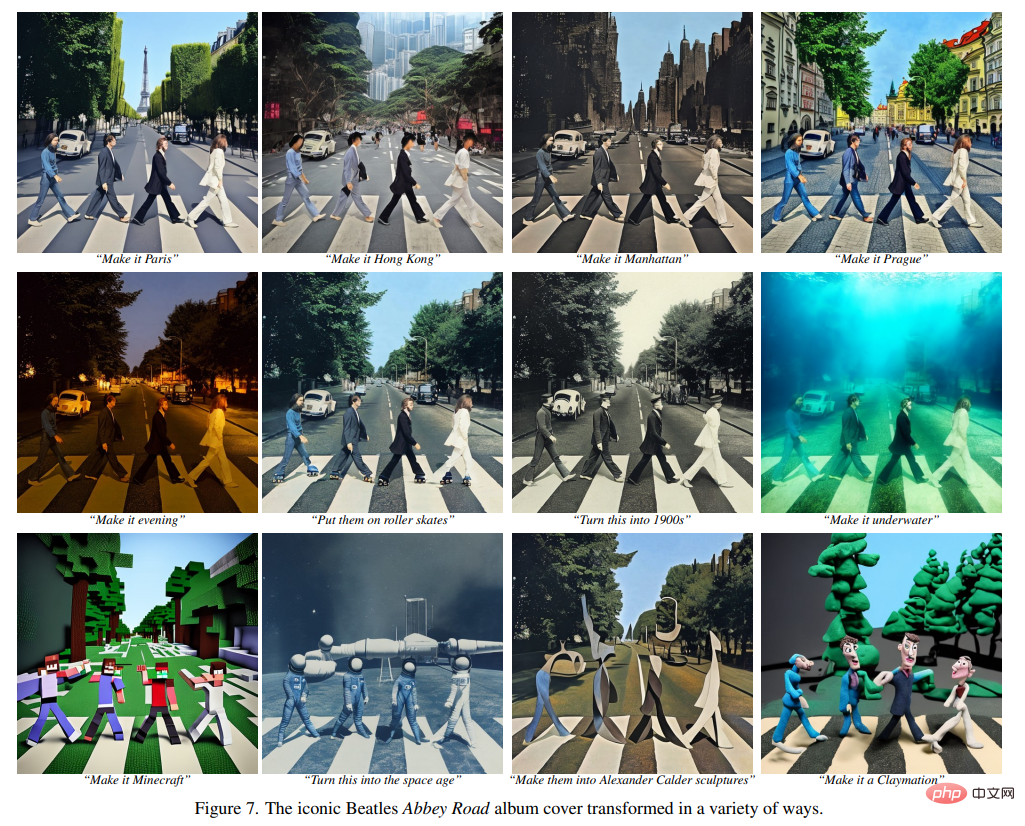

Selepas populariti model penyebaran, ramai orang telah menumpukan pada cara menggunakan gesaan yang lebih berkesan untuk menjana imej yang mereka inginkan. Dalam percubaan berterusan beberapa model lukisan AI, orang ramai telah meringkaskan pengalaman kata kunci untuk membuat lukisan AI dengan baik:

Dalam erti kata lain, jika anda menguasai kemahiran AI yang betul, kesan peningkatan kualiti lukisan akan menjadi sangat jelas (lihat: "Bagaimana untuk melukis "Alpaca Playing Basketball"? Seseorang membelanjakan 13 dolar AS untuk memaksa DALL· E 2 Tunjukkan kemahiran sebenar anda 》).

Selain itu, sesetengah penyelidik sedang berusaha ke arah lain: cara menukar lukisan kepada apa yang kita mahu dengan hanya beberapa perkataan.

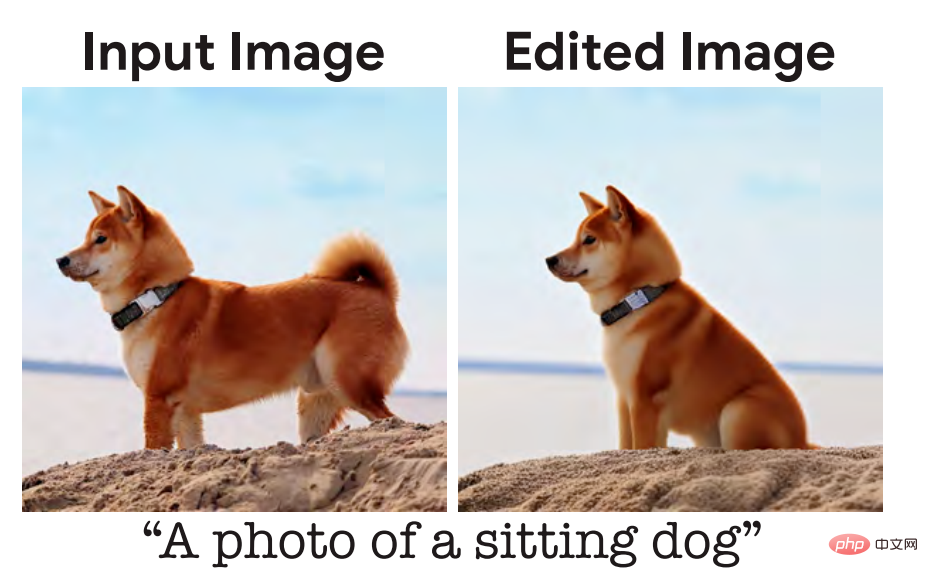

Beberapa masa lalu, kami melaporkan tentang penyelidikan daripada Google Research dan institusi lain . Sebut sahaja rupa imej yang anda mahukan dan ia pada asasnya akan melakukan apa yang anda mahu, menghasilkan imej fotorealistik, seperti anak anjing duduk:

Penerangan input yang diberikan kepada model di sini ialah "anjing duduk", tetapi mengikut tabiat komunikasi harian manusia, penerangan yang paling semula jadi adalah "biar anjing ini duduk". Sesetengah penyelidik percaya bahawa ini adalah masalah yang harus dioptimumkan, dan modelnya harus lebih sejajar dengan tabiat bahasa manusia.

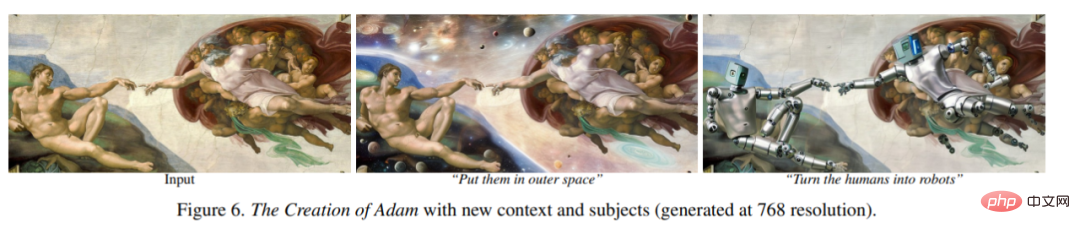

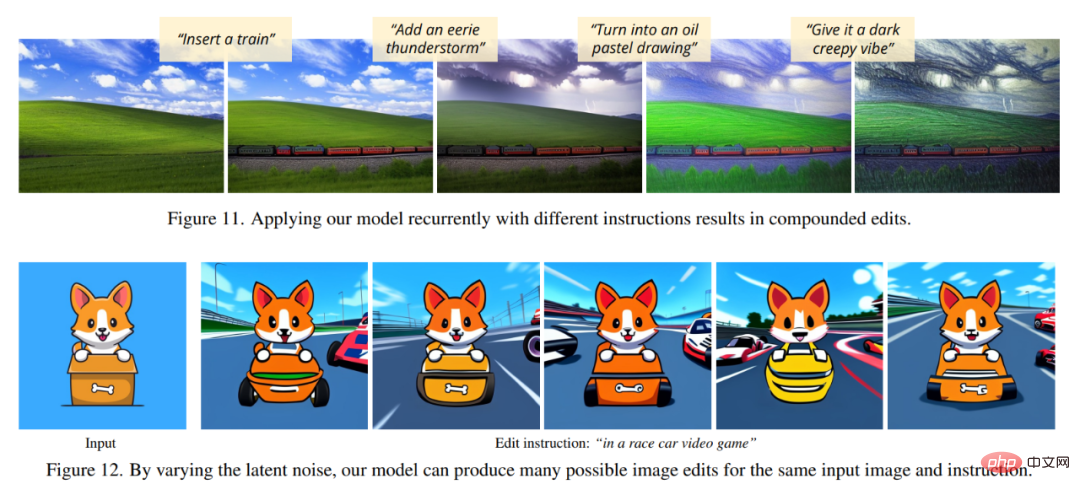

Baru-baru ini, pasukan penyelidik dari UC Berkeley mencadangkan kaedah baharu untuk mengedit imej berdasarkan arahan manusia: InstructPix2Pix: Memandangkan imej input dan penerangan teks yang memberitahu model apa yang perlu dilakukan, model Keupayaan untuk mengikuti arahan penerangan untuk mengedit imej.

Alamat kertas: https://arxiv.org/pdf/2211.09800.pdf

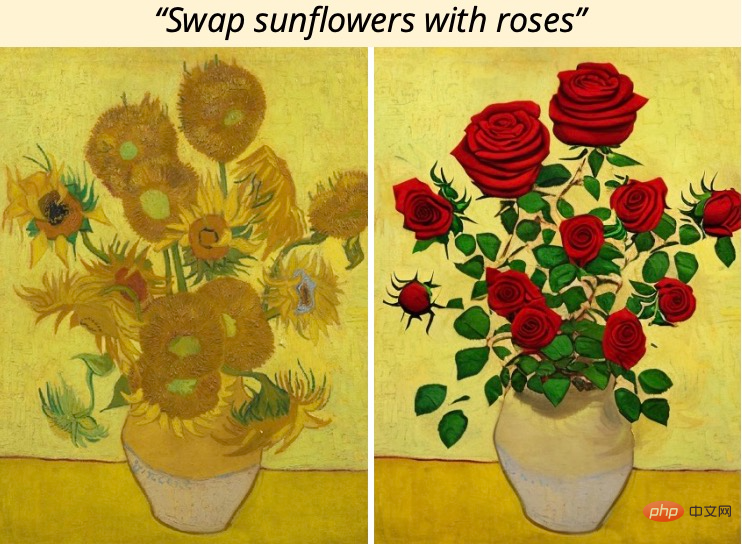

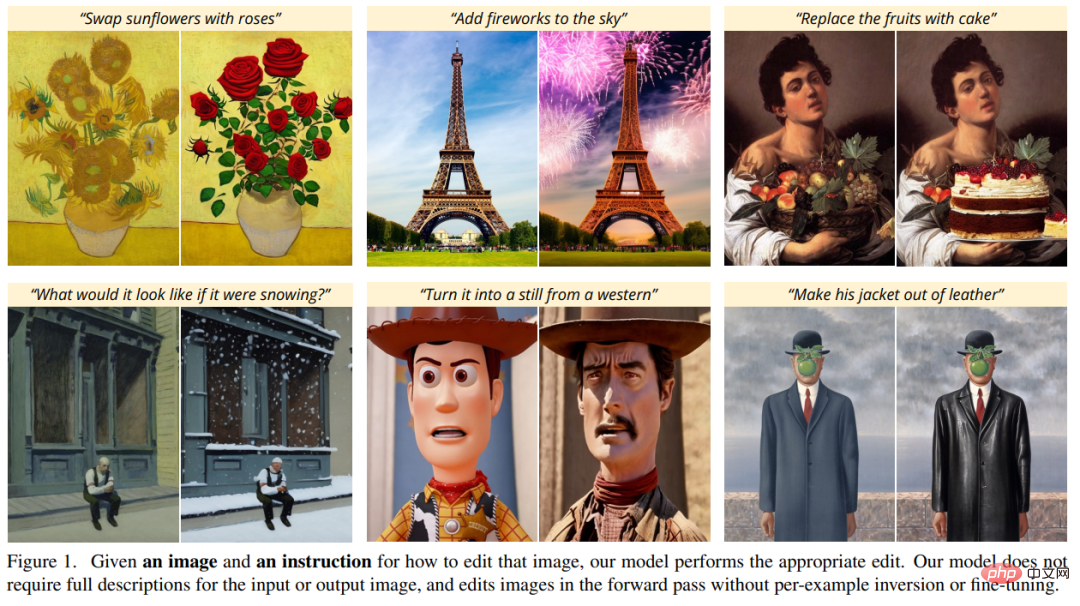

Sebagai contoh, untuk menukar bunga matahari dalam lukisan kepada mawar, anda hanya perlu mengatakan terus kepada model "Tukar bunga matahari kepada mawar":

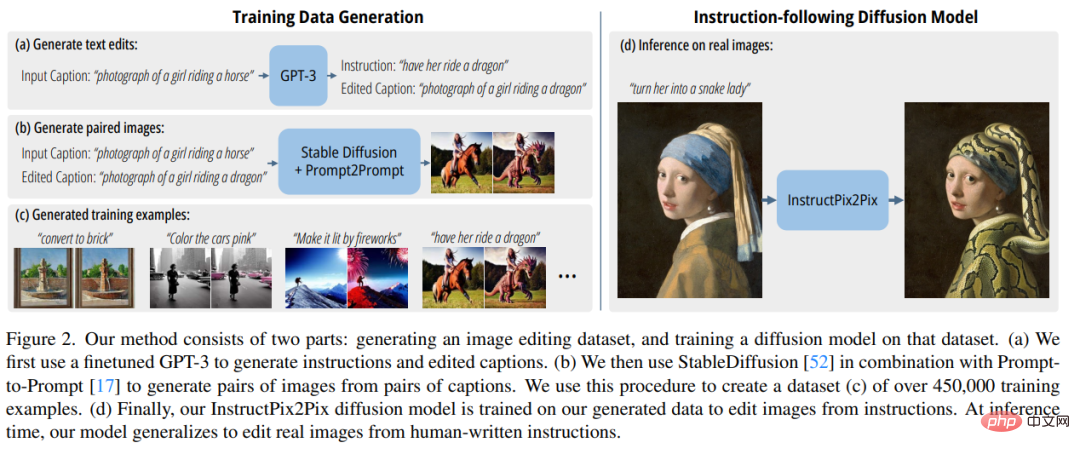

Untuk mendapatkan data latihan, kajian ini menggabungkan dua model pra-latihan besar - model bahasa (GPT-3) dan model generatif teks-ke-imej (Stable Diffusion) untuk menjana set data latihan berpasangan yang besar contoh penyuntingan imej. Para penyelidik melatih model baharu, InstructPix2Pix, pada dataset besar ini dan digeneralisasikan kepada imej sebenar dan arahan bertulis pengguna pada masa inferens.

InstructPix2Pix ialah model resapan bersyarat yang menjana imej yang diedit diberikan imej input dan arahan teks untuk mengedit imej. Model melakukan pengeditan imej secara terus dalam pas ke hadapan dan tidak memerlukan sebarang imej contoh tambahan, penerangan penuh imej input/output atau penalaan halus setiap contoh, jadi model boleh mengedit imej dengan cepat dalam beberapa saat sahaja.

Walaupun InstructPix2Pix dilatih sepenuhnya pada contoh sintetik (iaitu, penerangan teks yang dihasilkan oleh GPT-3 dan imej yang dijana oleh Stable Diffusion), model ini mencapai ketepatan pada imej sebenar arbitrari dan Zero generalisasi -shot kepada teks tulisan manusia. Mockup menyokong penyuntingan imej intuitif, termasuk menggantikan objek, menukar gaya imej dan banyak lagi.

Tinjauan Keseluruhan Kaedah

Para penyelidik menganggap penyuntingan imej berasaskan arahan sebagai masalah pembelajaran yang diselia: Pertama, mereka menjana set data latihan berpasangan yang mengandungi arahan penyuntingan teks dan imej sebelum dan selepas penyuntingan (Rajah 2a- c), dan kemudian melatih model penyebaran penyuntingan imej pada set data yang dihasilkan ini (Rajah 2d). Walaupun dilatih menggunakan imej yang dihasilkan dan arahan penyuntingan, model tersebut masih mampu menyunting imej sebenar menggunakan arahan sewenang-wenangnya yang ditulis oleh manusia. Rajah 2 di bawah ialah gambaran keseluruhan kaedah.

Hasilkan set data latihan pelbagai mod

dalam data Dalam peringkat penjanaan yang ditetapkan, penyelidik menggabungkan keupayaan model bahasa besar (GPT-3) dan model teks-ke-imej (Stable Diffusion) untuk menjana set data latihan pelbagai mod yang mengandungi arahan penyuntingan teks dan imej yang sepadan sebelum ini. dan selepas diedit. Proses ini terdiri daripada langkah berikut:

- Perhalus GPT-3 untuk menjana koleksi kandungan penyuntingan teks: Memandangkan gesaan menerangkan imej, hasilkan teks yang menerangkan perintah perubahan yang perlu dibuat dan gesaan yang menerangkan imej yang telah diubah (Rajah 2a); ) ke dalam imej pasangan yang sepadan (Rajah 2b).

- InstructPix2Pix

Para penyelidik menggunakan data latihan yang dijana untuk melatih model resapan bersyarat model Stable Diffusion, imej boleh diedit berdasarkan arahan bertulis.

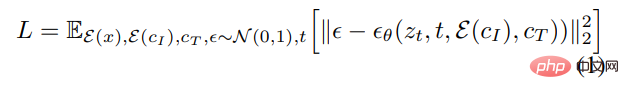

Pembelajaran model resapan menjana sampel data melalui satu siri pengekod auto denosing yang menganggarkan pecahan pengedaran data (menunjuk ke arah data berketumpatan tinggi). Resapan terpendam dipertingkatkan dengan beroperasi dalam ruang terpendam autopengekod variasi terlatih dengan pengekod

dan penyahkod Kecekapan dan kualiti model resapan. Untuk imej x, proses resapan menambahkan hingar pada pendam yang dikodkan

, yang menghasilkan z_t pendam yang bising, di mana bunyi tahap meningkat dengan langkah masa t∈T. Kami mempelajari rangkaian yang meramalkan hingar yang ditambahkan pada z_t terpendam bising diberi penyaman imej C_I dan pengatur arahan teks C_T. Para penyelidik meminimumkan objektif resapan terpendam berikut:

Kajian terdahulu (Wang et al.) telah menunjukkan bahawa untuk tugas terjemahan imej (terjemahan imej), terutamanya apabila data latihan berpasangan adalah terhad, penalaan halus model penyebaran imej yang besar adalah lebih baik daripada melatihnya dari awal. Oleh itu, dalam penyelidikan baharu, pengarang menggunakan pusat pemeriksaan Stable Diffusion yang telah terlatih untuk memulakan pemberat model, mengambil kesempatan daripada keupayaan penjanaan teks-ke-imej yang berkuasa.

Untuk menyokong penyaman imej, penyelidik menambah saluran input tambahan pada lapisan konvolusi pertama, menyambungkan z_t dan

. Semua pemberat yang tersedia bagi model resapan dimulakan dari pusat pemeriksaan pralatihan, manakala pemberat yang beroperasi pada saluran input yang baru ditambah dimulakan kepada sifar. Penulis di sini menggunakan semula mekanisme pelarasan teks yang sama yang asalnya digunakan untuk kapsyen tanpa mengambil arahan penyuntingan teks c_T sebagai input.  Hasil eksperimen

Hasil eksperimen

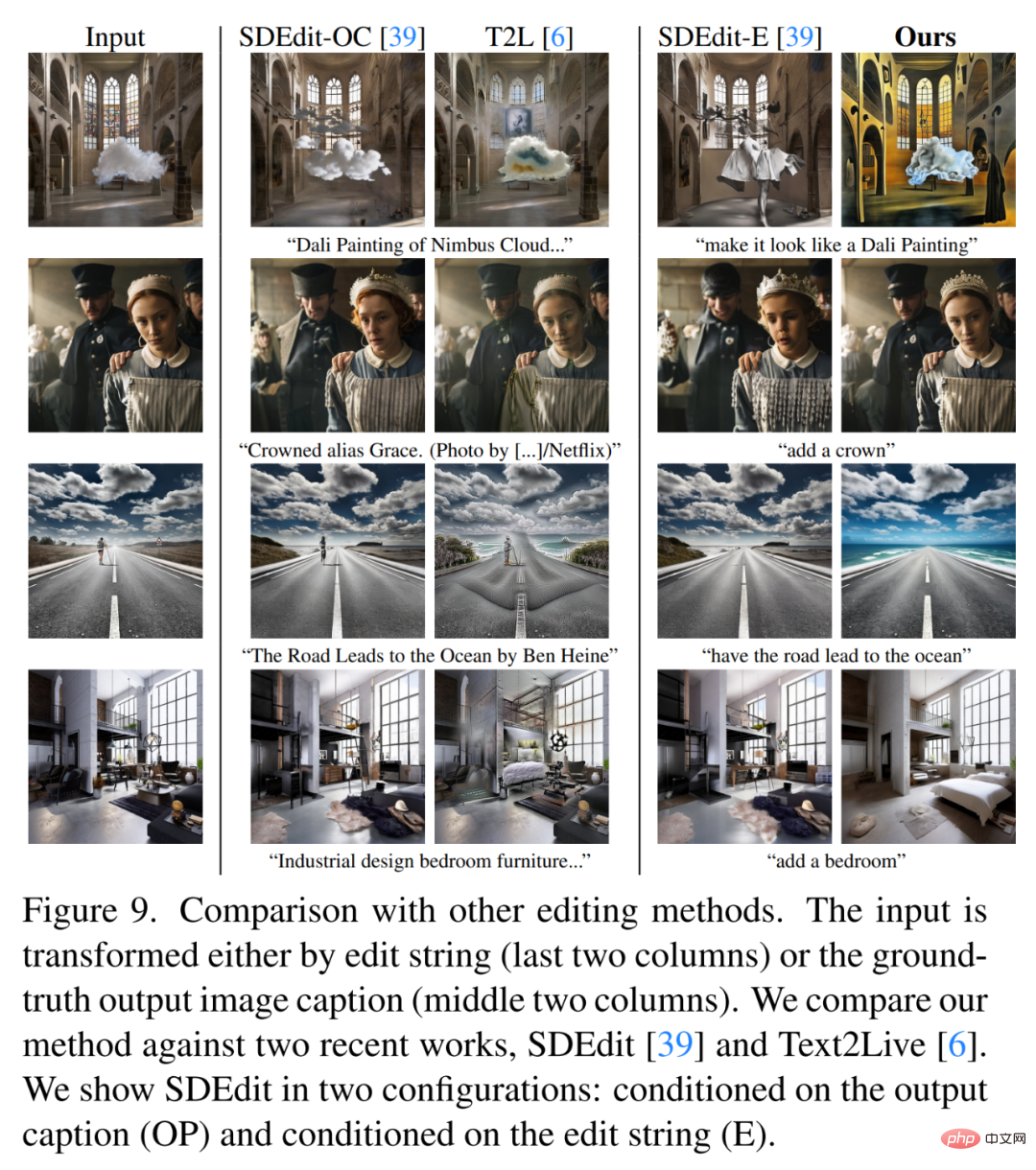

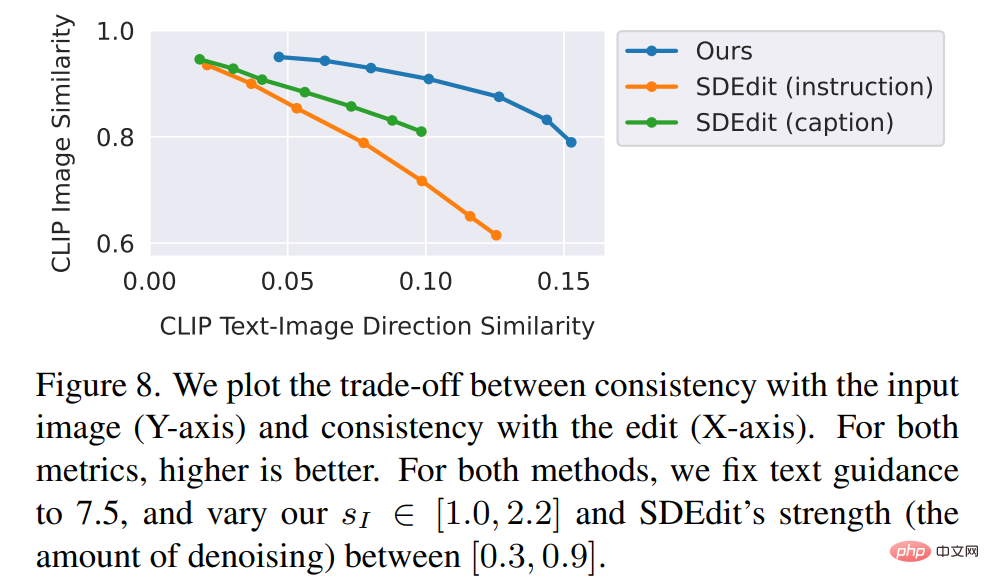

Para penyelidik membandingkan kaedah baharu dengan kaedah terkini Sesetengah teknologi seperti SDEdit, Text2Live, dsb. dibandingkan. Model baharu mengikut arahan untuk mengedit imej, manakala kaedah lain, termasuk kaedah garis dasar, memerlukan penerangan imej atau lapisan penyuntingan. Oleh itu, apabila membandingkan, pengarang menyediakan anotasi teks "diedit" untuk yang terakhir dan bukannya arahan mengedit. Penulis juga secara kuantitatif membandingkan kaedah baharu dengan SDEdit, menggunakan dua metrik yang mengukur ketekalan imej dan kualiti penyuntingan. Akhir sekali, penulis menunjukkan bagaimana saiz dan kualiti data latihan yang dihasilkan mempengaruhi keputusan ablasi dalam prestasi model.

Atas ialah kandungan terperinci GPT-3 dan Stable Diffusion bekerjasama untuk membantu model memahami keperluan ubah suai imej Party A. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

Cara menggunakan array char dalam bahasa c

Apr 03, 2025 pm 03:24 PM

Cara menggunakan array char dalam bahasa c

Apr 03, 2025 pm 03:24 PM

Arus char menyimpan urutan watak dalam bahasa C dan diisytiharkan sebagai array_name char [saiz]. Unsur akses diluluskan melalui pengendali subskrip, dan elemen berakhir dengan terminator null '\ 0', yang mewakili titik akhir rentetan. Bahasa C menyediakan pelbagai fungsi manipulasi rentetan, seperti strlen (), strcpy (), strcat () dan strcmp ().

Elakkan kesilapan yang disebabkan secara lalai dalam penyataan suis C

Apr 03, 2025 pm 03:45 PM

Elakkan kesilapan yang disebabkan secara lalai dalam penyataan suis C

Apr 03, 2025 pm 03:45 PM

Strategi untuk mengelakkan kesilapan yang disebabkan oleh lalai dalam pernyataan suis C: Gunakan enums dan bukannya pemalar, mengehadkan nilai pernyataan kes kepada ahli yang sah dari enum. Gunakan kejatuhan dalam pernyataan kes terakhir untuk membiarkan program terus melaksanakan kod berikut. Untuk pernyataan suis tanpa kejatuhan, selalu tambahkan pernyataan lalai untuk pengendalian ralat atau memberikan tingkah laku lalai.

Apakah fungsi jumlah bahasa C?

Apr 03, 2025 pm 02:21 PM

Apakah fungsi jumlah bahasa C?

Apr 03, 2025 pm 02:21 PM

Tiada fungsi jumlah terbina dalam dalam bahasa C, jadi ia perlu ditulis sendiri. Jumlah boleh dicapai dengan melintasi unsur -unsur array dan terkumpul: Versi gelung: SUM dikira menggunakan panjang gelung dan panjang. Versi Pointer: Gunakan petunjuk untuk menunjuk kepada unsur-unsur array, dan penjumlahan yang cekap dicapai melalui penunjuk diri sendiri. Secara dinamik memperuntukkan versi Array: Perlawanan secara dinamik dan uruskan memori sendiri, memastikan memori yang diperuntukkan dibebaskan untuk mengelakkan kebocoran ingatan.

Kepentingan lalai dalam pernyataan kes suis (bahasa c)

Apr 03, 2025 pm 03:57 PM

Kepentingan lalai dalam pernyataan kes suis (bahasa c)

Apr 03, 2025 pm 03:57 PM

Pernyataan lalai adalah penting dalam pernyataan kes suis kerana ia menyediakan laluan pemprosesan lalai yang memastikan bahawa blok kod dilaksanakan apabila nilai pembolehubah tidak sepadan dengan sebarang pernyataan kes. Ini menghalang tingkah laku atau kesilapan yang tidak dijangka dan meningkatkan keteguhan kod.

Apakah jenis nilai pulangan fungsi bahasa C? Ringkasan jenis nilai pulangan fungsi bahasa C?

Apr 03, 2025 pm 11:18 PM

Apakah jenis nilai pulangan fungsi bahasa C? Ringkasan jenis nilai pulangan fungsi bahasa C?

Apr 03, 2025 pm 11:18 PM

Jenis nilai pulangan fungsi bahasa C termasuk int, float, double, char, void dan jenis penunjuk. Int digunakan untuk mengembalikan bilangan bulat, terapung dan dua kali digunakan untuk mengembalikan terapung, dan char mengembalikan aksara. Kekosongan bermaksud bahawa fungsi tidak mengembalikan sebarang nilai. Jenis penunjuk mengembalikan alamat memori, berhati -hati untuk mengelakkan kebocoran ingatan. Struktur atau konsortium boleh mengembalikan pelbagai data yang berkaitan.

Konsep fungsi bahasa c

Apr 03, 2025 pm 10:09 PM

Konsep fungsi bahasa c

Apr 03, 2025 pm 10:09 PM

F Fungsi bahasa adalah blok kod yang boleh diguna semula. Mereka menerima input, melakukan operasi, dan hasil pulangan, yang secara modular meningkatkan kebolehgunaan dan mengurangkan kerumitan. Mekanisme dalaman fungsi termasuk parameter lulus, pelaksanaan fungsi, dan nilai pulangan. Seluruh proses melibatkan pengoptimuman seperti fungsi dalam talian. Fungsi yang baik ditulis mengikut prinsip tanggungjawab tunggal, bilangan parameter kecil, penamaan spesifikasi, dan pengendalian ralat. Penunjuk yang digabungkan dengan fungsi dapat mencapai fungsi yang lebih kuat, seperti mengubahsuai nilai pembolehubah luaran. Pointer fungsi meluluskan fungsi sebagai parameter atau alamat kedai, dan digunakan untuk melaksanakan panggilan dinamik ke fungsi. Memahami ciri dan teknik fungsi adalah kunci untuk menulis program C yang cekap, boleh dipelihara, dan mudah difahami.

Adakah jumlah kata kunci dalam bahasa C?

Apr 03, 2025 pm 02:18 PM

Adakah jumlah kata kunci dalam bahasa C?

Apr 03, 2025 pm 02:18 PM

Kata kunci Jumlah tidak wujud dalam bahasa C, ia adalah pengenal biasa dan boleh digunakan sebagai nama pembolehubah atau fungsi. Tetapi untuk mengelakkan salah faham, adalah disyorkan untuk mengelakkan menggunakannya untuk pengenalpastian kod berkaitan matematik. Lebih banyak nama deskriptif seperti Array_Sum atau Calculate_sum boleh digunakan untuk meningkatkan kebolehbacaan kod.

Bagaimana memahami! X dalam c?

Apr 03, 2025 pm 02:33 PM

Bagaimana memahami! X dalam c?

Apr 03, 2025 pm 02:33 PM

! X Memahami! X adalah bukan operator logik dalam bahasa C. Ia booleans nilai x, iaitu, perubahan benar kepada perubahan palsu, palsu kepada benar. Tetapi sedar bahawa kebenaran dan kepalsuan dalam C diwakili oleh nilai berangka dan bukannya jenis Boolean, bukan sifar dianggap sebagai benar, dan hanya 0 dianggap sebagai palsu. Oleh itu ,! X memperkatakan nombor negatif sama seperti nombor positif dan dianggap benar.